1 引言

目标检测是遥感图像判读中的一个重要研究方向,在军事侦察、智能监测、智慧城市等多个领域都有着广泛的应用需求。近些年来随着深度学习技术的不断发展,不断涌现出一些优秀的目标检测算法[1- 8],卷积神经网络(Convolutional Neural Network, CNN)也已成为遥感图像目标检测任务中的有力工具[9]。如Cheng等[10]提出了RIFD-CNN模型,该方法通过在训练过程中引入旋转不变正则化和Fisher判别正则化有效提高了遥感图像目标检测精度。为了使目标边框回归更加准确,Long等[11]提出了一种基于区域卷积神经网络的无监督评分边界框回归方法USB-BBR。为了消除候选区域建议网络(Region Proposal Network, RPN)对人工设计的依赖,学者们将Faster R-CNN[1]框架应用到遥感图像中并在此基础上进行改进,如Li等[12]提出了一个旋转不敏感RPN,该方法在RPN中引入多角度锚,可以有效的处理遥感图像中目标方向旋转变化的问题,此外该方法设计了一种双通道特征组合网络来学习目标的局部和上下文信息,有效提高了目标检测精度。Zhong等[13]利用位置敏感平衡方法来提高生成候选区域的质量,该方法在残差网络ResNet[14]的基础上引入全卷积网络[15],解决目标检测中的平移变化和图像分类中的平移不变性之间的矛盾。Xu 等[16]提出受长宽比约束的非最大值抑制来提高候选区域的质量,并利用可变形的CNN来建模物体的几何变化,有效改善了目标检测效果。Tang等[17]借鉴了SSD[6]的思路进行车辆目标检测,在特征图中每个位置生成一组不同尺度的默认边框,通过预测每个默认边框的偏移量来进行目标定位。Liu等[18]将传统的边界框替换为可旋转边框嵌入SSD中,使得该算法可以预测目标的方向角,具有旋转不变性。Liu等[19]以YOLOv2为基础设计了一种可以检测任意方向舰船的框架。虽然上述方法通过各种设计在一定程度上改善了遥感图像目标检测的性能,但由于图像分辨率不同或者目标尺度不一而导致的尺度差异依然是遥感图像中目标检测一个难题,如何提高多尺度目标的检测精度仍需进一步研究。

针对上述问题,本文以经典检测框架Cascade R-CNN网络为基础,设计了基于特征增强和锚点自动生成的遥感图像目标检测算法。该算法首先将ResNet50骨干网络中每个模块的3*3卷积替换为可操控的空洞卷积(Switch Atrous Convolution, SAC)[20]模块,使得同一特征图中包含不同感受野下提取的特征信息。在此基础上设计了增强特征金字塔网络(Enhanced Feature Pyramid Network, EFPN),引导前向传播得到的每层特征图信息流入传统特征金字塔的对应层次融合特征图上,使得被弱化的特征信息得到增强,增强网络对不同尺度特征的表达能力。为了获得更高质量的候选区域,在区域建议网络(Region Proposal Network, RPN)中引入可以自动学习锚点框位置和形状的锚点框自动生成模块(Anchor Automatic Generation Module, AAGM)[21]。经实验证明,本文所提方法可以有效提高遥感图像中多类多尺度目标的检测精度。

2 网络设计

本文所提方法的整体网络结构如图1所示,首先将ResNet50骨干网络中的3*3的卷积层全部替换为SAC模块,该模块利用不同的膨胀率的空洞卷积,使得特征图的不同区域可以动态的选择感受野,提取多尺度特征信息。为避免特征通道缩减导致的信息丢失以及更加充分的利用低层特征信息的细节表达能力和高层特征信息的语义表达能力搭建了增强特征金字塔网络,在原始特征金字塔的基础上,提出残差特征增强通道,将骨干网络前向传播得到的原始特征图与特征金字塔的融合特征图连接,并设计自适应插值融合模块将两者融合,增强网络的特征表达能力。在RPN网络中利用锚点框生成模块自动学习锚点框的位置和长宽,避免了人工预设锚点框形状和大小等相关参数所带来的限制。在分类回归网络中借鉴Cascade R-CNN中的级联思想,将多个分类回归阶段级联,前一个阶段回归得到的边框区域作为候选区域输入到下一个分类回归阶段,通过逐次提高各个阶段的交并比(Intersection over Union, IoU)阈值来找到IoU更高的正样本。

图1 目标检测整体流程

Fig.1 The flowchart of our method

2.1 特征提取网络

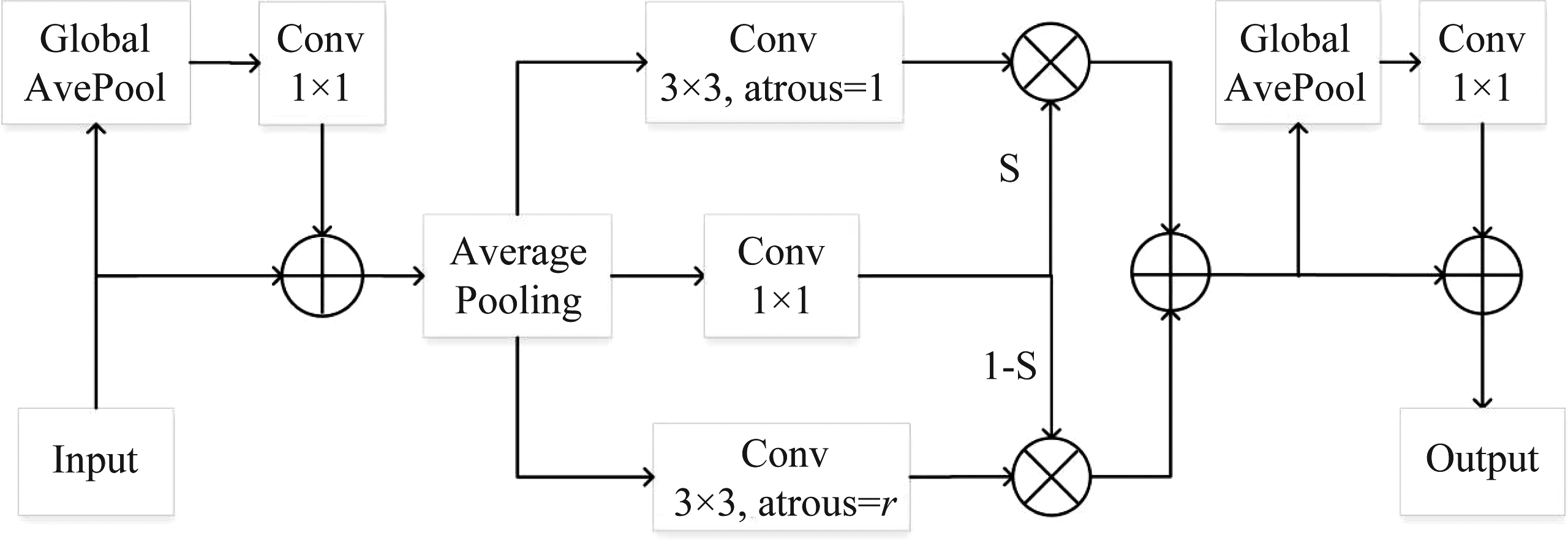

经研究表明,大尺度感受野对大尺度目标特征提取效果较好,小尺度感受野对小尺度目标特征提取效果较好[22],因此本文使用不同膨胀率的空洞卷积来改变卷积层滤波器的感受野大小,提高网络多尺度特征提取能力。已有的算法通常使用原始的ResNet网络进行特征提取,而本文将ResNet网络前向传播过程中的所有卷积核为3×3的标准卷积层全部替换为SAC模块,增加网络感受野大小的多样性。SAC模块结构如图2所示,在SAC模块的首部和尾部分别设计两个全局上下文信息模块,降低噪声的干扰, 增强目标信息,达到特征优选的目的。输入的特征首先通过一个全局平均池化层进行压缩,然后连接一个1×1的卷积层,将卷积得到的特征图与输入特征图相加,这种上下文模块可以有效的丰富特征图的全局信息,利于提取更稳健的特征信息。SAC的中间部分分为三条支路,其中上下两条分别是膨胀率为1和r的空洞卷积支路,中间一条支路即可切换函数S(.),由一个5×5的平均池化层和一个1×1卷积层组成,将得到的结果分别乘以其他两个支路得到的特征图,然后将两者相加得到融合的特征图。若在特征图某个位置的S值大于 0.5,则融合特征图的大部分信息来自膨胀率为1的分支,若S值小于0.5则最终特征图中的信息大部分来自膨胀率为r的分支。在训练过程中,利用预训练模型的权重来初始化膨胀率为r的卷积层的权重,具体的转化如公式(1)所示:

图2 SAC模块结构

Fig.2 The architecture of SAC model

![]() (1-S(x))·Conv(x,w+Δw,r)

(1-S(x))·Conv(x,w+Δw,r)

(1)

其中x是输入的特征图,1和r是SAC的超参数,也即膨胀率,这里设置r=3,w是预训练模型的权重,Δw是可训练的权重,初始化为0。

2.2 特征融合网络EFPN

为了改善多尺度目标的检测效果,现有的算法通常在特征融合网络部分使用特征金字塔结构,通过横向连接中的1×1的卷积直接将原始特征图通道数降到256[23],在通道减少的同时也会损失一部分的原始特征图通道特征信息,并且融合相邻层次的原始特征图在增加其他特征层特征信息的同时也会对本层特征信息产生弱化作用。基于以上考虑本文在特征融合网络中增加了一条残差特征增强通道,通过增强空间上下文信息来弥补通道减少带来的信息丢失,在特征金字塔融合特征图的基础上,将对应层的原始特征图信息经过一个聚合模块,该模块使用不同的比例参数α1、α2、α3来进行自适应池化操作实现下采样,提取不同尺度的上下文信息。下采样后的宽高分别αi×w、αi×h,接着利用一个1×1的卷积将不同尺度的特征图的通道维持在256,再利用双线性插值将三者上采样到w×h大小,接着对上采样结果进行自适应空间融合。融合的过程也即提取注意力的过程,首先将三个上采样结果concat,然后逐次经过一个1×1和3×3的卷积,最后利用sigmoid函数得到最后的注意力图,通过split操作将得到的总注意力图分离成三个子注意力分别应用于对应的输入特征图,最后将三个包含不同尺度上下文信息的特征图聚合后注入到原始的融合特征图中,使得特征得到进一步的增强。具体的融合过程如图3所示。

图3 EFPN网络结构

Fig.3 The architecture of EFPN

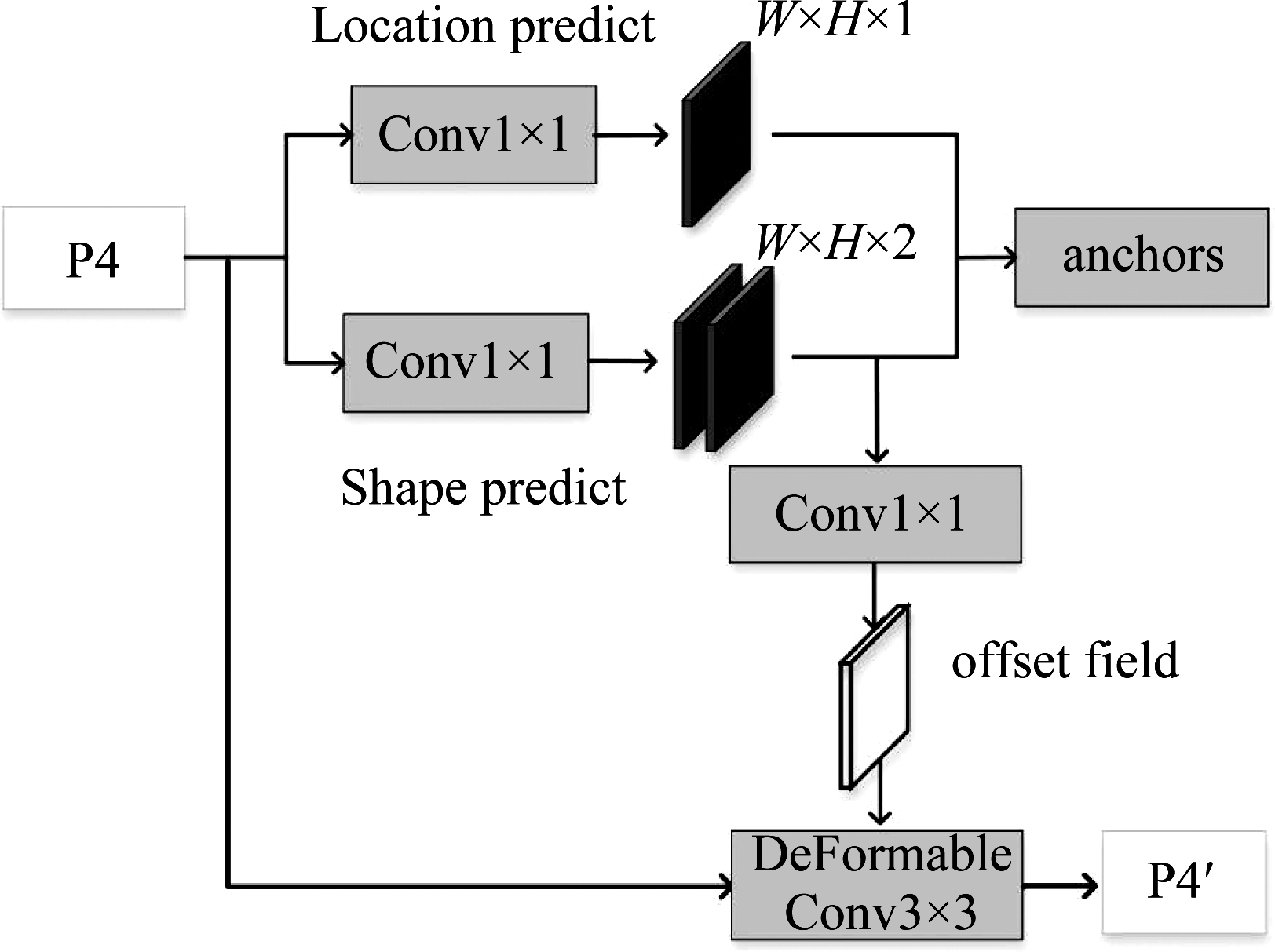

2.3 候选区域生成网络ARPN

常用的RPN网络需要针对不同的任务人工预定义一组锚点框的尺度和长宽比,这在很大程度上依赖于先验知识,若预设的参数与数据集不匹配则会很大程度的影响目标检测精度。考虑到包含目标的锚点框的位置和长宽与图像内容、感兴趣目标的位置和形状密切相关,同时为了降低计算成本,生成相对稀疏的高质量的锚点框,本文在RPN中使用锚点自动生成模块代替传统的锚点框生成法。如图4所示,首先将输入的融合特征图送入两个分支,一个分支对锚点框位置进行预测,对特征图进行1×1的卷积得到尺寸不变的概率图,其维度为W×H×1,其中每个位置上的值表示在该位置存在目标中心的可能性,然后使用Sigmoid函数将其转换成概率值。同时设定一个阈值,当某个位置的概率值高于阈值时,就认为在该位置可能存在目标。另一个分支对锚点框的形状进行预测,对输入的特征图进行1×1的卷积,生成一个维度为W×H×2的两通道映射图,分别对应每个位置候选框的偏移量dw和dh,然后通过一个逐元素的非线性变换层将其映射为候选框的w、h,具体的变换如公式(2)所示。

图4 ARPN网络结构

Fig.4 The architecture of ARPN

w=σ·s·edw,h=σ·s·edh

(2)

其中s是步幅,σ是经验比例因子,本文设为8。通过预测特征图中每个位置的最佳形状,使其最大程度的接近真值框区域。结合两条支路的预测结果,即可得到最终的锚点框。常用的RPN中每个位置的锚点框都均匀的享有相同的尺寸,在同一个卷积层的不同位置,感受野的尺寸是相同的,因此特征图可以学习到连续的特征表示,而锚点自动生成模块生成的不同位置上的锚点框可能具有不同的形状和尺寸,并且由研究可知,较大锚点框在较大的区域上进行编码,较小的锚点框应在较小的区域上进行编码[24],所以本文使用特征自适应模块对特征图进行调整,首先在上述锚点框形状预测分支的输出上使用1×1的卷积得到锚点框形状的偏移量,然后通过3×3的形变卷积[25]将偏移量信息融入到输入的特征图中对其进行调整。经过这种设计使得特征的有效范围和锚点框区域更加接近,得到更高质量的锚点框区域。

2.4 损失函数

在本文算法中,由于加入了锚点框的位置预测和形状预测两个设计,相应的,在进行端到端的训练时多任务损失函数也要进行相应的改变,除了基本的分类损失和回归损失之外,还需要学习锚点框的位置和形状,因此还要再加上相对应的两个损失函数部分。完整的损失函数部分如公式(3)所示。

L=λ1Lloc+λ2Lshape+Lcls+Lreg

(3)

本文使用focal loss[7]计算锚点框的位置损失Lloc,通过减少易分类样本的权重,使得网络更专注于难分类的样本,具体如公式(4)所示。

FL(pt)=-αt(1-pt)γlog(pt)

(4)

其中pt是锚点框区域属于正样本或负样本的概率,由公式(5)得到,其中y∈{±1},代表样本类别,p∈[0,1]是网络对于样本的标签类别为1的概率估计。αt为权重参数,由公式(5)得到,其中α∈[0, 1]。公式(4)中的(1-pt)γ为调节因子,γ≥0为可调节聚焦参数,当pt→1时,调节因子(1-pt)γ→0,因此易分类样本的权重就会减小,其对loss的贡献越小,相反的,难分类样本的权重会增大,进而使得网络更加关注难分类样本,通过这种动态调节方式尽可能的缓解样本的不平衡问题。

(5)

在学习锚点框的长宽时,常用的方法是先计算出和当前真值最匹配的宽高,然后计算损失函数,但是本文采用的方法中锚点框的形状不固定,所以要寻找和真值的IoU尽可能大的宽高,实际计算非常复杂,因此为了尽可能高效的在连续的宽和高的取值范围内找到最优值,我们对w和h的一些常用值进行采样,以模拟所有w和h的枚举,从理论上讲,采样的对越多,则近似值越准确,但计算量会越大,因此本文借鉴RPN网络中预设锚框的思想,使用9对w和h,也即给定一个锚点框的中心点,使用9对w和h得到的锚框来计算不同位置预设锚框与真值框的IoU,在这9对宽高中找到最大的IoU值用作vIoU(awh,gt)的近似值。其中预设锚框的相关参数设置参考文献[7],锚框尺寸分别为{20,21/3,22/3},宽高比分别为{0.5,1.0,2.0}。使用公式(6)计算不固定形状的锚点框和真值框之间的IoU。

(6)

其中IoUnormal表示常用的IoU计算方法,awh表示变化的锚点框的长和宽,gt表示地面真值的长和宽。最后利用bounded IoU loss[26]计算锚点框的形状损失Lshape。具体如公式(7)所示。

(7)

其中w,h,wg,hg分别表示锚点框和地面真值的宽和高,L1表示smooth L1 loss[27]。

3 实验

3.1 数据集与实验设置

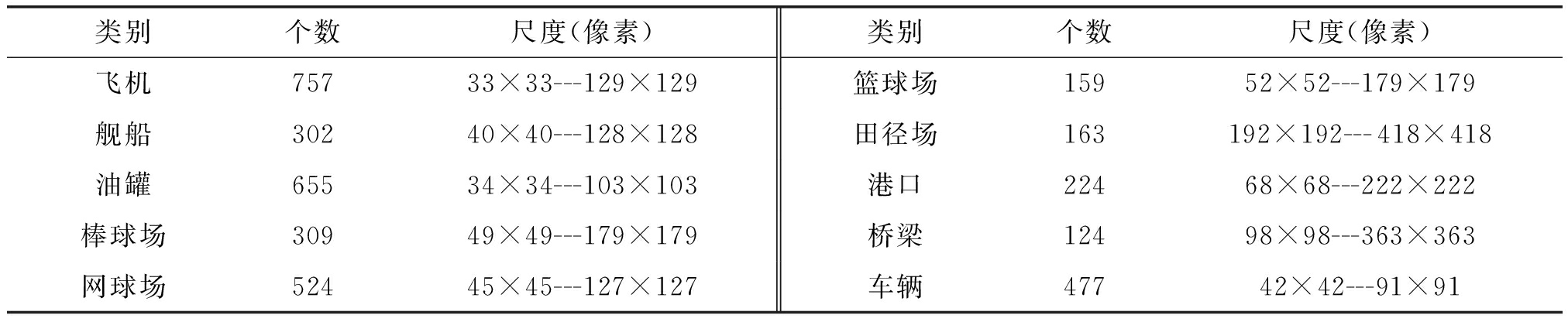

本文在NWPU VHR-10遥感数据集[28]上进行实验,该数据集总共包含分辨率及尺寸不一的650幅图像,目标一共被标记为如表1所示的十个类别,其中每类目标都涵盖了多种不同的形状和尺度。为满足卷积神经网络对于大量数据的需求,需要通过裁剪,旋转和翻转等操作进行数据扩充。为了降低十类目标数量的差异,我们对包含桥梁、田径场、篮球场和港口四类目标的图像分别进行水平翻转和垂直翻转,然后进行一次随机的亮度调整。得到最终的数据集后将其划分为训练集和测试集,本文随机选取了其中60%作为训练集,其余的作为测试集,其中训练集中样本量为8431,测试集中样本量为5453。

表1 NWPU VHR-10数据集目标信息统计

Tab.1 The object information statistics of NWPU VHR-10 dataset

类别个数尺度(像素)类别个数尺度(像素)飞机75733×33---129×129篮球场15952×52---179×179舰船30240×40---128×128田径场163192×192---418×418油罐65534×34---103×103港口22468×68---222×222棒球场30949×49---179×179桥梁12498×98---363×363网球场52445×45---127×127车辆47742×42---91×91

本文实验所采用的硬件配置为Intel i9-CPU,NIVIDIA GeForce RTX 2080 Ti显卡,采用深度学习工具包Pytorch完成实验。本文采用平均精度(average precision, AP)和平均精度均值(Mean Average Precision,mAP)作为评价指标,AP是每类目标的平均检测精度,mAP是针对数据集中十类目标的总体评价指标,值越高越好。

3.2 参数讨论

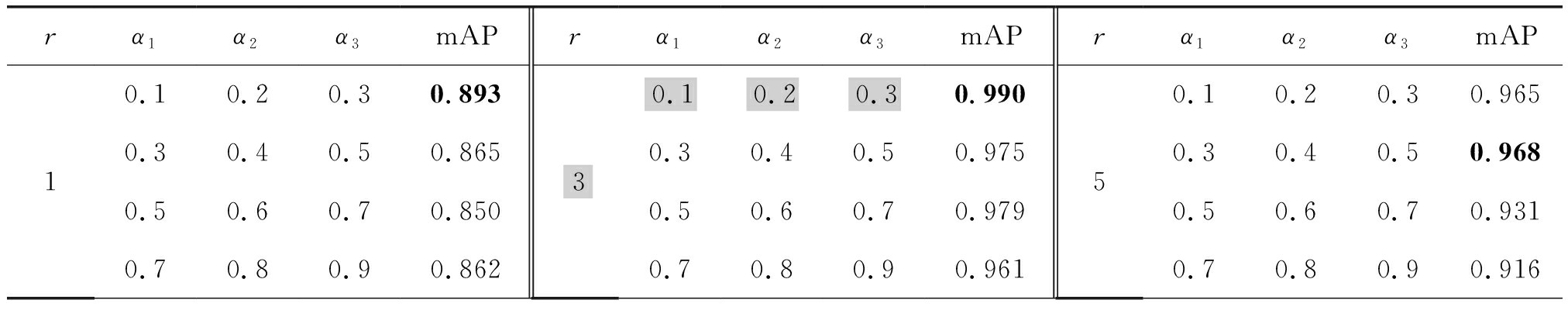

为了找到更合适的参数设置,本文在RSOD数据集[11]上对SAC模块中的膨胀率r以及特征融合网络中的比例参数αi进行了实验并根据实验结果进行讨论分析。首先按照3.1节所述对数据集进行处理,然后按照表2中不同的参数取值组合进行实验。实验结果如表2所示。

由表2可知,随着SAC中膨胀率r以及特征增强网络中的αi在不同的值时,得到mAP差异较大,这说明参数的设置对网络检测性能的影响至关重要。在SAC中膨胀率r在分别设置为1、3、5时,随着αi取值不断增大,mAP的变化虽偶有波动,但总体趋势是在不断减小,这表明在特征融合网络中,设置较小的比例参数可使获得的不同尺度的上下文信息更好的弥补减少通道中的信息损失,使得融合特征图的信息更加丰富。通过横向对比发现,在三组膨胀率r的实验中,r为3时的mAP为最高,r为1时的mAP最低,这说明使用空洞卷积可以使网络更有效的提取多尺度特征信息,但将膨胀率设置太大,反而减弱这种改善效果,导致mAP降低,检测性能下降。结合实验结果及上述分析,发现设置膨胀率r为3,融合比例参数αi分别为0.1、0.2以及0.3时,网络的mAP最高,检测性能最好。

表2 不同参数的影响分析

Tab.2 Analysis of influence of different parameters

rα1α2α3mAPrα1α2α3mAPrα1α2α3mAP10.10.30.50.70.20.40.60.80.30.50.70.90.8930.8650.8500.86230.10.30.50.70.20.40.60.80.30.50.70.90.9900.9750.9790.96150.10.20.30.9650.30.40.50.9680.50.60.70.9310.70.80.90.916

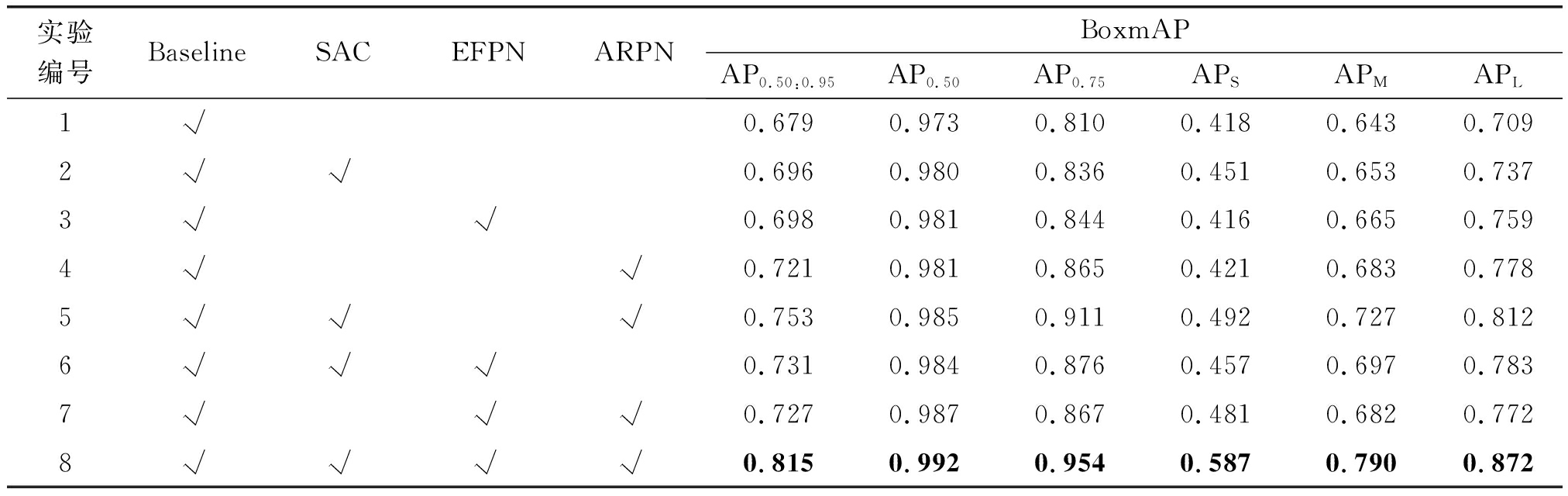

3.3 消融实验

为了分析算法中各个模块的有效性,本文设计了七组对比实验,实验结果如表3所示,随着SAC、EFPN以及ARPN模块的加入,算法的检测精度逐渐提高。实验1中是基础算法,没有加入任何模块。实验2加入SAC模块,mAP提升0.7%,因此在骨干网络中加入空洞卷积可以动态的选择感受野,有效的改善多尺度特征的提取。实验3加入EFPN模块,mAP相比于实验1增加了0.8%,证明通过短接支路可以成功的增强特征图中的有效信息。实验4加入了ARPN 模块,相比于实验1,mAP值增加了0.8%,证明锚点框自动生成模块的有效性。由前四组实验可知,SAC、EFPN以及ARPN三个模块都可以在不同程度上改善算法的检测性能。实验5在基础算法上同时加入了SAC和ARPN模块,mAP比基础算法提升了1.2%,实验6同时加入了SAC和EFPN模块,mAP提升了1.1%,实验7同时加入EFPN和ARPN模块,mAP提升了1.4%,最后一组实验同时加入三个模块,也即本文所提算法,mAP值为99.2%,比基础算法提高了1.9%。综合以上8组实验结果可知,本文所提算法中可以更有效的挖掘多尺度特征信息,有效增强了算法的尺度自适应性,提高了算法的检测性能。

表3 不同模块对检测性能的影响

Tab.3 The influence of different modules on detection performance

实验编号BaselineSACEFPNARPNBoxmAPAP0.50:0.95AP0.50AP0.75APSAPMAPL1√0.6790.9730.8100.4180.6430.7092√√0.6960.9800.8360.4510.6530.7373√√0.6980.9810.8440.4160.6650.7594√√0.7210.9810.8650.4210.6830.7785√√√0.7530.9850.9110.4920.7270.8126√√√0.7310.9840.8760.4570.6970.7837√√√0.7270.9870.8670.4810.6820.7728√√√√0.8150.9920.9540.5870.7900.872

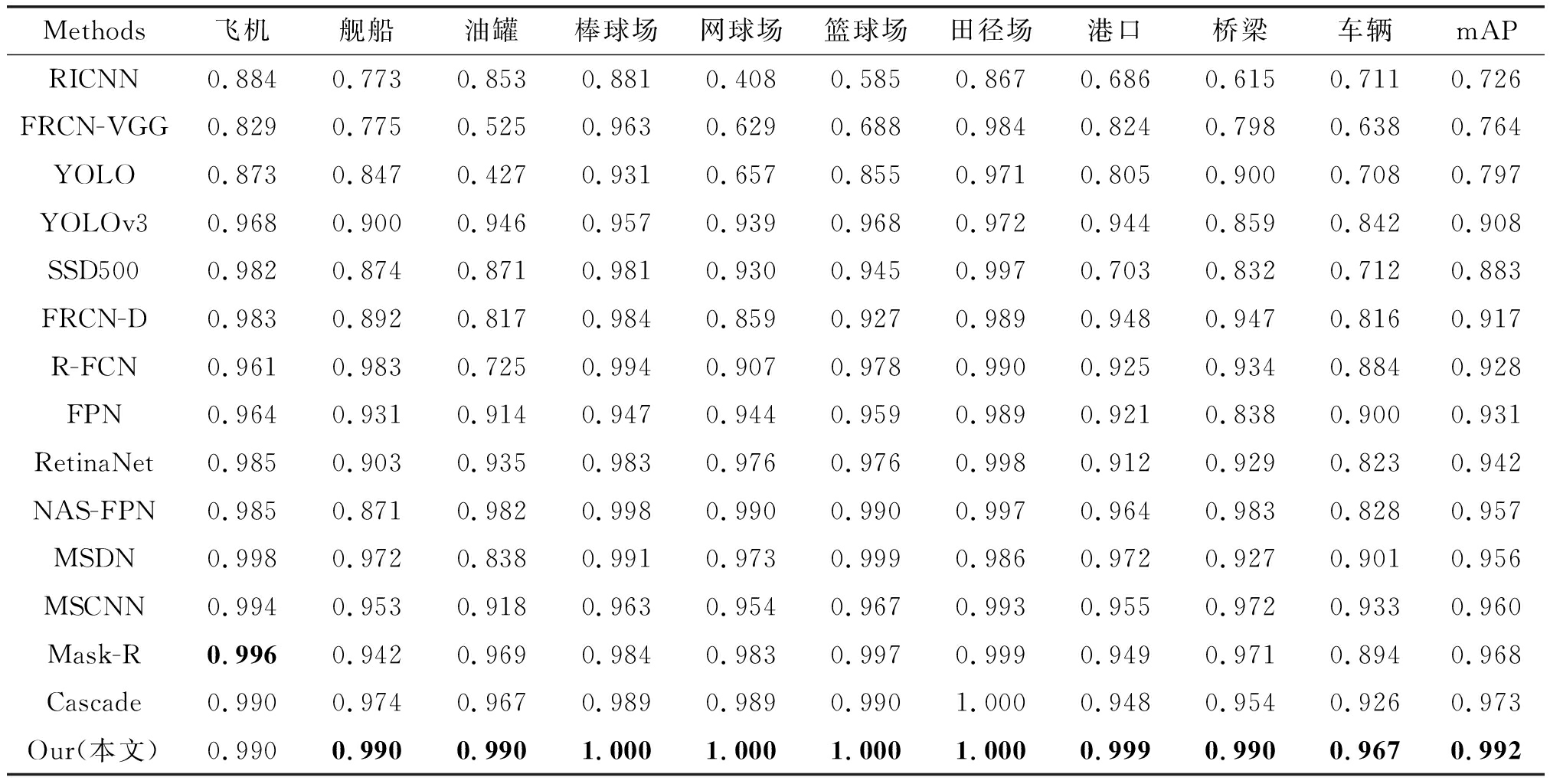

3.4 实验结果及分析

为了证明本文方法的有效性,本文对比分析了多个经典目标检测算法,不同算法的mAP统计结果如表4所示,每类目标中的最高AP用黑色粗体表示。

表4 不同算法检测性能对比

Tab.4 The performance comparison of different methods

Methods飞机舰船油罐棒球场网球场篮球场田径场港口桥梁车辆mAPRICNN0.8840.7730.8530.8810.4080.5850.8670.6860.6150.7110.726FRCN-VGG0.8290.7750.5250.9630.6290.6880.9840.8240.7980.6380.764YOLO0.8730.8470.4270.9310.6570.8550.9710.8050.9000.7080.797YOLOv30.9680.9000.9460.9570.9390.9680.9720.9440.8590.8420.908SSD5000.9820.8740.8710.9810.9300.9450.9970.7030.8320.7120.883FRCN-D0.9830.8920.8170.9840.8590.9270.9890.9480.9470.8160.917R-FCN0.9610.9830.7250.9940.9070.9780.9900.9250.9340.8840.928FPN0.9640.9310.9140.9470.9440.9590.9890.9210.8380.9000.931RetinaNet0.9850.9030.9350.9830.9760.9760.9980.9120.9290.8230.942NAS-FPN0.9850.8710.9820.9980.9900.9900.9970.9640.9830.8280.957MSDN0.9980.9720.8380.9910.9730.9990.9860.9720.9270.9010.956MSCNN0.9940.9530.9180.9630.9540.9670.9930.9550.9720.9330.960Mask-R0.9960.9420.9690.9840.9830.9970.9990.9490.9710.8940.968Cascade0.9900.9740.9670.9890.9890.9901.0000.9480.9540.9260.973Our(本文)0.9900.9900.9901.0001.0001.0001.0000.9990.9900.9670.992

由表4可知, 在NWPU VHR-10数据集上RICNN[28]算法的mAP值为72.6%, 在几类对比方法中检测精度最低,该算法没有对得到的边界框位置进行回归和优化,而是直接将提取的深度特征输入到支持向量机中进行分类,因此检测精度较低。FRCN-VGG是基于VGG[29]的Faster RCNN算法,该算法使用RPN网络预先筛选候选区域,同时对候选区域的深度特征进行分类和回归学习,使得其检测精度相对于RICNN提升了3.8%,但相对于其他算法检测精度仍是较低。YOLO[5]由于其本身算法的设计,只有一个目标分类和回归的阶段,因此会存在较多的漏检和误检,并且该方法需要对特征图进行网格划分,因此不适用于小尺度以及排列密集的目标检测任务。SSD算法相比于YOLO使用了多个层次的特征图,提高了于目标的尺度自适应性,检测精度也有所提高。与YOLO算法相比,YOLOv3[30]使用了新的网络结构darknet53,并且借鉴了残差网络的做法,加入残差通道,同时利用多个尺度的特征图进行预测,这在一定程度上改善了多尺度目标检测的效果,检测精度得到提升。

FRCN-Deform是以RseNet网络为基础网络并加入形变卷积和形变池化[25]的Faster RCNN算法, ResNet网络通过叠加残差单元来实现更深层的神经网络结构,使得网络可以学得更高质量的特征,并且在形变卷积和形变池化的加持下,网络可以根据目标的形状自动调整感受野,因此其检测精度达到91.7%。R-FCN[2]算法设计了位置敏感得分映射来对目标空间位置信息进行建模,同时将全部池化层和全连接层替换为卷积层,实现了所有卷积层的计算共享,避免了重复计算,进一步提高了检测精度和速度。FPN是在以ResNet为骨干网络的Faster RCNN中设计了特征金字塔网络,通过逐次融合多个层次的特征图将不同尺度的特征信息融合在一起,然后进行多尺度训练和检测,使得检测精度达到93.1%,后续很多算法都借鉴了这种特征融合结构。RetinaNet[7]网络在单阶段算法中使用特征金字塔结构,同时在训练中引入了Focal loss来调整不同样本所分配的权重,若为易分类样本,则减小其所对应的权重,若为难分类样本则提高其所对应的权重,通过动态的权重调整来解决正负样本不平衡的问题,在这种策略下该算法检测精度提升到94.2%。NAS-FPN[31]以RetinaNet算法为基础,在一个覆盖所有跨尺度连接的可扩展搜索空间中,使用神经网络搜索找到一种性能最好的特征金字塔结构,与FPN相比,检测精度提升了2.6%。MSDN[32]和MSCNN[33]算法则是分别在算法中的特征提取部分使用了形变卷积和空洞卷积,并且使用多层特征图进行分类回归,有效改善了不同尺度目标的检测效果。Mask-RCNN则是在以ResNet为骨干网络的Faster RCNN中原本的两个分支(分类+回归)上增加了第三个支路用于语义分割,同时将损失函数改变为分类损失、回归损失和掩膜损失三者之和,利用掩膜分支来为目标检测提供辅助信息,其检测精度相比于NAS-FPN提高了1.1%。Cascade-RCNN算法则是利用迭代的思想级联了几个检测网络,不断提高子检测网络的IoU阈值,从而达到不断优化预测结果的目的,在本文实验中该算法的检测精度达到97.3%,是对比算法中最优检测算法。相比于上述对比算法,本文所提算法取得了最高检测精度99.2%,针对舰船目标比次优算法检测精度高出1.6%,对油罐目标比次优算法检测精度高出2.3%,对于棒球场、网球场、篮球场以及田径场网球场目标则是全部都被检测到,检测精度达到百分百。对于港口目标比次优算法检测精度高出5.1%,对于桥梁目标比次优算法检测精度高出3.6%,对于车辆目标比次优算法检测精度高出4.1%。对比可知,飞机、油罐、棒球场、田径场等几类目标在所列出的对比算法中的检测精度差别不大,这是因为在飞机和油罐等目标的边界框形状比较规则,并且棒球场和田径场的尺度相对较大,语义信息相对丰富,因此检测效果相近。而对于舰船、港口、桥梁和车辆等几类目标检测效果相差较大,本文算法在这几类目标的检测效果均为最优,因为舰船和车辆等目标尺度较小,经过若干次的卷积操作之后,损失了部分特征信息,而本文所提算法中的特征增强模块可以有效的解决小尺度目标检测效果较差的问题。对于网球场、棒球场、港口和桥梁等目标,则是由于其长宽比差异较大,针对这种情况,预先寻找到更为合适的候选区域对后续的分类回归影响极大,而本文中的锚点自动生成模块可以有效的缓解这个问题。图5分别展示了本文所提算法以及几种对比算法的检测结果示例。从图中也可以看出。几种对比算法中不乏存在漏检、错误检测以及重叠的情况存在。对比之下,本文算法针对多类多尺度目标的检测效果更胜一筹。

图5 对比算法检测结果示例

Fig.5 Detection results with different methods

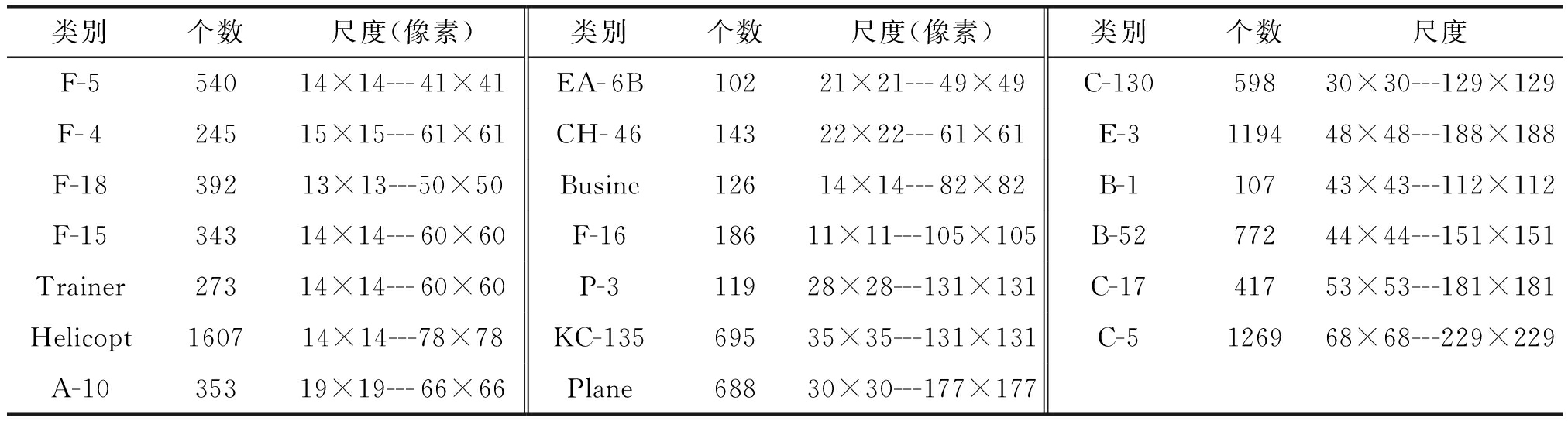

3.5 扩展实验

为了进一步验证本文所提算法的有效性,搜集制作了光学遥感飞机目标检测数据集。首先从网上搜集美国、日本、俄罗斯以及欧洲多个国家的主要飞机类型以及相关参数信息,并找到相应类别飞机常驻地的地理坐标,利用这些坐标从谷歌地球上下载相应地点的光学遥感数据,图像分辨率为0.6 m,共计下载约833幅大场景遥感图像,均包含一个完整的机场。最后综合各方面的信息,确定无误之后在大图上进行人工标注。此时数据集中飞机目标相关信息如表5所示。标注完成后对原始图像进行如3.1节所述的裁剪和旋转,最后从扩充数据集中随机抽取60%作为训练集,其余作为测试集。实验中初始学习率设置为0.0025,动量设置为0.9,正则化系数设置为0.0005,批量处理大小为2。

表5 飞机目标数据集中的目标相关信息

Tab.5 The influence of different modules on detection performance

类别个数尺度(像素)类别个数尺度(像素)类别个数尺度F-554014×14---41×41EA-6B10221×21---49×49C-13059830×30---129×129F-424515×15---61×61CH-4614322×22---61×61E-3119448×48---188×188F-1839213×13---50×50Busine12614×14---82×82B-1 10743×43---112×112F-1534314×14---60×60F-1618611×11---105×105B-5277244×44---151×151Trainer27314×14---60×60P-311928×28---131×131C-1741753×53---181×181Helicopt160714×14---78×78KC-13569535×35---131×131C-5 126968×68---229×229A-1035319×19---66×66Plane68830×30---177×177

从表5可以看出所制作的飞机数据集所含目标种类较多,且同类目标以及不同类目标之间都有着较大的尺寸差异,符合包含多类多尺度目标的条件,经过数据扩充数据量训练样本为15788,测试样本数量为9738,可以满足神经网络对数据集规模的要求。

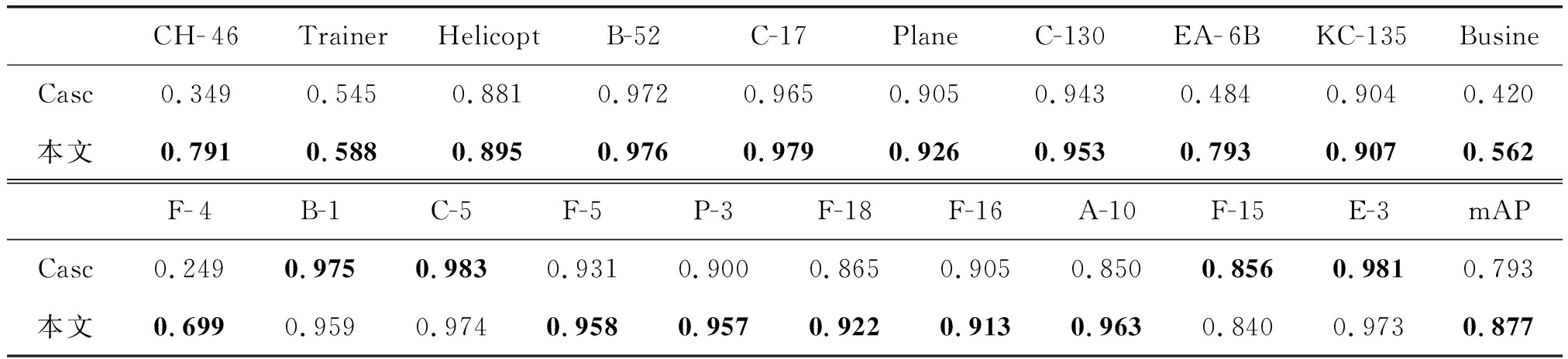

由众多文献以及前面的实验可知已知Cascade-RCNN算法为对比算法中性能最优的算法,因此本节扩展实验仅使用Cascade-RCNN (表格中简称为Casc)算法以及本章所提算法在飞机数据集上进行对比实验,并对两者的性能进行对比分析,实验结果如表6所示。

表6 两类算法针对飞机目标数据集的检测精度

Tab.6 The influence of different modules on detection performance

CH-46TrainerHelicoptB-52C-17PlaneC-130EA-6BKC-135BusineCasc0.3490.5450.8810.9720.9650.9050.9430.4840.9040.420本文0.7910.5880.8950.9760.9790.9260.9530.7930.9070.562F-4 B-1 C-5F-5P-3F-18F-16A-10F-15E-3mAPCasc0.2490.9750.9830.9310.9000.8650.9050.8500.8560.9810.793本文0.6990.9590.9740.9580.9570.9220.9130.9630.8400.9730.877

对比可知在飞机数据集上本文所提方法性能依然优于Cascade-RCNN算法,与之相比,本文所提方法的mAP提高了8.4%,且在20类目标中有16类目标的平均检测精度最优。从表格6中可知,对于B-1、C-5、F-15和E-3四类目标,Cascade-RCNN的检测效果优于本文所提算法,在遥感图像中,F-15外形以及尺寸和F-16极其相似,肉眼分辨都具有一定难度。并且经常会为这些飞机目标涂上伪装颜色使其与周围的环境融为一体,增加了分类的难度,因此存在漏检和误检情况,检测效果较差一些,同时这也对该遥感领域目标检测技术提出了更高的要求。对于较小尺度的飞机目标如F- 4、EA- 6B、CH- 46等目标,本文所提算法的检测精度得到了大幅度的提升,其AP值分别提高了45%、30.9%、44.2%,这三类目标在数据集中属于尺度较小的目标,除此之外还有Trainer、A-10以及F-5等小尺度飞机目标的检测精度也分别有不同程度的提升,由此可知本文所提算法对小尺度目标的检测效果非常好,印证了本文的特征增强策略可以弥补网络多次卷积和下采样所带来的小尺度目标信息丢失,有效的增强小尺度目标特征信息,提高小尺度目标的检测效果。本文所提算法对于如F-16、P-3、Plane以及Busine等中等尺度的飞机目标的检测性能也比较优异,这些目标的尺度相对较大,可辨识的深层抽象语义特征也比较丰富,因此对于中等尺度飞机目标的分类和定位也比较准确,分别比Cascade-RCNN算法的AP值提升了0.8%、5.7%、1.9%和14.2%。不难看出本文所提方法针对飞机数据集中的绝大部分目标都比较友好,充分证明了本文所提方法在多类多尺度目标检测任务中的优势。图6展示了部分本文所提算法在飞机数据集上的检测结果示例。

图6 本文所提算法在飞机数据集上部分检测结果

Fig.6 Number of object detection results on aircraft dataset of the algorithm proposed

4 结论

针对遥感图像中不同尺度目标检测算法精度有待提高的问题,本文设计了一种基于特征增强和锚点自动生成模块的多类多尺度目标检测框架。该框架以ResNet50为基础网络,并在ResNet50中引入可操控的空洞卷积模块来调整卷积感受野大小,有效提取不同尺度的目标特征信息。在特征融合网络部分设计了增强特征金字塔,构造短接支路将原始特征图信息与金字塔特征图融合,实现特征增强,有效提高网络对多尺度信息的表征能力。在候选区域生成网络中利用锚点自动生成模块学习更加准确的锚点框信息,生成更高质量的稀疏的锚点框。综上几点分析以及在多个数据集上的实验证明,本文所提方法对于多类多尺度目标的特征提取效果更加友好,能够更加准确的检测遥感图像多尺度目标。

[1] REN Shaoqing, HE Kaiming, GIRSHICK R, et al. Faster R-CNN: Towards real-time object detection with region proposal networks[C]∥IEEE Transactions on Pattern Analysis and Machine Intelligence. United States, IEEE, 2017, 39(6): 1137-1149.

[2] DAI Jifeng, LI Yi, HE Kaiming, et al. R-FCN: Object detection via region-based fully convolutional networks[EB/OL]. arXiv: 1605.06409. 2016.https:∥arxiv.org/abs/1605.06409.

[3] HE Kaiming, GKIOXARI G, DOLL R P, et al. Mask R-CNN[C]∥Proceedings of the IEEE International Conference on Computer Vision. Venice, Italy. IEEE, 2017: 2980-2988.

R P, et al. Mask R-CNN[C]∥Proceedings of the IEEE International Conference on Computer Vision. Venice, Italy. IEEE, 2017: 2980-2988.

[4] CAI Zhaowei, VASCONCELOS N. Cascade R-CNN: Delving into high quality object detection[C]∥IEEE Conference on Computer Vision and Pattern Recognition. Salt Lake City, UT, USA. IEEE, 2018: 6154- 6162.

[5] REDMON J, DIVVALA S, GIRSHICK R, et al. You only look once: Unified, real-time object detection[C]∥IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas, NV, USA. IEEE, 2016: 779-788.

[6] LIU Wei, ANGUELOV D, ERHAN D, et al. SSD: Single shot MultiBox detector[M]∥Proceedings of the European Conference on Computer Vision. Cham, Springer International Publishing, 2016: 21-37.

[7] LIN T Y, GOYAL P, GIRSHICK R, et al. Focal loss for dense object detection[C]∥IEEE International Conference on Computer Vision (ICCV). Venice, Italy. IEEE, 2017: 2999-3007.

[8] LAW H, DENG Jia. CornerNet: Detecting objects as paired keypoints[J]. International Journal of Computer Vision, 2020, 128(3): 642- 656.

[9] 王慧玲, 綦小龙, 武港山. 基于深度卷积神经网络的目标检测技术的研究进展[J].计算机科学, 2018, 45(9): 11-19.

WANG Huiling, QI Xiaolong, WU Gangshan. Research progress of object detection technology based on convolutional neural network in deep learning[J]. Computer Science, 2018, 45(9): 11-19.(in Chinese)

[10] CHENG Gong, HAN Junwei, ZHOU Peicheng, et al. Learning rotation-invariant and fisher discriminative convolutional neural networks for object detection[J]. IEEE Transactions on Image Processing, 2018, 28: 265-278.

[11] LONG Yang, GONG Yiping, XIAO Zhifeng, et al. Accurate object localization in remote sensing images based on convolutional neural networks[J]. IEEE Transactions on Geoscience and Remote Sensing, 2017, 55(5): 2486-2498.

[12] LI Ke, CHENG Gong, BU Shuhui, et al. Rotation-insensitive and context-augmented object detection in remote sensing images[J]. IEEE Transactions on Geoscience and Remote Sensing, 2018, 56(4): 2337-2348.

[13] ZHONG Yanfei, HAN Xiaobing, ZHANG Liangpei. Multi-class geospatial object detection based on a position-sensitive balancing framework for high spatial resolution remote sensing imagery[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2018, 138: 281-294.

[14] HE Kaiming, ZHANG Xiangyu, REN Shaoqing, et al. Deep residual learning for image recognition[C]∥IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas, NV, USA. IEEE, 2016: 770-778.

[15] SHELHAMER E, LONG J, DARRELL T. Fully convolutional networks for semantic segmentation[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(4):640- 651.

[16] XU Zhaozhuo, XU Xin, WANG Lei, et al. Deformable ConvNet with aspect ratio constrained NMS for object detection in remote sensing imagery[J]. Remote Sensing, 2017, 9(12): 1312.

[17] TANG Tianyu, ZHOU Shilin, DENG Zhipeng, et al. Arbitrary-oriented vehicle detection in aerial imagery with single convolutional neural networks[J]. Remote Sensing, 2017, 9(11):1170.

[18] LIU Lei, PAN Zongxu, LEI Bin. Learning a rotation invariant detector with rotatable bounding box[EB/OL]. arXiv preprint arXiv:1711.09405, 2017.https:∥arxiv.org/abs/1711.09405.

[19] LIU Wenchao, MA Long, CHEN He. Arbitrary-oriented ship detection framework in optical remote-sensing images[J]. IEEE Geoscience and Remote Sensing Letters, 2018, 15(6): 937-941.

[20] QIAO Siyuan, CHEN L C, YUILLE A. DetectoRS: detecting objects with recursive feature pyramid and switchable atrous convolution[EB/OL]. arXiv preprint arXiv:2006.02334, 2020.https:∥arxiv.org/abs/2006.02334.

[21] WANG Jiaqi, CHEN Kai, YANG Shuo, et al. Region proposal by guided anchoring[C]∥IEEE Conference on Computer Vision and Pattern Recognition. Long Beach, CA, USA. IEEE, 2019: 2960-2969.

[22] LI Yanghao, CHEN Yuntao, WANG Naiyan, et al. Scale-aware trident networks for object detection[C]∥IEEE/CVF International Conference on Computer Vision. Seoul, Korea (South). IEEE, 2019: 6053- 6062.

[23] LIN T Y, DOLL R P, GIRSHICK R, et al. Feature pyramid networks for object detection[C]∥IEEE Conference on Computer Vision and Pattern Recognition. Honolulu, HI, USA. IEEE, 2017: 936-944.

R P, GIRSHICK R, et al. Feature pyramid networks for object detection[C]∥IEEE Conference on Computer Vision and Pattern Recognition. Honolulu, HI, USA. IEEE, 2017: 936-944.

[24] 尚欣茹,温尧乐,奚雪峰,等.孪生导向锚框RPN网络实时目标跟踪[J].中国图象图形学报,2021,26(2):415-424.

SHANG Xinru,WEN Yaole,XI Xuefeng,et al. Target tracking system based on the Siamese guided anchor region proposal network[J]. Journal of Image and Graphics, 2021,26(2):415-424.(in Chinese)

[25] DAI Jifeng, QI Haozhi, XIONG Yuwen, et al. Deformable convolutional networks[C]∥IEEE International Conference on Computer Vision. Venice, Italy. IEEE, 2017: 764-773.

[26] TYCHSEN-SMITH L, PETERSSON L. Improving object localization with fitness NMS and bounded IoU loss[C]∥IEEE Conference on Computer Vision and Pattern Recognition. Salt Lake City, UT, USA. IEEE, 2018: 6877- 6885.

[27] GIRSHICK R. Fast R-CNN[C]∥IEEE International Conference on Computer Vision. Santiago, Chile. IEEE, 2015: 1440-1448.

[28] CHENG Gong, ZHOU Peicheng, HAN Junwei. Learning rotation-invariant convolutional neural networks for object detection in VHR optical remote sensing images[J]. IEEE Transactions on Geoscience and Remote Sensing, 2016, 54(12):7405-7415.

[29] SIMONYAN K, ZISSERMAN A. Very deep convolutional networks for large-scale image recognition[J]. arXiv preprint arXiv:1409.1556, 2014.

[30] REDMON J, FARHADI A. YOLOv3: an incremental improvement[EB/OL]. arXiv preprint arXiv:1804.02767, 2018.https:∥arxiv.org/abs/1804.02767.

[31] GHIASI G, LIN T Y, LE Q V. NAS-FPN: Learning scalable feature pyramid architecture for object detection[C]∥IEEE Conference on Computer Vision and Pattern Recognition. Long Beach, CA, USA. IEEE, 2019: 7029-7038.

[32] 邓志鹏, 孙浩, 雷琳, 等. 基于多尺度形变特征卷积网络的高分辨率遥感影像目标检测[J].测绘学报, 2018, 47(9): 1216-1227.

DENG Zhipeng, SUN Hao, LEI Lin, et al. Object detection in remote sensing imagery with multi-scale deformable convolutional networks[J]. Acta Geodaetica et Cartographica Sinica, 2018, 47(9): 1216-1227.(in Chinese)

[33] 姚群力, 胡显, 雷宏. 基于多尺度卷积神经网络的遥感目标检测研究[J]. 光学学报, 2019, 39(11):1128002.

YAO Qunli, HU Xian, LEI Hong. Object detection in remote sensing images using multiscale convolutional neural networks[J]. Acta Optica Sinica, 2019, 39(11): 1128002.(in Chinese)