1 引言

H.266是由ITU-T(国际电信联合会)VCEG(Video Code Expert Group)和ISO(国际标准化组织)MPEG(Motion Picture Expert Group)联合视频编码专家组JVET(Joint Video Exploration Team)制定的新一代视频编码标准。该标准于2017年10月开始征求意见书,直至2020年7月完成标准的制定。相比于之前的视频编码标准H.265,H.266更能有效编码高分辨率视频,包括HD/UHD/8K分辨率视频、HDR/WCG视频、10bit视频等。

H.266沿用之前视频编码标准所采用的基于块结构的混合编码框架,融合了帧内和帧间预测、变化编码和熵编码等模块,但为了获得更加有效的压缩增益,采用了大量的新技术。这些技术包括混合叉树分割[1]、解码端运动矢量修正、亮度色度的独立分割、新的帧内帧间预测工具等[1]。

帧内预测编码是H.266的关键模块,其帧内预测模式从H.265的35种扩展到了67种,目的是为了更加准确的预测,但也带来了计算复杂度的提升。

具体而言,H.266帧内预测过程采取了两步粗糙模式决策(Rough Mode Decision,RMD)。第一阶段,对DC、Planar、以及33种角度方向模式(2, 4,..., 66)进行Hadmard代价[2]计算,选出成本较低的N种模式。第二阶段,对所选出的N种模式的直接相邻模式进行进一步代价计算,更新候选列表。虽然这样的方法确实减少了需要进行计算的模式数,但仍然需要计算37~41种模式[2]。而在第二阶段后,要将前面所选择的模式和MPM(Most Probable Mode)构建的候选模式一起执行率失真优化RDO(Rate Distortion Optimization)比较过程,这也是非常耗时的。为了进一步降低计算复杂度,需要采取更有效的模式选择方法。

一般来说,视频编码中减少帧内预测模式计算复杂度的方法可以分为两类:一是减少需要进行代价计算的模式数量,二是采用更好的预测模式方法。在对H.265快速编码的研究中,文献[2-5]减少了需要进行RMD的模式数,文献[6-10]采用了更好的预测模式方法来降低编码复杂度。目前,针对H.266编码优化的文献较少,其更加多样的编码模式使得不能对原有适应于H.265的方法直接进行改进。文献[11]提出了一种基于梯度下降的预测模式方法,该算法利用MPM中的模式作为起点,利用双向搜索的梯度下降方法,选出两个方向中代价最小的模式,再取两者中的最优模式作为新的起点,计算其半径为2的所有模式代价,选出其中的最优模式,最后和DC、Planar进行RDO过程。文献[12]利用相邻块的最优模式与粗略模式决策(RMD)过程中选择的模式之间的相关性,来减少需要进行代价计算的模式数。以上两种H.266快速算法均基于H.266的早期平台VTM-2.0。然而,最新的H.266标准增加了MIP(Matrix weighted Intra Prediction,矩阵加权预测)、ISP(Intra Sub-Partitions,帧内子块划分技术)、MRL(Multiple reference line,多参考行帧内预测技术)等技术以提高编码性能,而计算复杂度又大幅增加。因此,我们对最新的H.266标准展开研究,主要针对帧内预测模式的快速判断。

考虑到最佳预测方向和CU块中像素值变化最小方向(下称纹理方向)高度相关,本文提出了一种基于结构张量的快速纹理方向判断方法,用以减少需要进行代价计算的模式数量,在保证图像质量和比特率变化不大的情况下,降低帧内预测的计算复杂度,加快编码速度。

本文其他章节安排如下:第2节介绍H.266帧内预测编码技术。第3节是本文提出的基于结构张量的H.266帧内预测快速算法。实验结果在第4节中分析讨论,第5节给出结论。

2 H.266帧内预测编码技术

2.1 帧内预测技术

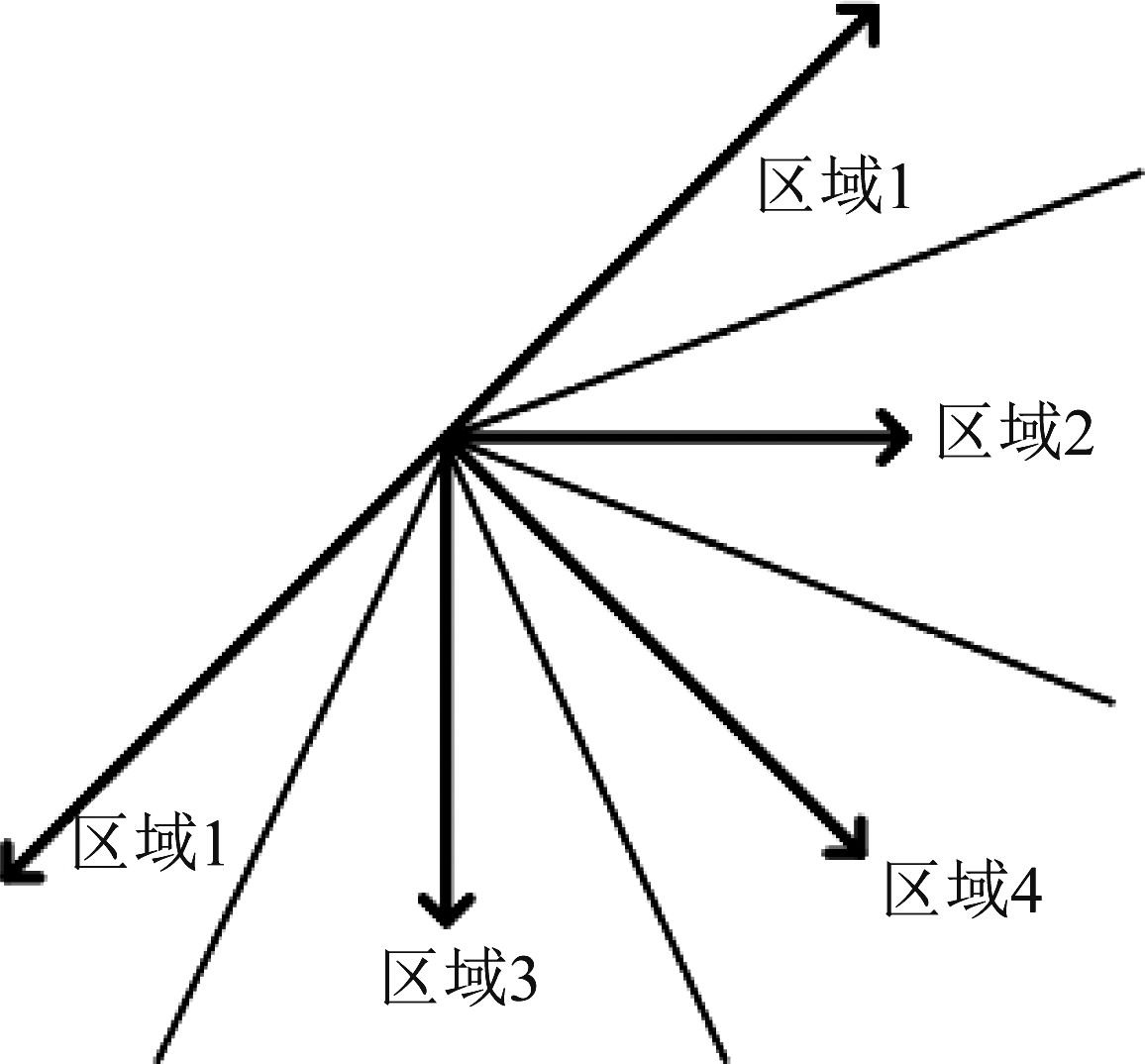

为进一步提高编码效率,H.266采取了众多帧内预测的新技术。为了提高预测的准确度,预测模式从原本的35种扩展到67种,如图1所示。为了加快编码速度,提出了矩阵加权预测(Matrix weighted Intra Prediction, MIP)[13]技术,又称仿射线性帧内预测。考虑到图像中距离越近的像素相关性也越强,重建像素离预测像素越近,预测将更准确,于是提出了帧内子块划分技术(Intra Sub-Partitions,ISP)[14]。为了进一步提高预测精度,提出了多参考行帧内预测技术(Multiple reference line,MRL)[15],在H.265中只允许使用参考行0来计算当前块的预测值,在MRL技术中,将可以额外使用参考行1和参考行3进行帧内预测。这些新技术的引入,提高了编码效率的同时增加了计算复杂度。

图1 H.266 帧内预测模式

Fig.1 H.266 intra prediction mode

2.2 帧内预测模式选择算法

H.266采用Hadmard代价函数选出代价较小的几种模式来进行最后的RDO,选出最优的模式,对于一个CU块进行帧内预测的具体过程如下:

1)对35种非扩展的传统亮度帧内角度预测模式进行代价计算,选出代价较小的N种模式建立候选列表。

2)对N种模式的直接相邻模式进行进一步的代价计算,依据代价大小,更新候选列表。

3)遍历MRL中的扩展行模式进行代价计算,依据代价大小,更新候选列表。

4)对MIP的模式进行代价计算和筛选,将最优模式加入候选列表。

5)遍历 MPM 的前几种可能模式,判断是否在候选列表中,如果没在,则加入候选列表。

6)判断是否进行 ISP 模式,如果是,则进行 ISP 的RDO过程,如果没有则进行传统的RDO。

H.266需要遍历至少37~41种的角度模式,使得计算复杂度大大增加。考虑到最佳预测模式与纹理方向高度相关,可以对当前块的纹理方向进行判断,从而减少不必要的候选模式及其代价函数的计算。因此,我们采用了广泛应用于边缘检测的结构张量方法,快速、有效地计算出当前块的块内平均亮度最小变化方向,从而判断最佳预测方向,减少候选的预测模式。

3 基于结构张量的H.266帧内预测快速算法

3.1 局部结构张量的奇异值分解与纹理方向性分析

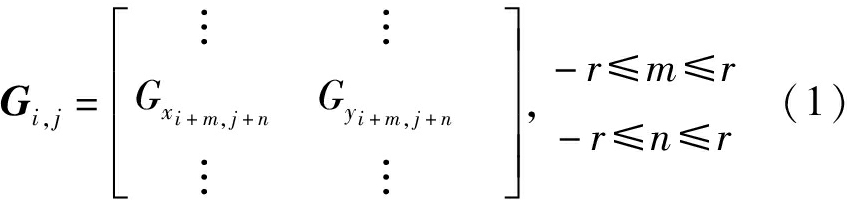

结构张量是从函数的梯度推导出的矩阵。对于给定一幅图像I,图像中的某个像素记为Pi, j,Gxi和Gyj分别是其在x和y方向上的梯度。当邻域窗口为r,权值和为1的时候,局部窗口的尺寸为(2r+1)×(2r+1),则这点的局部梯度向量Gi, j定义为[16]:

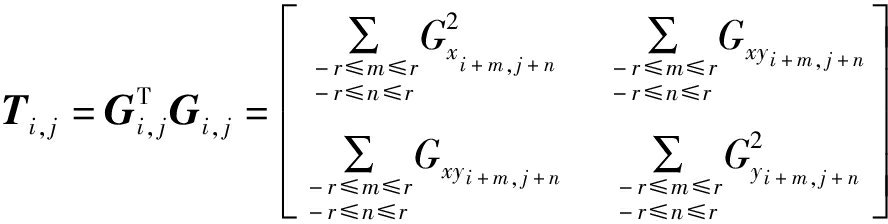

当前像素点的局部结构张量是一个2×2的结构矩阵T(也称为局部梯度协方差矩阵),表示如下[16]:

(2)

其中,

Gxy=Gx×Gy

当窗口尺寸r=0时:

(3)

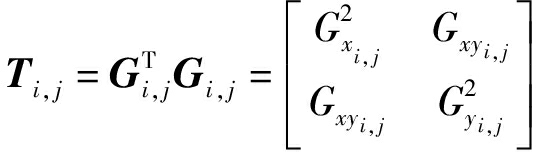

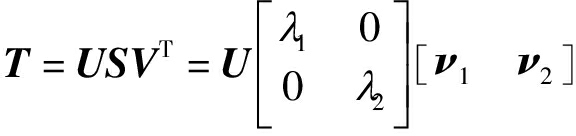

将结构矩阵T进行协方差矩阵奇异值分解(Singular Value Decomposition, SVD),可以得到[16]:

(4)

其中,U和V是正交矩阵,S为奇异值矩阵,λ1和λ2是两个特征值,λ1≥λ2≥0,ν1和ν2是特征值对应的特征向量,ν1为局部结构张量的主方向,ν2为局部结构张量的次方向。如果λ1>λ2,则局部窗口内的渐变方向与ν1或者-ν1是一致的。如果λ1=λ2时,局部窗口的内容没有明显方向,特别当λ1=λ2=0时,局部窗内的像素值都一样。这样,我们可以通过局部结构张量的奇异值分解来判断当前区域是否平坦,若有纹理方向,则可以通过求解主方向特征向量ν1与水平方向的夹角角度来获取当前区域的纹理方向。

3.2 依据纹理方向的预测模式分类

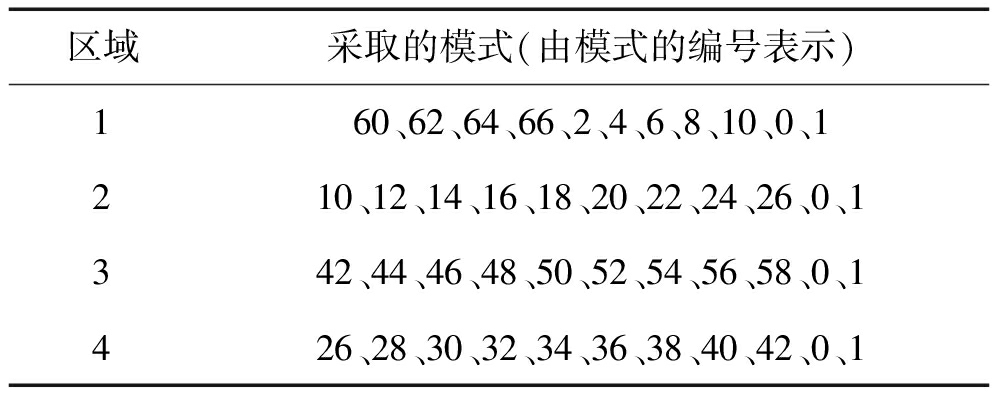

当CU块有明显纹理方向的时候,通常可以根据其纹理方向来确定最优模式的范围。因此我们依据四个角度45°,0°,-45°,-90°,将平面分为四个区域,如图2所示。针对不同区域,选取对应的候选模式,跳过其他模式的遍历,减少模式选择的计算复杂度。另外,我们将不同区域所对应的候选模式进行分类,如表1所示。

图2 平面四个区域

Fig.2 Four areas in the plane

表1 不同区域选择的模式

Tab.1 Modes selected by different regions

区域采取的模式(由模式的编号表示)160、62、64、66、2、4、6、8、10、0、1210、12、14、16、18、20、22、24、26、0、1342、44、46、48、50、52、54、56、58、0、1426、28、30、32、34、36、38、40、42、0、1

3.3 帧内预测MPM模式监督

在图像和视频编码中,相邻块通常具有较强的相关性,因此相邻块的帧内预测模式相同或者相似的概率较大。MPM就是基于左相邻CU和上相邻CU的帧内预测模式构成,可以充分利用相邻块模式信息之间的相关性对当前CU的帧内预测模式进行快速选择。

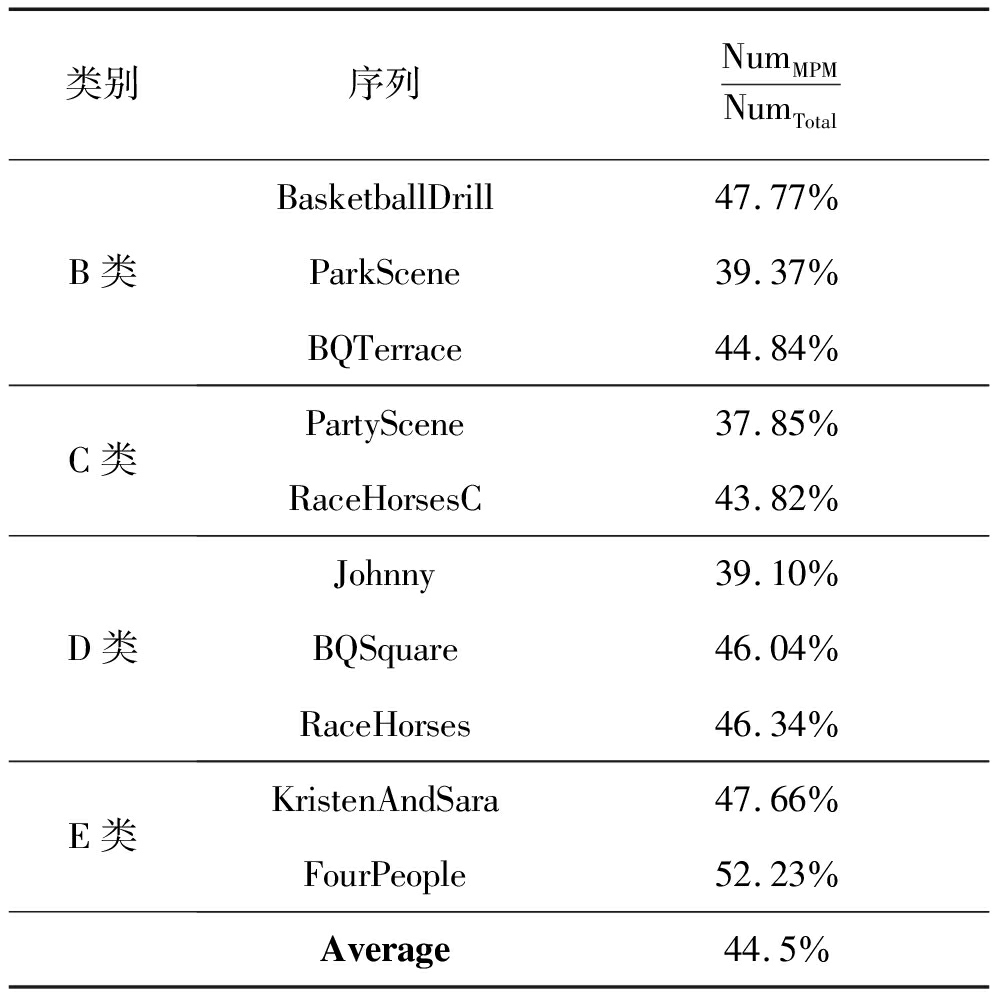

为了分析当前CU所选择的最优模式在MPM列表中占全部可能模式的比例,我们对各种类别的序列进行统计,最优模式在MPM列表中占比由![]() 表示,统计结果列在表2。由表2可知,44.5%的块在进行帧内预测后,选择的最优模式是在MPM列表中。因此可以用MPM列表中的模式对于前面选出的模式进行监督,减少扩展角度模式的代价计算:如果模式在MPM列表中,则进行扩展角度模式的代价计算,如果不在MPM列表中,则不进行扩展角度模式的代价计算。

表示,统计结果列在表2。由表2可知,44.5%的块在进行帧内预测后,选择的最优模式是在MPM列表中。因此可以用MPM列表中的模式对于前面选出的模式进行监督,减少扩展角度模式的代价计算:如果模式在MPM列表中,则进行扩展角度模式的代价计算,如果不在MPM列表中,则不进行扩展角度模式的代价计算。

表2 当前CU最优模式在MPM列表中的命中率统计

Tab.2 The hit rate statistics of the current CU optimal mode in the MPM list

类别序列NumMPMNumTotalB类BasketballDrill47.77%ParkScene39.37%BQTerrace44.84%C类PartyScene37.85%RaceHorsesC43.82%D类Johnny39.10%BQSquare46.04%RaceHorses46.34%E类KristenAndSara47.66%FourPeople52.23%Average44.5%

3.4 基于结构张量的帧内快速模式选择算法

因H.266的两步快速RMD技术仍然需要进行37~41种模式的RDO计算,我们通过结构张量和MPM模式监督来减少帧内预测的模式数。

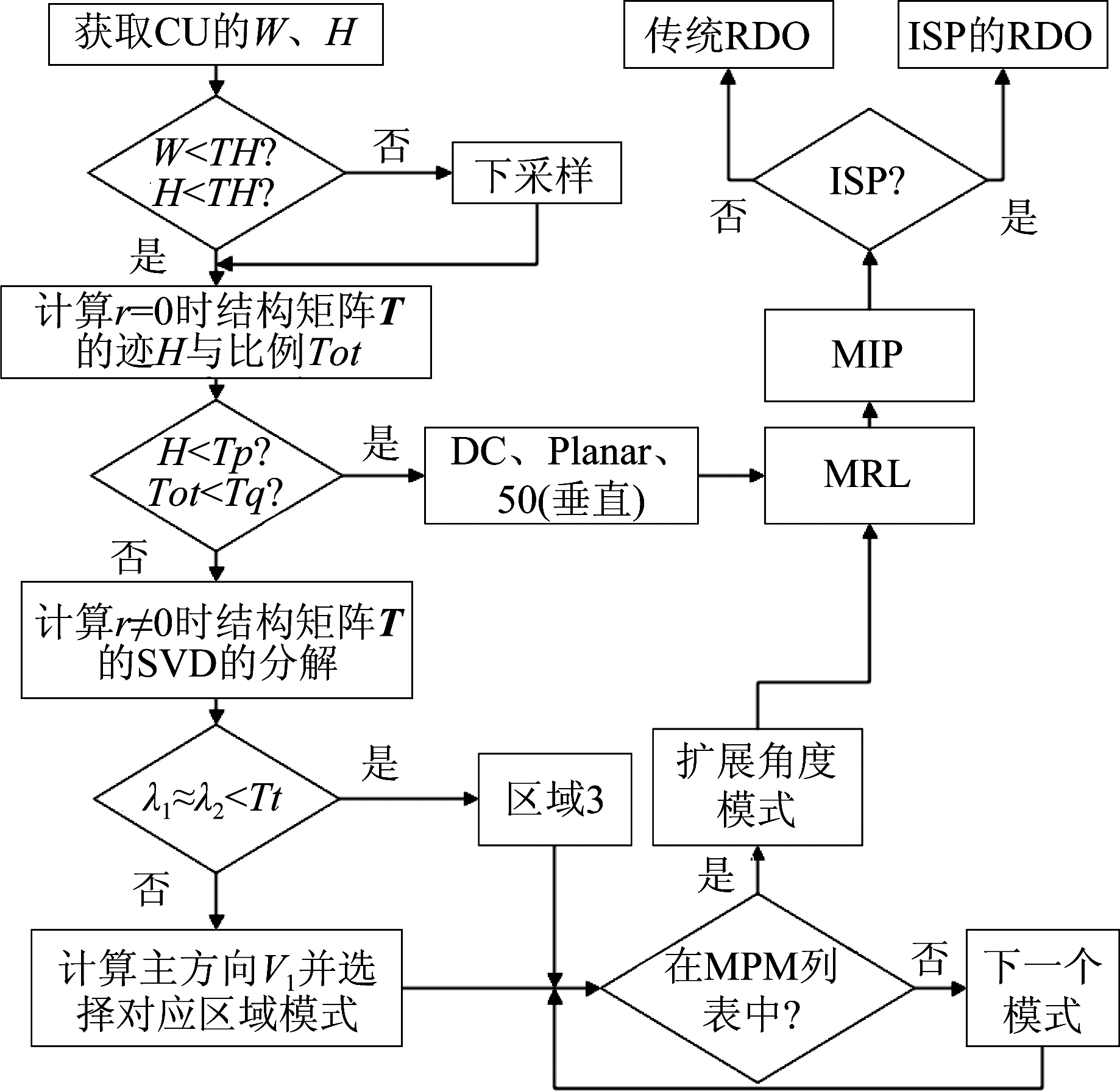

算法如图3所示,具体步骤描述如下:

图3 算法流程图

Fig.3 Algorithm flow chart

1)帧内预测开始,为了减少计算时间,需要进行对当前CU进下采样。首先获取当前CU块的宽W和高H,如果W<TH并且H<TH,则不进行下采样,否则需要对应进行下采样,从而降低计算复杂度,其中TH为阈值,设定为64。

2)计算当前编码块CU窗口尺寸为0的结构矩阵T,计算结构矩阵T的迹H,并统计满足H<Tp的像素块比例Tot。如果Tot<Tq,则认为该CU块为平坦区域,并跳过扩展角度模式,直接进入到步骤5)。其中Tp、Tq为用来区分平坦区域和有纹理方向区域的阈值,分别设定为65、0.49。

3)如果不满足Tot<Tq,则求取窗口尺寸为r(r≠0)的结构矩阵T,并对结构矩阵T进行SVD分解,获取特征值λ1、λ2以及对应的特征向量ν1和ν2。将特征值λ1、λ2与预设的阈值Tt进行比较,如果λ1≈λ2<Tt,则选择区域3,否则计算其主方向ν1,并选择对应区域的模式。

4)用MPM列表中的模式对于前面选出的模式进行监督,如果模式在MPM列表中,则认为被选中的概率比较大,则需要进行扩展角度模式的代价计算,如果不在MPM列表中,则认为被选中的概率不大,不进行扩展角度模式的代价计算。

5)依次进行MRL、MIP的模式选择和代价计算,并更新候选模式列表,最后判断是否进行ISP模式,如果是,则进行ISP的RDO过程,如果没有则进行传统的RDO。

4 实验结果及分析

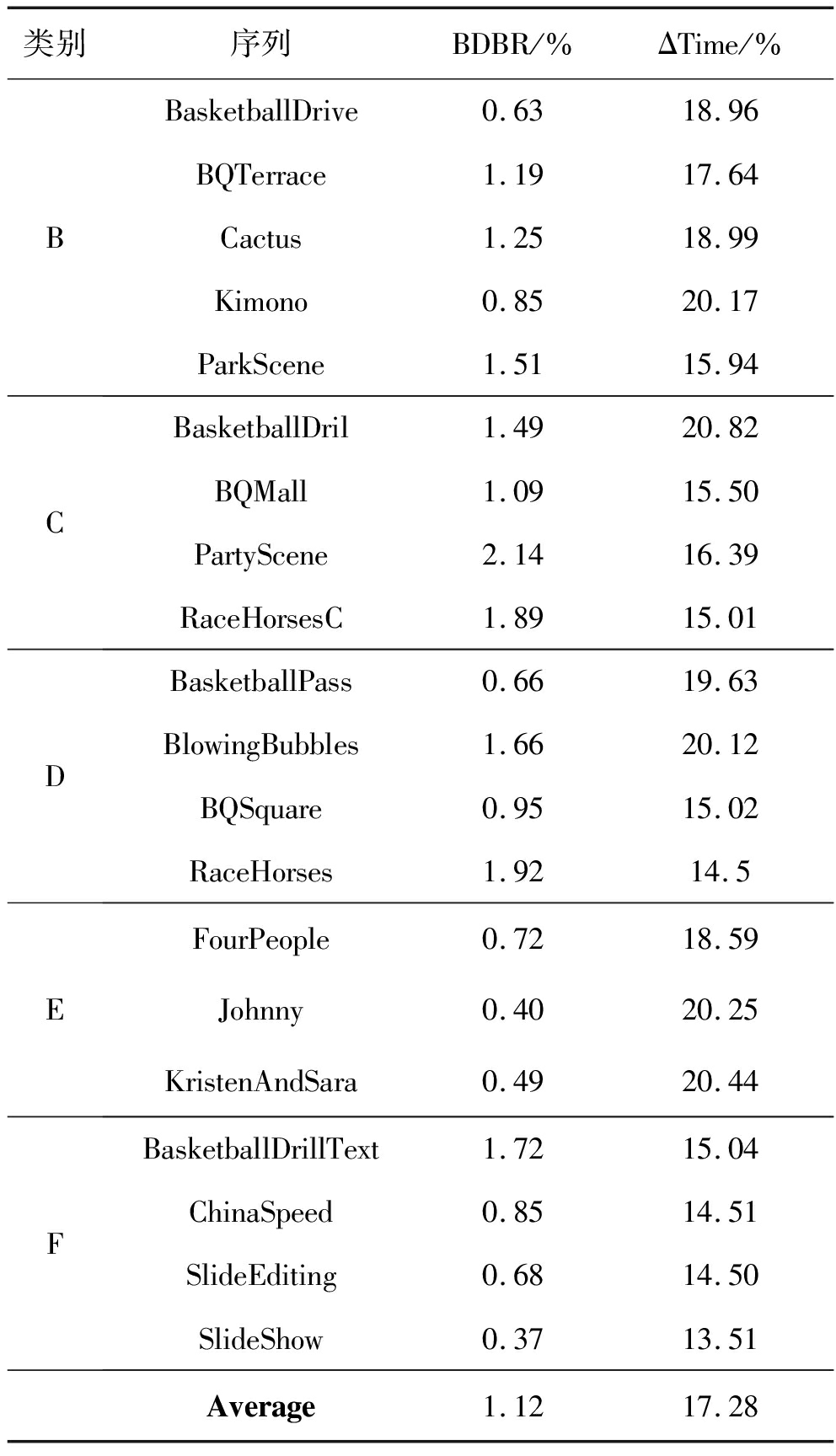

为了验证本文算法的有效性,采用 H.266最新测试平台 VTM-7.3作为测试环境,分别对20个测试视频序列进行编码性能评估。所有视频使用全帧内模式(All Intra,AI),编码量化参数(quantification parameter,QP)设为22,27,32,37。测试序列及算法性能如表3所示。

本文使用BDBR和ΔTime评价提出的算法性能。BDBR[17]表示的是H.266标准平台VTM-7.3与本文算法之间的比特率变化的公式,ΔTime计算如下:

(5)

其中,Timeproposed和Timeanchor分别表示本文算法和H.266标准平台VTM-7.3在全帧内模式下的平均编码时间。

由表3的实验结果可以得知,本算法相比于H.266标准平台VTM-7.3,在BDBR提升1.12时,时间节省了17.28%左右。

表3 测试序列及所提算法性能

Tab.3 Test sequence and the performance of the proposed algorithm

类别序列BDBR/%ΔTime/%BBasketballDrive0.6318.96BQTerrace1.1917.64Cactus1.2518.99Kimono0.8520.17ParkScene1.5115.94CBasketballDril1.4920.82BQMall1.0915.50PartyScene2.1416.39RaceHorsesC1.8915.01DBasketballPass0.6619.63BlowingBubbles1.6620.12BQSquare0.9515.02RaceHorses1.9214.5EFourPeople0.7218.59Johnny0.4020.25KristenAndSara0.4920.44FBasketballDrillText1.7215.04ChinaSpeed0.8514.51SlideEditing0.6814.50SlideShow0.3713.51Average1.1217.28

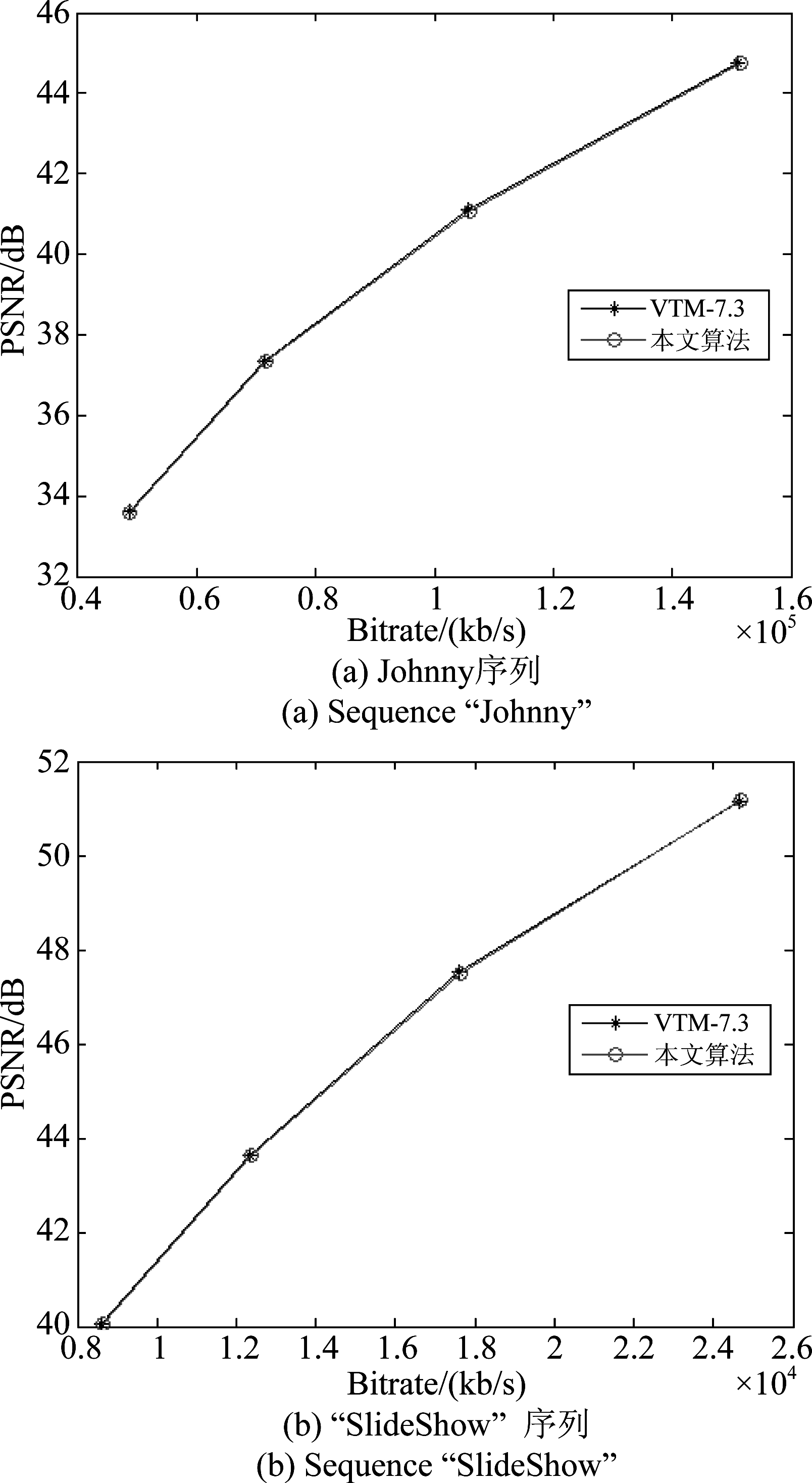

图4给出了测试序列Johnny和SlideShow的率失真曲线,将本文算法和H.266标准平台VTM-7.3进行比较。可以看出所提算法与H.266标准平台VTM-7.3相比,率失真性能基本相同,说明该算法能在保证视频质量基本不变的情况下,有效减少了计算复杂度。

图4 本文算法与H.266标准平台VTM-7.3的率失真曲线比较

Fig.4 RD curves of the proposed algorithm compared with H.266 VTM-7.3

5 结论

本文通过结构张量的奇异值分解获取局部区域中梯度的主要方向,根据方向分区,从对应的分区中获取当前CU的最可能的帧内预测模式区域,减少候选模式。在扩展角度模式的代价计算时,用MPM对扩展角度模式进行监督,跳过一些不必要的模式代价计算,进而实现计算复杂度的降低。实验结果表明, 在全帧内模式下,该算法相较H.266标准平台VTM7.3可平均节省17.28%的编码时间,BDBR仅增加 1.12%,有效地实现了H.266的帧内快速模式选择。

[1] AN Jicheng, HUANG Han, ZHANG Kai, et al.Quadtree plus binary tree structure integration with JEM tools.Document JVET-B0023, Feb.2016.

[2] LIU Xingang, LIU Yinbo, WANG Peicheng, et al.An adaptive mode decision algorithm based on video texture characteristics for HEVC intra prediction[J].IEEE Transactions on Circuits and Systems for Video Technology, 2017, 27(8): 1737-1748.

[3] DUAN Kun, LIU Pengyu, FENG Zeqi, et al.Fast PU intra mode decision in intra HEVC coding[C]∥2019 Data Compression Conference(DCC).Snowbird, UT, USA.IEEE, 2019: 570.

[4] MOTRA A S, GUPTA A, SHUKLA M, et al.Fast intra mode decision for HEVC video encoder[C]∥SoftCOM 2012, 20th International Conference on Software, Telecommunications and Computer Networks.Split, Croatia.IEEE, 2012: 1-5.

[5] 杨宇航, 蔡灿辉, 王张欣.利用纹理结构的HEVC快速帧内模式选择算法[J].信号处理, 2015, 31(9): 1094-1100.

YANG Yuhang, CAI Canhui, WANG Zhangxin.Fast mode decision for HEVC intra coding using texture information[J].Journal of Signal Processing, 2015, 31(9): 1094-1100.(in Chinese)

[6] YI Huan, QIN Huabiao.The optimization of HEVC intra prediction mode selection[C]∥2017 4th International Conference on Information Science and Control Engineering(ICISCE).Changsha, China.IEEE, 2017: 1743-1748.

[7] JAMALI M, COULOMBE S.Fast HEVC intra mode decision based on RDO cost prediction[J].IEEE Transactions on Broadcasting, 2019, 65(1): 109-122.

[8] WANG Minghai, WEI H, FANG Ying, et al.Fast mode selection algorithm for HEVC intra encoder[C]∥2018 IEEE International Conference on Automation, Electronics and Electrical Engineering(AUTEEE).Shenyang, China.IEEE, 2018: 169-172.

[9] ZHANG Mengmeng, ZHAO Chuan, XU Jizheng.An adaptive fast intra mode decision in HEVC[C]∥2012 19th IEEE International Conference on Image Processing.Orlando, FL, USA.IEEE, 2012: 221-224.

[10] JIANG Wei, MA Hanjie, CHEN Yaowu.Gradient based fast mode decision algorithm for intra prediction in HEVC[C]∥2012 2nd International Conference on Consumer Electronics, Communications and Networks(CECNet).Yichang, China.IEEE, 2012: 1836-1840.

[11] YANG Hao, SHEN Liquan, DONG Xinchao, et al.Low-complexity CTU partition structure decision and fast intra mode decision for versatile video coding[J].IEEE Transactions on Circuits and Systems for Video Technology, 2020, 30(6): 1668-1682.

[12] CHEN Yamei, YU Li, WANG Hongkui, et al.A novel fast intra mode decision for versatile video coding[J].Journal of Visual Communication and Image Representation, 2020, 71: 102849.

[13] PFAFF J, STALLENBERGER B, SCH FER M, et al.CE3: Affine linear weighted intra prediction.Document JVET-N0217, March.2019.

FER M, et al.CE3: Affine linear weighted intra prediction.Document JVET-N0217, March.2019.

[14] DE-LUX N-HERN

N-HERN NDEZ S, GEORGE S, MA J, et al.CE3: Intra Sub-Partitions Coding Mode.Document JVET M0102, Jan.2019.

NDEZ S, GEORGE S, MA J, et al.CE3: Intra Sub-Partitions Coding Mode.Document JVET M0102, Jan.2019.

[15] CHEN Jianle, YE Yan.Kim H.Algorithm description for Versatile Video Coding and Test Model 10.Document JVET-S2002-v1, July 2020.

[16] FENG Xiaoguang, MILANFAR P.Multiscale principal components analysis for image local orientation estimation[C]∥Conference Record of the Thirty-Sixth Asilomar Conference on Signals, Systems and Computers, 2002.Pacific Grove, CA, USA.IEEE, 2002: 478-482.

[17] BJONTEGAARD G.Calculation of Average PSNR differences between RD curves.Document VCEGM33, Apr.2001.