1 引言

视频行为识别是利用模式识别或深度学习等方法自动识别出视频中的行为动作,视频中的行为识别除了对空间表观信息的提取外,时间运动信息的获取成为行为识别的难点和重点所在[1]。目前,对视频行为识别算法的研究从早期的手工算法发展到深度学习算法模型,更加关注显著区域的空-时交互特征提取。

早期的视频行为识别算法依赖于手工设计编码器提取特征,传统行为识别算法中基于局部特征的改进型密集轨迹(iDT)算法[2],该方法考虑到相机的运动,通过利用前后帧的图像投影变化矩阵估计相机运动来消除背景区域的光流,使用L1正则化和Fisher Vector特征编码,在特征分类上采用SVM分类器,该模型在早期小规模数据集中的分类精度较好。但是随着种类繁多内容复杂的视频资源的爆炸式增长,传统分类模型已经不能满足高精度和应用性的现实要求。与此同时大数据时代为基于深度学习的视频行为识别模型训练提供充足资源,一些研究者着手于研究各种基于深度学习框架的视频行为识别模型。例如, Simoyan[3]提出Two-stream网络结构,将RGB图像和光流分别输入到Alexnet神经网络中,并融合从RGB帧中提取图像信息的空间流以及从密集光流中提取运动信息的时间流,将空间信息与时间运动信息结合的模型开创了利用双流卷积神经网络进行视频行为识别的时代,但是该模型解决的是短期视频分析问题,缺乏长时间视频处理能力。Wang[4]等提出TSN(Temporal Segment Networks)网络模型,模型将视频等间隔分成N段,每段进行Two-stream训练,通过结合多个短片段的类别得分并利用SoftMax函数预测最终分类结果。将视频分成多个片段并进行融合分类的TSN模型成功实现长时间视频行为识别分类,但是对于双流网络模型中空间网络与时间网络仅在最后进行简单融合,不够充分利用时间维度信息。针对双流网络模型中时间和空间网络融合问题,Feichtenhofer[5]等提出在空间维度上把两路神经网络在网络层中间位置进行首次融合,在网络最后层对时空网络进行二次融合,在时间维度上利用3D卷积3D池化进行融合,实验发现多种融合方式使网络性能有所提升。但是双流网络对于时序运动信息的提取都依赖于预先提取的光流,繁杂的数据量以及非端到端的性质降低了网络效率。因此一些学者考虑不采用光流信息,利用网络学习帧间关系来表示时间运动信息[6-8]。如Karpathy[6]等将高-低分辨率的图像帧输入到两路Alexnet卷积神经网络中进行特征学习,并总结了几种利用卷积神经网络提取时序语义信息的模式,但在UCF101上的分类效果一般,表明该多融合的高低分辨率网络模型也难以较好的捕捉运动信息。Ng等[9]利用长短期记忆网络(Long-Short Term Memory,LTSM)来对双流模型中的时域融合,但是LSTM网络训练难度较高,实验效果显示利用 LSTM 也难以对原始视频帧序列建模获取时序运动特征。Tran[10]等人提出的C3D网络模型在大规模数据集上进行空时特征学习。此网络由三维卷积层,三维最大池化层,全连接层和分类层组成,理论上可以对长视频时间运动信息建模,但是对于硬件条件有限的情况下也难以实现。

在视频行为识别中,准确有效的提取时空信息是至关重要的。受人类视觉机制启发,让系统学会忽略无关信息而关注重要信息对特征提取尤为重要。一些研究者[11-15]提出在视频行为识别算法中融入注意力机制。其中,Girdhar R[12]等尝试将注意力池化加入到CNN中,代替CNN网络结构中常用的平均池化和最大池化,使网络能够自动将注意点放在与动作类别息息相关的感兴趣区域,但是发现利用二阶池化的注意力需要矩阵相乘使模型计算量增加较大。Song[13]等在骨架动作识别上利用时域注意力子网络给不同帧分配重要性以及空域注意力子网络用于给不同关节点分配合适的权重,融入时域注意力和空域注意力的LSTM网络模型分类准确率提升,但是使得网络模型更加难以训练。Zhu[14]等人对深度神经网络的空间注意力进行经验性研究,提出可以消除广义注意力公式中的各种空间注意力元素,将可变形卷积与关键内容的显著性进行适当组合。增加此堆叠空间注意力的网络模型受益较小且速度变慢。除了空间注意力外,Hu[15]等提出通道注意力及其改进,通过压缩和激活两个步骤对特征加权作为下一级的输入。虽然增加通道注意力的模型分类准确率得到有效提升,但是网络模型训练需要较好的初始化而且内存消耗较大。

考虑到视频相邻帧间存在大量冗余,本文使用视频帧稀疏采样对长时间视频结构进行建模。在视频时序运动特征提取方面,设计一个端到端的2D时序特征提取网络,通过多尺度帧元组学习时序运动信息。在多尺度时序融合行为识别模型中,利用深度卷积神经网络学习多尺度帧元组特征。同时受注意力模块启发,为了实现聚焦图像显著区域以及对通道特征重要性的区分从而提取关键信息,本文在多尺度时序特征提取网络的基础上分别融入轻量通道分组注意力模块和通道-空间注意力模块,增加对动作聚集区域的注意,通过端到端的训练进行识别分类。

2 融入注意力的视频时序行为识别模型

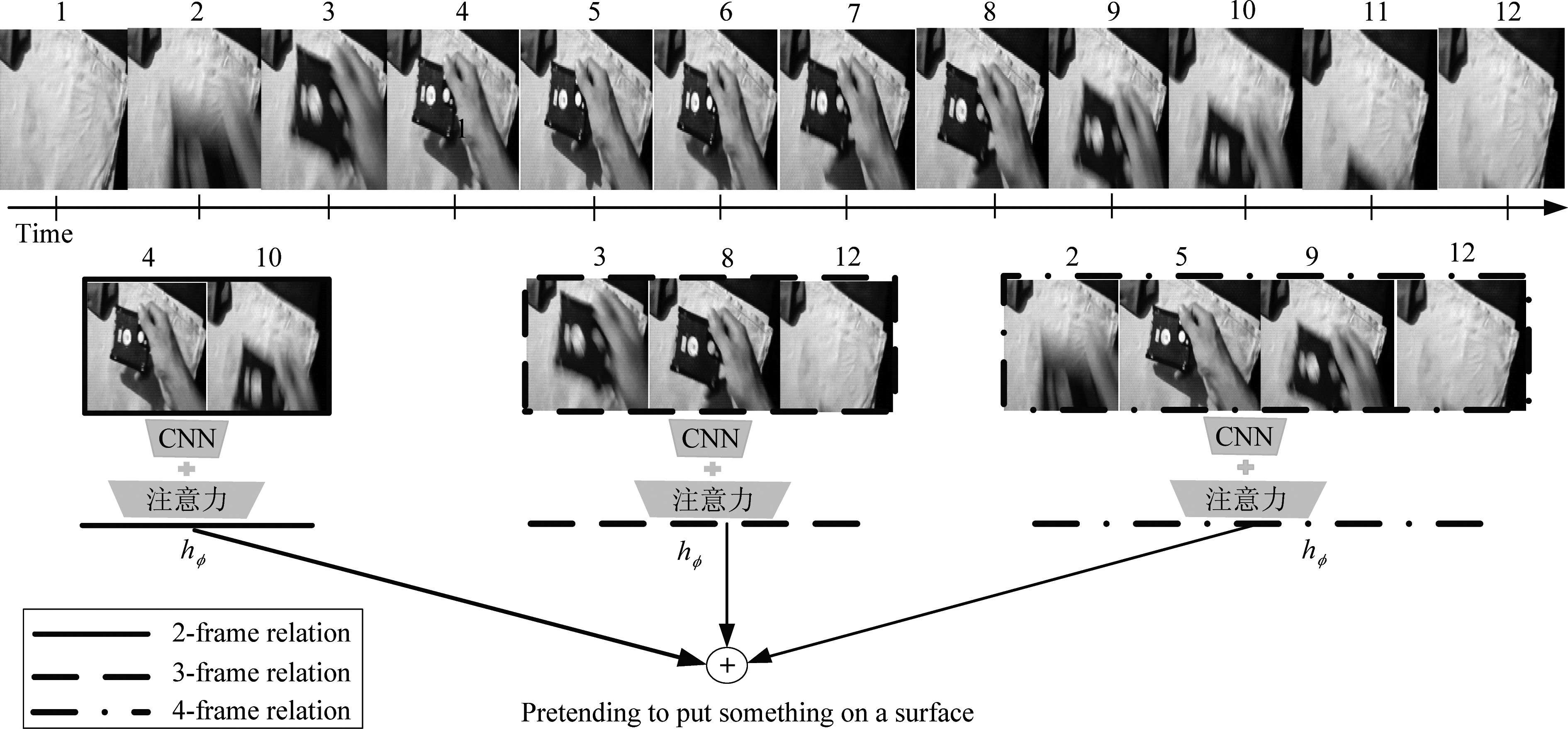

融入注意力机制的视频行为识别模型,通过对视频中的代表帧进行采样并构成不同的帧关系元组输入网络进行行为识别,主要分为时间采样阶段和特征提取识别阶段两部分,其整体结构图如下图1所示。

1)时间采样阶段:由于视频帧间结构相似性导致相邻帧间信息量较低,密集时间采样通常会导致大量信息冗余,稀疏采样可以有效减少计算量。基于此思想,对输入视频进行采样,并随机选取具有一定间隔的多帧图像形成不同尺度的帧关系元组,如图1展示2帧,3帧和4帧的帧关系组,将多尺度组的图像输入包含注意力模块的深度卷积神经网络。

图1 融于注意力的视频多时序推理行为识别模型

Fig.1 Attention-absorbing video multi-temporal reasoning behavior recognition model

2)特征提取识别阶段:在特征提取阶段,将时间采样阶段得到的短时序-长时序帧分别输入融合注意力机制的卷积神经网络进行特征提取,本文采用BN-Inception作为主干网络架构,BN-Inception是模块化的网络结构,采用并行的连接形式,在网络训练过程中对多分支进行选择。最后将经网络提取的多层次时空特征进行融合并连接分类器进行预测判断分类。

3 多尺度时序关系与注意力模块

3.1 定义时序关系

时间关系推理能力是指理解物体在时间域的变化关系的一种能力。例如,对于Something-something V1数据集中存在的类别“假装放某物”而不被识别为“放某物”,以及“从左向右推某物”而不被理解为“从右向左推某物”。为了具备理解时间关系的能力,受关系推理模块[16]启发,将下列复合函数定义为一组时序关系:

(1)

式中,假设输入视频V,选取n个有序帧,fi和fj代表视频中的第i帧和第j帧通过添加注意力模块的CNN后所提取的特征,gθ函数是对两个特征的拼接,hØ函数是对每两帧聚合后的结果的激活。使用带有参数θ和Ø的多层感知机实现两个函数的作用。可以进一步将2帧时间关系的复合函数扩展到更高的帧关系,如下式(2)所示:

(2)

在神经网络特征融合方式上可分为相加和拼接两种方式,拼接方式可以理解为通道的合并,相加方式是特征值的叠加。相加方式的融合是每个维度下描述图像特征的信息量增加,但是描述图像的维度并没有增加,显然这对图像的分类是有益的。而且相加方式与拼接比相对参数和计算量小很多,所以本文选择下式(3)所示简单地相加融合捕捉多尺度的时序关系。式中Td表示d帧之间关系融合的结果。

MTN(V)=T2(V)+T3(V)…+TN(V)

(3)

3.2 通道分组注意力

通道分组注意力将通道特征分组,在每个组中利用局部特征与全局特征的相似性突出显著特征,SGE注意力模块整体结构[17]如图2所示。图4(b)展示的是SGE网络层结构,不同于SK[18]选择核进行改造,SGE将特征按照通道分成G组,每组的输入特征xi 经过与全局平均池化后的含有语义向量的特征图谱g融合形成新的特征图,经过归一化和sigmoid激活函数操作后与原始特征按位点积。根据点积的定义,g.xi可以写成‖g‖‖xi‖cos θi,其中θi是g与xi的夹角,因此本身模长的特征以及与全局特征向量方向接近的特征就会得到较大的初始注意力系数。同时,由于不同的样本的注意力值的差异性较大,所以需要归一化到相同的范围以便给出准确的注意力权重。

图2 SGE注意力网络结构示意图

Fig.2 Structure diagram of SGE attention network

图3 CBAM网络结构整体图

Fig.3 Overall diagram of CBAM network structure

图4 各模块组件图

Fig.4 Component diagram of each module

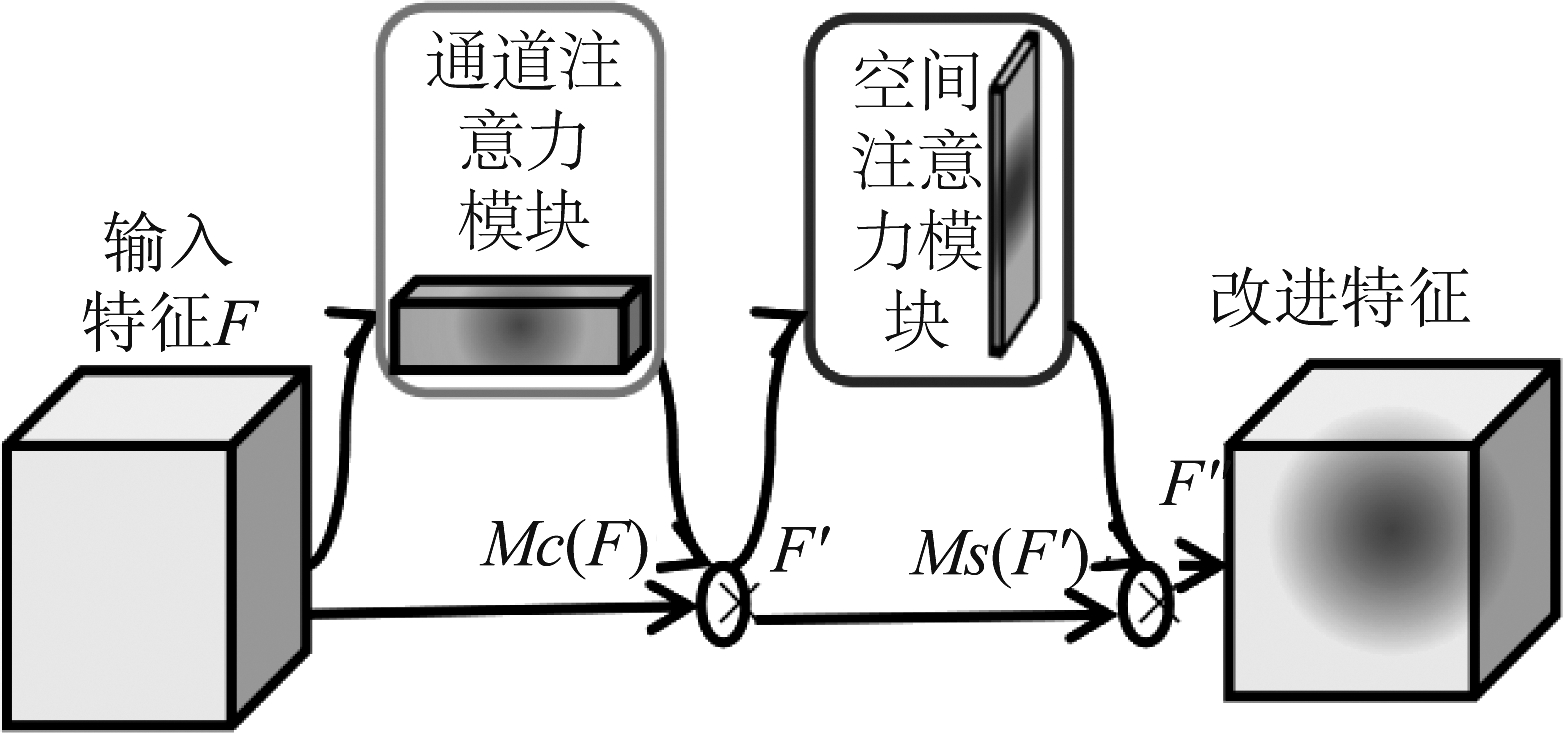

3.3 通道-空间注意力

CBAM注意力[19]网络类比于人类视觉注意力机制,对特征矩阵进行通道和空间的重新改造。采用一种自学习的方式对特征重新校准权重。CBAM的网络结构整体图如图3所示,对输入图像提取的特征F与通道注意力模块作用后的特征Mc(f)点乘后得到特征F′,同理再通过空间注意力模块的作用得到改进的特征F″。通道注意力模块与空间注意力模块采用顺序连接方式比并行连接方式更有效。

对于视频中的图像经过几个卷积层得到的特征矩阵会有多个通道,通常可达到1024或者2048个,但是并不是所有的通道信息同等重要,因此,可以通过增大有效通道权重,减小无效通道权重实现通道的过滤达到优化特征的目的。通道注意力模块对输入的H×W×C的特征F进行全局最大池化和平均池化得到两个1×1×C的通道描述,再将它们分别送入共享MLP,将输出的两个特征相加得到维度为1×1×C的特征,经过Sigmoid激活函数得到权重系数Mc。最后,利用权重系数Mc和原来的特征F相乘即可得到缩放后的新特征F′。

空间注意力模块与通道注意力模块不同,其关注哪里的信息是有意义的,通道注意力和空间注意力模块是相辅相成的,分别关注位置和内容,并以顺序的方式链接。与通道注意力模块相似的是,对于输入的H×W×C的特征F′先分别进行通道维度的最大池化和平均池化,得到两个1×1×C维度的特征然后按通道拼接。再利用一个7×7的卷积对特征进行卷积,通过Sigmoid激活函数得到一个与原特征维数相同的空间矩阵,将此空间注意力矩阵和原特征图相乘即可得到缩放后的新特征。

3.4 网络模块融合

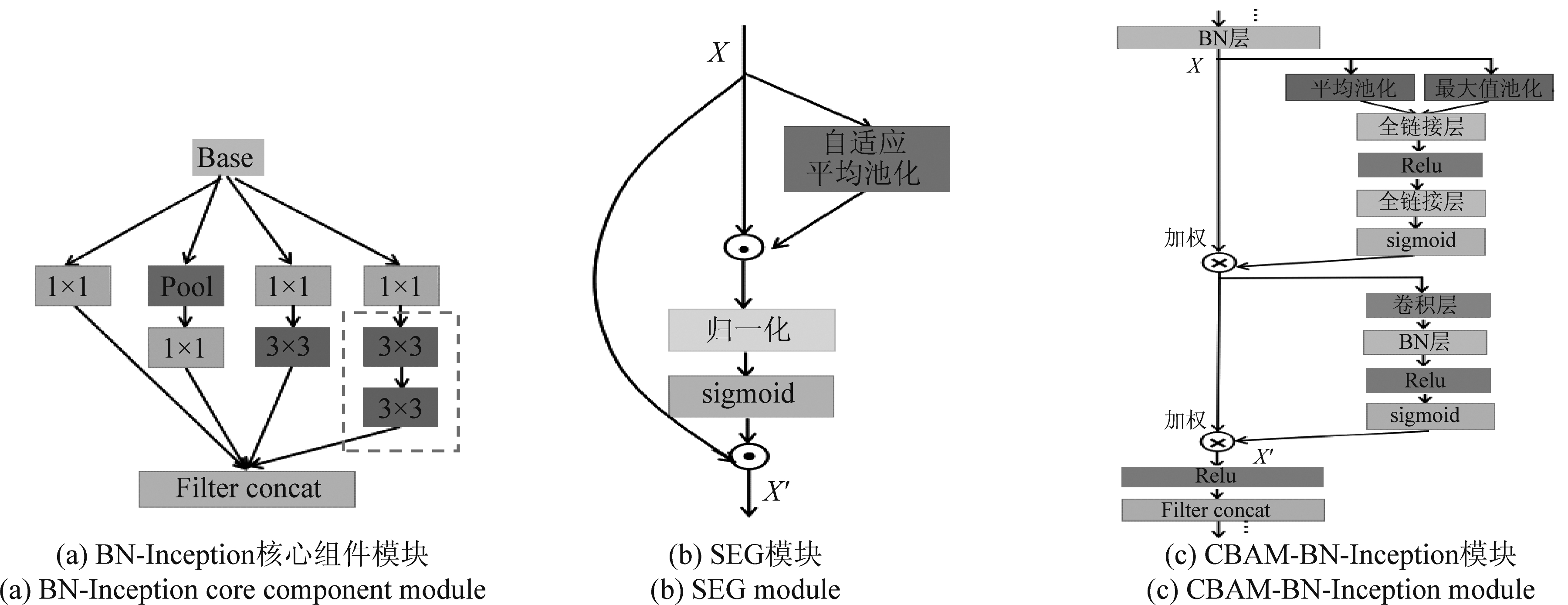

本文采用BN-Inception作为主干网络架构,BN-Inception是模块化的网络结构,采用并行的连接形式,在网络的训练过程中进行多分支的选择,如图4中(a)展示的是BN-Inception的核心组件。

图4(a)中BN-Inception图中的虚线框表示用两个3×3的卷积代替5×5的卷积,降低参数并减轻过拟合。BN在用于神经网络某层时,会对每一个mini-batch数据的内部进行标准化,使输出规范到N(0,1)的正太分布,解决在训练过程中中间层数据分布发生改变的问题,以防止梯度消失或爆炸、加快训练速度。有效的正则化方法使大型卷积网络训练速度加快很多倍,收敛后的分类准确率得到提升。图4(b)是SEG模块对输入的分组特征操作的网络层结构图,对每个分组后的特征进行显著区域的注意操作,本文在训练过程中将此模块嵌入BN-Inception。图4(c)展示的是在BN-Inception核心模块的最后BN层后加入CBAM模块。在训练过程中,SEG-BN-Inception将特征按照通道分成G组,每组特征经过全局平均池化得到g后与原分组特征按位点积,经过归一化和激活函数操作后再与原分组特征进行点积操作,基于以上操作得到特征语义显著区域激活。CBAM-BN-Inception对特征的重新校准来自于两个操作,图4(c)中上下两部分分别代表对特征的通道注意力和空间注意力,通过注意力模块作用得到通道或空间不同分配权重的特征X′。

4 实验仿真

在本节中,将通道分组注意力和通道-空间注意力模块分别融入多尺度时序识别主体网络中形成Multi-scale TRNSGE和Multi-scale TRNCBAM,并在Something-Something Dataset-V1和Jester dataset-V1两个数据集上验证模块的有效性,对网络分类准确率影响因素进行分析验证。

4.1 数据集及环境

算法实验完成所使用的软件环境是Pytorch 0.3.1,Ubuntu 16.04操作系统。实验平台为Intel(R)Core i7-7800X处理器,六核3.5 GHz,NVIDIA GTX 1080Ti显卡。

Something-Something Dataset-V1数据集包含108499个标注视频片段,每个视频时长约2~6 s。视频展示174种类别的人类动作。例如:把某物丢进某物,从左向右推动某物等。此数据集不只是为了分类检测物体,更重要的是理解人类行为之间的交互关系,表现那些直接或间接的行为动作,使机器更细致地理解物理世界中的基本动作。

Jester dataset-V1是关于动态手势的数据集,包含148092个标注视频片段,每个视频时长3 s左右。视频涵盖了25个类别的人类手势类别。视频展示人类行为者完成各种手势的过程,比如:向左或向右重击,两个手指向上或向下滑动,向前或向后摆手等。从视频中预测这些文本标注通常要求网络能够理解这些概念,比如三维空间的自由度:震荡、摇摆、举起等。两个数据集都是在自然视频场景下聚焦于人的动作视频。视频在自然光,运动模糊的情况下,捕捉了真实世界复杂的状况,具有一定迁移现实使用场景的可能性,总的来说两个数据集是具有挑战性的。

4.2 Something-somethingV1数据集

首先对输入图像裁剪大小为224×224的图像,左右翻转进行数据增强,然后送入网络进行训练测试。使用在ImageNet上预训练的权重初始化,初始学习率为0.001,每连续10个epoch将学习率降低为原来的10%,采用交叉熵损失函数作为优化标准,整个训练过程在损失基本稳定且准确率处于平稳期时停止训练,大约在120 epochs时停止,使用权重衰减为5e-4和动量为0.9的mini batch 随机梯度下降(SGD)对网络参数进行更新。由于实验设备有限设置batch size为20,调用PyTorch中Tensor的top k方法进行分类准确率的计算,测试时对图像进行了10-crop操作,即取这10张预测结果的均值作为该帧图像的结果,本文如无特殊说明,测试都是10-crop操作的结果,多尺度TRN指的是存在多种尺度的TRN,本文实验设置采用为8-frame relation。

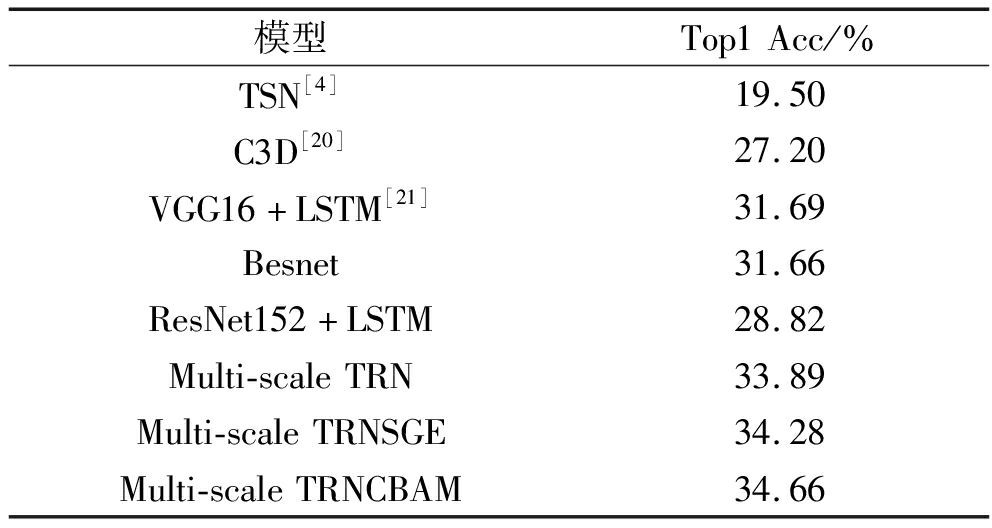

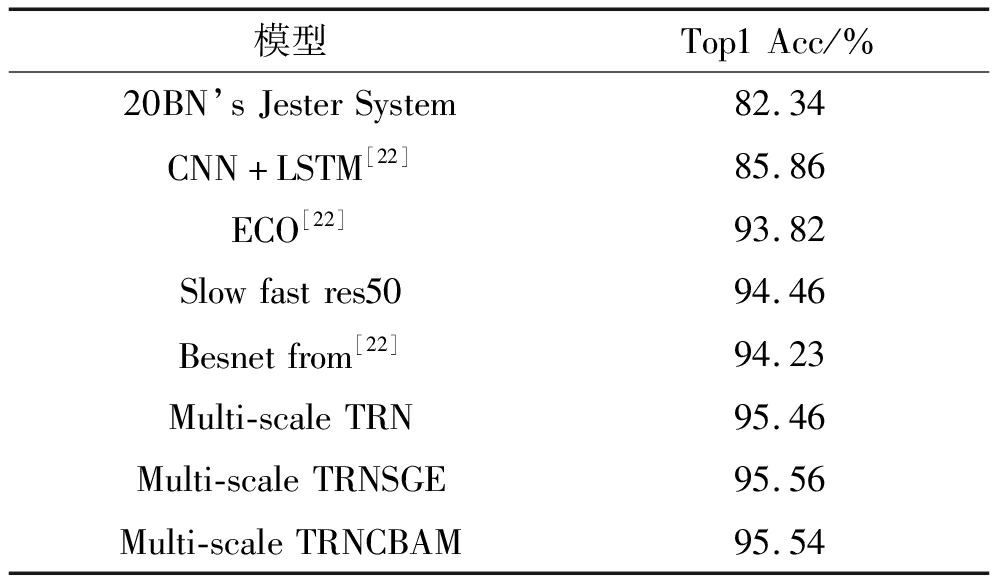

本节总共设置三组实验,首先第一组实验结果如下表1所示,各个主流网络在Something-Something Dataset-V1数据集上的表现以及多尺度TRN分别融入注意力机制TRN-SGE和TRN-CBAM网络在Something-Something Dataset-V1数据集上的分类准确率。可以看出,增加了注意力模块的多尺度视频时序行为识别网络得到有效的提升,其中Multi-scale TRNCBAM比Multi-scale TRN提升接近0.8%,Multi-scale TRNSGE比Multi-scale TRN提升接近0.4%,且与TSN等其他方法相比在此数据集上有较高的分类准确率。

表1 在Something-something Dataset-V1测试集的结果及比较模型排行

Tab.1 Ranking of results and comparison models in the testing set of Something-Something Dataset-V1

模型Top1Acc/%TSN[4]19.50C3D[20]27.20VGG16+LSTM[21]31.69Besnet31.66ResNet152+LSTM28.82Multi-scaleTRN33.89Multi-scaleTRNSGE34.28Multi-scaleTRNCBAM34.66

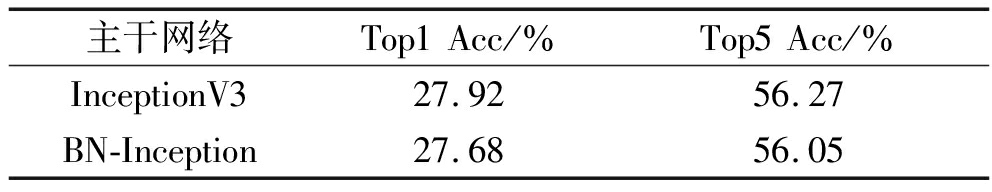

在Something-Something数据集中进行的第二组实验将研究主干网络对模型的影响,由于不同的预训练网络对特征提取的能力的差异性,不同的网络架构对分类识别效果会产生一定的影响。本组实验采用的单尺度TRN网络。在固定其他影响因素的前提下,分别应用在ImageNet数据集上预训练的参数初始化BN-Inception和InceptionV3作为主干网络进行系统测试,具体实验结果如下表2所示,如果只看分类准确率,InceptionV3的Top1和Top5准确率比BN-Inception高出约0.2个百分点,但是在训练过程中,单个英伟达Titan Xp GPU上的120个训练时期所消耗的时间分别大约在24小时和72小时,在平衡准确率和效率上选择BN Inception网络训练是更合理的,如无特殊说明,实验采用BN-Inception作为特征提取主干网络。

表2 不同主体网络在数据集上的性能表现

Tab.2 Performance of different agent networks on datasets

主干网络Top1Acc/%Top5Acc/%InceptionV327.9256.27BN-Inception27.6856.05

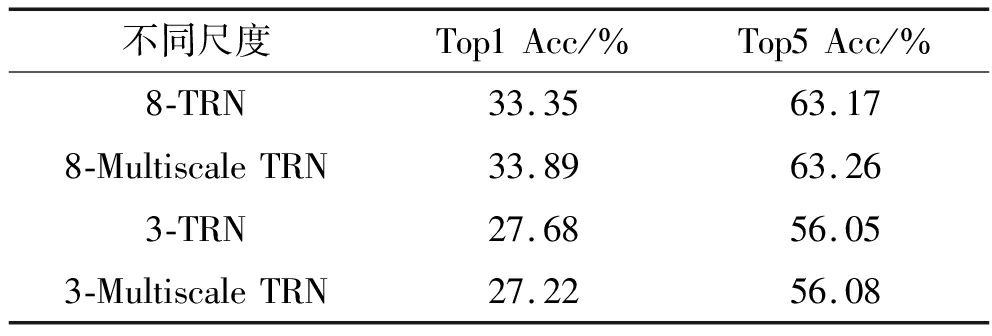

第三组实验是测试不同尺度帧关系对系统性能的影响,表3展示的在Something-something Dataset-V1数据集上单一尺度和多种尺度时序网络的Top1和Top5准确率。表3中8-TRN表示的是存在8-frame关系的单一尺度TRN网络,8-MultiScale TRN代表的是含8-frame及以下关系的多种尺度TRN网络,同理3-TRN表示的是3帧关系的单尺度TRN,3-MultiScale TRN表示的是3帧及2帧关系的TRN,通过对比8-TRN与3-TRN以及8-MultiScale TRN与3-MultiScale TRN可以发现,8帧关系无论是单一尺度还是多种尺度的网络都比3帧关系的网络表现好,理论上也可以推断出此结果,视频的帧关系数过低会影响信息的提取从而影响最终分类结果。根据实验经验考虑到效率和准确率,不选择更高的帧关系,8帧关系的网络比较合理的。通过对比单一尺度与多种尺度可以发现,在帧数较少的关系下,多尺度与单尺度效果不明显甚至会由于过低尺度的不合理性影响整体效果,但是在8帧关系下,多尺度网络展现出竞争力。

表3 Something-Something Dataset-V1数据集上不同尺度时序网络的准确率

Tab.3 Accuracy of time-series networks at different scales on Something-something Dataset V1 data sets

不同尺度Top1Acc/%Top5Acc/%8-TRN33.3563.178-MultiscaleTRN33.8963.263-TRN27.6856.053-MultiscaleTRN27.2256.08

由Something-Something Dataset-V1数据集上实验结果可知:

(1)Multi-scale TRNSGE和Multi-scale TRNCBAM作为特征提取网络都比单独的Multi-scale TRN更为有效,有更高的识别分类准确率,其中Multi-scale TRNCBAM比Multi-scale TRNSGE提升更加明显。且与该数据集上的其他算法网络相比具有一定性能优势。

(2)由第二组实验可知,InceptionV3与BN-Inception作为主干网络而言,虽然InceptionV3和BN-Inception相比具有更高的识别率但是网络训练效率较低,因此本文选用BN-Inception作为特征提取主干网络。

(3)在合理帧数情况下,多尺度关系的时序网络比单尺度网络具有更高的分类准确率,使模型获取更加丰富的时序特征的信息。

4.3 Jester数据集

Jester手势数据集上的训练与Something-Something数据集设置相同大小的批处理,对视频随机稀疏采样,Multi-scale TRN网络在120 epochs时结束,增加注意力模块的网络对结构的改变使得训练在220 epochs时达到稳定,测试时对图像进行了10-crop操作,取这10张预测结果的均值作为该帧图像的结果。将CBAM和SGE模块融入多尺度TRN网络所得分类准确率以及与其他网络分类准确率的对比排行如下表4所示,可以看出,Multi-scale TRN网络在Jester数据集已经达到95.46%的分类准确率,注意力模块的增加在一定程度上凝结特征提高分类准确率。SGE和CBAM 的增加,使分类准确率达到95.56%和95.54%,都提高约0.1个百分点。Jester手势识别数据集的背景和内容相对单一,且与Something-Something数据集相比缺少交互关系行为,通道-空间注意力与通道分组注意力相比在空间注意力上的优势在该数据集上体现的并不明显,因此该数据集上的注意力模块的选择可以进一步结合参数和计算量。

表4 注意力网络在Jester测试集结果及比较模型排行

Tab.4 Application of attention network in Jester test set and comparison model ranking

模型Top1Acc/%20BN’sJesterSystem82.34CNN+LSTM[22]85.86ECO[22]93.82Slowfastres5094.46Besnetfrom[22]94.23Multi-scaleTRN95.46Multi-scaleTRNSGE95.56Multi-scaleTRNCBAM95.54

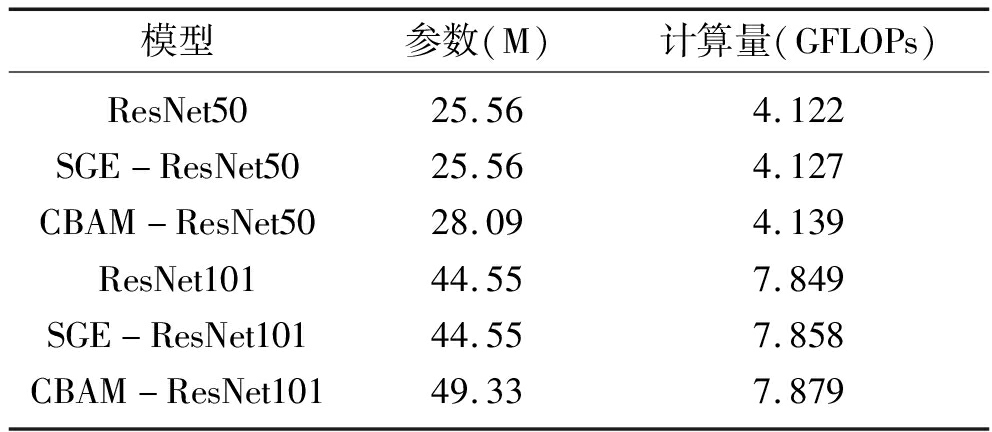

为了更好地比较两个模块增加对网络的影响,本文分析了CBAM与SGE的增加对网络参数和计算量的影响。表5所示是CBAM和SGE的增加引入的参数和计算量。可以看出,SGE和CBAM融入ResNet50,ResNet101所引入的参数量都是轻量级的。融入注意力机制对于本文的多尺度时序行为识别网络的参数和测试时间的数据对比展示在下表6中。

表5 融于注意力网络的参数和计算量对比表

Tab.5 Parameter and computational comparison table integrated into attention network

模型参数(M)计算量(GFLOPs)ResNet50SGE-ResNet50CBAM-ResNet50ResNet101SGE-ResNet101CBAM-ResNet10125.5625.5628.0944.5544.5549.334.1224.1274.1397.8497.8587.879

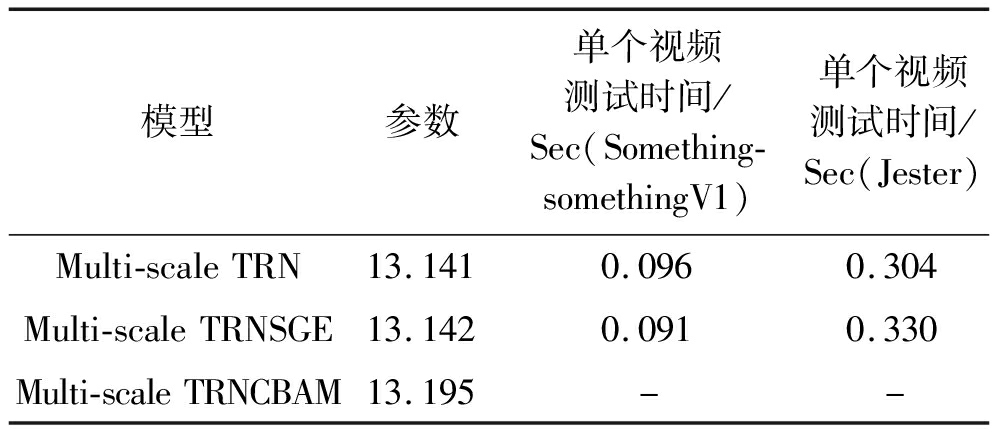

表6展示了Multi-scale TRN、Multi-scale TRNSGE、Multi-scale TRNCBAM的参数以及在两个数据集上测试单视频所消耗的时间,该对比实验都采用视频图像的1crop进行测试。可以看出,SGE和CBAM注意力模块的融入并未显著增加参数和测试时间,尤其SGE模块引入Multi-scale TRN增加的参数是0.001M,对于百万级的深度神经网络基本可忽略不记。实验数据表明两个融入注意力模块的网络可以忽略参数及测试时间增加的问题,通过注意力区分关注区域,有利于提高分类精度。

表6 模型参数及测试时间表

Tab.6 Model parameters and test schedule

模型参数单个视频测试时间/Sec(Something-somethingV1)单个视频测试时间/Sec(Jester)Multi-scaleTRNMulti-scaleTRNSGEMulti-scaleTRNCBAM13.14113.14213.1950.0960.091-0.3040.330-

由Jester数据集上实验结果可知:

(1)在Jester数据集上,Multi-scale TRNSGE和Multi-scale TRNCBAM作为特征提取网络比单独的Multi-scale TRN有更高的识别分类准确率,但是不如Something-Something Dataset-V1数据集上更为有效,且在该数据集上Multi-scale TRNCBAM与Multi-scale TRNSGE的分类准确率基本相同,通道-空间分组注意力与通道注意力相比在分类准确率上无明显优势。

(2)SGE和CBAM模块的引入都会使网络的参数和计算量增加,但是对与深度神经网络而言可以忽略不计。SGE的通道分组注意力相对于CBAM的通道和空间双注意力而言更加轻量化。

5 结论

由于视频行为识别算法需要聚焦视频显著区域提取强有力的时-空特征,本文提出融入注意力机制的视频多尺度时序融合行为识别算法模型。利用长-短时序图像帧信息融合提取视频运动信息,结合通道分组注意力和通道-空间双注意力对特征关系建模,忽略次要信息,提取关键特征信息。在Something-somethingV1和Jester两个数据集上的实验结果表明,配备注意力的网络优于基准网络。两个融入注意力机制的网络在Something-somethingV1数据集分别提升约0.4%和0.8%,并且实验数据表明可以忽略轻量注意力网络对模型增加的参数和计算量,验证了融入注意力机制的有效性。同时发现,多尺度关系网络分类性能优于单尺度关系网络。本文提出视频行为算法提取丰富的时-空信息,结合注意力模块进一步提高视频行为识别精度,对视频行为识别算法研究具有借鉴意义。

[1] 罗会兰, 童康, 孔繁胜.基于深度学习的视频中人体动作识别进展综述[J].电子学报, 2019, 47(5): 1162-1173.

LUO Huilan,TONG Kang,KONG Fansheng.The progress of human action recognition in videos based on deep learning: a review[J].Acta Electronica Sinica, 2019, 47(5): 1162-1173.(in Chinese)

[2] WANG Heng, KLASER A, SCHMID C, et al.Action recognition by dense trajectories[C]∥2011 IEEE Conference on Computer Vision and Pattern Recognition.Colorado Springs, USA, 2011: 3169-3176.

[3] SIMONYAN K, ZISSERMAN A.Two-stream convolutional networks for action recognition in videos[C]∥28th Annual Conference on Neural Information Processing Systems 2014, Montreal, QC, Canada, 2014: 568-576.

[4] WANG Limin, XIONG Yuanjun, WANG Zhe, et al.Temporal segment networks: towards good practices for deep action recognition[C]∥21st ACM Conference on Computer and Communications Security, Scottsdale, AZ, United states, 2016: 20-36.

[5] FEICHTENHOFER C, PINZ A, ZISSERMAN A, et al.Convolutional two-stream network fusion for video action recognition[C]∥29th IEEE Conference on Computer Vision and Pattern Recognition, Las Vegas, NV, United states, 2016: 1933-1941.

[6] KARPATHY A, TODERIC G, SHETTY S, et al.Large-scale video classification with convolutional neural networks[C]∥27th IEEE Conference on Computer Vision and Pattern Recognition, Columbus, OH, United states, 2014: 1725-1732.

[7] ZHU Wangjiang, HU Jie, SUN Gang, et al.A key volume mining deep framework for action recognition[C]∥ 29th IEEE Conference on Computer Vision and Pattern Recognition, Las Vegas, America, 2016:1991-1999.

[8] ZHOU Bolei, ANDONIAN A, TORRALBA A, et al.Temporal relational reasoning in videos[C]∥15th European Conference on Computer Vision, Munich, Germany, 2018: 831-846.

[9] NG Y H,HAUSKNECHT M,VIJAYANARASIMHAN S, et al.Beyond short snippets: deep networks for video classification[C]∥ IEEE Conference on Computer Vision and Pattern Recognition, Boston, America, 2015: 4694-4702.

[10] TRAN D, BOURDEY L, FERGUS R, et al.Learning spatiotemporal features with 3D convolutional networks[C]∥15th IEEE International Conference on Computer Vision, Santiago, Chile, 2015: 4489-4497.

[11] 王增强, 张文强, 张良.引入高阶注意力机制的人体行为识别[J].信号处理, 2020, 36(8): 1272-1279.

WANG Zengqiang, ZHANG Wenqiang, ZHANG Liang.Human behavior recognition with high-order attention mechanism[J].Journal of Signal Processing, 2020, 36(8): 1272-1279.(in Chinese)

[12] GIRDHAR R, RAMANAN D.Attentional pooling for action recognition[C]∥ 31st Annual Conference on Neural Information Processing Systems, Long Beach, CA, United states, 2017: 34-45.

[13] SONG Sijie, LAN Cuiling, XING Junliang, et al.An end-to-end spatio-temporal attention model for human action recognition from skeleton data[C]∥31st AAAI Conference on Artificial Intelligence, San Francisco, CA, United states, 2017: 4263-4270.

[14] ZHU Xizhou, CHENG Dazhi, ZHANG Zheng, et al.An empirical study of spatial attention mechanisms in deep networks[C]∥17th IEEE/CVF International Conference on Computer Vision, Seoul, Korea, Republic of, 2019: 6687-6696.

[15] HU Jie, SHEN Li, ALBANIE S, et al.Squeeze-and-excitation networks[J].IEEE Transactions on Pattern Analysis and Machine Intelligence, 2020, 42(8): 2011-2023.

[16] SANTORO A, RAPOSO D, MALINOWSKI M, et al.A simple neural network module for relational reasoning.arXiv preprint arXiv:1706.01427, 2017.

[17] LI Xiang, HU Xiaolin, YANG Jian.Spatial group-wise enhance: improving semantic feature learning in convolutional networks[C].arXiv:1905.09646, 2019.

[18] LI Xiang, WANG Wenhai, HU Xiaolin, et al.Selective kernel networks[C]∥ 32nd IEEE/CVF Conference on Computer Vision and Pattern Recognition, Long Beach, CA, United states, 2019: 510-519.

[19] WOO S, PARK J, LEE J Y, et al.CBAM: convolutional block attention module[C]∥15th European Conference on Computer Vision, Munich, Germany, 2018: 3-19.

[20] WANG Xiaolong, GUPTA A.Videos as space-time region graphs[C]∥15th European Conference on Computer Vision, Munich, Germany, 2018: 413-431.

[21] MAHDISOLTANI F, BERGER G, GHARBIEH W, et al.On the effectiveness of task granularity for transfer learning[C]∥arXiv:1804.09235, 2018.

[22] MATERZYNSKA J, BERGER G, BAX I, et al.The jester dataset: a large-scale video dataset of human gestures[C]∥17th IEEE/CVF International Conference on Computer Vision Workshop, Seoul, Korea, Republic of, 2019:2874-2882.