1 引言

情感分析是自然语言处理中的重要任务之一,其通过计算机辅助算法分析相关文本,进而获取人们对于产品、服务、事件等对象所持有的意见、评价等主观感受[1]。除了给出总体评价外,人们通常也会从实体的多个角度进行评价,导致一个评价中包含多个情感极性,若采用传统情感分析方法对整个评价进行情感分析,可能会使结果出现偏差。鉴于此,研究人员提出方面级情感分析方法,针对评论中每个目标词分别判定情感极性。例如,在关于餐厅的评论中“The food was definitely good,but the price is too high.”,两个目标词“food”和“price”的情感极性分别为积极和消极。

在早期研究中,方面级情感分析方法主要是基于规则与情感词典的方法[2]以及传统的机器学习方法[3],这些方法通过人工设计的特征能很好地利用文本信息,但需要对输入文本进行大量的预处理和复杂的特征工程,以及如依存句法分析等外部知识,方面级情感分析模型的性能很大程度上取决于人工特征设计的好坏及先验知识是否充分,需要耗费较多的人力。随着分布式表示[4]在机器翻译和自动问答等自然语言处理任务中的成功应用,以及多层网络架构拟合和学习能力的不断强大,促使研究者将依赖人工特征工程的传统方法迁移到基于神经网络的方法[5-7]。

现有的基于神经网络的情感分析模型框架通常遵循的训练过程为:首先将输入文本进行向量化表示,然后利用神经网络对文本向量化的表示矩阵进行特征提取,最后通过与任务目标一致的目标函数完成情感分析模型的训练。在此基础上,情感分析模型训练的成功与否取决于:文本向量化的表示是否能很好地表征整个语料的语义信息,提取的特征是否能包含充分的语义句法信息和情感信息,以及设计的目标函数是否有效。方面级情感分析与普通的句子级或文档级情感分析任务相比,需要更深层次的细粒度情感信息[8],当同一语料中存在多个不同的目标词时,如何针对目标词调整模型重点关注的上下文特征是该任务的重要挑战。因此,现有表现较好的模型常利用神经网络模型结合注意力机制来捕获与目标词相关的上下文情感信息,并进一步将特征信息整合后预测情感极性[9-16]。虽然上述方法提升了方面级情感分析模型的性能,但是由于用于训练方面级情感分析模型的数据集不仅需要找出每条语料的所有目标词,还需要对所有的目标词的情感极性进行标注,因此数据集构造难度较大,造成数据集规模无法扩大,方面级情感分析模型能够学习到的有效信息受限,进而导致模型的性能无法进一步得到有效提升。

尽管方面级标注的训练数据很缺乏,但是已公开的文档级标注的训练数据量较大,如Amazon数据集和Yelp数据集等,神经网络可通过这些带有情感标签的数据集学习到大量情感相关的语言表达模式和句法结构信息。因此研究者们利用资源丰富的文档级情感分析模型来辅助提升方面级情感分析模型的性能。文献[17]采用预训练和多任务学习的框架PRET+MULT,利用共享的嵌入层和长短时记忆(LSTM)层将文档级数据中的情感信息传递给方面级情感分析模型。文献[18]提出TransCap框架,采用胶囊网络将文档级先验知识共享给方面级情感分析任务。滕磊等人[19]在该框架的基础上采用了更加健壮和合理的动态路由方法,增强网络对方面情感方向的识别能力。虽然上述方法通过参数共享和多任务学习方法提升了方面级情感分析任务的性能,但无法精确控制哪些知识被迁移。针对该问题,Zhao等人[20]提出了注意力迁移模型IAN,该模型中包含Attention Guidance和Attention Fusion两种方法,前者在训练阶段将文档级情感分析模型的注意力权重作为引导方面级情感分析模型的学习信号,后者通过公式变换在训练和测试阶段都利用到了文档级知识,后者效果优于前者。我们在文献[20]的基础上,将注意力迁移模型中分立的Attention Guidance和Attention Fusion两种方法进行融合,并设计了更有效的目标函数使方面级情感分析模型能够充分利用文档级情感信息,从而进一步提升方面级情感分析模型的性能。此外,为了验证本文模型的性能,我们在公开数据集上进行实验,实验结果表明本文模型的有效性。

2 本文模型

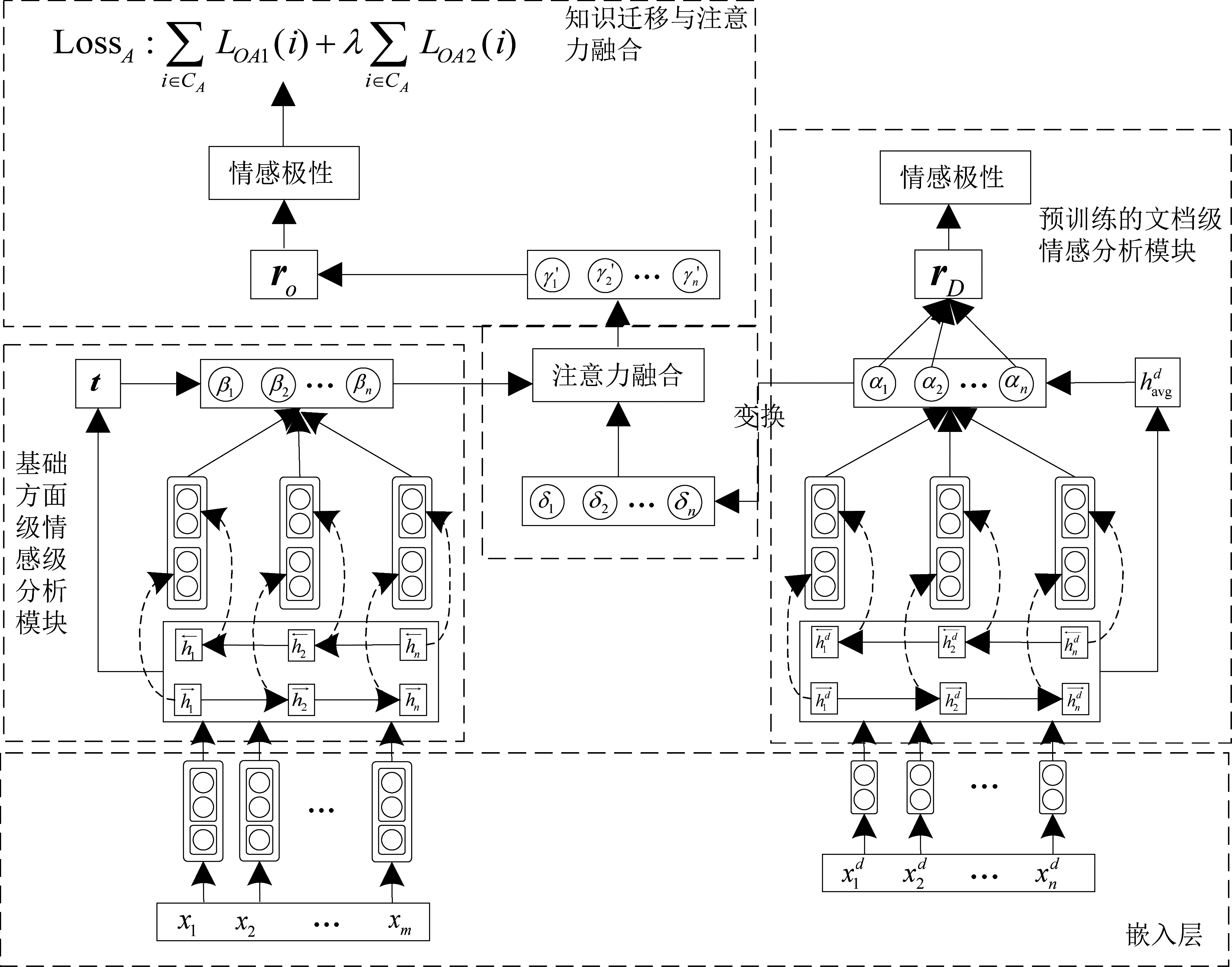

本文将训练得到的文档级情感分析模块中的文本及情感特征信息作为先验知识,通过知识迁移和注意力融合的方法来辅助提升方面级文本情感分析模型的性能,本节将具体介绍该模型的构造方法。

2.1 任务定义

用于训练文档级情感分析模型的语料集为CD,其中每条语料包含n个词,可表示为![]() 文档级情感分析模块的目标是预测每条语料总体的情感极性,定义为任务TD。用于训练方面级情感分析模型的语料集为CA,其中每条语料的形式可表示为[SA,t],SA={x1,x2,...,xm}为包含m个词的待分析语料,t={xl,xl+1,...,xr+l}为包含|r+1|个词的待分析目标方面词,t是SA的子集,一条待分析语料中可包含多个目标方面词,因此,方面级情感分析模型的任务是针对每个方面类别的目标方面词进行情感极性预测,定义为任务TA。

文档级情感分析模块的目标是预测每条语料总体的情感极性,定义为任务TD。用于训练方面级情感分析模型的语料集为CA,其中每条语料的形式可表示为[SA,t],SA={x1,x2,...,xm}为包含m个词的待分析语料,t={xl,xl+1,...,xr+l}为包含|r+1|个词的待分析目标方面词,t是SA的子集,一条待分析语料中可包含多个目标方面词,因此,方面级情感分析模型的任务是针对每个方面类别的目标方面词进行情感极性预测,定义为任务TA。

2.2 模型框架

本文的整体模型框架如图1所示,主要由4个部分组成,分别为嵌入层、预训练的文档级情感分析模块、基础的方面级情感分析模块以及知识迁移与注意力融合模块。

图1 本文模型框架

Fig.1 Architecture of the proposed model

2.2.1 嵌入层

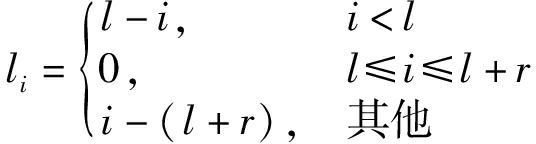

在提取文本语料特征前需要进行词嵌入操作,将所包含的单词映射到一个向量空间中,目的是编码输入的单词从而表征句子信息。具体方法是将文本语料中的每个单词与词嵌入表E∈RV×dw进行查找匹配,其中V代表单词表中单词的数量,dw为词嵌入维度。在查找匹配工作完成后,可得到文档级语料SD的词嵌入矩阵![]() 方面级语料SA的词嵌入矩阵{w1,w2,...,wm}∈Rm×dw,以及目标方面词t的词嵌入矩阵{wl,wl+1,...,wl+r}∈R|r+1|×dw。此外,在方面级情感分析中,方面词上下文中的位置信息对于判断其情感极性起到重要作用,因此本文将位置嵌入作为辅助特征与词嵌入一起作为TA任务的输入。首先计算出语句中每个单词wi相对于目标方面词的距离li,如公式(1)所示:

方面级语料SA的词嵌入矩阵{w1,w2,...,wm}∈Rm×dw,以及目标方面词t的词嵌入矩阵{wl,wl+1,...,wl+r}∈R|r+1|×dw。此外,在方面级情感分析中,方面词上下文中的位置信息对于判断其情感极性起到重要作用,因此本文将位置嵌入作为辅助特征与词嵌入一起作为TA任务的输入。首先计算出语句中每个单词wi相对于目标方面词的距离li,如公式(1)所示:

(1)

然后通过查找最大位置索引为L,嵌入维度为dp的位置嵌入表Ep∈RL×dP,将距离li映射为位置嵌入pi,最后将词嵌入与位置嵌入进行拼接得到方面级语料的最终嵌入表示ei=[wi;pi]。

2.2.2 预训练的文档级情感分析模块

本文采用了Bi-LSTM模块对输入的词嵌入矩阵进行编码,抽象出文本的语义与句法特征。在文档级文本情感分析任务TD中,将词嵌入矩阵![]() 输入到Bi-LSTM模块,该模块从前往后和从后往前两个方向进行特征提取,在该过程中,Bi-LSTM模块的隐藏单元将生成一个能够表征输入文本特征的隐藏状态序列

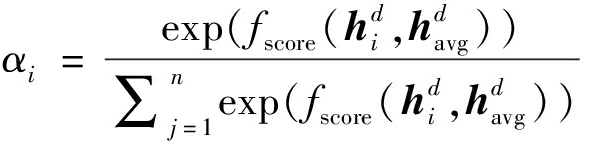

输入到Bi-LSTM模块,该模块从前往后和从后往前两个方向进行特征提取,在该过程中,Bi-LSTM模块的隐藏单元将生成一个能够表征输入文本特征的隐藏状态序列![]() 随后采用注意力机制为文本语句中的每个单词分配重要性权重αi,进而使训练TD任务的文本特征表示能够具有重要的情感特征,最终用于训练TD任务的语义与句法编码输出rD为:

随后采用注意力机制为文本语句中的每个单词分配重要性权重αi,进而使训练TD任务的文本特征表示能够具有重要的情感特征,最终用于训练TD任务的语义与句法编码输出rD为:

(2)

其中,αi的计算方法如下:

(3)

(4)

(5)

公式(4)中的Wd和bd分别为TD任务的权重矩阵和偏置向量。将TD任务的整个语料集CD的文本特征表示rD送入softmax层得到情感极性类别的分布概率,并通过最小化该分布概率与实际情感极性标签的交叉熵损失函数训练文档级情感分析模型,具体计算方法如下:

(6)

(7)

当训练完成后,TD任务中所有的模型参数均被保存下来,用于后续提升方面级情感分析模型的性能。

2.2.3 基础的方面级情感分析模块

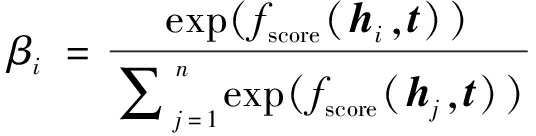

对于方面级文本情感分析任务TA,文本语义与句法编码的结构与任务TD基本一致,将嵌入层输出的{e1,e2,...,en}输入到Bi-LSTM模块中进行编码,生成包含高层次特征信息的隐藏状态序列{h1,h2,...,hn}。较之不同的是需要重点关注目标方面词的信息,因此在进行注意力计算时,本文将平均化的方面词向量![]() 作为查询向量,进而获取文本语句中与判断方面词情感极性更为相关的特征表示rA,具体计算方法如下:

作为查询向量,进而获取文本语句中与判断方面词情感极性更为相关的特征表示rA,具体计算方法如下:

fscore(hi,t)=tanh(hi·Wa·t+ba)

(8)

(9)

(10)

其中,Wa和ba分别为TA任务的权重矩阵和偏置向量。训练方面级情感分析模型的目标函数如下:

(11)

(12)

2.2.4 知识迁移与注意力融合

我们在上文提到过,情感分析模型的有效性与语料集的大小有着紧密的联系,语料集规模越大,模型获取的特征越充分。用于方面级情感分析任务的公开语料集因不易标注而规模较小,计算出的注意力权重βi关注重要情感特征的能力有限。而用于文档级情感分析模型的公开语料集规模较大,因此本部分将充分利用在文档级情感分析模型中获取的先验知识,通过αi的辅助来进一步学习βi,从而提升方面级情感分析模型性能。

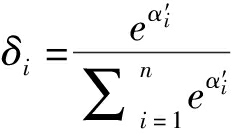

文档级情感分析任务中虽能获取更全面的情感信息,但是注意力权重αi偏重的情感特征是针对某个语料的整体情感倾向,无法体现同一语料不同目标词的情感。因此需要将αi进行变换,与目标词联系起来。根据以往经验,距离目标词越近的词语对于其情感的倾向性判断贡献越大,因此通过公式(13)、(14)变换得到δi,使αi能够包含与目标词距离相关的信息:

(13)

(14)

其中,li为语料中的单词与目标方面词的距离。

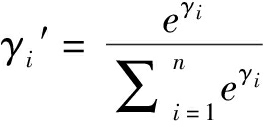

为使模型在测试阶段也能充分利用到文档级情感分析模型的先验知识,需要利用以下公式进一步进行注意力融合:

g=σ(Wg[δi,βi])

(15)

γi=gδi+(1-g)βi

(16)

(17)

其中,σ为sigmoid函数,Wg为注意力权重。将γi′替代公式(10)中的βi,得到特征融合后的句子表示ro。

此外,本文通过构造损失函数(18),使方面级情感分析模块中的注意力权重β与文档级情感分析模块中的注意力权重δ进行融合。该函数描述了注意力权重δ和β之间的相似性,当公式(19)的值越大,则表明δ和β越相似。通过指数运算转化esim(δi,βi)使δ和β之间微小的差距能够被放大。此外,为采用最小化损失函数的方法来训练模型,进一步对esim(δi,βi)取倒数。通过最小化函数LOA,使方面级情感分析模块能够充分利用文档级情感分析模块获取的情感特征,并将这些有效特征与方面级情感分析任务中的目标词相联系,进而提升方面级情感分析模型的性能。

(18)

(19)

最终本文训练方面级情感分析模型的最终损失函数由两部分组成:

LOA=LOA1+λLOA2

(20)

其中,λ∈[0,1]为超参数,控制LOA2在整个损失函数中的重要程度。

3 实验结果及分析

3.1 实验数据集

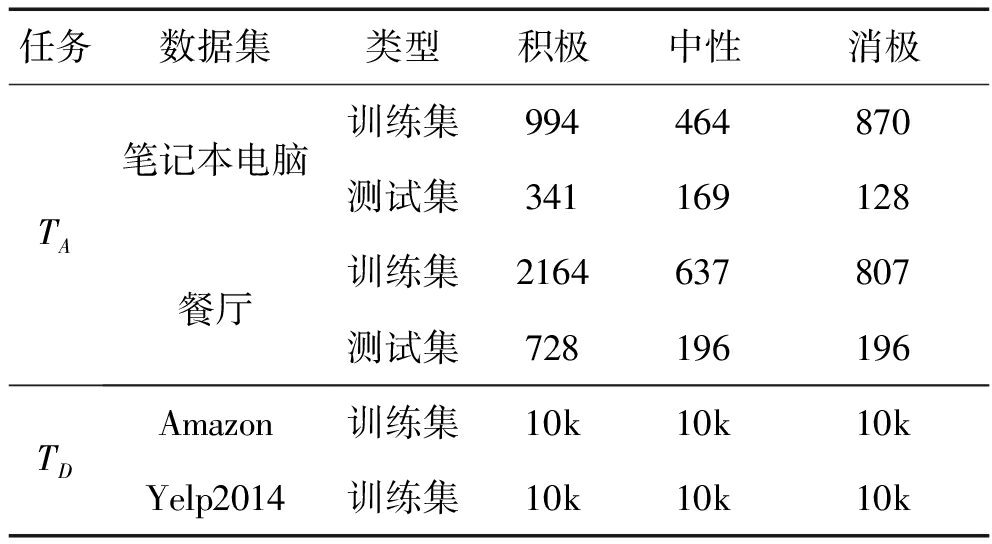

为验证本文模型的有效性,我们采用了方面级情感分析任务中广泛使用的公开数据集SemEval2014进行测试,包括笔记本电脑和餐厅2个领域的用户评论。数据样本的情感极性分为积极、消极和中性。

此外,训练文档级情感分析模块的数据集分别采用了Amazon电商数据集和Yelp2014数据集,Amazon电商数据集为笔记本电脑数据集的方面级情感分析提供可迁移的知识,Yelp2014数据集用于餐厅数据集的方面级情感分析提供可迁移的知识。原始数据集具有1-5星评级,我们按照评级<3,>3和=3分别划分为消极、积极和中性情感,每个数据集包含30k个具有平衡类标签的样本。这两个数据集中的所有样本都用于辅助训练,由于文档级情感分析模型在本文中起到辅助作用,因此在实验中不会给出该部分任务的性能。表1为本文实验数据集的具体情况。

表1 实验数据集统计信息

Tab.1 Statistical table of datasets used in the experiment

任务数据集类型积极中性消极TA笔记本电脑餐厅训练集994464870测试集341169128训练集2164637807测试集728196196TDAmazon训练集10k10k10kYelp2014训练集10k10k10k

3.2 实验设置

在本实验中,嵌入层的词嵌入通过文献[21]中的300维Glove进行初始化,并采用参数固定法在训练时固定参数。位置嵌入维度为200维。本文模型中的所有参数矩阵和偏置参数初始值均采用随机初始化,初始化的概率分布服从均匀分布U(-0.01,0.01)。Bi-LSTM网络的隐藏单元维度设为300。初始化学习率为0.1。控制LOA2在整个损失函数中的重要程度的参数λ为0.3。

3.3 超参数λ确定实验

为选定公式(20)中构造的损失函数LOA2最优占比,本部分通过实验确定超参数λ的取值。具体方法是从λ=0开始,按照0.1的步长进行实验,直到λ=1结束,记录λ每个取值在笔记本电脑和餐厅数据集下的实验结果。

从图2的结果可以看出,当λ<0.3时,两个数据集上的准确率和Macro-F1值呈上升趋势;当λ>0.3时,实验结果呈下降趋势;而当λ=0.3时,两个数据集的实验结果均达到最大值,此时方面级情感分析模型能够将文档级情感信息利用的最充分,达到最好的性能,因此在两个数据集中均设定超参数λ=0.3。

图2 超参数λ取值的实验结果

Fig.2 Experimental results of hyper-parameter λ

3.4 对比实验与分析

为评估本文模型的性能,本部分将与以下9个模型进行对比,其中模型(1)至(6)为方面级情感分析的一些经典模型,模型(7)至(9)是将文档级情感分析任务的知识迁移给方面级情感分析任务的模型。

(1)LSTM[22]是基础的长短时记忆网络,将该网络最后一层的隐含状态作为句子的高层表示特征,输入到分类器中进行训练。

(2)TD-LSTM[6]以目标词为中心,将文本拆分为两个部分,分别以正序和倒序输入2个LSTM中,将网络最后的隐含状态进行拼接后预测特定方面的情感极性。

(3)ATAE-LSTM[9]在LSTM的基础上融合注意力机制,将LSTM对文本上下文建模后为每个目标设置一个注意力向量,并由注意力向量产生特定方面的情感极性。

(4)IAN[23]利用2个LSTM网络分别对特定方面和上下文进行特征提取,然后再交互生成注意力向量作为最终的特征训练模型。

(5)MGAN[14]采用细粒度和粗粒度的注意机制来捕获方面和上下文之间的交互,并设计了一个方面对齐损失来描述具有相同上下文的方面之间的方面级交互。

(6)MFIF[24]的输入包含词嵌入和字符嵌入2种方式,将特定方面特征和上下文特征交互提取后,利用GRU和注意力机制进一步获取重要特征。

(7)PRET+MULT[17]通过方面级和文档级情感分析间的预训练和多任务学习,使方面级情感分析模型性能提升。

(8)TransCap[18]是基于迁移学习的胶囊网络结构,分享方面级情感分析和文档级情感分析任务之间的底层特征。

(9)ATN[20]模型中包含ATN-AG和ATN-AF两种方法,采用两种策略将文档级情感信息迁移到方面级情感分析模型中。

表2中每一行表示相应模型在不同数据集下得到的情感极性预测准确率,每一列中的粗体表示准确率最高的一项。总体来说,本文模型在对比实验中优于其他相关模型,说明该模型在方面情感分类任务中具有有效性。对比分析表2中的实验结果可以看出,加入注意力机制的ATAE-LSTM模型与LSTM模型相比,准确率有所提升,证明了注意机制在特定方面情感极性分类任务中能够重点学习到需要关注的信息。IAN模型与ATAE-LSTM模型相比,实验结果有所提升,是因为该模型充分考虑了目标方面与上下文之间的特征关系,不仅将池化的目标方面特征与上下文中每个词进行注意力计算,以学习到上下文每个词的重要性,还将池化的上下文特征与目标方面中每个词进行注意力计算,以学习到目标方面每个词的重要性。MFIF模型除了考虑目标方面词与上下文间的交互特征,在输入部分还进行了多特征处理,加入了字符特征,因此获得了较好的实验结果。以上模型证明了注意力机制的重要作用、获取特定方面与上下文之间的交互特征的重要性以及多样特征表示的优势。MGAN模型不仅采用了粗粒度的注意机制,而且还采用了提出的细粒度注意机制来获得方面和上下文之间的交互,并且设计了一个方面对齐损失来描述具有相同上下文的方面之间的方面级交互,该模型在仅使用注意力机制的对比模型中表现最好。

表2 各模型实验对比结果

Tab.2 Comparison of different methods

模型笔记本电脑Accuracy/%Macro-F1/%餐厅Accuracy/%Macro-F1/%LSTM66.5061.4174.3065.32ATAE-LSTM68.70-77.20-TD-LSTM71.8368.4378.0066.73IAN72.1067.8378.6069.65†MFIF75.34-80.35-MGAN75.3972.4781.2571.94PRET+MULT74.1469.1479.9869.39TransCap74.9270.2180.7271.98ATN-AG76.4172.5981.3972.44ATN-AF76.4872.6082.3674.00Ourmodel77.1873.0882.9874.82

PRET+MULT、TransCap和ATN模型均采用迁移学习的思想,将数据集较大的文档级情感分析模型中学习到更为充分的情感特征迁移到方面级情感分析任务中,准确率与未采用迁移学习的模型相比较高。其中,PRET+MULT模型的基础模型与ATAE-LSTM模型的结构基本类似,均采用了基于注意力机制的LSTM网络,但在笔记本电脑和餐厅数据集上的实验结果分别提升了5.44%和2.78%,说明迁移学习确实能够将文档级的有效特征用于提升方面级情感分析任务中。但PRET+MULT模型属于多任务学习模型,而多任务学习的本质在于找到多个任务的最优解,因此该模型可能会使方面级情感分析模型无法达到最优。TransCap模型是基于迁移学习的胶囊网络框架,该模型实验结果优于PRET+MULT模型,说明胶囊网络在特征提取上具有一定优势。ATN模型相较于PRET+MULT和TransCap的性能有了很大提升,说明该模型直接利用文档级情感特征辅助方面级情感分析任务,而非采用多任务学习的思想是对该任务有效的。此外,ATN模型中的ATN-AF方法能够在模型测试阶段也用到文档级情感知识,因此实验结果优于ATN-AG方法。本文模型在ATN模型的基础上设计了更有效的损失函数,使方面级情感分析模型能够更充分的利用文档级情感信息,并且将ATN-AG和ATN-AF进行了融合,使得模型进一步完善,因此准确率和F1值相较于ATN模型有了进一步提高。

4 结论

本文提出了一个新颖的用于方面级情感分析的模型。由于方面级文本语料规模较小且不易扩大,以往基于神经网络训练的模型受限于数据量无法进一步提升模型性能,因此本文利用数据量较大的文档级数据预先训练文档级情感分析模型,将该模型训练得到的注意力权重作为辅助信息,通过设计的知识迁移和注意力融合的计算方法以及有效的损失函数,从而训练得到性能有所提升的方面级情感分析模型。在整个模型设计中,本文将重点放到了目标函数的设计、知识迁移以及注意力融合上,重点探究了这部分结构对于方面级情感分析模型中的作用,而在输入文本单词和目标词的编码上仅使用了传统的Bi-LSTM网络,未来可设计更加有效的编码方案。后续我们也可以根据任务需求构造领域相关数据集,然后再进一步利用该模型的思想训练出领域相关的情感分析模型。

[1] HU Mingqing, LIU Bing.Mining and summarizing customer reviews[C]∥Proceedings of the 10th ACM SIGKDD International Conference on Knowledge Discovery and Data Mining, 2004: 168-77.

[2] DING Xiaowen, LIU Bing, YU Philip.A holistic lexicon-based approach to opinion mining[C]∥Proceedings of the International Web Search Web Data Mining WSDM.Palo Alto, CA, USA, Feb.2008: 231-240.

[3] KIRITCHENKO S, ZHU Xiaodan, CHERRY C, et al.Nrc-canada2014: Detecting aspects and sentiment in customer reviews[C]∥Proceedings of the 8th International Workshop Semantic Eval.Dublin, Ireland, Aug.2014: 437-442.

[4] MIKOLOV T, SUTSKEVERS I, CHEN K, et al.Distributed representations of words and phrases and their compositionality[C]∥Neural Information Processing Systems,2013: 3111-3119.

[5] 陈培新, 郭武.融合潜在主题信息和卷积语义特征的文本主题分类[J].信号处理, 2017, 33(8): 1090-1096.

Chen Peixin, Guo Wu.Document topic categorization combining latent topic information and convolutional semantic features[J].Journal of Signal Processing, 2017, 33(8): 1090-1096.(in Chinese)

[6] TANG Duyu, QIN Bing, FENG Xiaocheng, et al.Effective lstms for target-dependent sentiment classification[C]∥COLING, 2016: 3298-3307.

[7] XUE Wei, LI Tao.Aspect based sentiment analysis with gated convolutional networks[C]∥In Annual Meeting of the Association for Computational Linguistics(ACL), 2018(1): 2514-2523.

[8] PANG B, LEE L.Opinion mining and sentiment analysis[J].Foundations and Trends in Information Retrieval Found, 2008, 2: 1-13.

[9] WANG Yequan, HUANG Minlie, LI Zhao, et al.Attention-based lstm for aspect-level sentiment classification[C]∥Proceedings of the 2016 Conference on Empirical Methods in Natural Language Processing, 2016: 606-615.

[10] TANG Duyu, QIN Bing, LIU Ting.Aspect level sentiment classification with deep memory network[C]∥EMNLP, 2016: 214-224.

[11] MA Dehong, LI Sujian, ZHANG Xiaodong, et al.Interactive attention networks for aspect-level sentiment classification[C]∥Proceedings of IJCAI, 2017: 4068-4074.arXiv preprint arXiv:1709.00893.

[12] CHEN Peng, SUN Zhongqian, BING Lidong, et al.Recurrent attention network on memory for aspect sentiment analysis[C]∥In Proceedings of the 2017 Conference on Empirical Methods in Natural Language Processing, 2017: 452-461.

[13] MAJUMDER N, PORIA S, GELBUKH A, et al.Inter-aspect relation modeling with memory networks in aspect-based sentiment analysis[C]∥Proceedings of the 2018 Conference on Empirical Methods in Natural Language Processing, 2018: 3402-3411.

[14] FAN Feifan, FENG Yansong, ZHAO Dongyan.Multi-grained attention network for aspect-level sentiment classification[C]∥EMNLP, 2018: 3433-3442.

[15] SUN Jiahui, HAN Ping, CHENG Zheng, et al.Transformer based multi-grained attention network for aspect-based sentiment analysis[J].IEEE Access, 2020, 8:211152-211163.

[16] CU S,ZHANG L,HOU Y,et al.A position-aware bidirectional attention network for aspect-level sentiment analysis[C]∥Processing of the 27th International Conference on Computational Linguistics, 2018: 774-784.

[17] HE R, LEE W S, NG H T, et al.Exploiting document knowledge for aspect-level sentiment classification[C]∥Proceedings of the Association for Computational Linguistics(ACL), 2018:579-585.

[18] Chen Z,Qian T.Transfer capsule network for aspect level sentiment classification[C]∥Proceedings of the 57th Annual Meeting of the Association for Computational Linguistics(ACL), 2019: 547-556.

[19] 滕磊,严馨,徐广义,等.使用胶囊网络的细粒度情感分析方法[J].小型微型计算机系统, 2020, 41(12):88-94.

TENG Lei, YAN Xin, XU Guangyi, et al.Fine-grained sentiment analysis based on capsule network[J].Journal of Chinese Computer Systems, 2020, 41(12):88-94.(in Chinese)

[20] ZHAO Fei, WU Zhen, DAI Xinyu.Attention transfer network for aspect-level sentiment classification[M]∥Neural Information Processing, 2020.

[21] PENNINGTON J, SOCHER R, MANNING C.Glove: Global vectors for word representation[C]∥EMNLP, 2014, 14: 1532-1543.

[22] HOCHREITER S, SCHNIDHUBER J.Long short-term memory[J].Neural Computation, 1997, 9(8): 1735-1780.

[23] MA Dehong, LI Sujian, ZHANG Xiaodong, et al.Interactive attention networks for aspect-level sentiment classification[C]∥Proceedings of the 26th International Joint Conference on Artificial Intelligence.Melbourne, Australia, 2017: 4068-4074.

[24] ZENG Biqing, HAN Xuli, ZENG Feng, et al.Multifeature interactive fusion model for aspect-based sentiment analysis[J].Mathematical Problems in Engineering, 2019, 2019: 1-8.