1 引言

随着移动设备数量的增长和多媒体应用的普及,移动网络的数据流量呈现指数级增长,容量有限的回程链路将面临巨大的负载压力,无法进一步满足移动用户的日常需求。在这种情况下,一种新型的基于雾计算的雾无线接入(Fog-Radio Access Networks,F-RAN)架构被提出,它是将雾计算概念融入到无线接入网架构中,赋予了边缘节点存储、计算和通信的能力[1]。在F-RAN架构中,一方面可以通过在雾节点中配置专用的缓存设备,将热门用户请求的内容提前缓存,从而在用户发起内容请求时快速的在缓存中提取有效信息,减少无线通信中回程链路的负载压力,降低移动用户的请求时延。另一方面,也可以利用FUE自身有限的计算存储空间进行部分热门内容的缓存,通过D2D通信以单播或多播的方式将其缓存的热门内容分享至周围的一个或多个移动终端设备。然而,考虑到存储容量有限的移动终端设备和用户偏好随时间的不确定性变化,F-RAN架构中内容缓存问题将面临严峻的挑战。

目前,最近的文献利用机器学习的算法在集中研究无线网络的内容缓存策略。Jiang等[2]在移动边缘缓存(Mobile Edge Caching,MEC)场景下,基于用户的历史请求信息,通过机器学习的方法预测用户偏好,并将视频文件缓存在MEC服务器上,提出了一种基于多智能体强化学习(Multi-agent Reinforcement Learning,MARL)的协作内容缓存策略。虽然该协作内容缓存策略提高了缓存命中率,但是该内容缓存策略仅仅考虑了基站和终端设备的内容缓存以及基站之间的相关度,没有考虑边缘缓存节点的内容缓存问题。Li等[3]以最大化缓存概率为目标函数,将每个移动设备的内容缓存进行分区,通过结合D2D协作缓存以不同的缓存方式缓存不同流行度的文件,提出了一种基于软件定义的网络缓存算法。虽然该缓存算法提升了缓存命中率,但是该内容缓存算法仅仅考虑了终端设备的内容缓存,没有考虑边缘缓存节点和基站的内容缓存等问题。Jiang等[4]在F-RAN架构下,提出了一种利用在线梯度下降(Online Gradient Descent,OGD)算法和正则化逼近的方法以离线的方法预测用户偏好,以及利用用户偏好和内容特征的方法预测内容流行度的边缘缓存策略。虽然该边缘缓存策略能够以低复杂度、低时延的预测内容流行度的变化,但是该边缘缓存策略仅仅考虑了边缘缓存节点的内容缓存,没有考虑到基站和终端设备的内容缓存以及基站之间的相关度等问题。Chen等[5]以最大化缓存卸载概率为目标函数,通过概率潜在语义分析(Probabilistic Latent Semantic Analysis,PLSA)模型对用户偏好进行建模,提出了一种基于内容流行度的内容缓存策略。虽然该内容缓存策略缩短了学习时间和提高了内容缓存的性能,但是该内容缓存策略仅仅考虑了基站和终端设备的内容缓存,没有考虑到边缘缓存节点的内容缓存以及基站之间的相关度等问题。结合每个网络设备有限的存储容量,在文献[6]中我们以最大化缓存命中率为目标函数,提出了一种基于用户偏好和内容流行度的内容缓存及更新策略。该内容缓存策略虽然能有效的获得缓存命中率,但是没有考虑到基站之间的相关度等问题,会造成内容缓存冗余的问题。

基于上述内容缓存策略的不足,本文提出了一种基于Q-learning的协作式内容缓存算法。首先,利用主题模型中LDA模型动态地预测用户偏好;其次,利用已获得的用户偏好和小区内不同网络设备之间的拓扑关系以在线的方式预测内容流行度,然后再结合基站之间的相关度,以减少缓存内容文件的重复率;最后,以最大化缓存命中率为目标,利用强化学习中的 Q-learning算法获得了最优的内容缓存策略。

2 系统模型与问题描述

2.1 系统模型

如图1所示,考虑到在F-RAN架构下多个小区内的边缘缓存问题,本文将在该小区内部署M个边缘缓存节点(FAP)、E个基站(BS)以及K个随机分布的用户终端(FUE)。其中,该小区内多个FAP组成了FAP集合,即![]() 类似的,该小区内多个BS和多个FUE分别组成了BS集合和FUE集合,即

类似的,该小区内多个BS和多个FUE分别组成了BS集合和FUE集合,即![]() 和

和![]() 该小区的半径为dBS,边缘缓存节点到用户的最远通信距离和D2D用户的最远通信距离分别为dFAP和dFUE。假定该小区内每个边缘缓存节点FAP具有相同的存储容量,同时云计算中心存储着F个流行的内容文件,其内容文件集合可以表示为

该小区的半径为dBS,边缘缓存节点到用户的最远通信距离和D2D用户的最远通信距离分别为dFAP和dFUE。假定该小区内每个边缘缓存节点FAP具有相同的存储容量,同时云计算中心存储着F个流行的内容文件,其内容文件集合可以表示为![]() 该小区的用户不仅可以相互共享自己缓存的文件,还可以从基站和边缘缓存节点获取他们感兴趣的内容文件。

该小区的用户不仅可以相互共享自己缓存的文件,还可以从基站和边缘缓存节点获取他们感兴趣的内容文件。

图1 基于F-RAN架构的协作式内容缓存模型

Fig.1 Collaborative content caching model based on The F-RAN architecture

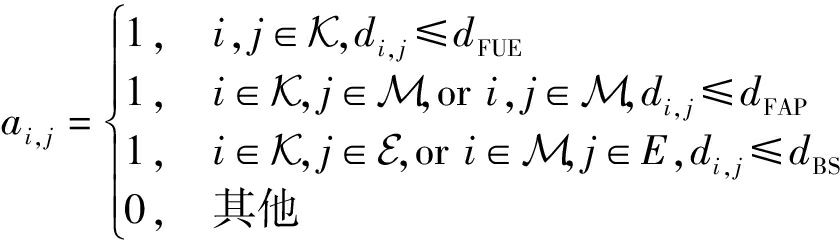

如图1所示,首先,该小区内的网络设备需要从云计算中心下载并且缓存内容文件,然后将其缓存的内容文件在基站(BS)、边缘缓存节点(FAP)和移动用户(FUE)三者之间共享。针对网络设备之间的关系问题,本文引入矩阵A来表示网络设备之间的拓扑关系,其数学表达式为A=[ai, j](K+M+E)×(K+M+E),i和j表示该小区内的所有网络设备[7]。若移动用户FUE i到FUE j之间的通信距离小于或者等于dFUE时,则矩阵A中的ai, j=1;反之,若移动用户FUE i到FUE j之间的通信距离大于dFUE时,则矩阵A中的ai, j=0。类似的,边缘缓存节点之间的通信距离与dFAP之间的关系和基站之间的通信距离与dBS之间的关系也满足上述约束条件,则ai, j的数学表达式为

(1)

其中di, j代表NE i和NE j之间的通信距离。

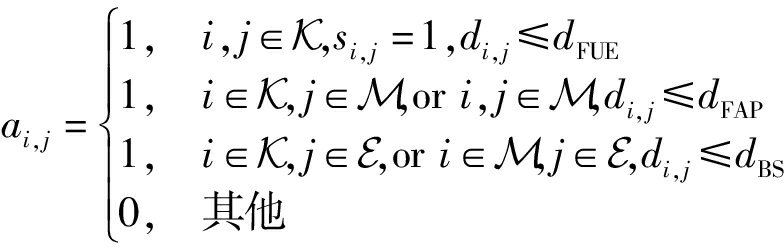

然而,在日常生活中,某些移动用户在基站和边缘缓存节点下载并且缓存自己需要的内容文件的同时,却自私的不愿意同其他移动用户分享自己缓存的内容文件。因此,本文引入矩阵S=[si, j]K×K,该矩阵S表示移动用户同其他移动用户共享自身存储内容文件的行为,则si, j的数学表达式为

(2)

综上所述,结合移动用户之间共享自身存储内容文件的行为,如果si, j=1且ai, j=1,则ai, j=1;反之,则ai, j=0。则网络之间的拓扑关系可更新为

(3)

为了描述不同网络设备的存储能力,本文用缓存命中率来表示缓存文件的性能,也就是说用缓存命中率来衡量缓存策略的有效性。即用户在有限的时间范围内获得内容请求文件的平均概率,用变量P表示,其数学表达式为

(4)

其中,参数gk表示FUE k发送请求内容文件的概率;pk, f=P(f|k)表示FUE k请求文件f的条件概率;![]() pk, f≤1且pk, f∈[0,1];参数ci, f表示内容文件f是否被NE i缓存在本地的状态。

pk, f≤1且pk, f∈[0,1];参数ci, f表示内容文件f是否被NE i缓存在本地的状态。

2.2 问题描述

考虑到每个网络设备有限的存储容量,本文以最大化缓存命中率为目标函数,网络设备之间的通信距离为约束条件构建内容缓存优化问题,其优化问题的数学表达式为

(5)

![]()

(5a)

(5b)

(5c)

其中,Bf表示缓存文件f的大小,Lk、LFAP和LBS分别表示FUE k、边缘缓存节点和基站存储容量的大小。根据该内容缓存优化问题可以看出,参数gk、pk, f和ci, f三者之间彼此耦合,因此该内容缓存优化问题是NP-hard问题,即该内容缓存优化问题的目标函数在其约束条件下得不到最优解。

为了解决上述所提出的内容缓存优化问题,本文首先采用用户偏好预测和内容流行度预测的方法来获得缓存概率矩阵P,然后结合基站之间的相关度矩阵B,最后利用Q-learning算法获得最优缓存状态矩阵H,从而解决了上述内容缓存优化问题的目标函数在其约束条件下得不到最优解的问题,得到了最优化缓存命中率。

3 基于Q-learning的协作式内容缓存策略

3.1 用户偏好预测

所谓用户偏好就是指用户对物品(可能是电影、美食、商品等)的喜欢程度[8]。在本文中,用户偏好表示的是在用户发送请求的条件下,每个文件被请求的概率。然而,在现实生活中,用户对于某个或某些物品的喜欢程度与时间相关联的,不同时间段内用户对于特定物品的喜欢程度也就不同。因此,FUE端通常利用用户偏好预测的方法得到最大化缓存命中率。

主题模型是一种对用户偏好进行预测的方法,它不仅能对文字中隐含的主题进行建模,还能够有效地解决文档之间语义相似度的问题[9]。因而,本文采用主题模型对用户偏好进行预测,它包括四种主题模型,分别是无监督的、无层次结构的主题模型、无监督的、有层次结构的主题模型、监督的、无层次结构的主题模型和监督的、有层次结构的主题模型[10]。

虽然文献[5]中利用PLSA模型有效地预测用户偏好,但是该模型不能在新文档中确定主题的分布以及其模型参数是随着文档数目的变化而变化的。而本文使用LDA模型来估计用户偏好,它可以将文档集中每篇文档的主题以概率的形式给出,从而通过分析一些文档抽取到它们的主题分布后,便可以根据主题分布进行主题聚类或文本分类。该模型是在文献[5]中模型的基础上,为主题和词的分布分别添加了两个狄利克雷先验分布,解决了PLSA模型的不足之处,即本文使用的模型没有将文档-主题作为模型参数,为文档-主题分布增加了先验分布,限制其整体上文档的主题分布以及对于新的文档能准确的确定其主题的分布。

为了有效的在FUE端预测用户的偏好,本文引入用户偏好矩阵U,该矩阵U=[pk, f]K×F,它代表该小区内FUE端所有用户的偏好。在LDA模型中,假设每一个文件有且只有一个主题,多个文件的主题构成主题集合![]() 即

即![]() 表示在该小区内FUE k发送请求的概率。P(zi|k)表示在该小区内FUE k选择主题zj的条件概率;P(f|zj)表示在该小区内FUE k选择主题zj中文件f的条件概率。在上述主题模型中,以上参数的初始值可以从历史矩阵N中获取,该历史矩阵N=[nk, f]K×F中获得,其中矩阵中参数nk, f表示有限时间内FUE k请求文件f的总数。

表示在该小区内FUE k发送请求的概率。P(zi|k)表示在该小区内FUE k选择主题zj的条件概率;P(f|zj)表示在该小区内FUE k选择主题zj中文件f的条件概率。在上述主题模型中,以上参数的初始值可以从历史矩阵N中获取,该历史矩阵N=[nk, f]K×F中获得,其中矩阵中参数nk, f表示有限时间内FUE k请求文件f的总数。

综上所述,在该小区内,FUE k请求文件f的联合概率为

(6)

(7)

(8)

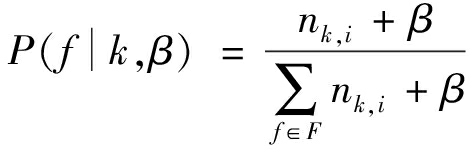

其中gk∈G,且G表示该小区内所有用户请求文件的概率矩阵,α、β是根据经验得出来的先验参数,Φ、Θ隐含狄利克雷分布的参数。

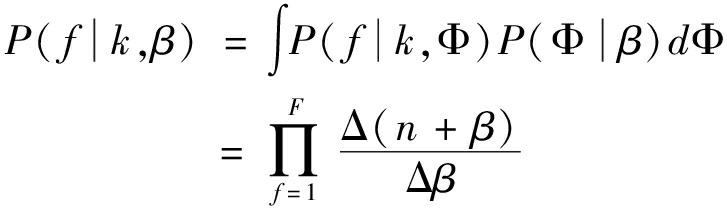

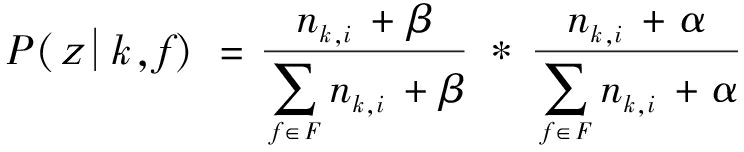

在LDA主题模型中,为了该算法收敛,本文采用吉布斯抽样(Gibbs Sampling)估计上述式子的未知参数,则该主题变量的后验概率为

(9)

其中P(f|k,β)和P(f|α)分别为:

(10)

(11)

在获取联合概率P(k, f)和用户请求概率gk之后,用户偏好pk, f可以通过pk, f=P(k, f)/gk得到,其算法的计算复杂度为ν。

3.2 内容流行度预测

在该小区内,用户偏好在一定程度上表示移动用户自身的喜好,而边缘缓存节点和基站端所考虑的是F-RAN架构下所有移动用户的共同偏好。因此,本文用内容流行度表示该小区内所有的边缘缓存节点和基站的共同偏好。

内容流行度就是指在某段时间内内容文件被请求的概率。从目前研究来看,内容流行度的数学模型主要有两种,即部分匹配预(Prediction by Partial Match,PPM)模型和Zipf分布流行度模型[11]。在日常生活中,内容流行度的预测普遍采用Zipf分布流行度模型进行分析和计算。然而,该分布流行度模型在实际运用中并没有考虑到小区内网络设备的通信范围等因素。因此,本文采用用户偏好矩阵U和网络拓扑关系矩阵A来预测内容流行度的变化,以此来获得该小区内不同边缘缓存节点和基站的共同偏好。

为了描述小区内不同边缘缓存节点和基站的内容流行度,本文引入内容流行度矩阵C,该矩阵C=[pj, f](M+E)×F,其中矩阵C中变量pj, f的数学表达式为

(12)

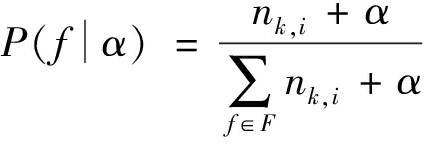

其中![]() 表示两个移动网络设备之间的通信距离的权重,用数学表达式表示为

表示两个移动网络设备之间的通信距离的权重,用数学表达式表示为

(13)

其中,参数λ表示F-RAN架构中系统预定义的两个移动网络设备之间的最小通信距离。

在内容流行度的预测阶段,其算法的计算复杂度为(M+E)*F。

3.3 基于Q-learning的协作式内容缓存算法

Q-learning算法既是强化学习中的一种值迭代算法,又是强化学习中的一种时序差分算法。Q-learning算法中状态表示环境的数据,动作表示智能体可以做出的动作。即由一个状态s描述的环境![]() 是所有可能状态的集合)和一个能够执行动作a的智能体

是所有可能状态的集合)和一个能够执行动作a的智能体![]() 是所有可能动作的集合),智能体所执行的动作会导致智能体从某一个状态转移到另一个状态。其算法的主要思想是利用状态和动作建立一张Q表,用来存储在某一时刻的状态下采取某个动作而获得收益的Q值,然后根据获得的Q值来选取能够获得最大收益的动作[12]。该算法的优点可以通过时间差分的方法进行离线学习,采用贝尔曼方程可以求解出马尔可夫过程的最优解。

是所有可能动作的集合),智能体所执行的动作会导致智能体从某一个状态转移到另一个状态。其算法的主要思想是利用状态和动作建立一张Q表,用来存储在某一时刻的状态下采取某个动作而获得收益的Q值,然后根据获得的Q值来选取能够获得最大收益的动作[12]。该算法的优点可以通过时间差分的方法进行离线学习,采用贝尔曼方程可以求解出马尔可夫过程的最优解。

为了描述小区内网络设备在内容缓存文件的情况,本文引入奖励矩阵R=[ri, j](K+M+E)×(K+M+E)来表示小区内在内容缓存文件时每个网络设备所获取的奖励值。其中,奖励矩阵中参数ri, j的值是由通信链路的选择方式、网络拓扑关系和网络设备之间的通信距离决定的。论文在选取奖励函数时之所以仅仅考虑了通信链路的选择方式、网络拓扑关系和网络设备之间的通信距离,由奖励函数ri, j的计算公式(16)可以看出,当区域内两个网络设备之间的传输距离越大时,其获得的奖励值也就越高;根据内容流行度pj, f的计算公式(12)可以看出,当区域内两个网络设备之间的传输距离越大时,内容流行度也就越高;由缓存命中率P的计算公式(4)可得,当边缘缓存节点和基站的内容流行度越高时,间接性的影响了区域内缓存命中率的大小。

(1)通信链路的选择方式

所谓通信链路,就是指在移动网络中某个节点到相邻节点的物理通道[13]。通常,根据连接方法的不同,通信链路可以分为点对点连接的通信链路和多点间的通信链路;根据通信方式的不同,通信链路可以分为单向通信链路和多项通信链路;根据容量大小的不同,通信链路可以分为有容量通信链路和无容量通信链路。在本文中,通信链路的选择方式有D2D通信链路、BS-FUE通信链路和FAP-FUE通信链路。

在F-RAN架构中,本文将奖励值设置为最高的通信链路的选择方式为D2D通信链路,将奖励值设置为最低的通信链路的选择方式为BS-FUE通信链路,而奖励值介于最低值和最高值之间的通信链路的选择方式为FAP-FUE通信链路。并且,奖励值ri, j的数学表达式为

ri,e=μri,m=γri, j=θ

(14)

其中![]() 且 μ<γ,μ,γ,θ是常数。

且 μ<γ,μ,γ,θ是常数。

(2)网络拓扑关系

若两个移动网络设备可以进行通信,即该网络设备可以建立通信链路,则奖励值ri, j为除零之外的其他值;反之,若两个移动网络设备不能进行通信,即该网络设备不能建立通信链路,则奖励值ri, j的为零。结合表达式(13),奖励值ri, j可以写为

ri, j=ai, j*ri, j

(15)

其中i, j∈[1,K+M+E]。

(3)网络设备之间的通信距离

在内容文件缓存的过程中,网络设备之间的通信距离影响网络设备之间的传输时间[14]。若移动网络设备之间的通信距离越短,则该移动网络设备的传输时间越短;反之,若移动网络设备之间的通信距离越长,则该移动网络设备的传输时间越长。则在该因素下,奖励值ri, j的数学表达式为

ri, j=wi, j*ri, j

(16)

Q表是Q-learning算法的重要组成部分。其行和列分别表示状态(State)和动作(Action),它表示了在当前每一个状态下采取不同动作获取的最高收益值。本文引入矩阵Q表示Q表中的Q值,其数学表达式为Q=[Qi, j](K+M+E)×(K+M+E),该矩阵Q的行和列分别表示当前的状态和当前状态下执行的动作。

对于奖励矩阵R,Qi, j表示为:

Qi, j=ri, j+α*maxQj

(17)

其中α∈[0,1];i, j∈[1,K+M+E]。

基于Q-learning的协作式内容缓存算法的具体步骤如下:

步骤1 在用户偏好的预测阶段,首先,通过历史矩阵N得到![]() 和P(0)(f|α);其次通过公式(9)、公式(10)和公式(11),分别计算出P(i)(z|k, f)、P(i)(f|k,β)和P(i)(f|α);最后,通过公式

和P(0)(f|α);其次通过公式(9)、公式(10)和公式(11),分别计算出P(i)(z|k, f)、P(i)(f|k,β)和P(i)(f|α);最后,通过公式![]() 获得了用户偏好矩阵U和请求概率矩阵G;

获得了用户偏好矩阵U和请求概率矩阵G;

步骤2 在内容流行度阶段,通过公式(12)获得了内容流行度矩阵C;

步骤3 将用户偏好矩阵U和内容流行度矩阵C构成整个系统的缓存概率矩阵P。首先,输入整个系统的缓存概率矩阵P、网络拓扑关系矩阵A以及用户的请求概率矩阵G;其次,通过公式(16)、公式(17)和公式(4)分别得到奖励矩阵R和矩阵Q以及缓存命中率P;最后,获得了缓存状态矩阵H。

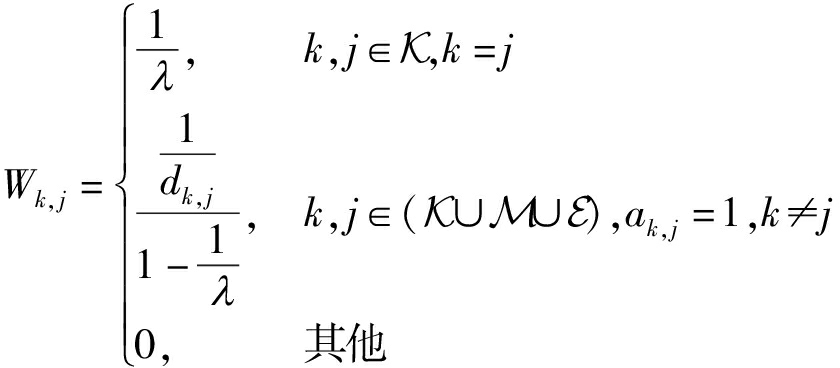

为了提高内容存储空间的利用率和减少内容缓存文件的重复率,本文还考虑了基站之间的协作关系,即基站的空间相关度,它表示在雾无线接入网络中两个基站之间的空间相关度。它是由两个基站之间的距离决定的。若NE i和NE j之间的距离小于等于基站i和基站j之间距离的2倍时,基站的空间相关度为1;否则,若NE i和NE j之间的距离大于基站i和基站j之间距离的2倍时,基站的空间相关度为0。其数学表达式可表示为

(18)

其中,该协作式内容缓存算法中使用基站相关度的条件是:

(1)若该协作式内容缓存策略的缓存设备是基站时,当基站之间的相关度与缓存设备乘积的值小于0,相近的基站能够共享缓存的文件。其数学表达式为

∑e∈Ehs,ece, f<0

(19)

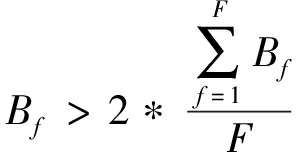

(2)单位文件缓存数量内通信带宽的2倍小于其通信的带宽,其数学表达式为

(20)

为了获得最优缓存策略,本文首先利用用户偏好预测和内容流行度预测的方法来获得缓存概率矩阵P,然后结合基站之间的相关度矩阵B,最后利用Q-learning算法获得最优缓存状态矩阵H,从而实现最大化缓存命中率。

4 仿真结果与分析

为了有效的反映所提出的协作式内容缓存算法的性能,论文考虑的比较算法是D2D内容缓存算法和FAP内容缓存算法。其中D2D内容缓存算法是预先将内容文件缓存到本地终端,当用户发送请求时,内容文件可以从自身携带的终端设备中获取或者从与它相邻或者相近的用户通过D2D链路进行传输;而FAP内容缓存算法是把传统云计算中的内容缓存扩展到网络边缘,通过将流行地内容文件缓存到更靠近用户的边缘节点上,从而降低了通信的时延以及缓解了前传链路的负载压力。基于对D2D内容缓存算法和FAP内容缓存算法的比较,论文所提出的协作式内容缓存算法综合考虑了基站缓存、D2D缓存以及FAP缓存,有效地提高了缓存命中率。

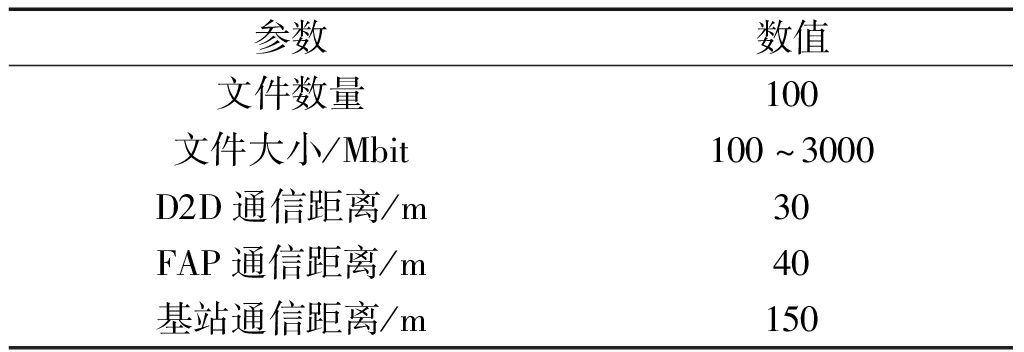

表1 仿真参数

Tab.1 Simulation Parameters

参数数值文件数量100文件大小/Mbit100~3000D2D通信距离/m30FAP通信距离/m40基站通信距离/m150

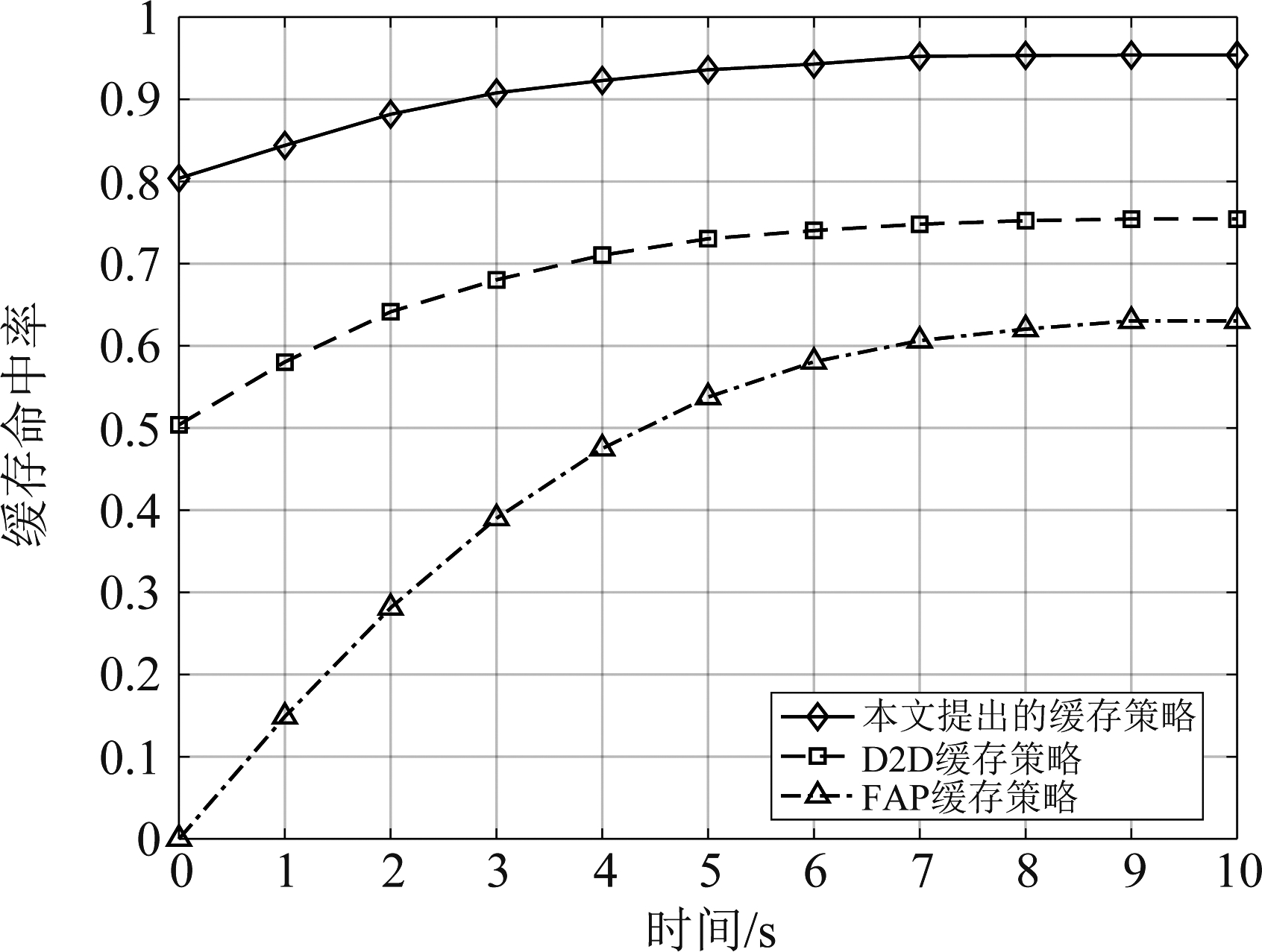

图2描述了在内容缓存阶段三种不同内容缓存算法的性能对比。文件大小的取值范围为[100,3000]Mbit,文件的数量F为100个,D2D内容缓存算法中用户的最大通信距离为30 m,FAP内容缓存算法中边缘缓存节点的最大通信距离为40 m。可以看到,在内容缓存阶段三种内容缓存算法的缓存命中率都随着缓存时间t的增加而增加。与FAP内容缓存算法和D2D内容缓存算法相比,论文所提出内容缓存算法有效地提高了缓存命中率。此外,因为初始阶段用户缓存的内容文件较少,基站内容缓存就会遭遇冷启动问题。所谓冷启动问题就是指在内容缓存的初始阶段,由于用户请求数据的不足,其缓存的内容文件就为零。FAP内容缓存算法和D2D内容缓存算法之所以解决了内容缓存中的冷启动问题,是因为在内容缓存阶段,FAP内容缓存、D2D内容缓存和基站内容缓存具有优先级。当用户发送请求时,首先,在用户所携带的终端设备中缓存被请求的内容文件,即D2D内容缓存;其次,在FAP中缓存被请求的内容文件;最后,在基站中缓存被请求的内容文件。在内容缓存的初始阶段,用户请求的内容文件较少,其被请求的内容文件只会缓存在终端设备和FAP中缓存,而不会在基站中进行缓存。

图2 内容缓存阶段缓存命中率随时间的变化情况

Fig.2 Caching hit rate versus time during the content caching phase

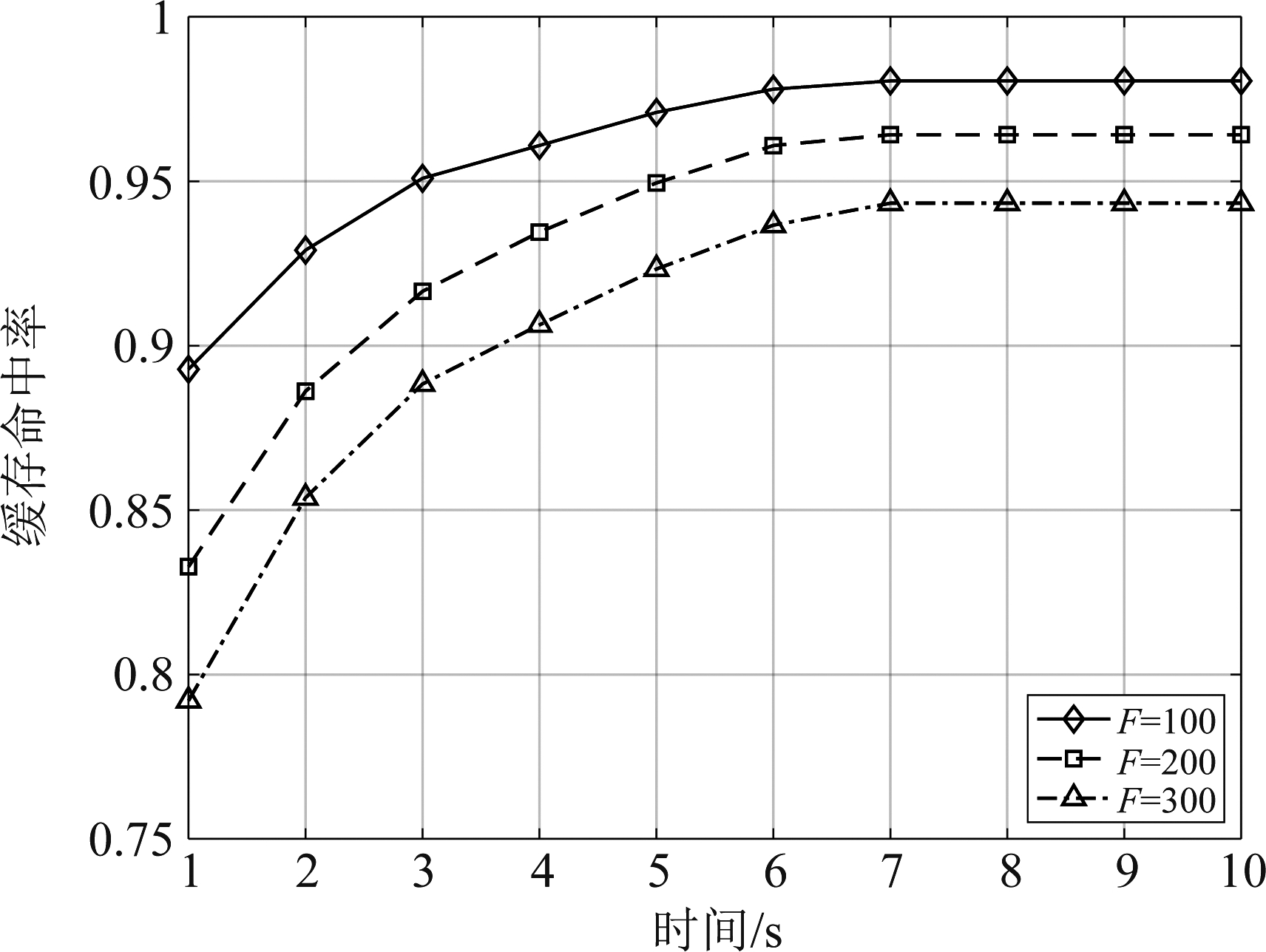

图3描述了在内容缓存阶段,随着文件数量的增加,缓存命中率随着时间的增加而降低。由于基站、边缘缓存节点和FUE端有限的存储容量,当文件的数量增加时,文件的主题数量随之增加,导致用户的偏好也就越多,基站、边缘缓存节点和FUE端缓存的文件的数量越来越多,缓存命中率会随之下降。

图3 文件数量对缓存性能的影响

Fig.3 The impact of the number of files on cache performance

图4描述了在内容缓存阶段,随着用户数量的增加,缓存命中率随着时间的变化而增大。由于用户数量的增加,在文件数量相同的条件下,缓存命中率会随之增加。

图4 用户数量对缓存性能的影响

Fig.4 The impact of user Numbers on cache performance

5 结论

本文提出了一种基于Q-learning的协作式内容缓存策略。首先,本文利用主题模型中LDA模型动态地预测用户偏好;其次,利用已获得的用户偏好和小区内不同网络设备之间的拓扑关系以在线的方式预测内容流行度,然后再结合基站之间的相关度,以减少缓存内容文件的重复率;最后,以最大化缓存命中率为目标,利用强化学习中的Q-learning算法获得了F-AP之间最优的内容缓存策略。仿真结果表明,与已有的内容缓存策略相比,所提出的内容缓存策略能有效的提高内容缓存命中率,提高通信系统的性能。

[1] 马妙丽.雾无线接入网内容流行度预测与边缘缓存方法研究[D].南京: 东南大学, 2018.

MA Miaoli.Research on content popularity prediction and edge caching in fog-ran[D].Nanjing: Southeast University, 2018.(in Chinese)

[2] JIANG Wei, FENG Gang, QIN Shuang, et al.Multi-agent reinforcement learning based cooperative content caching for mobile edge networks[J].IEEE Access, 2019, 7: 61856-61867.

[3] LI Qi, WANG Xiaoxiang, WANG Dongyu.Optimal D2D cooperative caching system in SDN based wireless network[C]∥2019 IEEE 30th Annual International Symposium on Personal, Indoor and Mobile Radio Communications(PIMRC).Istanbul, Turkey.IEEE, 2019: 1-7.

[4] JIANG Yanxiang, MA Miaoli, BENNIS M, et al.User preference learning-based edge caching for fog radio access network[J].IEEE Transactions on Communicatio-ns, 2019, 67(2): 1268-1283.

[5] CHEN Bingqiang, YANG Chenyang.Caching policy for cache-enabled D2D communications by learning user preference[J].IEEE Transactions on Communications, 2018, 66(12): 6586-6601.

[6] JIANG Fan, YUAN Zeng, SUN Changyin, et al.Deep Q-learning-based content caching with update strategy for fog radio access networks[J].IEEE Access, 2019, 7: 97505-97514.

[7] YANG Zhong, LIU Yuanwei, CHEN Yue.Q-learning for content placement in wireless cooperative caching[C]∥2018 IEEE Global Communications Conference(GLOBECOM).Abu Dhabi, United Arab Emirates.IEEE, 2018: 1-6.

[8] LI Yao, ZHANG Tiankui, XU Xiaogeng, et al.Content popularity and node level matched based probability caching for content centric networks[C]∥2016 IEEE/CIC International Conference on Communications in China(ICCC).Chengdu, China.IEEE, 2016: 1-6.

[9] LIN Xiaoyong, MA Jie, ZHANG Zeqiu, et al.CPC: A novel content popularity compensation algorithm for intelligent wireless router in user centric network[C]∥2017 12th International Conference on Intelligent Systems and Knowledge Engineering(ISKE).Nanjing, China.IEEE, 2017: 1-6.

[10] HONG J P.Content popularity-based caching techniques for wireless content delivery[C]∥2015 International Conference on Information and Communication Technology Convergence(ICTC).Jeju, Korea(South).IEEE, 2015: 1300-1302.

[11] GUO Kaiyang, YANG Chenyang, LIU Tingting.Caching in base station with recommendation via Q-learning[C]∥2017 IEEE Wireless Communications and Networking Conference(WCNC).San Francisco, CA, USA.IEEE, 2017: 1-6.

[12] WANG Shanfeng, GONG Maoguo, QIN Can, et al.A multi-objective framework for location recommendation based on user preference[C]∥2017 13th International Conference on Computational Intelligence and Security(CIS).Hong Kong, China.IEEE, 2017: 39-43.

[13] ZHANG Lingyan, WANG Shangguang, WONG R K, et al.Cognitively adjusting imprecise user preferences for service selection[J].IEEE Transactions on Network and Service Management, 2017, 14(3): 717-729.

[14] LONG Yunfei, LU Qin, XIAO Yue, et al.Domain-specific user preference prediction based on multiple user activities[C]∥2016 IEEE International Conference on Big Data(Big Data).Washington, DC, USA.IEEE, 2016: 3913-3921.