1 引言

随着社交媒体和互联网中多模态数据(图像、文本、语音、视频等)的爆炸式增长,跨模态检索受到学术界和工业界的广泛关注。跨模态检索作为近年来人工智能领域热门研究话题之一,旨在于度量不同模态数据之间的内容的相似性。在跨模态检索过程中,由于不同模态的数据在特征空间的分布不同,如何消除异构鸿沟成为跨模态检索领域一个亟待解决的问题。

在信息检索领域中,哈希方法由于检索速度较快、检索精度较高而备受研究者青睐。在跨模态检索中,哈希方法可以将高维的不同模态数据映射到统一的汉明空间,进而对不同模态的数据进行相似性度量,从而解决异构鸿沟的问题。在这些基于哈希的跨模态检索方法中,大致可以分为两类:1)基于浅层特征的方法,2)基于深层特征的方法。

其中,基于浅层特征的方法是通过浅层结构进行手工特征提取,如:集体矩阵分解哈希(Collective Matrix Factorization Hashing, CMFH)[1]、跨视角哈希(Cross View Hashing, CVH)[2]、语义相关最大化(Semantic Correlation Maximization,SCM)[3]、语义保留哈希(Semantics-preserving Hashing, SePH)[4]都采用的是手工提取的浅层特征进行研究。

伴随着深度学习在计算机视觉各个领域的不断发展并取得重大研究进展,如车辆追踪[5]、图像分割[6]、人脸识别[7]、图像检索[8]、行人/车辆再识别等[9-11]。同时,越来越多研究证明了采用深层卷积神经网络抽取到的特征能更好地对各种类型多模态数据进行表示,因此也被广泛应用到跨模态检索。

基于深度学习的深度哈希方法通过卷积神经网络将不同模态的数据映射成统一的哈希码,在汉明空间通过汉明距离进行相似性度量。其中代表性的工作包括Jiang等人[12]提出一种深度跨模态哈希方法(Deep Cross Modal Hashing,DCMH),采用卷积神经网路进行特征提取,设计了一个端到端的深度学习网络,将特征提取和哈希码学习整合到一个统一的框架内,获得了不错的效果。随后Yang[13]等人提出了一种成对关系深度哈希,在DCMH的基础上,通过减小产生哈希码之间的相关性,提高了跨模态检索的性能。Cao等人[14]提出一种名为深度视觉语义哈希方法(Deep Visual-semantic Hashing,DVSH),采用卷积神经网络(Convolutional Neural Network,CNN)和长短期记忆网络(Long Short-Term Memory,LSTM)分别学习不同模态的共同表征,取得了不错的效果。Zhen[15]等人提出一种深度监督跨模态检索方法,设计了三个不同角度的损失函数,使得网络能够产生更具判别性的哈希码,有效地提升了跨模态检索的性能。Wang等人[16]提出了一种基于深度卷积神经网络(Convolutional Neural Network, CNN)和神经语言模型(Neural Language Model, NLM)的多模态深度神经网络(Multi-modal Deep Neural Network,MDNN),分别学习图像模态和文本模态的映射函数,进而在统一的空间进行相似性度量,从而实现跨模态检索任务。然而上述方法仅使用高层特征进行图像的语义表征,忽视了不同尺度特征之间的语义相关性,具有一定的局限性。

为了解决上述问题,本文提出一种基于特征金字塔融合表征网络的跨模态哈希检索方法。该方法的主要创新点如下所述:

1)为了挖掘更丰富的语义关联,建立更精确的模态关系,在网络上我们提出一种新的多尺度特征融合模型。

2)不同于大多数的方法,本文方法不仅保留了固有的模态一致性关系,还充分利用了模态特有的特征,得到了更具代表性的表征。

3)在损失函数的设计上,设计了三重损失函数,模态间损失,模态内损失和汉明空间损失对模型进行监督学习。

实验结果表明本文所提方法可以有效地提升跨模态检索的准确性。

本文剩余的部分安排如下:第2节介绍本文所提出的算法;第3节进行实验结果分析;第4节给出结论。

2 所提方法

2.1 问题描述

作为跨模态检索最经典的应用场景,不失一般性,本算法只考虑图像和文本两个模态。假设数据集中含有n组数据,我们用![]() 表示数据集中所有样本;其中oi表示第i个样本点每个样本点包含图像和文本两个模态特征,用oi={Xi,Yi}表示,其中

表示数据集中所有样本;其中oi表示第i个样本点每个样本点包含图像和文本两个模态特征,用oi={Xi,Yi}表示,其中![]() 表示的图像模态的特征,

表示的图像模态的特征,![]() 表示文本模态的特征。另外我们给出S作为相似性矩阵,其中Si, j=1表示第i个样本与第j个样本相似,即至少拥有一个相同的类标签,否则Si, j=0。

表示文本模态的特征。另外我们给出S作为相似性矩阵,其中Si, j=1表示第i个样本与第j个样本相似,即至少拥有一个相同的类标签,否则Si, j=0。

跨模态哈希检索的网络模型,是利用X、Y和S学习图像模态的哈希函数hi(x)和文本模态的哈希函数ht(y),使得具有相同语义的文本和图像之间的汉明距离最小,而不同语义的图像和文本之间的汉明距离尽可能大。若令Bi(xi)=hi(xi)为第i个图像实例的哈希码,Bt(yj)=ht(xj)为第j个文本实例的哈希码,则有Si, j=1时,Bi(xi)和Bt(yj)的距离尽可能最小,相反Si, j=0时,其距离最大。

2.2 网络模型

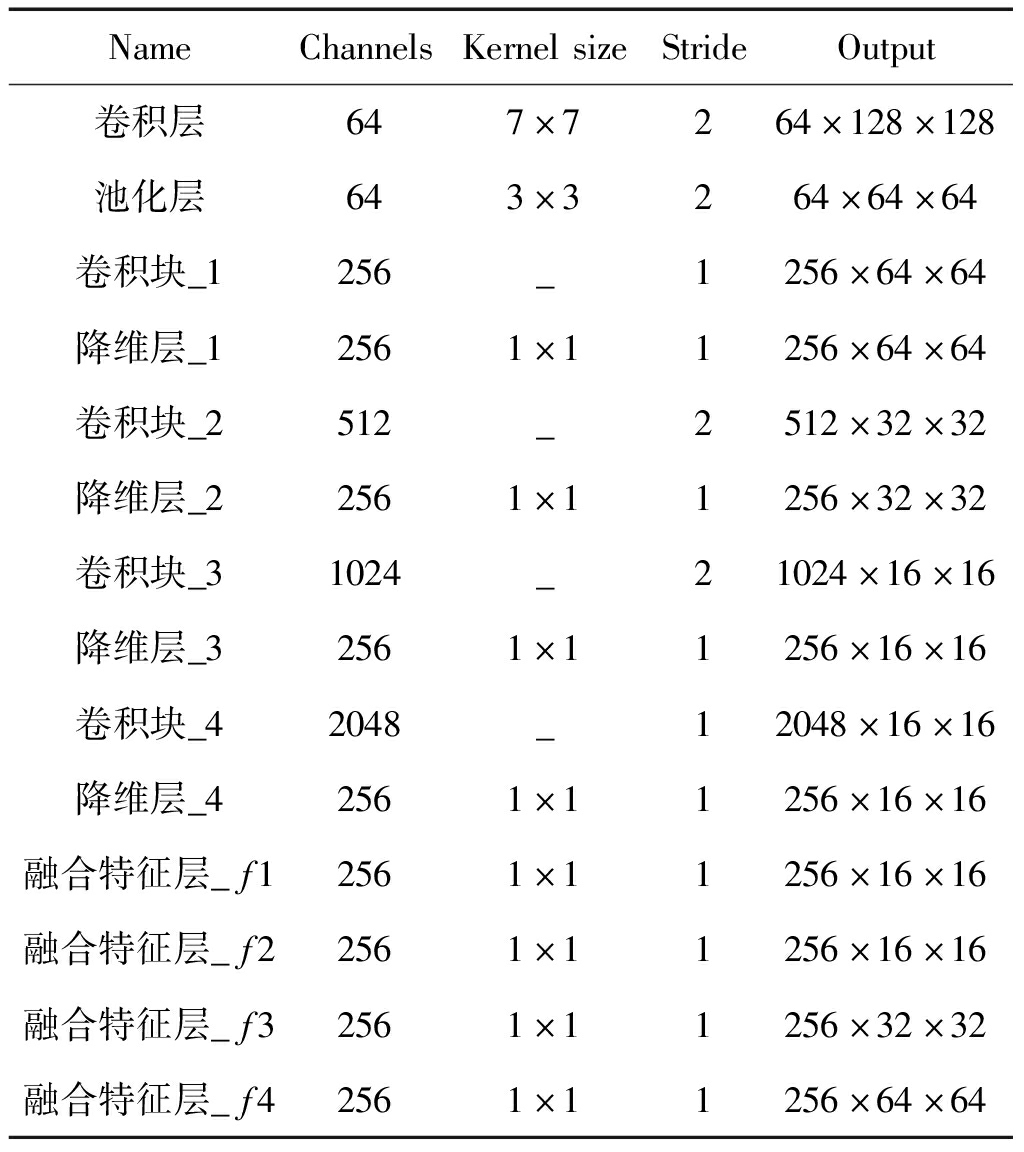

本文所提方法的基本流程图如图1所示:首先采用设计的图像和文本子网络提取模态独有特征,紧接着分别映射到公共表征空间和汉明空间进行训练学习。

2.2.1 图像特征提取网络

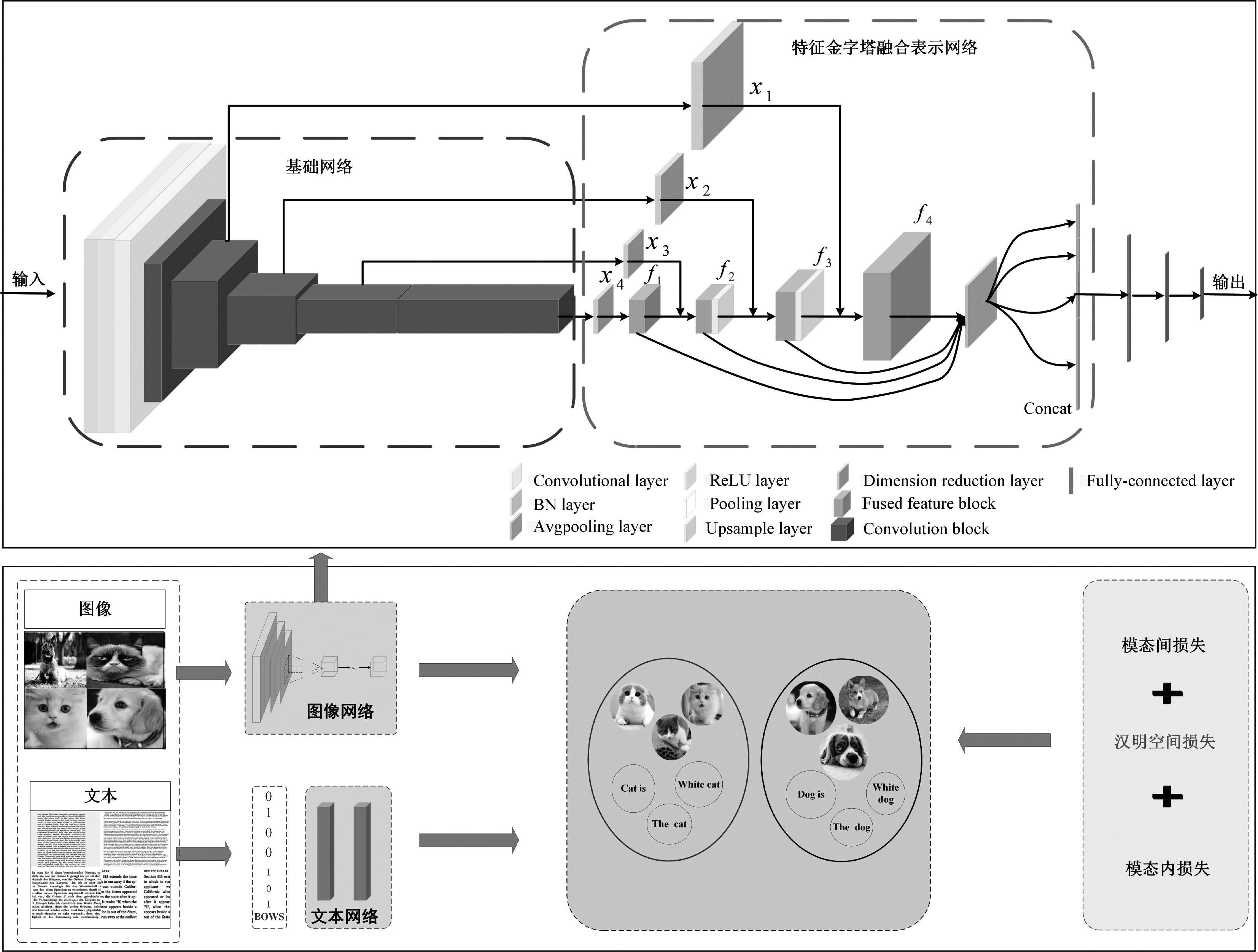

在图像特征学习部分,以ResNet-50[17]作为基础提取网络,如图1所示,使用的基础提取网络由卷积层、BN层、ReLU激活层、池化层、全连接层和四个卷积块组成。具体地,每个卷积块由不同数量的残差块组成。对于每个残差块,其输出包含先前(即较低)残差块的输出,因此,它具有组合输入图像的浅层特征和深层特征的能力。需要指出的是,在这里基础提取网络中的全连接层被两个全连接层和一个哈希映射层所取代;第一个全连接层具有1024个单位的神经元,第二个全连接层具有128个单位的神经元。哈希映射层具有K个神经元用来产生K位的哈希码,其中K为哈希码的长度。特征金字塔融合表征网络的详细参数如表1所示。具体而言,通过基础提取网络,在不同深度提取的特征自然对应于输入图像的多尺度信息,即不同层次的语义信息。即在基础网络顶部的图像具有较高的分辨率,但是语义信息较少,而在网络底部的图像具有较低的分辨率,但是语义信息较丰富。为了充分利用所提取的多尺度特征描述,本文设计一种金字塔特征融合表示方案,通过将来自基础网络不同深度的图像特征重构并集成在一起,以形成更全面的更具有代表性的特征。该方法从不同分辨率和不同深浅度的语义信息的角度全面地描述图像的特征。如图1所示,底层卷积块4首先经过降维操作以产生特征x4,然后将特征x4与由较高层卷积块3产生的特征x3相加,该特征x3也用降维操作来执行。重复地,对需要融合的图像块进行连续上采样,并将其添加到先前的融合特征中。因此,所有卷积块的语义信息和分辨率信息以金字塔的方式融合在一起,因此被称为金字塔特征融合表征网络。

表1 所提模型的网络参数

Tab.1 The network parameters of the proposed model

NameChannelsKernelsizeStrideOutput卷积层647×7264×128×128池化层643×3264×64×64卷积块_1256_1256×64×64降维层_12561×11256×64×64卷积块_2512_2512×32×32降维层_22561×11256×32×32卷积块_31024_21024×16×16降维层_32561×11256×16×16卷积块_42048_12048×16×16降维层_42561×11256×16×16融合特征层_f12561×11256×16×16融合特征层_f22561×11256×16×16融合特征层_f32561×11256×32×32融合特征层_f42561×11256×64×64

图1 所提方法的整体框图

Fig.1 The framework of the proposed method

金字塔特征表示可以用数学公式描述如下:

Fn=σ(Wn*xn+bn)n=1,2,3,4

(1)

fn=F5-n+upsample(fn-1)n=2,3,4

(2)

f1=F4

(3)

其中Fn指的是特征块,该特征块是由卷积块上的降维操作产生的。W和b分别表示权重和偏差,*是卷积运算,σ表示激活函数。Upsample()表示目标的上采样操作。但是对于具有目标尺度的要素,无需执行上采样操作。fn指的是上述金字塔融合之后所有深度的特征块。进一步通过考虑融合的卷积块之间的相关性,对获得的金字塔特征表示进行联合,以输出多维特征(即64×64、32×32、16×16)。为了减少计算量,通过Avgpooling层分别合并了四个重构的特征块,以获得二维特征向量。最后,将四个二维特征向量拼接在一起以共同表示图像特征。

2.2.2 文本特征提取网络

对于文本特征学习部分,首先文本用词袋(Bag of Words,BoW)模型抽取出词袋向量,作为网络的输入。模态特征提取网络采用两个具有全连接层的深度神经网络,具体配置信息是:其中第一层的神经元个数为8192,第二层神经元个数为哈希码的比特位数,第一层的激活函数采用ReLU(Rectified Linear Unit),第二层采用恒等函数作为激活函数。

2.3 损失函数的构建

我们令![]() 表示数据点i的学习图像特征,其对应于图像模态的特征金字塔融合表征网络的输出。此外,让

表示数据点i的学习图像特征,其对应于图像模态的特征金字塔融合表征网络的输出。此外,让![]() 表示数据点j的已获取的文本特征,其对应于文本模态的深层神经网络的输出。这里,θx是图像模态的深度神经网络需要学习的网络参数,而θy是文本模态的深层神经网络的网络参数。

表示数据点j的已获取的文本特征,其对应于文本模态的深层神经网络的输出。这里,θx是图像模态的深度神经网络需要学习的网络参数,而θy是文本模态的深层神经网络的网络参数。

为了优化上述所提的网络模型,本文采用如下损失函数:

![]()

γ(‖B-F![]() +‖B-G

+‖B-G![]() )+η(‖F1

)+η(‖F1![]() +‖G1

+‖G1![]() )

)

(4)

其中![]() 即为

即为![]() 即为G*j=g(yj;θy)分别代表网络提取的图像特征和文本特征,

即为G*j=g(yj;θy)分别代表网络提取的图像特征和文本特征,![]() 是图像模态和文本模态生成的哈希码,n为批处理的大小。γ和η是超参数,论文中均为1。

是图像模态和文本模态生成的哈希码,n为批处理的大小。γ和η是超参数,论文中均为1。

公式(4)中的第一项![]() 是依据似然函数定义的跨模态相似性的负对数似然函数,用于使网络生成的深度图像特征和深度文本特征保持跨模态的语义相似性,其函数定义如下:

是依据似然函数定义的跨模态相似性的负对数似然函数,用于使网络生成的深度图像特征和深度文本特征保持跨模态的语义相似性,其函数定义如下:

(5)

其中![]() 因此,最小化这个负对数似然性可以使F*i和G*j之间的相似性在Si, j=1时变大,在Si, j=0时变小。因此,优化公式(4)中第一项可以使图像特征表示F和文本特征表示G的跨模态相似性得以保留。同理

因此,最小化这个负对数似然性可以使F*i和G*j之间的相似性在Si, j=1时变大,在Si, j=0时变小。因此,优化公式(4)中第一项可以使图像特征表示F和文本特征表示G的跨模态相似性得以保留。同理![]() 和

和![]() 分别用来优化图像模态内和文本模态内的相似性。通过优化(4)中的第二项γ(‖B-F

分别用来优化图像模态内和文本模态内的相似性。通过优化(4)中的第二项γ(‖B-F![]() +‖B-G

+‖B-G![]() ),我们可以得到图像、文本特征的统一的哈希表示。公式(4)中的第三项η(‖F1

),我们可以得到图像、文本特征的统一的哈希表示。公式(4)中的第三项η(‖F1![]() +‖G1

+‖G1![]() )用于使哈希码的每一位在所有训练点上平衡。更具体地说,通过公式(4)中第三项使得所有训练点上每一位+1和-1的数量趋近相同,达到平衡。由公式(4)我们看出利用此目标函数通过随机梯度下降学习得到θx、θy以及B。

)用于使哈希码的每一位在所有训练点上平衡。更具体地说,通过公式(4)中第三项使得所有训练点上每一位+1和-1的数量趋近相同,达到平衡。由公式(4)我们看出利用此目标函数通过随机梯度下降学习得到θx、θy以及B。

3 实验结果及分析

3.1 数据集及评价指标

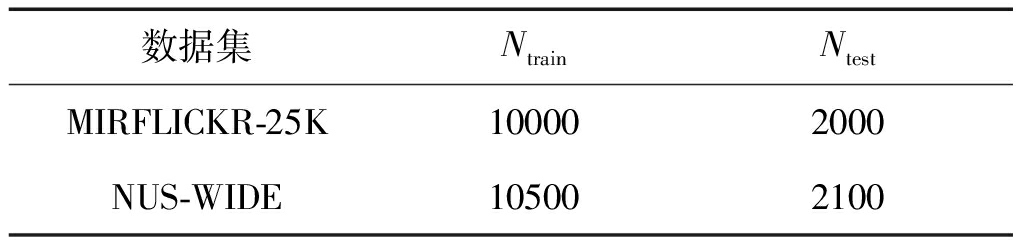

为了证明本文所提方法的有效性,我们分别在MIRFLICKR-25K数据集和NUS-WIDE数据集进行测试。

MIRFLICKR-25K[18]数据集共包含25000图片,每张图片又分别对应一个或多个文本标签,因此每一对可以看作一个图像文本对。数据总共分为24类,我们选择其中至少包含20个文本标签的样本用于实验。每一张图像还有人为标注的唯一的分类信息。每一对样本的文本特征由1386维的词袋向量表征。

NUS-WIDE[19]数据集是一个多标签的数据集。它包含260648张来自81个类别的图片,且每一张图片都对应一个或多个文本标签。这些文本标签和图像构成了图像文本对。我们选择样本充足的20类进行实验。文本特征由1000维的词袋向量表示。

表2 数据集中训练样本和测试样本数

Tab.2 Number of training samples and test samples in the data set

数据集NtrainNtestMIRFLICKR-25K100002000NUS-WIDE105002100

实验评估方面,我们采用跨模态检索研究中广泛使用的性能评估标准--平均精度均值(Mean Average Precision, MAP)[21-22]和Top-K-精度曲线(Top-K Precision Curve)两种评价指标对算法的有效性进行评估。在我们的实验中,我们研究了两种不同的跨模态检索任务的比较方法的mAP:1)使用图像查询(I→T)检索文本样本,以及2)使用文本查询(T→I)检索图像样本。

3.2 训练配置

本文实验是在Windows Server 2012系统的PyTorch框架上完成的,显卡配置是NVIDIA的GeForce GTX 1080Ti。网络模型训练采用随机梯度下降策略,初始学习率大小设定为0.001,γ=η=1,批量数据大小为64个样本。

3.3 性能比较

本文与多种跨模态哈希检索算法进行比较,包括DCMH[12]、SePH[4]、CMFH[1]、SCM[3]和CCA[20]。其中,CCA、SCM与CMFH算法采用手工提取的特征如颜色、纹理、SIFT[23]等作为图像特征,其余两种算法均采用深度卷积神经网络作为特征提取的手段。

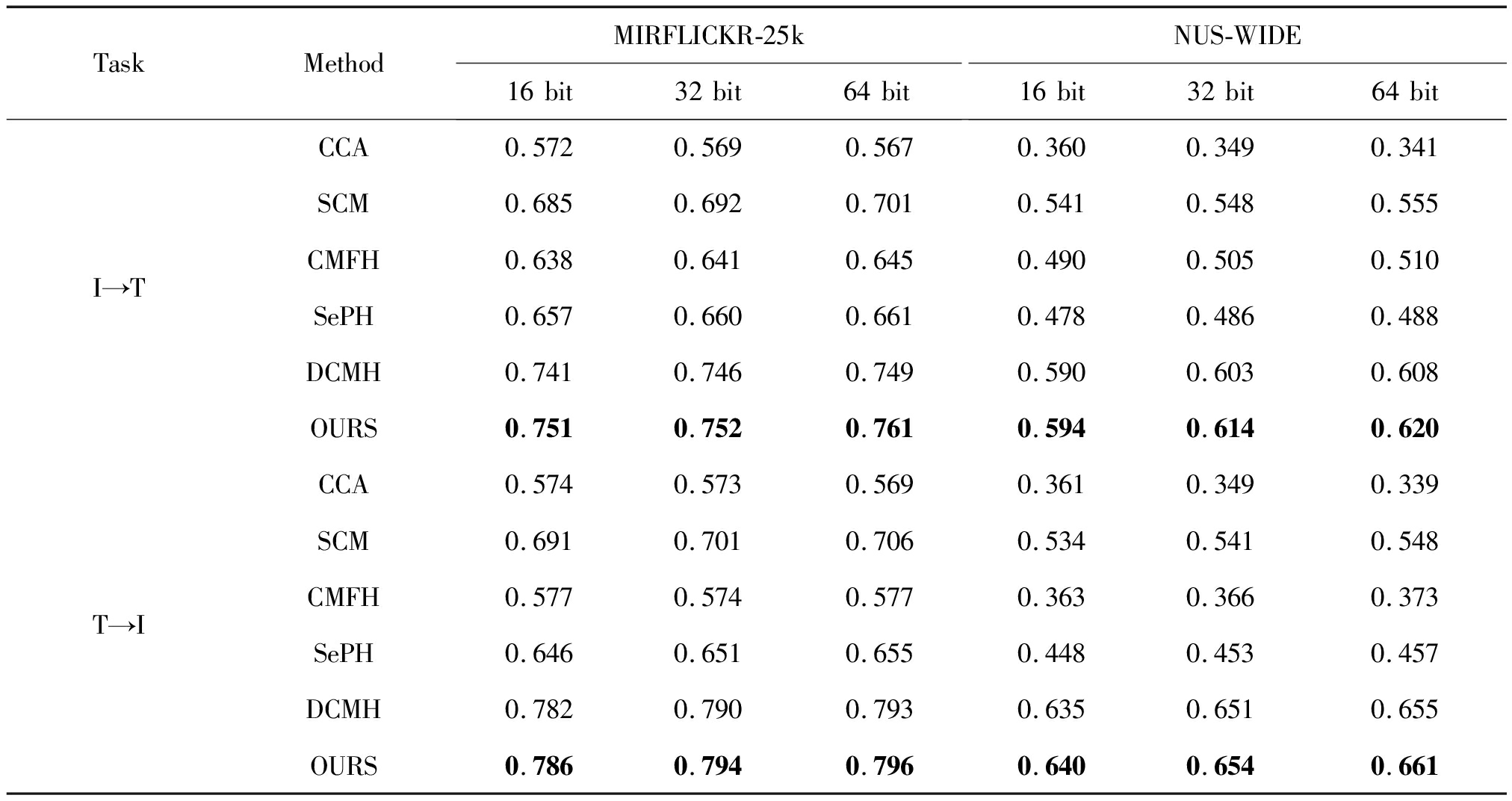

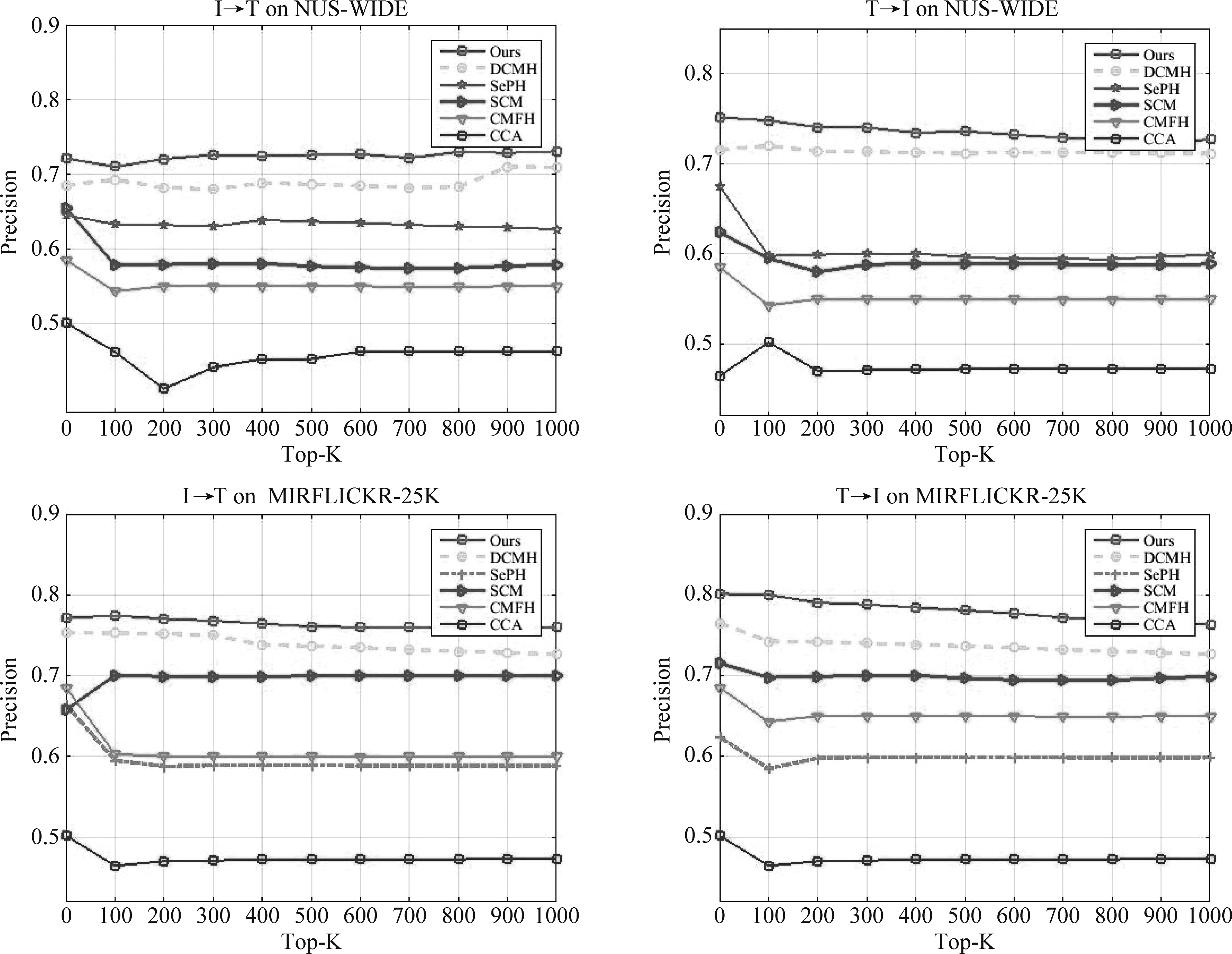

表3展示了所提算法与其他五种算法在两个跨模态数据集上的MAP值比较。图2展示了在两个数据集上16位哈希码的Top-K-精度曲线图。从表3和图2可以看出,提出的特征金字塔融合表征网络由于联合了上下文语义信息,得到更具代表性的语义表征信息,使得所提方法在检索性能上优于其他方法。其中CCA、SCM方法采用手工提取的特征,MAP值和Top-K曲线最低。DCMH作为较早将深度学习应用于跨模态特征提取的研究,其MAP优于采用手工特征的方法。但是,DCMH方法忽视了不同尺度特征的语义相关性,因此在检索性能上,我们的方法优于DCMH。

表3 在两个公开跨模态数据库中的MAP结果比较

Tab.3 Comparison in terms of MAP Values in two public cross-modal databases

TaskMethodMIRFLICKR-25k16bit32bit64bitNUS-WIDE16bit32bit64bitI→TCCA0.5720.5690.5670.3600.3490.341SCM0.6850.6920.7010.5410.5480.555CMFH0.6380.6410.6450.4900.5050.510SePH0.6570.6600.6610.4780.4860.488DCMH0.7410.7460.7490.5900.6030.608OURS0.7510.7520.7610.5940.6140.620T→ICCA0.5740.5730.5690.3610.3490.339SCM0.6910.7010.7060.5340.5410.548CMFH0.5770.5740.5770.3630.3660.373SePH0.6460.6510.6550.4480.4530.457DCMH0.7820.7900.7930.6350.6510.655OURS0.7860.7940.7960.6400.6540.661

图2 两数据集上Top-K-精度曲线

Fig.2 Precision top-K curves on two datasets

此外,我们还发现,随着哈希码长度的增长, 大多数算法的MAP值在增加。其原因可归结为两点,1)更长的哈希码使得图像和文本特征能够更好的匹配。2)更长的哈希码能够保存更加丰富的细节信息,更利于图像的精准检索。表3中,通常情况下I→T的检索性结果低于T→I,这是因为相对于图像,文本能够包含更纯粹的语义信息,能够更准确直接地刻画图像内容,因此,T→I可以取得更好的结果。

4 结论

本文提出了一种基于特征金字塔融合表征网络的跨模态哈希方法。所提方法通过设计特征金字塔融合表征网络提取具有多种层次不同尺度的语义信息,并进行联合表征,从而更加精确地学习哈希映射关系,进一步通过损失函数构建将特征学习和哈希码学习进行联立,有效弥合了跨模态检索中的异构鸿沟,提高了检索准确率。实验结果表明,本文所提方法优于多种现有跨模态哈希方法。

[1] DING Guiguang, GUO Yuchen, ZHOU Jile.Collective matrix factorization hashing for multimodal data[C]∥2014 IEEE Conference on Computer Vision and Pattern Recognition(CVPR).Columbus, OH, USA, 2014: 2083-2090.

[2] KUMAR S, UDUPA R.Learning hash functions for cross-view similarity search[C]∥Twenty-Second International Joint Conference on Artificial Intelligence.2011: 1360-1365.

[3] ZHANG Dongqing, LI Wujun.Large-scale supervised multimodal hashing with semantic correlation maximization[C]∥National Conference on Artificial Intelligence, 2014: 2177-2183.

[4] LIN Zijia, DING Guiguang, HU Mingqing, et al.Semantics-preserving hashing for cross-view retrieval[C]∥2015 IEEE Conference on Computer Vision and Pattern Recognition(CVPR).Boston, MA, USA.IEEE, 2015: 3864-3872.

[5] XIA Shuyin, LIU Yunsheng, DING Xin, et al.Granular ball computing classifiers for efficient, scalable and robust learning[J].Information Sciences, 2019, 483: 136-152.

[6] LIU Chenxi, CHEN Liang-Chieh, SCHROFF F, et al.Auto-Deeplab: Hierarchical neural architecture search for semantic image segmentation[C]∥2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition(CVPR).Long Beach, CA, USA.IEEE, 2019: 82-92

[7] DENG Jiankang, GUO Jia, XUE Niannan, et al.Arcface: Additive angular margin loss for deep face recognition[C]∥2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition(CVPR).Long Beach, CA, USA.IEEE, 2019: 4685-4694.

[8] ZHU Jie, WU Shufang, ZHU Hong, et al.Multi-center convolutional descriptor aggregation for image retrieval[J].International Journal of Machine Learning and Cybernetics, 2019, 10(7):1863-1873.

[9] 沈飞,朱建清,曾焕强,等.面向目标再辨识的空间和通道双重显著性挖掘算法[J].信号处理,2020,36(9):1471-1480.

SHEN Fei, ZHU Jianqing, ZENG Huanqiang, et al.Double saliency mining algorithm of space and channel for target re-identification[J].Journal of Signal Processing,2020,36(9):1471-1480.(in Chinese)

[10] 赵师亮,吴晓富,张索非.基于PCB特征加权的行人重识别算法[J].信号处理,2020,36(8):1300-1307.

ZHAO Shiliang,WU Xiaofu,ZHANG Suofei.Pedestrian re-recognition algorithm based on PCB feature weighting[J].Journal of Signal Processing,2020,36(8):1300-1307.(in Chinese)

[11] 尹梓睿,张索非,张磊,等.适于行人重识别的二分支EfficientNet网络设计[J].信号处理,2020,36(9):1481-1488.

YIN Zhirui,ZHANG Suofei,ZHANG Lei,et al.Two-branch EfficientNet network design suitable for pedestrian re-identification[J].Journal of Signal Processing,2020,36(9):1481-1488.(in Chinese)

[12] JIANG Qingyuan, LI Wujun.Deep Cross-modal hashing[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition(CVPR).Honolulu, HI, USA.IEEE, 2017: 3270-3278.

[13] YANG E, DENG Cheng, LIU Wei, et al.Pairwise relationship guided deep hashing for cross-modal retrieval[C]∥AAAI Conference on Artificial Intelligence, 2017:1618-1625.

[14] CAO Yue, LONG Mingsheng, WANG Jianmin, et al.Deep visual-semantic hashing for cross-modal retrieval[C]∥Proceedings of the 22nd ACM SIGKDD International Conference on Knowledge Discovery and Data Mining.San Francisco California USA.New York, NY, USA: ACM, 2016: 1445-1454.

[15] ZHEN Liangli, HU Peng, WANG Xu, et al.Deep supervised cross-modal retrieval[C]∥2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition(CVPR).Long Beach, CA, USA.IEEE, 2019: 10386-10395.

[16] WANG Wei, YANG Xiaoyan, B.C.OOI, et al.Effective deep learning-based multi-modal retrieval[J].The VLDB Journal, 2016, 25(1):79-101.

[17] HE Kaiming, ZHANG Xianyu, REN Shaoqing, et al.Deep residual learning for image recognition[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition(CVPR).Las Vegas, NV, USA.IEEE, 2016: 770-778.

[18] HUISKES M J, LEW M S.The MIR flickr retrieval evaluation[C]∥Proceedings of the 1st ACM international conference on Multimedia information retrieval-MIR′08.Vancouver, British Columbia, Canada.New York: ACM Press, 2008: 39-43.

[19] CHUA T S, TANG Jinhui, HONG Richang, et al.NUS-WIDE: a real-world web image database from National University of Singapore[C]∥CIVR′09: Proceedings of the ACM International Conference on Image and Video Retrieval.2009: 1-9.

[20] HOTELLING H.Relations between two sets of variates[M]∥Springer Series in Statistics.New York, NY: Springer New York, 1992: 162-190.

[21] FENG Fangxiang, WANG Xiaojie, LI Ruifan.Cross-modal retrieval with correspondence autoencoder[C]∥Proceedings of the 22nd ACM international conference on Multimedia.Orlando Florida USA.New York, NY, USA: ACM, 2014:7-16.

[22] PENG Yuxin, HUANG Xin, QI Jinwei.Cross-media shared representation by hierarchical learning with multiple deep networks[C]∥IJCAI′16: Proceedings of the Twenty-Fifth International Joint Conference on Artificial Intelligence, 2016: 3846-3853.

[23] LOWE D G.Distinctive image features from scale-invariant keypoints[J].International Journal of Computer Vision, 2004, 60(2): 91-110.