1 引言

在视频检索、人机交互、安全监控等[1-3]领域,人体行为识别受到了研究界和工业界的极大关注。大量研究学者在基于RGB视频序列的人体行为识别上取得不错的进展[4],但计算成本高且易受到光照和背景噪声干扰的问题仍没有彻底解决。近年来,随着高性价比的深度相机的普及和人体姿势估计技术的进步,使得人体骨架数据获取的更加容易。与使用RGB视频序列进行识别的传统过程相比,基于人体骨架的行为识别对光照、视角、颜色和遮挡等影响因素有很强的鲁棒性,更加简洁的数据包含了三维的时空信息,因而受到越来越多的关注。

传统人体骨架行为识别的方法主要集中于用手工制作的特征来表示骨架序列,并根据关节轨迹进行分类[5-7]。早期深度学习的方法应用于人体骨架行为识别研究,是将骨架序列重新排列为向量序列和伪图像,并将其输入到循环神经网络[8-10]或卷积神经网络[11]中。Yan等人[12]首次将图卷积网络应用到骨架序列的建模中,通过设计表征人体拓扑结构的邻接矩阵,一定程度上提高了网络对骨架数据的建模能力。Shi等人[13]利用非局部操作计算不同关节的相关性,并结合骨骼信息构建双流网络,实现邻接矩阵的自适应生成和不同模态数据的信息互补。Li等人[14]分别对行为动作和骨架结构的依赖关系进行建模,通过生成人体姿态进一步提升识别效果。Zhang等人[15]将关节的语义信息引入网络,摆脱骨架结构构建邻接矩阵的束缚,增强了特征的表达能力。

上述基于图卷积网络的方法相对于传统方法和其他深度学习方法体现出更明显的优势,但仍存在不足:(1)已有模型对时空特征的提取不充分;(2)缺乏对全局上下文信息的捕捉能力,在对人体先验知识的权衡上灵活性不足。

针对上述问题,本文以加强对时空特征的捕捉以及关节间的全局上下文信息的提取为出发点,同时考虑人体先验知识在不同时期对识别效果的影响,提出一种基于时空注意力机制和自适应图卷积网络的人体骨架行为识别方法(Spatio-Temporal Attention Mechanism and Adaptive Graph Convolutional Network,STAM-AGCN)。本方法构建基于非局部操作的空间注意力模块和时间注意力模块,并融合形成可嵌入的时空注意力模块;此外,利用高斯嵌入函数计算关节间的相似度,结合轻量级卷积神经网络捕捉通道维度的上下文信息,生成自适应邻接矩阵,并与代表人体结构的邻接矩阵以一种动态的方式结合;最后,从原始骨架数据提取关节信息和骨骼信息,与其各自的运动信息组合成双流网络分支,再将两个分支进行融合得到最终的结果。

2 时空注意力模块

一段骨架序列包含了时间域和空间域的全部信息,但只有与动作相关的区域是值得关注的,大量与动作无关的信息视为冗余信息,影响识别效果。注意力机制能选择性的关注图像或序列的关键部分,而忽略不相关的信息[16]。必须指出的是:(1)单独在空间域或时间域加入注意力机制等同于假设序列中的不同帧或每一帧的不同关节对于动作识别是同样重要的,这显然不是最优的。(2)注意力机制对嵌入位置敏感,易于出现难以优化的问题[17]。

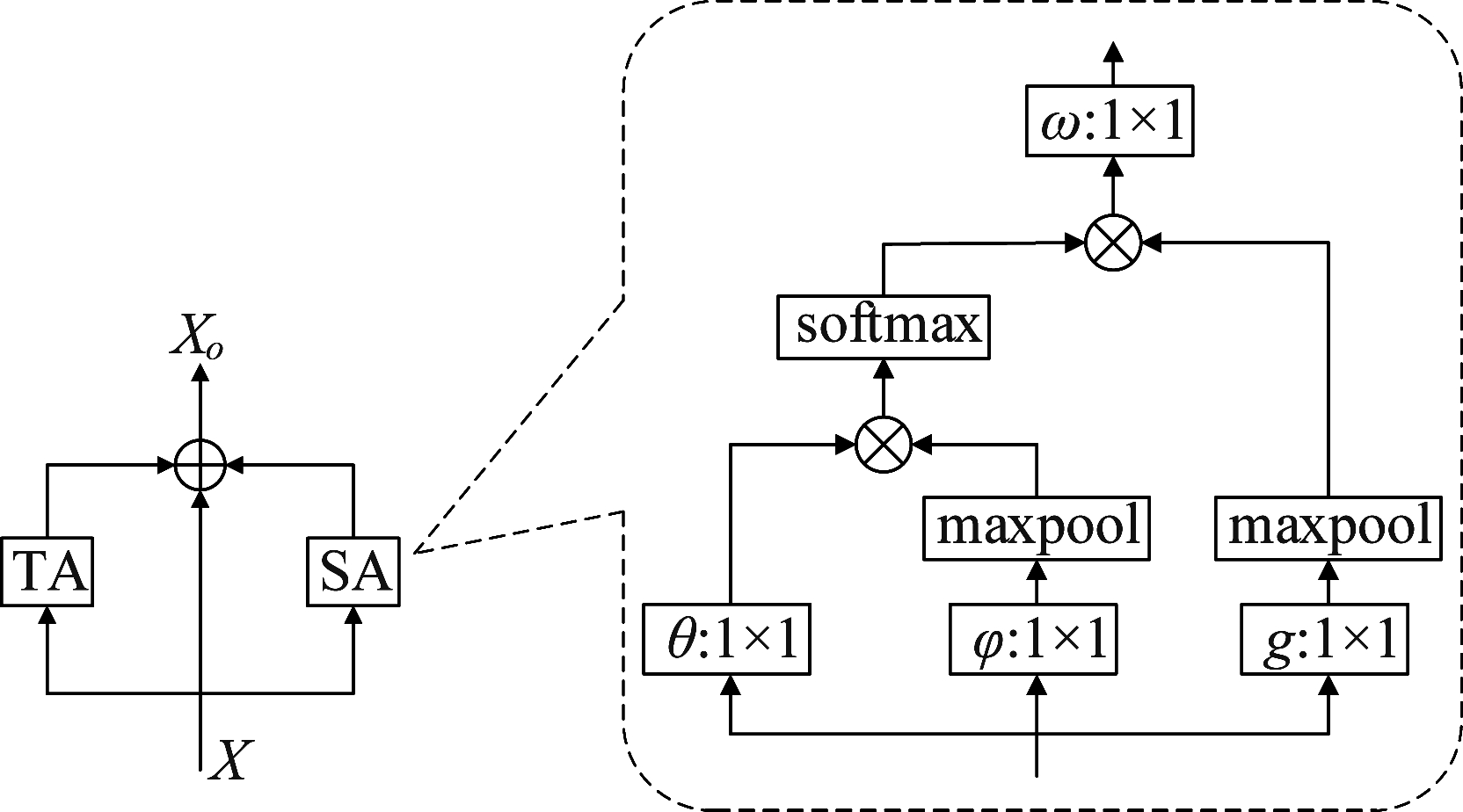

基于上述,提出一种可嵌入的时空注意力机制,旨在辅助模型关注最具判别性的关节和帧,削弱冗余信息对识别效果的影响。时空注意力模块如图1所示,包含一个空间注意力模块和时间注意力模块,分别捕捉帧内关节和帧间关节的相关性,并与输入特征进行相加融合。值的注意的是,时空注意力模块输出特征的维度和输入相同,该模块能够方便的嵌入任何卷积层之间。

图1 时空注意力模块

Fig.1 Spatio-Temporal attention module

Wang等人[18]受到非局部均值的启发提出非局部神经网络,非局部操作能够捕捉任意两个位置之间的长依赖关系,而忽略距离的影响。本文利用非局部操作分别捕捉帧内关节和帧间关节的相关性。为更清晰地阐述时空注意力模块,将其结构划分为以下步骤:

步骤1 在不考虑训练批次的情况下,输入特征X的维度为C×T×N,其中C、T、N分别对应通道、帧和关节的数目,将空间注意力模块的输入特征表示为![]() 即

即![]()

步骤2 将输入特征嵌入到高斯函数(θ和φ)中计算两个关节的相关性,并对每一个关节进行加权:

(1)

其中,![]() 和

和![]() 分别是关节i和关节j的特征;函数g是一个一元函数,即

分别是关节i和关节j的特征;函数g是一个一元函数,即![]() 是可学习参数;函数f是一个高斯函数:

是可学习参数;函数f是一个高斯函数:

(2)

其中,![]() 归一化因子

归一化因子![]() 为了降低计算成本,在函数φ和g之后添加2×2的最大池化层。

为了降低计算成本,在函数φ和g之后添加2×2的最大池化层。

步骤3 通过函数ω使加权结果的维度与输入保持一致,得到维度为C×T×N的空间注意力信息:

(3)

步骤4 将时间注意力模块的输入特征表示为![]() 即

即![]() 重复步骤2~3得到时间维度的注意力信息

重复步骤2~3得到时间维度的注意力信息![]() 与空间注意力信息和输入特征融合得到时空注意力信息:

与空间注意力信息和输入特征融合得到时空注意力信息:

(4)

生成的时空注意力信息oi的维度和输入特征相同,均为C×T×N。

3 自适应图卷积网络

3.1 时空图卷积网络

在一段骨架序列中,空间维度是每一帧的关节和自身的连接构成空间图,时间维度是相邻两帧之间对应关节构成时间边缘。时空图卷积网络[12]将空间图表示成根节点与相邻的节点的集合组成的邻接矩阵A∈{0,1}N×N,其中N代表关节数。假定第n层输入特征为Xn,输出特征为Xn+1,图卷积计算如下式所示:

(5)

其中⊙代表点积,Wk是权重,Kmax设置为3,代表最大距离。![]() 是归一化邻接矩阵,且

是归一化邻接矩阵,且![]() 这里α设置为0.001是为了避免空值。对于每一个邻接矩阵,都乘以一个可学习的掩码矩阵Mk。对于时间维度,将图卷积网络的输出Xn+1通过Kt×1的卷积层,这里Kt是时间维度的卷积核大小。

这里α设置为0.001是为了避免空值。对于每一个邻接矩阵,都乘以一个可学习的掩码矩阵Mk。对于时间维度,将图卷积网络的输出Xn+1通过Kt×1的卷积层,这里Kt是时间维度的卷积核大小。

3.2 自适应图卷积网络

图卷积网络的邻接矩阵代表了图的拓扑结构,矩阵中的值代表了不同关节依赖关系。必须要指出的是:(1)时空图卷积网络的邻接矩阵是根据人体的物理结构设计的,这种预定义式的邻接矩阵缺乏关节间全局上下文信息的捕捉能力。(2)代表人体物理结构的邻接矩阵提供了人体的先验知识,在训练早期能辅助模型收敛到全局最优[19]。

基于上述,为了在提取关节间的全局上下文信息的同时充分利用人体的先验知识,提出了自适应图卷积网络。第n层自适应图卷积网络可以表示为:

(6)

其中,Xn、Xn+1和Wk的含义和式(5)相同。自适应邻接矩阵包含三个部分:

(1)Ak是和式(5)中![]() 相同的邻接矩阵,λ是随着训练轮次的增大而逐渐降低的比例系数。在训练早期利用Ak提供的先验知识对网络进行指导,而在训练的后期降低它的影响能提供更大的灵活性。

相同的邻接矩阵,λ是随着训练轮次的增大而逐渐降低的比例系数。在训练早期利用Ak提供的先验知识对网络进行指导,而在训练的后期降低它的影响能提供更大的灵活性。

(2)Bk是与式(5)中Mk作用相同的掩码矩阵。

(3)Ck是仅靠数据驱动生成的邻接矩阵,用于捕捉全局上下文信息。

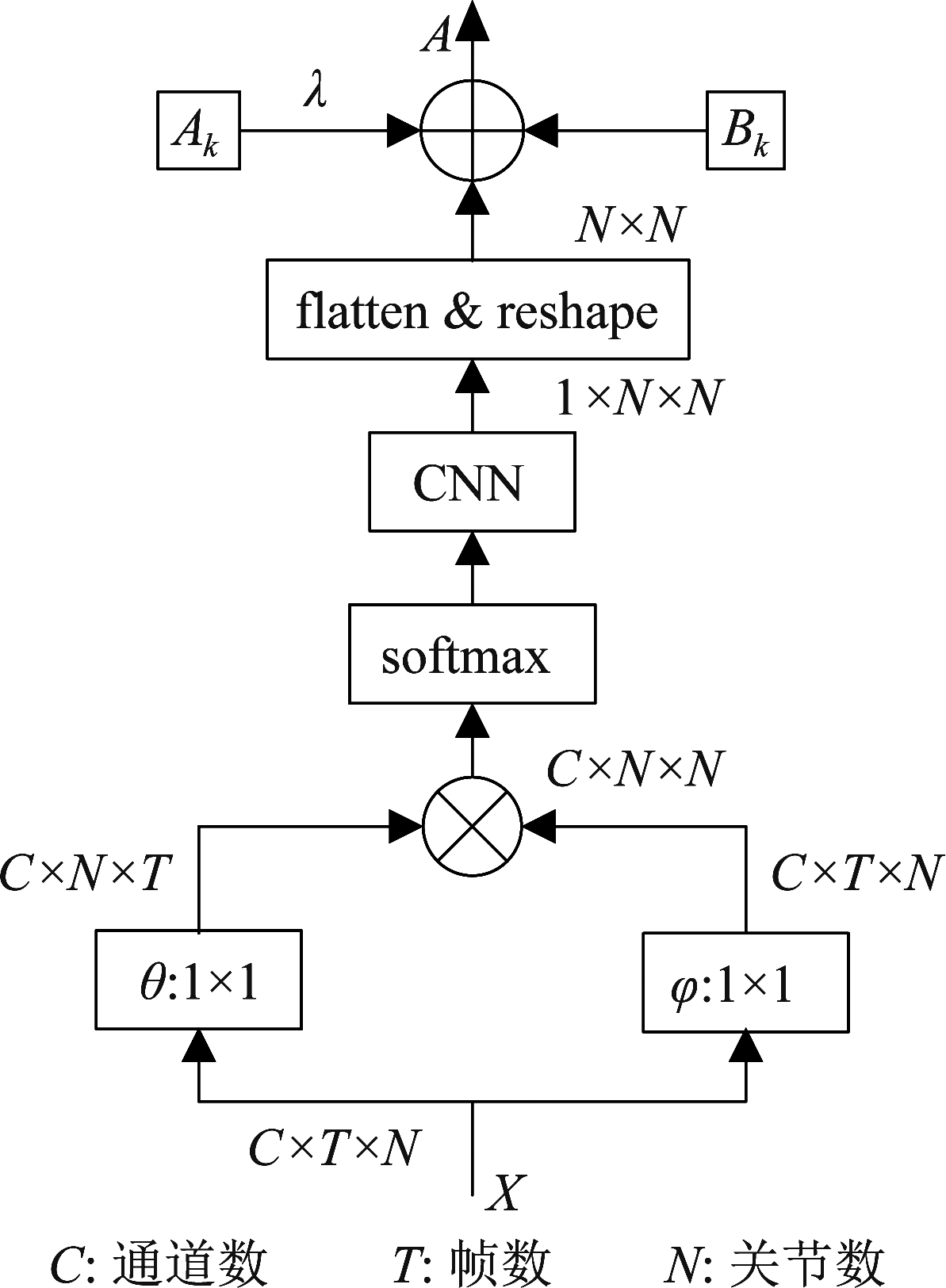

自适应邻接矩阵的网络结构如图2所示。主要步骤为:

图2 自适应图卷积网络

Fig.2 Adaptive graph convolutional network

步骤1 在不考虑训练批次的情况下,输入特征X的维度为C×T×N,分别对应通道数、帧数和关节数;

步骤2 将输入特征映射到嵌入函数θ和φ计算关节相关性,经矩阵相乘和归一化得到C×N×N形状的相关性矩阵;

步骤3 将相关性矩阵通过一个输出通道为1的1×1卷积,聚合通道维度的上下文信息,经形状变换后得到维度为N×N的邻接矩阵Ck;

步骤4 将λAk、Bk和Ck按相加的方式融合为自适应邻接矩阵。

与2s-AGCN[13]相比,上述自适应图卷积网络在高斯嵌入函数后加入一个轻量级卷积神经网络,并在融合Ak时加入了动态的比例系数λ。高斯嵌入函数具有计算关节相似度的能力,但不能有效地捕捉关节间的全局上下文信息,卷积神经网络能够融合通道维度的信息,其优秀的特征聚合能力弥补了这一缺点。动态比例系数λ的加入,可以使代表人体先验知识的原始邻接矩阵仅作用于训练的早期阶段,增加了该自适应图卷积网络的灵活性。

3.3 双流网络

原始骨架序列只包含了关节点的2D/3D坐标,作为骨架数据的关节信息。为了获取更多的识别信息,提高网络对不同动作的识别能力,从关节信息中分别提取骨骼信息、关节的运动信息和骨骼的运动信息。骨骼信息是另一种空间信息,不仅包含长度信息,还包含方向信息。t帧的关节Jt的骨骼信息表示为![]() 即靠近骨架重心的源关节点指向远离重心的目标关节点的向量。运动信息能区分不同动作的细微差别,比如“站起来”和“坐下”,仅使用关节信息和骨骼信息难以区分。运动信息定义为相邻两帧之间的坐标差,即关节的运动信息表示为

即靠近骨架重心的源关节点指向远离重心的目标关节点的向量。运动信息能区分不同动作的细微差别,比如“站起来”和“坐下”,仅使用关节信息和骨骼信息难以区分。运动信息定义为相邻两帧之间的坐标差,即关节的运动信息表示为![]() 骨骼的运动信息表示为

骨骼的运动信息表示为![]()

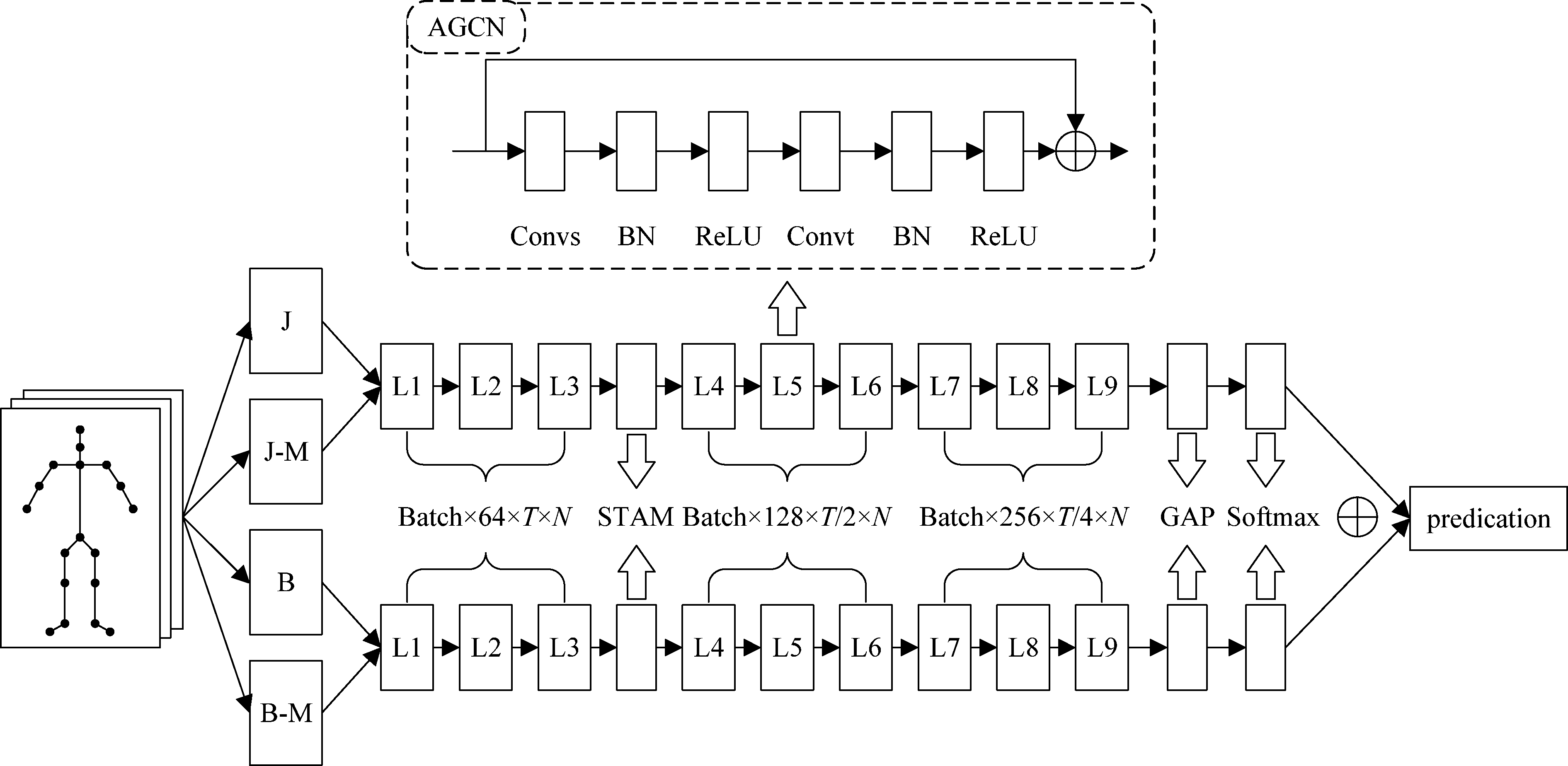

融合空间信息和时间信息能完整的表达人体的行为特征[20]。在数据处理部分,将关节信息和骨骼信息分别与其运动信息在通道维度上进行融合。假定关节信息和其运动信息的维度均为C×T×N,融合后得到维度为2C×T×N的关节流输入;同样,骨骼信息和其运动信息融合为相同维度的骨骼流输入。图3是STAM-AGCN的整体网络框架,骨架序列在输入到网络之前被提取出关节信息(J)、骨骼信息(B)和其各自的运动信息(J-M和B-M),分别融合后汇入不同的网络分支。每个网络分支包含9个AGCN块,分别对应图中L1至L9,其输出通道维度分别对应64,64,64,128,128,128,256,256,256,并在L4和L7中对帧数进行一次下采样。每个AGCN块由自适应图卷积和时间卷积串联组成,输出特征分别通过了归一化层和ReLU层,STAM块嵌入在AGCN块之间,相邻AGCN块之间引入ResNet机制,提高网络的稳定性。每个网络分支训练出单独的模型,融合得到最终的预测结果。

图3 双流网络模型

Fig.3 Two-stream network model

4 实验结果与分析

4.1 实验数据集

NTU RGB+D[21]数据集:共有56880个动作片段,包含60个动作类,每个片段最多有两人,每个人包含25个关节的3D坐标。该数据集有两种评价方式:(1)跨表演人(X-Sub),将来自20个受试者的40320个动作片段用于训练,其余20个受试者的动作片段用于测试。(2)跨视角(X-View):由摄像机2和摄像机3拍摄的37920个动作片段用于训练,摄像机1拍摄的18960个动作片段用于测试。

Kinetics[22]数据集:该数据集取自YouTube的视频片段,大约有30万个片段,每个片段大概有10 s,总计包含400个动作类别。但是该数据集并没有提供原始视频的骨架序列,yan等人[12]利用OpenPose[23]工具箱从中提取出单人18个关节的2D坐标和置信度得分,并将约24万个片段用于训练,约2万个片段用于测试。由于从YouTube收集视频的多样性,该数据集比NTU RGB+D数据集更具挑战性。

4.2 实验配置

实验中,NTU RGB+D数据集采用统一每个序列300帧,Kinetics数据集统一每个序列150帧。深度学习框架为PyTorch1.5,优化策略采用随机梯度下降(stochastic gradient descent,SGD),单次参加训练的样本数(Batch size)为32,总的轮次(Epoch)设置为50。前30个迭代次数的学习率设置为0.1,之后降低为0.01。比例系数λ初始为1,每隔两个轮次减少0.1,直至为0。所有模型由一块NVIDIA Tesla P100完成。

4.3 实验结果分析

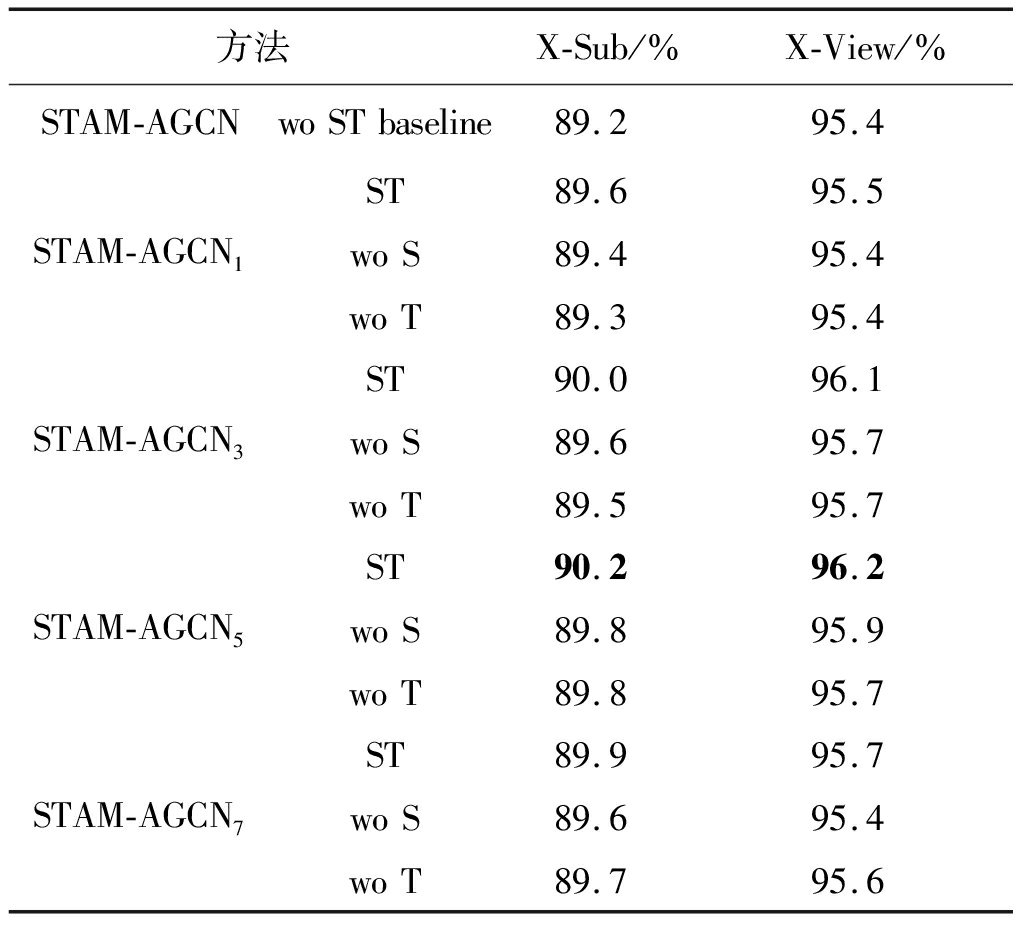

4.3.1 时空注意力机制对比实验

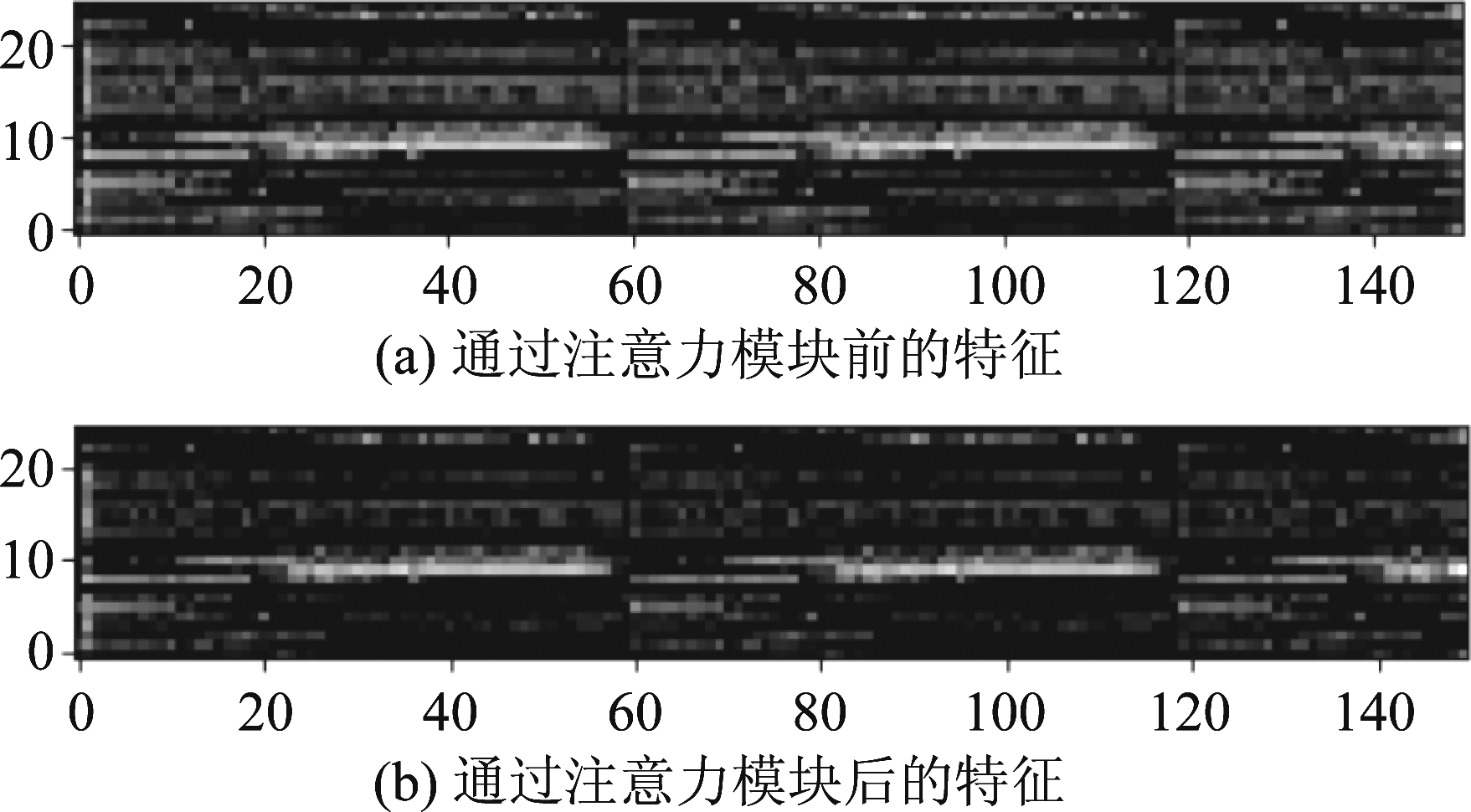

为验证时空注意力模块能否提升网络对时空信息的提取能力,在NTU RGB+D数据集的两种协议下进行了实验对比,具体实验结果如表1所示。分别在第1、3、5、7层之后添加空间注意力模块、时间注意力模块或者时空注意力模块,验证时空注意力模块添加到不同层的影响。wo S、wo T和wo ST分别代表缺少空间注意力模块、时间注意力模块和时空注意力模块。实验结果表明,无论在哪一层添加时空注意力模块,其识别准确率都高于基线和分别缺少空间注意力模块和时间注意力模块的网络。同时可以发现,缺少时间注意力模块的网络在准确率上通常略低于缺少空间注意模块的网络,这是因为连续帧之间存在高度的冗余性,进一步体现了注意力机制的重要性。图4给出了基于NTU RGB+D数据集的输入特征通过时空注意力模块前后的可视化效果,图中横轴和纵轴的坐标分别表示帧和关节。为了便于观察,将注意力机制添加到第5层之后,即帧数为150,关节数为25。图4(a)是通过时空注意力模块前的特征,可以看出空间维度和时间维度存在大量冗余信息;图4(b)是通过时空注意力网络后的特征,此时空间维度和时间维度的冗余信息被削弱,有用信息被突出,进一步验证了时空注意力模块在捕捉时空特征上的优越性。

图4 注意力特征可视化

Fig.4 Visualization of attention features

表1 时空注意力模块对比分析

Tab.1 Comparative analysis of Spatio-Temporal attention module

方法X-Sub/%X-View/%STAM-AGCNwoSTbaseline89.295.4STAM-AGCN1ST89.695.5woS89.495.4woT89.395.4STAM-AGCN3ST90.096.1woS89.695.7woT89.595.7STAM-AGCN5ST90.296.2woS89.895.9woT89.895.7STAM-AGCN7ST89.995.7woS89.695.4woT89.795.6

在不同层添加时空注意力模块的实验结果表明,在网络的前半部分添加时空注意力模块的效果更好,这是因为网络后半部分的特征尺寸相对较小,效果下降。在第3层之后添加时空注意力模块的网络准确率最高,与基线相比,提高1%(X-sub)和0.8%(X-View)。因此,后续试验均将时空注意力模块添加到第3层之后。

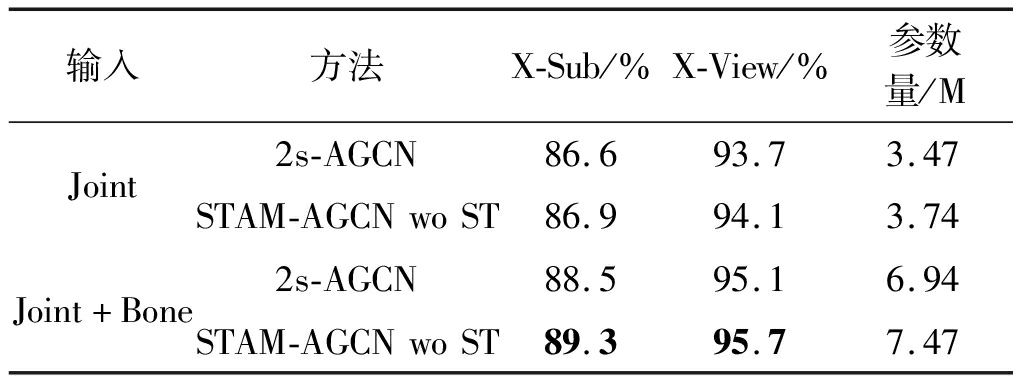

4.3.2 自适应图卷积网络对比实验

为更客观地验证自适应图卷积网络捕捉全局上下文信息的能力,使用2s-AGCN[13]的双流网络方法,同时去除时空注意力模块。表2给出了不同输入数据下两种模型的识别准确率和参数量,图5给出了本方法使用不同的比例系数时损失值曲线的变化情况,即λ=0、λ=1和λ对应的三条曲线分别是将Ak的比例系数设为恒为0、恒为1和随轮次下降三种情况的损失值变化曲线,模拟人体先验知识作用于网络不同时期的效果。由表2和图5可以得出:(1)无论是仅选用关节流网络,还是关节流和骨骼流的双流网络,本文提出来的自适应图卷积网络都优于2s-AGCN,且只增加了较少的参数量,在选用双流网络的情况下,识别准确率分别比2s-AGCN高0.8%(X-Sub)和0.6%(X-View),参数量只增加了0.53M;(2)对比将比例系数设置为0、1或逐轮次下降三种方案的损失值变化情况,λ随轮次下降会使网络有更快的收敛速度。

图5 损失值变化曲线

Fig.5 Change curve of loss value

表2 自适应图卷积对比分析

Tab.2 Comparative analysis of adaptive graph convolutional network

输入方法X-Sub/%X-View/%参数量/MJoint2s-AGCN86.693.73.47STAM-AGCNwoST86.994.13.74Joint+Bone2s-AGCN88.595.16.94STAM-AGCNwoST89.395.77.47

上述实验证明:在不明显增加参数量的情况下,本文提出的自适应图卷积网络能够有效捕捉全局上下文信息,并在权衡人体先验知识上有很强的灵活性。

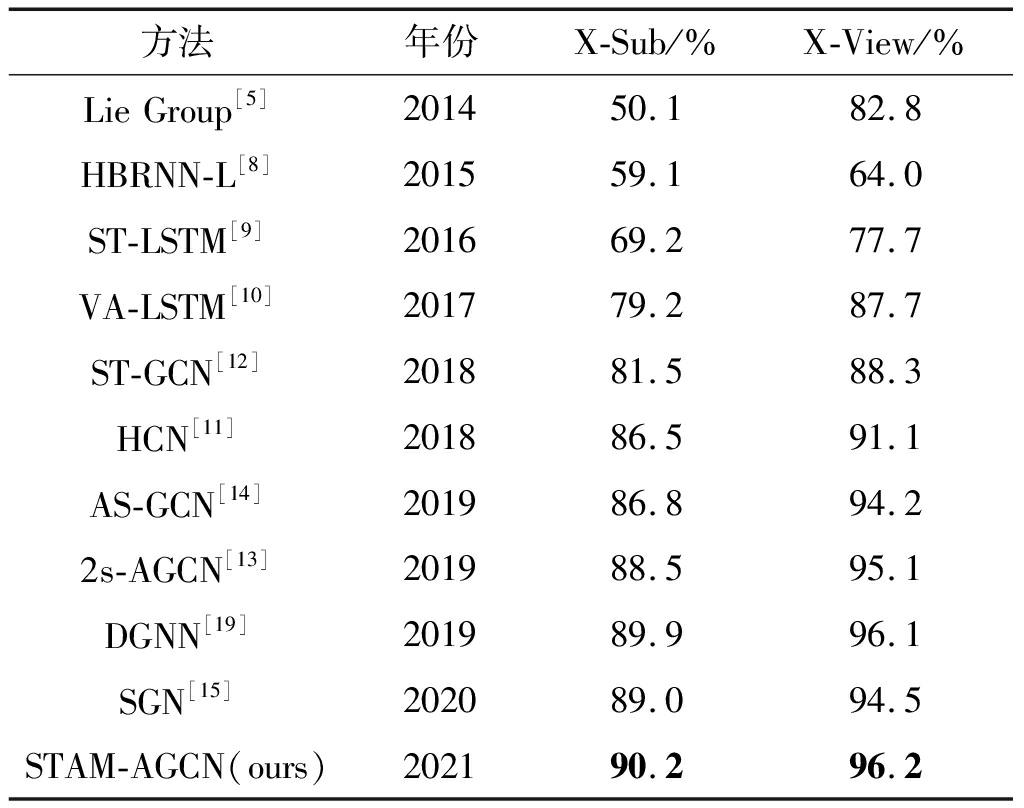

4.3.3 经典算法对比

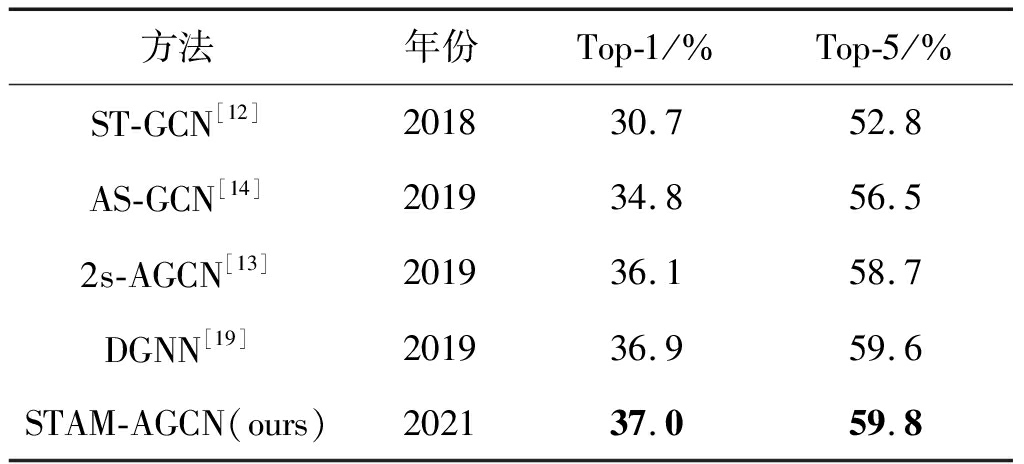

为了体现STAM-AGCN的优越性,在NTU RGB+D和Kinetics两个数据集上与最先进的方法进行了比较。主要包含基于手工特征[5]的方法、基于RNN[8-10]的方法、基于CNN[11]的方法和基于GCN[12-15,19]的方法。在NTU RGB+D上的比较结果如表3所示,可以得出:(1)基于GCN方法的性能通常优于其他三种方法;(2)在X-Sub和X-View两种划分协议下,STAM-AGCN模型的识别准确率分别达到了90.2%和96.2%,效果最优;(3)STAM-AGCN模型的识别准确率相较于基于CNN和GCN代表性的方法HCN[11]和ST-GCN[12],在X-Sub(X-View)上分别提高了3.7%(5.1%)、8.7%(7.9%)。对于Kinetics数据集,比较结果如表4所示,在Top-1和Top-5上的识别准确率分别达到了37.0%和59.8%,优于其他方法。

表3 NTU RGB+D数据集不同模型准确率对比

Tab.3 Comparison results of recognition accuracy on NTU RGB+D dataset

方法年份X-Sub/%X-View/%LieGroup[5]201450.182.8HBRNN-L[8]201559.164.0ST-LSTM[9]201669.277.7VA-LSTM[10]201779.287.7ST-GCN[12]201881.588.3HCN[11]201886.591.1AS-GCN[14]201986.894.22s-AGCN[13]201988.595.1DGNN[19]201989.996.1SGN[15]202089.094.5STAM-AGCN(ours)202190.296.2

表4 Kinetics数据集不同模型准确率对比

Tab.4 Comparison results of recognition accuracy on Kinetics dataset

方法年份Top-1/%Top-5/%ST-GCN[12]201830.752.8AS-GCN[14]201934.856.52s-AGCN[13]201936.158.7DGNN[19]201936.959.6STAM-AGCN(ours)202137.059.8

综合上述分析:(1)相较于传统方法,STAM-AGCN模型在提取时空特征和全局上下文信息上展现更强的性能;(2)STAM-AGCN模型在大规模数据集NTU RGB+D和Kinetics上取得最高的识别准确率。

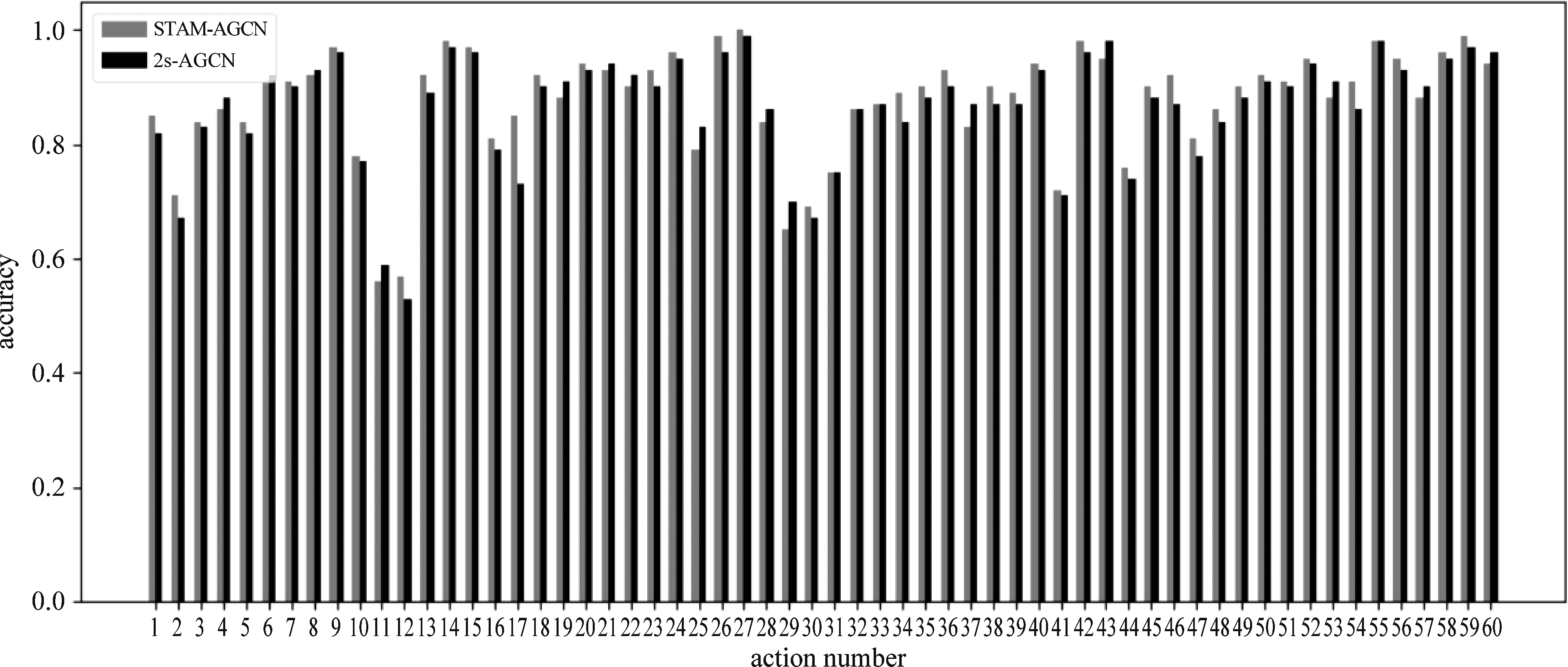

图6的直方图展示了STAM-AGCN和2s-AGCN[13]基于NTU RGB+D数据集X-Sub协议下的识别准确率,横轴代表动作编号,考虑关节流作为输入。可以得出:(1)相比于2s-AGCN,本文方法的大多数动作的识别准确率得到了明显提高,如“脱鞋(编号17)”和“搓手(编号34)”的识别准确率分别提高12%和5%;(2)部分涉及场景交互的动作,如“阅读(编号11)”和“书写(编号12)”的识别准确率不足60%,需要结合场景信息和交互信息进一步提高识别准确率。

图6 识别准确率对比

Fig.6 Comparison of recognition accuracy

5 结论

在基于人体骨架的行为识别方法中,对时空特征的提取以及关节间全局上下文信息的捕捉是提高模型准确率的关键。本文提出一种时空注意力机制和自适应图卷积网络,用于基于人体骨架的行为识别。该算法利用一种可嵌入的时空注意力模块同时捕捉空间域和时间域最具判别性的信息,增加了网络对行为的判别能力;同时,为图卷积网络提供一种仅靠数据驱动的自适应邻接矩阵,用于捕捉关节间的全局上下文信息,并动态的结合了人体的先验知识,增加了图卷积网络的灵活性;最后,构建双流网络融合多种模态的信息,进一步提高性能。实验结果表明,该算法相较于其他方法,有更好的捕捉时空特征和全局上下文信息的能力,更高的识别准确率。未来的工作中,将尝试加入场景信息、交互信息等提高场景交互类动作的识别准确率,并探索更加轻量级的时空特征提取方法。

[1] HU Weiming, TAN Tieniu, WANG Liang, et al.A survey on visual surveillance of object motion and behaviors[J].IEEE Transactions on Systems, Man, and Cybernetics, Part C(Applications and Reviews), 2004, 34(3): 334-352.

[2] YANG M H, KRIEGMAN D J, AHUJA N.Detecting faces in images: A survey[J].IEEE Transactions on Pattern Analysis and Machine Intelligence, 2002, 24(1): 34-58.

[3] TURAGA P, CHELLAPPA R, SUBRAHMANIAN V S, et al.Machine recognition of human activities: A survey[J].IEEE Transactions on Circuits and Systems for Video Technology, 2008, 18(11): 1473-1488.

[4] AGGARWAL J K, RYOO M S.Human activity analysis: A review[J].ACM Computing Surveys, 2011, 43(3): 16.

[5] VEMULAPALLI R, ARRATE F, CHELLAPPA R.Human action recognition by representing 3D skeletons as points in a lie group[C]∥2014 IEEE Conference on Computer Vision and Pattern Recognition.Columbus, OH, USA.IEEE, 2014: 588-595.

[6] XIA Lu, CHEN C C, AGGARWAL J K.View invariant human action recognition using histograms of 3D joints[C]∥2012 IEEE Computer Society Conference on Computer Vision and Pattern Recognition Workshops.Providence, RI, USA.IEEE, 2012: 20-27.

[7] WANG Heng, KL SER A, SCHMID C, et al.Dense trajectories and motion boundary descriptors for action recognition[J].International Journal of Computer Vision, 2013, 103(1): 60-79.

SER A, SCHMID C, et al.Dense trajectories and motion boundary descriptors for action recognition[J].International Journal of Computer Vision, 2013, 103(1): 60-79.

[8] DU Yong, WANG Wei, WANG Liang.Hierarchical recurrent neural network for skeleton based action recognition[C]∥2015 IEEE Conference on Computer Vision and Pattern Recognition(CVPR).Boston, MA, USA.IEEE, 2015: 1110-1118.

[9] LIU Jun, SHAHROUDY A, XU Dong, et al.Skeleton-based action recognition using spatio-temporal LSTM network with trust gates[J].IEEE Transactions on Pattern Analysis and Machine Intelligence, 2018, 40(12): 3007-3021.

[10] ZHANG Pengfei, LAN Cuiling, XING Junliang, et al.View adaptive recurrent neural networks for high performance human action recognition from skeleton data[J].2017 IEEE International Conference on Computer Vision(ICCV), 2017: 2136-2145.

[11] LI Chao, ZHONG Qiaoyong, XIE Di, et al.Co-occurrence feature learning from skeleton data for action recognition and detection with hierarchical aggregation[C]∥Proceedings of the Twenty-Seventh International Joint Conference on Artificial Intelligence.Stockholm, Sweden.California: International Joint Conferences on Artificial Intelligence Organization, 2018: 786-792.

[12] YAN Sijie, XIONG Yuanjun, LIN Dahua.Spatial temporal graph convolutional networks for skeleton-based action recognition[EB/OL].2018

[13] SHI Lei, ZHANG Yifan, CHENG Jian, et al.Two-stream adaptive graph convolutional networks for skeleton-based action recognition[C]∥2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition(CVPR).Long Beach, CA, USA.IEEE, 2019: 12018-12027.

[14] LI Maosen, CHEN Siheng, CHEN Xu, et al.Actional-structural graph convolutional networks for skeleton-based action recognition[C]∥2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition(CVPR).Long Beach, CA, USA.IEEE, 2019: 3590-3598.

[15] ZHANG Pengfei, LAN Cuiling, ZENG Wenjun, et al.Semantics-guided neural networks for efficient skeleton-based human action recognition[C]∥2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition(CVPR).Seattle, WA, USA.IEEE, 2020: 1109-1118.

[16] 王增强, 张文强, 张良.引入高阶注意力机制的人体行为识别[J].信号处理, 2020, 36(8): 1272-1279.

WANG Zengqiang, ZHANG Wenqiang, ZHANG Liang.Human behavior recognition with high-order attention mechanism[J].Journal of Signal Processing, 2020, 36(8): 1272-1279.(in Chinese)

[17] 孔玮,刘云,李辉,等.基于图卷积网络的行为识别方法综述[J/OL].控制与决策.

KONG Wei, LIU Yun, LI Hui, et al.A survey of action recognition methods based on graph convolution network[J/OL].Control and Decision.(in Chinese)

[18] WANG Xiaolong, GIRSHICK R, GUPTA A, et al.Non-local neural networks[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition.Salt Lake City, UT, USA.IEEE, 2018: 7794-7803.

[19] SHI Lei, ZHANG Yifan, CHENG Jian, et al.Skeleton-based action recognition with directed graph neural networks[C]∥2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition(CVPR).Long Beach, CA, USA.IEEE, 2019: 7904-7913.

[20] 曹毅, 刘晨, 黄子龙, 等.时空自适应图卷积神经网络的骨架行为识别[J].华中科技大学学报(自然科学版), 2020, 48(11): 5-10.

CAO Yi, LIU Chen, HUANG Zilong, et al.Skeleton-based action recognition based on spatio-temporal adaptive graph convolutional neural-network[J].Journal of Huazhong University of Science and Technology(Natural Science Edition), 2020, 48(11): 5-10.(in Chinese)

[21] SHAHROUDY A, LIU Jun, NG T T, et al.NTU RGB+D: A large scale dataset for 3D human activity analysis[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition(CVPR).Las Vegas, NV, USA.IEEE, 2016: 1010-1019.

[22] KAY W, CARREIRA J, SIMONYAN K, et al.The kinetics human action video dataset[EB/OL].2017

[23] CAO Zhe, SIMON T, WEI Shihen, et al.Realtime multi-person 2D pose estimation using part affinity fields[J].2017 IEEE Conference on Computer Vision and Pattern Recognition(CVPR), 2017: 1302-1310.