1 引言

自从20世纪90年代以来,人脸识别技术就一直是计算机视觉领域的一个热点研究问题,在交通、安防、民生等领域应用广泛。在一个完整的人脸识别任务中往往包含了四个子任务:人脸检测,人脸对齐,特征提取,特征分类。其中以特征提取最为关键。当前主流的人脸识别算法往往以深度卷积神经网络(Deep Convolutional Neural Network,DCNN)为特征提取网络,并在网络训练过程中施加分类监督。然而,由于当前高性能的特征提取网络往往是基于ImageNet数据集[1]研发,虽然适用于大规模图像分类任务,但是具有参数量大、计算量大等缺点,这往往无法满足经常需要部署到移动硬件平台的人脸识别算法的要求。因此,需要进一步研究适用于人脸识别这一特定场景且计算高效的网络结构,以提升人脸识别算法的性能和移动端部署能力。

近年来,国内外学者提出了许多新颖的卷积神经网络设计思路,这些思路主要包括残差连接,自学习结构和密集连接等。以这三者为基础的代表性网络分别是ResNet[2],Inception[3]和DenseNet[4]网络。ResNet网络通过残差连接的方式解决了单纯堆叠网络层所带来的网络性能退化问题,残差块的引入使得被残差块所连接的部分网络只需要进行难度更低的残差学习[5],这大大提升了网络对复杂数据的拟合能力。使用残差连接设计的网络虽然可以通过大幅度加深网络的速度来达到更好的性能,但是以逐像素相加的方式进行残差连接会带来一定程度的信息损失。Inception网络通过自学习结构的方式解决了网络设计过程中如何设计卷积核大小这一问题,对同一级别的特征采用不同大小的卷积核并行学习,每一种类型的卷积核具体学到的信息让网络自行分配,这在提升了网络性能的同时也减轻了算法研究人员的超参数设置压力。使用自学习结构设计的网络虽然可以通过大幅度加宽网络的宽度来达到更好的性能,但是存在参数量大的缺点。DenseNet网络通过密集连接的方式解决了单一特征无法全面描述物体信息这一问题,特征之间的密集连接使得深层的特征在具有丰富的语义信息[6]的同时也包含了一定的低级信息,如边缘、颜色、纹理等信息,使用这些混合的信息更能表达物体的全貌。同时,由于DenseNet采用了不同密集块之间使用相同的特征通道数这一设计,使得网络的参数量大幅度减少。使用密集连接设计的网络虽然具有较小的参数量和较高的性能,但是在网络训练和推理过程中的频繁IO操作会带来网络收敛缓慢、推理时间慢等缺点。

为了提高人脸特征提取网络的特征提取能力,从而提高人脸识别算法的精度,本文对人脸特征提取网络进行研究。在上文所述三种网络结构设计思路的基础上,针对各自的缺点进行改进,提出了一种适应人脸识别任务的高效网络结构——SFRNet。本文的内容安排如下:第2节给出了SFRNet的网络结构及其三个创新点。第3节在公开数据集上验证了SFRNet的特征提取能力和计算高效性。第4节给出本文的结论。

2 SFRNet网络结构

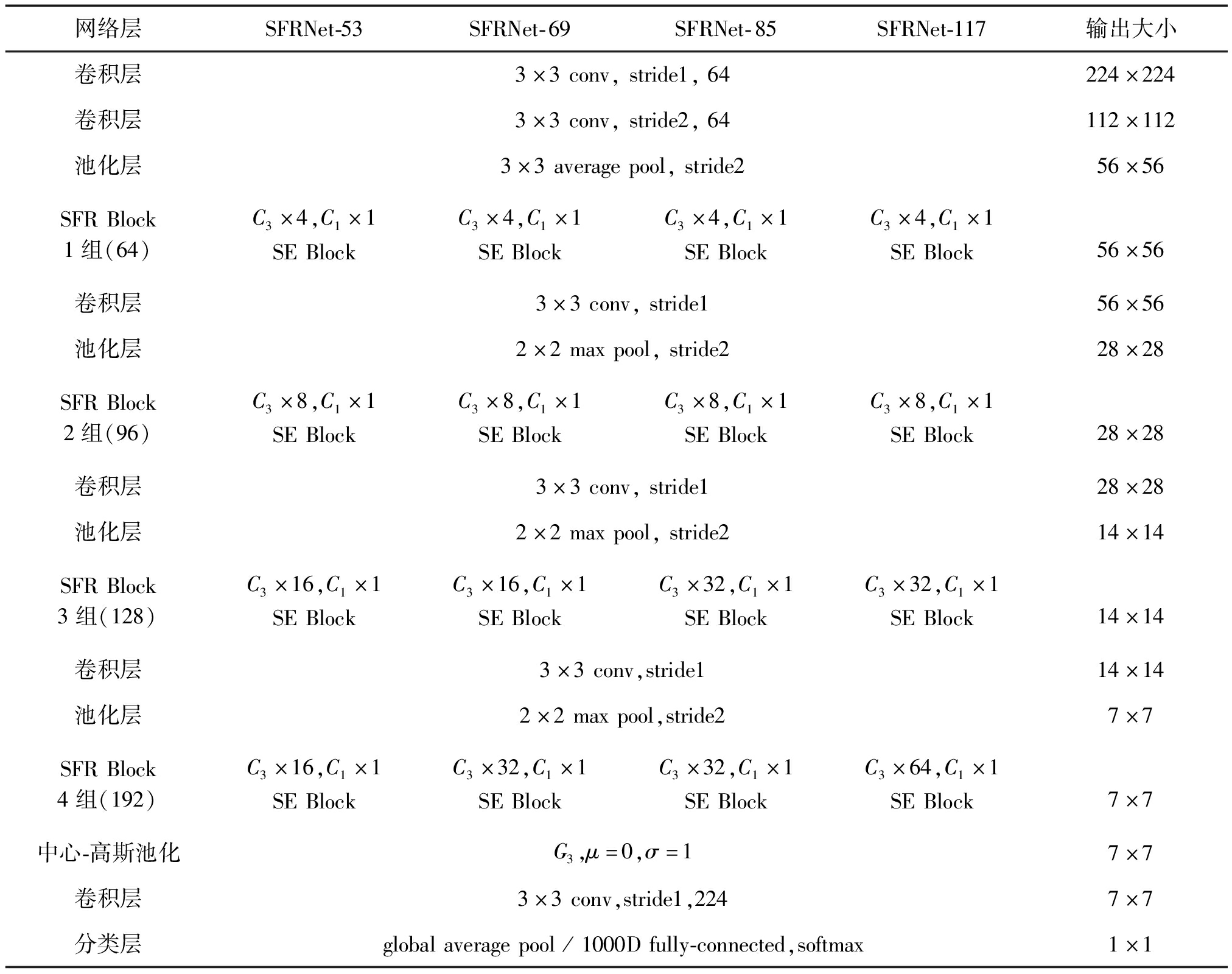

从整体上看,SFRNet由多个SFR Block堆叠而成。在统计网络层数时,本文只计算带有训练参数的网络层。同时,由于BN(Batch Normalization)层仅有少量的参数,因此不纳入层数统计范围,只是将其归类于附属的卷积层。以224×224大小的图像为输入,SFRNet的四种网络结构如表1所示。表中C3表示3×3的卷积组,C1表示1×1的卷积组,括号内的数字表示卷积组通道数量。

表1 SFRNet网络结构

Tab.1 SFRNet network structure

网络层SFRNet-53SFRNet-69SFRNet-85SFRNet-117输出大小卷积层3×3conv,stride1,64224×224卷积层3×3conv,stride2,64112×112池化层3×3averagepool,stride256×56SFRBlock1组(64)C3×4,C1×1SEBlockC3×4,C1×1SEBlockC3×4,C1×1SEBlockC3×4,C1×1SEBlock56×56卷积层3×3conv,stride156×56池化层2×2maxpool,stride228×28SFRBlock2组(96)C3×8,C1×1SEBlockC3×8,C1×1SEBlockC3×8,C1×1SEBlockC3×8,C1×1SEBlock28×28卷积层3×3conv,stride128×28池化层2×2maxpool,stride214×14SFRBlock3组(128)C3×16,C1×1SEBlockC3×16,C1×1SEBlockC3×32,C1×1SEBlockC3×32,C1×1SEBlock14×14卷积层3×3conv,stride114×14池化层2×2maxpool,stride27×7SFRBlock4组(192)C3×16,C1×1SEBlockC3×32,C1×1SEBlockC3×32,C1×1SEBlockC3×64,C1×1SEBlock7×7中心-高斯池化G3,μ=0,σ=17×7卷积层3×3conv,stride1,2247×7分类层globalaveragepool/1000Dfully-connected,softmax1×1

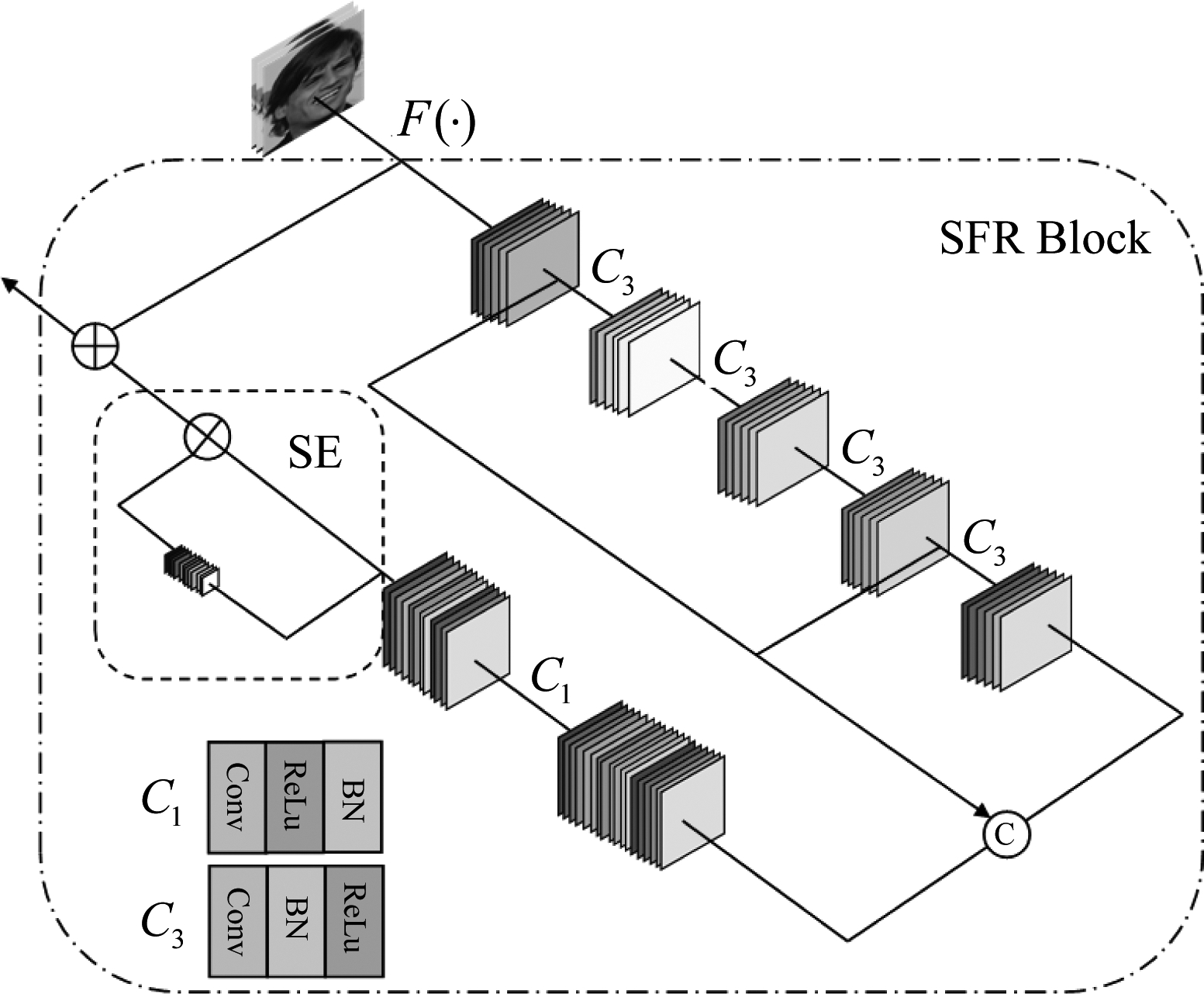

作为SFRNet的最小结构单元,每一个SFR Block由特征提取卷积组,通道整合卷积组,SE Block组成。最基础的含有四组特征提取卷积层的SFR Block的结构如图1所示。图中C3表示3×3的卷积组,用于提取特征,其一般组成为“Conv+ReLu+BN”;C1表示1×1的卷积组,用于整合不同通道的信息并降维,其一般组成为“Conv+BN+ReLU”;SE表示SE Block[7],用于对特征每个通道施加注意力[8]。SE Block内部的特征融合和SE Block的输出与输入之间的特征融合以逐元素相加的方式进行,不同特征提取卷积组之间的特征融合部分以逐元素相加的方式进行,部分以按通道级连的方式进行,其具体比例将在下文给出。

图1 SFR Block内部结构

Fig.1 Internal structure of SFR Block

常规的SE Block中有两层全连接层,一层用于降维,一层用于升维。本文为了减少信息缺失,将第一层全连接层删除并将平均池化改为最大值池化。改进后的SE Block结构如图2所示。其中Fmax(·)表示最大值池化,FC(·)表示全连接层,F(·)表示按通道相乘。

图2 改进后的SE Block内部结构

Fig.2 Internal structure of improved SE Block

2.1 稀疏特征重用

GPU计算效率和内存访问[9]成本是除了参数量和计算量以外影响模型推理速度的两个重要因素。对于卷积层而言,其内存访问成本的计算公式为:

MAC=hw(ci+co)+k2cico

(1)

上式中co表示输出通道数量,ci表示输入通道数量,h表示特征图的高,w表示特征图的宽,k表示卷积核的大小。当卷积层的计算量固定为B时,根据均值不等式有:

(2)

上式中B=k2hwcico,当且仅当ci=co时MAC取到下界。GPU计算效率是指GPU处理单张计算图所需的平均时间。由于GPU擅长并行计算,所以当输入GPU的计算图中所有张量都为大张量时,GPU的计算效率可以达到最大。综合以上两点,一个推理速度快的模型应该满足:(1)卷积层的输入输出通道数量相等。(2)尽量避免使用小尺寸卷积核,避免计算图中出现小张量。

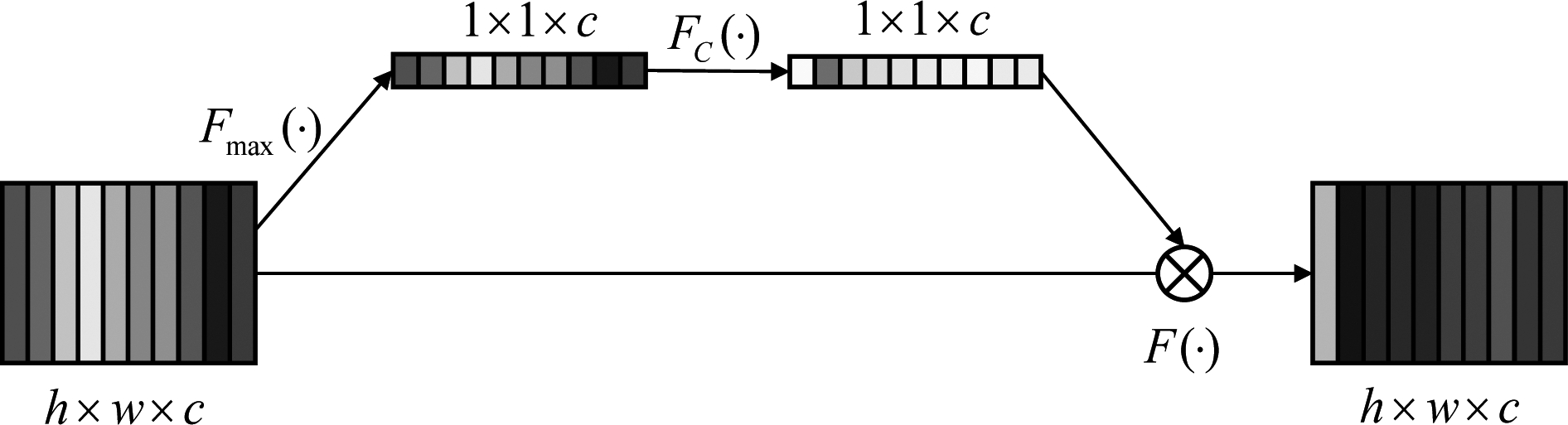

具体的,以在CIFAR-10数据集[10]上训练12个epoch得到的DenseNet121网络为例,对其第一个密集连接块的6组卷积层参数可视化可以得到图3的分布,图中Conv1—Conv6分别表示由浅到深的6组卷积层。可以发现,收敛后的DenseNet121网络参数大致满足高斯分布,一个密集连接块中的第一个卷积层和最后一个卷积层具有较大的参数值,其均值大约在0.3,其他各卷积层权重均值大约在0.1。这说明了训练收敛后的网络认为第一层和最后一层卷积层提取到的信息是最为重要且丰富的,DenseNet中由密集连接结构提取到的特征存在特征冗余的情况。

图3 密集连接块卷积层参数分布

Fig.3 Parameter distribution of convolutional layer in Densely connected block

基于以上两点分析,本文设计的SFR Block仅仅对第一组卷积层和最后一组卷积层提取到的特征进行融合,并且每一组卷积层的输入输出通道数量相等,称之为稀疏特征重用。这既从理论上提高了模型的推理速度,又解决了DenseNet中特征冗余的问题。

2.2 混合特征融合

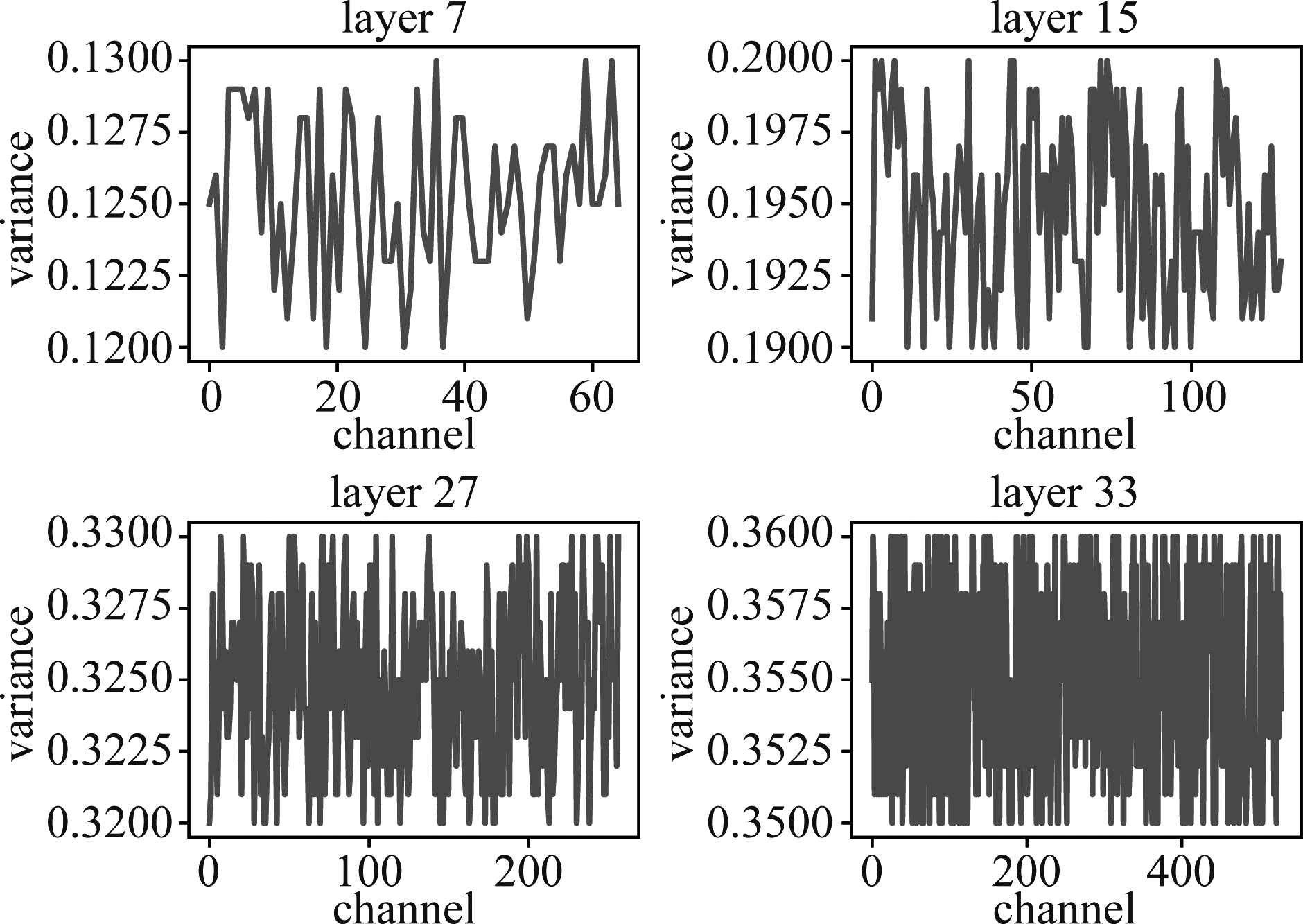

在深度神经网络中普遍采用的特征融合方式有两种:逐元素相加和按通道级联。逐元素相加是指两张特征图(图像)中相同位置处的像素值分别相加,相加后得到的特征图与原特征图的大小相同,通道数相等。按通道级联是将两张特征图(图像)在通道维度相连,相连后得到的特征图与原特征图的大小相同,通道数为原特征图通道数之和。上述两种特征融合方式各有优缺点,前者计算量小,但是有不可逆的信息损失;后者计算量大,但是能较完整保留原始信息。将2.1节中训练好的DenseNet-121网络的四个密集连接块的输出特征图可视化并分析其方差,可以得到图4的分布,图中Block1—Block4分别为由浅到深的4个密集连接块。可以发现每一个密集连接块的输出特征都具有较大的方差,其中最后一个密集连接块的方差最大。这说明了使用按通道级联进行特征融合的DenseNet即使在网络最深处也仅有较小的信息损失。因此,理论上可以在这些位置使用逐元素相加的方式代替,在减小计算量的同时保证低信息损失。为了验证上述想法,以在CIFAR-10数据集上训练25个epoch得到ResNet-34网络为例,统计其7、15、27、33层的特征图参数分布可以得到图5的结果。可以发现,使用逐元素相加进行特征融合的ResNet随着网络的加深,特征图的信息量也不断加大,最后一层特征融合后具有最大的方差和信息量。这说明了使用逐元素相加的方式进行特征融合在网络的深层仍然可以提取到信息量丰富的特征图。

图4 密集连接块输出特征图方差分布

Fig.4 Variance distribution of feature map in Densely connected block

图5 残差块输出特征图方差分布

Fig.5 Variance distribution of feature map in residual block

基于以上两点分析,SFRNet使用混合特征融合的方式进行特征融合。具体的,在网络的浅层SFR Block中使用按通道级联,在网络的深层SFR Block中使用逐元素相加。后续的交叉验证实验发现,对于由4个SFR Block堆叠而成的SFRNet而言,前三个SFR Block使用按通道级联,最后一个SFR Block使用逐元素相加可以获得最好的精度和速度的平衡。

2.3 中心-高斯池化

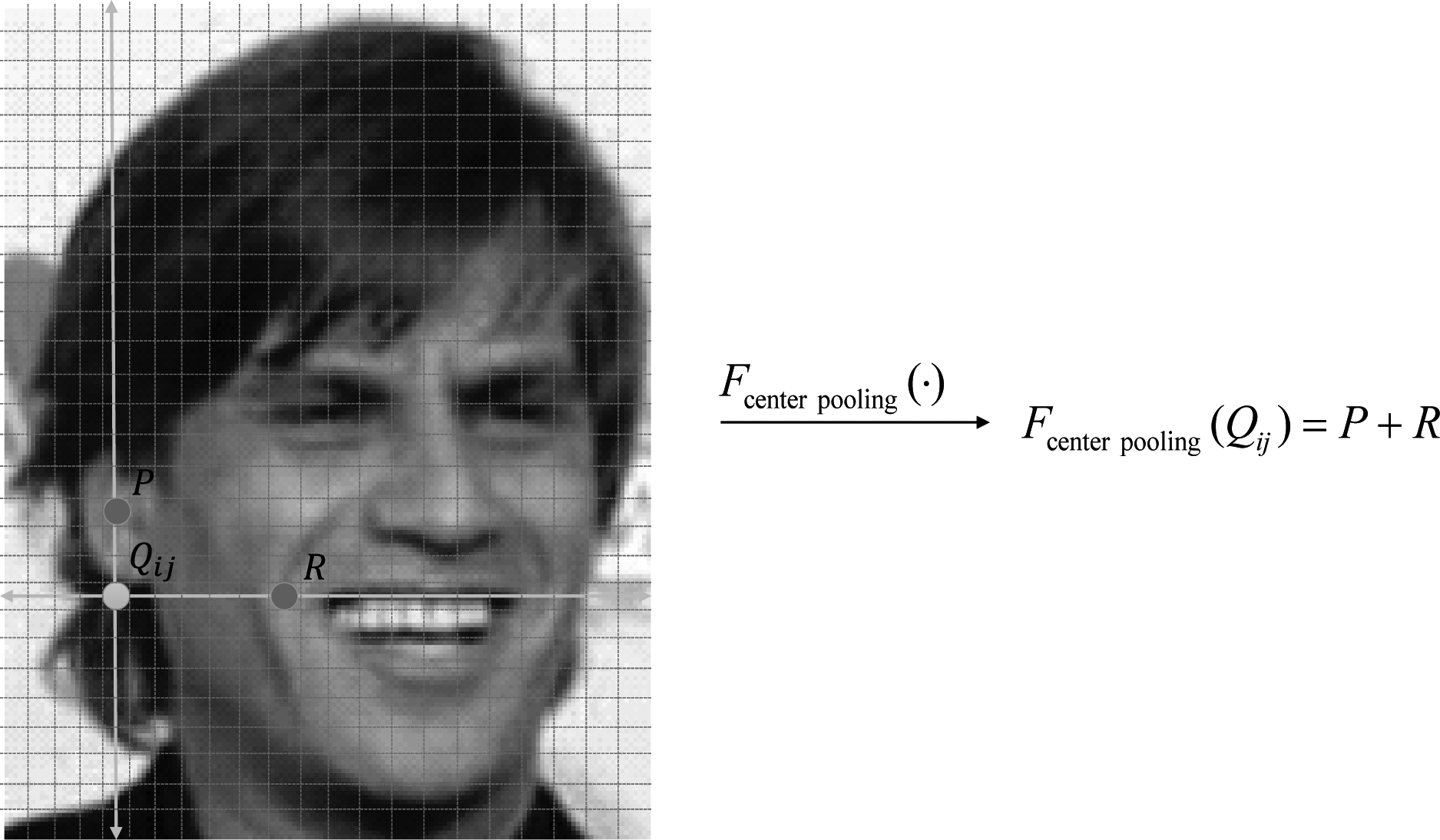

基于“物体中心视觉特征强,边缘视觉特征弱”这一理念[11],中心池化被广泛用于提取物体的强视觉特征。常规中心池化的操作较为简单,假设单层特征图为X=(xij)m×n,中心池化后变为Y=(yij)m×n,其中yij=max(xi1,xi2,…,xin)+max(x1j,x2j,…,xmj)。这种形式的中心池化普遍存在着图6的问题,点Q不在物体内部,但是经过中心池化后具有较高的响应,此时点Q会为网络引入无效特征。

图6 传统中心池化

Fig.6 Traditional center pooling

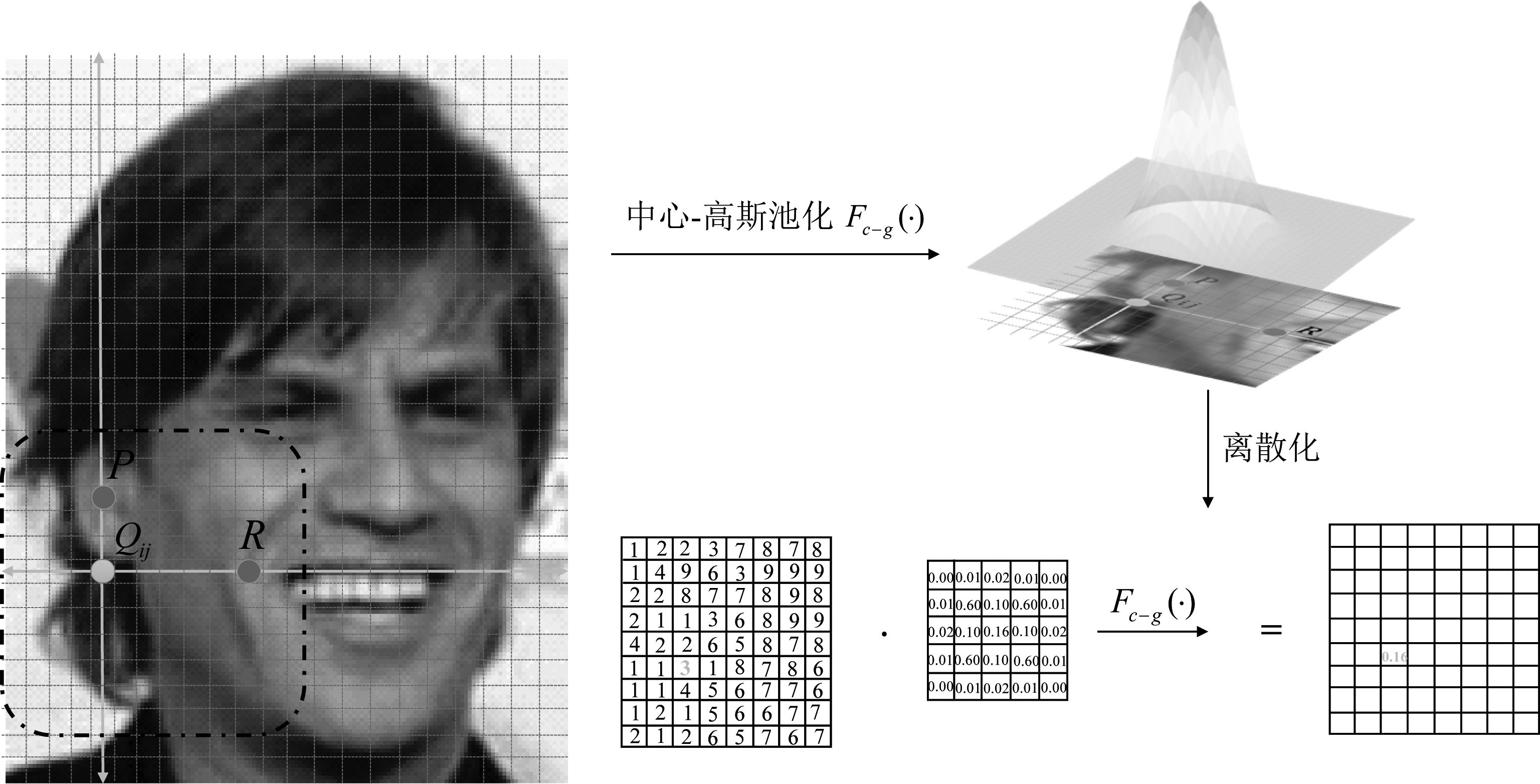

基于以上分析,本文在SFRNet中采用中心-高斯池化进行强视觉特征提取。具体的,对高斯池化中选择的强响应点以池化中心为原点进行高斯加权,这样可以解决传统中心池化存在的问题。中心-高斯池化的具体流程如图7所示,在实际操作过程中,可以用不同大小的二维高斯模版离散化高斯加权的过程。可以发现,中心-高斯池化在提取人脸的强视觉特征时有独特的优势:人脸区域具有不规则的形状,且对于特征提取网络而言,其输入图像已经经过人脸检测网络处理,人脸位置基本处于图像中心。在这种情况下,中心-高斯池化既可以提取到人脸中心的特征,又能避开如耳垂以下等非人脸区域的干扰。

图7 中心-高斯池化

Fig.7 Center-Gaussian pooling

中心-高斯池化在训练过程中的梯度反向传播遵循“梯度总和不变”原则。具体的,假设点Q经过中心-高斯池化后为:

Fc-g(Q)=Grow·Qmax-row+Gcol·Qmax-col

(3)

上式中Grow表示横向高斯加权系数,Gcol表示纵向高斯加权系数。对应梯度有:

(4)

在SFRNet中,只在最后一个SFR Block输出层采用中心-高斯池化。

3 实验

本文为了测试SFRNet在人脸识别这一特定场景中的性能以及其更一般的特征提取能力,分别在ImageNet数据集,CIFAR-100数据集,LFW数据集[12]和MegaFace数据集[13]上进行消融实验,共进行了图像分类和人脸识别两大类实验。同时,本小节的最后给出了SE Block改动合理性的对比实验和混合特征融合具体比例设置的交叉验证实验以及本文所提出三个创新点的消融实验。

3.1 图像分类实验

3.1.1 超参数设置及训练平台

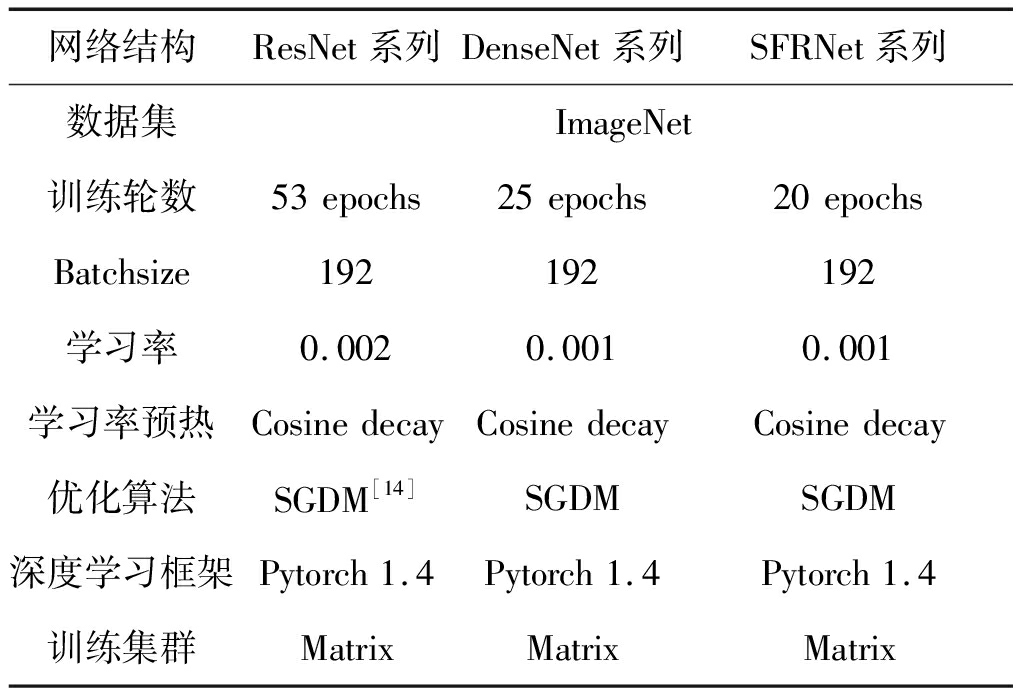

为了验证SFRNet的泛化性能,本文以ImageNet数据集为训练集,测试ResNet,DenseNet和SFRNet的特征提取能力。具体的超参数和训练平台如表2所示。

表2 图像分类实验配置

Tab.2 Experimental configuration of image classification

网络结构ResNet系列DenseNet系列SFRNet系列数据集ImageNet训练轮数53epochs25epochs20epochsBatchsize192192192学习率0.0020.0010.001学习率预热CosinedecayCosinedecayCosinedecay优化算法SGDM[14]SGDMSGDM深度学习框架Pytorch1.4Pytorch1.4Pytorch1.4训练集群MatrixMatrixMatrix

3.1.2 数据增强

在数据增强方面,本节采用了随机裁剪,颜色抖动,水平翻转,垂直翻转等常规数据增强手段。

3.1.3 实验结果

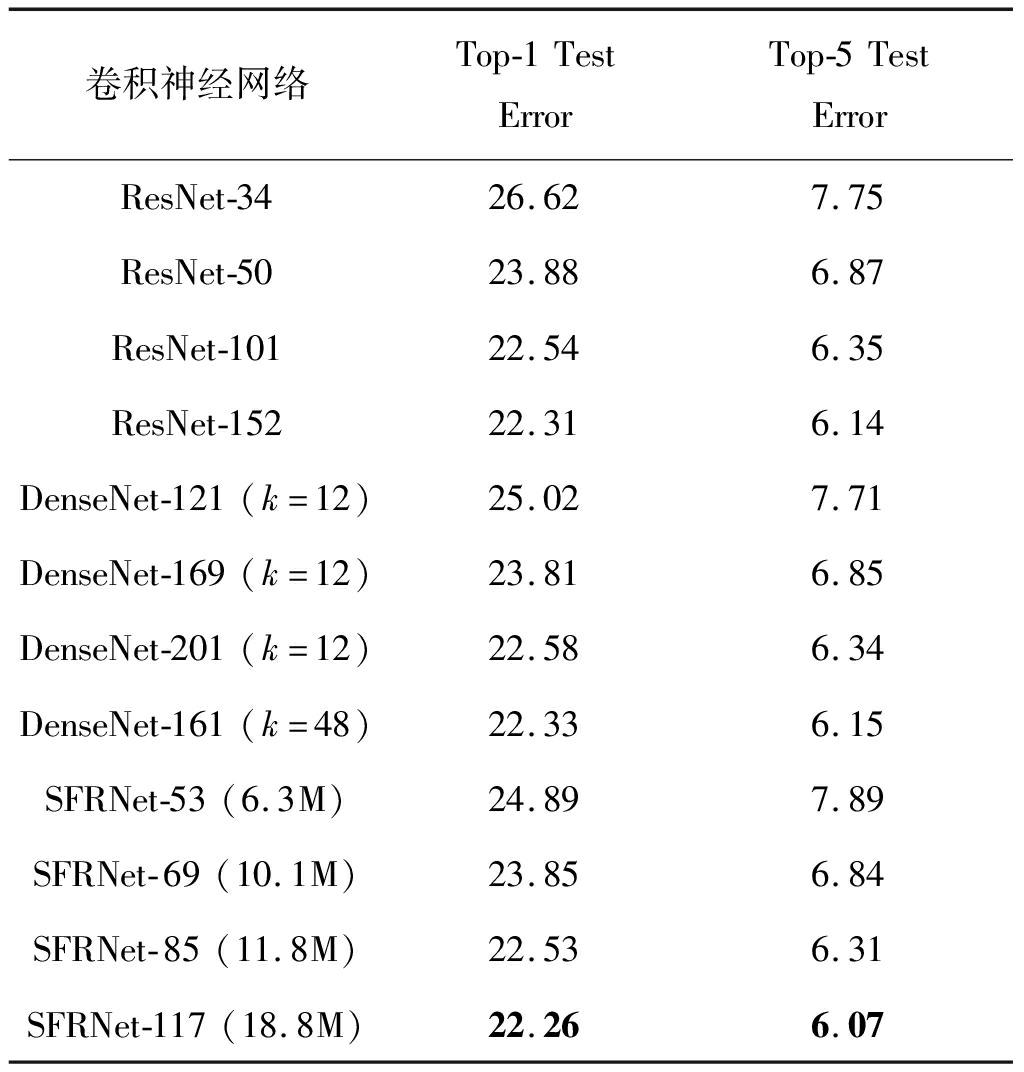

DenseNet,ResNet和SFRNet网络在ImageNet数据集上的Top-1错误率和Top-5错误率如表3所示。可以发现,单模型的SFRNet在Top-1和Top-5错误率上均大幅度优于ResNet,小幅度优于DenseNet。

表3 ImageNet数据集上Top-1和Top-5测试错误率(%)

Tab.3 Top-1 and Top-5 test error(%)on ImageNet dataset

卷积神经网络Top-1TestErrorTop-5TestErrorResNet-3426.627.75ResNet-5023.886.87ResNet-10122.546.35ResNet-15222.316.14DenseNet-121(k=12)25.027.71DenseNet-169(k=12)23.816.85DenseNet-201(k=12)22.586.34DenseNet-161(k=48)22.336.15SFRNet-53(6.3M)24.897.89SFRNet-69(10.1M)23.856.84SFRNet-85(11.8M)22.536.31SFRNet-117(18.8M)22.266.07

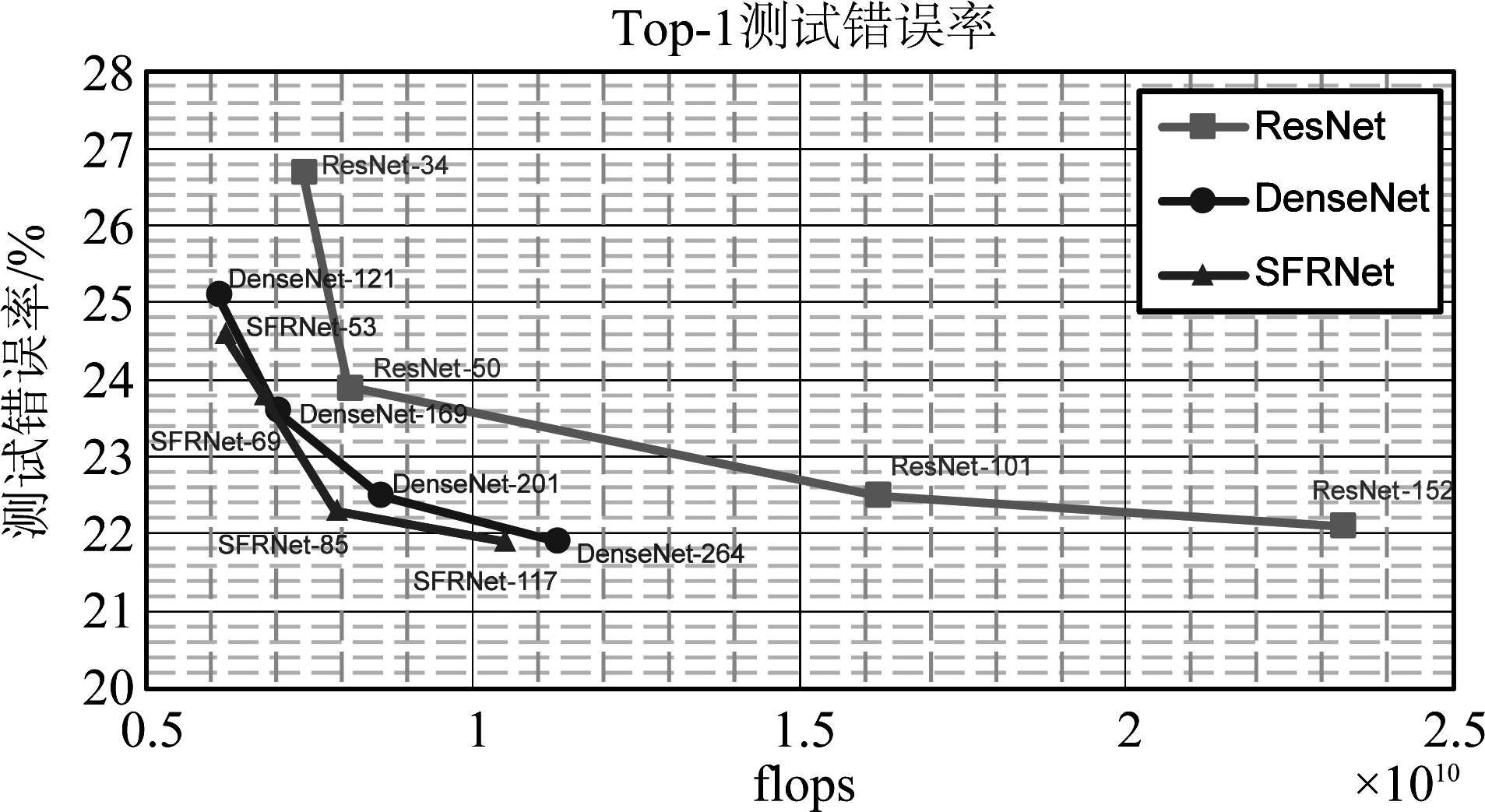

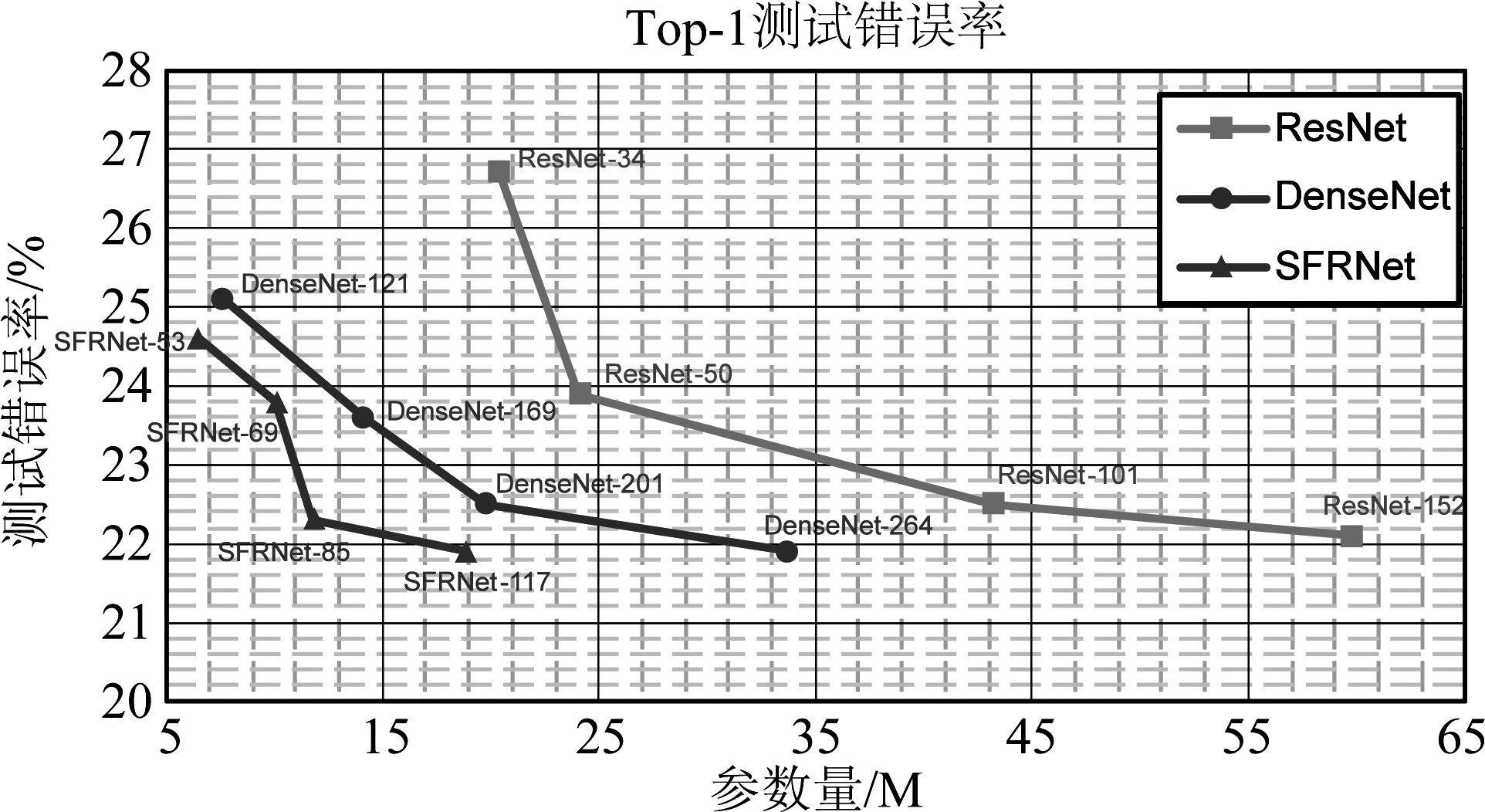

更近一步,图8和图9分别给出了ResNet,DenseNet和SFRNet这三者在不同的计算量和参数量下在ImageNet数据集上的Top-1错误率。可以发现,SFRNet的计算量大幅度低于ResNet,小幅度低于DenseNet,其中SFRNet-85和SFRNet-117的计算量和Top-1错误率有较好的平衡。得益于在深层网络使用逐元素相加的特征融合方式,随着网络层数的增加,SFRNet的计算量优势更为明显。SFRNet的参数量均大幅度低于ResNet和DenseNet,这得益于SFR Block中所采用的稀疏特征重用,每个SFR Block中只有第一组卷积层提取到的特征会与最后一组卷积层提取到的特征进行融合,在保证低内存访问成本的同时极大降低了网络的参数量。参数量的减小意味着当有移动硬件端部署的需求时,即使仅仅采用最简单的Int8量化方式,SFRNet也能直接移植到移动硬件端且不损失较大的精度。这在一些对精度要求不是很高的任务上具有很大的优势,免去了对模型进行量化训练[15]、模型剪枝[16]、知识蒸馏[17]等一系列复杂的模型训练中后期处理工作。

图8 网络测试错误率与计算量关系

Fig.8 The relationship between test error and calculation

图9 网络测试错误率与参数量关系

Fig.9 The relationship between test error and parameters

3.2 人脸识别实验

3.2.1 超参数设置及训练平台

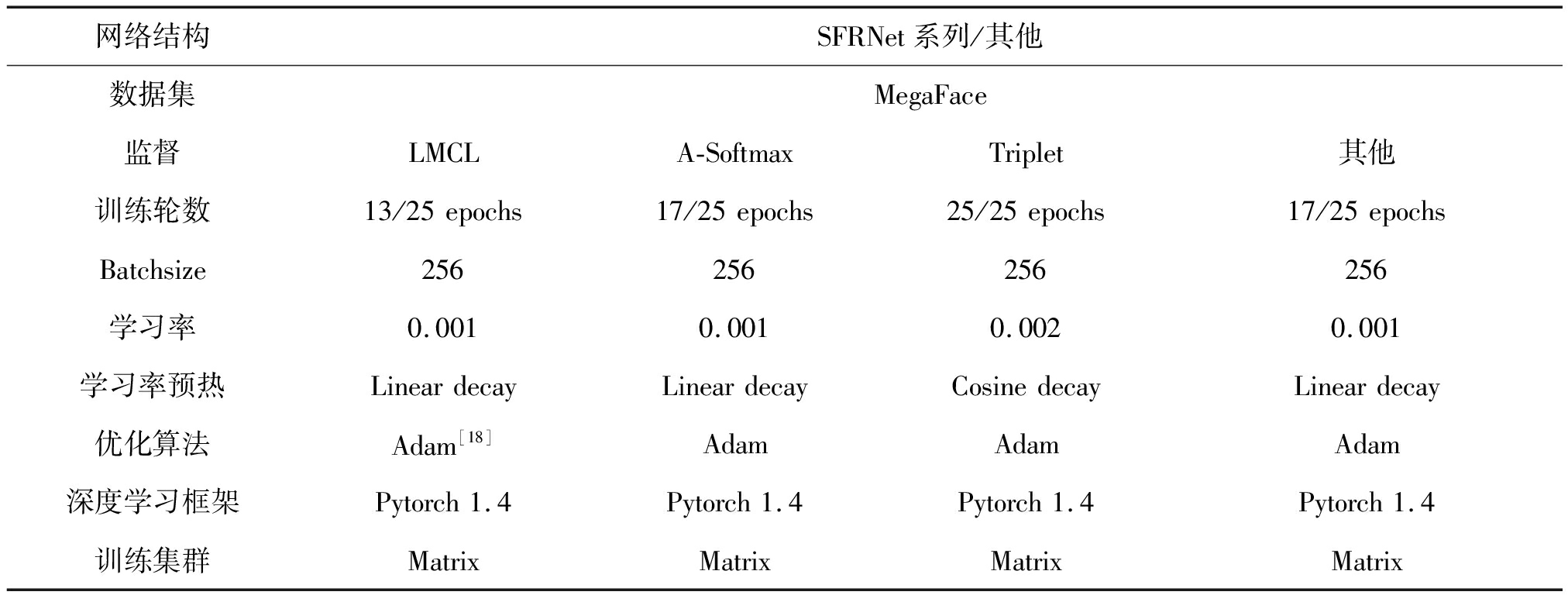

为了验证SFRNet在人脸识别这一特定场景中的特征提取能力,本文以MegaFace数据集为训练集,LFW和MegaFace数据集为验证集,在不同的分类监督下使用不同的特征提取网络并测试其人脸识别准确率。具体的超参数和训练平台如表4所示。

表4 人脸识别实验配置

Tab.4 Experimental configuration of face recognition

网络结构SFRNet系列/其他数据集MegaFace监督LMCLA-SoftmaxTriplet其他训练轮数13/25epochs17/25epochs25/25epochs17/25epochsBatchsize256256256256学习率0.0010.0010.0020.001学习率预热LineardecayLineardecayCosinedecayLineardecay优化算法Adam[18]AdamAdamAdam深度学习框架Pytorch1.4Pytorch1.4Pytorch1.4Pytorch1.4训练集群MatrixMatrixMatrixMatrix

3.2.2 数据增强

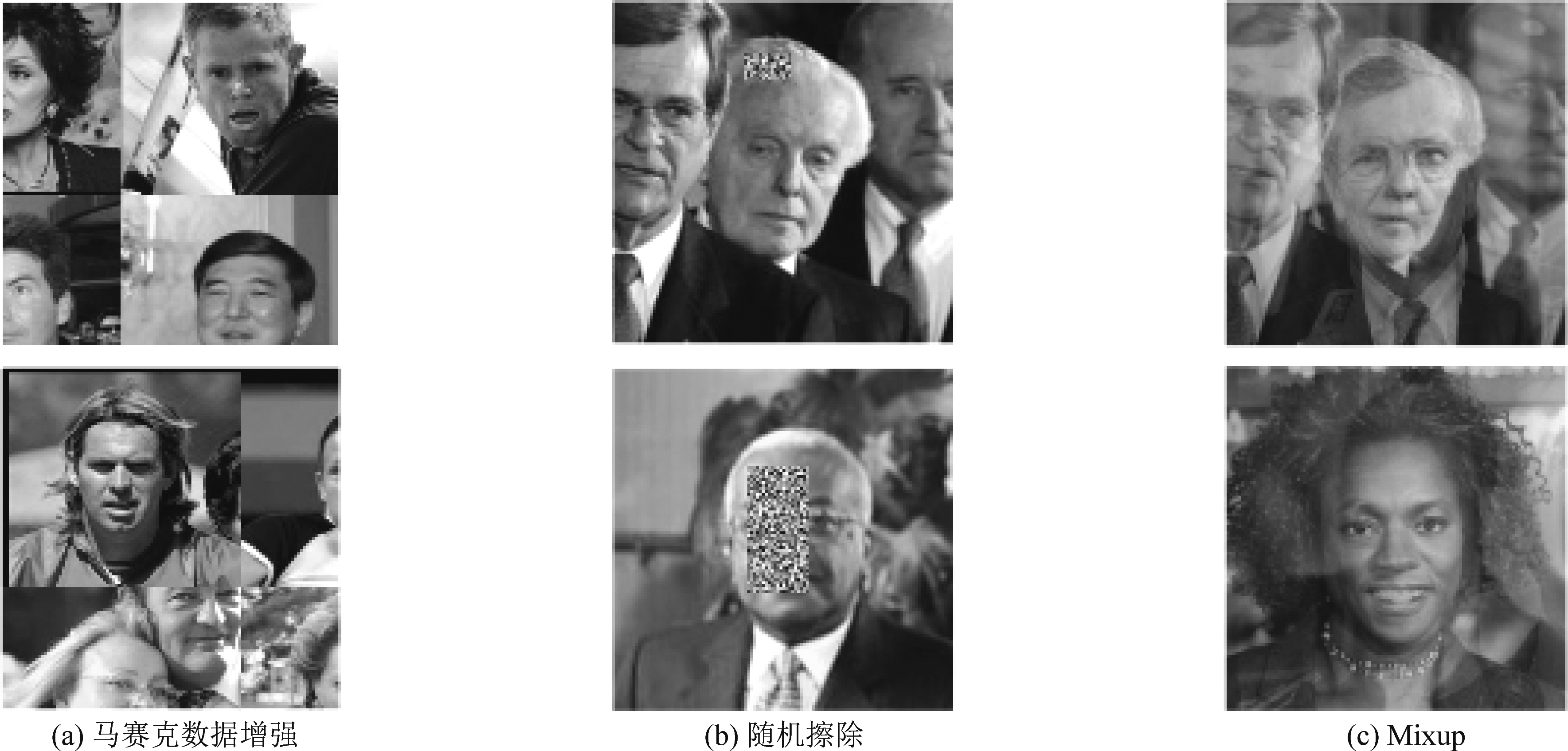

在数据增强方面,本节除了采用3.1.2节中常规数据增强手段外,还使用了随机擦除,Mixup,马赛克数据增强等手段以模拟人脸被遮挡等情况。图10展示了训练数据集中使用了上述三种额外数据增强手段后的部分训练图片。

图10 三种数据增强后的部分训练图片

Fig.10 Part of the training images under three data augmentation

3.2.3 实验结果

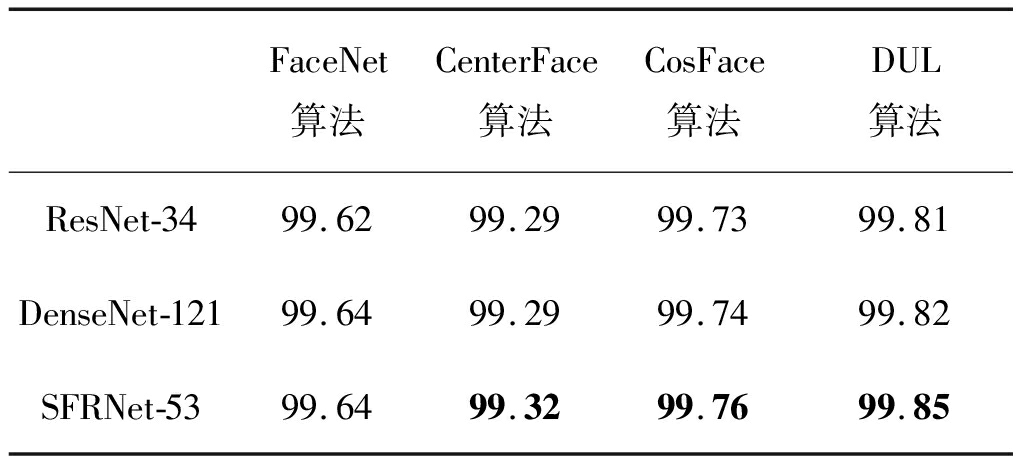

将FaceNet[19],CenterFace[20],CosFace[21],DUL[22]四种成熟的人脸识别算法中的特征提取网络替换为ResNet-34,DenseNet-121和SFRNet-53,测试算法在LFW数据集上的人脸识别准确率,可以得到表5的实验结果。可以发现,在CenterFace和CosFace算法中,使用SFRNet-53作为特征提取网络可以获得最高的人脸识别准确率;在FaceNet算法中,SFRNet-53的表现与DenseNet-121相当。

表5 LFW数据集上三种人脸识别算法的识别准确率(%)

Tab.5 The recognition accuracy(%)of three face recognition algorithms on the LFW dataset

FaceNet算法CenterFace算法CosFace算法DUL算法ResNet-3499.6299.2999.7399.81DenseNet-12199.6499.2999.7499.82SFRNet-5399.6499.3299.7699.85

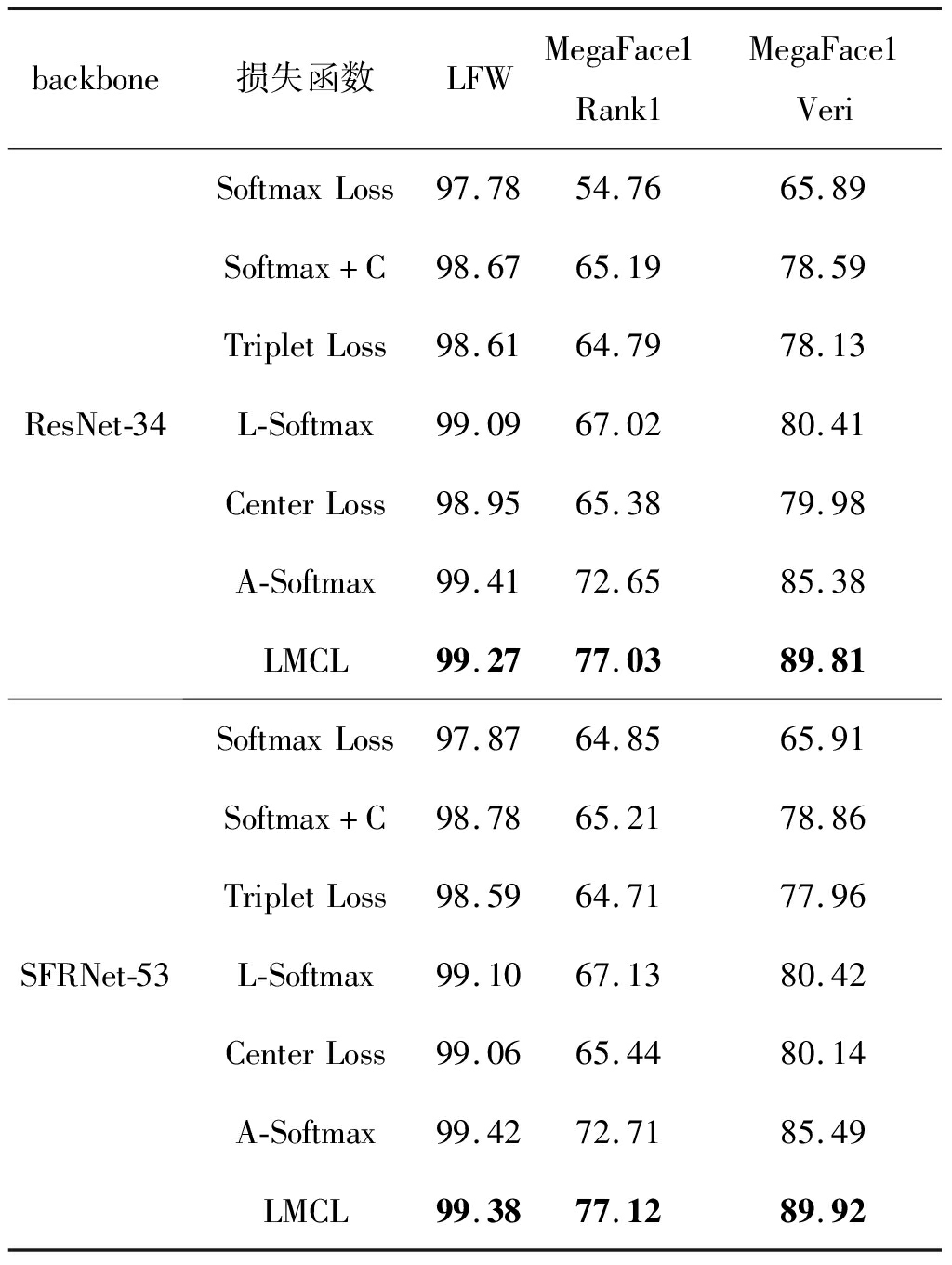

更进一步,为了验证SFRNet是否对所有的分类层监督都具有较强的泛化能力,分别以ResNet-34和SFRNet-53作为特征提取网络,在不同类型的分类层监督下训练人脸识别网络并测试其在LFW数据集上的识别准确率和MegaFace数据集上的rank1准确率,验证准确率,可以得到表6的实验结果。可以发现,SFRNet在大多数分类层监督下都具有较强的特征提取能力,以最优性能的LMCL[21]监督为例,单模型下SFRNet-53能提高其0.11%的人脸识别准确率。这说明了SFRNet对不同分类层监督的泛化能力强。

表6 LFW和MegaFace数据集上人脸识别准确率(%)

Tab.6 The accuracy(%)of face recognition on the LFW and MegaFace dataset

backbone损失函数LFWMegaFace1Rank1MegaFace1VeriResNet-34SoftmaxLoss97.7854.7665.89Softmax+C98.6765.1978.59TripletLoss98.6164.7978.13L-Softmax99.0967.0280.41CenterLoss98.9565.3879.98A-Softmax99.4172.6585.38LMCL99.2777.0389.81SFRNet-53SoftmaxLoss97.8764.8565.91Softmax+C98.7865.2178.86TripletLoss98.5964.7177.96L-Softmax99.1067.1380.42CenterLoss99.0665.4480.14A-Softmax99.4272.7185.49LMCL99.3877.1289.92

图11展示了LFW数据集上,SFRNet-53在LMCL监督下的部分预测结果。绿色的“True”表示算法判定为同一个身份ID,红色的“false”表示算法判定为不同的身份ID。

图11 LFW数据集上部分实验结果展示

Fig.11 Some experimental results on the LFW dataset

3.3 辅助实验

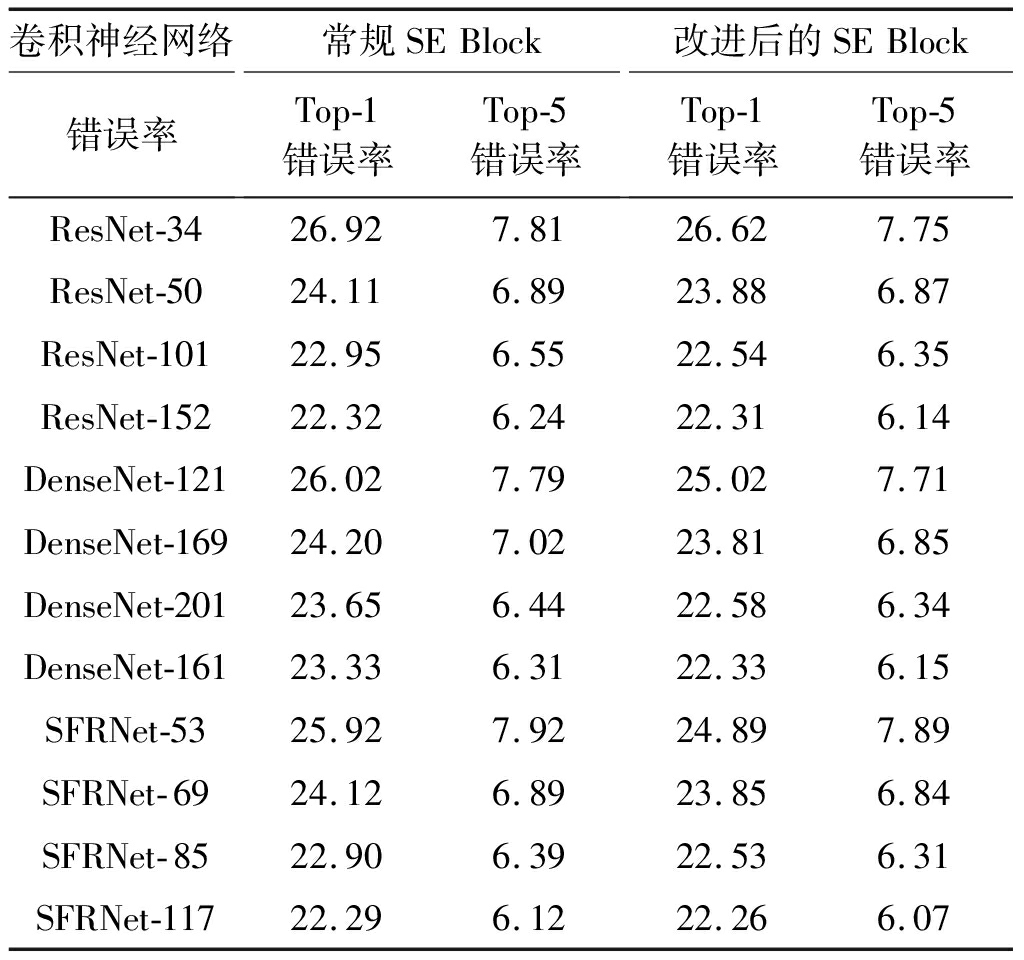

3.3.1 SE Block改进合理性论证

为了验证对常规SE Block结构改进的合理性,本文在ImageNet图像分类数据集上训练使用了常规SE Block结构和改进后的SE Block结构的ResNet、DenseNet、SFRNet系列网络,并测试其Top1和Top5错误率,可以得到表7的实验结果。可以发现改进后的SE Block相较于常规SE Block在Top-5错误率上有0.2%左右的降低,在Top-1错误率上有0.9%左右的降低,同时改进后的SE Block具有更少的参数量和更小的计算复杂度。这说明了本文对SE Block的改进是有效的。

表7 SE Block改进前后网络在ImageNet数据集上Top-1和Top-5测试错误率(%)

Tab.7 Top-1 and Top-5 test error(%)on ImageNet dataset before and after SE Block improvement

卷积神经网络错误率常规SEBlockTop-1错误率Top-5错误率改进后的SEBlockTop-1错误率Top-5错误率ResNet-3426.927.8126.627.75ResNet-5024.116.8923.886.87ResNet-10122.956.5522.546.35ResNet-15222.326.2422.316.14DenseNet-12126.027.7925.027.71DenseNet-16924.207.0223.816.85DenseNet-20123.656.4422.586.34DenseNet-16123.336.3122.336.15SFRNet-5325.927.9224.897.89SFRNet-6924.126.8923.856.84SFRNet-8522.906.3922.536.31SFRNet-11722.296.1222.266.07

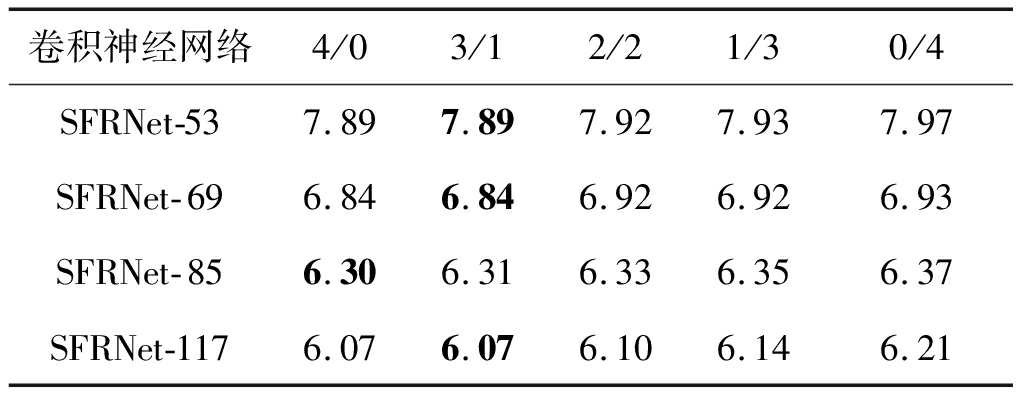

3.3.2 混合特征融合比例交叉验证

为了找到混合特征融合中的最佳比例,本文对含有四个SFR Block的SFRNet系列网络中的特征融合方式进行交叉验证,可以得到表8的实验结果,其中a/b表示前a个SFR Block使用按通道级联,后b个SFR Block使用逐元素相加。可以发现,对于四个SFR Block堆叠而成的SFRNet而言,前三个SFR Block使用按通道级联,最后一个SFR Block使用逐元素相加可以取得较低的Top-5测试错误率,同时具有较少的参数量和较小的计算复杂度。

表8 不同比例特征融合后的SFRNet系列网络在ImageNet数据集上的Top-5测试错误率(%)

Tab.8 Top-5 test error(%)of SFRNet with different feature fusion on ImageNet dataset

卷积神经网络4/03/12/21/30/4SFRNet-537.897.897.927.937.97SFRNet-696.846.846.926.926.93SFRNet-856.306.316.336.356.37SFRNet-1176.076.076.106.146.21

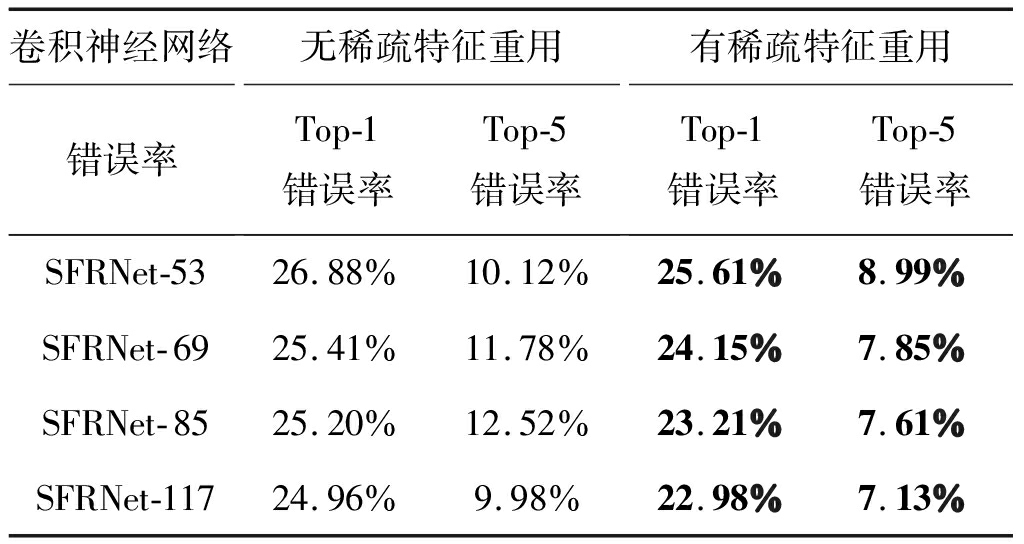

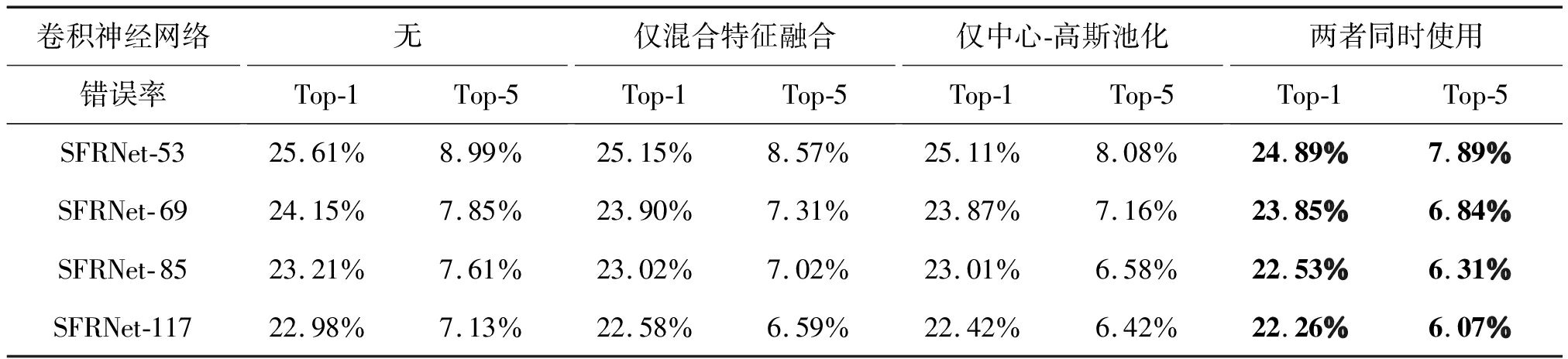

3.3.3 消融实验

为了验证稀疏特征重用、混合特征融合、高斯-中心池化的实际效果,本文对上述三点进行消融实验,可以得到表9和表10的实验结果。从表9中可以发现,稀疏特征重用是SFRNet系列网络的核心,为其降低了巨大的Top-1和Top-5测试错误率。从表10中可以发现,混合特征融合和中心-高斯池化可以辅助采用了稀疏特征重用的SFRNet系列网络,并降低一定的Top-1和Top-5测试错误率。

表9 稀疏特征重用消融实验

Tab.9 Sparse feature reuse ablation experiment

卷积神经网络错误率无稀疏特征重用Top-1错误率Top-5错误率有稀疏特征重用Top-1错误率Top-5错误率SFRNet-5326.88%10.12%25.61%8.99%SFRNet-6925.41%11.78%24.15%7.85%SFRNet-8525.20%12.52%23.21%7.61%SFRNet-11724.96%9.98%22.98%7.13%

表10 混合特征融合和中心-高斯池化消融实验

Tab.10 Hybrid feature fusion and Center-Gaussian pooling ablation experiment

卷积神经网络错误率无Top-1Top-5仅混合特征融合Top-1Top-5仅中心-高斯池化Top-1Top-5两者同时使用Top-1Top-5SFRNet-5325.61%8.99%25.15%8.57%25.11%8.08%24.89%7.89%SFRNet-6924.15%7.85%23.90%7.31%23.87%7.16%23.85%6.84%SFRNet-8523.21%7.61%23.02%7.02%23.01%6.58%22.53%6.31%SFRNet-11722.98%7.13%22.58%6.59%22.42%6.42%22.26%6.07%

4 结论

本文提出了一种适用于人脸识别这一特定场景且计算高效的特征提取网络——SFRNet。SFRNet以稀疏特征重用为核心思想,在不同层级的SFR Block中采用混合特征融合,在网络深层进行强视觉特征提取时采用中心-高斯池化。在ImageNet数据集上的实验表明,SFRNet在一般场景下也有很强的特征提取能力且具有参数量小,计算高效的特点。在LFW和MegaFace数据集上的实验表明,SFRNet适用于人脸特征提取且对大多数分类层监督具有良好的泛化性能。

[1] DENG Jia, DONG Wei, SOCHER R, et al.ImageNet: A large-scale hierarchical image database[C]∥2009 IEEE Conference on Computer Vision and Pattern Recognition.Miami, FL, USA.IEEE, 2009: 248-255.

[2] HE Kaiming, ZHANG Xiangyu, REN Shaoqing, et al.Deep residual learning for image recognition[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition(CVPR).Las Vegas, NV, USA.IEEE, 2016: 770-778.

[3] SZEGEDY C, LIU Wei, JIA Yangqing, et al.Going deeper with convolutions[C]∥2015 IEEE Conference on Computer Vision and Pattern Recognition(CVPR).Boston, MA, USA.IEEE, 2015: 1-9.

[4] HUANG Gao, LIU Zhuang, VAN DER MAATEN L, et al.Densely connected convolutional networks[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition(CVPR).Honolulu, HI, USA.IEEE, 2017: 2261-2269.

[5] YASARLA R, PATEL V M.Uncertainty guided multi-scale residual learning-using a cycle spinning CNN for single image de-raining[C]∥2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition(CVPR).Long Beach, CA, USA.IEEE, 2019: 8397-8406.

[6] AYALA D, BORREGO A, HERN NDEZ I, et al.A neural network for semantic labelling of structured information[J].Expert Systems With Applications, 2020, 143: 113053.

NDEZ I, et al.A neural network for semantic labelling of structured information[J].Expert Systems With Applications, 2020, 143: 113053.

[7] HU Jie, SHEN Li, SUN Gang.Squeeze-and-excitation networks[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition.Salt Lake City, UT, USA.IEEE, 2018: 7132-7141.

[8] BABILONI F, MARRAS I, SLABAUGH G, et al.TESA: tensor element self-attention via matricization[C]∥2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition(CVPR).Seattle, WA, USA.IEEE, 2020: 13942-13951.

[9] LEE Y, HWANG J W, LEE S, et al.An energy and GPU-computation efficient backbone network for real-time object detection[C]∥2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops(CVPRW).Long Beach, CA, USA.IEEE, 2019: 752-760.

[10] CARVALHO E F, ENGEL P M.Convolutional sparse feature descriptor for object recognition in CIFAR-10[C]∥2013 Brazilian Conference on Intelligent Systems.Fortaleza, Brazil.IEEE, 2013: 131-135.

[11] DUAN Kaiwen, BAI Song, XIE Lingxi, et al.CenterNet: keypoint triplets for object detection[C]∥2019 IEEE/CVF International Conference on Computer Vision(ICCV).Seoul, Korea(South).IEEE, 2019: 6568-6577.

[12] ZHANG Nanhai, DENG Weihong.Fine-grained LFW database[C]∥2016 International Conference on Biometrics(ICB).Halmstad, Sweden.IEEE, 2016: 1-6.

[13] MILLER D, BROSSARD E, SEITZ S, et al.MegaFace: A million faces for recognition at scale[EB/OL].2015: arXiv: 1505.02108[cs.CV].https:∥arxiv.org/abs/1505.02108.

[14] WANG Puyu, LEI Yunwen, YING Yiming, et al.Differentially private SGD with non-smooth loss[EB/OL].2021.

[15] EKKER K.Emergency management training: Handling rich qualitative and quantitative data[J].Journal of Intelligent & Fuzzy Systems, 2016, 31(2): 939-948.

[16] GUO Jinyang, OUYANG Wanli, XU Dong.Multi-dimensional pruning: A unified framework for model compression[C]∥2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition(CVPR).Seattle, WA, USA.IEEE, 2020: 1505-1514.

[17] CHO J H, HARIHARAN B.On the efficacy of knowledge distillation[C]∥2019 IEEE/CVF International Conference on Computer Vision(ICCV).Seoul, Korea(South).IEEE, 2019: 4793-4801.

[18] CHEN Kai, DING Haisong, HUO Qiang.Parallelizing Adam optimizer with blockwise model-update filtering[C]∥ICASSP 2020-2020 IEEE International Conference on Acoustics, Speech and Signal Processing(ICASSP).Barcelona, Spain.IEEE, 2020: 3027-3031.

[19] SCHROFF F, KALENICHENKO D, PHILBIN J.FaceNet: A unified embedding for face recognition and clustering[C]∥2015 IEEE Conference on Computer Vision and Pattern Recognition(CVPR).Boston, MA, USA.IEEE, 2015: 815-823.

[20] WEN Yandong, ZHANG Kaipeng, LI Zhifeng, et al.A discriminative feature learning approach for deep face recognition[C]∥Computer Vision-ECCV 2016:499-515.

[21] WANG Hao, WANG Yitong, ZHOU Zheng, et al.CosFace: large margin cosine loss for deep face recognition[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition.Salt Lake City, UT, USA.IEEE, 2018: 5265-5274.

[22] CHANG Jie, LAN Zhonghao, CHENG Changmao, et al.Data uncertainy learning in face recognition[C]∥2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition(CVPR).Seattle, WA, USA.IEEE, 2020: 5709-5718.