1 引言

合成孔径雷达(synthetic aperture radar, SAR)技术,能够实现全天时和全天候条件下提供高分辨率图像,因此在海洋监测和海上交通监管中发挥着重要作用[1-2]。近年来,TerraSAR-X、RadarSat-2、Sentinel-1和我国高分三号等卫星的飞速发展,推动了SAR图像舰船目标检测技术的研究,为军事和民用领域实现情报获取和舰船监视管理提供了重要信息技术支撑[3- 4]。

面向复杂场景下的舰船目标检测,传统方法在图像预处理之后对图像进行海陆分割处理,屏蔽陆地强散射区域以抑制虚警产生。在舰船目标检测阶段,根据SAR图像中的舰船目标和周围海洋回波分布的差异,依据人工设计特征来区分背景和舰船目标[5-7]。最后,通过分析舰船目标特征进行虚警鉴别得到大场景下的目标检测结果。其中,传统海陆分割方法主要可以两大类,第一类是以图像中海陆区域灰度分布特性为依据进行算法分割,如阈值分割法[8]、聚类法[9]、马尔科夫随机场法[10]等。第二类是基于现有地理数据库模型获取调整陆地掩膜,如文献[11]中通过地理信息匹配获取图像区域海岸线等。这两类传统分割方法对于图像质量及辅助信息要求较高,且方法需要人为进行参数调整,泛化性和稳定性较差,难以满足现实应用需求。传统SAR图像舰船目标检测方法中CFAR检测方法以其原理简单、检测效率高等特点而备受众多学者研究,形成了基于K分布[12]、G0分布等统计分布方法和SO-CFAR[13]、GO-CFAR[14]等策略型改进方法。这些方法对于某类特定场景能够产生较好的检测效果,但方法需要人为分析目标与背景特性,并且参数设计变化复杂,方法的自适应性明显不足,难以应用于复杂场景中舰船目标检测。

最近几年,由于卷积神经网络的强大特征提取能力,深度学习方法在对象检测、分类识别和目标分割等领域取得了巨大的成功[15-17]。在海陆分割研究任务中,文献[18]设计了DeepUNet网络架构,通过设计上下两部分采样模块,替代了原有U-Net网络编码-解码结构的卷积层,提高了光学遥感图像中海陆分割精度。文献[19]利用密集深度可分离网络的强大特征提取能力,构建了可提取图像高维特征的分割网络架构,实现了SAR图像海陆区域较为精确的分割。对于SAR图像目标检测任务,不同于传统的CFAR检测算法,基于深度学习的检测算法不需要复杂的建模过程,因此,引发了众多学者的研究兴趣。文献[20]基于SSD检测框架提出利用注意力机制优化复杂场景下的舰船目标特征,提升网络检测性能。文献[21]结合场景分类进行分层渐进检测,提高了近岸区域场景下目标检测精度及速度。文献[22]提出了一种基于自适应调整机制的深度神经网络,通过将旋转检测和单级检测相结合提升舰船检测性能。文献[23]提出了一种基于无锚框设定的特征平衡和优化网络,设计利用注意力引导平衡金字塔不同层次特征提取。文献[24]设计自上而下和自下而上的组合特征融合方式, 提升了复杂背景下多尺度和小尺度舰船检测性能。目前,基于深度学习方法的SAR图像目标检测方法多是基于anchor机制,该类方法会在特征图的每个像素点预定义不同尺度和纵横比的候选框。然而,这类方法在解决复杂大场景目标检测问题时,密集候选框的设定会消耗较大的计算资源,严重影响了检测的效率和性能。相比之下,anchor-free方法网络架构更为简洁,无锚框设计思想将极大程度减少占用的计算资源,更适用于实际应用中大场景目标检测。

传统检测方法需要人工设计特征且参数调节繁琐,算法对复杂场景适应性较差。现有基于深度学习的检测方法,能够提高检测自动化和智能化水平,但应于实际复杂大场景中还存在以下主要问题。一是大场景图像图幅较大,而舰船目标呈现较为明显的稀疏分布现象且相对尺寸较小,无法直接将整景图像送入网络进行处理。二是复杂场景中陆地目标影响较大,直接进行分块处理送入网络检测会导致陆地虚警较多,检测性能下降。三是舰船目标在大场景中占比较小,如果直接对大场景图像进行遍历搜索目标将会降低算法的运行效率。

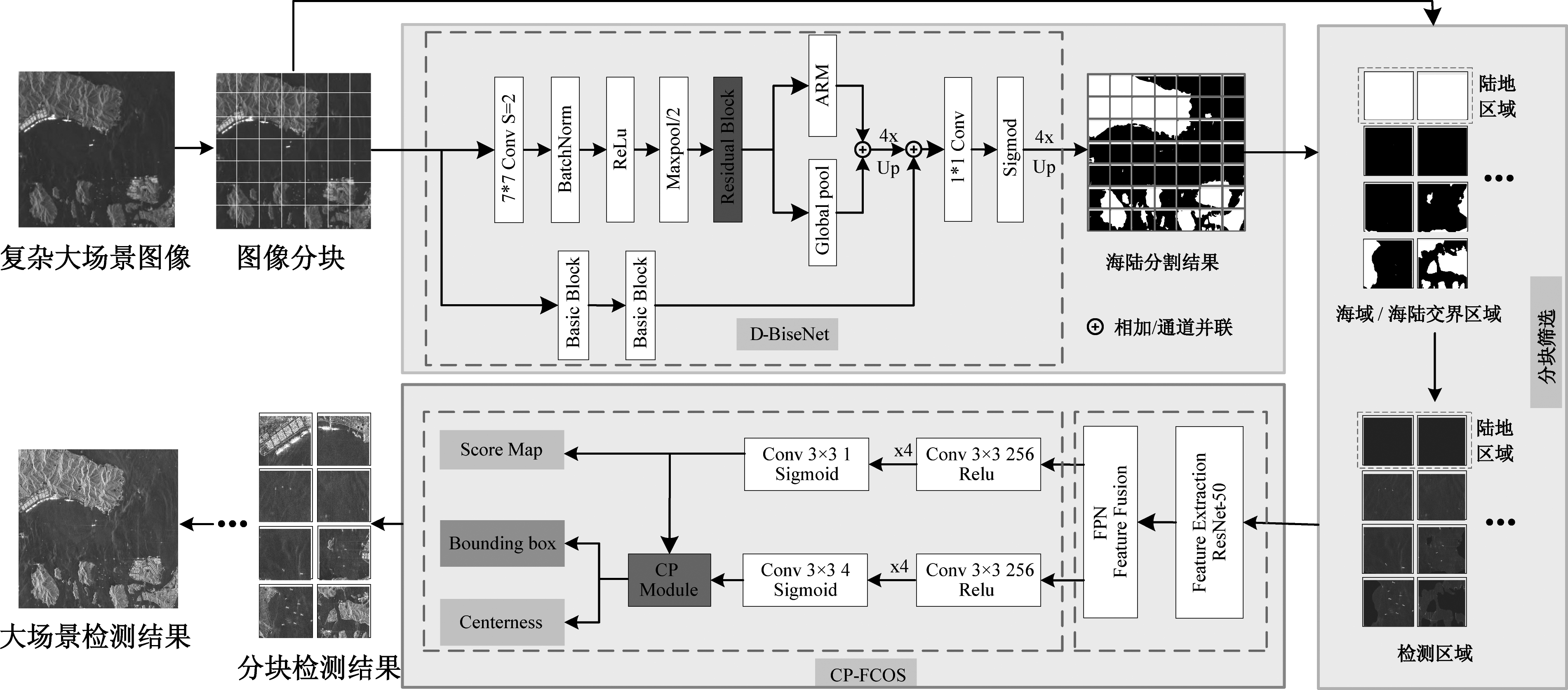

针对以上问题,本文提出了一种级联检测框架,该框架主要由D-BiSeNet海陆分割、分块区域筛选和CP-FCOS目标检测三部分级联而成。首先,对大场景图像进行分块处理,利用改进双边分割网络(Bilateral Segmentation Network)[25]对图像块进行海陆分割,有效分离海域与陆地区域;通过海域面积比分析,筛选剔除不包含目标的区域分块,得到待检测区域;最后将待检测区域送入Category-Position导引模块优化的FCOS[26]检测网络进行检测,通过合并分块检测结果得到大场景舰船目标检测结果。

2 方法

常规深度学习方法在解决大场景图像中目标检测问题时,通常直接将图像进行滑窗分割为切片,再利用经典深度检测网络Faster-RCNN、YOLO和SSD等对关注目标进行检测。但是这种方法存在的最直接问题是大量冗余图输入导致检测效率急剧下降,与此同时,先验可知的陆地区域检测将会导致大量虚警的产生。图1为典型的基于深度学习方法对大尺寸SAR图像提取舰船目标的框图。由图可以看出,通常采用密集滑窗的方式将SAR大尺寸图像切分成小切片,而后基于切片图像进行舰船目标提取。上述方法存在冗余信息,浪费计算资源,且切片图像中的陆地区域易产生虚警使得检测性能降低。

图1 常规基于深度学习的目标检测框图

Fig.1 The detection framework based on deep learning

基于以上考虑,对于复杂大场景SAR图像舰船目标检测任务,本文结合传统和深度检测方法思想构建级联框架,图2为网络总体框架图。该检测框架主要由D-BiSeNet海陆分割网络和CP-FCOS目标检测网络通过分块区域筛选模块级联而成。

图2 本文检测网络总体框架图

Fig.2 The overall frame structure of this paper

2.1 D-BiSeNet网络[25]

D-BiSeNet主要完成舰船检测算法中海陆分割功能,是基于传统双边分割网络改进的SAR图像分割网络。该网络由上下两个支路组成,上支路使用ResNet-18轻量化模型作为骨干网进行特征提取,可以在充分提取图像高维特征信息的同时减少网络的计算量,从而降低模型复杂度提高整体检测效率。其具体操作细节如下:首先将输入图像经过大小为7×7、步长为2的卷积核处理,提取图像最底层特征,批标准化处理调整数据分布为正态分布,以提高网络训练的稳定性,提取特征经过Relu激活函数提高网络非线性表达能力。通过将全局池化和两倍下采样后的底层特征送入残差模块进行深度特征提取,提高分割网络对SAR场景图像的高维特征获取能力。残差模块(Residual Block)由两个残差子模块构成,其具体结构如图3所示。最后将提取的高维特征经过全局平均池化和注意力模块(ARM)引导两部分进行特征优化,丰富提取特征中的上下文信息。与此同时,下支路则是将图像经过两个基础卷积模块(Basic Block)处理,每个基础模块由卷积层、批标准化层和激活层组成。经过两个基础模块连接处理,能够使得输出特征保留图像更多的空间位置信息[25]。

图3 残差卷积模块结构图

Fig.3 The frame structure of residual block

上支路输出的高维非线性特征进行4倍上采样后与下支路输出的低维空间特征进行通道并联,将融合后的特征通过大小为1×1的卷积核进行通道降维,最终通过Sigmoid激活函数将降维特征映射到[0, 1]区间得到海陆分割结果。

2.2 分块区域筛选

大场景SAR图像经过分块和海陆分割处理之后能够有效去除陆地区域对检测的影响,从而提高检测准确率。然而,直接将分割后的所有分块进行目标检测,不仅增加了处理时间还占用了内存,不利于工程的实际应用。因此,为了提高检测效率,本文依据大场景分块后的海陆分割结果,进行图像检测区域选择。根据海陆分割结果将切片图像分为三类场景:开阔海域,陆地区域,海陆交界区域,三类场景的原始图像、海陆分割结果和分割叠加后检测区域切片如图4所示。

图4 场景区域分块筛选示例

Fig.4 Example of scene block selection

相比于原始场景切片和映射后的检测区域切片,海陆分割二值化切片所呈现出的像素对比度信息更为直接,更易于对三类场景进行选择。定义切片海域面积比参数:

(1)

式中Ssea表示切片中海域像素总值,Sland表示切片中陆地像素总值。在整个大场景图像中,用于目标检测的区域必定是存在舰船目标的海陆混合区域或纯海区域。因此,对海陆分割结果中所有图像块进行海域面积比参数计算,选择超过设定阈值R的图像块作为候选区域送入检测器检测,如此可以有效去除无目标区域,提高检测效率。

2.3 CP-FCOS2.3.1 CP-FCOS网络结构

CP-FCOS网络是基于经典的anchor-free网络FCOS改进的舰船目标检测网络,图2为具体结构图。该检测网络主要分为三部分:特征提取网络、特征融合网络和Category-Position特征优化检测头。网络采用深度残差网络ResNet-50[27]作为骨干网络提取图像特征,而后利用特征金字塔网络FPN[28]融合提取的各层特征得到特征金字塔,最后通过改进检测头在融合后的特征图上对目标的类别和位置进行回归预测。

改进的检测头主要包含三路预测分支以及一个CP注意力特征优化模块。上两路预测分支分别回归目标类别和位置,CP注意力特征优化模块结合两路特征生成导引向量优化边框回归路径特征。目标分类子网络对特征金字塔某一层输出的特征图,使用4个3×3×256的卷积核进行处理,每一层卷积层之后都加入ReLu激活函数处理卷积层的输出,最后通过1个3×3×1的卷积核并进行Sigmoid激活得到网络的分类输出结果。边界框回归网络结构大体与目标分类子网络一致,不同的是最后使用的是1个3×3×4的卷积核卷积并使用Sigmoid激活函数得到网络最终的输出。第三路分支为中心性预测分支,其与边界框回归共享网络参数,中心性表示正样本区域内的点(i, j)距离标注框中心点的远近程度。

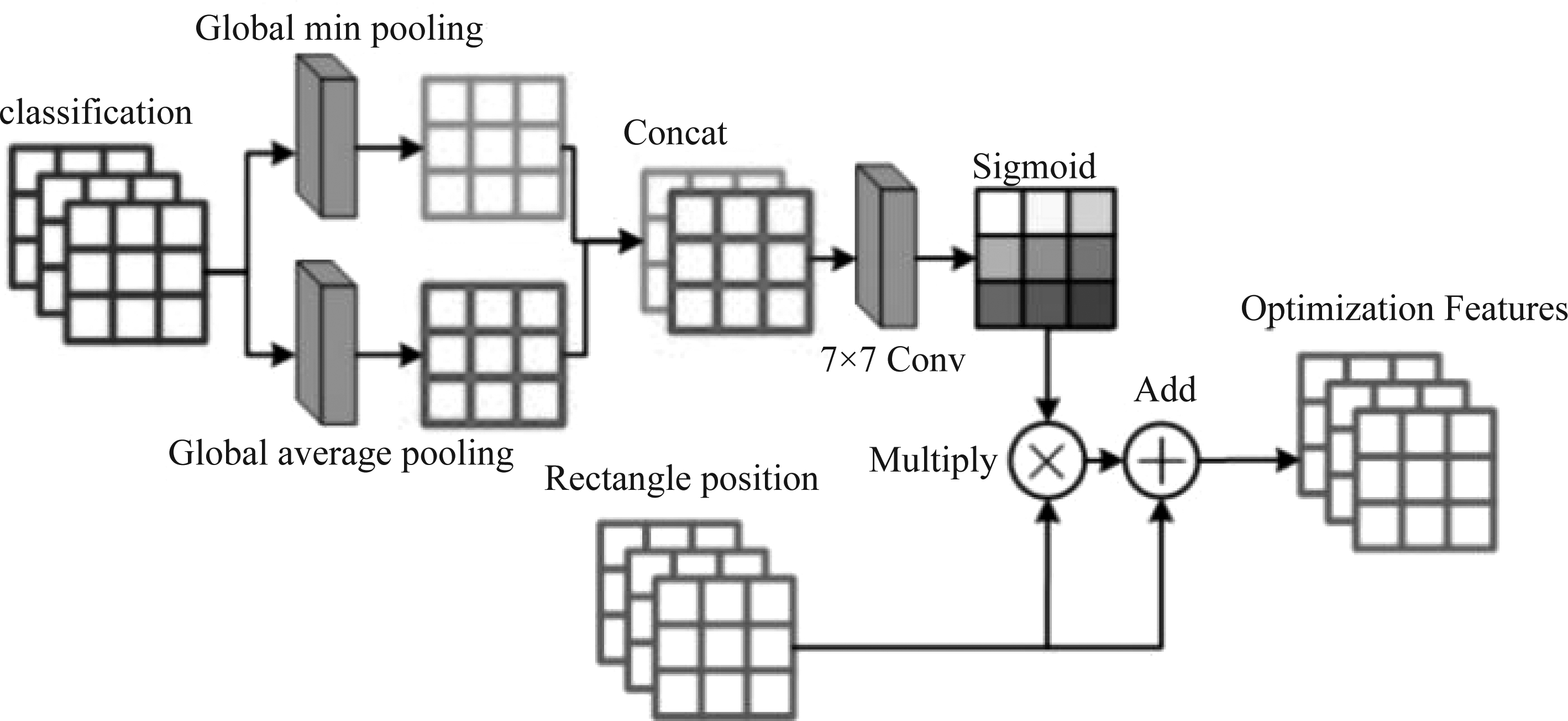

2.3.2 Category-Position导引模块

检测头采用图5所示Category-Position特征优化模块,其基于分类分支特征生成导引向量进而优化位置回归分支特征。模块中,分类分支的特征图分别经过全局最小池化和全局平均池化,而后通过通道并联进行链接,再对其进行卷积核大小为7×7 的卷积和sigmoid激活操作,生成特征导引向量。最后将该向量与位置回归分支的特征图做乘法操作,再与特征自身进行加和操作,生成位置及中心度回归预测的输入特征。

图5 Category-Position模块结构

Fig.5 Category-Position module

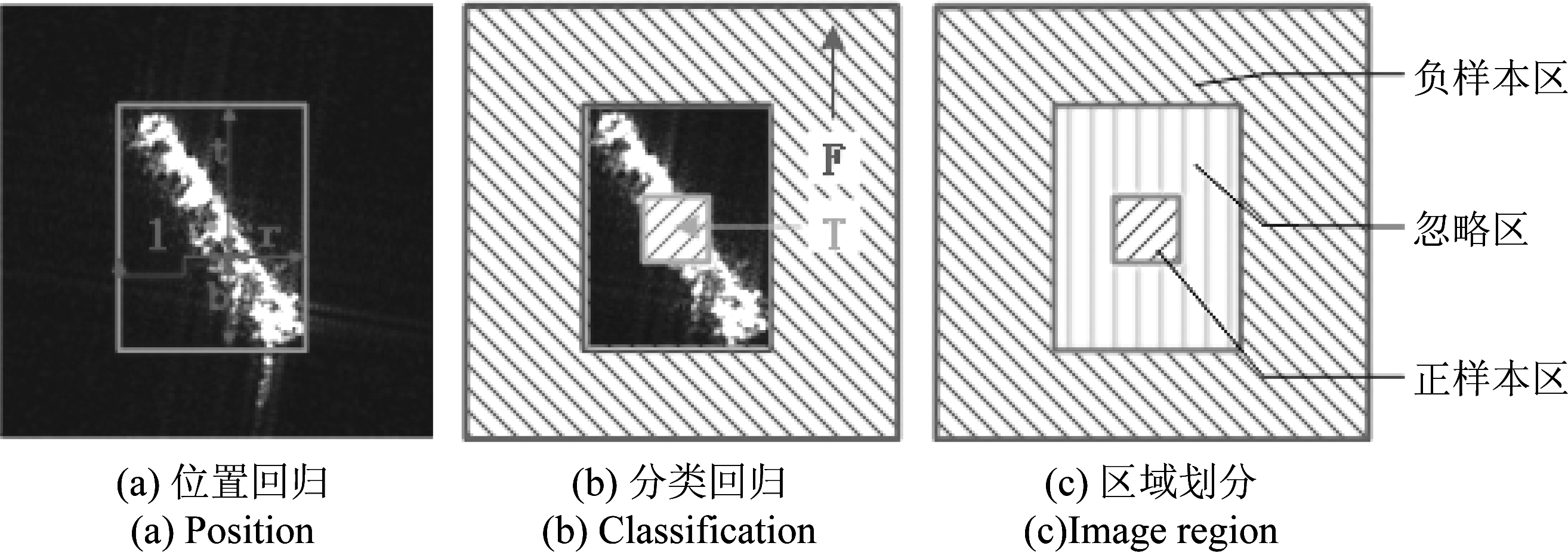

2.3.3 网络回归策略

不同于FCOS网络的回归思想,本文通过限定特征金字塔不同层级特征图边界框的回归范围,来降低真实边界框重叠带来的模糊性问题,算法具体步骤为计算各层特征图上舰船目标所在位置的回归目标(l,t,r,b)。如果某一像素位置满足

max(l,t,r,b)>Mi or min(l,t,r,b)<Mi-1

(2)

则会被设为负例,不会在该级特征图上进行类别及位置回归。其中,Mi是第i层特征图最大回归距离。模型设置[M1,M2,M3,M4,M5,M6]为[0,32,64,128,256,+Inf]。

依据SAR图像中舰船目标在矩形框内占比较小的特点,重新设计目标分类与边界框回归方法,将图像内容分为正样本区、负样本区、忽略区三部分,回归目标及图像区域划分如图6所示。

图6 回归目标及图像区域划分

Fig.6 Regression target and image region division

其中,正样本区为特征图上以舰船目标中心点展开一定距离的区域,区域大小不超过舰船目标真实外轮廓,本文中正样本区宽度取目标回归所在特征图1.5倍像元长度。负样本区为所有舰船目标标注框以外区域,该区域内全为海陆背景。图像中其他区域为忽略区,该区域内目标类别定义较模糊,容易对网络训练造成干扰。在网络训练时,分类分支对正样本区和负样本区内的点进行回归,忽略区不参与分类损失计算;位置回归分支对正样本区和忽略区内的点进行回归,负样本区内的点不参与回归损失计算。

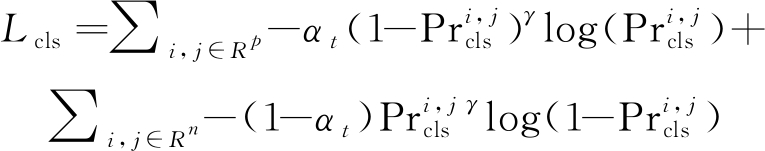

2.3.4 CP-FCOS损失函数

损失函数计算三个分支在特征图上对应区域的损失,其定义如式(3)所示

(3)

式中Npos为标准结果中正样本像素点的数量,m、n和1为损失平衡权重,用于调节三类损失占比。

类别回归分支采用Focal Loss作为分类损失函数,其计算表达式为:

(4)

其中,αt用来调节正负样本在训练过程中的重要性。γ为调制因子,用来降低容易分类的样本在模型中所占的比重,Rp和Rn分别表示特征图中正负样本区域集。

位置回归分支采用IOU LOSS计算位置回归损失,其表达式为:

(5)

其中,![]() 表示点(i, j)所属的真实框,

表示点(i, j)所属的真实框,![]() 表示点(i, j)的预测框,

表示点(i, j)的预测框,![]() 表示预测框与真实框之间的交并比,Ri表示特征图中忽略区域点集。

表示预测框与真实框之间的交并比,Ri表示特征图中忽略区域点集。

中心性预测分支采用交叉熵作为损失函数,其函数表达式为:

(6)

其中,![]() 表示点(i, j)的中心度预测值,

表示点(i, j)的中心度预测值,![]() 表示点(i, j)的中心度真实值,BCE表示求二进制交叉熵[26]。

表示点(i, j)的中心度真实值,BCE表示求二进制交叉熵[26]。

3 实验过程及分析

本文针对复杂大场景SAR图像舰船目标检测任务,设计了一种结合海陆分割、区域选择和目标检测的一体化检测架构,实现了大场景舰船目标的快速稳定检测。利用高分三号和哨兵一号图像数据,对所提检测框架进行评估,与CFAR传统检测算法、Faster-RCNN和RetinaNet深度学习检测方法进行对比分析,为充分验证网络检测性能,各深度学习检测方法均选用相同ResNet50预训练模型作为骨干网络。

3.1 实验数据集

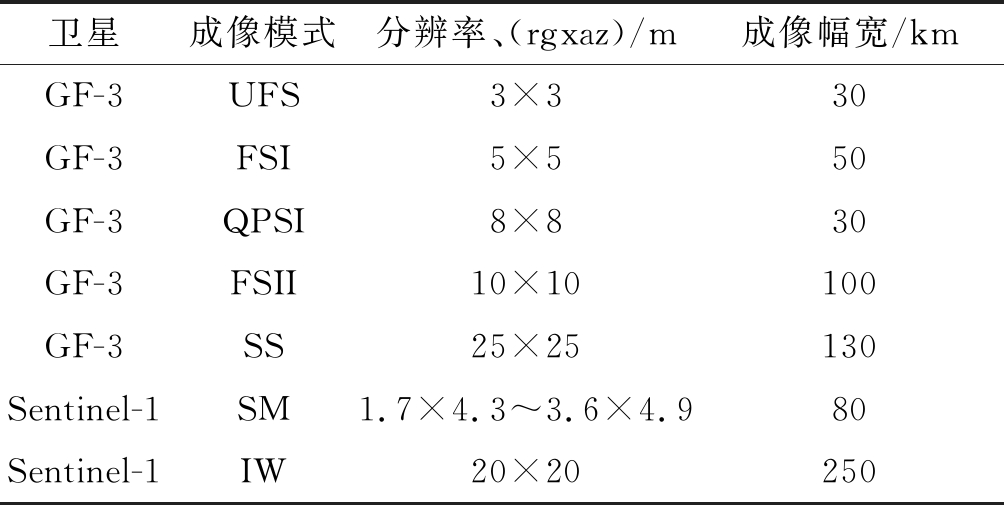

高分三号卫星是我国首颗C频段多极化高分辨率合成孔径雷达卫星[29],哨兵一号是欧洲极地轨道C频段雷达成像卫星。实验选用高分三号和哨兵一号卫星大场景实测数据,其中,高分三号卫星数据覆盖的范围主要是我国的部分港口和亚洲国家的若干港口,哨兵一号数据主要覆盖范围是巴西和美国等国家复杂港口区域[30]。表1显示了用于本实验的SAR数据主要信息,包括成像模式、分辨率、幅宽。

表1 SAR数据详细信息

Tab.1 Detailed information for SAR imagery

卫星成像模式分辨率、(rgxaz)/m成像幅宽/kmGF-3UFS3×330GF-3FSI5×550GF-3QPSI8×830GF-3FSII10×10100GF-3SS25×25130Sentinel-1SM1.7×4.3~3.6×4.980Sentinel-1IW20×20250

实验将收集到的50景大场景数据按照7∶3的比例分为训练集和测试集两部分,数据覆盖两种传感器、多种分辨率及成像模式,图幅约为25000×25000像素,覆盖范围包括港口、岛屿和开阔海域等多种复杂场景。由于网络输入尺寸限制,本文统一将大场景SAR图像分割为1024×1024大小切片,其中,训练数据集共有20000张,测试数据集共有8500张。此外,为了提升海陆分割和整体检测效率,将切片图像进行3倍下采样后送入海陆分割网络,最终通过结果合并得到大场景检测结果。

3.2 实验环境及参数设置

本文实验主要基于python编程语言实现,电脑操作系统为windows7,环境配置为CUDA9.2、cudnn7和torch1.3.1,计算机显卡为NVIDIA GTX Geforce 1080Ti。

文中实验均在相同环境中进行,结合环境平台配置、网络收敛要求和多次实验得出的最佳结果进行如下网络参数设置:海陆分割模块设置网络batch_size为5,初始学习率为0.001,训练迭代次数epoch为50。通过超参数λ的变化设定来控制海陆分割损失中绝对值损失的占比,实验采用SGD[31]对网络参数优化调整。目标检测模块中传统双参数CFAR检测器假定背景分布为高斯分布,参考文献[32]设置背景窗口大小为55,保护窗口大小为45,目标窗口大小为30,虚警概率为0.05。各种深度学习检测网络同海陆分割网络的参数选取准则进行如下设定:batch_size为2,迭代次数为60000,同样采用SGD算法对网络参数进行优化,初始学习率设为0.0004,权重衰减系数设为0.00002。

3.3 实验结果与分析

实验将选用的目标检测方法在设定数据集上进行了验证比较,采用目标检测率Pd、虚警率Pf和检测F1分数评价网络整体检测性能。其具体表达式分别为

(7)

(8)

(9)

其中,Ntp为算法检测结果中真实舰船目标的数目,Ngt为图像中真实舰船目标的数目,Nfp表示检测结果中错误目标的数目,Ntp+Nfp表示检测结果目标总数。

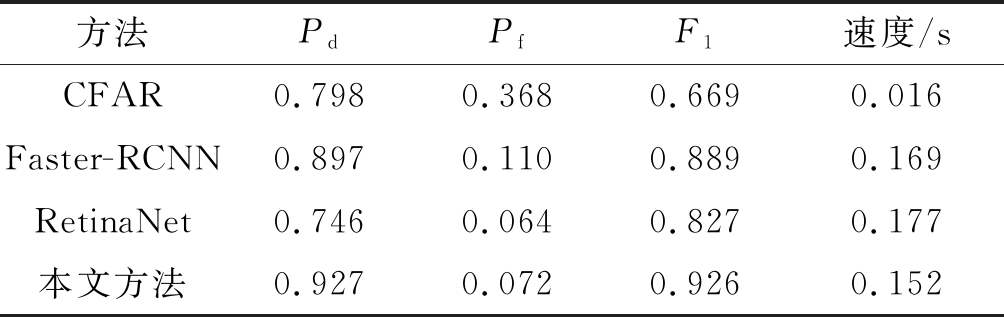

由于大场景图像尺寸不一,故速度评估为单切片处理时间s/1024×1024。为了更加凸显各检测方法的性能,所对比方法均采用本文所提级联检测流程,将四种检测方法直接应用于改进海陆分割和区域筛选后检测区域的检测。表2为各方法总体检测统计结果,由表可以看出,本文所提方法与传统CFAR、深度学习方法Faster-RCNN和RetinaNet相比,检测准确率分别提升12.9%、3.0%和18.1%,虚警率较CFAR和Faster-RCNN分别降低29.6%和3.8%,较RetinaNet方法略提高0.8%,这主要是因为本文方法中特征导引优化和回归方式改进设计,使得在同样复杂区域能够检测出更多正确目标并减少虚警目标的产生,而RetinaNet网络未充分提取近岸边缘区域特征,导致其目标漏检较多,虚警率也相对较低。对比综合检测指标F1分值,可以发现改进方法较CFAR、Faster-RCNN和RetinaNet方法分别提升25.7%,3.7%和9.9%,展现出较强的综合检测优势。在检测速度方面,对比实验选用双参数CFAR检测方法,其实现过程相对深度检测网络较为简单,因而在检测速度上有一定的优势,但该方法仅依靠强度信息进行目标检测易产生大量虚警和靠岸地区漏检,综合检测性能较差。改进的anchor-free网络的快速检测能力,使得本文所提网络在性能提升的基础上,其检测速度相比较其他两种典型深度学习检测方法能够提升10.0%以上,特别地,应用于复杂大场景时处理数据的高效性将更加凸显。

表2 不同方法总体检测结果

Tab.2 The overall results of different method

方法PdPfF1速度/sCFAR0.7980.3680.6690.016Faster-RCNN0.8970.1100.8890.169RetinaNet0.7460.0640.8270.177本文方法0.9270.0720.9260.152

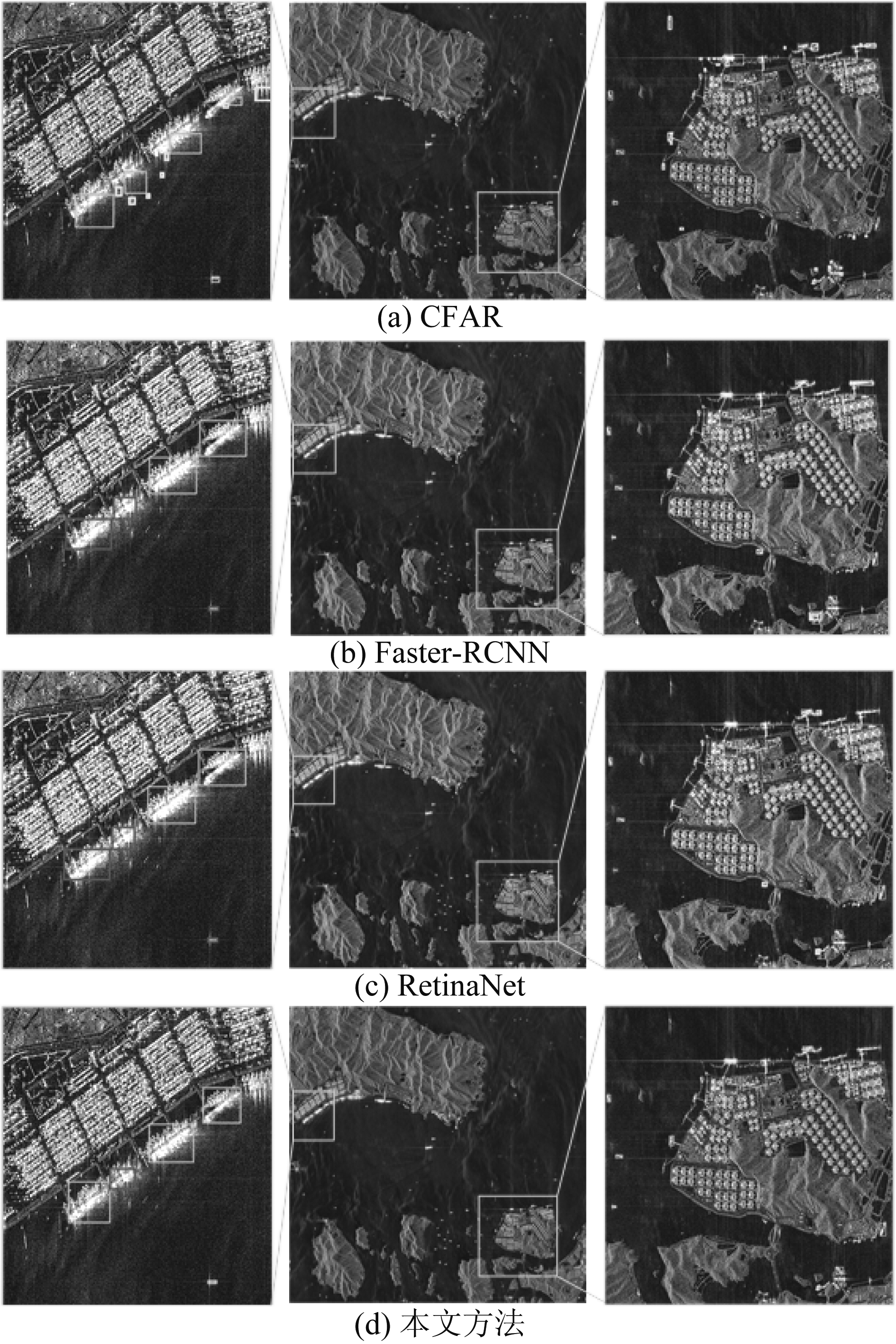

图7 场景1检测结果

Fig.7 The test results of scenario 1 image

图7为本文所列四种对比方法对于大场景图像处理的结果图。为了能更直观地分析检测结果,在图像中将部分区域放大。其中,蓝色框表示为正确检测目标,黄色为错检目标,红色为漏检目标。表3为对应检测统计结果,主要统计检测出的正确目标数Ntp、虚警目标数Nfp、相应的准确率Pd、虚警率Pf和F1分数。表3结果显示,对于此类复杂场景区域,在经过改进的D-BiSeNet海陆分割和区域筛选处理后,陆地区域虚警显著降低。对比于Faster-RCNN和RetinaNet两种方法,本文方法在降低检测冗余的基础上,能够更为准确地检测出靠岸目标以及海上小目标,这主要是因为网络特征提取的优化及目标回归方式的改进,从而增强了算法对于复杂背景下目标的辨识和定位能力。

表3 场景图1检测结果统计

Tab.3 The test results of scenario 1 image

方法NtpNfpPdPfF1CFAR521410.8530.7310.410Faster-RCNN54110.8850.1690.857RetinaNet4750.7710.0960.832本文方法5550.9020.0830.909

图8 场景2检测结果

Fig.8 The test results of scenario 2 image

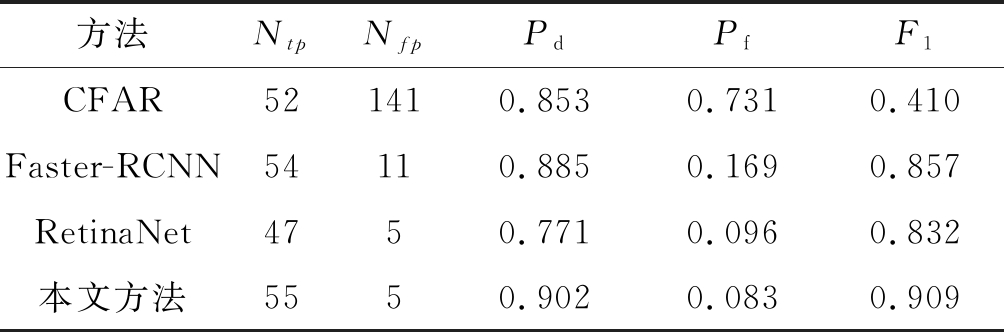

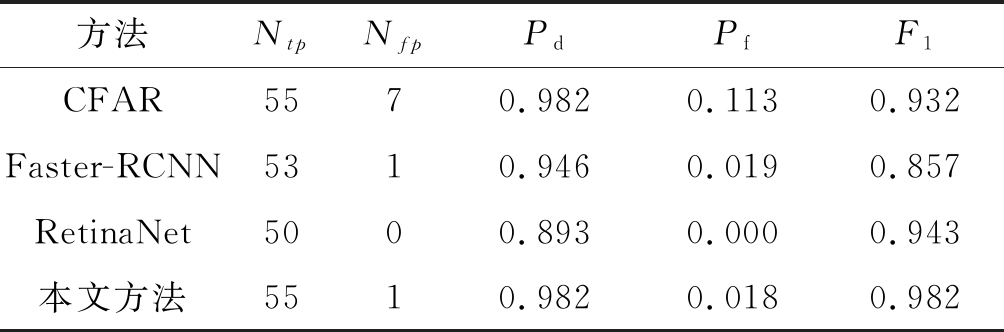

根据检测结果可以看到,传统CFAR方法检测效率较低,对于舰船密集停泊区域出现了较多的漏检,这说明了传统CFAR方法难以应用于此类复杂场景,其检测稳定性较差。相比较于传统方法,其他三种深度方法能够较大程度地抑制虚警,而本文所提方法检测性能更为突出,其目标检测准确率高、虚警率低,总体F1分值显著提高,较Faster-RCNN、RetinaNet分别高出12.5%和3.9%。图8为密集排布、小尺度场景检测结果,从中可以看到改进的级联检测方法能够提高小目标检测性能并显著控制虚警的产生。表4为对应统计结果。依据统计结果可以看出,本文所提出的复杂场景检测框架应用于此类简单场景同样能够有较高的检测性能,这也说明了本文方法具有较强泛化性和稳定性。

表4 场景图2检测结果统计

Tab.4 The test results of scenario 2 image

方法NtpNfpPdPfF1CFAR5570.9820.1130.932Faster-RCNN5310.9460.0190.857RetinaNet5000.8930.0000.943本文方法5510.9820.0180.982

4 结论

本文针对复杂大场景SAR图像舰船目标检测问题,设计了一种基于级联网络的快速检测框架。整体框架由D-BiSeNet海陆分割、分块区域筛选和CP-FCOS目标检测三部分组成。该框架利用改进的D-BiSeNet分割网络对大场景图像进行海陆分割处理,通过网络模型的优化设计,提升了复杂场景的分割性能。分块区域筛选模块依据分块分割结果进行检测区域选择,进一步减少算法处理区域,提高了整体检测速度。利用改进的检测网络CP-FCOS进行目标检测,强化网络特征提取能力,并结合提出的改进目标分类和边界框回归方式,提高了舰船目标定位效果。

实验过程对所提框架同时在高分三号和哨兵一号实测数据上进行了测试,并与传统CFAR和两种经典深度学习方法进行对比分析,实验结果表明:(1)本文所提的级联框架中D-BiSeNet模块能够较好地分离复杂场景中陆地区域,去除大量无目标背景区域,降低虚警率同时提升处理速度;(2)多场景实测数据实验表明,相比较传统CFAR和两种深度方法,本文检测框架准确率较高,综合检测性能最佳,且方法的稳定性、泛化性较强;(3)本文框架采用改进的anchor-free检测网络,在大场景检测速度上有明显的优势,特别地,对于复杂场景检测性能更为突出。综合分析可知,本文所提级联框架对于复杂大场景SAR图像具有较高的检测性能,其在检测精度和检测速度上具有明显优势,能应用于实际需求。后续研究将进一步探索设计性能更佳的无锚框检测网络,在设计更优的特征金字塔构建方式,充分融合底层空间信息和高层语义信息,提升网络检测准确率的同时,通过对特征筛选模块和级联网络的优化设计来提升网络整体检测速度,使之应用于复杂大场景时能够展现出更加优越的综合检测性能。

[1] WEI Shunjun, SU Hao, MING Jing, et al. Precise and robust ship detection for high-resolution SAR imagery based on HR-SDNet[J]. Remote Sensing, 2020, 12(1): 167.

[2] 应自炉, 宣晨, 翟懿奎, 等. 面向小样本SAR图像识别的自注意力多尺度特征融合网络[J]. 信号处理, 2020, 36(11): 1846-1858.

YING Zilu, XUAN Chen, ZHAI Yikui, et al. Self-attention multiscale feature fusion network for small sample SAR image recognition[J]. Journal of Signal Processing, 2020, 36(11): 1846-1858.(in Chinese)

[3] EL-DARYMLI K, MCGUIRE P, POWER D, et al. Target detection in synthetic aperture radar imagery: a state-of-the-art survey[J]. Journal of Applied Remote Sensing, 2013, 7(1): 71598-71632.

[4] CHEN Wenting, JI Kefeng, XING Xiangwei, et al. Ship recognition in high resolution SAR imagery based on feature selection[C]∥2012 International Conference on Computer Vision in Remote Sensing. Xiamen, China. IEEE, 2012: 301-305.

[5] CRISP D J.The State-of-the-Art in Ship Detection in Synthetic Aperture Radar Imagery[R]. Edinburgh, South Australia: DSTO Information Sciences Laboratory, 2014:013-053.

[6] IERVOLINO P,GUIDA R,WHITTAKER P.A novel ship-detection technique for Sentinel-1 SAR data[C]∥2015 IEEE 5th Asia-Pacific Conference on Synthetic Aperture Radar (APSAR). Singapore. IEEE, 2015: 797- 801.

[7] SCHULZ K, SOERGEL U, THOENNESSEN U. Segmentation of moving objects in SAR-MTI data[C]∥Aerospace/Defense Sensing, Simulation, and Controls. Proc SPIE 4382, Algorithms for Synthetic Aperture Radar Imagery VIII, Orlando, FL, USA. 2001, 4382: 174-181.

[8] OTSU N.A threshold selection method from gray-level histograms[J].IEEE Transactions on Systems,Man,and Cybernetics, 1979, 9(1): 62- 66.

[9] LIU Chun, YANG Jian, YIN Junjun, et al. Coastline detection in SAR images using a hierarchical level set segmentation[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2016, 9(11): 4908- 4920.

[10] LIU Zhongling, LI Fei, LI Ning, et al. A novel region-merging approach for coastline extraction from sentinel-1A IW mode SAR imagery[J]. IEEE Geoscience and Remote Sensing Letters, 2016, 13(3): 324-328.

[11] 黄祥李,张杰,计科峰,等. 基于GSHHG数据库与改进CV模型的SAR图像海陆分割算法[C]∥第五届高分辨率对地观测学术年会论文集, 西安, 2018:16.

HUANG Xiangli, ZHANG Jie, JI Kefeng, et al. Sea-land Segmentation Algorithm of SAR Image Based on GSHHG Database andImproved CV Model[C]∥The 5th China High Resolution Earth Observation Conference, Xi’an, 2018:16.(in Chinese)

[12] FRERY A C, MULLER H J, YANASSE C C F, et al. A model for extremely heterogeneous clutter[J]. IEEE Transactions on Geoscience and Remote Sensing, 1997, 35(3): 648- 659.

[13] NOVAK L M, HESSE S R. On the performance of order-statistics CFAR detectors[C]∥[1991]Conference Record of the Twenty-Fifth Asilomar Conference on Signals, Systems & Computers. Pacific Grove, CA, USA. IEEE, 1991: 835- 840.

[14] NOVAK L M. Performance of a high-resolution polarimetric SAR automatic target recognition system[J]. Lincoln Laboratory Journal, 1993, 6(1):11-24.

[15] CHEN L C, PAPANDREOU G, KOKKINOS I, et al. DeepLab: semantic image segmentation with deep convolutional nets, atrous convolution, and fully connected CRFs[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2018, 40(4): 834- 848.

[16] ZHAO Zhongqiu, ZHENG Peng, XU Shoutao, et al. Object detection with deep learning: A review[J]. IEEE Transactions on Neural Networks and Learning Systems, 2019, 30(11): 3212-3232.

[17] HE Jinglu, WANG Yinghua, LIU Hongwei. Ship Classification in Medium-Resolution SAR Images via Densely Connected Triplet CNNs Integrating Fisher Discrimination Regularized Metric Learning[J]. IEEE Transactions on Geoscience and Remote Sensing, 2020:1-18.

[18] LI Ruirui, LIU Wenjie, YANG Lei, et al. DeepUNet: A deep fully convolutional network for pixel-level sea-land segmentation[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2018, 11(11): 3954-3962.

[19] 张金松, 邢孟道, 孙光才. 一种基于密集深度分离卷积的SAR图像水域分割算法[J]. 雷达学报, 2019, 8(3): 400- 412.

ZHANG Jinsong, XING Mengdao, SUN Guangcai. A water segmentation algorithm for SAR image based on dense depthwise separable convolution[J]. Journal of Radars, 2019, 8(3): 400- 412.(in Chinese)

[20] ZHANG Xiaohan, WANG Haipeng, XU C, et al. A lightweight feature optimizing network for ship detection in SAR image[J]. IEEE Access, 2019, 7: 141662-141678.

[21] 付晓雅, 王兆成. 结合场景分类的近岸区域SAR舰船目标快速检测方法[J]. 信号处理, 2020, 36(12): 2123-2130.

FU Xiaoya, WANG Zhaocheng. SAR ship target rapid detection method combined with scene classification in the inshore region[J]. Journal of Signal Processing, 2020, 36(12): 2123-2130.(in Chinese)

[22] CHEN Chen,HE Chuan,HU Changhua,et al.MSARN: A deep neural network based on an adaptive recalibration mechanism for multiscale and arbitrary-oriented SAR ship detection[J]. IEEE Access, 2019, 7: 159262-159283.

[23] FU Jiamei, SUN Xian, WANG Zhirui, et al. An anchor-free method based on feature balancing and refinement network for multiscale ship detection in SAR images[J]. IEEE Transactions on Geoscience and Remote Sensing, 2021, 59(2): 1331-1344.

[24] DAI Wenxin, MAO Yuqing, YUAN R, et al. A novel detector based on convolution neural networks for multiscale SAR ship detection in complex background[J]. Sensors, 2020, 20(9): 2547.

[25] 戴牧宸, 冷祥光, 熊博莅, 等. 基于改进双边网络的SAR图像海陆分割方法[J]. 雷达学报, 2020, 9(5): 886- 897.

DAI Muchen, LENG Xiangguang, XIONG Boli, et al. Sea-land segmentation method for SAR images based on improved BiSeNet[J]. Journal of Radars, 2020, 9(5): 886- 897.(in Chinese)

[26] TIAN Zhi,SHEN Chunhua, CHEN Hao, et al. FCOS: fully convolutional one-stage object detection[C]∥2019 IEEE/CVF International Conference on Computer Vision (ICCV).Seoul,Korea (South).IEEE, 2019:9626-9635.

[27] HE Kaiming, ZHANG Xiangyu, REN Shaoqing, et al. Deep residual learning for image recognition[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Las Vegas, NV, USA. IEEE, 2016: 770-778.

[28] LIN T Y,DOLL R P,GIRSHICK R,et al.Feature pyramid networks for object detection[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Honolulu,HI,USA.IEEE,2017:936-944.

R P,GIRSHICK R,et al.Feature pyramid networks for object detection[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Honolulu,HI,USA.IEEE,2017:936-944.

[29] 孙显,王智睿,孙元睿,等. AIR-SARShip-1.0:高分辨率SAR舰船检测数据集[J]. 雷达学报,2019,8(6):852- 862.

SUN Xian, WANG Zhirui, SUN Yuanrui, et al. AIR-SARShip-1.0: High-resolution SAR ship detection dataset[J]. Journal of Radars, 2019, 8(6): 852- 862.(in Chinese)

[30] WANG Yuanyuan, WANG Chao, ZHANG Hong, et al. A SAR dataset of ship detection for deep learning under complex backgrounds[J]. Remote Sensing, 2019, 11(7): 765.

[31] RUDER S. An overview of gradient descent optimization algorithms[J]. Computer Science-Learning, 2016.

[32] 艾加秋, 齐向阳, 禹卫东. 改进的SAR图像双参数CFAR舰船检测算法[J]. 电子与信息学报, 2009, 31(12): 2881-2885.

AI Jiaqiu, QI Xiangyang, YU Weidong. Improved two parameter CFAR ship detection algorithm in SAR images[J]. Journal of Electronics & Information Technology, 2009, 31(12): 2881-2885.(in Chinese)