1 引言

基于深度神经网络的多源图像内容自动分析与目标识别方法近年来取得巨大进步。然而,深度神经网络对于视觉不可感知微小扰动的对抗脆弱性和深度计算模型决策过程的黑盒特性,给其在诸如医疗、自动驾驶和军事等安全敏感领域的广泛部署带来极大安全隐患[1-2]。为提升深度识别模型对自然堕化、随机噪声和对抗攻击的鲁棒性,学术界和工业界进行了大量的研究。对抗鲁棒性最有效的提升方法是采用最大化模型损失的对抗样本重训练深度网络模型。典型的对抗训练过程包括利用快速梯度符号方法(Fast Gradient Sign Method)[3]沿梯度方向产生扰动或利用投影梯度下降(Projected Gradient Descent-PGD)方法[4]迭代最大化网络的损失函数产生对抗样本。深度神经网络的对抗训练过程是有监督学习过程,而且对抗训练过程的样本采样复杂度要比标准训练高很多,因此需要更大规模的高质量标记数据集。

在许多应用领域中,大规模高质量标记数据集获取不仅十分耗时,而且代价昂贵。为了克服以上挑战,研究者们提出了许多自监督方法从无标记数据集中学习视觉特征[5- 6]。自监督学习利用数据本身产生的标记信息,以监督的形式实现模型训练,已经成为深度表示学习的一种有效解决方案。此外,最新研究表明利用无标记数据也可以提升模型表征的对抗鲁棒性。文献[7]首次将对抗训练引入到自监督学习过程,提供可用于下游多项任务的鲁棒预训练模型。文献[8]提出一种对抗自监督对比学习框架,将对抗样本产生和对抗训练目标函数中的互信息熵替换为对比损失函数,提升模型在多种应用场景中的对抗鲁棒性。文献[9]提出一种基于对抗对比学习的鲁棒预训练学习方法,将对抗扰动引入对比学习过程,提升标记数据有限场景下的模型鲁棒性。文献[10]提出一种新的样本采样策略优化对抗对比学习过程,同时采用全局选择和局部选择方法获取正负样本对提升模型的对抗鲁棒性。但是,上述所有对抗对比学习方法都需要进行负样本选择。

本文提出一种基于无负样本自监督对比学习的深度神经网络对抗鲁棒性提升方法,采用孪生网络架构,将训练样本图像与其无监督对抗样本进行对比学习,一方面回避了对抗对比学习负样本选择难的问题,应用场景更加广泛,另一方面充分利用大量存在的无标记数据大大提升了特征编码器的对抗鲁棒性和泛化性能。

2 无负样本自监督对比学习

2.1 基于孪生网络的无负样本对比学习

许多自监督学习方法[5]都是基于跨视角预测框架,将特征学习问题建模为同一幅样本图像的多个不同视角相互预测问题。预测问题通常投影于表示空间,即一幅样本图像的任意随机增广版本的特征表示能够预测同一幅图像的其他变换版本的特征表示。然而,在表示空间进行直接预测会导致崩塌表达,例如在多个视角间保持不变的表示可以实现跨视角预测。为了解决这个问题,对比学习方法把预测问题建模为区分性问题,即区分不同增广图像是否来自同一样本图像。在多数情况下,这种机制可以防止训练过程退化为崩塌表达,缺点是需要负样本进行对比学习。负样本最优选取、负样本的数量的确定无论是在理论上还是在实际应用中都仍然面临很大挑战。

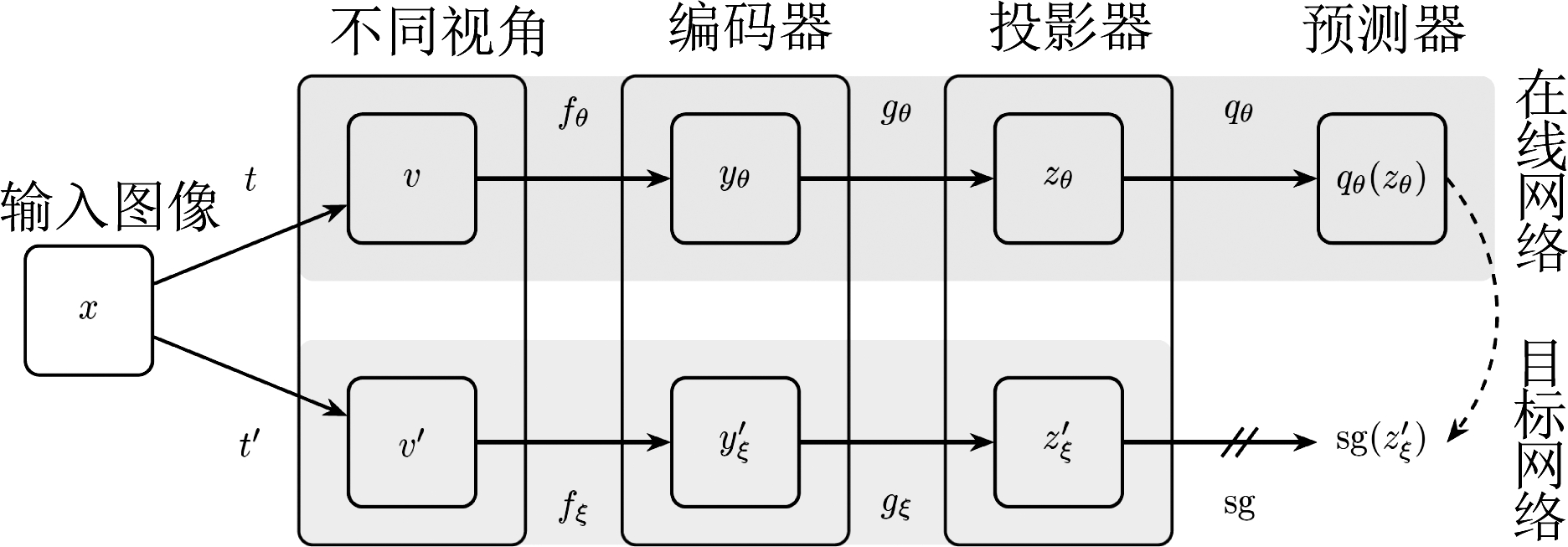

基于孪生网络的无负样本对比学习(Bootstrap Your Own Latent-BYOL)[6]提出了一种新颖的自监督学习样式,不需要负样本,在迁移学习场景和半监督学习场景取得了非常好的性能表现。BYOL采用孪生网络架构同时学习两个神经网络,分别称为在线网络和目标网络,其结构图如图1所示。在线网络由一组权重参数θ定义,结构上包括一个编码器fθ、一个投影器gθ和一个预测器qθ;目标网络结构上包括一个编码器fξ和一个投影器gξ,编码器和投影器的结构与在线网络相同,但采用一组不同的权重参数ξ。BYOL编码器采用ResNet50骨干网络实现,投影器和预测器采用多层感知器(包括两个线性层、一个批归一化层、一个线性矫正单元)。因为在线网络分支中存在预测器,而目标网络无预测器架构,所以整体网络结构是非对称孪生网络。

图1 BYOL无负样本自监督对比学习框架

Fig.1 The BYOL self-supervised learning framework without negative pairs

假设图像集合表示为D,任意选择一幅图像x~D,对图像增广变换的两个分布表示为T和T′。BYOL方法首先将图像x分别进行图像增广变换t~T和t′~T′,产生增强变换后的两个视角ν t(x)和ν′

t(x)和ν′ t′(x),将ν输入到在线网络,在线网络编码器输出表示为yθ

t′(x),将ν输入到在线网络,在线网络编码器输出表示为yθ fθ(ν),在线网络投影器输出表示为zθ

fθ(ν),在线网络投影器输出表示为zθ gθ(y);将ν′输入到目标网络,目标网络编码器输出表示为

gθ(y);将ν′输入到目标网络,目标网络编码器输出表示为![]() 目标网络投影器输出表示为

目标网络投影器输出表示为![]() 然后利用在线网络预测器qθ预测目标网络投影表示

然后利用在线网络预测器qθ预测目标网络投影表示![]() 在线网络预测器qθ输出表示为qθ(zθ)。最后对目标网络投影器输出表示

在线网络预测器qθ输出表示为qθ(zθ)。最后对目标网络投影器输出表示![]() 和在线网络预测器输出表示qθ(zθ)分别进行归一化得到

和在线网络预测器输出表示qθ(zθ)分别进行归一化得到![]() 和

和![]() 并计算两者之间的均方误差,误差定义见公式(1)。

并计算两者之间的均方误差,误差定义见公式(1)。

(1)

按照同样的处理流程,如果将ν′输入到在线网络、将ν输入到目标网络,则可以计算得到均方误差Nθ,ξ。在训练过程中进行随机优化,采用最小化总误差函数![]() 对在线网络参数θ进行优化。目标网络权重参数ξ是在线网络参数θ的指数移动平均,给定目标衰减率τ∈[0,1],每个训练步骤结束后,按照以下方式进行更新:

对在线网络参数θ进行优化。目标网络权重参数ξ是在线网络参数θ的指数移动平均,给定目标衰减率τ∈[0,1],每个训练步骤结束后,按照以下方式进行更新:

ξ←τξ+(1-τ)θ

(2)

网络参数的优化过程可以表示为:

(3)

其中optimizer表示优化器,η表示学习率。训练过程结束后,通常只保留编码器fθ用于后续分类与识别任务。

2.2 无负样本对抗对比学习

对抗样本可以看成是一类特殊的图像变换,添加对抗扰动后的对抗样本图像导致深度神经网络产生错误输出结果。对抗样本目前主要应用于有监督学习场景,例如图像分类、目标检测和图像分割等。

2.2.1 有监督对抗样本生成

分类器将图像样本x∈D映射到标记集合y∈{1,...,C},其中C是类别数目。深度神经网络分类器通过特征编码器fθ(x)和softmax回归预测后验类别概率:

(4)

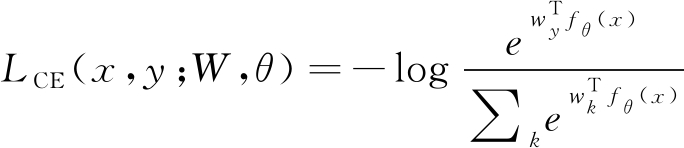

其中wi是类别i的分类参数向量。给定训练集合X={xi,yi},网络参数θ和分类权重![]() 通过最小化交叉熵损失函数定义的风险R=∑iLCE(xi,yi;W,θ)学习:

通过最小化交叉熵损失函数定义的风险R=∑iLCE(xi,yi;W,θ)学习:

(5)

给定训练完成后的分类器,图像样本x的非定向攻击对抗样本xadv表示为:

xadv=x+δ s.t. ||δ||p<ε &![]()

(6)

其中δ表示对抗扰动,扰动的Lp范数小于ε。对x的最优扰动δ*通常通过最大化交叉熵损失得到:

(7)

通常采用迭代方式寻找对抗扰动:

xi+1=∏B(x,ε)(xi-αsign(▽xiLCE(xi,y;W,θ)))

(8)

其中B(x,ε)表示以样本x中心、半径为ε的Lp范数球;∏表示范数球的投影函数;α表示迭代步长;sign(·)返回向量符号;i表示迭代次数。公式(8)可以扩展到多种不同的梯度攻击方法,例如投影梯度下降方法从x±ε邻域内的随机点初始化,进行i步梯度步骤获得对抗攻击样本xi+1。

2.2.2 无监督对抗样本生成

由于现有的基于梯度的对抗样本生成方法需要类别标记信息,因此无法直接应用于大量无标记数据。我们首先提出一种无监督对抗样本生成方法,对抗扰动生成是通过最大化BYOL框架中的总误差函数来实现:

(9)

其中ν和ν′表示对图像x分别进行图像增广变换t~T和t′~T′,产生增强变换后的两个视角ν t(x)和ν′

t(x)和ν′ t′(x)。需要说明的是公式(9)产生的对抗样本是基于变换后图像t(x)的而并不是原始图像x,因此可以产生更加多样化的扰动样本。

t′(x)。需要说明的是公式(9)产生的对抗样本是基于变换后图像t(x)的而并不是原始图像x,因此可以产生更加多样化的扰动样本。

2.2.3 基于无监督对抗样本的对比学习

基于无监督对抗扰动和BYOL对比学习框架,我们提出一种学习鲁棒深度表征的无负样本对抗对比学习框架。按照最小最大优化描述形式,学习过程的目标函数可以表示为:

(10)

其中t(x)+δ表示公式(9)产生的无监督对抗扰动。公式(10)中的对抗对比学习框架本质上和有监督对抗训练框架相同,区别之处在于所训练的模型是对无监督的对抗扰动具有鲁棒性。借助于BYOL孪生网络结构,最大化训练样本与其无监督对抗样本间的多隐层表征相似性,增强模型的内在鲁棒性,并且优化方向与梯度变化最快方向对齐。此外,由于无标记数据的数据量更大、多样性更丰富,使得在线网络在训练集区域泛化性更好,可以防御对抗样本的迁移攻击,提升模型鲁棒性。

2.2.4 孪生网络动态优化特性

自监督对抗训练没有使用负样本防止训练的崩溃,并且由于训练的主要目的是使在线网络的编码器有强鲁棒性,所以优化方式并没有试图同时优化θ、 ξ使得损失最小。假设最佳优化为qθ=q*,即:

(11)

![]()

![]()

(12)

将在线网络参数传入目标网络用于更新是非常有效的可变性来源,但目标网络的突然变化可能会打破最佳预测值的假设。在这种情况下,不能保证损失接近条件方差,因此目标网络采用公式(2)综合式更新,确保预测器在训练过程中的优化接近最优,并充分发挥了不对称结构的优势,使训练不易陷入非凸优化的局部最优值。

3 实验结果与分析

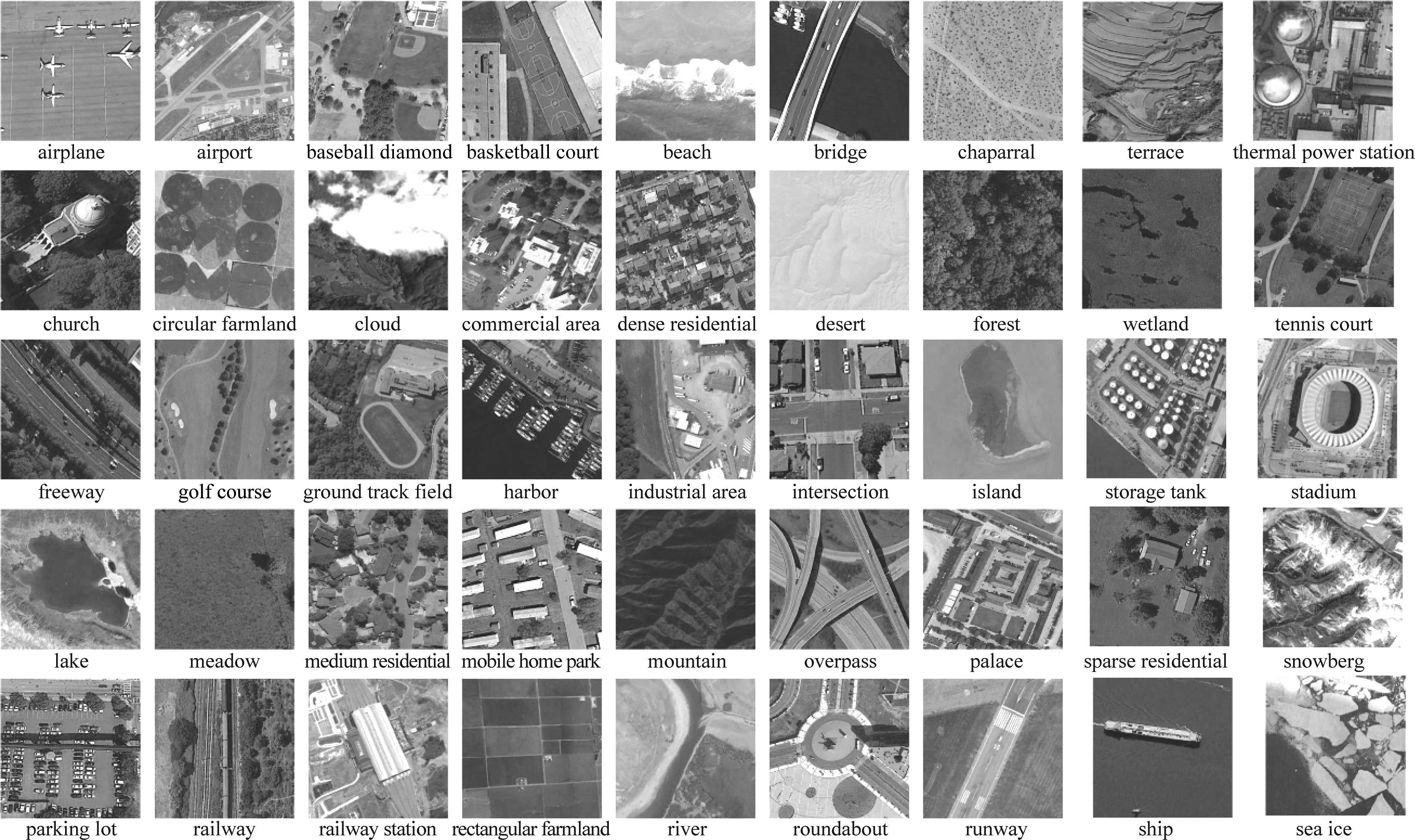

为了验证本文方法的有效性,我们在光学遥感场景分类数据上开展基于深度卷积神经网络模型的遥感场景识别对抗攻防实验。实验数据采用两个广泛使用的开源数据集UC-Merced数据集[11]和NWPU-RESISC45数据集[12-13]。UC-Merced数据集包含21类地表覆盖典型场景,每类包括100幅样本图像,样例图像如图2所示。数据集总计2100幅0.3 m空间分辨率图像,每幅图像空间大小为256×256像素。NWPU-RESISC45数据集是目前最大规模的开源遥感光学场景分类数据集,覆盖45个典型地表场景类别,其中每个类别有700幅样本图像,样例图像如图3所示。数据集中样本图像来自100多个国家和地区,空间分辨率范围在30 m到0.2 m之间,空间大小为256×256像素。同UC-Merced数据集相比,NWPU-RESISC45数据集更接近真实应用场景。两个数据集中的样本图像,实验中我们都首先进行重采样为224×224像素,并通过随机的几何变换和光度变换进行数据增广。

图2 UC-Merced数据集样例图像

Fig.2 Some example images from the UC-Merced data set

图3 NWPU-RESISC45数据集样例图像

Fig.3 Some example images from the NWPU-RESISC45 data set

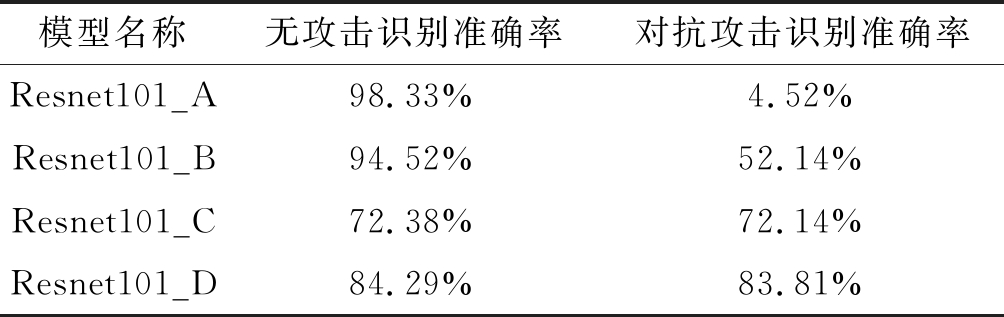

基于我们前期对主流深度卷积神经网络模型的对抗攻击鲁棒性评估结论[14],选择对抗鲁棒性较好的残差网络作为编码器,网络层数设置为101。投影器和预测器采用同样的多层感知器,输出设置为256个节点。为了证明自监督对比学习对深度识别模型的对抗鲁棒性具有提升效果,在UC-Merced数据集上我们区分四种不同训练方法得到的模型:1)在原始无对抗攻击的UC-Merced数据集训练集上,训练Resnet101网络模型,在原始无对抗攻击的UC-Merced数据集测试数据集上进行分类实验,网络模型表示为Resnet101_A。 2)将Resnet101作为对抗自监督无负样本对比学习模型的编码器,将无攻击测试集和测试集投影梯度下降PGD攻击对抗样本分别输入目标网络和在线网络进行训练,训练完成后再次使用无攻击训练数据进行微调,网络模型表示为Resnet101_B。3)将Resnet101_A网络进行对抗训练,得到新的鲁棒性网络表示为Resnet101_C。4)将Resnet101作为对抗自监督无负样本对比学习模型的编码器,将无攻击测试集和测试集PGD攻击对抗样本分别输入目标网络和在线网络进行训练,训练完成后再次进行对抗训练,得到新的鲁棒性网络,该网络模型表示为Resnet101_D。对于Resnet101的训练统一使用随机梯度下降优化器,学习率设为10-3,训练50轮次,微调时其他参数相同,训练10轮次;训练基于对抗自监督无负样本对比学习模型时使用Adam优化器,训练500轮次,对抗训练按照场合不同使用类别级PGD攻击和实例级PGD攻击,最大扰动强度设为16。表1给出了UC-Merced数据集上不同训练方法得到的模型在无攻击干净测试数据集和PGD攻击测试数据集上的统计性能。

表1 UC-Merced数据集统计识别结果

Tab.1 Statistics of recognition performance on the UC-Merced data set

模型名称无攻击识别准确率对抗攻击识别准确率Resnet101_A98.33%4.52%Resnet101_B94.52%52.14%Resnet101_C72.38%72.14%Resnet101_D84.29%83.81%

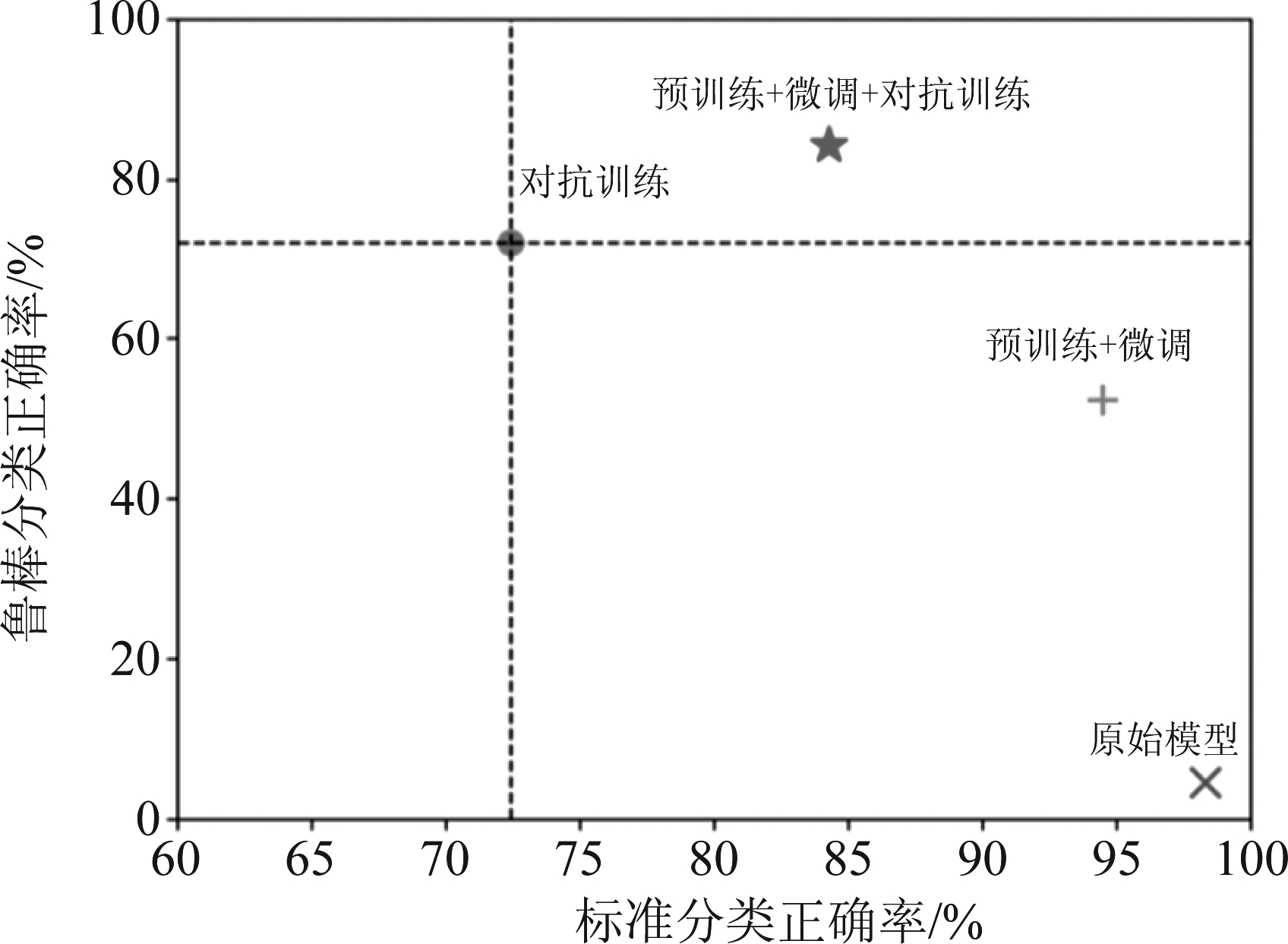

图4给出了表1统计数据的直观图示形式。对抗自监督无负样本对比学习可以用于训练一个鲁棒的预训练模型,提升预训练模型的对抗攻击鲁棒性,加速在小规模数据上模型的快速收敛。使用对抗自监督无负样本对比学习得到的预训练模型微调后,在几乎不损失无攻击干净数据集上性能的同时,可以将对抗攻击识别准确率提升接近50个百分点,大幅提升了模型的对抗攻击鲁棒性。此外,根据应用场景的不同,鲁棒预训练模型还可以进一步结合对抗训练,提升其在对抗攻击数据集上的泛化性能。

图4 UC-Merced数据集不同训练方法性能差异

Fig.4 Performance of different learning methods on the UC-Merced data set

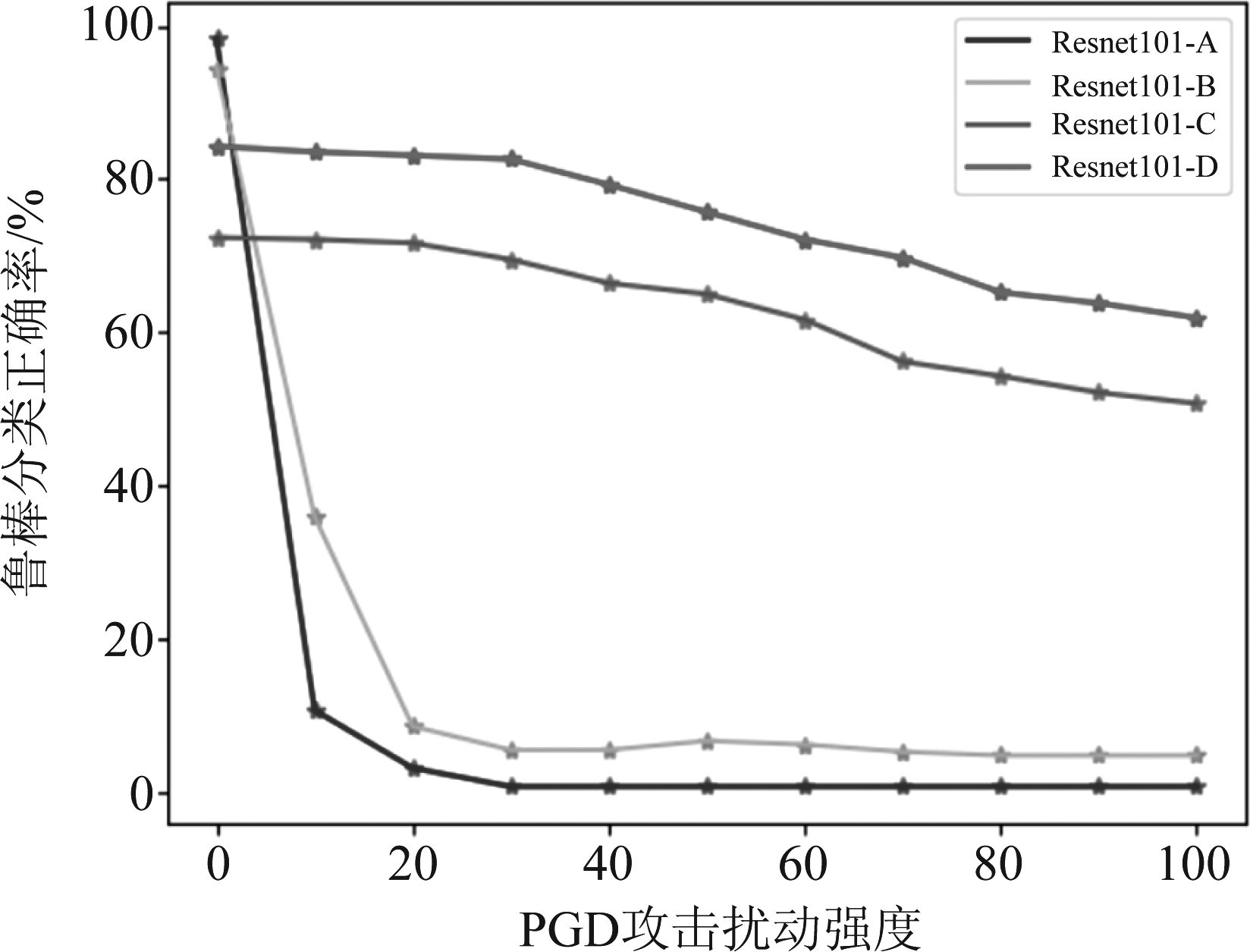

为检验对抗扰动的大小对于模型性能的影响,全面考察模型鲁棒性,使用不同强度的PGD的攻击,观察模型的鲁棒性表现,如图5所示。从实验结果可以看到,未经对抗训练的网络虽然在干净样本上保有较高的正确率,但在对抗样本的攻击下正确率急剧下降,经过对抗训练的模型对抗鲁棒性明显增强,在对抗预训练模型基础上的对抗训练训练模型鲁棒性性能最优,不会随对抗扰动的加大而产生迅速的性能下降且性能始终稳定强于直接的对抗训练模型10%以上,说明对抗预训练可以有效且稳定的提升模型鲁棒性。

图5 UC-Merced数据集不同强度攻击时各模型性能变化曲线

Fig.5 Performance of different models on the UC-Merced data set with varying degree of perturbations

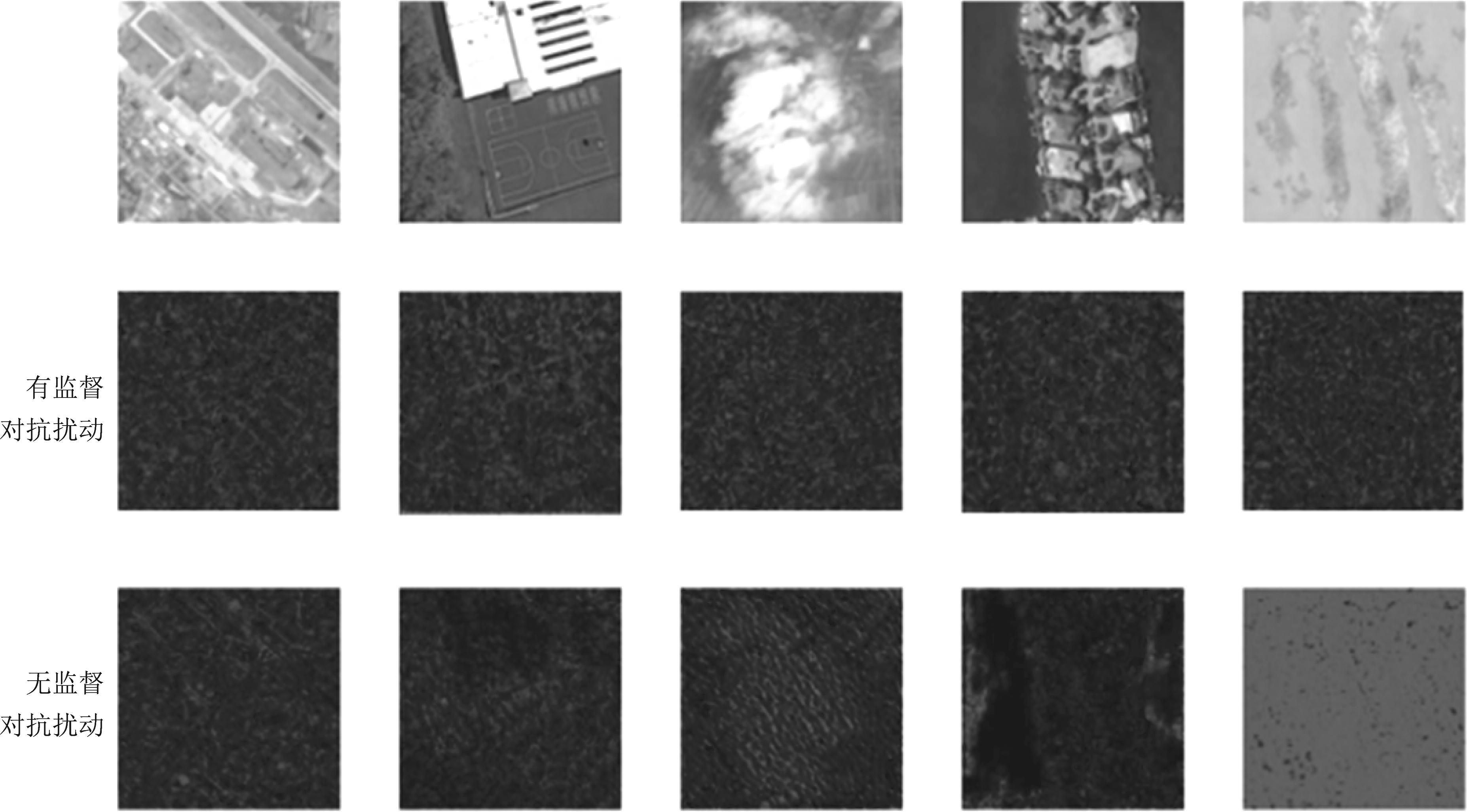

NWPU-RESISC45数据集中典型样本图像的无监督对抗扰动与有监督对抗扰动对比如图6所示,为了显示效果,图中的扰动幅度都进行了放大。可以看到无监督对抗扰动与有监督对抗扰动在空间分布上存在较明显的差别。无监督对抗扰动能够充分发掘样本图像的结构性特征信息,而有监督对抗扰动在视觉感知上呈现明显的纹理偏好。

图6 NWPU-RESISC45数据集样例图像两类扰动可视化对比

Fig.6 Visualizations of different perturbations on sample images from the NWPU-RESISC45 data set

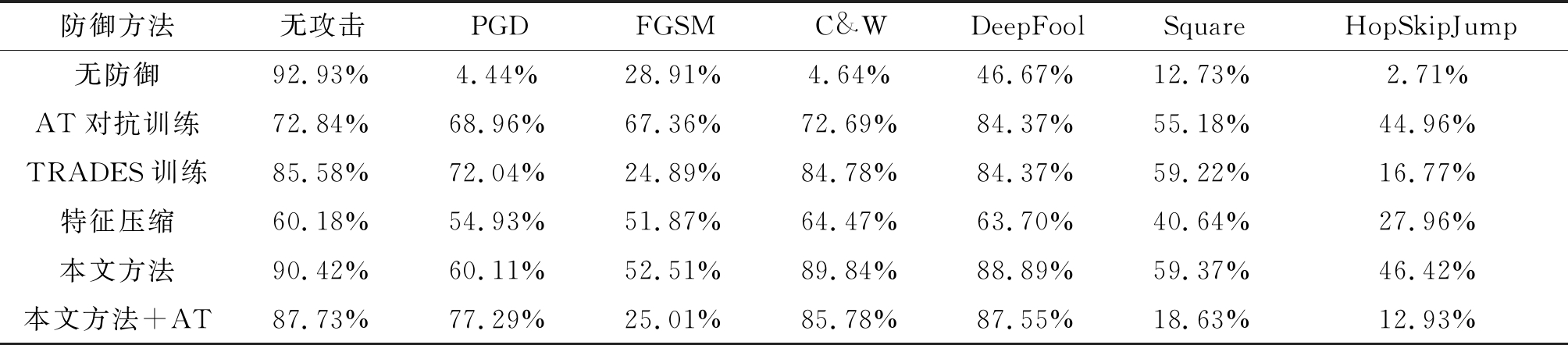

为了更加全面评估本文所提方法对于不同类型对抗攻击的综合鲁棒性,在NWPU-RESISC45测试数据集中我们使用PGD[4]、FGSM[3]、C&W[15]、DeepFool[16]四种白盒对抗攻击方法和HopSkipJump[17]、Square[18]两种黑盒攻击方法产生对抗样本。此外,我们还对比了三种主流的防御方法的性能表现,包括标准对抗训练(adversarial training-AT)、改进对抗训练(TRADES)[19]和特征压缩方法[20]。NWPU-RESISC45数据集每个类别的700幅图像中选择200幅作为有监督微调训练样本、400幅作为无监督对抗预训练样本、100幅作为测试集。实验中FGSM攻击噪声范数选用L∞,扰动强度约束ε=0.3;PGD攻击噪声范数选用L∞,扰动强度约束ε=0.3,最大迭代次数设定为100;C&W攻击学习率0.01,最大迭代次数设定为100;DeepFool攻击扰动步长设定为10-6,最大迭代次数100;Square攻击最大迭代次数100;HopSkipJump攻击噪声范数选用L2,强度约束ε=0.3,最大迭代次数100。表2给出了NWPU-RESISC45数据集上不同场景下的识别正确率统计信息,可以看出:本文所提出的预训练方法充分利用无标记数据,对多类型对抗攻击具有更高的鲁棒性。

表2 NWPU-RESISC45数据集识别正确率统计信息

Tab.2 Statistics of recognition accuracy on the NWPU-RESISC45 data set

防御方法无攻击PGDFGSMC&WDeepFoolSquareHopSkipJump 无防御92.93%4.44%28.91%4.64%46.67%12.73%2.71%AT对抗训练72.84%68.96%67.36%72.69%84.37%55.18%44.96%TRADES训练85.58%72.04%24.89%84.78%84.37%59.22%16.77%特征压缩60.18%54.93%51.87%64.47%63.70%40.64%27.96%本文方法90.42%60.11%52.51%89.84%88.89%59.37%46.42%本文方法+AT87.73%77.29%25.01%85.78%87.55%18.63%12.93%

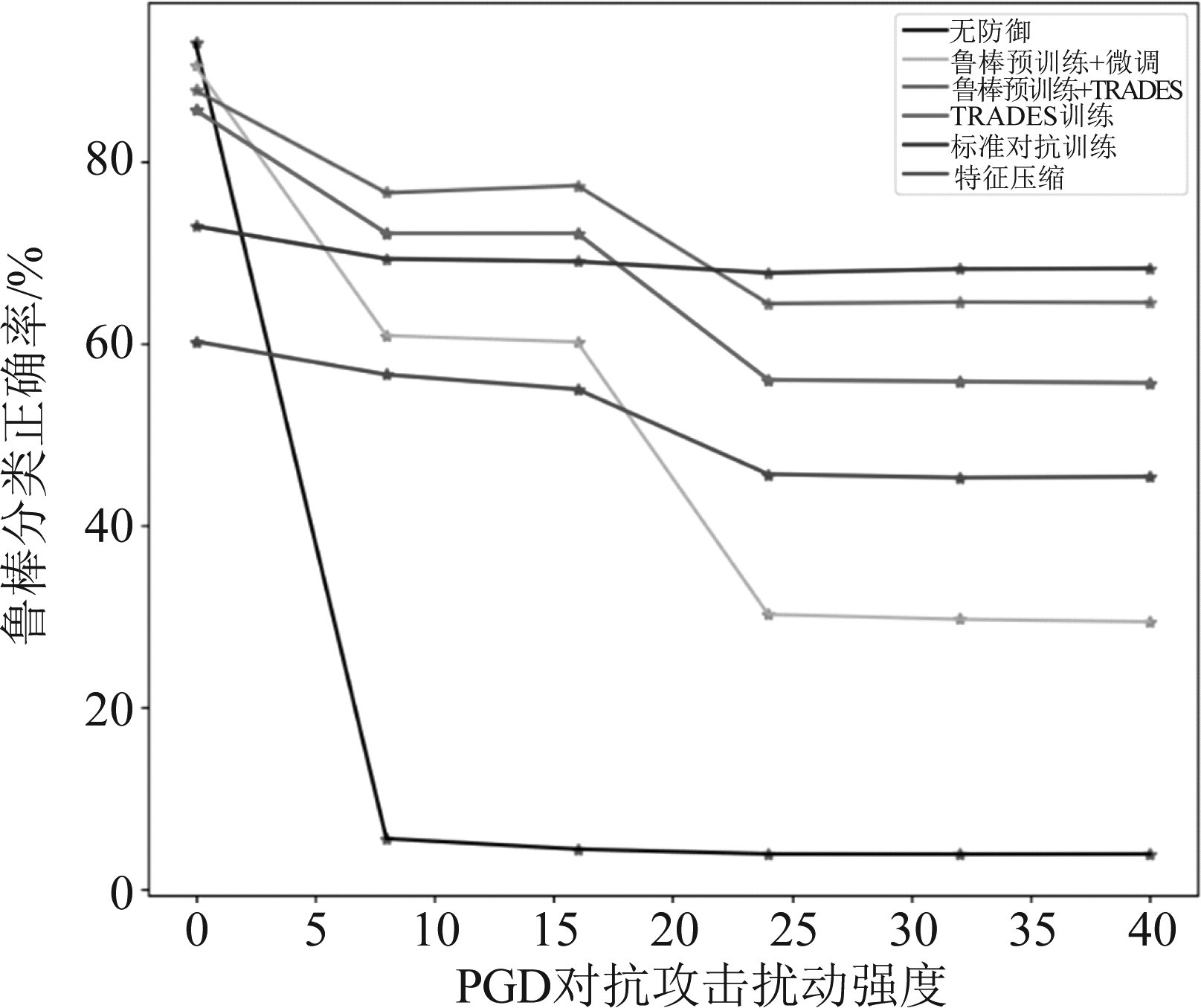

图7是NWPU-RESISC45数据集上使用不同强度的PGD攻击时Resnet101深度识别模型的鲁棒识别准确率变化曲线。从实验结果可以看出各类防御方法的识别准确率都会先随着攻击强度的增加而逐渐下降,然后维持在一个相对较低的水平。在对抗扰动幅度较小时,本文所提方法与TRADES的结合取得了最高的识别准确率,且其准确率始终高于TRADES训练方法,体现了本文方法为模型鲁棒性提供的增益。标准对抗训练方法虽然在扰动幅度较小时相较于其他方法正确率较低,但对于对抗扰动的强度变化不敏感,在大强度攻击时体现出更强的鲁棒性。仅仅使用本文方法,经微调后得到的网络在攻击强度低时表现良好,但随着攻击强度的加大,性能下降较为明显,若要面对较大强度的攻击,还需结合其他方法。特征压缩方法对于攻击强度不敏感,但取得的防御效果普遍不如其他方法,反映出预处理防御方法的局限性。本文方法在场景分类任务[21-22]中提升了深度神经网络模型的对抗鲁棒性,下一步可以扩展到目标检测与图像分割任务中。

图7 NWPU-RESISC45数据集不同防御方法抵抗PGD攻击性能差异

Fig.7 Performance of different defense methods on the NWPU-RESISC45 data set

4 结论

本文提出一种基于自监督对比学习的深度神经网络图像识别模型对抗鲁棒性提升方法,主要思想是利用无负样本对比学习框架,充分挖掘无监督数据辅助深度模型的学习过程。采用在线网络和目标网络双孪生网络架构,最大化训练样本与其无监督对抗样本间的多隐层表征相似性,增强模型的内在鲁棒性。本文所提方法一方面回避了对比学习负样本选择难的问题,应用场景更加广泛;另一方面充分利用大量存在的无标注数据大大提升了特征编码器的对抗鲁棒性和在干净数据集上的泛化性能。在光学遥感场景分类数据上的实验结果证明了本文所提方法可以充分利用无监督数据有效提升深度模型的对抗攻击鲁棒性。

[1] BERGHOFF C, NEU M, TWICKEL A. Vulnerabilities of connectionist AI applications: evaluation and defence[EB/OL]. arXiv preprint arXiv:2003.08837, 18 Mar 2020.

[2] FAWZI A, MOOSAVI-DEZFOOLI S M, FROSSARD P. The robustness of deep networks: a geometrical perspective[J]. IEEE Signal Processing Magazine, 2017, 34(6):50- 62.

[3] GOODFELLOW I, SHLENS J, SZEGEDY C, et al. Explaining and harnessing adversarial examples[EB/OL]. arXiv preprint arXiv: 1412.6572, 20 Dec 2014.

[4] MADRY A, MAKELOV A, SCHMIDT L, et al. Towards deep learning models resistant to adversarial attacks[EB/OL]. arXiv preprint arXiv:1706.06083, 19 Jun 2017.

[5] LIU Xiao, ZHANG Fanjin, HOU Zhenyu, et al. Self-supervised learning: generative or contrastive[EB/OL]. arXiv preprint arXiv:2006.08218,15 Jun 2020.

[6] GRILL J B, STRUB F, ALTCHE F, et al. Bootstrap your own latent a new approach to self-supervised learning[C]∥Proceedings of 34th Conference on Neural Information Processing Systems, Vancouver, Canada, 2020.

[7] CHEN Tianlong, LIU Sijia, CHANG Shiyu, et al. Adversarial robustness: from self-supervised pre-training to fine-tuning[C]∥Proceedings of IEEE/CVF Conference on Computer Vision and Pattern Recognition, Seattle, WA, USA, 2020.

[8] KIM M, TACK J, HWANG S J. Adversarial self-supervised contrastive learning[C]∥Proceedings of 34th Conference on Neural Information Processing Systems, Vancouver, Canada, 2020.

[9] JIANG Ziyu, CHEN Tianlong, CHEN Ting, et al. Robust pre-training by adversarial contrastive learning[C]∥Proceedings of 34th Conference on Neural Information Processing Systems, Vancouver, Canada, 2020.

[10] BUI Anh, LE Trung, ZHAO He, et al. Understanding and achieving efficient robustness with adversarial contrastive learning[EB/OL]. arXiv preprint arXiv:2101.10027, Jan 2021.

[11] YANG Yi, NEWSAM Shawn. Bag-of-visual-words and spatial extensions for land-use classification[C]∥Proceedings of the 18thACM SIGSPATIAL International Conference on Advances in Geographic Information Systems, 2010.

[12] CHENG Gong, XIE Xingxing, HAN Junwei, et al. Remote sensing image scene classification meets deep learning: challenges, methods, benchmarks, and opportunities[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2020,13(1):3735-3756.

[13] CHENG Gong, HAN Junwei, LU Xiaoqiang. Remote sensing image scene classification: benchmark and state of the art [J]. Proceedings of the IEEE, 2017,10:1865-1883.

[14] 徐延杰,孙浩,雷琳,等. 基于对抗攻击的SAR舰船识别卷积神经网络鲁棒性研究[J].信号处理,2020,36(12):1965-1978.

XU Yanjie, SUN Hao, LEI Lin, et al. The research for the robustness of SAR ship identification based on adversarial example[J]. Journal of Signal Processing, 2020, 36(12): 1965-1978.(in Chinese)

[15] CARLINI N, WAGNER D. Towards evaluating the robustness of neural networks[C]∥IEEE Symposium on Security and Privacy, 2017: 39-57.

[16] MOOSAVI-DEZFOOLI S M, FAWZI A, FROSSARD P. Deepfool: a simple and accurate method to fool deep neural networks [C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE Press, 2016: 2574-2582.

[17] CHEN Jianbo, JORDAN Michael, WAINWRIGHT Martin. HopSkipJumpAttack: A query-efficient decision-based attack[C]∥Proceedings of IEEE Symposium on Security and Privacy, 2020: 1277-1294.

[18] ANDRIUSHCHENKO M, CROCE F, FLAMMARION N, et al. Square attack: a query-efficient black-box adversarial attack via random search[EB/OL]. arXiv preprint arXiv:1904.02144, 28 Apr 2020.

[19] ZHANG Hongyang, YU Yaodong, JIAO Jiantao, et al. Theoretically principled trade-off between robustness and accuracy [C]∥Proceedings of the 36th International Conference on Machine Learning, Long Beach, California, 2019.

[20] XU Weilin, EVANS David, QI Yanjun. Feature squeezing: detecting adversarial examples in deep neural networks[C]∥Proceedings of Network and Distributed System Security Symposium, San Diego, California, 2018.

[21] 黄伟锋,张甜,常东良,等. 基于多视角融合的细粒度图像分类方法[J].信号处理,2020,36(9):1607-1614.

HUANG Weifeng, ZHANG Tian, CHANG Dongliang, et al. Multi-view comprehensive based fine-grained image classification[J]. Journal of Signal Processing, 2020, 36(9): 1607-1614.(in Chinese)

[22] 张家辉,谢毓湘,郭延明. 基于局部特征显著化的场景分类方法[J].信号处理,2020,36(11):1804-1810.

ZHANG Jiahui, XIE Yuxiang, GUO Yanming. Scene classification method based on local feature saliency[J]. Journal of Signal Processing, 2020, 36(11): 1804-1810.(in Chinese)