1 引言

目标跟踪是计算机视觉研究领域的重要研究方向,其融合了图像处理、模式识别及机器学习等许多领域的先进技术,在视频监控、国防军事、人机交互[1]等领域有着广阔的应用前景。但由于复杂场景因素,如遮挡、尺度变化、形变及背景杂斑等,目标跟踪技术的研究仍然是一个十分具有挑战性的研究领域[2]。

近年来,判别式相关滤波方法[3]得益于快速傅里叶变换和循环移位密集采样,在目标跟踪领域脱颖而出,赢得研究学者们的青睐。但循环移位导致边界效应,边界效应带来的错误样本会大幅度降低滤波器的鲁棒性。于2010年,Bolme[4]等提出了平方误差最小输出和MOSSE,首次将相关滤波方法用于目标跟踪领域。相较于当时其他算法,其跟踪速度和准确率都名列前茅,所以引发了研究学者们对基于相关滤波方法的目标跟踪算法研究。Henriques[5]等在MOSSE基础上提出了循环移位密集采样的核相关滤波算法CSK,通过增加正则项以避免过拟合及利用核函数技巧提高算法鲁棒性。Danelljan[6]等提出了空间正则化相关滤波跟踪算法SRDCF,其用于惩罚滤波器系数的空间正则项权值是一个固定的逆高斯分布,使滤波器专注于目标区域学习,有效缓解了边界效应。由于SRDCF的损失函数没有闭式解,极大增加了计算复杂度;且空间正则项权值没有与目标的变化建立关联,在复杂跟踪场景下算法无法获取可信任的空间正则项权值。背景感知相关滤波器BACF[7]从大样本的循环移位样本集中用矩阵裁剪出真实样本以提升真实样本的比例,这使得算法引入了更多背景样本而有效抑制边界效应,但引入背景信息容易使滤波器学习背景噪声导致滤波器腐败。虽然该算法有在检测阶段矫正滤波器,但效果有限。为了提高滤波器鲁棒性,更好适应复杂跟踪场景,异常抑制相关滤波器ARCF[8]使用响应图变化的异常来抑制和学习环境噪声。但ARCF没有考虑响应图变化中隐含的时间相关信息,以至于滤波器在复杂跟踪场景下容易发生突变导致目标跟踪失败;且ARCF以固定学习率线性加权更新滤波器,容易使滤波器学习背景信息或不能及时适应目标外观的变化。自适应空间正则项相关滤波跟踪算法ASRCF[9],算法提出的自适应空间正则项可有效抑制边界效应,且通过引入空间正则项的先验信息以避免滤波器退化。但ASRCF 算法的损失函数没有加入时间正则项,使抑制滤波器变化能在滤波器的训练过程进行。学习时空正则项的相关滤波跟踪算法STRCF[10],是在SRDCF的基础上提出的,增加了时间正则项,有效抑制相邻两帧滤波器的突变及解决滤波器退化问题。尽管STRCF的稳定性和鲁棒性非常好,但其时空正则项引入了太多需要手动设置的参数。一方面,这些参数需要花费大量时间进行实验调参。另一方面,固定的参数在每个视频序列中不一定总是表现良好。

为了充分利用响应图中隐含的关键信息,本文在STRCF的基础上提出一种专注学习时空关系的相关滤波跟踪算法(Focusing on Learning Spatio-Temporal Relationships Correlation Filter, FLSTCF),引入相邻两帧的响应图变化作为空间正则项权值的参考权重,而当前帧响应图的振荡程度确定时间正则项权值。本文算法FLSTCF使抑制边界效应、响应图的专注学习及避免滤波器突变能在滤波器的训练过程进行,提高了算法的稳定性、鲁棒性和跟踪速度。最后本文算法FLSTCF采用交替方向乘子法[11]对损失函数进行迭代优化,以较少的迭代次数便可求解出滤波器、空间正则权重,有效减低求解损失函数的计算负担。

2 专注学习时空关系的相关滤波模型

2.1 问题的提出

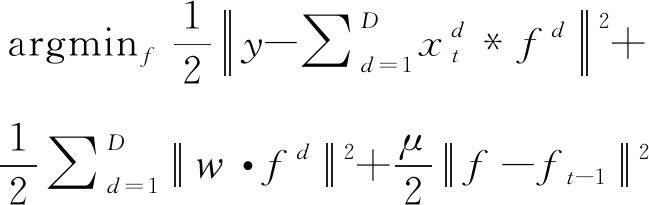

为了抑制边界效应,SRDCF[6]建议通过对滤波器系数施加空间惩罚来解决这一问题,这不可避免地增加复杂性为代价以提高跟踪性能。但SRDCF在部分遮挡、相似干扰等目标发生短期的大变化情况下性能会下降,从而导致后续的跟踪发生漂移或丢失。为了解决上述问题,Li[10]等人提出了STRCF,该滤波器在SRDCF的损失函数基础上引入了时间正则项,以抑制滤波器因短期目标外观变化发生退化,因而获得更稳定的跟踪效果,其损失函数为:

(1)

其中ft-1表示第t-1帧的滤波器,![]() 表示空间正则项,w为空间正则项权值,

表示空间正则项,w为空间正则项权值,![]() 表示时间正则项,μ 为时间正则项权值。STRCF可以通过ADMM方法有效求解损失函数。通过结合时间和空间正则项,STRCF可有效处理边界效应及抑制滤波器退化,而不会造成效率上的损失,并且在稳定性、准确性和速度等方面都优于SRDCF。

表示时间正则项,μ 为时间正则项权值。STRCF可以通过ADMM方法有效求解损失函数。通过结合时间和空间正则项,STRCF可有效处理边界效应及抑制滤波器退化,而不会造成效率上的损失,并且在稳定性、准确性和速度等方面都优于SRDCF。

STRCF为了抑制边界效应,选择直接忽略所有循环移位样本的边界部分像素,即让边界部分的滤波器系数接近零。观察STRCF的损失函数可知,在STRCF滤波器的求解过程,空间正则项权值始终作为固定参数且独立于损失函数的,并没有根据滤波器的更新而同步调整,从而导致所求滤波器可能并不是当前最优。而事实上,空间正则项权值理应为变量,应与目标的变化建立关联即随目标外观变化而变化,便于获取可信任的空间正则项权值。STRCF将时间正则项整合到损失函数中,使抑制滤波器退化能在滤波器训练过程中进行。STRCF中固定的时间正则项权值表明了每一帧都对滤波器进行同等约束,虽然这样有效避免滤波器突变,但固定时间权值容易使滤波器学习背景信息或不能及时适应目标外观的变化。时间正则项权值也应于目标的变化建立关联,便于自动调整时间正则项权值,从而提高适应性和跟踪速度。

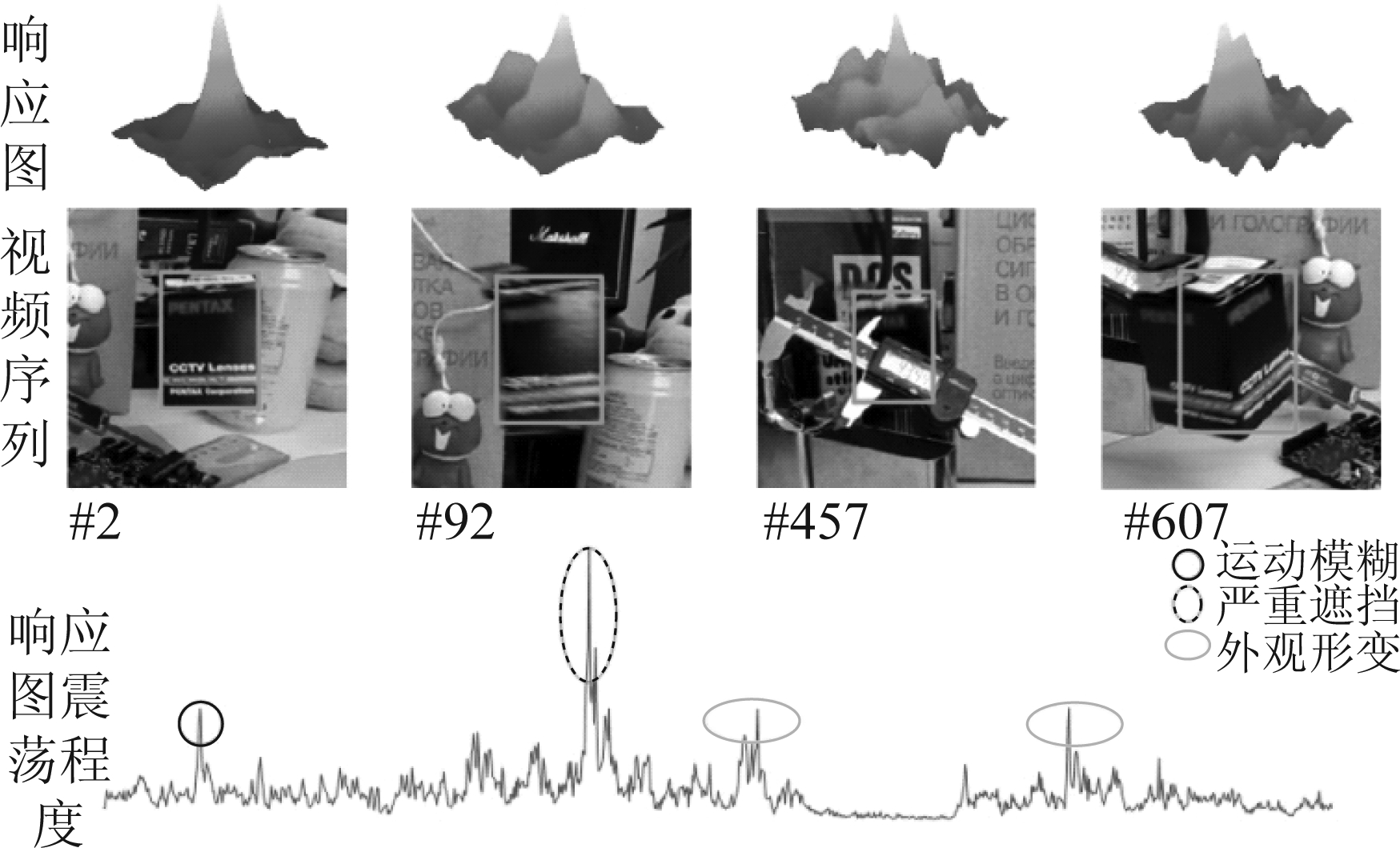

图1 不同样本的响应图隐含的关键信息

Fig.1 Key information implied in response graphs of different samples

在判别式相关滤波方法中常用响应图作为跟踪置信度指标。响应图隐含着有关当前帧目标外观等相似性的关键信息(如图1),然而仅利用当前帧响应图的振荡程度,而忽略表示相邻两帧响应图变化中不同位置的可信度:变化剧烈意味着较低的可信度,反之亦然,那么无法更好地提高算法的稳定性和鲁棒性。为了充分利用响应图中隐含的关键信息,本文算法FLSTCF引入相邻两帧的响应图变化作为空间正则项权值的参考权重,使滤波器专注于对象可信赖部分的学习;当前帧响应图的振荡程度来确定时间正则项权值,用于限制滤波器参数变化。本文提出的算法有效避免滤波器突变、抑制边界效应及提高了跟踪速度。

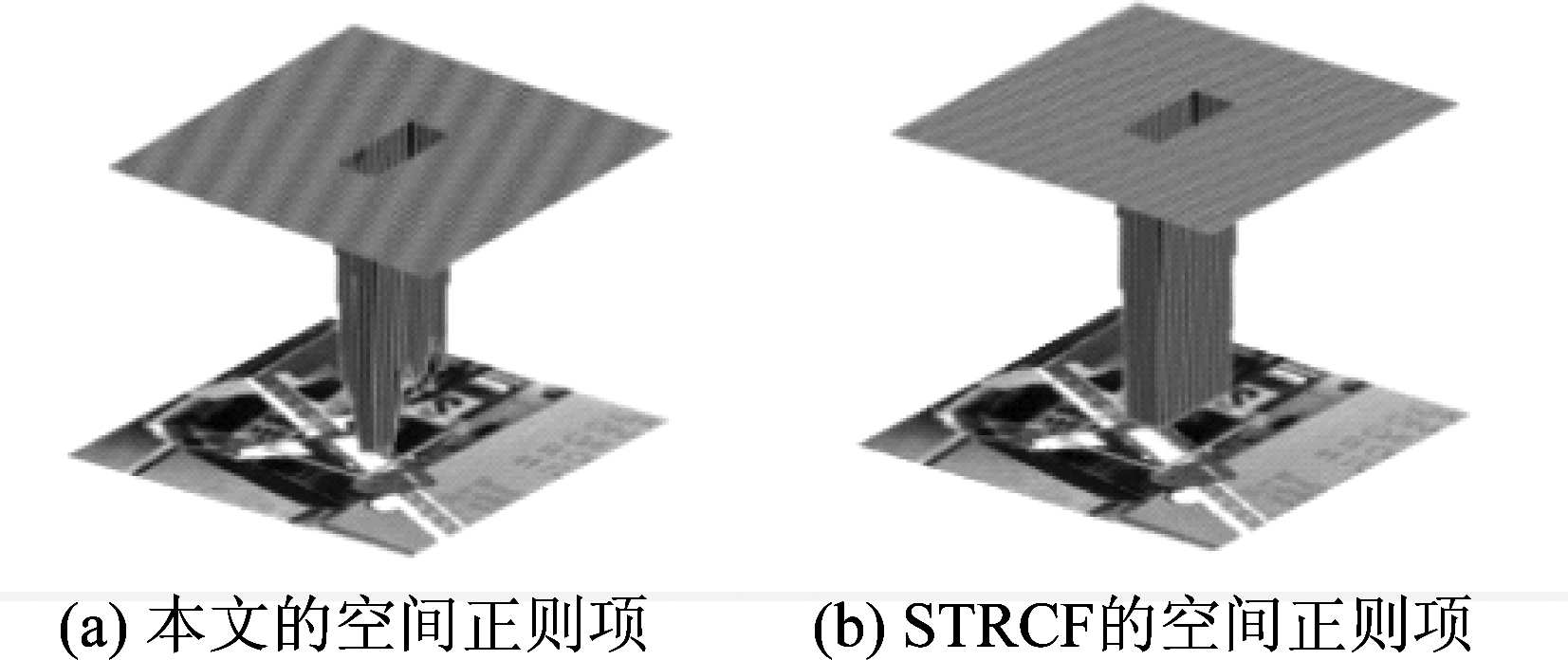

在STRCF中,空间正则项参数类似于“回”字(如图2(b)),中间数值为零,四周数值为数千大小,在跟踪过程中是固定的。本文的引入相邻两帧的响应图变化作为空间正则项权值的参考权重(如图2(a)),对变化较大部分进行较高的惩罚,对可信赖部分提供较低的约束。定义m0为:

图2 不同算法的空间正则项对比图

Fig.2 Comparison of spatial regularization terms of different algorithms

m0=|Μt[ψΔ]-Μt-1+M0|

(2)

其中Mt、Μt-1表示相邻两帧的响应图,使用ψΔ进行循环移位操作,将响应图的峰值移位到中心;M0引用STRCF中的空间正则项权值w。

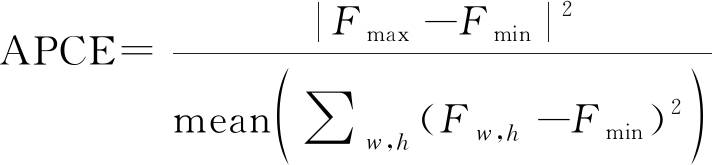

与STRCF不同,我们引入当前帧响应图的振荡程度确定时间正则项权值。在判别式相关滤波方法中, 常用LMCF[12]提出的平均峰值相关能量APCE表征响应图的振荡程度。在合成孔径(SAR)雷达成像技术中,为了定量描述算法对旁瓣和杂波抑制的效果,常用峰值旁瓣比(Peak Side Lobe Ratio, PSR)[13]和积分旁瓣比(Integral Side Lobe Ratio, ISR)[13]作为成像质量的评价指标对。本文改进ISR结合APCE用于表示当前帧响应图的振荡程度。APCE及ISR公式定义如下:

(3)

其中Fmax、Fmin分别表示响应图的最大值和最小值;Fw,h表示响应图(w,h)坐标点(响应图为w*h大小)

(4)

其中Ptotal为整幅响应图的能量;Pmain为主峰能量,主峰窗口大小与第二帧响应图主峰窗口大小一致。

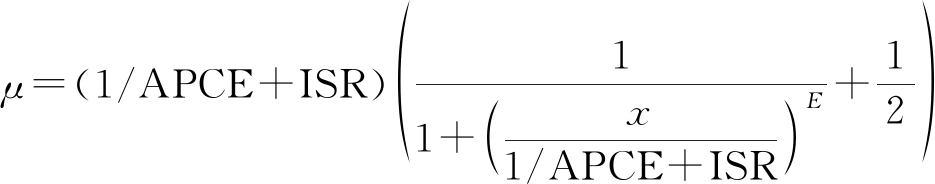

本文先以1/APCE、ISR进行线性相加,再经过线性变换函数,使算法对滤波器的约束更加准确。定义μ为:

(5)

2.2 专注学习时空关系模型优化

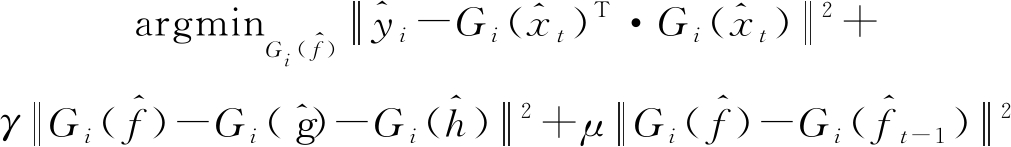

在式(1)中拓展空间正则项,本文算法FLSTCF的损失函数为:

![]()

![]()

(6)

其中![]() 表示空间正则项权值的参考权重,m0的定义见式(2);μ是时间正则项权值,用当前帧响应图的振荡程度表示,μ的定义见式(5)。

表示空间正则项权值的参考权重,m0的定义见式(2);μ是时间正则项权值,用当前帧响应图的振荡程度表示,μ的定义见式(5)。

损失函数式是凸函数,可采用交替方向乘子法求解全局最优解。因此,引入辅助变量f=g,得式(6)的增广拉格朗日方程:

![]()

![]()

![]()

(7)

其中,s,γ分别是拉格朗日数乘因子和惩罚参数。当![]() 时,式(7)的增广拉格朗日方程可表示为:

时,式(7)的增广拉格朗日方程可表示为:

![]()

![]()

(8)

然后采用ADMM算法交替求解以下拆分的子问题:

![]()

![]()

![]()

h(k+1)=h(k)+f(k+1)-g(k+1)

(9)

(1)子问题f

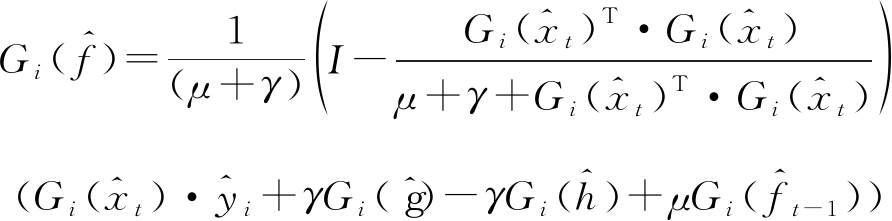

为了降低计算复杂度,利用帕塞瓦尔定理[14]将式(9)中第1条式子转换为频域形式,转换后的公式如下:

(10)

其中^表示已转为离散傅里叶变换。观察式(10)可知,标准高斯标签![]() 的第i个元素只依赖于滤波器

的第i个元素只依赖于滤波器![]() 和样本

和样本![]() 在整个D通道中的第i元素。因此将式(10)改写为元素级的表达式:

在整个D通道中的第i元素。因此将式(10)改写为元素级的表达式:

(11)

其中Gi(·)∈RD表示在整个D通道上的第i个元素。式(11)存在闭式解,可直接求导得:

(12)

(2)子问题g

子问题g没有涉及相关运算,可在时域中直接求解式(9)中第2条式子,得:

(13)

(3)子问题m

子问题m的求解与子问题g求解方法一致,为了使空间正则项权值在时域上更新,直接对式(9)中第3条式子求导,得:

(14)

(4)更新惩罚参数γ

γ(k+1)=min (γmax,ργ(k))

(15)

其中γmax,ρ分别表示γ 的最大值和尺度参数。

3 实验分析与讨论

3.1 实现细节

本文所有实验均在Intel(R) Core(TM)i5-9500 CPU,16 GB,Window10的PC上进行,软件为Matlab2017a搭配Visual Studio2015。本文算法FLSTCF的相关参数均参考STRCF配置,只有空间正则项权值的参考权重、时间正则项权值的参数设置有所修改,其中α=0.2、x=13、E=0.5。本文与近几年优秀算法在OTB数据集上进行实验对比,有STRCF、SRDCFdecon、Staple[15]、ECO-HC[16]、BACF、LMCF,以突出本文算法的鲁棒性。本文所对比的算法均是使用手工特征,如HOG、CN及灰度特征。OTB数据集是视频目标跟踪领域中代表性人工标注的测试数据集,其包含着各种挑战,如遮挡、尺度变化、形变及背景杂斑等复杂场景。OTB-2013于2013年提出,包含51个视频序列。于2015年,OTB数据集扩展至100个视频序列,其中OTB-100[17]包含OTB数据集中所有视频序列,OTB-50是从OTB数据集中选取更富有挑战性的50个视频序列, 与OTB-2013[18]之间只有28个公共视频序列。本文选取一次通过评估标准(One-Pass Evaluation, OPE),并使用OTB数据集有两个评价标准评估算法:Precision plot、Success plot。其中Precision plot指预测的目标位置和真实的目标位置之间的平均欧式距离小于阈值所占整个系列帧数的比重;Success plot指预测的跟踪框和真实的跟踪框之间的重叠率大于阈值所占整个系列帧数的比重。Precision plot与Success plot之间,Success plot更能表征算法的整体性能。

3.2 对比实验

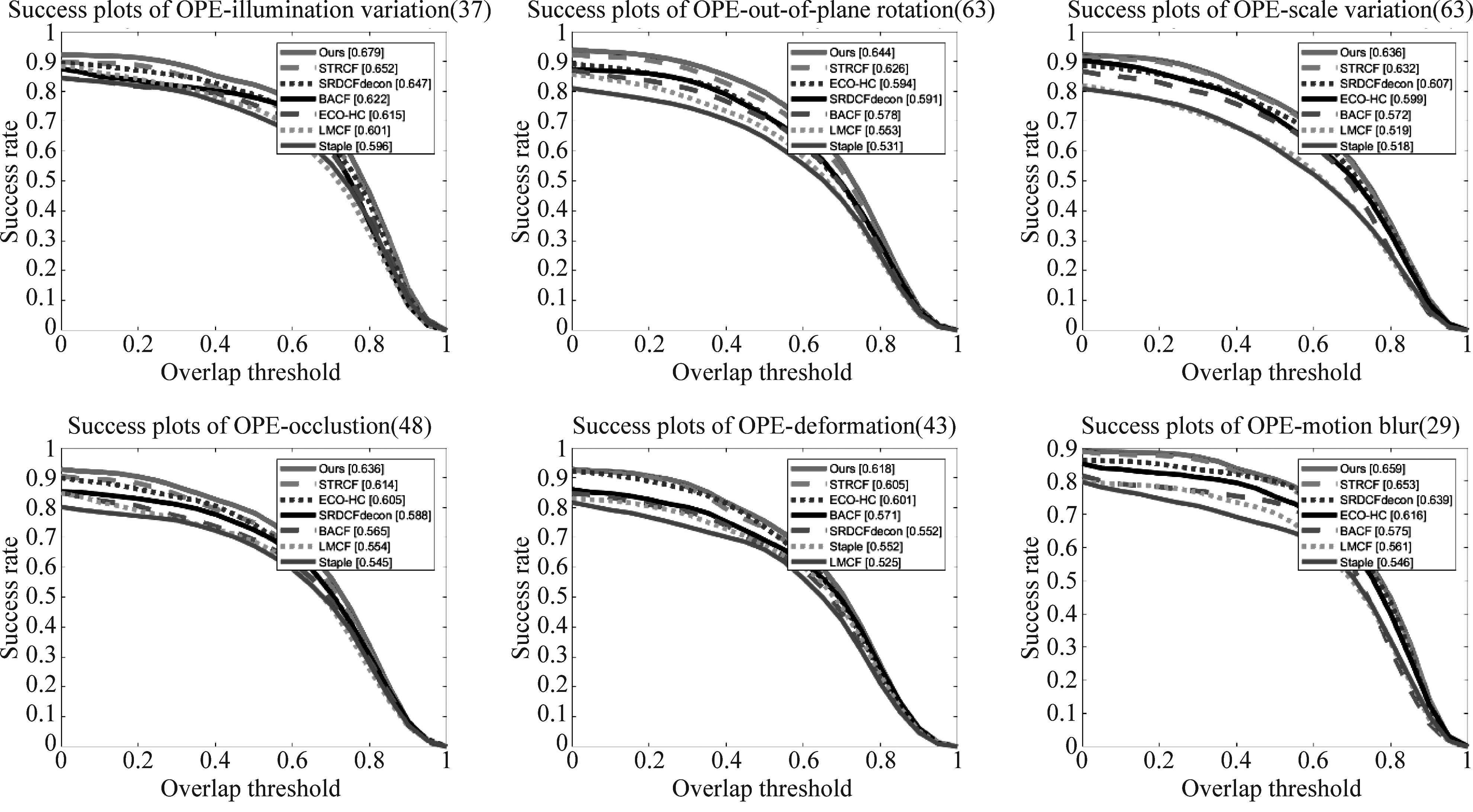

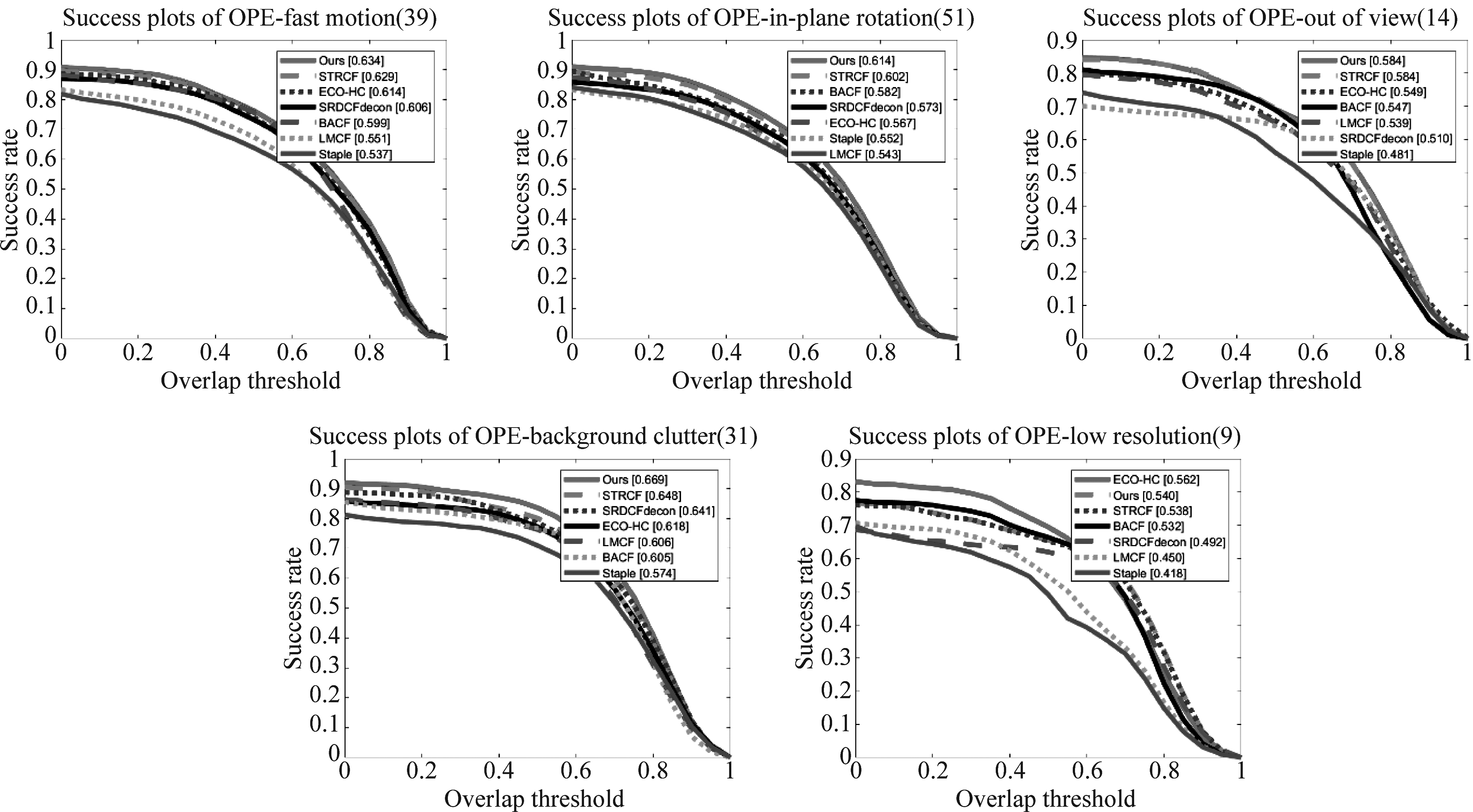

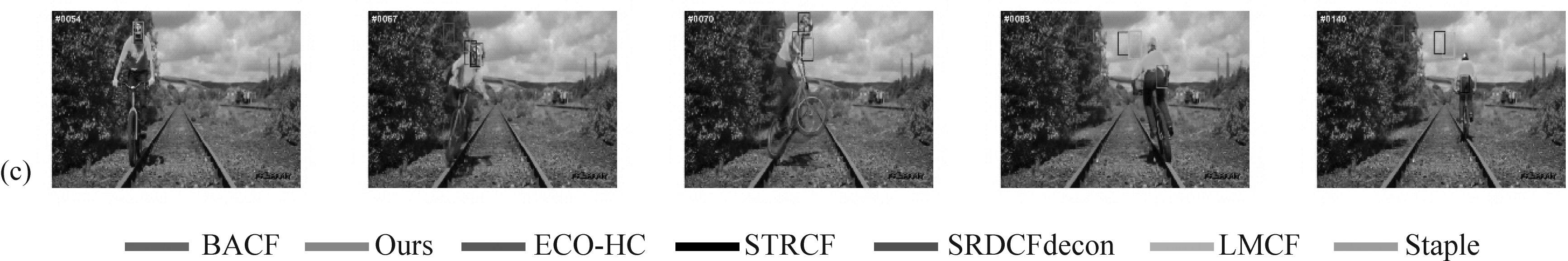

图3展示了7个对比跟踪算法在OTB数据集上的Precision plot、Success plot,观察可知本文提出的算法在OTB数据集上整体表现优于其他对比算法,其在OTB-50上的Precision plot、Success plot分别为83.9%、61.7%;在OTB-100上的Precision plot、Success plot分别为87.6%、66.6%;在OTB-2013上的Precision plot、Success plot分别为89.9%、68.9%;相较于STRCF,Precision plot、Success plot都提升了1.2%,表明了本文算法FLSTCF根据响应图变化,引入专注学习时空关系可让算法及时适应目标外观变化,矫正STRCF在某些视频上的跟踪误差,从而实现准确跟踪。图4展示了7个对比跟踪算法在OTB-100数据集上不同属性的Success plot,图4表明了本文算法FLSTCF在各个属性上均表现良好,都优于其他对比算法。只有在低分辨率(Low Resolution)属性上排位第二。因为目标外观尺寸变化时,其图像分辨率也随之变化,但本文算法以牺牲最优尺度估计换取跟踪速度,仅对候选区域进行5个步长尺度因子计算。

图3 OTB数据集Precision plot、Success plot评估结果

Fig.3 Evaluation results of OTB data sets precision plot and success plot

图4 7个对比算法在OTB-100上各属性的评估结果

Fig.4 The evaluation results of seven algorithms on OTB-100 are compared

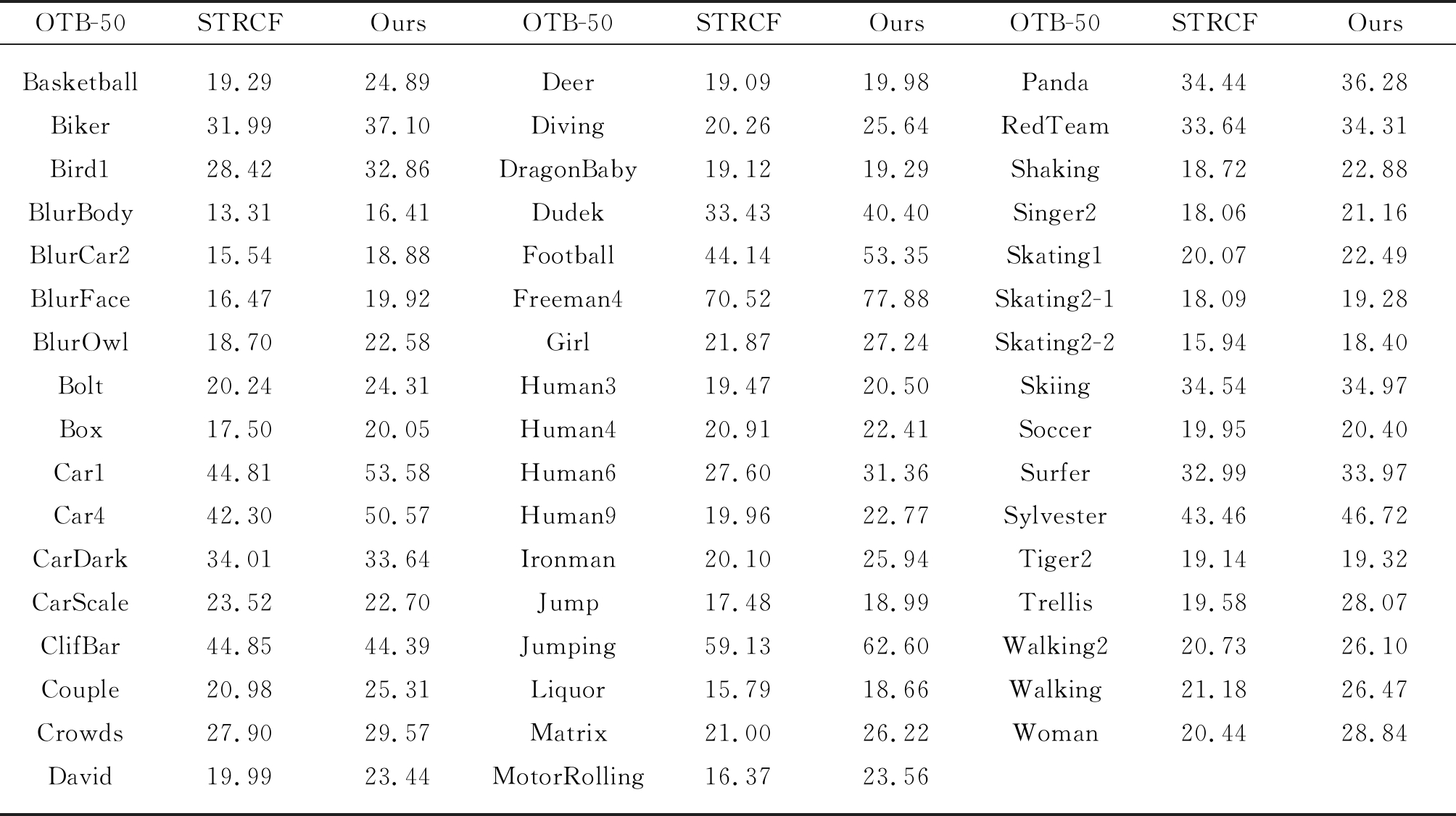

本文2.2节阐述了FLSTCF借助AMDD算法及帕塞瓦尔定理极大降低了求解损失函数式(6)的复杂度,但相较于STRCF的损失函数式(1),FLSTCF的损失函数的确是增多了对子问题m的求解。子问题m没有涉及相关运算,可直接在时域求解,所以对跟踪速度影响甚微。与STRCF一样,子问题f的求解才是整个跟踪过程耗时所在,子问题f过于复杂以致于需要转到频域后再对点元素求解,极大影响了跟踪速度。为了提高FLSTCF的跟踪速度,本文在空间正则项权值的参考权重的求解处做了加速处理,即滤波器将避免学习对应相邻两帧的响应图中剧烈变化的像素点。再有,当时间正则项权值μ变化很大时,表明了目标外观发生急剧变化,便停止对滤波器的学习以提高跟踪速度。表1显示了FLSTCF、STRCF在OTB-50数据集上的跟踪速度(单位:FPS/s)结果。由表可知,本文算法FLSTCF在OTB-50数据集上的跟踪速度优于SRTCF,FLSTCF在OTB-50数据集的平均跟踪速度为29.53 FPS/s,而STRCF在OTB-50数据集的平均跟踪速度25.94 FPS/s,提高了约4 FPS/s。

表1 FLSTCF、STRCF在OTB-50数据集上的跟踪速度

Tab.1 Tracking speed of FLSTCF and STRCF on OTB-50 data set

OTB-50STRCFOursOTB-50STRCFOursOTB-50STRCFOursBasketballBikerBird1BlurBodyBlurCar2BlurFaceBlurOwlBoltBoxCar1Car4CarDarkCarScaleClifBarCoupleCrowdsDavid19.2931.9928.4213.3115.5416.4718.7020.2417.5044.8142.3034.0123.5244.8520.9827.9019.9924.8937.1032.8616.4118.8819.9222.5824.3120.0553.5850.5733.6422.7044.3925.3129.5723.44DeerDivingDragonBabyDudekFootballFreeman4GirlHuman3Human4Human6Human9IronmanJumpJumpingLiquorMatrixMotorRolling19.0920.2619.1233.4344.1470.5221.8719.4720.9127.6019.9620.1017.4859.1315.7921.0016.3719.9825.6419.2940.4053.3577.8827.2420.5022.4131.3622.7725.9418.9962.6018.6626.2223.56PandaRedTeamShakingSinger2Skating1Skating2-1Skating2-2SkiingSoccerSurferSylvesterTiger2TrellisWalking2WalkingWoman34.4433.6418.7218.0620.0718.0915.9434.5419.9532.9943.4619.1419.5820.7321.1820.4436.2834.3122.8821.1622.4919.2818.4034.9720.4033.9746.7219.3228.0726.1026.4728.84

3.3 消融分析

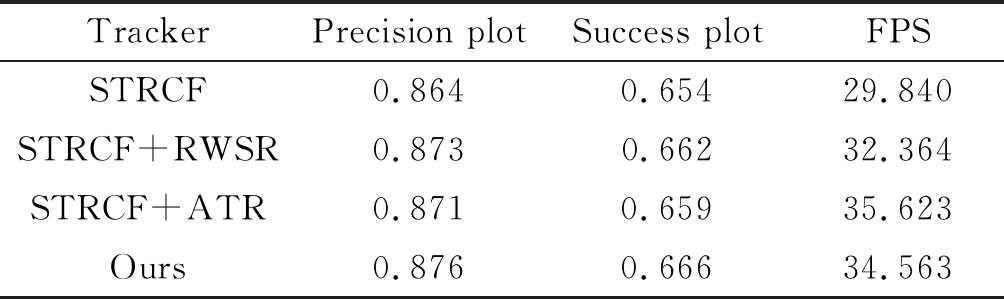

本文算法FLSTCF引入相邻两帧的响应图变化作为空间正则权值的参考权重及当前帧响应图的振荡程度确定时间正则项权值,两者可各自添加在STRCF中,当然添加两者可以使算法性能达到最优。本部分在STRCF中逐个添加空间正则项权值的参考权重(RWSR)及自适应时间正则项权值(ATR),基于OTB-100数据集实验证明了本文方法的可行性、有效性,总体评估结果如表2所示。添加了本文方法,性能便会得到平稳提升。更值得注意是的,与RWSR相比,ATR还可以提高速度,因为算法减少了对响应图振荡激烈的样本进行无意义且有害的训练。

表2 本文算法的消融分析

Tab.2 Analysis of the algorithm in this paper

TrackerPrecision plotSuccess plotFPSSTRCF0.8640.65429.840STRCF+RWSR0.8730.66232.364STRCF+ATR0.8710.65935.623Ours0.8760.66634.563

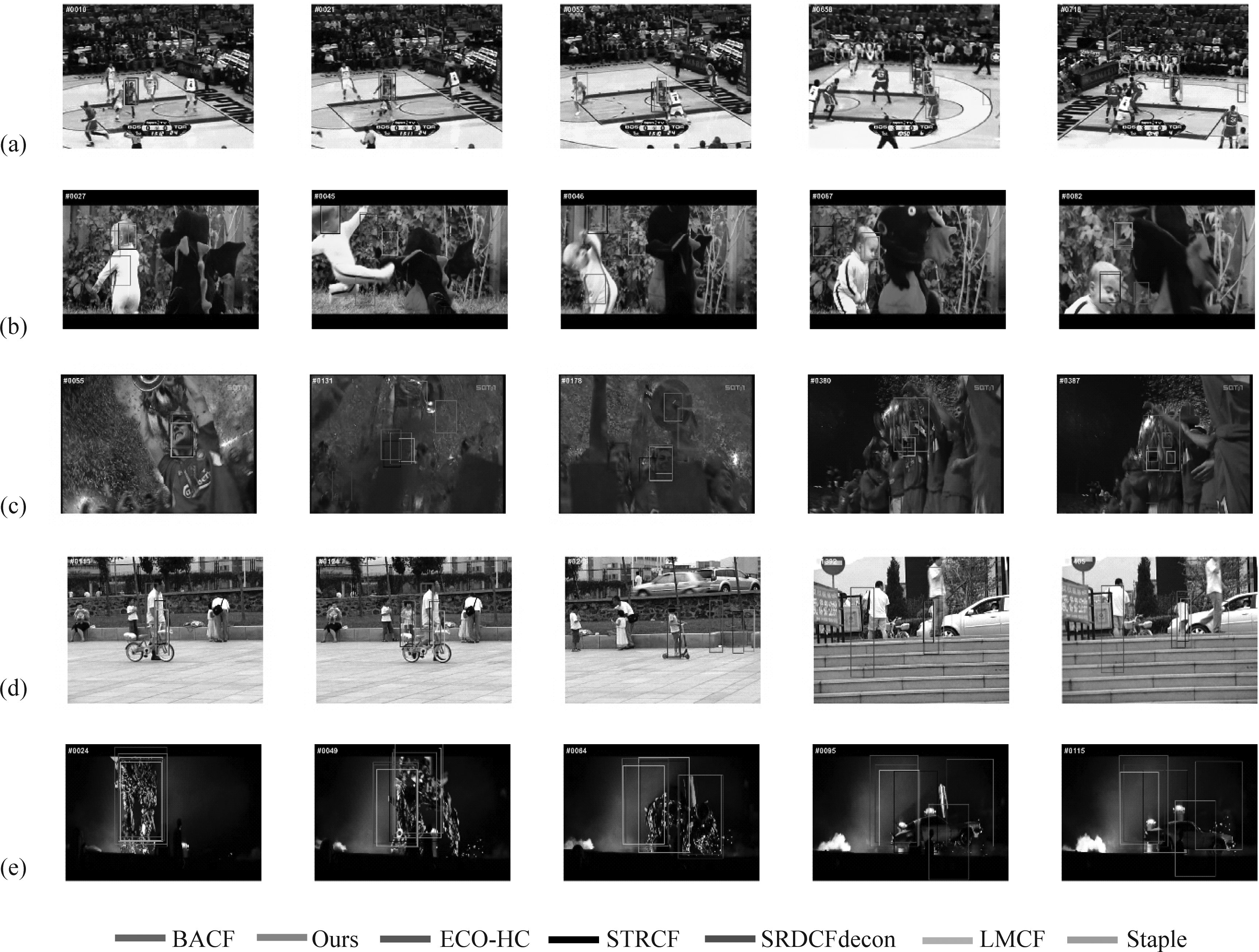

3.4 定性分析

为了更直观地评估本文算法FLSTCF的性能,本章节选取OTB数据集中5组富有挑战性的视频序列进行定性分析实验,图5展示了7个对比跟踪算法的总体跟踪效果。这5组视频几乎囊括了全部挑战,(a)Basketball具有光照变化、遮挡、平面外旋转等属性;(b)DragonBaby具有尺寸变化、运动模糊、快速运动、出视野等属性;(c)Soccer具有平面旋转、背景模糊等属性;(d)Girl2具有尺寸变化、遮挡、低分辨率等属性;(e) Trans2具有光照变化、遮挡、形变等属性。左上角的黄色数值为视频序列当前帧数。

图5 不同算法的跟踪结果. (a)Basketball, (b)DragonBaby, (c)Soccer, (d)Girl2, (e)Trans2

Fig.5 Tracking results of different algorithms. (a)Basketball, (b)DragonBaby, (c)Soccer, (d)Girl2, (e)Trans2

观察各视频序列可发现,(a)Basketball在第21帧存在部分短时间遮挡,但是已有一些算法出现跟踪漂移,从而导致后续帧跟踪错误。在第52帧时由于目标外观形变使得滤波器未能及时适应目标外观变化,影响了响应图的可信度,导致所有算法都出现了跟踪漂移。在第52帧,STRCF出现跟踪框逐渐变小,后续帧跟踪几乎全部出错;而本文算法引入当前帧响应图的振荡程度确定时间正则权值,能够灵活适应目标外观形变。(b)DragonBaby是个极具有挑战性的视频序列,本文所对比的7个算法都存在一定跟踪漂移,但后续帧能再检测出目标从而跟踪正确。快速运动和快速形变是相关滤波方法的缺陷,目前为止没有哪一种可以完美解决这两问题,但本文算法能较好的抑制滤波器的退化,有利于后续帧的再检测到正确目标,如第27帧,本文算法已经出现了跟踪漂移,但是在第45帧时又正确跟踪回目标。值得注意的是,本文算法相较于STRCF提升了13.35%。(c)在Soccer视频序列中,采用手工特征的跟踪器表现乏力,但本文算法FLSTCF在该视频序列表现良好,以57.2% 的成绩优于STRCF(50.23%)和其他对比算法。在第131帧时,除本文算法外均未能应付目标部分或完全被遮挡或目标区域模糊,全部出现跟踪漂移。在第176帧时,相似物体干扰会导致STRCF跟踪错误,但本文算法未受到影响,再一次验证了本文算法的优越性。本文所对比的7个算法第380帧后丢失目标,因为目标发生了长时间严重遮挡。(d)Girl2视频序列最大的跟踪难点在于第111帧的长时间遮挡,会导致一些算法的跟踪框直接跟着白色上衣人物移动,丢失目标。此视频系列中本文算法FLSTCF跟踪效果最优,Success plot 达到69.87%的良好表现。观察第124帧可知BACF、STRCF、SRDCFdecon、LMCF及Staple跟踪错误,但在后续的第333帧时STRCF、SRDCFdecon、LMCF又跟回目标,因为第230多帧时白色上衣人物走出了视野,使得跟踪框停留在原地,而小女孩正慢慢接近跟踪框,随后进入了算法的检测范围,所以算法得以再检测出目标。如果白色上衣人物一直在视野内或是两人物是相向运动,那么在第124帧丢失目标后再无检测跟回的可能了。在第1392帧时,目标也遭到了部分遮挡,所有算法均发生漂移,但并不影响后续的跟踪。(e)Trans目标严重形变,从一个竖着的物体变成横着的物体。在第49帧时,本文算法FLSTCF还是可以正确跟踪目标,尺度估计也非常好;但是在第64帧时所有算法均发生跟踪漂移,直到彻底丢失目标。在第95帧时,所有算法失效,这是因为所有算法都是以一定比例的尺度因子进行采样,所以并不能有效解决目标在图像平面中旋转及目标旋转出图像平面问题。

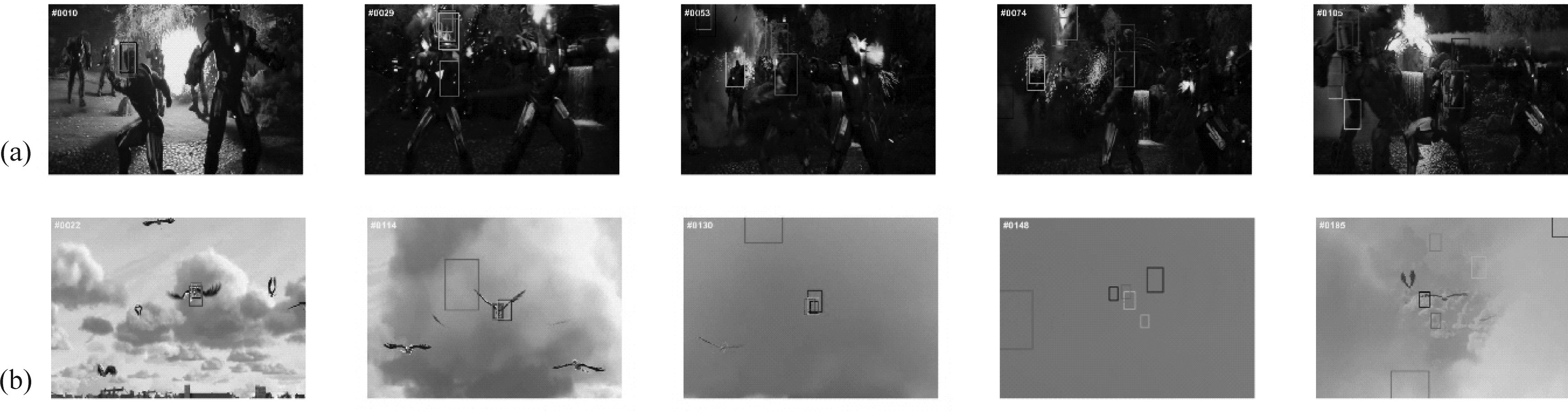

3.5 失败案例分析

本文算法FLSTCF可有效缓解边界效应带来的影响及抑制滤波器发生突变,但并不能克服判别式相关滤波方法的局限性,如目标快速形变及滤波器尺寸恒定不变;再者就是本文算法FLSTCF对长时间遮挡的视频序列跟踪乏力。图6展示了本文算法FLSTCF跟踪丢失视频序列,(a)Ironman视频序列,所有对比算法在该序列上大失所望,本文算法FLSTCF在该序列的Success plot只有11.53%,而STRCF有20.22%。该序列从第10帧开始就存在遮挡、快速运动及快速形变等挑战,大部分算法出现了轻微漂移。在第29帧,FLSTCF就发生严重漂移,跟踪框出了边界;而在第74帧,FLSTCF错误定位到相似物上,偏差严重。(b)对于Bird视频序列,目标框尺寸较小导致特征提取粗略,所有对比算法都发生轻微漂移,如第22帧所示。在114帧时,SRDCFdecon已经完全丢失了目标,而本文算法FLSTCF尚可跟踪目标,直到目标进入云层被长时间遮挡后就彻底丢失了目标。由第148帧可知,所有算法都发生了严重漂移。在目标飞出云层后,又由于相似物干扰,所有算法均未能重新定位回目标,如第185帧所示。(c)在Biker视频序列中,目标框尺寸较小导致算法提取的特征不足且由于快速运动,所有对比算法在第70帧均失效。在第83帧时,目标被完全遮挡且后续帧被长时间遮挡,导致目标跟踪丢失。

图6 跟踪失败的案例. (a) Ironman, (b) Bird, (c) Biker

Fig.6 Tracking failed cases. (a) Ironman, (b) Bird, (c) Biker

4 结论

本文提出专注学习时空关系的相关滤波跟踪算法(FLSTCF),引入相邻两帧的响应图变化作为空间正则权值的参考权重,使滤波器专注于对象可信赖部分的学习;而当前帧响应图的振荡程度确定时间正则项权值,用于约束滤波器的参数变化。最后通过ADMM方法实现本文算法损失函数的优化和更新,极大减少计算复杂度,通过在OTB数据集上进行了大量对比实验,充分验证了本文算法在复杂场景下更具有稳定性、鲁棒性及速度更快。FLSTCF无法克服长时间遮挡问题,在LCT+[19]中的实验表明,针对长期视觉跟踪的问题最有效的方法即是采取目标再检测方法。所以本文未来的工作方向尝试引入深度特征结合手工特征及增加目标再检测机制来提高FLSTCF的跟踪性能。

[1] 卢湖川, 李佩霞, 王栋. 目标跟踪算法综述[J]. 模式识别与人工智能, 2018, 31(1): 61-76.

LU Huchuan, LI Peixia, WANG Dong. Visual object tracking: A survey[J]. Pattern Recognition and Artificial Intelligence, 2018, 31(1): 61-76.(in Chinese)

[2] 孙欣, 何宁. 结合背景空间信息的相关滤波目标跟踪算法研究[J]. 计算机应用与软件, 2020, 37(2): 130-133,176.

SUN Xin, HE Ning. Correlation filtering object tracking algorithm combined with background space information[J]. Computer Applications and Software, 2020, 37(2): 130-133,176.(in Chinese)

[3] LIN Zhiguan, YUAN Chun. Robust visual tracking in low-resolution sequence[C]∥2018 25th IEEE International Conference on Image Processing (ICIP). Athens, Greece. IEEE, 2018: 4103- 4107.

[4] BOLME D S, BEVERIDGE J R, DRAPER B A, et al. Visual object tracking using adaptive correlation filters[C]∥2010 IEEE Computer Society Conference on Computer Vision and Pattern Recognition. San Francisco, CA, USA. IEEE, 2010: 2544-2550.

[5] HENRIQUES J F, CASEIRO R, MARTINS P, et al. Exploiting the circulant structure of tracking-by-detection with kernels[C]∥European Conference on Computer Vision. Springer, Berlin, Heidelberg, 2012: 702-715.

[6] DANELLJAN M, H GER G, KHAN F S, et al. Learning spatially regularized correlation filters for visual tracking[C]∥2015 IEEE International Conference on Computer Vision (ICCV). Santiago, Chile. IEEE, 2015: 4310- 4318.

GER G, KHAN F S, et al. Learning spatially regularized correlation filters for visual tracking[C]∥2015 IEEE International Conference on Computer Vision (ICCV). Santiago, Chile. IEEE, 2015: 4310- 4318.

[7] GALOOGAHI H K, FAGG A, LUCEY S. Learning background-aware correlation filters for visual tracking[C]∥2017 IEEE International Conference on Computer Vision (ICCV). Venice, Italy. IEEE, 2017: 1144-1152.

[8] HUANG Ziyuan, FU Changhong, LI Yiming, et al. Learning aberrance repressed correlation filters for real-time UAV tracking[C]∥2019 IEEE/CVF International Conference on Computer Vision (ICCV). Seoul, Korea (South). IEEE, 2019: 2891-2900.

[9] DAI Kenan, WANG Dong, LU Huchuan, et al. Visual tracking via adaptive spatially-regularized correlation filters[C]∥2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Long Beach, CA, USA. IEEE, 2019: 4665- 4674.

[10] LI Feng, TIAN Cheng, ZUO Wangmeng, et al. Learning spatial-temporal regularized correlation filters for visual tracking[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City, UT, USA. IEEE, 2018: 4904- 4913.

[11] BOYD S, PARIKH N, CHU E, et al. Distributed optimization and statistical learning via the alternating direction method of multipliers[J]. Foundations & Trends in Machine Learning, 2011, 3(1): 1-122.

[12] WANG Mengmeng,LIU Yong,HUANG Zeyi.Large margin object tracking with circulant feature maps[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Honolulu, HI, USA. IEEE, 2017: 4800- 4808.

[13] 付晓雅, 王兆成. 结合场景分类的近岸区域SAR舰船目标快速检测方法[J]. 信号处理, 2020, 36(12): 2123-2130.

FU Xiaoya, WANG Zhaocheng. SAR ship target rapid detection method combined with scene classification in the inshore region[J]. Journal of Signal Processing, 2020, 36(12): 2123-2130.(in Chinese)

[14] ASHOK NARAYANAN V, PRABHU K M M. The fractional Fourier transform: Theory, implementation and error analysis[J]. Microprocessors and Microsystems, 2003, 27(10): 511-521.

[15] BERTINETTO L,VALMADRE J,GOLODETZ S,et al.Staple: complementary learners for real-time tracking[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Las Vegas, NV, USA. IEEE, 2016: 1401-1409.

[16] DANELLJAN M, BHAT G, KHAN F S, et al. ECO: efficient convolution operators for tracking[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Honolulu, HI, USA. IEEE, 2017: 6931- 6939.

[17] WU Y, LIM J, YANG M H. Object tracking benchmark[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(9): 1834-1848.

[18] WU Yi, LIM J, YANG M H. Online object tracking: A benchmark[C]∥2013 IEEE Conference on Computer Vision and Pattern Recognition. Portland, OR, USA. IEEE, 2013: 2411-2418.

[19] MA Chao, HUANG Jiabin, YANG Xiaokang, et al. Adaptive correlation filters with long-term and short-term memory for object tracking[J]. International Journal of Computer Vision, 2018, 126(8): 771-796.