1 引言

近些年来,随着物联网、人工智能和虚拟现实等技术的发展[1],高能耗的计算密集型业务不断增长,计算密集型应用和资源受限的移动计算系统之间的冲突给未来移动业务的发展带来了前所未有的挑战。为了应对这一挑战,通常采用的是移动云计算技术(Mobile Cloud Computing, MCC)[2],将移动终端上的计算任务卸载到资源丰富的远端云完成。然而,传统的MCC方法具有通过广域网的数据传输引起的长延迟和低可靠性的缺点。近些年,可以在移动用户附近提供云计算能力的移动边缘计算(Mobile Edge Computing, MEC)被提议作为5G的关键技术之一[3- 4]。将用户的计算任务卸载到邻近的MEC服务器,即移动边缘计算卸载,被认为是解决上述挑战的一个有前途的解决方案[5]。与传统的MCC方案相比,边缘计算可以实现更低的延迟和更高的可靠性,已经成为研究热点。

移动边缘计算中的计算卸载和资源分配方法至关重要,人们已经进行了一些研究[6-9]。针对完全卸载问题,文献[10]根据需要卸载的数据量,将所有用户设备分为两组,第一组中的用户设备允许访问MEC服务器,而第二组只能在本地处理任务,根据通信和计算资源的分配确定最佳传输功率。文献[11]提出了使用MEC的无线蜂窝网络中用于计算卸载和干扰管理的集成框架,将计算卸载决策,物理资源块分配和MEC计算资源分配建模为优化问题,采用图像着色的方法进行物理资源块的分配。文献[12]研究了在多个无线接入系统中移动终端的计算卸载问题,提出了一种基于博弈论计算卸载和资源分配的方案来解决此优化问题。针对部分卸载问题,文献[13]考虑到多个子任务卸载相互之间的关系,提出了一种基于强化学习的无模型方法,根据网络环境的变化自适应地学习以优化卸载决策和能耗,但是文章中只考虑了单用户的场景。文献[14]针对部分卸载,考虑线性关系的子任务模型,提出了一种迭代启发式MEC资源分配来动态的做出卸载决策。针对联合MEC与MCC的卸载问题,文献[15]引入了混合光纤网络,以支持云边协同的计算卸载问题,提出了近似协同计算卸载方案和博弈论协同计算卸载方案。文献[16]联合设备到设备(Device to Device, D2D)通信和MEC两种技术,提出了一种基于MEC中D2D协作的节能且具有延迟限制的卸载方案,根据请求设备的时延限制和能耗限制对卸载请求进行分类,利用最大匹配和最小代价图算法找到合适的卸载目标。

上述研究部分考虑的是单基站用户卸载的情况,并且用户一次只卸载一个任务,部分考虑了多基站用户的情况,但是都没有考虑到多基站重叠覆盖用户的基站接入选择问题以及多用户多任务的卸载问题。本文针对多基站、多用户和多任务卸载场景,提出了基站选择、卸载决策及资源分配联合优化算法。针对边缘云与远端云协作的多用户多基站场景,基于基站接入选择,在边缘服务器计算资源约束条件下,构建了能耗与时延加权和的最小化的混合整数优化问题,并将该NP-hard问题分两步进行求解。首先,在不考虑MEC服务器计算资源的约束和用户间资源竞争的情况下,将多用户优化问题解耦成单用户的凸优化模型,采用拉格朗日乘子法进行求解,并作为各个用户的初始卸载决策;然后,针对多基站重叠覆盖的用户,利用初始的卸载决策以及用户到基站的信道增益,提出了一种自适应的基站选择方案,针对MEC计算资源有限的问题,采用一种迭代式的启发算法,基于初始卸载决策对用户的计算卸载决策进行优化以满足MEC资源的约束。仿真结果表明,通过联合边缘云与远端云服务器,本文提出的多用户基站选择、资源分配及卸载决策算法能有效的降低用户的处理时延与能耗。

本文的其余部分安排如下,第2节给出了系统模型和问题描述,第3节提出了基于多用户基站选择的联合计算卸载及资源分配的算法,第4节对算法进行了仿真和分析,第5节总结了本文的主要内容。

2 系统模型及问题描述

2.1 系统模型

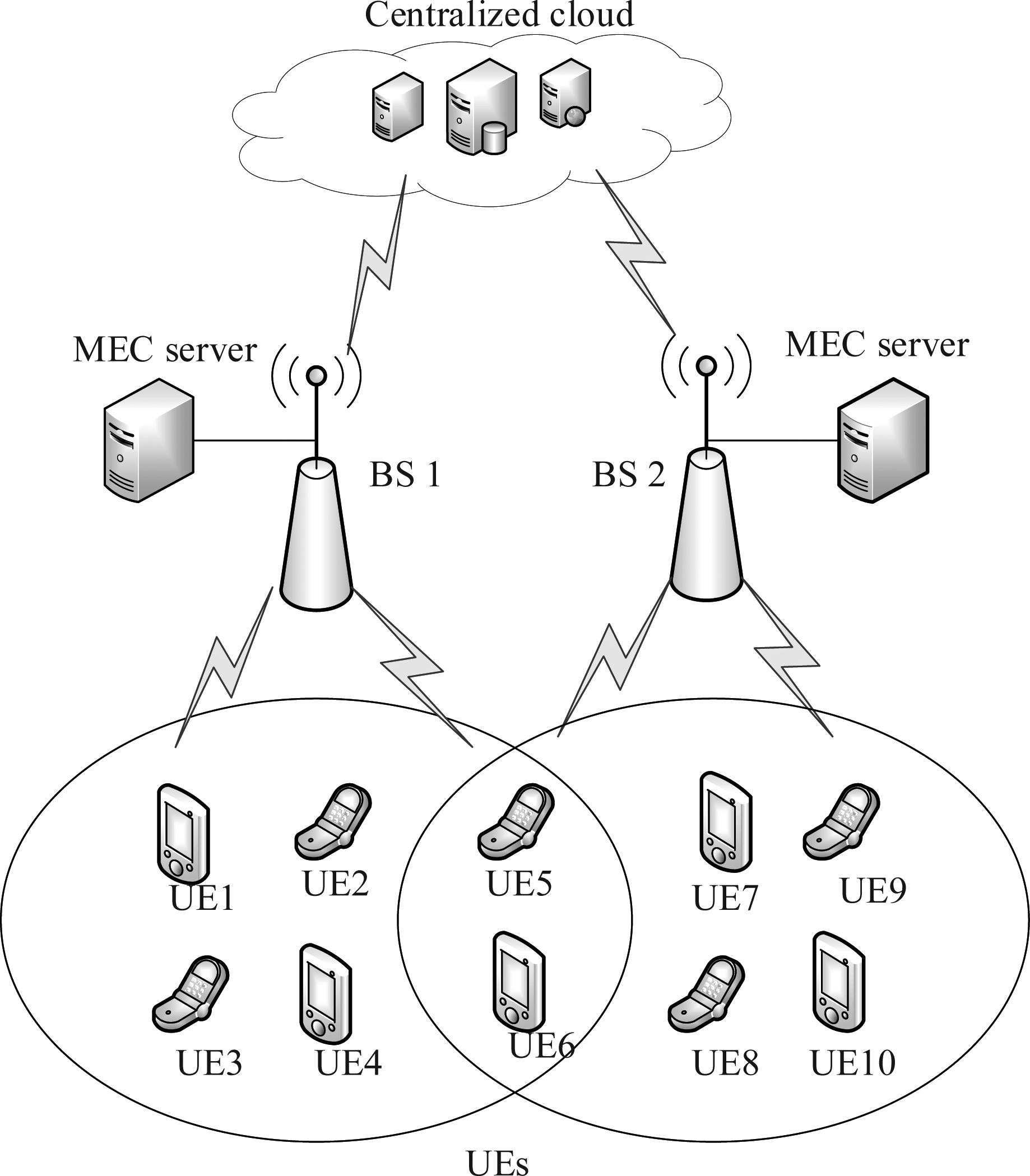

本文的系统模型如图1所示,由一个远端云节点和多个配置了MEC服务器的基站组成,每个基站覆盖范围内分布了多个用户终端。其中,远端云节点与基站、基站与移动终端设备分别存在一对多的映射关系,终端设备通过无线网络接入到基站,基站可以通过互联网将任务卸载至远端云节点并接受远端云节点响应的计算结果,返回给终端设备。考虑到部分用户处于多个基站重叠覆盖,因此可以从这些基站中选择一个接入,在任务处理过程中,用户仅能选择一个基站进行接入。例如图1中的UE5、UE6可以选择通过基站1或基站2接入,因此本文针对多基站覆盖的用户,在卸载过程中考虑到了基站的选择。假设有N个用户终端,每个用户一次请求多个任务,这些任务的数据量大小和任务复杂度相同。假设终端i当前有一批任务量为ki的任务需要被执行,用户的每个任务都可以选择在本地执行、卸载到MEC执行或者远端云执行。定义xi表示用户i本地执行的任务数,![]() 表示卸载至边缘服务器的任务数,

表示卸载至边缘服务器的任务数,![]() 表示卸载至远端云的任务数,则终端i的卸载决策约束为:

表示卸载至远端云的任务数,则终端i的卸载决策约束为:

(1)

图1 移动边缘计算系统框架

Fig.1 Mobile edge computing system framework

假设有M个基站,每个基站都配备一个MEC服务器,MEC服务器又可分为λm个服务模块,m=1,…,M,每个服务模块计算能力相同且同一时间只能处理一个任务。例如,与基站1相连的MEC服务器有λ1个服务模块,与基站2相连的MEC服务器有λ2个服务模块。所有基站中的用户都工作在相同频段,相互之间会有干扰,信道带宽为B。

本文的目标是降低系统的时延和用户终端的能耗。系统的时延包括计算时延和通信时延,计算时延包含本地执行时延、MEC执行的时延以及远端云执行的时延,通信时延包括任务数据从移动端传输到基站的时延以及从基站传输到远端云的时延。终端的功耗包括本地计算能耗和传输能耗,主要包括用户自身计算任务需要消耗的能量以及上传任务数据到基站所需要的能量。

2.2 通信模型

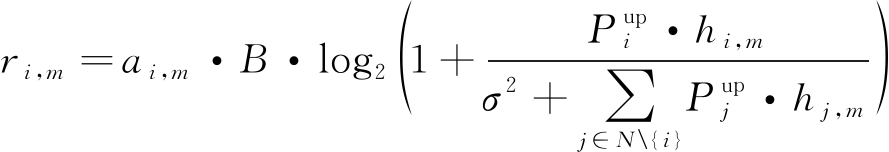

与本地计算相比,将计算任务卸载到MEC或云端进行处理可以降低时延与能耗,但传输任务数据会消耗额外的时延与能耗(即通信时延与能耗)。根据Shann-Hartley定理,用户i到基站m的通信模型可以定义为:

(2)

其中B表示信道带宽,ai,m表示若用户i选择基站m进行卸载,则ai,m=1,反之![]() 表示用户i的传输功率,hi,m表示用户i和基站m之间的信道增益,σ2表示高斯白噪声功率,

表示用户i的传输功率,hi,m表示用户i和基站m之间的信道增益,σ2表示高斯白噪声功率,![]() 表示其他用户传输卸载数据对用户i产生的干扰。

表示其他用户传输卸载数据对用户i产生的干扰。

2.3 计算模型

将用户终端i的计算任务定义为数组![]() 其中

其中![]() 表示任务计算输入数据的大小,Di表示单任务执行所需的CPU周期数,

表示任务计算输入数据的大小,Di表示单任务执行所需的CPU周期数,![]() 表示任务计算后响应数据大小,时延与计算能耗分三种情况进行讨论。

表示任务计算后响应数据大小,时延与计算能耗分三种情况进行讨论。

(1) 当用户i选择本地执行时,用户终端i任务的执行时间![]() 和执行任务的计算能耗

和执行任务的计算能耗![]() 可以表示为:

可以表示为:

(3)

(4)

其中fi为用户终端i的计算能力,即单位时间运行CPU周期数,c表示每个CPU周期消耗能量的系数。

(2) 当用户i选择将任务卸载到MEC执行时,通过无线传输会产生相应的时延与能耗,忽略基站与MEC之间的有线传输时延。根据通信模型可以得到卸载数据从用户终端到边缘节点的传输时间以及卸载任务数据至边缘服务器的计算时间和上传功耗为:

(5)

(6)

其中fedge为MEC为用户终端i分配的计算资源,并且卸载至MEC的任务数与MEC的服务模块数需要满足:

(7)

(3) 当用户i选择将任务卸载到远端云执行时,定义到远端云任务数据的传输时延为![]() 其中包括用户卸载数据到基站接入点的时延

其中包括用户卸载数据到基站接入点的时延![]() 和基站到远端云节点的有线传输时延

和基站到远端云节点的有线传输时延![]() 总传输时延可以表示为:

总传输时延可以表示为:

(8)

定义基站到远端云节点的传输速率为R,有:

(9)

(10)

定义远端云的计算能力为fcloud,由于远端云的计算资源丰富,不用考虑计算资源分配,其执行时延为:

(11)

则有远端云执行卸载任务时的时延以及用户能耗分别为:

(12)

(13)

综合式(2)~式(13),可以得到用户i的执行时延以及执行能耗为:

(14)

(15)

用户请求的一批任务可以选择在本地、MEC服务器、远端云服务器同时执行,因此这批任务执行时延是三者最长的执行时延。由于MEC和远端云的服务器一般是电力线供电,能源相对比较充足,因此本文主要考虑用户端的能耗,忽略MEC和远端云的服务器的执行能耗。由于计算完成返回的结果数据量较小,因此忽略了接收返回数据时用户的能耗和时延[17-18]。

2.4 问题描述

本文考虑的是当用户需要执行一批相同大小的任务时,为了快速的完成这批任务的计算,可以联合本地、MEC服务器以及远端云服务器分别对这批任务中的部分任务进行同时处理。那么用户终端完成任务的总时延T以及总能耗E为:

(16)

(17)

本文期望通过优化基站选择、卸载决策和资源分配降低任务时延和终端能耗,定义系统函数为用户时延与能耗的加权和,可以表示为:

Z(A,X,C)=E(A,X,C)+ε·T(A,X,C)

(18)

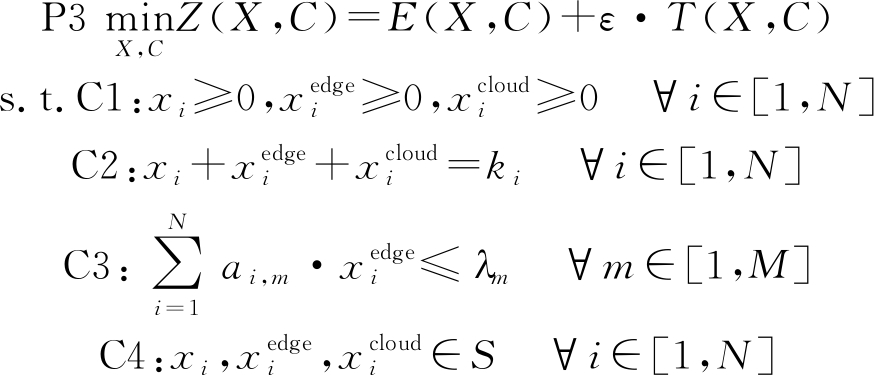

那么整个多基站多用户场景下的基站选择、卸载决策和资源分配优化问题可以公式化为:

![]()

![]()

![]()

![]()

![]()

C5:ai,m∈{0,1} ∀m∈[1,M], ∀i∈[1,N]![]()

(19)

其中ε表示为权重系数,S表示自然数的集合。约束C1表示一个用户最多选择一个基站进行接入,C2表示在本地、MEC和远端云执行的任务数均为正数,C3表示用户终端的ki个任务需要全部执行完成,C4表示卸载到目标基站下MEC服务器处理的任务数不能超过目标基站MEC的服务模块数量,C5表示基站的选择是一个二进制变量,C6表示在不同位置处理的任务数均为自然数。基站选择定义为A 〈ai,m〉,卸载决策定义为

〈ai,m〉,卸载决策定义为![]() 计算资源分配定义为

计算资源分配定义为![]() 表示分配给用户终端i的MEC服务模块的个数。

表示分配给用户终端i的MEC服务模块的个数。

3 基站选择、计算卸载和资源分配联合优化算法

问题P1中包含的基站选择A、卸载决策X以及资源分配C的解都是正整数解,内部之间相互关联,实际求解十分复杂,是一个NP-hard问题。为了简化求解过程,本文将原始问题P1解耦成单用户情况下的计算卸载机制,并以此为基础,采用一种次优的启发式算法来进行多用户情况下的求解。

3.1 单用户计算卸载机制

考虑单用户的场景,假设MEC服务模块数量无约束,同时不考虑用户间的干扰。对于单基站覆盖下的用户,显然只能卸载到一个基站,而对于重叠覆盖区域的用户,在这一小节中会分别计算卸载到不同基站下的卸载决策,则P1进行重写为:

![]()

s.t. C1,C2,C3,C5

(20)

定理1 问题P2是一个凸优化问题。

证明 对于问题P2,考虑能耗部分,![]() 可以简化为

可以简化为![]() 其中ai,bi,ci均为常量,又由于

其中ai,bi,ci均为常量,又由于![]() 将这一条件带入Ei,m表达式当中,消去xi,然后分别对

将这一条件带入Ei,m表达式当中,消去xi,然后分别对![]() 求偏导,可以得到均为常数,其二阶导均为零,因此能耗部分是凸函数。对于时延部分

求偏导,可以得到均为常数,其二阶导均为零,因此能耗部分是凸函数。对于时延部分![]() 令

令![]() 有:

有:

(21)

上式结果为常数,因此可以认为f1(x)为凸函数,同理可得f2(x)、 f3(x)也是凸函数。然后令f(x)=max{f1(x)、 f2(x)},其定义域为domf(x)=dom f1(x)∩domf2(x),任取0≤θ≥1以及x,y∈domf(x),有:

f(θx+(1-θ)y)=max{f1(θx+(1-θ)y), f2(x)+(1-θ)f2(y)}≤

max{θf1(x)+(1-θ)f1(y),θf2(x)+(1-θ)f2(y)}≤

θmax{f1(x), f2(x)}+(1-θ)max{f1(y), f2(y)}=

θf(x)+(1-θ)f(y)

(22)

从而说明了函数f(x)的凸性。同理,当f1(x)、 f2(x)、 f3(x)为凸函数时,则max{f1(x)、 f2(x)、 f3(x)}仍然是凸函数,所以可得时延部分也是凸函数,故P2是凸优化问题。

由定理1可知,P2是一个凸优化问题,在针对用户i求解时,卸载的目标基站是已知的,为了求出最优卸载决策,可以引入相应的拉格朗日函数:

(23)

考虑到上述问题包含不等式以及等式约束,对于该凸优化问题,找到满足KKT条件的点〈X,α,β〉是该问题的最优解。由于在不考虑资源约束的情况下,用户之间就不存在约束关系,可以解耦成单用户求解,对于单基站覆盖下的用户只需要求解一次,对于多基站覆盖下的用户,则需要分别求解卸载到不同基站下的卸载决策,最终可以得到所有用户的卸载决策X。

采用拉格朗日乘子法对问题P2解到的是非整数解,考虑到实际情况,需要进行取整。因此对求得的解![]() 将xi与

将xi与![]() 分别向上和向下取整,记为

分别向上和向下取整,记为![]() 得到对应的四组解

得到对应的四组解![]() 然后将这四组解代入目标函数中,获得目标函数最优解对应的卸载决策。

然后将这四组解代入目标函数中,获得目标函数最优解对应的卸载决策。

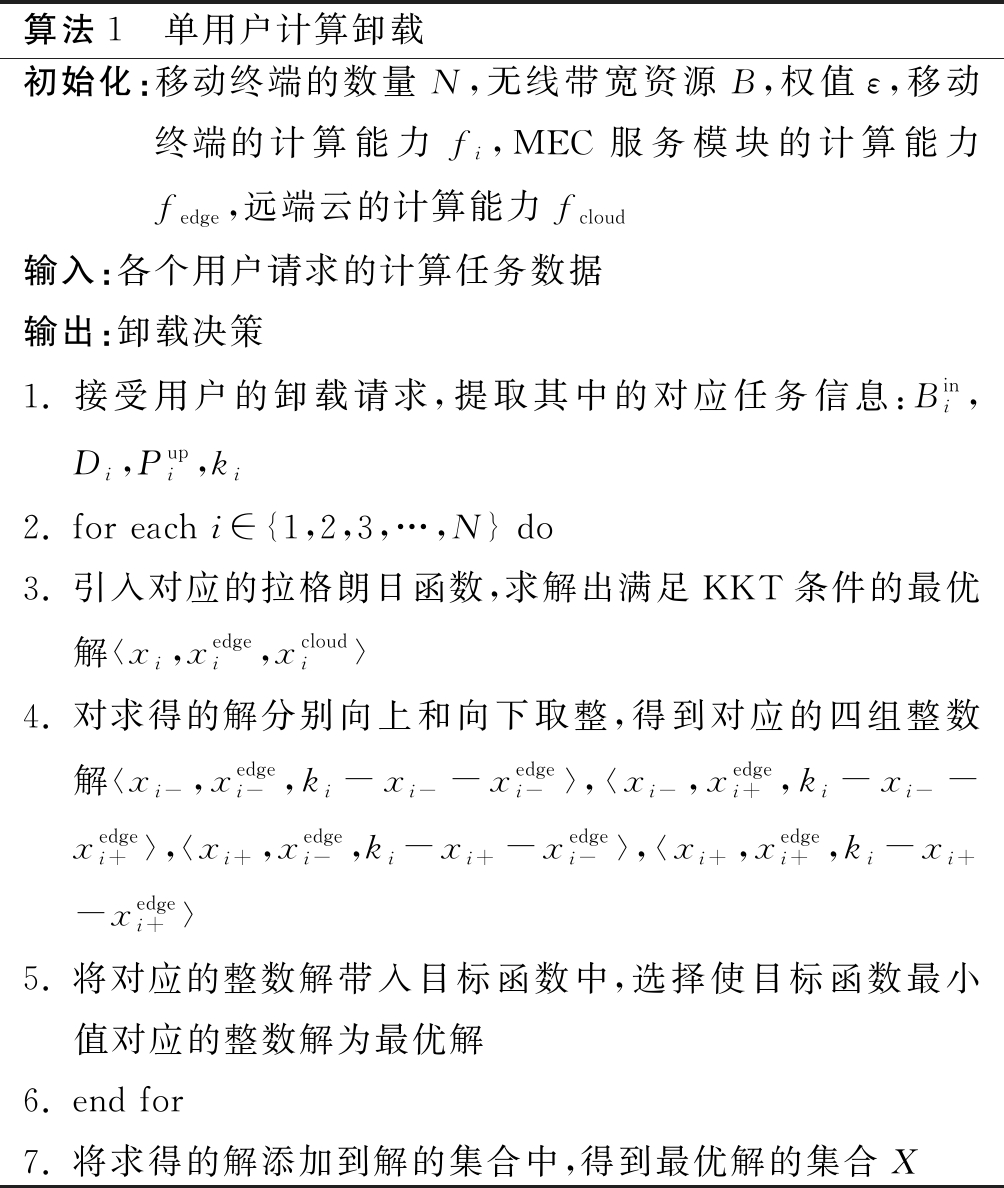

综上所述,针对不同区域的用户,不考虑MEC服务器计算资源的限制,分别引入在相应基站下卸载时的拉格朗日函数,求解出满足KKT条件的解,然后对求得的解取整,具体过程如表1所示。

表1 单用户计算卸载算法

Tab.1 Offloading algorithm calculated by single user

算法1 单用户计算卸载初始化:移动终端的数量N,无线带宽资源B,权值ε,移动终端的计算能力fi,MEC服务模块的计算能力fedge,远端云的计算能力fcloud输入:各个用户请求的计算任务数据输出:卸载决策1. 接受用户的卸载请求,提取其中的对应任务信息:Bini,Di,Pupi,ki2. for each i∈{1,2,3,…,N} do3. 引入对应的拉格朗日函数,求解出满足KKT条件的最优解

3.2 多用户基站选择、计算卸载及资源分配机制

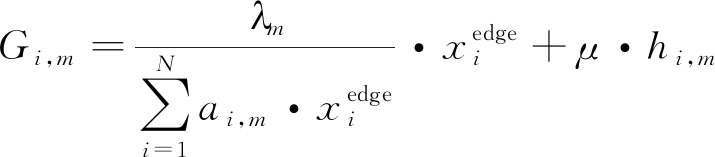

在本小节中,研究多用户的计算卸载问题。在多用户的场景下,需要考虑基站的选择、用户之间的干扰和MEC计算资源的限制,用户无线传输时的相互干扰以及MEC计算资源的竞争导致多用户的传输时延总大于单用户的传输时延。针对上述单用户的情况下,现在推广至多小区多用户的场景。首先根据用户到基站的信道增益将用户区分为单基站覆盖下的用户,这一类用户不需要进行目标基站的选择,对于重叠覆盖区域的用户,为了能够合理的分配MEC计算资源,需要先对重叠区域用户进行目标卸载基站的选择。对于基站m覆盖下的用户,令ai,m=1,未被基站m覆盖的用户ai,m=0。通过在3.1小节中求解得到的用户在选择不同基站时的卸载决策,考虑目标基站能为该用户分配的平均服务模块数和用户与目标基站之间的信道增益,本文定义基站选择函数为:

(24)

其中μ表示权重,基站选择函数表示用户终端i卸载任务到基站m能够分配到的服务模块数与用户终端i和基站m之间的信道增益的加权和。对于重叠区域覆盖的用户,分别计算用户i到不同基站的Gi,m,对Gi,m进行降序排列,选择的第一个值对应的基站作为用户i的目标卸载基站,将用户i到其余基站的选择值设为0,最终可以获得所有用户的基站选择决策A。那么问题P1可以重新描述为:

(25)

此时用户对基站的选择已经完成,然后分别对各个基站进行多用户的任务调度,这仍然是一个混合整数约束优化问题。因此本文采用启发式算法对P3进行求解,利用3.1中求得的单用户情况下的卸载决策作为初始解,考虑到MEC服务模块数量的限制,对资源冲突用户终端的初始卸载决策进行动态调整以满足MEC服务模块数量的限制。

首先引入一个判决函数[14],利用这个函数来解决MEC服务器计算资源受限的情况,定义为:

(26)

其中![]() 表示用户i在单用户情况下解出的卸载决策对应的系统函数值,

表示用户i在单用户情况下解出的卸载决策对应的系统函数值,![]() 表示用户i将原始卸载决策进行修正后得到的系统函数值。目标是使得整个系统的系统函数最小,在单用户情况下,不用考虑资源的受限,得出的解必定优于多用户场景。因此在多用户场景下,需要找到修正后的卸载决策对系统函数影响最小的情况。那么用两者之差来反映用户终端对MEC服务器计算资源的依赖程度,如果差值越小,则表明对MEC服务器计算资源的依赖程度越低。

表示用户i将原始卸载决策进行修正后得到的系统函数值。目标是使得整个系统的系统函数最小,在单用户情况下,不用考虑资源的受限,得出的解必定优于多用户场景。因此在多用户场景下,需要找到修正后的卸载决策对系统函数影响最小的情况。那么用两者之差来反映用户终端对MEC服务器计算资源的依赖程度,如果差值越小,则表明对MEC服务器计算资源的依赖程度越低。

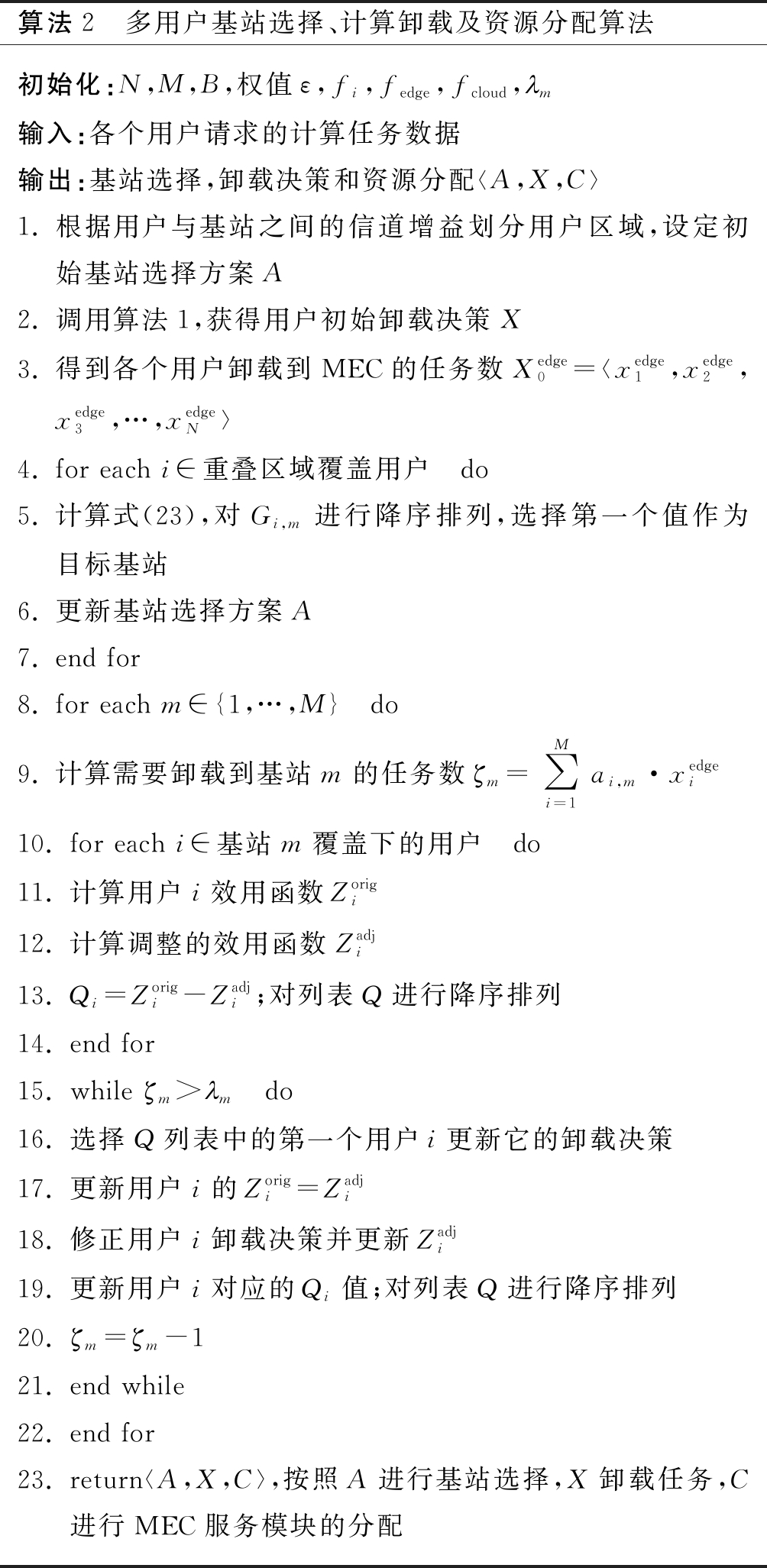

综上所述,算法2描述了多用户基站选择、计算卸载及资源分配机制。首先根据用户与各个基站之间的信道增益将用户划分为单基站覆盖下的用户和多基站覆盖下的用户,设置初始的基站选择方案A。然后调用算法1获得用户的初始卸载决策,计算各个用户卸载到MEC的任务数,根据式(24)进行重叠覆盖区域用户的基站选择,获得最终的基站选择方案A。接下来依次对每个基站下覆盖用户的卸载决策进行动态调整以满足MEC服务模块的约束,分别计算![]() 与

与![]() 获得它们的差值,对其进行降序排列,建立一个循环更新初始卸载决策直到满足MEC服务模块约束的限制,在每轮循环中选择第一个用户更新它们的卸载决策,重新计算

获得它们的差值,对其进行降序排列,建立一个循环更新初始卸载决策直到满足MEC服务模块约束的限制,在每轮循环中选择第一个用户更新它们的卸载决策,重新计算![]() 与

与![]() 对它们的差值进行降序排列直到循环结束。最终获得所有用户的基站选择方案A,卸载决策方案X,MEC服务模块分配方案C,具体过程如表2所示。

对它们的差值进行降序排列直到循环结束。最终获得所有用户的基站选择方案A,卸载决策方案X,MEC服务模块分配方案C,具体过程如表2所示。

表2 多用户基站选择、计算卸载及资源分配算法

Tab.2 Multi-user base station selection, computing unloading and resource allocation algorithms

算法2 多用户基站选择、计算卸载及资源分配算法初始化:N,M,B,权值ε,fi,fedge,fcloud,葜m输入:各个用户请求的计算任务数据输出:基站选择,卸载决策和资源分配

4 仿真结果与分析

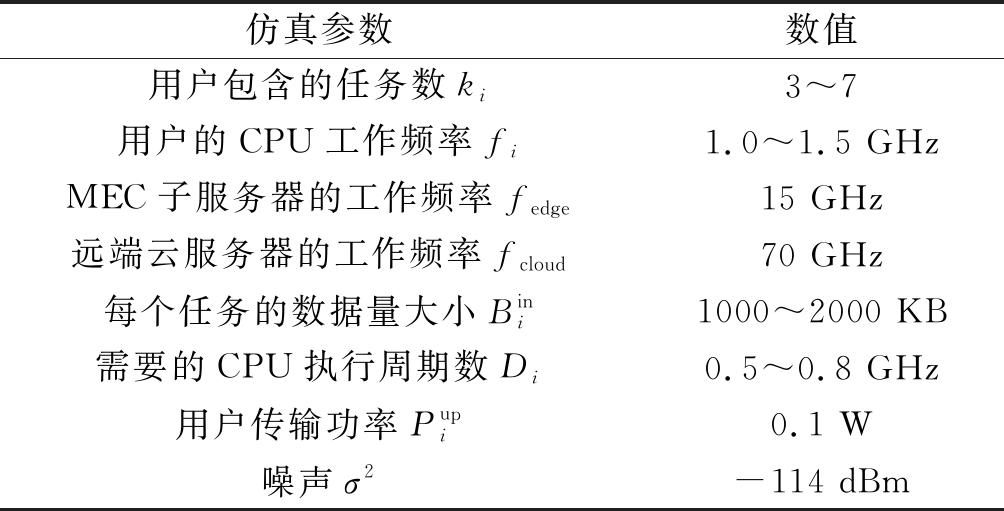

在本节中,基于分层的异构网络,同时考虑边缘云处理器与远端云处理器,对本文所提出的算法性能进行仿真分析。为了便于分析,本文考虑两个基站情况下的性能分析,信道增益hi遵循的空间路径损耗模型为:

(27)

其中Ad=4.11表示天线增益, fc=2.6 GHz表示载波频率,di表示用户到基站之间的距离,de≥2表示路径损耗指数,本文取de=2.8,所有用户的计算效率参数c=10-22。对于数据卸载模式,信道带宽B=20 MHz,用户随机分布在半径为100 m的圆当中,两个基站分布在圆内的一条直径上,与圆心都相距50 m,其余参数如表3所示。

表3 仿真参数

Tab.3 Simulation parameters

仿真参数数值用户包含的任务数ki3~7用户的CPU工作频率fi1.0~1.5 GHzMEC子服务器的工作频率fedge15 GHz远端云服务器的工作频率fcloud70 GHz每个任务的数据量大小Bini1000~2000 KB需要的CPU执行周期数Di0.5~0.8 GHz用户传输功率Pupi0.1 W噪声σ2-114 dBm

本文将所提出的算法与完全本地执行、完全卸载到MEC执行、完全卸载到远端云执行、采用本文算法但只选择距离最近的基站进行接入以及文献[14]的算法这五种方案进行对比。假设基站1的MEC服务模块数为λ1=20,基站2的MEC服务模块数为λ2=15,时延与能耗之间的权重设置为ε=5。

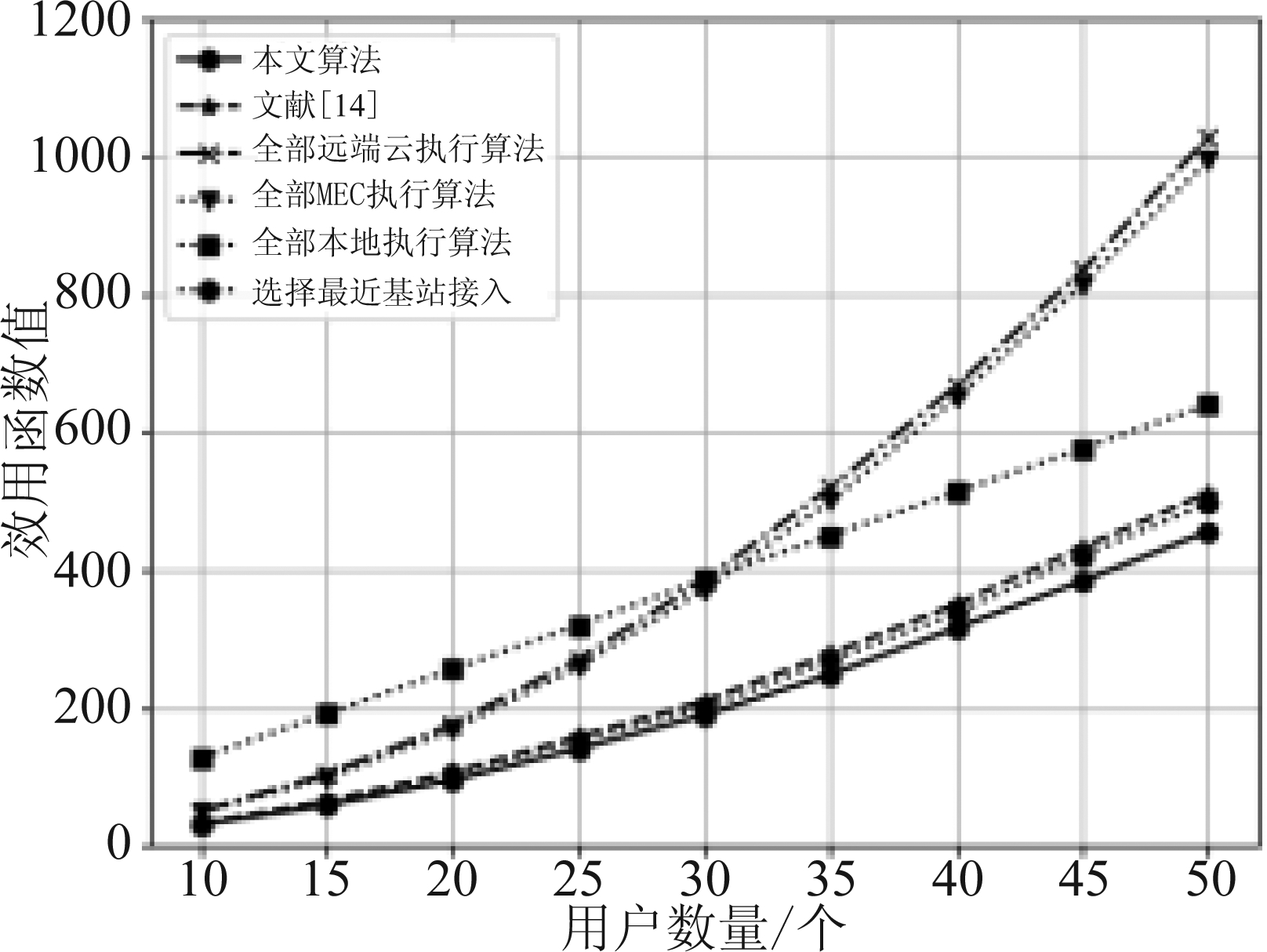

图2给出了6种算法的效用函数值随用户数变化的情况。由图中可以看出,本文所提出的算法要明显优于其他四种对比算法,随着用户数量的不断增加,对资源的需求就越来越高,本文提出的模型可以让多任务同时在不同的服务器进行计算,大大减小任务之间的计算等待时间,能够在通信资源与计算资源有限的情况下,有效的降低用户终端的效用函数值。在边缘计算资源有限的情况下,本文提出的算法可以在较低复杂度的前提下,对边缘服务器的计算资源进行一个合理的分配。

图2 不同策略下用户终端的效用函数值变化

Fig.2 Terminal values of utility function under different strategies

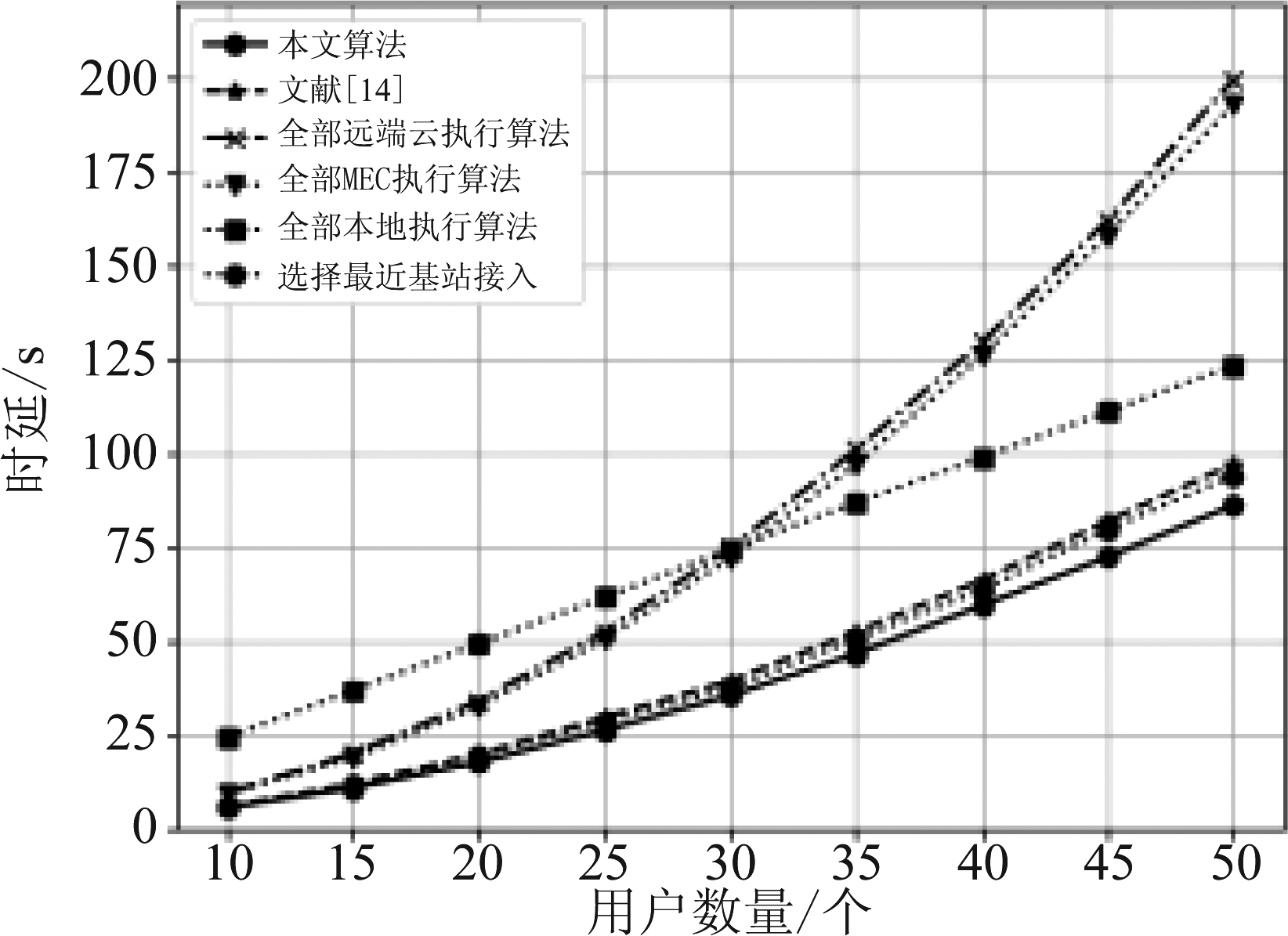

图3 不同策略下用户终端的总时延变化

Fig.3 Changes of total terminal delay under different strategies

图3给出了6种算法的时延随用户数变化的情况。随着用户数的增长,采用本文所提出的算法可以很好的优化系统的时延。可以发现当用户数较少时,用户之间的干扰较小,同时边缘服务器的服务模块数较为充足,采用卸载的方式能够有效的降低时延,但随着用户数量的增加,用户之间的干扰逐渐严重,卸载任务花费的时延成本也就更大。图4给出了6种算法的终端能耗随用户数变化的情况。由于本文提出系统函数是时延与能耗的共同优化,此时考虑的是时延敏感型任务,但是也可以明显看出,当用户数少的时候,用户之间的干扰较小并且MEC计算资源丰富,花费的能耗要优于本地执行能耗,随着用户数的增加,用户之间的干扰逐渐严重,卸载计算需要花费的传输能耗在增加,此时本文提出的算法优于完全卸载时花费的能耗。同时,由于卸载时只考虑将任务卸载到基站的能耗,因此卸载到MEC与远端云对于用户来说花费的能耗是相同的。

图4 不同策略下用户终端的总能耗变化

Fig.4 Changes of total energy consumption of terminals under different strategies

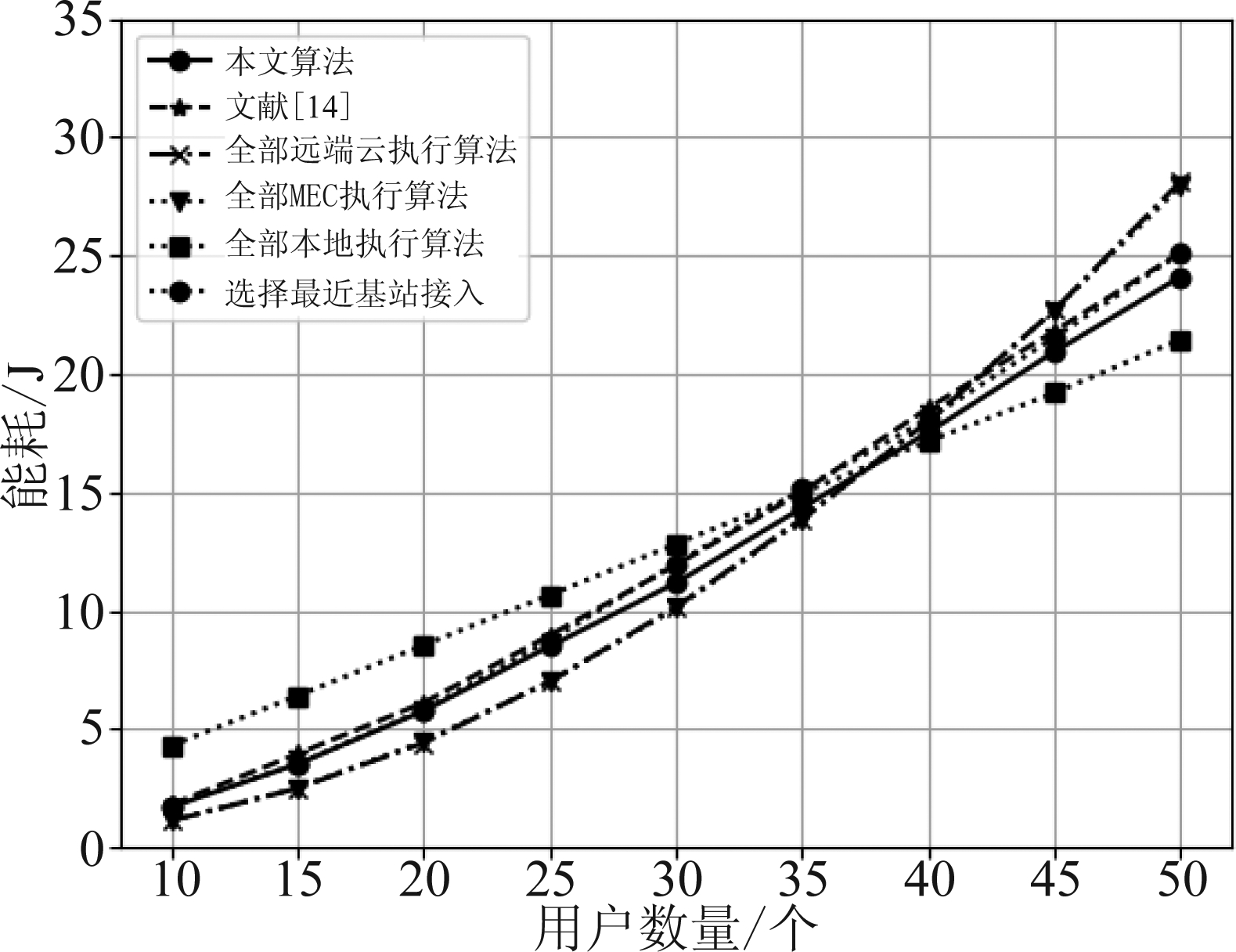

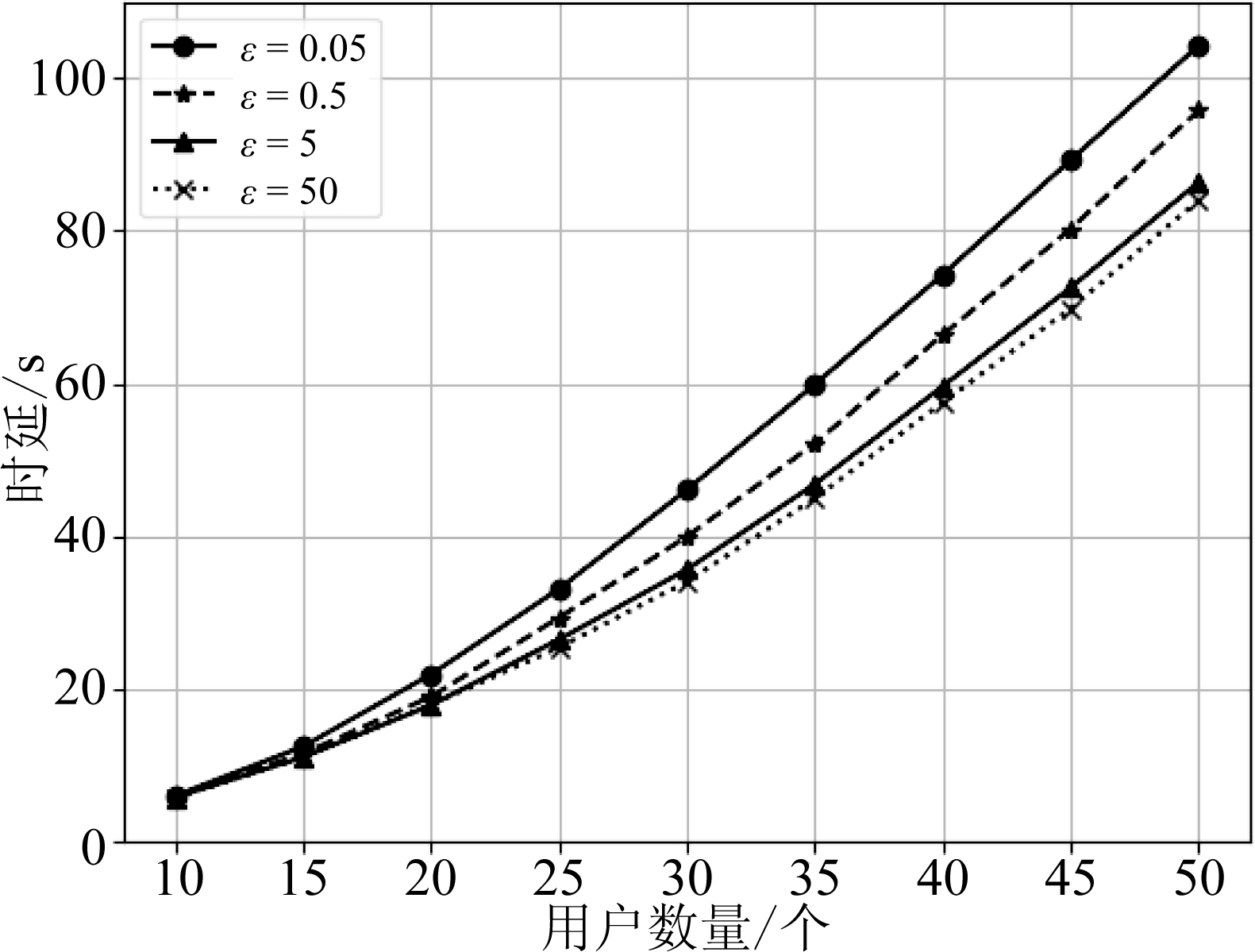

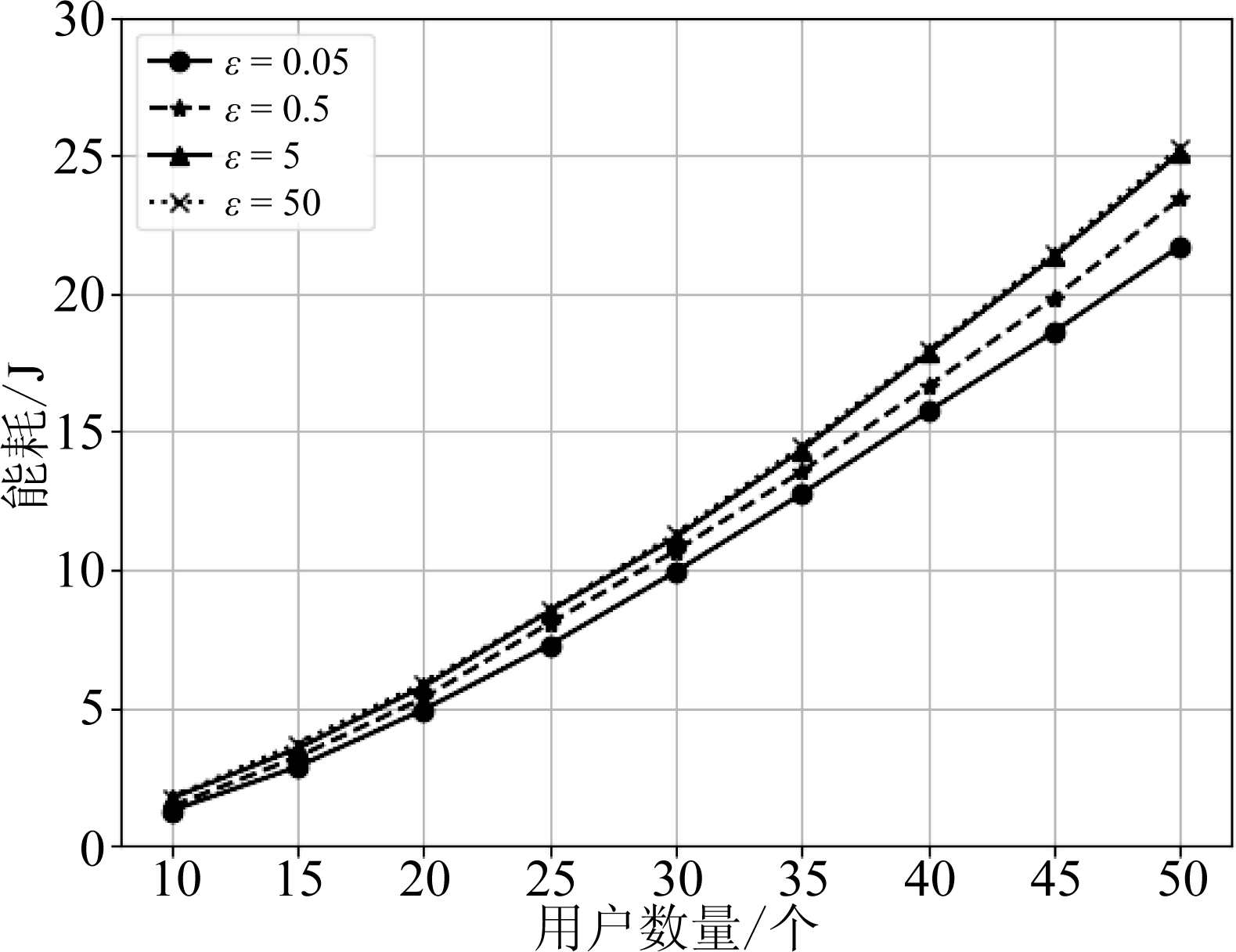

图5和图6对比分析了不同权重下的时延与能耗的花费情况,此时的MEC服务模块数保持不变,当ε=0.05时,此时任务类型为能耗敏感型任务,由图5可以发现用户的能耗对比其他情况花费更小,随着权值的不断增加,用户执行的任务类型慢慢的变为时延敏感型任务,当ε=5与ε=50时,任务对时延的要求更加严格,采用本文的算法则可以很好的满足这一时延要求。根据不同的任务类型要求,动态的改变卸载决策以满足时延与能耗的要求。

图5 不同权值下系统的总时延

Fig.5 Total delay of the system under different weights

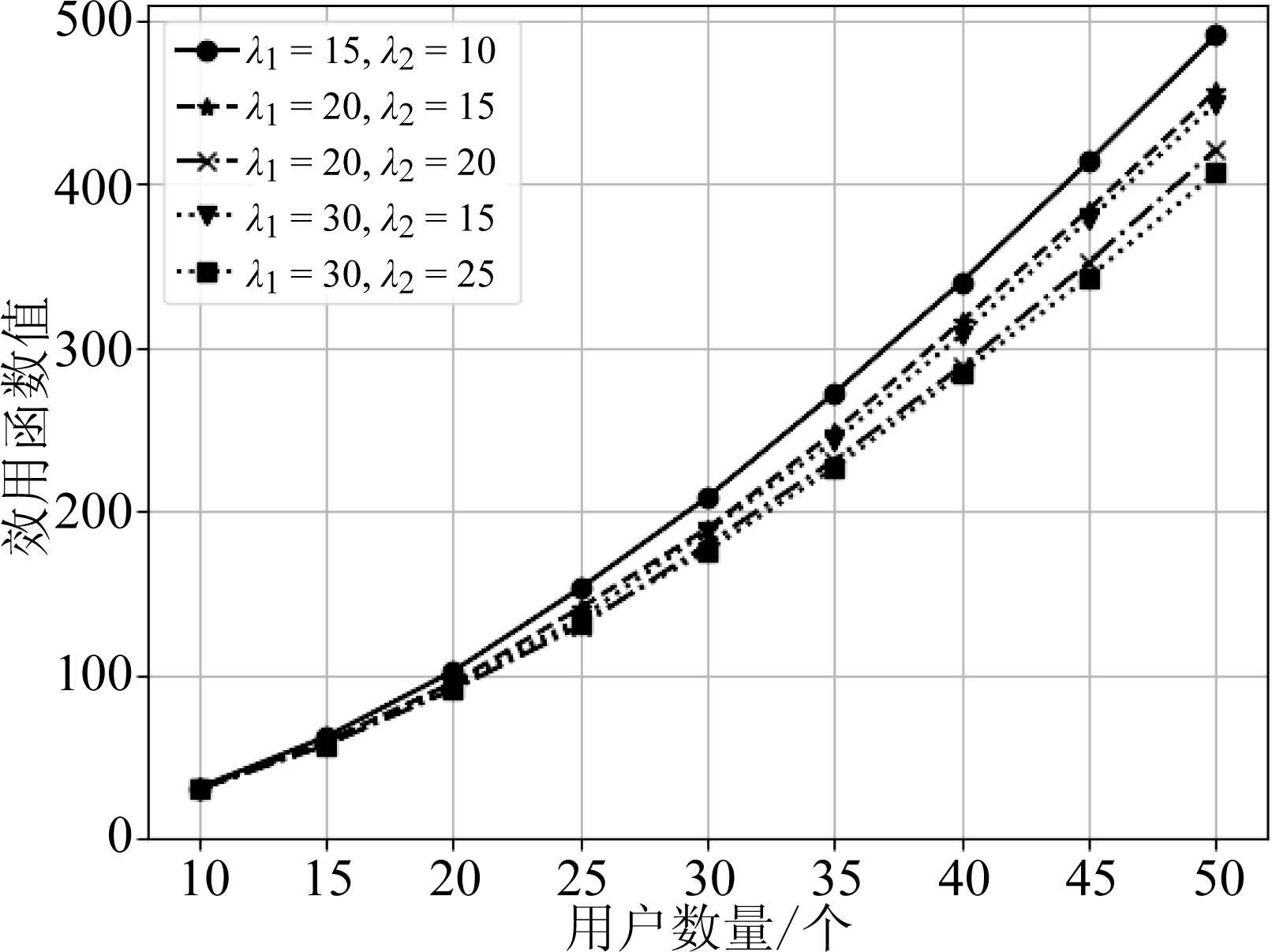

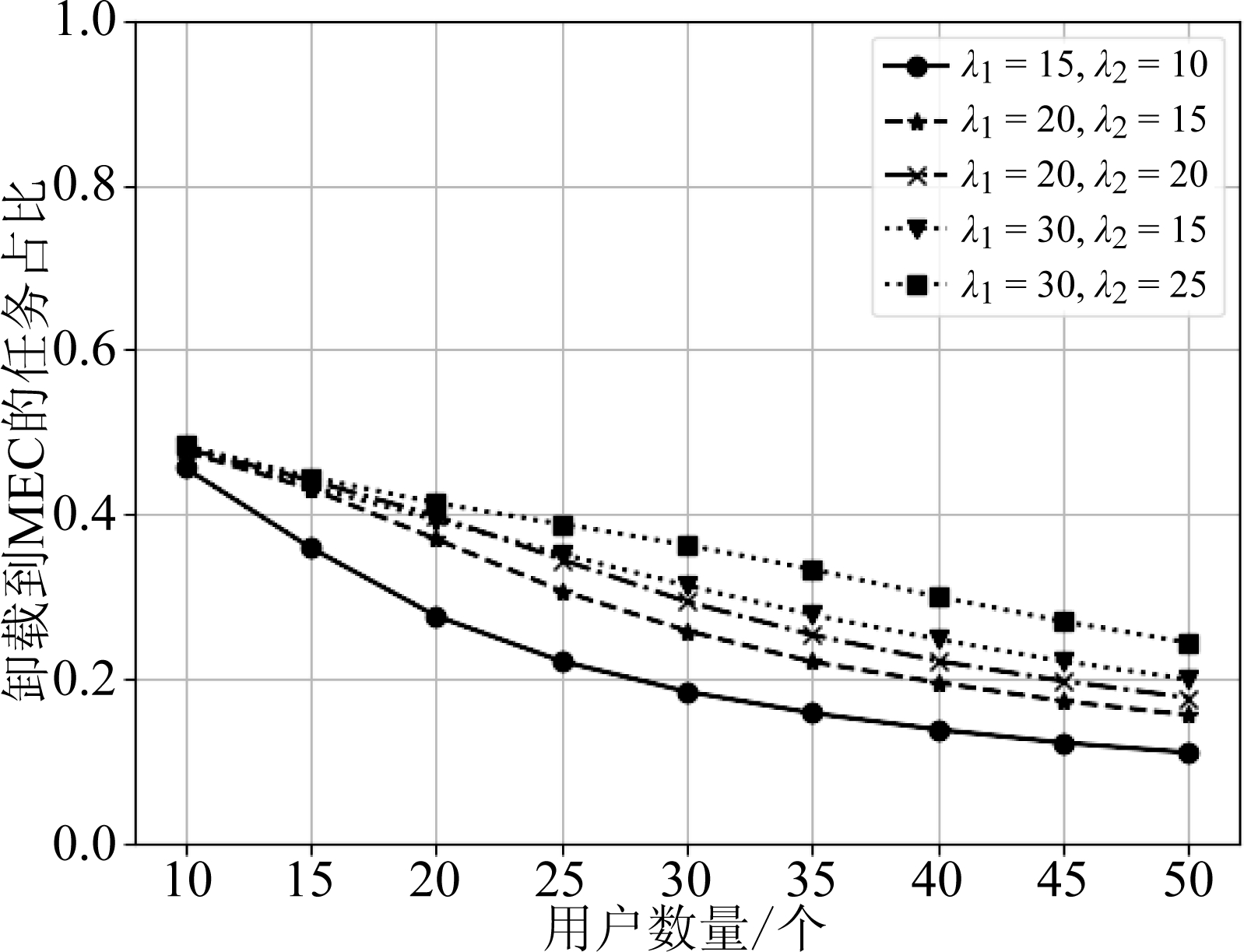

为了研究在云边混合场景下MEC服务模块数对于系统性能的影响,此时固定权值ε=5,改变不同基站下MEC服务模块的数量,对于不同λ1与λ2的取值,一方面反映了不同基站下MEC服务器的计算资源丰富度不一样,另一方面也反映了边缘云计算资源的丰富度。图7反映了不同MEC服务模块数量下的系统函数值的变化情况,随着边缘云的计算资源越来越丰富,在不同用户数下,系统函数值均在逐渐减小,特别是随着用户数的增加,对计算资源的要求越来越严格,此时增加MEC服务模块数能够有效的降低系统的效用值。图8反映了在不同服务模块数量下任务选择卸载到MEC执行的比例,可以发现,随着用户数的增加,需要执行的任务数也在逐渐增加,但是MEC的计算资源有限,当MEC计算资源达到饱和时,边缘服务器则不在接受任务卸载,所以随着用户数的增加,卸载到MEC的任务数的比例也在逐渐下降。纵向对比发现,MEC计算资源越丰富,卸载到MEC的任务比例也就越高。

图6 不同权值下系统的总能耗

Fig.6 Total energy consumption of the system under different weights

图7 不同服务模块数量下的系统效用值

Fig.7 System utility values for different number of service modules

图8 不同服务模块数量下卸载到MEC的任务数量占比

Fig.8 The proportion of tasks offloaded to MEC under different number of service modules

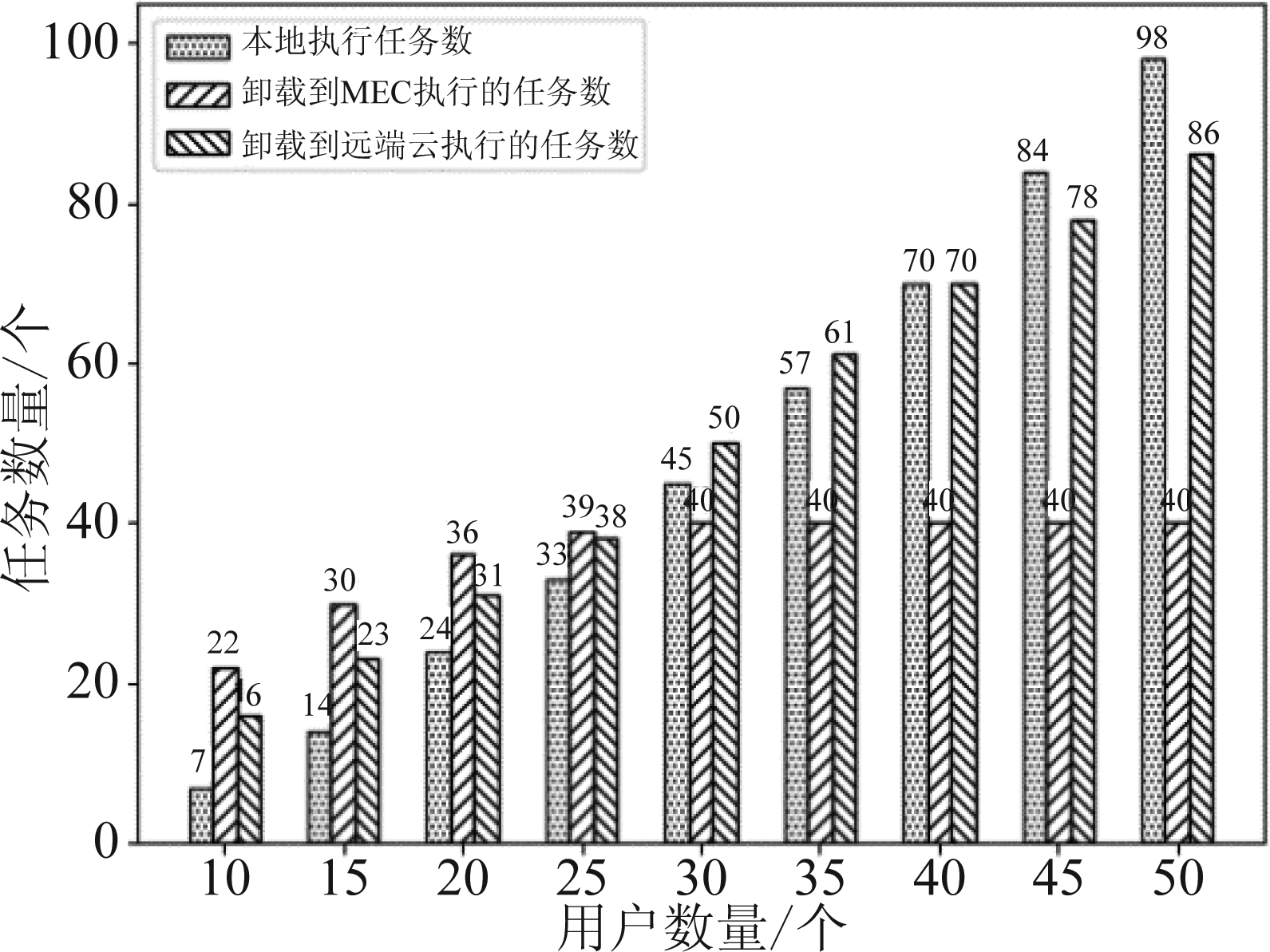

图9 任务在不同服务器执行的分布情况

Fig.9 The distribution of tasks executed on different servers

为了更进一步的研究具体任务决策的分配情况,本文分析了在权值ε=5,λ1=λ2=20的情况下,采用本文算法得到的卸载决策分布情况。从图9中可以发现,在用户数少的时候,MEC计算资源丰富,更多的任务选择卸载到MEC进行执行,但随着用户数量的增加,MEC计算资源变得匮乏,卸载到MEC的任务数被限制在40,其他的任务只能选择本地或者远端云执行。仔细观察可以发现,当用户数大于40的时候,选择本地执行的任务数已经超过了选择远端云卸载的任务数,这是因为在用户数量增多的同时,通信资源变得越来越匮乏,卸载到远端云的花费更高了。同时,仿真分析也发现,当用户数量在25到30左右的时候,两个基站的MEC总服务模块的数量刚好满足最优情况下计算资源的利用,重复多次可以发现,当MEC服务模块的数量大约是用户数量的1.5倍时,边缘服务器可以刚好满足任务卸载的需求。

最后分析一下用户面对不同基站的一个选择情况。用户对于基站的选择来自于两个方面的因素的影响,一方面是目标基站能够分配的计算资源值,另一方面则是与该基站之间的信道增益情况。对于基站的选择首先是连接到不同基站的一个信道增益情况,当连接到不同基站的信道增益相差不大的时候,此时不同基站下能够分配的计算资源则起着至关重要的作用。图10很好的反映了对于基站包含不同的MEC计算资源的情况下用户选择卸载的情况,虽然基站的选择受到初始用户位置分布的影响,但多组数据可以表明,计算资源丰富的基站明显选择的用户比例更高。

图10 不同服务模块数量下用户选择基站1接入的比例

Fig.10 Proportion of base station 1 access selected by users under different number of service modules

5 结论

在联合边缘云与远端云的一种分层网络架构下,本文讨论了多用户多任务场景下的用户任务调度以及MEC计算资源分配,同时还考虑了多基站覆盖下用户的基站选择问题。提出了以最小化用户端的时延与能耗为目标的优化问题,然后将多用户场景解耦为单用户多任务卸载场景,设计了基于乘子法的用户卸载决策机制。利用单用户下求解的卸载决策以及信道增益情况对多基站覆盖下的用户进行卸载目标基站选择。然后考虑到多用户场景下信道资源与计算资源的限制,提出了一种次优的迭代启发式算法对单用户场景下求得的解进行动态修正。得到的结果在系统性能方面优于局部卸载的算法,实验结果表明,不同的时延与能耗之间的权值会影响卸载决策,不同的MEC计算资源也会影响卸载决策。接下来将进一步考虑多用户多任务之间具有约束优先级场景下的计算卸载问题,讨论子任务之间具有约束场景下对于计算卸载的影响,降低系统的时延与能耗。

[1] SHI Weisong, CAO Jie, ZHANG Quan, et al. Edge computing: Vision and challenges[J]. IEEE Internet of Things Journal, 2016, 3(5): 637- 646.

[2] SU Zhou, XU Qichao, HOU Fen, et al. Edge caching for layered video contents in mobile social networks[J]. IEEE Transactions on Multimedia, 2017, 19(10): 2210-2221.

[3] PAN Jianli, MCELHANNON J. Future edge cloud and edge computing for Internet of Things applications[J]. IEEE Internet of Things Journal, 2018, 5(1): 439- 449.

[4] YANG Bin, MAO Guoqiang, DING Ming, et al. Dense small cell networks: From noise-limited to dense interference-limited[J]. IEEE Transactions on Vehicular Technology, 2018, 67(5): 4262- 4277.

[5] YANG Lichao, ZHANG Heli, LI Ming, et al. Mobile edge computing empowered energy efficient task offloading in 5G[J]. IEEE Transactions on Vehicular Technology, 2018, 67(7): 6398- 6409.

[6] MACH P, BECVAR Z. Mobile edge computing: A survey on architecture and computation offloading[J]. IEEE Communications Surveys & Tutorials, 2017, 19(3): 1628-1656.

[7] COSKUN C C, DAVASLIOGLU K, AYANOGLU E. Three-stage resource allocation algorithm for energy-efficient heterogeneous networks[J]. IEEE Transactions on Vehicular Technology, 2017, 66(8): 6942- 6957.

[8] PHAM Q V, LE Long bao, CHUNG S H, et al. Mobile edge computing with wireless backhaul: Joint task offloading and resource allocation[J]. IEEE Access, 2019, 7: 16444-16459.

[9] AHMAD A, PAUL A, KHAN M, et al. Energy efficient hierarchical resource management for mobile cloud computing[J]. IEEE Transactions on Sustainable Computing, 2017, 2(2): 100-112.

[10] BARBAROSSA S, SARDELLITTI S, DI LORENZO P. Joint allocation of computation and communication resources in multiuser mobile cloud computing[C]∥2013 IEEE 14th Workshop on Signal Processing Advances in Wireless Communications (SPAWC). Darmstadt, Germany. IEEE, 2013: 26-30.

[11] WANG Chenmeng, YU F R, LIANG Chengchao, et al. Joint computation offloading and interference management in wireless cellular networks with mobile edge computing[J]. IEEE Transactions on Vehicular Technology, 2017, 66(8): 7432-7445.

[12] LI Qiuping, ZHAO Junhui, GONG Yi. Cooperative computation offloading and resource allocation for mobile edge computing[C]∥2019 IEEE International Conference on Communications Workshops (ICC Workshops). Shanghai, China. IEEE, 2019: 1- 6.

[13] PAN Shengli, ZHANG Zhiyong, ZHANG Zongwang, et al. Dependency-aware computation offloading in mobile edge computing: A reinforcement learning approach[J]. IEEE Access, 2019, 7: 134742-134753.

[14] NING Zhaolong, DONG Peiran, KONG Xiangjie, et al. A cooperative partial computation offloading scheme for mobile edge computing enabled Internet of Things[J]. IEEE Internet of Things Journal, 2019, 6(3): 4804- 4814.

[15] GUO Hongzhi, LIU Jiajia. Collaborative computation offloading for multiaccess edge computing over fiber-wireless networks[J]. IEEE Transactions on Vehicular Technology, 2018, 67(5): 4514- 4526.

[16] RANJI R, MANSOOR A M, SANI A A. EEDOS: an energy-efficient and delay-aware offloading scheme based on device to device collaboration in mobile edge computing[J]. Telecommunication Systems, 2020, 73(2): 171-182.

[17] GUO Jun, ZHANG Heli, YANG Lichao, et al. Decentralized computation offloading in mobile edge computing empowered small-cell networks[C]∥2017 IEEE Globecom Workshops (GC Wkshps). Singapore. IEEE, 2017: 1- 6.

[18] BI Suzhi, ZHANG Yingjun. Computation rate maximization for wireless powered mobile-edge computing with binary computation offloading[J]. IEEE Transactions on Wireless Communications, 2018, 17(6): 4177- 4190.