1 引言

情感识别有助于快速传达信息并理解别人的真实意图,是人机交互的关键[1]。在情感表示模型方面,主要分为离散表示模型[2]和维度表示模型[3],离散表示模型将人类的情感划分为几种常见的情感,来反映人的基本情绪,而维度情感表示模型使用维度空间中的连续数值来描述情感状态,每个情感状态对应二维空间中的一个点[4],坐标系横轴arousal代表激活度,表示情感的激昂与低迷程度,值越大表示情感越激昂,值越小表示情感越低迷;坐标轴valence代表愉悦度,表示情感的积极与消极程度,值越大表示情感积极程度越高,值越小表示情感消极程度越高。维度情感识别模型能够更为有效的反映交互对象的心理细微波动,对于增强交互的自然度有着重要作用,同时维度情感表示识别模型在提高情感识别的准确性和鲁棒性中也起着重要的作用。因此本文以维度情感表示模型为研究基础。

目前基于单模态的情感识别已经取得了一定的进展,Wang等人[5]利用双向递归神经网络(Bi-RNN)对视频特征进行情感学习,但是情感是由多种模态综合表现出来的,各个模态之间也具有一定的关联,同时不同模态对于情感结果的贡献程度也不尽相同[6]。通常来说,多模态情感识别的性能要优于单模态情感识别性能,而目前主要的多模态情感融合方法是特征层融合和决策层融合。

特征层融合方法需要分别从多种模态信息中提取特征,构建用于识别情感的联合特征,对各模态有较高的同步要求。Chaparro等人[7]提出基于脑电图等生理信号的多模态情感识别模型,在特征层串联融合面部表情特征和心电信号特征构成多模态特征,实验表明,多模态特征的识别率高于一种模态特征的识别率。Xu等人[8]利用注意力机制对语音和音频文本在特征层进行融合,在交互式情绪二元运动捕捉(IEMOCAP)数据集上取得了最好的性能。在国际音视频情感识别竞赛(audio/visual emotion challenge, AVEC2017)中,Singh等人[9]利用传统的视频纹理特征和openXBOW提取的音频词袋特征集(bag-of-audio-words, BoAW)进行特征层融合的情感识别。Basnet等人[10]通过基于交互信息选择的音视频特征层融合构建情感预测模型。Aven等人[11]对音频、视频和文本特征进行特征层融合对抑郁症相关的情感状态构建情感识别模型。特征层只是对各个模态的情感特征进行简单拼接,并没有考虑到模态之间的信息交互。决策层融合方法考虑不同模态信息对于情感识别贡献度不同,大多数多模态融合情感识别方法采用决策层融合。Poria等人[12]利用等权重原理,在决策层加权融合音频、视频和文本的分类结果,此时等价于无加权融合。Sebastian等人[13]在特征层上对语音和音频文本进行前期特征层融合,然后输入到网络中再与经过长短时记忆网络(Long Short Term Memory, LSTM)的文本特征结果进行决策层的后期融合。Huang等人[14]基于LSTM的决策层情感识别在AVEC2017中取得了不错的成绩,之后又提出了端到端情感识别模型[15]。Chen等人[16]基于LSTM-RNN模型提出多任务学习的多模态情感识别方法。决策层融合虽然解决了不同模态之间的时序不同步问题,但是没有考虑到不同模态的情感特征信息的关联。

本文针对以上问题,提出基于多头注意力机制的模型层融合维度情感识别方法,模型层融合既解决了不同模态时序不同步的问题,同时考虑了不同模态的情感特征信息之间的关联性。在模型层融合部分,本文利用多头注意力机制构建模型层融合模块,分别将音视频信息放入模块中进行高层维度的时序动态情感特征学习,再将其放入融合模块中进行模型层的时序动态情感特征学习,最后用双向长短时记忆网络(Bi-directional Long Short Term Memory, BLSTM)和线性变换,得到最终情感预测值。因为维度情感数据库较小,为了解决这个的问题,本文对原始数据库进行了数据增广,然后提取音频和视频的情感特征信息。文中比较了使用相同数据库的研究人员识别方法,模型层融合方法在激活度和愉悦度上均取得了最佳的性能。实验结果表明,基于模型层的音视频维度情感识别中,可以在高层维度对情感信息有效捕捉,进而更好的对音视频信息进行有效融合。

本文在第一部分中对情感识别相关研究现状和研究内容进行了介绍,在第二部分中介绍了本文提出的基于多头注意力机制的模型层融合维度情感识别方法,在第三部分中介绍了实验结果和分析,最后在第四部分中对实验做了总结和展望。

2 基于多头注意力机制的模型层融合维度情感识别

本文所提的基于多头注意力机制的模型层融合维度情感识别方法整体框架如图1所示。基于音视频数据进行维度情感识别建模,主要包括音频模块、视频模块和音视频融合模块,音频和视频模块通过自注意力机制学习各自单模态的情感时序信息,而音视频融合模块在模型层实现音视频信息的交互。整个模型是将音频模块和视频模块的高层输出转换到相同的情感语义特征空间中,然后通过音视频融合模块生成有效的情感表征,最后通过一个线性变换层输出情感预测值。具体来说,就是对原始数据进行数据增广和标签延迟优化之后,选取在长短时序列上表征较好的音视频情感特征,本文选取音频特征包括BoAW和2010届国际语音会议特征集(Interspeech 2010, IS2010)和视频特征包括视频词袋特征集(bag-of-video-words, BoVW)和人脸超分辨率序列特征集(Visual Geometry Group Face, VGGFace)作为情感特征[14]。特征提取之后把音视频情感特征进行线性变换,放入到多头注意力模型中,经过多头注意力模型的数据信息与原始情感特征进行求和与归一化,得到的数据信息再分别进行一维卷积学习情感时序信息,最后将其与上一步的数据信息一起进行求和与归一化,这样音视频的情感特征处理完毕。再将其放入到多模态融合模块,利用多头注意力机制根据音频和视频数据帧之间的相关性确定时序对齐分数,最后输出的数据信息经过BLSTM模型之后,线性变换得到最终的情感预测值。

2.1 双向长短时记忆网络

情感状态随着时间动态变化,尽管传统的LSTM[17]可以有效的学习时间序列中的动态情感信息,但是该模型只能基于先前的信息和当前的信息来预测情感,而不能使用后续的信息。为了更充分的利用上下文信息,本文使用BLSTM模型对不同形式的信息进行特征学习,以更好地预测维度情感信息。在BLSTM的某个时刻,可以对当前时间节点的前后信息进行学习。本文中的系统框架最后使用BLSTM网络来训练维度情感回归模型。下面给出了时间步长t时BLSTM的公式:

(1)

(2)

(3)

其中,uf,ub,wf,wb,vf,vb分别对应于前向传播和后向传播的权重向量,![]() 分别表示在时间t时刻隐藏层的前向传播和后向传播,yt是节点在时间t时刻的输出向量,bf,bb,bf表示相应的偏移量。

分别表示在时间t时刻隐藏层的前向传播和后向传播,yt是节点在时间t时刻的输出向量,bf,bb,bf表示相应的偏移量。

图1 基于多头注意力机制的模型层融合维度情感识别系统框架

Fig.1 A framework of model level fusion dimension emotion recognition based on Transformer

2.2 多头注意力机制

注意力机制(Attention)的核心是借鉴人脑在特定时间对于某一种事物的注意力关注,大脑集中在该事物的某一焦点位置,而忽略事物的其他位置。在本文中,利用多头注意力机制基于自注意力模块提取更具表现力的序列表示,并联合多个注意力表征进行情感建模。多头注意力模型扩展了传统的注意力机制,具有多个头部,而且每个头部都可以产生不同的注意力分布。这样可以有效的学习音视频信息中的长时依赖性,通过位置对计算不同位置之间的关系,可以在较长时间跨度上学习时序依赖性,而且只需计算一次即可得到变换后的表示。在本实验中,注意力机制首先分别线性变换查询Q(query)、键K(key)、值V(value)三个输入,然后计算h次放缩点积注意力(scaled dot-product attention)。每个放缩点积注意力是单独计算的,最终组合其所有的输出到另一个线性层获得最终结果,如公式(4)、(5)所示。

MultiHead(Q,K,V)=concat(head1,…,headm)Wo

(4)

(5)

其中,参数矩阵![]()

2.3 评价指标

维度情感的性能的评价标准是一个不断探索的问题,早期的文献一般采用均方误差(Root Mean square err, RMSE)来度量估计的性能。设![]() 是估计的标签,θ是真实的标签,n是样本数目,

是估计的标签,θ是真实的标签,n是样本数目,![]() 分别是

分别是![]() 和θ的方差,

和θ的方差,![]() 分别是

分别是![]() 和θ的期望,则RMSE的定义为:

和θ的期望,则RMSE的定义为:

(6)

RMSE描述了预测与真值的偏差,但RMSE对于异常值敏感,且无法对θ和![]() 的相对变化趋势进行描述,因此不能很好地描述与真值的吻合度。鉴于RMSE的确定皮尔逊系数(Pearson correlation coefficient,PCC)被用来作为维度情感预测的评价指标,其定义为:

的相对变化趋势进行描述,因此不能很好地描述与真值的吻合度。鉴于RMSE的确定皮尔逊系数(Pearson correlation coefficient,PCC)被用来作为维度情感预测的评价指标,其定义为:

(7)

PCC的取值范围是[-1,1],它反映了预测与真值具有线性关系的紧密程度。PCC能够很好地反映预测与真值的协同变化关系。但是,由于PCC对预测的幅值不敏感,无法对θ和![]() 的偏差进行度量,因此仍不能很好地描述与真值的吻合程度。为了更好地描述预测与真值的吻合程度,一致性相关系数(Concordance correlation coefficient, CCC)作为预测性能的评价指标,其定义为:

的偏差进行度量,因此仍不能很好地描述与真值的吻合程度。为了更好地描述预测与真值的吻合程度,一致性相关系数(Concordance correlation coefficient, CCC)作为预测性能的评价指标,其定义为:

(8)

CCC结合了PCC与RMSE的优点,既反应了预测与真值的协同变化关系又反应了预测与真值的吻合程度,是目前广泛使用的维度情感预测性能评价指标,所以本文实验均以CCC为最终评价标准。

2.4 数据增广

为了解决维度情感数据集的数据量较小,在情感识别模型训练过程中会出现过拟合的问题,本文提出了针对多模态数据集的数据增广方法,具体如下:

(1)音频数据:对数据集进行数据预处理之后,对每个数据集中的视频以音频为主进行数据分段,在这个过程中,分段的大小和不同识别模型进行学习的性能会有所差异,经过多次探索,数据段大小为6 s的时候使用本文提出的模型,识别性能最好,同时记录分段时间戳。

(2)视频数据:根据音频的分段时间戳,对视频进行分段,因为数据集的视频规格为50帧/秒,所以分段之后的视频信息为每段300帧。

(3)数据段:按照时间戳对数据进行分段之后,每个原始视频都会得到多个数据段,再将数据段用于相应的情感特征提取。

2.5 标签延迟

对于数据集的情感标签来说,不同的标注人员在标注时会有不同的反应时间,而且某一时刻标注的情感状态会受到前面音视频数据的影响,从而导致情感标签和真实的情感状态会有不同程度的偏差。因此,本文首先对数据集的情感标签进行延迟优化实验。

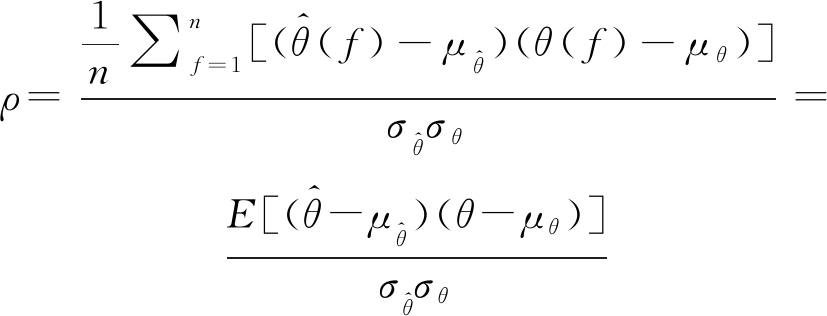

如表1所示,首先对音频特征(BoAW和IS2010)进行0.0 s~3.0 s的标签延迟实验(标签延迟步长为0.2 s)。BoAW特征在3.0 s标签延迟下的CCC性能达到最大,分别为0.461和0.486。IS2010特征的激活度和愉悦度在2.8 s标签延迟下的CCC性能达到最大,分别为0.371和0.388。然后对视频特征(BoVW和VGGFace)进行0.0 s~3.0 s的标签延迟实验。BoVW特征的激活度在1.2 s标签延迟下的CCC性能达到最大,为0.537。愉悦度在1.8 s标签延迟下的CCC性能达到最大,为0.542。VGGFace特征的激活度在2.2 s标签延迟下的CCC性能达到最大,为0.513。愉悦度在1.6 s标签延迟下的CCC性能达到最大,为0.480。音频特征和视频特征的激活度、愉悦度的最佳标签延迟都比较接近,说明所选择的情感特征在维度情感识别上都较为稳定[14]。

表1 不同特征标签延迟的CCC

Tab.1 CCC with different feature annotation delays

BoAWIS2010BoVWVGGFace激活度愉悦度激活度愉悦度激活度愉悦度激活度愉悦度0.00.3140.4090.3320.3560.4710.4990.4580.4760.20.2890.3470.3380.3520.4800.5040.4570.4790.40.2770.3400.3310.3540.4920.5090.4620.4830.60.3200.3310.3180.3350.5010.5120.4690.4860.80.3240.3280.3140.3300.5210.5130.4730.4881.00.3440.3680.3050.3270.5200.5220.4770.4531.20.3580.3760.3030.3220.5370.5290.4830.4621.40.3720.3690.2920.3180.5270.5330.4860.4651.60.3910.4080.2780.3200.5100.5380.4900.4801.80.4100.4360.3220.3380.4910.5420.5200.4762.00.4240.4470.3470.3520.4730.5400.5100.4712.20.4320.4570.3420.3590.4610.5370.5130.4692.40.4410.4850.3600.3670.4610.5380.5070.4672.60.4510.4820.3660.3750.4580.5320.4990.4622.80.4590.4840.3710.3880.4520.5300.4870.4523.00.4610.4860.3680.3700.4470.5270.4880.450

3 实验结果与分析

3.1 数据集介绍

本文中使用AVEC2017数据集上的多态维情感数据集进行相关实验。AVEC2017数据集使用的语料库是SEW A数据集的子集[18]。该数据集是由对象的自然行为组成的音频和视频数据集。使用网络摄像头和麦克风在受试者家中的计算机上收集所有数据。对象的年龄在18至60岁之间,并且每个记录中只有一个人的数据。因此,实验数据减少了对音频情感标签的干扰。在数据集的注释过程中,注释者根据激活和效价两种情感维度对生活,工作或其他讨论内容进行注释。整个注释过程由6位注释者(3位女性,3位男性)进行,他们年龄在20~24岁之间,并且会说德语,每隔0.1 s进行一次标签注释。在该实验中,共有48个音频和48个对应的视频,每个视频的录制时间范围从46秒到3分钟不等,为了使实验结果更加准确,在实验开始前,对数据集进行了三种分类方式,分别记作标签1、标签2和标签3,每种标签选择音视频的根据完全随机,然后根据每种标签的不同分类做了3次实验,其中每种标签的34个音频和视频用作训练集,7个音频和视频用作验证集,另外7个音视和视频用作测试集。

3.2 参数设置

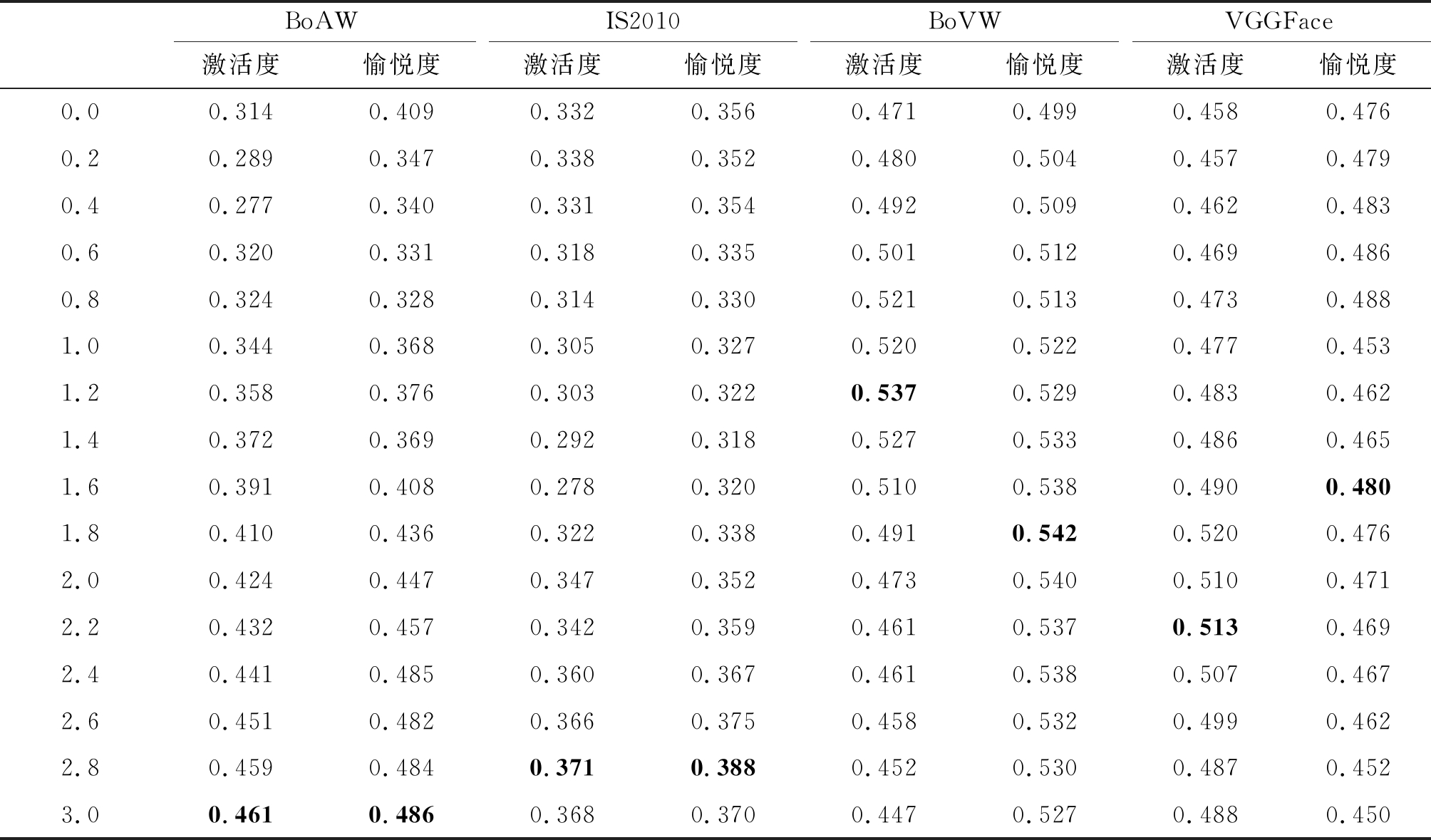

基于音视频的模型层融合实验中由两个四头注意力层组成,并且每两个注意力层有一个残差连接和层归一化,注意力的隐藏节点数和一维时序层的输出节点数均为64。BLSTM中的层数设置为3,卷积核均为3×3×3,隐藏层对不同的输入节点特征信息进行了优化。使用的优化器是Adam,损失函数使用crossentropyloss,学习率初始化为0.01,每40个周期减少一半,最大迭代次数为200,样本批次大小为128。如图2所示为三种融合方法的epochs和CCC性能的可视化结果,从中可以看出模型层融合的稳定性和CCC性能都要比其他两种模型要好。

图2 三种融合方法的迭代次数和CCC性能可视化结果

Fig.2 Visualization of epochs and CCC of three fusion methods

3.3 实验结果与分析

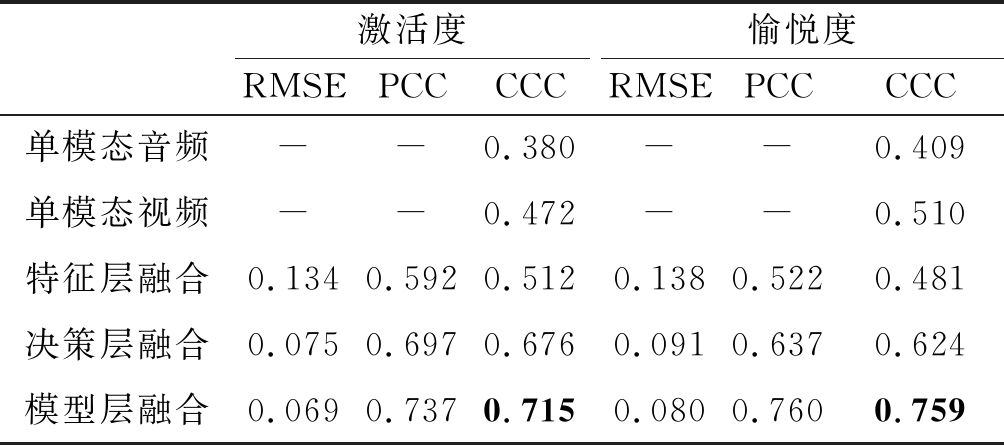

如表2所示,本文首先使用BLSTM模型对音频和视频进行了单模态情感识别,在BLSTM模型中,IS2010作为短时音频特征、BoAW作为长时音频特征在长短时记忆网络中学习效果较好。在视频特征中,深度学习网络的特征提取,可以对视频的时空信息进行有效建模,尤其是VGGFace网络相比于其他深度学习网络更适合用于情感特征提取,特别是对于短时的情感识别模型中,而基于openXBOW的BoVW特征集,适合在长时的情感识别建模中使用。结果显示,视频在激活度和愉悦度上的CCC性能都要比音频高,音频情感信息相比于视频情感信息较弱,验证了视频情感特征的性能强于音频情感特征的性能[9]。

本文进一步使用BLSTM模型分别进行了基于特征层融合和决策层融合的维度情感识别实验。特征层融合在激活度上比单模态维度情感识别更有效,为0.512,它的主要的优势在于基于深度学习的情感特征可以更好的进行学习,但是在实验结果中,愉悦度上的CCC性能并没有提升,这是由于特征层融合使得不同模态信号之间的相互作用很难在不同时间从不同但耦合的模态中提取有效的情感特征。此外实验过程中过多的维度使得实验性能下降,也印证了特征层融合面临着不同模态之间同步的问题,容易出现维度灾难的问题。决策层融合在激活度和愉悦度上的CCC性能都要高于特征层融合,分别为0.676和0.624,性能提升很大,它主要是利用了不同模态的情感识别高层表征,对最终情感进行了非线性决策,但是在实验结果中,不同的模态组合的性能相差较大,支配度上的性能提升也并不明显,这主要是因为决策层融合需要多模态信息流的同步,而且没有考虑到不同模态情感特征信息的关联。

表2 单模态和三种多模态融合方法的实验结果

Tab.2 Experiment result of single-model and three multi-model fusion methods

激活度RMSEPCCCCC愉悦度RMSEPCCCCC单模态音频--0.380--0.409单模态视频--0.472--0.510特征层融合0.1340.5920.5120.1380.5220.481决策层融合0.0750.6970.6760.0910.6370.624模型层融合0.0690.7370.7150.0800.7600.759

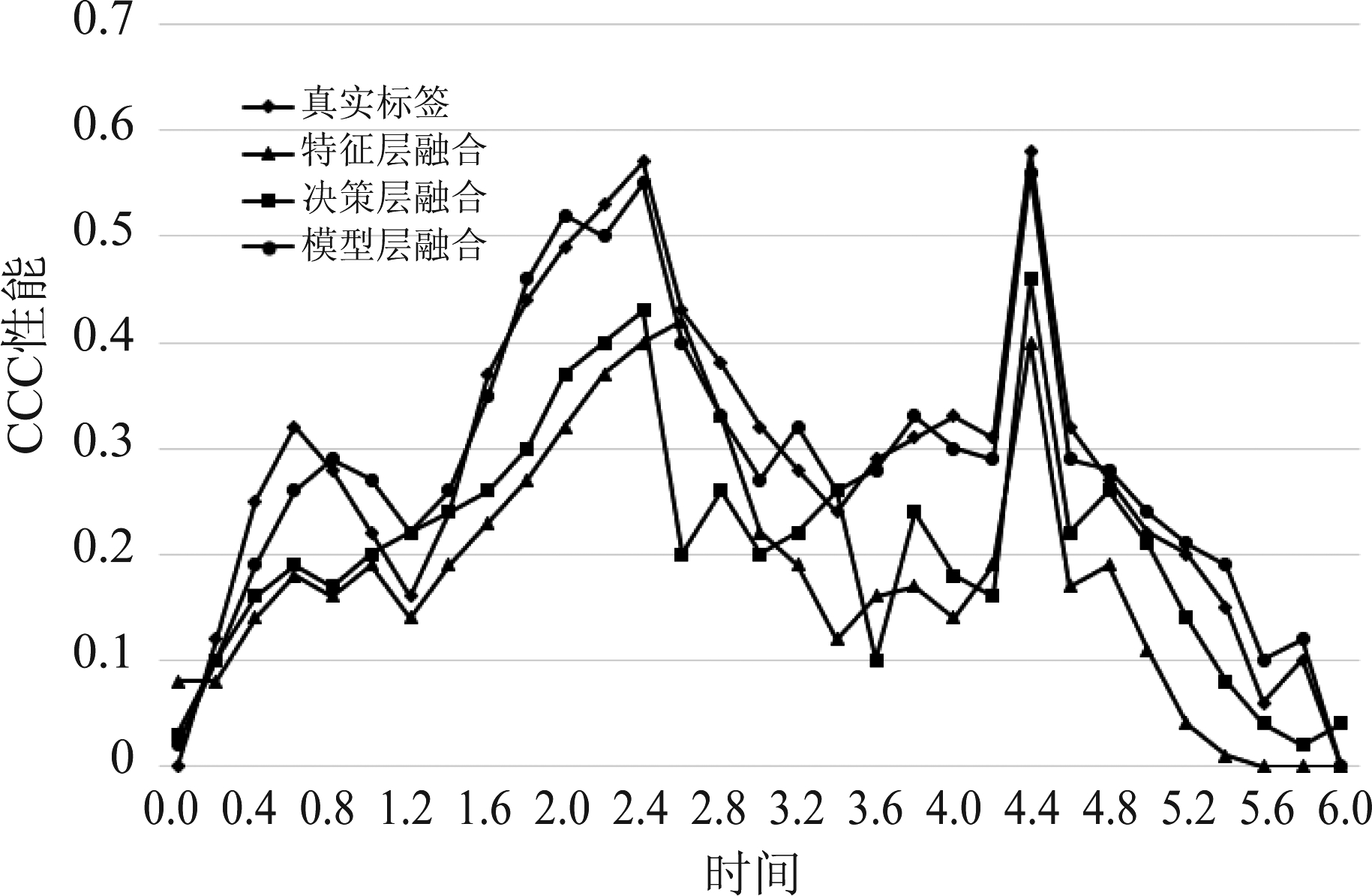

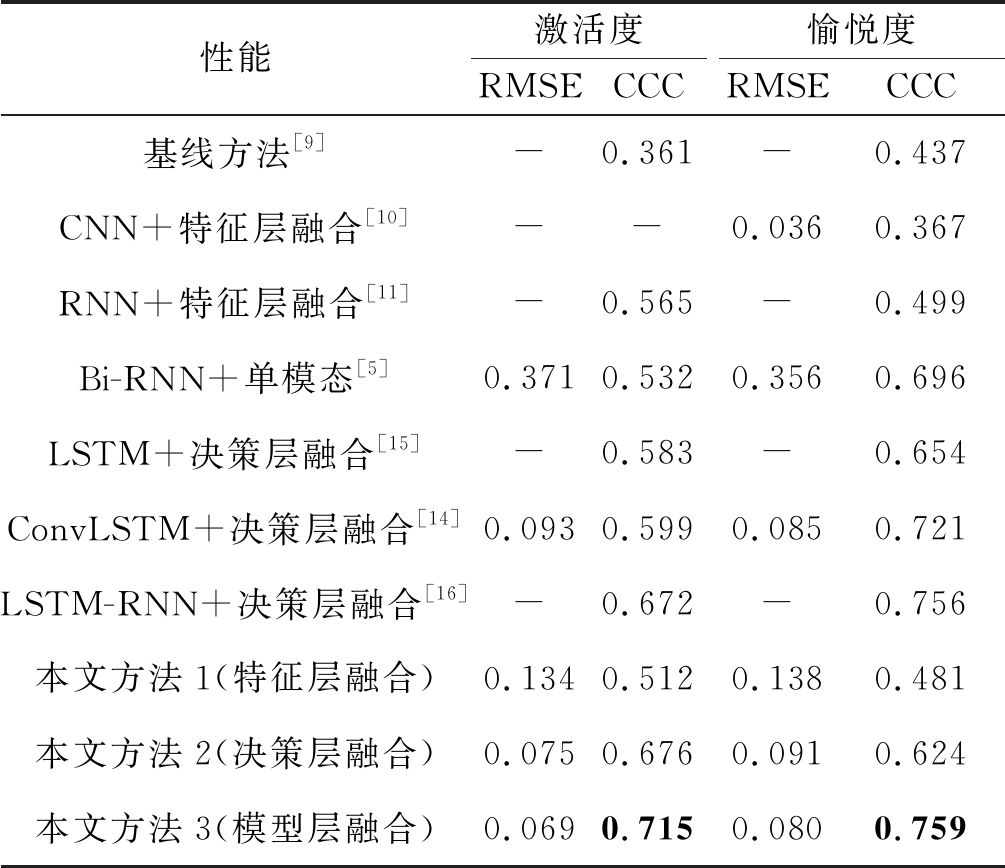

模型层融合的CCC性能在激活度和愉悦度上的结果比特征层融合和决策层融合的结果都要好,分别为0.715和0.759。结果表明,模型层融合进一步解决了多模态信息流的同步和不同模态情感特征信息关联的问题,因此模型层融合使视频模态可以更好的接收音频模态的情感信息,并实现了音视频的有效融合。如图3所示为实验过程中单个样本的三种融合方法情感预测值和真实值的可视化结果,模型层融合的预测值与真实值较为吻合,也证明了模型层融合方法相对于特征层和决策层来说,在CCC性能上表现更好。最后,本文比较了使用相同数据集的研究人员的方法,如表3所示,本文提出的模型层融合方法在激活度和愉悦度上表现最佳。这表明多头注意力机制可以有效的生成情感特征表征,进一步使得BLSTM模型可以更好地进行维度情感识别建模。

图3 三种融合方法的情感预测值和真实值可视化结果

Fig.3 Visualization of sentiment prediction and true value of three fusion methods

表3 实验结果和其他论文方法比较

Tab.3 Comparison of our experiment with other paper methods

性能激活度RMSECCC愉悦度RMSECCC基线方法[9]-0.361-0.437CNN+特征层融合[10]--0.0360.367RNN+特征层融合[11]-0.565-0.499Bi-RNN+单模态[5]0.3710.5320.3560.696LSTM+决策层融合[15]-0.583-0.654ConvLSTM+决策层融合[14]0.0930.5990.0850.721LSTM-RNN+决策层融合[16]-0.672-0.756本文方法1(特征层融合)0.1340.5120.1380.481本文方法2(决策层融合)0.0750.6760.0910.624本文方法3(模型层融合)0.0690.7150.0800.759

4 结论

本文在基于BLSTM模型的特征层和决策层融合维度情感识别实验的基础上,通过借鉴注意力机制模型,构建了基于多头注意力机制的模型层融合维度情感识别模型,并进行了基于音视频的模型层融合实验,本文提出的基于多头注意力机制的模型层融和维度情感识别方法在激活度上的CCC性能表现较为突出,比第二名高出了6.40%,说明了在维度情感识别领域,模型层融合对于情感的兴奋水平识别较为明显,而在愉悦度上的CCC性能仅比基线方法高出了0.40%,说明在模型层融合中,对于情感的正负状态识别性能略低,这主要是由于对立情感在维度上的表现相近造成的,比如高兴和悲伤,两种情感的维度绝对值都较为相近。但是本文的方法在激活度和愉悦度上都表现出了最好的性能,说明本文所提方法可以融合模型中的高层输出使得音频和视频信息有效融合,进一步提高情感识别的CCC性能。多模态情感融合目前常用方法是模型层融合,但是模型层融合在性能和鲁棒性方面还存在一些问题。因此,考虑缺失信息的多模态模型层的情感融合将是下一步的研究重点之一。

[1] TAO Jianhua, TAN Tieniu. Affective computing: A review[J]. Affective Computing and Intelligent Interaction. Berlin, Heidelberg: Springer Berlin Heidelberg, 2005: 981-995.

[2] ANTONETTI P, VALOR C. A theorisation of discrete emotion spillovers: an empirical test for anger[J]. Journal of Marketing Management, 2020(1):1-27.

[3] LIU Meng, INCE R A A, CHEN Chaona, et al. Emotion categories are represented by a 2-dimensional valence-arousal space[J]. Journal of Vision, 2020, 20(11): 1224.

[4] COWIE R, DOUGLAS-COWIE E, TSAPATSOULIS N, et al. Emotion recognition in human-computer interaction[J]. IEEE Signal Processing Magazine, 2001, 18(1): 32- 80.

[5] WANG Xiaohua, PENG Muzi, PAN Lijuan, et al. Two-level attention with two-stage multi-task learning for facial emotion recognition[J]. Vis Commun Image R, 2019: 217-225.

[6] CHEN L, WU Min, PEDRYCZ W, et al. Emotion recognition and understanding for emotional human-robot interaction systems[M]. Cham: Springer International Publishing, 2021.

[7] KWAK Y, KONG K, SONG W J, et al. Multilevel feature fusion with 3D convolutional neural network for EEG-based workload estimation[J]. IEEE Access, 2020, 8: 16009-16021.

[8] XU Haiyang, ZHANG Hui, HAN Kun, et al. Learning alignment for multimodal emotion recognition from speech[C]∥Interspeech 2019. ISCA: ISCA, 2019: 3569-3573.

[9] SINGH N, DHALL A. Continuous Multimodal Emotion Recognition Approach for AVEC 2017[J]. ArXiv Preprint ArXiv:1709.05861, 2017.

[10]BASNET R, ISLAM M T, HOWLADER T, et al. Statistical selection of CNN-based audiovisual features for instantaneous estimation of human emotional states[C]∥2017 International Conference on New Trends in Computing Sciences (ICTCS). Amman. IEEE, 2017: 50-54.

[11]SAMAREH A, JIN Yan, WANG Zhangyang, et al. Detect depression from communication: How computer vision, signal processing, and sentiment analysis join forces[J]. IISE Transactions on Healthcare Systems Engineering, 2018, 8(3): 196-208.

[12]PORIA S, CAMBRIA E, HOWARD N, et al. Fusing audio, visual and textual clues for sentiment analysis from multimodal content[J]. Neurocomputing, 2016, 174: 50-59.

[13]SEBASTIAN J, PIERUCCI P. Fusion techniques for utterance-level emotion recognition combining speech and transcripts[C]∥Interspeech 2019. ISCA: ISCA, 2019: 51-55.

[14]HUANG Jian, LI Ya, TAO Jianhua, et al. Continuous multimodal emotion prediction based on long short term memory recurrent neural network[C]∥AVEC′17: Proceedings of the 7th Annual Workshop on Audio/Visual Emotion Challenge, 2017: 11-18.

[15]HUANG Jian, LI Ya, TAO Jianhua, et al. End-to-end continuous emotion recognition from video using 3D convlstm networks[C]∥2018 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). Calgary, AB, Canada. IEEE, 2018: 6837- 6841.

[16]CHEN Shizhe, JIN Qin, ZHAO Jinming, et al. Multimodal multi-task learning for dimensional and continuous emotion recognition[C]∥AVEC′17: Proceedings of the 7th Annual Workshop on Audio/Visual Emotion Challenge, 2017: 19-26.

[17]ZHANG Su,GUAN Cuntai.Emotion recognition with refined labels for deep learning[C]∥2020 42nd Annual International Conference of the IEEE Engineering in Medicine & Biology Society (EMBC). Montreal, QC, Canada. IEEE, 2020: 108-111.

[18]RINGEVAL F,SCHULLER B,VALSTAR M,et al.AVEC 2017:Real-life depression,and affect recognition workshop and challenge[C]∥AVEC′17: Proceedings of the 7th Annual Workshop on Audio/Visual Emotion Challenge, 2017: 3-9.