1 引言

文献[1]为了解决深度模型针对不同任务分别进行训练的问题,提出一种具有完全卷积架构的分层多任务网络(Hierarchical Multi-Task Network,HMTNet),可同时根据给定的人脸图像识别一个人的性别、种族等人脸属性。与现有深度方法相比,所提出的HMTNet在多个数据库上均具有最优秀的表现,并且可通过联合训练和特征聚合来学习更多区分性特征表示。文献[2]发现人脸属性存在依赖性,针对如何通过使用人脸属性之间的任务依赖性提高单任务的性能问题,提出使用任务依赖性进行人脸属性预测的多任务学习,并通过微笑和性别预测评估模型性能,实验结果表明所提网络的有效性。多任务学习之软共享机制中的十字绣网络(Cross-Stitch Networks)[3],通过激活网络,进行端到端的学习,进而自动决定共享层,即具有十字绣单元的网络可学习共享特征和独立特征表示的最佳组合。在人脸美丽预测中,单独采用十字绣网络,不能有效地获取图像中主要特征,不利于多任务学习区分特征,不能有效提高任务准确率。

自注意力(Self-Attention)[4]模块本质上是权重矩阵。图像中表示的信息权重各不相同,注意力机制更多关注权重高的部分,被广泛用于机器翻译以及概念抽象等领域,摒弃了传统循环神经网络或卷积神经网络。在进行数据读取时,前输入和后输入有相似特征的数据,即前输入和后输入是有关联的,需要将前输入进行部分“记忆”。为了更好地处理与序列高度相关的任务,引入长短时记忆(Long Short-Term Memory,LSTM)[5]模块,该结构可应用遗忘门和输出门“忘记”部分信息,以此来解决梯度消失的问题。故而,将十字绣网络中的部分层网络更换为Self-Attention模块与LSTM模块,实现参数共享,有益于探究人脸美丽预测与性别识别、肤色识别、微笑识别、表情识别等多任务之间的联系。

最初十字绣网络设计是针对同一输入不同任务预测;本文设计的网络是多个不同输入多个不同输出,将神经网络模块作为特定组件嵌入到多任务学习网络,十字绣网络允许神经网络模块嵌入网络结构,从而促使其在深度学习中的应用。因此,本文将十字绣网络与Self-Attention、LSTM模块进行融合,不仅对数据预测有良好表现、提高了模型训练速度,而且方便模块应用,为多任务学习提供了一种解决方案。

2 基于改进十字绣网络的任务分类

2.1 多任务学习机制

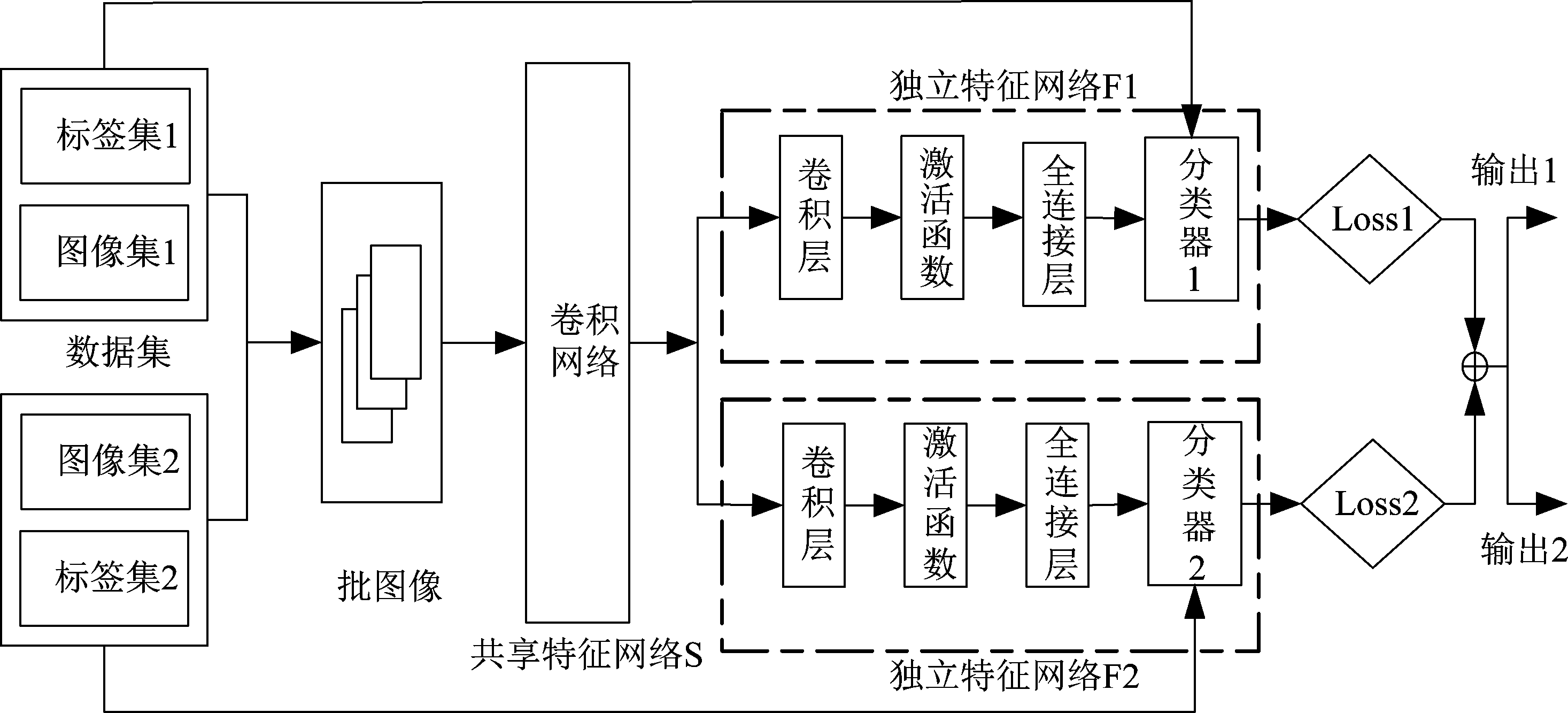

在多任务学习中,常见方法是参数硬共享机制与参数软共享机制。参数硬共享结构如图1所示,该机制在多任务学习中历史最为悠久、应用最为广泛,可应用于所有任务的隐藏层,即有相同的特征共享层,且保留任务独立特征层,大大减少了过拟合的风险;该共享结构较为容易理解和实现,是一种有效的方式,但是一种比较“粗鲁”的参数共享方式。参数软共享结构如图2所示,该机制是一种基于约束的共享,即每一个任务都有自己的特征参数以及子任务之间的约束,该设计比参数硬共享机制更具有鲁棒性,具体实现方式有多种;软共享机制是一种比较“温和”的参数共享方式,层与层、模块与模块之间按照一定的规则策略来进行知识的共享。

图1 多任务学习之参数硬共享机制

Fig.1 Parameter hard sharing mechanism for Multi-task Learning

图2 多任务学习之参数软共享机制

Fig.2 Parameter soft sharing mechanism for Multi-task Learning

2.2 改进十字绣网络结构

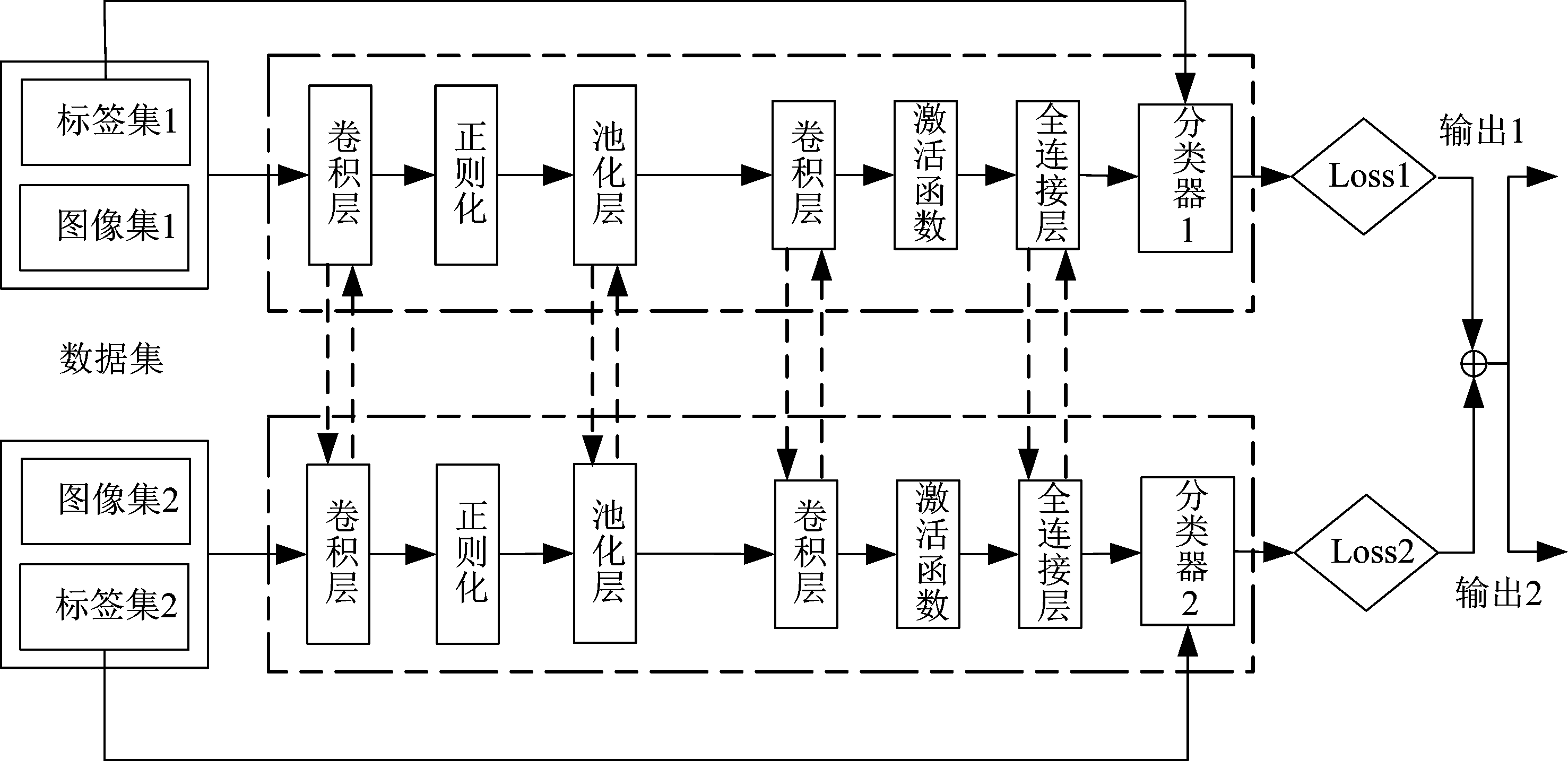

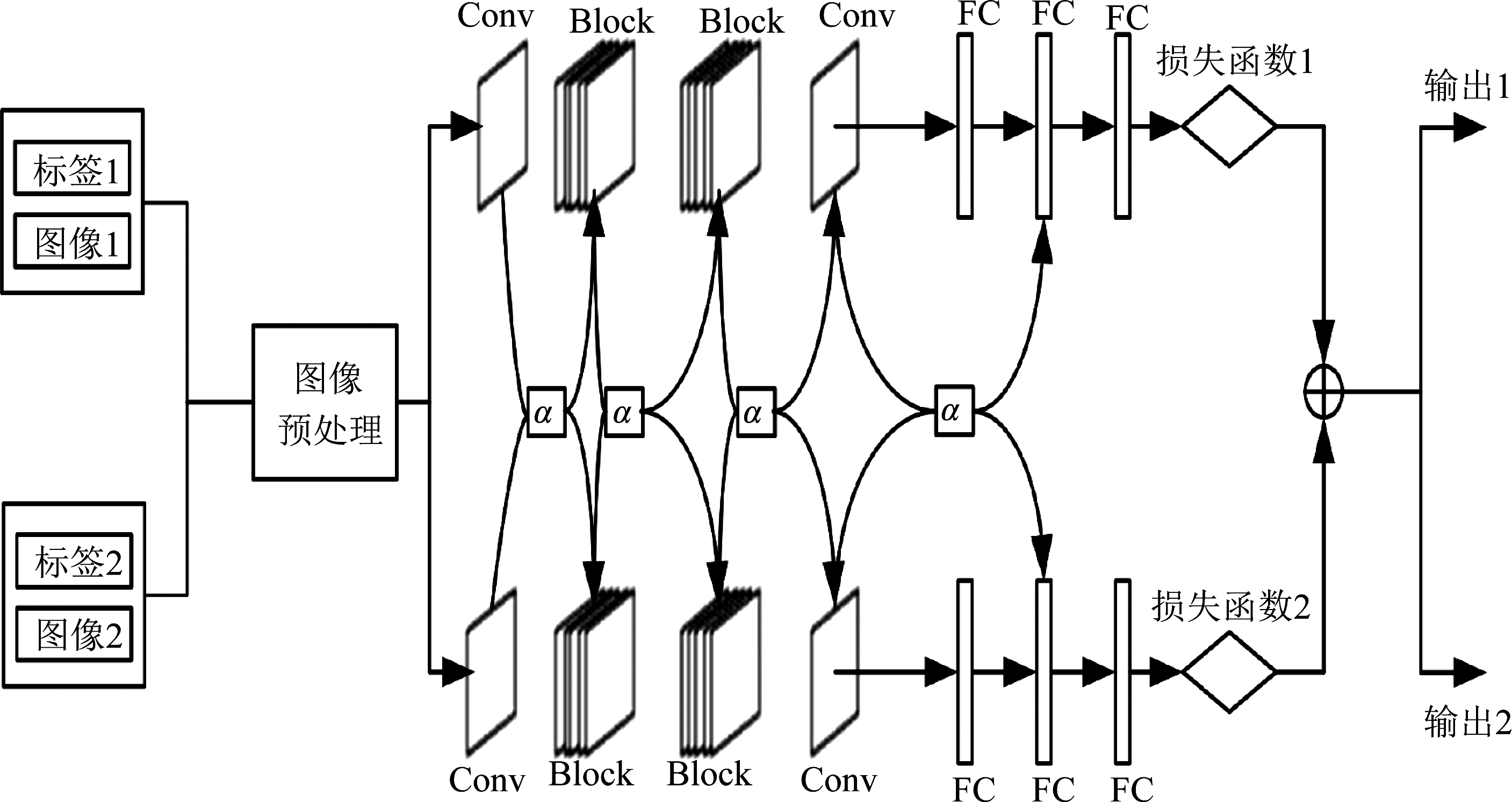

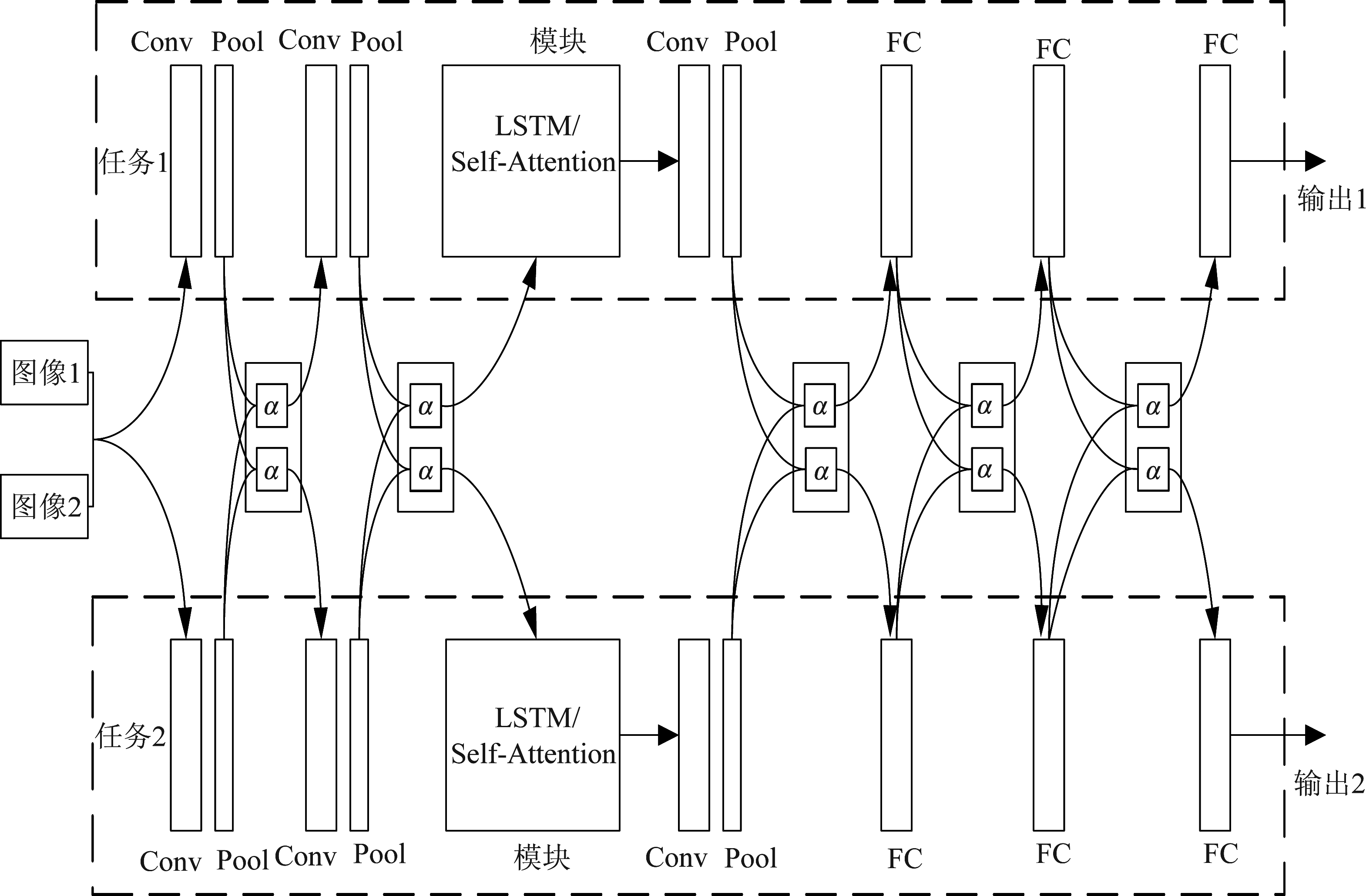

本文构建了一种灵活的多任务框架,将十字绣网络中的部分层网络更换为Self-Attention模块与LSTM模块,实现层与层之间、模块与模块之间的参数共享,以适应不同的任务。改进十字绣网络可在池化层或全连接层之后加上十字绣单元,称之为“微共享”;也可在模块上应用十字绣单元,称之为“模块共享”,框图如图3所示。

图3 改进十字绣网络框图

Fig.3 The block illustration of the Improved Cross-Stitch Network

本文针对人脸美丽预测、性别识别、微笑识别、肤色识别、表情识别等任务,构建了一个多任务学习网络,包括图像预处理、特征学习软共享结构与多任务分类。其中,特征学习软共享结构由Alexnet、VGG16_bn与Resnet50等特征提取层组成。本文的改进十字绣网络是一种通用的多任务学习共享框架,每个经典网络或自己搭建适合任务的网络均可使用该多任务学习共享结构。首先,图像预处理是对来自不同数据集的图像进行统一尺寸、人脸对齐、图像增强、归一化和图像剪裁等操作;其次,分别依托Alexnet、VGG16_bn与Resnet50等网络,构建特征学习软共享结构,学习图像共享的深度特征;最后,多任务损失权重采用固定比值进行多任务分类。

多任务损失函数的权重采用固定值,表示为

(1)

其中,Ltotal表示模型总损失,Lt表示单个任务的损失,ωt为每个任务所对应的权重,T表示模型训练的任务个数。

图4为改进十字绣网络结构图,是图3中间部分的具体实现。其中,两个不同输入对应任务1和任务2,分别针对两个任务训练了两个网络,采用十字绣单元将两个网络组合成一个多任务学习网络,可按照所需进行参数共享,即两个网络之间的十字绣单元如同一个“阀门”控制着网络共享程度。

图4 改进十字绣网络结构图

Fig.4 Improved Cross-Stitch Network structure illustration

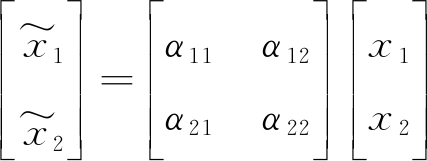

给定两个任务的激活图x1和x2,特征学习这两个输入激活图的线性组合![]() 和

和![]() 和α21表示不同任务之间的权重值,α11和α22表示相同任务之间的权重值。权重矩阵对两个任务之间的关系进行编码,可通过设置α12、α21、α11和α22值来设置共享程度。激活图的线性组合作为下一层网络的输入,调整α12、α21、α11和α22值可优化激活图的线性组合。该网络可通过设置α12或α21为0来进行任务的单独训练,说明两个网络之间没有共享特征;通过为它们分配更大的值来表示更高的共享程度。改进十字绣网络的计算公式可表示为

和α21表示不同任务之间的权重值,α11和α22表示相同任务之间的权重值。权重矩阵对两个任务之间的关系进行编码,可通过设置α12、α21、α11和α22值来设置共享程度。激活图的线性组合作为下一层网络的输入,调整α12、α21、α11和α22值可优化激活图的线性组合。该网络可通过设置α12或α21为0来进行任务的单独训练,说明两个网络之间没有共享特征;通过为它们分配更大的值来表示更高的共享程度。改进十字绣网络的计算公式可表示为

(2)

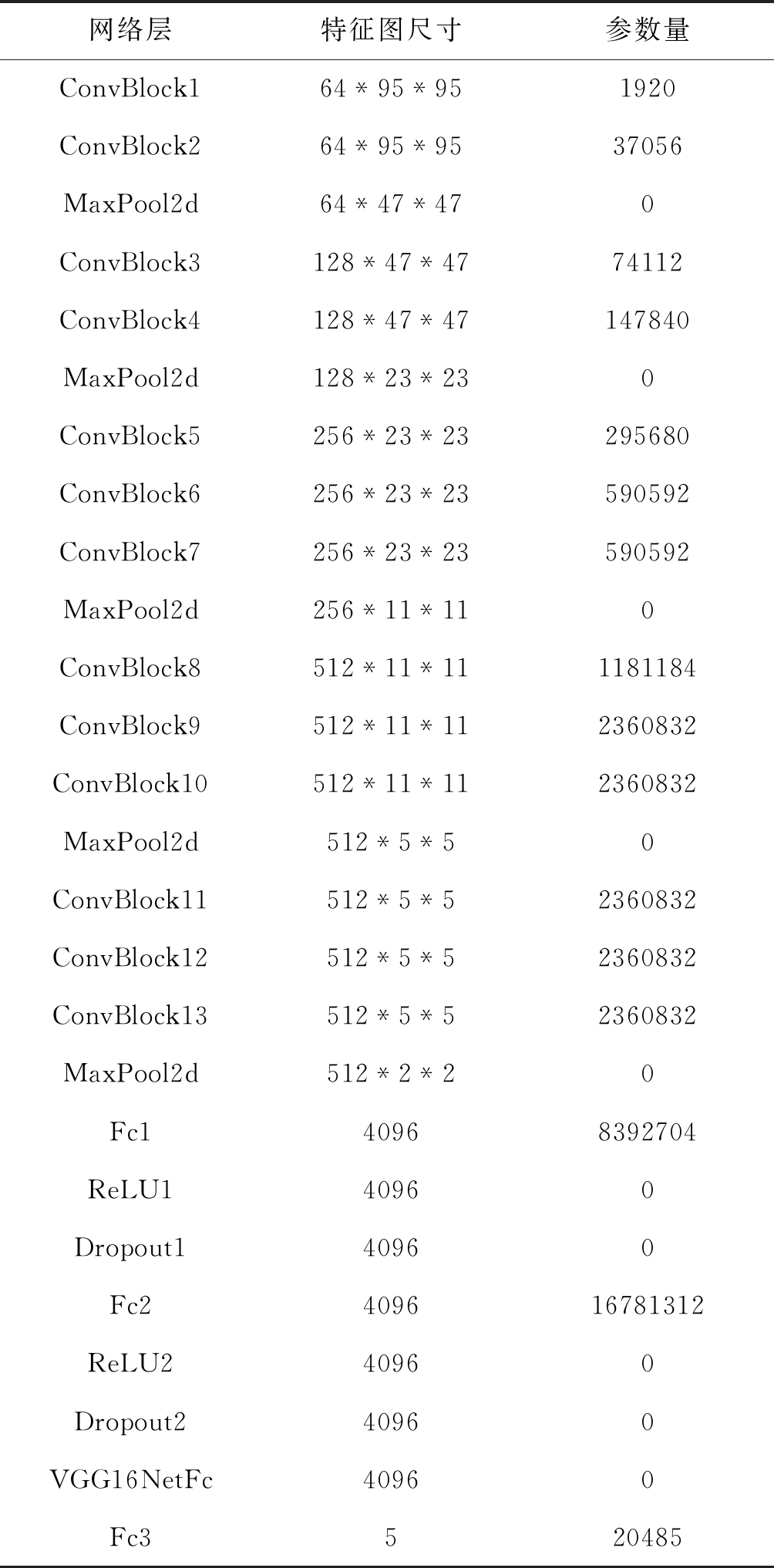

本文以VGG16_bn为基础,构建改进十字绣网络。该网络主要由13个卷积层、5个池化层以及3个全连接层组成,还包括ReLu激活层、BatchNormalization正则化层、Dropout正则化层等。输入图像大小为144*144, 剪裁为95*95。网络输入大小为3*95*95,参数量共计39917637。本文将Conv2d、BatchNorm2d与ReLU顺序组合成一个卷积块,其具体网络各部分及参数分析如表1所示。

表1 网络参数

Tab.1 Network parameters

网络层特征图尺寸参数量ConvBlock164*95*951920ConvBlock264*95*9537056MaxPool2d64*47*470ConvBlock3128*47*4774112ConvBlock4128*47*47147840MaxPool2d128*23*230ConvBlock5256*23*23295680ConvBlock6256*23*23590592ConvBlock7256*23*23590592MaxPool2d256*11*110ConvBlock8512*11*111181184ConvBlock9512*11*112360832ConvBlock10512*11*112360832MaxPool2d512*5*50ConvBlock11512*5*52360832ConvBlock12512*5*52360832ConvBlock13512*5*52360832MaxPool2d512*2*20Fc140968392704ReLU140960Dropout140960Fc2409616781312ReLU240960Dropout240960VGG16NetFc40960Fc3520485

2.3 Self-Attention模块

人类大脑对于图像的不同部分注意力是不同的,鉴于这一原理,本文引入了注意力机制。图像中表示的信息权重各不相同。普通模型对图像每一部分权重都看作是一样的,而注意力机制却不一样。Self-Attention[4]是注意力机制的重要改进。因此,本文提出在网络中采用Self-Attention模块。其主要原理为

X*WQ=Q

(3)

其中,X是输入向量即图像矩阵,WQ是模型训练过程中学习到的合适参数,Q是学习到的特征图矩阵。

Self-Attention可学习全局信息,同时并行训练。该模块是将Q和K—V对映射到输出,即

(4)

其中,Q、K、V均为向量,来自同一输入;dk为K的向量维度。

2.4 LSTM模块

传统网络在处理前输入和后输入时是完全独立的,但某些任务要求能更好地处理序列信息,即前输入和后输入是有关系的。为了更好地处理序列信息,本文提出采用LSTM模块[3]。LSTM单元结构原理可表示为

ft=σ(Wf·[Ot-1,xt]+bf)

(5)

it=σ(Wi·[Ot-1,xt]+bi)

(6)

Ot=ht*tanh(Ct)

(7)

其中, ft是遗忘门,it是输入门,ht是输出门,这是LSTM记忆单元可进行信息“记忆”的关键。Ot是LSTM记忆单元的输出状态,σ()、tanh()是激活函数,Ct是LSTM记忆单元的新状态,Wf、Wi是中间记忆单元对应的权重矩阵,bf、bi是中间记忆单元对应的偏置项。

3 实验结果与分析

3.1 实验基础

实验采用六核十二线程的AMD计算机处理器;单显GeForce RTX 2080容量为8G;主板读取内存容量为32G;所采用的深度学习框架为PyTorch和以TensorFlow为后端的Keras;GPU并行计算架构为CUDA Toolkit 10.0,基于CUDA的深度学习加速库cuDNN为7.5;Python版本为3.6等。

3.2 实验对象及处理

本文采用的数据集分别是Genki4k数据集[6]、SCUT-FBP5500数据集[7]、Fer2013数据集[8]、LSAFBD数据集[9]和Celeba数据集[10]。

(1)Genki4k数据集

Genki4k数据集[6],由加利福尼亚大学机器概念实验室所收集,是一个专门用于做笑脸识别的数据库,共4000张人脸,包含自然状态下“笑”和“不笑”两种人脸表情,每张图像尺度大小不一,而且还有姿势、光照的变化以及头部的扭动。Genki4k数据集文件夹包含files文件夹和labels.txt文件。按照标签0和1,把该数据集划分成训练集和测试集,分别再对训练集和测试集进行划分,分为两个文件夹0和1,子文件夹0表示“笑”的图像,子文件夹1表示“不笑”的图像。图像通道统一为三通道真彩图像。由于图像尺寸不一致,故而进行图像尺寸更改,将处理后的Genki4k数据集作为微笑数据集。

(2)SCUT-FBP5500数据集

SCUT-FBP5500数据集[7],由华南理工大学人机智能交互实验室发布,共5500个正面人脸,包括2000张亚洲女性、2000张亚洲男性、750张高加索男性、以及750张高加索女性。该数据集文件夹包含图像和标签。根据下载数据集的标签,将图像分为性别二分类数据集,即将该数据集划分为训练集和测试集,再分别对训练集和测试集进行划分,分为两个文件夹0和1,子文件夹0表示女性图像,子文件夹1表示男性图像,并进行图像尺寸更改。将处理后的该数据集作为性别数据集。

(3)Fer2013数据集

Fer2013数据集[8],是常用的表情识别数据集,由35886张人脸表情图像组成,其中训练图像28708张,测试图像7178张,每张图像由固定大小为48×48的灰度图像组成,共有七种表情,分别对应数字标签0~6,具体表情对应的标签为:生气、厌恶、恐惧、开心、伤心、惊讶、中性。首先,使用工具包读取数据集,获取要素pixels、emotion和Usage。其次,划分训练集和测试集。最后,将原始图像数据保存为jpg格式,并根据用途和标签进行分类,分别保存到对应的文件夹下。将处理后的Fer2013数据集作为表情数据集。

(4)LSAFBD数据集

大规模亚洲人脸美丽数据库(Large Scale Asia Facial Beauty Database,LSAFBD)[9]由本项目组构建,包括有标签图像2万张、无标签图像8万张,共计10万张图像。取其中有标签女性1万张图像作为实验的数据集。每张图像的美丽程度对应0、1、2、3、4五个等级之一。遍历LSAFBD数据集,根据标签将其划分成训练集和测试集,分别再对训练集和测试集划分成子文件夹0、1、2、3、4。在数据训练的处理中,读取各个子文件夹的图像,更改图像为指定的尺寸,与此同时进行数据的打乱操作。将处理后的LSAFBD数据集作为人脸美丽数据集。

(5)Celeba数据集

Celeba数据集[10],由香港中文大学搜集整理,是“CelebFaces Attribute”的缩写。该数据集包含10177个名人202599张人脸图像,每张图像都做了特征标记,包含人脸bbox标注框、5个人脸特征点坐标以及40个属性标记共三个文件夹,一个描述文档。属性Pale_Skin是40个属性标记之一。读取Celeba图像和对应属性Pale_Skin标签,先将其划分成训练集和测试集,分别再对训练集和测试集划分成子文件夹0和1,0代表肤色白皙,1代表肤色非白皙。在数据训练的处理中,读取各个子文件夹图像,更改图像为指定的尺寸,与此同时进行数据的打乱操作。将处理后的Celeba数据集作为肤色数据集。

3.3 结果分析

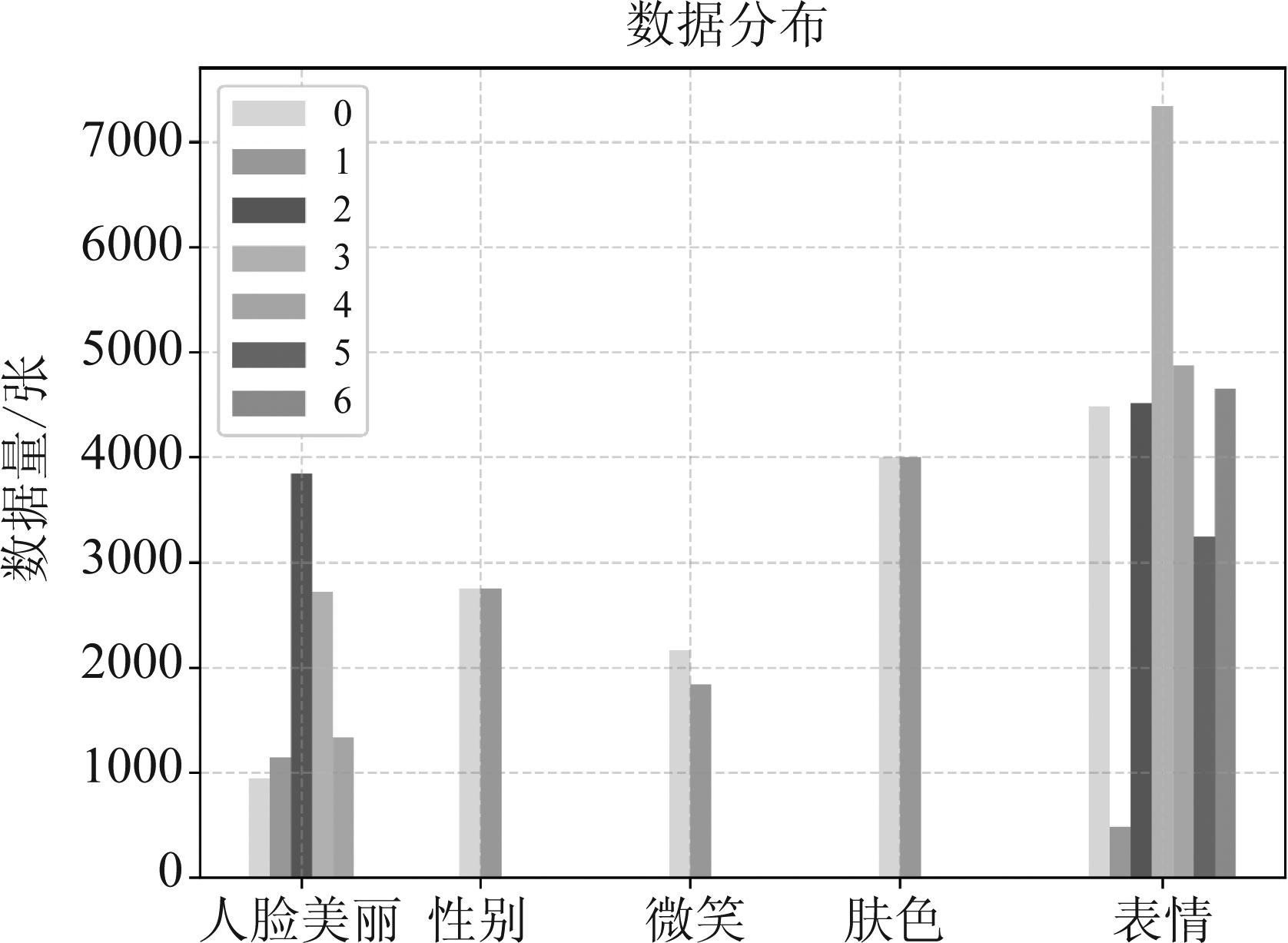

如图5所示,是LSAFBD人脸美丽数据集、SCUT-FBP5500性别数据集、Genki4k微笑数据集、Celeba肤色数据集、Fer2013表情数据集中每个类别的数据量。其中,SCUT-FBP5500性别数据集、Genki4k微笑数据集、Celeba肤色数据集是两分类任务,每个数据集两个类别的数据量基本是相等的,即处于数据均衡状态,在数据预处理时不用进行数据均衡处理;LSAFBD人脸美丽数据集是五分类任务,实际生活中人脸美丽吸引力的分布应符合正态分布,在数据预处理时进行图像增强使之数据集符合正态分布;Fer2013表情数据集是七分类任务,存在数据不均衡问题,在数据预处理时进行数据均衡处理。

图5 数据集各类别数量分布

Fig.5 Quantity distribution of each category in datasets

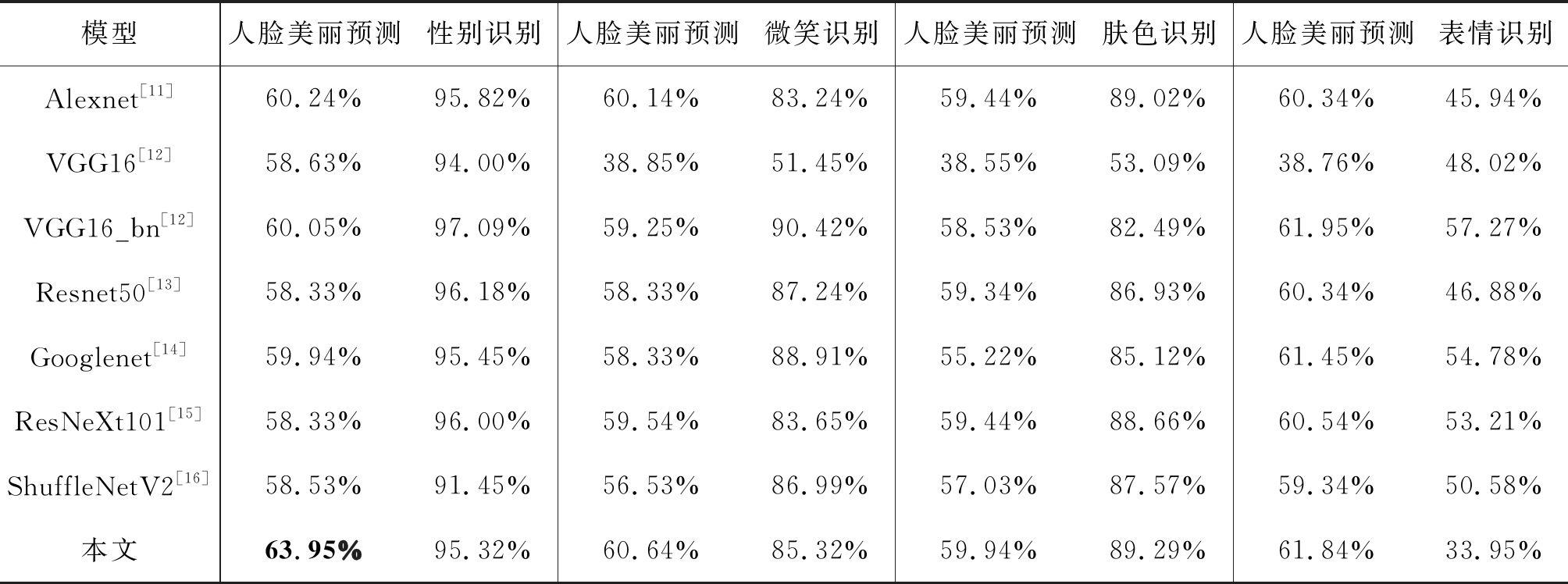

表2是以人脸美丽预测为主任务,分别以性别识别、微笑识别、肤色识别和表情识别为辅助任务,在多个经典模型下的训练结果。经典模型采用硬共享机制进行训练。对比多个经典模型发现,同等条件下VGG16_bn的准确率高于VGG16,说明采用正则化手段是一种提高网络学习能力比较有效的方式。在多个经典模型中,Alexnet、VGG16_bn的总体表现效果较佳。对比多任务学习发现,在表情影响下的人脸美丽预测任务准确率要高于性别影响下的人脸美丽预测任务准确率,表情比性别的区分特征明显;在性别影响下的人脸美丽预测任务准确率要高于微笑影响下的人脸美丽预测任务准确率,性别比微笑的区分特征明显;在微笑影响下的人脸美丽预测任务准确率要高于肤色影响下的人脸美丽预测任务准确率,微笑比肤色的区分特征明显。由此可知,区分特征明显的辅助任务更易提升人脸美丽预测主任务的准确率。与经典模型,本文所使用的改进十字绣模型表现出更优异的效果,准确率在多数任务下有所提升。通过对比发现,改进十字绣模型在以性别识别为辅助任务的人脸美丽预测实验上取得最佳的效果,并且该多任务在各个模型中表现更稳定。

表2 基于经典模型与改进十字绣模型的多任务学习实验

Tab.2 Multi-task Learning experiment based on classic model and Improved Cross-Stitch model

模型人脸美丽预测性别识别人脸美丽预测微笑识别人脸美丽预测肤色识别人脸美丽预测表情识别Alexnet[11]60.24%95.82%60.14%83.24%59.44%89.02%60.34%45.94%VGG16[12]58.63%94.00%38.85%51.45%38.55%53.09%38.76%48.02%VGG16_bn[12]60.05%97.09%59.25%90.42%58.53%82.49%61.95%57.27%Resnet50[13]58.33%96.18%58.33%87.24%59.34%86.93%60.34%46.88%Googlenet[14]59.94%95.45%58.33%88.91%55.22%85.12%61.45%54.78%ResNeXt101[15]58.33%96.00%59.54%83.65%59.44%88.66%60.54%53.21%ShuffleNetV2[16]58.53%91.45%56.53%86.99%57.03%87.57%59.34%50.58%本文63.95%95.32%60.64%85.32%59.94%89.29%61.84%33.95%

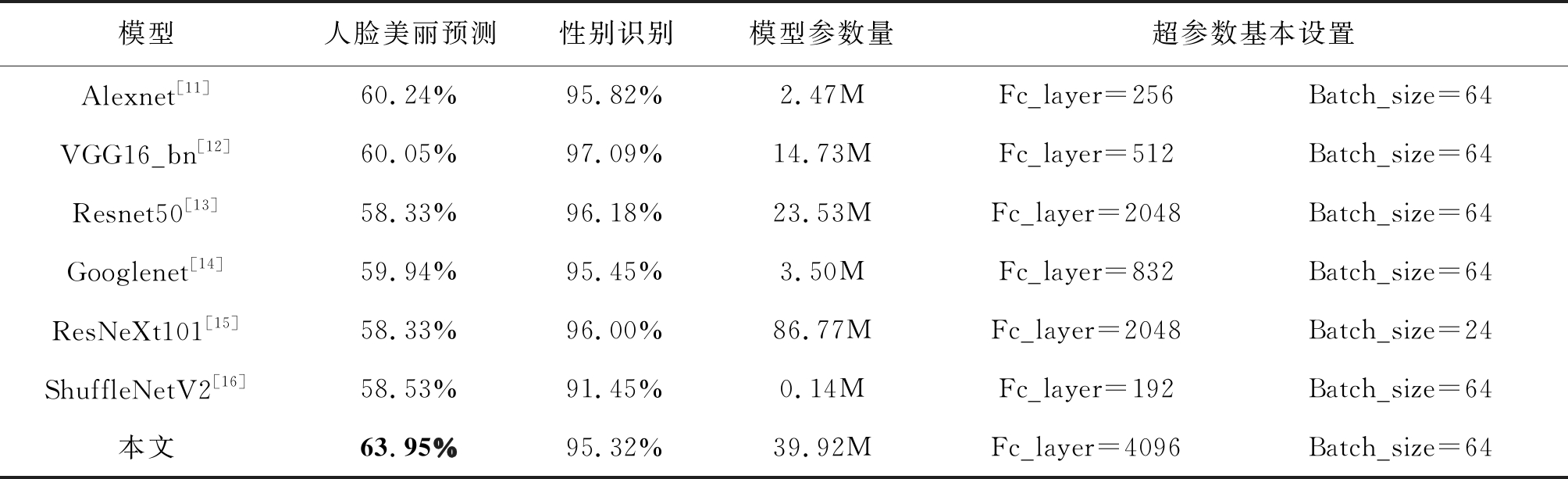

表3 改进十字绣模型与经典模型对比实验结果

Tab.3 Improved Cross-Stitch model and comparison of experimental results with classic models

模型人脸美丽预测性别识别模型参数量超参数基本设置Alexnet[11]60.24%95.82%2.47MFc_layer=256Batch_size=64VGG16_bn[12]60.05%97.09%14.73MFc_layer=512Batch_size=64Resnet50[13]58.33%96.18%23.53MFc_layer=2048Batch_size=64Googlenet[14]59.94%95.45%3.50MFc_layer=832Batch_size=64ResNeXt101[15]58.33%96.00%86.77MFc_layer=2048Batch_size=24ShuffleNetV2[16]58.53%91.45%0.14MFc_layer=192Batch_size=64本文63.95%95.32%39.92MFc_layer=4096Batch_size=64

表3是以人脸美丽预测为主任务,以性别识别为辅助任务,在多个经典模型以及本文所构建的改进十字绣网络下的训练结果。经典模型采用硬共享机制,本文构建的改进十字绣网络采用软共享机制。对比表3可知,硬共享机制下的经典模型在人脸美丽预测任务上的测试准确率最高达到60.24%,软共享机制下的改进十字绣网络在人脸美丽预测任务上的测试准确率最高可达63.95%。Alexnet是一个参数量比较少、网络学习能力比较强的优秀网络结构,综合平衡了速度和效果。ShuffleNetV2是一个效果较佳、网络较小的轻量化网络,模型大小仅有0.14M,取得了58.53%的准确率。Resnet50、ResNeXt101模型参数量比VGG16_bn多,但在人脸美丽预测任务中效果却比VGG16_bn差。由此看来,并非网络越深、神经网络参数越多学习效果就越好。网络深度可能与数据量、数据清晰度以及数据格式等数据属性相匹配才可获得更好的学习效果。VGG16_bn、本文方法的模型参数量比Googlenet多,但人脸美丽预测任务的准确率也高于Googlenet。因此,若想达到一定的准确率仍需要一定深度的网络结构;一味追求轻量化,将会以损失准确率为代价,需要在准确率可接受范围和模型大小之间寻找一个平衡点。受限于硬件条件,Fc_layer层神经元个数和批次大小有变化。

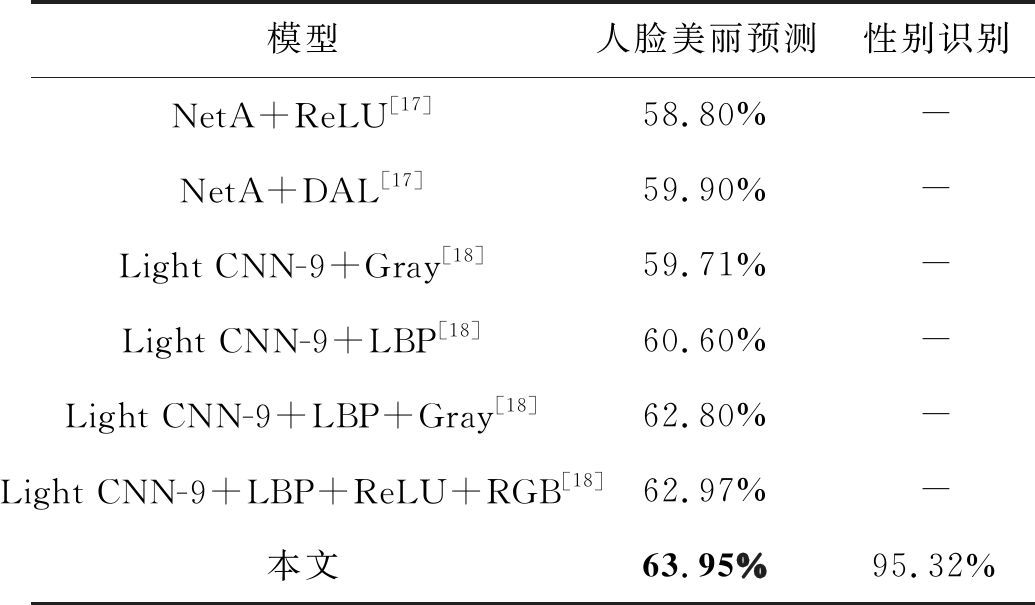

表4 人脸美丽预测研究实验结果

Tab.4 Experimental results of Facial Beauty Prediction

模型人脸美丽预测性别识别NetA+ReLU[17]58.80%-NetA+DAL[17]59.90%-Light CNN-9+Gray[18]59.71%-Light CNN-9+LBP[18]60.60%-Light CNN-9+LBP+Gray[18]62.80%-Light CNN-9+LBP+ReLU+RGB[18]62.97%-本文63.95%95.32%

表4中文献[17-18]方法以人脸美丽预测为任务,在NetA网络、Light CNN-9网络下的准确率;本文方法是以人脸美丽预测为主任务,以性别识别作为辅助任务,在改进十字绣网络下的准确率。NetA+ReLU采用NetA模型[17]、ReLU激活函数;NetA+DAL采用NetA模型、双激活层(Double Activation Layer,DAL)函数。Light CNN-9+Gray采用Light CNN-9[18]模型、输入图像是Gray单通道灰度图像;Light CNN-9+LBP采用Light CNN-9模型、局部二值模式(Local Binary Patterns,LBP)算子;Light CNN-9+LBP+Gray采用Light CNN-9模型、LBP算子,输入图像是Gray单通道灰度图像;Light CNN-9+LBP+ReLU+RGB采用Light CNN-9模型和LBP算子、ReLU激活函数,输入图像是RGB三通道真彩图像。本文将十字绣网络中的部分层网络更换为Self-Attention模块、LSTM模块,进行层与层之间、模块与模块之间的参数共享。改进十字绣网络是一种通用多任务学习共享框架。该网络针对不同的任务自动决定共享层,并且允许模型在不同的表示子空间中学习到相关的信息,降低层的复杂度。采用常规方法在人脸美丽预测任务上获得的最高准确率为62.97%,采用本文改进十字绣网络方法取得的准确率高达63.95%。改进十字绣网络不仅能自动寻找该任务下的最佳共享层,且能并行学习Self-Attention顶层中隐藏的依赖信息,较好地拟合了数据。

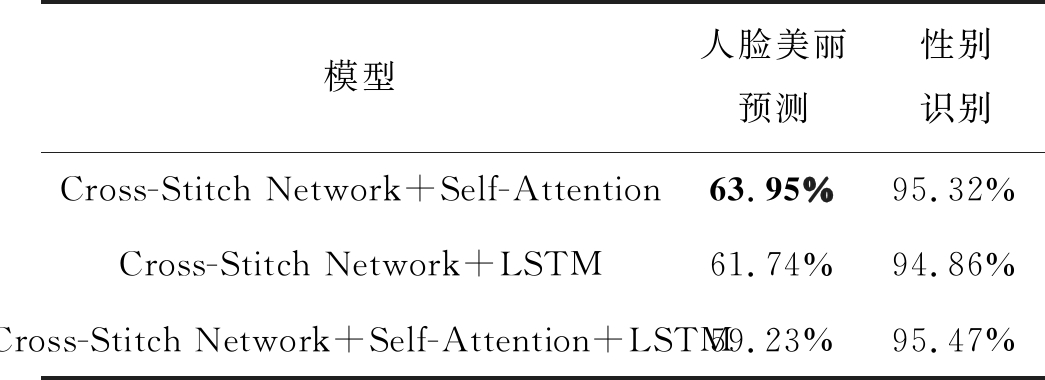

表5 改进十字绣网络实验结果

Tab.5 Improved Cross-Stitch Network experiment results

模型人脸美丽预测性别识别Cross-Stitch Network+Self-Attention63.95%95.32%Cross-Stitch Network+LSTM61.74%94.86%Cross-Stitch Network+Self-Attention+LSTM59.23%95.47%

表5是以人脸美丽预测为主任务,以性别识别为辅助任务,在本文所构建的改进十字绣网络下的训练结果。改进十字绣网络可将十字绣网络的部分层更换为Self-Attention模块或LSTM模块或Self-Attention模块和LSTM模块。改进十字绣网络采用Self-Attention模块表现效果较佳,人脸美丽预测任务高达63.95%;采用LSTM模块人脸美丽预测任务达到61.74%;采用Self-Attention和LSTM模块人脸美丽预测任务达到59.23%。故而,改进十字绣网络采用Self-Attention模块在该任务更能学习到数据的分布,取得更好的分类准确率。实验采用Dropout模型泛化方法,一般网络需要设置丢弃率在0.5及其以下,0.2~0.4为宜。如果丢弃率设置过大,则学习速度过慢,耗费大量时间,网络深度较浅将出现不能达到较好学习任务的目的;如果丢弃率设置过小,模型泛化能力达不到预想要求,模型泛化能力将不如人意。

4 结论

本文提出的改进十字绣网络,以人脸美丽预测为主任务,辅助任务使用人脸多个相关属性,包括性别识别、微笑识别、肤色识别和表情识别。改进十字绣网络,将其部分层网络更换为Self-Attention模块与LSTM模块,从而实现层与层之间、模块与模块之间的参数共享;在人脸美丽预测任务上取得较佳的实验结果。尚存在不足的是数据集中存在大量的未标记数据,未来将采用弱监督学习算法;同时,调试超参数α需要花费大量时间,可采用自动调优机制,自动寻求最优的α值。

[1] XU Lu, FAN Heng, XIANG Jinhai. Hierarchical multi-task network for race, gender and facial attractiveness recognition[C]∥2019 IEEE International Conference on Image Processing (ICIP). Taipei, Taiwan, China. IEEE, 2019: 3861-3865.

[2] FAN Di, KIM H, KIM J, et al. Multi-task learning using task dependencies for face attributes prediction[J]. Applied Sciences, 2019, 9(12): 2535.

[3] MISRA I, SHRIVASTAVA A, GUPTA A, et al. Cross-stitch networks for multi-task learning[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Las Vegas, NV, USA. IEEE, 2016: 3994- 4003.

[4] VASWANI Ashish, SHAZEER Noam, PARMAR Niki, et al. Attention is All you Need[J]. arXiv preprint arXiv:1706.03762(2017).

[5] GRAVES Alex. Supervised Sequence Labelling with Recurrent Neural Networks[J]. URL http:∥books.google.com/books(2012).

[6] The MPLab GENKI- 4K Dataset, http:∥mplab.ucsd.edu.

[7] LIANG Lingyu, LIN Luojun, JIN Lianwen, et al. SCUT-FBP5500: A diverse benchmark dataset for multi-paradigm facial beauty prediction[C]∥2018 24th International Conference on Pattern Recognition (ICPR). Beijing, China. IEEE, 2018: 1598-1603.

[8] The Facial Expression Contest, https:∥www.kaggle.com/deadskull7/fer2013.

[9] GAN Junying, ZHAI Yikui, WANG Bin. Unconstrained facial beauty prediction based on multi-scale K-means[J]. Chinese Journal of Electronics, 2017, 26(3): 548-556.

[10]Large-scale CelebFaces Attributes (CelebA) Dataset, http:∥mmlab.ie.cuhk.edu.hk/projects/CelebA.html.

[11]KRIZHEVSKY Alex, SUTSKEVER Ilya, HINTON E. Geoffrey, et al. Imagenet classification with deep convolutional neural networks[J]. Advances in Neural Information Processing Systems, 2012, 25: 1097-1105.

[12]SIMONYAN Karen, ZISSERMAN Andrew. Very deep convolutional networks for large-scale image recognition[J]. 3rd International Conference on Learning Representations, 2015, arXiv preprint arXiv:1409.1556(2014).

[13]HE Kaiming, ZHANG Xiangyu, REN Shaoqing, et al. Deep residual learning for image recognition[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Las Vegas, NV, USA. IEEE, 2016: 770-778.

[14]SZEGEDY C, LIU Wei, JIA Yangqing, et al. Going deeper with convolutions[C]∥2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Boston, MA, USA. IEEE, 2015: 1-9.

[15]XIE Saining, GIRSHICK Ross, DOLLAR Piotr, et al. Aggregated Residual Transformations for Deep Neural Networks[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2017: 1492-1500.

[16]MA Ningning, ZHANG Xiangyu, ZHENG Haitao, et al. Shufflenet v2: Practical guidelines for efficient cnn architecture design[C]∥In Proceedings of the European Conference on Computer Vision(ECCV), 2018: 116-131.

[17]甘俊英, 翟懿奎, 黄聿, 等. 基于双激活层深度卷积特征的人脸美丽预测研究[J]. 电子学报, 2019, 47(3): 636- 642.

GAN Junying, ZHAI Yikui, HUANG Yu, et al. Research of facial beauty prediction based on deep convolutional features using double activation layer[J]. Acta Electronica Sinica, 2019, 47(3): 636- 642.(in Chinese)

[18]甘俊英, 谭海英, 项俐, 等. 结合局部二值模式和卷积神经网络的人脸美丽预测[J]. 信号处理, 2019, 35(1): 150-158.

GAN Junying, TAN Haiying, XIANG Li, et al. Facial beauty prediction combined local binary pattern and convolution neural network[J]. Journal of Signal Processing, 2019, 35(1): 150-158.(in Chinese)