1 引言

语音分离,也被称为“鸡尾酒会”问题[1],指的是在复杂的声学环境中,存在多个噪声源和相互重叠的说话人声音,需要同时跟踪并分离出多个声源。主要应用在于鲁棒性的语音下游任务的前端,如语音识别、说话人识别、音频分类等,或者提升聆听者的听觉感受,如耳机、助听器等设备的语音质量。随着深度学习技术的发展,单通道语音分离不断进步,传统方法中计算听觉场景分析[2](Computational Auditory Scene Analysis, CASA)和非负矩阵分解[3](Nonnegative Matrix Factorization, NMF)等也利用神经网络进行改进,同时出现了深度聚类[4](Deep clustering),置换不变训练[5](Permutation Invariant Train, PIT),深度吸引子网络[6](Deep attractor Net, DANet)等方法很好地解决了源排列问题。相比单通道系统,多通道系统则蕴含了说话人的空间位置信息,可进一步助力语音分离。

先前多数方法将时域通过短时傅里叶变换(Short-Time Fourier transform, STFT)转换到频域,再进行估计时频掩蔽,每一个掩蔽对应一个目标说话人,滤除干扰信号从而达到分离效果。但是,转换到频域后由于训练网络难以同时利用幅度谱和相位谱,通常只输入幅度谱进行训练,在解码阶段补上相位信息,存在相位不匹配的问题。因此,时域音频分离网络[7](TaSNet)、全卷积时域语音分离网络[8](Conv-Tasnet)的提出,将语音直接在时域进行编解码处理,实现端到端的训练,从而获得更加优异的性能。

多通道语音分离任务主要处理的是带有空间混响的远场语音输入。通常空间混响会模糊语音谱的线索,相比单通道系统,多通道系统则能够利用通道间的冗余信息尽可能地缓解或解决这个问题。多数多通道研究主要集中于两个方面,一是使用神经网络估计波束成形的权重,作用于原始信号从而增强语音信号[9-10];二是在单通道系统的基础上进一步利用多通道的空间特性进行辅助输入,联合训练分离网络[11-12]。

本文研究的主要对象是自组织麦克风网络[13],不同于固定麦克风阵列的方式,其网络几何拓扑没有严格的约束,能够灵活地部署应用,在人工智能物联网(AIoT)领域具有很好的应用前景。自组织麦克风网络中各个麦克风节点设备的拾音效果不同,本文希望能够有效利用其中较好的通道数据,同时不被较差的通道数据干扰。基于这种思考,本文介绍一种充分利用通道间信息而无需知道麦克风位置的语音分离方法,通过引入压缩激励脊髓(Squeeze-Excitation-Spinal,SES)模块,基于注意力的思想,有效利用全局信息获得特征响应的权重,能够加入到端到端的训练框架中。所提出的方法使用全局均值池化操作实现通道的全局表征,使用脊髓模块进行灵活学习通道间非线性关系,完成对多通道语音特征的权重分配。本工作将单通道的Conv-TasNet扩展到多通道系统,在多通道语音数据集中进行实验测试,和原有单通道系统相比,性能具有明显提升,并能够超过最先进的多通道方法。

本文余下内容安排如下:第2节详细介绍所提出方法的具体内容,第3节记录实验和结果分析,第4节对本文进行总结。

2 本文提出的多通道语音分离方法

2.1 问题定义

自组织麦克风网络下的问题场景同麦克风阵列场景相似,因此本文考虑所应用场景中部署了M(M≥2)个任意位置的麦克风,存在C(C≥2)个说话人以及N(N≥1)个噪声源。假定自组织麦克风网络收到的语音信号为X(t)=[x1(t),x2(t),…,xM(t)],包含M个通道,则其定义如下:

![]()

k=1,2,…,M

(1)

其中,C个说话人发出的干净语音信号记作S(t)=[s1(t),s2(t),…,sC(t)],N个噪声信号记作![]() 表示第i个说话人语音si或第j个噪音信号ni在第k个麦克风位置对应的混响信号,⊗表示卷积操作。所期望的结果是通过分离网络F得到各个说话人对应干净语音

表示第i个说话人语音si或第j个噪音信号ni在第k个麦克风位置对应的混响信号,⊗表示卷积操作。所期望的结果是通过分离网络F得到各个说话人对应干净语音![]() 即

即

(2)

2.2 压缩激励脊髓模块

压缩激励脊髓模块源于图像分类中的压缩激励网络[14](Squeeze-Excitation Net, SE)和脊髓网络[15](Spinal Net),通过将二者结合获得新的通道维度注意力机制单元,适合处理麦克风网络中的多通道语音分离任务。

压缩激励网络的核心思想在于对输入数据通道间的相互关系进行建模,从而对其中的有利数据和不利数据进行调整权重的分配,希望将权重分配偏向价值最大的信息,最终使模型能充分利用数据从而获得更好的结果。压缩激励网络通过压缩操作,将多通道特征顺着通道维度进行聚合,得到整体通道的全局信息,解决之前无法利用局部通道之外信息的问题,通过激励操作学习通道间非线性的相互作用和非互斥关系,利用门控机制调节,根据捕获的通道关系进行信息筛选。为了降低模型的复杂度和提高泛化能力,压缩激励网络加入了两层全连接层,构造瓶颈结构进行参数化。

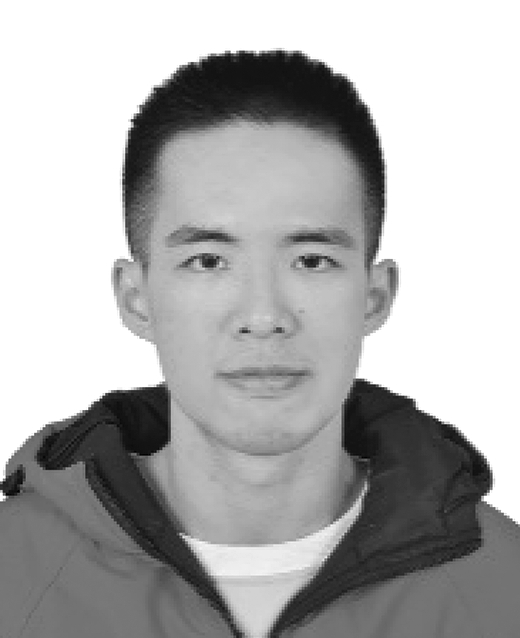

脊髓网络借鉴了人体感受触觉的方式,人脑接收不同部位的信号,脊髓则从接收不同部位的触觉,故而引出了“逐步输入”的概念,能够对局部和全局都产生作用,就像非条件反射的不自主控制和大脑控制脊髓调节痛感的自主控制,解决深度神经网络中计算量大、梯度消失等问题。脊髓网络由输入行、中间行和输出行组成。输入行分割输入,将上一层的部分输入和输出馈送给包含少量神经元的中间行,中间行包含非线性激活函数,输出行包含线性激活函数,这样的结构保证了输入权重的数量远低于传达深度神经网络,并且不存在梯度消失问题。图1(b)和图1(a) 对比,中间行和输出行的每个隐层包含两个神经元。隐层的输出神经元数等于输出神经元数。中间神经元的数目可以根据需要而改变。

图1 单隐层神经网络和脊髓网络结构

Fig.1 The schema of Neural Network (a) and Spinal Network (b)

如图2所示,压缩激励脊髓模块保留了压缩激励网络的主要步骤,同样分为压缩和激励两个阶段。压缩阶段是通过全局均值池化操作将多通道特征压缩到通道维度,得到通道特征分布情况的表征。激励阶段是使用脊髓网络代替全连接操作,利用缩放因子降低通道维度从而减少计算量,经过激励函数后再映射到原有通道维度,得到特征响应的权重并对特征信息进行更新,通过残差连接的方式接入训练网络。压缩阶段的目标对象在于各个通道内部间的信息,而激励阶段中脊髓网络的目的是为融合各通道间的信息。

图2 压缩激励脊髓结构

Fig.2 The schema of SES block

2.3 基于压缩激励脊髓模块的全卷积时域语音分离网络

全卷积时域语音分离网络(Conv-TasNet)是一种时域单通道的端到端语音分离方法,包括编码器、分离网络和解码器等三部分[8]。编码器与解码器使用1-D卷积/1-D转置卷积代替STFT/iSTFT作为处理波形的特征变换。分离网络使用了由1-D空洞卷积块堆叠组成的时间卷积网络(TCN),这些卷积块的空洞因子随着层数增加而指数上升,使得卷积块能够利用语音信号的上下文信息进行建模。每个1-D卷积块由一个1×1卷积运算和一个深度可分离卷积运算组成,其在两个卷积运算之间加上非线性激活函数参数整流线性单元(PReLU)和全局归一化操作。

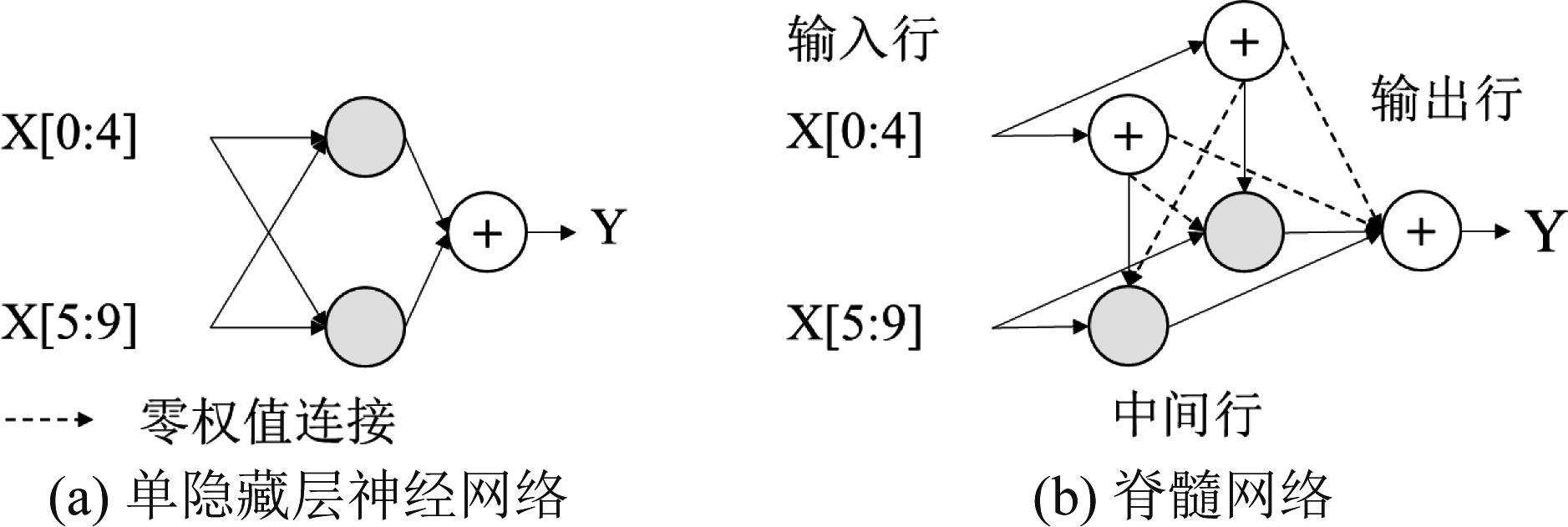

本文将在多通道全卷积时域语音分离网络的基础,进行了压缩激励脊髓模块的结合方式探究。在编码器的部分,仍旧使用1-D卷积进行特征变换。如图3(a)所示,本文将原始全卷积时域语音分离网络中堆叠的空洞卷积块集合记作重复单元,并在重复单元中进行了三种方式的应用:如图3(b)与(d)所示,将压缩激励脊髓模块插入在每个重复单元内的第一个空洞卷积块之前与之后,两者的区别在于前者提前进行了通道注意力学习,图3(b)则将模块插入在卷积块之间,在重复单元内对每个空洞卷积块都进行压缩激励。压缩激励脊髓模块使用的时候与堆叠空洞卷积块原有的残差连接保持一致。

图3 多通道语音分离网络结构(a)和SES模块三种不同应用方式的重复单元结构(b)、(c)、(d)

Fig.3 Multichannel speech separation network (a) and the three application ways of SES block (b)、(c)、(d)

3 仿真实验和结果分析

3.1 实验数据

本文在基于LibriSpeech[16]的合成数据集[10]上进行了双通道双人的含噪语音分离实验。所使用的LibriSpeech数据集是单人的干净英文发音,为了获得符合本文所面向场景的数据集,对其进行以下操作进行人工合成包含噪音混响条件的多通道混合数据集,并对其划分成生成条件一致的训练集、验证集、测试集,分别包含4000,1000, 600条4 s长度的话语语音。2条说话人语音和1条噪音随机从100 小时的LibriSpeech 数据集和 100 Nonspeech[17]数据集中挑选。话语重叠率根据正态分布随机取0%~100%,并确保其平均重叠率为50%。2条说话人语音根据重叠率进行时移变换,随机取0~5 dB信噪比进行混合。统一噪声长度为4 s, 原始噪声不足的进行重复,并使其对混合说话人信噪比为10~20 dB。通过Image法[18]进行生成模拟混响与其进行卷积混合后分别求和到每个麦克风。其中模拟房间的长宽随机从3~10 m选取, 高度从2.5~4 m随机选取,混响时间从0.1~0.5 s随机选取,并设定所有麦克风、说话人、噪声源与房间的墙体有至少0.5 m。

3.2 实验设置

本文的实验中,取M=2、3,C=2,N=1,即在2个通道(2ch)和3个通道(3ch)条件下,对包含1个噪音信号语音数据进行2个说话人语音分离,但是本文所设计的网络结构可用于更多说话人数量的语音分离实验。实验中,全卷积语音分离网络参数配置与文献[8]最优结果参数相同。实验中考虑如图3(b)~(d)所示的三种压缩激励脊髓模块在语音分离网络中的应用方式对整个体系结构进行了优化,即压缩激励脊髓模块插入在堆叠空洞卷积块之前(front-SES)、之间(inter-SES)和之后(rear-SES)。为了检查压缩激励脊髓模块中脊髓网络的有效性,本文也选择了全连接层和卷积层作为对比,记作FC和Conv。同时,分离网络的输出作为时频掩蔽或直接输出作为估计目标信号(Directly Output, DO)在实验中也将进行探讨。默认的实验设置选用网络输出作为时频掩蔽的方式。本文实验选用最初的单通道全卷积时域语音分离网络作为基线,其中单通道指只使用第一个通道的语音数据。同时,也对最先进的自组织麦克风网络下多通道语音分离系统[10]进行了复现实验,该模型结合了转换平均级联(Transform-Average-Concatenate, TAC)与滤波求和网络(Filter-and-Sum Network, FaSNet),后续文中将该模型记作FaSNet-TAC。

3.3 实验结果与分析

为了度量分离后的语音质量,本文使用了信噪失真比[19](Signal-to-Distortion Ratio, SDR)、尺度不变的信噪失真比[20] (Scale-Invariant SDR, SISDR)、感知语音质量评估(Perceptual Evaluation of Speech Quality, PESQ)和短时客观可懂度(Short-Time Objective Intelligibility, STOI)作为评估指标。

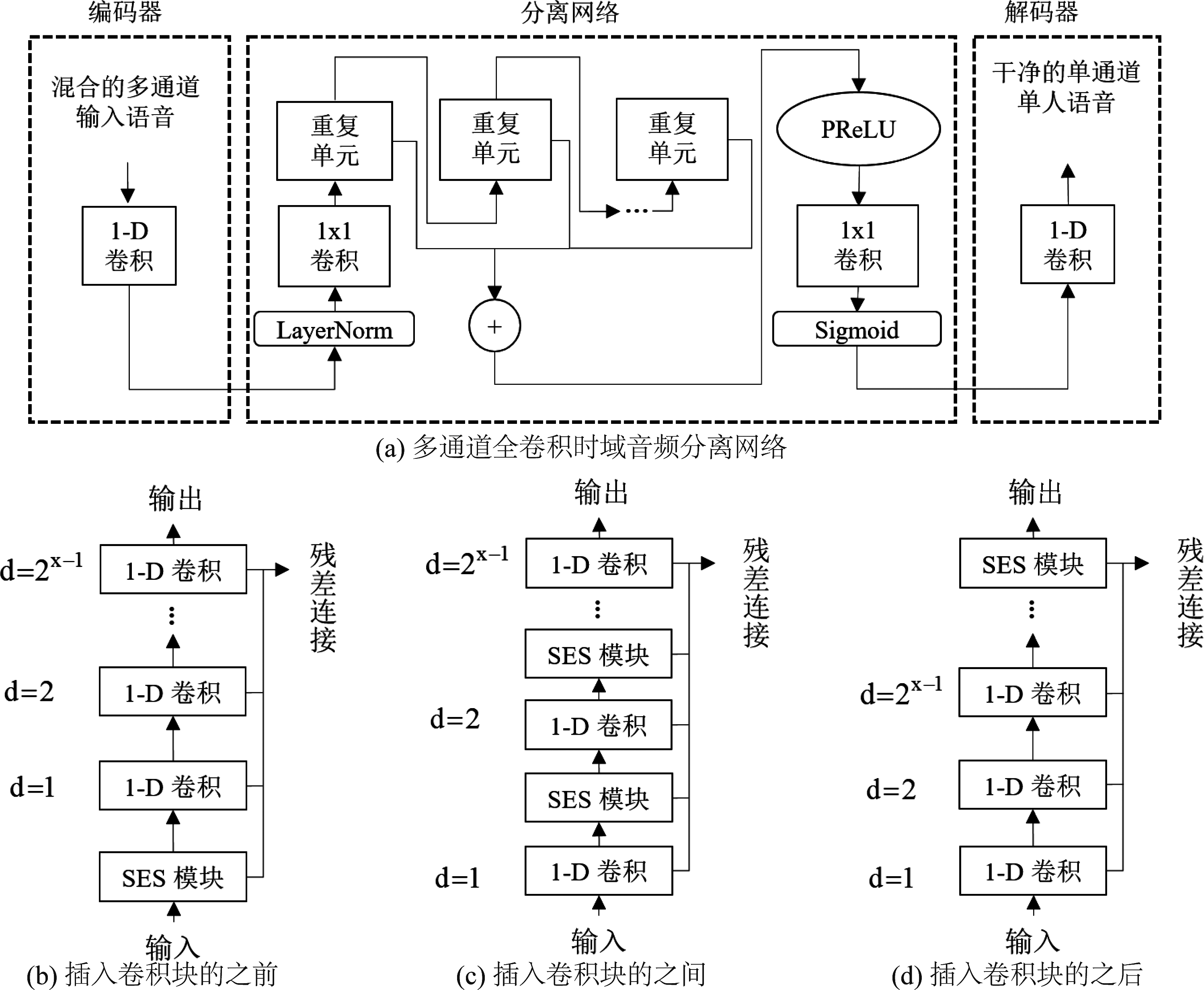

从表1可以看出,直接利用卷积将单通道全卷积时域语音分离网络扩展到多通道系统,性能有所提升,说明多通道数据具有有效的空间线索,有助于推断说话人信息从而提高语音分离。在本文的实验里,压缩激励脊髓模块的三种应用方式中,rear-SES方式最优, front-SES方式次之,inter-SES最差。相比rear-SES方式, front-SES可能由于学习特征不完全充分所以结果未达到最优,而inter-SES方式可能会导致对通道关系的过度学习,因而这种方式还有很大的调整空间来改善结果。与全连接层和卷积层两种构造瓶颈结构的方式相比,脊髓网络促进了激励阶段中对全局通道数据分布情况的捕获,从而利用通道间的差异,进而显著地提升了分离性能,可媲美最新的多通道FaSNet-TAC模型。卷积网络在从波形中学习方面具有很大的潜力,当使用1-D卷积代替短时傅里叶变换作为编解码器对整个网络进行端到端的训练时,基于掩蔽的方式并不优于直接将分离网络输出作为估计源的基于输出的方法,这是一个值得进一步探究的问题。

表1 自组织麦克风双语音分离实验结果

Tab.1 Experiments Results on Ad-hoc Microphones

with Two Speakers

模型平均结果SDRSISDRPESQSTOIUnprocessed Mixture-0.33-0.401.340.75Conv-TasNet[8]6.095.331.720.812ch Conv-TasNet+front-SES+front-SES+DO+inter-SES+inter-SES+DO+rear-SE+FC+rear-SE+FC+DO+rear-SE+Conv+rear-SE+Conv+DO+rear-SES+rear-SES+DO+DO7.508.238.217.567.407.808.247.668.017.938.348.496.847.497.446.906.697.087.466.957.207.207.567.731.791.861.851.811.781.821.861.801.841.851.871.870.820.840.830.820.800.830.850.820.840.840.850.853ch Conv-TasNet+rear-SES+DO7.558.456.877.691.811.870.820.862ch FaSNet-TAC[10]3ch FaSNet-TAC8.218.327.487.531.851.860.840.85

4 结论

针对自组织麦克风网络,本文提出的压缩激励脊髓模块,不依赖于麦克风的位置与几何结构,能够捕捉跨通道的信息,建模通道间的相互依赖关系,以较低的计算代价显著提升语音分离的性能。本文在仿真的LibriSpeech多通道混响数据集的测试实验中,和单通道基线相比获得显著性能的提升,证明所提出方法的有效性。同时,实验也表明了以端到端方式训练网络时直接将网络输出作为分离目标的估计不逊色与基于掩蔽的方法。对于自组织麦克风网络而言,本文还有一些后续问题有待解决。比如当某个麦克风节点缺失时,分离系统需要保证这种可变通道输入的鲁棒性和稳定性。对于应用场景而言,本文所提出的方法是基于注意力的思想,与多模态语音增强与分离系统有一定的兼容性,有利于未来进一步的结合使用。

[1] HAYKIN S, CHEN Zhe. The cocktail party problem[J]. Neural Computation, 2005, 17(9): 1875-1902.

[2] LIU Yuzhou, WANG Deliang. Divide and conquer: A deep CASA approach to talker-independent monaural speaker separation[J]. IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2019, 27(12): 2092-2102.

[3] LE ROUX J, HERSHEY J R, WENINGER F. Deep NMF for speech separation[C]∥2015 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). South Brisbane, QLD, Australia. IEEE, 2015: 66-70.

[4] HERSHEY J R, CHEN Zhuo, LE ROUX J, et al. Deep clustering: Discriminative embeddings for segmentation and separation[C]∥2016 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). Shanghai, China. IEEE, 2016: 31-35.

[5] KOLB☞K M, YU Dong, TAN Zhenghua, et al. Multitalker speech separation with utterance-level permutation invariant training of deep recurrent neural networks[J]. IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2017, 25(10): 1901-1913.

[6] CHEN Zhuo, LUO Yi, MESGARANI N. Deep attractor network for single-microphone speaker separation[C]∥2017 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). New Orleans, LA, USA. IEEE, 2017: 246-250.

[7] LUO Yi, MESGARANI N. TaSNet: time-domain audio separation network for real-time, single-channel speech separation[C]∥2018 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). Calgary, AB, Canada. IEEE, 2018: 696-700.

[8] LUO Yi, MESGARANI N. Conv-TasNet: Surpassing ideal time-frequency magnitude masking for speech separation[J]. IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2019, 27(8): 1256-1266.

[9] LUO Yi, HAN Cong, MESGARANI N, et al. FaSNet: low-latency adaptive beamforming for multi-microphone audio processing[C]∥2019 IEEE Automatic Speech Recognition and Understanding Workshop (ASRU). Singapore. IEEE, 2019: 260-267.

[10]LUO Yi, CHEN Zhuo, MESGARANI N, et al. End-to-end microphone permutation and number invariant multi-channel speech separation[C]∥ICASSP 2020-2020 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). Barcelona, Spain. IEEE, 2020: 6394- 6398.

[11]GU Rongzhi, ZHANG Shixiong, CHEN Lianwu, et al. Enhancing end-to-end multi-channel speech separation via spatial feature learning[C]∥ICASSP 2020-2020 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). Barcelona, Spain. IEEE, 2020: 7319-7323.

[12]GU Rongzhi, WU Jian, ZHANG Shixiong, et al. End-to-end multi-channel speech separation[J]. arXiv:1905.06286, 2019.

[13]BERTRAND A. Applications and trends in wireless acoustic sensor networks: A signal processing perspective[C]∥2011 18th IEEE Symposium on Communications and Vehicular Technology in the Benelux (SCVT). Ghent, Belgium. IEEE, 2011: 1- 6.

[14]HU Jie, SHEN Li, SUN Gang. Squeeze-and-excitation networks[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City, UT, USA. IEEE, 2018: 7132-7141.

[15]KABIR H M D, ABDAR M, JALALI S M J, et al. SpinalNet: deep neural network with gradual input[J]. arXiv:2007.03347, 2020.

[16]PANAYOTOV V, CHEN Guoguo, POVEY D, et al. Librispeech: An ASR corpus based on public domain audio books[C]∥2015 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). South Brisbane, QLD, Australia. IEEE, 2015: 5206-5210.

[17]HU Guoning, WANG Deliang. A tandem algorithm for pitch estimation and voiced speech segregation[J]. IEEE Transactions on Audio, Speech, and Language Processing, 2010, 18(8): 2067-2079.

[18]ALLEN J B, BERKLEY D A. Image method for efficiently simulating small-room acoustics[J]. The Journal of the Acoustical Society of America, 1979, 65(4): 943-950.

[19]VINCENT E, GRIBONVAL R, FEVOTTE C. Performance measurement in blind audio source separation[J]. IEEE Transactions on Audio, Speech, and Language Processing, 2006, 14(4): 1462-1469.

[20]ROUX J L, WISDOM S, ERDOGAN H, et al. SDR-half-baked or well done?[C]∥ICASSP 2019-2019 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). Brighton, UK. IEEE, 2019: 626- 630.