1 引言

近年来,随着合成孔径雷达(Synthetic Aperture Radar, SAR)的分辨率不断提高,SAR目标在图像上呈现出更加精细的结构特性,目标间甚至是同一目标的不同型号间差异性更加明显,有助于SAR目标分类精度的提升。因此SAR目标分类技术尤其是高分辨率SAR图像中目标具体型号的分类技术已成为SAR图像解译的热点内容。

SAR目标分类技术主要分为特征提取和分类两个阶段:首先从训练样本中提取有效的目标特征,随后学习合适的分类策略和识别工具,进而对大量测试样本实现分类识别。目前常用于SAR目标的特征包括散射中心特征[1-2]、几何特征[3-4],或是利用主成分分析[5]、线性鉴别分析[5]、非负矩阵分解[6]等能实现图像压缩降维的模式识别领域特征,以及傅里叶变换、小波分解、单演信号[7]、Gabor滤波[8]等信号分解算法提取的SAR图像变换域特征。其中变分模态分解[9]就是一种具有较好抗噪能力的信号分解算法,已成功应用于机械故障诊断、语音信号分析等领域。为了将其应用在图像处理领域,Dragomiretskiy等人将变分模态分解改进为二维变分模态分解[10] (Two Dimensional Variational Mode Decomposition,2D-VMD)。2D-VMD是一种非递归的、自适应的、变分的信号分解模型,它以最小参数和不显式插值的数学良好方式,将图像分解为多个不同中心频率的模态,分别反映出图像中的区域、边缘等变换域特征信息[11]。基于2D-VMD各子模态能表征SAR目标不同信息的特性,本文将2D-VMD与双向二维主成分分析((2D)2PCA)降维算法结合,提出一种多模态(2D)2PCA特征,有效描述SAR目标的区域及边缘特征。

SAR目标分类算法大致可分为传统分类方法和深度学习方法。传统分类方法如模板匹配识别、K-近邻、贝叶斯[12]、支持向量机[13] (Support Vector Machine, SVM)等,大多利用了SAR图像概率分布等先验知识,算法性能受SAR数据噪声等成像质量和分类器参数设置影响较大;深度学习方法[15-16]以卷积神经网络[14](Convolutional Neural Network, CNN)为代表,网络性能严重依赖于大规模且样本均衡的数据集。近年来,稀疏表示分类[17](Sparse Representation-based Classification, SRC)在人脸识别[18]、目标分类[19]及图像超分辨率等研究方面表现出了良好的性能,SRC通过训练样本线性表达测试样本,利用编码系数的稀疏性对测试样本进行分类[20]。但SRC要求每一类的训练样本必须构成完备字典,且需求解带约束条件的 1范数最小化问题,求解模型较复杂。Zhang等人[21]利用

1范数最小化问题,求解模型较复杂。Zhang等人[21]利用 2范数代替SRC模型中的

2范数代替SRC模型中的 1范数使模型具有闭合解,提出了基于协同表示的分类(Cooperative Representation Classification,CRC)方法,在与SRC识别率相近的同时极大地减少了运算量,同时CRC强调所有类别训练样本对测试样本的贡献[22],增强了测试样本与同类训练样本之间的相关性,在人脸识别[23-24]、高光谱图像分类[25]等领域验证了其分类的鲁棒性。

1范数使模型具有闭合解,提出了基于协同表示的分类(Cooperative Representation Classification,CRC)方法,在与SRC识别率相近的同时极大地减少了运算量,同时CRC强调所有类别训练样本对测试样本的贡献[22],增强了测试样本与同类训练样本之间的相关性,在人脸识别[23-24]、高光谱图像分类[25]等领域验证了其分类的鲁棒性。

基于CRC的上述优势,本文提出了一种基于多模态联合协同表示的SAR车辆目标分类方法,包括特征提取和分类两个阶段。首先提取多模态下的(2D)2PCA特征,利用不同模态表征的区域特征和边界特征,对原始SAR图像的特征信息进行补充;接着在分类阶段将CRC[21]扩展为多模态联合协同表示分类器(JMCRC),通过原始图像和各模态分类任务的结合,提升分类器分类性能。

2 多模态(2D)2PCA特征

2.1 二维变分多模态分解

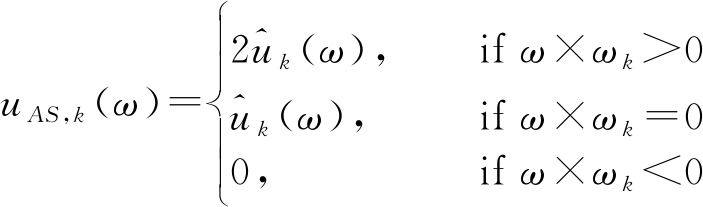

一维信号单边解析信号通过抑制负频率可以获得。扩展至二维时,为了获得单边的二维解析信号,需将频域的一个半平面设为零,记这个分界面为向量ω,由此我们可以在频域上定义二维解析信号:

(1)

经傅里叶变换的二维解析信号可表示为:

uAS,k(x)=uk(x)*![]()

(2)

其中,*表示卷积并且变换是可分的。解析信号沿参考方向ωk的直线分别独立计算,因此式(2)本质上是一维的,同时具有理想二维傅里叶特性。

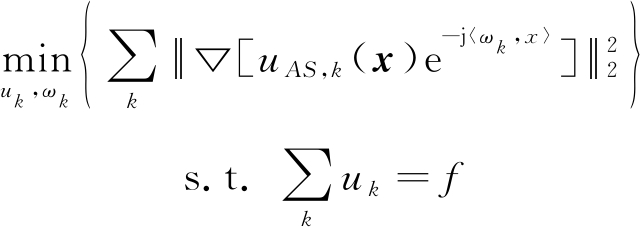

根据二维解析信号的定义,需最小化的目标函数为:

(3)

为求取式(3)约束性变分问题的最优解,添加拉格朗日乘法算子λ和二次惩罚因子α,将式(3)扩展为式(4)所示的拉格朗日形式的非约束变分问题:

![]()

![]()

(4)

对于式(4)的非约束变分问题,文献[10]采用乘法算子交替方向法(ADMM)迭代优化![]() 求得的拉格朗日表达式的鞍点即为式(3)的最优解,从而将图像分解为K个不同中心频率的子模态和1个高频余量。

求得的拉格朗日表达式的鞍点即为式(3)的最优解,从而将图像分解为K个不同中心频率的子模态和1个高频余量。

2.2 (2D)2PCA特征提取

主成分分析(Principal Component Analysis, PCA)通过把样本空间转变为分量互不相关的特征空间,提取特征空间中对方差贡献最大的主要特征,达到降低样本数据维度的目的,广泛应用于计算机视觉及模式识别领域。(2D)2PCA是在PCA的基础上发展出来的。相对于传统的PCA,(2D)2PCA不用将图像向量化,而是直接基于图像矩阵进行处理。给定样本集合X,(2D)2PCA 具体步骤如下:

对于行映射形式Y1=XA,A为一组正交基构成的投影矩阵,Y1为原始样本X经A映射后的结果,行变换对应的总体散布矩阵Gt,r为:

(5)

对于列映射形式Y2=XB,B为一组正交基构成的投影矩阵,Y2为原始样本X经B映射后的结果,列变换对应的总体散布矩阵Gt,l为:

(6)

分别计算散布矩阵Gt,r、Gt,l的特征值和特征向量,取特征值累积贡献率0.9以上的特征向量分别构成投影矩阵A、B,因此原始样本联合映射形式为:

Y=BTXA

(7)

Y即为原始样本集合映射后的(2D)2PCA特征,最大程度保留了原始样本数据信息。

3 多模态联合协同表示分类器

协同表示的核心思想是在各类子空间中,用训练样本协同编码测试样本,通过测试样本与各类训练样本的残差大小对测试样本进行分类。假设有C类训练样本![]() 其中

其中![]() 表示训练样本在第k模态下第i类的N个训练样本子集,k=0,1,...,K,K为样本模态数,k=0时代表原始图像。对任一待测样本y=[y(0),y(1),…,y(K)],可以用所有训练样本的线性组合协同表示为y=Xα,α=[α1 α2 …αC]Τ为协同表示的编码向量。根据协同表示理论, JMCRC模型定义为:

表示训练样本在第k模态下第i类的N个训练样本子集,k=0,1,...,K,K为样本模态数,k=0时代表原始图像。对任一待测样本y=[y(0),y(1),…,y(K)],可以用所有训练样本的线性组合协同表示为y=Xα,α=[α1 α2 …αC]Τ为协同表示的编码向量。根据协同表示理论, JMCRC模型定义为:

(8)

其中,λ为正则化参数。令式(8)关于α的导数为0,易求得其封闭解:

(9)

则样本y与类别i在第k模态下的残差为:

(10)

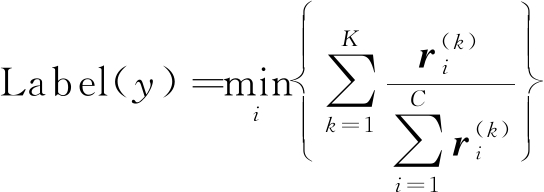

本文使用的多模态联合协同表示分类器主要在残差融合策略上进行改进。JMCRC模型认为原始图像与各子模态的特征在分类任务中同等重要,单独基于某一模态特征的分类残差进行分类可能会导致错误的结果,因此必须联合考虑各模态下样本y与类别i的分类残差。基于上述理论本文改进的JMCRC将样本y的类标签定义为原始图像与各模态归一化残差和最小的类,即测试样本y的类标签表示为:

(11)

4 SAR图像车辆目标多模态协同表示分类方法

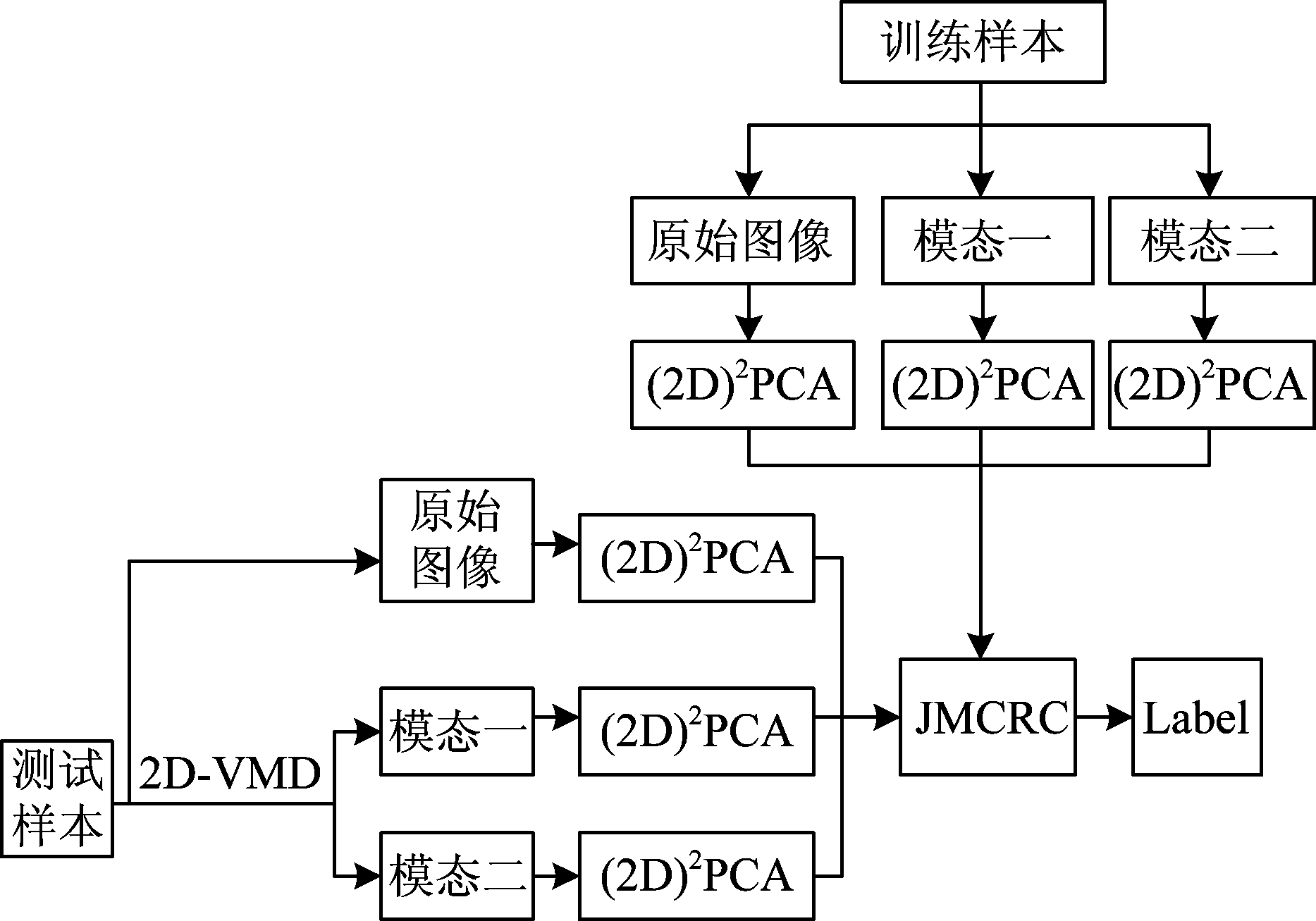

本文提出的SAR图像车辆目标分类算法具体流程如图1所示。

图1 本文算法流程图

Fig.1 Algorithm flow chart in this paper

(1)预处理阶段:对于所有类别的SAR车辆目标样本,进行中心截取或补零操作,将切片大小统一调整为128×128像素。

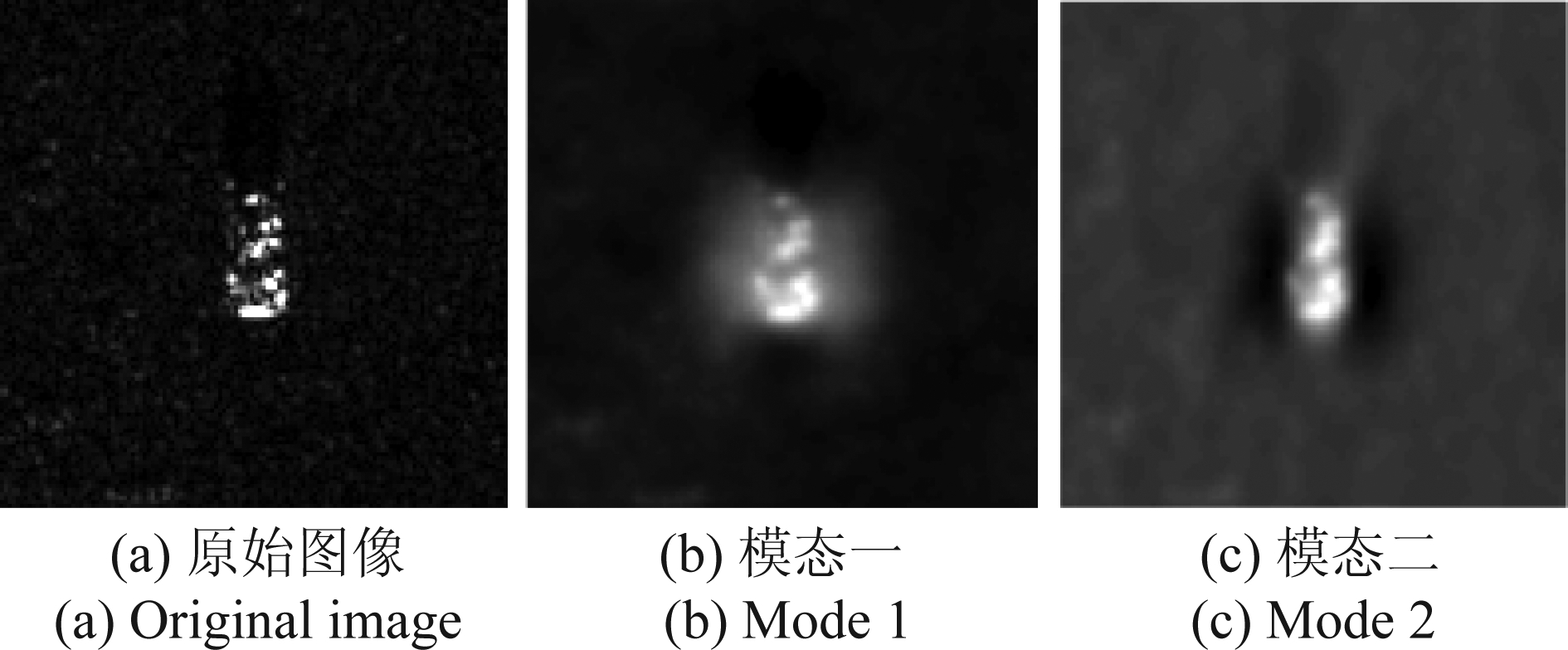

(2)特征提取阶段:首先利用2D-VMD依次将SAR车辆目标图像数据(如MSTAR数据)分解为具有不同中心频率的多个子模态分量和一个高频噪声余量,如图2所示,不同中心频率下的子模态图像能层次化地反映SAR车辆目标切片的不同特征信息:模态一主要反映目标的区域信息(图2(b)),模态二则反映目标的边缘等细节信息(图2(c))。接着分别提取原始图像及各子模态的40×40维(2D)2PCA特征,组合成1600×N维特征向量,作为分类器的输入。

图2 MSTAR数据BMP2车辆目标模态分解结果

Fig.2 BMP2 Vehicle target of MSTAR data mode decomposition results

(3)分类阶段:首先基于式(8)的JMCRC模型分别对特征提取阶段得到的各模态下样本的特征向量进行协同表示,接着依据式(9)~(10)求得各模态下利用各类别训练样本协同表示的待分类样本y的编码向量α与归一化残差系数![]() 最后根据式(11)的多模态残差融合策略求得待分类样本y的标签Label(y),Label(y)代表的类别即为样本y的分类结果。

最后根据式(11)的多模态残差融合策略求得待分类样本y的标签Label(y),Label(y)代表的类别即为样本y的分类结果。

5 实验与分析

5.1 实验数据

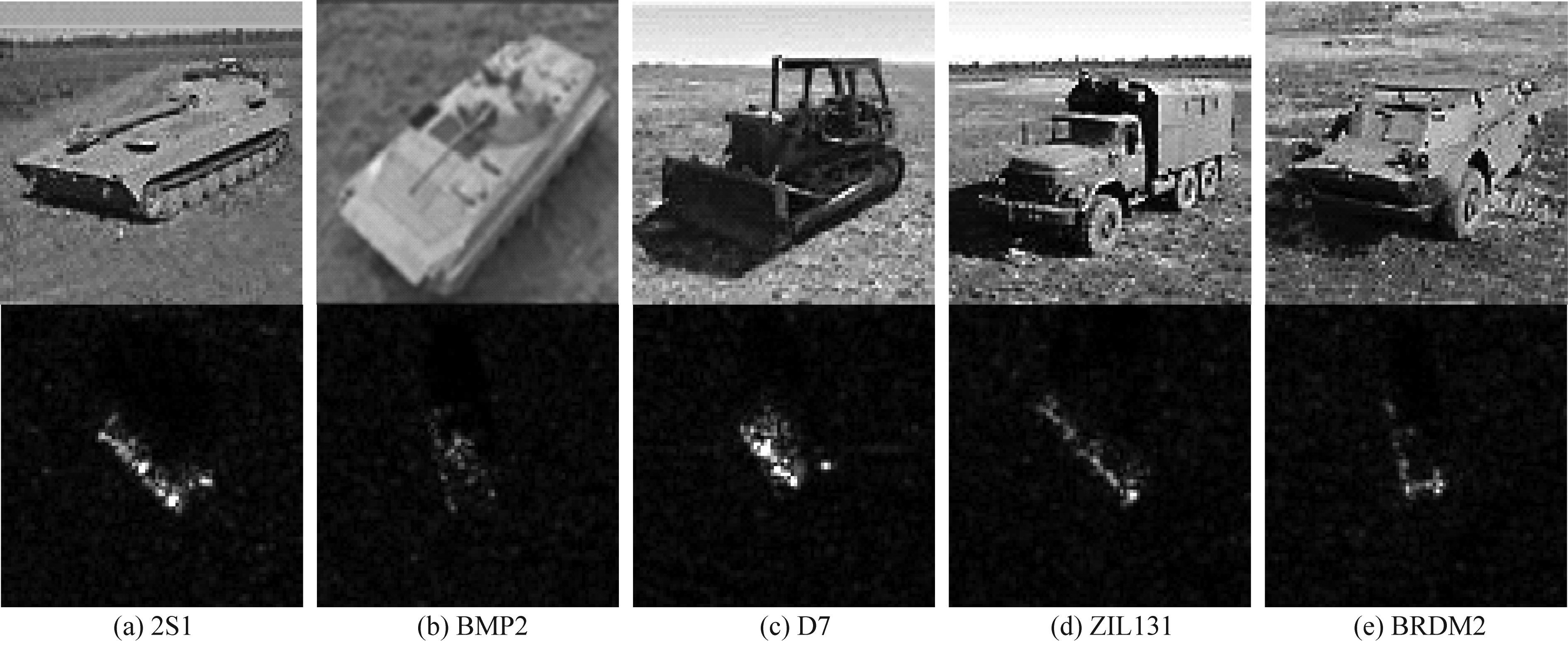

实验数据采用MSTAR实测数据集和国内某实测数据,其中MSTAR实测数据集包含X波段下不同俯仰角的10类车辆目标,图像分辨率0.3 m×0.3 m。10类车辆目标切片的光学图像和SAR图像如图3所示。为验证本文算法的有效性,分别对标准扩展条件(SOC)和型号变化、俯仰角变化、样本不平衡三种扩展条件下的SAR车辆目标进行分类实验,并与现有的典型SAR目标分类算法进行对比,包括KNN,基于PCA的SVM[13]算法,SRC以及基于单演信号的分类算法[7]。

图3 MSTAR数据集10类目标光学及SAR图像

Fig.3 10 types of optical and SAR images of targets of MSTAR dataset

5.2 SOC条件

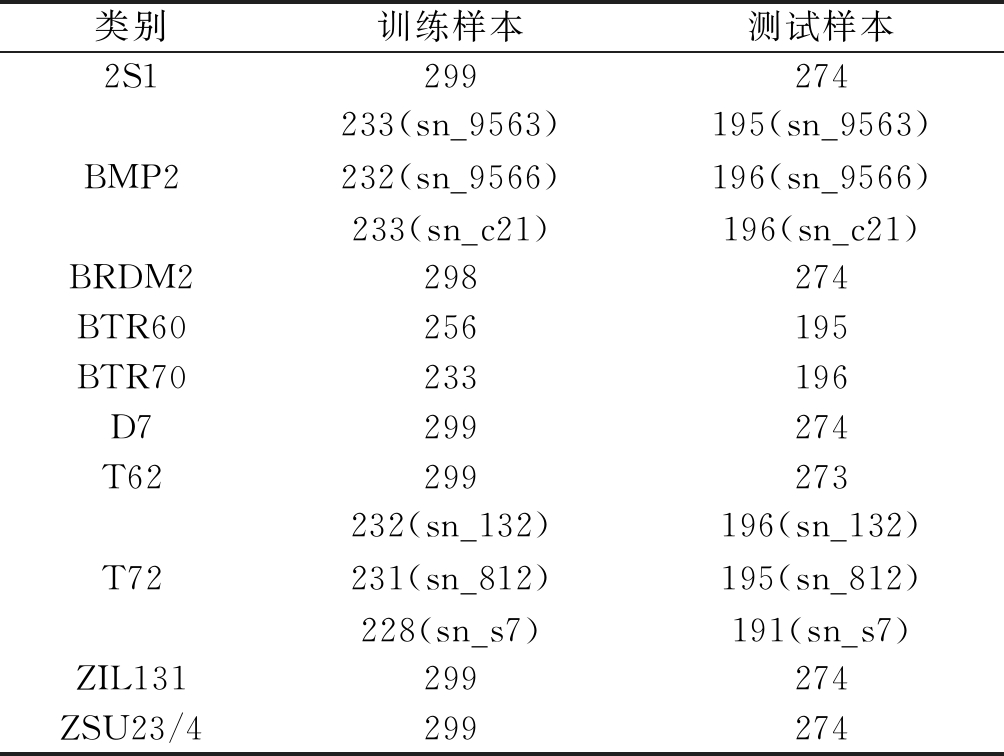

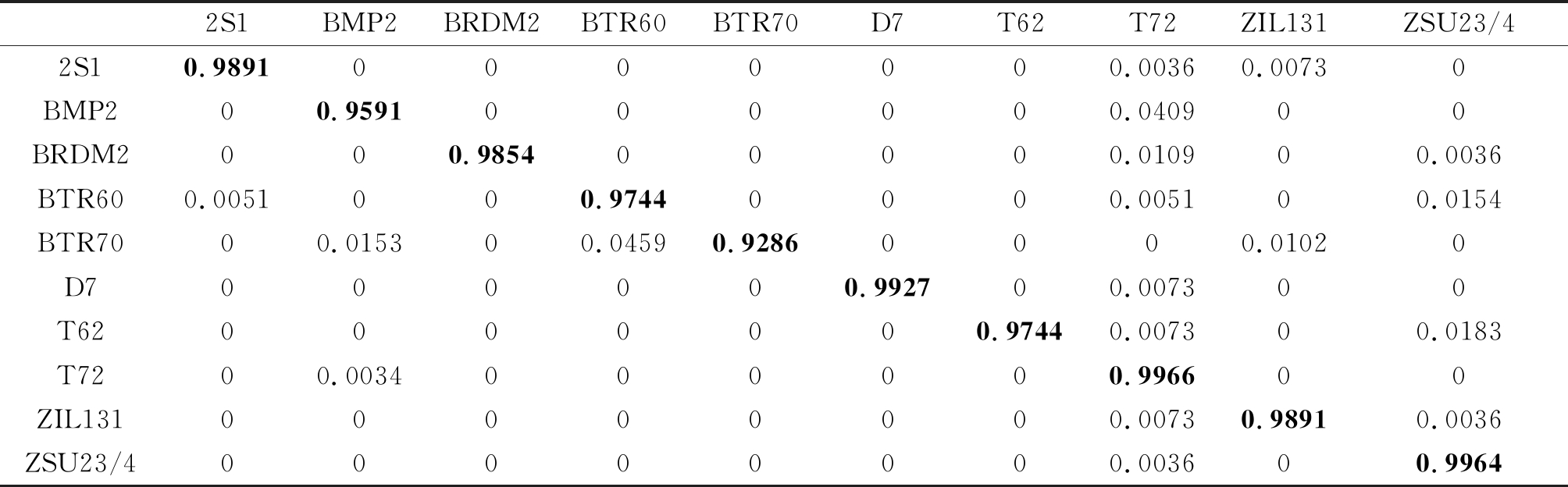

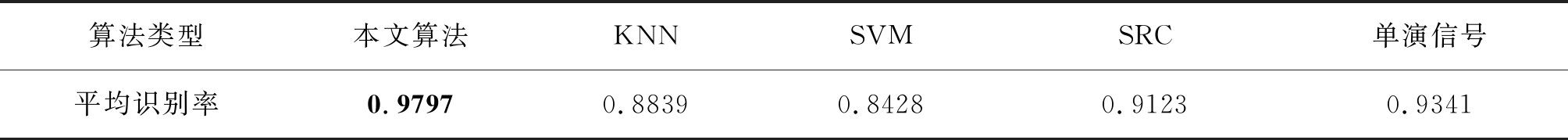

本文SOC条件下训练集和测试集分别采用俯仰角为17°和15°下的10类目标的MSTAR数据,具体实验数据设置如表1所示,其中每一类的训练样本和测试样本均包含所有的子型号,相比于仅使用单一型号增加了识别难度。本文算法得到的混淆矩阵显示在表2,10类目标的平均识别精度为97.97%。与其他典型目标分类算法的对比如表3所示,可以看出本文算法在SOC条件下的识别结果明显优于其他典型分类方法,充分说明了本文算法对于SOC条件下MSTAR车辆目标分类的有效性。

表1 本文SOC实验条件数据情况

Tab.1 Experiment Data under SOC experimental conditions in this paper

类别训练样本测试样本2S1299274BMP2233(sn_9563)232(sn_9566)233(sn_c21)195(sn_9563)196(sn_9566)196(sn_c21)BRDM2298274BTR60256195BTR70233196D7299274T62299273T72232(sn_132)231(sn_812)228(sn_s7)196(sn_132)195(sn_812)191(sn_s7)ZIL131299274ZSU23/4299274

表2 SOC实验条件下本文算法混淆矩阵

Tab.2 Confusion matrix of the proposed algorithm under SOC experimental conditions

2S1BMP2BRDM2BTR60BTR70D7T62T72ZIL131ZSU23/42S10.98910000000.00360.00730BMP200.9591000000.040900BRDM2000.985400000.010900.0036BTR600.0051000.97440000.005100.0154BTR7000.015300.04590.92860000.01020D7000000.992700.007300T620000000.97440.007300.0183T7200.0034000000.996600ZIL13100000000.00730.98910.0036ZSU23/400000000.003600.9964

表3 SOC实验条件下各类算法识别率比较

Tab.3 Comparison of recognition rates of various algorithms under SOC experimental conditions

算法类型本文算法KNNSVMSRC单演信号平均识别率0.97970.88390.84280.91230.9341

5.3 型号变化

在实际场景中,同类目标通常存在不同型号的变体或者安装了不同挂载物。这些变体间主体结构相似,仅在具体细节配置上存在差异,如坦克目标是否装备油箱,天线是否展开;装甲车目标是否装备导弹、火炮等。因此,对车辆目标进行精准的型号识别有重要的研究意义。本节设置了两组实验,实验一选择四类目标共8种具体型号,实验二选择T72目标的5种子型号,来完成两组SAR车辆目标型号分类实验。

5.3.1 4类目标的型号识别

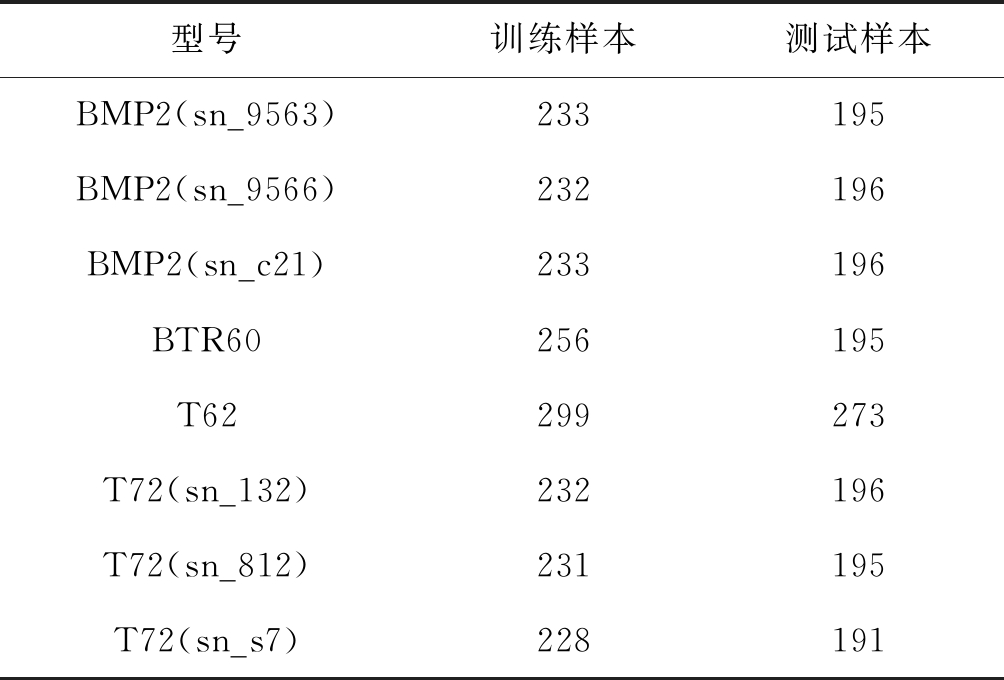

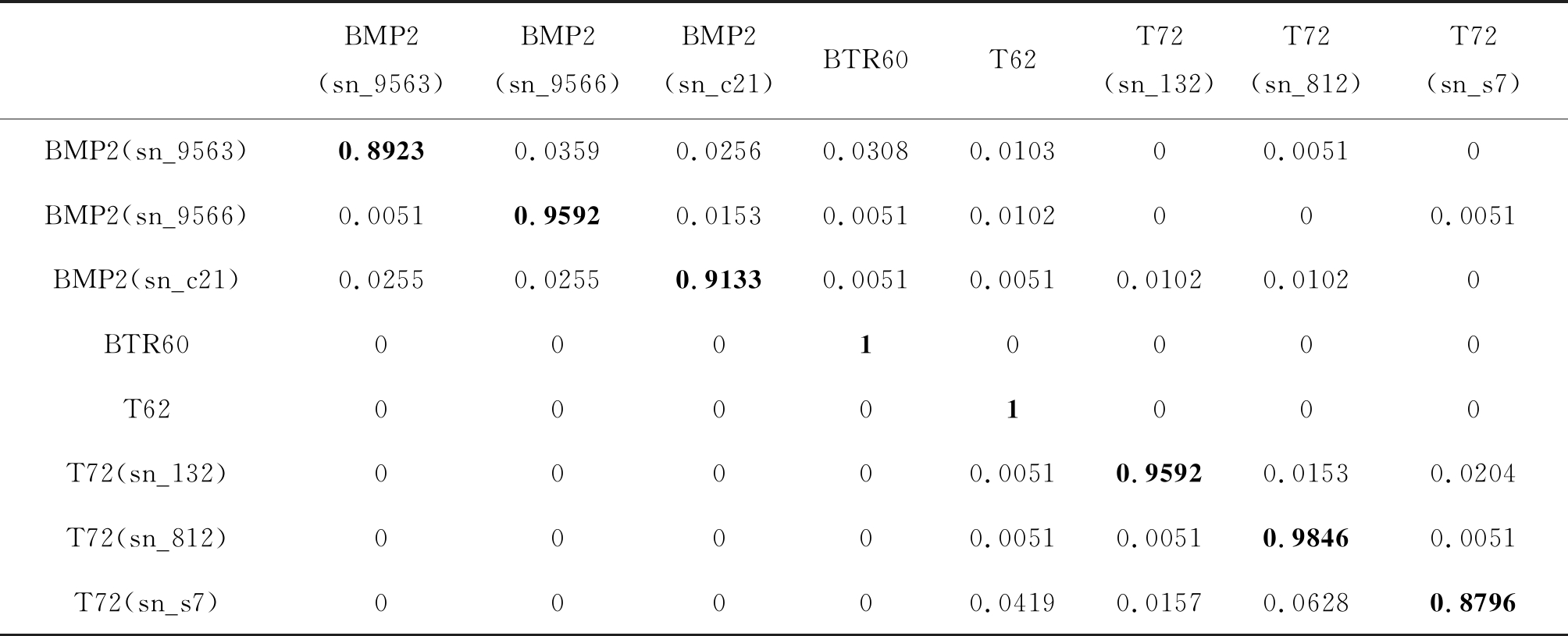

训练样本和测试样本分别为俯仰角17°和15°下的BMP2、BTR60、T72、T62四类目标,如表4所示,其中BMP2、T72两类目标各包含三种不同的型号变体,同时为加大型号变化识别难度,加入BTR60/BMP2和T72/T62两组散射特性相似的目标。BMP2为步兵战车,BTR60为装甲运输车,T72和T62为主战坦克,两两在SAR图像上具有相似的散射表现[7]。本文算法得到的混淆矩阵显示在表5,4类目标共计8种子型号的平均识别率为95.11%,与典型算法的对比如表6所示,可以看出本文算法在当前条件下的平均识别率明显优于其他算法。

表4 4类目标的型号识别实验条件数据情况

Tab.4 Model recognition experimental condition data under the 4 types of targets

型号训练样本测试样本BMP2(sn_9563)233195BMP2(sn_9566)232196BMP2(sn_c21)233196BTR60256195T62299273T72(sn_132)232 196T72(sn_812)231195T72(sn_s7)228191

表5 4类目标的型号分类实验条件下本文算法混淆矩阵

Tab.5 Confusion matrix of the algorithm presented in this paper under the experimental conditions of model recognition for 4 types of targets

BMP2(sn_9563)BMP2(sn_9566)BMP2(sn_c21)BTR60T62T72(sn_132)T72(sn_812)T72(sn_s7)BMP2(sn_9563)0.89230.03590.02560.03080.010300.00510BMP2(sn_9566)0.00510.95920.01530.00510.0102000.0051BMP2(sn_c21)0.02550.02550.91330.00510.00510.01020.01020BTR6000010000T6200001000T72(sn_132)00000.00510.95920.01530.0204T72(sn_812)00000.00510.00510.98460.0051T72(sn_s7)00000.04190.01570.06280.8796

表6 4类目标的型号分类实验条件下各类算法识别率比较

Tab.6 Comparison of recognition rates of various algorithms under model recognition experimental conditions for 4 types of targets

算法类型本文算法SVM单演信号平均识别率0.95110.82650.85335

5.3.2 T72目标型号分类

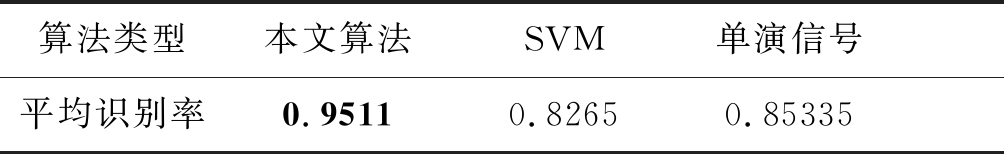

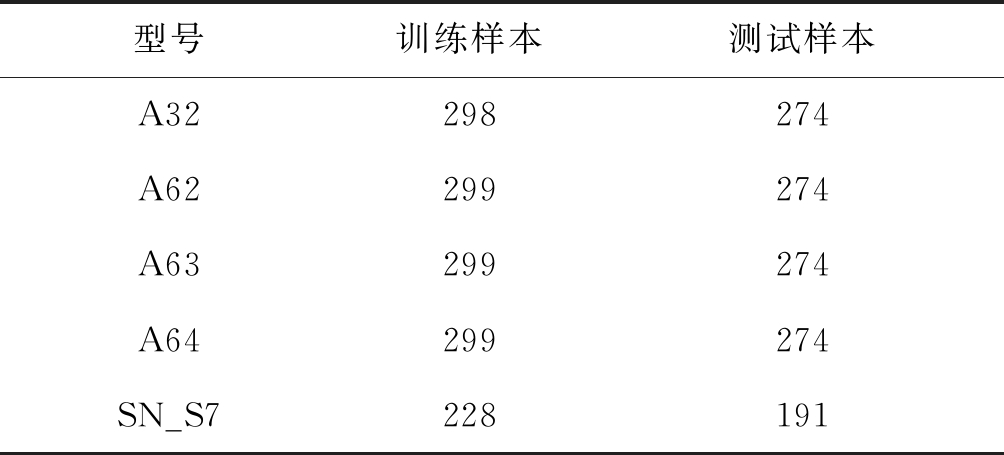

T72数据集内不同子型号识别实验条件设置如表7所示,训练样本和测试样本分别为俯仰角17°和15°下T72目标的A32、A62、A63、A64、SN_S7五种子型号。本文算法对T72目标五种子型号识别结果的混淆矩阵如表8所示,平均识别率为98.37%,显著高于表9中其他经典算法的识别结果。

表7 T72目标的五种具体型号识别实验条件数据情况

Tab.7 Experimental data under five specific types recognition for T72 target

型号训练样本测试样本A32298274A62299274A63299274A64299274SN_S7228191

表8 T72目标的五种子型号识别实验条件下本文算法混淆矩阵

Tab.8 Confusion matrix in this paper under the experimental conditions of five specific type recognition of T72 target

型号A32A62A63A64SN_S7A320.98540.00360.00360.00730A6200.99640.003600A6300.00360.996400A640.01090.021900.95990.0073SN_S700.010500.01050.9791

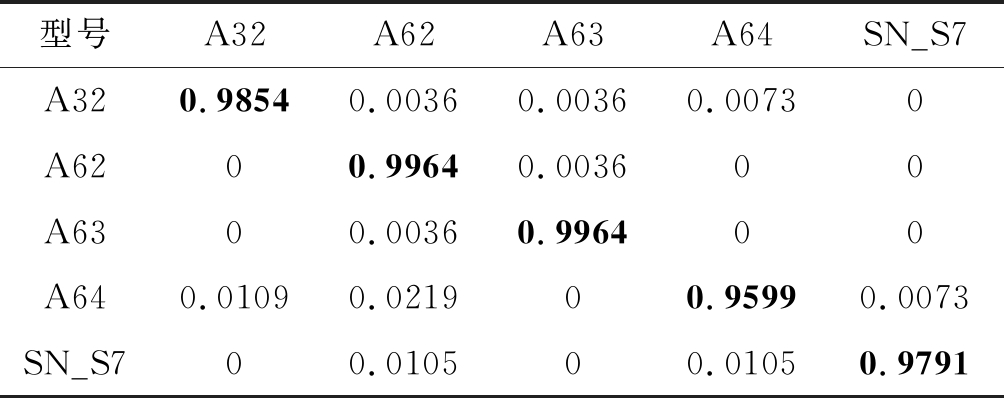

表9 T72目标的五种具体型号识别实验条件下各类算法识别率比较

Tab.9 Comparison of recognition rates of various algorithms under the experimental conditions of five specific model recognition of T72 target

算法类型本文算法SVM单演信号平均识别率0.98370.67990.9627

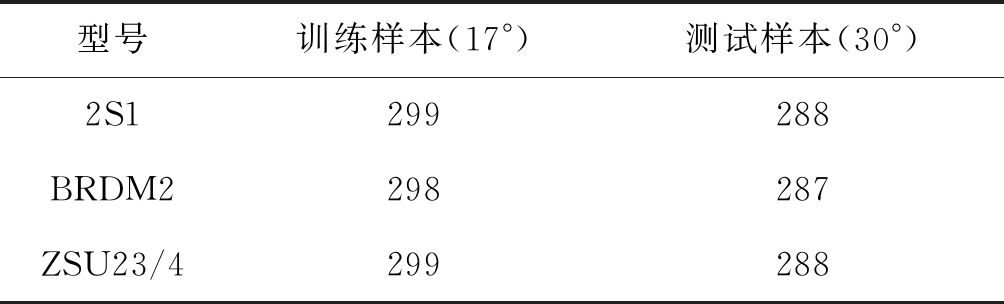

5.4 俯仰角变化条件

受SAR成像特性影响,不同俯仰角下样本成像有明显差异,且俯仰角变化越大样本间相似度越低。为验证本文算法在俯仰角变化下的鲁棒性,设置俯仰角变化下的目标识别实验,训练集和测试集分别采用俯仰角为17°和30°下的3类目标,数据情况如表10所示。本文算法在俯仰角变化下取得99.42%的识别率,混淆矩阵显示在表11,远高于表12所示的其他算法,验证了本文算法在俯仰角变化情况下的识别性能。

表10 俯仰角变化实验条件下数据情况

Tab.10 Experimental condition data of depression angle variance

型号训练样本(17°)测试样本(30°)2S1299288BRDM2298287ZSU23/4299288

表11 俯仰角变化实验条件下本文算法混淆矩阵

Tab.11 Confusion matrix in this paper under the experimental conditions of depression angle variance

型号2S1BRDM2ZSU23/42S10.98610.01390BRDM200.99650.0035ZSU23/4001

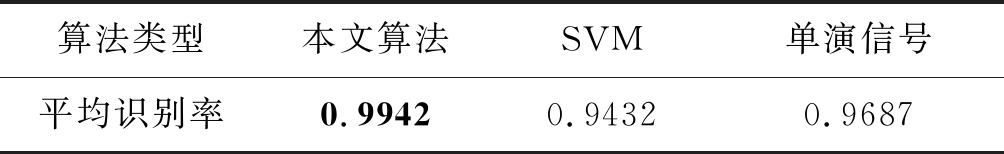

表12 俯仰角变化实验条件下各类算法识别率比较

Tab.12 Comparison of recognition rates of various algorithms under the experimental conditions of depression angle variance

算法类型本文算法SVM单演信号平均识别率0.99420.94320.9687

5.5 样本不平衡条件

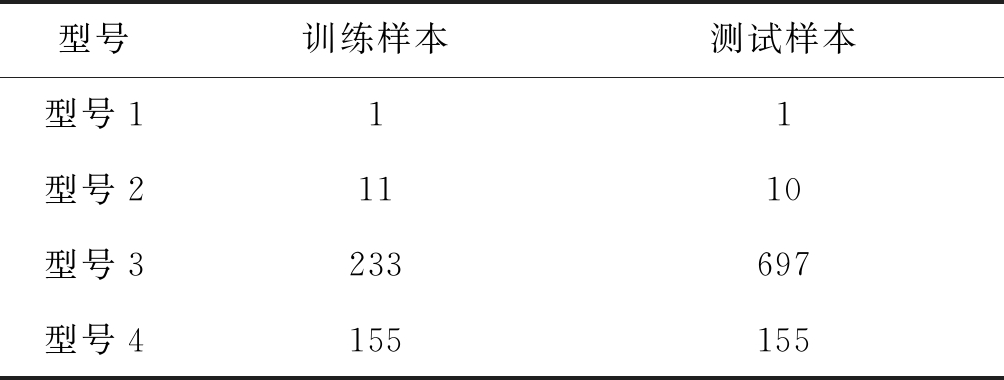

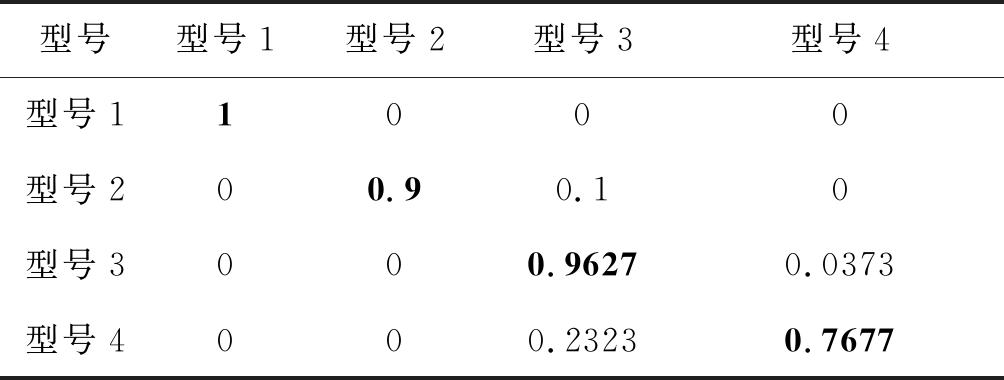

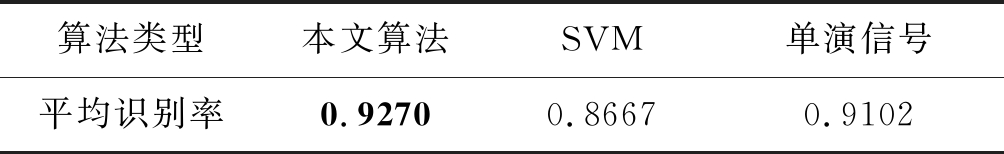

类别不平衡是指分类任务中不同类别的训练样本数目差别很大的情况。考虑到SAR车辆目标实测数据中,往往存在各类别样本数据不平衡的情况,而这样的不平衡情况使得分类器泛化能力较差的问题。本文在样本严重不平衡的实测数据集上进行实验,数据集中包含四种型号的车辆目标样本各2个、21个、310个、930个,均来自X波段实测SAR数据,空间分辨率0.5 m×0.5 m。实验中训练样本和测试样本的具体划分如表13所示。表14为本文算法在不平衡条件下的混淆矩阵,平均识别率为92.7%,优于表15所示的其他算法。

表13 样本不均衡实验条件下数据情况

Tab.13 Experimental condition data of sample unbalanced

型号训练样本测试样本型号111型号21110型号3233697型号4155155

表14 样本不均衡实验条件下本文算法混淆矩阵

Tab.14 Confusion matrix in this paper under the experimental conditions of sample unbalanced

型号型号1型号2型号3型号4型号11000型号200.90.10型号3000.96270.0373型号4000.23230.7677

表15 样本不均衡实验条件下各类算法识别率比较

Tab.15 Comparison of recognition rates of various algorithms under the experimental conditions of sample unbalanced

算法类型本文算法SVM单演信号平均识别率0.92700.86670.9102

6 结论

本文提出了一种SAR图像车辆目标多模态联合协同表示分类方法,利用2D-VMD技术提取能分别表征SAR图像车辆目标区域特征和边缘特征的子模态,扩展SAR图像的多模态信息,结合(2D)2PCA提取各子模态的主成分特征,在保留各模态信息的同时降低特征维度减少运算量。将协同表示分类改进为能联合表征各模态特征的多模态联合协同表示分类,从而提升了分类器性能。设置了多组实验,分别在SOC条件、两种型号差异条件、俯仰角变化和样本不平衡条件下进行,实验验证本文算法对MSTAR数据集和某实测数据集实现分类,分别取得了97.97%、95.11%、98.37%、99.42%和92.7%的平均识别率,显著高于其他算法,表明了本文算法的优异性能。

[1] 丁柏圆, 文贡坚, 余连生, 等. 属性散射中心匹配及其在SAR目标识别中的应用[J]. 雷达学报, 2017, 6(2):157-166.

DING Baiyuan, WEN Gongjian, YU Liansheng, et al. Matching of attributed scattering center and its application to synthetic aperture radar automatic target recognition[J]. Journal of Radars, 2017, 6(2):157-166.(in Chinese)

[2] 唐涛,粟毅. 散射中心特征序贯匹配的SAR图像目标识别方法[J]. 系统工程与电子技术, 2012,34(6): 1131-1135.

TANG Tao, SU Yi. Object recognition in SAR imagery using sequential feature matching of scattering centers[J].System Engineering and Electronics, 2012, 34(6):1131-1135.(in Chinese)

[3] PARK J I, PARK S H, KIM K T. New discrimination features for SAR automatic target recognition[J]. IEEE Geoence & Remote Sensing Letters, 2013, 10(3): 476- 480.

[4] 王彦平, 张艺博, 李洋, 等. 基于2DPCA-SCN正则化的SAR图像目标识别方法[J]. 信号处理, 2019, 35(5):802- 808.

WANG Yanping, ZHANG Yibo, LI Yang, et al. Target recognition method based on 2DPCA-SCN recularization for SAR image[J]. Journal of Signal Processing, 2019, 35(5):802- 808.(in Chinese)

[5] MISHRA A K. Validation of PCA and LDA for SAR ATR[C]∥Tencon IEEE Region 10 Conference. IEEE, 2009.

[6] DANG S, CUI Z, CAO Z, et al. SAR target recognition via incremental nonnegative matrix factorization[J]. Remote Sensing, 2018, 10(3): 374.

[7] DONG G, KUANG G, WANG N, et al. SAR target recognition via joint sparse representation of monogenic signal[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2015, 8(7): 3316-3328.

[8] 王璐,张帆,李伟,等. 基于Gabor滤波器和局部纹理特征提取的SAR目标识别算法[J]. 雷达学报,2015,4(6):658- 665.

WANG Lu,ZHANG Fan,LI Wei,et al. A method of SAR target recognition based on Gabor filter and local texture feature extraction[J]. Journal of Radars,2015,4(6):658- 665.(in Chinese)

[9] DRAGOMIRETSKIY K, ZOSSO D. Variational mode decomposition[J]. IEEE Transactions on Signal Processing, 2014, 62(3): 531-544.

[10]DRAGOMIRETSKIY K, ZOSSO D. Two-dimensional variational mode decomposition[M].Tai X C, Bae E, Chan T F.et al. Energy Minimization Methods in Computer Vision and Pattern Recognition. Springer,Cham. 2015:197-208.

[11]CHEN L, ZHAN P, LI T, et al. Representation of BVMD features via multitask compressive sensing for SAR target classification[J]. Remote Sensing Letters, 2020, 11(8): 807- 816.

[12]LI C, LIU G. Block sparse Bayesian learning over local dictionary for robust SAR target recognition[J]. International Journal of Optics, 2020, 2020(2): 1-10.

[13]CHANG C C, LIN C J. LIBSVM: A library for support vector machines[J]. ACM Transactions on Intelligent Systems and Technology (TIST), 2011, 2(3): 1-27.

[14]CHO J H, PARK C G. Multiple feature aggregation using convolutional neural networks for SAR image-based automatic target recognition[J]. IEEE Geoscience and Remote Sensing Letters, 2018, 15(12): 1882-1886.

[15]GAO F, HUANG T, SUN J, et al. A new algorithm for SAR image target recognition based on an improved deep convolutional neural network[J]. Cognitive Computation, 2019, 11(6): 809- 824.

[16]ZHAO P, LIU K, ZOU H, et al. Multi-stream convolutional neural network for SAR automatic target recognition[J]. Remote Sensing, 2018, 10(9): 1473.

[17]THIAGARAIANM J, RAMAMURTHY K, KNEE P,et al. Sparse representations for automatic target classification in SAR images[C]∥4th Int. Symp. Commun. Control Signal Process,2010: 1- 4.

[18]PENG Y, LI L, LIU S, et al. Extended sparse representation-based classification method for face recognition[J]. Machine Vision and Applications, 2018, 29(6): 991-1007.

[19]LV J. Exploiting multi-level deep features via joint sparse representation with application to SAR target recognition[J]. International Journal of Remote Sensing, 2020, 41(1): 320-338.

[20]张虹, 左鑫兰, 黄瑶. 基于稀疏表示系数相关性的特征选择及 SAR 目标识别方法[J]. 激光与光电子学进展, 2020, 57(14): 141029.

ZHANG Hong, ZUO Xinlan, HUANG Yao. Feature selection based on the correlation of sparse coefficient vectors with application to SAR target recognition[J]. Laser & Optoelectronics Progress, 2020, 57(14): 141029.(in Chinese)

[21]ZHANG L, YANG M, FENG X. Sparse representation or collaborative representation: Which helps face recognition?[C]∥2011 International Conference on Computer Vision. IEEE, 2011: 471- 478.

[22]王俊茜, 郑文先, 徐勇. 基于测试样本误差重构的协同表示分类方法[J]. 计算机科学, 2020, 47(6): 104-113.

WANG Junqian, ZHENG Wenxian, XU Yong. Novel image classification based on test sample error reconstruction collaborative representation[J]. Computer Science, 2020,47(6): 104-113.(in Chinese)

[23]VO D M, LEE S W. Robust face recognition via hierarchical collaborative representation[J]. Information Sciences, 2018, 432: 332-346.

[24]LIU B, JING L, LI J, et al. Group collaborative representation for image set classification[J]. International Journal of Computer Vision, 2019, 127(2): 181-206.

[25]SU H, ZHAO B, DU Q, et al. Multifeature dictionary learning for collaborative representation classification of hyperspectral imagery[J]. IEEE Transactions on Geoscience and Remote Sensing, 2018, 56(4): 2467-2484.