1 引言

深度伪造(DeepFake),即利用深度学习技术合成虚假图像、视频、音频等多媒体内容,作为新兴的多媒体内容篡改方式,是目前受社会各界关注最为广泛且负面影响深远的安全隐患之一[1-2]。较传统手工伪造多媒体(借助Photoshop、Audacity等媒体编辑软件),深度伪造多媒体具有伪造内容自由度更高、伪造效果更逼真、人眼更难察觉等显著优势。深度伪造多媒体往往含有虚假的人物、事件及语音资料,一旦在网络空间大范围快速传播,可被利用于散布虚假信息、诱导舆情发展、制造传播仇恨、煽动群体行为,对个人、集体乃至国家安全造成严重损害。2018年,网络上出现美国前总统奥巴马发表不当言论(对其后一任总统特朗普进行人身攻击)的视频[3],经证实是利用深度伪造技术产生的虚假视频。2019年,新华网披露目前微信诈骗科技含量越来越高,已出现通过深度伪造的克隆语音进行成功诈骗的案例[4]。此外,开源的“换脸”、“换声”等程序层出不穷,且不乏“一键式”深度伪造软件和手机App,使得深度伪造的“门槛”大幅降低,也使深度伪造多媒体内容取证成为亟待研究的世界性课题。

伪造视频中对面部信息的篡改主要可以分为四种类型[5]:

整脸合成(Entire Face Synthesis):整脸合成指通过深度伪造技术合成现实世界不存在的人脸,主要分为基于生成对抗网络(generative adversarial network,GAN)[6]和自编码器(autoencoder)[7]的方法。目前较有代表性的方法为文献[8]中提出的StyleGAN,2020年11月,韩国MBN电视台成功运用该技术合成了第一位AI主播,实现了智能新闻播报[9]。

换脸(Identity Swap):换脸伪造将已有视频中的人脸替换为已知的目标人脸,因视频的动态特性和口型语音一致性的要求,视频换脸往往比图像换脸操作更为精密复杂。目前主要的视频换脸工具包括开源的FaceSwap[10]、Deep-FaceSwap[11]、Faceswap-GAN[12]、DeepFaceLab[13]等。

属性篡改(Attribute Manipulation):属性篡改通过修改或者增减面部的一些属性达到篡改目的。常见的可篡改属性包括发型、头发皮肤颜色、性别、年龄、增减眼镜等饰物等。此类篡改操作通常是通过GAN来完成,例如文献[14]中提出的StarGAN。

表情交换(Expression Swap):此类篡改主要目的为改变人的面部表情,比较流行的技术为Face2Face[15]和Neural Textures[16]。

在以上这四种类型中,换脸视频通过面部替换伪造一个人说出特定的语句或者做出特定的动作,可用于误导舆论、扰乱社会秩序, 甚至可能会威胁人脸识别系统、干预政府选举和颠覆国家政权等,已成为当前最先进且危害最大的新型网络攻击形式。因此,本文主要研究深度伪造中换脸视频的检测问题。

随着深度伪造的广泛研究,出现了一些利用深度学习对深度伪造进行检测的方法[17-26],文献[17-20]构造了端到端(end-to-end)的深度伪造检测网络,包括Mesonet[18]、MISLnet[19]、ShallowNet[20]等,其中MISLnet是一个通用图像取证网络,原本用来检测加噪、中值滤波、高斯模糊、JPEG压缩等操作。文献[21]将人脸区域分为了整脸、眼、鼻、口以及剩余区域等5个内容作为Xception网络的输入,从实验结果看,最能帮助检测的区域为眼和口部,而其他区域效果较差。文献[22]则指出,一般的深度伪造都包括合成面部和面部融合两个步骤,现有的方法大多通过捕捉合成过程中可能出现的细微痕迹进行检测,而文献[22]提出了一种面部X射线(face X-ray)用于检测人脸图像的伪造,面部X射线将输出一幅灰度图像,它反映了输入图像是否可以分解为来自不同来源的两幅图像。然而,以上的方法都是从图像层面对深度伪造进行检测,丢失了视频中的时间和运动信息。为了将时间信息纳入考量,文献[23]提出了利用视频中光流场(optical flow field)信息检测深度伪造的思路,将待检测视频中的光流信息作为卷积神经网络(Convolutional Neural Networks, CNN)的输入,利用网络提取光流中能分辨深度伪造的深层特征。文献[24-25]则以循环神经网络(Recurrent Neural Network, RNN)与卷积神经网络相结合的方式,利用循环神经网络捕捉图像流的时间信息的能力来检测深度伪造视频。文献[26]采用动作识别中的3D(3 Dimension)卷积[27]代替传统的2D卷积,对比了3D ResNet、3D ResNeXt和I3D(Inception3D)在检测深度伪造视频上的能力。

总体来说,现有深度伪造视频取证方法大多基于对比真实和伪造视频之间的视觉差异,从而提炼出定量特征描述用于分类,这种研究方式有一定的效果但缺乏针对深度伪造合成原理的探索。此外,循环神经网络和3D卷积神经网络虽然可以保留视频中的时间信息,但是网络复杂度较高,权值参数数量庞大,且需要大量的训练样本进行训练,对计算资源要求较高。值得注意的是,在视频换脸深度伪造过程中,主要技术挑战在于眼部的动态呈现和口型与语音的一致性问题上,这些部位也自然成为更易留下伪造痕迹的地方。因此,本文针对深度伪造的合成过程中容易出现的眨眼不自然痕迹和口型拟合问题,利用基于dlib人脸识别库[28]的Face-recognition工具库,提取人脸的眼部和口部位置作为双流3D卷积神经网络的输入。同时,本文提出仅包含两个Inception模块的高效I3D网络,保留了I3D网络多层次、多维度的特征,去除了原始I3D网络中存在的冗余部分,在保证一定准确率的同时将训练速度提升为原来的三倍。下文将详细介绍本文提出的基于双流特征的高效I3D网络模型。

2 基于双流特征的高效Inception3D神经网络

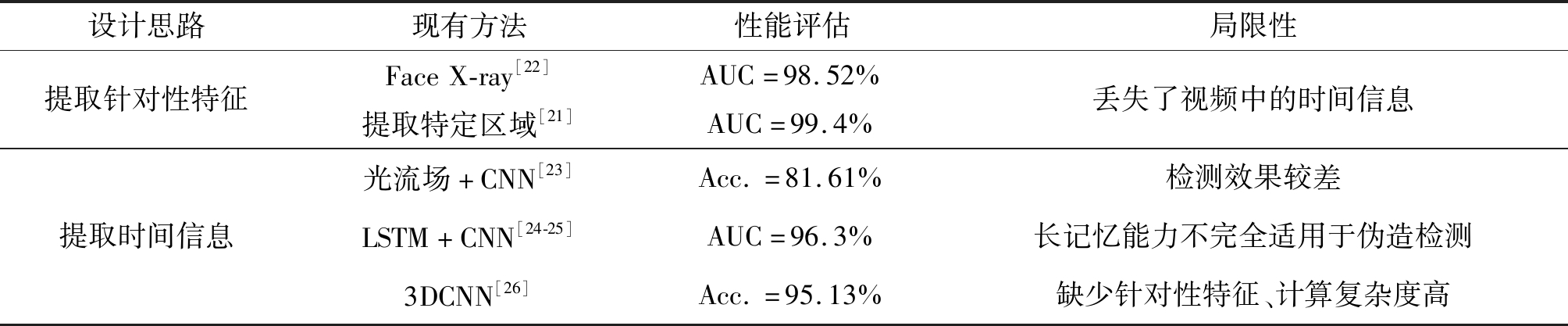

现有的一些具有代表性的深度伪造换脸检测方法的性能和局限性如表1所示,表中Acc.表示正确率(Accuracy),性能评估均取在FaceForensics++上测试的数据。其中,Face X-ray[22]提出提取人脸边缘融合痕迹、文献[21]将人脸区域分成五个内容作为输入,这两种方法均只利用了深度伪造换脸视频中的视觉信息,未能充分考虑视频中的时间信息。为将时间维度的特征纳入深度伪造检测的考虑,文献[23-25]分别提出了利用光流场和LSTM结构,但均存在一定的局限性。文献[26]的作者提出利用3DCNN结构检测深度伪造,取得了一定效果,但缺乏针对性特征处理,且整体复杂度较高。

表1 现有方法评估

Tab.1 Assessment of existing methods

设计思路现有方法性能评估局限性提取针对性特征FaceX-ray[22]提取特定区域[21]AUC=98.52%AUC=99.4%丢失了视频中的时间信息提取时间信息光流场+CNN[23]Acc.=81.61%检测效果较差LSTM+CNN[24-25]AUC=96.3%长记忆能力不完全适用于伪造检测3DCNN[26]Acc.=95.13%缺少针对性特征、计算复杂度高

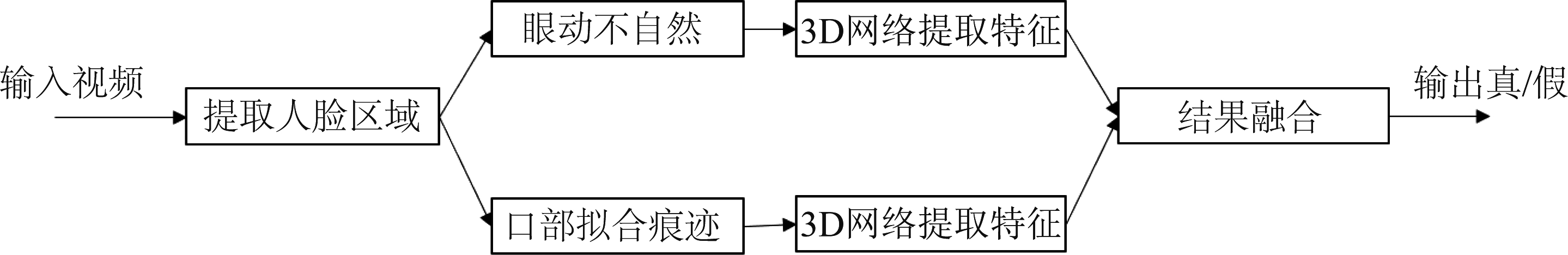

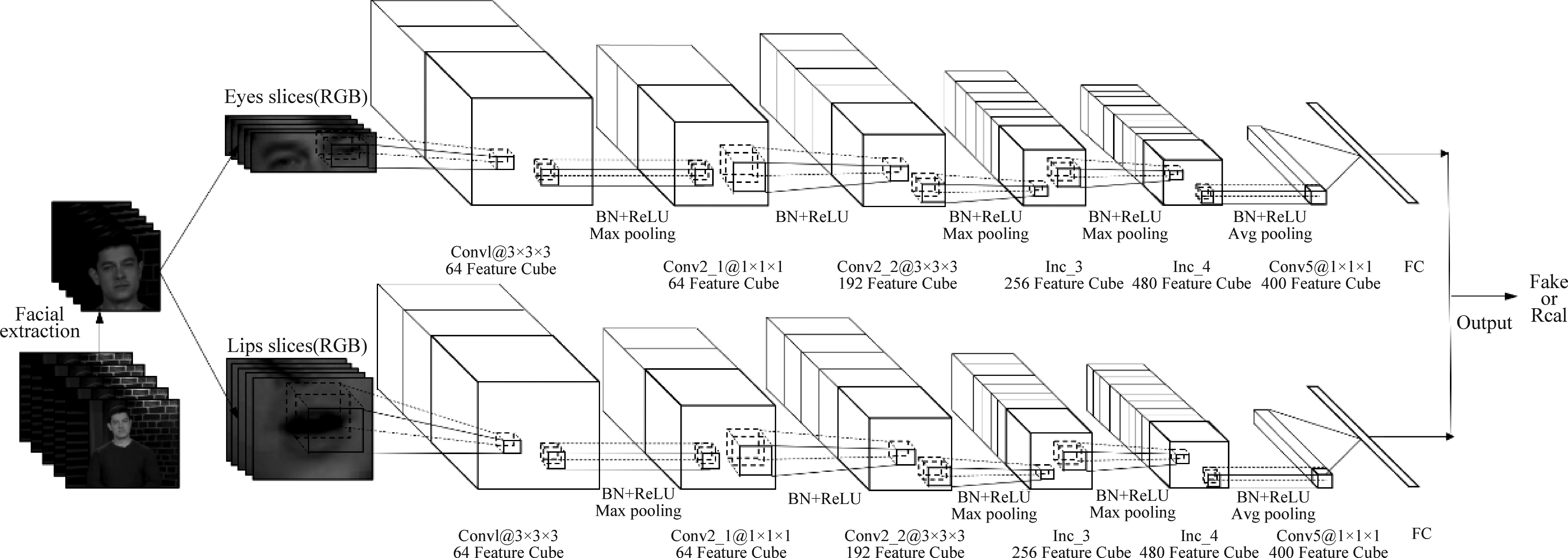

针对以上问题,本文提出用眼、口双流特征捕捉换脸视频中较明显的篡改痕迹,通过3D卷积神经网络提取深层特征,且保留时间维提取运动信息中的篡改痕迹,更进一步改进了原始的I3D网络,提出更高效的I3D网络。图1展示了本文提出的双流三维卷积网络模型检测总体流程。下文将详细介绍双流特征和高效I3D网络。

图1 双流3D卷积网络检测总体流程图

Fig.1 Two stream 3D CNN detection flowchart

2.1 双流特征

换脸视频篡改检测中,最重要的信息是人脸篡改的痕迹,这种痕迹包括合成人脸操作留下的伪影,以及拼接合成人脸与真实背景时留下的不自然的痕迹。而视频中这些痕迹只存在于很小的范围内,大部分的背景是冗余信息,可以去除。去除这些信息将减少操作的复杂度,使网络集中学习有意义的部分,提高识别准确率、缩短训练时间。

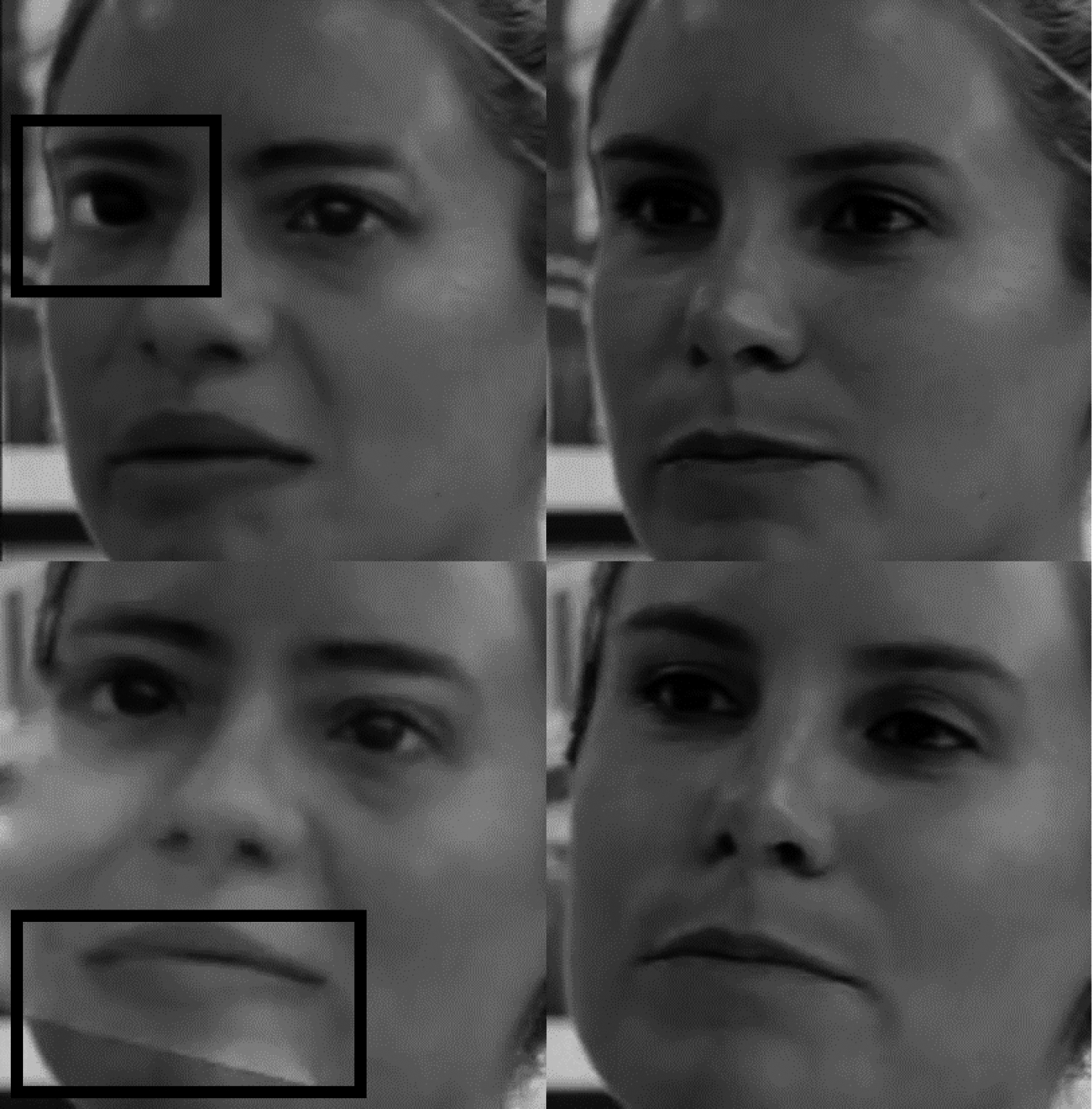

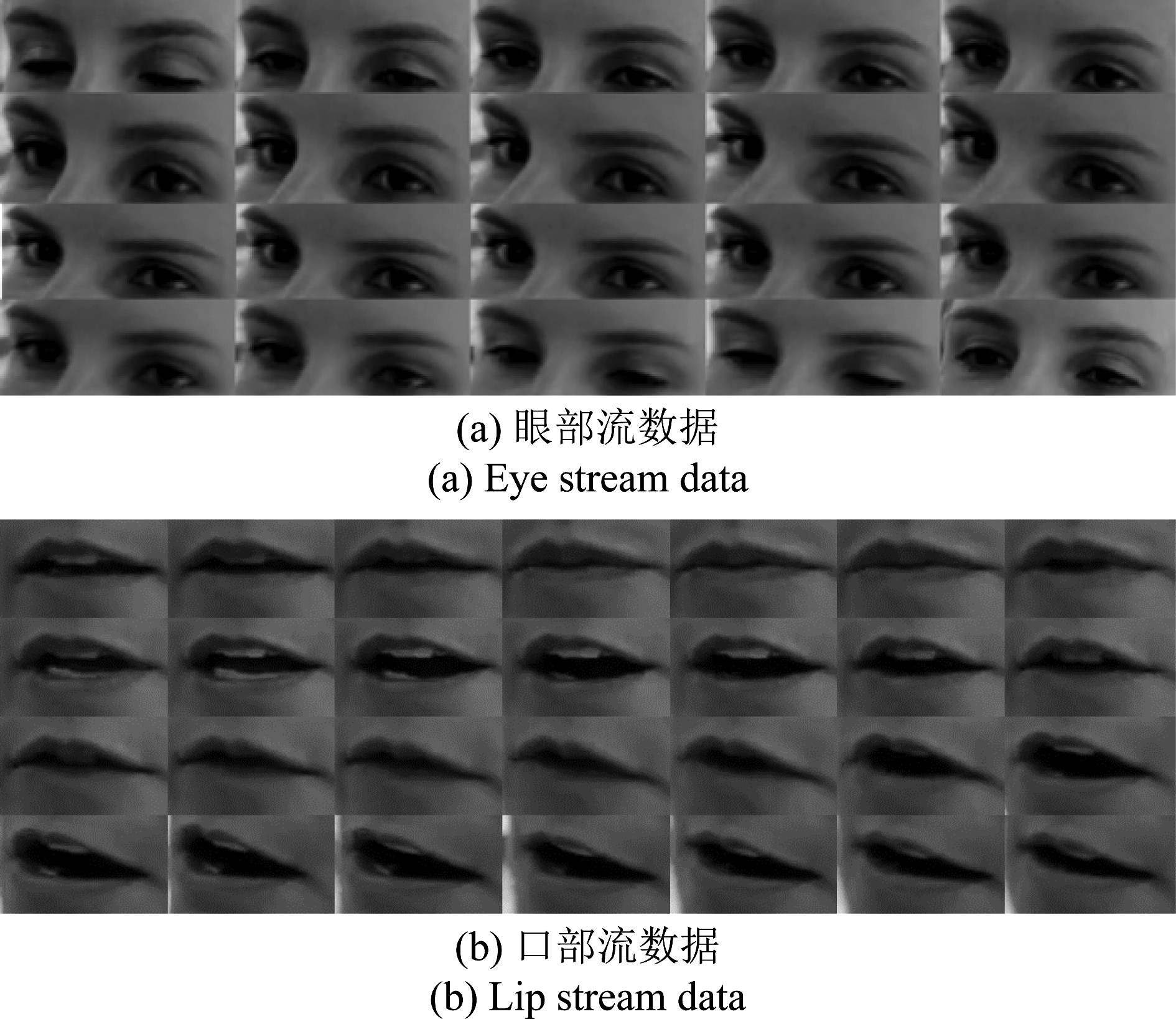

观察大量的换脸视频发现,合成假脸与真实人脸之间存在几个比较明显的差异:假脸的眼部通常不能同真脸的眼部一样灵活的活动,在眨眼频次、眼球活动等方面存在异常;假脸的嘴部在口型变化时,周围的皮肤纹理变化较小,与真脸的正常变化相比存在明显差异。针对这两个差异,提取出视频人脸的眼部、口部作为神经网络的输入,进行针对性的特征提取和识别,再将两个部分的结果融合来得到最终的结果。

图2 眼、口篡改痕迹(图左为篡改视频、图右为真实视频)

Fig.2 The eye, mouth artifacts (left: fake, right: real)

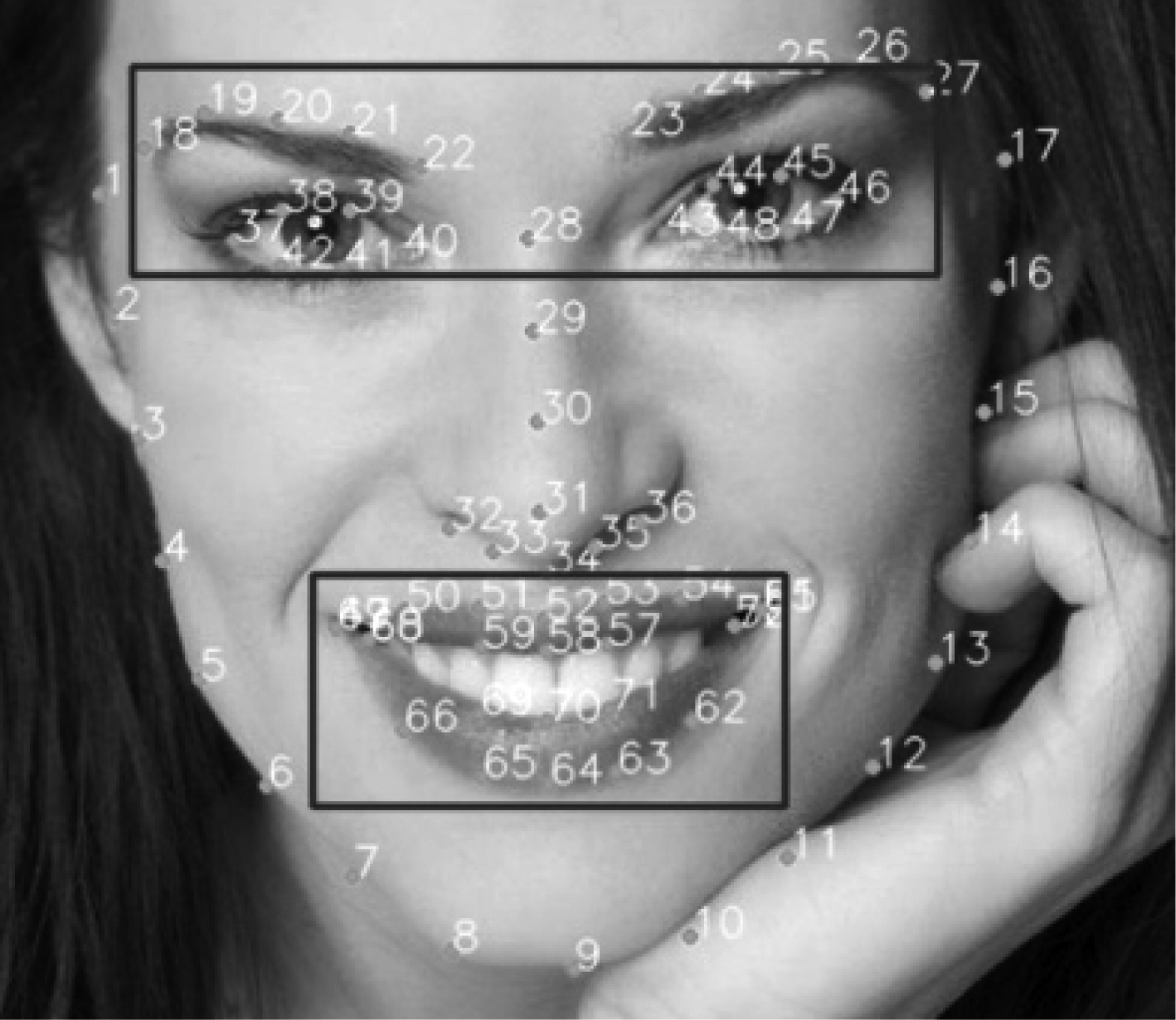

为了定位视频中的人脸,并准确提取人脸的眼、口部分,本文使用的基于dlib开源库的Face-recognition人脸识别库,定义了人脸部区域的68个特征点,包含了脸部轮廓、眉眼、鼻子以及口部等关键区域,如图3所示。为分别提取眼部和口部区域作为双流网络输入,将点18~27、点37~48作为眼部区域关键点,并由此定义区域外围矩形框;将点49~68作为口部区域的关键点,也定义相应的外围矩形框。区别于用于目标识别人物的区域提取,在取证过程中为尽可能保留更多可能产生篡改痕迹的内容,我们将对应区域外围适当放大,各方向均扩展一定像素。最终提取出的眼部和口部区域作为双流网络的输入。

图3 人脸特征点及双流区域提取

Fig.3 Face feature points and two stream region extraction

2.2 Inception3D神经网络及改进

提取出换脸视频中最有可能留下篡改痕迹的眼部和口部区域后,需要使用深度神经网络进一步提取深层特征和运动特征。目前针对视频中动作识别的研究已经得到广泛开展[29-31],主要思路有三种[25]:第一种是视频中的RGB帧与其光流在网络的两个分支中处理后融合的双流网络,利用光流来捕捉时间信息和跨帧运动[29],第二种是由循环卷积层支持的单流神经网络,训练好的循环卷积模型处于网络顶部,用来处理视频的时间维度,而卷积神经网络则提取高级语义特征,提取并认识每一帧的内容[30],第三种则是通过3D卷积学习丰富的时空特征[31]。这些方法中,光流的使用在动作识别任务场景中收获了很好的效果,但其更适用于捕捉微小的跨帧运动,对于捕捉换脸视频中的篡改痕迹收效甚微。而循环卷积层方面,首先其训练复杂度较高,对于数据量庞大的视频内容需要较高的算力支撑。更重要的是,循环卷积层所具备长记忆能力的优势可能并不完全适用于伪造内容检测,因后者主要关注时间和空间维度局部区域的不一致性。而3D卷积结构与前两种思路不同,既能在时域和空域同时感知视频特征,又能高效计算,因此更适用于换脸视频的检测。

2.2.1 标准Inception3D网络

Inception3D网络[31]最初被提出用于动作识别领域,是由Google公司在2015年提出的Inception二维卷积神经网络[32]膨胀成三维而来,原始的卷积核与池化核均扩展为三维,从而可以从视频中完整提取时间和空间特征,在速度和准确性上都表现出了优异的性能。原始的I3D网络包含RGB和光流两个不同的网络分支,基于前文的分析及现有实验结果,因光流信息并不能很好的提取换脸篡改痕迹,本文使用I3D网络检测换脸视频时,没有使用光流分支。

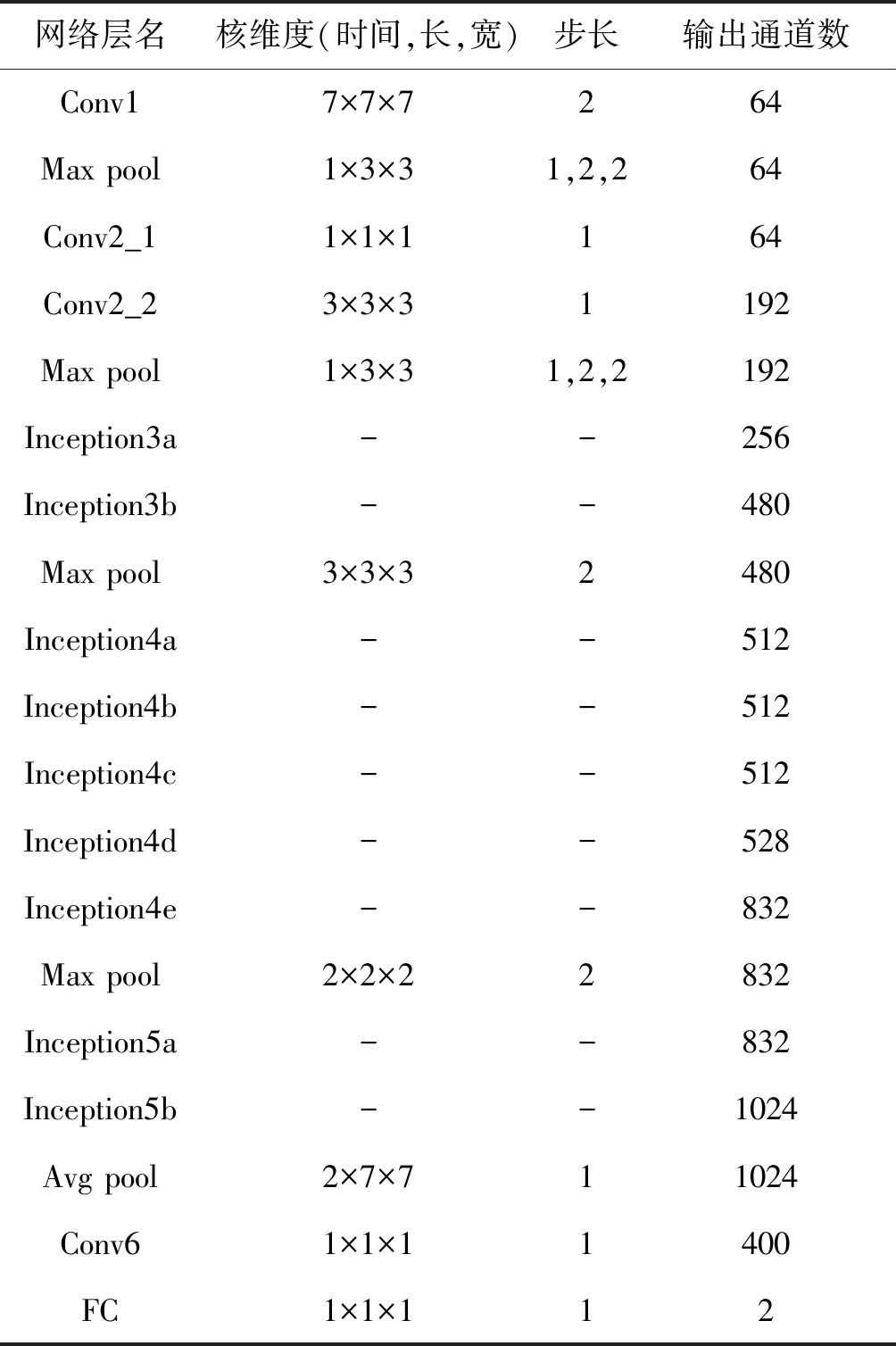

表2 标准I3D网络参数

Tab.2 Parameters of standard I3D

网络层名核维度(时间,长,宽)步长输出通道数Conv17×7×7264Max pool1×3×31,2,264Conv2_11×1×1164Conv2_23×3×31192Max pool1×3×31,2,2192Inception3a--256Inception3b--480Max pool3×3×32480Inception4a--512Inception4b--512Inception4c--512Inception4d--528Inception4e--832Max pool2×2×22832Inception5a--832Inception5b--1024Avg pool2×7×711024Conv61×1×11400FC1×1×112

当包含时间顺序的一系列视频帧输入二维的卷积神经网络时,二维的滤波器将无视时间关系,将三维的输入处理成简单的二维特征图,这破坏了视频中包含的运动信息。为了保留Inception网络多尺寸、高深度提取图像中视觉信息的特性,同时不损失时间信息,可以将二维卷积神经网络膨胀为三维卷积神经网络,将原本方形(N×N)的滤波器变为立方形(N×N×N)的,这赋予了滤波器额外的时间维度,从而使输出的特征图依然保留时间特征。二维模型处理两个空间维度(长度和宽度)时,卷积核和步长都是相同的,这表明网络中较深的特征受到两个维度越来越远位置的影响是同等的。然而在时间维上,对称的滤波器不一定有最佳的效果,而应该取决于帧率和图像尺寸。如果在时间维上相对于空间增长太快,可能会合并来自不同物体的边缘,破坏早期特征,而如果增长太慢,就可能不能很好地捕捉场景动态。

I3D网络参数如表2所示,为了更好的保留时间特征,在前两个最大池化层(max-pooling)中不执行时间维的池化(pooling),使用1×3×3的内核且步长为1,而在其他最大池化层中使用了对称的内核和超过1的步长。在整体架构上,除了最后一个卷积层以外,每一个卷积层之后都使用了批标准化(Batch Normalization, BN)层和ReLU激活函数。

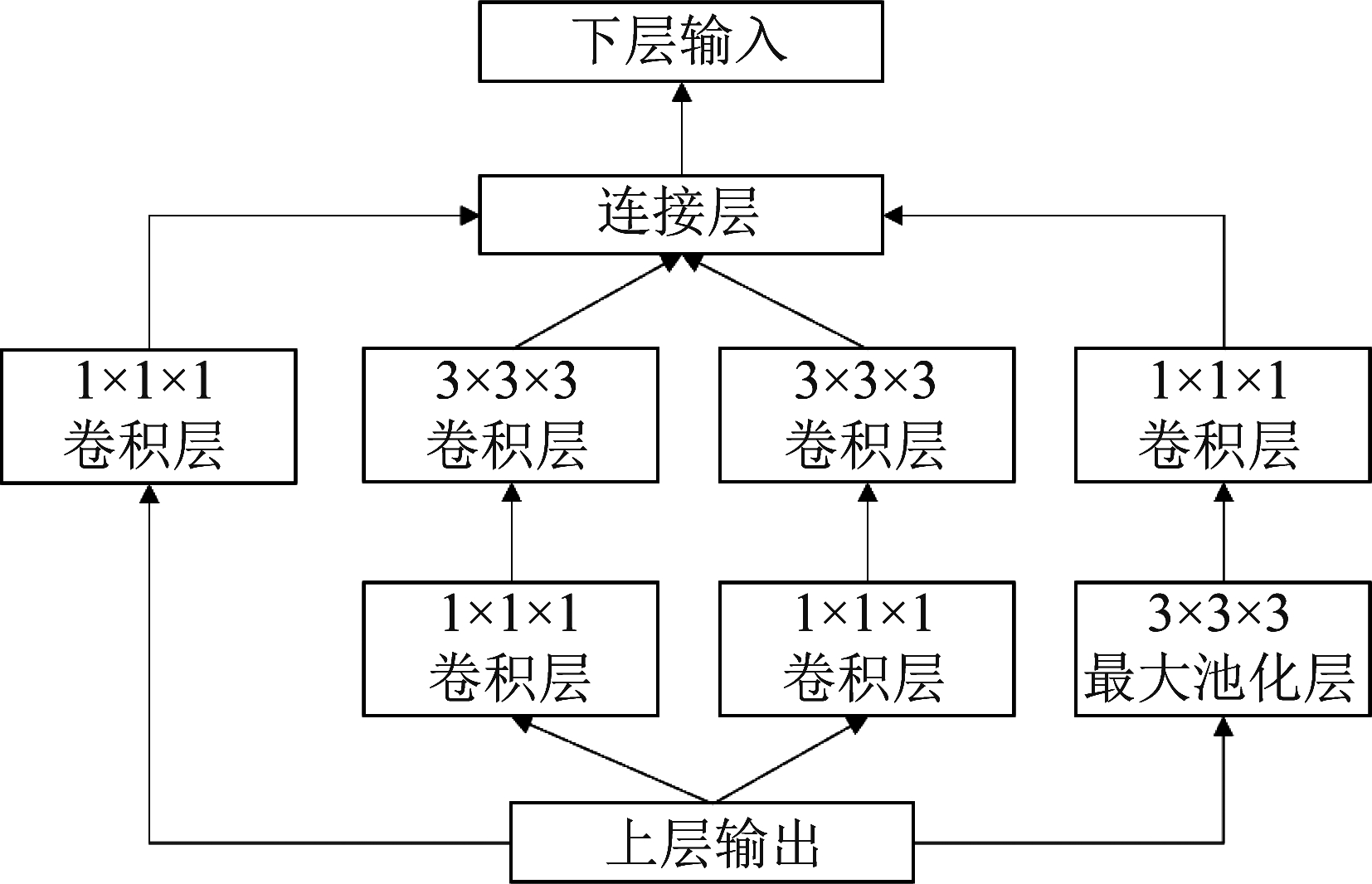

在I3D网络中,大量使用了Inception结构,这是一种利用1×1×1的卷积核扩展网络深度和广度的方法。图4展示了Inception结构的细节内容,可见该结构对上一层的输入使用多尺度的卷积处理,拓展了网络的广度,同时为了减少计算量,使用1×1×1卷积层在提升网络深度的同时避免参数爆炸式增长。在表2中,每一个Inception层都拥有相同的结构,只是在输出通道数上略有差别。

图4 Inception结构

Fig.4 Inception submodule

I3D网络的输入为上一步双流预处理模块提取的按时间顺序排列的眼、口图片序列,每个序列包含100帧图片,对应帧率为24 Hz的4.2秒视频流,每张图像经过重采样调整为224×224像素。整个网络一共有27层(包括池化层),在完全连接层(Fully connected, FC)之前,通常还会使用dropout层防止过拟合。在完全连接层之后,使用softmax激活函数作为分类器以及交叉熵损失作为代价函数:

loss=-[ylog(p)+(1-y)log(1-p)]

(1)

其中y代表样本标签(正类:输入视频为真实视频,记为1。负类:输入视频为虚假视频,记为0),p代表预测为正的概率。在训练阶段,损失反向传播促使网络学习真实视频与虚假视频之间的差异。

2.2.2 高效Inception3D网络

在动作识别问题中通常要对400类以上的动作进行分类,需要捕捉每一个动作之间宏观上的差别。而换脸视频的检测是二分类问题,从分类数量上来看,动作识别问题要提取更加深层的特征,将动作识别领域的I3D网络直接用于换脸视频检测,在特征提取上存在一定的冗余。基于此,本文在标准I3D网络的基础上提出了更精简的高效I3D网络,一方面保留标准I3D网络多尺度提取时间和空间特征的特性,另一方面删减网络冗余,提升训练速度。

对于I3D网络,Inception模块是增加网络深度的重要环节,层数较多的网络能够捕捉更深层的特征,表达能力更强,同时也会带来过拟合、计算复杂度过高的问题。原始Inception网络的提出主要用于400类图像分类。对于图像分类问题,深层特征更具表达能力以提升分类效果。但对于深度伪造检测,其主要思想是通过深度神经网络提取与伪造痕迹紧密相关的特征,而非内容识别特征。而这种特征往往既不在浅层(纹理特征)也不在深层(宏观特征),而是在较为适中的网络层中。同时,换脸检测是一个二分类问题,已与I3D网络设计时考虑的任务截然不同。因此,在基于I3D网络的换脸检测问题中,考虑总体减少网络层数和Inception模块。通过实验,发现增加Inception模块对正确率提升的意义不大,但在训练和检测速度上却有比较明显的影响,最终通过实验确定了高效I3D的结构。

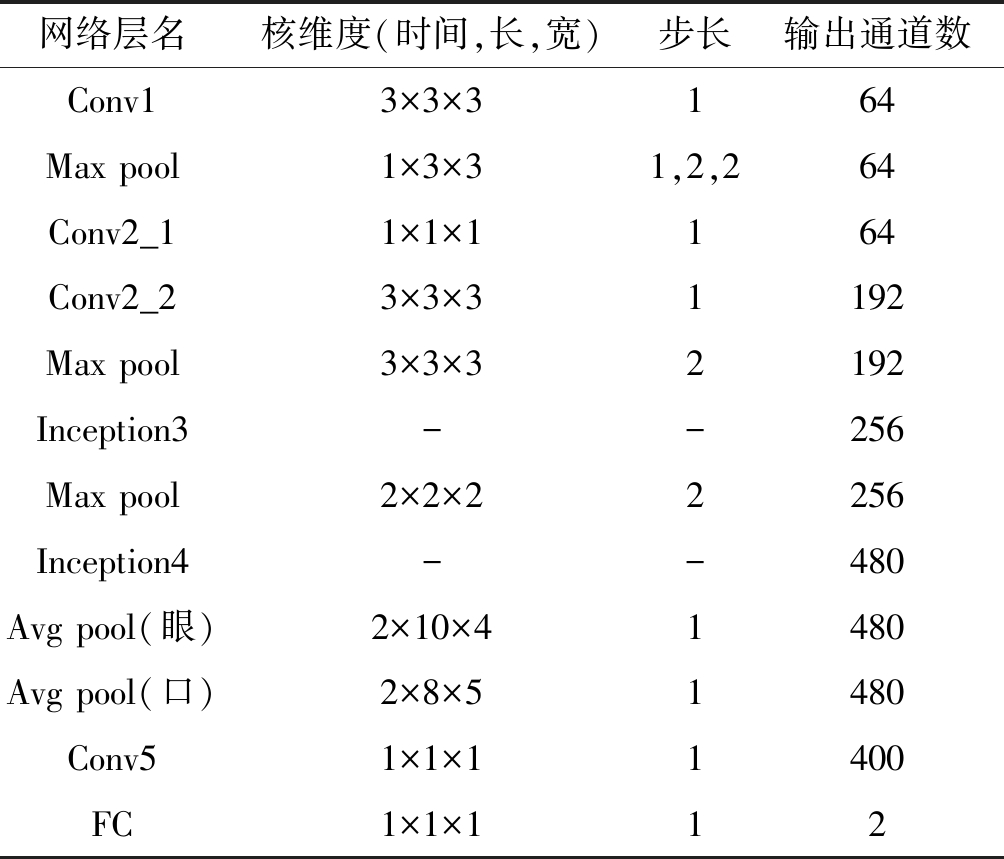

此外,标准I3D网络的输入是224×224大小的图片,而大部分的眼、口图片大小仅为100像素以下,因此本文调整了双流特征的输入,眼部图片将调整为80×30的大小,而口部图片将调整为60×40的大小,帧数不变。随着输入图片大小调整,平均池化层的内核大小也做出了相应调整,不同流的网络参数如表3所示。与标准I3D网络相同,除了最后一个卷积层以外,每一个卷积层之后都使用了BN层和ReLU激活函数,在全连接层添加了参数为0.36的dropout层,之后使用softmax激活函数作为分类器以及交叉熵损失作为代价函数。本文设计的高效I3D网络结构模型如图5所示。

表3 本文提出的高效I3D网络参数

Tab.3 Parameters of efficient I3D proposed in this paper

网络层名核维度(时间,长,宽)步长输出通道数Conv13×3×3164Max pool1×3×31,2,264Conv2_11×1×1164Conv2_23×3×31192Max pool3×3×32192Inception3--256Max pool2×2×22256Inception4--480Avg pool(眼)2×10×41480Avg pool(口)2×8×51480Conv51×1×11400FC1×1×112

图5 高效Inception3D网络结构图

Fig.5 The structure of efficient Inception3D network

在整个网络中使用了三种类型的卷积层,包括如Conv1、Conv2_2的普通卷积层,Inception模块中用在3×3×3卷积层之前的1×1×1卷积层,以及如Conv5的1×1×1卷积层。普通卷积层主要是为了学习更高层次的篡改特征,每一个卷积层都将学习前一个卷积层输出的低层特征,得到特征的新表达,需要注意的是,Inception模块中有两种1×1×1卷积层,如果是单独使用,其后不接3×3×3卷积层,这种卷积层也属于普通卷积层,在Inception模块中与3×3×3卷积层并行使用,主要目的是拓展网络的宽度,提取不同尺度的特征。如Conv2_1的1×1×1卷积层在下一层必须是一个普通卷积层,这种卷积层的串联主要是为了对数据进行降维,例如在Inception3中一个分支的输入为50×10×15×192,输出为50×10×15×32,若不使用1×1×1卷积层,直接使用3×3×3卷积层,卷积层的参数为3×3×3×192×32,而在3×3×3卷积层之前先使用16输出的1×1×1卷积层,卷积层参数则会变为1×1×1×192×16+3×3×3×16×32,减少了大约十倍。如Conv5的1×1×1卷积层只用到了一次,与全连接层类似,可以方便调节分类,对不同的数据集有更多的适配性。

在Inception4之后的网络可以认为是分类层,对之前一系列卷积层提取出的深度特征进行进一步学习和分类,最终识别输入图像是否经过换脸篡改。最大池化层(Max pool)保留滑动窗口邻域内的最大值,而平均池化层(Avg pool)保留本地邻域内的平均值。池化层可以降低特征图的维数,减少训练的计算成本和过拟合,在本网络中使用了三个最大池化层和一个平均池化层。

3 实验结果及分析

3.1 数据集

本文主要使用了目前比较常用的四个数据集[17,33-36]:

Celeb-DF[33]:Celeb-DF旨在生成具有更好视觉质量的假视频。该数据库由408个从YouTube上提取的真实视频组成,对应59位名人的采访,这些名人在性别、年龄和种族方面分布各异。此外,这些视频在诸如脸部像素大小、方向、光照条件和背景等方面都有很大的变化。在假视频方面,该数据集使用DeepFake技术总共创建了795个视频,对59个受试者中的每一对进行面部交换,最终视频为MPEG4.0格式。

DFDC[34]:DFDC(DeepFake Detection Challenge)数据集是最新的公开深度伪造数据集之一,由Facebook与其他公司和学术机构(如微软、亚马逊和麻省理工学院)合作发布。在本文中使用DFDC预览数据集,由来自66个付费演员的1131个真实视频组成,确保性别、肤色和年龄的现实差异。需要注意的是,此数据集与其他流行的数据集相比,没有使用公开可用的数据或者来自社交媒体网站的数据。在假视频方面,该数据集使用了两种不同的未知方法创建了4119个视频,通过交换具有相似外表(例如肤色、面部毛发、眼镜)的主体产生。DFDC数据集还考虑了不同的采集场景(如室内和室外)、光照条件(如白天和夜晚)、人与相机的距离以及姿态变化等。

FaceForensics++[17]:FaceForensics++数据库于2019年发布,作为原始FaceForensics数据库[35]的扩展,该数据集专注于面部表情操作。FaceForensics++包含来自YouTube的1000个真实视频,假视频则是使用计算机图形学(CG, Computer Graphics)和深度学习方法生成的,每个方法生成了1000个假视频。在本文中专注于深度学习方法,假视频采用faceswap方法生成。

DeepFake Detection[36]:DeepFake Detection数据集是谷歌AI实验室于2019年发布的深度伪造公开数据集。该数据集包含了来自28位自愿和付费演员在不同场景下拍摄的几百个真实视频,假视频则是使用公开的深度伪造生成方法创建的,共包含超过3000个视频。

现有的数据集都是在已有真实视频的基础上,利用一种或多种算法创造出不同的篡改视频,这导致数据集的真实视频比较少,而虚假视频相当多,真假的比例失衡在网络训练时可能存在一些影响,因此,实验过程中调整了这一比例,在篡改视频中随机选取一部分,使真假视频的比例控制在1:1左右。对于DFDC数据集,本论文只采用了预览数据集,即DFDC preview,并未采用比赛中的全部数据。在本文中,所有数据集都被划分成训练集(80%)和测试集(20%)两部分,实验结果来自测试集上的检测结果。

3.2 网络训练及实验结果3.2.1 网络预训练

本文采用了文献[31]的方法在ImageNet数据集上对高效I3D网络进行预训练。由于ImageNet是一个图片数据集,无法直接应用到3D卷积神经网络上,文献[31]提出,将一张图片作为一帧复制多份,扩充为一列帧,即可制作出平凡(boring)的动态数据集对3D卷积神经网络进行预训练。在本文中,对于高效I3D网络,从ImageNet数据集1000类中选取了400类,每一类包含49张图片,每张图片扩充成150帧进行预训练。

3.2.2 数据预处理

数据预处理过程将待验视频中的人脸区域提取出来,并进一步提取眼部和口部特征分别作为双流网络的输入。其中,如前文所述及图6所示,眼部和口部区域分别包含了各自区域内的20个特征点。为包含更多有用信息,眼部区域矩形框长和宽分别拓展了10和5个像素,口部区域各边缘分别拓展了10个像素。

图6 眼、口双流特征示例

Fig.6 Examples of two stream characteristics of eye and lip

3.2.3 实验结果分析

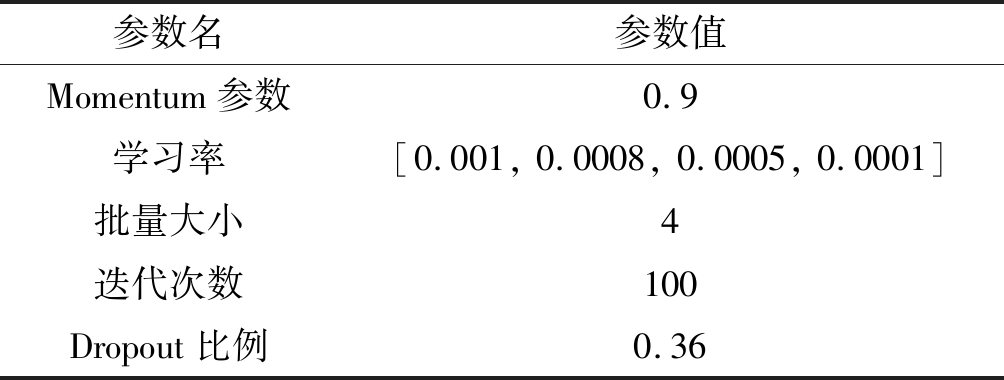

高效I3D网络在TensorFlow平台上进行训练和测试。训练时,网络权重由ImageNet预训练权重初始化,批量大小为4,训练100个阶段。学习率设置为阶梯函数下降,每训练25个阶段下降一次,分别为0.001, 0.0008, 0.0005, 0.0001,使用动量梯度下降算法优化。眼部、口部数据分别调整为80×30、60×40的大小作为网络输入,网络两个分支的输出平均得到最后的结果,超参数设置情况见表4。本文采用准确率以及受试者工作特征(Receiver Operating Characteristic, ROC)曲线来评估网络优劣,并与文献[17]中提到的Xception网络进行比较。需要注意的是,Xception是针对视频每一帧进行检测的,因此在本文讨论时,设定一个视频中如果超过50%的帧都被认定为假,就认为这个视频是伪造的。

表4 网络训练使用的超参数

Tab.4 List of Hyperparameters in Training

参数名参数值Momentum参数0.9学习率[0.001, 0.0008, 0.0005, 0.0001]批量大小4迭代次数100Dropout比例0.36

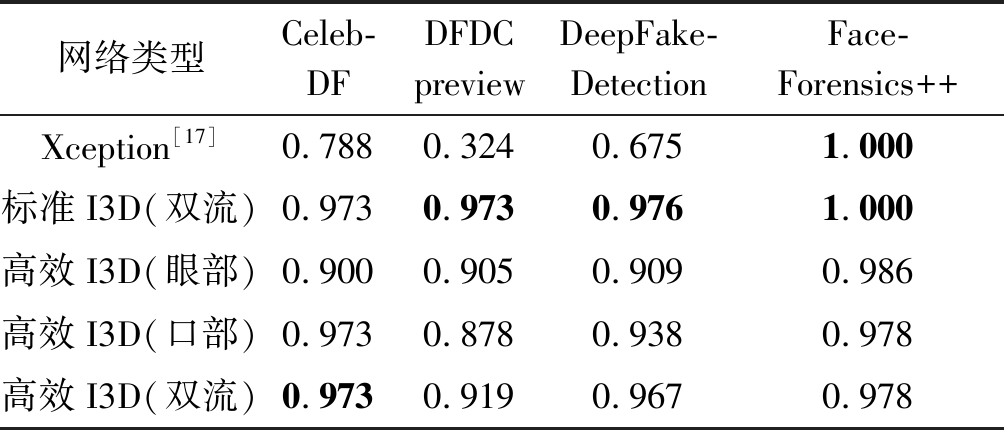

表5给出了在不同数据集下几种方法的分类准确度。表中每一行代表一种方法,其中第三行代表高效I3D网络的眼部流分支,第四行代表高效I3D网络的口部流分支,第五行代表由眼部和口部结果平均所得到的高效I3D网络结果。表中每一行展示了不同方法在同一个数据集上的结果。从结果上看,由于Xception网络是针对FaceForensics++数据集提出且在FaceForensics++上训练,所以该网络在FaceForensics++数据集上表现得很好,而在其他数据集上,本文提出的双流高效I3D则表现出了比较大的优势。比较第三、四、五行的结果,可以看出大部分情况下,双流网络的结果好于眼部或口部单流的结果。从数据集上看,几种网络在FaceForensics++数据集上的效果要好于在其他数据集上的,这主要是因为FaceForensics++数据集相较于其他数据集数据量更大,可以使网络训练地更加充分。相对应的,DFDC预览数据集是四个数据集中数据量最小的,在此数据集上的训练效果也就相对比较差。对比标准I3D网络和高效I3D网络,在最终分类准确度相差不大的情况下,标准I3D网络的训练速度为0.52秒每批,测试速度为0.36秒每视频,而高效I3D的训练速度为0.19秒每批,测试速度为0.07秒每视频,在测试速度上提升为原来的2.7倍,训练速度上提升为原来的5.1倍。

表5 不同网络在各数据集下的分类准确度

Tab.5 The classification accuracy of different networks in different datasets

网络类型Celeb-DFDFDCpreviewDeepFake-DetectionFace-Forensics++Xception[17]0.7880.3240.6751.000标准I3D(双流)0.9730.9730.9761.000高效I3D(眼部)0.9000.9050.9090.986高效I3D(口部)0.9730.8780.9380.978高效I3D(双流)0.9730.9190.9670.978

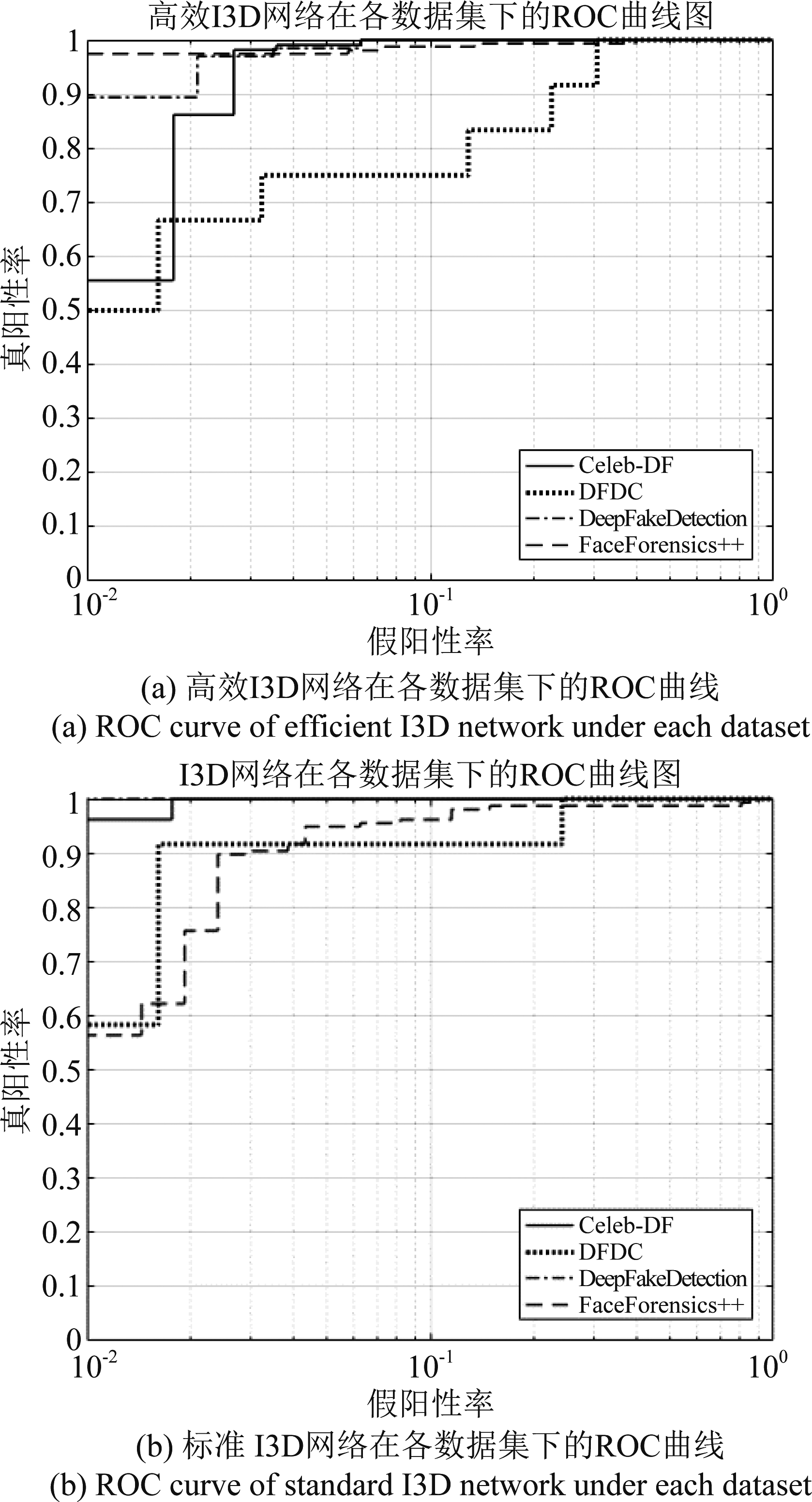

图7 两种3D网络在不同数据集下的ROC曲线

Fig.7 ROC curves of the two 3D networks under different datasets

进一步,本文所提高效双流I3D和标准双流I3D网络在各数据集上实验所得ROC曲线如图7所示。由于两种网络的检测性能比较接近,为方便观察,将假阳性率设置为对数尺度。在高效I3D网络具有3倍左右计算速度提升的前提下,由图可见,对于FaceForensics++数据集,高效I3D网络性能好于标准I3D网络,而对于其他三个数据集,后者性能略好于前者。总体来说,各数据集ROC曲线均接近(0,1)最优点,表明本文所提方法的优越性。

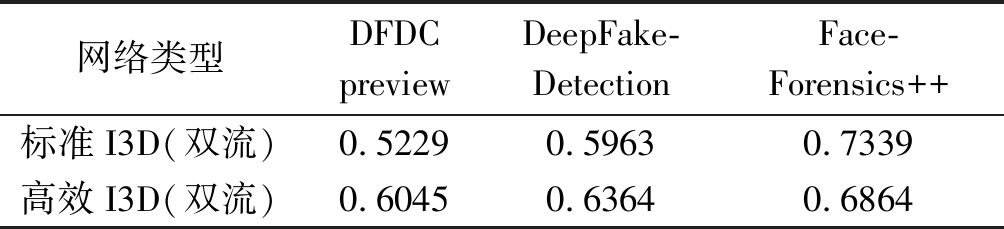

为了检测在不同数据集上的性能,本文使用在Celeb-DF数据集上训练的网络模型对其他三个数据集的测试集进行检验,结果如表6所示。表中数据显示,在DFDC 预览和DeepFakeDetection数据集上高效I3D的结果要好于标准I3D,标准I3D存在过拟合的现象。在FaceForensics++数据集上,标准I3D的性能略好,可能是由于Celeb-DF数据集与FaceForensics++数据集的换脸篡改算法存在一定的重合。从实验结果可以看出跨库性能并不太理想,这与目前大多数深度伪造检测方法面临的问题相同。其主要原因在于缺乏有效手段保证网络学习到的仅为伪造痕迹,而没有受到其他非相关信息(语义、背景等)的影响。此外,各数据集中所使用的伪造算法的差异,也是导致跨库性能下降的原因之一。如何改良网络结构、结合手工与深度特征、改进训练方式,以最终提升深度伪造检测算法的跨库性能,也是以后研究的重点之一。

表6 高效I3D与标准I3D的跨库检测正确率

Tab.6 Efficiency I3D and standard I3D cross-dataset detection accuracy

网络类型DFDCpreviewDeepFake-DetectionFace-Forensics++标准I3D(双流)0.52290.59630.7339高效I3D(双流)0.60450.63640.6864

4 结论

本文提出了一种用于深度伪造换脸视频检测的眼部和口部双流高效Inception3D深度神经网络协同检测方法。预处理阶段,利用dlib人脸识别库检测视频中的人脸并分别提出眼部和口部区域作为网络输入。随后,通过本文设计的高效I3D双流网络分别学习眼部和口部在空域和时域的篡改特征。最后利用双流输出结果协同判定待验视频的真实性。实验结果显示,本文所提方法在Celeb-DF、DFDC预览、DeepFakeDetection等目前常用的数据集上的检测准确性较Xception网络分别提升了18.5%、59.5%以及29.2%。而相对于采用了标准I3D结构的双流网络,其高效版可在Celeb-DF数据集上保证检测准确率不变的情况下实现约3倍的处理速度提升。后续工作将关注如何改进双流特征的融合机制、设计端到端的网络、优化网络结构和训练策略等,以进一步提升检测性能。

[1] 梁瑞刚, 吕培卓, 赵月, 等. 视听觉深度伪造检测技术研究综述[J]. 信息安全学报, 2020, 5(2): 1-17.

LIANG Ruigang, LV Peizhuo, ZHAO Yue, et al. A survey of audiovisual deepfake detection techniques[J]. Journal of Cyber Security, 2020, 5(2): 1-17.(in Chinese)

[2] 陶建华, 傅睿博, 易江燕, 等. 语音伪造与鉴伪的发展与挑战[J]. 信息安全学报, 2020, 5(2): 28-38.

TAO Jianhua, FU Ruibo, YI Jiangyan, et al. Development and challenge of speech forgery and detection[J]. Journal of Cyber Security, 2020, 5(2): 28-38.(in Chinese)

[3] Watch Jordan Peele use AI to make Barack Obama deliver a PSA about fake news,VINCENT J, https:∥www.theverge.com/tldr/2018/4/17/17247334/ai-fake-news-video-barack-obama-jordan-peele-buzzfeed, Apr. 2018.

[4] 声音合成、换脸、转发微信语音……AI诈骗防不胜防,韩丹东, 姜珊, http:∥www.xinhuanet.com/legal/2019- 07/25/c_1124795264.htm,2019.

Voice synthesis, face changing, WeChat voice forwarding…AI scams are hard to prevent, HAN Dandong and JIANG Shan,http:∥www.xinhuanet.com/legal/2019- 07/25/c_1124795264.htm,2019.(in Chinese)

[5] TOLOSANA R, VERA-RODRIGUEZ R, FIERREZ J, et al. Deepfakes and beyond: A Survey of face manipu-lation and fake detection[J]. Information Fusion, 2020, 64: 131-148.

[6] GOODFELLOW I J, POUGET-ABADIE J, MIRZA M, et al. Generative adversarial nets[C]∥Proceedings of the 27th International Conference on Neural Information Processing Systems-Volume 2. 2014: 2672-2680.

[7] PIDHORSKYI S, ADJEROH D A, DORETTO G. Adversarial latent autoencoders[C]∥2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Seattle, WA, USA. IEEE, 2020: 14092-14101.

[8] KARRAS T, LAINE S, AILA T. A style-based generator architecture for generative adversarial networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2020.

[9] MBN introduces Korea's first AI news anchor,YOON So-Yeon,https:∥koreajoongangdaily.joins.com/2020/11/10/entertainment/television/MBN-AI-artificial-intellegence/20201110153900457.html, Nov.2020.

[10] FaceSwap Multimedia App, https:∥github.com/MarekKowalski/FaceSwap/.

[11] FaceSwap, a tool that utilizes deep learning to recognize and swap faces in pictures and videos, https:∥github.com/deepfakes/faceswap.

[12] Faceswap-GAN, Adding Adversarial loss and perceptual loss (VGGface) to deepfakes'(reddit user) auto-encoder architecture,https:∥github.com/shaoanlu/faceswap-GAN.

[13] PETROV I, GAO Daiheng, CHERVONIY N, et al. DeepFaceLab: A simple, flexible and extensible face swapping framework[EB/OL]. 2020: arXiv:2005.05535 [cs.CV].https:∥arxiv.org/abs/2005.05535.

[14] CHOI Y, CHOI M, KIM M, et al. StarGAN: unified generative adversarial networks for multi-domain image-to-image translation[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City, UT, USA. IEEE, 2018: 8789- 8797.

[15] THIES J, ZOLLHÖFER M, STAMMINGER M, et al. Face2Face: real-time face capture and reenactment of RGB videos[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Las Vegas, NV, USA. IEEE, 2016: 2387-2395.

[16] THIES J, ZOLLHÖFER M, NIEßNER M. Deferred neural rendering: Image synthesis using neural textures[J]. ACM Transactions on Graphics, 2019, 38(4): 66.

[17] RÖSSLER A, COZZOLINO D, VERDOLIVA L, et al. FaceForensics++: learning to detect manipulated facial images[C]∥2019 IEEE/CVF International Conference on Computer Vision (ICCV). Seoul, Korea (South). IEEE, 2019: 1-11.

[18] AFCHAR D, NOZICK V, YAMAGISHI J, et al. MesoNet: a compact facial video forgery detection net-work[C]∥2018 IEEE International Workshop on Information Forensics and Security (WIFS). Hong Kong, China. IEEE, 2018: 1-7.

[19] BAYAR B, STAMM M C. Constrained convolutional neural networks: A new approach towards general purpose image manipulation detection[J]. IEEE Transactions on Information Forensics and Security, 2018, 13(11): 2691-2706.

[20] TARIQ S, LEE S, KIM H, et al. Detecting both machine and human created fake face images in the wild[C]∥ MPS'18: Proceedings of the 2nd International Workshop on Multimedia Privacy and Security, 2018: 81- 87.

[21] TOLOSANA R, ROMERO-TAPIADOR S, FIERREZ J, et al. DeepFakes evolution: analysis of facial regions and fake detection performance[M]. Pattern Recognition. ICPR International Workshops and Challenges. Cham: Springer International Publishing, 2021: 442- 456.

[22] LI Lingzhi, BAO Jianmin, ZHANG Ting, et al. Face X-ray for more general face forgery detection[C]∥2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Seattle, WA, USA. IEEE, 2020: 5000-5009.

[23] AMERINI I, GALTERI L, CALDELLI R, et al. Deepfake video detection through optical flow based CNN[C]∥ 2019 IEEE/CVF International Conference on Computer Vision Workshop (ICCVW). Seoul, Korea (South). IEEE, 2019: 1205-1207.

[24] GÜERA D, DELP E J. Deepfake video detection using recurrent neural networks[C]∥2018 15th IEEE International Conference on Advanced Video and Signal Based Surveillance (AVSS). Auckland, New Zealand. IEEE, 2018: 1- 6.

[25] SABIR E, CHENG Jiaxin, JAISWAL A, et al. Recurrent convolutional strategies for face manipulation detection in videos[J]. Interfaces (GUI), 2019, 3(1).

[26] WANG Yaohui, DANTCHEVA A. A video is worth more than 1000 lies. Comparing 3DCNN approaches for detecting deepfakes[C]∥2020 15th IEEE International Conference on Automatic Face and Gesture Recognition (FG 2020). Buenos Aires, Argentina. IEEE, 2020: 515-519.

[27] 甘俊英,李山路,翟懿奎,等. 基于3D卷积神经网络的活体人脸检测[J]. 信号处理, 2017,33(11): 1515-1522.

GAN Junying, LI Shanlu, ZHAI Yikui, et al. 3D convolutional neural network based on face anti-spoofing[J]. Journal of Signal Processing, 2017,33(11): 1515-1522.(in Chinese)

[28] KING D E. Dlib-ml: A machine learning toolkit[J]. The Journal of Machine Learning Research, 2009, 10: 1755-1758.

[29] SIMONYAN K, ZISSERMAN A. Two-stream convolutional networks for action recognition in videos[C]∥Proceedings of the 27th International Conference on Neural Information Processing Systems-Volume 1. 2014: 568-576.

[30] DONAHUE J, HENDRICKS L A, GUADARRAMA S, et al. Long-term recurrent convolutional networks for visual recognition and description[C]∥2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Boston, MA, USA. IEEE, 2015: 2625-2634.

[31] CARREIRA J, ZISSERMAN A. Quo vadis, action recognition? A new model and the kinetics dataset[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Honolulu, HI, USA. IEEE, 2017: 4724- 4733.

[32] SZEGEDY C, LIU Wei, JIA Yangqing, et al. Going deeper with convolutions[C]∥2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Boston, MA, USA. IEEE, 2015: 1-9.

[33] LI Yuezun, YANG Xin, SUN Pu, et al. Celeb-DF: A large-scale challenging dataset for DeepFake forensics[C]∥2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Seattle, WA, USA. IEEE, 2020: 3204-3213.

[34] DOLHANSKY B, HOWES R, PFLAUM B, et al. The deepfake detection challenge (DFDC) preview dataset[EB/OL]. 2019: arXiv:1910.08854[cs.CV].https:∥arxiv.org/abs/1910.08854.

[35] RÖSSLER A, COZZOLINO D, VERDOLIVA L, et al. FaceForensics: A large-scale video dataset for forgery detection in human faces[EB/OL]. 2018: arXiv:1803.09179[cs.CV].https:∥arxiv.org/abs/1803.09179.

[36] Contributing data to deepfake detection research, Google AI Blog,https:∥ai.googleblog.com/2019/09/contributing-data-to-deepfake-detection.html,Sep. 2019.