1 引言

时序行为检测针对较长的未分割视频,除了对视频中行为种类进行分类,还需定位行为边界。可用于:视频自动剪裁,视频监控,人体运动分析等。

该领域研究使用的数据集有THUMOS2014、ActivityNet等。评价指标为重叠度(IOU)=0.5时的平均精确度(mAP)。近几年该领域达到的mAP均不高,在30%左右,所以设计更好的时序行为检测网络,提高行为检测精度成了研究重点。Zhao等人提出的SSN网络[1],通过其输入特征的设计以及输出分数的设计来改善网络结构;Yuan等人对视频每个类别生成三种序列:开始帧概率,中间帧概率,结束帧概率,再基于这些概率设计了一种结构化最大和(Structured Maximal Sums)[2]算法来产生检测结果。Dai等人[3]参考了Faster-RCNN[4]的结构,对视频先用2stream网络[5]提取特征序列,再用滑窗机制在视频的每个位置生成多个不同尺寸的提议候选框,之后对每个提议候选框训练一个动作分类器来对提议候选框做分类和排序。Gao等人提出一种级联边界回归(CBR)模型[6],对视频提取特征产生特征序列,然后用滑窗机制产生提议候选框,之后构建了一个分类器以及一个边界回归器,通过级联的边界回归来精确定位动作的时序边界。腾讯优图实验室开源了一种稠密边界动作生成器(DBG)算法[7],该方法能端对端的生成高质量的时序动作提名,其在THUMOS14数据集上,IOU=0.5时达到了39.8%的mAP。

时序行为检测与人体行为识别之间的关系和目标检测与图片分类之间的关系非常像。基于图片分类,发展了许多模型(如ResNet[8],VGGNet[9]等),这些模型在目标检测中起了很大作用,冯等人[10]基于ResNet50重新设计了目标检测框架,并训练了一个全精度参数模型。同样,人体行为识别的相关模型(如2stream[5],C3D[11]等)也被广泛用在时序行为检测。由于时序行为检测和目标检测间存在一定相似性,所以很多时序行为检测方法都采用了与一些目标检测方法相似的框架(最常见的就是参考R-CNN系列方法[4,12])。

时序行为检测主要有以下难点:目标检测中,目标边界通常非常明确,所以可标注较为明确的边界框。但行为动作的边界有时并不明确,行为的开始和结束常常无法给出一个准确边界。所以行为的时序边界精度的提高成了提高时序行为检测精度的关键。基于此想法,进行了一系列的实验与研究。

时序行为检测不仅需处理视频帧在空间的信息,还需处理时间轴的信息,本文采用R-C3D网络[13]做为基础网络,R-C3D网络由特征提取子网、时序候选子网、行为分类子网组成。本文分别从视频空间域和时间域的角度改进R-C3D网络的时序候选子网,提出在空间域上改进的逐层空间卷积方法C-R-C3D,进而提出在空间域和时间域上同时改进的时域反卷积-逐层空间卷积算法DCC-R-C3D。

本文的创新点体现在:时序候选子网中,特征图的高宽由(H/16,W/16)变为(1,1)的过程中,使用多层卷积使网络在特征图的空间域逐层下采样,提取更丰富的空间特征,即本文提出的C-R-C3D方法;借助CDC网络[14]中反卷积在时间域上上采样的思路,通过反卷积网络增加特征图长度,结合C-R-C3D方法,提出在时空域上同时改进的DCC-R-C3D算法。

2 改进的R-C3D时序行为检测网络的设计

2.1 特征提取子网

R-C3D的特征提取子网由3D卷积层构成,采取C3D网络的卷积层构建特征提取子网,提取视频的时空特征,C3D网络提取特征的结构如图1。

![]()

图1 C3D特征提取网络结构

Fig.1 Feature extraction network structure of C3D

2.2 时序候选子网

2.2.1 逐层空间卷积方法

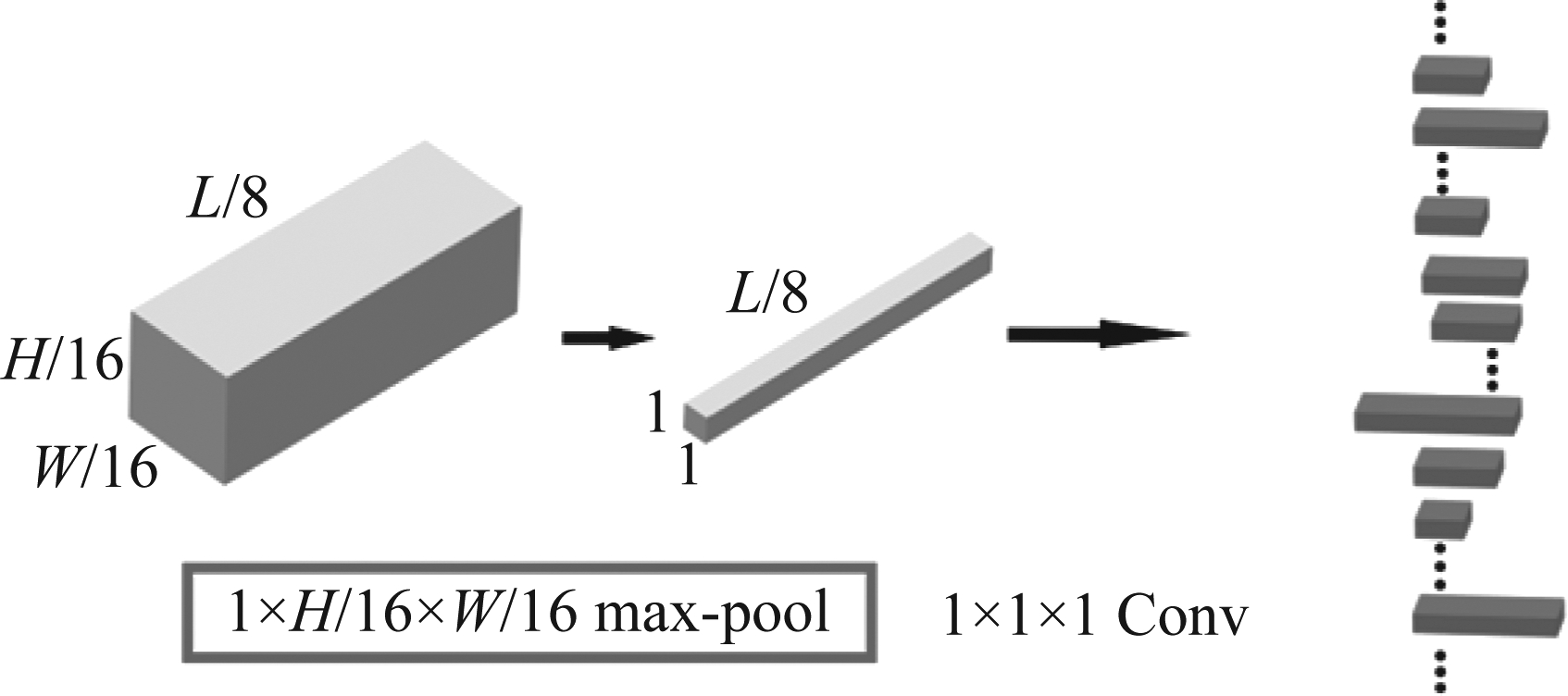

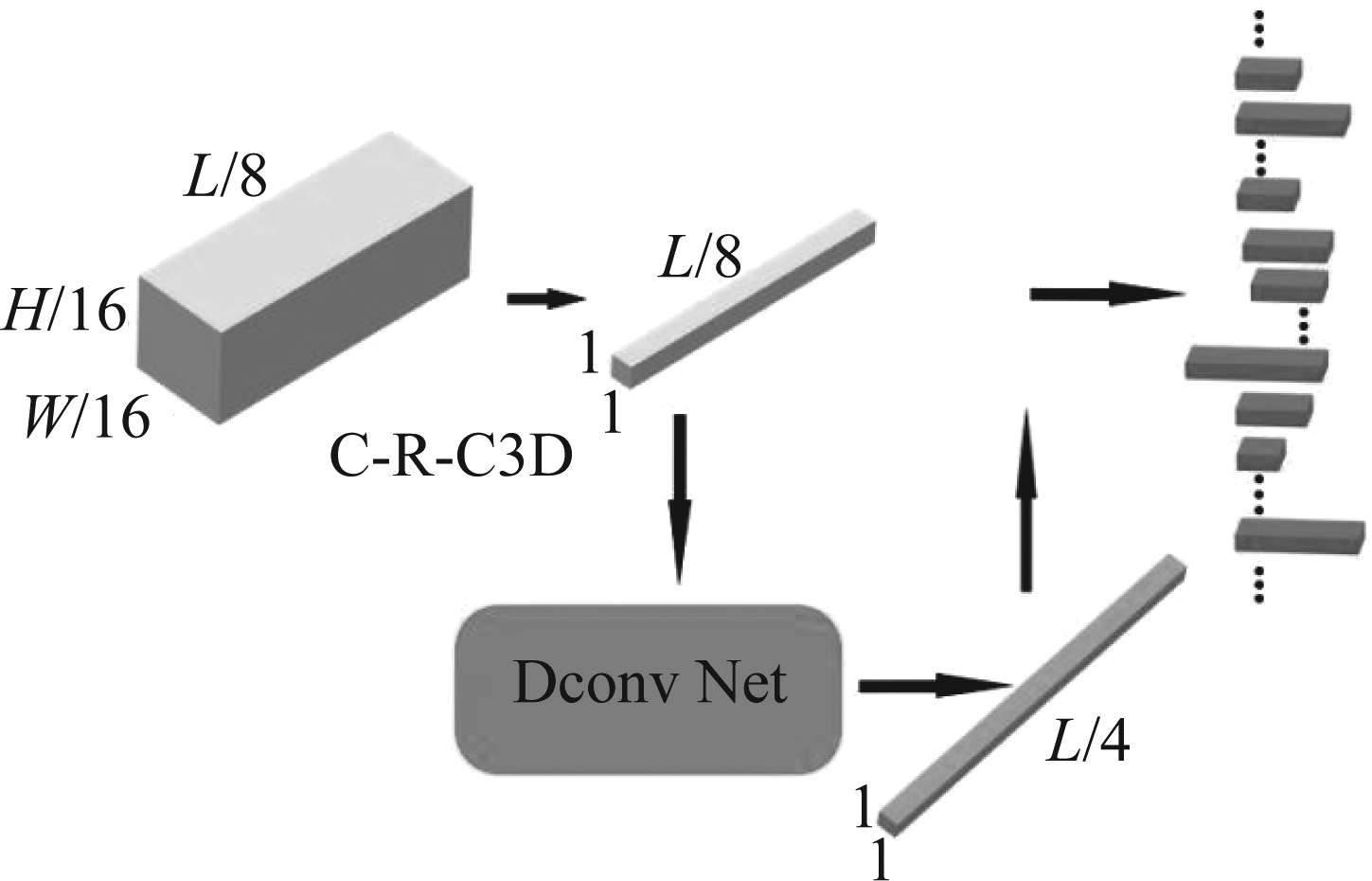

时序候选子网的输入为特征提取子网输出(L/8,H/16,W/16)尺寸的特征图。需转为(L/8,1,1)尺寸后在时间轴提取候选段,R-C3D网络的方法是使用(1,H/16,W/16)尺寸的最大池化层经一次卷积将特征图变为(L/8,1,1)的尺寸。

宽、高直接变为1可能丢失图片空间上的信息,为提取行为在空间上更丰富的信息,提出在空间域上改进的逐层空间卷积方法C-R-C3D:令上述原R-C3D的卷积方法为C1-R-C3D,C2-R-C3D为通过(3,3,3)尺寸的卷积层和(1,H/16,W/16)尺寸的最大池化层,C3-R-C3D为通过尺寸为(3,3,3)和(3,5,5)的卷积层及尺寸为(1,2,2)的最大池化层,C4-R-C3D为通过尺寸为(3,3,3)、(3,3,3)和(3,3,3)的卷积层及尺寸为(1,2,2)的最大池化层。C4-R-C3D达到了本文提出的C-R-C3D方法的卷积层数上限,即4层。时序候选子网中实现C-R-C3D方法的具体部位为图2画框区域。

图2 C-R-C3D方法

Fig.2 C-R-C3D method

各阶C-R-C3D方法的卷积层如图3所示。

图3 各阶C-R-C3D方法

Fig.3 C-R-C3D method of each order

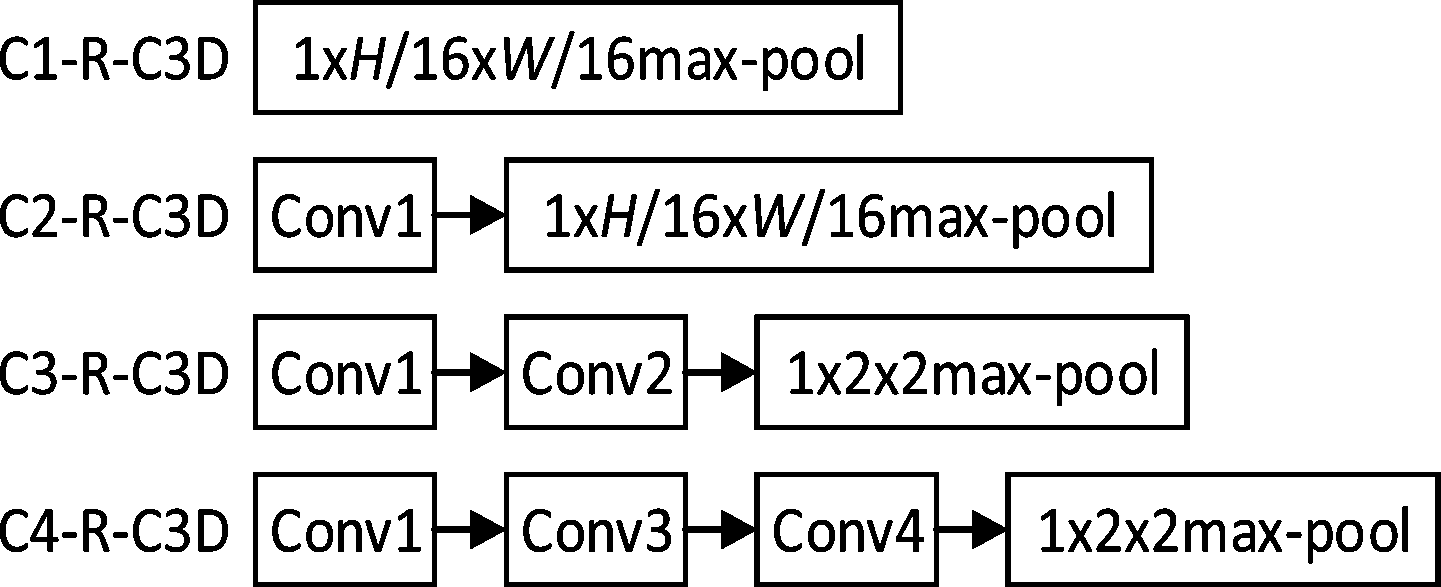

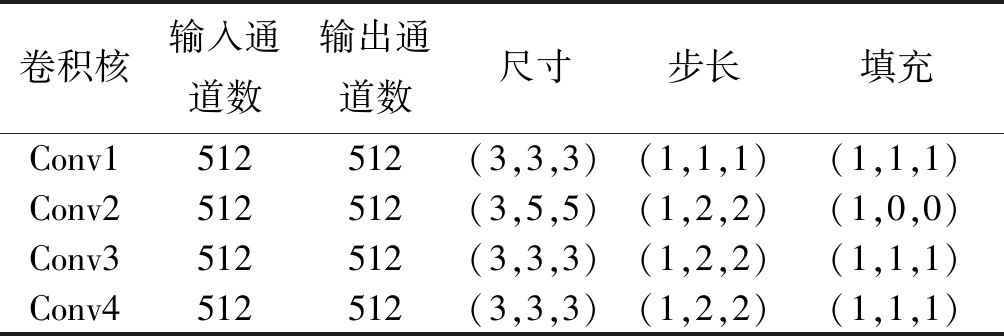

各个卷积核的输入通道数、输出通道数、尺寸、步长、填充具体值如表1。

表1 C-R-C3D方法所用的卷积核

Tab.1 Convolution kernel used in C-R-C3D method

卷积核输入通道数输出通道数尺寸步长填充Conv1512512(3,3,3)(1,1,1)(1,1,1)Conv2512512(3,5,5)(1,2,2)(1,0,0)Conv3512512(3,3,3)(1,2,2)(1,1,1)Conv4512512(3,3,3)(1,2,2)(1,1,1)

经C-R-C3D方法得到尺寸(L/8,1,1)的特征图,特征图的宽、高为1,即平面空间只考虑1个像素,时间轴上考虑L/8长度内的视频时序信息。

2.2.2 时域反卷积-逐层空间卷积算法

借助CDC网络中反卷积操作的思想,即采用反卷积操作将特征图在时间轴的长度变长,结合C-R-C3D方法,提出在时空域上同时改进的时域反卷积-逐层空间卷积算法DCC-R-C3D。DCC-R-C3D算法实现的时序候选子网如图4所示。

图4 DCC-R-C3D算法

Fig.4 DCC-R-C3D algorithm

DCC-R-C3D算法将时序候选子网中的特征图经反卷积由尺寸(L/8,1,1)延长为(L/4,1,1),即特征图在时间轴的长度增倍,宽、高不变。

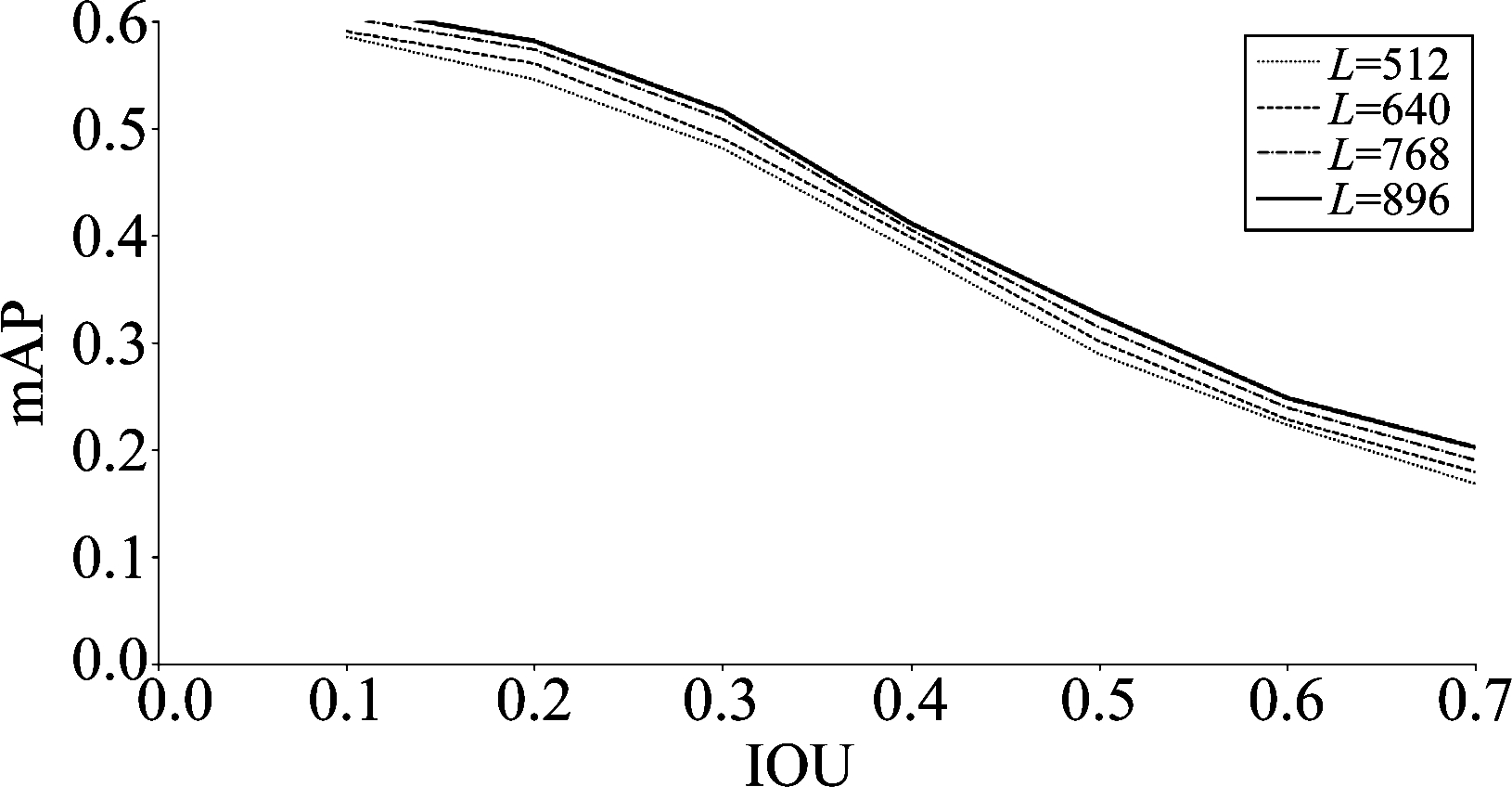

反卷积网络实际增加了特征图长度,特征图长度和输入视频长度共用变量L,由对应关系知,特征图长度与输入视频长度成正比,为证明CDC网络中的反卷积操作增加特征图长度从而提高检测精度的思想同样适用于R-C3D网络,在文章的后续做了对比实验一:直接改变输入视频长度L,研究不同输入视频时间长度L能否影响行为检测网络的精度。此环节中,结果是随着输入视频的长度L增加,行为检测网络精度也在增加,所以结论是较长的特征图对应着较高的行为检测网络精度,该对比实验证明了可引用CDC网络中反卷积的思想,即对视频时空域同时改进的DCC-R-C3D算法的正确性。

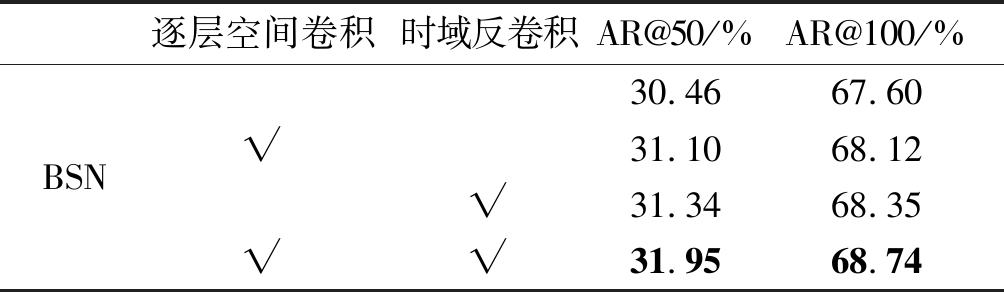

由于本文提出的DCC-R-C3D算法作用于R-C3D网络的时序候选子网,时序候选子网的任务是从包含时序信息的特征图中提取包含人体动作的边界区间,即DCC-R-C3D算法优化的是生成动作边界的位置。行为检测是由动作边界定位和边界内动作识别共同完成的,而动作识别的研究目前已趋于成熟,影响行为检测精度的因素主要在于动作边界的确定。R-C3D是端到端的实现行为检测的网络,无法单独评估动作边界定位这项指标,为了验证DCC-R-C3D算法提高行为检测网络的检测精度是由优化动作区间的定位而引起的,在文章的后续做了对比实验二:将DCC-R-C3D算法引入到边界敏感网络(BSN[15]),BSN由时序评估模块、提名生成模块和提名评估模块组成。BSN针对时序提名生成任务,能单独生成行为片段的定位边界,评估指标为召回率。此环节中,将DCC-R-C3D中的逐层空间卷积、时域反卷积两部分按照不同组合方式引入BSN的时序评估模块,做消融实验,来观察DCC-R-C3D算法对BSN网络定位动作边界召回率的影响。结果是引入了DCC-R-C3D算法的BSN对于动作的定位拥有更高的召回率。该对比实验验证了DCC-R-C3D算法是通过提高动作区间定位精度的方式提高了时序行为网络的检测精度。

2.3 行为分类子网

该子网的输入由两部分组成:第一部分为特征提取子网提取的特征,第二部分为时序候选子网生成的时序候选段,结合第一个子网所提取的特征和第二个子网生成的时序候选段,将各个候选边界内的视频进行分类与回归位置微调,分类和回归任务共同优化,分类使用softmax损失函数,回归使用平滑的L1损失函数。总体公式如下:

(1)

式中,Ncls和Nreg分别代表批处理大小和时序候选段的数量,ai是提议或动作预测的可能性,![]() 代表相应的动作真实标签,λ为常系数,

代表相应的动作真实标签,λ为常系数,![]() 表示时序候选段相对偏移,

表示时序候选段相对偏移,![]() 代表对应坐标转换的真实边界框,坐标转换如下:

代表对应坐标转换的真实边界框,坐标转换如下:

(2)

其中,ci和li分别表示时序候选段的中心位置和长度,而![]() 和

和![]() 分别表示相应的真实边界框的中心位置和长度。上面的损失函数同时运用于时序候选子网和行为分类子网,时序候选子网中,二元损失函数预测是否包含行为,回归损失优化候选框和真实边界框之间的相对偏移;行为分类子网中,多元损失函数预测行为的具体类别,类别总数为21,包含20类行为和1个背景类,回归损失同样地优化候选框和真实边界框之间的相对偏移。

分别表示相应的真实边界框的中心位置和长度。上面的损失函数同时运用于时序候选子网和行为分类子网,时序候选子网中,二元损失函数预测是否包含行为,回归损失优化候选框和真实边界框之间的相对偏移;行为分类子网中,多元损失函数预测行为的具体类别,类别总数为21,包含20类行为和1个背景类,回归损失同样地优化候选框和真实边界框之间的相对偏移。

同时,利用非极大值抑制(Soft-NMS)算法[16],去除冗余的边界框,在Soft-NMS中,对于与最大置信度分数的候选框相比,交并比(IOU)大于一定阈值的框乘以一个与IOU相关的系数,最终得到更新后的IOU值,此时,当拥有最大置信度分数的候选框与其余候选框所算得的新的IOU大于一定阈值Nt时,这些多余的候选框就被抑制掉了:

式中,Nt为阈值,iou(M,bi)为计算M与bi间的交并比函数,M为拥有最大置信度分数的候选框,bi为其余的候选框,si为窗口得分。

3 实验结果与分析

3.1 实验环境与方法

实验环境所用GPU为两块NVIDIA GTX1080Ti显卡,计算机操作系统为Ubuntu16.04,实验所用的数据集为THUMOS Challenge 2014官网下载的THUMOS14数据集。针对本文提出的DCC-R-C3D改进算法,分类使用Softmax损失函数,回归使用平滑的L1损失函数,优化器采用的是随机梯度下降算法(SGD),批处理的大小(batchsize)设置为2,学习率设为10-4,训练轮数最大值为5。

R-C3D网络由特征提取子网、时序候选子网、行为分类子网组成。本文针对影响时序候选子网行为分类的因素,对视频做逐层空间卷积,即C-R-C3D方法;针对影响时序候选子网行为定位的因素,对视频做时域反卷积,结合C-R-C3D,提出DCC-R-C3D算法。本文提出的基于DCC-R-C3D算法改进的R-C3D网络由于同时考虑了行为的时空特性,有着更好的检测精度。为方便读者理解本文提出的DCC-R-C3D算法,作者将该算法源码开源在了https:∥github.com/tx-ai/DCC-R-C3D.git。

3.2 数据准备

首先从行为检测数据集官网上下载THUMOS2014数据集,并按照官网给出的标签将每个视频归类并将视频用帧表示,再将帧数据通过由DCC-R-C3D算法改进后的R-C3D网络,得到预测值,结合标签,训练卷积神经网络模型。

THUMOS14数据集包含大量的人类动作在真实环境中的视频。动作包括日常生活动作和体育动作。THUMOS14可进行两个任务,动作识别:对于目标动作类,预测某个视频包含某种动作,视频是剪辑好的短视频;时序动作检测:对于未剪辑过的视频,不仅判断视频中包含哪些动作,而且判断动作在视频的时间位置,即动作的开始和结束时间。

其中时序动作检测用到的数据集中,训练集包含20个类,共200个视频,测试集包含20个类,共213个视频。图5是该数据集中部分采样的帧。

图5 实验数据集THUMOS2014

Fig.5 Experimental data set THUMOS2014

3.3 实验结果与分析

3.3.1 逐层空间卷积方法

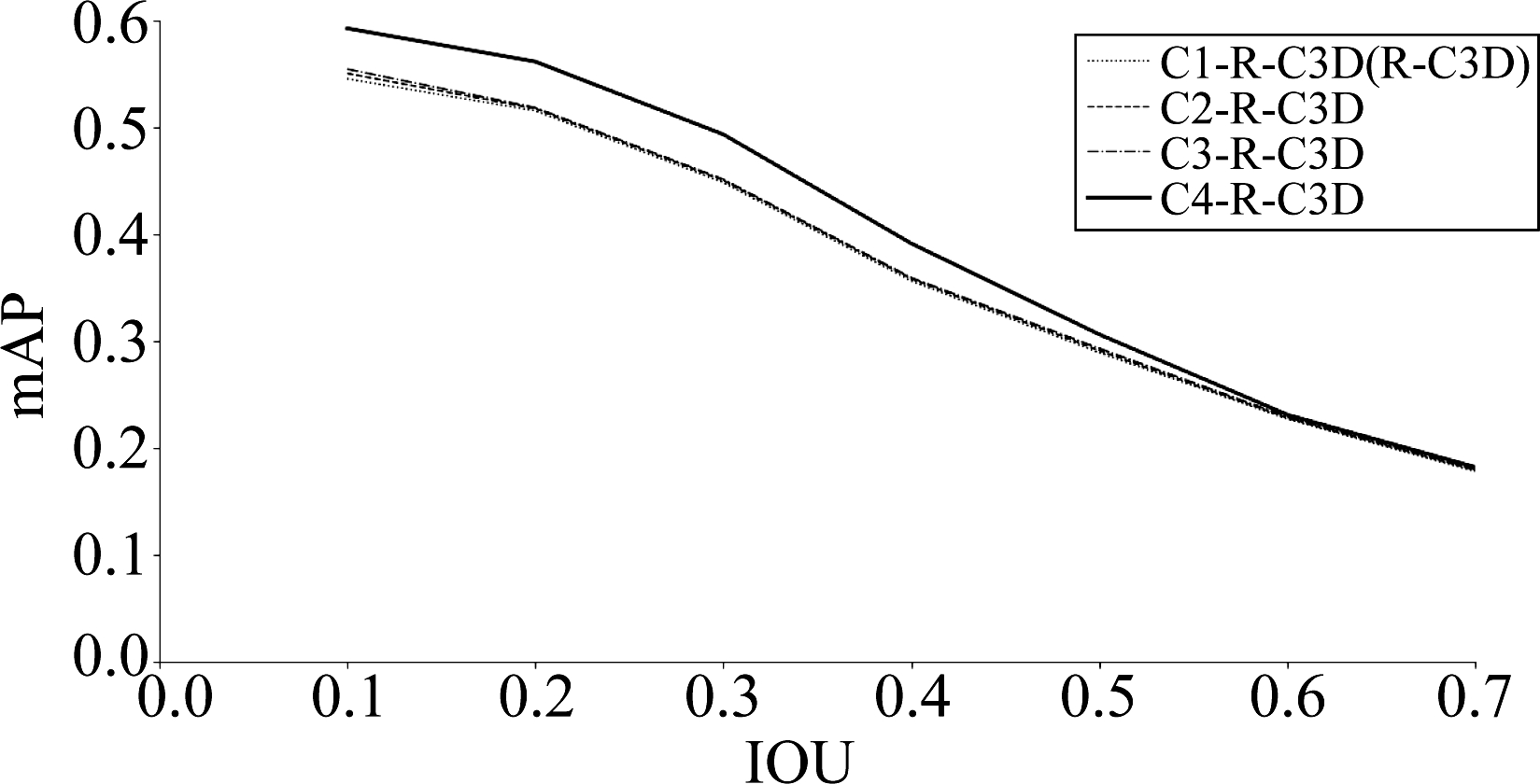

各阶C-R-C3D方法包括,C1-R-C3D:一个最大池化层;C2-R-C3D:一个卷积层和一个最大池化层;C3-R-C3D:两个卷积层和一个最大池化层;C4-R-C3D:三个卷积层和一个最大池化层。时序候选子网中,C-R-C3D方法实现的效果是将特征图的宽、高由(H/16,W/16)变为(1,1),特征图在时间轴上的长度保持L/8不变。各阶C-R-C3D方法最终得到的改进R-C3D时序行为检测网络在视频时间长度L=768时的mAP与IOU之间的关系如图6。

图6 各阶C-R-C3D方法改进的R-C3D网络对应mAP曲线图

Fig.6 Corresponding mAP curve diagram of the improved R-C3D network of each order of C-R-C3D method

由mAP-IOU曲线图可知,C-R-C3D方法随着阶数的增高,检测精度也随之增高,4阶C4-R-C3D方法改进的 R-C3D网络的检测精度最高。各阶C-R-C3D方法改进的R-C3D网络在IOU=0.5,视频时间长度L=768时的mAP如表2。

表2 各阶C-R-C3D算法改进的R-C3D网络当IOU=0.5时的mAP

Tab.2 The mAP of the R-C3D network improved by the C-R-C3D algorithm of each order when IOU=0.5

各阶C-R-C3D视频时长L/帧IOUmAP/%C1-R-C3D (R-C3D)7680.528.9C2-R-C3D7680.529.1C3-R-C3D7680.529.3C4-R-C3D7680.530.6

由表可知,C4-R-C3D改进的 R-C3D网络精度为30.6%,比原R-C3D网络提高了1.7%。宽、高由(H/16,W/16)变为(1,1)的过程实际上就是对视频画面也就是空间域上的变换,空间域上一定范围内卷积次数的增加能提取行为在空间上的更多信息,对各行为类别的类间差异有着更好的区分。

3.3.2 时域反卷积-逐层空间卷积算法

以4阶 C4-R-C3D方法为基准,即后续研究使用的C-R-C3D方法均是指C4-R-C3D。

借用CDC网络中反卷积操作的思想:在时间域进行上采样,将时间轴上特征图的长度延长,从而能提取视频内行为更多的时序信息,确定行为的时序边界。结合C-R-C3D方法,提出了时域反卷积-逐层空间卷积算法DCC-R-C3D。DCC-R-C3D算法的核心思想是:既能满足空间域上行为类别的精确分类,又能满足时间域上行为边界的精确定位。

得到(L/8,1,1)的特征图后,CDC网络将此处L/8经反卷积变为L,增大特征图长度。因特征图长度过长会增大GPU运算耗费的显存,GPU资源有限情况下,采用反卷积操作时,本文只将特征图长度增加到L/4。DCC-R-C3D算法改进的R-C3D网络在IOU=0.5,视频时间长度L=768时的mAP如表3。

表3 由DCC-R-C3D算法改进的R-C3D网络当IOU=0.5时的mAP

Tab.3 The mAP of R-C3D network improved by DCC-R-C3D algorithm when IOU=0.5

算法视频时长L/帧IOUmAP/%C-R-C3D7680.530.6DCC-R-C3D7680.531.4

由表3可知,DCC-R-C3D算法改进的R-C3D网络精确度为31.4%,比C-R-C3D方法直接改进的R-C3D网络提高了0.8%。反卷积操作实际改变了特征图在时间轴上的长度,增大了行为在时序边界上的特征值数量,从而能反映出更精确的时序边界。

对比实验一:

以上C-R-C3D方法和DCC-R-C3D算法均是在视频时间长度L=768时实施的,而由DCC-R-C3D算法得出的结论:增加特征图的长度能够提高网络的检测精度。为增加该结论的说服性,在此做了对比实验:显然,特征图长度与输入视频时间长度成正比,从输入视频时间长度的角度出发,直接增加输入视频时间长度L,观察网络的检测精度是否随之提高。即对比实验为:保持网络结构不变,改变输入的视频时间长度L,观察网络的检测精度的变化。此时,分别取输入视频的时间长度L为 512、640、768、896,观察mAP与IOU之间的关系,结果如图7。

图7 不同视频时间长度L对应mAP曲线图

Fig.7 The corresponding mAP curve of different video time length L

由mAP-IOU曲线图可知,随着视频时间长度L的增大,检测精度随之提高。证明结论正确,DCC-R-C3D算法通过增加特征图长度的方式提高了R-C3D网络的检测精度。

对比实验二:

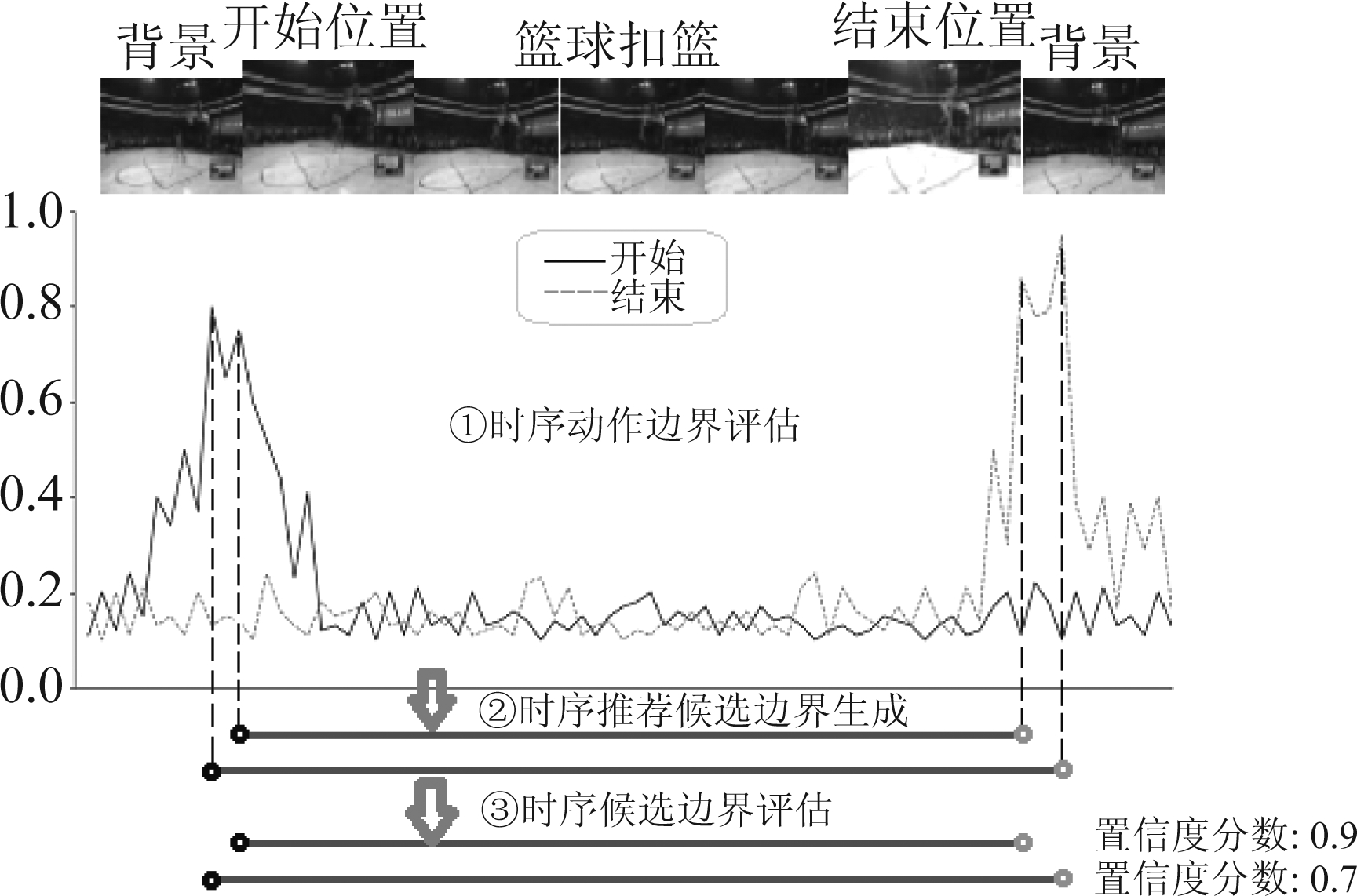

BSN主要包含三步:(1)时序动作边界评估,采用3层一维卷积对视频序列每个位置上动作开始、结束和进行的概率同时建模,生成动作开始、结束和进行的概率序列。(2)时序推荐候选边界生成,根据动作开始和结束的概率序列生成候选集,并在开始、中间、结束三个位置提取特征,得到每个候选边界的特征。(3)时序候选边界评估,利用(2)的特征对(2)的候选边界打分评估,滤去冗余边界。

图8 边界敏感网络(BSN)

Fig.8 Boundary Sensitive Network(BSN)

为了验证DCC-R-C3D算法是通过提高行为边界的定位精度从而提高了R-C3D行为检测网络的检测精度,将DCC-R-C3D算法引入到BSN的时序评估模块中,对特征图在空间域逐层下采样以及在时间域上采样。表4列出了DCC-R-C3D算法中的逐层空间卷积和时域反卷积对BSN的AR@AN的影响,AR为平均召回率,AN为候选边界的平均数量。

由表4知:(1)相较于原始BSN,单独使用逐层空间卷积或时域反卷积对BSN性能均有所提高。(2)逐层空间卷积联合时域反卷积,即DCC-R-C3D算法在候选边界数量分别为50和100时,平均召回率分别达到了31.95%和68.74%,相较于原BSN分别提高了1.49%和1.14%。实验证明了DCC-R-C3D算法有助于提取更精确的行为边界,从而使R-C3D行为检测网络获得了更高的行为检测精度。

表4 DCC-R-C3D算法对BSN整体性能的贡献

Tab.4 Contribution of DCC-R-C3D algorithm to the overall performance of BSN

逐层空间卷积时域反卷积AR@50/%AR@100/%BSN30.4667.60√31.1068.12√31.3468.35√√31.9568.74

3.4 算法比较与可视化结果

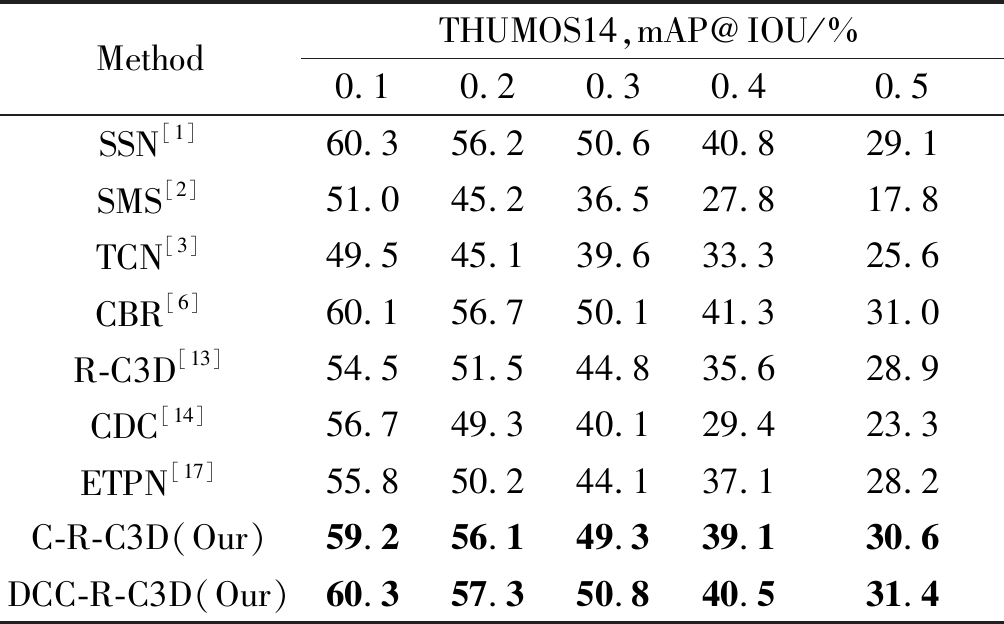

本文从视频中行为空域分类的角度,提出逐层空间卷积方法C-R-C3D,从视频每帧的空间上提取出更多包含人体行为的特征,提高行为的分类精度;从视频中行为时序的角度出发,结合C-R-C3D方法,借助CDC网络中反卷积操作增加特征图长度的思想,提高行为在时间轴上的定位精度,提出时域反卷积-逐层空间卷积算法DCC-R-C3D,对长时间未分割视频中的人体行为的检测表现出了其优势。表5比较了IOU从0.1到0.5,几种经典时序行为检测网络和本文提出的C-R-C3D方法以及DCC-R-C3D算法改进的网络的mAP,数据集使用的是THUMOS14公开数据集。

表5 改进算法和各经典算法的mAP比较

Tab.5 Comparison of mAP between the improved algorithm and the classic algorithms

MethodTHUMOS14,mAP@IOU/%0.10.20.30.40.5SSN[1]60.356.250.640.829.1SMS[2]51.045.236.527.817.8TCN[3]49.545.139.633.325.6CBR[6]60.156.750.141.331.0R-C3D[13]54.551.544.835.628.9CDC[14]56.749.340.129.423.3ETPN[17]55.850.244.137.128.2C-R-C3D(Our)59.256.149.339.130.6DCC-R-C3D(Our)60.357.350.840.531.4

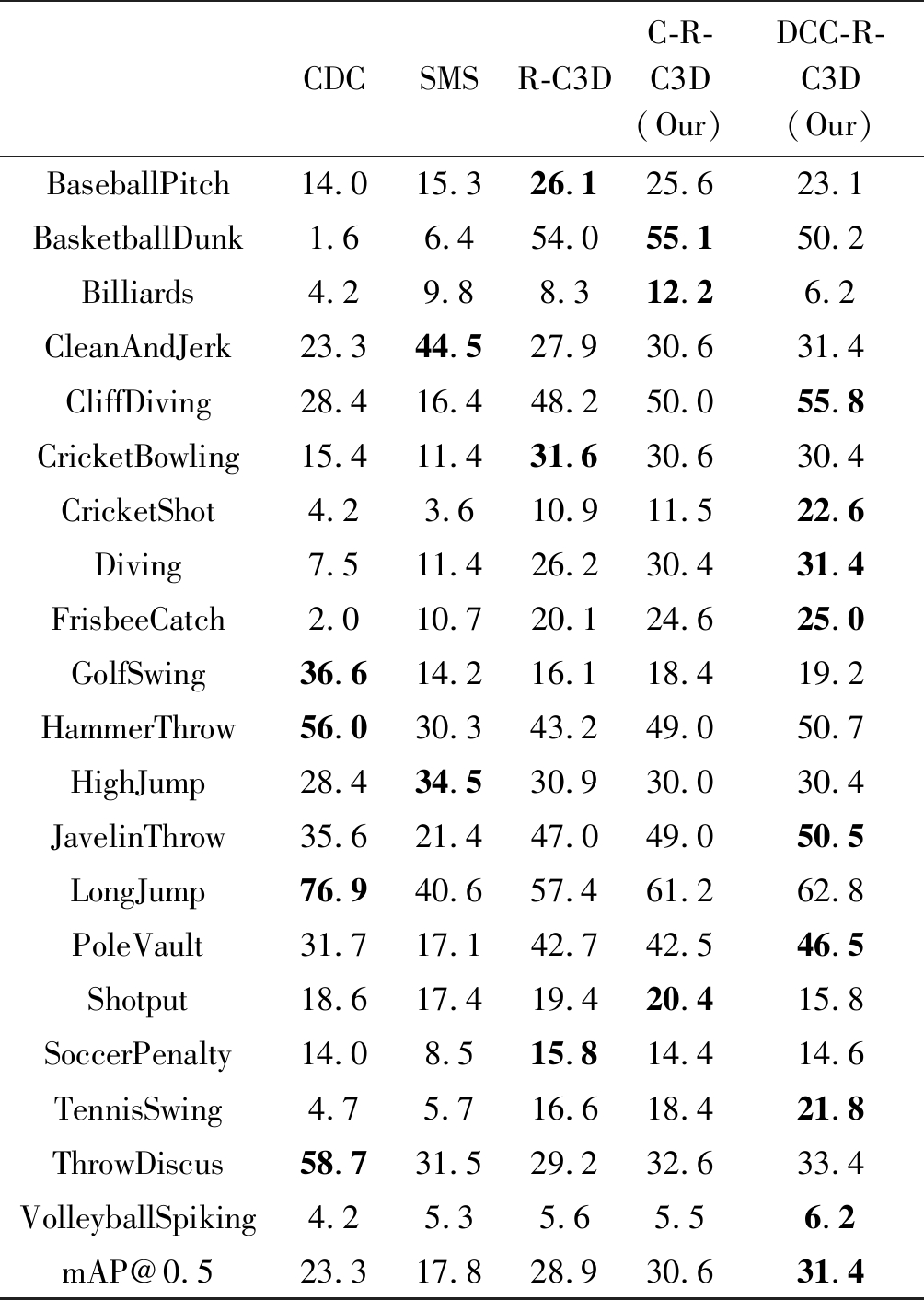

由于通过逐层空间卷积增加了空间上的特征数量,通过时域反卷积操作增加了特征图在时间轴上长度,所以经过DCC-R-C3D算法改进的网络能提取长时间范围内行为更丰富的时空信息,对行为检测精度有着明显的提高。表6展示了算法对THUMOS14数据集内各类动作的检测精确度,以及对这20类动作求和做平均后的mAP。其中,对于DCC-R-C3D算法改进的网络,CliffDiving(悬崖跳水)、CricketShot(板球射击)、JavelinThrow(标枪投掷)、PoleVault(撑竿跳高)等包含长时间运动信息的行为的精确度分别达到了55.8%、22.6%、50.5%、46.5%,20类动作的平均精确度达到了31.4%。优于目前大部分的时序行为检测网络。

表6 THUMOS14数据集内各种行为的AP(以百分比为单位)比较

Tab.6 Comparison of AP (in percentage) of various behaviors in the THUMOS14 dataset

CDCSMSR-C3DC-R-C3D(Our)DCC-R-C3D(Our)BaseballPitch14.015.326.125.623.1BasketballDunk1.66.454.055.150.2Billiards4.29.88.312.26.2CleanAndJerk23.344.527.930.631.4CliffDiving28.416.448.250.055.8CricketBowling15.411.431.630.630.4CricketShot4.23.610.911.522.6Diving7.511.426.230.431.4FrisbeeCatch2.010.720.124.625.0GolfSwing36.614.216.118.419.2HammerThrow56.030.343.249.050.7HighJump28.434.530.930.030.4JavelinThrow35.621.447.049.050.5LongJump76.940.657.461.262.8PoleVault31.717.142.742.546.5Shotput18.617.419.420.415.8SoccerPenalty14.08.515.814.414.6TennisSwing4.75.716.618.421.8ThrowDiscus58.731.529.232.633.4VolleyballSpiking4.25.35.65.56.2mAP@0.523.317.828.930.631.4

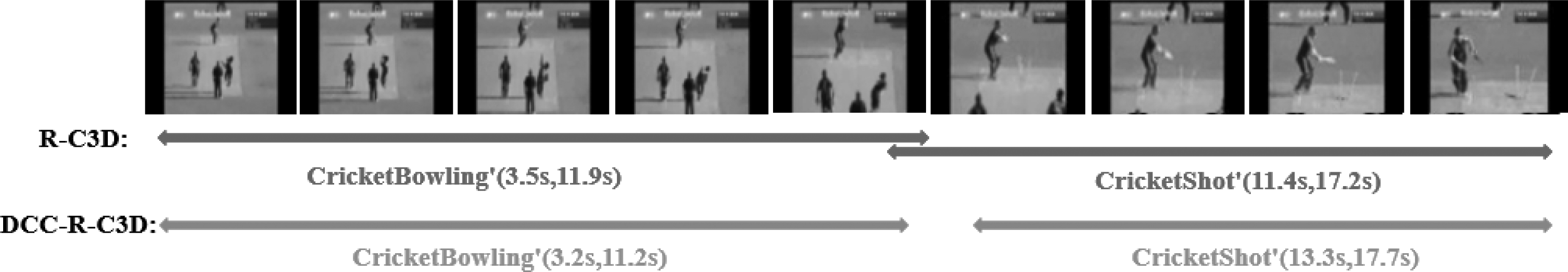

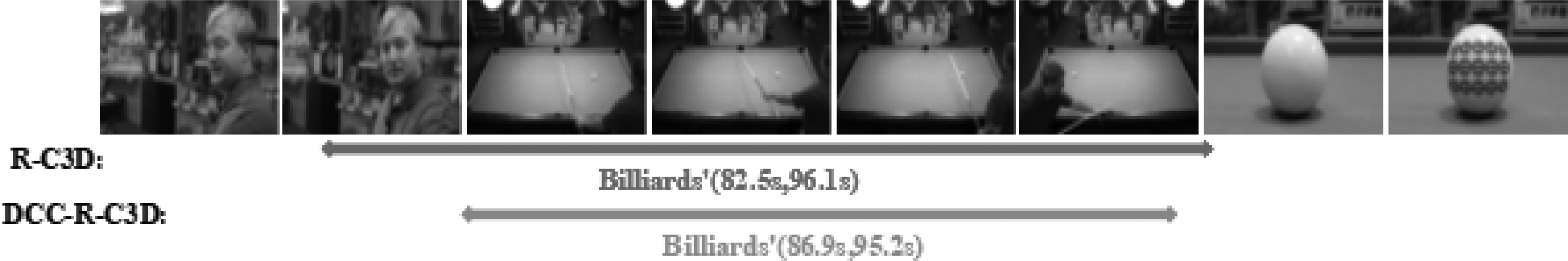

分别将测试视频通过训练好的原R-C3D网络和由本文提出的DCC-R-C3D算法改进后的网络,得到检测结果。图9为板球运动,包含CricketBowling和CricketShot两类动作,可以看到对于该长时间包含多种人体行为的视频,原R-C3D网络对两类行为在时间轴上的定位出现了混淆,没有把两类行为的时序边界很好的区分开,而由DCC-R-C3D算法改进后的网络则很好区分了两类行为,实现了行为在时间轴上的精确定位和行为类别的识别。图10为台球运动,可以看到行为前后都存在非行为的背景因素,原R-C3D网络的检测结果里混入了少量背景,而DCC-R-C3D算法改进的网络则很好的区分了行为和背景之前的差异。实验结果表明了由DCC-R-C3D算法改进的R-C3D网络在时序行为检测上有更优异的性能。

图9 板球运动在R-C3D和DCC-R-C3D网络上的检测结果

Fig.9 Detection results of cricket on R-C3D and DCC-R-C3D networks

图10 台球运动在R-C3D和DCC-R-C3D网络上的检测结果

Fig.10 Detection results of billiards on R-C3D and DCC-R-C3D networks

4 结论

本文提出逐层空间卷积方法C-R-C3D,且发现高阶C-R-C3D方法在视频空间域上拥有更优的行为分类精度。在C-R-C3D方法的基础上,借用CDC网络中反卷积操作增加特征图长度的思想,提出了时域反卷积-逐层空间卷积算法DCC-R-C3D,改进了R-C3D网络,并验证了其可行性与其提高检测精度的内在原因。相比于原始R-C3D网络,经DCC-R-C3D算法改进后的R-C3D网络能同时在视频的时空域上表现出较高的行为检测精度。时序行为检测可用于多个领域,例如对长视频的自动剪裁分类、智能监控等等,由于时序行为检测在目前的研究阶段所表现的检测精度并不高,故还有很大的研究空间去不断提升时序行为检测算法的精度,提高其可用性。未来的工作将从去除视频中的背景因素的角度出发,进一步提高对视频空间域中人体行为的分类精度,例如,构建合适的目标检测及目标跟踪算法,对输入视频进行预处理来去除背景等。

[1] ZHAO Y, XIONG Y, WANG L, et al. Temporal action detection with structured segment networks[J]∥Proceedings of the IEEE International Conference on Computer Vision(ICCV), 2017: 2914-2923.

[2] YUAN Z, STROUD J C, LU T, et al. Temporal action localization by structured maximal sums[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition(CVPR), 2017: 3684-3692.

[3] DAI X, SINGH B, ZHANG G, et al. Temporal context network for activity localization in videos[C]∥Proceedings of the IEEE International Conference on Computer Vision(ICCV), 2017: 5793-5802.

[4] REN S, HE K, GIRSHICK R, et al. Faster r-cnn: Towards real-time object detection with region proposal networks[J]. Advances in Neural Information Processing Systems, 2015: 91-99.

[5] SIMONYAN, KAREN, ZISSERMAN, et al. Two-Stream Convolutional Networks for Action Recognition in Videos[J]. Advances in Neural Information Processing Systems, 2014: 568-576.

[6] GAO J, YANG Z, NEVATIA R. Cascaded Boundary Regression for Temporal Action Detection[J]. ArXiv preprint arXiv: 1705.01180, 2017.

[7] LIN C, LI J, WANG Y, et al. Fast Learning of Temporal Action Proposal via Dense Boundary Generator[J]. AAAI Conference on Artificial Intelligence(AAAI), 2020: 11499-11506.

[8] HE K, ZHANG X, REN S, et al. Deep residual learning for image recognition[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition(CVPR), 2016: 770-778.

[9] SIMONYAN K, ZISSERMAN A. Very deep convolutional networks for large-scale image recognition[J]. ArXiv preprint arXiv: 1409.1556, 2014.

[10] 冯烨, 张索非, 吴晓富. 面向目标检测的SSD网络轻量化设计研究[J]. 信号处理, 2020, 36(5): 756-762.

FENG Ye, ZHANG Suofei, WU Xiaofu. A Light-weighted SSD Network Design for Object Detection[J]. Journal of Signal Processing, 2020, 36(5): 756-762.(in Chinese)

[11] TRAN D, BOURDEV L, FERGUS R, et al. Learning Spatiotemporal Features with 3D Convolutional Networks[C]∥IEEE International Conference on Computer Vision (ICCV), 2015: 4489- 4497.

[12] GIRSHICK R, DONAHUE J, DARRELL T, et al. Rich feature hierarchies for accurate object detection and semantic segmentation[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition(CVPR), 2014: 580-587.

[13] XU H, DAS A, SAENKO K, et al. R-C3D: Region Convolutional 3D Network for Temporal Activity Detection[C]∥Proceedings of the IEEE International Conference on Computer Vision(ICCV), 2017: 5783-5792.

[14] SHOU Z, CHAN J, ZAREIAN A, et al. CDC: Convolutional-De-Convolutional Networks for Precise Temporal Action Localization in Untrimmed Videos[J]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition(CVPR), 2017: 5734-5743.

[15] LIN T, ZHAO X, SU H, et al. Bsn: Boundary sensitive network for temporal action proposal generation[C]∥Proceedings of the European Conference on Computer Vision (ECCV), 2018: 3-19.

[16] BODLA N, SINGH B, CHELLAPPA R, et al. Soft-NMS—improving object detection with one line of code[C]∥Proceedings of the IEEE International Conference on Computer Vision(ICCV), 2017: 5561-5569.

[17] YANG K, QIAO P, LI D, et al. Exploring Temporal Preservation Networks for Precise Temporal Action Localization[J]. ArXiv preprint arXiv: 1708.03280, 2017.