1 引言

合成孔径雷达(Synthetic Aperture Radar, SAR)作为一种主动微波遥感成像技术,具有观测范围广、多极化、多分辨率、全天时全天候的特点,是对地观测的有效手段[1-7]。与SAR遥感技术相比,光学载荷受到成像条件干扰,如光照变化、云遮挡、伪装等因素,无法形成有效的持续观测,因此,光学载荷在目标监测系统中的实际应用受到了制约。随着SAR载荷成像技术的发展,其图像分辨率获得较大提升,但并未对SAR图像的智能解译带来本质上的改变。首先,由于SAR成像机理与人类视觉系统差异较大,使得高分辨率SAR图像目标可视性依旧较差;其次,SAR遥感图像中地物环境复杂,目标图像特性会随着成像参数、成像姿态、地物环境的不同而发生较大的变化,为SAR遥感图像的目标解译带来巨大的挑战。多年来,大量研究工作都聚焦于SAR遥感图像目标的智能解译当中,其中最具代表性的是美国麻省理工学院(Massachusetts Institute of Technology, MIT)林肯实验室于80年代提出的分层模块化SAR图像自动智能化解译处理流程,主要包含三个阶段:目标检测、目标鉴别和目标分类/识别。该处理流程简洁清晰,被广泛应用于SAR图像智能化解译系统当中。其中,第一级目标检测阶段,旨在从复杂的图像中提取出感兴趣目标区域(Region of interesting, ROI);然后,第二级目标鉴别阶段,进一步在感兴趣目标区域内鉴别出不包含目标的虚警信息;最后,第三级目标分类/识别阶段,在提取出目标切片信息的基础上对目标细粒度型号信息进行分类/识别。现阶段大量的研究工作着重于构建目标检测及鉴别方法,并取得了显著的成果[8-13],但是针对SAR遥感目标的细粒度型号分类/识别还未形成有效的方法,且由于传统机器学习算法在特征提取及分类能力上存在局限性,SAR遥感图像目标型号的判读仍然依赖专业人员,导致自动解译智能化程度低、处理时效性差,无法在实时处理系统中得到有效应用。因此,本文的研究内容主要聚焦于第三级目标分类/识别阶段,从而实现SAR遥感图像车辆目标的自动细粒度型号识别。

在SAR遥感图像车辆目标细粒度型号识别方面,部分学者开展了一些研究工作,整体的方法大致可以分为两类:(1)基于人工设计特征的方法;(2)基于数据驱动的卷积神经网络方法。对于人工设计特征方法,首先需要设计并选取有效的目标判别性特征描述规则,然后根据规则构建特征向量,最后送入分类器进行训练学习,从而实现细粒度型号识别。例如,由于单个散射中心在SAR图像域的特征表征易受到目标方位、雷达波入射方向、相干斑噪声等因素影响,唐涛等人[14]提出了散射中心特征序贯匹配的SAR图像目标识别方法,改善了以上缺点,在构建了多个峰值散射中心的几何绕射模型参数后,进行特征点集的欧式距离匹配,实现了3种型号车辆的识别;刘中杰等人[15]提出了基于稀疏表达的车辆目标识别方法,通过主成分分析(Principle Component Analysis, PCA),在避免预处理对于SAR图像目标信息的损失的同时,提取出了对于构建稀疏表达过完备字典的有效主成分特征,最后通过稀疏表达字典学习,生成具有判别性的稀疏编码特征,实现了5种型号的SAR车辆目标识别;张之光等人[16]对于SAR图像车辆切片,以非负矩阵分解提取局部特征的方式来构建稀疏表达字典的原子描述,并结合稀疏表达,实现了3类SAR车辆目标的分类;此外,康妙等人[17]对SAR遥感车辆目标切片提取了25种基线特征和局部纹理特征,然后将特征串联输入栈式自编码器(Stacked AutoEncoder, SAE)神经网络进行特征融合,实现了10种型号的SAR车辆目标识别。然而,由于受到不同姿态及入射角度的影响,同一目标不同姿态的散射信息差异较大,这些特征提取范式难以通过某一种或几种人工设计特征的组合形成有效的鲁棒性描述,且由于各种型号车辆的SAR成像散射特性类间差异小,用传统方法如模板匹配、支持向量机、稀疏表达等线性分类模型,难以达到较好的分类效果。近几年,AlexNet在2012年图片分类比赛ImageNet中取得了巨大的成功,使得图片识别错误率下降了14%,推动了深度学习在图像分类任务中的应用和发展,随后,相继出现的VGGNet[37]、ResNet[38]等深度学习分类网络在自然场景图像分类任务中均取得了不错的成果,因此,近年来很多研究工作均考虑采用深度学习分类网络架构来实现SAR遥感图像车辆目标细粒度型号识别任务[18-25]。Li Wang等人[26]提出了通道特征筛选模块嵌入的ESENet网络,实现了10种型号的SAR车辆目标识别;Cui Zongyong等人[27]提出了基于Yolov2网络的SAR遥感图像车辆目标检测识别一体化网络,实现了在复杂SAR遥感图像场景中针对10种型号车辆目标的快速检测识别;Qi Baogui等人[28]提出了基于PCANet的SAR遥感图像10种型号车辆目标的准确识别方法;Ding Jun等人[29]在基于深度学习卷积网络结构上验证了数据增强预处理对于SAR车辆目标型谱级识别的有效性,实验结果表明基于深度学习卷积网络架构,结合数据增强预处理操作可以获得更好的型号识别效果。综上所述,深度卷积神经网络具有较强的特征非线性映射能力,能够获取更鲁棒且有效的特征描述,以实现较高精度的目标型谱级识别,可广泛应用于SAR遥感图像目标识别任务。

然而,由于遥感场景与自然场景图像存在巨大差异,且SAR与光学成像机理存在很大不同之处,直接将深度卷积神经网络应用于SAR遥感图像目标识别任务不能发挥出最大的效能。因此,本文以高分辨率SAR遥感图像车辆目标型谱级智能解译为背景,采用深度卷积神经网络分类架构,结合多尺度特征提取及卷积特征的高阶表示实现了高精度的车辆目标型号识别。首先,卷积神经网络深度越深,便可以获取越为抽象的泛化特征,故本文采用ResNet-50为基础网络架构;然后,针对SAR遥感观测车辆具有多角度、多尺度、多分辨率和不同信噪比条件下成像差异性等问题,本文采用自动数据增强(AutoAugment Policy)方式,以16种单一图像处理方式作为搜索空间,通过强化学习搜索算法在策略空间中寻优,得到5个最优策略组合,最后将其连接为一个大数据增强策略,实现数据样本的增强,以提升模型对SAR遥感图像目标观测条件变化时特征提取的鲁棒性;其次,针对ResNet-50模型中的残差单元对于不同尺度的SAR图像散射特征获取能力差的问题,本文提出了金字塔卷积残差特征提取单元,使网络可以捕获不同尺度下SAR遥感车辆图像局部及全局的散射信息,实现了更有效的特征提取;最后,对于卷积神经网络“堆栈”式逐层卷积特征提取方式对于图像总体结构及细节信息的损失问题,本文提出了基于卷积结构的高阶特征表示方式,可更有效地对车辆目标型号间的差异性进行细粒度特征描述,实现高精度的型谱级车量目标识别。网络具体结构如图1所示。此外,本文采用提出的高阶特征表示的多尺度残差卷积网络(Multi-Scale Residual Convolution Neural Network with High Order Feature Representation, HOF+PyconvResNet50)在MSTAR (Moving and Stationary Target Acquisition and Recognition)数据集上,针对10种车辆目标型号识别开展了详细的实验,结果表明了本文提出方法的有效性,并取得了99.88%的识别总体精度(Overall Accuracy, OA),相较于原始的ResNet-50提升了1.20%,指标明显优于现有其他的目标型号识别算法。本文的研究工作的贡献可以总结为以下三点:

(1)针对SAR遥感图像车辆目标识别任务提出了一套有效的细粒度识别算法,对10种型号车辆多角度、多尺度、多分辨和多信噪比的观测数据,实现了高精度的目标型谱级识别,实验结果明显优于现有识别算法;

(2)针对现有卷积网络残差单元对于不同尺度特征获取能力较差的缺陷,提出了金字塔卷积残差特征提取单元,提升了网络对于SAR图像局部及全局散射信息的特征提取泛化能力;

(3)针对卷积神经网络“堆栈”式逐层卷积结构,对SAR遥感图像车辆目标进行特征描述时易丢失结构及细节信息的问题,提出了基于卷积结构的高阶特征表示方式,有效提升了深度卷积网络对于细粒度型号识别任务的特征提取及泛化能力。

本文后续内容如下:在第2节将对提出的高阶特征表示的多尺度残差网络算法进行详细介绍;在第3节采用了多个现有分类/识别算法作为对比,对本文提出算法进行了详细的实验分析;在第4节对本文的工作进行了总结。

2 基于高阶特征表示的多尺度残差卷积网络

2.1 算法总体介绍

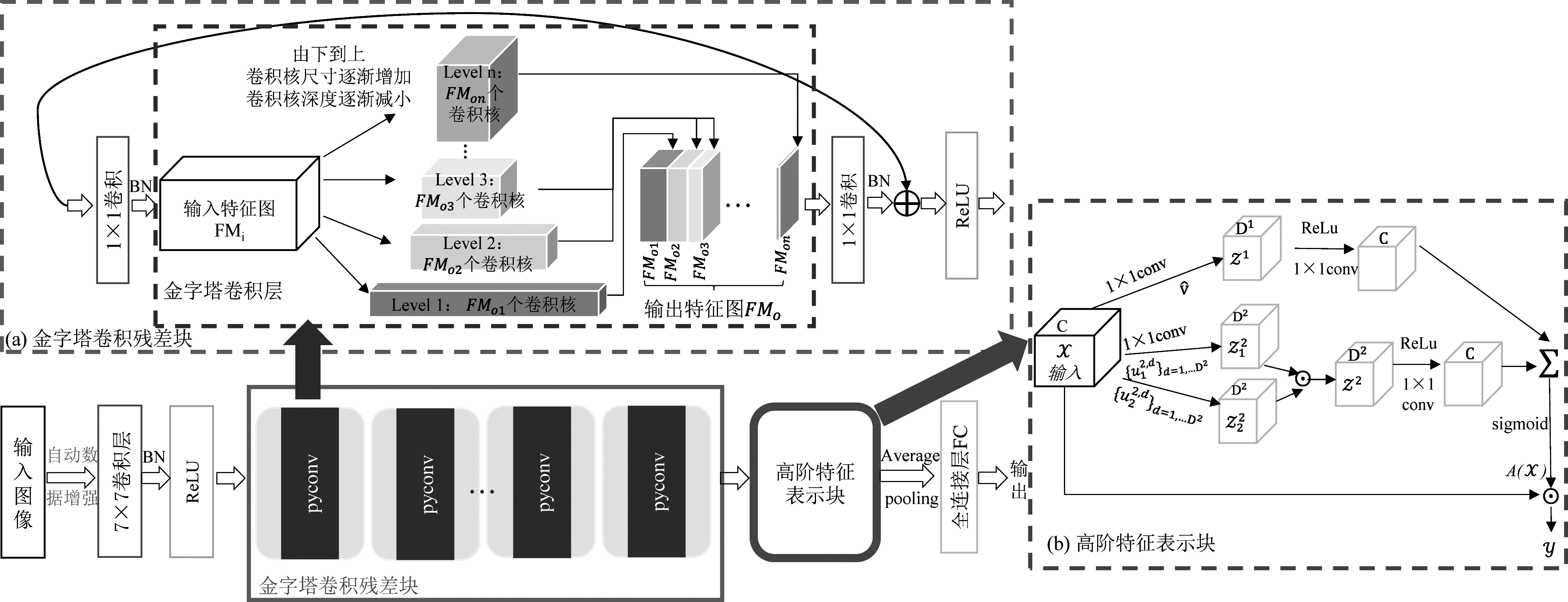

本文提出的高阶特征表示的多尺度残差卷积网络架构如图1所示,该方法在ResNet-50网络的基础上,对残差单元进行优化,构建的金字塔卷积残差模块(如图1(a)),通过将不同尺寸及深度的卷积核嵌入到残差模块中,实现了多尺度的特征提取;其次,特征提取层之后,进一步引入了高阶特征表示(如图1(b)),整体高阶特征表示是基于1×1卷积及张量对应元素相乘,可以有效提升目标细粒度的识别能力。由于Jun Ding等人[29]的工作证明了数据增强对于SAR遥感图像目标型号识别的有效性,以及SAR遥感图像目标成像时,同一个目标受不同因素影响其图像散射特性具有的差异性,本文提出的算法采用了一种自动数据增强方式来提升网络的鲁棒性。综上,本文将依据图1分别对2.2 数据预处理(样本自动数据增强)、2.3 多尺度残差特征提取、2.4 高阶特征表示这三个部分进行详细的阐述。

图1 网络总体架构图

Fig.1 Overall network architecture

2.2 数据预处理

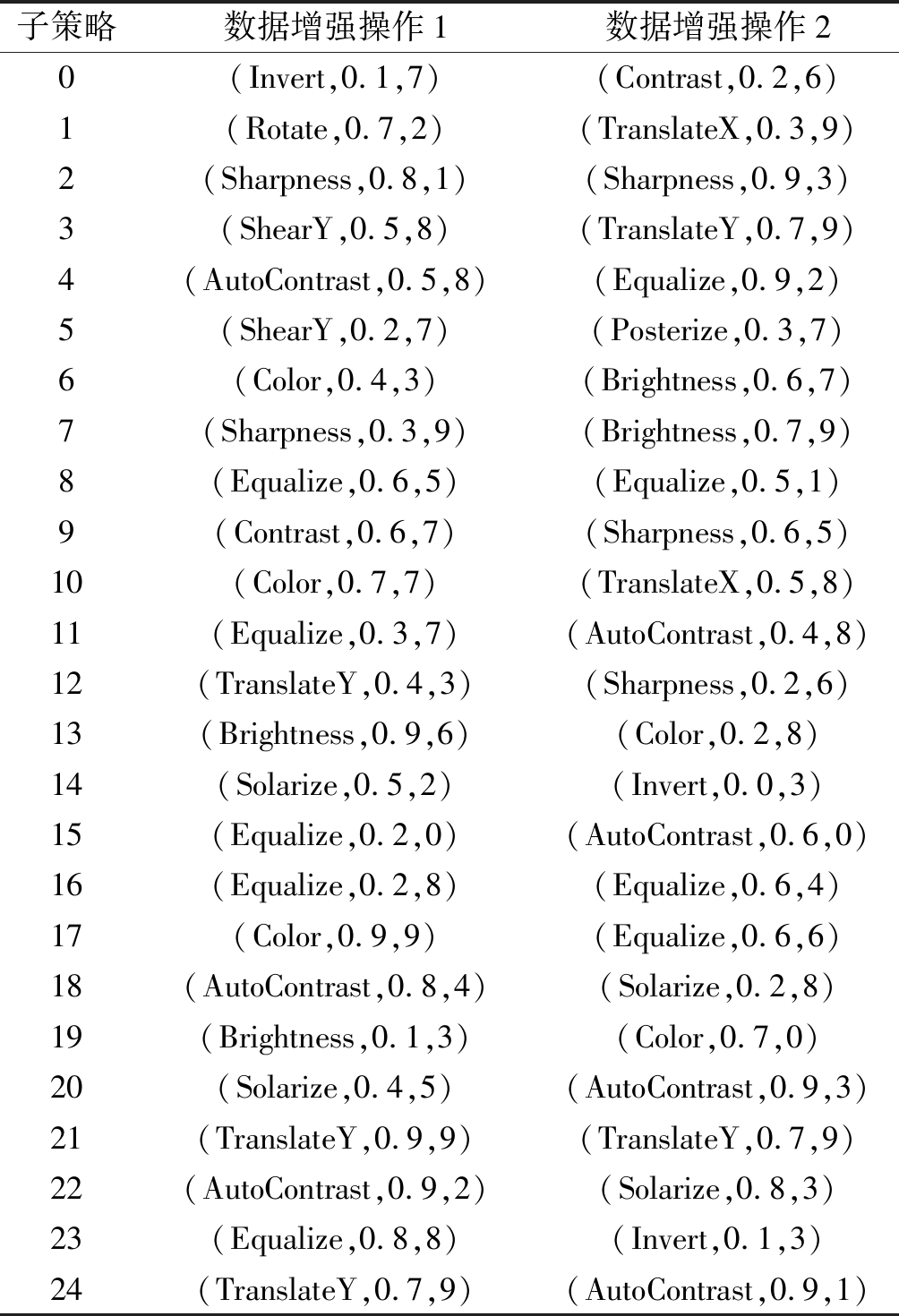

本文采用AutoAugment Policy[30]自动数据增强对训练集图像进行预处理。与之前手动设计的数据增强不同,AutoAugment通过自动搜索来找到合适的数据增强策略。AutoAugment算法首先设计了一个搜索空间,一个策略由5个子策略组成,每个子策略又由两个要依次应用的图像操作组成,图像操作包括16个:ShearX/Y,TranslateX/Y,Rotate,AutoContrast,Invert,Equalize,Solizeize,Posterize, Contrast,Color,Brightness,Sharpness,Cutout[31],Sample Pairing,每个操作带有一个默认的离散范围及其应用的概率;然后通过强化学习的搜索算法,搜索到5个最优策略,并连接为一个大策略,共包含25个子策略。AutoAugment分别在精简的CIFAR10、ImageNet、SVHN数据集中搜索到相应的数据增强策略,且得到的数据增强策略具有可迁移性,即从一个数据集中学习到的策略能够适用于训练其他数据集。由于本文使用的MSTAR数据集与CIFAR10数据集类别相同,样本数相当,故采用AutoAugment CIFAR10 Policy(AACP)对训练集数据进行预处理,如表1所示。

表1 在精简CIFAR10上搜索到的AutoAugment策略

Tab.1 AutoAugment policy found on reduced CIFAR-10

子策略数据增强操作1数据增强操作20(Invert,0.1,7)(Contrast,0.2,6)1(Rotate,0.7,2)(TranslateX,0.3,9)2(Sharpness,0.8,1)(Sharpness,0.9,3)3(ShearY,0.5,8)(TranslateY,0.7,9)4(AutoContrast,0.5,8)(Equalize,0.9,2)5(ShearY,0.2,7)(Posterize,0.3,7)6(Color,0.4,3)(Brightness,0.6,7)7(Sharpness,0.3,9)(Brightness,0.7,9)8(Equalize,0.6,5)(Equalize,0.5,1)9(Contrast,0.6,7)(Sharpness,0.6,5)10(Color,0.7,7)(TranslateX,0.5,8)11(Equalize,0.3,7)(AutoContrast,0.4,8)12(TranslateY,0.4,3)(Sharpness,0.2,6)13(Brightness,0.9,6)(Color,0.2,8)14(Solarize,0.5,2)(Invert,0.0,3)15(Equalize,0.2,0)(AutoContrast,0.6,0)16(Equalize,0.2,8)(Equalize,0.6,4)17(Color,0.9,9)(Equalize,0.6,6)18(AutoContrast,0.8,4)(Solarize,0.2,8)19(Brightness,0.1,3)(Color,0.7,0)20(Solarize,0.4,5)(AutoContrast,0.9,3)21(TranslateY,0.9,9)(TranslateY,0.7,9)22(AutoContrast,0.9,2)(Solarize,0.8,3)23(Equalize,0.8,8)(Invert,0.1,3)24(TranslateY,0.7,9)(AutoContrast,0.9,1)

注: (TranslateY,0.7,9)分别对应图像操作,应用该操作的概率,搜索到的离散范围值。

2.3 多尺度残差特征提取单元

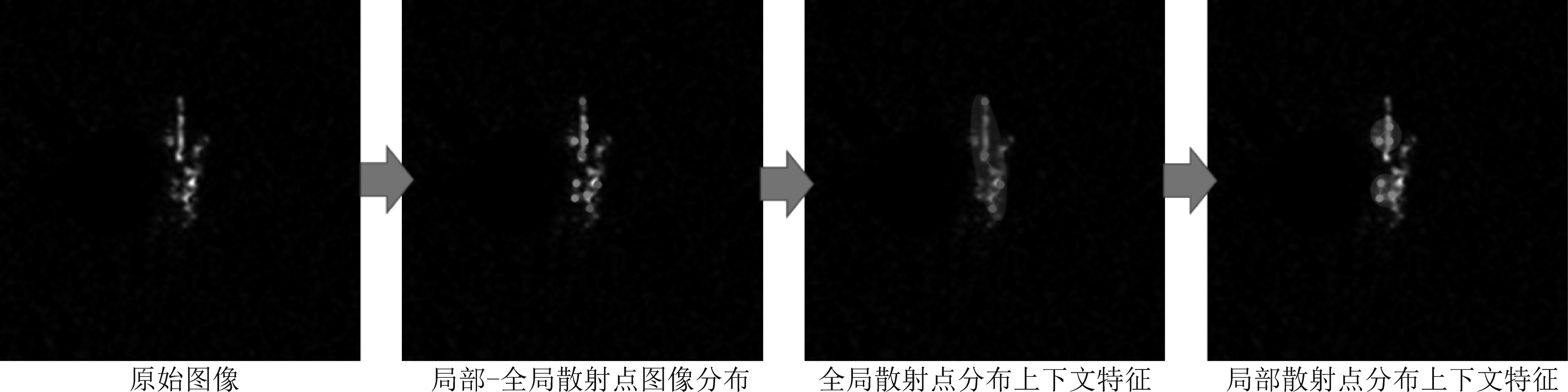

SAR遥感成像对于同一目标的图像域散射信息会随成像条件的变化而变化,如何有效提取不变性散射特征是一个难点。如图2所示。

图2 多尺度散射点分布特征示意图

Fig.2 Schematic diagram of distribution features of multi-scale scattered points

这些不变性散射分布特征都暗含在多尺度散射点分布当中,故针对多尺度特征的提取及融合成为了SAR遥感图像目标描述的关键。

本文在残差块的基础上,将原始的3×3卷积层替换为金字塔卷积[32],使网络能够在多个不同尺度的卷积核上对输入进行处理,提取多尺度特征。金字塔卷积每一层包括不同空间尺寸和深度的卷积核,从下到上,卷积核尺寸逐渐增大,深度逐渐减小,可以并行提取到不同尺度的细节信息,再融合输出。同时,相比标准卷积,金字塔卷积的实现更加高效,不会提升额外的计算量与参数量,并具有灵活的可扩展性。金字塔卷积结构及结合金字塔卷积的残差块结构如图1(a)所示。

2.4 高阶特征表示

现有卷积神经网络架构都是基于“堆栈式”逐层卷积与池化操作来实现特征提取的过程,其中“卷积”操作可以看作是对输入图像信号的“感受”,而“池化”操作可以看作是对局部上下文特征的聚合。随着网络层数的加深,多次的卷积与池化操作使得网络深层特征对于目标的结构与细节纹理信息损失严重,然而,这些信息对于细粒度目标型号的识别任务是非常重要的,因此本文考虑在较深层ResNet-50的特征提取层后引入高阶特征表示如图1(b)所示,从而恢复卷积神经网络中深层次特征的结构与细节信息,以促进目标的型谱级识别。在ResNet-50卷积网络中,由于每一层的特征都是以张量形式存在的,本文通过张量分解的角度,通过主成分分析的高阶统计来近似的表达深层次特征描述,从而实现对丢失结构与纹理信息的补充。

首先,定义被分解的深层特征为![]() 其中C,M和N分别为特征层的通道数、高度和宽度。然后,一个张量X的分解可以被定义为一个线性高阶统计x的预测过程,其中

其中C,M和N分别为特征层的通道数、高度和宽度。然后,一个张量X的分解可以被定义为一个线性高阶统计x的预测过程,其中![]() 为一个对于X的局部特例描述,因此一个张量X可被定义为:

为一个对于X的局部特例描述,因此一个张量X可被定义为:

f(x)=〈w,φ(x)〉

(1)

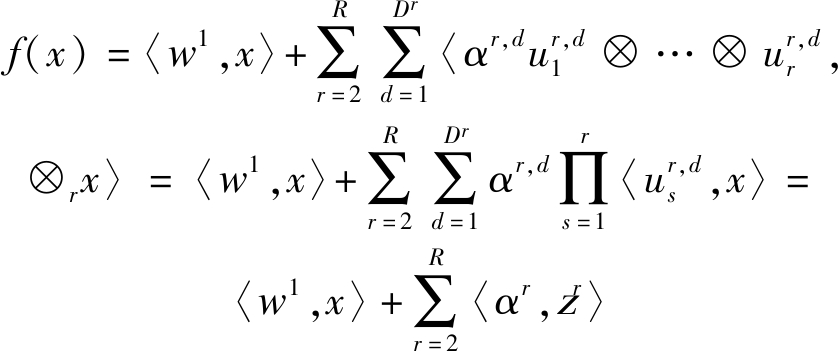

其中w为权重参数,φ(x)为所有高阶统计的表示范式,〈·,·〉表示两个尺寸一致的张量的内积。这里,公式(1)可以表示为一个齐次多项式,如公式(2)所示:

(2)

在公式(2)中,R表示阶数,⊗rx表示x中所有r阶单项式的张量,r阶张量wr决定了一个r阶齐次多项式的预测。然后,利用张量分解原理[33],wr可以被近似为Dr个秩1张量,即![]() 其中r>1。这里,αr,d是第d个秩1张量的权重,

其中r>1。这里,αr,d是第d个秩1张量的权重,![]() 为单位向量,⊗表示外积。因此,公式(2)可以被进一步的改写成公式(3):

为单位向量,⊗表示外积。因此,公式(2)可以被进一步的改写成公式(3):

(3)

在公式(3)中,αr为权重向量,zr可以表示为:zr=[zr,1,…,zr,Dr]T,其中,![]() 因此,基于公式(3),张量分解的任意阶近似可以等同于学习参数w1,αr和ur,d。这里w1可以看作是卷积神经网络中学习到的权重参数,

因此,基于公式(3),张量分解的任意阶近似可以等同于学习参数w1,αr和ur,d。这里w1可以看作是卷积神经网络中学习到的权重参数,![]() 可以看作是Dr个作用在张量X上的1×1卷积集合,从而形成多种模态特征,即通道数为Dr的特征图

可以看作是Dr个作用在张量X上的1×1卷积集合,从而形成多种模态特征,即通道数为Dr的特征图![]() 再通过张量元素对应相乘对特征图

再通过张量元素对应相乘对特征图![]() 进行融合,即

进行融合,即![]() 特征图的个数越多,对于张量X的近似越精确,但是在实际应用中考虑计算量的花费与性能间的权衡,一般高阶统计阶数R设置为R=1或2或3。同理,参数αr也可以由1×1卷积学习得到。综上,通过多个1×1卷积结合张量的元素对应相乘运算,我们可以形成张量的高阶统计拟合去恢复深层次特征中的结构与细节信息描述用于目标的型谱级识别任务。

特征图的个数越多,对于张量X的近似越精确,但是在实际应用中考虑计算量的花费与性能间的权衡,一般高阶统计阶数R设置为R=1或2或3。同理,参数αr也可以由1×1卷积学习得到。综上,通过多个1×1卷积结合张量的元素对应相乘运算,我们可以形成张量的高阶统计拟合去恢复深层次特征中的结构与细节信息描述用于目标的型谱级识别任务。

3 实验分析

3.1 数据集介绍

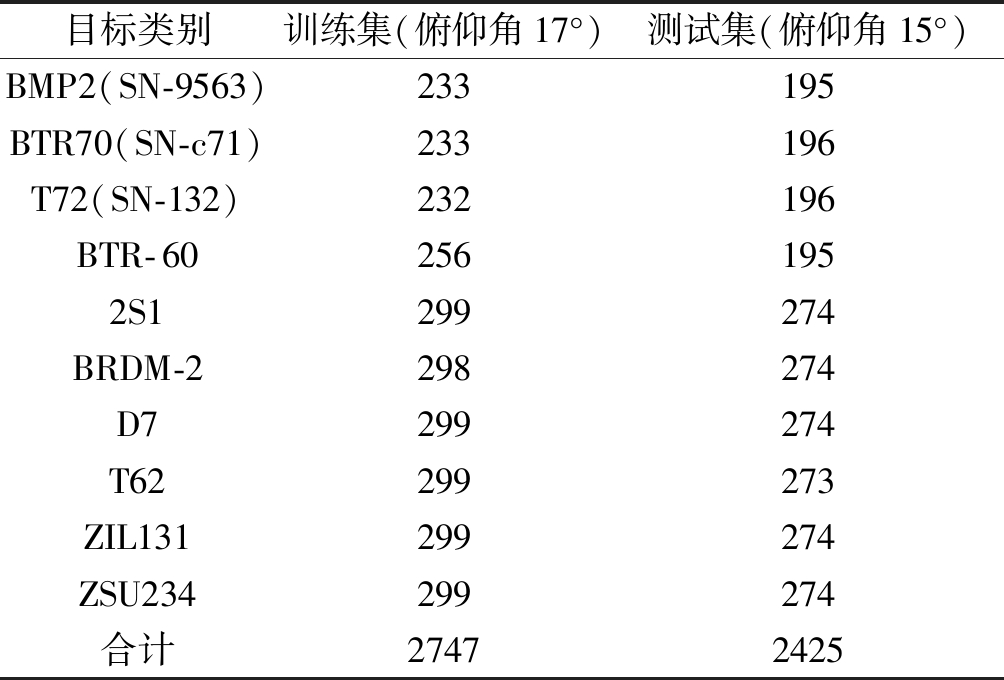

为了验证模型的性能,本文在MSTAR数据集上进行了实验。 MSTAR数据集是由美国预先研究计划局和空军实验室(DARPA/AFRL)提供的面向SAR自动目标识别的公测数据集,在1995年和1996年由Sandia国家实验室SAR传感器平台使用X波段、HH极化方式的聚束式SAR雷达收集得到[35]。它在范围和方位角上均提供0.3×0.3 m空间分辨率,图像尺寸主要有128×128、129×129、158×158像素等。公开发布的数据集包括十类地面军用车辆,即装甲运兵车:BMP2,BRDM2,BTR60和BTR70;坦克:T62,T72;火箭发射车:2S1;防空单位:ZSU-234;卡车:ZIL-131;推土机:D7等十类军事目标。MSTAR数据集由两个子数据集组成,即标准操作条件(SOC)数据集和扩展操作条件(EOC)数据集。SOC数据集分别由17°和15°俯角的十个目标类别组成,图3为十类目标的光学图像和SAR图像对照。本文选取在SOC下俯仰角为17°和15°的图像分别作为训练集和测试集,详细类别和数目见表2。

表2 MATAR数据集SOC条件下10类目标训练、测试样本数

Tab.2 Number of target training and test samples under SOC of MATAR datasets

目标类别训练集(俯仰角17°)测试集(俯仰角15°)BMP2(SN-9563)233195BTR70(SN-c71)233196T72(SN-132)232196BTR-602561952S1299274BRDM-2298274D7299274T62299273ZIL131299274ZSU234299274合计27472425

3.2 实验设置及评价指标

本文所有实验基于Pytorch1.3.1和TITAN RTX进行。对所提出网络,我们首先将图像统一裁剪为224×224尺寸以适应网络输入,设置batchsize为32,学习率为3e- 4,使用Adam优化器进行训练。我们采用了两个评价分类方法性能的常用标准——总体精度OA(Overall Accuracy)、混淆矩阵CM(Confusion Matrix)作为实验的评价指标。

混淆矩阵:一种特殊的矩阵,以可视化的方式显示算法的性能,可直观看出每一类别正确分类、错误分类的详细情况,在监督学习中得到了广泛的应用。图4为一个简单的二分类混淆矩阵,模型需要判断样本是正例(positive)还是反例(negative)。

图3 数据集中十类目标的光学图像和SAR图像对照

Fig.3 Contrast of optical images and SAR images of 10 classes targets in the data set

图4 混淆矩阵示意图

Fig.4 Diagram of confusion matrix

混淆矩阵的每一列代表预测类别标签,每一行表示数据的真实归属类别标签,我们可以得到四个指标TP、FN、FP、TN,其含义如下:

(1)TP:True Positive,真实值是正例,模型预测为正例的数量;

(2)FN:False Negative,真实值是正例,模型预测为反例的数量,即统计学中的第二类错误;

(3)FP:False Positive,真实值是反例,模型预测为正例的数量,即统计学中的第一类错误;

(4)TN:True Negative,真实值是反例,模型预测为反例的数量。

总体精度OA:表示为精确分类的样本总数除以测试样本总数,在混淆矩阵表示下,OA的计算公式为:

(4)

即,混淆矩阵对角线值之和/全部值之和。

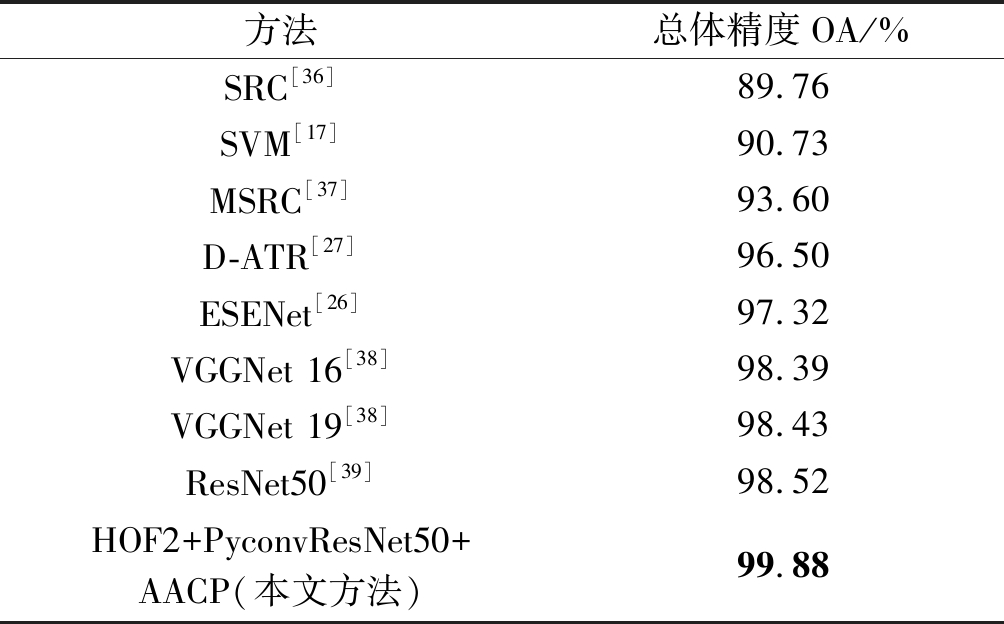

3.3 对比试验分析

为了验证所提出网络的有效性,本节将本文模型与其他算法进行了比较,如表3所示。SRC、SVM、MSRC为传统算法。SRC利用稀疏表示(Sparse Representation Based Classification)对MSTAR数据集的10类目标进行分类[36],其分类OA为89.76%;将串联的基线特征和TPLBP纹理特征送入支持向量机(SVM)进行分类[17],得到OA为 90.73%;利用基于单基因信号稀疏表示的分类方法得到的OA为93.60%。由此可见,使用传统算法模型的分类性能普遍不高,表明了其特征提取的局限性。

试验另外使用了近年提出的两种基于深度学习的SAR遥感图像车辆目标型谱级识别方法作为对比,即Li Wang等人提出的ESENet[26]与Cui Zongyong等人提出的D-ATR[27]。ESE-Net通过设计增强型压缩激励模块进行通道特征筛选,OA达到97.32%;D-ATR将检测、判别、特征提取、分类集成为一个整体系统,其OA达到96.5%。可见,使用基于深度学习的模型分类性能更高,表明了深度学习方法特征提取的优越性,但由于其所使用的分类网络深度不够,提取到的特征不够复杂,一定程度上影响了分类性能。

试验还与VGGNet[38]、ResNet[39]两种经典的卷积神经网络(CNN)模型进行了比较。其中VGGNet16由于网络层数较浅,OA仅达到98.39%;VGGNet19稍优,OA达到98.43%;ResNet50由于层数深,特征表示能力更强,OA达到98.52%。

本文提出的网络模型HOF2+PyconvResNet50+AACP基于ResNet50,添加了金字塔卷积和高阶特征表示以提取多尺度高阶特征,在阶数为2时达到了OA为99.88%的最优性能。可见,提取的高阶多尺度特征大大改善了残差网络的分类性能。相较于上述两种基于深度学习的SAR遥感图像车辆目标识别模型,分类性能更好,体现了本文提出的高阶特征表示多尺度残差卷积网络的优越性。

表3 不同方法识别总体精度对比

Tab.3 Classification overall accuracy comparison of different methods

方法总体精度OA/%SRC[36]89.76SVM[17]90.73MSRC[37]93.60D-ATR[27]96.50ESENet[26]97.32VGGNet 16[38]98.39VGGNet 19[38]98.43ResNet50[39]98.52HOF2+PyconvResNet50+AACP(本文方法)99.88

3.4 优化讨论

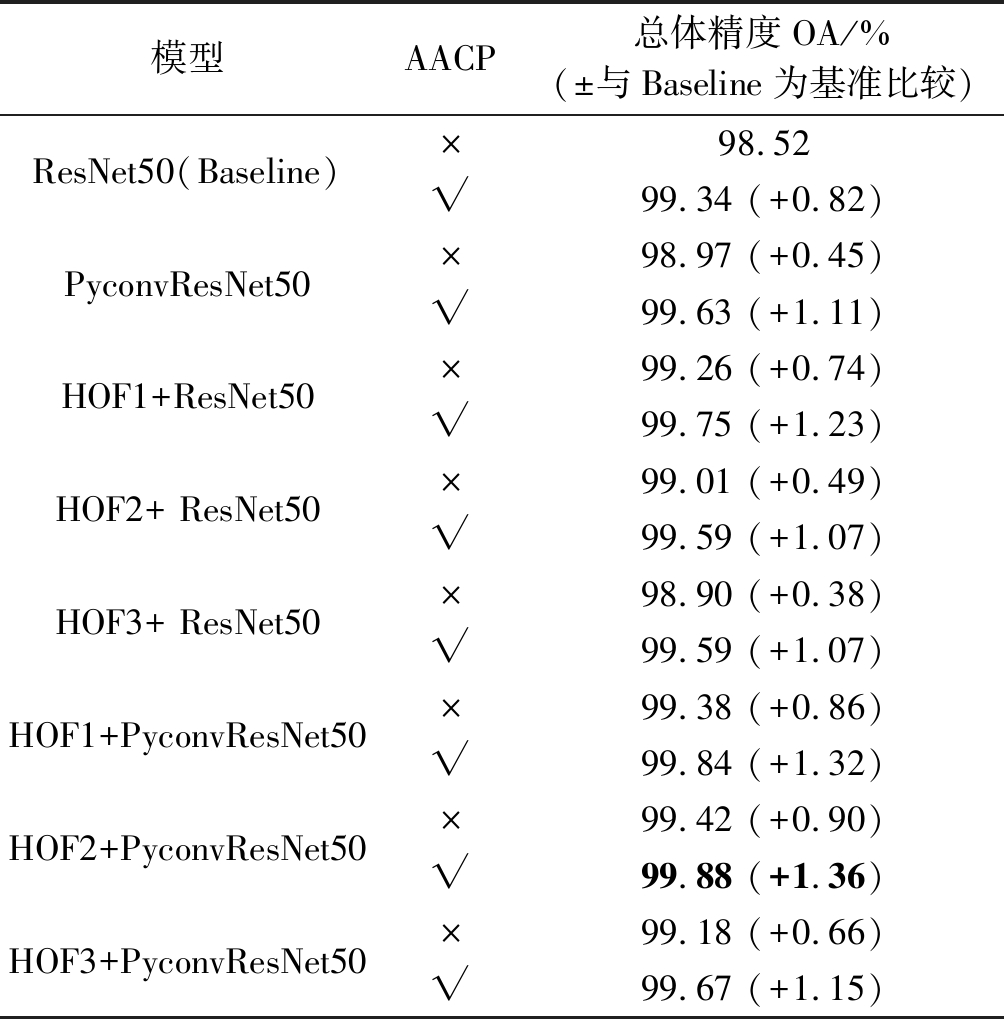

为了分析金字塔卷积、高阶特征表示模块、自动数据增强(AutoAugment)策略对模型性能的影响,我们进行了一系列的对比实验,如表4所示。

(1)金字塔卷积对模型性能的影响:如表4前两行所示,将ResNet50(Baseline)残差块中的3×3卷积层替换为金字塔卷积层得到PyconvResNet50后,OA有0.45%的提升,证明金字塔卷积提取到的多尺度融合特征优于单个3×3卷积层提取的较单一特征,对于分类性能具有一定改善作用。

表4 模型分类性能优化参数讨论

Tab.4 Discussing of classification performance of the optimization parameters of models

模型AACP总体精度OA/% (±与Baseline为基准比较)ResNet50(Baseline)×98.52√99.34 (+0.82)PyconvResNet50×98.97 (+0.45)√99.63 (+1.11)HOF1+ResNet50×99.26 (+0.74)√99.75 (+1.23)HOF2+ ResNet50×99.01 (+0.49)√99.59 (+1.07)HOF3+ ResNet50×98.90 (+0.38)√99.59 (+1.07)HOF1+PyconvResNet50×99.38 (+0.86)√99.84 (+1.32)HOF2+PyconvResNet50×99.42 (+0.90)√99.88 (+1.36)HOF3+PyconvResNet50×99.18 (+0.66)√99.67 (+1.15)

(2)不同阶数特征对模型性能的影响:实验中,为了探索不同阶数的高阶特征表示对于分类性能的影响,我们在ResNet50和PyconvResNet50的基础上,分别添加了阶数为1、2、3的高阶特征表示模块,见表4第3~8行。对于ResNet50,通过对比可知,高阶特征表示模块对于分类性能有较大提升。添加一阶模块后模型性能最佳,而随着阶数增加,OA相较于Baseline虽然有一定提升,但比一阶差。该现象可能是由于MSTAR数据集图像本身比较简单,没有过于复杂的判别性信息,或是基于ResNet50提取的特征不够丰富,更高阶的特征提取无法在该数据集上完全发挥作用。将高阶特征表示模块添加至PyconvResNet中,通过对比可知,分类性能也有较大提升。

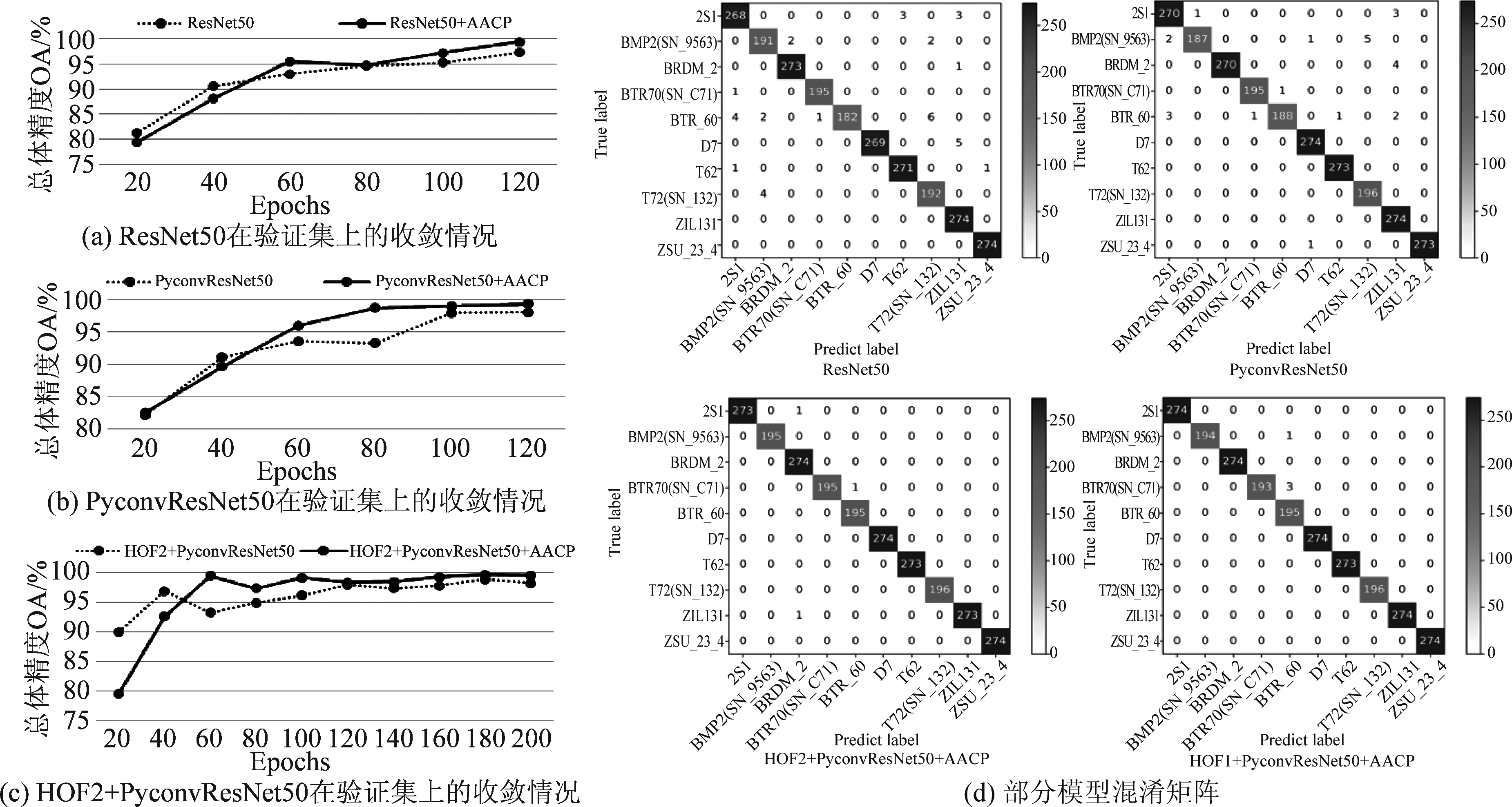

(3)自动数据增强(AutoAugment)策略对模型性能的影响:为了进一步验证自动数据增强策略对分类性能的提升,我们在实验中利用该策略对训练集数据进行预处理。由于MSTAR数据集同精简CIFAR10数据集类别相同,样本数相当,我们使用AutoAugment在精简CIFAR10数据集上搜索得到的CIFAR10策略(AutoAugment CIFAR10 Policy,AACP)。通过对比实验可知,使用AACP对训练数据进行预处理后,每个模型的分类性能均有较大的提升,其中对于HOF2+PyconvResNet50,OA提升至99.88%,比Baseline提升了1.36%,达到了最优分类性能。此外,我们研究了不同模型分别在使用和不使用AACP进行数据增强预处理时,在验证集上的收敛情况,如图5(a)~(c)。分析得知,使用AACP进行数据增强预处理,前期模型收敛较慢,但在中后期阶段,其优势便得到明显体现,模型收敛更加稳定,且OA更高。可见,使用AACP进行数据增强预处理能够在很大程度上提升模型的鲁棒性。图5(d)为部分模型的混淆矩阵。

图5 部分模型在验证集上的收敛情况及混淆矩阵

Fig.5 The convergence on the validation set and confusion matrixes of some models

4 结论

本文以SAR遥感车辆目标细粒度型号识别为研究背景,基于MSTAR公开数据集进行了车辆目标型号识别的研究工作,提出了基于高阶特征表示的多尺度残差卷积识别网络。该网络有效提升了残差卷积网络对于SAR遥感图像目标多尺度散射特征的提取能力,同时,通过构建的高阶特征表示方法改进了深层次卷积特征对于目标结构与细节纹理丢失严重导致细粒度型号识别能力差的问题。通过详尽的实验分析,验证了提出方法的有效性,针对10种车辆目标型号识别准确率达到了99.88%,指标明显优于现有的分类识别算法。然而,由于MSTAR数据集规模小,样本数量有限,且目前满足SAR的高分辨率目标识别图像数据集不足,而本文提出的网络结构较庞大,方法的泛化性仍待进一步验证。另外,在实际侦测系统当中,敌对方车辆目标的型号样本获取困难,如何在样本获取受限条件下实现高精度的分类识别成为了一项挑战,并且,针对SAR遥感成像的多极化信息,如何有效的结合深度学习卷积神经网络进行特征提取,促进分类识别都是未来研究的工作的重点。

[1] OUCHI K. Recent trend and advance of synthetic aperture radar with selected topics[J]. Remote Sens. -Basel, 2013, 5(2): 716- 807.

[2] NOVAK L M, OWIRKA G J, BROWER W S, et al. The automatic target-recognition system in SAIP[J]. Lincoln Laboratory Journal, 1997,10:187- 202.

[3] EL-DARYMLI K, GILL E W, MCGUIRE P, et al. Automatic Target Recognition in Synthetic Aperture Radar Imagery: A State-of-the-Art Review[J].IEEE Access, 2016: 6014- 6058.

[4] WU J, PU W, HUANG Y, et al. Bistatic Forward-Looking SAR Focusing Using ω-k Based on Spectrum Modeling and Optimization[J]. IEEE J. Sel. Top. Appl. Earth Obs. Remote Sens., 2018, 11: 4500- 4512.

[5] MOREIRA A, PRATS-IRAOLA P, YOUNIS M, et al. A tutorial on synthetic aperture radar[J]. IEEE Geosci. Remote Sens. Mag., 2013, 1:6- 43.

[6] SUN Y, LIU Z, TODOROVIC S, et al. Adaptive boosting for SAR automatic target recognition[J]. IEEE Trans.Aerosp. Electron.Syst., 2007, 43:112-125.

[7] FENG X, WANG H, JIN Y. Deep learning as applied in SAR target recognition and terrain classification[J]. J. Radars, 2017, 6:136-148.

[8] DUDGEON D E, LACOSS R T. An overview of automatic target recognition[J]. Lincoln Laboratory Journal, 1993,6(1): 3-10.

[9] NOVAK L M, OWIRKA G J, NETISHEN C M. Radar Target Identification Using Spatial Matched Filters[J]. Pattern Recognition, 1994, 27(4): 607- 617.

[10] ROSS T D, BRADLEY J J, O’CONNOR M P. SAR ATR: so what’s the problem? An MSTAR perspective[C]∥Proc. SPIE Conf. on SAR, 1999, 3721: 662- 672.

[11] BHANU B, DIDGEON D E, ZELNIO E G, et al. Introduction to The Special Issue on Automatic Target Detection and Recognition[J]. IEEE Transactions on Image Processing, 1997, 6(1): 1- 6.

[12] OWIRKA G J, NOVAK G M. A New SAR ATR Algorithm Suite[J]. SPIE, 1994, 2230: 336-343.

[13] NOVAK L M, OWIRKA F J, BROWER W S. An Efficient Multi-Target SAR ATR Algorithm[J]. IEEE, 1998:3-13.

[14] 唐涛, 粟毅. 散射中心特征序贯匹配的SAR图像目标识别方法[J]. 系统工程与电子技术, 2012, 34(6): 1131-1135.

TANG Tao, SU Yi. SAR image target recognition method based on sequential matching of Scattering center features[J]. Systems Engineering and Electronics, 2012, 34(6): 1131-1135.(in Chinese)

[15] 刘中杰, 曹云峰, 庄丽葵, 等. 面向SAR图像目标识别的鲁棒处理算法[J]. 系统工程与电子技术, 2013, 35(12): 2489-2494.

LIU Zhongjie, CAO Yunfeng, ZHUANG Likui, et al. Robust Processing algorithm for SAR image target recognition[J]. Systems Engineering and Electronics, 2013, 35(12): 2489-2494.(in Chinese)

[16] 张之光, 雷宏. 以非负矩阵分解提取局部特征的SAR目标稀疏表示分类[J]. 电讯技术, 2016, 56(5): 495-500.

ZHANG Zhiguang, LEI Hong. Sparse representation classification of SAR targets with local features extracted by non-negative matrix decomposition[J]. Telecommunication Engineering, 2016, 56(5): 495-500.(in Chinese)

[17] 康妙, 计科峰, 冷祥光, 等. 基于栈式自编码器特征融合的SAR图像车辆目标识别[J]. 雷达学报, 2017, 6(2): 167-176.

KANG Miao, JI Kefeng, LENG Xiangguang, et al. Vehicle target recognition based on stacking Self-encoder Feature fusion in SAR images[J]. Journal of Radars, 2017, 6(2): 167-176.(in Chinese)

[18] WANG H, LI S, ZHOU Y, et al. SAR automatic target recognition using a Roto-translational invariant wavelet-scattering convolution network[J]. Remote Sens., 2018, 10: 501.

[19] HE H, WANG S, YANG D, et al. SAR target recognition and unsupervised detection based on convolutional neural network[C]∥In Proceedings of the 2017 Chinese Automation Congress (CAC), Jinan, China, 20-22 October, 2017:435- 438.

[20] CHEN S, WANG H, XU F, et al. Target classification using the deep convolutional networks for SAR images[J]. IEEE Trans. Geosci. Remote Sens., 2016, 54:4806- 4817.

[21] ZHOU F, WANG L, BAI X, et al. SAR ATR of ground vehicles based on LM-BN-CNN[J]. IEEE Trans. Geosci. Remote Sens., 2018, 56:7282-7293.

[22] SHI X, ZHOU F, YANG S, et al. Automatic Target Recognition for Synthetic Aperture Radar Images Based on Super-Resolution Generative Adversarial Network and Deep Convolutional Neural Network[J]. Remote Sensing, 2019, 11: 135.

[23] WANG Z, DU L, ZHANG P, et al. Visual Attention-Based Target Detection and Discrimination for High-Resolution SAR Images in Complex Scenes[J]. IEEE Trans. Geosci. Remote Sens., 2018, 56:1855-1872.

[24] MORGAN D A. Deep convolutional neural networks for ATR from SAR imagery[C]∥In Proceedings of the Algorithms for Synthetic Aperture Radar Imagery XXII. International Society for Optics and Photonics, Baltimore, MD, USA. 2015, Volume 9475:94750F.

[25] CUI Z, DANG S, CAO Z, et al. SAR Target Recognition in Large Scene Images via Region-Based Convolutional Neural Networks[J]. Remote Sens., 2018, 10:776.

[26] WANG L, BAI X, ZHOU F. SAR ATR of Ground Vehicles Based on ESENet[J]. Remote Sensing, 2019, 11(11): 1316.

[27] CUI Z, TANG C, CAO Z, et al. D-ATR for SAR Images Based on Deep Neural Networks[J]. Remote Sensing, 2019, 11(8): 906.

[28] QI B, JING H, CHEN H, et al. Target recognition in synthetic aperture radar image based on PCANet[J]. The Journal of Engineering, 2019(21): 7309-7312.

[29] DING J, CHEN B, LIU H, et al. Convolutional Neural Network With Data Augmentation for SAR Target Recognition[J]. IEEE Geoence & Remote Sensing Letters, 2016: 364-368.

[30] CUBUK E D, ZOPH B, DANDELION Mané, et al. AutoAugment: Learning Augmentation Strategies From Data[C]∥2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). IEEE, 2020.

[31] TERRANCE D, GRAHAM W T. Improved regularization of convolutional neural networks with cutout[J]. arXiv preprint, 2017, arXiv: 1708.04552.

[32] DUTA I C, LIU L, ZHU F, et al. Pyramidal Convolution: Rethinking Convolutional Neural Networks for Visual Recognition[J]. arXiv preprint, 2020, arXiv: 2006.11538.

[33] TAMARA G K, BRETT W B. Tensor decompositions and applications[J]. SIAM review, 2009, 51(3): 455-500.

[34] CHEN B, DENG W, HU J. Mixed High-Order Attention Network for Person Re-Identification[C]∥2019 IEEE/CVF International Conference on Computer Vision (ICCV). IEEE, 2019.

[35] Defense Advanced Research Projects Agency (DARPA)/Air Force Research Laboratory (AFRL). The Air Force Moving and Stationary Target Recognition Database[EB/OL].https:∥www.sdms.afrl.af.mil/index.php?collection=mstar (accessed on 10 September 2020).

[36] SONG H, JI K, ZHANG Y, et al. Sparse Representation-based SAR Image Target Classification on the 10-class MSTAR data set[J]. Applied Sciences, 2016, 6(1): 26.

[37] DONG G, WANG N, KUANG G. Sparse representation of monogenic signal: With application to target recognition in SAR images[J]. IEEE Signal Processing Letter, 2014, 21(8): 952-956.

[38] SIMONYAN K, ZISSERMAN A. Very Deep Convolutional Networks for Large-Scale Image Recognition[J]. Computer Science, 2014.

[39] HE K, ZHANG X, REN S, et al. Deep Residual Learning for Image Recognition[C]∥IEEE Conference on Computer Vision and Pattern Recognition, 2016.