Reference format: PIAO Zhengquan, TANG Linbo, ZHAO Baojun, et al. Intelligent Detection of Traffic Targets for Vehicle Blind Zone Collision Avoidance System[J]. Journal of Signal Processing, 2021, 37(2): 242-247. DOI: 10.16798/j.issn.1003- 0530.2021.02.009.

交通事故引发巨大损失。研究发现非人为因素(如视觉盲区)和驾驶员自身因素(如不文明驾驶行为等)是造成众多交通事故的主要因素。而根据Daimler-Benz公司的研究[1]:如果驾驶员能够提前0.5 s得到预警就可以避免60%的后方碰撞发生,而如果能够提前1 s得到预警则可以避免90%的后方碰撞。因此,针对由视觉盲区和驾驶员自身因素所导致的碰撞问题,开展面向视觉盲区的车辆智能预防碰撞相关技术研究,对降低由视觉盲区和驾驶员不文明驾驶行为所造成的交通事故发生频次、减少经济损失、保障人民的生命安全具有重要意义。

近些年国内外在盲区防撞上的相关应用研究主要包括前向防撞系统设计和盲区检测。其中,防撞系统设计主要包括通过利用不同传感器采集信号,然后对其进行处理和分析实现车辆前向防撞的预警。盲区检测则主要用于车辆变道时,通过对盲区中的目标进行检测和识别以达到防撞的目的。(1)国外的防撞系统设计和盲区检测研究包括:Wei Pan等[2]采用激光雷达与可见光摄像头融合的方式进行道路交通指示塔的检测识别,以防止车辆进入禁止区域;Angel M等人[3]利用单目摄像头并结合聚类和分类算法实现对盲区车辆的检测。针对后方盲区防撞的问题,Ra M[4]利用鱼眼镜头检测后方的来车,当检测到车辆出现在盲区时向驾驶员发出警报信息。Zhao等[5]将盲区检测问题转化为分类问题,通过设计轻量深度神经分类网络对摄像头采集的盲区图像进行检测。(2)国内的防撞系统设计和盲区检测研究包括:Yutao Ba等人[6]对多种传感器采集到的车辆动态、测量的距离、驾驶行为和生理特征数据进行判别分析,通过监督学习的方式预测车辆发生碰撞的风险。Zhuang Jiayuan等人[7]采用雷达传感器进行障碍目标的检测,并通过检测结果调整车辆航向和前进速度实现防撞的目的。Liu等[8]利用毫米波雷达对车辆后部盲区进行探测,所提出方法对白天和夜晚场景均有效。杨炜等[9]设计一种车载高清红外视觉传感器的右侧盲区预警系统,该系统利用深度学习模型进行行人和骑行者的识别。杨思思[10]则采用单目视觉技术对城市道路上车辆后视镜盲区的骑行车辆进行检测和对高速公路弯道进行识别。

视觉目标检测是智能防撞系统中的关键技术,近些年单目视觉中的目标检测领域取得了较大发展。单目视觉目标检测当前的主要研究现状是:按照所在的不同时期,目标检测主要可以分为非深度学习的检测和基于深度学习的检测方法。2012年以前的目标检测主要基于对候选窗特征提取进行识别范式,不同检测器间的区别一般在于候选窗的生成方式和特征提取、分类方法的不同。典型成果如基于HoG特征和SVM判别的行人检测[11];利用通道特征的ICF检测器[12]。然而由于手工设计的特征不能很好地描述和区分复杂场景中的目标,因此该阶段目标检测的性能相对较低。随着2012年AlexNet网络[13]在图像识别任务上的性能遥遥领先当时最先进的传统识别算法,深度学习应用于目标检测领域的时代正式到来。深度学习技术与先前主流的传统机器学习技术的主要差别是:深度学习可以端到端地从数据中学习逐层抽象的特征描述,避免了人手工设计特征的繁琐和呆板。因为这些深度特征相对于传统的浅层特征具有更强的描述性能和可鉴别能力,所以基于深度学习的目标检测可以达到更高的检测精度,但当前该类方法的一大不足是其依赖大量的有标签数据。基于深度学习的目标检测按照检测模型的框架不同主要可分为两阶段检测[14,17]、单阶段检测[15]和无锚点检测[16]。两阶段检测的优点是检测精度高,缺点是检测速度较慢;单阶段检测则较好地平衡了检测精度与速度;而针对基于锚点检测模型对锚点参数设置敏感和由锚点所产生的大量计算冗余等问题,发展出了无锚点检测的思想。

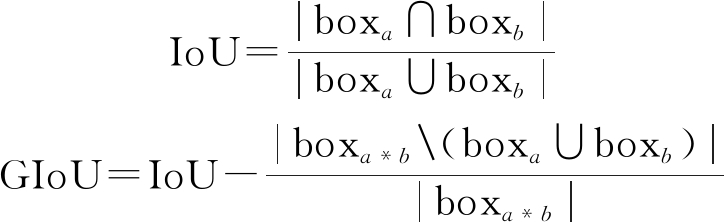

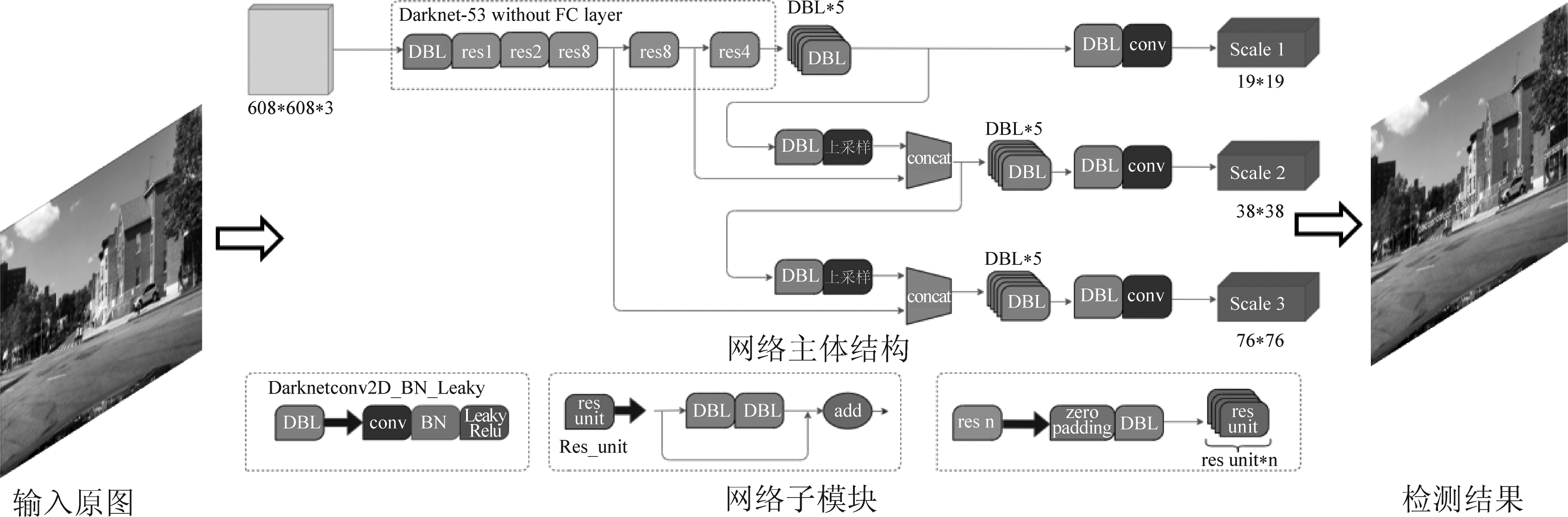

然而现阶段较少有检测模型直接面向车载智能防撞系统需求,因此当前主流的检测模型一般并不直接与该应用场景相匹配。面向车辆盲区防撞系统的交通目标智能检测需要综合考虑车载硬件平台计算资源的限制,其中主要包括两个方面:一方面模型的检测精度与计算复杂度需要能够较好地折中,另一方面检测网络的基本单元利于硬件平台的实现。由于现有以Faster RCNN为代表的两阶段检测器由于计算复杂度较高,而不适用于资源受限的车载终端平台,因此单阶段检测模型更适用于实际场景。众多单阶段检测器中,YOLOv3可以较好地取得检测精度和较高的检测性能。此外,现阶段一些较新的网络所包含的基本单元(如深度可分离卷积、反卷积,空洞卷积等)不利于硬件平台(如华为海思AI芯片、FPGA等)实现,而YOLOv3的网络单元主要包括基本的卷积和池化操作,因而对硬件的实现较为友好。综合上述两方面的因素,YOLOv3作为车载平台交通目标智能检测的基础模型。在此基础上,结合该应用场景下两个方面的约束,本文构建了道路场景目标检测模型,在原始模型的基础上引入性能提升策略,并分别在国内、国外的道路场景目标检测数据集上验证了模型的计算效率和模型在全距离与近距离检测的性能。

考虑到道路场景的复杂性和计算平台的资源限制,检测模型既需要保持较高的计算效率和检测性能,又需要有利于现有硬件平台的实现。根据先前引言部分介绍选择YOLOv3[24]作为原始检测模型,在此基础上分别于模型的训练阶段引入了其他策略,使得在不提高计算复杂度的情况下,进一步提升检测模型的性能。通过在模型训练阶段采用新型的数据增强方式,以增大训练数据集的多样性;通过使用性能更好的目标定位损失计算方式,以帮助模型更好地学习。由于所引入的策略分别作用于模型的训练阶段的数据增强和损失计算,因而不会在预测阶段引入额外的计算消耗,且可以保持原有模型的硬件移植特性。

本文选择YOLOv3[24]作为原始检测模型,模型的结构示意图如下图1。

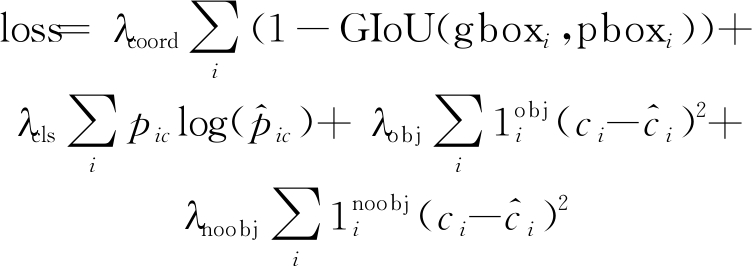

模型的损失函数为:

(1)

其中,λ·为权重系数;pic表示类别编码;ci为预测置信度;1obj(·)则为示性函数。

(1)Mosaic数据增强

数据增强(广)是一种常见的提升模型性能的手段,其主要思想是通过额外扩增训练数据的多样性以提高模型的泛化性能。数据增强一般只作用于模型的训练阶段,因而该策略不会对测试模型引入附加的计算复杂度。现有的数据增广方式一般针对单张图像进行几何和颜色空间等变换来扩增训练样本,最近,一些同时融合多张图像进行数据增强的方法被相继提出,比如Mixup[18]和CutMix[19]。而不同于Mixup和CutMix同时融合两张图像,Mosaic的优点则是可以同时融合四张图像,因此Mosaic具有更大的组合空间,因而增强数据的多样性更强,检测目标的背景变化也更加丰富,Mosaic已被应用于YOLOv4[20]中。Mosaic以随机的方式将四张图像拼接成一幅固定大小的图像,即拼图上各子区域划分是随机确定的,被拼接的每张图像对应于其中某一个子区域,拼接时不改变原图像的尺寸和宽高比,而将原图像上超出拼接子区域的部分直接截断。

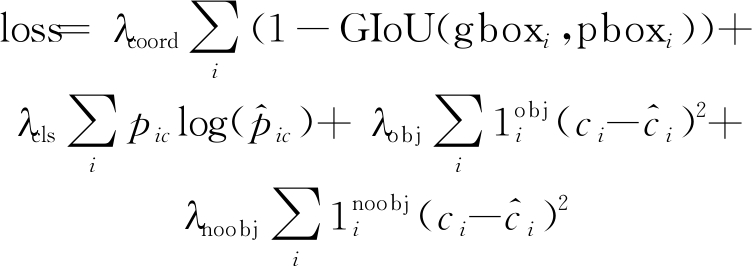

(2)利用GIoU计算定位损失

传统基于L2范数表示的定位误差不能真实地衡量预测框与真实框之间的位置偏差,针对该问题已有工作利用IoU计算预测框与真实框间的偏差,以更好地进行检测框的定位。但由于存在两个没有相交区域的目标框所对应的IoU值为0的情况,而该情况在训练阶段无法直接利用IoU产生定位损失,进而无法通过梯度信息进行框坐标预测的调整。针对该问题,GIoU度量准则[21]被提出,该准则在IoU的基础上考虑了两框的最小外接矩形区域大小,以克服相离检测框之间IoU为0的问题。公式(2)给出了GIoU的计算方法。

(2)

其中,|·|表示检测框box的区域面积;A\B表示在A中去除B区域;boxa*b则表示包围boxa与boxb的最小面积矩形。

图1 检测模型结构图示

Fig.1 Structure of the detection model

(1)数据集

分别选择国内道路场景目标检测数据ApolloScape[22]和国外道路场景目标检测数据BDD100K[23]进行实验验证。其中ApolloScape是由百度公司通过在采集车车顶上安装的高分辨率相机以1 m/帧的速率同步记录采集车周围的场景数据得到,数据采集于多条不同道路场景和不同天气场景,图像数据的分辨率为3384×2710,处理后包含训练数据6万张、测试数据1237张。BDD100K则由伯克利大学AI实验室发布,该数据集包含不同场地、不同天气和不同光照下的多种场景的采样图像,图像分辨率为1280×720,经处理后包含训练数据7万张、测试数据1万张。

针对车辆低速启动或者转弯时的防撞需求,需衡量检测模型近距离(20 m左右)目标的检测性能。针对该需求,需要对原始数据集作出额外处理。该处理的思路为采用手动点选确定需保留的近距离目标,而那些没有被点选的目标则交由机器剔除。为了保证数据质量,被选目标与被剔除目标间的相交区域需要机器做出判断,然后再交由人工涂鸦的方式抹除。

(2)实验设置

模型训练和测试的平台为单块Tesla V100 GPU。模型的具体参数设置则主要包括,初始学习率为0.00579、训练轮数为300、模型通过SGD方法进行学习、动量置为0.937、权重衰减系数为0.000484、批训练大小设置为64;此外,模型训练阶段分别在其第240轮和第270将学习率衰减为当前的0.1倍。

(1)ApolloScape

分别进行图像所有(距离)目标的检测测试和近距离目标测试,结果如图2所示。

图2 ApolloScape上的检测结果

Fig.2 The detection results on ApolloScape

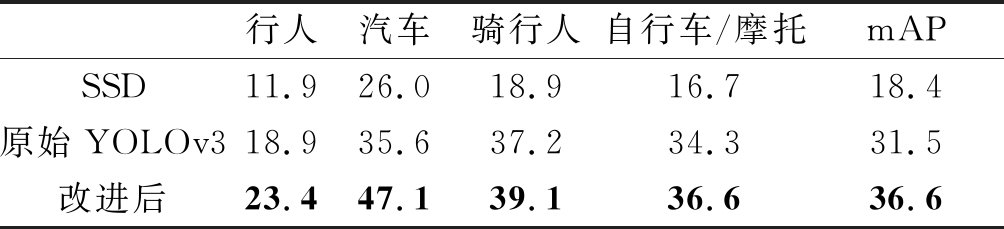

表1 ApolloScape所有范围目标的检测结果AP值统计

Tab.1 AP value statistics of the detection results of all targets on ApolloScape

行人汽车骑行人自行车/摩托mAPSSD11.926.018.916.718.4原始YOLOv318.935.637.234.331.5改进后23.447.139.136.636.6

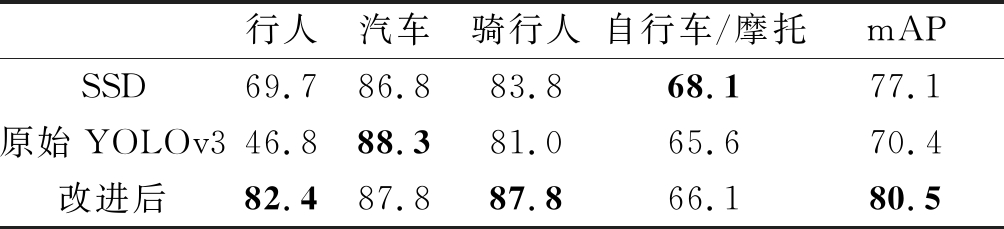

表2 ApolloScape近距离(20 m内)检测结果AP值统计

Tab.2 Close distance (within 20 m) test results AP value statistics on ApolloScape

行人汽车骑行人自行车/摩托mAPSSD69.786.883.868.177.1原始YOLOv346.888.381.065.670.4改进后82.487.887.866.180.5

上表1和表2结果显示,改进后的网络比原始网络达到更高的AP值,改进后的模型对ApolloScape所有范围目标mAP提高5%,而在近距离的检测中mAP提高10%。为了进一步验证网络的性能,将其与近期在嵌入式上应用较为广泛的单阶段检测网络SSD进行了比较,其中由上表2可以看出结果改进后的YOLOv3在近距离目标的检测精度要高出3%以上。此外可以看出,虽然检测模型在该数据集所有范围上的目标检测率较低,但对近距离目标的检测性能较高。由于远处目标一般尺寸较小且易受光照、干扰物等其他因素的影响而造成检测困难,所以远处目标检测性能较低。而对于车辆低速启动或者转弯时的防撞场景,关注的是车辆周围近距离目标的检测情况,而那些较远距离目标的检测与否并不直接影响近距离防撞的性能。通过上述实验结果可以看出该模型检测可以在一定程度上满足该场景需求。

(2)BDD100K

所有(距离)目标的检测测试和近距离目标测试结果如下图3所示。

图3 BDD100K上的检测结果

Fig.3 The detection results on BDD100K

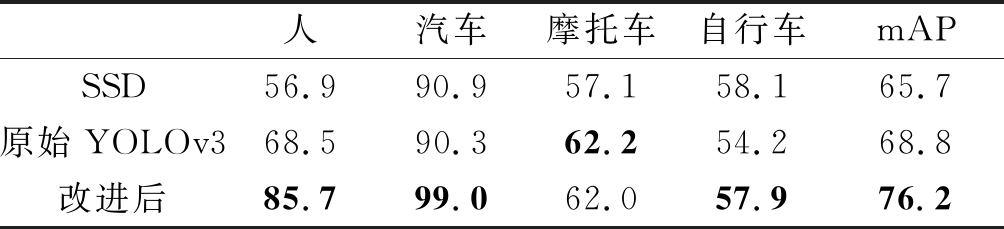

由表3和表4可以看出,改进后模型对汽车、人和自行车的检测精度要高于改进前模型的检测性能,且对摩托车的检测性能与基础模型检测性能接近,但平均精度mAP要明显高于原始模型。与经典检测网络SSD相比,改进后的YOLOv3在BDD近距离目标的检测精度要高出15%左右。另一方面,近距离检测精度明显高于所有范围目标的检测性能。但由于BDD100K数据包含了不同天气、不同天时和不同场地的数据,即其数据复杂度要明显高于ApolloScape数据集,所以BDD100K上的检测精度低于ApolloScape上的检测精度。此外还可以看出,在这两个数据集上该模型对近距汽车类目标的检测率均在90%以上。

表3 BDD100K数据集所有范围目标的检测结果AP值统计

Tab.3 AP value statistics of detection results of all range targets on BDD100K

人汽车摩托车自行车mAPSSD27.756.228.725.634.5原始YOLOv339.056.529.527.538.1改进后59.375.642.736.053.4

表4 BDD100K近距离(20 m内)检测结果AP值统计

Tab.4 Close distance (within 20 m) test results AP value statistics in BDD100K

人汽车摩托车自行车mAPSSD56.990.957.158.165.7原始YOLOv368.590.362.254.268.8改进后85.799.062.057.976.2

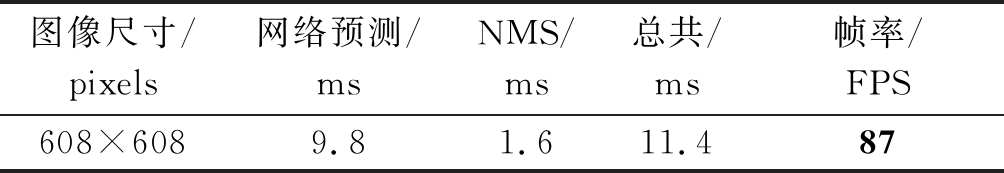

(3)检测速度

在单块V100 GPU平台上进行检测速度统计,得到单张图像的检测耗时情况如表5所示,从中可以看出其检测帧率可达87 FPS,可满足实时性检测需求。

表5 检测速度统计

Tab.5 Detection speed statistics

图像尺寸/pixels网络预测/msNMS/ms总共/ms帧率/FPS608×6089.81.611.487

针对车载智能防撞系统中道路场景目标检测的需求,构建综合考虑计算复杂度和精度的检测模型。为了提升检测性能,模型结合了Mosaic数据增强策略和GIoU的目标定位损失计算方式。此外,分别通过国内、国外道路场景检测数据集进行了实验验证,实验结果表明该检测模型可以具有较高的检测实时性,同时对近距离目标检测的性能也可达到较高的精度,因而适用于车辆低速启动或者转弯时智能避撞时的检测需求。

[1] BOARD U. Vehicle-and Infrastructure-based Technology for the Prevention of Rear-end Collisions, ser[J]. Special Investigation Report. National Transportation Safety Board, 2001.

[2] PAN WEI, LUCAS C, TASMIA R, et al. LiDAR and Camera Detection Fusion in a Real Time Industrial Multi-Sensor Collision Avoidance System[J]. Electronics, 2018, 7(6): 84.

[3] SOTELO M  , BARRIGA J. Blind spot detection using vision for automotive applications[J]. Journal of Zhejiang University-Science A, 2008, 9(10): 1369-1372.

, BARRIGA J. Blind spot detection using vision for automotive applications[J]. Journal of Zhejiang University-Science A, 2008, 9(10): 1369-1372.

[4] RA M, JUNG H G, SUHR J K, et al. Part-based vehicle detection in side-rectilinear images for blind-spot detection[J]. Expert Systems with Applications, 2018, 101: 116-128.

[5] ZHAO Yiming, LIN Bai, et al. Camera-Based Blind Spot Detection with a General Purpose Lightweight Neural Network[J]. Electronics, 2019, 8(2): 233.

[6] BA Y, ZHANG Wei, WANG Qinhua, et al. Crash prediction with behavioral and physiological features for advanced vehicle collision avoidance system[J]. Transportation Research Part C: Emerging Technologies, 2017, 74: 22-33.

[7] ZHUANG J, ZHANG L, ZHAO S, et al. Radar-based collision avoidance for unmanned surface vehicles[J]. China Ocean Engineering, 2016, 30(6): 867- 883.

[8] LIU G, ZHOU M, WANG L, et al. A blind spot detection and warning system based on millimeter wave radar for driver assistance[J]. Optik-International Journal for Light and Electron Optics, 2017, 135: 353-365.

[9] 王敏, 周树道, 彭文星, 等. 基于超声波传感器的汽车盲区检测系统研究[J]. 自动化技术与应用, 2017,36(3):110-112.

WANG Min, ZHOU Shudao, PENG Wenxing, et al. Research on Vehicle Blind Spot Detection System Based on Ultrasonic Sensor[J]. Automation Technology and Application, 2017,36(3):110-112.(in Chinese)

[10] 杨思思. 基于单目视觉的车辆盲区预警系统的研究及实现[D]. 杭州:浙江大学,2015.

YANG Sisi. Vehicle Blind Spot Warning Algorithm Research and Svstem Design based on Monocular Vision[D]. Hangzhou:Zhejiang University, 2015.(in Chinese)

[11] DALAL N, TRIGGS B. Histograms of oriented gradients for human detection[C]∥2005 IEEE Conference on Computer Vision and Pattern Recognition (CVPR′05). Ieee, 2005, 1: 886- 893.

[12] DOLL R P, TU Z, PERONA P, et al. Integral channel features[C]∥In: Proceedings of the British Machine Vision Conference. BMVC Press , London,2009: 91.1-91.11.

R P, TU Z, PERONA P, et al. Integral channel features[C]∥In: Proceedings of the British Machine Vision Conference. BMVC Press , London,2009: 91.1-91.11.

[13] KRIZHEVSKY A, SUTSKEVER I, HINTON G E. Imagenet classification with deep convolutional neural networks[C]∥ Advances in Neural Information Processing Systems, 2012: 1097-1105.

[14] GIRSHICK R. Fast r-cnn[C]∥ Proceedings of the IEEE International Conference on Computer Vision, 2015: 1440-1448.

[15] REDMON J, DIVVALA S, GIRSHICK R, et al. You only look once: Unified, real-time object detection[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2016: 779-788.

[16] LAW H, DENG J. Cornernet: Detecting objects as paired keypoints[C]∥ Proceedings of the European Conference on Computer Vision (ECCV), 2018: 734-750.

[17] 张天坤, 李汶原, 平凡, 等. 面向多源遥感图像的自适应目标检测[J]. 信号处理, 2020, 36(9): 1407-1414.

ZHANG Tiankun, LI Wenyuan, PING Fan, et al. Adaptive target detection for multi-source remote sensing images[J]. Journal of Signal Processing, 2020, 36(9): 1407-1414.(in Chinese)

[18] ZHANG H, CISSE M, DAUPHIN Y N, et al. mixup: Beyond empirical risk minimization[J]. arXiv preprint arXiv: 1710.09412, 2017.

[19] YUN S, HAN D, OH S J, et al. Cutmix: Regularization strategy to train strong classifiers with localizable features[C]∥Proceedings of the IEEE International Conference on Computer Vision, 2019: 6023- 6032.

[20] BOCHKOVSKIY A, WANG C Y, LIAO H Y M. YOLOv4: Optimal Speed and Accuracy of Object Detection[J]. arXiv preprint arXiv: 2004.10934, 2020.

[21] REZATOFIGHI H, TSOI N, GWAK J Y, et al. Generalized intersection over union: A metric and a loss for bounding box regression[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2019: 658- 666.

[22] HUANG X, CHENG X, GENG Q, et al. The apolloscape dataset for autonomous driving[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition Workshops, 2018: 954-960.

[23] YU F, CHEN H, WANG X, et al. BDD100K: A diverse driving dataset for heterogeneous multitask learning[C]∥Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2020: 2636-2645.

[24] REDMON J, FARHADI A. Yolov3: An incremental improvement[J]. arXiv preprint arXiv: 1804.02767, 2018.

瓢正泉 男, 1994年生, 河南固始人。北京理工大学信息与电子学院, 博士研究生, 主要研究方向为目标检测与识别。

E-mail: piaozhengquan@bit.edu.cn

唐林波 男, 1978年生, 湖北京山人。北京理工大学信息与电子学院, 讲师, 博士, 主要研究方向为智能图像处理。

E-mail: tanglinbo@bit.edu.cn

赵保军 男, 1960年生, 陕西周至县人。北京理工大学信息与电子学院, 教授, 博士后, 主要研究方向为信号处理。

E-mail: zbj@bit.edu.cn

曾 涛 男, 1971年生, 天津人。北京理工大学信息与电子学院, 研究员, 主要研究方向为雷达信息、信号处理与系统设计。

E-mail: zengtao@bit.edu.cn