1 引言

多媒体是多种信息形式所构成的信息传播媒介,如文本、图像、音频、视频等。多媒体技术给予人类充分发挥自身智慧能力的机会,同时也潜移默化地改造着人类认识世界的方式,改变着人类传统的时空观。多媒体手段消解了不同感觉通道、不同语言、不同国界之间的界限。它意味着人们可以通过多种感官、多个渠道进行深度的融合交流。

认知在心理学中是指“通过形成概念、知觉、判断或想象等心理活动来获取知识的过程”[1],特别注意的是思维对信息的处理功能。因此,多媒体认知就是人类对于多媒体信息进行思维处理获取知识的过程。

人类对外部世界的认识过程就是认知,因此,认知对人类的影响非常巨大。自古以来,对人类认知的主动和被动影响就一直伴随着人类的发展,而进入互联网时代,网络信息使得人类认知领域的斗争进一步加剧。正如美国政治学者Joseph S. Nye在其著作中所说,“全球信息时代的到来正迅速使传统实力符号成为过去式,权力关系版图正在重新绘制,最擅长国际报道的国家(或非国家行为体)可能胜出。”[2] 网络中的文本、音频、图像、视频等多媒体信息的传播,使得实际真相或被还原、或被误解,导致公众的认知受到影响而改变,产生了认知安全问题。因此,多媒体认知安全,可以定义为针对虚假、危害、认知偏见的多媒体人类认知不良影响的安全防护。多媒体认知安全对国家、社会、个人都具有重要的意义。

多媒体认知安全,特别是进入社交媒体时代以后,成为了全人类社会亟待解决的重大挑战问题。虚假、危害、认知偏见的多媒体信息在网络中深度传播,引发了国家经济、政治、社会等诸多方面的安全问题。2013年,美联社的推特账户被入侵后发布了“白宫爆炸、美国总统奥巴马受伤”的图文假消息,导致美国股市市值损失了2000亿美元[3],在经济上造成了严重危害。2016年,超过500条美国总统候选人特朗普和希拉里的虚假新闻在推特等平台传播[4],干扰了民众的认知,甚至影响到大选结果的公平,在政治上产生了严重威胁。2014年马航航班失踪事件后,近百种虚假信息出现在新浪微博等平台[5],危害公众舆论认知的同时,也严重伤害的家属的感情。2020年新冠疫情爆发的1月到3月间,中国各大互联网平台中就出现了超过2000条虚假多媒体消息[6],严重干扰了抗击疫情的阶段的社会安全。当前社会,民众的认知恐慌,对人类社会的伤害,不亚于一场战争。

多媒体认知安全技术的发展经历了两个主要时期:传统多媒体技术的认知安全对抗时期和基于人工智能技术的融媒体认知安全对抗时期。传统技术包括多媒体截取、修改、编辑、伪造等塑造技术,随着多媒体技术的发展,分别在文本、音频、图像、视频等不同格式的多媒体中发展出结合载体特征的多媒体认知安全对抗技术。而2012年Hinton等人提出的深度学习开始在语音识别[7]、图像识别[8]等多媒体处理领域获得惊人效果,大大加速了人工智能和大数据时代的到来,深度学习作为人工智能的代表性技术,为多媒体认知安全技术带来了新的动力,实现了更加逼真的多媒体认知对抗;语义学习的出现,打破了多媒体不同格式认知安全的界限,催生出了融媒体[9-10]这一新形态,又进一步导致了融媒体认知安全的威胁,发展出了基于人工智能技术的融媒体认知安全对抗技术。

本文对多媒体安全认知技术的相关研究工作进行了调研,并进行了分类与分析。我们在第2节中介绍传统多媒体认知安全技术,在第3节中介绍基于人工智能的多媒体认知安全技术,并在第4节总结目前的研究情况与未来的发展趋势。

2 传统多媒体认知安全技术

2.1 多媒体与认知安全

人类接触多媒体的认知与人类的认知特点密切相关。2007年,Anderson[11]通过从大脑和行为研究中提出人类的认知架构与模型。人类于灵长类动物同享相同的基本认知架构,但却进化出了对认知进行抽象控制并处理更复杂的关系模式的能力。人类认知架构由一组与不同大脑区域相关联的很大程度上独立的模块组成,这些不同模块分别组合与工作,构成了人类对世界的认知。然而,根据Roets的研究[12]表明,假新闻即便经过澄清后,人们对其的态度变化也会因为认知水平的高低而发生不同的转变,认识水平较低的人往往对澄清后的新闻态度变化较小。因此,现有认知模型的发展仍然无法满足当前融媒体真假信息爆炸的场景下人类认知安全的需求。

人类在接触多媒体假消息的时的认知如何探究,是认知机理的研究。针对假消息的认知机理,Guo等人[13]提出了主要研究虚假新闻对人类认知的潜在影响的领域,称为认知安全(CogSec),该领域涵括从误解、不可信的知识获取、有针对性的态度的形成,到有偏见的决策,并研究了揭露虚假新闻的有效方法。Pennycook等人[14]发现接受假消息的人往往同时自我本身也会在转述时对其进行二次加工,在二次加工时信息往往会增强,但教育能赋予人在二次加工时反思的能力,从而提升人对假消息的鉴别能力。Shu等人[15]通过对社交媒体上的假新闻进行了心理学和社会理论中的假新闻表征,进行社交调查,尝试对社交媒体加入如用户社交参与度等辅助信息,以提高假新闻检测的成功率。Nummenmaa等人[16]发现,在社交网络中,情绪会大规模产生同化,同时这种会分享会传染的情绪可以同步每个人的大脑行为从而影响社会性的行为活动。Peng等人[17]通过观察参与者对名人正面及负面八卦新闻时,对参与者的在线情绪状态进行评估,明确发现人们对名人的负面八卦有更加强烈的情绪,参与者们更喜欢听到名人相关的负面八卦,并且热衷于分享。 Bago等人[18]对比了直觉和推理思考两种反应范式,直觉认知接近于偏见,而推理思考则能纠正偏见认知,提供了更强的融媒体认知伪造的真相识别能力。

基于民众这种对假消息的认知机理,一些研究提出了针对外部社会环境影响民众社会认知的措施。Basol等人[19]探索了一种通过心理接种来建立对网络错误信息的态度抵抗的可能性。“接种”这个比喻是基于一个医学上的类比:通过预先将人们暴露在剂量较低的错误信息中,学习假消息的典型模式,预防融媒体假消息的发生,获得认知免疫的能力。Bergstrom等人[20]发现社交网络的结构会影响人对外界消息的总体判断,人们的行为可能会受到社交网络结构的影响。如果身边大多数人都接受了某个消息并信以为真,那么该个体接受该消息的可能性也将大大增强。因此,可以尝试通过对脑电信号的分析预测对某个消息的传播性。

综上,人类的认知能力受到外部消息的影响,特别是虚假消息,会严重干预到人类的认知安全,因此,多媒体认知安全技术的重点就是关注虚假多媒体信息的检测。

2.2 文本认知安全技术

在互联网兴起后,网络和社交媒体更加成为了认知领域争夺的重要阵地。网络社交媒体中,用户之间可以分享信息、观念甚至情感,从而影响人群的固有认知,甚至实现外部认知操控[21],典型的手段包括设置议题、编造假新闻、煽动舆论等,已经在如今的国际社会屡见不鲜。美国DARPA曾于2011年实施了社交媒体战略传播[22]的研究,耗资5000万美元研究了影响公众舆论的网络行为[23]。针对反美信息在网络中的传播,研究发现可以利用虚拟网络身份发现假消息传播用户身份[24]。而美国Ntrepid公司为用户提供了虚拟身份的许可,已被美国国防部采购并用于网络虚拟身份的制造。

文本的认知安全技术,针对基于文本结构的伪造文本和基于语法语义的伪造文本两类伪造方法分别提出了相应的检测技术。

基于文本结构的伪造方法主要针对有格式文本如文档,其伪造往往会导致文本格式排版的异常。Meng等人[25]证明了伪造文本的高频词比普通文本的高频词要少,设计了一个预处理程序来细化所有给定文本,扩大普通文本和隐写文本之间的频率差异。从细化后的文本中提取出对频率敏感的12维特征向量,最后使用SVM分类器区分普通文本和伪造文本。Din等人[26]提出了一种形式化的遗传算法来检测分析文本上的异常信息,采用运行时间、适应度值、平均均值概率、方差概率和标准差概率等5个目标函数来衡量待检测文本,研究结果表明,基于遗传算法的异常文本分析方法具有良好的应用前景。Samanta等人[27]讨论了基于贝叶斯估计和相关系数的文本异常分析方法,进行伪造文本的异常检测并尝试了定位。

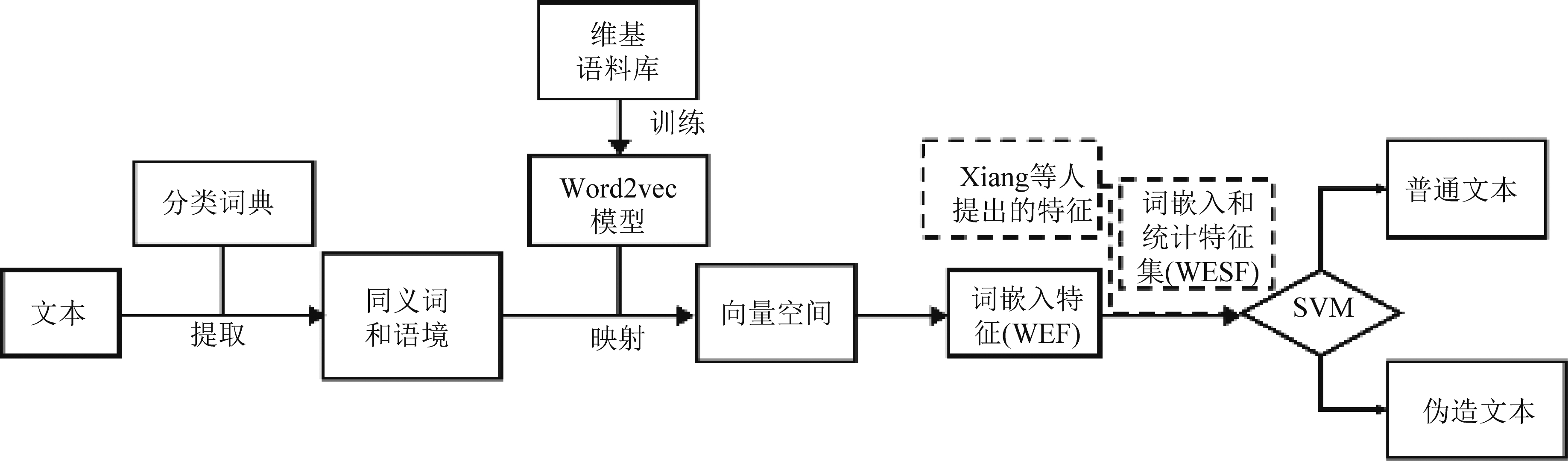

基于语法语义的伪造,则是利用自然语言文本内在的语义连贯性相关性与语法的多样性进行文本的异常检测。Yang等人[28]针对自然语言处理中语法的多样性和语义的多义性,提出了一种基于元特征和免疫克隆机制的文本异常分析方法,采用元特征表示文本,然后利用免疫克隆机制选择合适的特征,构成有效的检测器,该方法比现有的典型方法具有更好的性能。Chen等人[29]针对基于语境聚类的文本信息隐藏方案,提出了一种新的隐写分析技术。该技术引入了上下文聚类来估计上下文适应度,并根据上下文适应度值的统计值来区分普通文本和隐写文本,实现文本异常(隐写)检测。同义词替换不仅会造成统计上的失真,而且会造成语义上的失真,Zuo等人[30]提出了一种基于词嵌入特征的语义失真检测方法,如图1所示。该方法设计了一种由词频特征和统计特征组成的词嵌入和统计特征集(WEF)融合特征,可以实现更低的检测错误率。

图1 基于词嵌入特征的语义失真检测方法

Fig.1 Semantic distortion detection method based on word embedding feature

综上,传统的文本认知安全技术利用文本结构格式和语义语法上的异常特征进行检测,实现文本伪造的检测,从而保护人类的认知正确。然而,网络文本大数据环境下,大量新的伪造文本方法不断涌现,未知伪造方法和深度学习的高质量伪造文本都导致传统文本认知安全技术存在着难以逾越的障碍。文本认知安全技术结合人工智能技术的发展成为了必然。

2.3 音频认知安全技术

音频是存储一段连续声音内容的文件,其内容通过听觉途径影响个体的认知。在大部分情况下,音频比文本或单独的图像具有更高可信度,且由于视频图像需要镜头始终捕捉事件对象,音频的采集与保存具有更高的方便性和隐蔽性。

窃听的音频对人类认知的影响曾经发挥了重要影响。著名的“水门事件”就发端于1972年在民主党总部水门大厦安装窃听装置的可疑人员被逮捕。在其后的调查中,委员会发现时任美国总统尼克松从1971年年初,为了记录与手下的谈话和电话内容下令在白宫办公室里安装窃听系统[31]。储存同等价值的内容时,音频手段在保证隐蔽性的同时具有更小的存储占用,这让诸如水门事件等窃听丑闻在历史上时有发生。

国际音频工程协会(AES)在公布的AES27-1996标准及其子标准AES43-2000中将音频真实性定义为音频未经任何人为删除、插入、拼接等修改操作。伴随音频内容的修改,音频属性参数也会发生相应的改变[32-33]。音频的删除指从语义连续性的角度将音频的部分片段删除,剩余部分自动链接在一起。音频的插入是在音频中插入另一音频片段,以破坏原有音频的语义,插入的操作可以在同一音轨上,也可插入另一段音轨。音频的拼接是指将多个音频的片段剪辑出来,然后拼接在一起达到创造新音频的效果。此外,音频的叠加也是常见的修改方式,可将若干条音轨的内容混合在一起,在特定情况下能掩盖关键信息或者伪造现场。

音频对人类认知安全的影响,主要是由于其中包含虚假、危害和认知偏见等信息造成的。音频认知安全技术主要是音频取证分析,是通过特定采集系统在特定位置对事件进行的真实“声学表示”。

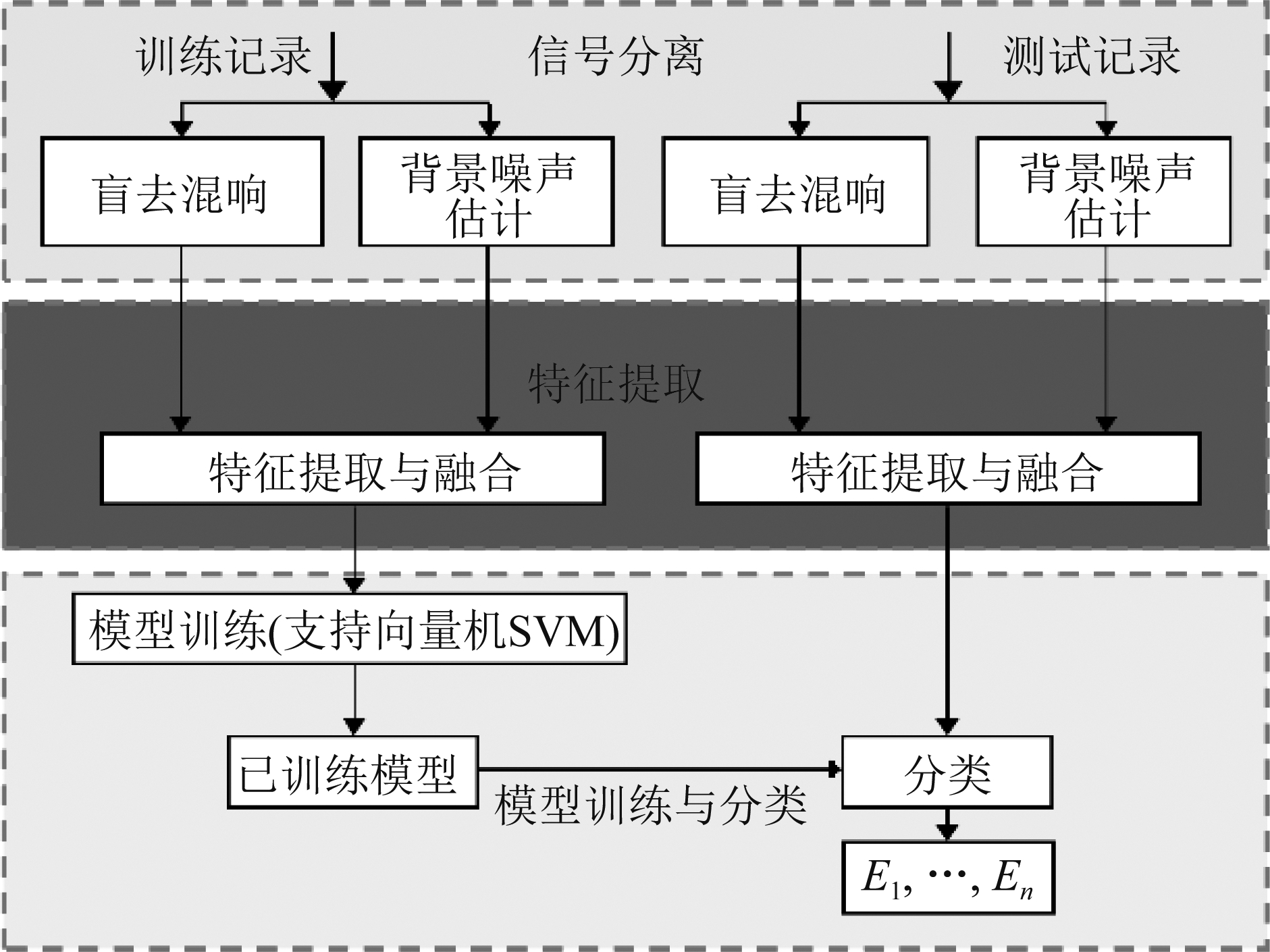

已有研究表明,声学环境、采集系统和编码过程会在生成的音频中留下伪影,因此可以用于数字音频的真实性验证。例如,Malik等人在[34]中提出了基于声环境特征的音频伪造检测技术,根据测试音频记录估计声环境特征变化进行伪造检测。采集系统在生成的音频中也会留下其特征伪影,可用于证据的真实性验证。由于采集系统特征与其他来源的不同,噪声信号的差异可以用于检测音频文件的真实性。典型的方法是使用基于电网频率ENF的特征,将电力线频率耦合到数字录音系统[35]以验证数字音频的真实性,如图2所示,通过背景噪声估计和盲去混响的数字信号处理实现信号分离,对信号进行测量和分析后进行声学环特征提取,从而获得ENF进行检测。但是,如果使用设计良好的音频设备(例如,电容器或压电麦克风)或电池供电设备来捕获录音,则基于ENF的方法不能适用。另一类技术则是基于音频后处理技术的音频取证。去噪、压缩、滤波、转码等音频后处理操作通常用于抑制篡改痕迹,但这些操作也会使音频出现相应的特征。典型的方法包括基于音频转码、二次压缩[36]等的音频后处理取证技术。然而,以上几种技术均存在局限性,层出不穷的音频伪造手段可以绕开检测算法针对的伪影特征,给音频取证带来了现实困难。

图2 声学环境检测流程图

Fig.2 Flow chart of acoustic environment detection

另一类用于音频认知安全的技术是说话人识别技术。说话人识别也称声纹识别,通过对目标说话人的语音建立声纹模型,将特定目标人的语音识别出来。由此引入音频同一性鉴定的研究,即鉴别说话人是否为本人[37]。但此类方法需要首先建立目标人物的声纹模型,且受到不同语种、复杂背景噪声和多变背景音乐等各种因素的影响,在互联网音频的大数据环境下面临严峻挑战。

综上,传统的音频认知安全技术,从虚假音频在环境、采集、编码中的伪影进行取证实现伪造音频的检测,或者利用目标说话人的声纹模型进行鉴别实现伪造语音的检测。然而,随着深度学习的出现,虚假音频的模仿程度越来越高,普通人已经真假难辨,因此,音频认知安全技术也需要快速发展到基于人工智能的音频取证技术。

2.4 图像认知安全技术

数字图像不具有传统意义的底片,易受图像处理影响破坏其真实性、完整性,进而成为他人操纵公共认知的工具之一。利用计算机软件伪造修改数字图像,可以模糊乃至修改公众对于客观事物的认知来达到操纵公共事件的目的。2007年10月12日,陕西林业厅发布了农民周正龙使用数码相机拍摄的华南虎照片。随后,照片在发布后其真实性受到网友、华南虎专家和中科院学者等各方的质疑,同时有网友发现“华南虎”原型为年画。2008年,相关部门宣布周正龙所拍摄华南虎实际上是由年画经过重新翻拍而伪造,相关人员受到处分。“华南虎事件”[38]等一系列图像认知安全事件的发生,干扰了公众认知,产生了恶劣影响。

传统的图像伪造方法是基于图像编辑或图像处理技术实现的,主要包括图像篡改与图像生成两类。但是,由于图像生成在质量不够高时,一旦被怀疑是计算机生成图像,人们就不会相信它是支持事实的可靠证据。因此,图像篡改是图像伪造技术中比较传统的主流成熟技术。进一步,对于图像认知安全问题而言,图像篡改就暗示着真实世界照片的篡改。

图像篡改的过程实际上是用一些新内容替换原始区域内的内容。新内容的来源和组成决定了篡改的具体类型。如果新内容是原始图像本身的一个完整部分,则可称为图像复制[39]。比如2009年伊朗导弹新闻图片造假事件,就采用了复制操作。如果新内容是来自另一个源图像的整个部分,则可称为图像拼接[40]。比如2013年澳大利亚杜那利山火,小女孩头戴防毒面具与考拉在山火中相互依偎的图像就采用了拼接操作。如果新内容是原始图像或其他图像中的基本补丁组成,我们称之为图像修复[41]。比如2013年美联社记者拍摄的一张反阿萨德叛乱分子手持步枪的照片中,左下角的摄像机被记者故意删除,就是采用了修复操作。

传统的图像认知安全技术,针对以上几种典型的图像篡改技术,研发了相应的检测技术。

针对图像复制操作,首先关注到的是基于块的区域复制,可以利用像素值、统计度量、频率系数、不变矩、局部二值模式(LBP)和方向梯度直方图(HoG)等图像局部特征、主成分分析(PCA)和奇异值分解等。基于块的方法的一个主要缺点是,所有重叠块的数量都很大,并且彻底搜索匹配块非常耗时。考虑到现实世界图像中的相似像素通常在空间上非常接近,Cozzolino等人提出了改进的PatchMatch算法[42-43],以计算最近邻场,其中匹配区域可以显式显示。这种密集场技术在不牺牲检测精度的情况下证明了其有效性。基于块的区域复制检测算法在高性能计算单元出现之前,由于计算维度过高而效率低下,且对噪声和图像失真非常敏感。因此可以把注意力集中在图像中的几个关键点上,显著降低计算成本。尺度不变特征(SIFT)[44]和加速鲁棒特征(SURF)[45-46]提供了图像复制检测的两类经典的关键点特征,但基于关键点的检测精度仍然不够高。

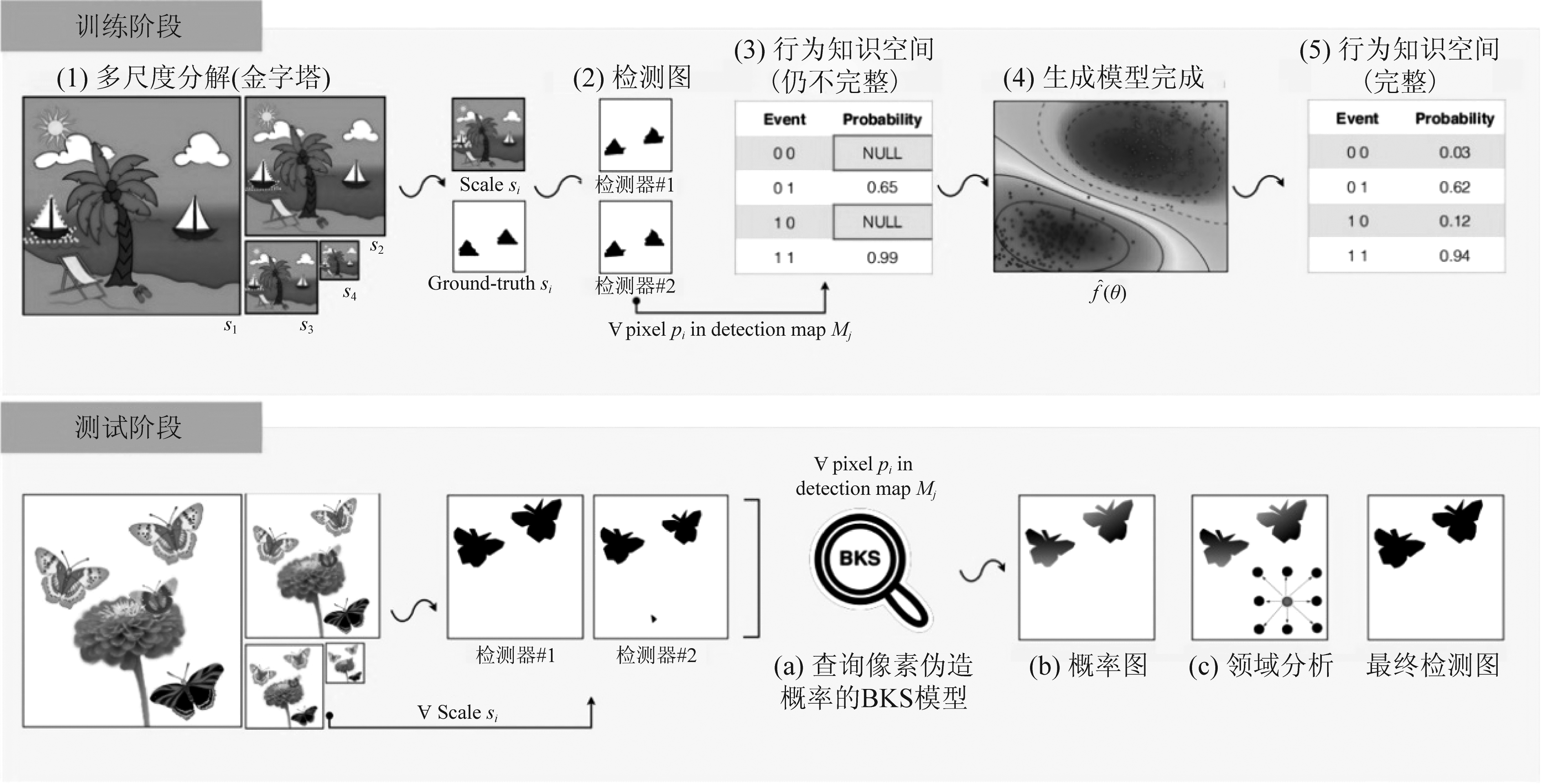

因此,结合基于块和基于关键点的区域复制检测[47],能够在检测精度与检测效率上取得平衡,实现更适应现实需求的图像复制篡改检测。如图3所示,首先通过对输入图像应用高斯金字塔分解来构建数据的多尺度表示。这使得组合分类器对图像复制伪造中的操作(如大小调整和噪声添加)更具鲁棒性。这个过程会导致不完整的表示,因为在训练阶段通常无法找到来自K个组合检测器的二进制输出的所有可能组合。再通过应用生成模型完成(如回归)来更好地拟合条件概率数据,填充缺失概率,并从行为知识空间BKS表示中去除可能的噪声和异常值,从而解决该问题。最后,在测试阶段,对于图像中的每个像素,我们查询BKS表示,在给定K个检测映射的情况下,计算其成为复制-移动伪造的概率。这将生成一个概率图,然后通过多向邻域分析对其进行进一步处理,以根据其邻域信息对像素进行分类。

图3 融合基于块和基于关键点的行为知识空间的图像复制伪造检测方案

Fig.3 Behavior knowledge space-based fusion of block-based and key-point-based image copy-move forgery detection scheme

针对图像拼接操作,由于难以找到拼接的原图,因此关注更多的篡改特征。首先关注边缘不连续,将对象粘贴到图像中会在被篡改区域的边缘留下异常伪影。由于认为篡改图像中的锐利边缘会产生高相位一致性,可以采用图像游程直方图和Sobel算子构建特征来表示边缘,实现基于游程分析的边缘异常图像拼接检测[48-49]。将图像残差图、DWT、矩统计、直方图计数与马尔可夫过程整合起来,利用马尔可夫过程构造高维特征[50],可以实现更好的性能。当攻击者篡改JPEG图像并以JPEG格式保存更改后的版本时,由于两个压缩过程,生成的图像肯定会产生双重量化(DQ)效果。在拼接图像中,真实区域肯定会产生DQ效应,而被篡改区域很可能会丢失DQ效应,由此可以基于DCT系数的直方图分析其异常[51-52],实现基于JPEG压缩不一致的拼接检测。被篡改区域内的照明也会与图像其他部分中的照明不一致,因此可以估计人脸上的照明方向[53]或估计每个波段的光源颜色[54]进行区域异常的拼接检测。而在相机成像中,全彩图像的插值参数估计的视觉不一致性[55]、成像噪声(PRNU)的不一致性[56]都可以用于检测拼接图像。

图像修复操作主要可以分为基于扩散的方法和基于示例的方法两类。对于擦除操作留下的孔,基于扩散的方法将局部图像纹理从孔的外部平滑地传播到孔的内部[57];基于范例的方法从图像的其他部分复制一些补丁,并将它们缝合在一起以填补漏洞[58]。

除此之外,还可以通过剪裁等手段删除部分图像内容,能够操纵公众对于图像的感知重点来影响公众对于事件的判断。如2017年美国总统特朗普就职典礼在华盛顿纪念碑的官方照片就进行了裁剪,保留了人群密集的上半区域而裁去了人数少的下半区域,从而暗示公众当时的人群规模巨大。

然而,传统的图像认知安全技术仍然是面向具体特征的,在大数据环境下,未知类型的伪造图像难以进行通用检测。另一方面,深度学习的发展使得图像生成技术取得了质的飞跃,生成伪造图像需要融合多维度的复杂特征进行检测,超出了传统图像认知安全技术的能力。因此,图像认知安全技术也进入了人工智能的新时代。

2.5 视频认知安全技术

视频区别于单个的图像,是一段连续的、帧之间有内容联系的图像序列。由于视频本身为多张图像,使用传统计算机软件对每张图片手动处理工程量大。因而对于视频而言,可以通过剪辑手段进行帧的删除、分解与组装,来实现影响观众的认知。同时,视频由于容量较大,也具有容纳图像、音频、文字等其他形式多媒体信息的能力,对人类认知的干扰影响更大。2018年上海辟谣平台的十大谣言中过半都是伪造视频的形式[59],视频认知安全技术在当下网络时代成为重要需求。

视频片段的删减可以隐去视频内容中的部分信息。为更好地建设精神文明社会,中国广播电视总局对国内上映的电影严格审批,并删去过分血腥恐怖的镜头片段,以防止对未成年人造成不利的影响。

视频片段的拼接又称蒙太奇,将一个或多个视频片段进行分解、重新组织。视频拼接是拍摄者对视频的总体安排,不论是叙述方式还是叙述角度,都受到剪辑者个人的主观影响。在电视节目《新闻调查:孙伟铭案》中,节目旁白介绍我国法律对“酒驾逃逸”并没有明确规定,各地法官对类似案件的判决差别也有出入,同时画面呈现的是近年来酒后驾车事故图片:车辆破损在路边、孤零零留在现场的一只鞋,画面的拼接对于观众的情绪具有极大的激发性。目前视频拼接技术已经发展的逐渐趋于成熟,2021年,Park等人[60]提出了一种于语义分割的静态视频拼接方法,以减少视差和错位失真,显著改善了几何畸变和像素畸变。

除了剪辑手段,3D动画技术也经常应用于视频伪造中。通过计算机生成逼真的三维动画,将其嵌入至真实的视频背景中,加以后期的修补和润色后,便可以达到以假乱真的作用。2012年,一段老鹰试图在蒙特利尔公园捡起一个蹒跚学步的孩子的视频在国外视频平台引发了公众的广泛讨论与顾虑。但事实上,蒙特利尔国家动画和设计中心发布声明说,将视频作为3D动画和数字设计学士学位课程的集体项目发布,鹰和孩子都是使用3D动画合成。

视频造假比其他造假方式更容易造成舆情极端扩散。如2020年新冠疫情爆发初期,“双黄连可预防新冠病毒”等视频在微博等社交平台的传播加剧了药物等医疗资源的挤兑,造成了群体恐慌[61]。

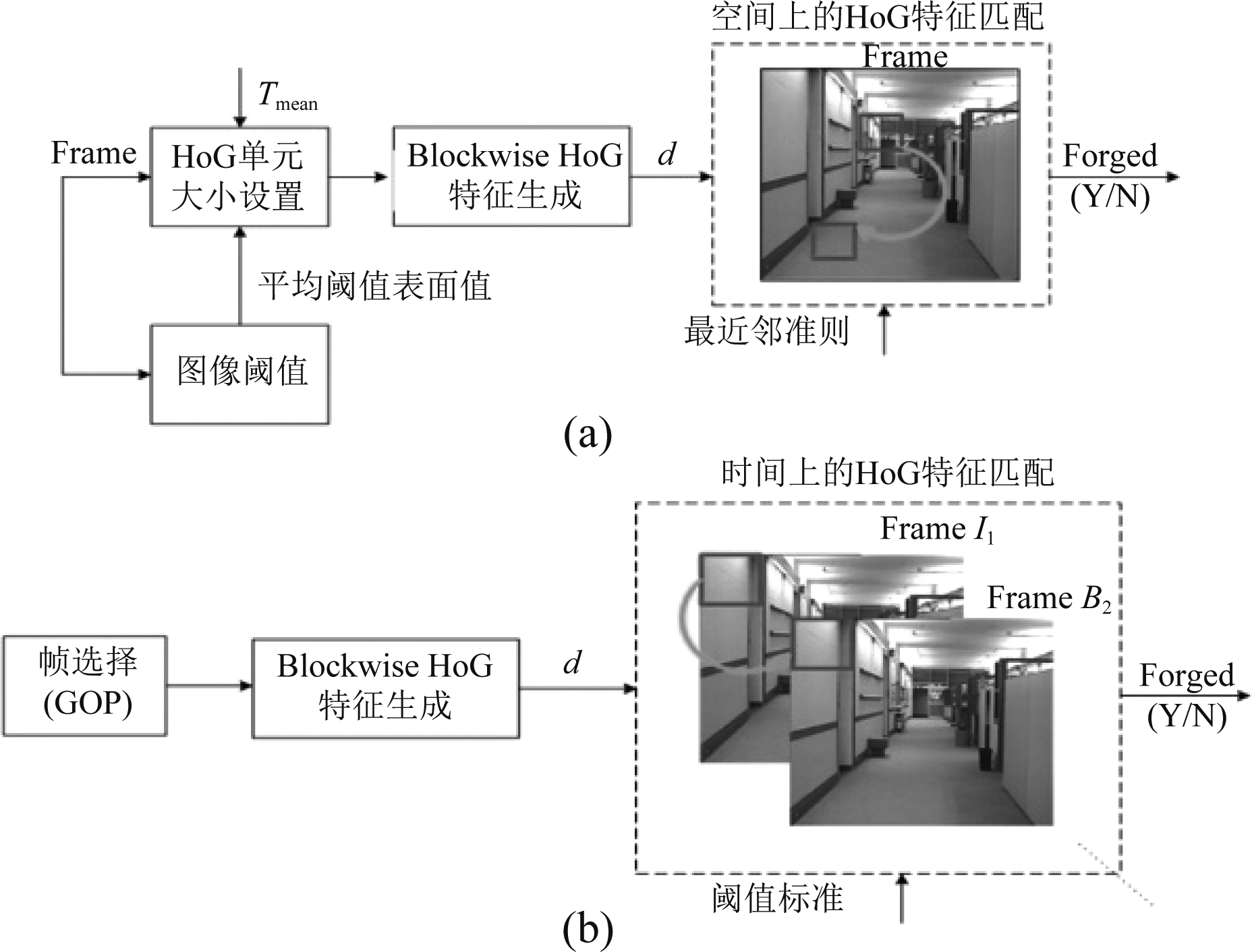

传统的视频认知安全技术,主要利用视频特征的统计相关性[62]、基于帧的统计异常检测[63]以及不同数字设备的不一致性[64]特征进行检测。如图4所示,该方法利用了方向梯度直方图(HOG)特征,从块中提取HOG特征,然后在时间和空间域中与从其他块中提取的HOG特征进行匹配,以检测篡改。针对复制粘贴篡改,可以通过查看特定设备制造商特有的特定特征的统计或数学相关性中的不一致性来检测篡改。

图4 基于方向梯度直方图(HOG)特征与压缩特性的 视频复制伪造检测方案

Fig.4 Video copy-move forgery detection using HOG features and compression properties

传统的视频认知安全技术,主要是视频删减、拼接、剪辑、合成技术的检测技术,采用视频信号处理的技术进行取证,发现典型视频处理的痕迹并进行判定。但是,随着深度学习为代表的人工智能技术发展,视频质量越来越高,传统的视频取证技术无法有效检测出深度伪造的视频。另外,手段真实、内容伪造的视频也超出了传统视频取证技术的能力范围,需要在人工智能的语义学习等技术支撑下才能有效应对。

3 基于人工智能的多媒体认知安全技术

3.1 基于人工智能的文本认知安全技术

深度学习模型的发展,使得人工智能技术合成的文本质量不断提高,甚至可以达到在以假乱真的地步。

自然语言处理(NLP)技术中,循环神经网络(RNN)、变分自编码器(VAE)、对抗生成网络(GAN)可以在不同的场合条件下生成高质量文本,普通公众感官上鉴别伪造文本越来越难。而社交网络中的文本信息很可能造成严重的认知影响,这是人工智能时代文本认知安全的新挑战。

基于人工智能的文本认知安全技术也在飞速发展之中。文本特征是从社交媒体中的文本内容提取出的统计特征或语义特征,虚假新闻检测就首先运用文本特征进行机器学习建模得到分类器进行检测。Castillo 等人[65]首先将机器学习算法运用到了该领域,引入可信度的概念判断Twitter 上突发事件的真假,他们主要提取了文本特征,使用 K-means 算法对时空进行聚类分析。Aditi Gupta等人[66]在前人的基础上进一步比较了SVM、决策树等常见机器学习分类算法的性能。Sejeong Kwon等人[67]从语言结构的角度分析了谣言和普通新闻的差异,Kai Shu等人[15]进一步从心理学、社会学角度帮助文本建模。

在中文文本领域中,Fan Yang等人[68]首次运用新浪微博数据将谣言检测应用于中文中,Shengyun Sun等人[69]也提出了一些特征来增强中文微博的谣言检测效果,Kaimin Zhou等人[70]引入强化学习在谣言传播的早期对其进行预测。然而传统的语言模型可解释性不强,因为他们高度依赖与特定的事件和相应的领域知识,因此传统的基于机器学习的假新闻检测模型很难提取出合适的文本特征。为了克服这一局限性,Jing Ma[71]等人提出了利用递归神经网络RNN的深度学习模型来学习一段时间序列中文本的特征,取得了不错的效果,如图5所示,RNN网络能够学习隐藏表示,以捕获相关帖子的上下文信息随时间的变化。

图5 基于GRU的RNN谣言检测模型

Fig.5 GRU-based RNN rumor detection model

然而,当前的基于人工智能的文本认知安全技术仍然存在依赖于数据集的问题,难以实现较好的泛化能力,特别是在基于深度学习的文本生成技术不断进步的条件下,伪造文本的质量不断提升,文本认知安全技术仍然要在模型泛化能力和零样本检测等问题上面临考验。

3.2 基于人工智能的音频认知安全技术

人工智能技术的应用让人们看到了将深度学习运用到语音合成的领域,随着Deepfake技术的传播与应用,语音伪造也能在一定程度上达到以假乱真的地步。2019年,英国某能源公司被曝出涉及了AI语音诈骗案件。犯罪分子使用电话会议,YouTube,社交媒体甚至是TED演讲中获得的音频训练模型来复制公司老板的声音,并成功欺骗公司员工进行大额转账,成功骗走22万欧元。此外,根据某开发语音诈骗软件的网路安全公司调查报告,从2013年到2017年间,语音诈骗的数量增长了350%,当中每638个诈骗电话中,就有一个是AI合成的。

本文将分别阐述语音生成和语音模拟两种技术[72]。

语音生成是在拥有高质量目标伪造对象语音的情况下,由机器主动伪造语音内容的技术。20世纪末,基于隐马尔可夫模型的统计学习语音合成系统(HMM based Speech synthesis System)趋于成熟,实现了基于统计规律的自动语音合成[73]。21世纪,凌振华基于传统HTS语音合成系统,引入了深度置信网络作为语音参数增强模型。2014年,随着长短时记忆模型(LSTM)广泛被应用,Frank K. Soong等人[74-75]创新性的提出语音合成的双向LSTM模型,实现了语音合成质量的显著突破。而谷歌公司则提出了基于深度学习的WavetNet语音合成模型[76],直接对原始音频进行建模以形成高保真度的语音。Bengio等人2017年提出了Char2Wav[77],首先从文本中读取信息,然后编码生成音频,实现了端到端的语音合成。同年,王雨轩等人提出了一种端到端语音合成系统Tacotron[78],将文本数据转化为梅尔频谱(mel-spectrogram)再利用Griffin-Lim生成音频。

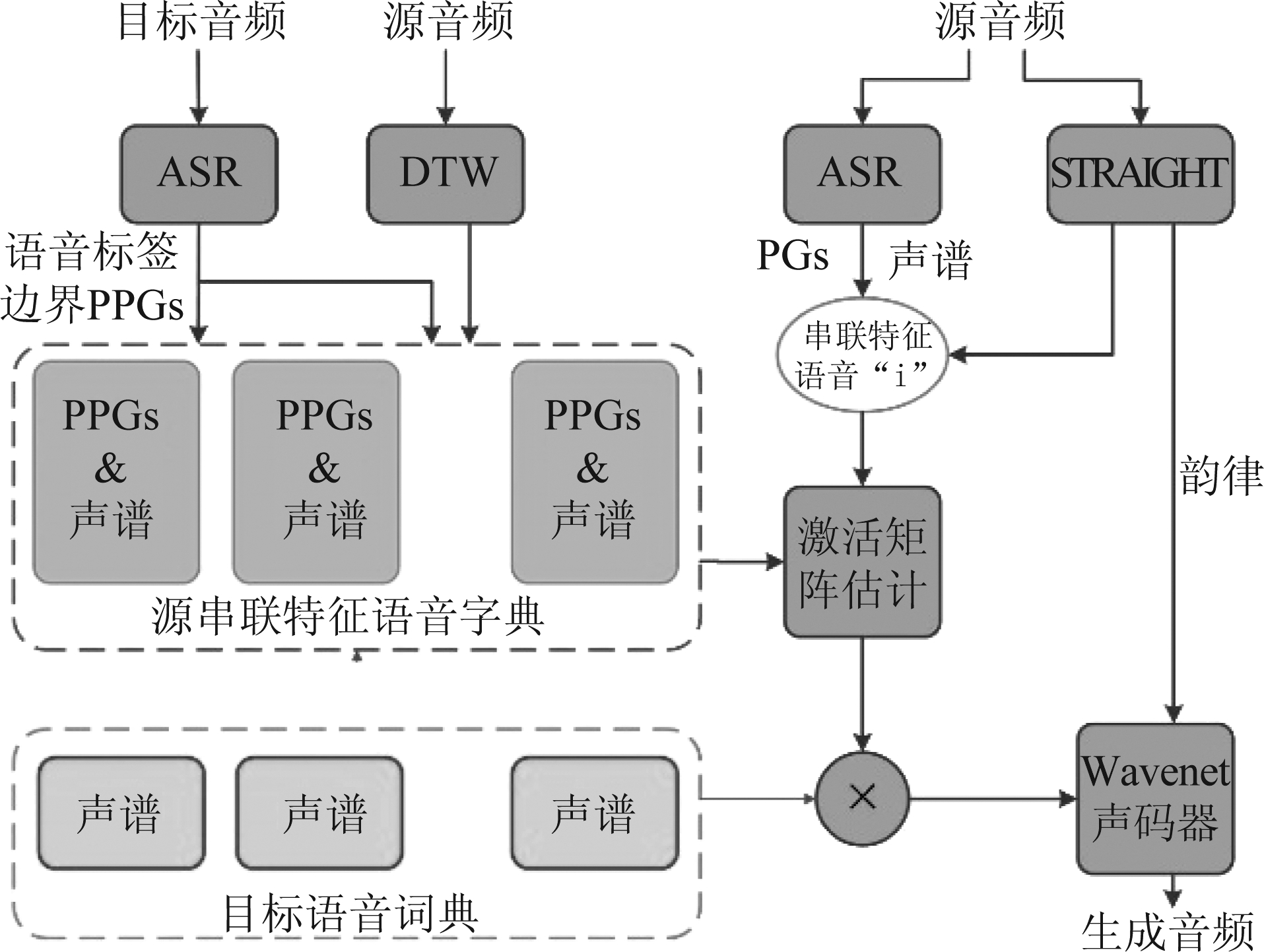

语音模拟是在保持语音内容和背景信息不变的情况下,通过改变音频属性来使伪造后的语音听起来像是目标伪造对象发出的,和基于深度学习的语音生成模型相比,语音模拟的输入为音频而非文本。Sun等人提出了基于音素后验概率(PPGs)的DBLSTM-RNN网络模型[79],通过Bi-LSTM解决了源语音和目标语音内容不相同而引起的帧不对齐的问题。注意力机制用于语音模拟,能够有效学习人类伪造语音的优势,Zhang等人提出的WaveNet模型[80]有效的实现了人类对语音模拟主观感受的真实性。

如图6所示,语音模拟的训练首先用基于隐马尔可夫的自动语音识别器(ASR)查找每个训练样本的语音标签、边界和语音后验概率图(PPG),从而实现具有串联特征的语音稀疏表示;并分别构造一一耦合的源语音字典和目标语音字典,结合WaveNet实现了多个说话人到目标说话人的语音模拟训练。

图6 基于串联特征语音稀疏表示的语音模拟

Fig.6 Tandem feature sparse representation based voice conversion

语音生成和语音模拟技术的发展对音频认知安全带来了很大挑战。针对性的认知安全技术则发展比较滞后,主要集中在开放音频生成、音频模拟数据集上的检测任务,在实验室环境中实现深度学习的检测模型,但对于网络开放环境下的音频认知安全,仍存在方法未知、泛化能力差的问题,有待进一步研究解决。

3.3 基于人工智能的图像认知安全技术

随着深度学习在计算机视觉的应用,数字图像对于影响公众认知的手段已经不仅仅局限传统的图像处理方式。在卷积神经网络中运用梯度反向传播算法显著提升手写数字识别效果后,图像认知技术得到了高速发展与广泛运用。

2014年,Goodfellow等人在深度学习模型的基础上提出了生成式对抗网络(GAN)[81-82],它以零和博弈以及对抗训练的思想在计算机视觉尤其是样本生成领域取得了显著的成功。Mehdi Mirza等人为GAN增加约束条件,提出了条件生成对抗网络(CGAN)[83],将无监督的生成模型变成了有监督的生成。Isola等人提出一对一的图像风格迁移模型pix2pix[84],对于给定的一张图像A,通过训练就能够生成与条件输入B图像风格一致的图像。JY Zhu等人提出CycleGAN[85],弥补了pix2pix只能成对训练的遗憾,CycleGAN先将源域图像映射到目标域,再返回源域得到二次生成图像,当源域图像和二次生成的图像之间的损失函数越低,则目标域图像也越逼真,除了风格迁移,CycleGAN可以转换季节、将二维图像转化为三维图像、将物体转化为另一个物体(物体变换)。Kim T等人基于生成式对抗网络提出了一个DiscoGAN[86]来学习发现跨域关系,DiscoGAN能够在保留源域图像主要特征的情况下将源域图像迁移至目标域图像,可以应用于人物性别转换、包与鞋子之间的转换、汽车到人脸的转换等等场景。除了基于图像的图像生成,以文本为驱动的图像生成同样是目前的研究热点之一。Reed S等人首次提出了根据输入文本描述自动合成人造图像的网络模型GAN-CLS[87]。H Zhang等人进一步解决了提高生成图像分辨率以及为图像增加细节的问题,提出了StackGAN模型[88]。

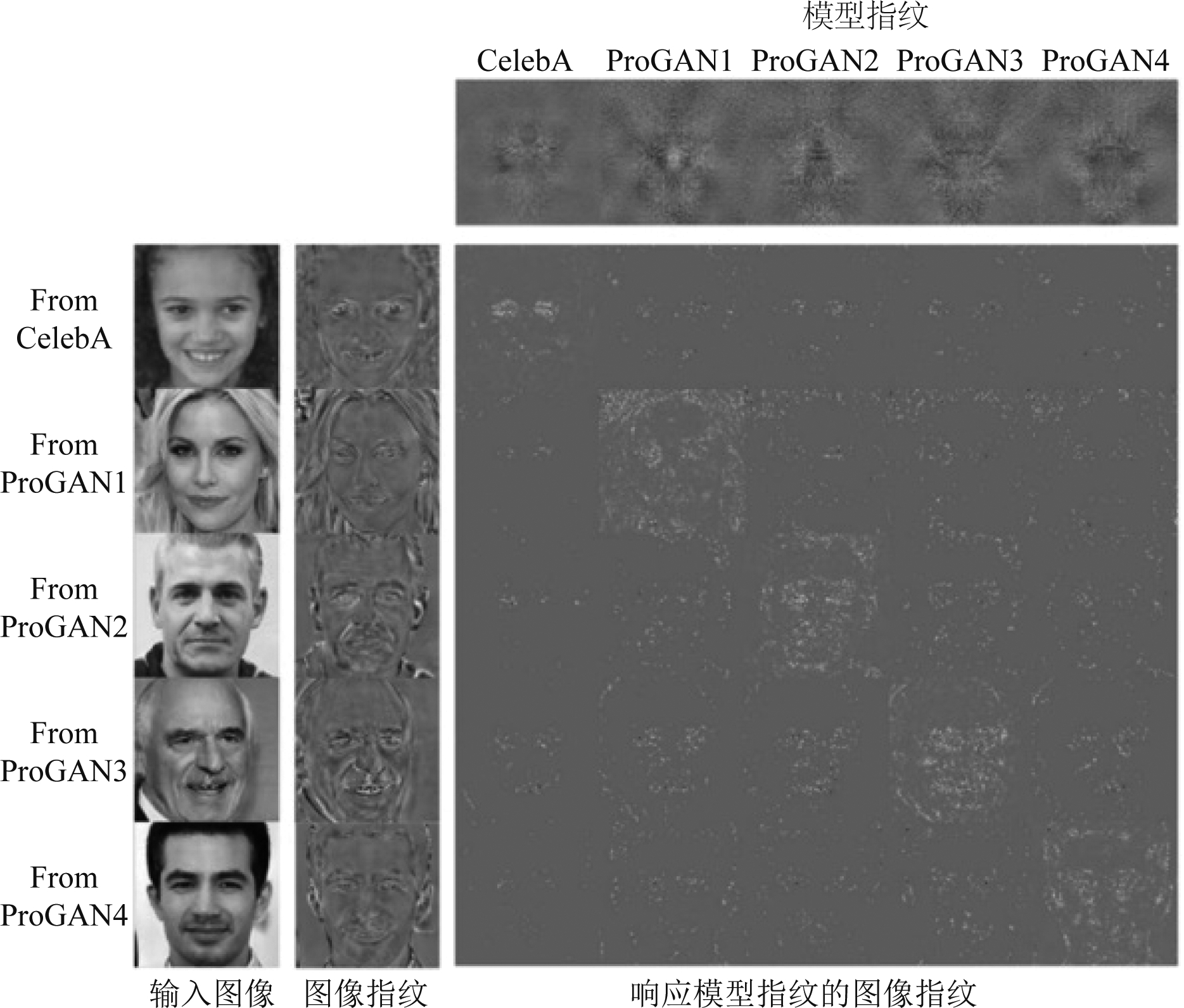

针对人工智能产生的伪造图像,可以从像素、数据、特征等不同层次进行分析。像素层面,人工智能生成的高质量图像会带有自身特定的伪影,如伪造人脸的混合伪影、面部五官细节的伪影、颜色伪影、光源伪影、模型伪影等。如图7所示,CelebA的真实人脸和ProGAN1、ProGAN2、ProGAN3、ProGAN4模型经过指纹提取后得到了显著不同的指纹,且指纹对图像噪声是鲁棒的。于是可以基于这一模型指纹设计伪造图像的检测模型[89],实现GAN伪造图像的精准检测。然而,该模型的检测只针对GAN生成的图像,无法对非GAN模型的生成图像实现泛化检测。

图7 生成对抗网络(GAN)的指纹

Fig.7 Fingerprint of generative adversarial network (GAN)

而从数据层面出发,研究数据驱动的伪造图像检测模型,是由深度神经网络(DNN)自动学习数据中伪造图像样本的特性。Wang等人在2021年提出了一个基于注意力机制的数据增强框架[90]来引导检测器细化和扩大其对伪造图像的注意力。具体来说就是跟踪并遮挡了前N个敏感的人脸面部区域,鼓励检测器更深入地挖掘以前忽略的区域,以便进行更具代表性的伪造。与CNN网络集成后,该模型取得了数据驱动的假脸检测任务在FF++数据集上的最好结果。

从高层语义的特征空间着手,可以开展基于高层语义的不一致性的伪造图像检测。Xin Yang等人经过对DeepFake生成过程进行研究发现,深度神经网络合成算法并不能保证生成面孔和原始面孔具有一致的面部界标(即人脸上的重要结构在人脸上的位置,如眼睛和嘴角)[91]。这些不一致性特征可以通过头部姿势估计加以提取,并作为判别视频是否真实的依据,该方法能够有效评价DeepFakes伪造人脸图像头部姿势的不一致性。然而,特征不一致性问题可能在新的伪造方法中被规避,难以实现鲁棒可泛化的检测。

基于人工智能的图像认知安全技术面临以下挑战:1)基于伪影的模型如何针对新的伪造技术实现检测;2)基于数据驱动的模型如何实现快速高效的伪造检测;3)基于不一致性的模型如何实现更强的模型泛化能力。在鲁棒特征提取、高效模型结构、数据集鲁棒性扩增和对抗性扩增等方向上保有研究突破的希望。

3.4 基于人工智能的视频认知安全技术

深度学习模型尤其是生成式对抗网络启发了研究者对于连续的视频序列进行有条件的修改。2017年底,一位网名为“deepfakes”的用户将名人的脸与色情视频主角交换;2018年,网名为“BuzzFeed”的用户利用换脸软件FakeApp给美国时任总统换脸。这些事件引发了社会各界的轩然大波,基于生成式对抗网络的deepfake换脸技术开始走进公众的视野[92]。Deepfake技术可划分为重现(reenactment)、替换(replace),编辑(editing)和合成(synthesis)。

重现是使用源对象xs驱动目标对象xt,使xt与xs做同样的动作,这个动作可以是面部表情、嘴部动作、眼部动作、头部、姿态动作。KR Prajwal等人提出了Wav2lip模型[93],利用输入音频可驱动视频目标的嘴部运动,技术适用于对视频的后期配音处理。Thies J等人提出一个支持实时对单目标视频序列进行表情重现的方法[94]。A Siarohin等人将模型从成对训练的限制中解放出来,提出了一个基于多重身份的人脸表情重现框架FreeNet[95]。

替换不仅使用源对象xs驱动目标对象xt的动作,还将源对象xs替换目标对象xt。迁移(transfer)是利用替换方法在时尚行业中用于不同服装中的个人虚拟试穿。交换(swap)常见于换脸,这种技术因其危害性而闻名,视频生成者可以将受害者的脸与色情视频人物互换以达到诽谤、勒索等目的;对政治人物进行交换来达到调侃、诬陷、传播政治观点等目的。另一方面,在公开场合使用换脸技术将人物身份匿名化来代替传统的马赛克也是它积极的一面。目前,Perov I等人在github上发布的DeepfaceLab换脸软件[96]是使用最广泛的换脸工具。

编辑通过添加、更改或删除等方式修改目标身份的属性,例如更换目标对象的衣服、胡子、年龄、体重、颜值和甚至种族、肤色。合成是指在缺少源对象的情况下创建的虚拟Deepfake角色,这一技术适用于电影和游戏行业。

视频的认知安全技术中,用于图像伪造检测的模型通常可以被用于对视频进行单帧的伪造检测。因此也具有一定的相关性。然而,视频中包含了一系列时间上连续的图像帧,且包含相符合的音频轨道。这使得视频认知安全技术中出现了面向时间不一致性、视听觉不一致性的检测方法等。

伪造人脸视频中可以提取基于时间的生物信号,与真实人脸视频的生物信号存在不一致[97]。如图8所示,首先是收集具有人脸部分的固定长度的视频片段,用open face库进行人脸检测,研究者使用了六个信号,表示出人脸的左脸颊、右脸颊和中部区域,并从这些时间片段中提取photo-plethysmography (PPG)特征的生物信号。检测这些提取的PPG信号向不同域(时间,频率,时频)的变换来计算时间相关性和时间一致。通过分析建议的信号转换和相应的特征集,建立广义的分类器,使用特征集中的信号特征作为特征向量来训练SVM。生成新颖的信号映射,使用PPG映射作为三层卷积神经网络CNN的输入进行训练。最后汇总真实性概率以进行分类。

图8 基于生物信号时间不一致的伪造视频检测

Fig.8 Biological signal time inconsistency for video forgery detection

Irene Amerini等人提出通过光流法来探究可能的帧间差异[98],光流是在两个连续帧之间计算的矢量场,用来描述相对于观察者的运动所造成的观测目标、表面或边缘的运动。嘴唇,眼睛等的异常移动会导致篡改后的视频在光流矩阵中应更易于发现。

2021年Haliassos等人针对伪造图像的口型缺陷,提出了读取唇语验证语义的不一致性模型[99],实现了在FaceForensics++数据集上的最佳检测能力。

视频的认知安全技术与图像有相似之处,也有自身的特点,由于视频更加复杂,检测的特征也更加多样。但在网络大数据环境下,同样面临着泛化性、鲁棒性与效率的严峻挑战。

3.5 社交网络下融媒体的认知安全技术

随着社交网络的发展,多媒体的不同媒介融合传播,并借助社交网络的广泛性和及时性影响到全球。融媒体是把多模态的多媒体信息整合起来,文本、音频、图像、视频等作为一个整体进行传播,形成融媒体的传播效应,进一步增强信息丰富度和可信度,增大了对受众的认知影响:包含文本、音频、图像、视频等媒体的Twitter消息引发了中东北非诸多国家的颜色革命,新冠疫情期间微信朋友圈、抖音等社交平台出现了大量配有文字、音频、图像、视频的假消息,严重威胁了国家与社会的安全。

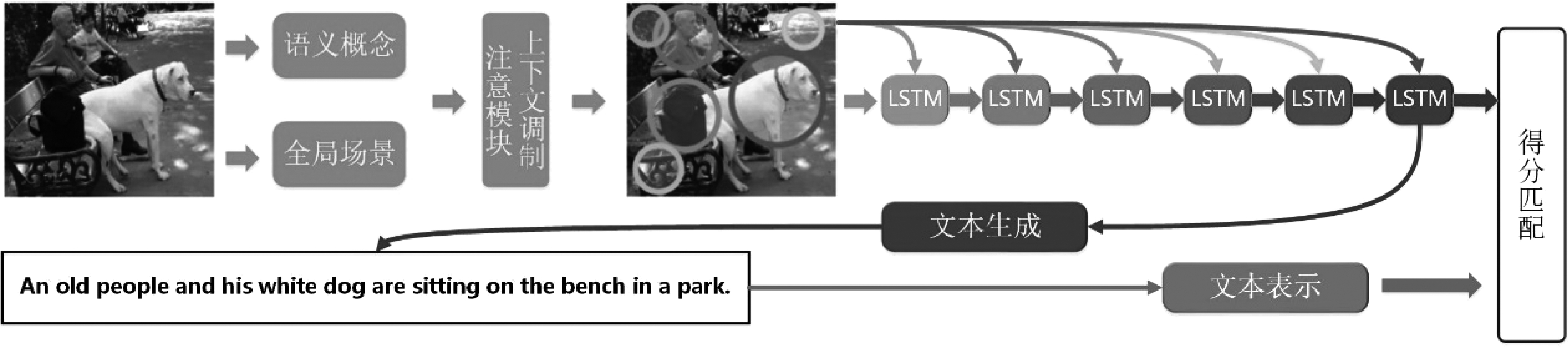

当前,融媒体的认知安全技术,除了单个媒介(如视频)的认知安全技术以外,还包括基于跨媒体表示学习的认知安全推理技术。主要采用融媒体不同模态数据的特征成对匹配的方法,通过特征相似性度量来进行融媒体安全检测。Wu等人提出了图文和文图的双向语义相似度度量[100],实现了不同媒体间的匹配度学习。Karpathy等人则是利用R-CNN按区域划分图像,计算每个可能区域的图像与文本的语义相似度,构建了深度视觉语义对齐DVSA网络模型[101]。Ma等人则从文本角度出发,注重消除词对句子的依赖,用不同句子片段与多级图像特征进行匹配计算相似度,提出了多模态卷积神经网络(m-CNN)[102];Huang等人在多区域的基础上,引入了多标签思想进行图像语义特征预测,并利用LSTM自注意力机制语义顺序预测,构建的语义概念顺序(SCO)学习模型[103]能对图像匹配出语义信息并生成对应文本。如图9所示,首先使用多区域多标签CNN从图像局部区域预测其语义概念,例如人和狗,以及指示这些概念之间配置的全局场景。然后,预测的概念和场景以门控方式自适应组合,作为后续上下文调制注意模块中的参考信息,以找到与概念相关的图像区域(由不同颜色的圆圈标记)。对概念的语义顺序,在不同的时间阶段将概念相关区域依次输入LSTM,然后按照所需的语义顺序进行聚合。对图像和文本的表达进行匹配评分从而得到匹配结果,可进一步用于融媒体不同媒介之间的一致性检查,实现融媒体认知安全。

图9 基于语义概念顺序(SCO)学习的融媒体匹配模型

Fig.9 Fusion media matching model based on semantic concept order (SCO) learning

Wang等人则进一步运用注意力机制,实现了图文关联的单词间语义关系的表征学习[104]。Wu等人在跨模态融媒体的语义对齐上提出了基于生成式对抗网络(GAN)的语义学习[105]。由于融媒体不同模态下信息的不一致性,可以对伪造的融媒体认知威胁信息进行检测和发现,实现融媒体认知安全。

然而,融媒体对认知的威胁不只是伪造融媒体才会发生,真实的融媒体截取后也会对人类认知造成威胁。面对融媒体大范围影响当前群众认知的情况,如何构建安全的人类多媒体认知模型,成为了当前亟待研究的问题。

随着跨媒体表示学习等技术的发展,融媒体技术仍在不断进步,融媒体的质量不断提升,对人类认知安全的威胁将越来越大,而当前对假消息为代表的融媒体威胁的认知安全技术仍然不能实现有效防护。未来,如何发布无法用于认知威胁的融媒体数据及如何利用人工智能增强人类融媒体的认知安全仍将是人类社会共同关注的重要研究课题。

4 总结与展望

多媒体认知安全伴随着多媒体信息技术的发展而不断进步,从早期的文本、音频、图像、视频认知安全,发展到基于人工智能技术的多媒体认知安全,一直到今天的社交网络融媒体认知安全,对人类认知提出了愈来愈严峻的挑战。然而,目前业内对多媒体安全的认知研究仍然处于发展阶段,现有的认知架构模型和基于网络媒体的消息认证机理的探索提供了方法和途径。除了经典的基于人脑的认知模型以外,在营销和情感计算领域也存在许多类似的认知机理实验研究,多媒体对人类认知的影响会因为受众的情感而产生不同的反应,情感计算领域的研究提供了人类对多媒体认知的研究助力。

未来,随着人工智能与深度学习的迅速发展,使机器辅助甚至代替人类成为认知和改造世界的角色之一。深度学习的发展提出了基于人工智能辅助的认知安全对抗技术,能够辅助人类识别多媒体认知安全的威胁;另一方面,聊天/问答机器人、网络宣传机器人、社交网络代理机器人等社交机器人的产生和进步,也对人类的认知安全产生非常严峻的挑战。

现有社交机器人在经过一定的学习训练,能够适应社交网络的复杂交互场景,赋予不同行为方式、语言习惯、性格特征等个性特点,能够通过弱图灵测试,达到在社交网络环境下与真实人类难以区分的情况下,极有可能被利用作为舆论引导、行为操控等认知安全的把控手段与工具,多智能体构造及自主协同的新型认知环境即将到来。

在新型认知环境下,多智能体自主协调的新型认知环境干预塑造问题将是未来研究中的一大挑战,融合网络多媒体不同媒介进行干预塑造,可以为解决这一挑战性问题提供思路。

[1] Wikipedia. Cognition[EB/OL]. [2021-07-15]. https:∥zh.wikipedia.org/wiki/认知.

[2] 约瑟夫·奈. 权力大未来[M]. 王吉美, 译. 北京: 中信出版社, 2010: 18.

NYE Joseph S. Jr. The Future of Power[M]. WANG Jimei,translation. Beijing, CITIC Press, 2010:18.(in Chinese)

[3] BOVET A, MAKSE H A. Influence of fake news in Twitter during the 2016 US presidential election[J]. Nature Communications, 2019, 10(1): 1-14.

[4] GRINBERG N, JOSEPH K, FRIEDLAND L, et al. Fake news on Twitter during the 2016 US presidential election[J]. Science, 2019, 363(6425): 374-378.

[5] GUO Bin, DING Yasan, SUN Yueheng, et al. The mass, fake news, and cognition security[J]. Frontiers of Computer Science, 2021, 15(3): 153806.

[6] 吴广智, 郭斌, 丁亚三, 等. 假消息认知机理研究综述[J]. 计算机科学, 2021, 48(6): 306-314.

WU Guangzhi, GUO Bin, DING Yasan, et al. Cognitive mechanisms of fake news[J]. Computer Science, 2021, 48(6): 306-314.(in Chinese)

[7] MOHAMED A R, HINTON G, PENN G. Understanding how Deep Belief Networks perform acoustic modelling[C]. 2012 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). Kyoto, Japan. IEEE, 2012: 4273- 4276.

[8] KRIZHEVSKY A, SUTSKEVER I, HINTON G E. ImageNet classification with deep convolutional neural networks[J]. Communications of the ACM, 2017, 60(6): 84-90.

[9] LONG J, SHELHAMER E, DARRELL T. Fully convolutional networks for semantic segmentation[C]. 2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Boston, MA, USA. IEEE, 2015: 3431-3440.

[10]WANG Xiangyu, RUI Yong, KANKANHALLI M. Up-Fusion: An Evolving Multimedia Fusion Method[J]. ACM Transactions on Multimedia Computing, Communications, and Applications (TOMM), 2014, 11(1): 1-19.

[11]ANDERSON J R. How can the human mind occur? [M]∥How Can the Human Mind Occur in the Physical Universe? Oxford University Press, 2007: 237-248.

[12]ROETS A. ‘Fake news’: Incorrect, but hard to correct. The role of cognitive ability on the impact of false information on social impressions[J]. Intelligence, 2017, 65: 107-110.

[13]GUO Bin, DING Yasan, SUN Yueheng, et al. The mass, fake news, and cognition security[J]. Frontiers of Computer Science, 2020, 15(3): 1-13.

[14]PENNYCOOK G, RAND D G. Who Falls for fake news? The roles of bullshit receptivity, overclaiming, familiarity, and analytic thinking[J]. Journal of Personality, 2020, 88(2): 185-200.

[15]SHU Kai, SLIVA A, WANG Suhang, et al. Fake news detection on social media[J]. ACM SIGKDD Explorations Newsletter, 2017, 19(1): 22-36.

[16]NUMMENMAA L, GLEREAN E, VIINIKAINEN M, et al. Emotions promote social interaction by synchronizing brain activity across individuals[J]. Proceedings of the National Academy of Sciences of the United States of America, 2012, 109(24): 9599-9604.

[17]PENG Xiaozhe, LI You, WANG Pengfei, et al. The ugly truth: Negative gossip about celebrities and positive gossip about self entertain people in different ways[J]. Social Neuroscience, 2015, 10(3): 320-336.

[18]BAGO B, RAND D G, PENNYCOOK G. Fake news, fast and slow: Deliberation reduces belief in false (but not true) news headlines[J]. Journal of experimental psychology: general, 2020, 149(8): 1608.

[19]BASOL M, ROOZENBEEK J, VAN DER LINDEN S. Good news about bad news: Gamified inoculation boosts confidence and cognitive immunity against fake news[J]. Journal of Cognition, 2020, 3(1): 2.

[20]BERGSTROM C T, BAK-COLEMAN J B. Information gerrymandering in social networks skews collective decision-making[J]. Nature, 2019, 573(7772): 40- 41.

[21]BUNCE V. The Prospects for a Color Revolution in Russia[J]. Journal of the American Academy of Arts & Sciences, 2017: 19-29.

[22]RAWNSLEY A. Pentagon wants a social media propaganda machine [EB/OL]. [2020-06-15]. https:∥www.wired.com/2011/07/darpa-wants-social-media-sensor-for-propaganda-ops/.

[23]QUINN B, BALL J. US military studied how to influence Twitter users in Darpa-funded research[EB/OL]. [2020-06-15].https:∥www.theguardian.com/world/2014/jul/08/darpa-social-networks-research-twitter-influence-studies.

[24]孙定宇. 网络信息战——社交媒体武器化趋势及影响[J]. 国防科技, 2021, 42(1): 60- 65.

SUN Dingyu. Network information warfare: Trends and impact of social media weaponization[J]. National Defense Technology, 2021, 42(1): 60- 65.(in Chinese)

[25]MENG Peng, HANG Liusheng, CHEN Zhili, et al. STBS: A statistical algorithm for steganalysis of translation-based steganography[C]. International Workshop on Information Hiding. Springer, Berlin, Heidelberg, 2010.

[26]DIN R, YUSOF S A M, AMPHAWAN A, et al. Performance analysis on text steganalysis method using a computational intelligence approach [C]. in International Conference on Electrical Engineering, Computer Science and Informatics (EECSI 2015), 2015.

[27]SAMANTA S, DUTTA S, SANYAL G. IEEE, A real time text steganalysis by using statistical method [M].(Proceedings of 2nd IEEE International Conference on Engineering & Technology Icetech-2016). 2016: 264-268.

[28]YANG Hao, CAO Xianbin. Linguistic steganalysis based on meta features and Immune mechanism [J]. Chinese Journal of Electronics, 2010, 19 (4), 661- 666.

[29]CHEN Zhili, HUANG Liusheng, MIAO Haibo, et al. Steganalysis against substitution-based linguistic steganography based on context clusters [J]. Computers & Electrical Engineering, 2011, 37 (6), 1071-1081.

[30]XIN Zuo, HU Huanhuan, ZHANG Weiming, et al. Text semantic steganalysis based on word embedding: 4th international conference, ICCCS 2018, Haikou, China, June 8-10, 2018, Revised Selected Papers, Part IV[C]. International Conference on Cloud Computing & Security. Springer, Cham, 2018.

[31]Wikipedia. Watergate scandal[EB/OL]. [2021-07-15]. https:∥zh.wikipedia.org/wiki/水门事件.

[32]ALI Z, IMRAN M, ALSULAIMAN M. An automatic digital audio authentication/forensics system[J]. IEEE Access, 2017, 5: 2994-3007.

[33]余颖娟. 数字音频同源复制和异源拼接篡改检测算法研究[D]. 广州: 华南理工大学, 2018.

YU Yingjuan. Research on digital audio copy-move and splicing detection[D]. Guangzhou: South China University of Technology, 2018. (in Chinese)

[34]ZHAO H, MALIK H. Audio recording location identification using acoustic environment signature[J]. IEEE Transactions on Information Forensics and Security, 2013, 8(11): 1746-1759.

[35]GERAZOV B, KOKOLANSKI Z, ARSOV G, et al. Tracking of electrical network frequency for the purpose of forensic audio authentication[C]. 2012 13th International Conference on Optimization of Electrical and Electronic Equipment (OPTIM). IEEE, 2012: 1164-1169.

[36]BIANCHI T, DEROSA A, FONTANI M, et al. Detection and localization of double compression in MP3 audio tracks[J]. EURASIP Journal on Information Security, 2014, 2014(1): 1-14.

[37]王志飞. 数字音频司法鉴定技术研究[D]. 厦门: 厦门大学, 2014.

WANG Zhifei. Research on digital audio judicial authentication technology[D]. Xiamen, China: Xiamen University, 2014. (in Chinese)

[38]王伟, 曾凤, 章国安, 等. 合成图像被动取证技术研究进展[J]. 南通大学学报(自然科学版), 2013, 12(3) :1-6.

WANG Wei, ZENG Feng, ZHANG Guo-an, et al. Survey on techniques of composite image passive forensics[J]. Journal of Nantong University (Natural Science Edition), 2013, 12(3) :1-6. (in Chinese)

[39]CHRISTLEIN V, RIESS C, JORDAN J, et al. An evaluation of popular copy-move forgery detection approaches[J]. IEEE Transactions on Information Forensics and Security, 2012, 7(6): 1841-1854.

[40]NG T T, CHANG S F, SUN Qibin. Blind detection of photomontage using higher order statistics[C]. 2004 IEEE International Symposium on Circuits and Systems (IEEE Cat. No. 04CH37512). IEEE, 2004, 5: V-V.

[41]SCHETINGER V, OLIVEIRA M M, DA SILVA R, et al. Humans are easily fooled by digital images[J]. Computers & Graphics, 2017, 68: 142-151.

[42]COZZOLINO D, POGGI G, VERDOLIVA L. Copy-move forgery detection based on patchmatch[C]. 2014 IEEE International Conference on Image Processing (ICIP). IEEE, 2014: 5312-5316.

[43]COZZOLINO D, POGGI G, VERDOLIVA L. Efficient dense-field copy-move forgery detection[J]. IEEE Transactions on Information Forensics and Security, 2015, 10(11): 2284-2297.

[44]PAN Xunyu, LYU Siwei. Region duplication detection using image feature matching[J]. IEEE Transactions on Information Forensics and Security, 2010, 5(4): 857- 867.

[45]XU Bo, WANG Junwen, LIU Guangjie, et al. Image copy-move forgery detection based on SURF[C]. 2010 International Conference on Multimedia Information Networking and Security. IEEE, 2010: 889- 892.

[46]ZANDI M, MAHMOUDI-AZNAVEH A, TALEBPOUR A. Iterative copy-move forgery detection based on a new interest point detector[J]. IEEE Transactions on Information Forensics and Security, 2016, 11(11): 2499-2512.

[47]FERREIRA A, FELIPUSSI S C, ALFARO C, et al. Behavior knowledge space-based fusion for copy-move forgery detection[J]. IEEE Transactions on Image Processing, 2016, 25(10): 4729- 4742.

[48]HE Zhongwei, SUN Wei, LU Wei, et al. Digital image splicing detection based on approximate run length[J]. Pattern Recognition Letters, 2011, 32(12): 1591-1597.

[49]MOGHADDASI Z, JALAB H A, MD Noor R, et al. Improving RLRN image splicing detection with the use of PCA and kernel PCA[J]. The Scientific World Journal, 2014, 2014.

[50]EL-ALFY E S M, QURESHI M A. Combining spatial and DCT based Markov features for enhanced blind detection of image splicing[J]. Pattern Analysis and Applications, 2015, 18(3): 713-723.

[51]BIANCHI T, PIVA A. Image forgery localization via block-grained analysis of JPEG artifacts[J]. IEEE Transactions on Information Forensics and Security, 2012, 7(3): 1003-1017.

[52]WANG W, DONG J, TAN T. Exploring DCT coefficient quantization effects for local tampering detection[J]. IEEE Transactions on Information Forensics and Security, 2014, 9(10): 1653-1666.

[53]PENG B, WANG W, DONG J, et al. Optimized 3D lighting environment estimation for image forgery detection[J]. IEEE Transactions on Information Forensics and Security, 2016, 12(2): 479- 494.

[54]FAN Yu, CARRÉ P, FERNANDEZ-MALOIGNE C. Image splicing detection with local illumination estimation[C]∥2015 IEEE International Conference on Image Processing (ICIP). IEEE, 2015: 2940-2944.

[55]FERRARA P, BIANCHI T, DE ROSA A, et al. Image forgery localization via fine-grained analysis of CFA artifacts[J]. IEEE Transactions on Information Forensics and Security, 2012, 7(5): 1566-1577.

[56]CHIERCHIA G, POGGI G, SANSONE C, et al. A Bayesian-MRF approach for PRNU-based image forgery detection[J]. IEEE Transactions on Information Forensics and Security, 2014, 9(4): 554-567.

[57]BERTALMIO M, SAPIRO G, CASELLES V, et al. Image inpainting[C]∥Proceedings of the 27th Annual Conference on Computer Graphics and Interactive Techniques, 2000: 417- 424.

[58]CRIMINISI A, PÉREZ P, TOYAMA K. Region filling and object removal by exemplar-based image inpainting[J]. IEEE Transactions on Image Processing, 2004, 13(9): 1200-1212.

[59]王新刚, 张蒙帅. “短视频”文化现象的价值困境及其化解[J]. 广西社会科学, 2019(3): 150-154.

WANG Xingang, ZHANG Mengshuai. The value dilemma of “short video” cultural phenomenon and its resolution [J]. Social Sciences in Guangxi, 2019(3): 150-154.(in Chinese)

[60]PARK K W, SHIM Y J, LEE M J. Region-based static video stitching for reduction of parallax distortion[J]. Sensors, 2021, 21(12): 4020.

[61]匡文波, 高钰辰. 后短视频时代的问题与多维治理模式[J]. 新闻论坛, 2021, 35(2): 13-16.

KUANG Wenbo, GAO Yuchen. Problems and multi-dimensional governance models in the post-short video era [J]. News Tribune, 2021, 35(2): 13-16.(in Chinese)

[62]ZHANG J, SU Y, ZHANG M. Exposing digital video forgery by ghost shadow artifact[C]. Proceedings of the First ACM Workshop on Multimedia in Forensics, 2009: 49-54.

[63]BESTAGINI P, MILANI S, TAGLIASACCHI M, et al. Local tampering detection in video sequences[C]∥2013 IEEE 15th International Workshop on Multimedia Signal Processing (MMSP). IEEE, 2013: 488- 493.

[64]SUBRAMANYAM A V, EMMANUEL S. Video forgery detection using HOG features and compression properties[C]. 2012 IEEE 14th International Workshop on Multimedia Signal Processing (MMSP). IEEE, 2012: 89-94.

[65]CASTILLO C, MENDOZA M, POBLETE B. Information credibility on twitter[C]. Proceedings of the 20th International Conference on World Wide Web-WWW '11. Hyderabad, India. New York: ACM Press, 2011:675- 684.

[66]GUPTA A, KUMARAGURU P, CASTILLO C, et al. TweetCred: real-time credibility assessment of content on twitter[M]∥Lecture Notes in Computer Science. Cham: Springer International Publishing, 2014: 228-243.

[67]KWON S, CHA M, JUNG K, et al. Prominent features of rumor propagation in online social media[C]. 2013 IEEE 13th International Conference on Data Mining. Dallas, TX, USA. IEEE, 2013: 1103-1108.

[68]YANG Fan, LIU Yang, YU Xiaohui, et al. Automatic detection of rumor on Sina Weibo[C]. Proceedings of the ACM SIGKDD Workshop on Mining Data Semantics-MDS '12. Beijing, China. New York: ACM Press, 2012: 13.

[69]SUN Shengyun, LIU Hongyan, HE Jun, et al. Detecting event rumors on sina weibo automatically[M]. Web Technologies and Applications. Berlin, Heidelberg: Springer Berlin Heidelberg, 2013: 120-131.

[70]ZHOU Kaimin, SHU Chang, LI Binyang, et al. Early rumour detection[C]. Proceedings of the 2019 Conference of the North. Minneapolis, Minnesota. Stroudsburg, PA, USA: Association for Computational Linguistics, 2019: 1614-1623.

[71]MA Jing, GAO Wei, MITRA Prasenjit, et al. Detecting rumors from microblogs with recurrent neural networks[C]. In IJCAI 2016. 3818-3824.

[72]陶建华, 傅睿博, 易江燕, 等. 语音伪造与鉴伪的发展与挑战[J]. 信息安全学报, 2020, 5(2): 28-38.

TAO Jianhua, FU Ruibo, YI Jiangyan, et al. Development and challenge of speech forgery and detection[J]. Journal of Cyber Security, 2020, 5(2): 28-38.(in Chinese)

[73]LING Zhenhua, DENG Li, YU Dong. Modeling spectral envelopes using restricted boltzmann machines and deep belief networks for statistical parametric speech synthesis[J]. IEEE Transactions on Audio, Speech, and Language Processing, 2013, 21(10): 2129-2139.

[74]ZEN H, SAK H. Unidirectional long short-term memory recurrent neural network with recurrent output layer for low-latency speech synthesis[C]. 2015 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). South Brisbane, QLD, Australia. IEEE, 2015: 4470- 4474.

[75]FAN Yuchen, QIAN Yao, XIE Fenglong, et al. TTS synthesis with bidirectional LSTM based recurrent neural networks[J]. Proceedings of the Annual Conference of the International Speech Communication Association, INTERSPEECH, 2014: 1964-1968.

[76]OORD A V D, DIELEMAN S, ZEN H, et al. WaveNet: A generative model for raw audio[J]. arXiv preprint arXiv:1609.03499. 2016: 1-15.

[77]SOTELO J, MEHRI S, KUMAR K, et al. Char2Wav: end-to-end speech synthesis [EB/OL]. http:∥www.josesotelo.com/speechsynthesis/, 2017.

[78]WANG Yuxuan, SKERRY-RYAN R J, STANTON D, et al. Tacotron: towards end-to-end speech synthesis[C]. Interspeech 2017. ISCA: ISCA, 2017: 4006- 4010.

[79]SUN Lifa, KANG Shiyin, LI Kun, et al. Voice conversion using deep bidirectional long short-term memory based recurrent neural networks[C]. 2015 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). IEEE, 2015: 4869- 4873.

[80]SISMAN B, ZHANG Mingyang, LI Haizhou. A voice conversion framework with tandem feature sparse representation and speaker-adapted wavenet vocoder[C]. Interspeech, 2018: 1978-1982.

[81]GOODFELLOW I, POUGET-ABADIE J, MIRZA M, et al. Generative adversarial networks[J]. Communications of the ACM, 2020, 63(11): 139-144.

[82]曹仰杰, 贾丽丽, 陈永霞, 等. 生成式对抗网络及其计算机视觉应用研究综述[J]. 中国图象图形学报, 2018, 23(10): 1433-1449.

CAO Yangjie, JIA Lili, CHEN Yongxia, et al. Review of computer vision based on generative adversarial networks[J]. Journal of Image and Graphics, 2018, 23(10): 1433-1449.(in Chinese)

[83]MIRZA M, OSINDERO S. Conditional generative adversarial nets[J]. arXiv preprint arXiv: 1411.1784, 2014.

[84]ISOLA P, ZHU J Y, ZHOU T, et al. Image-to-image translation with conditional adversarial networks[C]. Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2017: 1125-1134.

[85]ZHU Junyan, PARK T, ISOLA P, et al. Unpaired image-to-image translation using cycle-consistent adversarial networks[J]. 2017 IEEE International Conference on Computer Vision (ICCV), 2017: 2242-2251.

[86]KIM T, CHA M, KIM H, et al. Learning to discover cross-domain relations with generative adversarial networks[C]. Proceedings of the 34th International Conference on Machine Learning. Sydney,Australia: PMLR,2017.

[87]SIDHARTH S, CHARULATHA B S. Generative adversarial neural networks for text-to-image synthesis of dog images[M]. Proceedings of International Conference on Big Data, Machine Learning and their Applications. Singapore: Springer Singapore, 2020: 307-314.

[88]ZHANG Han, XU Tao, LI Hongsheng, et al. StackGAN: text to photo-realistic image synthesis with stacked generative adversarial networks[J]. 2017 IEEE International Conference on Computer Vision (ICCV), 2017: 5908-5916.

[89]YU N, DAVIS L S, FRITZ M. Attributing fake images to gans: Learning and analyzing gan fingerprints[C]. Proceedings of the IEEE/CVF International Conference on Computer Vision, 2019: 7556-7566.

[90]WANG Chenrui, DENG Weihong. Representative forgery mining for fake face detection[C]. Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2021: 14923-14932.

[91]YANG Xin, LI Yuezun, LYU Siwei. Exposing deep fakes using inconsistent head poses[C]. ICASSP 2019-2019 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). IEEE, 2019: 8261- 8265.

[92]MIRSKY Y, LEE W. The creation and detection of deepfakes[J]. ACM Computing Surveys, 2021, 54(1): 1- 41.

[93]PRAJWAL K R, MUKHOPADHYAY R, NAMBOODIRI V P, et al. A lip sync expert is all You need for speech to lip generation in the wild[C].Proceedings of the 28th ACM International Conference on Multimedia. Seattle WA USA. New York, NY, USA: ACM, 2020: 484- 492.

[94]THIES J, ZOLLHÖFER M, STAMMINGER M, et al. Face2Face: real-time face capture and reenactment of RGB videos[C]. 2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Las Vegas, NV, USA. IEEE, 2016: 2387-2395.

[95]ZHANG Jiangning, ZENG Xianfang, WANG Mengmeng, et al. FReeNet: multi-identity face reenactment[C]. 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Seattle, WA, USA. IEEE, 2020: 5326-5335.

[96]PETROV I, GAO Daiheng, CHERVONIY N, et al. DeepFaceLab: A simple, flexible and extensible face swapping framework[J]. arXiv preprint arXiv:2005.05535, 2020: 1-10.

[97]CIFTCI U A, DEMIR I, YIN L. Fakecatcher: Detection of synthetic portrait videos using biological signals[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2020.

[98]AMERINI I, GALTERI L, CALDELLI R, et al. Deepfake video detection through optical flow based cnn[C]∥Proceedings of the IEEE/CVF International Conference on Computer Vision Workshops, 2019: 0-0.

[99]HALIASSOS A, VOUGIOUKAS K, PETRIDIS S, et al. Lips Don't Lie: A generalisable and robust approach to face forgery detection[C]. Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2021: 5039-5049.

[100]WU Yiling, WANG Shuhui, HUANG Qingming. Online asymmetric similarity learning for cross-modal retrieval[C]. 2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Honolulu, HI, USA. IEEE, 2017: 3984-3993.

[101]KARPATHY A, LI Feifei. Deep visual-semantic alignments for generating image descriptions[C]. 2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Boston, MA, USA. IEEE, 2015: 3128-3137.

[102]MA Lin, LU Zhengdong, SHANG Lifeng, et al. Multimodal convolutional neural networks for matching image and sentence[C]. 2015 IEEE International Conference on Computer Vision (ICCV). Santiago, Chile. IEEE, 2015: 2623-2631.

[103]HUANG Yan, WU Qi, WANG Wei, et al. Image and sentence matching via semantic concepts and order learning[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2020, 42(3): 636- 650.

[104]WANG Shuhui, CHEN Yangyu, ZHUO Junbao, et al. Joint global and co-attentive representation learning for image-sentence retrieval[C]. Proceedings of the 26th ACM International Conference on Multimedia. Seoul Republic of Korea. New York, NY, USA: ACM, 2018: 1398-1406.

[105]WU Yiling, WANG Shuhui, SONG Guoli, et al. Augmented adversarial training for cross-modal retrieval[J]. IEEE Transactions on Multimedia, 2021, 23: 559-571.