1 引言

语音是人类交流和人机交互的主要通信信息,不仅传递了需要表达的语言内容,也包含了说话人所独有的身份特征。目前,随着深度学习技术的应用,语音合成技术飞速发展,可以合成出足以欺骗人类和人机交互设备的目标说话人语音。该技术可应用于智能设备的语音交互,如提供高度拟人、流畅自然的语音交互功能,开发阅读听书、无障碍播报等语音应用,使用户获得更亲切、更便捷的交互体验;也可以推动文娱新兴产业的发展,如在影视、游戏等制作中进行虚拟角色的声音模拟、供自媒体等内容创作方定制个性化声音应用于传播平台等。然而,语音伪造技术一旦被不法分子利用,如应用于舆论误导或攻击身份识别系统等不良用途,将会对全球的民生、经济、政治和社会带来严重的威胁。

语音伪造技术的恶意攻击对象可分为人类听觉系统和机器听觉系统两大类。在对人类听觉系统(Human Audio System,HAS)的攻击方面,基于深度学习的虚假信息伪造技术(Deepfake)已经引爆了全球社会各界的关注。语音伪造是Deepfake技术实现舆论操控的核心技术之一,通过合成目标说话人的语音,可操控目标人物发表有目的的虚假言论。当不法分子利用虚假语音煽动暴力冲突时,可能影响国家政权安全和国民生命安全;利用虚假语音进行电话诈骗、勒索时,可能危害国民财产安全;恶意合成的虚假语音流入社交媒体广泛传播,可能损害他人名誉或引发社会动荡,影响社会稳定。此外,语音伪造技术对现有的司法取证也带来了相应的挑战。在对机器听觉系统的攻击方面,语音已是目前人工智能时代人机交互的最重要接口,基于说话人声纹特征的身份认证技术在各种智能设备、网络交易的安全访问控制中发挥着重要作用,因此伪造语音针对说话人验证系统(Automatic Speaker Verification,ASV)的恶意攻击,将非法获取目标用户的访问权限,实现对目标用户的智能设备、安全账户的操控,对基于语音的安全访问控制带来严重的威胁。

为了有效防御恶意滥用的伪造语音对人类和机器造成的上述危害,近年来针对伪造语音的检测技术在同步发展,相继有学者对不同类型的伪造语音检测展开了多角度的研究。自2015年起,由英国爱丁堡大学等多个研究机构共同发起的ASVspoof系列挑战赛也持续引领了伪造语音检测领域的发展。目前,大部分相关工作主要集中于针对ASV系统的伪造语音检测技术的研究,而对直接攻击人类听觉的Deepfake语音检测的研究也正在引起学者们的广泛关注。

本文对语音伪造和检测技术进行了全面分析。第2节介绍了语音伪造技术的基本概念、传统方法和基于深度学习的方法;第3节针对不同的伪造语音技术,分别从检测系统的前端和后端介绍了基于深度学习伪造语音检测方法;第4节介绍了语音伪造和检测领域近年来主要比赛的概况及结果;第5节介绍了伪造语音检测最新工作中常用的数据集;第6节总结了语音伪造和检测领域的相关工具包和论文代码;第7节讨论了语音合成和伪造语音检测的未来的研究方向;第8节对本文内容进行总结。

2 语音伪造技术

语音伪造的目的是生成目标说话人的声音,以欺骗人类听觉系统(HAS)或自动说话人验证系统(ASV)。目前的语音伪造技术主要包括语音模仿(Impersonation)、语音合成(Text to Speech,TTS)、语音转换(Voice Conversion,VC)、重放攻击(Replay Attack,RA)以及对抗攻击(Adversarial Attack)。语音模仿是指通过人类模拟产生目标说话人风格的语音,属于非自动化的语音伪造手段,其实施难度较高,可模仿的目标说话人范围受限,抗检测能力弱。语音合成是指根据给定的语言内容合成目标说话人风格的语音,实现文本到声音的映射;语音转换是指将源说话人的语音转换为目标说话人风格的语音,实现声音到声音的映射。由于语音合成和转换技术可以实现任意语言内容的目标说话人风格语音伪造,因此是主要的语音伪造手段,在深度伪造中得到广泛使用。重放攻击是指对目标说话人的语音通过设备录制后进行编辑和回放以产生高度逼真的目标说话人语音。重放攻击容易实施,无需特定的专业知识和复杂的设备,因此常用于攻击ASV系统。重放语音与目标说话人的声学特征高度相似,但语音内容的可控性弱。对抗攻击是指通过对抗样本技术,在语音信号上添加微量扰动实现对ASV系统的攻击,该攻击手段是当前的新型攻击手段,利用了深度神经网络(Deep Neural Network,DNN)所存在的缺陷,在不影响人类听觉感知的情况下,欺骗ASV系统使之产生误判。图1对以上五类语音伪造技术的攻击对象和可能带来的危害进行了总结。由于语音模仿和重放攻击技术实现简单,因此本文主要对语音合成、语音转换、以及对抗攻击三类伪造语音技术的研究进展情况进行综述。

图1 五种伪造语音攻击类型的攻击对象及危害

Fig.1 The attack targets and hazards of five speech spoofing attacks

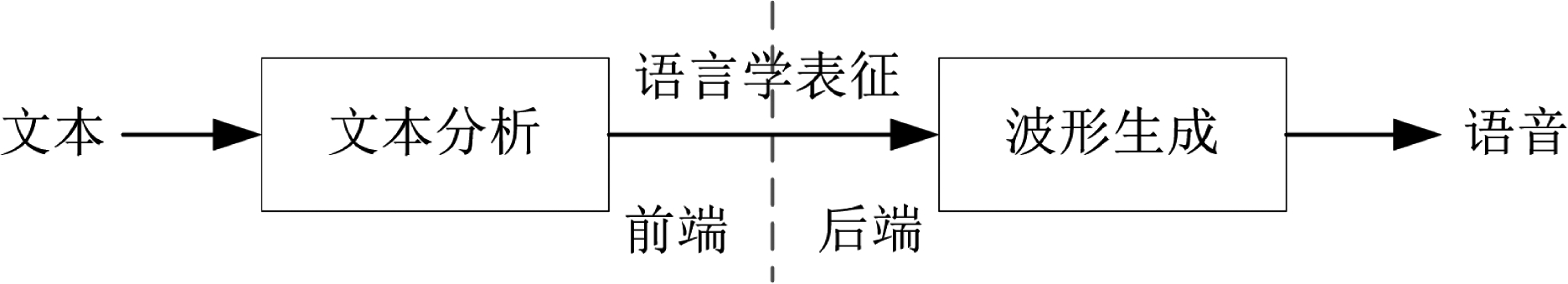

2.1 语音合成

语音合成将指定的语言文本生成目标说话人声音,实现文本到声音的映射。典型的语音合成系统如图2所示,包括前端文本分析和后端语音波形生成两部分。文本分析将输入文本通过规范化、分词、词性标注等步骤生成对应的音素序列、时长预测等信息;语音波形生成根据文本分析生成的语言规范合成目标说话人的语音波形。随着深度学习的发展,语音合成技术逐渐从传统语音合成发展为基于深度学习机制的语音合成。目前基于深度学习的语音合成技术已经逐渐采用端到端语音合成机制,即将文本分析和波形生成过程连接,直接输入文本或者注音字符,输出语音波形。本小节将分别介绍具有代表性的传统语音合成工作和最新的深度学习语音合成工作。

图2 语音合成技术基础框架

Fig.2 The architecture of a generic text to speech system

传统语音合成主要包括波形拼接法和参数生成法。波形拼接语音合成将自然语音数据中的语音单元按照一定的规则拼接,合成与目标说话人高度相似且自然的语音,包括语料库收集、声学单元选取、拼接伪造等步骤。简单的波形拼接语音合成的方法是利用编辑软件直接对音频信号进行裁剪、插入、复制粘贴等修改操作,即复制粘贴篡改。更复杂的拼接方法会调整控制各拼接单元的韵律,以得到更自然流畅的合成语音,代表性工作包括基音同步叠加的PSOLA技术[1]和利用隐马尔可夫模型(Hidden Markov Model,HMM)限制目标单元韵律参数的单元选择系统[2]等。近年来,波形拼接语音合成大多采用深度学习技术,如2017年Google提出的基于序列到序列LSTM自编码器的实时单元选择系统[3]等。波形拼接式语音合成适用于某些特定领域,如天气预报、报时、金融业务等。该方法使用真实的语音片段,可以最大限度保留语音音质,可以合成高自然度的语音。然而,其需要大量目标说话人语料,且对于不同领域的文本合成稳定性不强,容易被人或机器识别。基于参数生成的语音合成通过声学模型预测声学参数,将声学参数通过声码器合成出目标说话人语音。参数生成语音合成技术的传统代表性工作包括基于HMM的统计参数合成方法[2]以及基于 DNN 的参数合成方法[4]等。参数语音合成可以输出稳定流畅的语音,但受限于参数合成器的缺陷以及统计建模的损失,如生成参数不够平滑、HMM建模不够准确等问题,合成的语音通常不够自然。

随着深度学习技术的发展,近年来的语音合成技术基本采用深度学习方法,主要包括管道式(Pipeline)语音合成和端到端式语音合成两类。管道式语音合成整体上可分为文本分析、声学模型、声码器三个模块。文本分析模块根据输入文本进行韵律预测和每个音素的时长预测;声学模型建立文本特征和声学特征之间的联系,根据文本分析的输出经由DNN映射到声学特征;声码器模块实现声学参数到语音波形的转换。2017年,百度人工智能实验室[5]使用神经网络模型替换传统参数语音合成的子模块,结合改进后的WaveNet声码器提出Deep Voice系统。2018年,百度人工智能实验室[6]进一步提出基于注意力机制的全卷积语音合成系统 Deep Voice3,该系统使用编码器将文本转换为高级特征表示,使用自回归解码器生成梅尔尺度谱图,同时引入非自回归的后处理转换网络converter根据解码器隐状态预测声码器参数,提高了语音合成的速度。管道式语音合成利用深度学习的强大学习能力,一定程度上弥补了传统统计建模式语音合成的不足,但多个模块之间会产生误差累积,且需要高昂成本的文本标注以及文本特征和声学特征的强制对齐,上述问题限制了其语音合成的效果。

端到端式语音合成系统实现了直接输入文本或者注音字符,输出音频波形,极大程度地降低了语音合成系统构建的复杂度,减少了合成过程中的人工干预和对语言学相关背景知识的需求。端到端系统中模块的减少也有效避免了传统方法多阶段建模导致的误差累积,取得了语音合成性能上的大幅提升。目前基于深度学习的端到端式语音合成系统可分为自回归模型和非自回归模型两类。自回归语音合成基于序列到序列的生成模型,可以达到目前最优的语音合成效果,但是合成速度较慢。2016 年Google提出WaveNet语音合成算法[7],通过扩张因果卷积网络根据当前时刻采样点生成下一采样点。该模型直接对原始语音数据进行建模,避免了声码器对语音进行参数化时导致的音质损失。然而,该系统无法实现输入文本或标注音符到输出语音的直接转换。2017年,Wang等人[8]提出了第一个端到端语音合成系统 Tacotron。该模型引入了注意力机制,输入文本或者注音字符,输出线性语谱图,再通过Griffin-Lim算法生成语音波形。Tacotron中的所有特征模型可自行学习调优,便于添加语种、音色、情感等限制条件,但是模型复杂,纠错能力和人为干预能力差,且音质不如基于WaveNet合成的语音。2018年,Tacotron的改进系统Tacotron2简化了前端模型结构[9],基于文本输入生成梅尔语谱图,通过改进的WaveNet声码器合成语音波形,构建完整的语音合成系统。该系统可生成接近人类声音的合成语音。2021年,Weiss等人[10]通过在自回归解码器中添加规范化流来扩展Tacotron系统,提出端到端语音合成系统Wave-Tacotron。该模型不生成中间特征,因此无需声码器,可以实现文本到波形的端到端语音合成。

非自回归语音合成基于全并行网络结构,通过一次前馈计算生成整句语音,极大地提升了语音合成的速度,可控性强且语音合成质量接近自回归模型的效果。2019年,Wang等人[11]提出了基于源滤波的实时参数语音合成模型。该模型基于频谱距离和相位距离的训练准则,对给定的输入声学特征,通过源模块、基音F0和谐波加噪模型生成正弦激励信号,然后通过级联扩张卷积和长短期记忆网络(Long-Short Term Memory,LSTM)将激励信号和频谱特征转换成语音波形。2019年,Ren等人[12]提出了一种基于Transformer的语音合成系统FastSpeech,从基于编码器-解码器的教师模型中提取注意力对齐来预测音素持续时间,通过长度调节扩展源音素序列以匹配目标音素序列的长度,并行生成梅尔谱图。该系统在语音质量方面与自回归模型相当,同时极大地提升了语音生成速度。2020年,Ren等人[13]提出FastSpeech2,解决了FastSpeech中师生蒸馏复杂且耗时的问题,同时引入更多语音变化信息,进一步提升了语音音质和生成速度。2021年,Elias等人[14]使用基于变分自编码器(Variational Auto-Encoder,VAE)的残差编码器扩展了Tacotron系统,提出端到端语音合成系统Parallel Tacotron。该系统使用VAE和迭代谱图损失以提高语音合成的自然度,同时采用了LCNN实现自注意机制以提高生成效率。该模型显著提高了语音生成速度,且生成的语音质量与Tacotron2相当。2021年, ańcucki[15]提出了一种基于FastSpeech的全并行语音合成系统FastPitch,通过在语音生成过程中改变基音轮廓预测以匹配话语语义,达到更自然的语音生成效果。该模型不会引入额外开销,可快速合成高保真度频谱图。2021年,Yang等人[16]改进MelGAN,提出一种可快速生成高质量语音的多频带MelGAN模型。该模型将频谱图作为生成器的输入,输出子带表示,将其合并成全波段信号表示后输入鉴别器,同时使用多分辨率STFT损失替换原始的特征匹配损失。该模型在保持生成语音质量的同时提高了生成速度,相比于原始MelGAN生成速度提升了7倍。

ańcucki[15]提出了一种基于FastSpeech的全并行语音合成系统FastPitch,通过在语音生成过程中改变基音轮廓预测以匹配话语语义,达到更自然的语音生成效果。该模型不会引入额外开销,可快速合成高保真度频谱图。2021年,Yang等人[16]改进MelGAN,提出一种可快速生成高质量语音的多频带MelGAN模型。该模型将频谱图作为生成器的输入,输出子带表示,将其合并成全波段信号表示后输入鉴别器,同时使用多分辨率STFT损失替换原始的特征匹配损失。该模型在保持生成语音质量的同时提高了生成速度,相比于原始MelGAN生成速度提升了7倍。

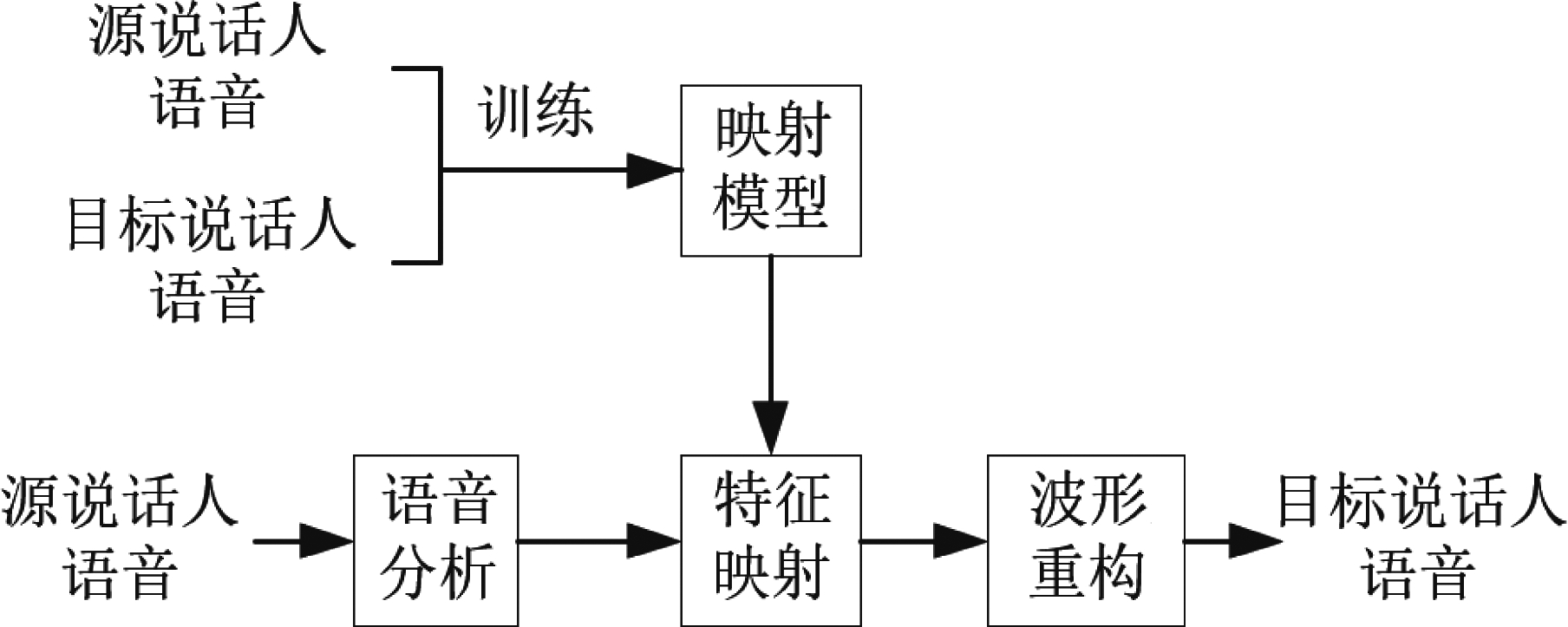

2.2 语音转换

语音转换是指将源说话人的语音转换为目标说话人语音,实现声音到声音的映射。典型的语音转换模型如图3所示,包括语音分析、映射和波形重构三个主要环节。语音分析将源说话人的语音提取出中间特征表示(超节段、分段信息),映射模块将源说话人特征转换为目标说话人特征,重建模块将目标说话人特征重构成语音波形信号。

图3 语音转换技术基础框架

Fig.3 The architecture of a generic voice conversion system

针对所需训练数据形式和数据对齐任务的不同,语音转换可分为平行语料和非平行语料的语音转换两类。平行语料即源说话人和目标说话人的训练数据成对且语音内容相同。基于平行语料的语音转换需要对源和目标说话人语音特征通过时间对齐操作后进行特征映射。帧对齐常用的方法有动态时间规整(Dynamic Time Warping,DTW)[17],音素对齐的常用方法有自动语音识别(Automatic Speech Recognition,ASR)等。基于平行数据的统计建模方法包括基于参数统计的高斯混合模型(Gaussian Mixture Model,GMM)[18]、最小二乘回归[19]、方向核偏最小二乘法(Directional Kernel Partial Least Squares,DKPLS)[19],以及基于非参数统计的非负矩阵分解(Non-negative Matrix Factorization,NMF)[20]方法等。非平行语料即源说话人和目标说话人的训练数据语言内容不相同,因此在非平行预料的语音转换中,建立源说话人和目标说话人之间的映射更为复杂。基于非平行数据的统计建模方法包括基于INCA算法[21]的对齐技术,以及基于音素后映射图(Phonetic Posterior Gram,PPG)[22]的方法等。近年来,随着深度学习的发展,借助深度神经网络的学习能力,可以从大量的语音数据集中学习映射关系,提高了语音转换的语音质量和相似度。

传统的语音转换技术通常包括特征提取,声学特征映射和波形重构三个主要环节。特征提取通过分析语音信号得到声码器参数,包括共振峰频率、共振峰带宽、频谱倾斜等声道谱参数,以及基频、时长、能量等韵律参数。其中,声道谱包含了说话人的个性化特征。经典的特征提取算法有谐波-噪声模型(Harmonic Noise Model,HNM)[23]、STRAIGHT模型[24]等。声学特征映射从源说话人声音中提取的说话人语音特征转换成逼近目标说话人的语音特征。其中,韵律参数的转换主要集中在基频包络的转换,而声道谱参数的转换建模相对复杂,目前仍是制约语音转换质量的瓶颈问题。声道谱参数转换最早由Abe 等人[25]提出使用矢量量化码本映射实现,但该方法在量化时会带来特征空间不连续的问题。Chen等人[18]提出使用GMM克服上述问题,但GMM存在非一一映射的情况,无法从根本上解决过平滑问题。随着神经网络的发展,Desai等人[26]提出使用人工神经网络(Artificial Neural Network,ANN)实现源说话人和目标说话人的特征参数映射。上述模型通常需要使用大量的训练数据,且普遍存在过平滑所引入的音质不佳问题。波形合成采用声码器,基于特征映射获得的特征参数合成出接近目标说话人风格的语音。常用的声码器包括传统的参数声码器以及基于神经网络的声码器,经典的参数声码器有STRAIGHT[24]、WORLD[27]等,基于神经网络的声码器有WaveNet[7]、WaveRNN[28]、WaveGlow[29]、Parallel WaveGAN[30]等。传统的语音转换方法只能实现一对一的转换,也没有摆脱对训练数据的强依赖。

近年随着深度学习技术的快速发展,自动编码器(AutoEncoder)、生成对抗网络(Generative Adversarial Network,GAN)等可实现序列到序列高精度转换的神经网络技术在语音转换领域取得了良好的应用效果。目前主流的语音转换技术都基于深度学习方法,根据转换任务的不同,可分为一对一转换、多对多转换和少样本转换。一对一语音转换实现从单个固定源说话人语音到单个固定目标说话人语音的转换。2018年,Donahue等人[31]提出使用WaveGAN 来实现语音转换。2018年,Kaneko等人[32]提出一对一转换方法CycleGAN-VC,使用周期一致的对抗网络CycleGAN进行平行数据的语音转换。与逐帧对齐方法相比,CycleGAN-VC使用具有门控卷积神经网络(Convolutional Neural Networks,CNN)和身份映射损失的CycleGAN映射函数,允许在保留语言信息的同时捕获语音顺序和分层结构,该方法打破了需要平行训练数据的限制。多对多语音转换实现从任意源说话人到任意目标说话人的语音转换,主要实现思路基于语音内容与说话人风格信息的分离。文献[33-35]均采用AutoEncoder,通过编码器将数据的表层特征转换为隐表示,通过解码器从隐层表示中恢复出表层特征,采用解纠缠机制将语音中的内容和身份信息分开,以实现任意人之间的语音转换。2018年,Kameoka等人[36]提出的StarGAN-VC采用星形生成对抗网络实现非平行多对多语音转换。StarGAN-VC使用对抗性损失训练生成器,确保每对属性域之间的映射保留语言内容信息,在预测时无需任何关于输入语音属性的信息。2019年,SERR 等人[37]提出基于流模型(flow)的语音转换技术Blow,采用超网络限制的单尺度归一化流程实现多对多的语音转换。2021年,Zhang等人[38]提出了一种可实现多对多非平行语音转换的TTS-VC迁移学习框架,该方案利用TTS系统将输入文本映射到说话人无关的上下文向量,从而监督基于AutoEncoder的语音转换系统潜在表示的训练。2021年,Lin等人[39]提出了一种可实现非平行多对多语音转换的端到端系统FragmentVC。该系统从对数梅尔谱图中提取目标说话人频谱特征表示,使用wav2vec2.0提取源说话人风格的潜在特征表示,通过对两个不同特征空间的隐表示进行训练提取目标说话人的细粒度语音,进而融合到转换语音中。该方法无需考虑语音内容和说话人身份特征之间的解纠缠。由于大量可用的说话人语料难以获取,因此少样本语音转换成为目前的研究趋势。2019年Chou等人[40]通过实例归一化技术进行音色和内容分离,然后再重组音色和内容,可实现仅一句原始语音和一句目标音色语音就能进行语音转换。2019年,Qian等人[35]基于StyleGAN的思路,提出零样本(Zero-Shot)语音转换方案AutoVC,使用一个具有瓶颈(bottleneck)的AutoEncoder,在语音自重构质量与说话人身份解纠缠之间进行瓶颈调谐,以实现非平行数据中的多对多少样本语音转换。2021年,Zhang等人[41]提出基于GAN的零样本非平行语音转换方法GAZEV,在GAN框架中采用说话人嵌入损失,同时引入自适应实例规范化策略,解决现有方案中说话人身份转换的局限性。该方法生成的转换语音在质量和相似度上明显优于AutoVC方法。

等人[37]提出基于流模型(flow)的语音转换技术Blow,采用超网络限制的单尺度归一化流程实现多对多的语音转换。2021年,Zhang等人[38]提出了一种可实现多对多非平行语音转换的TTS-VC迁移学习框架,该方案利用TTS系统将输入文本映射到说话人无关的上下文向量,从而监督基于AutoEncoder的语音转换系统潜在表示的训练。2021年,Lin等人[39]提出了一种可实现非平行多对多语音转换的端到端系统FragmentVC。该系统从对数梅尔谱图中提取目标说话人频谱特征表示,使用wav2vec2.0提取源说话人风格的潜在特征表示,通过对两个不同特征空间的隐表示进行训练提取目标说话人的细粒度语音,进而融合到转换语音中。该方法无需考虑语音内容和说话人身份特征之间的解纠缠。由于大量可用的说话人语料难以获取,因此少样本语音转换成为目前的研究趋势。2019年Chou等人[40]通过实例归一化技术进行音色和内容分离,然后再重组音色和内容,可实现仅一句原始语音和一句目标音色语音就能进行语音转换。2019年,Qian等人[35]基于StyleGAN的思路,提出零样本(Zero-Shot)语音转换方案AutoVC,使用一个具有瓶颈(bottleneck)的AutoEncoder,在语音自重构质量与说话人身份解纠缠之间进行瓶颈调谐,以实现非平行数据中的多对多少样本语音转换。2021年,Zhang等人[41]提出基于GAN的零样本非平行语音转换方法GAZEV,在GAN框架中采用说话人嵌入损失,同时引入自适应实例规范化策略,解决现有方案中说话人身份转换的局限性。该方法生成的转换语音在质量和相似度上明显优于AutoVC方法。

2.3 对抗攻击

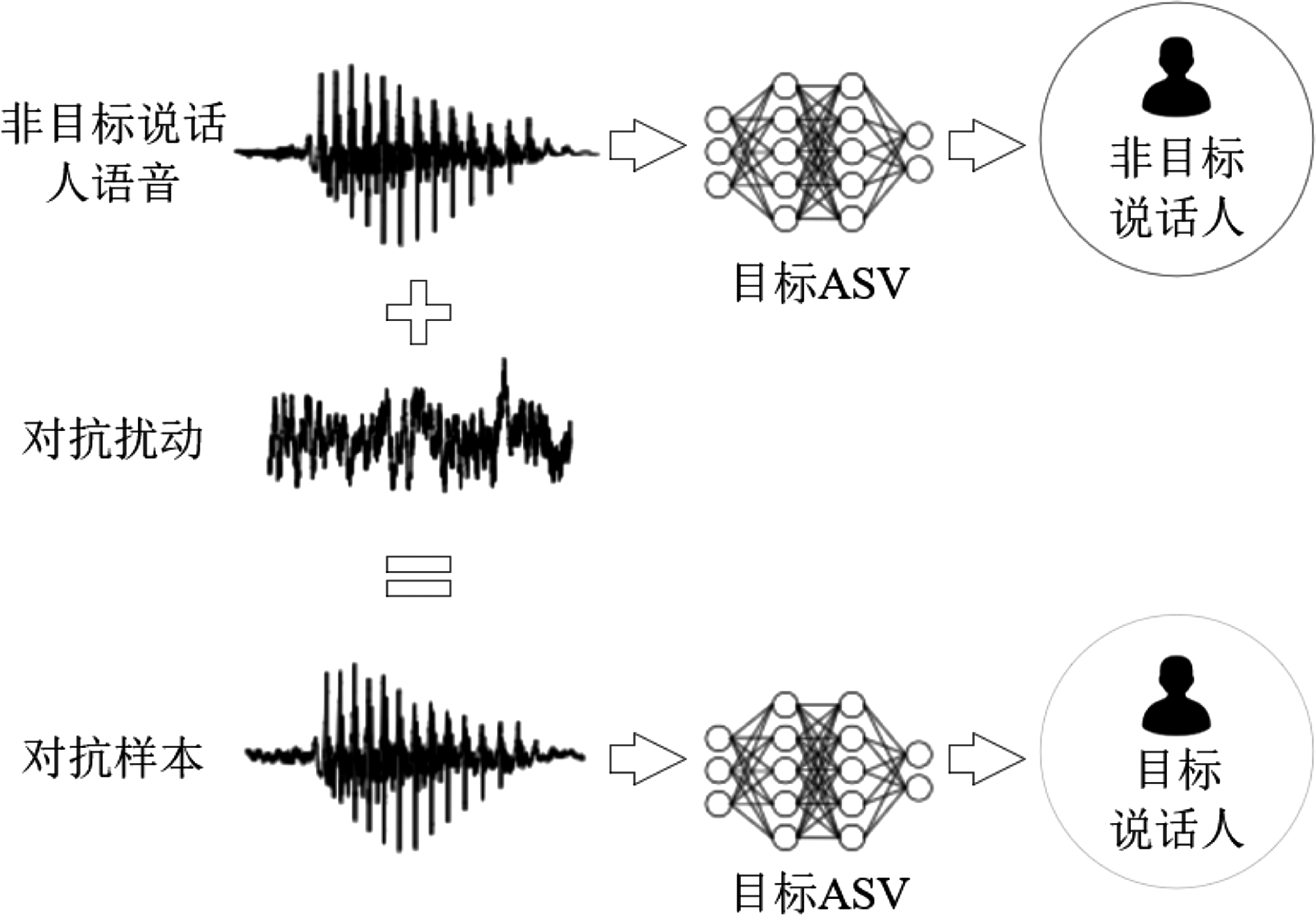

对抗样本是针对深度神经网络所存在的缺陷而产生的一类新型攻击手段,在计算机视觉领域被广泛研究。在语音领域,目前针对ASR的对抗攻击的研究较为广泛,代表性工作包括2018年Yuan等人[42]提出的在音乐中植入命令的Commandersong系统,2019年Qin等人[43]提出的不易感知且鲁棒的对抗样本生成算法,以及2020年Chen等人[44]提出的可攻击黑盒商业设备的Devil's whisper系统等。近两年,针对ASV系统的对抗攻击手段也在逐渐发展,并揭露了该类攻击对ASV系统存在威胁。ASV对抗攻击方法的基本原理如图4所示,即利用ASV深度神经网络的特点,在原始语音信号中添加微小扰动,使得人耳无法察觉的情况下欺骗目标ASV系统产生错误的判决。对抗攻击作为伪造语音攻击中的主动式攻击,对其进行研究有助于发现ASV系统的缺陷,提高ASV系统鲁棒性。目前针对ASV系统对抗攻击的工作可分为白盒攻击和黑盒攻击两类。

图4 ASV对抗攻击示意图

Fig.4 A diagram of ASV adversarial attack

白盒攻击假定攻击者完全掌握目标ASV系统的模型结构和参数设置。2020年,Wang等人[45]参考ASR对抗样本领域工作,将对抗扰动限制在原始音频的全局掩蔽阈值以下来构建不可感知的ASV对抗样本。2020年,Xie等人[46]提出了一种快速且通用的对抗样本生成技术,在任意说话人语音中加入音频无关的通用对抗扰动,可欺骗基于x-vector的目标ASV系统。该方法同时具有良好的鲁棒性,生成的对抗音频在重放场景下成功率约为80%。2021年,Zhang等人[47]提出了一种使用两阶段迭代优化的文本无关的通用对抗扰动生成方法。该方法在重放场景下对目标系统的攻击成功率为100%,且语音识别的词错误率(Words Error Rate,WER)仅增加3.55%。虽然白盒攻击可以取得良好的攻击效果,但在实际应用场景中,攻击者很难完全掌握商业ASV系统的详细信息,因此相关研究离实际应用还有一定的距离。

黑盒攻击假定攻击者无法获得目标ASV系统的具体模型信息,仅可获取特定输入所产生的输出结果,更接近实际中的攻击场景。2019年,Liu等人[48]使用快速梯度符号法(Fast Gradient Sign Method,FGSM)和投影梯度下降法(Projected Gradient Descent,PGD)生成对抗样本,在白盒和黑盒条件下均可攻击基于轻量卷积神经网络(Light CNN,LCNN)的抗欺骗ASV系统(即集成了伪造语音检测系统的ASV系统)。2020年,Li等人[49]研究了GMM i-vector系统和x-vector系统面对对抗攻击的脆弱性,使用针对GMM i-vector系统生成的对抗样本在黑盒条件下成功攻击了目标x-vector系统。2020年,Villalba等人[50]使用FGSM和Carlini-Wagner算法构造对抗样本,攻击三种基于x-vector的ASV系统。实验证明,即使是使用FGSM等简单方法生成的对抗样本,也可成功利用其传递性,使小型白盒网络生成的对抗样本攻击大型黑盒ASV系统。2020年,Zhang等人[51]基于MI-FGSM算法提出一种针对黑盒ASV的攻击策略,采用迭代集成方法(Iterative Ensemble Method,IEM)提升对抗样本的可传递性。2020年,Chen等人[52]提出了一种对抗攻击方法FAKEBOB,结合对抗样本的置信度和最大失真,在对抗扰动强度和不可感知性之间取得平衡。实验证明,FAKEBOB在开源和商业系统上都能达到99%的目标攻击成功率。2020年,Das等人[53]总结了现有工作的攻击手段、目标系统、数据集和评价指标。2021年,Gomez-Alanis 等人[54]提出了一种针对伪造语音检测系统的对抗攻击方法,提出对抗生物特征识别转换网络(Adversarial Biometrics Transformation Network,ABTN)联合处理ASV系统和伪造语音检测系统的损失,该方案可在不被ASV检测到的情况下对伪造语音检测系统进行白盒或黑盒攻击。研究表明,该领域现有工作分散在不同数据集、不同攻击和防御手段上,难以进行直接对比,且较多工作集中于不具有实际意义的白盒攻击上,但以上工作的实验均证明,即使是集成了伪造语音检测系统进行辅助判决的ASV系统也容易受到黑盒对抗攻击的影响。

3 伪造语音检测技术

早期的伪造语音检测技术主要侧重于防止ASV系统遭受欺骗。目前,随着Deepfake技术的发展,伪造语音技术用于构造虚假信息的问题引起普遍关注,更多工作关注虚假语音的检测。从图1可以看出,用于防御ASV系统安全性的伪造语音检测技术可涵盖用于虚假语音中的伪造语音检测技术。本节主要介绍用于检测语音合成、语音转换、重放攻击和对抗攻击的伪造语音检测技术。随着伪造语音检测技术的发展,伪造检测应具备同时检测不同类型伪造语音的能力。

3.1 伪造语音检测系统通用结构

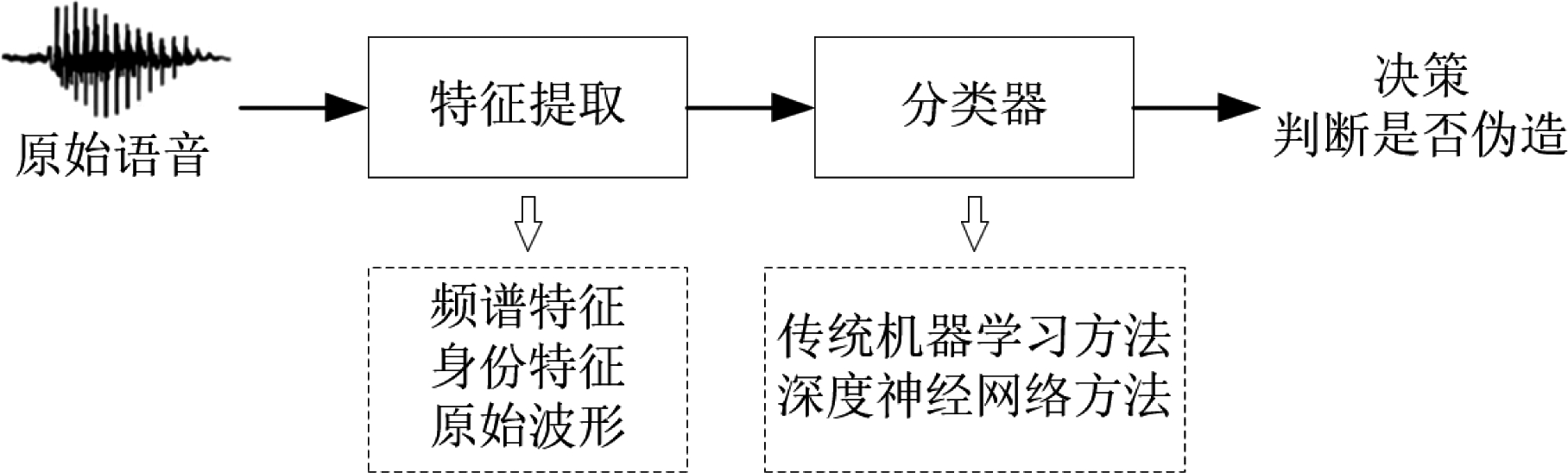

语音伪造检测技术的基本思路是寻找伪造语音与真实语音之间的特征差异。典型的伪造语音检测系统一般由前端和后端两部分组成,前端通过分析语音信号提取具有区分性的特征,后端通过分类判断语音是真实语音还是伪造语音。传统的检测系统前端的区分性特征采用专家设计的手工特征,后端直接使用GMM或支持向量机(Support Vector Machine,SVM)进行分类判决。近年来基于深度学习的系统逐渐成为主流,系统前端提取输入神经网络的语音特征,后端则通过神经网络学习特征的高级表示,然后进行分类判决。目前已经有部分端到端系统出现,可以直接将原始音频波形作为网络输入,学习高级特征表示后判决。

3.2 攻击场景和评价指标

为了对不同检测算法的性能进行有效地比较,需要使用标准数据集和通用评价指标。2013年,INTERSPEECH会议举办了第一届关于ASV伪造和防御的特别会议(special session),诞生了两年一届的ASVspoof系列挑战赛,极大地推动了伪造语音检测技术的发展。目前伪造语音检测研究常用的数据集可根据不同攻击场景分为两类。本小节将分别介绍伪造语音的两类攻击场景和常用评价指标。

3.2.1 攻击场景

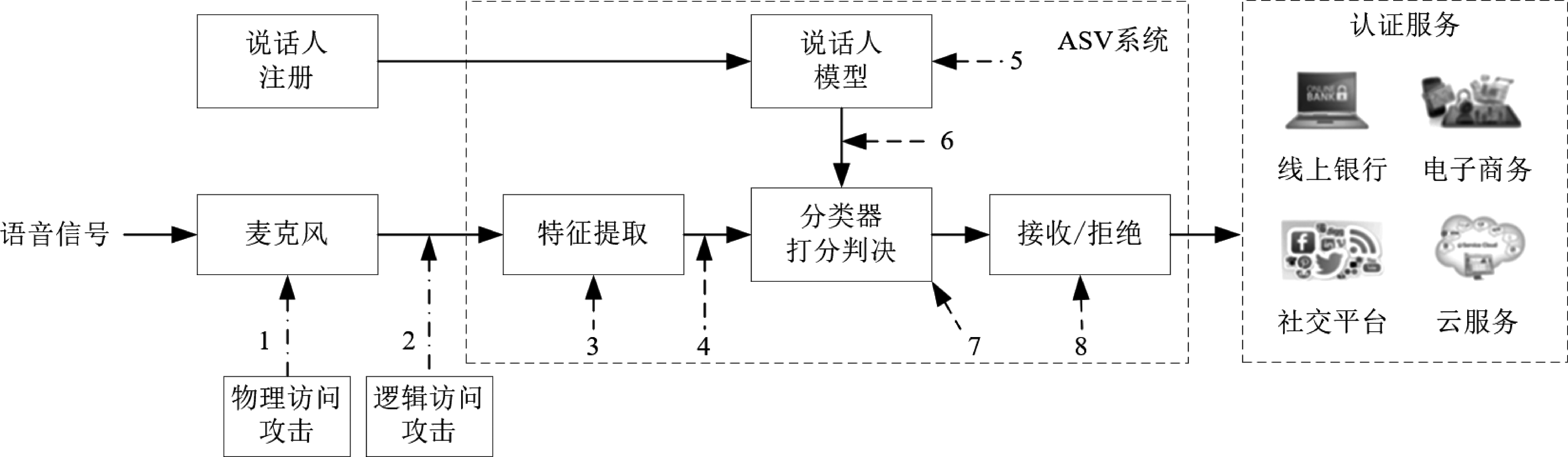

身份认证应用中常用的ASV系统结构及其主要可能存在的攻击节点如图6所示。其中,节点1和2为直接攻击节点,该类攻击发生在语音声纹特征提取之前;节点3到8为间接攻击节点,此时攻击者可以介入ASV内部处理流程中的各个操作环节。在间接攻击情形中,目标ASV系统对于攻击者而言为白盒系统,攻击者可通过技术手段完全掌握包括特征提取、分类、判决等模型节点和注册的说话人模型在内的信息,并可以通过干扰任意节点来达成欺骗攻击。例如对于节点5,攻击者可修改或增添未授权用户的声纹信息;对于其他节点,攻击者均可根据目标ASV系统中深度模型具体的输入和输出生成特定的语音对抗样本。目前针对伪造语音攻击的研究大多属于直接攻击(节点1和2)。在ASVspoof 2019中,根据伪造语音输入目标ASV系统的途径,可将伪造语音攻击分为两类,即物理访问(Physical Access,PA)攻击和逻辑访问(Logical Access,LA)攻击。在物理访问攻击中,语音样本以空气传播的方式通过麦克风捕获后输入目标ASV 系统(节点1);在逻辑访问攻击中,语音样本直接输入目标ASV系统(节点2)。据此,目前伪造语音检测常用数据集可分为LA和PA两类,其中LA场景的伪造语音类型包括转换语音、合成语音等,PA场景的伪造语音包括重放语音。

图6 身份认证应用中ASV系统基本结构及主要攻击节点

Fig.6 A Brief illustration and main attack points of ASV system in authentication services

3.2.2 评价指标

伪造语音检测算法的常用性能指标包括等错误率(Equal Error Rate,EER)和串联检测代价函数t-DCF。

1)等错误率(EER)

等错误率(EER)是错误接受率(False Accept Rate,FAR)和错误拒绝率(False Rejection Rate,FRR)相等时的错误率。伪造语音检测作为二分类任务,当检测系统将伪造语音错误分类成真实语音时,即为错误接受,当检测系统将真实语音错误分类成伪造语音时,即为错误拒绝。给定检测系统的检测分数和阈值θ,错误接受率和错误拒绝率可分别按式(1)和式(2)计算:

(1)

(2)

由式(1)和式(2)可知,Pfa(θ)和Pmiss(θ)分别是θ的单调递减函数和单调递增函数。阈值为θ时的等错误率EER对应于Pfa(θ)和Pmiss(θ)相等时的值,即EER=Pfa(θ)=Pmiss(θ)。等错误率越小代表伪造语音检测系统的效果越好,但该指标并未考虑伪造语音检测系统对ASV系统可靠性的影响。

2)串联检测代价函数(t-DCF)

串联检测代价函数(tandem Detection Cost Function,t-DCF)是在ASVspoof 2019挑战赛中新引入的评价指标。实际场景中,伪造语音检测系统对ASV系统起到辅助判决作用,因此仅考虑伪造语音检测系统性能的EER指标不一定可靠。此外,EER也不适用于电话银行业务等目标用户优先级高于伪造攻击的用户身份验证应用。因此,ASVspoof 挑战赛官方提出t-DCF指标,该指标并非用来独立评估伪造语音检测系统,而是反映了实际情况下伪造语音和伪造语音检测系统对ASV系统性能共同产生的影响。t-DCF借鉴了最小风险贝叶斯决策进行系统可靠性评估。实际中,ASV系统可能遇到合法用户、临时冒充的非法用户以及试图恶意操纵ASV决策的攻击者,该指标综合考虑了不同情况下的误判代价。其简要计算过程如式(3)所示:

(3)

其中,Pfa(θ)和Pmiss(θ)分别是阈值为θ时伪造语音检测系统的错误接受率和错误拒绝率;系数β取决于实际中的伪造攻击优先级、误判成本以及ASV系统的检测性能(FA和FR等)。t-DCF越小说明检测系统的泛化性能越好。由于t-DCF指标计算较复杂,详细计算方法可参考文献[55]。

3.3 针对语音合成/转换的伪造语音检测技术

由于语音合成和语音转换都需要使用声码器进行语音波形的合成,因此其检测方法类似。早期的语音合成检测方案主要考虑语音信号、声纹特征和频谱分布等生物信息的差异特征,如针对语音篡改,传统的方法大多研究音频噪声特性或语音编码特性实现篡改定位。部分研究集中于声码器和自然语音之间的声学差异。由于人类听觉系统对相位相对不敏感,传统的声码器通常不会重建语音的相位信息,因此导致真实语音和合成语音之间相位谱的差异,可用于检测伪造语音。此外,研究表明传统语音合成方法难以建立可靠的韵律模型,统计参数合成方法生成语音的基频F0通常过度平滑,波形拼接方法生成语音的单元连接点处F0跳跃,因此部分工作使用基频信息进行伪造语音检测[56]。随着深度学习技术的发展,目前基于DNN的伪造语音检测已成为主流方法,合成语音检测系统的研究主要集中在特征提取方法,特征表示学习网络结构设计和损失函数设计三个方面。本小节将根据检测系统前端与后端的通用结构(如图5),分别从特征提取前端和分类后端两个角度介绍现有工作的研究进展。

图5 伪造语音检测系统通用结构

Fig.5 The architecture of a generic speech spoofing detection system

3.3.1 前端特征提取

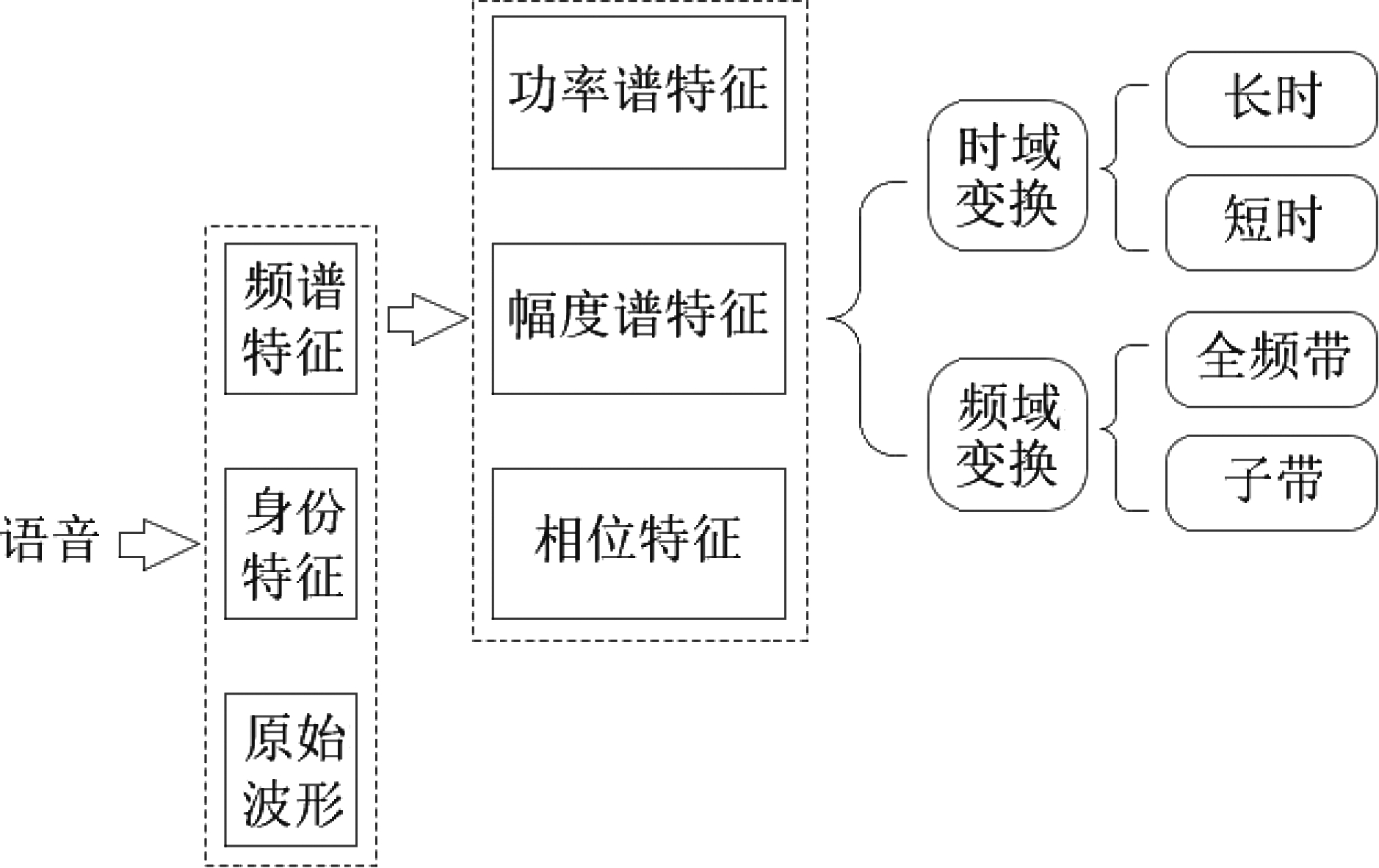

伪造语音检测系统前端的工作主要研究如何提取伪造语音中可区分于真实语音的特征以输入后端进行判决,如利用伪造语音通常缺少频谱和时间细节信息的特点构造特征。传统的检测方法大多使用精心设计的手工特征,随着基于数据驱动的深度学习方法的普及,前端特征逐渐向频谱等相对低层次的特征发展。图7总结了目前伪造语音检测的常用特征,主要可分为三大类:频谱特征,身份特征和原始波形,其中使用最广泛的是频谱特征。部分端到端系统直接从原始语音数据(如文献[57-58])或i-vector、x-vector等身份特征(如文献[58-59])中学习帧级或序列级特征。频谱特征可进一步细分为功率谱特征、幅度谱特征和相位特征。根据时频变换的不同又可以对以上三类特征分别从时域(长时/短时变换)和频域(全频带/子带变换)角度分别进行特征提取。本小节将重点介绍伪造语音检测系统前端最常用的频谱特征。请注意,本小节中同一表格内的实验结果来自同一工作,不同表格内的实验结果来自不同工作,由于不同工作采取的后端分类模型和数据集不尽相同,因此结果数据不可跨表比较。

图7 伪造语音检测系统常用特征分类

Fig.7 A classification of commonly used features for spoofing detection system

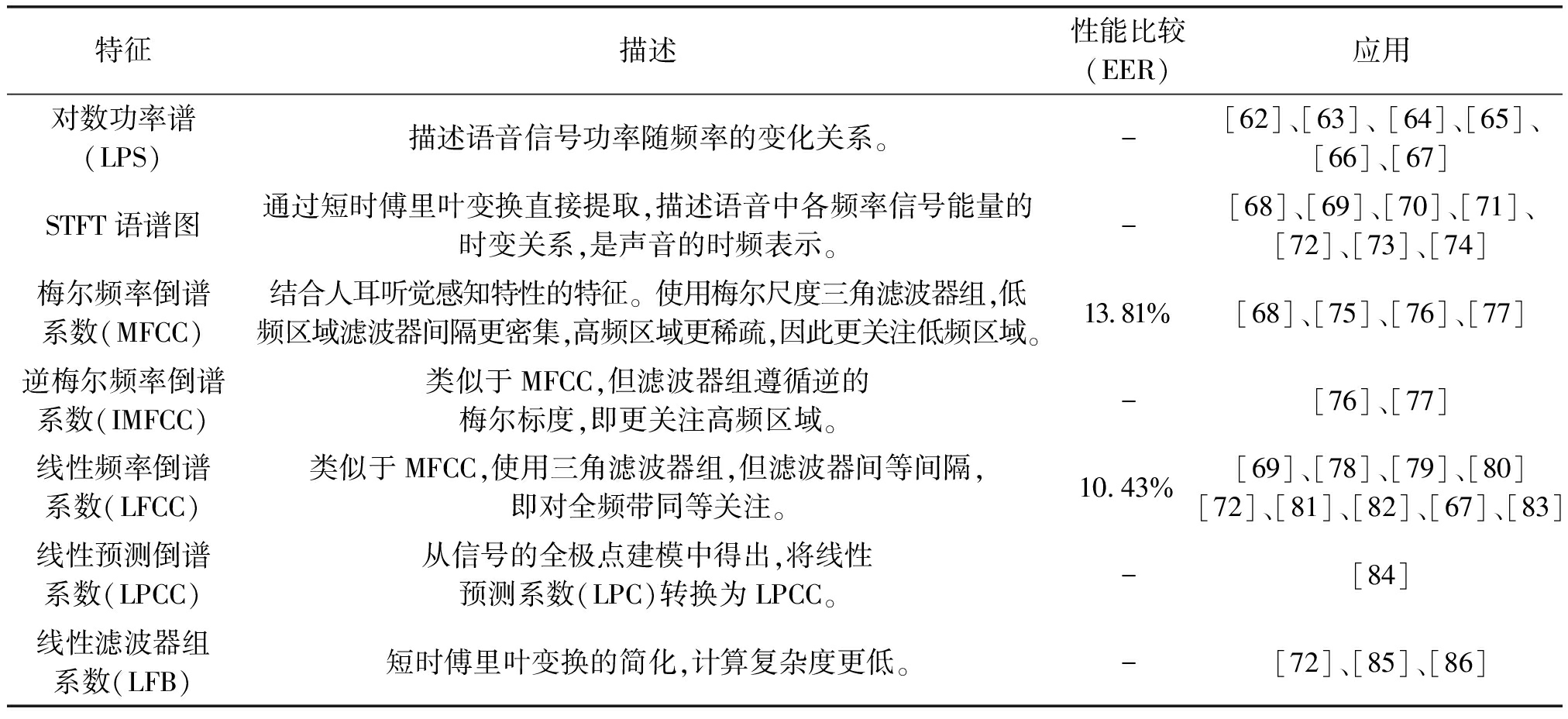

1)短时功率谱特征

短时功率谱特征描述了信号功率随频率的变化情况。常用的短时功率谱特征包括对数功率谱,基于滤波器的倒谱系数(Filter-Based Cepstral Coefficient,FBCC)和基于全极点语音建模参数的倒谱系数等。基于滤波器的倒谱系数包括梅尔频率倒谱系数(Mel-Frequency Cepstral Coefficients,MFCC)、矩形滤波倒谱系数(Rectangular Filter Cepstral Coefficients,RFCC)、线性频率倒谱系数(Linear Frequency Cepstral Coefficients,LFCC)和逆梅尔频率倒谱系数(Inverted Mel-Frequency Cepstral Coefficients,IMFCC)等。基于全极点语音建模参数的倒谱系数包括线性预测倒谱系数(Linear Prediction Cepstral Coefficients,LPCC)等。由于伪造语音无法很好地模拟语音的时间特征,因此倒谱的高阶系数和一阶、二阶动态差分系数都有利于进行伪造语音检测。

2018年,TODISCO等人[60]在ASVspoof 2017 v2数据集上比较了使用GMM后端时,MFCC特征和LFCC特征的性能,结果如表1所示。实验表明, LFCC特征的效果普遍好于MFCC特征。

表1 常用短时功率谱特征(“-”表示论文中未提及)

Tab.1 Commonly used short-term power spectrum features (“-” indicates that it was not mentioned in the article)

特征描述性能比较(EER)应用对数功率谱(LPS)描述语音信号功率随频率的变化关系。-[62]、[63]、 [64]、[65]、 [66]、[67] STFT语谱图通过短时傅里叶变换直接提取,描述语音中各频率信号能量的时变关系,是声音的时频表示。-[68]、[69]、[70]、[71]、 [72]、[73]、[74] 梅尔频率倒谱系数(MFCC)结合人耳听觉感知特性的特征。使用梅尔尺度三角滤波器组,低频区域滤波器间隔更密集,高频区域更稀疏,因此更关注低频区域。13.81%[68]、[75]、[76]、[77] 逆梅尔频率倒谱系数(IMFCC)类似于MFCC,但滤波器组遵循逆的梅尔标度,即更关注高频区域。-[76]、[77] 线性频率倒谱系数(LFCC)类似于MFCC,使用三角滤波器组,但滤波器间等间隔,即对全频带同等关注。10.43%[69]、[78]、[79]、[80] [72]、[81]、[82]、[67]、[83] 线性预测倒谱系数(LPCC)从信号的全极点建模中得出,将线性预测系数(LPC)转换为LPCC。-[84]线性滤波器组系数(LFB)短时傅里叶变换的简化,计算复杂度更低。-[72]、[85]、[86]

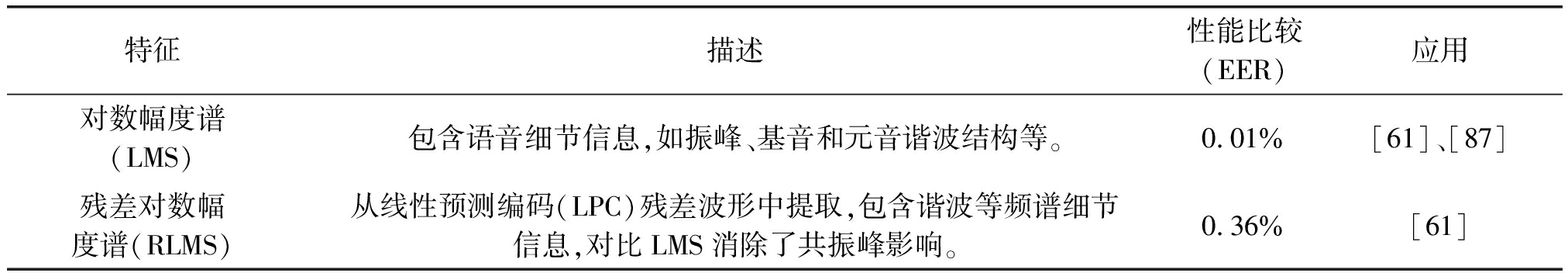

2)短时幅度谱特征

目前用于伪造语音检测的幅度谱特征包括:对数幅度谱(Log Magnitude Spectrum,LMS)和残差对数幅度谱(Residual Log Magnitude Spectrum,RLMS)特征。对数幅度谱包含了语音信号的细节信息,如共振峰、基音和元音的谐波结。残差对数幅度谱是从线性预测编码(LPC)残差波形中提取,包含谐波等频谱细节信息。与LMS相比,RLMS消除了共振峰影响。

2016年,Tian等人[61]在ASVspoof 2015数据集上比较了两种短时幅度谱特征对于未知类型攻击的检测性能,结果如表2所示。实验表明,一般情况下,高维特征的动态系数(差分和加速度系数)获得最佳的检测性能,再次印证了利用合成语音中时间细节信息缺失的特点有助于进行伪造检测。

表2 常用短时幅度谱特征(“-”表示论文中未提及)

Tab.2 Commonly used short-term magnitude spectrum features (“-” indicates that it was not mentioned in the article)

特征描述性能比较(EER)应用对数幅度谱(LMS)包含语音细节信息,如振峰、基音和元音谐波结构等。0.01%[61]、[87]残差对数幅度谱(RLMS)从线性预测编码(LPC)残差波形中提取,包含谐波等频谱细节信息,对比LMS消除了共振峰影响。0.36%[61]

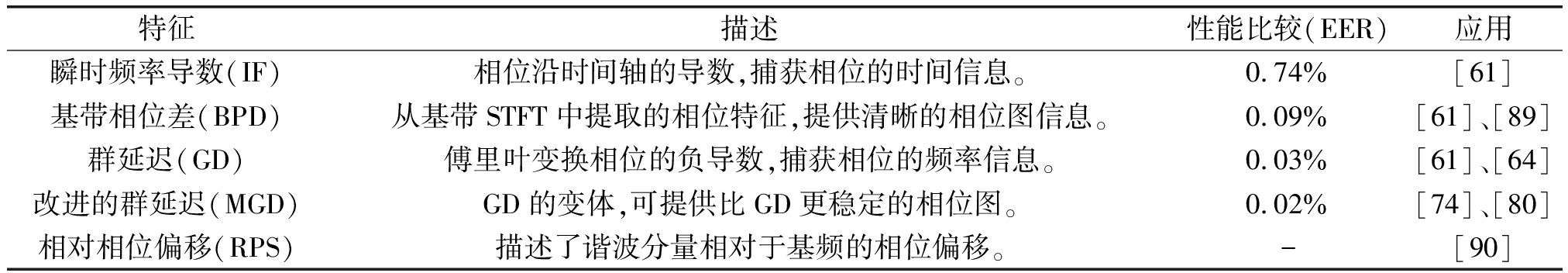

3)短时相位特征

由于声码器重建波形时忽略了相位信息,因此短时相位特征是检测伪造语音的有效特征之一。由傅里叶变换得到的相位谱存在相位扭曲,因此需对其进行处理以得到稳定有效的相位特征。常用的相位特征包括群延迟(Group Delay,GD),改进的群延迟(Modified Group Delay,MGD)[88]、基带相位差(Baseband Phase Difference,BPD)[89]、瞬时频率导数(Instantaneous Frequency Derivative,IF)[61]、以及相对相位偏移(Relative Phase Shift,RPS)[90]等。

2016年,Tian等人[61]在ASVspoof 2015数据集上比较了多种短时相位特征对于未知类型攻击的检测性能,结果如表3所示。

表3 常用短时相位特征(“-”表示论文中未提及)

Tab.3 Commonly used short-term phase features (“-” indicates that it was not mentioned in the article)

特征描述性能比较(EER)应用瞬时频率导数(IF)相位沿时间轴的导数,捕获相位的时间信息。0.74%[61]基带相位差(BPD)从基带STFT中提取的相位特征,提供清晰的相位图信息。0.09%[61]、[89]群延迟(GD)傅里叶变换相位的负导数,捕获相位的频率信息。0.03%[61]、[64]改进的群延迟(MGD)GD的变体,可提供比GD更稳定的相位图。0.02%[74]、[80] 相对相位偏移(RPS)描述了谐波分量相对于基频的相位偏移。-[90]

4)基于长时变换的特征

研究表明,从语音信号中提取的长时变换特征对伪造检测有效。例如在ASVspoof 2015挑战赛中表现最佳的耳蜗滤波器瞬时频率倒谱系数(Cochlear Filter Cepstral Coefficients with Instantaneous Frequency,CFCCIF)[91],和基于长时常数Q变换的倒谱系数(Constant-Q Cepstral Coefficients,CQCC)[92],均基于长时变换得到。CQCC特征是一种专门为伪造语音检测工作设计的特征,基于长时窗口恒定Q变换(CQT),对LA和PA场景下不同类别的攻击均可有效检测。2021年,Gao等人[93]利用二维DCT变换提取对数梅尔谱图上的捕捉伪造音频的伪影,得到长时频谱-时间调制特征Global M,该特征迫使后端分类网络从输入音频的长时调制模式中学习高级表示。

近两年提出的基于CQT的一系列特征均在伪造语音检测任务上表现良好[94-95],该领域的研究极大地提升了伪造语音检测的效果。对比CQT变换和短时快速傅里叶变换(Short-Time Fourier Transform,STFT),CQT 的滤波器组中心频率按指数规律分布,滤波带宽不同、但中心频率与带宽比为常量 Q。STFT中每个滤波器的带宽恒定且与窗口函数相关,故频率越高Q因子越大。由于人耳的感知系统在听觉范围内的Q因子是近似恒定的,且短时窗口无法很好地描述长时间跨度内的区分性信息,因此基于CQT的特征在伪造语音检测中性能更优。

2020年,Das等人[96]比较了CQCC、eCQCC、COSPIC特征的性能,结果如表4所示。实验表明,eCQCC、COSPIC特征普遍优于CQCC特征,说明了原始的CQCC特征存在优化空间。

表4 常用长时变换特征(“-”表示论文中未提及)

Tab.4 Commonly used long-term features (“-” indicates that it was not mentioned in the article)

特征描述性能比较EERt-DCF应用CQT谱图通过CQT变换直接提取,类似STFT语谱图的提取。--[69]、[73]、[74]、[97]耳蜗滤波器瞬时频率倒谱系数(CFCCIF)将耳蜗滤波系数(CFCC)与瞬时频率相结合。使用类似小波变换的听觉变换和基于人耳耳蜗的毛细胞和神经脉冲密度等机制计算。--[91]基于常数Q变换的倒谱系数(CQCC)通过时频分析常数Q转换(CQT)提取。根据人类感知系统特点,在全频带保持恒定的Q因子。在低频提供更高的频率分辨率,在高频提供更高的时间分辨率。LA 13.746%PA 11.799%LA 0.327PA 0.277[62]、[68]、[75]、[67]、[77]、[81]、[96]扩展CQCC(eCQCC)CQCC特征的扩展,是一种全频带特征,将倍频程功率谱的系数与线性功率谱的系数相结合。LA 7.329%PA 8.147%LA 0.168PA 0.184[96]常数Q统计量加主信息系数(CQSPIC)一种混合特征,综合考虑子频带以及全频带的信息。LA 7.709%PA 7.998%LA 0.184PA 0.192[96]

5)基于子带变换的特征

传统的特征提取技术大多使用离散余弦变换捕获来自全频带的信息(如短时功率谱特征中的倒谱系数)。近年来的研究成果表明伪造语音的干扰存在于语音的子带级别,而且只有在同频带中提取高分辨率特征才能可靠地提取这些干扰信息,因此子带变换相比于全频带变换可以更可靠地捕捉伪造语音中特定频段内的精细特征,最新的工作大都采用基于子带变换的前端特征。

传统的子带特征包括子带频谱质心幅度系数(Spectral Centroid Magnitude Coefficient,SCMC)、子带质心频率系数(Subband Centroid Frequency Coefficient,SCFC)等,多用于重放语音检测。近期工作提出了一些基于子带变换的新特征。2020年,Yang等人[98]发现传统的子带特征没有考虑每个子带内的细节信息,提出三种基于子带变换的特征:恒Q等子带变换(CQ-EST)、恒Q倍频程子带变换(CQ-OST)和离散傅里叶梅尔子带变换(DF-MST),通过静态系数、动态差分系数和加速度系数的特征组合可达到远超CQCC、MFCC特征的效果。三种特征在ASVspoof 2019 LA数据集上的检测结果如表5所示。

表5 常用子带特征(“-”表示论文中未提及)

Tab.5 Commonly used subband features (“-” indicates that it was not mentioned in the article)

特征描述性能比较EERt-DCF应用频谱质心幅值倒谱系数(SCMC)傅里叶变换后,采用梅尔尺度Gabor滤波器组计算频谱质心幅值(SCM),最后计算倒谱系数。--[99]、[100] 子带质心频率系数(SCFC)傅里叶变换后,采用梅尔尺度Gabor滤波器组估算子带质心频率系数。--[100]恒Q等子带变换(CQ-EST)CQT变换后(代替STFT变换)计算对数功率谱,经过均匀重采样后计算等子带,最后计算DCT得到CQ-EST系数。11.791%0.238[98]恒Q倍频程子带变换(CQ-OST)类似于CQ-EST,但计算倍频程子带。8.036%0.188[98]离散傅里叶梅尔子带变换(DF-MST)DFT变换后计算对数功率谱,然后估算梅尔尺度子带,最后计算DCT得到DF-MST系数。10.907%0.279[98]

综上,目前伪造语音检测的前端提取的常见特征包括功率谱、幅度谱、相位谱等频谱特征。且最近的研究表明,高分辨率频谱特征、基于长时变换的特征和子带特征有利于进行伪造语音检测,因此新的工作更多地关注于构造基于长时变换(如CQT变换)的子带特征。由于不同的特征关注于语音信号的不同信息,且研究表明单一特征通常只对检测特定类型的伪造干扰有效,因此目前工作基本采用融合多个不同前端的子系统的方法,综合不同特征的优势以达到更好的检测效果。

3.3.2 后端分类模型

伪造语音检测系统的后端对前端提取的特征进行处理和分类,以辨别语音真伪。传统方法大多是基于特征的机器学习方法,直接对输入的手工特征进行分类甄别。常用后端分类器包括基于高斯混合模型(GMM)的分类器和基于支持向量机(SVM)的分类器等。其中,GMM使用多个高斯分布函数的线性组合拟合任意分布。在伪造语音检测中,使用适当的训练数据分别为真实类和伪造类学习GMM,在分类阶段,通过计算两种假设间的对数似然比,根据阈值判断目标语音所属类别。GMM作为早期最常用的后端分类器,目前仍有一些工作在使用。传统的GMM分类器独立地累积所有语音帧的分数,并且未考虑帧间关系。2020年,Lei等人[81]提出一种孪生(Siamese)卷积网络,将GMM分量上语音帧的对数概率作为输入,综合考虑GMM得分和帧间的局部关系提升了分类效果。2021年,Kumar等人[101]基于传统GMM分类器提出选择特定帧计算对数似然比的决策方法,减少语音转换中未经修改的清音帧对决策得分的影响。

随着深度学习的发展,最新的伪造语音检测系统的后端大多基于DNN构成特征表示和分类网络,借助神经网络的特征学习能力,对前端输入特征学习其高级特征表示后再进行分类。目前大多数工作针对特定攻击或基于固定数据集,因此单个系统无法高效地检测多种不同的伪造攻击(TTS、VS和TTS-VC混合等)和训练集中不存在的未知攻击。由于实际中难以提前获知攻击的具体类型,因此最新的研究重点普遍集中于提高检测的泛化性,即设计能跨越不同伪造攻击类型并可抵抗不同通道环境噪声干扰的通用检测系统。目前,基于DNN的研究工作主要包括深度神经网络结构、损失函数和深度网络训练方法三方面。

1)深度神经网络结构

伪造语音检测系统的后端网络一般采用基于卷积神经网络(CNN)的架构,如轻量卷积神经网络(Light Convolutional Neural Network,LCNN)(文献[51,65,71,74,78,83,97,102-103])、残差网络(Deep residual network,ResNet)(文献[62,68-70,104])、挤压-激励网络(Squeeze-and-Excitation Networks,SENet)(文献[62,69,84,102,105])等,部分工作还引入了门控递归单元(Gated Recurrent Unit,GRU)等循环神经网络(Recurrent Neural Network,RNN)架构用以捕获序列上下文信息。为了提高分类器的判别效果,特征表示学习的基本思路通常是学习更高级且鲁棒的表示,同时使同类样本间特征距离尽量接近且异类样本间的特征距离尽量远。本小节将分别介绍以上网络结构的特点以及相关工作的核心思想。

残差网络(ResNet)最早为了解决深层网络的退化和梯度消失问题而提出。对于基于CNN的伪造语音检测网络,当网络层数较深时,会出现梯度消失问题,此时较低层难以在训练中接收有用的更新信息,阻碍了网络进一步学习有区分性的高级特征表示。采用ResNet可有效地解决该问题,其核心是使用跳过连接作为捷径,减少深层网络的训练参数,允许训练过程中参数更新更快地向较低层传播。目前,ResNet已成为伪造语音检测领域使用最广泛的网络之一。2019年,Alzantot等人[68]提出了一种基于深度ResNet的检测方案,针对三种不同的前端特征(MFCC、频谱图、CQCC)进行分数融合。2020年,Li等人[69]提出了一种基于Res2Net的检测方案,Res2Net将同一块中的特征分成多个通道组,不同组进行不同尺度的变换,并在组间设计类似残差的连接,该结构可学习多尺度特征表示,提高系统面对未知攻击的泛化能力。2020年,Parasu等人[70]提出了一种可跨数据库和攻击类型的具有良好通用性的Light-ResNet结构,该网络是ResNet的简化版,减少参数防止过拟合的同时实现网络轻量化。实验表明,该模型跨数据集检测时效果优于ASVspoof 2019挑战赛的CQCC-GMM基线系统和注意力过滤网络AFN。

轻量卷积神经网络(LCNN)由Wu等人[106]于2018年提出,最早用于面部识别领域,目前已被证明可有效地运用于伪造语音检测领域,ASVspoof 2017挑战赛的最佳系统和ASVspoof 2019挑战赛LA场景的最佳单系统都基于LCNN网络。LCNN可在减少计算成本和存储空间的情况下处理带有大量噪声标签的大规模数据,其核心在于每个卷积层后引入了最大特征图(Max Feature Map,MFM)激活函数。对比ReLU激活函数,MFM激活后得到的特征图更紧密,同时可实现特征选择和特征降维。实验表明,MFM激活丢弃音频特征中的噪音影响(环境噪音、信号失真等),保留核心信息,增强下层网络特征学习能力。2019年,Gomez-Alanis[103]基于GRU合并LCNN和RNN,提出了一种轻量卷积门控递归神经网络(LC-GRNN)。LC-GRNN结合了LCNN和RNN的优势,能够在帧级别提取判别特征并学习上下文特征。2020年,Wu等人[65]提出了一种基于CNN的拟合真实语音分布的特征真化(Genuinization)模型,该模型接收前端提取的手工特征输入,输出更利于辨别语音真伪的高级特征表示。作者认为相比种类繁多的伪造语音,真实语音的分布更容易拟合。因此,该特征真化模型不改变真实语音的输入特征,而是将伪造语音的输入映射到不同的输出。真化模型的结构类似自编码器,通过学习真实语音特征,放大真假语音之间的差异。2021年,Kuak等人[97]结合LCNN中的MFM激活函数和ResNet残差结构,提出检测系统ResMax。该模型为单模型,参数量较少且具有良好的检测效果。

挤压-激励网络(SENet)由Hu等人[107]于2018年提出,其核心是通过挤压-激励操作显示建模通道之间的相互依赖性。网络中挤压-激励(SE)模块先对特征图进行挤压操作得到通道级全局特征,再对全局特征做激励以学习各通道间关系。该模块为不同通道分配不同影响权重,从而提高了模型专注于与伪造检测最相关的通道信息的能力。2019年,Lai等人[62]提出了基于SENet和ResNet的检测系统ASSERT,该方法融合了SENet、平均-标准差ResNet、扩张ResNet等五种不同的系统。SENet也可与ResNet等网络架构相结合,以达到更好的检测效果。2020年,Li等人[69]提出的基于Res2Net的检测方案,将挤压-激励模块引入Res2Net网络中进一步提高了检测性能。

除上述常用网络架构外,也有部分工作的后端基于其他网络。2020年,Tak等人[104]首次探索了RawNet2网络在伪造语音检测领域测的应用。RawNet2是一种端到端网络,无需输入任何特征,直接将原始波形输入SincNet,然后使用ResNet学习更深层的区分性信息,然后通过GRU聚合话语级表征。2020年,Subramani等人[108]使用EfficientCNN网络结合残差模块,构建了参数量少且检测精度高的RES-EfficientCNN模型。2021年,Tak等人[86]使用图形注意力网络(Graph Attention Network,GAT)建模跨越不同子带和时间段的特征数据。2021年,Hemavathi等人[109]使用基于非负矩阵分解的盲信源分离(BSS)技术,将合成语音分解成真实语音部分和伪影部分,再使用基于CNN的分类器对目标语音进行分类,该论文中并未与最先进的检测方法进行对比,但也代表了检测领域的一种新思路。2021年,Chen等人[59]提出了一种不同于传统检测系统框架的伪造语音检测系统spoofprint。该系统类似于ASV系统,分为注册和验证两阶段。注册阶段根据目标说话人的真实语音样本学习说话人水印模型,验证阶段计算测试样本和说话人水印之间的余弦相似度,进而判断测试样本的真伪。2021年,Luo等人[110]提出了一种基于胶囊网络(Capsule Network,CapsNet)的检测网络,修改了原始网络的动态路由算法,迫使网络学习伪造语音中的伪影,增强系统的泛化能力。

2)损失函数

近年来的伪造语音检测工作普遍使用交叉熵损失(也称softmax损失)或AM-softmax损失,最近的部分工作关注于设计更有效的损失函数。此类工作主要针对现有检测系统对未知数据泛化能力不佳的问题进行损失设计。2020年,Chen等人[85]使用增强边缘余弦损失函数 (Large Margin Cosine Loss,LMCL)和频率掩蔽增强来迫使神经网络学习更鲁棒的特征嵌入。LMCL损失旨在将softmax损失重整为余弦损失,并迫使DNN学习可最大化类间方差并最小化类内方差的特征表示。2020年,Zhang等人[79]认为多样的伪造攻击类型间的分布并不相似,因此常用的拉近同类样本表示距离的训练方法影响了现有检测系统的泛化能力,由此设计了一种新的损失函数OC-Softmax(One-Class Softmax)。该方法通过压缩真实语音的表示来区分真实与伪造语音。2020年,Gomez-Alanis等人[111]提出基于核密度估计(Kernel Density Estimation,KDE)的损失函数。通过估计每个小批次内数据类的概率密度函数(Probability Density Function,PDF),计算每个小批次内所有训练类的KDE损失。实验结果表明,该损失优于softmax损失和triplet损失。2021年,Wang等人[72]总结并比较了常用的不同损失函数的性能,并针对基于边缘的softmax对超参数设置敏感的问题,提出了一种使用概率-相似度梯度(Probability-to-Similarity Gradient,P2SGrad)的无超参数的均方误差损失函数,实验结果表明,基于P2SGrad损失的EER低于使用AM-softmax和OC-softmax损失的EER。

3)深度网络训练方法

目前一些研究工作从深度神经网络的训练方法角度研究如何提高检测系统的泛化能力,如采用自监督学习、域自适应学习、对抗训练等。2020年,Jiang等人[67]受PASE+的启发,提出了一种基于多任务自监督学习的伪造语音检测方案SSAD。该方法使用基于时域卷积网络(Temporal convolutional network,TCN)的SSAD编码器提取原始音频的深层表示,同时通过最小化回归任务和二分类任务的损失帮助编码器获取更好的高级表示。SSAD提取高维特征后输入LCNN-big网络进行判别。2021年,Zhang等人[83]为解决数据集中信道不匹配的问题,提出了多任务学习和对抗训练两种网络。多任务学习网络中增加了信道分类器,对抗训练网络在前者基础上在信道分类器前添加梯度反转层,形成最大最小化的对抗训练,当训练稳定时,网络可学习到无关于信道影响的深度特征表示。2021年,Ma等人[78]受LwF(Learning without Forgetting)的启发,使用连续学习方法训练伪造语音检测系统DFWF,该模型可帮助减少对过去知识的遗忘,同时通过在真实语音中增加额外的正样本对齐(Positive Sample Alignment,PSA)约束,保持真实语音特征表示分布的一致性。

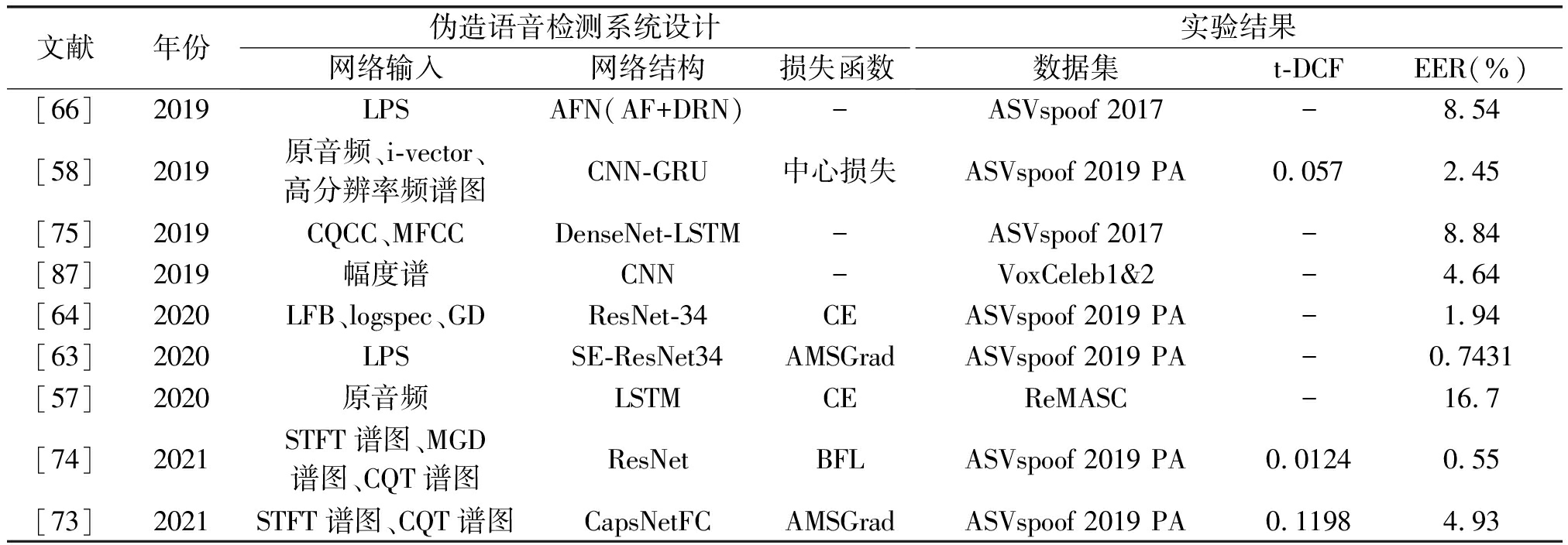

表6总结了近几年合成/转换语音检测方面关注于后端的工作。表中的所有工作均在ASVspoof2019数据集上进行实验,该数据集包含逻辑访问(LA)场景和物理访问(PA)场景两个子集,其中LA子集包括合成和转换语音等,PA子集包括重放语音。由于部分工作同时具备检测合成/转换语音和重放语音的能力,因此两个子集的实验结果均记录在下表。此外,工作[78]的LA→PA表示跨数据集检测结果,即在LA子集上训练,在PA子集上测试,PA→LA含义类似。

表6 近期合成/转换语音检测工作(“-”表示论文中未提及)

Tab.6 A summary of recent work focus on TTS/VC attack detection (“-” indicates that it was not mentioned in the article)

文献年份伪造语音检测系统设计网络输入网络结构损失函数融合子系统数量实验结果t-DCFEER(%)[62]2019LPS、CQCCSENet-34、SENet-50、均值方差ResNet、扩张ResNet、AFNBCE、MCE贪婪融合5LA 0.155PA 0.016LA 6.70PA 0.59[68]2019MFCC、CQCC、对数STFTResNetCE分数加权平均3LA 0.153PA 0.069LA 6.02PA 2.78[69]2020语谱图、LFCC、CQT谱图Res2Net、SE-Res2NetBCE分数平均3LA 0.074PA 0.012LA 2.50PA 0.46[79]2020LFCCResNet-18OC-softmax--LA 0.059LA 2.19[85]2020LFBResNet-18LMCL--LA 0.052LA 1.81[80]2020LFCC、MGDCC、乘积谱(prod-spec)ResNet-18BCE分数加权平均3LA 0.189PA 0.061LA 9.87PA 1.75[65]2020基于CQT的LPSCNN、LCNN---LA 0.102LA 4.07[81]2020LFCCGMM、CNNCE--LA 0.093PA 0.195LA 3.79PA 7.98[67]2020LPS、CQCC、LFCCTCN、LCNNMSE、CE---LA 5.31[72]2021LFCC、LFB、语谱图LCNNP2SGrad--LA 0.089LA 3.99[86]2021LFBResNet-18、GATBCESVM融合4LA 0.048LA 1.68[83]2021LFCCLCNN、ResNet、ResNet-OCOC-softmax---LA 3.92[59]2021s-vector、x-vectorResNet18-L-FMLCML逻辑回归2-LA E1 0.64[78]2021LFCCLCNNPSA---LA→PA 9.25 /PA→LA 10.45[110]2021LFCC、STFT胶囊网络边缘损失分数平均2LA 0.033PA 0.051LA 1.07PA 2.05[97]2021CQT谱图ResMax---LA 0.06PA 0.009LA 2.19PA 0.37[93]2021Global MCNN+GRUCE加权投票2LA 0.074LA 4.03

3.4 重放语音检测

重放攻击通过对目标说话人语音进行录制编辑回放实现攻击,其攻击过程如图8所示,通常用于攻击ASV系统。重访攻击的语音信号中包含了生成重放语音的各个中间设备和环境的卷积和加性失真信号,因此现有针对重放语音的检测技术更多关注于语音信号在录制、编辑、扬声器播放各环节所引入的与自然场景中说话人不同的语音信号特征。

图8 重放攻击常见形式

Fig.8 A diagram of generic replay attack

重放语音检测系统的基本结构遵循通用的伪造语音检测系统架构,即主要包括前端特征提取和后端特征表示网络两部分,目前部分研究根据重放语音的独特性质提出基于活体检测的方案,本小节将分别介绍这三个方面的研究进展。

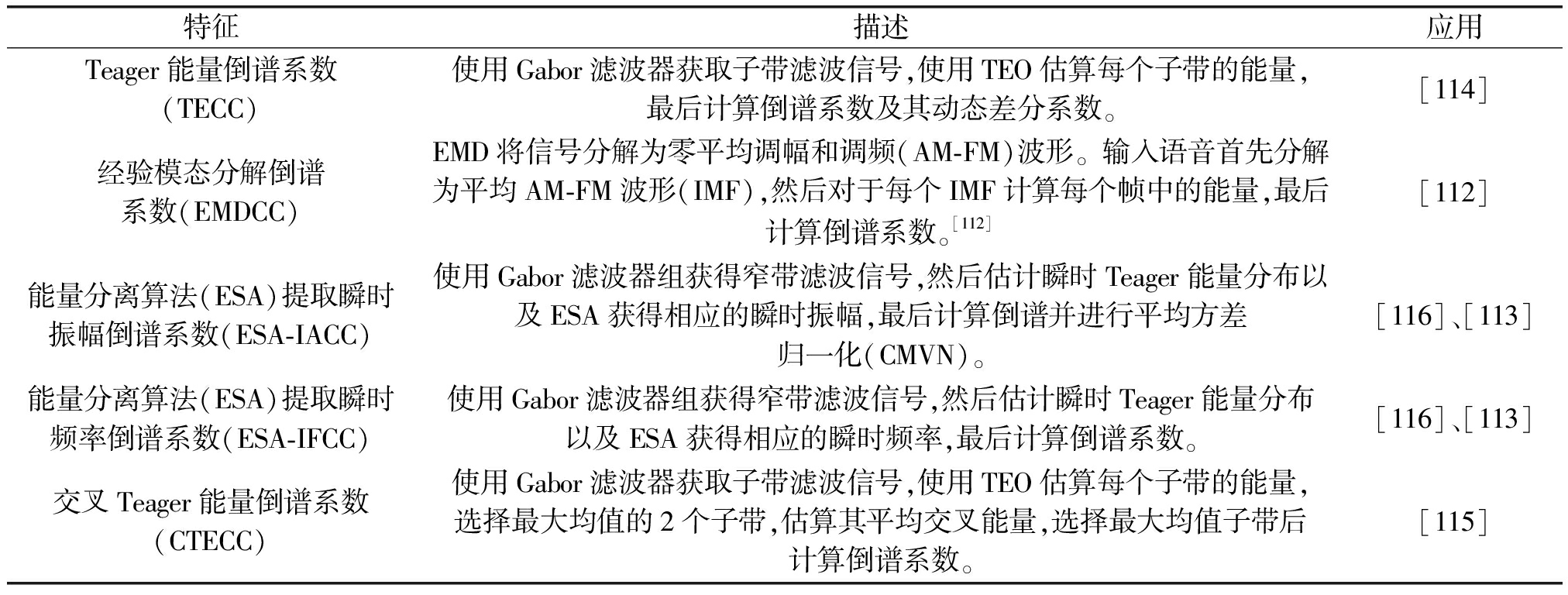

3.4.1 前端特征提取

重放语音检测常用的特征与合成与转换语音检测略有不同。早期的工作发现音频中的高频和相位信息有助于进行重放检测,近年来随着录音设备质量的提升,真实语音与重放语音之间的差异逐渐减小,进一步提升了检测难度。常用的特征包括经验模态分解倒谱系数(Empirical Mode Decomposition Cepstral Coefficients,EMDCC)[112],频谱质心幅值倒谱系数(SCMC)[100],子带质心频率系数(SCFC)[100],逆梅尔频率倒谱系数(IMFCC)[76],和基于能量分离算法(ESA)提取的瞬时振幅倒谱系数(ESA-IACC)[113]和瞬时频率倒谱系数(ESA-IFCC)[113]等。基于ESA提取的特征对于噪声环境下录制的重放音频具有高检测性能,但无法良好地检测安静环境下录制的重放音频。

近期工作提出了一些针对重放语音的有效特征。2019年,Kamble等人[114]考虑重放语音中混响的影响,观察到在不同混响环境中可捕捉到不同的Teager能量轨迹,因此使用Teager能量算子(Teager Energy Operator,TEO)对重放语音的子带能量进行估算后映射到倒谱域,获得Teager能量倒谱系数(Teager Energy Cepstral Coefficients,TECC)。2021年,Acharya等人[115]提出交叉Teager能量倒谱系数(Cross-Teager Energy Cepstral Coefficients,CTECC)特征,其思路是从多通道输入中选取最大交叉能量的最优通道,便于追踪由于设备重放而导致的语音信号失真。

表7总结了近年重放语音检测工作中常用的特征。除表中总结的特征外,其余的常用特征还包括CQCC、IMFCC、SCMC、SCFC、LPCC、LFCC、GD、MGD等,可在3.2.1节表1~5中参考详细信息。与合成和转换语音检测类似,目前尚不存在检测重放语音的最佳特征的共识,因此前沿工作基本采用多子系统融合的方法。近年来,伪造语音检测逐渐向更高的泛化性和通用性发展,因此未来将更关注构造可同时检测所有伪造语音类型且不受跨数据集影响的前端特征。

表7 重放语音检测常用特征

Tab.7 Commonly used features for replay attack detection

特征描述应用Teager能量倒谱系数(TECC)使用Gabor滤波器获取子带滤波信号,使用TEO估算每个子带的能量,最后计算倒谱系数及其动态差分系数。[114]经验模态分解倒谱系数(EMDCC)EMD将信号分解为零平均调幅和调频(AM-FM)波形。输入语音首先分解为平均AM-FM波形(IMF),然后对于每个IMF计算每个帧中的能量,最后计算倒谱系数。[112][112]能量分离算法(ESA)提取瞬时振幅倒谱系数(ESA-IACC)使用Gabor滤波器组获得窄带滤波信号,然后估计瞬时Teager能量分布以及ESA获得相应的瞬时振幅,最后计算倒谱并进行平均方差归一化(CMVN)。[116]、[113]能量分离算法(ESA)提取瞬时频率倒谱系数(ESA-IFCC)使用Gabor滤波器组获得窄带滤波信号,然后估计瞬时Teager能量分布以及ESA获得相应的瞬时频率,最后计算倒谱系数。[116]、[113]交叉Teager能量倒谱系数(CTECC)使用Gabor滤波器获取子带滤波信号,使用TEO估算每个子带的能量,选择最大均值的2个子带,估算其平均交叉能量,选择最大均值子带后计算倒谱系数。[115]

3.4.2 后端分类模型

重放语音检测系统的后端分类模型也可分为基于传统机器学习的分类模型和基于深度网络的分类模型。最常用的机器学习分类器为基于GMM的分类器([117]、[118]、[119]、[120])。与合成语音检测类似,使用GMM分类器的方法在训练阶段分别计算真实语音和伪造语音的GMM模型,在测试阶段根据两个模型计算测试语音特征向量的对数似然比,通过与设定阈值的比较判断语音的真假。ASVspoof 2017 EER为6.72%的获胜系统使用了GMM分类器对从频谱图中学习到的特征表示进行分类。SVM i-vector也是常用分类模型。ASVspoof 2015的获胜系统采用基于标准i-vector的方法提取高级特征表示。2017年,Lavrentyeva等人[118]受此启发,采用线性核SVM分类器对提取的i-vector高级特征表示进行分类。除上述两种主流分类模型以外,2017年,Ji等人[119]提出了一系列基于GMM均值超向量(GSV)的分类方法,包括GMM均值超向量-随机森林(GSV-RF)和GMM均值超向量-梯度提升决策树(GSV-GBDT)等。ASVspoof 2017排名第二的系统即采用了GSV-GBDT和GSV-RF等多种分类器。文献[120]表明,在给定短时音频输入时,采用最大似然准则训练的标准GMM分类模型比采用基于高斯混合模型-通用背景模型(GMM-UBM)、GMM-SVM、i-vectors等分类模型的性能更优。

基于深度学习的重放检测系统的后端网络结构与合成和转换语音检测系统类似,一般采用基于卷积神经网络(CNN)的架构。然而,重放语音数据受跨数据集的信道不匹配问题的影响更大,因此部分工作提出新的训练框架以克服此类问题。以下分别从深度神经网络结构、损失设计和深度网络训练方法介绍近年来关注于重放语音检测后端网络的工作。

1)深度神经网络结构

残差网络(ResNet)由于其可学习更深层网络的性质,也是重放攻击最常用的网络架构之一。2018年,Tom等人[102]在深度残差网络中采用注意力机制,利用GD特征检测重放语音。2019年,Lai等人[66]提出基于扩张ResNet的注意过滤网络AFN。该网络使用基于注意力的滤波来增强时频域中的特征表示。2020年,Von等人[64]提出一种基于ResNet的孪生网络结构,由共享同一组可训练参数的两个子网组成,训练目的是增加类间方差的同时缩小类内方差。2020年,Yoon等人[63]以双向LSTM为动机,提出双向特征分割的方法,使用基于SE-ResNet34的特征表示学习网络进行重放语音检测。

由于现代麦克风阵列录制的音频具有丰富的空间信息,现有方法大多仅针对双通道音频输入, 2020年Gong等人[57]设计了一种利用多通道信息的端到端重放攻击检测网络。该系统捕获音频的多通道信息,输入LSTM和全连接层。由于卷积网络缺少空间信息和池化后低级特征的关系,2021年Ouyang等人[73]提出了一种针对重放攻击的检测系统CapsNetFC,该系统基于胶囊网络,能利用向量同时捕获存在概率和空间信息。

2)损失设计

2021年,Dou等人[74]使用平衡的焦点损失(Balanced Focal Loss,BFL)函数作为训练目标,使模型能更多地关注具有动态缩放损失值的不可区分样本。实验证明,该损失的检测性能优于二元交叉熵损失。

3)深度网络训练方法

部分工作从训练方法的角度进行探索以提升重放语音检测的性能。2020年,Shim等人[87]针对重放语料库中信道不匹配的情况,提出了一种基于自监督的重放检测预训练框架。其思路是从语料库中选取一对片段,训练深层神经网络判断这两个片段的声学结构是否相同。实验表明,使用该预训练框架后,VoxCeleb1&2语料库上的EER从6.36%降低到4.64%。2020年,Wang等人[71]针对当前重放检测系统泛化性差的现状,提出了双对抗域自适应框架(Dual-Adversarial Domain Adaptation,DADA),该框架可以通过使用两个域判别器分别实现对重放音频和真实音频的细粒度对齐。在ASVspoof 2017 v2数据集和AVspoof数据集上的实验表明,DADA框架明显优于基线模型和域对抗训练(Domain Adversarial Training,DAT)框架。表8总结了近年来针对重放语音检测的代表性工作。

表8 近期重放语音检测工作(“-”表示论文中未提及)

Tab.8 A summary of recent work focus on replay attack detection (“-” indicates that it was not mentioned in the article)

文献年份伪造语音检测系统设计网络输入网络结构损失函数实验结果数据集t-DCFEER(%)[66]2019LPSAFN(AF+DRN)-ASVspoof 2017-8.54[58]2019原音频、i-vector、高分辨率频谱图CNN-GRU中心损失ASVspoof 2019 PA0.0572.45[75]2019CQCC、MFCCDenseNet-LSTM-ASVspoof 2017-8.84[87]2019幅度谱CNN-VoxCeleb1&2-4.64[64]2020LFB、logspec、GDResNet-34CEASVspoof 2019 PA-1.94[63]2020LPSSE-ResNet34AMSGradASVspoof 2019 PA-0.7431[57]2020原音频LSTMCEReMASC-16.7[74]2021STFT谱图、MGD谱图、CQT谱图ResNetBFLASVspoof 2019 PA0.01240.55[73]2021STFT谱图、CQT谱图CapsNetFCAMSGradASVspoof 2019 PA0.11984.93

3.4.3 活体检测方法

一些工作从设备播放所引入的信号特征进行重放攻击检测。2015年,Shiota等人[121]发现,在自然语音产生过程中,气流和声腔之间的相互作用会产生一种爆破声,然而扬声器发出的重放语音不含爆破声。据此可对重放语音进行检测。2017年,Chen等人[122]提出了一种监视磁场变化的方法,由于设备扬声器播放语音时会产生人类发声时没有的磁场,所以可通过监视磁力计读数来检测重放语音。2017年,Feng等人[123]提出的方法要求用户在发出指令时佩戴相应的可穿戴设备,ASV设备收到指令后判断该语音与合法用户的体表振动是否吻合。2017年,Lei等人[124]提出了一种基于用户存在年来关注于重放语音检测后端网络的工作。

3.5 对抗攻击检测

针对对抗攻击的检测技术主要分为主动防御和被动防御两类。主动防御技术在构建分类神经网络时就考虑增强其抵抗对抗样本的鲁棒性,被动防御技术不修改原始模型,在分类神经网络建立后再考虑防御对抗样本。

3.5.1 主动防御方法

针对ASV对抗样本,典型的主动防御方法即对抗训练。2020年,Wu等人[105]使用对抗训练方法,将对抗示例注入训练数据中,以增强基于DNN的ASV系统对于对抗示例的鲁棒性。实验表明,基于SENet的抗欺骗ASV系统,在经过对抗训练后,识别正确率从48.32%提升到92.4%。为解决ASV防御机制通用性差的问题,可采用集成对抗训练的方法,通过攻击几个不同的目标模型生成更大的对抗样本库,然后利用对抗样本的传递性来训练防御模型。

3.5.2 被动防御方法

针对ASV对抗样本,典型的被动防御方法包括输入重构和对抗性检测。输入重构即在样本输入目标ASV系统之前对其进行简单的变换操作,该操作不会改变真实音频的检测结果,但会让对抗样本失去攻击能力。2020年,Wu等人[105]使用空间平滑法对ASV对抗样本进行被动防御。空间平滑最早在图像领域中应用,是一种使用附近像素平滑中心像素的方法。实验表明,应用空间平滑后对抗样本对目标ASV系统的干扰明显减弱,三种滤波方法中,高斯滤波的效果差于中值滤波和均值滤波。2020年,Li等人[125]提出一个类VGG网络(Visual Geometry Group Network)的独立检测网络来防御对抗攻击,该方法对未知ASV系统具有较好鲁棒性,但对未知对抗攻击方法鲁棒性较弱。

对抗性检测即在样本输入目标ASV系统之前,通过独立的检测网络判断该语音的真伪。最新的工作表明,基于自监督学习的语音预训练方法可通过消除语音中的杂音来防御对抗样本。2020年,Wu等人[126]提出一种基于自监督的被动防御方法Mockingjay,该模型利用自监督学习模型构造一个深度过滤器,通过重构被遮罩的输入,从输入的频谱图中提取鲁棒的高级表示来检测对抗输入。实验结果表明,自监督学习模型提取的表征能够有效地防止对抗样本的可移植性,可有效防御黑盒攻击。2020年,Liu等人[127]提出一种基于自监督学习的预训练模型TERA,该模型比Mockingjay更先进,同样通过重构语音帧学习深层表示,但该模型使用随机策略沿时间、通道、幅度三个维度改变输入音频。TERA模型可有效消除对抗样本中的对抗干扰。2021年,Wu等人[128]进一步改进TERA模型,提出攻击无关的串联TERA模型。该模型进一步降低了对抗样本的攻击成功率,并且不会过多地影响真实样本的识别准确性。2021年,Wu等人[129]使用自监督学习模型(SSLM)对ASV进行对抗攻击防御,分别从重构波形以消除扰动和对抗性检测两方面检测对抗样本。同时,该工作提出了一种评估对抗攻击防御系统性能的指标。

4 相关竞赛

本节分别介绍伪造语音和检测领域的主流竞赛。

4.1 语音伪造竞赛

主流的伪造语音竞赛包括暴雪挑战赛(Blizzard Challenge)、语音转换挑战赛(Voice Conversion Challenge,VCC)等。部分声学国际会议也会组织语音伪造挑战,如ICASSP 2021举办的多说话人多风格音色克隆大赛(M2VoC)等。

暴雪挑战赛是由卡内基梅隆大学和日本名古屋工业大学联合发起的一年一度的国际语音合成大赛,于2005年首次举办,至今已举办16届。该赛事旨在构建一个公开、统一的语音合成技术评测平台,推动语音合成技术的快速发展。参赛者需根据官方发布的数据集合成一组规定的测试语句,主办方将通过听力测试评价合成语音的质量。

语音转换挑战赛(VCC)是由名古屋大学和中国科学技术大学等多所高校联合发起的两年一度的国际语音转换大赛,于2016年首次举办,至今已举办三届(2016、2018、2020)。该大赛通过发布公开数据集,并针对VC技术面临的未决问题和挑战组织竞争性评估,以促进VC技术的发展。参赛者需根据官方发布的指定数据集,针对具体任务实现语音转换(如半平行转换、跨语种转换等),主办方将通过自然度和说话人相似度两方面评估转换语音的质量。

多说话人多风格音色克隆大赛(M2VoC)是声学、语音和信号处理国际会议ICASSP 2021的信号处理挑战旗舰任务之一。该赛事针对当前多说话人和多风格语音伪造的局限,提供通用的数据集和测试平台,以促进语音克隆的发展。M2VoC 2021有两个赛道,分别是少样本赛道和极少样本赛道。参赛者需根据语音样本生成规定的句子和短段落,主办方分别针对说话人相似度、语音质量、风格/表现力和发音准确度进行克隆语音评估。

4.2 伪造语音检测竞赛

伪造语音检测领域内规模最大、最全面的挑战赛是由英国爱丁堡大学、法国EURECOM、日本NEC、东芬兰大学等多个研究机构共同组织发起的两年一度的ASVspoof挑战赛(Automatic Speaker Verification Spoofing And Countermeasures Challenge)。该赛事旨在通过发布公开数据集并组织竞争性评估来促进ASV伪造语音检测技术的发展。ASVspoof挑战赛于2015年首次举办,至今已举办三届(2015、2017、2019),第四届正在进行中。ASVspoof 2015挑战赛关注合成和转换两种类型的伪造攻击;ASVspoof 2017挑战赛关注重放攻击;ASVspoof 2019挑战赛通过LA和PA两个子任务,同时关注多种合成/转换伪造攻击和重放攻击;ASVspoof 2021挑战赛三个子任务分别关注LA场景,PA场景和无ASV的语音Deepfake检测。相比前三次竞赛,ASVspoof 2021有三点改进:首先,扩展了LA场景的挑战,探索对信道变化具有鲁棒性的检测算法;其次,PA场景子任务使用真实物理环境下录制的音频,更具现实意义;最后,该比赛首次对以欺骗人类为目的的语音Deepfake检测进行探索。

CSIG图像图形技术挑战赛是由中国图象图形学学会(CSIG)主办的系列赛事,旨在促进我国图像图形技术及相关产业的发展和应用,解决企业面临的技术难题,扩大企业宣传规模,帮助企业吸引更多的优秀人才。2021年,第二届CSIG图像图形技术挑战赛新增伪造媒体取证挑战,包括伪造视频检测和伪造语音检测两个项目。参赛者需根据官方发布的数据集提交检测结果,由主办方公布检测结果和排名。

5 相关数据集

本节介绍近年来伪造语音检测研究中常用的数据集。

5.1 ASVspoof 挑战赛数据集

ASV挑战赛通过颁布公开数据集并组织竞争性评估来促进伪造语音检测技术的发展。目前ASVspoof挑战赛已举办三届(2015、2017、2019)。ASVspoof 2015数据集是第一个用于伪造和检测研究的主要数据集。该数据集仅针对LA场景,由真实语音和合成/转换语音组成。ASVspoof 2017 v2数据集是一个重放数据集,在RedDots语料库及其重放语音上建立。目前ASVspoof 2017 数据集均指ASVspoof 2017 v2数据集,该版本纠正了第一版的数据异常。ASVspoof 2019数据集有LA和PA两个子集,LA子集中包含真实语音和合成/转换语音,PA子集中包含真实语音和重放语音。此前,ASVspoof 2017数据集中的重放音频是在非受控条件下录制的。据此,ASVspoof 2019数据集在一个模拟且可控的声学环境中创建,以控制重放语音中的非受控因素。

5.2 AVspoof 数据集

AVspoof数据集包含合成、转换、重放三种伪造攻击。其中,重放音频由多种高质量设备(三星Galaxy S4、iPhone 3GS、笔记本电脑和高品质扬声器)播放,测试集中引入了未知重放攻击。

5.3 ReMASC 数据集

ReMASC数据集于2020年发布,是第一个专为保护语音控制系统免受各种形式的重放攻击而设计的数据库。数据集中包含来自四个系统的录音,这些录音具有不同的声学环境设置(如背景噪声及扬声器和设备之间的相对位置)。

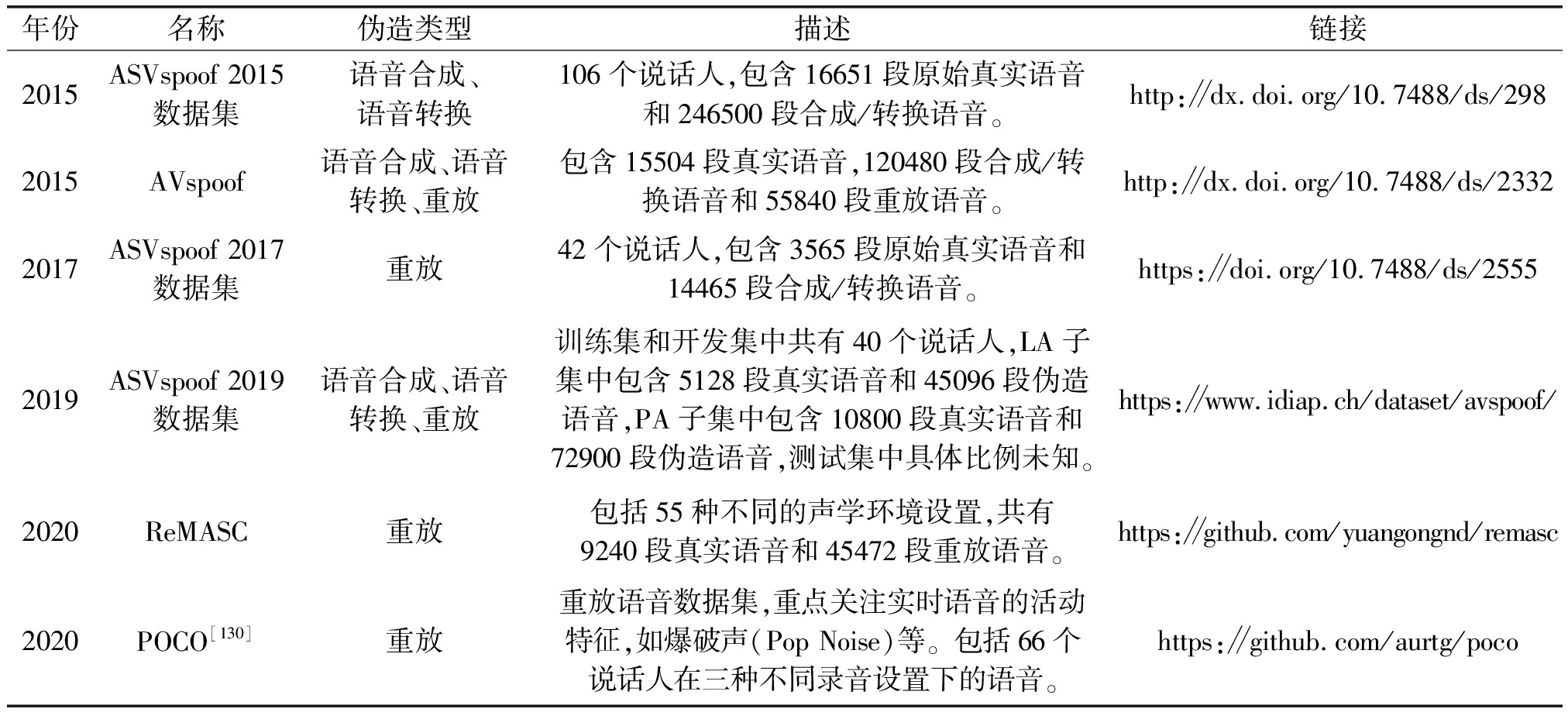

表9总结了上述五个数据集的基本信息。

表9 伪造语音检测常用数据集总结

Tab.9 A summary of commonly used dataset for spoofing detection

年份名称伪造类型描述链接2015ASVspoof 2015数据集语音合成、语音转换106个说话人,包含16651段原始真实语音和246500段合成/转换语音。http:∥dx.doi.org/10.7488/ds/2982015AVspoof语音合成、语音转换、重放包含15504段真实语音,120480段合成/转换语音和55840段重放语音。http:∥dx.doi.org/10.7488/ds/23322017ASVspoof 2017数据集重放42个说话人,包含3565段原始真实语音和14465段合成/转换语音。https:∥doi.org/10.7488/ds/25552019ASVspoof 2019数据集语音合成、语音转换、重放训练集和开发集中共有40个说话人,LA子集中包含5128段真实语音和45096段伪造语音,PA子集中包含10800段真实语音和72900段伪造语音,测试集中具体比例未知。https:∥www.idiap.ch/dataset/avspoof/2020ReMASC重放包括55种不同的声学环境设置,共有9240段真实语音和45472段重放语音。https:∥github.com/yuangongnd/remasc2020POCO[130]重放重放语音数据集,重点关注实时语音的活动特征,如爆破声(Pop Noise)等。包括66个说话人在三种不同录音设置下的语音。https:∥github.com/aurtg/poco

6 工具资源及相关源代码

随着语音伪造和检测技术的发展,网络上逐渐涌现众多开源软件和商业应用,本节将对现有的语音伪造工具或开源代码进行汇总。与语音伪造和检测相关的工具可分为两类,即1)包含语音伪造或检测的工具资源;2)用于语音伪造或检测的机器学习源代码等。

6.1 伪造语音

1)工具资源

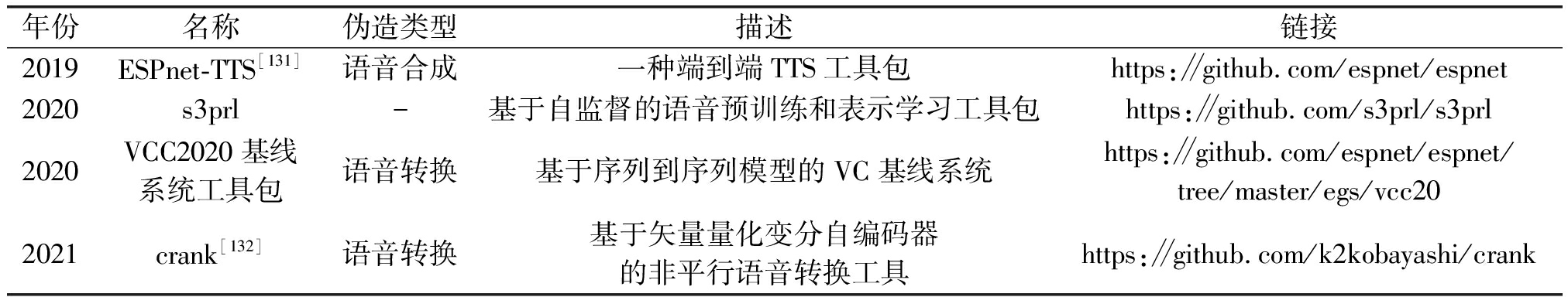

表10整理了部分语音伪造工具资源,包括语音转换和语音合成。表中s3prl工具包是一个基于自监督学习的语音预训练和表示学习工具包,可用于语音伪造和伪造语音检测的各种下游任务。

表10 语音伪造工具资源整理

Tab.10 A summary of tool resources for speech forgery

年份名称伪造类型描述链接2019ESPnet-TTS[131]语音合成一种端到端TTS工具包https:∥github.com/espnet/espnet2020s3prl-基于自监督的语音预训练和表示学习工具包https:∥github.com/s3prl/s3prl2020VCC2020基线系统工具包语音转换基于序列到序列模型的VC基线系统https:∥github.com/espnet/espnet/tree/master/egs/vcc20 2021crank[132]语音转换基于矢量量化变分自编码器的非平行语音转换工具https:∥github.com/k2kobayashi/crank

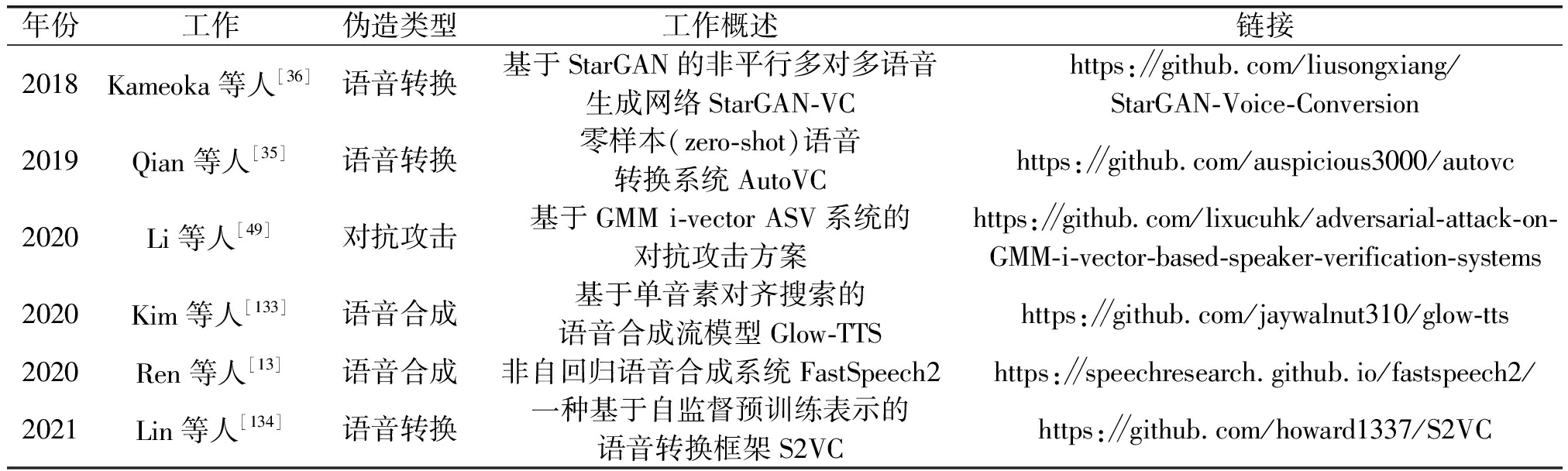

2)源代码

表11整理了部分语音伪造工作的源代码,包括语音转换,语音合成和对抗攻击。

表11 语音伪造源代码整理

Tab.11 A summary of source code for speech forgery

年份工作伪造类型工作概述链接2018Kameoka等人[36]语音转换基于StarGAN的非平行多对多语音生成网络StarGAN-VChttps:∥github.com/liusongxiang/StarGAN-Voice-Conversion2019Qian等人[35]语音转换零样本(zero-shot)语音转换系统AutoVChttps:∥github.com/auspicious3000/autovc2020Li等人[49]对抗攻击基于GMM i-vector ASV系统的对抗攻击方案https:∥github.com/lixucuhk/adversarial-attack-on-GMM-i-vector-based-speaker-verification-systems2020Kim等人[133]语音合成基于单音素对齐搜索的语音合成流模型Glow-TTShttps:∥github.com/jaywalnut310/glow-tts 2020Ren等人[13]语音合成非自回归语音合成系统FastSpeech2https:∥speechresearch.github.io/fastspeech2/2021Lin等人[134]语音转换一种基于自监督预训练表示的语音转换框架S2VChttps:∥github.com/howard1337/S2VC

6.2 伪造语音检测

1)工具资源

表12整理了部分伪造语音检测的工具资源,包括数据集和ASVspoof挑战赛基线系统工具包。

表12 伪造语音检测工具资源整理

Tab.12 A summary of tool resources for speech spoofing detection

年份名称描述链接2019ASVspoof 2019基线系统工具包包括LFCC、CQCC特征,GMM后端分类模型,t-DCF评价指标的开源库或工具,和基于MATLAB的LFCC-GMM、CQCC-GMM基线系统实现https:∥www.asvspoof.org/asvspoof2019/ASVspoof_2019_baseline_CM_v1.zip2021ASVspoof 2021基线系统源代码包括LFCC-GMM、CQCC-GMM、LFCC-LCNN、RawNet2四个系统的实现http:∥github.com/asvspoof-challenge/2021

2)源代码

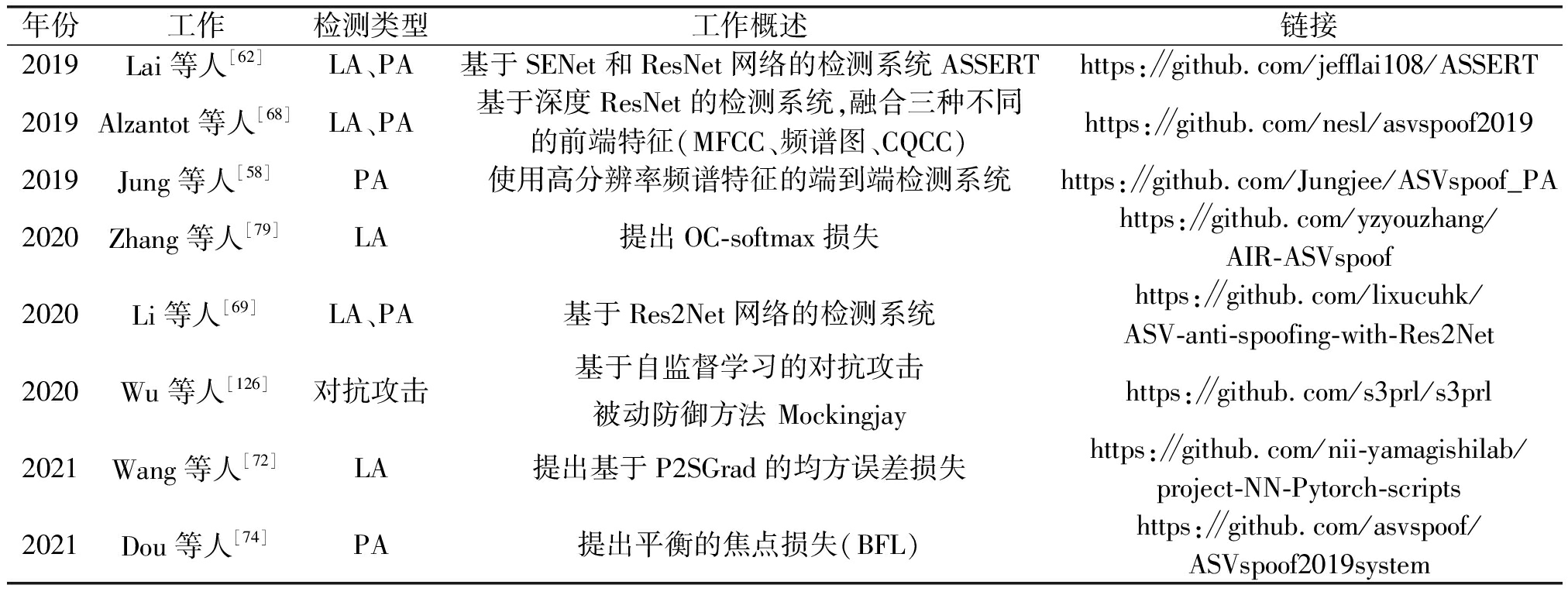

表13整理了部分效果较好的伪造语音检测系统的源代码,其中“检测类型”列表示该工作可以检测何种类型的伪造攻击,LA表示可以在LA场景下应用,即可检测合成/转换语音,PA表示可在PA场景下应用,即可检测重放语音。

表13 伪造语音检测源代码整理

Tab.13 A summary of source code for speech spoofing detection

年份工作检测类型工作概述链接2019Lai等人[62]LA、PA基于SENet和ResNet网络的检测系统ASSERThttps:∥github.com/jefflai108/ASSERT2019Alzantot等人[68]LA、PA基于深度ResNet的检测系统,融合三种不同的前端特征(MFCC、频谱图、CQCC)https:∥github.com/nesl/asvspoof20192019Jung等人[58]PA使用高分辨率频谱特征的端到端检测系统https:∥github.com/Jungjee/ASVspoof_PA2020Zhang等人[79]LA提出OC-softmax损失https:∥github.com/yzyouzhang/AIR-ASVspoof2020Li等人[69]LA、PA基于Res2Net网络的检测系统https:∥github.com/lixucuhk/ASV-anti-spoofing-with-Res2Net2020Wu等人[126]对抗攻击基于自监督学习的对抗攻击被动防御方法 Mockingjayhttps:∥github.com/s3prl/s3prl2021Wang等人[72]LA提出基于P2SGrad的均方误差损失https:∥github.com/nii-yamagishilab/project-NN-Pytorch-scripts2021Dou等人[74]PA提出平衡的焦点损失(BFL)https:∥github.com/asvspoof/ASVspoof2019system

7 未来研究方向

7.1 语音伪造

1)少样本伪造

现有语音伪造方法需要大量高质量的训练语料,少样本伪造技术还在探索中。通常,在资源受限条件下的伪造语音自然度和可懂度下降明显。同时,真实环境下难以获取充足且录制环境相同的高音质语音。因此,未来的研究应探索少样本语音伪造,并克服跨数据集训练语料对合成语音质量的影响。

2)鲁棒伪造

现有的语音伪造方法大多依赖于同一环境录制的训练语料库,对于来自不同语料库的训练数据难以保障合成语音的质量。不同录制环境下获取的数据集,数据分布差异大,并且含有较多不同的背景噪声。因此,未来的研究应探索跨数据集的鲁棒性语音伪造。可以对含噪语音进行分解,提取纯净语音,或选取抗干扰的声学特征和抗干扰的伪造算法。

3)自然韵律伪造

现有语音伪造方法生成的语音大多存在韵律转换不自然,朗读节奏僵硬的问题,例如词语之间音素转换不自然、没有适当停顿、感情起伏不明显等,即使发音存在的问题较小,听者依然容易分辨出合成语音。因此,未来的研究应探索语音自然韵律的伪造,捕捉自然语音中灵活的韵律节奏特点,根据不同的语义合成具有不同朗读情感的语音。

4)口语风格伪造

现有语音伪造方法生成的自然口语声音很难接近真人,因为真人的语音大多存在口音、习惯性赘语、口误等特点,而合成语音通常较为千篇一律,缺乏变化。因此,未来的研究应探索口语化语音的多风格伪造,捕捉自然口语中灵活的语音特征,实现多风格差异化韵律建模,在符合语言习惯的情况下,灵活建模语气词、语调变化等口语特征。

7.2 伪造语音检测

1)高泛化性检测

现有伪造语音检测方法大多依赖于特定的数据集或特定的伪造方法,训练数据种类单一且同分布,因此泛化能力较弱,该问题目前仍是伪造检测领域研究的核心难点。未来的研究应进一步探索有效的多角度深度融合特征以及有效的集成算法,提高检测算法的泛化能力。如在听觉方面,可探索语速、声纹、频率分布等特征的融合。

2)少样本检测

现有的伪造语音检测方法大都依赖于大规模、高质量的深度伪造数据集,也有工作已经初步探索了小样本的伪造语音检测。未来的研究应更多地探索基于小样本的自监督学习等技术,在保证检测效果的前提下,有效降低模型训练成本。

3)鲁棒检测

现有的伪造语音检测方法容易在训练集上过拟合,对经过重压缩、加噪等处理后的语音检测鲁棒性较差。因此,未来的研究应探索鲁棒的检测算法,如利用对抗样本对检测模型进行对抗训练,或在模型建立的不同阶段,探索不同预处理方法对检测算法鲁棒性的影响。

4)活体特征检测

现有的伪造语音绝大多数没有底噪和背景杂音,而真实语音在录制过程中多少会存在录音底噪、环境噪声、喷麦等现象。最新的伪造语音检测方法通常缺乏对该差异的考虑,因此,未来的研究应将上述活体特征作为辅助信息,联合深度检测模型共同判断语音的真伪。

5)多模态检测

现有的伪造语音检测方法大都集中于单纯的伪造语音检测,然而现有的多媒体伪造视频大多通过画面和语音结合以达到更逼真的伪造效果。因此,未来的研究应探索伪造数据的多模态检测,例如对于伪造视频数据从音频和视频等多角度对其进行联合检测。

6)特定说话人风格检测

现有的伪造语音检测方法可以以高自然度模拟目标说话人的音色,但往往忽视了目标说话人独特灵活的口语语言特征,如口头禅、赘语、口音、发音习惯等。因此,未来的研究应探究特定说话人的语言风格,捕捉能体现说话人个体言语特点的有效特征,以便检测音频真伪。

8 结论

语音伪造指使用某种技术手段生成可欺骗人类听觉系统(HAS)或自动说话人验证系统(ASV)的虚假语音,伪造方法包括模仿、合成、转换、重放、对抗攻击五大类。深度语音伪造技术作为Deepfake操控舆论的核心技术,同时也对人类和ASV系统构成了极大威胁,从而驱动了伪造语音检测技术的发展。

本文综述了语音伪造和检测领域的研究现状。五种语音伪造技术中,模仿语音较难欺骗目标ASV系统,因此不是伪造的主要研究内容;合成和转换语音技术在近几年快速发展,在样本充足的情况下生成的伪造语音可达到以假乱真的地步;重放语音对ASV系统的威胁最大,但是重放攻击只对文本独立和没有错误密码保护的ASV系统有效;对抗攻击是近几年兴起的针对神经网络弱点的攻击,研究表明即使是具有伪造检测机制的ASV系统,也容易受到黑盒对抗攻击。针对伪造语音检测,现有伪造语音检测系统通常由前端特征提取器和后端深度网络分类模型组成。输入后端的常用语音特征包括原始语音、频谱特征和身份特征等。常用深度网络结构包括ResNet、LCNN、SENet等。由于实际中ASV系统无法预判受到伪造攻击的具体类型,因此目前的研究趋势是针对不同伪造攻击手段构建高泛化性的通用检测系统。

目前,针对语音伪造,现有工作已经渐趋成熟,未来会向少样本高质量的语音伪造和更高自然度的语音伪造方向发展;针对伪造语音检测,未来将会向对多种伪造攻击都有效的通用检测和高泛化性检测发展。随着伪造语音质量提升,现有主流检测方法可能无法长久适用,因此要跟随伪造技术同步发展检测手段,也可在关注音频时频特性的同时,利用辅助信息(如重放检测中的爆破音检测、磁场检测等)发展新的检测思路。此外,进一步完善相关司法立法并构建数字内容可信体系也将为包括该领域在内的网络信息内容安全提供保障。

[1] BIGORGNE D, BOEFFARD O, CHERBONNEL B, et al. Multilingual PSOLA text-to-speech system[C]∥1993 IEEE International Conference on Acoustics, Speech, and Signal Processing. Minneapolis, MN, USA. IEEE, 1993: 187-190.

[2] YOSHIMURA T. Simultaneous modeling of phonetic and prosodic parameters, and characteristic conversion for HMM-based text-to-speech systems[J]. Ph D Thesis, Nagoya Institute of Technology, 2001(January): 1-109.

[3] WAN V, AGIOMYRGIANNAKIS Y, SILEN H, et al. Google's Next-Generation Real-Time Unit-Selection Synthesizer Using Sequence-to-Sequence LSTM-Based Autoencoders[C] ∥Interspeech 2017. ISCA: ISCA, 2017: 1143-1147.

[4] ZE Heiga, SENIOR A, SCHUSTER M. Statistical parametric speech synthesis using deep neural networks[C]∥2013 IEEE International Conference on Acoustics, Speech and Signal Processing. Vancouver, BC, Canada. IEEE, 2013: 7962-7966.

[5] ARIK S Ö, CHRZANOWSKI M, COATES A, et al. Deep voice: Real-time neural text-to-speech[C]. Proceedings of the 34th International Conference on Machine Learning-Volume 70. JMLR. org, 2017: 195-204.

[6] PING Wei, PENG Kainan, GIBIANSKY A, et al. Deep voice 3: 2000-speaker neural text-to-speech[EB/OL]. https:∥www.researchgate.net/publication/320582779_Deep_Voice_3_2000-Speaker_Neural_Text-to-Speech,2017.

[7] OORD A V D, DIELEMAN S, ZEN H, et al. Wavenet: a generative model for raw audio[EB/OL]. 2016: arXiv: 1609.03499[cs.SD]. https:∥arxiv.org/abs/1609.03499.

[8] WANG Yuxuan, SKERRY-RYAN R, STANTON D, et al. Tacotron: A fully end-to-end text-to-speech synthesis model[EB/OL]. https:∥www.researchgate.net/publication/315696313_Tacotron_A_Fully_End-to-End_Text-To-Speech_Synthesis_Model,2017.

[9] SHEN J, PANG Ruoming, WEISS R J, et al. Natural TTS synthesis by conditioning wavenet on MEL spectrogram predictions[C]∥2018 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). Calgary, AB, Canada. IEEE, 2018: 4779- 4783.

[10]WEISS R J, SKERRY-RYAN R, BATTENBERG E, et al. Wave-tacotron: Spectrogram-free end-to-end text-to-speech synthesis[C]∥ICASSP 2021 - 2021 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). Toronto, ON, Canada. IEEE, 2021: 5679-5683.

[11]WANG X, TAKAKI S, YAMAGISHI J. Neural source-filter-based waveform model for statistical parametric speech synthesis[C]∥ICASSP 2019-2019 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). Brighton, UK. IEEE, 2019: 5916-5920.

[12]REN Yi, RUAN Yangjun, TAN Xu, et al. FastSpeech: fast, robust and controllable text to speech[EB/OL]. https:∥www.researchgate.net/publication/333309265_FastSpeech_Fast_Robust_and_Controllable_Text_to_Speech,2019.

[13]REN Yi, HU Chenxu, QIN Tao, et al. FastSpeech 2: Fast and high-quality end-to-end text-to-speech[EB/OL]. https:∥www.researchgate.net/publication/342027657_FastSpeech_2_Fast_and_High-Quality_End-to-End_Text-to-Speech,2020.

[14]ELIAS I, ZEN H, SHEN J, et al. Parallel tacotron: Non-autoregressive and controllable TTS[C]∥ICASSP 2021 - 2021 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). Toronto, ON, Canada. IEEE, 2021: 5709-5713.

![]() A. Fastpitch: parallel text-to-speech with pitch prediction[C]∥ICASSP 2021 - 2021 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). Toronto, ON, Canada. IEEE, 2021: 6588- 6592.

A. Fastpitch: parallel text-to-speech with pitch prediction[C]∥ICASSP 2021 - 2021 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). Toronto, ON, Canada. IEEE, 2021: 6588- 6592.

[16]YANG Geng, YANG Shan, LIU Kai, et al. Multi-band melgan: Faster waveform generation for high-quality text-to-speech[C]∥2021 IEEE Spoken Language Technology Workshop (SLT). Shenzhen, China. IEEE, 2021: 492- 498.

[17]HELANDER E, SCHWARZ J, NURMINEN J, et al. On the impact of alignment on voice conversion performance[C]∥Ninth Annual Conference of the International Speech Communication Association, 2008.

[18]CHEN Yining, CHU Min, CHANG E, et al. Voice conversion with smoothed GMM and MAP adaptation[C]∥Eighth European Conference on Speech Communication and Technology, 2003.

[19]HELANDER E, VIRTANEN T, NURMINEN J, et al. Voice conversion using partial least squares regression[J]. IEEE Transactions on Audio, Speech, and Language Processing, 2010, 18(5): 912-921.

[20]AIHARA R, TAKASHIMA R, TAKIGUCHI T, et al. Individuality-preserving voice conversion for articulation disorders based on non-negative matrix factorization[C]∥2013 IEEE International Conference on Acoustics, Speech and Signal Processing. Vancouver, BC, Canada. IEEE, 2013: 8037- 8040.

[21]ERRO D, MORENO A, BONAFONTE A. INCA algorithm for training voice conversion systems from nonparallel corpora[J]. IEEE Transactions on Audio, Speech, and Language Processing, 2010, 18(5): 944-953.

[22]SUN Lifa, LI Kun, WANG Hao, et al. Phonetic posteriorgrams for many-to-one voice conversion without parallel data training[C]∥2016 IEEE International Conference on Multimedia and Expo (ICME). Seattle, WA, USA. IEEE, 2016: 1- 6.

[23]STYLIANOU Y, CAPPE O, MOULINES E. Continuous probabilistic transform for voice conversion[J]. IEEE Transactions on Speech and Audio Processing, 1998, 6(2): 131-142.

[24]KAWAHARA H, ESTILL J, FUJIMURA O. Aperiodicity extraction and control using mixed mode excitation and group delay manipulation for a high quality speech analysis, modification and synthesis system STRAIGHT[C]. Second International Workshop on Models and Analysis of Vocal Emissions for Biomedical Applications, 2001.

[25]ABE M, NAKAMURA S, SHIKANO K, et al. Voice conversion through vector quantization[J]. ICASSP- 88, International Conference on Acoustics, Speech, and Signal Processing, 1988: 655- 658vol.1.

[26]DESAI S, RAGHAVENDRA E V, YEGNANARAYANA B, et al. Voice conversion using Artificial Neural Networks[C]∥2009 IEEE International Conference on Acoustics, Speech and Signal Processing. Taipei, Taiwan, China. IEEE, 2009: 3893-3896.

[27]MORISE M, YOKOMORI F, OZAWA K. WORLD: A vocoder-based high-quality speech synthesis system for real-time applications[J]. IEICE Transactions on Information and Systems, 2016, E99.D(7): 1877-1884.

[28]KALCHBRENNER N, ELSEN E, SIMONYAN K, et al. Efficient neural audio synthesis[EB/OL]. https:∥www.researchgate.net/publication/323392276_Efficient_Neural_Audio_Synthesis,2018.

[29]PRENGER R, VALLE R, CATANZARO B. Waveglow: A flow-based generative network for speech synthesis[C]∥ICASSP 2019 - 2019 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). Brighton, UK. IEEE, 2019: 3617-3621.

[30]YAMAMOTO R, SONG E, KIM J M. Parallel wavegan: A fast waveform generation model based on generative adversarial networks with multi-resolution spectrogram[C]∥ICASSP 2020 - 2020 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). Barcelona, Spain. IEEE, 2020: 6199- 6203.

[31]DONAHUE C, MCAULEY J, PUCKETTE M. Adversarial audio synthesis[EB/OL]. https:∥arxiv.org/abs/1802.04208?context=cs,2018.

[32]KANEKO T, KAMEOKA H. CycleGAN-VC: Non-parallel voice conversion using cycle-consistent adversarial networks[C]∥2018 26th European Signal Processing Conference (EUSIPCO). Rome, Italy. IEEE, 2018: 2100-2104.

[33]HSU C C, HWANG H T, WU Y C, et al. Voice conversion from non-parallel corpora using variational auto-encoder[C]∥2016 Asia-Pacific Signal and Information Processing Association Annual Summit and Conference (APSIPA). Jeju, Korea (South). IEEE, 2016: 1- 6.

[34]CHOU J C, YEH C C, LEE H Y, et al. Multi-target voice conversion without parallel data by adversarially learning disentangled audio representations[C]∥Interspeech 2018. ISCA: ISCA, 2018: 501-505.

[35]QIAN Kaizhi, ZHANG Yang, CHANG Shiyu, et al. AutoVC: zero-shot voice style transfer with only autoencoder loss[EB/OL]. https:∥www.researchgate.net/publication/333130186_AutoVC_Zero-Shot_Voice_Style_Transfer_with_Only_Autoencoder_Loss,2019.

[36]KAMEOKA H, KANEKO T, TANAKA K, et al. StarGAN-VC: Non-parallel many-to-many voice conversion using star generative adversarial networks[C]∥2018 IEEE Spoken Language Technology Workshop (SLT). Athens, Greece. IEEE, 2018: 266-273.

[37]SERR J, PASCUAL S, SEGURA C. Blow: a single-scale hyperconditioned flow for non-parallel raw-audio voice conversion[EB/OL]. https:∥www.researchgate.net/publication/333600086_Blow_a_single-scale_hyperconditioned_flow_for_non-parallel_raw-audio_voice_conversion,2019.

J, PASCUAL S, SEGURA C. Blow: a single-scale hyperconditioned flow for non-parallel raw-audio voice conversion[EB/OL]. https:∥www.researchgate.net/publication/333600086_Blow_a_single-scale_hyperconditioned_flow_for_non-parallel_raw-audio_voice_conversion,2019.

[38]ZHANG Mingyang, ZHOU Yi, ZHAO Li, et al. Transfer learning from speech synthesis to voice conversion with non-parallel training data[J]. IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2021, 29: 1290-1302.

[39]LIN Y Y, CHIEN C M, LIN J H, et al. Fragmentvc: any-to-any voice conversion by end-to-end extracting and fusing fine-grained voice fragments with attention[C]∥ICASSP 2021 - 2021 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). Toronto, ON, Canada. IEEE, 2021: 5939-5943.

[40]CHOU J C, LEE H Y. One-shot voice conversion by separating speaker and content representations with instance normalization[C]∥Interspeech 2019. ISCA: ISCA, 2019: 664- 668.

[41]ZHANG Zining, HE Bingsheng, ZHANG Zhenjie. GAZEV: GAN-based zero-shot voice conversion over non-parallel speech corpus[C]∥Interspeech 2020. ISCA: ISCA, 2020: 791-795.

[42]YUAN Xuejing, CHEN Yuxuan, ZHAO Yue, et al. Commandersong: A systematic approach for practical adversarial voice recognition[C]∥27th {USENIX} Security Symposium ({USENIX} Security 18), 2018: 49- 64.

[43]QIN Yao, CARLINI N, COTTRELL G, et al. Imperceptible, robust, and targeted adversarial examples for automatic speech recognition[C]∥International conference on machine learning. PMLR, 2019: 5231-5240.

[44]CHEN Yuxuan, YUAN Xuejing, ZHANG Jiangshan, et al. Devil’s whisper: A general approach for physical adversarial attacks against commercial black-box speech recognition devices[C]∥29th {USENIX} Security Symposium ({USENIX} Security 20). 2020: 2667-2684.

[45]WANG Qing, GUO Pengcheng, XIE Lei. Inaudible adversarial perturbations for targeted attack in speaker recognition[C]∥Interspeech 2020. ISCA: ISCA, 2020: 4228- 4232.

[46]XIE Yi, SHI Cong, LI Zhuohang, et al. Real-time, universal, and robust adversarial attacks against speaker recognition systems[C]∥ICASSP 2020 - 2020 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). Barcelona, Spain. IEEE, 2020: 1738-1742.

[47]ZHANG Weiyi, ZHAO Shuning, LIU Le, et al. Attack on practical speaker verification system using universal adversarial perturbations[C]∥ICASSP 2021 - 2021 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). Toronto, ON, Canada. IEEE, 2021: 2575-2579.

[48]LIU Songxiang, WU Haibin, LEE H Y, et al. Adversarial attacks on spoofing countermeasures of automatic speaker verification[C]∥2019 IEEE Automatic Speech Recognition and Understanding Workshop (ASRU). Singapore. IEEE, 2019: 312-319.

[49]LI Xu, ZHONG Jinghua, WU Xixin, et al. Adversarial attacks on GMM I-vector based speaker verification systems[C]∥ICASSP 2020 - 2020 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). Barcelona, Spain. IEEE, 2020: 6579- 6583.

[50]VILLALBA J, ZHANG Yuekai, DEHAK N. X-vectors meet adversarial attacks: Benchmarking adversarial robustness in speaker verification[C]∥Interspeech 2020. ISCA: ISCA, 2020: 4233- 4237.

[51]ZHANG Yuekai, JIANG Ziyan, VILLALBA J, et al. Black-box attacks on spoofing countermeasures using transferability of adversarial examples[C]∥Interspeech 2020. ISCA: ISCA, 2020: 4238- 4242.

[52]CHEN Guangke, CHEN Sen, FAN Lingling, et al. Who is real bob? adversarial attacks on speaker recognition systems[J]. 2021 IEEE Symposium on Security and Privacy (SP), 2021: 694-711.

[53]DAS R K, TIAN Xiaohai, KINNUNEN T, et al. The attacker's perspective on automatic speaker verification: An overview[C]∥Interspeech 2020. ISCA: ISCA, 2020: 4213- 4217.

[54]GOMEZ-ALANIS A, GONZALEZ J A, PEINADO A M. Adversarial transformation of spoofing attacks for voice biometrics[C]∥IberSPEECH 2021. ISCA: ISCA, 2021: 255-259.

[55]KINNUNEN T, LEE K A, DELGADO H, et al. t-DCF: a detection cost function for the tandem assessment of spoofing countermeasures and automatic speaker verification[J]. arXiv preprint arXiv:1804.09618, 2018.

[56]陶建华, 傅睿博, 易江燕, 等. 语音伪造与鉴伪的发展与挑战[J]. 信息安全学报, 2020, 5(2): 28-38.

TAO Jianhua, FU Ruibo, YI Jiangyan, et al. Development and challenge of speech forgery and detection[J]. Journal of Cyber Security, 2020, 5(2): 28-38.(in Chinese)

[57]GONG Yuan, YANG Jian, POELLABAUER C. Detecting replay attacks using multi-channel audio: A neural network-based method[J]. IEEE Signal Processing Letters, 2020, 27: 920-924.

[58]JUNG J W, SHIM H J, HEO H S, et al. Replay attack detection with complementary high-resolution information using end-to-end DNN for the ASVspoof 2019 challenge[C]∥Interspeech 2019. ISCA: ISCA, 2019: 1083-1087.

[59]CHEN Tianxiang, KHOURY E. Spoofprint: A new paradigm for spoofing attacks detection[C]∥2021 IEEE Spoken Language Technology Workshop (SLT). Shenzhen, China. IEEE, 2021: 538-543.

[60]TODISCO M, DELGADO H, LEE K A, et al. Integrated presentation attack detection and automatic speaker verification: Common features and Gaussian back-end fusion[C]∥Interspeech 2018. ISCA: ISCA, 2018: 77- 81.

[61]TIAN Xiaohai, WU Zhizheng, XIAO Xiong, et al. Spoofing detection from a feature representation perspective[C]∥2016 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). Shanghai, China. IEEE, 2016: 2119-2123.

[62]LAI C I, CHEN Nanxin, VILLALBA J, et al. ASSERT: anti-spoofing with squeeze-excitation and residual networks[C]∥Interspeech 2019. ISCA: ISCA, 2019: 1013-1017.

[63]YOON S H, YU Hajin. Multiple points input for convolutional neural networks in replay attack detection[C]∥ICASSP 2020 - 2020 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). Barcelona, Spain. IEEE, 2020: 6444- 6448.

[64]VON PLATEN P, TAO Fei, TUR G. Multi-task Siamese neural network for improving replay attack detection[C]∥Interspeech 2020. ISCA: ISCA, 2020: 1076-1080.

[65]WU Zhenzong, DAS R K, YANG Jichen, et al. Light convolutional neural network with feature genuinization for detection of synthetic speech attacks[C]∥Interspeech 2020. ISCA: ISCA, 2020: 1101-1105.

[66]LAI C I, ABAD A, RICHMOND K, et al. Attentive filtering networks for audio replay attack detection[C]∥ICASSP 2019 - 2019 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). Brighton, UK. IEEE, 2019: 6316- 6320.

[67]JIANG Ziyue, ZHU Hongcheng, PENG Li, et al. Self-supervised spoofing audio detection scheme[C]∥Interspeech 2020. ISCA: ISCA, 2020: 4223- 4227.

[68]ALZANTOT M, WANG Ziqi, SRIVASTAVA M B. Deep residual neural networks for audio spoofing detection[C]∥Interspeech 2019. ISCA: ISCA, 2019: 1078-1082.

[69]LI Xu, LI Na, WENG Chao, et al. Replay and synthetic speech detection with Res2Net architecture[C]∥ICASSP 2021 - 2021 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). Toronto, ON, Canada. IEEE, 2021: 6354- 6358.

[70]PARASU P, EPPS J, SRISKANDARAJA K, et al. Investigating light-ResNet architecture for spoofing detection under mismatched conditions[C]∥Interspeech 2020. ISCA: ISCA, 2020: 1111-1115.

[71]WANG Hongji, DINKEL H, WANG Shuai, et al. Dual-adversarial domain adaptation for generalized replay attack detection[C]∥Interspeech 2020. ISCA: ISCA, 2020: 1086-1090.

[72]WANG Xin, YAMAGISHI J. A comparative study on recent neural spoofing countermeasures for synthetic speech detection[C]∥Interspeech 2021. ISCA: ISCA, 2021.

[73]OUYANG Meidan, DAS R K, YANG Jichen, et al. Capsule network based end-to-end system for detection of replay attacks[C]∥2021 12th International Symposium on Chinese Spoken Language Processing (ISCSLP). Hong Kong, China. IEEE, 2021: 1-5.

[74]DOU Yongqiang, YANG Haocheng, YANG Maolin, et al. Dynamically mitigating data discrepancy with balanced focal loss for replay attack detection[C]∥2020 25th International Conference on Pattern Recognition (ICPR). Milan, Italy. IEEE, 2021: 4115- 4122.

[75]HUANG Lian, PUN C M. Audio replay spoof attack detection using segment-based hybrid feature and DenseNet-LSTM network[C]∥ICASSP 2019 - 2019 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). Brighton, UK. IEEE, 2019: 2567-2571.

[76]CHETTRI B, STURM B L, BENETOS E. Analysing replay spoofing countermeasure performance under varied conditions[C]∥2018 IEEE 28th International Workshop on Machine Learning for Signal Processing (MLSP). Aalborg, Denmark. IEEE, 2018: 1- 6.

[77]DUA M, JAIN C, KUMAR S. LSTM and CNN based ensemble approach for spoof detection task in automatic speaker verification systems[J]. Journal of Ambient Intelligence and Humanized Computing, 2021: 1-16.

[78]MA Haoxin, YI Jiangyan, TAO Jianhua, et al. Continual learning for fake audio detection[C]∥Interspeech 2021. ISCA: ISCA, 2021.

[79]ZHANG You, JIANG Fei, DUAN Zhiyao. One-class learning towards synthetic voice spoofing detection[J]. IEEE Signal Processing Letters, 2021, 28: 937-941.

[80]MONTEIRO J, ALAM J, FALK T H. An ensemble based approach for generalized detection of spoofing attacks to automatic speaker recognizers[C]∥ICASSP 2020 - 2020 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). Barcelona, Spain. IEEE, 2020: 6599- 6603.

[81]LEI Zhenchun, YANG Yingen, LIU Changhong, et al. Siamese convolutional neural network using Gaussian probability feature for spoofing speech detection[C]∥Interspeech 2020. ISCA: ISCA, 2020: 1116-1120.

[82]TAK H, PATINO J, NAUTSCH A, et al. Spoofing attack detection using the non-linear fusion of sub-band classifiers[C]∥Interspeech 2020. ISCA: ISCA, 2020: 1106-1110.

[83]ZHANG You, ZHU Ge, JIANG Fei, et al. An empirical study on channel effects for synthetic voice spoofing countermeasure systems[C]∥Interspeech 2021. ISCA: ISCA, 2021.

[84]WITKOWSKI M, KACPRZAK S, ![]() P, et al. Audio replay attack detection using high-frequency features[C]∥Interspeech 2017. ISCA: ISCA, 2017: 27-31.

P, et al. Audio replay attack detection using high-frequency features[C]∥Interspeech 2017. ISCA: ISCA, 2017: 27-31.

[85]CHEN Tianxiang, KUMAR A, NAGARSHETH P, et al. Generalization of audio deepfake detection[C]∥Odyssey 2020 The Speaker and Language Recognition Workshop. ISCA: ISCA, 2020: 1-5.

[86]TAK H, JUNG J W, PATINO J, et al. Graph attention networks for anti-spoofing[C]∥Interspeech 2021. ISCA: ISCA, 2021.

[87]SHIM H J, HEO H S, JUNG J W, et al. Self-supervised pre-training with acoustic configurations for replay spoofing detection[C]∥Interspeech 2020. ISCA: ISCA, 2020: 1091-1095.

[88]WU Zhizheng, CHNG E S, LI Haizhou. Detecting converted speech and natural speech for anti-spoofing attack in speaker recognition[C]∥Interspeech 2012. ISCA: ISCA, 2012.

[89]KRAWCZYK M, GERKMANN T. STFT phase reconstruction in voiced speech for an improved single-channel speech enhancement[J]. IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2014, 22(12): 1931-1940.

[90]SANCHEZ J, SARATXAGA I, HERN EZ I, et al. Toward a universal synthetic speech spoofing detection using phase information[J]. IEEE Transactions on Information Forensics and Security, 2015, 10(4): 810- 820.

EZ I, et al. Toward a universal synthetic speech spoofing detection using phase information[J]. IEEE Transactions on Information Forensics and Security, 2015, 10(4): 810- 820.

[91]PATEL T B, PATIL H A. Combining evidences from mel cepstral, cochlear filter cepstral and instantaneous frequency features for detection of natural vs. spoofed speech[C]∥Sixteenth annual conference of the international speech communication association, 2015.

[92]TODISCO M, DELGADO H, EVANS N. A new feature for automatic speaker verification anti-spoofing: Constant Q cepstral coefficients[C]∥Odyssey 2016. ISCA, 2016: 283-290.

[93]GAO Yang, VUONG T, ELYASI M, et al. Generalized spoofing detection inspired from audio generation artifacts[C]∥Interspeech 2021. ISCA: ISCA, 2021.

[94]YANG Jichen, DAS R K, ZHOU Nina. Extraction of octave spectra information for spoofing attack detection[J]. IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2019, 27(12): 2373-2384.

[95]YANG Jichen, DAS R K. Long-term high frequency features for synthetic speech detection[J]. Digital Signal Processing, 2020, 97: 102622.

[96]DAS R K, YANG Jichen, LI Haizhou. Assessing the scope of generalized countermeasures for anti-spoofing[C]∥ICASSP 2020 - 2020 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). Barcelona, Spain. IEEE, 2020: 6589- 6593.

[97]KWAK I Y, KWAG S, LEE J, et al. ResMax: detecting voice spoofing attacks with residual network and max feature map[C]∥2020 25th International Conference on Pattern Recognition (ICPR). Milan, Italy. IEEE, 2021: 4837- 4844.

[98]YANG Jichen, DAS R K, LI Haizhou. Significance of subband features for synthetic speech detection[J]. IEEE Transactions on Information Forensics and Security, 2020, 15: 2160-2170.

[99]LE P N, AMBIKAIRAJAH E, EPPS J, et al. Investigation of spectral centroid features for cognitive load classification[J]. Speech Communication, 2011, 53(4): 540-551.

[100]GUNENDRADASAN T, WICKRAMASINGHE B, LE N P, et al. Detection of replay-spoofing attacks using frequency modulation features[C]∥Interspeech 2018. ISCA: ISCA, 2018: 636- 640.

[101]KUMAR A K, PAUL D, PAL M, et al. Speech frame selection for spoofing detection with an application to partially spoofed audio-data[J]. International Journal of Speech Technology, 2021, 24(1): 193-203.

[102]TOM F, JAIN M, DEY P. End-to-end audio replay attack detection using deep convolutional networks with attention[C]∥Interspeech 2018. ISCA: ISCA, 2018: 681- 685.

[103]GOMEZ-ALANIS A, PEINADO A M, GONZALEZ J A, et al. A light convolutional GRU-RNN deep feature extractor for ASV spoofing detection[C]∥Interspeech 2019. ISCA: ISCA, 2019: 1068-1072.

[104]TAK H, PATINO J, TODISCO M, et al. End-to-End anti-spoofing with RawNet2[C]∥ICASSP 2021 - 2021 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). Toronto, ON, Canada. IEEE, 2021: 6369- 6373.

[105]WU Haibin, LIU Songxiang, MENG H, et al. Defense against adversarial attacks on spoofing countermeasures of ASV[C]∥ICASSP 2020 - 2020 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). Barcelona, Spain. IEEE, 2020: 6564- 6568.

[106]WU Xiang, HE Ran, SUN Zhenan, et al. A light CNN for deep face representation with noisy labels[J]. IEEE Transactions on Information Forensics and Security, 2018, 13(11): 2884-2896.

[107]HU Jie, SHEN Li, SUN Gang. Squeeze-and-excitation networks[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City, UT, USA. IEEE, 2018: 7132-7141.

[108]SUBRAMANI N, RAO D. Learning efficient representations for fake speech detection[J]. Proceedings of the AAAI Conference on Artificial Intelligence, 2020, 34(4): 5859-5866.

[109]HEMAVATHI R, KUMARASWAMY R. Voice conversion spoofing detection by exploring artifacts estimates[J]. Multimedia Tools and Applications, 2021: 1-20.

[110]LUO Anwei, LI Enlei, LIU Yongliang, et al. A capsule network based approach for detection of audio spoofing attacks[C]∥ICASSP 2021 - 2021 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). Toronto, ON, Canada. IEEE, 2021: 6359- 6363.

[111]GOMEZ-ALANIS A, GONZALEZ-LOPEZ J A, PEINADO A M. A kernel density estimation based loss function and its application to ASV-spoofing detection[J]. IEEE Access, 2020, 8: 108530-108543.

[112]TAPKIR P, PATIL H. Novel empirical mode decomposition cepstral features for replay spoof detection[C]∥Interspeech 2018. ISCA: ISCA, 2018: 721-725.

[113]KAMBLE M, TAK H, PATIL H. Effectiveness of speech demodulation-based features for replay detection[C]∥Interspeech 2018. ISCA: ISCA, 2018: 641- 645.

[114]KAMBLE M R, PATIL H A. Analysis of reverberation via teager energy features for replay spoof speech detection[C]∥ICASSP 2019 - 2019 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). Brighton, UK. IEEE, 2019: 2607-2611.

[115]ACHARYA R, KOTTA H, PATIL A T, et al. Cross-teager energy cepstral coefficients for replay spoof detection on voice assistants[C]∥ICASSP 2021 - 2021 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). Toronto, ON, Canada. IEEE, 2021: 6364- 6368.

[116]PRAJAPATI G P, KAMBLE M R, PATIL H A. Energy separation based features for replay spoof detection for voice assistant[C]∥2020 28th European Signal Processing Conference (EUSIPCO). Amsterdam, Netherlands. IEEE, 2021: 386-390.

[117]WITKOWSKI M, KACPRZAK S, ZELASKO P, et al. Audio Replay Attack Detection Using High-Frequency Features[C]∥Interspeech. 2017. ISCA: ISCA, 2017: 27-31.

[118]LAVRENTYEVA G, NOVOSELOV S, MALYKH E, et al. Audio-replay attack detection countermeasures[C]∥International conference on speech and computer. Springer, Cham, 2017: 171-181.

[119]JI Zhe, LI Z Y, LI Peng, et al. Ensemble Learning for Countermeasure of Audio Replay Spoofing Attack in ASVspoof2017[C]∥Interspeech. 2017. ISCA: ISCA, 2017: 87-91.

[120]CAI Weicheng, CAI Danwei, LIU Wenbo, et al. Countermeasures for automatic speaker verification replay spoofing attack: On data augmentation, feature representation, classification and fusion[C]∥Interspeech. 2017. ISCA: ISCA, 2017: 17-21.

[121]SHIOTA S, VILLAVICENCIO F, YAMAGISHI J, et al. Voice liveness detection algorithms based on pop noise caused by human breath for automatic speaker verification[C]∥Sixteenth annual conference of the international speech communication association, 2015.

[122]CHEN Si, REN Kui, PIAO Sixu, et al. You can hear but You cannot steal: Defending against voice impersonation attacks on smartphones[C]∥2017 IEEE 37th International Conference on Distributed Computing Systems (ICDCS). Atlanta, GA, USA. IEEE, 2017: 183-195.

[123]FENG Huan, FAWAZ K, SHIN K G. Continuous authentication for voice assistants[C]∥Proceedings of the 23rd Annual International Conference on Mobile Computing and Networking. Snowbird Utah USA. New York, NY, USA: ACM, 2017: 343-355.

[124]LEI Xinyu, TU GUAN-HUA, LIU A X, et al. The insecurity of home digital voice assistants-Amazon alexa as a case study[EB/OL]. https:∥www.researchgate.net/publication/321745125_The_Insecurity_of_Home_Digital_Voice_Assistants_-_Amazon_Alexa_as_a_Case_Study,2017.

[125]LI Xu, LI Na, ZHONG Jinghua, et al. Investigating robustness of adversarial samples detection for automatic speaker verification[C]∥Interspeech 2020. ISCA: ISCA, 2020.

[126]WU Haibin, LIU A T, LEE H Y. Defense for black-box attacks on anti-spoofing models by self-supervised learning[C]∥Interspeech 2020. ISCA: ISCA, 2020: 3780-3784.

[127]LIU A T, LI Shangwen, LEE Hongyi. Tera: self-supervised learning of transformer encoder representation for speech[J]. arXiv preprint arXiv:2007.06028, 2020.

[128]WU Haibin, LI Xu, LIU A T, et al. Adversarial defense for automatic speaker verification by cascaded self-supervised learning models[J]. ICASSP 2021-2021 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP), 2021: 6718- 6722.

[129]WU Haibin, LI Xu, LIU A T, et al. Adversarial defense for automatic speaker verification by self-supervised learning[EB/OL]. https:∥arxiv.org/abs/2106.00273v1,2021.

[130]AKIMOTO K, LIEW S P, MISHIMA S, et al. POCO: A voice spoofing and liveness detection corpus based on pop noise[C]∥Interspeech 2020. ISCA: ISCA, 2020: 1081-1085.

[131]HAYASHI T, YAMAMOTO R, INOUE K, et al. Espnet-TTS: Unified, reproducible, and integratable open source end-to-end text-to-speech toolkit[C]∥ICASSP 2020-2020 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). Barcelona, Spain. IEEE, 2020: 7654-7658.

[132]KOBAYASHI K, HUANG W C, WU Y C, et al. Crank: an open-source software for nonparallel voice conversion based on vector-quantized variational autoencoder[C]∥ICASSP 2021 - 2021 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). Toronto, ON, Canada. IEEE, 2021: 5934-5938.

[133]KIM J, KIM S, KONG J, et al. Glow-TTS: A generative flow for text-to-speech via monotonic alignment search[EB/OL]. https:∥www.researchgate.net/publication/341615271_Glow-TTS_A_Generative_Flow_for_Text-to-Speech_via_Monotonic_Alignment_Search,2020.

[134]LIN J H, LIN Y Y, CHIEN C M, et al. S2VC: A framework for any-to-any voice conversion with self-supervised pretrained representations[C]∥Interspeech 2021. ISCA: ISCA, 2021.