1 引言

随着信息技术的快速发展和普及,人们越来越倾向于通过公共社交网络平台如脸书、微博等来发布和获取世界各地的最新消息。这为人们的日常生活和交流带来极大便利的同时也导致了虚假信息的泛滥问题。虚假信息的传播轻则导致误解和误判,重则影响社会稳定甚至国家安全。例如在2020年的新冠肺炎疫情防控期间,关于疫情的谣言、虚假新闻等信息的传播[1]给社会带来巨大恐慌和潜在危害。因此,研究针对网络虚假信息的取证技术对于净化网络空间,维护社会和国家稳定具有重要意义和价值。

近年来,人工智能技术的发展为虚假信息的产生提供了新技术,使得所产生的虚假信息更加隐蔽和难检测。产生虚假信息的原因有很多,最主要的原因是因为创建虚假信息的成本非常低廉[2],而网络用户鉴别虚假信息的难度和成本非常高。同时,很多心理因素例如从众效应等也在潜移默化中影响人们对这些虚假信息的判断[3],促使社交媒体用户普遍倾向于不经严格考证就传播这些未经证实的信息[4],导致虚假信息可以在创建之后迅速传播。最后,虚假信息的广泛传播通常会给发布者带来很多利益[5- 6],这个事实又刺激了更多的人加入到创建和传播虚假信息的过程中,导致虚假信息进一步泛滥,这也使得虚假信息的种类众多且成因复杂。总而言之,多方面的原因共同导致这些错误的信息在网络上大行其道。又因为“注意力经济”的原因,这些虚假信息会不断地挤压真实信息的生存空间,起到“劣币驱逐良币”的作用。因此,研究针对网络虚假言论的高效且精准的取证技术刻不容缓。

实际上,虚假信息的泛滥已经引起了世界各国学者的广泛关注和高度重视,人们从包括行为学、心理学、工程学、计算机科学等多个角度对其进行研究。然而,近两年人工智能技术的飞速发展使得虚假信息的伪造更加隐蔽。基于深度学习的虚假信息制造方法,可以通过不断训练和调整判别器的输出,使得生成的虚假信息更具欺骗性,从而有效避开一些已有的取证方法,这给当前的虚假信息取证技术带来极大挑战。

虚假信息的种类有很多,通常可以根据载体类别进行划分,例如视频虚假信息、图像虚假信息、语音虚假信息、文本虚假信息等。考虑到语言是人类最主要也是最独特的交流方式,因此本文主要关注网络虚假言论的取证技术。而语音和文字分别是人类语言的两种主要表现形式,故而我们将分别从文本和语音两方面综述网络虚假言论取证相关的研究成果。

2 网络虚假文本取证

2.1 相关概念

虚假文本信息可以是来自于社交媒体平台的虚假消息,也可以是来自新闻网站的虚假新闻。例如,在2020年初新冠疫情期间,曾广泛流传“今晚9时30分,央视新闻频道,白岩松主持《新型冠状病毒肺炎》专题现场直播,邀请钟南山院士介绍疫情,请届时收看。”的虚假信息。这些虚假信息仅仅依靠普通用户难以鉴别,因此亟需更加智能化的取证手段对网络流传的信息进行精准的智能检测。虽然我们关注的重点是虚假文本取证,但其中所涉及的方法并不局限于单一地从文本的角度对其检测,还考虑到这些虚假文本信息在网络中的传播模式。因此,本节将分别从虚假文本本身和其传播模式两方面对虚假文本取证进行一个综合考察。为了更好地理解虚假文本信息的取证工作,我们首先需要区别一些广泛使用且意义相近的概念。虚假信息的英文名称是“disinformation”,与错误信息“misinformation”的含义有所区别。虚假信息和错误信息都是指非真实的信息,但前者是指创建者本身有意虚构事实而后者是创建者无意间篡改事实[7]。与其相关的概念还包括虚假新闻(fake news)和假新闻(false news),其中的区别类似于虚假信息和错误信息,即分别带有有意的或无意的非真实事实,不同的是这两者更具体的指代新闻这一信息类型。另外一个相关概念是谣言(rumors),Shu等人[2]认为谣言是“为了达到某种目的,正在流传的未经验证的信息论述”。该定义与前文所提虚假信息的定义相接近,但是强调了信息不一定是不真实的信息,而是未经验证的、没有充分证据来说明的信息。本文将虚假信息定义为“带有非真实事实并且有意误导他人的信息”。这个定义包含了虚假信息和虚假新闻,与谣言的定义有一部分重合,但是又与错误信息、假新闻有一定区别。在此虚假信息定义的基础上,虚假文本信息指的是“带有非真实事实并且有意误导他人的文本信息”。

2.2 网络虚假文本取证技术

本文将目前常见的虚假文本取证方法分为三大类:基于事件真实性校验、基于文本语言特征表示以及基于信息传播模式挖掘。基于事件真实性校验的取证方法主要针对虚假文本描述的客观事件进行真实性校验,验证其描述的事件内容是否是真实的。基于文本语言特征表示的取证方法主要通过提取和分析虚假文本的语言特征来进行判断。上述两类方法均仅从虚假文本自身进行考虑,第三类方法则是从传播的角度对虚假文本进行分析。通常,虚假信息由于其带有创建者的主观意图,因此其传播模式会和真实信息不同。例如,虚假新闻的传播速度比真实新闻更快,传播范围也更广。因此,第三类方法主要是从传播模式挖掘的角度对虚假文本进行取证。下面我们逐一对各类方法的相关研究成果进行综述和分析。

2.2.1 基于事件真实性校验的虚假文本取证

虚假文本信息中很大一部分属于事实伪造,因此最朴素的一种思想是通过检验文本信息内所包含事件的真实性来判断该文本是否为虚假文本,这种方法称为事实检测(fact-checking)[8-9]。最初的基于事件真实性校验的虚假文本取证方法采用的是人工检测,包括基于专家经验的事实检测和基于众包(crowd-sourced)的事实检测。前者依赖于领域专家作为事实检测者来验证给定的信息内容,而后者则依赖于大量普通个人充当事实检测者。这些方式的事实检测服务实际上已经有很多网站提供[10]。但是,这类方法难以适应互联网上迅速膨胀的信息数量。在此基础上,更多的人开始考虑自动事实检测这一思路。

自动事实检测方法主要利用三元组(主实体(Subject),关系(Predicate),客实体(Object))来代表事件知识[11]。其中主实体和客实体均指代实体(entity),关系指代主实体和客实体之间的关联关系。事实则是指结果为真的三元组知识。这些事实一同构成了一个知识库(KB, Knowledge Base)[12],同时这些事实所包含的所有实体和关系分别以节点和边的形式构成了知识图谱(KG, Knowledge Graph)[13]。事实检测过程中需要将已有的知识和待检测文本中提取出的知识进行对比校验。因此,文本信息的自动事实检测可以分为两个阶段:事实抽取(fact extraction)和事实校验(fact verification)。

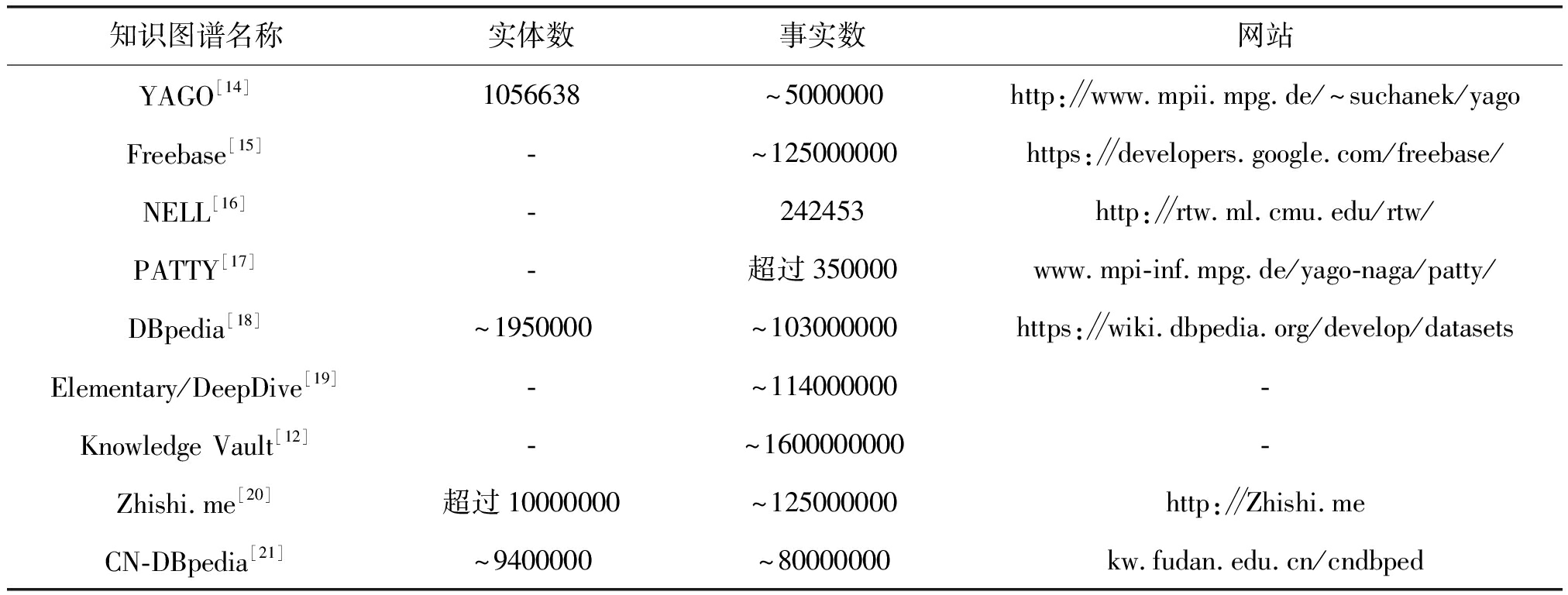

事实抽取,也称作关系提取(relation extraction)。旨在从非结构化文本和其他结构化或半结构化来源发现和识别文本中的实体和关系以构建知识图谱。良好的大规模的知识图谱可以为事实检测的工作铺平道路。构建这些知识图谱往往需要从开放的网页上收集大量的事实,并对这些收集到的内容进行适当的清洗,这些网页源可以选择单一的源如维基百科,这会使得知识库的置信度比较高,但不够完备;相反,如果选择复合的多个源,会使得其置信度降低,但完备性提高。构建知识库和知识图谱是一个较为复杂的过程,事实上,这部分工作已经有很多研究,并且构建了常用的一些知识图谱可供使用,如表1。

表1 用于事件真实性校验的知识图谱汇总[10-11]

Tab.1 A summary of fact-checking based knowledge graph[10-11]

知识图谱名称实体数事实数网站YAGO[14]1056638~5000000http:∥www.mpii.mpg.de/~suchanek/yagoFreebase[15]-~125000000https:∥developers.google.com/freebase/NELL[16]-242453http:∥rtw.ml.cmu.edu/rtw/PATTY[17]-超过350000www.mpi-inf.mpg.de/yago-naga/patty/DBpedia[18]~1950000~103000000https:∥wiki.dbpedia.org/develop/datasetsElementary/DeepDive[19]-~114000000-Knowledge Vault[12]-~1600000000-Zhishi.me[20]超过10000000~125000000http:∥Zhishi.meCN-DBpedia[21]~9400000~80000000kw.fudan.edu.cn/cndbped

事实校验是指为了判断文本内容的真实性,我们需要将其中提取的待验证的知识和知识库中已有的事实进行比较。在目前大多数基于事实校验的研究中,最常使用的数据集为FEVER[22-23],其中声明了185445个知识,被用来评估事实校验系统基于所提供的事实证据验证所声明事件知识的能力。通常,事实检验任务在基于事实真实性校验的虚假文本取证中可以分为两个步骤,证据检索和声明验证。前者要求系统从知识库或知识图谱中返回与声明相关的语句作为证据,而后者则是在给定的证据下对声明的真实性进行验证。这些验证往往会有三种结果:“支持(support)”、“反对(refute)”和“信息不足(not enough info)”。

由于已有的系统在证据检索阶段已经表现得十分出色[24-25],因此现在更多的研究集中于声明验证的阶段。事实校验任务直观上与自然语言推理[26](NLI, Natural Language Inference)任务十分接近。自然语言推理是一项判断前提与假设之间语义相关性的任务。因此自然语言推理的模型可以被用在事实校验中[25]。如Thorne等人[23]通过拼接所有证据语句后使用NLI模型来检测其与声明之间的相关性,Yin和Roth [27]提出了针对事实检测的端到端的架构,认为联合训练证据选择和声明验证阶段可以提高性能,而Hidey和Diab[28]、Nie等人[29]则建议以多任务方式训练上述两个部分。Luken等人[30]则提取每个证据-声明对的特征并采用一种可分解的注意力模型(DAM, Decomposable Attention Model)进行验证。随后又选择了比DAM更有效的ESIM[31] (Enhanced Sequence Inference Model)模型[25],同时在原来的基础上进一步考虑证据的额外特征,形成 NSMN(Neural Semantic Matching Network)的方法[24]。此外预训练语言模型[32-33]也可以提高预测的准确性,如:将BERT[32] (Bidirectional Encoder Representations from Transformers)应用到每个声明-证据对的编码中,然后使用多层感知层来预测和聚合结果[35-36]。同样基于BERT,再加上图注意力网络[36]来聚合下游推理的句子特征[37-38]也能提高最终的检测效果。利用相似的思路,也可以使用分割的句子作为节点,在语义级别分别为声明和证据构造图[39],以此来提高性能。Chen等人[40]则摒弃了前面将句子视作节点的方法,而是将实体视为节点,提取更细粒度的特征来进行事实校验。考虑到基于语义相似检验方法的局限性,又进一步吸收对比学习的方法,在区分相似性语句上取得更好的结果[41]。

通常来说,基于事件真实性校验的虚假文本取证虽然可以检测出信息中事件的真实性,但仍然有部分弊端。其一,很多虚假信息,尤其是虚假新闻,其中的事实往往是具有时效性的最新消息而非一些常识,因此即使知识库或者知识图谱可以基于已有的知识推理,在某些即时消息上仍然不能准确判断。其二,基于事件真实性校验过程的基本假设是“知识库中的内容全部是真实的”,但事实上,这部分事实仍有可能出错,在Knowledge Vault[12]知识库中,有约1.6B个三元组,其中271M事实的置信度为0.9或者更高,324M为0.7或者更高,这意味着还有大量的事实置信度不足0.7。而且,这个问题往往会随着知识图谱的膨胀而更加严重。

2.2.2 基于语言特征表示的虚假文本取证

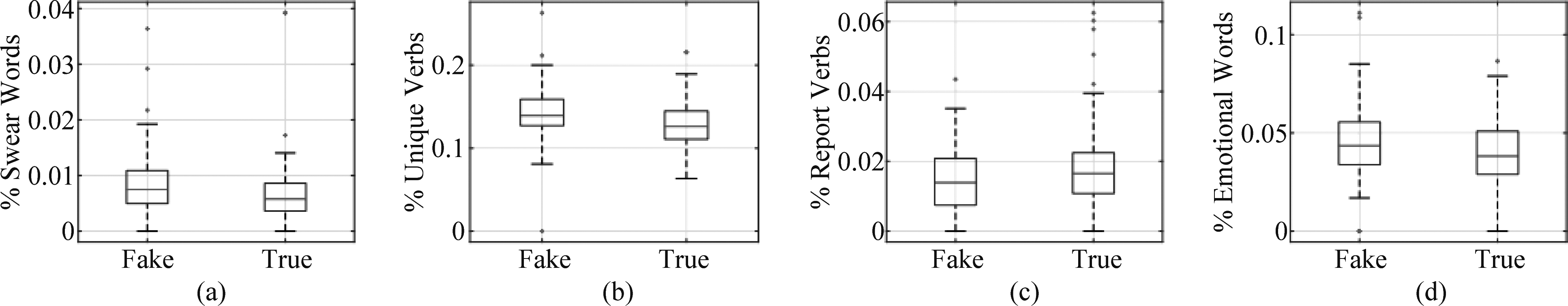

基于语言特征表示的虚假文本取证主要是通过抽取和分析文本的语义表示,通过检测文本语义表达来判断是否是虚假文本。基于事实的虚假文本取证主要是评估给定文本内容的真实性,而基于语言特征表示的虚假文本取证则是通过抽取和分析虚假文本的语言表达特征,例如写作风格,来区分是否为虚假文本(如图1)。由于基于语言特征表示的虚假文本取证方法是根据一组特征来进行训练和预测文本是否为虚假文本,因此特征的选择和提取对最终分类效果至关重要。概括地说,文本特征可以分为显式特征和隐式特征。

图1 该图来自参考文献[43].图中反映虚假新闻特征,(a)(b)(c)(d)分别在:(1)非正式性:脏话单词数;(2)多样性:非 重复动词数;(3)主观性:汇报类动词数(如announce等);(4)情绪化程度:情绪词数四个方面表示虚假新闻和真实新闻差别

Fig.1 This Figure is from reference[43].The feature of fake news, (a) (b) (c) (d) respectively indicate the difference between fake news and true news in four aspects: (1) Informality: the number of swear words; (2) Diversity: the number of non-repetitive verbs; (3) Subjectivity: the number of reporting verbs (such as announce, etc.); (4) Emotional degree: the difference in the number of emotional words

显式文本特征通常被用于传统机器学习框架下的虚假文本取证。这些特征从语言的四个层面描述了文本风格:词汇(lexicon)、语法(syntax)、语篇(discourse)和语义(semantic) [43- 44]。(1)在词汇层面主要是通过使用词袋特征 (BOW, bag-of-world) [43]确定词汇的统计频率来表示文本特征。(2)在语法层面,可以通过词性标注(POS, part-of-speech taggers)并求出词性标注的频率来完成[43- 44],也可以通过构造概率上下文无关文法(PCFG, Probabilistic Context-Free Grammar)分析树并计算重写规则的频率来实现[45]。(3)在语篇层面,修辞结构理论(RST, rhetorical structure theory)和修辞分析工具可以被用来捕获句子间的修辞关系频率作为特征[46]。(4)语义层面则可以考虑每个词汇或短语的心理语言类别并通过LIWC(linguistic inquiry and word count)方法[45]进行表示,也可以考虑TF-IDF[45] (Term Frequency-Inverse Document Frequency)以及word2vec[47]来实现表示。这些特征往往不会单独地使用,而是在传统的机器学习框架下同时提取多个特征来对虚假文本的意图进行判定,例如文献[44,46]使用了多种特征组合在XGBoost(eXtreme Gradient Boosting)和随机森林(RF, Random Forest)的框架下对虚假文本进行取证,而Mouratidis等[48]则采用了支持向量机(SVM, Support Vector Machine)、RF、朴素贝叶斯方法并进行了分析和评估。

隐式文本特征通常用文本的嵌入式特征向量表示语义。这种嵌入过程可以在词汇级别[49-50]、语句级别[51-52]或者文章级别[52]执行,最终的结果是得到表示文本语义的特征向量。然后构建分类器,以鉴别输入文本为真实文本或者虚假文本。近两年,随着神经网络技术的发展,基于神经网络的虚假文本取证模型得到了广泛的应用。例如,在文献[53-55]中利用卷积神经网络(CNN, Convolutional Neural Network)实现了虚假文本取证。Cho等[56]、Alkhodair等[57]以及Choudhary等[58]利用循环神经网络(RNN, Recurrent Neural Network)也实现了虚假文本的取证。Aslam等[59]则使用了长短时记忆(LSTM, Long-short term memory)以及GRU(Gate Recurrent Unit)来提取句子特征。基于Transformer的虚假文本取证模型[32,60]也是一种可行的方法,例如文献[61]中使用BERT来提取语言特征,而Kaliyar等[62]则将BERT和卷积神经网络进行融合以此来提高检测效果。另外,也可以通过矩阵或者张量分解[63]来提取这种隐式文本特征,并实现虚假文本的取证。除此之外,也有方法考虑多个角度如图像和文本以此实现了一种复合模型来对虚假文本进行检测[18,64]。

2.2.3 基于传播模型的虚假文本取证

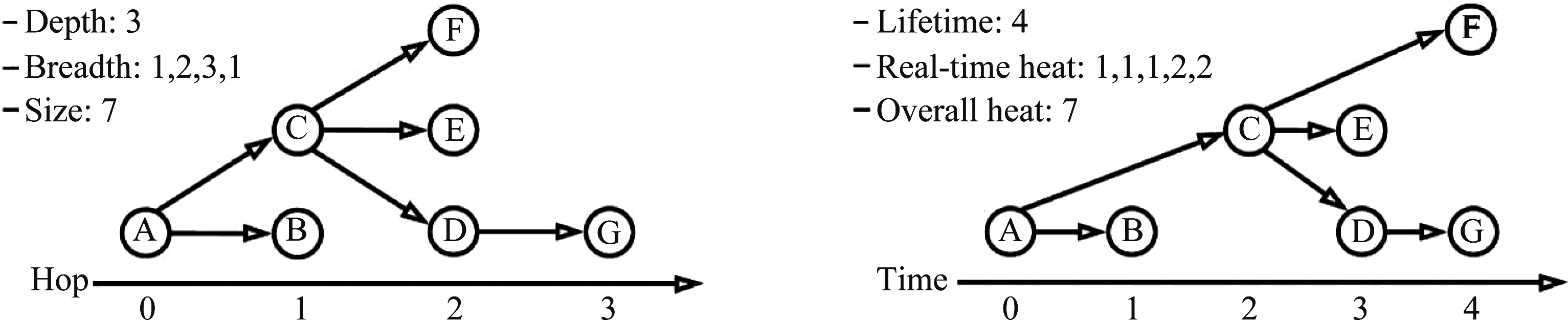

除了基于文本内容的取证方式以外,还有研究人员从信息传播的视角来检测虚假信息,通过研究和利用与虚假信息扩散相关的信息来分辨出真实信息和虚假信息的差别。有研究表 明:(1)未经证实的信息往往会经过多次分享,而真实信息在传播过程中通常只有一个突出的峰值[4,65];(2)虚假信息要比真实信息传播得更快更远;(3)政治虚假信息比其他任何虚假信息传播得更远、更快、更广[66]。

这些虚假信息传播的形式可以直接地表示为树或者类似树的结构(如图2),也称作新闻级联[66- 67],但广义上讲,不仅仅虚假新闻适用于这种形式,虚假信息往往也能够通过这种形式进行表示。需要指出的是,由于存在多个初始发布者的原因,特定的新闻文章可以同时产生多个新闻级联。更进一步,新闻级联中的每个节点还可以带有额外的属性,例如表明每个用户的立场是支持还是反对,每个用户的配置信息以及历史的帖子和评论等。

图2 虚假新闻级联,该图源自于参考文献[56]

Fig.2 Fake news cascade, the

Figure is derived from reference[56]

基于传播模型的虚假文本取证可以使用传统的机器学习方法。用一系列特征把这种级联进行恰当的表示,随后输入到如 SVM[65,68]、决策树[69]、朴素贝叶斯[69]以及随机森林[65]的方法中来对虚假信息进行取证。除此之外,也可以对正常信息和虚假信息的传播过程做一个比较,即通过计算两者传播过程的相似性来检测真实信息和虚假信息,如Vishwanathan等[70]利用图核来计算两者的相似性,Wu 等[68]则利用随机游走图核来计算,而Ma等[71]则使用传播树核的方法来进行计算和检测。

更进一步,可以考虑深度学习模型,如Wu等[72]将LSTM融入RNN来对虚假信息进行检测,Liu等[73]则选择同时利用RNN和CNN进行检测。另外也可以通过构造基于新闻级联的一种树结构的递归神经网络来对虚假信息进行检测[67,74]。Lu等[75]使用GRU和CNN 来学习传播表示,从而对虚假信息进行检测。比新闻级联更加广义的表示是图。随着图神经网络技术的发展,很多利用传播图的检测技术也逐渐产生,例如文献[76]利用图神经网络分析虚假信息的传播模式来检测虚假信息,而Sahoo等[77]则使用了几何深度学习的方法依据传播模式对虚假信息进行检测,Silva[78]为传播网络中的节点和级联分配不同级别的重要性以此尝试在传播前期对虚假信息进行取证。

与前两者基于文本的取证方法不同,由于虚假信息的传播往往难以由创建者所控制,因此传播模型的特征相较于文本特征更难以隐藏。但是,虚假信息的传播并非是所期望的事情,传播时间越长,检测效果越准确,但负面影响也就越大。因此,基于传播模型的虚假信息取证很难对虚假信息做一个早期的检测和预防。当这种方法检测出虚假信息时,往往虚假信息已经传播得较为广泛且难以干预了。

3 网络虚假音频取证

3.1 相关概念

近年来,语音伪造(或语音生成)技术进展显著。从效果上看,部分深度伪造(生成)的语音已达到“以假乱真”的程度,标志着该类技术已步入新的发展与应用阶段。首先,需要澄清的是,这里的语音伪造和语音生成具有相同的内涵,都是指借助计算机产生符合预期的语音。所谓的“符合预期”,要看具体应用场景。先看下面四类典型的应用场景:

1)在机场广播语音场景,其“预期”是让乘客在嘈杂的环境中获取航班信息等,对语音的可懂度和清晰度要求较高。即便乘客能够觉察出广播语音并非播音员而是计算机合成的语音,这并不影响乘客对信息的获取,是符合预期的。

2)在影视制作场景,代表性的案例是《速度与激情7》。在影片拍摄进度过半时,主演保罗·沃克意外去世,为环球影业提出了严峻的挑战。仅从声音的角度考虑,这里的“预期”是通过计算机,在电影制作中生成保罗·沃克的语音,保持人物的连贯性与一致性,并让观众难以察觉,以保持艺术水准与追求商业价值。

3)在电话诈骗场景,2019年《华尔街日报》报道,有犯罪分子利用语音伪造技术成功诈骗了英国能源公司22万欧元。这里的“预期”是通过计算机,生成特定目标人的语音,并诱导听者相信这是目标人的真实语音,以达到诈骗的目标。

4)在淘宝、支付宝和腾讯微信的声纹验证场景,意图不轨的人可利用计算机伪造机主的语音,预期是欺骗自动身份验证环节。

在上述场景中,场景1和2中的语音不含“主观恶意”,可使用语音生成这类中性的表述;场景3和4中的语音含有“主观恶意”,常使用语音伪造这类带贬义倾向的表述。场景1和场景2、3的不同之处在于:场景1重点关注语音的可懂度与清晰度。至于是否与真人发声类似,则不重要;场景2、3更关注语音与目标人的真实语音是否“像”,能否欺骗人类。至于语音的可懂度、清晰度和流畅度等指标,则不重要。例如,如果目标人有口吃,那么场景2、3下伪造(生成)的语音也应该在强度、停顿等声学特征上符合目标人口吃的特点。实际上,场景2和3所要解决的问题是欺骗人类的感知与认知,让计算机生成的语音符合常识与记忆,这非常具有挑战性。

近年来,以深度学习为特色的语音伪造(或语音生成)技术进步也主要体现在这点上。以往,为了伪造(生成)目标人语音,往往需要语音专家的长时间编辑与处理。现在,只要满足数据条件,就能自动生成预期语音。场景1、2、3和场景4的不同之处在于:场景1、2、3中语音的作用对象是人,而场景4中语音的作用对象是机器。对机器的攻击,实际上是寻找目标机器算法的漏洞。依据目标机器算法是否已知,可分为白盒攻击和黑盒攻击。白盒攻击是指已知目标机器算法,通过梯度下降、强化学习等,有针对性的破解。黑盒攻击往往依赖于大量的随机尝试,而实用系统的封号机制限制了攻击次数,从而保证验证或识别服务的安全性。以场景2和场景3为代表的,以欺骗人类感知和认知为目标的语音伪造(生成)技术,是本文关注的重点。

语音伪造(生成)技术往往与图像、视频伪造(生成)技术联合使用,通过多模态的手段增加数字媒体的可信度,使人更难以识别真假。尤其是恶意使用音视频伪造技术,为网络安全与个人隐私带来极大的挑战,已成为令人不安的社会问题,受到政府和产业界的密切关注。针对该问题,2016年,隶属于美国国防部的国防高级研究计划局(DARPA, Defense Advanced Research Projects Agency)启动了大规模媒体取证项目(MediFor, Large-scale Media Forensic)以促进媒体完整性研究。项目提出,媒体完整性包括物理完整性、数字完整性和语义完整性,分别从物理准则、采集处理和语义语境角度审视数字媒体,明晰了数字内容取证的三类准则。美国国家标准技术署(NIST, National Institute of Standards and Technology)随即跟进,举办媒体取证竞赛(MFC, Media Forensics Challenge)以促进该领域产业与学术发展。2020年,Facebook公司出资1000万美元发起DeepFake检测挑战赛(DFDC, Deepfake Detection Challenge),以排行榜形式筛选顶级防伪系统,刺激学术界和产业界的研究。2019年11月18日,我国互联网信息办公室、文化和旅游部、国家广播电视总局联合印发了《网络音视频信息服务管理规定》,第十一条明确规定“网络音视频信息服务提供者和网络音视频信息服务使用者不得利用基于深度学习、虚拟现实等的新技术新应用制作、发布、传播虚假新闻信息”,以法律手段明确打击非法技术应用。另一方面,善意使用音视频伪造技术,不仅能极大促进娱乐、广告和影视等产业的发展,还能让历史人物数字重现,可与已故亲人对话,体现其暖心的一面。

语音伪造(或语音生成)是一类技术的统称,包括语音合成、语音转换、录音回放、语音拼接和编辑,以及真人模仿等。录音回放,是通过录音设备将目标人语音存储下来,再通过扬声器回放,其效果取决于录音环境、录音设备、扬声设备和扬声环境等因素。在理想的环境与设备条件下,录音回放是效果最好的语音伪造(或语音生成)手段。但其不足之处也很明显:需要高质量采集设备提前录制目标人指定内容和指定场景下的语音,录音后,其语音内容、音色、音调和韵律等都难以改变,应用场景有限。对录音回放的恶意应用,主要在生物特征验证场景,而不是语义欺骗场景。语音拼接和编辑主要指语音专家借助音频编辑软件的手工操作。常见的音频编辑软件包括Adobe Audition(CoolEdit)、GoldWave、Sonar和Audacity等。在拼接和编辑过程,语音专家往往依据个人经验与直觉,在语谱图上对音高、音量、速度等进行操作,通过反复试错与听音,逐步调整到期望效果。这种人机协同的语音拼接和编辑能得到效果不错的语音,但耗时耗力,成本较大。真人模仿包括两种情况:第一种是以同卵双胞胎为代表的先天性生理结构相似,使得彼此能够成为伪造的手段。第二种情况是以配音演员为代表的后天训练,使得演员们能够根据自身发音特点,对声音相近的目标人能够准确模仿,2018年至2020年,湖南卫视推出的《声临其境》是原创声音魅力竞演秀节目,在三季的演出中,以朱亚文、秦昊和刘琳等为代表的优秀演员,为各位观众展现了如火纯青的声音模仿艺术。文献[79]指出,未经训练的模仿者并不能对识别系统带来很高的危害,文献[80]通过专业人员模拟名人声音作为伪造语音,在测试集上的等错点为35.85%。这意味着人与机器都难以分辨真假。近期,语音克隆(voice cloning)[81]和语音模仿(voice impersonation) [82]也受到关注。语音克隆[81]是语音合成的一种,强调通过对少量目标人语音样本的学习,能将任意文本生成目标人语音。语音模仿[82]属于非并行训练语料的语音转换技术,通过对目标人语音样本的学习,能将源说话人语音转化为目标说话人语音。

近年来,以深度学习为技术特色的语音合成与语音转换,不仅在语音可懂度、清晰度和流畅度等方面长足进步,更在融入目标人发音风格和情感信息等方面取得突破性进展。在语料充足的条件下,可生成以假乱真的目标人语音,这也是本文重点论述的内容。为了更全面的了解语音取证技术的进展,本文将先从技术的对立面,详细回顾下语音伪造技术在近两年的发展。

3.2 语音合成技术

语音合成,又称文语转换(TTS, Text to Speech),是将文字信息转化为自然语音的技术[83]。统计参数语音合成、波形拼接语音合成和基于深度学习语音合成是三类主要的语音合成算法。其中,统计参数语音合成和波形拼接隶属于传统语音合成算法。基于深度学习的,尤其受端到端思想的驱动的语音合成技术,能够描述语音数据复杂的内部结构,合成效果在自然度和表现性上有较大提升。

综观语音合成研究历史,早期研究主要采用参数合成方法,其目标是提升合成语音的可懂度和自然度。可懂度强调合成语音的清晰与易理解程度;自然度强调听者的舒适性和整体风格的一致性。值得提及的是Holmes的并联共振峰合成器[84]和Klatt的串/并联共振峰合成器[85],只要精心调整参数,这两个合成器都能合成出较自然的语音。但是,准确提取共振峰参数比较困难,合成语音的音质难以达到实用要求。上世纪九十年代,基音同步叠加(PSOLA, Pitch-synchronous overlap-add)[86]的提出极大提升了合成语音的质量和自然度。然而,PSOLA算法对基音周期的起始、长度和强度标注有要求,错误的标注会显著影响合成语音的效果。为了解决这些问题,参数统计语音合成(SPSS, Statistical parametric speech synthesis)等相继发展起来,提升了合成语音的质量和自然度。

3.2.1 参数统计语音合成技术

典型的SPSS系统包括三个模块:文本分析、参数预测和声码器(Vocoder,也称语音合成器)。文本分析模块将输入语音转换为用于语音合成的文本特征,参数预测模块基于文本特征预测声学参数,而声码器依据声学参数合成预期的语音。

文本分析也隶属于自然语言处理(NLP, Natual Language Processing),最初,文本分析是一系列处理规则的集合。受数据驱动思想的影响,二元文法、三元文法、隐含马尔可夫模型(HMM, Hidden Markov model)和深度神经网络都相继在音素层、音节层、单词层、短语层和句子层等用于文本分析。在音素层,文本分析主要预测相邻音素是否在同一音节内;在音节层,主要解决重音问题;在单词层,主要解决单词所包含音节的位置和个数;在短语层,主要解决短语所包含单词的位置和个数;在句子层,主要解决当前句子中音节、单词或短语的总数。这方面的代表性工作是Festival系统[87]。

参数预测的难点是协同发音。音素的实际发音受上下文语境影响较大,这意味着声学特征的预测要重点考虑前后音素的作用。有两类主要的参数预测方法:基于HMM的参数预测方法[88]和基于DNN的参数预测方法[89-90]。基于HMM的参数预测,其状态通常采用单高斯或高斯混合模型(GMM, Gaussian mixture models)建模,通过最大似然准则优化目标函数,以达到对频谱参数的准确预测。与基于HMM的参数预测方法相比,基于DNN的参数预测方法能更好的利用上下文信息提升声学参数预测质量。

声码器负责将参数转换为语音波形,具有代表性的声码器包括HTS-Engine[91]、STRAIGHT[92-93]和WORLD[94]声码器。HTS-Engine出现较早,早期的合成语音质量较差,通过引入深度学习方法,其近期的语音合成质量有显著提升。STRAIGHT[92]和WORLD声码器不仅可以生成高质量语音,还能实时处理。这点对于实用语音合成应用尤为重要。

在深度学习以前,基于GMM和HMM的语音合成是主流技术路线之一,能够产生清晰易懂的语音,但也受浅层模型制约,不能很好的学习上下文信息和深层非线性结构,易存在过平滑和过拟合现象,使得合成语音可能有模糊不清的现象。

3.2.2 波形拼接语音合成技术

顾名思义,波形拼接语音合成技术是从预先录下的庞大的语音数据库中挑选合成语音单元[95]。理论上,只要语音数据库足够大,包括了各种可能语境下的语音单元就可能拼接出任何语句。由于合成的语音基元都是来自自然的原始发音,合成语句的清晰度和自然度都将会非常高。波形拼接技术主要考虑语料库的构建、声学单元、基元选取和拼接损失四个方面。语料库构建,通常采用尽可能少的语料覆盖尽可能多的发音现象;在语料库基础上,根据任务需求选取合适的声学单元;在不同的上下文语境下,声学单元有不同变体,通过选取最为合适的基元,在拼接损失听感知最小的约束条件下,完成语音合成任务。

3.2.3 基于深度学习的语音合成技术

深度学习为语音合成注入新的活力,也带来了质的提升,主要体现在四个方面:一是深度学习赋能传统方法,二是声码器的改进,三是端到端语音合成框架的提出与实现,四是基于生成对抗网络的语音合成技术。

深度学习赋能传统方法的代表性工作是采用深度学习模型替换高斯混合模型,进行声学参数预测[96]。这类方法虽然也使用了深度神经网络,但依赖传统方法生成的对齐数据。在主观感受上虽有所提升,不过并不显著。

声码器改进的代表性工作是Google DeepMind团队提出的Wavenet[97]。 Wavenet源于图像处理领域的PixelCNN[98]和PixelRNN[99],是基于概率的、自回归的序列生成模型。Wavenet的核心是带洞因果卷积(Dilated causal convolution),既保证了较大的感受野,又能保证预测的因果性,也可并行计算。采用5分制的主观评价分数,基于Wavenet声码器的合成语音,在美式英语上可达4.21的主观分,在汉语普通话上可达4.08的主观分,显著优于传统的HMM拼接方法(美式英语3.86,汉语普通话3.47)和LSTM(美式英语3.67,汉语普通话3.79)。Wavenet为高质量语音合成提供了研究方向,为了解决其计算复杂度高的不足,LPCNet[100],WaveRNN[101]等相继被提出,并显著降低了计算复杂度。以Wavenet为代表的深度神经声码器,能够产生人类水平的自然语音,摆脱了传统波形拼接方式对语料库等繁杂的要求,在语音合成史上也具有着重要的意义。

在向端到端语音合成框架发展过程中,序列到序列(Seq2Seq, Sequence to sequence)语音合成方法扮演了重要的过渡角色。Seq2Seq语音合成[102]的提出初衷是为了更好的利用上下文信息。但随着研究深入,Seq2Seq无需显示对齐的优点更加突出,并且与注意力机制、编码器-解码器设计思想相结合,诞生了端到端语音合成框架。端到端语音合成框架的早期工作是Yoshua Bengio等,于2017年提出Char2Wav[103],影响最为广泛的是Tacotron1&2[104-105]。受Tacotron的影响,百度提出DeepVoice3[106]并迅速商业化,DeepVoice3含有说话人嵌入模块,意味着端到端语音合成框架可融入说话人风格,达到语音伪造或生成的目标。在Tacotron2基础上,文献[107]通过引入变分自动编码器(VAE, Variational Autoencoder),以无监督的方式学习说话人风格的潜在表示。这些工作表明,现阶段语音合成不仅能够产生自然的语音,还能产生目标说话人特定风格的语音,为前面所述的语音生成或语音伪造提供了技术可行性。

2014年,生成对抗网络[108]为图像领域注入了新的研究思路。通过对抗学习,随机噪声也能通过网络变换成惟妙惟肖的图像,使GAN迅速成为了研究热点。GAN在语音合成领域发展相对较晚,主要集中在神经声码器的研究[109],也是Wavenet的替代方案之一。借助GAN的强大描述能力,使得合成语音质量较高,但也存在训练困难等诸多问题,有待进一步深入研究。

3.3 语音转换技术

语音转换是在不改变语义信息的基础上,转换语音对应的说话人风格信息。在一段语音中,与说话人风格相关的有语义内容、音段特征和超音段特征。语音转换的任务是保持语义内容不变,转换音段特征和超音段特征。与语音合成向比较,语音合成的输入是文本,语音转换的输入是语音。语音合成的重点是生成清晰自然的语音,语音转换的重点是生成自然且与目标人风格一致的语音,更具挑战性。从技术发展历史上看,语音转换技术发展可分为基于统计学习的语音转换和基于深度学习的语音转换两个阶段;从训练数据上看,语音转换技术可分为基于并行训练语料的语音转换和基于非并行训练语料的语音转换。从转换的人数看,语音转换技术可分为单人到单人的成对(pairwise)语音转换和多人到多人的多人(many-to-many)语音转换。从设计思路上看,绝大多数语音转换技术都是先做“减法”再做“加法”。所谓“减法”,是从待转换语音中剥离原说话人特征,抽取语义信息;所谓“加法”,是利用抽取的语义信息,生成附加目标说话人特征的自然语音。

3.3.1 基于统计学习的并行训练语料语音转换

所谓并行训练语料语音转换,是指在训练过程中,源说话人的语音和目标说话人的语音具有相同的文字内容,重点是在特征空间寻找合适的映射方法。基于统计学习的并行训练语料语音转换技术的主要思路是:首先,基于源说话人的语音和目标说话人的语音相同的文字内容,利用动态时间规整(DTW, Dynamic time warping)[110]或隐含马尔可夫模型[111]做发音特征在帧层面的对齐;随后,基于矢量量化[112]、高斯混合模型[113-114]、动态核偏最小二乘(DKPLS, Dynamic kernel partial least squares)[115]、特征弯曲[116]和非负矩阵分解(NMF, Non-negative matrix factorization)[117-119]等方法,实现特征的变换;最后,再将变换的特征映射到时域。对于并行训练语料语音转换技术而言,训练语料的缺乏是上述各类方法所面临的共同问题。基于矢量量化、高斯混合模型和动态核偏最小二乘等方法,通过统计平均建立转换模型,优点是模型稳健,缺点是易产生过平滑现象(over-smoothing)导致转换语音模糊。特征弯曲和非负矩阵分解等方法,在声学或音素特征层面上直接转换。通过附加正则项约束,可让激励矩阵尽可能稀疏化,缓解训练数据缺乏等问题,效果较好,是近年来基于统计学习的并行训练语料语音转换的主要研究方向。

3.3.2 基于统计学习的非并行训练语料语音转换

所谓非并行训练语料语音转换,是指在训练过程中,源说话人的语音和目标说话人的语音具有不同的文字内容,难点是在特征空间寻找变换之前,还要在发音内容上做显式或隐式的选择与对齐。一般而言,非并行训练语料语音转换方法不要求并行语料,可用的数据资源显著增多,主要问题由训练语料缺乏转为训练语料的合理利用。通常,有三种利用训练语料的思路:一是通过连续语音识别方法识别文本,利用文本匹配寻找可并行训练的短语音对[120];二是通过聚类[121]或选择[122]的方法,在声学特征空间构建并行转换单元;三是借鉴说话人识别的联合因子分析方法[123],在超矢量空间的说话人因子空间,通过更换说话人因子达到隐式转换的目标[124]。基于连续语音识别的思路简单直接,但有两点不足,一是连续语音识别引擎计算资源消耗较大,二是识别过程中有可能带来错误传播。为了避免上述不足,近邻搜索迭代合并和转换对齐算法和单元选择均在声学层面选择发音相近的单元并建立转换关系,取得了更好的转换效果,曾是基于统计学习的非并行训练语料语音转换的主流算法。基于说话人因子的语音转换算法的核心思路是寻找一个空间,可以分离说话人因子、语音内容因子和信道因子等,通过替换说话人因子达到语音转换的目标,其优点是通过调节说话人因子可实现多说话人到多说话人的映射,但转换效果有待提升。

3.3.3 基于深度学习的并行训练语料语音转换

与基于统计学习的并行训练语料语音转换相比,基于深度学习的并行训练语料语音转换主要在三个方面有所改进:一是在原有统计模型基础上,用深度神经网络代替统计模型实现特征映射[125-126];二是采用序列到序列的映射方法[127-128];三是采用编码器-解码器结构[129-131]。基于并行训练语料语音转换技术,在帧对齐之后,通常采用GMM、DKPLS或NMF方法完成源说话人语音向目标说话人语音的映射。这种映射函数是非线性的、复杂的,采用深度神经网络代替统计模型,能够更好的发现映射的非线性关系,实现更为自然的语音转换。不过,如前所述,并行训练语料往往相对较少,而深度神经网络又需要大规模数据驱动,两者之间构成内在的矛盾。通过预训练学习语音共性特征,通过迁移学习向目标人语音特色调整,是解决数据矛盾的主要思路。基于并行训练语料的语音转换是典型的序列到序列的映射任务,与对齐-转换的思路相比,LSTM和BiLSTM[131]等借助记忆模块可同时完成隐式对齐和转换任务,显著简化了转换的流程且取得不错的转换效果。编码器-解码器通过隐变量,也能实现序列到序列的映射,不过,它更强调使用注意力机制[130]和卷积深度神经网络[131]。无论是成对还是多人语音转换任务,编码器-解码器均是目前最优的语音转换技术。

3.3.4 基于深度学习的非并行训练语料语音转换

有两类基于深度学习的非并行训练语料语音转换思路。第一类,如前所述,语音转换是先“减法”再“加法”的过程。一种理想的做法是:先通过连续语音识别将语音转化为文本,再通过语音合成将文本转化为目标说话人的语音,就实现了非并行语料的语音转换任务。这类思路各步骤物理意义明确,转换效果好,是业界广泛应用的语音转换方法。第二类是借鉴图像领域的生成对抗网络。在图像领域,GAN能够生成以假乱真的图片[108]。在语音信号处理领域中,提取的二维特征也可以当作图片处理。CycleGAN[133-134]、StarGAN[135,136]和VAE-GAN[137]等是这类思路的代表性方法。

第一类思路的核心问题有三个:如何更好利用语音合成系统?如何更好利用语音识别系统?如何解决好两者的耦合关系?神经声码器和端到端设计是近期来语音领域的重要进步。语音转换领域充分吸收了语音合成进步的成果,主要体现在以下几个方面:一是与条件GAN类似,通过在语音生成端引入说话人变量作为条件,引导语音合成的共性语音转化为特定目标人的特性语音,代表性的工作是Cotatron[138];二是在大量数据训练所得的语音合成声码器基础上,通过自适应微调参数成为适用于特定目标人的神经声码器[139];三是基于编码器-解码器结构,跨文本和语音两个模态学习,共享语音生成模块[140]。上述三个方面的共性出发点是:充分利用大量数据训练所得的语音合成声码器,解决目标说话人数据相对不足的问题。语音识别在语音转换中的应用思路比较单一:即将源语音的内容信息抽取出来。内容信息的表征形式既可文本字符,也可是音素后验概率(PPG, Phoneticposteriogram)[141]。从转换效果上看,基于PPG的内容表征方法既能保留内容信息,又能保留源语音与转换语音的声学共性,转换效果最好。在两者耦合上,编码器-解码器结构、端到端的设计思想与多任务优化成为三个关键词。以语音识别为代表一类技术,负责从源语音中抽取内容信息,履行编码器的职责;以语音合成为代表的一类技术,负责使用内容信息和目标说话人特征合成转换语音,履行解码器的职责。编码器和解码器,即可仿照语音识别和语音合成领域相关技术单独优化,又可端到端联合优化,例如,Parrotron[142]。在上述优化过程中,源语音和转换语音要保持相同的语音内容,这使得编码器和解码器之间的隐变量在尽可能过滤说话人特征基础上保留内容信息。此外,为了保证转换效果,通常将解码器输出语音与目标人真实语音对比,构造损失函数。语音转化的总体优化往往由上述两部分构成,隶属于多任务优化[140]。

GAN在图像领域的表现令人惊艳。在语音处理领域,通过短时傅里叶变换等可将一维语音序列转化为二维语谱图,就可借鉴GAN实现语音转换。最早采用类似思路的是CycleGAN[133-134],通过引入对抗损失、循环一致损失和全等映射损失,可以实现成对语音转换。随后发展起来的StarGAN[135-136]扩展了CycleGAN,通过引入说话人条件,可实现多对多语音转换。在小规模实验数据库上,基于GAN的技术转换效果较好。基于GAN的语音转换技术框架结构简单,是其优点。但不足之处也有很多:1)训练较为困难,不易收敛;2)与第一类设计思路相比,其物理意义并不明确;3)实际应用中,语音转换效果不理想。为解决第一个不足,有研究者提出用VAE代替GAN[143],或将VAE与GAN结合使用[137],既降低了训练的难度,也提升了转换语音的效果。目前为止,基于GAN的语音转换技术还远未达到与图像领域类似的期望,有待未来深入研究。

与语音合成相比,语音转换的输入是语音,更符合日常交流习惯。预期在不远的将来,语音转换的效果与速度进一步提升,就很有可能达到实时的、可欺骗人类感官与认知的语音转换效果。跨过这道技术门槛,无论是在影视等领域出于善意的语音生成,还是在诈骗等领域出于恶意的语音诈骗,语音转换会有比语音合成更为广泛、更具有想象力的应用空间。

3.4 语音鉴伪与取证3.4.1 伪造语音性能评估

无论是语音合成还是语音转换,都有两类评价指标:主观评价指标和客观评价指标[144-145]。所谓主观评价,是招募一定数量的志愿者,对合成或转换语音的自然度、可懂度和相似度等主观打分,再计算分数的平均值作为语音合成或转换的主观评价指标。一般而言,评价语音质量本身的优良常采用5分制;评价两段语音的相似度常采用4分制。虽然主观评价指标符合语音合成或转换的初衷,但因其成本高、周期长等,研究者也相继提出客观评价指标,例如,梅尔倒谱失真(MCD, Mel-Cepstral Distortion)[146]、均方根误差(RMSE, Root Mean Squared Error)等。虽然这些客观评价指标简单易算,在很大程度上反映了合成或转换语音的质量,但在某些时候与主观评价指标还有差异,更适合作为参考性指标。为了更加便捷与准确的评价语音质量,还有一类技术是把主观评价指标作为系统预测参数,通过设计网络模型达到自动评估的目标,典型的工作有MOSNet[147]、MBNet[148]等。国际上,公认的语音合成学术评测是Blizzard Challenge(http:∥festvox.org/blizzard),语音转换学术评测是Voice Conversion Challenge(http:∥vc-challenge.org)。这两个评测的官方主页上,都详细披露了评测结果与各参与单位的技术路线,供学术与产业界有关人士参考。

3.4.2 语音鉴伪与取证技术

语音鉴伪(Antispoof),也称语音取证(Speech forensics),其内涵都是判断指定语音是由真人发出的,还是由计算机生成的[149]。在以深度学习为特色的语音生成技术发展之前,由计算机生成的语音虽然在语音内容相关的清晰度、可懂度等方面达到较高水平,但在说话人风格相关的韵律、音色等方面,还有诸多不足,人耳较容易分辨是真实语音还是生成语音。随着语音合成和语音转换技术的突破,生成的语音越来越真实,尤其是对目标人的恶意伪造技术有了突破性的进展,使得普通人越来越难以辨别真实语音和伪造语音。这也就对语音鉴伪有了越来越迫切的应用需求。语音鉴伪伴随着说话人识别(也称声纹识别)技术发展而发展,其代表性事件是2015年、2017年和2019年举办的自动说话人识别欺骗攻击与防御对策挑战赛(ASVspoof, Automatic Speaker Verification Spoofing and Countermeasures Challenge)[149-153],该评测由英国爱丁堡大学、法国EURECOM、日本国立情报学研究所、东芬兰大学等多个世界领先的研究机构共同组织发起,隔年举行,是迄今为止针对虚假语音和声纹识别,规模最大、最全面的挑战赛。ASVSpoof依据ISO标准30107-1等定义了两种鉴伪场景:物理访问(PA, Physical Access,)和逻辑访问(LA, Logical Access)。在物理访问场景,攻击语音由录音回放产生;在逻辑防伪场景,攻击语音由语音合成或语音转换产生。ASVspoof 2015仅含逻辑访问场景任务[149],ASVspoof 2017仅含物理访问场景任务[150]。ASVSpoof 2019[152-153]同时包括逻辑访问场景任务和物理访问场景任务。近期刚结束的ASVSpoof 2021不仅包括逻辑访问场景任务和物理访问场景任务,还增加了深度伪造场景任务,专门针对质量不断提升的伪造语音。

回顾语音鉴伪的发展历程,无论是语音合成(参数生成、波形拼接和深度学习等)攻击,语音转换攻击,还是录音回放攻击等。研究者主要从特征提取和统计建模两个层面着手,或利用先验知识设计特征,或采用数据驱动方法,设计防伪算法。在特征提取上,代表性工作包括线性频标倒谱系数(LFCC, Linear frequency cepstrumcoefficient)[154]、常Q倒谱系数(CQCC, Constant Q cepstral coefficients)[155]、瞬时频率(Instant frequency,IF)[156]等。与语音信号处理中常见的Fbank和梅尔频标倒谱系数(MFCC, Mel-Frequency Cepstrum Coefficient)相比,用于音频鉴伪的特征更侧重参数的平滑性、高频部分和相位特征等。

在统计建模上,传统的高斯混合模型以及I-vector[157]正逐步被以LightCNN[158]、残差网络[159]、变分自动编码器[160]和孪生网络[160]等为代表的深度学习模型所取代。受SENet(Squeeze-and-Excitation networks)[161]启发,卷积模块注意力机制(CBAM, Convolutional Block Attention Module)[162]、瓶颈注意力模块(BAM, Bottleneck Attention Module)[163]和双注意力网络(DAN, Dual Attention Network)[164]等相继被应用到语音鉴伪深度神经网络上,并在ASVspoof等数据集上性能有所提升。近期,以时域语音合成检测网络(Time-domain synthesis speech detection net, TDSSDNet)[165]和RawNet2[166]为代表的端到端设计、Capsule[167]、Res2Net[168]和Mockingjay[169]为代表的预训练模型有望成为下阶段语音鉴伪研究的热点。

在特征提取和深度模型确定后,系统主体框架形成。后端分类器设计、多系统融合和多模态信息共享等研究点是主体框架的重要补充。在深度模型后端的设计上,有两类设计思路,一类是将输出层的标签直接设为真实语音和伪造语音,在测试过程中输入待测语音可直接输出判决结果,符合流行的端到端思想,但网络设计与训练调参相对复杂;另一类是仿照说话人识别中的X-vector[170]系统,将输出层的标签设为真实语音和已知的各类伪造语音,提取神经网络的低维嵌入作为待测语音的表征输入到后端分类器进行真伪判别。后一种方式,因其性能优异也更为灵活,是主流的语音鉴伪设计方法。此时,后端分类器的设计对性能有显著影响。常见的后端分类器包括支持向量机、线性鉴别性分析和概率线性鉴别式分析等。在系统融合上,多借鉴于说话人识别的融合方法,有投票策略、支持向量机和逻辑回归等,融合系统通过“取长补短”,其性能往往优于单系统。但融合系统比较复杂,实用性较差。提升最优单系统的识别性能,实用意义更强。在很多应用场景,伪造的音视频往往同时出现,此时,音视频内容的同步性、信息的互补性,也能作为防伪检测的重要手段。尽管在ASVSpoof 2015、2017和2019上报道的评测结果都相对较好,无论是物理访问场景还是逻辑访问场景,性能优异系统的等错点均低于5%,SOTA系统的等错点会低于2%[165-168],看似能够达到诸多场景的实用需求。然而,ASVSpoof评测的语音伪造方法有限,录音回放设备质量有待提升,这使得有针对性设计的系统在实验数据集上性能优异,应用性能被乐观估计。

目前,语音防伪系统在可解释性上、泛化性上、多编码和多应用场景适应性等方面,都依然缺乏足够坚实的理论基础,不能清晰划分伪造语音和真实语音的边界。尤其在实用过程中,攻击方不太可能将攻击手段预先告知,这使得依赖数据驱动或有针对性设计的防伪算法失效,性能显著下降。

4 未来展望

随着网络社交媒体不断深入人们的生活中,方便了人们的同时也导致了虚假信息的泛滥。因此,研究针对虚假言论的精准且高效的取证技术成为近两年的研究热点。从应用和研究的角度观察,虚假言论的取证技术有着广阔的应用前景。本文综述了当前网络虚假言论的取证技术的前沿动态。同时需要指出的是,这些方法和策略并非相互独立的。在实际中,这些方法往往相互结合以取长补短。

虽然近两年,深度学习技术的进步带来了网络虚假言论取证技术的飞速发展,然而依然存在一些挑战难题尚未得到有效解决。首先,在虚假文本取证方面,虚假文本的早期检测和取证[43,78]是一个值得重视但却依然缺乏有效技术的领域。虚假信息对社会有着巨大的危害作用,其危害程度往往与其传播程度正相关,越早的检测越有利于制止其传播以降低危害。但是虚假文本的早期检测也存在很多挑战。例如,在传播的早期,检测方难以获得虚假信息的传播模式,相关的知识库也可能还未更新。因此,早期检测需要在相当有限的条件内对信息进行一个判断。除此之外,在检测到虚假信息之后,如何以更低的代价制止和阻塞虚假信息的传播也是一个重要的问题[171-172]。

同时,越来越多的网络信息以网络多媒体的形式出现。这些不同形式的媒体之间互为补充,并相互增强。单一地从言论角度对虚假信息进行取证在未来将不能覆盖大部分的网络信息。更重要的是,相比于文本或者语言信息,具有视觉图像的信息会吸引更多的用户,并造成更广泛的影响。因此研究如何针对网络多媒体的虚假信息进行有效检测,亦或是依据这些多种媒介信息之间的关联对其进行检测,也将会成为一个具有广阔前景的研究方向[173-176]。

5 结论

互联网的普及以及社交网络的发展,在给人们日常生活带来便利的同时,也造成了虚假信息的广泛传播。这一方面导致人们获取正确信息的难度增大,另一方面也容易被别有用心的人利用从而诱导网络舆论,破坏社会稳定,甚至危害国家安全。因此研究网络虚假信息的取证技术成为了近两年研究人员关注的热点。本文主要关注网络虚假言论的取证技术,分别从文本和音频两方面综述了该领域的发展历程和近年的研究成果。总的来说,虽然技术的进步使得虚假信息取证技术不断进步,但是其对抗技术,即虚假信息的生成技术也在同步发展。例如,近几年深度学习的发展使得虚假信息取证技术性能不断提升,然而同时,基于深度学习的虚假信息生成技术也在逐渐增强。作为检测方,一方面需要全方位了解最新的虚假信息生成技术以有针对性地提升检测性能,另一方面检测方也需要从多个不同的视角看待和建模这个任务,例如除了分析载体自身的特性,还可以从传播学等角度进行虚假信息挖掘。总的来说,本文较为全面的综述了网络虚假言论的检测和取证技术,希望能帮助未来相关领域研究人员更好的了解该领域从而研究更先进的技术以推动该领域的持续进步。

[1] LA BELLA E, ALLEN C, LIRUSSI F. Communication vs evidence: What hinders the outreach of science during an infodemic? A narrative review[J/OL]. Integrative Medicine Research, 2021, 10(4): 100731.https:∥www.sciencedirect.com/science/article/pii/S2213422021000184.

[2] SHU K, SLIVA A, WANG S, et al. Fake news detection on social media: A data mining perspective[J/OL]. SIGKDD Explor. Newsl., 2017, 19(1): 22-36. https:∥doi.org/10.1145/3137597.3137600.

[3] LEIBENSTEIN H. Bandwagon, snob, and Veblen effects in the theory of consumers’ demand[J]. The Quarterly Journal of Economics, 1950, 64(2): 183-207.

[4] ZUBIAGA A, LIAKATA M, PROCTER R, et al. Analysing how people orient to and spread rumours in social media by looking at conversational threads[J/OL]. PLOS ONE, 2016, 11(3): 1-29.https:∥doi.org/10.1371/journal.pone.0150989.

[5] SUBRAMANIAN S. Inside the Macedonian fake-news complex, wired, February 15[EB]. 2017.https:∥www.wired.com/2017/02/veles-macedonia-fake-news/.

[6] TOWNSEND T. Meet the Romanian Trump fan behind a major fake news site.[EB/OL]. 2016. http:∥www.inc.com/tess-townsend/ending-fed-trump-facebook.html.

[7] KSHETRI N, VOAS J. The economics of “fake news”[J]. IT Professional, 2017,19(6): 8-12.

[8] CIAMPAGLIA G L, SHIRALKAR P, ROCHA L M, et al. Computational fact checking from knowledge networks[J/OL]. PLOS ONE, 2015, 10(6): 1-13.https:∥doi.org/10.1371/journal.pone.0128193.

[9] COHEN S, LI C, YANG J, et al. Computational journalism: A call to arms to database researchers[C]∥CIDR. 2011.

[10]ZHOU X, ZAFARANI R. A survey of fake news: Fundamental theories, detection methods, and opportunities[J]. ACM Computing Surveys (CSUR), 2020, 53(5):1- 40.

[11]JI S, PAN S, CAMBRIA E, et al. A survey on knowledge graphs: representation, acquisition, and applications[J/OL]. IEEE Transactions on Neural Networks and Learning Systems, 2021: 1-21.http:∥dx.doi.org/10.1109/TNNLS.2021.3070843.

[12]DONG X, GABRILOVICH E, HEITZ G, et al. Knowledge vault: A web-scale approach to probabilistic knowledge fusion[C/OL]∥KDD ’14: Proceedings of the 20th ACM SIGKDD International Conference on Knowledge Discovery and Data Mining. New York, NY, USA: Association for Computing Machinery, 2014:601- 610.https:∥doi.org/10.1145/2623330.2623623.

[13]SHI B, WENINGER T. Discriminative predicate path mining for fact checking in knowledge graphs[J/OL]. Knowledge-Based Systems, 2016, 104: 123-133.https:∥www.sciencedirect.com/science/article/pii/S0950705116300570.

[14]SUCHANEK F M, KASNECI G, WEIKUM G. Yago: A core of semantic knowledge[C/OL]∥WWW ’07: Proceedings of the 16th International Conference on World Wide Web. New York, NY, USA: Association for Computing Machinery, 2007: 697-706.https:∥doi.org/10.1145/1242572.1242667.

[15]BOLLACKER K, EVANS C, PARITOSH P, et al. Freebase: A collaboratively created graph database for structuring human knowledge[C/OL]∥SIGMOD’08: Proceedings of the 2008 ACM SIGMOD International Conference on Management of Data. New York, NY, USA: Association for Computing Machinery,2008: 1247-1250.https:∥doi.org/10.1145/1376616.1376746.

[16]CARLSON A, BETTERIDGE J, KISIEL B, et al. Toward an architecture for never-ending language learning[J/OL]. Proceedings of the AAAI Conference on Artificial Intelligence, 2010, 24(1).https:∥ojs.aaai.org/index.php/AAAI/article/view/7519.

[17]NAKASHOLE N, WEIKUM G, SUCHANEK F. PATTY: A taxonomy of relational patterns with semantic types[C]∥Proceedings of the 2012 Joint Conference on Empirical Methods in Natural Language Processing and Computational Natural Language Learning. 2012: 1135-1145.

[18]AUER S, BIZER C, KOBILAROV G, et al. DBpedia: A nucleus for a web of open data[C]∥ABERER K, CHOI K-S, NOY N, et al. The Semantic Web. Berlin, Heidelberg: Springer Berlin Heidelberg, 2007: 722-735.

[19]NIU F, ZHANG C, RÉ C, et al. Elementary: Large-scale knowledge-base construction via machine learning and statistical inference[J]. International Journal on Semantic Web and Information Systems (IJSWIS), 2012, 8(3): 42-73.

[20]NIU X, SUN X, WANG H, et al. Zhishi.me-Weaving Chinese linking open data[C]∥AROYO L, WELTY C, ALANI H, et al. The Semantic Web-ISWC 2011. Berlin, Heidelberg: Springer Berlin Heidelberg, 2011: 205-220.

[21]XU B, XU Y, LIANG J, et al. CN-DBpedia: A never-ending Chinese knowledge extraction system[C]∥BENFERHAT S, TABIA K, ALI M. Advances in Artificial Intelligence: From Theory to Practice. Cham: Springer International Publishing, 2017: 428- 438.

[22]THORNE J, VLACHOS A, CHRISTODOULOPOULOS C, et al. Fever: a large-scale dataset for fact extraction and verification[J]. arXiv preprint arXiv:1803.05355, 2018.

[23]THORNE J, VLACHOS A, COCARASCU O, et al. The fact extraction and verification (fever) shared task[J]. arXiv preprint arXiv:1811.10971, 2018.

[24]NIE Y, CHEN H, BANSAL M. Combining fact extraction and verification with neural semantic matching networks[J/OL]. Proceedings of the AAAI Conference on Artificial Intelligence, 2019, 33(1): 6859- 6866.https:∥ojs.aaai.org/index.php/AAAI/article/view/4662.

[25]HANSELOWSKI A, ZHANG H, LI Z, et al. Ukp-athene: Multi-sentence textual entailment for claim verification[J]. arXiv preprint arXiv:1809.01479, 2018.

[26]DAGAN I, GLICKMAN O, MAGNINI B. The PASCAL recognising textual entailment challenge[C]∥QUI ONERO-CANDELA J, DAGAN I, MAGNINIB, et al. Machine Learning Challenges. Evaluating Predictive Uncertainty, Visual Object Classification, and Recognising Tectual Entailment. Berlin, Heidelberg:Springer Berlin Heidelberg, 2006: 177-190.

ONERO-CANDELA J, DAGAN I, MAGNINIB, et al. Machine Learning Challenges. Evaluating Predictive Uncertainty, Visual Object Classification, and Recognising Tectual Entailment. Berlin, Heidelberg:Springer Berlin Heidelberg, 2006: 177-190.

[27]YIN W, ROTH D. Twowingos: A two-wing optimization strategy for evidential claim verification[J]. arXiv preprint arXiv:1808.03465, 2018.

[28]HIDEY C, DIAB M. Team SWEEPer: Joint sentence extraction and fact checking with pointer networks[C]∥Proceedings of the First Workshop on Fact Extraction and VERification (FEVER), 2018: 150-155.

[29]NIE Y, BAUER L, BANSAL M. Simple compounded-label training for fact extraction and verification[C/OL]∥Proceedings of the Third Workshop on Fact Extraction and VERification (FEVER). Online: Association for Computational Linguistics, 2020: 1-7.https:∥www.aclweb.org/anthology/2020.fever-1.1.

[30]LUKEN J, JIANG N, de MARNEFFE M-C. QED: A fact verification system for the FEVER shared task[C]∥Proceedings of the First Workshop on Fact Extraction and VERification (FEVER). 2018: 156-160.

[31]CHEN Q, ZHU X, LING Z, et al. Enhanced lstm for natural language inference[J]. arXiv preprint arXiv:1609.06038, 2016.

[32]DEVLIN J, CHANG M-W, LEE K, et al. Bert: Pre-training of deep bidirectional transformers for language understanding[J]. arXiv preprint arXiv:1810.04805,2018.

[33]YANG Z, DAI Z, YANG Y, et al. Xlnet: Generalized autoregressive pretraining for language understanding[J]. arXiv preprint arXiv:1906.08237, 2019.

[34]NIE Y, WANG S, BANSAL M. Revealing the importance of semantic retrieval for machine reading at scale[J]. arXiv preprint arXiv:1909.08041, 2019.

[35]SOLEIMANI A, MONZ C, WORRING M. BERT for evidence retrieval and claim verification[C]∥JOSE J M, YILMAZ E, MAGALH ES J, et al. Advances in Information Retrieval. Cham: Springer International Publishing, 2020: 359-366.

ES J, et al. Advances in Information Retrieval. Cham: Springer International Publishing, 2020: 359-366.

![]() CUCURULL G, CASANOVA A, et al. Graph attention net-works[J]. arXiv preprint arXiv:1710.10903, 2017.

CUCURULL G, CASANOVA A, et al. Graph attention net-works[J]. arXiv preprint arXiv:1710.10903, 2017.

[37]ZHOU J, HAN X, YANG C, et al. GEAR: Graph-based evidence aggregating and reasoning for fact verification[J]. arXiv preprint arXiv:1908.01843, 2019.

[38]LIU Z, XIONG C, SUN M, et al. Fine-grained fact verification with kernel graph attention network[J]. arXiv preprint arXiv:1910.09796, 2019.

[39]ZHONG W, XU J, TANG D, et al. Reasoning over semantic-level graph for factchecking[J]. arXiv preprint arXiv:1909.03745, 2019.

[40]CHEN C, CAI F, HU X, et al. An entity-graph based reasoning method for fact verification[J]. Information Processing & Management, 2021, 58(3): 102472.

[41]CHEN C, ZHENG J, CHEN H. CosG: A graph-based contrastive learning method for fact verification[J/OL]. Sensors, 2021, 21(10).https:∥www.mdpi.com/1424- 8220/21/10/3471.

[42]CONROY N K, RUBIN V L, CHEN Y. Automatic deception detection: Methods for finding fake news[J/OL]. Proceedings of the Association for Information Science and Technology, 2015, 52(1): 1- 4.https:∥asistdl.onlinelibrary.wiley.com/doi/abs/10.1002/pra2.2015.145052010082.

[43]ZHOU X, JAIN A, PHOHA V V, et al. Fake news early detection: A theory-driven model[J/OL]. Digital Threats: Research and Practice, 2020, 1(2).https:∥doi.org/10.1145/3377478.

[44]FENG S, BANERJEE R, CHOI Y. Syntactic stylometry for deception detection[C]∥Proceedings of the 50th Annual Meeting of the Association for Computational Linguistics (Volume 2: Short Papers), 2012: 171-175.

[45]PÉREZ-ROSAS V, KLEINBERG B, LEFEVRE A, et al. Automatic detection of fake news[J]. arXiv preprint arXiv:1708.07104, 2017.

[46]KARIMI H, TANG J. Learning hierarchical discourse-level structure for fake news detection[J]. arXiv preprint arXiv:1903.07389, 2019.

[47]SHU K, WANG S, TANG J, et al. User identity linkage across online social networks: A review[J/OL]. SIGKDD Explor. Newsl., 2017, 18(2): 5-17.https:∥doi.org/10.1145/3068777.3068781.

[48]MOURATIDIS D, NIKIFOROS M N, KERMANIDIS K L. Deep learning for fake news detection in a pairwise textual input schema[J]. Computation, 2021,9(2): 20.

[49]MIKOLOV T, CHEN K, CORRADO G, et al. E icient estimation of word representations in vector space[J]. arXiv preprint arXiv:1301.3781, 2013.

icient estimation of word representations in vector space[J]. arXiv preprint arXiv:1301.3781, 2013.

[50]PENNINGTON J, SOCHER R, MANNING C D. Glove: Global vectors for word representation[C]∥Proceedings of the 2014 conference on empirical methods in natural language processing (EMNLP), 2014: 1532-1543.

[51]ARORA S, LIANG Y, MA T. A simple but tough-to-beat baseline for sentence embeddings[C]∥International conference on learning representations, 2017.

[52]LE Q, MIKOLOV T. Distributed representations of sentences and documents[C/OL]∥XING E P, JEBARA T. Proceedings of Machine Learning Re-search, Vol 32: Proceedings of the 31st International Conference on Machine Learning. Bejing, China: PMLR, 2014: 1188-1196.http:∥proceedings.mlr.press/v32/le14.html.

[53]HE K, ZHANG X, REN S, et al. Deep residual learning for image recognition[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition,2016: 770-778.

[54]HUANG G, LIU Z, VAN DER MAATEN L, et al. Densely connected convolutional networks[C]∥Proceedings of the IEEE conference on computer vision and pattern recognition, 2017: 4700- 4708.

[55]KIM Y. Convolutional neural networks for sentence classification[J/OL]. CoRR,2014, abs/1408.5882.

[56]CHO K, VAN ![]() B, GULCEHRE C, et al. Learning phrase representations using RNN encoder-decoder for statistical machine translation[J]. arXiv preprint arXiv:1406.1078, 2014.

B, GULCEHRE C, et al. Learning phrase representations using RNN encoder-decoder for statistical machine translation[J]. arXiv preprint arXiv:1406.1078, 2014.

[57]ALKHODAIR S A, DING S H, FUNG B C, et al. Detecting breaking news rumors of emerging topics in social media[J]. Information Processing & Management, 2020,57(2): 102018.

[58]CHOUDHARY A, ARORA A. Linguistic feature based learning model for fake news detection and classification[J]. Expert Systems with Applications, 2021, 169:114171.

[59]ASLAM N, ULLAH KHAN I, ALOTAIBI F S, et al. Fake detect: A deep learning ensemble model for fake news detection[J]. Complexity, 2021, 2021.

[60]VASWANI A, SHAZEER N, PARMAR N, et al. Attention is all you need[J]. arXiv preprint arXiv:1706.03762, 2017.

[61]CHOUDHARY M, CHOUHAN S S, PILLI E S, et al. BerConvoNet: A deep learning framework for fake news classification[J]. Applied Soft Computing, 2021:107614.

[62]KALIYAR R K, GOSWAMI A, NARANG P. FakeBERT: Fake news detection in social media with a BERT-based deep learning approach[J]. Multimedia Tools and Applications, 2021, 80(8): 11765-11788.

[63]KALIYAR R K, GOSWAMI A, NARANG P. DeepFakE: improving fake news detection using tensor decomposition-based deep neural network[J]. The Journal of Supercomputing, 2021, 77(2): 1015-1037.

[64]WANG W Y. “liar, liar pants on fire”: A new benchmark dataset for fake news detection[J]. arXiv preprint arXiv:1705.00648, 2017.

[65]KWON S, CHA M, JUNG K, et al. Prominent features of rumor propagation in online social media[C/OL]∥2013 IEEE 13th International Conference on Data Mining. 2013: 1103-1108.http:∥dx.doi.org/10.1109/ICDM.2013.61.

[66]VOSOUGHI S, ROY D, ARAL S. The spread of true and false news online[J/OL]. Science, 2018, 359(6380): 1146-1151.https:∥science.sciencemag.org/content/359/6380/1146.

[67]MA J, GAO W, WONG K F. Rumor detection on twitter with tree-structured recursive neural networks[C]. Proceedings of the 56th Annual Meeting of the Association for Computational Linguistics (ACL 2018), 2018: 1980-1989. https:∥ink.library.smu.edu.sg/sis_research/4561.

[68]WU K, YANG S, ZHU K Q. False rumors detection on Sina Weibo by propagation structures[C/OL]∥2015 IEEE 31st International Conference on Data Engineering. 2015: 651- 662.http:∥dx.doi.org/10.1109/ICDE.2015.7113322.

[69]CASTILLO C, MENDOZA M, POBLETE B. Information credibility on twitter[C/OL]∥WWW’11: Proceedings of the 20th International Conference on World Wide Web. New York, NY, USA: Association for Computing Machinery,2011: 675- 684.https:∥doi.org/10.1145/1963405.1963500.

[70]VISHWANATHAN S V N, SCHRAUDOLPH N N, KONDOR R, et al. Graph kernels[J]. Journal of Machine Learning Research, 2010, 11: 1201-1242.

[71]MA J, GAO W, WONG K F. Detect rumors in microblog posts using propagation structure via kernel learning[C]. Proceedings of the 55th Annual Meeting of the Association for Computational Linguistics (ACL 2017), 2017: 708-717. https:∥ink.library.smu.edu.sg/sis_research/4563.

[72]WU L, LIU H. Tracing fake-news footprints: Characterizing social media messages by how they propagate[C/OL]∥WSDM’18: Proceedings of the Eleventh ACM International Conference on Web Search and Data Mining. New York, NY, USA: Association for Computing Machinery, 2018: 637- 645.https:∥doi.org/10.1145/3159652.3159677.

[73]LIU Y, WU Y-F. Early detection of fake news on social media through propagation path classification with recurrent and convolutional networks[J/OL]. Proceedings of the AAAI Conference on Artificial Intelligence, 2018, 32(1). https:∥ojs.aaai.org/index.php/AAAI/article/view/11268.

[74]BIAN T, XIAO X, XU T, et al. Rumor detection on social media with bi-directional Graph convolutional networks[J/OL]. Proceedings of the AAAI Conference on Artificial Intelligence, 2020, 34(1): 549-556.https:∥ojs.aaai.org/index.php/AAAI/article/view/5393.

[75]LU Y-J, LI C-T. GCAN: Graph-aware co-attention networks for explainable fake news detection on social media[J]. arXiv preprint arXiv:2004.11648, 2020.

[76]HAN Y, KARUNASEKERA S, LECKIE C. Graph neural networks with continual learning for fake news detection from social media[J]. arXiv preprint arXiv:2007.03316, 2020.

[77]SAHOO S R, GUPTA B B. Multiple features based approach for automatic fake news detection on social networks using deep learning[J]. Applied Soft Computing,2021, 100: 106983.

[78]SILVA A, HAN Y, LUO L, et al. Propagation2Vec: Embedding partial propagation networks for explainable fake news early detection[J]. Information Processing &Management, 2021, 58(5): 102618.

[79]VESTMAN V, KINNUNEN T, HAUTAM KI R G, et al. Voice mimicry attacks assisted by automatic speaker verification[J/OL]. Comput. Speech Lang., 2020,59: 36-54.http:∥dx.doi.org/10.1016/j.csl.2019.05.005.

KI R G, et al. Voice mimicry attacks assisted by automatic speaker verification[J/OL]. Comput. Speech Lang., 2020,59: 36-54.http:∥dx.doi.org/10.1016/j.csl.2019.05.005.

[80]NEELIMA M, SANTIPRABHA I. Mimicry Voice Detection using Convolutional Neural Networks.2020 International Conference on Smart Electronics and Communication (ICOSEC), 2020:314-318, doi: 10.1109/ICOSEC49089.2020.9215407.

[81]ARIK S O, CHEN J, PENG K, et al. Neural voice cloning with a few samples[J]. arXiv preprint arXiv:1802.06006, 2018.

[82]GAO Y, SINGH R, RAJ B. Voice impersonation using generative adversarial networks[C]∥2018 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). IEEE, 2018: 2506-2510.

[83]MCAULAY R, QUATIERI T. Speech analysis/Synthesis based on a sinusoidal representation[J/OL]. IEEE Transactions on Acoustics, Speech, and Signal Processing, 1986, 34(4): 744-754.http:∥dx.doi.org/10.1109/TASSP.1986.1164910.

[84]HOLMES J. The influence of glottal waveform on the naturalness of speech from a parallel formant synthesizer[J/OL]. IEEE Transactions on Audio and Electroacoustics, 1973, 21(3): 298-305.http:∥dx.doi.org/10.1109/TAU.1973.1162466.

[85]DENNIS, KLATT H. Software for a cascade/parallel formant synthesizer[J/OL]. The Journal of the Acoustical Society of America, 1980, 67: 971-995. http:∥dx.doi.org/10.1121/1.383940.

[86]MOULINES E, CHARPENTIER F. Pitch-synchronous waveform processing techniques for text-to-speech synthesis using diphones[J/OL]. Speech Communication,1990, 9(5): 453- 467.https:∥www.sciencedirect.com/science/article/pii/016763939090021Z.

[87]TAYLOR P, BLACK A W, CALEY R. The Architecture of the festival speech synthesis system[C]∥In The Third ESCA Workshop in Speech Synthesis, 1998:147-151.

[88]TOKUDA K, NANKAKU Y, TODA T, et al. Speech synthesis based on hidden Markov models[J/OL]. Proceedings of the IEEE, 2013, 101(5): 1234-1252.http:∥dx.doi.org/10.1109/JPROC.2013.2251852.

[89]ZE H, SENIOR A, SCHUSTER M. Statistical parametric speech synthesis using deep neural networks[C/OL]∥2013 IEEE International Conference on Acoustics, Speech and Signal Processing. 2013: 7962-7966. http:∥dx.doi.org/10.1109/ICASSP.2013.6639215.

[90]LING Z-H, KANG S-Y, ZEN H, et al. Deep learning for acoustic modeling in parametric speech generation: A systematic review of existing techniques and future trends[J/OL]. IEEE Signal Processing Magazine, 2015, 32(3): 35-52. http:∥dx.doi.org/10.1109/MSP.2014.2359987.

[91]KIM S-J, KIM J-J, HAHN M. HMM-based Korean speech synthesis system for hand-held devices[J/OL]. IEEE Transactions on Consumer Electronics, 2006,52(4): 1384-1390.http:∥dx.doi.org/10.1109/TCE.2006.273160.

[92]BANNO H, HATA H, MORISE M, et al. Implementation of realtime STRAIGHT speech manipulation system: Report on its first implementation[J/OL]. Acoustical Science and Technology, 2007, 28(3): 140-146.http:∥dx.doi.org/10.1250/ast.28.140.

[93]KAWAHARA H, MORISE M, TAKAHASHI T, et al. Tandem-STRAIGHT: A temporally stable power spectral representation for periodic signals and applications to interference-free spectrum, F0, and aperiodicity estimation[C/OL]∥2008IEEE International Conference on Acoustics, Speech and Signal Processing. 2008:3933-3936.http:∥dx.doi.org/10.1109/ICASSP.2008.4518514.

[94]MORISE M, YOKOMORI F, OZAWA K. WORLD: A vocoder-based high-quality speech synthesis system for real-time applications[J/OL]. IEICE Trans-actions on Information and Systems, 2016, E99.D(7): 1877-1884.http:∥dx.doi.org/10.1587/transinf.2015EDP7457.

[95]HUNT A, BLACK A. Unit selection in a concatenative speech synthesis system using a large speech database[C/OL]∥1996 IEEE International Conference on Acoustics, Speech, and Signal Processing Conference Proceedings: Vol 1. 1996:373-376 vol.1.http:∥dx.doi.org/10.1109/ICASSP.1996.541110.

[96]LING Z-H, DENG L, YU D. Modeling spectral envelopes using restricted Boltzmann machines and deep belief networks for statistical parametric speech syn-thesis[J/OL]. IEEE Transactions on Audio, Speech, and Language Processing, 2013, 21(10): 2129-2139.http:∥dx.doi.org/10.1109/TASL.2013.2269291.

[97]VAN DEN OORD A, DIELEMAN S, ZEN H, et al. WaveNet: A generative model for raw audio[J/OL]. CoRR, 2016, abs/1609.03499. http:∥arxiv.org/abs/1609.03499.

[98]OORD A V D, KALCHBRENNER N, VINYALS O, et al. Conditional image generation with PixelCNN decoders[C]∥NIPS’16: Proceedings of the 30th International Conference on Neural Information Processing Systems. Red Hook, NY, USA: Curran Associates Inc., 2016: 4797- 4805.

[99]VAN DEN OORD A, KALCHBRENNER N, KAVUKCUOGLU K. Pixel recurrent neural networks[C]∥ICML’16: Proceedings of the 33rd International Conference on International Conference on Machine Learning-Volume 48. New York, NY, USA: JMLR.org, 2016: 1747-1756.

[100]VALIN J-M, SKOGLUND J. LPCNET: Improving neural speech synthesis through linear prediction[C/OL]∥ICASSP 2019-2019 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). 2019: 5891-5895.http:∥dx.doi.org/10.1109/ICASSP.2019.8682804.

[101]KALCHBRENNER N, ELSEN E, SIMONYAN K, et al. Efficient neural audio synthesis[J/OL]. CoRR, 2018, abs/1802.08435. http:∥arxiv.org/abs/1802.08435.

[102]LI R, WU Z, LIU X, et al. Multi-task learning of structured output layer bidirectional LSTMS for speech synthesis[C/OL]∥2017 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP), New Orleans, LA: IEEE,2017: 5510-5514.http:∥ieeexplore.ieee.org/document/7953210/.

[103]SOTELO J, MEHRI S, KUMAR K, et al. Char2Wav: End-to-End speech synthesis[C]∥2017 International Conference on Learning Representations, 2017: 1- 6.

[104]WANG Y, SKERRY-RYAN R, STANTON D, et al. Tacotron: Towards end-to-end speech synthesis[C/OL]∥Interspeech 2017. [S.l.]: ISCA, 2017: 4006- 4010.http:∥www.isca-speech.org/archive/Interspeech_2017/abstracts/1452.html.

[105]SHEN J, PANG R, WEISS R J, et al. Natural TTS synthesis by conditioning wavenet on MEL spectrogram predictions[C/OL]∥2018 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). Calgary, AB:IEEE, 2018: 4779- 4783.https:∥ieeexplore.ieee.org/document/8461368/.

[106]PING W, PENG K, GIBIANSKY A, et al. Deep Voice 3: 2000-Speaker neural text-to-speech[J/OL]. CoRR, 2017, abs/1710.07654. http:∥arxiv.org/abs/1710.07654.

[107]ZHANG Y-J, PAN S, HE L, et al. Learning latent representations for style control and transfer in end-to-end speech synthesis[C/OL]∥ICASSP 2019-2019 IEEE International Conference on Acoustics, Speech and Signal Processing(ICASSP). Brighton, United Kingdom: IEEE, 2019: 6945- 6949.https:∥ieeexplore.ieee.org/document/8683623/.

[108]GOODFELLOW I J, POUGET-ABADIE J, MIRZA M, et al. Generative adversarial networks[J/OL]. arXiv:1406.2661 [cs, stat], 2014. http:∥arxiv.org/abs/1406.2661.

[109]JUVELA L, BOLLEPALLI B, YAMAGISHI J, et al. GELP: GAN-excited linear prediction for speech synthesis from Mel-spectrogram[C/OL]∥Interspeech2019. [S.l.]: ISCA, 2019: 694- 698.http:∥www.isca-speech.org/archive/Interspeech_2019/abstracts/2008.html.

[110]KOTANI G, SUDA H, SAITO D, et al. Experimental investigation on the efficacy of Affine-DTW in the quality of voice conversion[C/OL]∥2019 Asia-Pacific Signal and Information Processing Association Annual Summit and Conference (APSIPAASC). 2019: 119-124.http:∥dx.doi.org/10.1109/APSIPAASC47483.2019.9023107.

[111]HU H T, YU C, LIN C H. HNM parameter transform for voice conversion using a HMM-WDLT framework[C/OL]∥2010 The 2nd International Conference on Industrial Mechatronics and Automation: Vol 2. 2010: 282-287. http:∥dx.doi.org/10.1109/ICINDMA.2010.5538313.

[112]SHIKANO K, NAKAMURA S, ABE M. Speaker adaptation and voice conversion by codebook mapping[C/OL]∥1991 IEEE International Symposium on Circuits and Systems (ISCAS). 1991: 594-597 vol.1. http:∥dx.doi.org/10.1109/ISCAS.1991.176405.

[113]STYLIANOU Y, CAPPE O, MOULINES E. Continuous probabilistic transform for voice conversion[J/OL]. IEEE Transactions on Speech and Audio Processing, 1998, 6(2): 131-142.http:∥dx.doi.org/10.1109/89.661472.

[114]TODA T, SARUWATARI H, SHIKANO K. Voice conversion algorithm based on Gaussian mixture model with dynamic frequency warping of STRAIGHT spectrum[C/OL]∥2001 IEEE International Conference on Acoustics, Speech, and Signal Processing. Proceedings (Cat. No.01CH37221): Vol 2. 2001: 841- 844 vol.2.http:∥dx.doi.org/10.1109/ICASSP.2001.941046.

[115]HELANDER E, SILEN H, VIRTANEN T, et al. Voice conversion using dynamic kernel partial least squares regression[J/OL]. IEEE Transactions on Audio, Speech, and Language Processing, 2012, 20(3): 806- 817. http:∥dx.doi.org/10.1109/TASL.2011.2165944.

[116]TIAN X, LEE S W, WU Z, et al. An exemplar-based approach to frequency warping for voice conversion[J/OL]. IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2017, 25(10): 1863-1876. http:∥dx.doi.org/10.1109/TASLP.2017.2723721.

[117]AIHARA R, UEDA R, TAKIGUCHI T, et al. Exemplar-based emotional voice conversion using non-negative matrix factorization[C/OL]∥Signal and Information Processing Association Annual Summit and Conference (APSIPA), 2014 Asia-Pacific. 2014: 1-7.http:∥dx.doi.org/10.1109/APSIPA.2014.7041640.

[118]ÇISMAN B, LI H, TAN K C. Sparse representation of phonetic features for voice conversion with and without parallel data[C/OL]∥2017 IEEE Automatic Speech Recognition and Understanding Workshop (ASRU). 2017: 677- 684. http:∥dx.doi.org/10.1109/ASRU.2017.8269002.

[119]SISMAN B, ZHANG M, LI H. Group sparse representation with WaveNet vocoder adaptation for spectrum and prosody conversion[J/OL]. IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2019, 27(6): 1085-1097.http:∥dx.doi.org/10.1109/TASLP.2019. 2910637.

[120]DONG M, YANG C, LU Y, et al. Mapping frames with DNN-HMM recognizer for non-parallel voice conversion[C/OL]∥2015 Asia-Pacific Signal and Information Processing Association Annual Summit and Conference (APSIPA). 2015: 488- 494.http:∥dx.doi.org/10.1109/APSIPA.2015.7415320.

[121]ERRO D, MORENO A, BONAFONTE A. INCA algorithm for training voice conversion systems from nonparallel corpora[J/OL]. IEEE Transactions on Audio, Speech, and Language Processing, 2010, 18(5): 944-953. http:∥dx.doi.org/10.1109/TASL.2009.2038669.

[122]SUNDERMANN D, HOGE H, BONAFONTE A, et al. Text-Independent voice conversion based on unit selection[C/OL]∥2006 IEEE International Conference on Acoustics Speech and Signal Processing Proceedings: Vol 1. 2006: I-I.http:∥dx.doi.org/10.1109/ICASSP.2006.1659962.

[123]KENNY P, BOULIANNE G, OUELLET P, et al. Joint factor analysis versus eigenchannels in speaker recognition[J/OL]. IEEE Transactions on Audio, Speech, and Language Processing, 2007, 15(4): 1435-1447. http:∥dx.doi.org/10.1109/TASL.2006.881693.

[124]OHTANI Y, TODA T, SARUWATARI H, et al. Non-parallel training for many-to-many eigenvoice conversion[C/OL]∥2010 IEEE International Conference on Acoustics, Speech and Signal Processing. 2010: 4822- 4825. http:∥dx.doi.org/10.1109/ICASSP.2010.5495139.

[125]MOHAMMADI S H, KAIN A. Voice conversion using deep neural networks with speaker-independent pre-training[C/OL]∥2014 IEEE Spoken Language Technology Workshop (SLT). 2014: 19-23.http:∥dx.doi.org/10.1109/SLT.2014.7078543.

[126]CHEN L-H, LING Z-H, LIU L-J, et al. Voice conversion using deep neural networks with layer-wise generative training[J/OL]. IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2014, 22(12): 1859-1872. http:∥dx.doi.org/10.1109/TASLP.2014.2353991.

[127]NAKASHIKA T, TAKIGUCHI T, ARIKI Y. High-order sequence modeling using speaker-dependent recurrent temporal restricted boltzmann machines for voice conversion[C]∥INTERSPEECH, 2014.

[128]NAKASHIKA T, TAKIGUCHI T, ARIKI Y. Voice conversion using RNN pre-trained by recurrent temporal restricted Boltzmann machines[J/OL]. IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2015,23(3): 580-587.http:∥dx.doi.org/10.1109/TASLP.2014.2379589.

[129]ZHANG J-X, LING Z-H, LIU L-J, et al. Sequence-to-sequence acoustic modeling for voice conversion[J/OL]. IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2019, 27(3): 631- 644. http:∥dx.doi.org/10.1109/TASLP.2019.2892235.

[130]TANAKA K, KAMEOKA H, KANEKO T, et al. ATTS2S-VC: Sequence-to-sequence voice conversion with attention and context preservation mechanisms[C/OL]∥ICASSP 2019-2019 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP), 2019: 6805- 6809.http:∥dx.doi.org/10.1109/ICASSP.2019.8683282.

[131]KAMEOKA H, TANAKA K, ![]() D, et al. ConvS2S-VC: Fully convolutional sequence-to-sequence voice conversion[J/OL]. IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2020, 28: 1849-1863. http:∥dx.doi.org/10.1109/TASLP.2020.3001456.

D, et al. ConvS2S-VC: Fully convolutional sequence-to-sequence voice conversion[J/OL]. IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2020, 28: 1849-1863. http:∥dx.doi.org/10.1109/TASLP.2020.3001456.

[132]MING H, HUANG D, XIE L, et al. Deep bidirectional LSTM modeling of timbre and prosody for emotional voice conversion[C/OL]∥Interspeech 2016, 2016:2453-2457.http:∥dx.doi.org/10.21437/Interspeech.2016-1053.

[133]KANEKO T, KAMEOKA H. CycleGAN-VC: Non-parallel voice conversion using cycle-consistent adversarial networks[C/OL]∥2018 26th European Signal Processing Conference (EUSIPCO), 2018: 2100-2104. http:∥dx.doi.org/10.23919/EUSIPCO.2018.8553236.

[134]KANEKO T, KAMEOKA H, TANAKA K, et al. Cyclegan-VC2: Improved cyclegan-based non-parallel voice conversion[C/OL]∥ICASSP 2019-2019 IEEE International Conference on Acoustics, Speech and Signal Processing(ICASSP). 2019: 6820- 6824. http:∥dx.doi.org/10.1109/ICASSP.2019.8682897.

[135]KAMEOKA H, KANEKO T, TANAKA K, et al. StarGAN-VC: non-parallel many-to-many Voice Conversion Using Star Generative Adversarial Net-works[C/OL]∥2018 IEEE Spoken Language Technology Workshop (SLT). 2018:266-273. http:∥dx.doi.org/10.1109/SLT.2018.8639535.

[136]KANEKO T, KAMEOKA H, TANAKA K, et al. StarGAN-VC2: Rethinking conditional methods for StarGAN-based voice conversion[C/OL]∥Interspeech2019. [S.l.]: ISCA, 2019: 679- 683. http:∥www.isca-speech.org/archive/Interspeech_2019/abstracts/2236.html.

[137]HUANG W-C, LUO H, HWANG H-T, et al. Unsupervised representation disentanglement using cross domain features and adversarial learning in variational autoencoder based voice conversion[J/OL]. IEEE Transactions on Emerging Topics in Computational Intelligence, 2020, 4(4): 468- 479. http:∥dx.doi.org/10.1109/TETCI.2020.2977678.

[138]PARK S, KIM D, JOE M. Cotatron: Transcription-Guided Speech Encoder for Any-to-Many Voice Conversion Without Parallel Data.in Interspeech 2020, Oct. 2020:4696-4700. doi: 10.21437/Interspeech.2020-1542.

[139]LUONG H-T, YAMAGISHI J. Bootstrapping non-parallel voice conversion from speaker-adaptive text-to-speech[C/OL]∥2019 IEEE Automatic Speech Recognition and Understanding Workshop (ASRU). 2019: 200-207. http:∥dx.doi.org/10.1109/ASRU46091.2019.9004008.

[140]ZHANG M, WANG X, FANG F, et al. Joint Training Framework for Text-to-Speech and Voice Conversion Using Multi-Source Tacotron and WaveNet.in Interspeech 2019, Sep. 2019:1298-1302. doi: 10.21437/Interspeech.2019-1357.

[141]SUN L, LI K, WANG H, et al. Phonetic posteriorgrams for many-to-one voice conversion without parallel data training[C/OL]∥2016 IEEE International Conference on Multimedia and Expo (ICME). 2016: 1- 6. http:∥dx.doi.org/10.1109/ICME.2016.7552917.

[142]BIADSY F, WEISS R J, MORENO P J, et al.Parrotron: An End-to-End Speech-to-Speech Conversion Model and its Applications to Hearing-Impaired Speech and Speech Separation.in Interspeech 2019, Sep. 2019: 4115-4119. doi: 10.21437/Interspeech.2019-1789.

[143]KAMEOKA H, KANEKO T, TANAKA K, et al. ACVAE-VC: Non-parallel voice conversion with auxiliary classifier variational autoencoder[J/OL]. IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2019, 27(9): 1432-1443.http:∥dx.doi.org/10.1109/TASLP.2019.2917232.

[144]SISMAN B, YAMAGISHI J, KING S, et al. An overview of voice conversion and its challenges: From statistical modeling to deep learning[J/OL]. IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2021, 29: 132-157. http:∥dx.doi.org/10.1109/TASLP.2020.3038524.

[145]COOPER E, YAMAGISHI J.“How do Voices from Past Speech Synthesis Challenges Compare Today?”. in 11th ISCA Speech Synthesis Workshop (SSW 11), Aug. 2021:183-188. doi: 10.21437/SSW.2021-32.

[146]KUBICHEK R. Mel-cepstral distance measure for objective speech quality assessment[C/OL]∥Proceedings of IEEE Pacific Rim Conference on Communications Computers and Signal Processing: Vol 1. 1993: 125-128 vol.1. http:∥dx.doi.org/10.1109/PACRIM.1993.407206.

[147]LO C-C, FU S-W, HUANG W-C, et al. MOSNet: Deep learning-based objective assessment for voice conversion[C/OL]∥Proc. Interspeech 2019. 2019: 1541-1545. http:∥dx.doi.org/10.21437/Interspeech.2019-2003.

[148]LENG Y, TAN X, ZHAO S, et al. MBNET: MOS prediction for synthesized speech with mean-bias network[C/OL]∥ICASSP 2021-2021 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). 2021:391-395. http:∥dx.doi.org/10.1109/ICASSP39728.2021.9413877.

[149]WU Z, EVANS N, KINNUNEN T, et al. Spoofing and countermeasures for speaker verification: A survey[J]. Speech Communication, 2015, 66: 130-153.

[150]DELGADO H, TODISCO M, SAHIDULLAH M, et al. ASVspoof 2017 Version2.0: meta-data analysis and baseline enhancements[C/OL]∥Odyssey 2018 - The Speaker and Language Recognition Workshop. 2018. https:∥hal.inria.fr/hal-01880206.

[151]KINNUNEN T, LEE K A, DELGADO H, et al. t-DCF: a detection cost function for the tandem assessment of spoofing countermeasures and automatic speaker verification[C/OL]∥Speaker Odyssey 2018 The Speaker and Language Recognition Workshop. 2018. https:∥hal.inria.fr/hal-01880306.

[152]WANG X, YAMAGISHI J, TODISCO M, et al.ASVspoof 2019: A large-scale public database of synthesized, converted and replayed speech, Computer Speech & Language, 2020, 64, 101114. https:∥doi.org/10.1016/j.csl.2020.101114.

[153]TODISCO M, WANG X, VESTMAN V, et al. ASVspoof 2019: Future horizons in spoofed and fake audio detection[J]. Proc. Interspeech 2019, 2019.

[154]SAHIDULLAH M, KINNUNEN T. A comparison of features for synthetic speech detection[C]∥in INTERSPEECH. 2015.

[155]TODISCO M, DELGADO H, EVANS N. Constant Q cepstral coefficients: Aspoofing countermeasure for automatic speaker verification[J/OL]. Computer Speech and Language, 2017, 45: 516-535.https:∥www.sciencedirect.com/science/article/pii/S0885230816303114.

[156]ANON. Chapter 10 -instantaneous frequency estimation and localization[G/OL]∥BOASHASH B. Time Frequency Analysis. Oxford: Elsevier Science, 2003:421- 464. https:∥www.sciencedirect.com/science/article/pii/B9780080443355500310.

[157]DEHAK N, KENNY P J, DEHAK R, et al. Front-end factor analysis for speaker verification[J/OL]. IEEE Transactions on Audio, Speech, and Language Processing, 2011, 19(4): 788-798.http:∥dx.doi.org/10.1109/TASL.2010.2064307.

[158]WU X, HE R, SUN Z, et al. A light CNN for deep face representation with noisy labels[J/OL]. IEEE Transactions on Information Forensics and Security,2018, 13(11): 2884-2896. http:∥dx.doi.org/10.1109/TIFS.2018.2833032.

[159]CHEN Z, XIE Z, ZHANG W, et al. ResNet and model fusion for automatic spoofing detection[C/OL]∥Proc. Interspeech 2017. 2017: 102-106. http:∥dx.doi.org/10.21437/Interspeech.2017-1085.

[160]ADIBAN M, SAMETI H, SHEHNEPOOR S. Replay spoofing countermeasure using autoencoder and siamese networks on ASVspoof 2019 challenge[J/OL]. Computer Speech and Language, 2020, 64: 101105. https:∥www.sciencedirect.com/science/article/pii/S0885230820300383.

[161]HU J, SHEN L, ALBANIE S, et al. Squeeze-and-excitation networks[J/OL]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2020, 42(8): 2011-2023. http:∥dx.doi.org/10.1109/TPAMI.2019.2913372.

[162]WOO S, PARK J, LEE J-Y, et al. CBAM: Convolutional block attention module[C]∥FERRARI V, HEBERT M, SMINCHISESCU C, et al. Computer Vision- ECCV 2018. Cham: Springer International Publishing, 2018: 3-19.

[163]PARK J, WOO S, LEE J, et al. BAM: Bottleneck attention module[J/OL]. CoRR,2018, abs/1807.06514. http:∥arxiv.org/abs/1807.06514.

[164]NAM H, HA J-W, KIM J. Dual attention networks for multimodal reasoning and matching[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2017.

[165]HUA G, TEOH A B J, ZHANG H. Towards end-to-end synthetic speech detection[J/OL]. IEEE Signal Processing Letters, 2021, 28: 1265-1269.

[166]TAK H, PATINO J, TODISCO M, et al. End-to-end anti-spoofing withRawNet2[C]∥ICASSP 2021-2021 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP), 2021: 6369- 6373.

[167]LUO A, LI E, LIU Y, et al. A Capsule network based approach for detection of audio spoofing attacks[C]∥ICASSP 2021-2021 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP), 2021: 6359- 6363.

[168]LI X, LI N, WENG C, et al. Replay and synthetic speech detection with res2net architecture[C]∥ICASSP 2021-2021 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP), 2021: 6354- 6358.

[169]LIU A T, YANG S-W, CHI P-H, et al. Mockingjay: Unsupervised speech representation learning with deep bidirectional transformer encoders[C/OL]∥ICASSP, 2020 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP), 2020: 6419- 6423.

[170]SNYDER D, GARCIA-ROMERO D, SELL G, et al. X-vectors: Robust dnn embeddings for speaker recognition[C]∥2018 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). 2018: 5329-5333.

[171]FARAJTABAR M, YANG J, YE X, et al. Fake news mitigation via point process based intervention[C/OL]∥PRECUP D, TEH Y W. Proceedings of Machine Learning Research, Vol 70: Proceedings of the 34th International Conference on Machine Learning. [S.l.]: PMLR, 2017: 1097-1106.http:∥proceedings.mlr.press/v70/farajtabar17a.html.

[172]RUBIN V L. Disinformation and misinformation triangle: A conceptual model for “fake news” epidemic, causal factors and interventions[J]. Journal of Documentation, 2019.

[173]GIACHANOU A, ZHANG G, ROSSO P. Multimodal multi-image fake news detection[C/OL]∥2020 IEEE 7th International Conference on Data Science and Advanced Analytics (DSAA), 2020: 647- 654.http:∥dx.doi.org/10.1109/DSAA49011.2020.00091.

[174]CAO J, QI P, SHENG Q, et al. Exploring the role of visual content in fake news detection[M/OL]∥SHU K, WANG S, LEE D, et al. Disinformation, Mis-information, and Fake News in Social Media: Emerging Research Challenges and Opportunities. Cham: Springer International Publishing, 2020: 141-161.https:∥doi.org/10.1007/978-3-030- 42699- 6_8.

[175]KHATTAR D, GOUD J S, GUPTA M, et al. MVAE: Multimodal variational autoencoder for fake news detection[C/OL]∥New York, NY, USA: Association for Computing Machinery, 2019: 2915-2921.https:∥doi.org/10.1145/3308558.3313552.

[176]SONG C, NING N, ZHANG Y, et al. A multimodal fake news detection model based on crossmodal attention residual and multichannel convolutional neural networks[J]. Information Processing & Management, 2021, 58(1): 102437.