1 引言

信息安全是国际上各国政府和公民的最迫切的基础安全,而数字信息疆域的安全即是国家重大安全战略之一,也是国家软实力的重要象征。近些年随着数字媒体在人们工作、学习、生活中的信息获取占比不断增大,且各种数字编辑工具的普及和计算机算力的大幅度提升、人工智能方法井喷式发展,出现了恶意再编辑篡改数字内容的黑色产业链,如成为CNN、BBC攻击其他政府政治舆论武器,以及各种明星代言虚假广告,甚至成为色情产业中牟取暴利的工具。国际上已经出现了诸多涉及到政治事件、政治人物、明星名人等著名数字信息篡改造假事件。这些数字内媒体篡改技术引发了全球人民对数字信息安全的恐慌和焦虑,对全球各国信息安全造成巨大威胁和挑战。随着人工智能等为代表的新技术不断涌现,促进数字篡改方法日益更新,数字媒体的篡改模式更加多样化,篡改隐蔽性更高,伪造媒体逼真度不断接近人眼感知极限。数字媒体“鉴真”已经成为全世界人民共同面对的难点问题。

目前,国际上Deepfake等工具已经衍生出了数十种新型的篡改工具,例如 Deepface,Zao APP等工具已经可以制造出大量的篡改视频,传统Adobe公司旗下“PS全家桶”等传统编辑工具,不断更新其算法,在图像和视频编辑领域的能力越来越大。综上所述,数字媒体安全在我国国家安全领域中暴露出新的威胁态势,总结以下四个方面:

(1)造假新闻视频和图片已经成为西方国家的一种新型舆论武器。例如西方媒体炮制“新疆种族灭绝”,“武汉病毒”等伪造新闻视频事件频发。“灰色滤镜”、深度伪造等技术正在被西方媒体恶意滥用。造假新闻视频和图片危害全球所有国家信息安全及政府公信力、政治人物的信誉等。

(2)造假媒体侵害个人隐私、财产安全及数字媒体版权利益。例如,Facebook、Google、抖音、ZAO等视频网站及社交媒体APP上存在很多被“换脸”或“表情劫持”的国家领导人和明星、名人的造假视频,如“Deepfake Queen”事件等。影视作品非法编辑成恶搞视频等,从而非法获取其商业利益,引发数字经济纠纷。而社交网络中造假图像和视频严重威胁每个人的数字身份的安全性和财产安全性。

(3)造假媒体催生新型欺诈新型犯罪。例如,近年来出现高仿真智能造假的“绑架虚拟人质视频诈骗”、“人脸合成视频诈骗”、“合成虚假图像/视频骗保”等,以骗取赎金、公司财务、保费等为目的的新型犯罪形式,造成了个人家庭、企业单位、政府机关等蒙受巨大经济损失,影响社会稳定、和谐。

(4)造假媒体危害国家司法公正和社会稳定。例如犯罪嫌疑人相关审讯/羁押视频、监控拍摄的犯罪过程视频、手机拍摄犯罪内容相关图像、视频等存在被劫持篡改编辑的风险。

针对上述数字编辑造假,即篡改技术而诞生的新技术——数字媒体篡改取证检测技术是近十几年来发展起来的热门研究领域。作为与篡改相对立的篡改取证检测技术,其发展也面临一些困难。经调研分析,难点总结为四点:

(1)目前数字音频、图像、视频的编码标准较多,开源和商业编码器种类繁多,且各种媒体可能遭受的篡改攻击方式也多种多样,这给篡改检测方法带来了极大的困难和挑战;

(2)目前已有的研究缺乏基础的篡改攻击理论和检测理论完备体系及高效的方法论等;

(3)目前数字编辑工具和算法繁多,从Adobe全家桶、到Deepfake工具,从人工编辑到自动编辑,从商业软件到个人爱好者的算法,使得数字媒体的编辑手段和边界无限扩大,造成数字篡改手段和技术的多样性;

(4)深度学习人工智能方法与媒体篡改编辑的深度融合,使得篡改逼真程度更上一个台阶,使得有效检测难度指数式增长。

尽管存在上述的问题,但数字媒体被动取证检测领域已经取得了丰富的成果,并已经在一些领域开始应用数字视频内容生成篡改方法。越来越多的篡改模型、攻击模型、检测模型、失真模型、统计特征模型、深度模型及漏洞模型等被学者和工程师们发现并面向上述问题,设计优化算法模型,使得数字媒体被动取证检测技术的理论体系不断完善,方法论也在不断发展与改进。

而在数字媒体篡改领域中最为复杂、最为隐蔽的视频文件篡改成为了当下热点问题和鉴定难题。下面将从数字视频篡改国内外现状、篡改技术现状、检测技术现状,以及现有攻击工具和国际标准数据集等方面展开介绍。

数字媒体篡改取证检测技术(Digital Tampered Media Forensic Detection Technology)是一门综合性学科,包含了数字信号处理、数字图像/视频处理、数学形态学、概率统计学、模式识别、密码学、心理学、人工智能学、信息论等综合性学科。这里面所提到的数字取证检测技术与传统物理取证技术、计算机取证技术是不同类型的技术,所涉研究科学问题不同,但三类技术具有互补性。数字媒体篡改取证检测技术分为主动式和被动式取证检测技术两种,其中主动式的方法包含数字水印技术、数字签名技术、区块链技术等,而被动取证检测技术可分为时空域和编码域被动检测技术以及深度网络模型检测技术。本文着重从数字媒体中数字视频被动取证检测技术角度来阐述。

数字视频取证检测技术的一般定义:为了鉴定数字视频可能经历的后操作处理的历史操作链检测技术集合。而数字视频被动取证检测技术则是指无需已知视频原始信息,而通过统计分析方法识别其内在特征一致性的突变或特殊非典型特征统计分布存在,从而发现篡改操作链的技术方法集合。目前该技术可以分为两大类:一类是针对特定篡改方法的检测算法,也称为专用篡改痕迹被动检测算法[1];另一类是针对多种篡改痕迹统计分析方法的检测算法,也称通用篡改痕迹被动检测算法[2-3]。从公开发表论文数量来看,目前绝大多数的被动篡改检测算法都是专用类型的算法,且效果十分显著;而少数通用算法针对篡改检测的效果还有待进一步提高和完善。尤其是通用算法目前对篡改类型的识别能力不足,只能判断是否经历了篡改过程。但是通用算法的最大优势就是快速筛选和识别经历篡改的数字视频,然后可以再用专用被动检测算法识别其可能的篡改操作类型或者溯源篡改操作链。

2 数字视频再编辑技术

数字视频编辑工具非常普遍,例如ADOBE全家桶,美图工具,抖音美白工具、DeepFake工具等。这些编辑技术使得对视频再编辑操作变得容易和逼真。

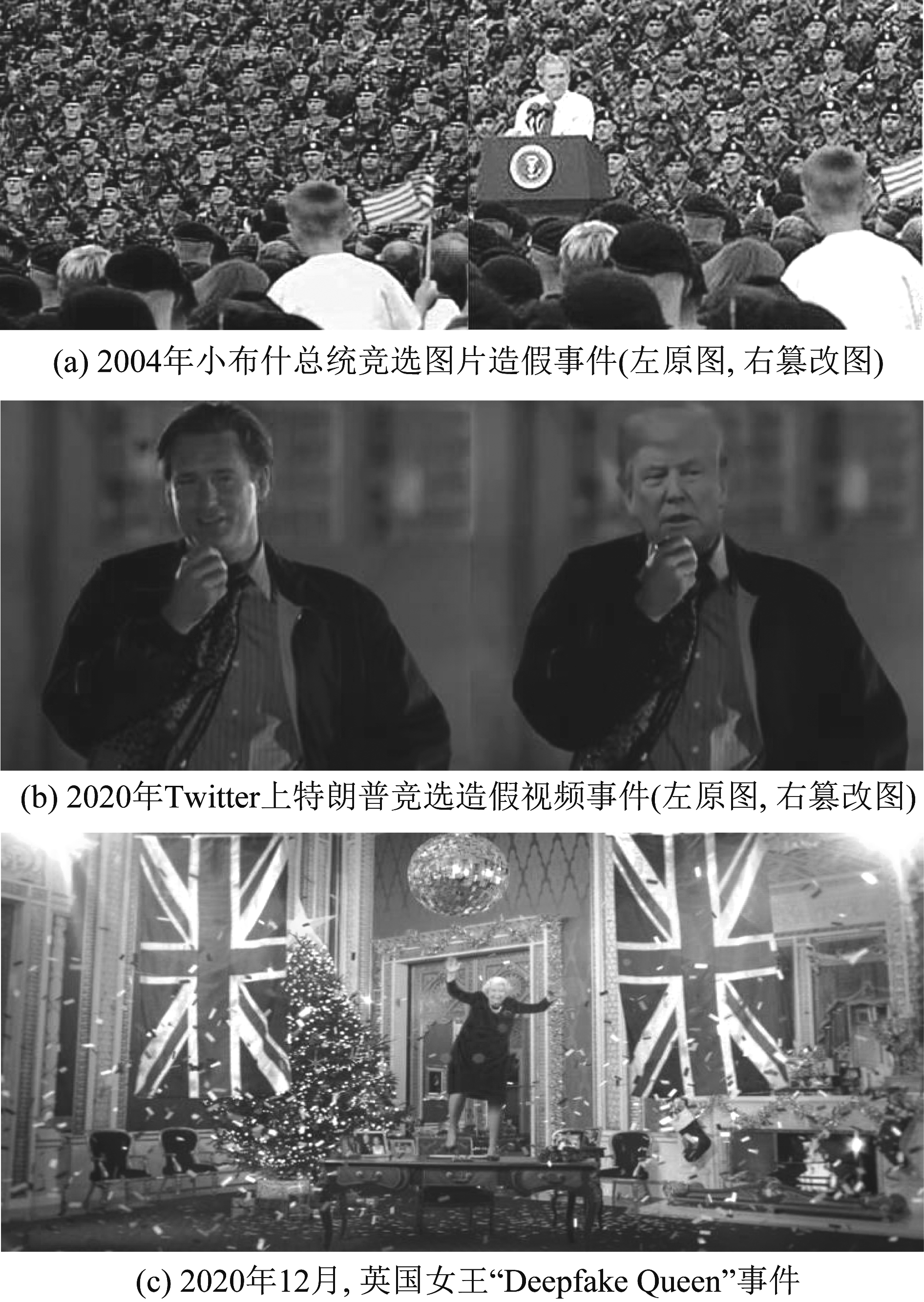

图1中后两个案例都是2020年发生的数字视频篡改造假的最新国际事件。图1(a)是2004年小布什竞选时所用的宣传画,也是用电脑做了PS的处理,但早期的PS效果还存在一些人眼可以分辨的瑕疵;图1(b)是2020年Twitter上特朗普竞选造假视频事件,此时的PS已经使用了最先进的人工智能技术进行生成,在人眼视觉方面达到“以假乱真”,甚至面部表情都是同步的;图1(c)是2020年12月英国第四频道独家炮制了英国伊丽莎白二世女王 “Deepfake Queen”事件,让女王在圣诞节之夜独自秀了一段在圣诞致辞中跳起了TikTok热舞,尽管事后第四频道宣称此段视频采用Deepfake技术将美国著名演员黛布拉·斯蒂芬森的人脸替换成了女王的人脸。但是造成了巨大的新闻轰动和舆论抨击。这些事件显示了数字媒体造假的技术正在史无前例地不断迅猛发展。据人工智能安全公司Sensity.AI的最新数据显示:在2020年中,互联网上发布了超过60000个深度虚假视频。数字视频编辑篡改技术已经成为破坏力极强的信息战和舆论战的武器之一。数字视频编辑篡改技术的一般定义:为了视频画面提质、传输、存储,或改变内容内在关系的后编辑操作的技术集合。这一后编辑操作可能是常规的需求,也可能是恶意的目的。目前,本文中将常见的数字视频编辑篡改技术分为四大类:

图1 数字媒体篡改的著名案例

Fig.1 Famous cases of digital media tampering

第一类,数字视频文件再编辑的篡改方法:本文是指针对数字视频的码流、或者编码参数、容器等的编辑,达到对原始视频文件的再编辑目的,一般不改变视频内容。例如,码率重采样、视频格式转码、容器转换、各种滤波器操作等后处理操作。

第二类,数字视频内容再编辑的篡改方法:本文是指针对数字视频的部分解码或完全解码后内容进行内容级编辑操作,达到对原始视频内容的再编辑目的。例如,视频帧间插入/删除攻击、帧内复制粘贴攻击操作等。

第三类,数字视频内容生成的篡改方法:本文是指针对数字视频内容的部分生成替换或全部生成虚拟目标全局替换,进行视频内容级编辑操作,达到对原始视频内容的再编辑目的。例如,使用deepfake生成虚拟人物或目标的视频内容等操作。

第四类,数字视频的重拍摄篡改方法:本文是指针对数字视频内容的重新数字采集再编辑操作,达到对原始视频内容的再编辑目的。例如,利用数字设备对屏幕画面进行重新拍摄和再编辑操作。

俗话说:“知己知彼,百战不殆”,下面详细阐述视频再编辑篡改的经典算法,具体如下:

2.1 数字视频文件编辑篡改方法

视频文件编辑篡改是指在不改变视频内容的前提下对视频文件的编辑操作,比如转码操作、分辨率提升/降低、平滑操作、锐化操作、去噪操作、信息隐藏操作等。在保证视频内容不变的前提下,可以躲过很多人为检查达到传递各种有效信息的目的。例如通过一部广泛传播的电影视频,在其中进行数字视频文件编辑篡改。从人体肉眼来看,这部电影在内容上并没有什么变化。而接受信息者则可以通过这个电影视频的改动,进行逆向操作破解获取到有效信息。这适用于网络中现实中一些地下产业,非法组织进行有害、非法信息的传播联系。对社会造成极大的潜在威胁。

数据隐藏技术可以在不影响视觉效果的前提下,向视频内嵌入信息,实现对视频文件的编辑。例如,北京交通大学的李赵红等人[4]研究了P帧各种尺寸PU划分类型在隐写前后的数目变化,构建了25维和3维特征用来检测HEVC视频的块划分模式隐写算法。帧率变化是通过提升或下降视频的帧率方法来达到编辑视频文件的目的。Khoubani等人[5]基于模糊平滑的快速四元数小波运动补偿进行帧率上转换。这篇论文使用图像序列的相位来考虑QWT运动估计,实现了更准确的运动估计、更少的后处理流程和更低的复杂度。码率变换是另外一种视频文件编辑的方法,Kevin等人[6]提出一种通过求解优化问题来选择比特率的方法即Bola算法,这是一种基于缓冲区的算法,通过将比特率选择建模为一个优化问题,并对给定的缓冲区值进行了求解,从而提高用户的视频服务质量。Yin等人[7]提出了MPC算法,该算法会对吞吐量缓冲区占用率有一定的预测性,根据最近下载的块的吞吐量样本预测未来块下载的吞吐量,然后使用这个预测的吞吐量选择比特率,来优化一个给定的QoE函数,从而达到调节码率的目的。对视频滤波可以过滤掉视频中的噪声,受深度学习在图像超分辨率、图像去噪等领域成功应用的启发,Kim等人[8]结合残差学习方式提出了IFCNN网络,用以取代视频编码中的环路滤波算法,即把未经环路滤波的重建图像直接输入网络进行增强处理。

综上所述,数字视频文件编辑篡改方法多种多样,篡改的手段和目的各不相同。无论是信息隐藏技术,还是视频滤波器技术等,都给数字视频的原始性、唯一性和真实性带来了挑战。从信息安全角度来讲,这些操作都是不安全的,需要检测和溯源。

2.2 数字视频内容编辑篡改方法

视频内容篡改是指部分解码或全解码后,针对音频、图像、视频中特定对象的操作过程,其结果是改变内容的原始属性,导致内容的不可信。从视频帧目标被攻击角度来看,数字视频内容编辑篡改分为帧间编辑篡改和帧内编辑篡改。

视频的帧间编辑篡改方式主要有:帧删除篡改,即删除原始视频的至少一帧或连续多帧的操作;帧插入篡改,即非同源视频的帧片段插入到原视频帧序列中的操作;帧复制粘贴篡改,即同源视频的帧片段在相同视频中不同时间轴上复制插入到原视频中的操作。针对这类视频内容的帧间编辑篡改问题,2012年孙锬锋等人[9]提出了视频帧间篡改中主要篡改类型的定义,即包括视频帧复制粘贴、帧插入、帧删除等,其中对于帧的复制粘贴,可以划分为同源和异源两类,同源的帧复制表示复制的对象来自于当前视频片段,而异源帧复制粘贴是将其他视频的片段复制到当前视频片段中。2014年王婉等人[10]根据场景的差异性将视频内容编辑篡改划分为静止背景下的内容编辑篡改以及包含运动背景的篡改场景,并提出了一种可以同时检测帧删除,帧插入及帧复制的算法。同年柏正尧等人[11]针对帧间篡改对帧间相关性进行研究,并将非负张量分解(Nonnegative tensor factorization, NTF)算法应用到了视频帧间篡改检测中。与帧内篡改模式不同,帧间篡改需要对连续的帧序列进行处理[12]。冯春晖等人[13]通过分析残差强度在不同宏块间分布是否具有波动性来检测视频是否被帧删除,并定位删除点的位置。该作者在[13]的基础上进一步分析了具有丰富运动信息下的视频帧间篡改场景,考虑到运动视频容易导致帧间数据特征的变化,作者从帧间差异的角度,提出了一种删帧检测算法[14],对复杂篡改环境下的序列中不同干扰帧进行分析,并利用运动残差特征区分不同干扰帧和删帧位置处的帧,进而提出一种去帧内编码处理算法,使算法能够应对运动信息带来的影响。不同于视频内容帧间篡改,视频内容帧内篡改并非以帧为单位进行篡改,而是以目标为单位进行编辑篡改操作,2021年Yang Quanxin等人[12] 指出视频帧内篡改主要有空域复制粘贴,帧内目标移除等,作者发现帧内篡改将引起视频在时空域上的高频信息的波动。

无论是视频帧内编辑篡改还是视频帧间编辑篡改,都能够极大地改变原始视频的内容信息,进而影响人们对客观事物和内在关系逻辑的认知。随着篡改手段的不断改良以及硬件设备的升级,视频编辑篡改的门槛越来越低,篡改视频的逼真程度也越来越高,对此类篡改视频的检测需求越来越强烈。

2.3 数字视频内容生成篡改方法

视频内容生成方法是指在GAN网络及其衍生网络根据对抗原理,即生成器和判别器构成网络,从一幅噪声图像不断逼近真实图像的方法,其生成图像和视频并不是真实的物理拍摄获得。

Elor等人[15]的方案可以生成含有人物的视频,并且可以通过扭曲来轻微改变人物的头部姿势。因为这种方法是基于单个目标图像的,它从源视频中的嘴唇内部复制到目标视频,因此仅能部分保留目标视频中的人物身份。Kim等人[16]的做法相对于以前的方法而言,可以生成更为逼真的视频。当研究人员拿一个人在说话的真实视频和由深度学习网络基于前者生成的视频进行对比时,结果证明两者几乎没有差别。Deep Video Portraits可以通过一段目标人物的视频,来学习构成脸部、眉毛、嘴角和背景等的要素以及它们的正常运动是什么样子。然后,通过仔细追踪源视频中相同的标志物,Deep Video Portraits就可以对目标人物的脸部进行必要的扭曲,将源视频中人物的动作和表情用作那些视觉信息的来源。Zhou等人[17]使用音频来生成视频。他们将一个无声的视频分解为两部分,一部分是人物身份信息,另一部分是语音信息,这里的语音信息是指通过人物嘴部动作传递出来的广义语音信息,而非听到的声音。Fried等人[18]基于文本来编辑视频。给定任意文本,该方法就能改变一段视频中人物所说的话,同时保持无缝的试听流。要对一段视频中人物讲话内容进行改变,只需要编辑一下想要表达的文本内容,这种方法十分地简单易行。Suwajanakorn等人[19]对人脸中的口型进行替换。这种方法主要包括四个步骤。第一,使用RNN将输入的音频映射到稀疏的嘴部形状轮廓,该轮廓由若干个点组成,包括嘴唇内部和嘴唇外部。第二,使用生成的轮廓来产生人物嘴部的纹理特征。第三,对所得的视频帧进行重新排序,从而匹配头部动作和嘴型,使生成的视频看起来更加自然。第四,将下巴和颈部进行对齐,生成最终的伪造视频。

由于数字视频内容生成篡改工具日趋多样化,各种对抗生成深度网络效果良好等特点,生成数字视频的质量也在不断完善。此技术在很多影视作品中生成逼真的虚拟画面和人物方面具有得天独厚的优势。但同时此技术也正在被滥用到网络视频、监控视频等,造成视频内容的真实性的真假难辨问题。

2.4 数字视频重拍摄的篡改方法

数字视频重拍摄的篡改方法是指物理上用物理设备对数字视频内容播放进行重拍摄而造成内容时空含义混乱,达到篡改内容的目的,也就是“二次拍摄篡改编辑”。

现有的重拍摄的编辑篡改方法主要根据拍摄设备、拍摄场景以及拍摄对象的差异进行分类[20],主要包括面向液晶屏幕(LCD)的重拍摄篡改、面向手持设备的重拍摄篡改、面向彩色显示设备的重拍摄篡改等。Lee等人[20]提出目前重拍摄视频大部分产生于视频投放到液晶屏幕(LCD)上时被重拍摄,因此该作者重点研究LCD显示的视频重拍摄编辑篡改。P. Bestagini等人[21]提出了同步性不一致的重拍摄编辑篡改,作者指出重拍摄中的同步性不一致会产生块重影现象,具体表现为图像块在视觉特性上的重叠。另外,Xavier等人[22]根据电影被投影时引起屏幕空间上的亮度重分配效应、垂直投影在屏幕上的图像的稳定性效应、高频闪烁的显示屏与摄像机快门之间的相互作用这三种效应设计不同的重拍摄编辑篡改场景。Mahdian等人[23]分析了不同品牌LCD显示屏的重拍摄视频在频谱波纹上的差别。除了针对LCD屏幕的重拍摄,重拍摄编辑篡改还包括以手持摄像机拍摄的视频。此类视频中的运动分为帧内运动和手持引起的全局运动,其中全局运动为手持重拍摄独有的效应。Marco等人[24]提出了具有的全局运动特征的手持拍摄视频编辑篡改。另外,图像重拍摄编辑篡改方面的几个经典场景同样也可以在视频重拍摄上适用。比如Thongkamwitoon[25]针对图像的类别差异构建重拍摄图像集合,通过挖掘彩色图像和黑白图像在色度上的差异引起的重拍摄图像在像素上的失真特性对图像进行重拍摄检验。Anjum等人[26]通过挖掘图像中高层次边缘细节特征,进而根据在原始图像和重拍摄图像中不同组别的边缘像素数量具有一定差异这一特性,构建具有不同边缘特性的重拍摄场景并进行分类。

当然,随着视频录制设备以及网络媒体的发展,视频重拍摄的编辑篡改方法也在不断更新,大部分学者研究LCD屏幕上视频的重拍摄,利用LCD屏幕特性提取特征进行分类识别。也有部分学者将研究聚焦在手持拍摄设备下的重编码场景,总体来说,重拍摄编辑篡改的方法还较为单一,但仍具有研究潜力。

上述数字视频编辑技术表明了:

1)数字视频无论是编码复杂性,还是数据量的规模庞大,都给篡改编辑带来了更多的可利用空间和隐藏空间;

2)篡改攻击的角度多样性,导致了针对篡改类型的通用识别算法实现具有较大难度。

针对上述篡改编辑类型,对目前已经取得的被动检测成果进行介绍和分析。

3 数字视频被动取证检测技术

上述数字视频篡改编辑技术种类繁多,从码流级到像素级,从人工方法到智能方法,从时空域到编码域编辑。这些篡改方法具备隐秘性,但是也在某一层面上有迹可循,在对视频篡改编辑过程中,产生各种篡改数据,篡改数据可能破坏原始数据的分布而造成异常点的发生,甚至造成非典型特征分布模式等情况。进而形成了一系列与之对抗的数字视频被动检测技术,来解决视频篡改问题。

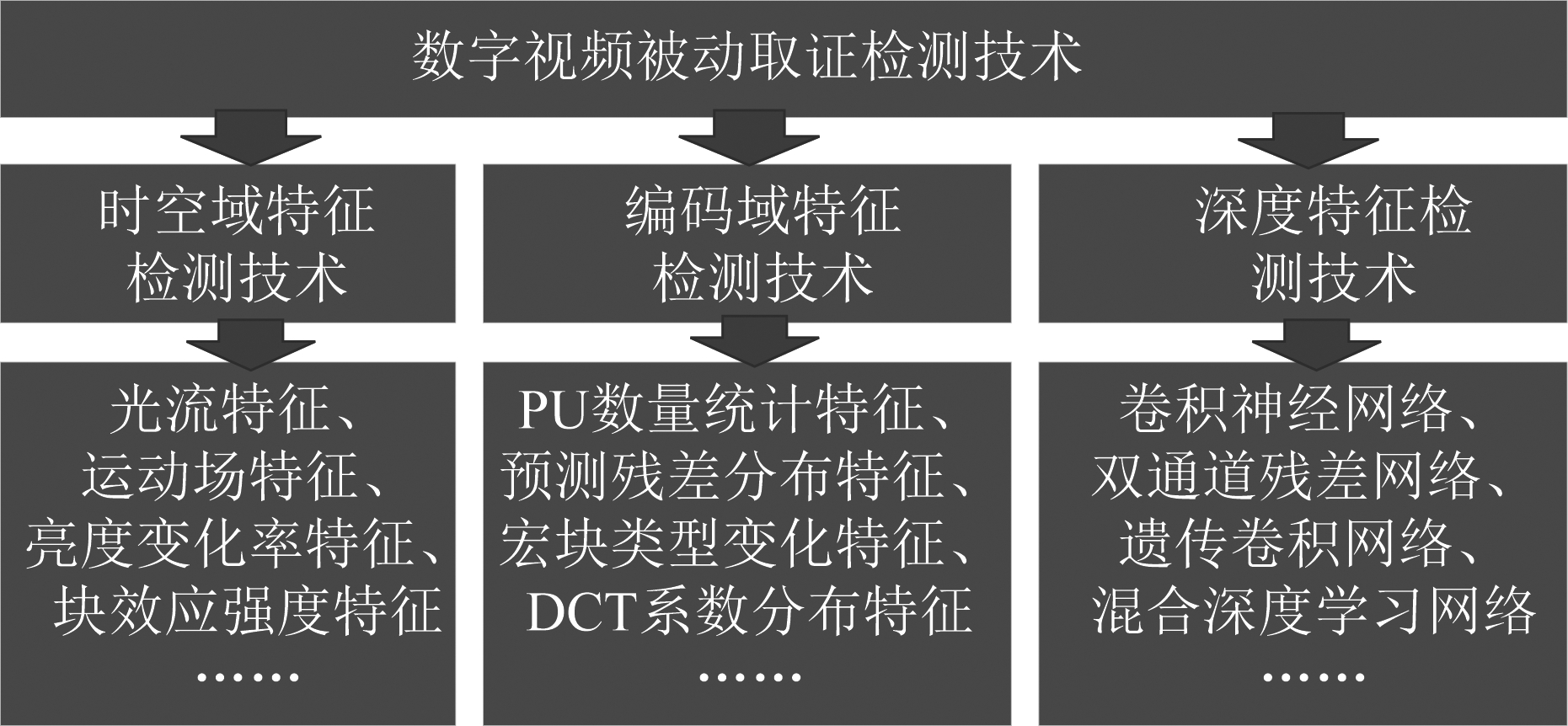

正如第二节中介绍,若要检测技术与篡改技术相抗衡,现存的问题包括:数据编码的多样性,视频数据的冗余性,编辑算法多样性,深度学习技术的进化性等。面对这些问题,数字视频被动取证检测技术也在不断发展。经过对参考文献的充分分析,总结了数字视频被动取证检测技术如图2所示。

图2 数字视频被动检测技术的分类图

Fig.2 Classification of digital video passive detection technology

在图2中我们把数字视频篡改被动取证技术分为三类:

1)时空域特征检测技术。即无论是音频、图像、视频完全解码后,就会是一种结构化或半结构化的媒体原始文件,在原始文件上,可以构建各种物理、几何、光学等的传统数学特征模型,而这些数学模型通常是某种目标特征属性的固定模式、或者连续变化的某种特征数据表征。篡改编辑的过程中会破坏这种上述固定内在模式,引起连续性质的某些突变、或者出现某些特殊非典型痕迹残留分布等情况,而这些情况就可以通过针对时空特征建模方法来加以检测和识别。代表性算法如图2左下图中所示。

2)编码域特征检测技术。即在数字媒体不完全解码的情况下,码流域、编码域的编码参数、编码域的预测模式、编码域分块模式等环境下,同样具有潜在的首次编码后的系数分布规律和特殊内在统计模式。而这种潜在的分布规律和模式,需要构建高维特征模型,如高阶概率统计模型、多模态融合特征模型等才能洞悉其规律。而且这种高维特征模型对人眼和人耳不可感知的细微编辑痕迹更为敏感。而且编码技术本身也会对数字媒体产生失真效果,因此,对完全解码后媒体数据可能带来意想不到的影响。但是在编码域对篡改痕迹直接展开分析的同时,已经充分考虑了编码失真的影响,在检测过程中可以更加精细化感知各种篡改编辑残留的痕迹。代表性算法如图2中下图所示。

3)深度特征检测技术。即无论数字媒体是什么容器格式或者什么编码,首先需要生成大量的篡改样本,把篡改样本进行初步的预处理之后,直接送到深度网络模型中加以学习叠代,直到获得预期稳定的输出,此时深度网络特征模型已经完成了参数训练,此后只需要给定输入就可给出分类结果。当然目前为止,这样简单粗暴的方法效果并不明显。学者们纷纷提出了多样化的深度网络模型、预处理方法、增加Attention机制、修剪网络无意义的层、增加强化学习的机制等等。通过深度网络自主学习的能力,学习到人类目前无法感知的特征,增强对篡改数据规律知识的学习,最终能否优于人类设计特征的效果。但是目前为止,大部分的深度网络模型对全局学习的效果不佳。代表性算法如图2右下图所示。

3.1 时空域特征检测技术

在数字视频的拍摄过程中,相邻帧或像素之间往往存在一定的关联,而对于视频的篡改往往会破坏这种关联性,因此视频篡改操作往往会在时空域留下痕迹。在文献中,时空域的检测算法能够直接对篡改痕迹像素或帧之间的异常特性进行建模,但算法复杂度往往较高。

文献[27]中,巢娟等人提出了一种基于光流一致性的帧间篡改检测方法,针对帧插入和帧删除的细微差别,提出了两种不同的检测方案。实验表明,该方案在识别帧插入和帧删除模型方面取得了较好的效果。在文献[28]中,吴俞醒等人提出了一种基于速度场一致性的视频帧间伪造(连续帧删除和连续帧复制)检测算法。在文献[3]中,许强等人结合GOP结构非对齐的HEVC重编码引起的质量下降特性,通过分析HEVC编码标准中帧间编码对重建像素值的影响,提出基于帧间质量下降机制分析的检测算法,该算法对GOP结构非对齐的重编码检测问题能取得0.98以上的AUC值。而对于视频转码检测,在[29]中,许强构建了去块滤波模式决策特征以及SAO补偿特征来进行重编码的检测,算法分别在公开数据集上进行了验证,算法能取得97.21%的平均准确率。在文献[30-31]中,何沛松等人将待测视频解码为一连串连续的视频帧后,根据块效应强度变化规律的不同能够对视频双编码视频进行检测。在文献[32]中,杨高波等人提出了一种基于边缘强度的被动取证方法来检测候选视频中可能的视频帧速率上转换(FRUC)操作。平均检测准确率达94.5%。在文献[33]中,边山等人在大量实验的基础上,发现目前大多数视频编辑软件中采用的帧速率上转换算法不可避免地会在生成的视频帧序列的帧间相似性中引入一些周期性的伪影。

综上所述,时空域特征检测技术可以较全面的解决帧间和帧内篡改编辑的被动检测问题,但仍存在以下问题:

(1)视频包含快速运动的信息,或者包含场景切换,算法的性能将下降。这个问题是目前被动检测算法中普遍存在的鲁棒性问题,有待改善。

(2)在重编码比特率较低时检测性能会出现明显下降。这是因为视频重编码时比特率(画面质量)较低,会造成严重的信息失真,与篡改编辑痕迹耦合在一起,造成检测困难。这一问题应该系统研究比特率变化与篡改编辑痕迹变化之间的关系。

(3)时空特征检测技术基本上都是针对专用篡改编辑而设计的,因此通用性和泛化能力都十分有限。有的算法对复合篡改编辑的方式显得无能为力。这也是未来要解决的重要问题之一。

3.2 编码域特征检测技术

视频重编码操作是在首次编码的基础上再一次执行编码操作,基于编码域特征统计分析的视频重编码痕迹检测算法实际上就是根据重编码操作对视频编码后的参数扰动关系构建检测依据,依赖手工设计的特征来进行检测的算法。

在文献[34]中,DAVID等人提出了基于预测痕迹变化(VPF)的二次压缩篡改检测算法。针对重编码P帧的宏块预测类型的变化来检测二次压缩后留下的痕迹,同时借助峰值出现的周期性来预测首次压缩时的GOP值,该方法解决了之前的检测算法中算法准确率受到第二次压缩参数选择影响的缺陷,提供了一种性能较为稳定且综合准确率在90%以上的算法,但该方法在视频序列较短时效果一般,且在实验过程中未考虑B帧的影响。在文献[35]中,该团队在MPEG-2标准上提出了一种基于广义VPF(G-VPF)的双压缩检测算法,该方法将VPF应用扩展到包含B帧的视频序列,通过对双压缩方案进行率失真分析,引入了运动矢量来增强VPF的获取过程,随后指出了B帧存在引起的VPF移位,并在算法中通过补偿这种移位来增强了算法的检测效率,试验结果表明该方法不仅在双重压缩检测和GOP大小估计方面优于其他方法,而且在计算时间上也更有优势。在文献[36]中,王让定等人提出了一种基于量化DCT系数以及TU尺寸的算法用于检测双压缩中不同QP的场景,该算法将四维的TU尺寸特征,四维的TU统计特性特征以及九维的量化DCT系数分布特征并使用SVM进行分类,在首次压缩使用QP(QP1)大于重压缩使用QP(QP2)的情况下达到了98%以上的准确率。该方法仅提取了17维特征,大大增加了检测效率,但在QP1大于或等于QP2的场景中效果一般。在文献[37]中,赵耀等人提出了一种能针对H.264自适应场景的重压缩检测算法,该算法利用了在重压缩的过程中,一段自适应编码区域的最后一个I帧不随压缩变化的特性,基于序列帧比特度量(FBC)来构建特征并进行判断,该方法弥补了重压缩算法在自适应场景下的缺失,在该场景中实现了较高的准确率。在文献[38]中,赵耀等人通过对预测模式特征(PMF)的分析,提出了一种用于假高清视频场景的重压缩检测方案,该方法首先从四个方向的帧内预测模式中提取一个四维特征。其次,从三个预测模式中提取了6维特征。最后,将这两种特征集结合到PMF中,检测出假高清视频,并进一步估计其原始QP和比特率。实验结果表明,该方法的性能优于现有的算法,且在高清晰度的视频中也有很好的效果。在文献[39]中,蒋兴浩等人提出了一种基于帧内预测模式的新方法。文献分析了帧内编码的质量退化机理,并充分考虑了帧内编码的误差来源,建立了等效误差模型,随后提出了基于帧内预测模式统计特征的双HEVC压缩检测特征模型。最后,用720p和1080p的HEVC视频代替低分辨率(CIF或QCIF)视频进行了实验。实验结果表明,与现有方法相比,该方法具有更好的效率。此外,该方法对不同的编码配置具有较强的鲁棒性。

综上所述,该类检测算法能有效的检测普通场景下的重编码操作,但存在一些不足:

(1)算法过度依赖解码器对参数的提取,并且容易受到反取证手段的攻击。

(2)当视频包含强运动成分信息或场景切换时,算法性能将下降。

(3)智能编码技术的兴起,给重编码检测带来了新的危机。

3.3 深度特征检测技术

近年来,卷积神经网络(CNN)已经在多媒体取证领域取得成功应用。 CNN 能够从训练样本中自动有效地学习层次化的特征表达。受此启发,一系列算法利用卷积神经网络来解决视频重编码痕迹检测问题。

在[40]中,何沛松等人首先建立视频帧集合,以 3 帧为单位进行分块,若 3 帧中第二帧为重定位I 帧,则该片段定义为正样本,否则为负样本。通过这种预处理操作,构建一个卷积神经网络,利用平均池化,作者能很好地检测出重定位 I 帧。类似的,在 [41]中, 许强等人通过构建 Genetic CNN,来进行AVC视频中重定位 I 帧的检测。不同于一般的卷积神经网络, Genetic CNN 能够结合遗传算法,实现自动设计网络架构的目的,通过算法对比,该算法的有效性得到验证。在[42]中,何沛松等人通过构建一个混合深度神经网络来揭露伪高清的HEVC重编码视频。通过提取基于块的残差信号,并构建一个双支路的网络进行检测,不同分支的输出向量将拼接后再联合优化得到逐块的检测结果。最后采用多数投票(local-to-global)策略得到最终的检测结果。除此之外,何沛松等人在[2]中提出了一种混合神经网络,通过从压缩域中的编码信息中学习鲁棒时空表示,来揭示具有双重压缩的HEVC视频中异常帧。该文献提出了两种编码信息图,包括CU尺寸图(CSM)和CU预测模式图(CPM)。与传统的基于解码帧像素级表示的模式不同,将短视频中提取的CSM和cpm作为输入,达到了对低质量视频重新压缩的高鲁棒性。实验结果表明,与传统方法相比,该方法能获得更高的性能,特别是在以低比特率进行重压缩的视频中。在[43]中,Gan等人提出了一种基于VGG-11卷积神经网络的视频帧内伪造取证算法,该算法能自动检测视频伪造帧。该算法首先将视频解压缩为一系列帧,计算出每帧的运动剩余映射,提取隐写特征。然后,以四个不同的隐写特征样本集作为训练集,并将测试集作为训练和测试模型。通过对比实验,选择了最佳性能特征。最后,通过伪造视频对伪造的帧进行了成功的标记。面对新型AI篡改攻击,Li等人[44]通过眨眼检测揭露AI生成的假脸视频。该算法将CNN和RNN结合起来,以捕获眨眼过程中的现象和规律。Li先对一段视频中人物眼部检测,得到眼部的视频序列,然后对序列中的眼部特征使用CNN进行提取,并把提取后的眼部特征使用LSTM进行序列学习,最后对眼部进行眨眼状态检测。实验结果证明,该方法能够有效的检测出AI图像。但是,如果在生成AI图像时,伪造者可以使用带有眨眼动作的图片进行训练,该检测方法的效果便会大打折扣。进一步的,Li等人[45]对假脸边界进行检测。作者使用软件包dlib提取脸部区域。将脸部在多种尺寸下进行对齐,并任意选取其中一个,将其进行高斯模糊,并将高斯模糊后的脸部图像再次经过仿射变化,使之回到原图像的尺寸,来模拟DeepFake产生的换脸图像。对使用上述方法产生的假脸进行CNN检测,实验结果证明,使用CNN对脸部边界进行检测,能够有效的鉴别出假脸。另外,Li等人[46]同时考虑时间信息和空间信息,使用3DCNN来对伪造视频进行鉴别。更多的,Zhang等人[47]在频域内对GAN生成的图像进行检测。GAN生成图像时要经历上采样这一过程,而根据信号处理的知识可知,这一过程会导致频谱的复制,因此生成图像的频谱中会存留一些痕迹。Zhang等人先将真实图像和生成图像进行DFT,然后将所得的频谱图做为分类器的输入,从而获得了一个检测网络。并且,这篇文章还分析了不同频带对检测效果的影响。由于上采样时产生的痕迹主要存留在中频和高频区域,所以使用中频和高频的滤波器训练得到的分类器具有更好的表现。更近的,Amerini等人[48]通过基于CNN的光流法来检测篡改视频。真实视频和AI生成视频的区别在于,真实视频时通过摄像机拍摄的,而AI生成视频是通过计算机合成的,光流可以利用这种差异,考虑序列时间维度中可能存在的异常,并在光流场中体现出来。

综上所述,深度神经网络的运用在一定程度上解决了传统算法的缺陷,虽然这些算法都能够取得较高的准确率,但其仍然存在一系列局限性:

(1)大多数基于深度神经网络的算法对样本数量要求较高,并且需要耗费大量的时间训练网络模型。

(2)这些算法都是以重定位I帧或者块为单位作为输入,如何设计高效的网络实现视频级别的重编码痕迹检测是今后研究的重要方向。

(3)深度神经网络在提升了人工检测效率和准确率,但其深度网络的可解释性和学习到特征的可解释性仍然是不透明的,很多时候“过学习”的现象或者“欠学习”的问题普遍存在。这一问题有待进一步改善。

4 相关竞赛及数据库和工具介绍

数字视频篡改技术通过篡改或替换原视频信息,合成虚假的内容,给社会带来了诸多负面影响。为此,众多国内外公司、大学、领域专家对篡改视频的鉴别进行了深入的研究,建立篡改数据库、开展赛事来帮助识别篡改视频。

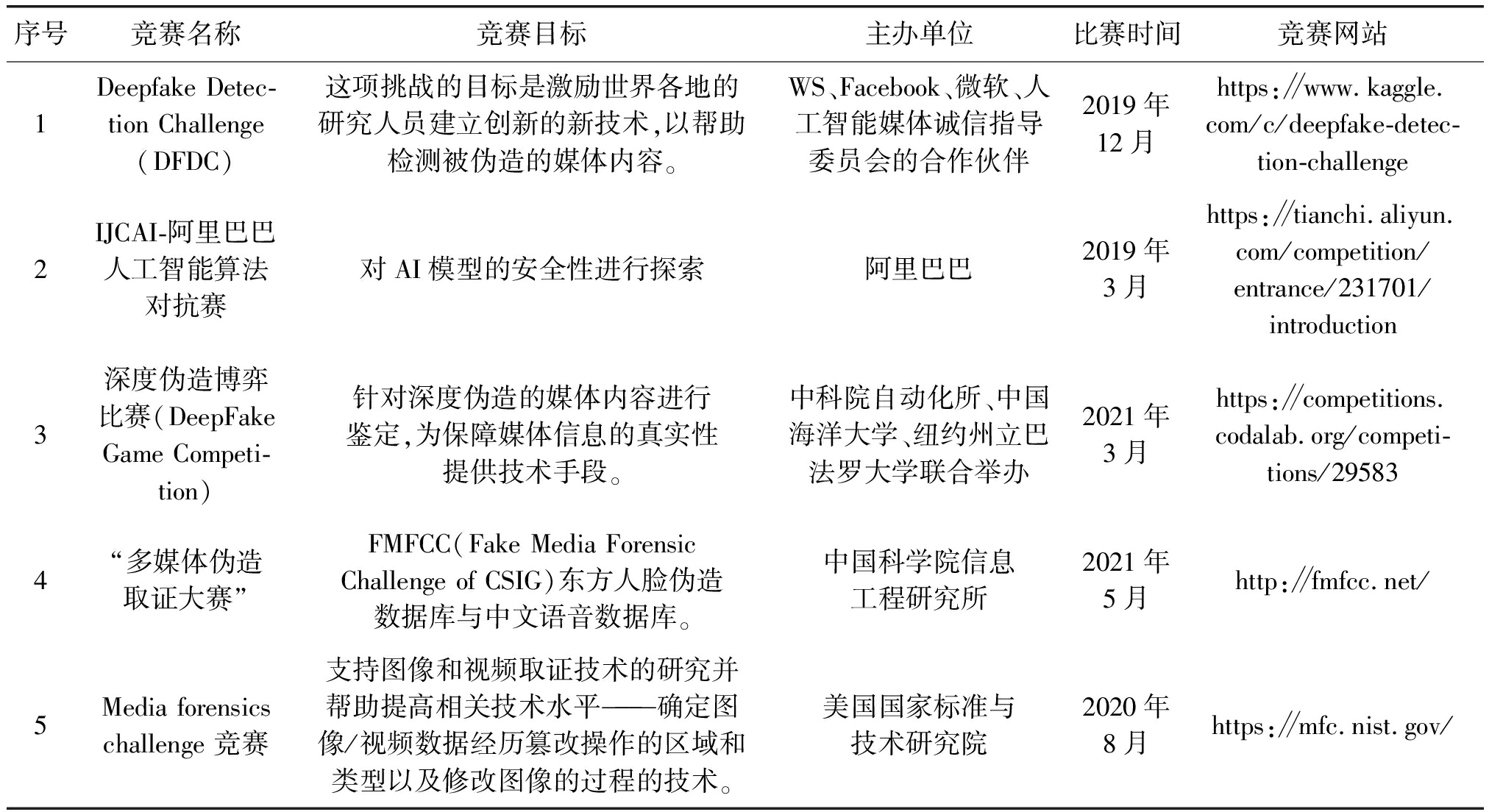

4.1 国际竞赛和国内竞赛介绍

在数字视频篡改取证检测领域,已经有越来越多的国际和国内的互联网公司和AI公司,以及各大名牌大学开始参与进来,通过建设不同类型的篡改数据库,建设统一的算法测试标准,以及建设对抗和检测博弈的竞赛机制等,在全球范围内,展开了大规模的赛事和算法PK。越来越多的企业也加入其中,增强了赛事的激烈程度和检测算法实用化的趋势,为数字视频取证检测技术的发展做出了积极的贡献。具体国内外主流竞赛如表1所示。

表1 国际竞赛和国内竞赛介绍

Tab.1 Introduction of international and national competitions

序号竞赛名称竞赛目标主办单位比赛时间竞赛网站1Deepfake Detec-tion Challenge(DFDC)这项挑战的目标是激励世界各地的研究人员建立创新的新技术,以帮助检测被伪造的媒体内容。WS、Facebook、微软、人工智能媒体诚信指导委员会的合作伙伴2019年12月https:∥www.kaggle.com/c/deepfake-detec-tion-challenge2IJCAI-阿里巴巴人工智能算法对抗赛对AI模型的安全性进行探索阿里巴巴2019年3月https:∥tianchi.aliyun.com/competition/entrance/231701/introduction3深度伪造博弈比赛(DeepFake Game Competi-tion)针对深度伪造的媒体内容进行鉴定,为保障媒体信息的真实性提供技术手段。中科院自动化所、中国海洋大学、纽约州立巴法罗大学联合举办2021年3月https:∥competitions.codalab.org/competi-tions/295834“多媒体伪造取证大赛”FMFCC(Fake Media Forensic Challenge of CSIG)东方人脸伪造数据库与中文语音数据库。中国科学院信息工程研究所2021年5月http:∥fmfcc.net/5Media forensics challenge 竞赛支持图像和视频取证技术的研究并帮助提高相关技术水平———确定图像/视频数据经历篡改操作的区域和类型以及修改图像的过程的技术。美国国家标准与技术研究院2020年8月https:∥mfc.nist.gov/

目前国际上2020年初,以Facebook,Google为代表举办DFDC(深度伪造人脸检测)竞赛获得了大家的普遍关注,但是该竞赛采用的数据集均来自于欧美国家人种采集。国内中国科学院信息工程研究所2021年5月举办了“多媒体伪造取证大赛”,大赛采用承办方自制的FMFCC(Fake Media Forensic Challenge of CSIG)东方人脸伪造数据库与中文语音数据库[49,50]。在数字媒体篡改取证检测领域引起了高度关注和各高校团体踊跃参赛的盛况。

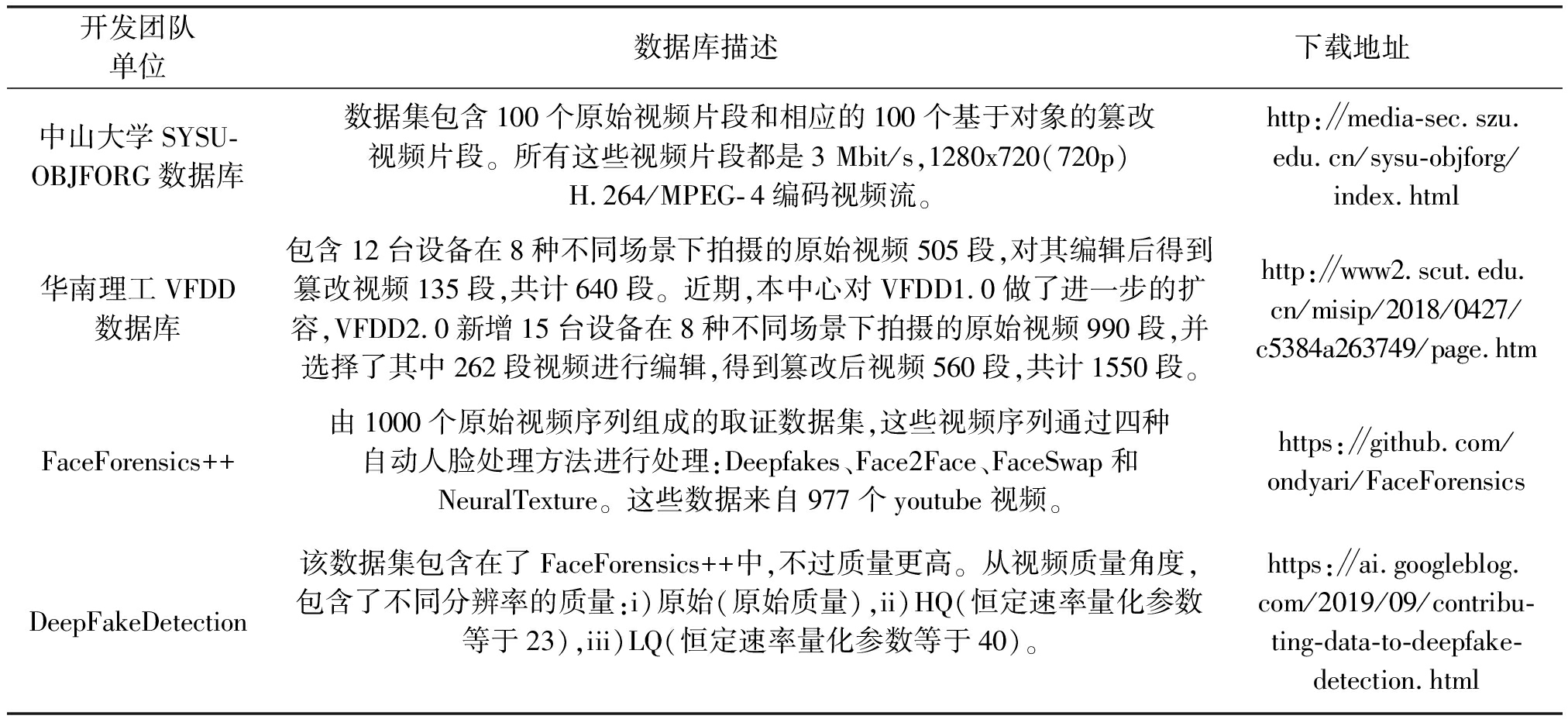

4.2 数字视频篡改数据集

在将近20年的发展过程中,国内和国际领域专家和团队为了算法研究做出了大量的基础工作和贡献,纷纷开发并开放了自主研发的篡改数据库,以供国内外学者们和科学家们对算法进行公开测试,以证明其算法的有效性。具体的一些视频篡改数据库信息如表2所示。

表2 数字视频篡改数据集

Tab.2 Datasets of digital video tampering

开发团队单位数据库描述下载地址中山大学SYSU-OBJFORG数据库数据集包含100个原始视频片段和相应的100个基于对象的篡改视频片段。所有这些视频片段都是3 Mbit/s,1280x720(720p)H.264/MPEG-4编码视频流。http:∥media-sec.szu.edu.cn/sysu-objforg/index.html华南理工VFDD数据库包含12台设备在8种不同场景下拍摄的原始视频505段,对其编辑后得到篡改视频135段,共计640段。近期,本中心对VFDD1.0做了进一步的扩容,VFDD2.0新增15台设备在8种不同场景下拍摄的原始视频990段,并选择了其中262段视频进行编辑,得到篡改后视频560段,共计1550段。http:∥www2.scut.edu.cn/misip/2018/0427/c5384a263749/page.htmFaceForensics++由1000个原始视频序列组成的取证数据集,这些视频序列通过四种自动人脸处理方法进行处理:Deepfakes、Face2Face、FaceSwap和NeuralTexture。这些数据来自977个youtube视频。https:∥github.com/ondyari/FaceForensicsDeepFakeDetection该数据集包含在了FaceForensics++中,不过质量更高。从视频质量角度,包含了不同分辨率的质量:i)原始(原始质量),ii)HQ(恒定速率量化参数等于23),iii)LQ(恒定速率量化参数等于40)。https:∥ai.googleblog.com/2019/09/contribu-ting-data-to-deepfake-detection.html

从表中可以看出随着硬件设备的升级以及视频编辑技术的发展,视频篡改数据集正朝着数据量越来越大、篡改类型越来越丰富、篡改视频逼真度越来越高的方向发展,我们相信,今后将会有更加完备的数据集被生成,进而为取证算法和技术的研究提供充分的数据基础。

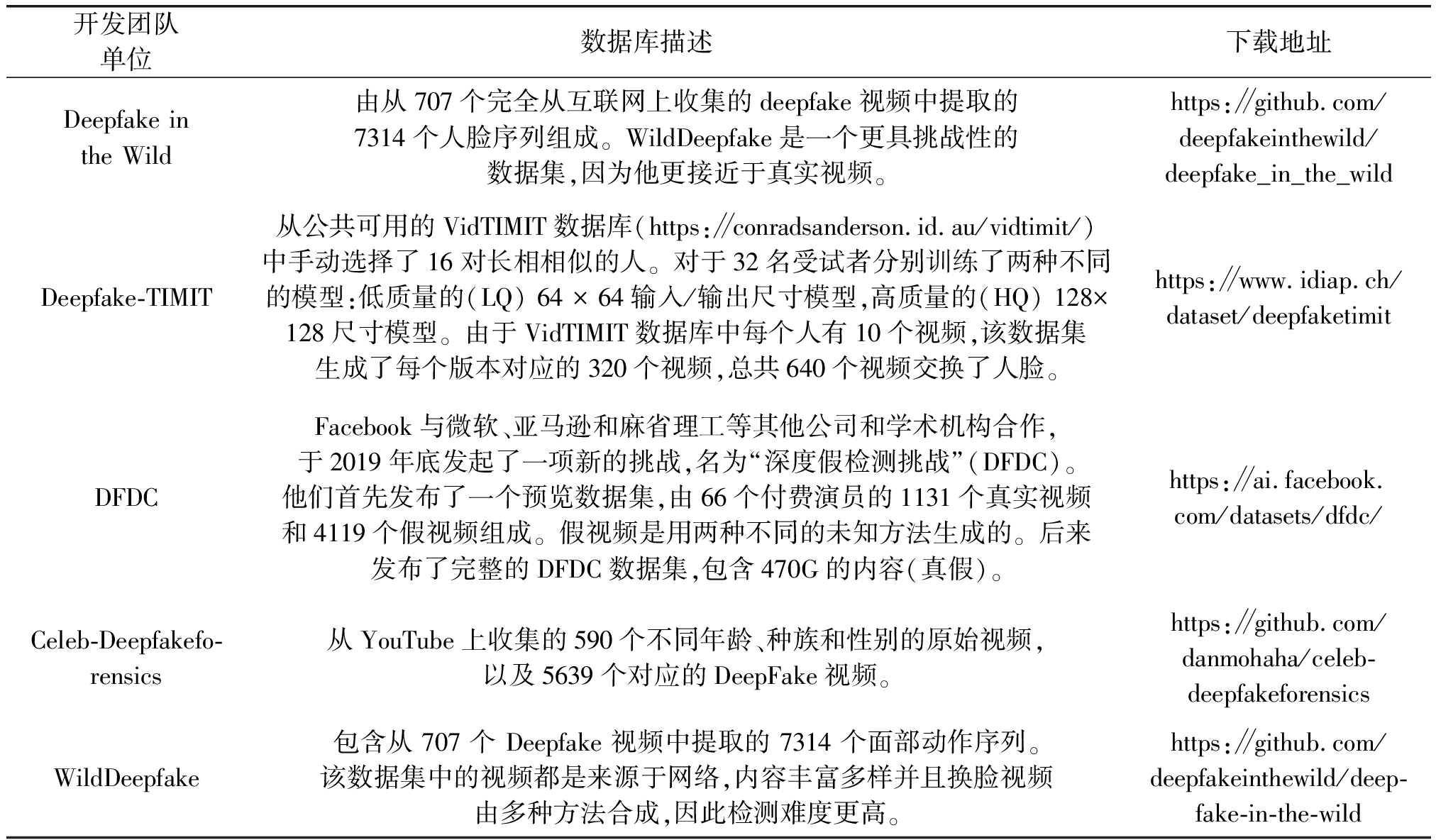

续表2

开发团队单位数据库描述 下载地址Deepfake in the Wild由从707个完全从互联网上收集的deepfake视频中提取的7314个人脸序列组成。WildDeepfake是一个更具挑战性的数据集,因为他更接近于真实视频。https:∥github.com/deepfakeinthewild/deepfake_in_the_wildDeepfake-TIMIT从公共可用的VidTIMIT数据库(https:∥conradsanderson.id.au/vidtimit/)中手动选择了16对长相相似的人。对于32名受试者分别训练了两种不同的模型:低质量的(LQ) 64 × 64输入/输出尺寸模型,高质量的(HQ) 128×128尺寸模型。由于VidTIMIT数据库中每个人有10个视频,该数据集生成了每个版本对应的320个视频,总共640个视频交换了人脸。https:∥www.idiap.ch/dataset/deepfaketimitDFDCFacebook与微软、亚马逊和麻省理工等其他公司和学术机构合作,于2019年底发起了一项新的挑战,名为“深度假检测挑战”(DFDC)。他们首先发布了一个预览数据集,由66个付费演员的1131个真实视频和4119个假视频组成。假视频是用两种不同的未知方法生成的。后来发布了完整的DFDC数据集,包含470G的内容(真假)。https:∥ai.facebook.com/datasets/dfdc/Celeb-Deepfakefo-rensics从YouTube上收集的590个不同年龄、种族和性别的原始视频,以及5639个对应的DeepFake视频。https:∥github.com/danmohaha/celeb-deepfakeforensicsWildDeepfake包含从 707 个 Deepfake 视频中提取的 7314 个面部动作序列。该数据集中的视频都是来源于网络,内容丰富多样并且换脸视频由多种方法合成,因此检测难度更高。https:∥github.com/deepfakeinthewild/deep-fake-in-the-wild

4.3 视频篡改领域常用第三方工具库简介

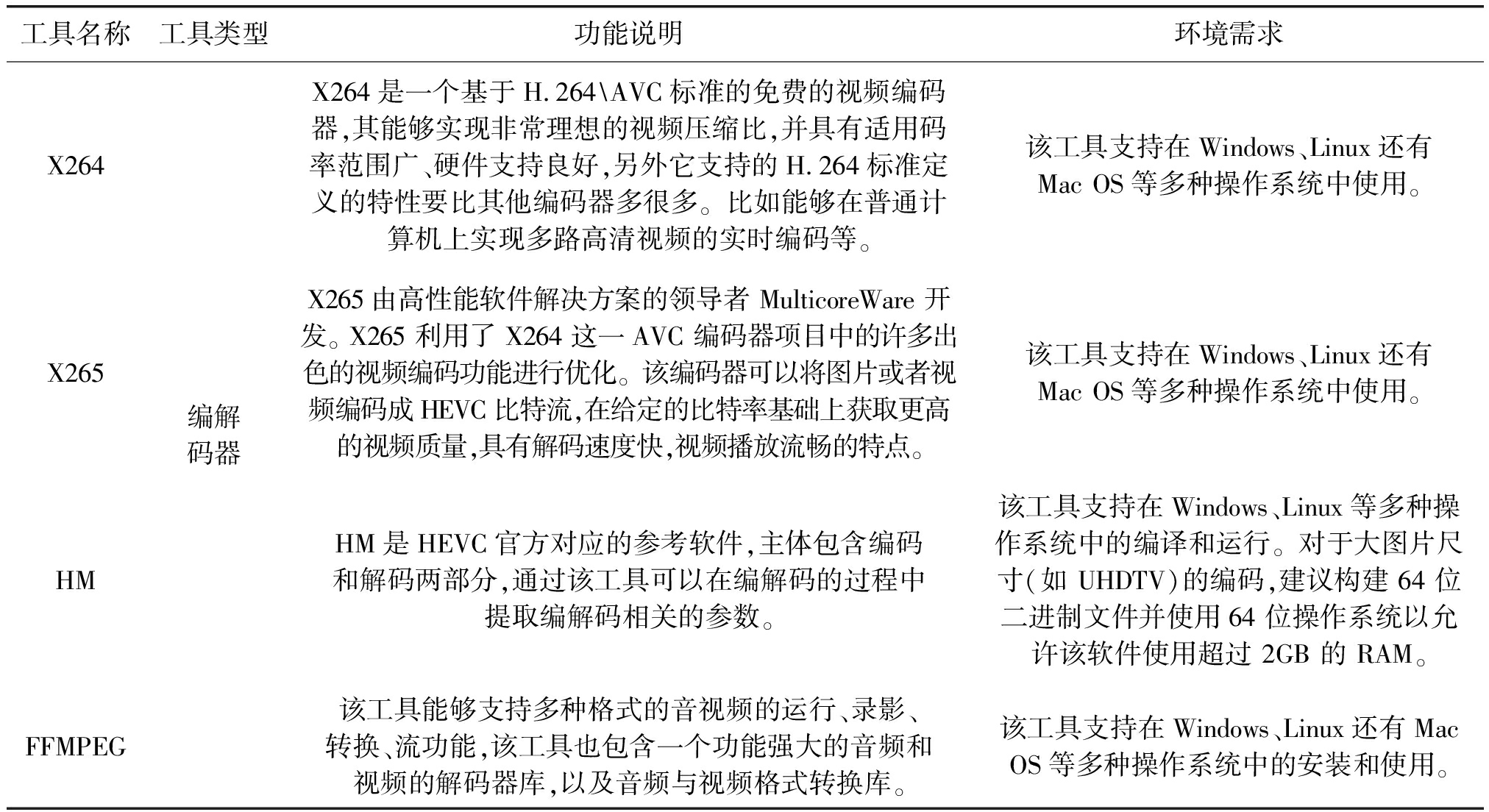

在数字视频被动篡改检测领域常用到的第三方工具库十分丰富,下面(表3)介绍几种应用较为广泛的工具库,供大家学习研究参考:

表3 视频篡改领域常用第三方工具库简介

Tab.3 Overview of common third-party tool libraries in video tampering

工具名称工具类型功能说明环境需求X264X265HMFFMPEG编解码器X264是一个基于H.264\AVC标准的免费的视频编码器,其能够实现非常理想的视频压缩比,并具有适用码率范围广、硬件支持良好,另外它支持的H.264标准定义的特性要比其他编码器多很多。比如能够在普通计算机上实现多路高清视频的实时编码等。该工具支持在Windows、Linux还有Mac OS等多种操作系统中使用。X265由高性能软件解决方案的领导者 MulticoreWare 开发。 X265 利用了 X264 这一AVC 编码器项目中的许多出色的视频编码功能进行优化。该编码器可以将图片或者视频编码成HEVC比特流,在给定的比特率基础上获取更高的视频质量,具有解码速度快,视频播放流畅的特点。该工具支持在Windows、Linux还有Mac OS等多种操作系统中使用。HM是HEVC官方对应的参考软件,主体包含编码和解码两部分,通过该工具可以在编解码的过程中提取编解码相关的参数。该工具支持在Windows、Linux等多种操作系统中的编译和运行。对于大图片尺寸(如 UHDTV)的编码,建议构建 64 位二进制文件并使用64 位操作系统以允许该软件使用超过 2GB 的 RAM。该工具能够支持多种格式的音视频的运行、录影、转换、流功能,该工具也包含一个功能强大的音频和视频的解码器库,以及音频与视频格式转换库。该工具支持在Windows、Linux还有Mac OS等多种操作系统中的安装和使用。

总体而言,目前针对视频篡改检测方面的编解码器、可视化工具多种多样,各种工具的使用方法、编译环境、支持的功能有些许差异。在进行视频篡改检测方向的研究时,针对具体的需求选择合适的平台,利用相匹配的工具进行检测算法的设计是本项研究的关键。

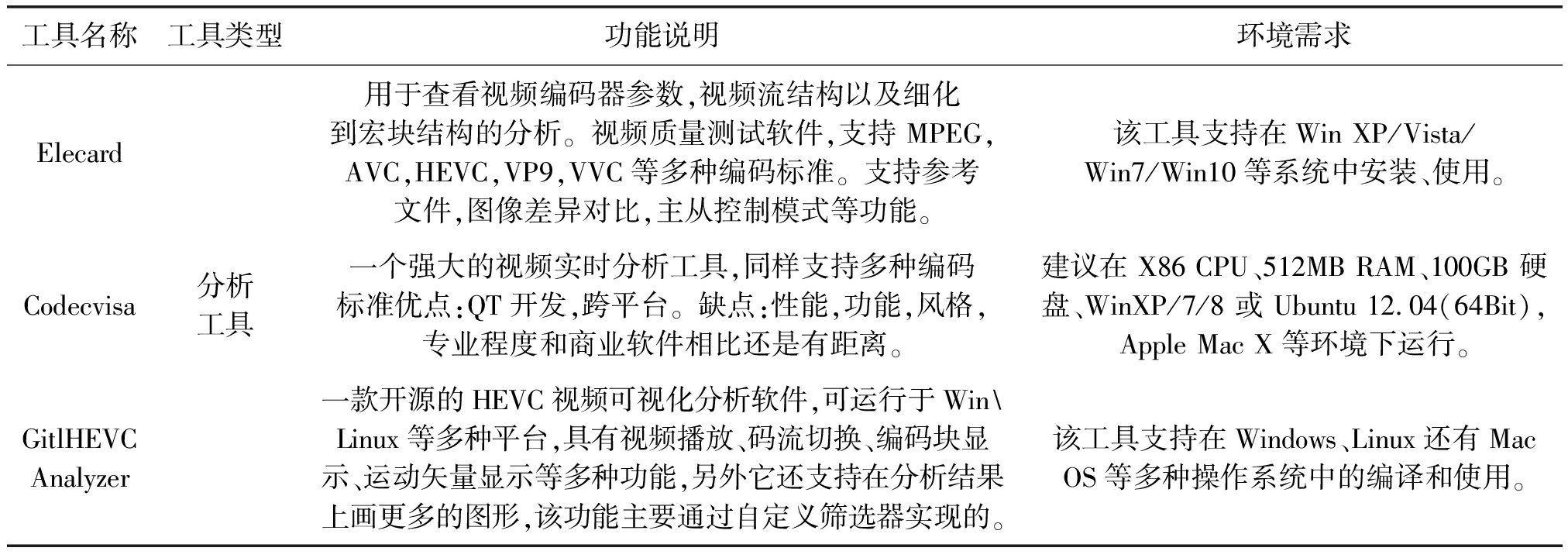

续表3

工具名称工具类型功能说明环境需求ElecardCodecvisaGitlHEVC Analyzer分析工具用于查看视频编码器参数,视频流结构以及细化到宏块结构的分析。视频质量测试软件,支持 MPEG,AVC,HEVC,VP9,VVC等多种编码标准。支持参考文件,图像差异对比,主从控制模式等功能。该工具支持在Win XP/Vista/Win7/Win10等系统中安装、使用。一个强大的视频实时分析工具,同样支持多种编码标准优点:QT开发,跨平台。缺点:性能,功能,风格,专业程度和商业软件相比还是有距离。建议在 X86 CPU、512MB RAM、100GB 硬盘、WinXP/7/8 或 Ubuntu 12.04(64Bit), Apple Mac X等环境下运行。一款开源的HEVC视频可视化分析软件,可运行于Win\Linux等多种平台,具有视频播放、码流切换、编码块显示、运动矢量显示等多种功能,另外它还支持在分析结果上画更多的图形,该功能主要通过自定义筛选器实现的。该工具支持在Windows、Linux还有Mac OS等多种操作系统中的编译和使用。

5 结论

综上所述,从数字媒体取证检测技术到数字视频被动检测技术,从人工设计特征到自动特征获取,从MPEG-x标准到H.26X标准,从相关理论体系到客观指标的评价体系,国际相关篡改取证的公开数据库等,全方位进行了阐述和现状分析,更多的详细技术细节可以阅读相关参考文献。作者希望让读者从本文中看到数字媒体取证技术的方兴未艾,欢迎大家加入到该领域共同探讨和探究更深层次的理论体系和新颖的方法论,设计更多更实用的算法和技术框架,以及共同探讨未来可能的应用落地场景和建设全新的产业链。

数字视频取证检测技术正处在发展的初级阶段,目前还存在大量的待研究的问题:

(1)篡改攻击残留痕迹与数字视频编码技术的依赖关系尚存在空白领域有待探索。如数字视频各类编码标准的不同特性内在机制和信息失真模型理论、特征模型建模的方法论、算法检测框架的高效性和安全性等问题,还需要不断完善,逐步建立起完整的被动检测理论体系。

(2)人工智能理论、深度网络学习方法与视频再编辑篡改技术之间的博弈是未来的发展趋势。如新型的VVC编码已经采用了众多的神经网络模块替代传统编码框架中画面提质模块、滤波模块、运动预测模块等,检测视频再编辑篡改痕迹难度更上一个台阶,新理论和新方法的博弈较量更具挑战性。

(3)目前尽管已经出现了若干的公开视频再编辑篡改数据库,但是覆盖篡改类型还比较有限,且篡改类型也在不断发展与更新,数据库建设的标准也不统一,数据库的原始样本也存在混乱的情况,对整个领域研究的未来发展还是远远不够的。

(4)现有客观评价指标大多数仅限于传统的检测准确率、算法效率、篡改定位准确率等指标,但这些指标无法满足对篡改检测算法性能全方位的评价,对未来算法应用落地是一个不容回避的现实问题,亟待更多的学者投入精力和更多研究成果来支撑和扩充客观评价指标体系。

(5)专用算法尽管已经取得了丰硕的成果,但还存在着诸多边界条件的限制,离实际应用存在较大差距。与之相对的通用算法成果数量不多,且边界限定条件也不利于实用。通用算法的检测目标任务、识别准确率、泛化能力等,距离实际应用的需求还存在着较大提升空间。

作者希望通过本文对数字视频被动检测技术的综述,能够对国内读者、学者们、工程师们起到抛砖引玉的作用,让越来越多的人们关注这一前沿信息安全领域,关注国家信息安全和数字视频内容安全这一既熟悉又陌生的方向。为我国在此领域开拓新的基础理论研究和掌握国际领先前沿攻防技术做出贡献。

[1] MI Zhongjie, JIANG Xinghao, SUN Tanfeng. GAN-generated image detection with self-attention mechanism against gan generator defect[J]. IEEE Journal of Selected Topics in Signal Processing, 2020, 14(5): 969-981.

[2] HE Peisong, LI Haoliang, WANG Hongxia, et al. Frame-wise detection of double HEVC compression by learning deep spatio-temporal representations in compression domain[J]. IEEE Transactions on Multimedia, 2020, DOI: 10.1109/ TMM.2020.3021234.

[3] XU Qiang, JIANG Xinghao, SUN Tanfeng. Detection of HEVC double compression with non-aligned GOP structures via inter-frame quality degradation analysis[J]. Neurocomputing,2021, 452: 99-113.

[4] LI Zhonghao, MENG Laijin, XU Shutong, et al. A hevc video steganalysis algorithm based on PU Partition modes[J]. Computers, Materials & Continua, 2019, 59(2):563-574.

[5] KHOUBAN Sahar, MORADI Mohammad Hassan. A fast quaternion wavelet-based motion compensated frame rate up-conversion with fuzzy smoothing: application to echocardiography temporal enhancement[J]. Multimedia Tools and Applications, 2020, 80(6):8999-9025.

[6] KEVIN Spiteri, RAHUL Urgaonkar, RAMESH K. Sitaraman. BOLA: near-optimal bitrate adaptation for online videos[J]. IEEE/ACM Transactions on Networking, 2020, PP(99):1-14.

[7] YIN Xiaoqi, JINDAL Abhishek. A control-theoretic approach for dynamic adaptive video streaming over HTTP[J]. Computer Communication Review, 2015, 45(4):325-338.

[8] PARK W S, KIN M. CNN-based in-loop filtering for coding efficiency improvement[C]∥2016 IEEE 12th Image, Video, and Multidimensional Signal Processing Workshop (IVMSP). IEEE, 2016, DOI: 10.1109 /IVMSPW.2016.7528223.

[9] SUN Tanfeng, JIANG Xinghao, CHAO Juan. A novel video inter-frame forgery model detection scheme based on optical flow consistency[J]. International Workshop on Digital Watermarking, 2012.

[10]WANG Wan, JIANG Xinghao, WANG Shilin, et al. Identifying Video Forgery Process Using Optical Flow[M]∥Digital-Forensics and Watermarking. Springer Berlin Heidelberg, 2014: 244-257.

[11]YIN Liguo, BAI Zhengyao, YANG Renqing. Video forgery detection based on nonnegative tensor factorization[C]∥Information Science and Technology (ICIST), 2014 4th IEEE International Conference on. IEEE, 2014: 148-151.

[12]YANG Quanxin, YU Dongjin, ZHANG Zhuxi, et al. Spatiotemporal trident networks: detection and localization of object removal tampering in video passive forensics[J]. IEEE Transactions on Circuits and Systems for Video Technology. 2020/12, DOI: 10.1109/TCSVT.2020.3046240.

[13]FENG Chunhui, XU Zhengquan, ZHANG Wenting, et al. Automatic location of frame deletion point for digital video forensics[C]∥Proceedings of the 2nd ACM workshop on Information hiding and multimedia security. ACM, 2014: 171-179.

[14]FENG Chunhui, XU Zhengquan, JIA Shan, et al. Motion-adaptive frame deletion detection for digital video forensics[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2016, 27(12):2543-2554.

[15]AVERBUCH-Elor, HADAR, Cohen. Bringing portraits to life[J]. ACM Transactions on Graphics, 2017, 36(6):1-13.

[16]KIM Hyeongwoo, THEOBAL Christian, PABLO Carrido. Deep video portraits[J]. ACM Transactions on Graphics, 2018, 37(4):1-14.

[17]ZHOU Hang. Talking face generation by adversarially disentangled audio-visual representation[J]. Proceedings of the AAAI Conference on Artificial Intelligence, 2019, 33:9299-9306.

[18]FRIED O, TEWARI A, ZOLLH Z M, et al. Text-based editing of talking-head video[J]. ACM Trans. Graph, 2019, 38(4): 1-14.

[19]SUPASORN Suwajanakorn, STEVEN Seitz. Synthesizing Obama: learning lip sync from audio[M]. ACM, 2017.

[20]LEE J W, LEE M J, LEE H Y, et al. Screenshot identification by analysis of directional inequality of interlaced video[J]. Eurasip Journal on Image & Video Processing, 2012(1):1-15.

[21]BESTAGINI P, VISENTINI-Scarzanella M, TAGLIASACCHI M, et al. Video recapture detection based on ghosting artifact analysis[C]∥Image Processing (ICIP), 2013 20th IEEE International Conference on. IEEE, 2013: 4457- 4461.

[22]NEVIERE Rolland. Forensic characterization of camcorded movies: digital cinema vs. celluloid film prints[C]∥Proceedings of SPIE—The International Society for Optical Engineering, Burlin-game, 9 February 2012, 83030R- 83030R-11.

[23]MAHDIA B, NOVOZAMSKY A, SAIC S. Identification of aliasing-based patterns in re-captured LCD screens[C]∥Image Processing (ICIP), 2015 IEEE International Conference on. IEEE, 2015: 616- 620.

[24]VISENTINI, DRAGOTTI P. Video jitter analysis for automatic bootleg detection[C]∥Multimedia Signal Processing (MMSP), 2012 IEEE 14th International Workshop on. IEEE, 2012: 101-106.

[25]THONGKAMWITOON T, MUAMMRA H, DRAGOTTI P. An image recapture detection algorithm based on learning dictionaries of edge profiles[J]. Information Forensics and Security, IEEE Transactions on, 2015, 10(5): 953-968.

[26]ANJUM A, ISLAM S. Recapture detection technique based on edge-types by analysing high-frequency components in digital images acquired through LCD screens[J]. Multimed Tools Appl, 2020,79: 6965- 6985.

[27]CHAO Juan, JIANG Xinghao, SUN Tanfeng. A novel video inter-frame forgery model detection scheme based on optical flow consistency[C]∥International Workshop on Digital Watermarking. Springer, Berlin, Heidelberg, 2012: 267-281.

[28]WU Yuxing, JIANG Xinghao, SUN Tanfeng, et al. Exposing video inter-frame forgery based on velocity field consistency[C]∥2014 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). IEEE, 2014: 2674-2678.

[29]XU Qiang, JIANG Xinghao, SUN Tanfeng, et al. Detection of transcoded HEVC videos based on in-loop filtering and PU partitioning analyses[J]. Signal Processing: Image Communication, 2021, 92:116109.

[30]HE Peisong, SUN Tanfeng, JIANG Xinghao, et al. Double compression detection in MPEG- 4 videos based on block artifact measurement with variation of prediction footprint[C]∥International Conference on Intelligent Computing. Springer, 2015: 787-793.

[31]HE Peisong, JIANG Xinghao, SUN Tanfeng, et al. Detection of double compression in MPEG- 4 videos based on block artifact measurement[J]. Neurocomputing, 2017, 228: 84-96.

[32]Yao Yuxuan, Yang Gaobo, SUN Xingming, et al. Detecting video frame-rate up-conversion based on periodic properties of edge-intensity[J]. Journal of Information Security and Applications, 2016, 26: 39-50.

[33]BIAN Shan, LUO Weiqi, HUANG Jiwu. Detecting video frame-rate up-conversion based on periodic properties of inter-frame similarity[J]. Multimedia Tools and Applications, 2014, 72(1): 437- 451.

[34]VAZQUEZ D, FONTANI M, BIANCHI T, et al. Detection of video double encoding with GOP size estimation[C]∥IEEE International Workshop on Information Forensics and Security (WIFS), 2012:151-156.

[35]VAZQUEZ D, FONTANI M, SHULLANI D, et al. Video integrity verification and GOP size estimation via generalized variation of prediction footprint[J]. IEEE Transactions on Information Forensics and Security, 2020(15):1815-1830.

[36]LI Qian, WANG Rangding, XU Dawen. Detection of double compression in HEVC videos based on TU size and quantized DCT coefficients[J]. IET Inf. Secur., 2019(13): 1- 6.

[37]YAO Haichao, NI Rongrong, ZHAO Yao. Double compression detection for H.264 videos with adaptive GOP structure[J]. Multimedia Tools and Applications, 2020(79):5789-5806.

[38]YU Yang, YAO Haichao, NI Rongrong, et al. Detection of fake high definition for HEVC videos based on prediction mode feature[J]. Signal Processing, 2020, 166(Jan.):107269.1-107269.11.

[39]JIANG Xinghao, XU Qiang, SUN Tanfeng, et al. Detection of HEVC double compression with the same coding parameters based on analysis of intra coding quality degradation process[J]. IEEE Transactions on Information Forensics and Security, 2019(15): 250-263.

[40]HE Peisong, JIANG Xinghao, SUN Tanfeng, et al. Frame-wise detection of relocated I-frames in double compressed H.264 videos based on convolutional neural network[J]. Journal of Visual Communication and Image Representation, 2017(48): 149-158.

[41]XU Qiang, JIANG Xinghao, SUN Tanfeng, et al. Relocated I-frames detection in H. 264 double compressed videos based on genetic-CNN[C]. in: 2018 Asia-Pacifc Signal and Information Processing Association Annual Summit and Conference (APSIPA ASC), 2018: 710-716.

[42]HE Peisong, LI Haoliang, LI Bin, et al. Exposing fake bitrate videos using hybrid deep-learning network from recompression error[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2019(99):1-13.

[43]GAN Yanfen, YANG Jixiang, LAI Wenda. Video object forgery detection algorithm based on VGG-11 convolutional neural network[C]∥2019 International Conference on Intelligent Computing, Automation and Systems (ICICAS). IEEE, 2019: 575-580.

[44]LI Yuezun, CHANG Ming-Ching, LYU Siwei. In Ictu Oculi: Exposing AI Created Fake Videos by Detecting Eye Blinking[C]∥2018 IEEE International Workshop on Information Forensics and Security (WIFS). IEEE, 2018.

[45]LI Yuezun, LYU Siwei. Exposing DeepFake Videos By Detecting Face Warping Artifacts[C]. in: 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops. IEEE, 2019: 46-52.

[46]LI Haoliang, HE Peisong, WANG Shiqi, et al. Learning Generalized Deep Feature Representation for Face Anti-Spoofing[J]. IEEE Transactions on Information Forensics and Security, 2018, PP(99):1-1.

[47]XU Zhang, SVEBOR Karaman, SHIH-FU Chang. Detecting and Simulating Artifacts in GAN Fake Images[C]. in: 2019 IEEE International Workshop on Information Forensics and Security. IEEE, 2019: 1-6.

[48]IRENE Amerini, LEONARDO Galteri, ROBERTO Caldelli. Deepfake Video Detection through Optical Flow Based CNN[C]. in: 2019 IEEE/CVF International Conference on Computer Vision Workshops. IEEE, 2019: 1-3.

[49]陶建华, 傅睿博, 易江燕. 语音伪造与鉴伪的发展与挑战[J].信息安全学报, 2020, 5(2):28-38.

TAO Jianhua, FU Ruibo, YI Jiangyan. Development and challenge of speech forgery and detection[J].Journal of Cyber Security, 2020, 5(2):28-38.(in Chinese)

[50]韩语晨, 华光, 张海剑. 基于Inception3D网络的眼部与口部区域协同视频换脸伪造检测[J]. 信号处理, 2021, 37(4): 567-577.

HAN Yuchen, HUA Guang, ZHANG Haijian. Inception3D net based video face swapping forgery detection jointly exploiting eye and mouth areas[J]. Journal of Signal Processing, 2021, 37(4): 567-577.(in Chinese)