1 引言

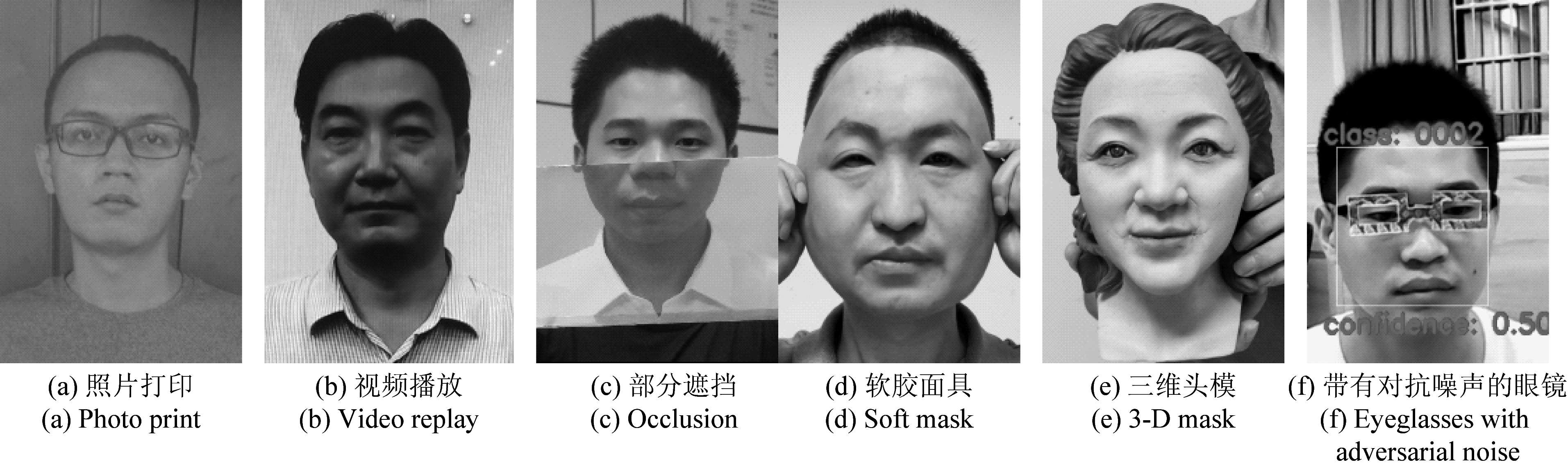

随着人脸识别身份认证技术的广泛应用,人脸攻击成为一个日益严峻的问题,必须在人脸识别系统做出判断之前确认送入判别器的人脸是自然人脸(下文称真脸,真实样本,活体)还是一张用于恶意欺诈的伪造人脸(下文称假脸,攻击样本,非活体)。从广义来看,假脸可定义为任何一张含有恶意攻击行为的人脸,它可是自然人脸的纸张打印/照片打印、视频播放/视频回放/视频重放、部分或全部被不同材质的物质遮挡或包裹的脸,或者是三维/3D打印的脸或头模,也可是进一步含有人眼无法辨识,用于误导假脸检测器的噪声(例如,对抗噪声)的脸。

设计抵御如此种类繁多或未知的假脸攻击已非易事,而当上述假脸处于不同的实际应用场景时则更加困难,因此,置于人脸识别系统前端的假脸鉴别器一直以来都是研究的热点和难点。自人脸作为生物特征用于身份认证伊始,研究人脸攻击和防御的工作就没有停止过,而随着以人脸识别为代表的人工智能技术应用于我国社会生活的各个方面,对于人脸攻击防御的研究变得更加迫切,意义也更为重大。

为了欺骗人脸识别系统,成本低廉且简单可行的攻击大多以假脸呈现于摄像头前的形式出现,人脸呈现攻击(Presentation Attack)是人脸欺诈或称人脸欺骗的典型方式。确保摄像头前的对象为真实人脸是人脸识别系统作出正确判断的第一步,正是由于这个原因,针对人脸呈现攻击的防御策略得到最为广泛和持续的研究。人脸欺诈检测方法根据其与用户的互动程度可分为配合型和静默型两大类。配合型的人脸欺诈检测需要用户根据系统的指示进行摇头、眨眼、张嘴等动作,实现难度较低,但检测用时长,用户体验不佳[1]。静默型的人脸欺诈检测无需用户配合,只需用户将脸部呈现在摄像头前,即可迅速得到检测结果,用时短,用户体验好,与配合型检测方法相比优势明显,受到广泛重视。目前最新的研究主要是针对静默型人脸欺诈检测方法。

对于确定环境下的人脸呈现攻击,基于深度学习模型的假脸检测器大多可输出令人满意的检测结果,这主要是由于深度网络模型具有数据驱动的特点,对于“已见(seen)”的样本能够很好地鉴别。然而,在实际应用场景下,无论是真实样本还是攻击样本,其分布都可能与训练模型时的不同,导致检测模型可能会输出不可预测的结果,从而造成检测结果不准。上述与训练环境一致情况下的检测简称为库内检测,而在其他情况下的检测则统称为跨库检测或跨数据集检测。在库内测试获得高准确率并不意味着算法能胜任实际应用中的检测任务。如何避免模型的跨库检测性能大幅下降是几乎所有人脸欺诈检测方法的核心问题。本文重点针对近2年来基于深度神经网络的算法进行综述,聚焦本领域的最新进展。

2 人脸欺诈的典型方式和检测流程简介

为了帮助读者更好地了解人脸欺诈检测技术,本小节先对其背景知识作简单介绍。人脸识别的研究从20世纪60年代后期开始,到20世纪90年代中期,人脸识别系统已在美国实现了商业应用。随之而来出现了针对人脸识别系统的攻击和反攻击研究。2002年,已有国外学者利用照片和视频进行了攻击实验并作了相关报道[1]。图1展示了6种典型的人脸欺诈攻击手段。

图1 典型人脸呈现攻击手段示例

Fig.1 Typical face presentation attack examples

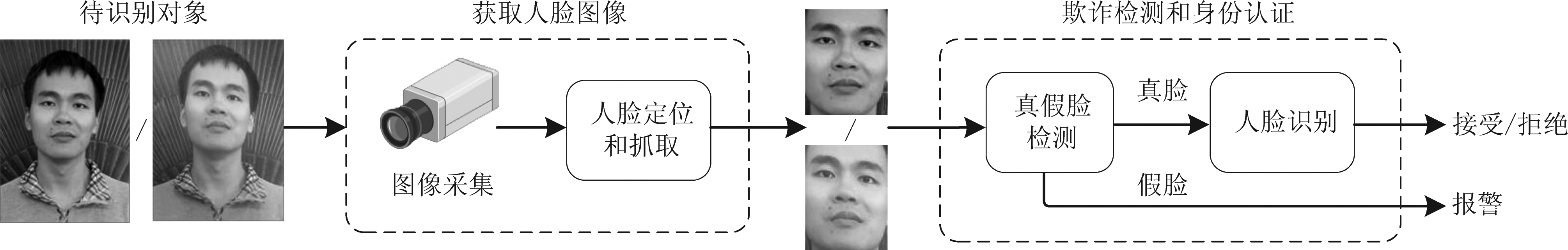

由于人脸呈现攻击对外界环境要求低,实施者无需专业知识,因此危害性也最大。国内外很早就开始了相关的防御研究。在我国,中科院自动化所谭铁牛团队于2004年已提出相应的解决方案[2]。图2展示了人脸欺诈检测与身份认证的全过程。

图2 人脸欺诈检测与身份认证流程图. 输入端左图为真脸,右图为假脸

Fig.2 Flowchart of face spoofing detection and identity verification. At the sender, the face on the left is genuine while the face on the right is fake

3 人脸欺诈检测方法

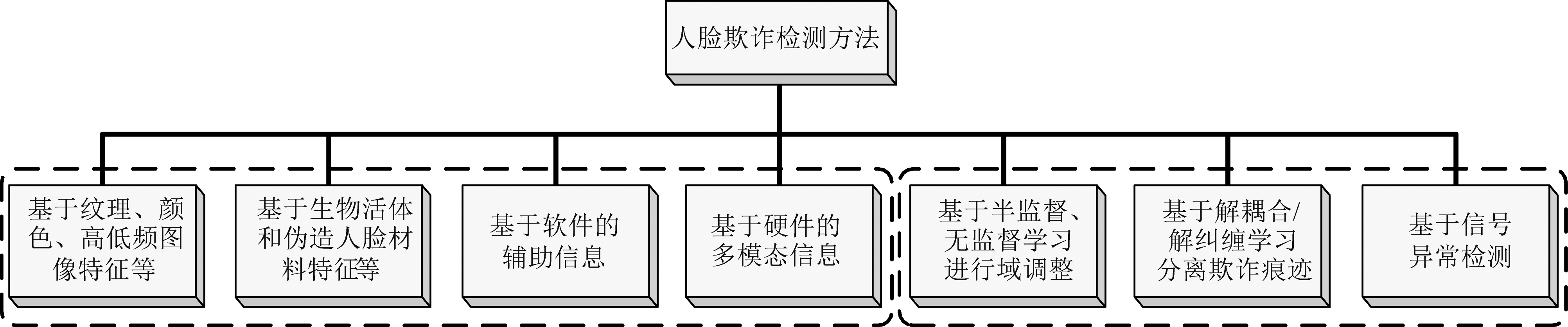

人脸欺诈检测方法可从不同角度进行分类,早期大多按特征提取类型,如纹理、运动、3D形状和多谱反射比等四个方面进行分类。近期,从特征提取手段的角度,人脸欺诈检测可分为基于传统手工特征的方法和基于深度学习的方法。从实现平台的角度又可分为基于高运算资源固定端的方法和基于低运算资源移动端的方法等。与现有文献的分类方法不同,本文以技术动机作为分类依据,将人脸欺诈检测方法分为7个大类,具体如图3所示。下面逐一进行综述。

图3 按技术动机进行的人脸欺诈检测方法分类

Fig.3 The classification of face spoofing detection methods based on technical motivation

3.1 基于纹理、颜色、高低频图像特征等

早期的人脸呈现攻击检测(Presentation Attack Detection, PAD)主要基于传统机器学习方法,有些直接在亮度或灰度分量上提取图像纹理特征(例如,计算局部二值化模式(Local Binary Patterns, LBP)纹理描述子),局部空间相邻模式的共生矩阵,统计图像特征的二值化,分辨率不变的描述子等。文献[3]指出仅依赖灰度分量描述真脸和欺诈脸(下文简称真假脸)之间的差异是不够的,并用实验展示真假脸LBP直方图在Cr和Cb两个色差分量上的卡方值远大于灰度分量上的卡方值,据此引出一个基于卡方距离的描述,提出一个基于颜色纹理(Color Texture)分析的PAD方法,取得了不俗的跨库检测效果。该文还对多个颜色空间,包括RGB(红、绿、蓝),HSV(色调、饱和度和亮度)和YCrCb(亮度分量、Cr和Cb色度分量),及其组合空间的特征对PAD方法性能的影响进行了充分的比较。还有一些文献将图像映射到变换域后再做处理,例如,文献[2]利用真假脸的图像和图像序列在傅里叶域中频谱的分布和频率分量的统计特征不同来进行分类。文献[4]提出一种基于局部二进制模式的色差共生矩阵(Chromatic Co-occurrence of Local Binary Pattern, CCoLBP)特征。文献[5]提出用DWT(离散小波变换)+LBP+DCT(离散余弦变换)来联合反映视频段的频域、空域和时域特征。总的来看,利用传统分类器的PAD方法在近年来呈下降趋势。

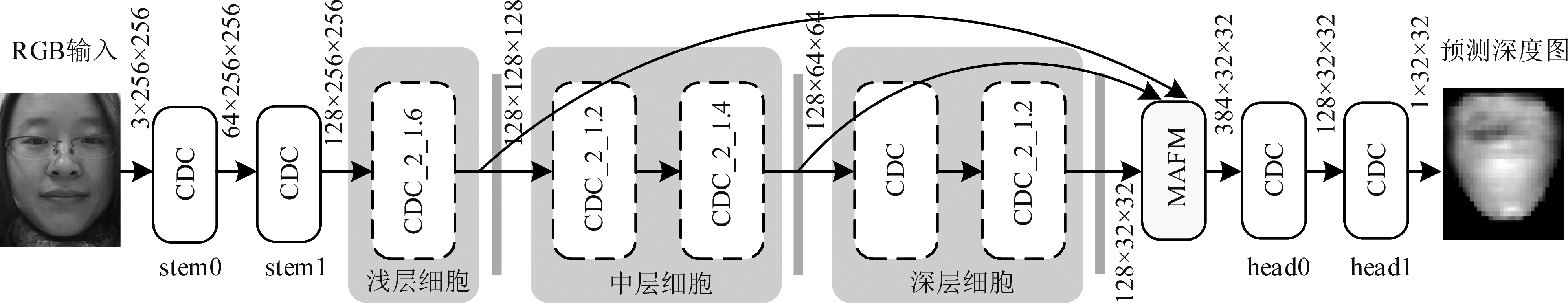

深度卷积神经网络具有强大的图像特征提取功能,这一优势在文献[6]中得到充分展示。文献[6]受传统LBP特征提取方法的启发,提出一种中心差分卷积(Central Difference Convolution,CDC)运算子,提取特征图的一阶梯度信息,抓住内在的细节模式。考虑到亮度级的语义信息和梯度级的细节信息在区分真假脸时均是关键信息,作者在设计CDCN(CDC Network, CDCN)网络时将相同位置上传统卷积所得到的元素与中心差分卷积所得到的元素按特定权重相加,由此使得亮度级的语义信息和梯度级的细节信息在网络中得到汇聚和融合。该文CDCN网络与多尺度注意力融合模块(Multiscale Attention Fusion Module, MAFM)所构成的CDCN++网络(见图4)以256×256尺寸的RGB彩色人脸图像作为输入,通过一系列CDC卷积层提取特征,包括低阶、中阶和高阶三类,再通过MAFM进行融合,最后得到32×32尺寸的深度图估计结果。由于打印攻击和重放攻击的人脸大多为平面,假脸所得的深度图应主要为0值,而真实立体人脸则有丰富的深度信息,故可将估计所得到的深度图作为真假脸的判别依据。据报道,在OULU-NPU数据库[7]和SiW数据库[8]的各种测试条件下均达到了当时的领先水平,对于CASIA-MFSD[9],Replay-Attack[10]和MSU-MFSD[11]数据库也有很高的检测准确率。但该方法在Replay-Attack库到CASIA-MFSD库的跨库检测中半总错误率HTER高达29.40%。此外,该方法只适用于平面打印攻击和重放攻击,对于3D面具头模攻击效果有限,因为3D假脸也有立体信息。

图4 文献[6]的CDCN++网络架构示意图

Fig.4 Illustration of CDCN++ network in reference [6]

文献[12]提出一个用带有微分高斯掩模的局部有向数值(Local Directional Number, LDN)模式去抓取细节外貌信息,由于光照变化和噪声影响纹理模式分布,为了进一步获取运动信息,该文把有向数值模式扩展成一个空时域的变种,将来自三个正交平面的局部有向数值模式称为LDN-TOP。多尺度的LDN-TOP提取来自彩色图像的完整信息,生成具有强大表征能力的特征向量。文献[13]提出一种通过学习融合高频和低频特征的人脸反欺诈(Face Anti-spoofing, FAS)方法,尤其提出用3个高通和3个低通滤波器提取人脸图像的高通和低通分量。考虑到欺诈的特征存在于不同的特征级中,训练网络时用了多尺度三元组损失函数。文献[14]指出,目前许多FAS方法直接从常用的颜色空间(例如,RGB,HSV,YCrCb)提取特征用于区分真假脸。然而,该文认为现有颜色空间原本是用来显示图像或视频的视觉内容的,并不适合用于区分真假脸。因此,提出一种深度学习网络CompactNet,用以学习裁剪后的紧致的脸。CompactNet并不直接在颜色空间提取特征,而是将彩色脸送入一个逐层渐进的空间生成器,在最优化的“点到中心”三元组(Triplet)损失函数准则下,学习一个带有最小类内距离,最大类间距离,同时不同类之间有一个安全间隔的紧致空间,在这个紧致的空间中由预训练好的特征提取器来提取特征。

基于纹理、颜色、高低频图像等特征的分类是最早和最直接的人脸欺诈检测手段,真假脸的分类被归结为真脸特征和假脸特征的分类,因此,面临最大的挑战是如何确保在源域所提取的特征能适用于“未见过”的目标域。由于应用场景千差万别,对于单模态图像而言,仅从特征提取的角度来降低跨库检测错误率一直未能达到预期,不过这一努力在基于多模态图像的PAD任务中有望实现。

3.2 基于生物活体和伪造人脸材料特征等

基于生物活体及伪造人脸材料特征的人脸欺诈检测方法所依据的原理在于活体人脸含有体温、脉搏、五官运动等伪造人脸所不具备的特征,而伪造人脸则含有皮肤以外材质的反光、人脸图像重捕获带来的失真伪影、屏幕上光线干涉产生的摩尔纹等活体人脸所不具备的特征。这类方法原理简单,可解释性好。

早在2007年,文献[15]就已提出通过嘴部定位和提取光流来进行活体评估。近期,文献[16]把人脸的反欺诈看成是一种材料识别问题,将其与经典的人类材料感知结合起来,抓取多种提示信号(例如,皮肤,眼镜和硅胶)之间的差异,得到可区分度高且鲁棒的特征。文献[17]认为场景的内在特性,例如,人脸面部的漫反射,深度和反射率等可用于FAS,提出采用经典的从光影恢复形状(Shape from Shading)的方法获得面部的漫反射图、深度图和反射率图等,进一步设计了一个浅层CNN框架,从这些“图”中挖掘有意义的特征模式。文献[18]提出一种处理双像素(Dual Pixel,DP)传感器图像的FAS网络,包含深度重构和深度分类两个网络。前者利用输入的DP图像对生成一幅带有大约1 mm基准的深度图;后者据此区分真实个体和平面攻击。文献[19]提出一种仅需要很小数据库和有限硬件资源的PAD方法,易于部署到资源有限的设备,例如,手机。具体而言,用一个单目可见光照相机拍摄2张人脸照片,一张用闪光灯,一张不用闪光灯。该文利用不同的反射特性构造鉴别特征:一种来自虹膜区域的特殊反射,具有依赖于活体的特殊强度分布;另一种则来自整个人脸区域的漫反射,可表征个体脸的3D结构。

随着3D打印技术的发展,3D面具呈现攻击已成为人脸识别系统的一个严峻挑战。为了抵御3D面具呈现攻击,人脸的远程光电容积脉搏波(remote photoplethymorgraphy, rPPG)被用作是一个内在的检测信号,它独立于面具材料和外貌质量。尽管现有基于rPPG的方法已被证明有效,但受噪声污染时提取的脉搏信号不准确。为了从含噪原始rPPG信号中辨识心跳残痕,文献[20]提出一个全局噪声感知模板学习和认证框架。该文作者在现有以及自己扩展的数据库上进行了大量实验,证明了方法的有效性和鲁棒性。文献[21]指出,尽管现有基于rPPG的方法检测结果令人鼓舞,但它需要长时间(10-12秒)观察才能获得心跳信息,不利于某些应用场景,例如手机解锁,电子支付等。该文提出一种用于应对3D面具脸攻击的快速PAD方法,通过rPPG的时域相似度分析来实现分类。文献[22]基于对图像反射的分析提出一个新的3D面具呈现攻击检测方法。首先用一个内在的图像分解算法计算人脸图像的反射图像,接着,从三个正交的平面提取强度分布直方图,以反映真脸和3D面具脸反射图像的强度差异。考虑到平滑表面的反射图像对于光照变化更加敏感,故用一维卷积神经网络来提取不同材料或表面在光照变化下的特征。文献[23]指出3D欺诈攻击更具有挑战性,因为材料的3D特征与真脸更加接近,提出用多颜色通道的分解式双线性编码,学习真脸和假脸之间的细微差异。

基于生物活体和伪造人脸材料特征的这类方法最大的优点是有一定克服跨库性能下降的潜力,但存在的共同问题是:第一,需要额外的硬件采集活体与非活体的特征信息,例如,红外摄像头,热敏摄像头,导致在商业应用中检测系统的部署和维护成本过高;第二,由于采集的特征至少为2路输入,故计算的复杂度增加;第三,系统硬件尺寸相对较大。

3.3 基于软件的辅助信息

基于辅助信息人脸欺诈检测方法的原理在于利用伪3D信息(例如,估计所得到的深度图)、运动信息等作为检测方法的辅助信息输入,相比于仅利用人脸图像作为输入,可更有效地提高人脸欺诈检测方法的性能。由于通常无法直接获得辅助信息,故在使用前需利用人脸图像对辅助信息进行估计。这类方法无需硬件配合,成本低,是目前的一个研究热点。

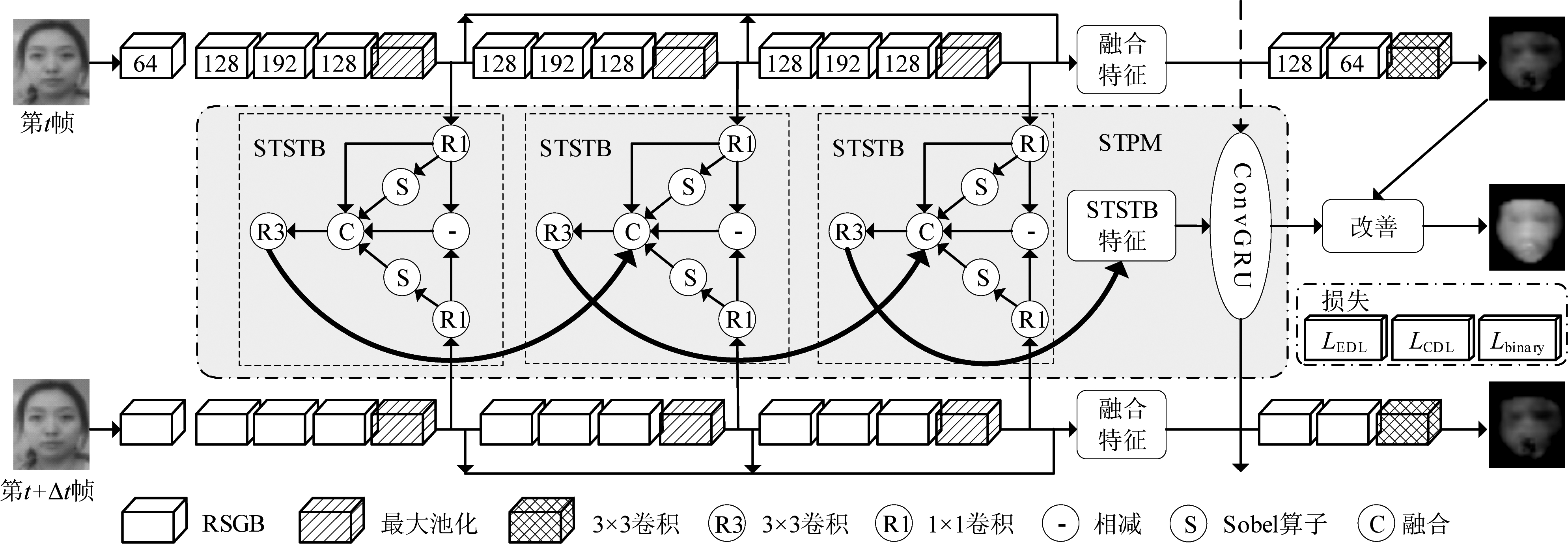

图5 文献[25]的网络架构示意图,其中64,128,192分别代表网络的层数

Fig.5 Illustration of the detection network in reference [25], where 64, 128 and 192 denote the number of layers, respectively

2017年,Atoum等人[24]最先提出一种带辅助信息的端到端学习和训练网络,利用局部特征块和整体深度图作为辅助信息进行活体检测。近期文献[25]认为以往的方法通常将人脸反欺诈刻画为一个单帧多任务问题,简单地用深度增大损失,忽视了细粒度信息和人脸面部深度与运动模式之间的相互影响,故有必要检测来源于多帧的呈现攻击,进而提出一种基于空域梯度和时域深度学习的人脸欺骗检测方法。空间梯度残差模块(Residual Spatial Gradient Block,RSGB)可更好表征空域信息,时空传播模块(Spatio-Temporal Propagation Module,STPM)可更好表征时域信息。其中STPM由短时空时模块(Short-term Spatio-Temporal Block,STSTB)和卷积门控循环单元(Convolutional Gated Recurrent Unit, ConvGRU)两部分组成。利用RSGB分别提取各帧人脸图像的低阶、中阶和高阶细粒度空间特征并加以融合,预测各帧人脸的粗糙深度图。利用STSTB获取相邻帧人脸图像之间的短时空时域信息,并利用ConvGRU对其进行融合,获取表征多帧的长时空时域信息。利用此信息对粗糙深度图进行细化,获得最后的细致深度图。为了使网络在训练过程中学习到更细微的欺骗痕迹,该方法还提出了利用对比深度损失(Contrastive Depth Loss,CDL)来优化网络参数,将预测所得的深度图与用于监督的深度图都通过8方向差分滤波,再用滤波后的结果计算欧氏距离损失。这一损失包含了预测深度图和参考深度图之间的局部差异,更有利于引导网络对人脸图像的细节进行特征提取。最后根据预测的深度图,对人脸的真伪进行分类判别。根据该文的实验结果,在OULU-NPU[7]和SiW[8]数据库的库内测试中性能达到了当时的领先水平。另外在CASIA-MFSD[9]和Replay-Attack[10]数据库之间,以及从SiW数据库到OULU-NPU数据库的跨库测试中泛化性能均有一定改善。但该方法计算复杂度高,且在Replay-Attack库到CASIA-MFSD库的跨库检测中半总错误率HTER仍高达22.80%。

文献[26]提出一种基于3D点云(3D Point Cloud)辅助信息的人脸欺骗检测方法,利用三维稠密脸部校正技术生成稠密3D点云,并通过随机采样和归一化,得到2500个数据点作为辅助信息。另一方面,对样本视频帧进行人脸检测,截取人脸图像并进行数据增广后,输入到一个自编码网络结构当中,将输入的人脸图像编码为256维的特征;而解码器则由两层全连接层构成,将特征解码为3×2500的数据,即2500个点的三维位置信息。利用预处理得到的3D点云辅助信息对由自编码器生成的3D点云进行监督,利用倒角损失(Chamfer Loss)来衡量两者的差异,通过最小化损失来优化自编码器的参数,使其能够根据输入的人脸图像生成准确的3D点云。由于打印攻击和重放攻击的人脸绝大多数呈现在平面之上,与立体真实人脸的差异可通过3D点云直观反映,因此可将自编码器根据输入人脸图像所生成的3D点云作为人脸欺骗检测的判断依据。在实际应用中,未知真伪的人脸图像会被送入训练好的自编码器,再根据生成的3D点云对其进行人脸欺骗检测。该方法最大的亮点是无需附加的网络来估计类似深度图之类的辅助信息,可直接用一个编解码网络预测3D点云,在高检测性能和计算复杂度之间进行了折中,能在移动网络等小算力的应用场景进行部署。其库内检测性能与文献[25]相当,但跨库性能仍有不足,例如,在Replay-Attack库到CASIA-MFSD库的跨库检测中HTER仍高达25.70%。

文献[27]设计了一个双流空-时域网络,分别发掘潜在的深度信息和多尺度信息。在双流网络中,引入一个时间移动模块,可无需额外计算地提取时间信息。在深度估计网络中,提出一个对称损失函数,进行更精确的辅助监督。接着,根据所估计的深度信息构造尺度级(Scale-level)注意力模块,为不同尺度的对象特征添加不同的注意力权重。文献[28]认为传统二值损失函数监督下得到的深度模型在描述内在的和可区分的欺诈模型时能力不足,故在对现有基于像素级的监督算法进行全面审视和分析以后,提出一种金字塔结构的监督,从多尺度的空间上下文学习局部细节和全局语义。所提出的金字塔监督不仅能够改善现存像素级监督架构的性能,还能加强模型的可解释性,例如,确定补丁级(Patch-level)的呈现攻击位置。文献[29]采用基于超图(Hypergraph)的卷积神经网络来学习与姿态无关的3D人脸特征表示,将RGB信息与深度信息分别输入同样的网络结构后,再将其特征融合并作判决。文献[30]设计了一个双流特征提取网络同时处理深度信息与色差信息,并针对两者不同的特点,在深度通道中加入特征增强模块,在色差通道中加入特征选择模块。文献[31]重新审视了基于深度的全卷积FAS方法,提出一个一般性的理论分析方法证明在缺乏足够训练样本时,例如,人脸欺诈检测任务,局部标签监督比全局标签监督对于局部任务而言更加合适。据此,空域聚合的像素级局部分类器(Spatial Aggregation of Pixel-level Local Classifiers)由全卷积(Fully Convolutional Network, FCN)和聚合两部分组成。FCN预测像素级(Pixel-level)的三元(Ternary)标签,包括真实前景,欺诈前景,以及未确定的背景。这些标签聚合在一起,产生一个更加准确的图像级(Image-level)的判定。不过该方法的实验结果显示还存在较大的改进空间,仍以从Replay-Attack库到CASIA-MFSD库的跨库检测为例,其HTER高达37.50%。

总的来看,辅助信息可帮助现有的人脸欺诈检测方法根据应用场景进行定制化,在一定程度上提高了分类算法的泛化性能。

3.4 基于硬件的多模态信息

基于多模态融合的人脸欺诈检测方法原理在于通过联合利用可见光图像、红外图像、深度图等多种模态的人脸信息,挖掘更为丰富有效的分类特征,从而进一步提高人脸欺诈检测方法的分类准确率及泛化性能。与基于辅助信息的方法需要对辅助信息进行软估计不同,该类方法所使用的多模态信息均可通过多模态传感器实际采集,精确度更高,更有利于检测性能的提高。

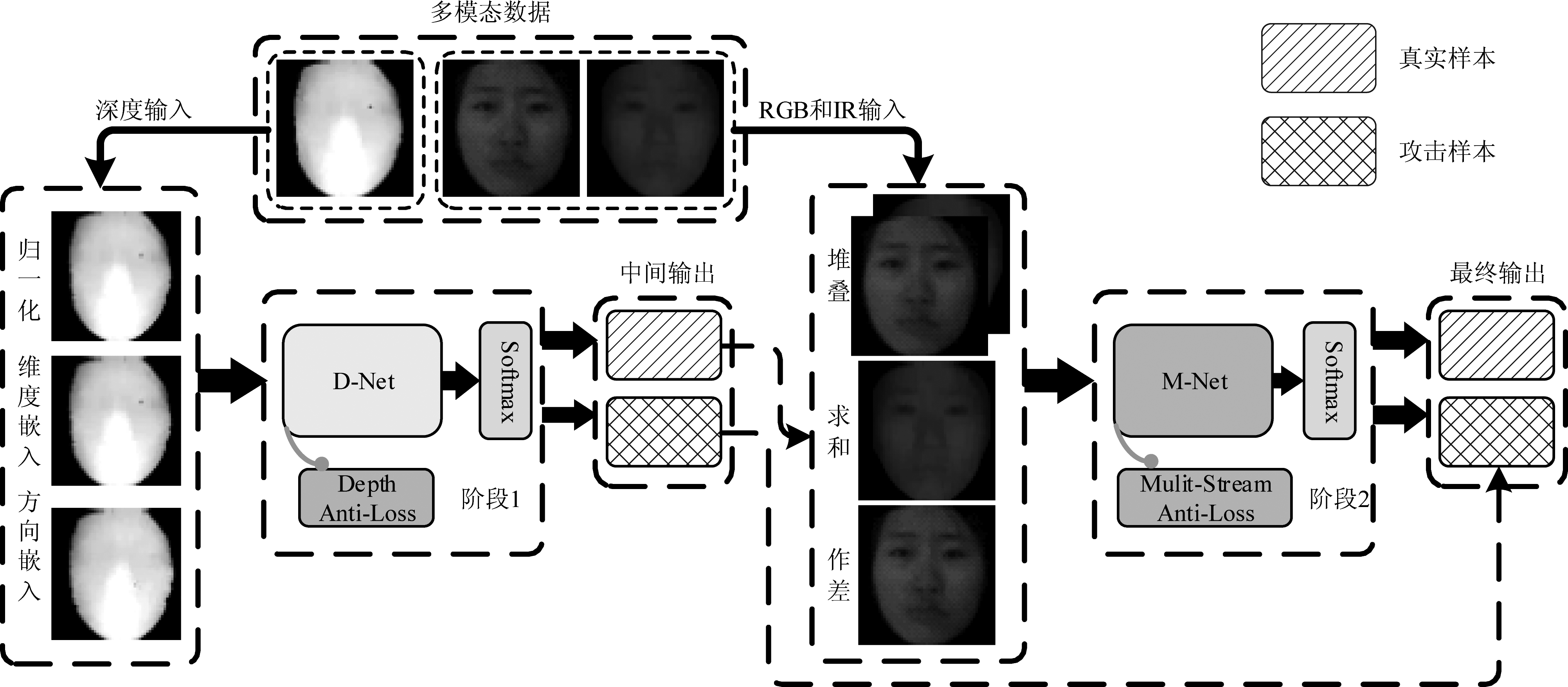

典型文献[32]指出现存用多模态数据的深度学习FAS方法在遇到2D打印攻击和高精度的3D面具攻击时,泛化性能不好,一个主要的原因是用于保留真假脸之间内在特性的多频段信息未能很好的提取出来。该文提出一个基于多模态数据的两级级联框架,能够有选择地融合来自于不同多模态数据的低级和高级特征,用多模态数据在彩色和红外图像上构建与距离无关的谱,增强数据的非线性,从物理特性特征(Physical Attribute Features)而不是某些限定下的个体结构特征来增强网络模型的区分能力。

文献[33]考虑了不同的攻击图像质量和环境因素,提出一种基于立体匹配的实时FAS方法,将左右两个视角的一对红外图像输入到所提出的轻量化立体匹配网络中,生成一幅差异图,然后将这幅差异图作为分类网络的输入,获取人脸的活体信息。文献[34]讨论了在不同模态中,即使利用同一个骨干网络,不同模态之间的性能差异仍然巨大,据此提出利用跨模态的辅助信息。一般而言,在多模态检测领域,色差通道仍然是主要信息来源,其他通道往往被看作是辅助信息,但文献[35]尝试了仅利用近红外成像信息(只有灰度信息)进行3D面具的人脸欺诈检测。为更好地从CNN的低层学习到复杂的纹理特征,该文在网络末端加入了一个补丁汇集层(Patch Pooling Layer),先将特征图分成不重叠小块,然后再通过平均各个块的特征描述获得总特征描述,其检测结果并不亚于其他利用了色差信息的方法,这说明在刻画真实人脸与欺诈人脸差别方面,其他模态信息能发挥的作用比人们预想得更大,值得深入研究。文献[36]指出用深度信息可鉴别2D呈现攻击,但对3D无效,因此提出一个多传感器方法,同时利用了可见光图像和紫外光谱的局部和全局特征。文献[37]讨论了不同模态相机之间轻微的细粒度差异,提出了一个跨域多模态FAS数据库GREAT-FASD,并提出3种评价协议(protocols),所构建的数据库覆盖了4个人群种族,4种攻击种类,年龄跨度从20岁~50岁,以及2种不同深度传感器的多模态相机。

图6 文献[32]的算法原理示意图. D-Net网络从深度图提取分类信息,M-Net网络融合不同模态的图像作为网络输出

Fig.6 Illustration of the algorithm in reference [32]. D-Net extracts the classification information from the depth images. M-Net fuses the images of different modalities and makes decision

近年来随着制造工艺的发展和硬件成本的降低,具有多模态传感器的人脸识别和认证系统变得越发普及,对多模态融合的人脸欺诈检测研究也成为了近年来新兴的热点,不过就技术层面来说,这类方法可更多的看成是单模态方法的延伸和推广。

3.5 利用半监督、自监督/无监督学习进行域调整的策略

源域由已见的欺诈类型构成,而目标域则由未见过的攻击类型的未标签数据构成。域自适应(Domain Adaptation)的目的在于缩小训练样本与实际检测样本之间的差异;而域泛化(Domain Generalization)则利用多个现有源域来训练模型而不会看到任何目标数据,旨在通过对齐多个源域之间的分布来学习广义特征空间。基于域自适应和域泛化的FAS方法是目前的一个研究热点。

2015年,Yang等人[38]引入主题域自适应(subject adaptation)的概念,指出以往的通用反欺诈分类器被努力训练成可检测针对所有样本的攻击,然而,由于样本之间个体的差异,分类器无法在所有的样本上具有好的泛化性能,于是提出了一种针对特定人脸(person-specific face)的反欺诈检测框架,可自然融入人脸识别系统,并以机器学习分类器为例,进行了实现。该文的出发点是两个假设:第一,真假样本之间的关系可公式化为平移和线性变换;第二,两个主题域中真样本之间的关系与假样本之间的关系相同。

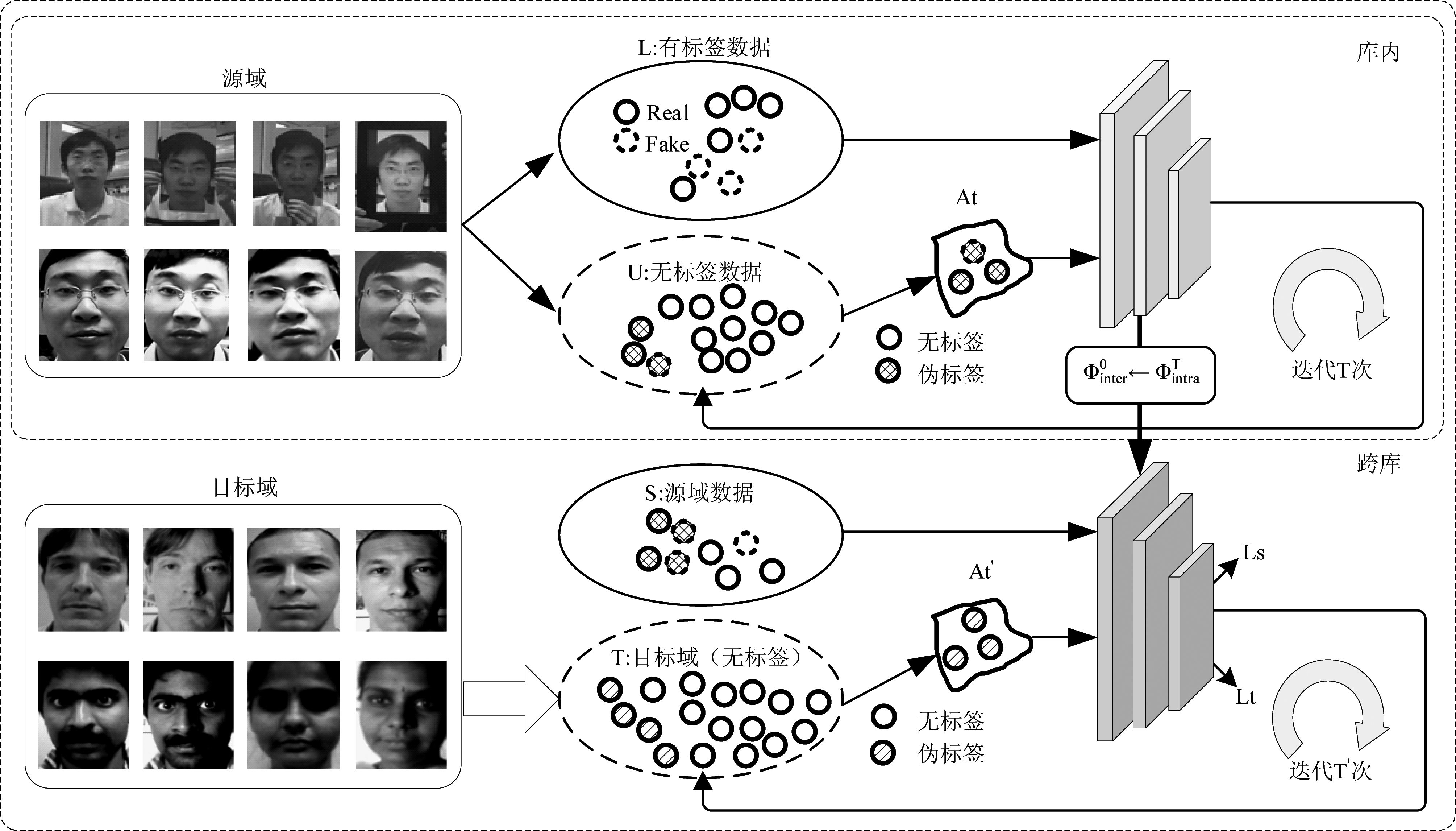

近期基于域自适应的典型文献[39]指出,现有FAS方法通常需要大量的标注数据训练有效的FAS模型,然而,考虑到欺诈数据的攻击特性和多样性,要获得所有的欺诈种类几乎是不可能的,这就限制了FAS网络在实际使用中的性能,因此亟需一个在线学习的FAS方法。该文提出了一个半监督学习的网络框架,用有限的标签训练数据(例如,50张人脸图像)来应对人脸欺诈攻击。具体而言,在训练模型时渐进地采用带有可靠伪标签的未标注数据来丰富训练数据的多样性。由于人脸欺诈数据通常以视频流的方式出现,该文利用时域的一致性来巩固一张选定图像伪标签数据的可靠性。进一步而言,该文提出一个自适应的迁移机制来缓解未见欺诈数据的影响。得益于方法的渐进式标注特性,该文方法既能够用已见过的数据(即源域)训练网络,也能用来源于未见过的攻击类型且没有标签的数据(即目标域)训练网络,可有效减少域之间的差异,大幅提升跨库检测能力。其主要不足是依赖于一些假设条件,包括时域的约束,初始标注数据的数量以及与预测置信度门限等。

图7 文献[39]的算法原理示意图

Fig.7 Illustration of the algorithm in reference [39]

文献[40]指出,在基于学习的人脸反欺诈检测中有一个共识,即有关相机模型的差异导致了实际应用中的域差异。该文提出一种能够在特征级降低来自相机内在方差影响的框架,它由两个部分组成:第一个分支学习相机不变的欺诈特征,可依赖于在高频域中特征级的分解来实现。但欺诈噪声不仅仅存在于高频域,因此,第二个分支从基于高频和低频信息重构后的增强图像中进一步提升可区分能力。文献[41]认为FAS本质上是一个局部任务,提出一个称为自监督区域全卷积(Self-Supervised Regional Fully Convolutional Network, SSR-FCN)的人脸欺诈检测框架,训练后用于以自监督的方式从人脸学习局部可区分的线索。文献[42]认为可将人脸欺诈检测定义为学习一个用于零样本或小样本FAS的元模型,检测器应该首先学习有区分度的特征,使其能从预先定义好的攻击类型泛化到未见过的欺诈种类,并通过从预先定义好的攻击和几个新的攻击类型学习,快速适应到新的欺诈类型。该方法在具体实现上是通过训练元学习器来求解深度回归。文献[43]认为基于深度学习的PAD方法容易过度关注某一特定区域,将其性能局限于防御传统的攻击,使得系统易于遭受对抗样本的攻击。为了利用更多的输入信息,增强PAD检测的鲁棒性,该文提出一个多区域卷积神经网络,同时引入针对局部块的局部分类损失概念,便于利用全部人脸区域的输入信息,避免过度关注局部区域。文献[44]提出利用深度强化学习的方式来学习图像子块与人脸欺诈有关的信息,并引入一个循环机制,用RNN循环网络去学习局部信息的表征。文献[45]为了改善现有方法的泛化性和适用性,在设计CNN模型的时候进行了两个创新:一是提出一种基于全成对混淆(Total Pairwise Confusion)的损失函数用于训练模型,二是将快速域自适应分量用于CNN模型。该CNN模型以多任务的方式进行工作,一次同时完成人脸识别和人脸的反欺诈。文献[46]发现导致域偏移的因素有拍摄设备差异、图像质量差异、拍摄条件和人物差异等,但这些因素并不反映欺诈手段的本质特征。若能消除这些因素的影响,则能缩小域偏移的程度,从而提高跨域检测性能。为此,提出一个一类域自适应方法,采用网络剪枝,对一个预训练好的人脸欺诈检测网络,保留其在目标域上“表现好”的滤波组,去除“表现差”的滤波组,使其适应目标域的数据分布从而提高跨域(库)检测性能。文献[47]提出一个不依赖源数据的域自适应FAS框架,将网络模型转化为一个学习含噪标签的过程,无需有标签的源域数据即可在目标域优化网络。为了得到可靠的伪标签,提出用带有背景的动态图像去捕捉真假脸之间的动态差异。该方法有效性的关键在于采用了动态图像输入以及目标域数据标签的自动修正步骤。

目前基于域自适应和域泛化的FAS方法还处于启发式的研究阶段,大多数方法基于对真假人脸的基本常识(例如,假脸的深度图为“0”)或经验上认为影响域偏移的因素来设计监督用的损失函数,对于实现域自适应和域泛化所需要的全面且准确的约束条件尚未见到共识。

3.6 利用解耦合/解纠缠学习分离欺诈痕迹的改进策略

解耦合/解纠缠学习(Disentanglement Learning)常常用于表达复杂的数据和特征,因此,利用解耦合学习网络,可有效区分活体和非活体人脸的特征,从而帮助我们设计一个能估计欺诈痕迹的通用检测模型。这种改进策略是目前的一个研究热点。

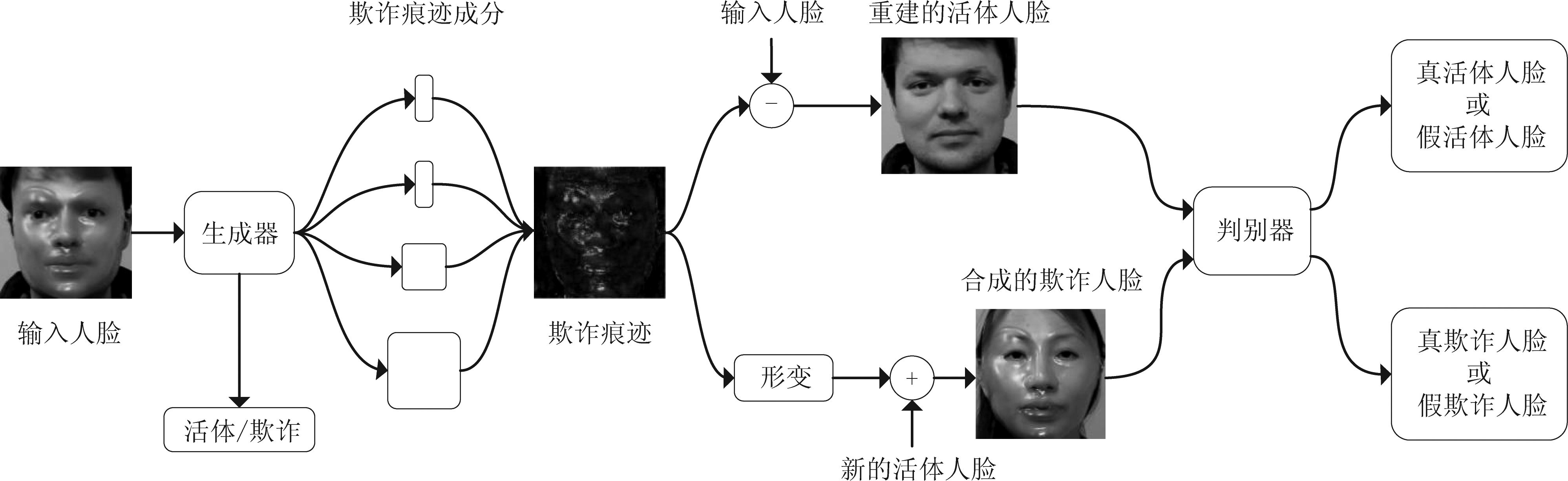

受噪声建模和去噪算法的启发,文献[48]最先将人脸的反欺诈检测转化为人脸的去欺诈问题,即将欺诈人脸分解成欺诈噪声和真脸,然后利用欺诈噪声来区分真假人脸。近期典型文献[49]提出了分离“欺诈痕迹”(例如,颜色畸变,3D面膜边缘,摩尔纹)的思路,即去除与欺诈无关的因素(如光照等)后反映活体人脸和欺诈人脸之间最本质的区分特征。该文作者构造了一个欺诈痕迹分离网络(Spoof Trace Disentanglement Network, STDN),如图8所示,从输入图片中分离出“欺诈痕迹”。所分离出的“欺诈痕迹”不但可为判决结果提供明确支撑,还可与任意真脸融合生成新的欺诈样本,解决训练数据不足的问题。该方法在已知攻击类型(白盒攻击)和未知攻击类型(黑盒攻击)的两类数据库中均进行了实验,结果极具有启发意义。另外,由于该方法的生成器可提取欺诈痕迹,作者还尝试了将欺诈痕迹输入简单神经网络进行攻击种类的分类,同样取得了较好的效果。

图8 文献[49]的欺诈痕迹分离网络STDN结构示意图

Fig.8 Illustration of the spoof trace disentanglement network in reference [49]

文献[50]提出一种解耦合表示方案,由解耦合表征学习网(DR-Net)和多域学习网(MD-Net)构成。前者通过生成模型学习一对编码器,它可从个体有区分度的特征分离出PAD有用的特征。这些来源于不同域的解耦合特征接着被送入MD-Net,学习与域独立的特征,用于跨域的PAD检测。文献[51]提出一个用解耦合表征实现无监督的域自适应方案(Unsupervised Domain Adaptation with Disentangled Representation, DR-UDA)。DR-UDA由3个模块组成:ML-Net,UDA-Net,DR-Net。ML-Net用有标签的源域人脸图像通过度量学习来获得有区分度的特征。UDA-Net执行无监督的对抗域自适应,目的是联合优化源域和目标域,以得到两个域共享的特征空间。由此,源域的PAD模型可有效地迁移到没有标签的目标域。DR-Net进一步分离与特定域有关的特征,这可通过重构来源于共享特征空间的源域脸和目标域脸。文献[52]认为,以往的方法依赖从图像提取的特征来研究可区分的模型,因此,欺诈模式和真实人脸仍有纠缠。受到解耦合表征学习的启发,该文提出一种新的视角,将图像内容特征和活体特征进行解耦合后仅将活体特征用于真假脸分类,并联合低级和高级监督改善泛化性能。文献[53]观察到在连续的真脸和假脸的图像序列中,运动模式是有差异的。据此,设计了一个基于自编码器结构的网络,对输入图片进行编码后,将编码向量分解成两部分,一部分包含与人脸身份相关的信息,可独立重构出该身份的真实人脸;另一部分则包含反映欺诈特征的信息。最终判决时除了用到欺诈特征,还用到了两帧图像间的运动变化信息,即同时利用了时域和空域的信息。

由于应用场景的复杂性、欺诈类型的多样性以及缺乏欺诈痕迹的示例样本(ground truth),目前这类方法存在欺诈痕迹的描述不够全面,度量标准不统一,以及欺诈特征的提取易受外界环境影响等问题。

3.7 源于信号异常检测的改进思路

最为直接的改进思路来源于信号异常检测的做法,将真脸看成一类数据,而将所有的非真脸看成是异常数据。这种改进思路是目前的一个研究热点。实际上,一类分类器很早就已用于指纹和说话人的欺诈检测。

文献[54]较早提出一个一类PAD检测系统,其构成包括一个剪切和归一化输入人脸帧的预处理器,一个图像质量评价(Image Quality Measures, IQMs)特征提取器以及一个基于广义高斯混合模型(Gaussian Mixture Model, GMM)的异常检测器。该文与当时基于SVM的二类分类器进行了性能对比,证明了方法的有效性。近期典型文献[55]指出,在不同环境下记录的人脸或多或少都会有差异,这使得FAS检测器的性能下降。为了避免这种情况,检测器需要使自己适应新环境,如此才能充分利用新环境中的真脸。该文将FAS问题转化为一个一类自适应问题,提出一类自适应人脸欺诈检测(One-Class-Adaptation FAS,OCA-FAS),通过在OCA任务上训练一个元学习器,以学习适应真脸(活体脸),并提出一个元损失函数搜索策略,用于搜索一个更好的损失函数,帮助元学习器完成OCA任务。该文作者尤其比较了一类人脸欺诈检测(One-Class FAS,OC-FAS)和OCA-FAS这两种方法的差异,指出前者假设了一种极端的情况,即完全无法获得欺诈人脸,而仅用活体人脸训练检测模型。但实际上,有些欺诈人脸还是可获取的。若仅用活体人脸训练模型,很难学习到真脸和假脸之间鲁棒的可区分特征。OCA-FAS的自适应性使其更加接近于真实的应用场景。

文献[56]给出一个将一类分类器用于多模态图像进行PAD的范例,设计多模态融合神经网络模型,结合一类高斯混合模型训练高泛化性人脸欺骗检测模型的方法。多通道卷积神经网络将灰度、深度、红外和热成像4种模态的图像信息分别输入网络的4个支路,初步提取特征后再进行融合,并将融合后的特征通过后续网络进一步提取特征,最终得到融合多模态人脸信息的特征,通过分类器输出分类结果。文献[57]考虑到训练时缺乏攻击样本,用一个高斯分布对伪负类进行建模,首次提出利用特征空间的伪负样本训练一个端到端的一类神经网络;并用一个成对的混淆损失函数来正则化训练过程。文献[58]提出一种基于特定客户(client-specific)异常检测的PAD方法,通过利用多个不同的一类分类器进行大量实验,展现在异常检测的模型构建和决策边界选择时,利用特定客户信息可显著改善检测器的性能。文献[59]将PAD看成是一个开集下的检测任务,通过超球面损失函数得到一个正常样本聚集在中心、未知样本(异常样本)分散在外围的隐特征空间,根据待测样本在该特征空间的位置即可判断其类别。文献[60]使用分类器堆叠的策略,通过训练并融合63个异常检测器获得更好的泛化能力。

对于真脸的特征表述在理论上可以尽可能的复杂,然而,考虑到不同应用场景对于特征提取的影响,真样本在特征空间中分布的紧致程度却无法保证,在完全无视假脸信息的情况下,分类器性能会急剧恶化,已有文献就这个问题进行了讨论。目前一类分类器的设计大多朝着尽可能多利用已知假脸信息的方向发展,检测性能也由此得到改善。

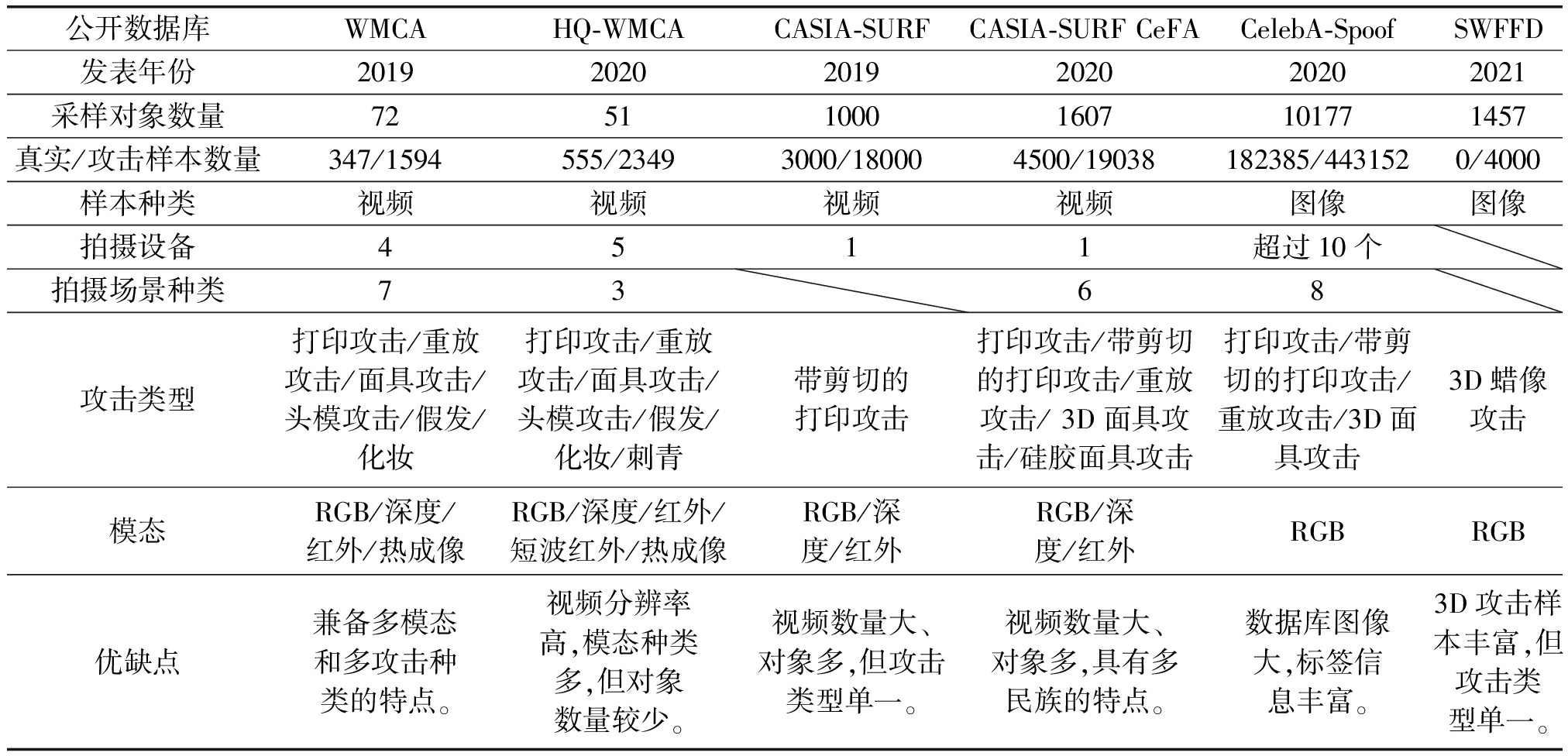

4 人脸欺诈检测数据库的新进展

早期公开发布的人脸欺诈检测数据库主要为单模态数据库,通常只包含RGB彩色图像或视频,样本的标注种类往往较少。近年来随着利用多种传感器拍摄人脸进行活体检测的应用场景逐渐增加,多模态人脸欺诈检测数据库成为了数据库构建的新方向。大部分多模态数据库包含了RGB域彩色图像、深度图像、红外图像等多种不同模态的人脸信息。另一方面,由于部分人脸识别应用场景中设备的限制,仍需使用单模态数据,因此单模态人脸欺诈检测数据库也有一定的发展。近两年公开发布的单模态数据库主要通过扩大样本规模及增加标注数量,应用于多任务多标签细粒度的分类当中。本节对近两年发布的主要人脸欺诈检测数据库进行介绍。数据库的基本信息如表1所示。

表1 2019年以来发布的主要人脸欺诈检测数据库及其基本信息一览表

Tab.1 Major open face spoofing detection datasets since 2019 and their basic information

公开数据库WMCAHQ-WMCACASIA-SURFCASIA-SURF CeFACelebA-SpoofSWFFD发表年份201920202019202020202021采样对象数量725110001607101771457真实/攻击样本数量347/1594555/23493000/180004500/19038182385/4431520/4000样本种类视频视频视频视频图像图像拍摄设备4511超过10个拍摄场景种类7368攻击类型打印攻击/重放攻击/面具攻击/头模攻击/假发/化妆打印攻击/重放攻击/面具攻击/头模攻击/假发/化妆/刺青带剪切的打印攻击打印攻击/带剪切的打印攻击/重放攻击/ 3D面具攻击/硅胶面具攻击打印攻击/带剪切的打印攻击/重放攻击/3D面具攻击3D蜡像攻击模态RGB/深度/红外/热成像RGB/深度/红外/短波红外/热成像RGB/深度/红外RGB/深度/红外RGBRGB优缺点兼备多模态和多攻击种类的特点。视频分辨率高,模态种类多,但对象数量较少。视频数量大、对象多,但攻击类型单一。视频数量大、对象多,具有多民族的特点。数据库图像大,标签信息丰富。3D攻击样本丰富,但攻击类型单一。

4.1 WMCA

WMCA(Wide Multi Channel Presentation Attack,WMCA)数据库[61]全称为“宽范围多通道呈现攻击”数据库,由瑞士著名的研究机构Idiap Research Institute于2019年发布。该数据库包含了72名不同对象人脸的真实及欺诈攻击,共计1941段视频样本,模态包括RGB、深度、红外和热成像等4种。彩色视频的分辨率为1920×1080,帧率为30帧/秒;深度视频的分辨率为640×480,帧率30帧/秒;红外视频的分辨率为640×480,帧率30帧/秒;高质量红外视频的分辨率为1280×1024,帧率为15帧/秒;热成像视频的分辨率为320×240,帧率为15帧/秒;高质量热成像视频的分辨率为640×480,帧率为25帧/秒。欺诈攻击方式包括纸张打印,屏幕重放,多种面具,头部模型,以及特殊的眼镜、假发及化妆攻击等。该数据库同时具备多模态和多攻击类型的特点。

4.2 HQ-WMCA

HQ-WMCA(High-Quality Wide Multi-Channel Attack,HQ-WMCA)数据库[62]全称为“高质量宽范围多通道呈现攻击”数据库,是WMCA数据库的升级版本。包含51名不同对象人脸的555段真实视频和2349段欺诈攻击视频,模态涵盖RGB、深度、红外、短波红外和热成像等5种。彩色视频的分辨率为1920×1200,帧率为30帧/秒;深度视频的分辨率为720×1280,帧率为30帧/秒;红外视频的分辨率为1920×1200,帧率为90帧/秒;短波红外视频的分辨率为640×512,帧率为90帧/秒;热成像视频的分辨率为640×480,帧率为30帧/秒。欺诈攻击方式除了包括WMCA数据库中的所有种类,还另外增添了面部刺青。相比于WMCA,HQ-WMCA数据库虽然对象数量有所减少,但在模态数量、攻击方式和样本总数均有所增加。

4.3 CASIA-SURF

CASIA-SURF数据库[63]是中国科学院自动化研究所在2019年发布的多模态人脸欺诈检测数据库,用于当年CVPR会议的多模态人脸欺诈检测挑战赛中[64]。包含1000名中国人对象,共有真实人脸视频3000段和欺诈攻击视频18000段,模态涵盖RGB、深度和红外等3种。数据库中的视频包括分辨率为1280×720的彩色视频,分辨率为640×480的深度视频,以及分辨率为640×480的红外视频。攻击方式主要为带剪切的纸张打印,即通过将攻击人脸中特定部位进行剪切,露出部分人脸,以完成人脸识别过程中眨眼、张嘴等要求。攻击通过6种不同的方式实现,包括:纸张平整且眼睛部位剪切,纸张弯曲且眼睛部位剪切,纸张平整且眼睛和鼻子部位剪切,纸张弯曲且眼睛和鼻子部位剪切,纸张平整且眼睛、鼻子和嘴巴部位剪切,以及纸张弯曲且眼睛、鼻子和嘴巴部位剪切。该数据库包含的攻击方式较为单一,但中国人对象数量和样本数量均十分庞大,适合于开发针对国内应用场景的人脸欺诈检测算法。

4.4 CASIA-SURF CeFA

CASIA-SURF跨民族多模态人脸欺诈检测数据库CASIA-SURF CeFA[65]由中国科学院自动化研究所于2020年发布,被用于2020年CVPR会议上的人脸欺诈检测挑战赛中[66]。包含1607名对象,来自东亚、中亚和非洲三个不同的人类种族,共有真实人脸视频4500段和欺诈攻击视频19038段,模态涵盖RGB、深度和红外等3种。包括彩色视频、深度视频和红外视频共三种,视频的分辨率统一为1280×720,帧率统一为30帧/秒。攻击方式包括2D纸张打印和屏幕重放,3D打印面具和硅胶面具。与CASIA-SURF数据库相比,该数据库的对象数量更多,样本规模更大,攻击方式更为丰富。另外,与CASIA-SURF数据库只包含中国人对象不同,CASIA-SURF CeFA数据库具有多种族特点,包含来自三个种族的对象,更适合于开发针对多国家或地区应用场景的人脸欺诈检测算法。

4.5 CelebA-Spoof

CelebA-Spoof数据库[67]是由北京交通大学、商汤科技及香港中文大学于2020年联合发布的人脸欺诈检测数据库。该数据库由CelebA大规模人脸属性数据库发展而来,样本均为RGB彩色图像。包含10177名对象人脸的真实及欺诈攻击共625537张图像样本。攻击方式包括普通纸张打印,带剪切的纸张打印,屏幕重放和三维面具。与前述4个多模态人脸欺诈检测数据库不同,该数据库为单模态数据库,且样本为图像而非视频,但其对象数量和样本数量更为庞大,样本涉及的拍摄装置和拍摄环境也更为多样。该数据库的显著特点还包括标注信息丰富,除了人脸欺诈检测数据库常用的真实人脸和不同类型的攻击人脸标签外,还从CelebA数据库继承了40种人脸属性标签,使得每一张图像样本都具有丰富的标签信息,适合用于多任务、多标签和细粒度的单模态人脸欺诈检测技术开发与验证。

4.6 SWFFD

SWFFD(Single Wax

Figure Face Database,SWFFD)数据库[68]全称为“单蜡像人脸数据库”,由武汉大学和西弗吉尼亚大学的合作团队于2021年发布。由于3D攻击人脸制作困难,花费不菲,导致现有数据库中的3D人脸数据存在样本尺寸小,多样性不够,真实度差等问题。为了解决上述困难,SWFFD数据库通过收集制作精良的名人蜡像图像来获得真实度极强的3D人脸样本。该数据库包含1457位世界知名人物的共4000张蜡像人脸图像。所有图像中人脸区域的尺寸不小于50×50像素,避免了人脸样本尺寸过小的问题。其中25.20%图像中人脸区域尺寸小于200×200像素,64.92%图像介于200×200像素和600×600像素之间,8.80%图像介于600×600像素和1000×1000像素之间,还有1.08%图像超过1000×1000像素,使得3D人脸样本的情况具有多样性。另外所有图像中人脸被遮挡的面积均不超过人脸总面积的50%,以保证3D人脸样本具有较高的质量。

5 结论与展望

人脸欺诈具有广泛的含义,它可以是针对人脸识别系统的欺骗,也可以是针对人眼的欺骗(例如,最近火爆的Deepfake视频换脸技术),因此,防御策略有所不同。本文仅针对用于欺骗人脸识别系统的人脸欺诈检测方法进行了阶段性总结,重点针对操作简单、成本低廉且常见的2D和3D人脸欺诈的防御方法进行了综述。按技术动机,将这些技术分为7类,其中前4类的研究历史较久,相互之间的关联性较强;而后3类则是近年随着深度学习网络迅猛发展起来的新兴方法,相互之间亦有密切关联。目前商业上的应用主要基于前4类方法,而后3类则更多地属于探索性研究。总的来看,7类方法的库内检测性能大多优越,部分方法的检测误差已接近于0,且各类方法的表现相差不远;但跨库泛化性能欠佳,HTER值的分布范围大致为10%~40%,且同一方法从A库到B库与从B库到A库的HTER值可能相差10%左右,波动较大,此外,不同库组合后的跨库HTER值更是难以预测,目前尚未见到泛化性能能在现有公开库中均列前茅的方法。

从理论上来看,未来的研究仍将集中于改善方法的泛化性能。而从应用的角度来看,网络模型的轻量化亦是一个值得重视的课题。限于文章篇幅,本文没有对模型的计算复杂度作过多的讨论,然而在工业应用中,这是一个极为重要的问题。实际上,人脸欺诈检测技术永远都是朝着“模型小,速度快,准确率高”的方向发展。最后需要说明的是,本文没有讨论针对对抗样本攻击的防御策略,原因之一是文章篇幅限制;原因之二是对抗样本攻击目前还处在白盒攻击阶段,有关黑盒攻击成功的案例尚未达到造成威胁的程度,但作为前瞻性研究,同样是一个值得关注的课题。

[1] 孙霖. 人脸识别中的活体检测技术研究[D]. 杭州:浙江大学博士论文,2010.

SUN Lin. Research on anti-spoofing in face recognition[D]. Hangzhou: Zhejiang University, 2010. (in Chinese)

[2] LI Jiangwei, WANG Yunhong, TAN Tieniu, et al. Live face detection based on the analysis of Fourier spectra[C]∥Biometric Technology for Human Identification, Orlando, USA: SPIE, 2004: 296-303.

[3] BOULKENAFET Z, KOMULAINEN J, HADID A. 2016. Face spoofing detection using colour texture analysis[J]. IEEE Transactions on Information Forensics and Security, 2016, 11(8): 1818-1830.

[4] PENG Fei, QIN Le, LONG Min. Face presentation attack detection based on chromatic co-occurrence of local binary pattern and ensemble learning[J]. Journal of Visual Communication and Image Representation, 2020, 66: 102746.

[5] ZHANG Wanling, XIANG Shijun. Face anti-spoofing detection based on DWT-LBP-DCT features[J]. Signal Processing: Image Communication, 2020, 89: 115990.

[6] YU Zitong, ZHAO Chenxu, WANG Zezheng, et al. Searching central difference convolutional networks for face anti-spoofing[C]∥Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, Seattle, USA: IEEE, 2020: 5295-5305.

[7] BOULKENAFET Z, KOMULAINEN J, LI L,et al. OULU-NPU: A mobile face presentation attack database with real-world variations[C]∥The 12th IEEE International Conference on Automatic Face & Gesture Recognition, Washington DC, USA: IEEE, 2017: 612- 618.

[8] LIU Y, JOURABLOO A, LIU X. Learning deep models for face anti-spoofing: Binary or auxiliary supervision[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, Salt Lake City, USA: IEEE, 2018: 389-398.

[9] ZHANG Zhiwei, YAN Junjie, LIU Sifei, et al. A face antispoofing database with diverse attacks[C]∥The 5th IAPR International Conference on Biometrics, New Delhi, India: IEEE, 2012: 26-31.

[10]CHINGOVSKA I, ANJOS A, MARCEL S. On the effectiveness of local binary patterns in face anti-spoofing[C]∥2012 International Conference of Biometrics Special Interest Group, Darmstadt, Germany: IEEE, 2012: 1-7.

[11]WEN D, HAN H, JAIN A K. Face spoof detection with image distortion analysis[J]. IEEE Transactions on Information Forensics and Security, 2015. 10(4): 746-761.

[12]ZHOU Junwei, SHU Ke, LIU Peng, et al. Face anti-spoofing based on dynamic color texture analysis using local directional number pattern[C]∥The 25th International Conference on Pattern Recognition, Milan, Italy: IEEE, 2021: 4221- 4228.

[13]CHEN Baoliang, YANG Wenhan, WANG Shiqi.Generalized face antispoofing by learning to fuse features from high-and low-frequency domains[J]. IEEE MultiMedia, 2021, 28(1): 56- 64.

[14]LI Lei, XIA Zhaoqiang, JIANG Xiaoyue, et al. CompactNet: learning a compact space for face presentation attack detection[J]. Neurocomputing, 2020, 409: 191-207.

[15]KOLLREIDER K, FRONTHALER H, FARAJ M I,et al. Real-time face detection and motion analysis with application in "liveness" assessment[J]. IEEE Transactions on Information Forensics and Security, 2007, 2(3): 548-558.

[16]YU Zitong, LI Xiaobai, NIU Xuesong, et al. Face anti-spoofing with human material perception[C]∥2020 European Conference on Computer Vision, Berlin, German: Springer, 2020: 557-575.

[17]PINTO A, GOLDENSTEIN S, FERREIRA A,et al. Leveraging shape, reflectance and albedo from shading for face presentation attack detection[J]. IEEE Transactions on Information Forensics and Security, 2020, 15: 3347-3358.

[18]WU Xiaojun, ZHOU Jinghui, LIU Jun,et al. Single-shot face anti-spoofing for dual pixel camera[J]. IEEE Transactions on Information Forensics and Security, 2021, 16: 1440-1451.

[19]EBIHARA F, SAKURAI K, IMAOKA H. Efficient face spoofing detection with flash[J]. IEEE Transactions on Biometrics, Behavior, and Identity Science, 2021.

[20]LIU Siqi, LAN Xiangyuan, YUEN Pongchi. Multi-Channel remote photoplethysmography correspondence feature for 3D mask face presentation attack detection[J]. IEEE Transactions on Information Forensics and Security, 2021, 16: 2683-2696.

[21]LIU Siqi, LAN Xiangyuan, YUEN Pongchi. Temporal similarity analysis of remote photoplethysmography for fast 3D mask face presentation attack detection[C]∥Proceedings of the IEEE/CVF Winter Conference on Applications of Computer Vision, Snowmass, USA: IEEE, 2020: 2608-2616.

[22]LI Lei, XIA Zhaoqiang, JIANG Xiaoyue, et al. 3D face mask presentation attack detection based on intrinsic image analysis[J]. IET Biometrics, 2020, 9(3): 100-108.

[23]JIA Shan, LI Xin, HU Chuanbo, et al. 3D face anti-spoofing with factorized bilinear coding[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2020.

[24]ATOUM Y, LIU Y, JOURABLOO A,et al. Face anti-spoofing using patch and depth-based CNNs[C]∥2017 IEEE International Joint Conference on Biometrics, Denver, USA: IEEE, 2017: 319-328.

[25]WANG Zezheng, YU Zitong, ZHAO Chenxu, et al. Deep spatial gradient and temporal depth learning for face anti-spoofing[C]∥Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, Seattle, USA: IEEE, 2020: 5042-5051.

[26]LI Xuan, WAN Jun, JIN Yi,et al. 3DPC-Net: 3D point cloud network for face anti-spoofing[C]∥2020 IEEE International Joint Conference on Biometrics, Houston, USA: IEEE, 2020: 1- 8.

[27]ZHENG Wei, YUE Mengyuan, ZHAO Shuhuan, et al. Attention-based spatial-temporal multi-scale network for face anti-spoofing[J]. IEEE Transactions on Biometrics, Behavior, and Identity Science, 2021, 3(3): 296-307.

[28]YU Zitong, LI Xiaobai, SHI Jingang, et al. Revisiting pixel-wise supervision for face anti-spoofing[J]. IEEE Transactions on Biometrics, Behavior, and Identity Science, 2021, 3(3): 285-295.

[29]TE Gusi, HU Wei, GUO Zongming.Exploring hypergraph representation on face anti-spoofing beyond 2D attacks[C]∥2020 IEEE International Conference on Multimedia and Expo, London, UK: IEEE, 2020: 1- 6.

[30]PENG Dongmei, XIAO Jing, ZHU Rong,et al. TS-FEN: Probing feature selection strategy for face anti-spoofing[C]∥2020 IEEE International Conference on Acoustics, Speech and Signal Processing, Barcelona, Spain: IEEE, 2020: 2942-2946.

[31]SUN Wenyun, SONG Yu, CHEN Changsheng, et al. Face spoofing detection based on local ternary label supervision in fully convolutional networks[J]. IEEE Transactions on Information Forensics and Security, 2020, 15: 3181-3196.

[32]LIU Weihua, WEI Xiaokang, LEI Tao, et al. Data fusion based two-stage cascade framework for multi-modality face anti-spoofing[J]. IEEE Transactions on Cognitive and Developmental Systems, 2021.

[33]LI Zhishan, YUAN Jiayan, JIA Baozhi, et al. An effective face anti-spoofing method via stereo matching[J]. IEEE Signal Processing Letters, 2021, 28: 847- 851.

[34]LIU Ajian, TAN Zichang, WAN Jun, et al. Face anti-spoofing via adversarial cross-modality translation[J]. IEEE Transactions on Information Forensics and Security, 2021, 16: 2759-2772.

[35]KOTWAL K, MARCEL S. CNN patch pooling for detecting 3D mask presentation attacks in NIR[C]∥2020 IEEE International Conference on Image Processing, Abu Dhabi, United Arab: IEEE, 2020: 1336-1340.

[36]SIEGMUND D, KERCKHOFF F, MAGDALENO J Y,et al. Face presentation attack detection in ultraviolet spectrum via local and global features[C]∥2020 International Conference of the Biometrics Special Interest Group, Darmstadt, Germany: IEEE, 2020: 1-5.

[37]JI Qiaobin, XU Shugong, CHEN Xudong, et al. A cross domain multi-modal dataset for robust face anti-spoofing[C]∥The 25th International Conference on Pattern Recognition, Milan, Italy: IEEE, 2021: 4309- 4316.

[38]YANG Jianwei, LEI Zhen, YI Dong,et al. Person-specific face anti-spoofing with subject domain adaptation[J]. IEEE Transactions on Information Forensics and Security, 2015, 10(4): 797- 809.

[39]QUAN Ruijie, WU Yu, YU Xin, et al. Progressive transfer learning for face anti-spoofing[J]. IEEE Transactions on Image Processing, 2021, 30: 3946-3955.

[40]CHEN Baoliang, YANG Wenhan, LI Haoliang, et al. Camera invariant feature learning for generalized face anti-spoofing[J]. IEEE Transactions on Information Forensics and Security, 2021, 16: 2477-2492.

[41]DEB D, JAIN A K. Look locally infer globally: a generalizable face anti-spoofing approach[J]. IEEE Transactions on Information Forensics and Security, 2021, 16: 1143-1157.

[42]QIN Yunxiao, ZHAO Chenxu, ZHU Xiangyu, et al. Learning meta model for zero-and few-shot face anti-spoofing[C]∥Proceedings of the AAAI Conference on Artificial Intelligence, New York, USA: AAAI, 2020: 11916-11923.

[43]MA Yukun, WU Lifang, LI Zeyu.A novel face presentation attack detection scheme based on multi-regional convolutional neural networks[J]. Pattern Recognition Letters, 2020, 131: 261-267.

[44]CAI Rizhao, LI Haoliang, WANG Shiqi, et al. DRL-FAS: A novel framework based on deep reinforcement learning for face anti-spoofing[J]. IEEE Transactions on Information Forensics and Security, 2021, 16: 937-951.

[45]TU Xiaoguang, MA Zheng, ZHAO Jian,et al. Learning generalizable and identity-discriminative representations for face anti-spoofing[J]. ACM Transactions on Intelligent Systems and Technology, 2020, 11(5): 1-19.

[46]MOHAMMADI A, BHATTACHARJEE S, MARCEL S. Domain adaptation for generalization of face presentation attack detection in mobile settings with minimal information[C]∥2020 IEEE International Conference on Acoustics, Speech and Signal Processing, Barcelona, Spain: IEEE, 2020: 1001-1005.

[47]LV Lingling, XIANG Youjun, LI Xianfeng, et al. Combining dynamic image and prediction ensemble for cross-domain face anti-spoofing[C]∥2021 IEEE International Conference on Acoustics, Speech and Signal Processing, Toronto, Canada: IEEE, 2021: 2550-2554.

[48]JOURABLOO A, LIU Yaojie, LIU Xiaoming. Face de-spoofing: Anti-spoofing via noise modeling[C]∥2018 European Conference on Computer Vision, Munich, Germany: Springer, 2018: 290-306.

[49]LIU Yaojie, STEHOUWER J, LIU Xiaoming. On disentangling spoof trace for generic face anti-spoofing[C]∥2020 European Conference on Computer Vision, Berlin, German: Springer, 2020: 406- 422.

[50]WANG Guoqing, HAN Hu, SHAN Shiguang, et al. Cross-domain face presentation attack detection via multi-domain disentangled representation learning[C]∥Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, Seattle, USA: IEEE, 2020: 6678- 6687.

[51]WANG Guoqing, HAN Hu, SHAN Shiguang, et al. Unsupervised adversarial domain adaptation for cross-domain face presentation attack detection[J]. IEEE Transactions on Information Forensics and Security, 2021, 16: 56- 69.

[52]ZHANG Keyue, YAO Taiping, ZHANG Jian, et al. Face anti-spoofing via disentangled representation learning[C]∥2020 European Conference on Computer Vision, Berlin, German: Springer, 2020: 641- 657.

[53]LIU Zhao, FENG Zunlei, ZOU Zeyu, et al. Disentangled representation based face anti-spoofing[C]∥The 25th International Conference on Pattern Recognition, Milan, Italy: IEEE, 2021: 2017-2024.

[54]NIKISINS O, MOHAMMADI A, ANJOS A,et al. On effectiveness of anomaly detection approaches against unseen presentation attacks in face anti-spoofing[C]∥2018 International Conference on Biometrics, Gold Coast, Australia, IEEE, 2018: 75- 81.

[55]QIN Yunxiao, ZHANG Weiguo, SHI Jingping, et al. One-class adaptation face anti-spoofing with loss function search[J]. Neurocomputing, 2020, 417: 384-395.

[56]GEORGE A, MARCEL S. Learning one class representations for face presentation attack detection using multi-channel convolutional neural networks[J]. IEEE Transactions on Information Forensics and Security, 2021, 16: 361-375.

[57]BAWEJA Y, OZA P, PERERA P,et al. Anomaly detection-based unknown face presentation attack detection[C]∥2020 IEEE International Joint Conference on Biometrics, Houston, USA: IEEE, 2020: 1-9.

[58]FATEMIFAR S, ARASHLOO S R, AWAIS M,et al. Client-specific anomaly detection for face presentation attack detection[J]. Pattern Recognition, 2021, 112: 107696.

[59]LI Zhi, LI Haoliang, LAM Kwok-Yan, et al. Unseen face presentation attack detection with hypersphere loss[C]∥2020 IEEE International Conference on Acoustics, Speech and Signal Processing, Barcelona, Spain: IEEE, 2020: 2852-2856.

[60]FATEMIFAR S, AWAIS M, AKBARI A,et al. A stacking ensemble for anomaly based client-specific face spoofing detection[C]∥2020 IEEE International Conference on Image Processing, Abu Dhabi, United Arab: IEEE, 2020: 1371-1375.

[61]GEORGE A, MOSTAANI Z, GEISSBÜHLER D,et al. Biometric face presentation attack detection with multi-channel convolutional neural network[J]. IEEE Transactions on Information Forensics and Security, 2020, 15: 42-55.

[62]HEUSCH G, GEORGE A, GEISSBÜHLER D,et al. Deep models and shortwave infrared information to detect face presentation attacks[J]. IEEE Transactions on Biometrics, Behavior, and Identity Science, 2020, 2(4): 399- 409.

[63]ZHANG Shifeng, LIU Ajian, WAN Jun, et al. CASIA-SURF: A large-scale multi-modal benchmark for face anti-spoofing[J]. IEEE Transactions on Biometrics, Behavior, and Identity Science, 2020, 2(2): 182-193.

[64]LIU Ajian, WAN Jun, ESCALERA S,et al. Multi-modal face anti-spoofing attack detection challenge at CVPR2019[C]∥Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops, Long Beach, USA: IEEE, 2019: 1601-1610.

[65]LIU Ajian, TAN Zichang, WAN Jun, et al. CASIA-SURF CEFA: A benchmark for multi-modal cross-ethnicity face anti-spoofing[C]∥Proceedings of the IEEE/CVF Winter Conference on Applications of Computer Vision, Waikoloa, USA: IEEE, 2021: 1179-1187.

[66]LIU Ajian, LI Xuan, WAN Jun, et al. Cross-ethnicity face anti-spoofing recognition challenge: A review[J]. IET Biometrics, 2021, 10(1): 24- 43.

[67]ZHANG Yuanhan, YIN Zhenfei, LI Yidong, et al. CelebA-Spoof: Large-scale face anti-spoofing dataset with rich annotations[C]∥2020 European Conference on Computer Vision, Berlin, German: Springer, 2020: 70- 85.

[68]JIA Shan, HU Chuanbo, LI Xin, et al. Face spoofing detection under super-realistic 3D wax face attacks[J]. Pattern Recognition Letters, 2021, 145: 103-109.