1 引言

高光谱传感器可以获取从可见光到红外光谱范围内的数百个连续波段的数字图像[1]。与传统多光谱系统相比,高光谱传感器能够提供更多目标光谱的细节信息,以区分图像场景中的目标[2]。

在过去的三十年里,已经发展了大量的技术应用于高光谱图像(Hyperspectral image,HSI)分类,例如,被广泛使用的支持向量机(the support vector machine,SVM)[3],使用Logistic函数计算后验概率的多项逻辑回归(multinomial logistic regression)分类器[4- 6],智能模型人工免疫网络(the artificial immune network,AIN)和生物脱氧核糖酸计算(biological deoxyribonucleic acid,BDA)[7- 8]。上述分类器虽然能够有效利用HSI的光谱信息,但它们忽略了空间位置信息。近年来,为了进一步提升HSI的分类性能,提出了基于复合核、聚类和分割的方法[9-11],将空间信息应用于HSI分类。还有一些分类方法侧重于特征提取(如多特征融合[12]、扩展形态学轮廓[13]和多核学习[14]等)。稀疏表示方法[15]已在许多计算机视觉任务中得到有效应用[16-18],文献[16]认为信号可利用字典进行稀疏表示,而噪声不具备这种特性,光谱空间联合相关性可促进信号的识别,进而提出将图像自相似性和光谱空间联合相关性引入稀疏表示,实现信号和噪声分离;文献[17]将稀疏表示应用于光学相干层析图像去噪,首先通过扫描获取较高信噪比的图像,然后为每幅图像学习一个字典,利用字典对低信噪比的扫描图像进行去噪;文献[18]在文献[17]的基础上,利用训练图像之间的推断关系学习字典,然后利用推断关系获取测试图像的缺失信息,在去噪的同时还可插入丢失的数据,快速获得目标图像。文献[19]将稀疏表示用于目标检测,考虑了不同邻域像素的贡献不同,提出了一种加权邻域自适应的方法。稀疏表示也被应用于高光谱图像分类中,文献[20]通过字典优化,使稀疏表示分类使用的字典集更具典型性;文献[21]在进行稀疏表示时,引入字典原子和待测像元的引力,能够快速找到与待测像素匹配的原子。[20]和[21]对空间信息的利用较少,且一定程度上依赖类字典的数量。文献[22]利用训练样本和测试样本的距离矩阵增强类别区分度,将含有光谱信息和空间信息的正则项同时引入联合稀疏表示中进行分类;文献[23]将高斯加权函数引入到测试像素的邻域像素,获得加权联合欧氏距离,随后采用稀疏表示方法获得残差,最后使用决策函数来平衡加权联合欧氏距离和稀疏表示的残差,体现了空间信息的重要性;文献[24]考虑局部空间结构信息,利用局部特征生成基于高斯核函数的区域级空间核,并将其整合到稀疏表示分类中;文献[25]通过聚类平衡光谱信息和空间信息,对空间进行预处理。文献[22-25]在基于稀疏表示的分类过程中都用到了空间信息,但未考虑字典的优化问题。文献[26-27]为每个测试像素定义一个固定大小的局部区域,虽然这种基于固定区域的联合稀疏表示方法运用到了空间信息,但是区域的形状和大小固定,高光谱图像的空间信息得不到充分利用。文献[1]使用基于超像素的分类方法,然而,这种方法容易因超像素分割不准确而导致较大区域地物的分类精度下降。

针对上述问题,为了更加充分的利用空间信息,本文提出了一种基于二次空间处理的联合稀疏表示高光谱图像分类(joint sparse representation of hyperspectral image classification based on quadratic space processing,QSP-JSRC)算法。首先提取高光谱图像的形态学特征,结合光谱特征共同选取初始字典,用于判别式字典和分类器的训练。同时,根据高光谱图像的空间结构,利用梯度信息调整每个超像素的形状和尺寸,获得分割效果较好的超像素,实现空间信息的第一次利用,然后在超像素边缘和固定邻域的双重约束下,通过计算邻域像素的权重对每个像素原子进行自适应邻域选择,实现空间信息的第二次利用。最后,利用训练得到的分类器对测试像素进行联合稀疏表示分类。

2 稀疏表示的高光谱图像分类

由于每个高光谱测试像素可以表示为所有训练样本的稀疏线性组合。稀疏表示已经成功应用于高光谱图像分类中。设将高光谱图像的一个测试像素表示为y(test)∈RT×1,其中T表示光谱带的数目,字典为D=[D1,...,Dc,...,DC]∈RT×N,其中C是类别数,N是字典个数,Dc∈RT×Nc,c=1,2,...,C表示一个子字典,Nc是第c类子字典的个数。则测试像素可表示为:

y(test)=Dα(test)

(1)

稀疏重构向量可以通过求解式(2)的误差约束问题得到,式(2)也可以写成求解式(3)的稀疏约束问题:

![]() s.t. ||y(test)-Dα(test)||2≤σ

s.t. ||y(test)-Dα(test)||2≤σ

(2)

![]() s.t. ||α(test)||0≤K

s.t. ||α(test)||0≤K

(3)

式中K为设定的稀疏度,表示α(test)中非零系数的个数,σ为误差容限。式(3)所示的问题通常被认为是非确定性多项式(non-deterministic polynomial,NP-hard)问题,计算复杂度很高,所以总是需要用贪婪算法来解决,例如正交匹配追踪(orthogonal matching pursuit,OMP)算法、子空间追踪(subspace pursuit,SP)算法。获得了稀疏系数向量![]() 后,可以根据最小重构误差准则来确定测试像素的类别标签,即:

后,可以根据最小重构误差准则来确定测试像素的类别标签,即:

(4)

3 基于二次空间处理的联合稀疏表示高光谱图像分类

3.1 判别式字典训练

由于稀疏表示的性能很大程度上取决于字典的质量,通过直接从原始高光谱数据中提取像素来构造字典的方法,往往需要大量的训练像素且分类效果不佳。一种广泛使用的字典学习算法是K-均值奇异值分解(K-means singular value decomposition,KSVD)算法。传统的KSVD算法随机选择初始字典,然后进行字典训练,在整个分类过程中往往需要占用大量时间进行字典优化,本文使用形态学方法,提取形态学特征,结合光谱特征共同预选取初始字典,减少训练所需时间。

为了方便处理高光谱数据,本文首先利用主成分分析(principal component analysis,PCA)方法对高光谱图像提取主成分特征图I,然后利用矩形结构元素对提取的主成分特征图进行基于重建的形态学运算,为每个像素引入了空间结构特征,提高每个像素在空间上的区分性,便于边缘特征提取。利用矩形结构元素对主成分灰度特征图进行腐蚀和膨胀的操作分别定义为:

IΘB={x|(B)x⊆I}

(5)

(6)

式中![]() 表示B的映像,Θ表示腐蚀运算,⊕表示膨胀运算。腐蚀运算可以分离纤细点处的物体,膨胀运算可以填充物体内部的细小空洞。而通过腐蚀和膨胀运算可实现图像的开闭运算。形态学开运算O(I)和闭运算ρ(I)分别定义为:

表示B的映像,Θ表示腐蚀运算,⊕表示膨胀运算。腐蚀运算可以分离纤细点处的物体,膨胀运算可以填充物体内部的细小空洞。而通过腐蚀和膨胀运算可实现图像的开闭运算。形态学开运算O(I)和闭运算ρ(I)分别定义为:

O(I)=(IΘB)⊕B

(7)

ρ(I)=(I⊕B)ΘB

(8)

通过形态学运算,提取图像的形态学特征,结合光谱特征共同构建初始字典D。

KSVD算法旨在解决式(9)的字典优化问题

(9)

其中Y(train)∈RT×Z是输入的训练样本,其中Z表示训练样本的个数。D=[D1,...,Dc,...,DC]∈RT×N表示初始字典,C是总类别数,![]() 表示训练样本对应的稀疏系数矩阵。引入分类误差约束项||H(train)-WA(train)

表示训练样本对应的稀疏系数矩阵。引入分类误差约束项||H(train)-WA(train)![]() 到式(9)中构成判别式KSVD训练算法,其中

到式(9)中构成判别式KSVD训练算法,其中![]() 表示训练样本的类别矩阵,W∈RC×N是需要训练的分类器。将分类误差约束项引入式(9)中,以共同训练字典和分类器,目标函数如式(10)所示:

表示训练样本的类别矩阵,W∈RC×N是需要训练的分类器。将分类误差约束项引入式(9)中,以共同训练字典和分类器,目标函数如式(10)所示:

![]() λ1||H(train)-WA(train)

λ1||H(train)-WA(train)![]()

![]()

(10)

其中λ1是用来平衡重构误差和分类误差约束的标量。式(10)可通过[28]中的方法求解,表示为:

![]()

![]()

(11)

令![]() 则式(11)可以等效为式(12)所示的优化问题:

则式(11)可以等效为式(12)所示的优化问题:

(12)

式(10)也可利用KSVD算法求解。

3.2 双重空间约束下的自适应邻域选择

本文提出在超像素的边缘约束下令每个像素在固定邻域范围内自适应选择邻域像素,既利用了超像素分割的优势,又通过邻域自适应选择避免了超像素分割不准确带来的边缘像素错分的情况,也能减少无边缘约束时直接令像素自适应选择邻域造成的聚类误差,起到双重保障的作用。

本文使用改进的分水岭算法创建超像素图。在分割之前,将主成分分析(PCA)应用于原始高光谱图像。由于第一主成分应包含高光谱图像最重要的信息,故将第一主成分图作为超像素分割的基础图像,创建超像素图的过程如图1所示。本文选择分水岭(watershed)算法进行超像素分割是因为分水岭算法能够很好的利用边缘梯度信息调整边缘分割的形状,而简单线性迭代聚类(simple linear iterative clustering,SLIC)算法进行超像素分割时,分割边缘的调整范围具有较大局限性。

图1 超像素图创建

Fig.1 Creation of superpixels map

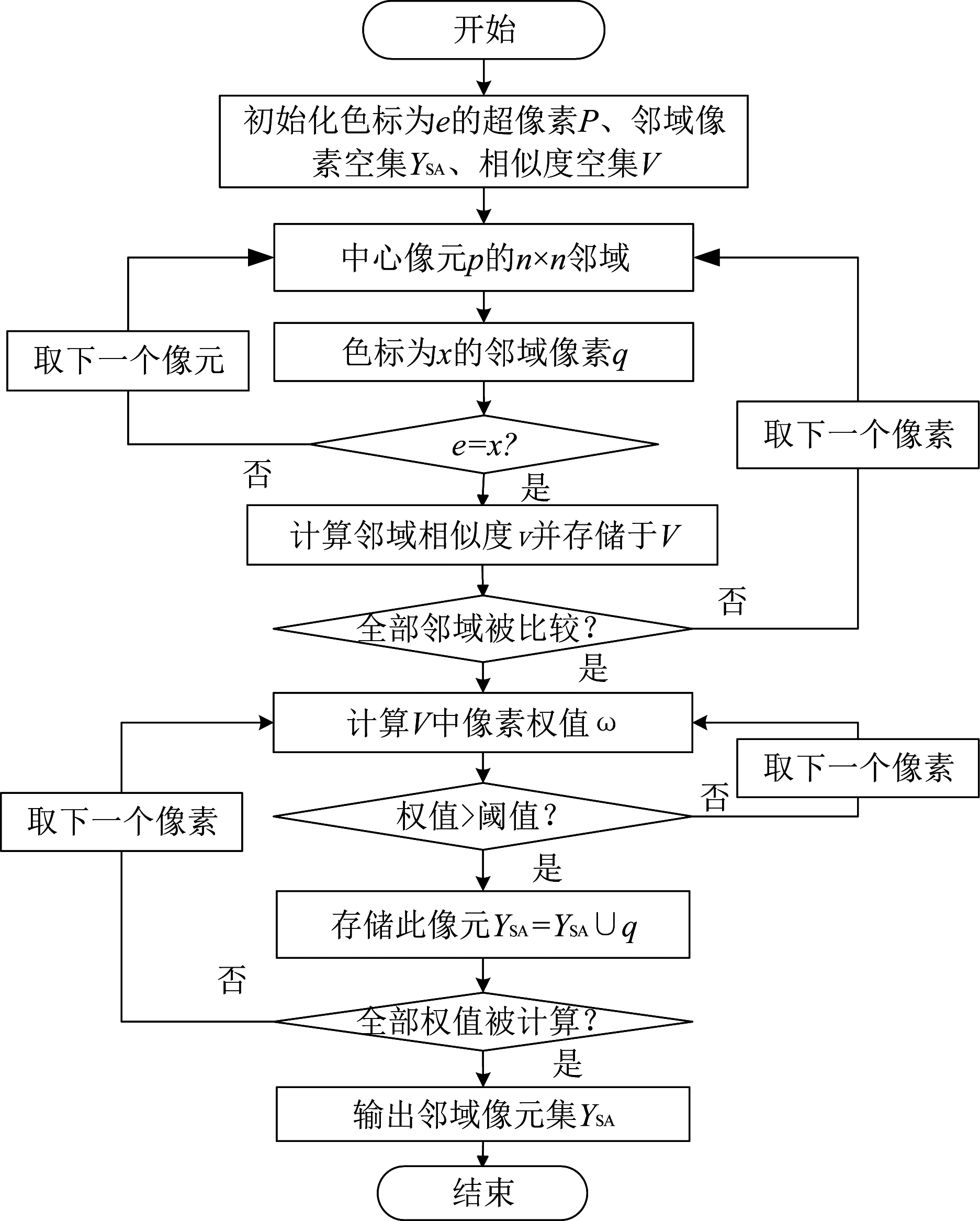

自适应邻域创建过程如图2所示,首先在超像素图中选取一个色标为e的超像素P=[p1,p2,...,pL],其中pi表示超像素中的第i个像素,L表示色标为e的超像素中原子的个数,选择中心像素pi的n×n邻域像素集Qi=[qi,1,qi,2,...,qi,n×n],其中qi, j表示中心像素pi的第j个邻域像素,对应的色标为xi, j。然后判断色标xi, j与e是否相同,若相同则计算此邻域像素与中心像素的相似度vi, j并存储Vi=Vi∪vi, j,当符合双重约束条件的邻域像素的相似度全部被计算以后,通过公式(16)计算双重约束下每个相邻像素的权值,当权值符合阈值要求时,则将像素记录于邻域像素子集YSA=YSA∪qi, j。

图2 自适应邻域创建图

Fig.2 Creation of adaptive neighborhood

邻域像素的相似度计算规则如式(13)所示:

vi, j=(1-λ)ds(pi,qi, j)+λs(pi,qi, j),j=1,2,...,J

(13)

其中λ为平衡空间相似度和光谱相似度的系数,ds(pi,qi, j)表示相邻像素的空间相似性,s(pi,qi, j)表示光谱的余弦相似性,计算方式分别如式(14)、(15)所示:

![]() j=1,2,...,J

j=1,2,...,J

(14)

(15)

式中(xxi,yyi)表示中心像素pi的空间坐标,(xxi, j,yyi, j)为pi的第j个相邻像素的空间坐标,pi,t和qi, j,t分别表示中心像素和相邻像素的第t个维度的光谱分量。

令![]() i=vi,1+vi,2+...+vi,J,则每一个双重约束范围内的邻域像素的权重可表示为:

i=vi,1+vi,2+...+vi,J,则每一个双重约束范围内的邻域像素的权重可表示为:

(16)

本文通过在以训练像素为中心的n×n邻域内,求解与训练像素类别相同的邻域训练像素的权值的均值获得阈值大小。双重空间约束的自适应邻域选择流程图如图3所示。

图3 双重空间约束的自适应邻域选择流程图

Fig.3 Adaptive neighborhood selection flow chart under double space constraints

自适应邻域选择具体步骤如算法1所示。

算法1 双重空间约束的自适应邻域选择算法输入:超像素图。1. 初始化:色标为e的超像素P=[p1,p2,...,pL],存储邻域像元的集合YSA=⌀,存储邻域像元索引的集合S=⌀,取超像素内的一个像素pi作为中心像素,存储像素相似度的集合Vi=⌀令j=0,J=0。2. 确定中心像素pi的n×n邻域像素集Qi=[qi,1,qi,2,...,qi,n×n]。3. While n×n邻域

3.3 自适应像素集的联合稀疏表示分类

对于每个自适应像素子集YSA∈RT×M,可使用联合稀疏表示来分类,对应的联合稀疏系数矩阵ASA可通过式(17)求解:

![]() s.t. ||ASA||row,0≤K

s.t. ||ASA||row,0≤K

(17)

通过公式(10)学习到的字典![]() 和分类器W需要分别进行归一化处理才能用于分类。利用归一化后的分类器W创建类别矩阵HSA=[h1,h2,...],对于每个自适应像素子集有:

和分类器W需要分别进行归一化处理才能用于分类。利用归一化后的分类器W创建类别矩阵HSA=[h1,h2,...],对于每个自适应像素子集有:

HSA=W×ASA

(18)

其中hi是YSA中对应像素yi的类别向量,最大值所在的位置就是yi的类别标签。最后HSA的每一行相加得到一个新的类别向量hSA,自适应像素子集的中心像素![]() 的类别标签就是hSA中最大值所在的位置,如式(19)所示:

的类别标签就是hSA中最大值所在的位置,如式(19)所示:

(19)

QSP-JSRC算法步骤如算法2所示。

算法2 QSP-JSRC算法输入:高光谱数据1. 主成分特征图提取:使用主成分分析方法提取主成分特征图I。2. 判别式KSVD字典训练:提取形态学特征,和光谱特征共同构建初始字典D=[D1,...,Dc,...,DC]进行训练,得到训练后的字典D⌒=[D⌒1,...,D⌒c,...,D⌒C]和分类器W。3. 超像素创建:使用改进的分水岭算法在主成分特征图上构建超像素图。4. 二次空间约束在超像素边缘约束下,在固定邻域内令每个像素pi在邻域像素集Qi=[qi,1,qi,2,...,qi,n×n]中计算相应权值,进行自适应邻域像素选取,获得自适应邻域集合YSA。5. 使用分类器分类:将学习到的分类器W⌒应用于自适应邻域子集YSA的稀疏系数矩阵ASA,获得相应的类别矩阵HSA=W×ASA,最终获得中心像素的最终标签用于构建分类图。输出:分类标签图。

本文在初始字典的选择上做了预处理,故能够有效缩短字典训练的时间而获得较高质量的字典,且本文提出的双重空间约束方法能够有效避免单纯使用超像素分类带来的地物边缘分类准确度低的问题,既降低了超像素分割的要求,又能使细节处理更加精确。本文采用总体分类精度(OA)、平均准确度(AA)和Kappa系数作为客观指标来评估分类结果。OA是正确分类的测试像素的百分比,AA是每个类别中像素分类正确的百分比的均值。Kappa系数用于一致性检验。

4 实验结果与分析

4.1 高光谱数据集说明

Indian Pines数据集是AVIRIS传感器在美国Indiana上空拍摄的高光谱图像,图像空间分辨率为20 m,光谱覆盖范围为0.2~2.4 μm,尺寸为145×145。在实验中,去除了部分水吸收波段后,可用光谱波段减少到200个。此图像包含16个地物参考类别,图8(a)是相应的标准地物分类结果图。Salinas数据集是AVIRIS传感器在1988年拍摄的美国加利福尼亚州的Salinas山谷的高光谱图像,空间分辨率为3.7 m,该图像尺寸大小为512×217,实验时丢弃部分水吸收波段后,有效光谱波段还有204个,此图像包含16个不同的地物类别,相应的标准地物分类结果如图9(a)所示。

4.2 参数设置

本次实验使用的电脑主频为3 GHz,内存为8 GB,处理器为Intel(R)CORE(TM) i5- 8500,电脑的操作系统为Windows 10,使用的仿真平台为Matlab R2016a。本次实验将本文所提算法与基于超像素判别稀疏模型的分类方法(spectral-spatial classification of hyperspectral images with a superpixel-based discriminative sparse model,SBDSM)、基于二级字典的联合稀疏表示分类方法(joint sparse representation of hyperspectral image classification based on secondary dictionary,SD-JSRC)、基于空间预处理联合稀疏表示分类方法(joint sparse representation hyperspectral image classification based on spatial preprocessing,SP-JSRC)、基于字典优化的联合稀疏表示高光谱图像分类方法(joint sparse representation hyperspectral image classification based on dictionary optimization,DO-JSRC)和两种传统的分类方法如K近邻(k-nearest-neighbor,KNN)算法、正交匹配追踪(orthogonal matching pursuit,OMP)算法进行对比。

Indian Pines和Salinas数据集的训练样本和测试样本数量如表1所示。对于Indian Pines数据集,随机选择16类地物中10%的标记样本作为训练样本,剩余90%作为测试样本,对其进行分类实验。对于Salinas数据集,随机选择16类地物中1%的标记样本作为训练样本,其余99%作为测试样本。实验中每个类别的字典个数设置为每个类别训练样本数量的80%,其余相同指标设置为相同值。由于训练样本随机选取,故取10次实验结果的平均值作为实验结果数据。超像素分割获取边缘约束信息时,均取图像的最佳分割效果进行分类实验,Indian Pines数据集和Salinas数据集的伪彩图和超像素分割结果分别如图4和图5所示。对于本文使用的两个数据集,将公式(10)中的稀疏度设置为3。由于初始字典的预处理以及使用分类标记的正交匹配追踪算法,多次迭代所得字典差距较小,故字典训练阶段迭代次数设为3。通过多次实验发现,邻域尺寸设置为5×5时,分类结果最佳。KNN算法中的KKNN值设置为3。由于阈值与训练样本有关,而训练样本随机选取,故在λ为0.6时,经过多次实验取平均值,Indian Pines图像的阈值设为0.8506,Salinas图像的阈值设为0.2142。

图4 Indian pines数据集的高光谱图像

Fig.4 Hyperspectral image of Indian pines dataset

图5 Salinas数据集的高光谱图像

Fig.5 Hyperspectral image of Salinas dataset

4.3 实验结果分析

为了直观地看出本算法中初始字典优化和双重空间约束对分类的影响,表2列出了本文的QSP-JSRC算法与对比算法在字典个数、训练样本数量以及测试样本数量均相同的条件下对两幅高光谱图像进行分类运算的平均运行时间。本文算法的运行时间包括特征提取、超像素图创建、字典学习和分类阶段所耗时间;SBDSM算法的运行时间包括超像素图创建、字典训练和分类阶段的运行时间;SD-JSRC算法的运行时间包括二级字典构建和分类阶段所用时间;SP-JSRC算法运行时间包括空间预处理和分类所用的时间;DO-JSRC算法的运行时间包括波段选择、备选集划分、字典优化和分类所用时间。

表1 数据集的训练样本和测试样本个数

Tab.1 Number of training samples and test samples of data set

类别Indian Pines地物训练测试Salinas地物训练测试1Alfalfa1036Weeds_12019892Corn-no till1431285Weeds_23736893Corn-min83747Fallow2019564Corn24213Fallow plow1413805Grass/Pasture48435Fallow smooth2726516Grass/Tree73657Stubble4039197Grass/Pasture-mowed1018Celery3635438Hay-windrowed48430Grapes113111589Oats1010Soil62614110Soybeans-no till97875Corn33324511Soybeans-min2462209Lettuce 4wk11105712Soybeans-clean59534Lettuce 5wk19190813Wheat21184Lettuce 6wk990714Woods1271138Lettuce 7wk11105915Building-Grass-Trees-Drives39347Vinyard untrained73719516Stones-Steel Towers1083Vinyard trellis181789总数10489201总数54353586

表2 不同算法运行时间(s)

Tab.2 Running time of different algorithms (s)

算法Indian PinesSalinasQSP-JSRC443.01562.95SBDSM978.50111.67SD-JSRC835.79921.43SP-JSRC245.69523.26DO-JSRC1168.073646.11KNN32.7535.57OMP31.1555.58

可以看到,在Indian Pines数据集中,本文提出的QSP-JSRC算法的运行时间优于SBDSM算法,而在Salinas数据集中SBDSM算法的运行时间很短。这是因为在地物分部较为复杂、各类样本数量差距较大的高光谱遥感地图上,本文提出的算法在选择初始字典时做了预处理,大大缩短了字典训练所用时间。但Salinas图像上同质区域较为集中,异质区域之间差异明显,且每类样本数量均较多,故使用基于超像素的联合稀疏表示分类的SBDSM算法用时更少。

图6是两个数据集在不同稀疏水平下的总体精度。对Salinas数据集而言,稀疏度在2到7时,分类精度较稳定,稀疏度进一步从7增加到20时,QSP-JSRC算法的总体分类精度有所下降。在Indian Pines数据集上,稀疏度对精度的影响总体较小。

图7是在邻域选择过程中,平衡空间相似度和光谱相似度的系数λ取不同值时所对应的总体精度示意图,可以看到λ的值从0增加到1时,两个数据集的总体分类精度呈现先上升后下降的趋势,在0.5左右的时候,能够获得较好的分类结果,在λ取0.6时分类精度最好。

图6 不同稀疏水平下的总体精度

Fig.6 Overall accuracy under different sparsity level

图7 不同平衡系数下的总体精度

Fig.7 Overall accuracy under different balance factors

图8是Indian Pines数据集在不同算法上获得的分类图,不同灰度代表不同的地物,同类地物灰度相同,可以看到使用KNN算法和OMP算法得到的分类结果均呈现非常嘈杂的估计,尤其是在类样本数量较少的区域。SD-JSRC算法、DO-JSRC算法的分类效果略好一些,但由于这两种算法的分类效果受字典个数的制约,故而在异质地物距离较近和地物样本本身数量较少的地方分类效果仍不够好。SBDSM算法对超像素进行联合稀疏表示分类能获得较好的分类效果,但超像素的分割时,对不同地物相邻部分分割准确度不高,容易造成超像素边缘区域分类错误。SP-JSRC算法也采用了区域性的分类方法,存在与SBDSM算法相似的问题。相比之下,本文所提算法既能结合超像素分割的优势,尽可能区分不同像素的边缘,又能通过自适应邻域选择的方式兼顾可能已被错分的边缘区域,实现更好的细节处理。

图9是Salinas数据集的分类结果图,直观地展示了分类效果。从图中可见,本文算法的分类结果非常接近标准分类图像,仅有极少部分区域未能正确分类。直接使用KNN算法和OMP算法分类的效果非常差。SBDSM算法由于直接对超像素进行联合稀疏表示分类,故分类结果受超像素的数量和分割效果影响较大,容易产生较大区域的错分。SP-JSRC算法利用聚类思想对空间进行预处理,也易产生区域性分类错误。SD-JSRC算法、DO-JSRC算法分类结果受字典个数影响较大,分类效果不够稳定,当类字典个数较少时,分类效果较差。

图8 Indian Pines数据集的分类结果

Fig.8 Classification results of Indian Pines dataset

图9 Salinas数据集的分类结果

Fig.9 Classification results of Salinas dataset

类字典个数占训练样本比例80%时,在Indian Pines数据集上本文提出的QSP-JSRC算法的总分类精度可达到96.46%,相较于SBDSM、SD-JSRC、SP-JSRC、DO-JSRC、KNN、OMP算法分别高出3.76%、4.75%、4.94%、3.43%、22.14%、22.35%,且不论是总体分类精度还是平均准确度均呈现较好的结果,每类地物的分类准确度也较为平衡,未出现某类地物分类精度非常低的情况,具体参考数据如表3所示。在Salinas数据集上,本文提出的QSP-JSRC的总分类精度可达到98.87%,相较于SBDSM、SD-JSRC、SP-JSRC、DO-JSRC、KNN、OMP算法分别高出2.57%、4.71%、5.82%、4.55%、12.40%、13.02%,具体数据如表4所示。

表3 Indian Pines数据集在不同算法下的分类精度(%)

Tab.3 Classification accuracy of Indian Pines under different algorithms (%)

类别QSP-JSRCSBDSMSD-JSRCSP-JSRCDO-JSRCKNNOMPAlfalfa91.6786.1191.6710010087.5081.52Corn-no till96.2695.3390.8283.1987.3973.2566.56Corn-min92.7777.1172.2984.4793.5764.5567.58Corn89.2092.9678.4087.4499.5352.8745.98Grass/Pasture96.0987.3692.1891.2682.5390.9983.69Grass/Tree97.7296.50 97.1196.3510097.3794.21Grass/Pasture-mowed88.8910088.8992.3188.8992.3176.92Hay-windrowed99.3010099.5310099.0789.0789.77Oats10080.0090.00 10010050.00 80.00 Soybeans-no till92.8085.1481.8393.0398.7474.2872.83Soybeans-min98.7395.4797.6988.9192.2171.3274.15Soybeans-clean94.1991.0188.7685.5891.0129.80 38.15Wheat98.3797.8398.9110010095.6596.52Woods98.9597.9898.8699.9191.3092.0387.32Building-Grass-Trees-Drives93.3789.9187.3210095.1041.9450.54Stones-Steel Towers98.80 98.80 97.5998.4198.8097.6795.35OA96.4692.70 91.7191.5293.0374.3274.11AA95.4491.9790.7493.8094.8875.0475.05Kappa95.9691.6690.5190.3692.0870.7770.52

表4 Salinas数据集在不同算法下的分类精度(%)

Tab.4 Classification accuracy of Salinas under different algorithms (%)

类别QSP-JSRCSBDSMSD-JSRCSP-JSRCDO-JSRCKNNOMPWeeds_110010099.8510010098.2999.15Weeds_299.8410099.2110099.9598.3798.59Fallow97.3510083.7910010087.6394.02Fallow plow99.2710098.7598.5499.8598.7799.57Fallow smooth98.4562.7995.2593.9199.0696.1194.15Stubble99.1110099.0399.8799.8299.5299.64Celery98.8499.9498.3699.6199.6999.1599.21Grapes99.2397.4591.1577.2183.4275.7670.75 Soil99.7210099.5396.1897.7497.6797.09Corn97.3499.8882.5096.6595.1483.0579.72Lettuce 4wk98.4610095.5799.8199.8190.8293.19Lettuce 5wk95.9110096.1797.1710099.6997.38Lettuce 6wk96.2810095.9498.9997.8697.6897.24Lettuce 7wk98.2199.0265.0693.7196.8892.0791.31Vinyard untrained10090.2796.1693.1888.9859.6160.95Vinyard trellis95.3310091.1610099.0487.0997.54OA98.8796.3094.1693.0594.3286.4785.85AA98.3396.8392.9796.5597.3391.3391.84Kappa98.7495.8793.5192.3693.6884.9384.24

图10是Indian Pines数据集和Salinas数据集在不同算法中字典占训练样本不同比例的总体精度。可以看出在两个数据集上,每个算法的分类精度均随着字典原子占训练样本比例的增加而提高,本文算法在字典个数较少时也能获得较好的分类精度,类字典原子所占百分比增加的过程中,各算法的分类精度增幅开始相对较大,而后趋于平缓。本文提出的算法在各个比例下的总体分类精度均优于对比算法。

图10 不同算法中字典占训练样本数量不同比例的总体精度

Fig.10 Overall accuracy of dictionary in different proportions of the number of training sample in different algorithms

为了验证超像素分割以及形态学处理对实验精度的影响,本文针对这两项操作进行了消融实验。在字典数量不变的基础上,只通过光谱特征随机选择初始字典,实验结果如表5所示。在没有超像素边缘约束的情况下,只在5×5邻域内通过权值计算规则进行邻域自适应选择,所得的分类结果如表6所示。从表中可以看到在去掉形态学处理或超像素分割的情况下,所得的分类精度都有一定程度的下降,证明了形态学特征提取能够帮助提取更有效的字典,有利于稀疏表示分类时获得较好的分类精度,超像素分割能够帮助使得邻域自适应选择的像素原子更具有相似性,提升像素的分类正确率。

表5 无形态学处理的消融实验的分类精度(%)

Tab.5 Classification accuracy of ablation experiments without morphological processing (%)

类别Indian Pines类别SalinasAlfalfa92.31Weeds_199.60Corn-no till99.03Weeds_299.76Corn-min74.97Fallow98.52Corn85.02Fallow plow96.96Grass/Pasture87.36Fallow smooth95.78Grass/Tree99.70Stubble98.88Grass/Pasture-mowed76.92Celery97.26Hay-windrowed99.76Grapes92.64Oats80.00Soil99.54Soybeans-no till87.66Corn89.58Soybeans-min94.11Lettuce 4wk92.53Soybeans-clean81.87Lettuce 5wk95.49Wheat98.18Lettuce 6wk92.28Woods98.86Lettuce 7wk90.46Building-Grass-Trees-Drives75.60Vinyard untrained86.55Stones-Steel Towers98.41Vinyard trellis88.60OA91.72OA94.34AA89.36AA94.65Kappa90.58Kappa93.71

表6 无超像素分割的消融实验的分类精度(%)

Tab.6 Classification accuracy of ablation experiments without superpixel segmentation (%)

类别Indian Pines类别SalinasAlfalfa96.15Weeds_199.75Corn-no till99.03Weeds_299.70Corn-min74.83Fallow95.45Corn81.16Fallow plow97.32Grass/Pasture85.98Fallow smooth97.21Grass/Tree98.78Stubble98.80Grass/Pasture-mowed69.23Celery97.54Hay-windrowed99.76Grapes94.73Oats90.00Soil99.46Soybeans-no till76.23Corn85.50Soybeans-min93.50Lettuce 4wk92.24Soybeans-clean86.94Lettuce 5wk94.92Wheat98.79Lettuce 6wk95.45Woods98.59Lettuce 7wk77.05Building-Grass-Trees-Drives75.60Vinyard untrained84.01Stones-Steel Towers100Vinyard trellis82.28OA90.48OA93.71AA89.04AA93.21Kappa89.71Kappa93.01

5 结论

本文提出了基于二次空间处理的联合稀疏表示高光谱图像分类算法。一方面,为了获得较好的字典,在进行字典和分类器训练之前,通过形态学特征提取,结合光谱信息对初始字典进行预选取,减少字典优化时间;另一方面,为了充分利用空间信息,本文采取一种二次利用空间信息的方法,在超像素边缘和固定邻域双重约束下通过权重计算自适应选择邻域原子,减少直接对超像素分类造成的边缘像素错分的频率。在Indian Pines数据集和Salinas数据集上进行仿真实验,验证本文提出的算法和几个对比算法的分类效果。实验表明本文所提算法能够有效提高分类精度,且在字典原子较少的情况下也能获得较好的分类效果,稳定性较好。本文还有许多值得进一步研究的地方,例如,获取更多特征信息以进一步优化初始字典或如何设定权值能进一步提升自适应邻域选择的准确度等。

[1] FANG Leyuan, LI Shutao, KANG Xudong, et al. Spectral-spatial classification of hyperspectral images with a superpixel-based discriminative sparse model[J]. IEEE Transactions on Geoscience and Remote Sensing, 2015, 53(8): 4186- 4201.

[2] PAL M, FOODY G M. Feature selection for classification of hyperspectral data by SVM[J]. IEEE Transactions on Geoscience and Remote Sensing, 2010, 48(5): 2297-2307.

[3] DEMIR B, ERTÜRK S. Improving SVM classification accuracy using a hierarchical approach for hyperspectral images[C]∥2009 16th IEEE International Conference on Image Processing (ICIP). Cairo, Egypt, New York: IEEE, 2009: 2849-2852.

[4] BOHNING D. Multinomial logistic regression algorithm[J]. Annals of the Institute of Statistical Mathematics, 1992, 44(1): 197-200.

[5] LI Jun, BIOUCAS-DIAS J M, PLAZA A. Spectral-spatial hyperspectral image segmentation using subspace multinomial logistic regression and markov random fields[J]. IEEE Transactions on Geoscience and Remote Sensing, 2012, 50(3): 809- 823.

[6] LI Jun, BIOUCAS-DIAS J M, PLAZA A. Semisupervised hyperspectral image segmentation using multinomial logistic regression with active learning[J]. IEEE Transactions on Geoscience and Remote Sensing, 2010, 48(11): 4085- 4098.

[7] JIAO Hongzan, ZHONG Yanfei, ZHANG Liangpei. Artificial DNA computing-based spectral encoding and matching algorithm for hyperspectral remote sensing data[J]. IEEE Transactions on Geoscience and Remote Sensing, 2012, 50(10): 4085- 4104.

[8] ZHONG Yanfei, ZHANG Liangpei. An adaptive artificial immune network for supervised classification of multi-/hyperspectral remote sensing imagery[J]. IEEE Transactions on Geoscience and Remote Sensing, 2012, 50(3): 894-909.

[9] ERGUL U, BILGIN G. Classification of hyperspectral images with multiple kernel extreme learning machine[C]∥2018 26th Signal Processing and Communications Applications Conference (SIU). Izmir, Turkey. IEEE, 2018: 1- 4.

[10] TARABALKA Y, BENEDIKTSSON J A, CHANUSSOT J. Spectral-spatial classification of hyperspectral imagery based on partitional clustering techniques[J]. IEEE Transactions on Geoscience and Remote Sensing, 2009, 47(8): 2973-2987.

[11] PRASAD S, CUI Minshan, LI Wei, et al. Segmented mixture-of-Gaussian classification for hyperspectral image analysis[J]. IEEE Geoscience and Remote Sensing Letters, 2014, 11(1): 138-142.

[12] 郭文慧,曹飞龙.基于3D多尺度特征融合残差网络的高光谱图像分类[J]. 模式识别与人工智能, 2019, 32(10): 882- 891.

GUO Wenhui, CAO Feilong. Hyperspectral image classification based on 3D multi-scale feature fusion residual network[J]. Pattern Recognition and Artificial Intelligence, 2019, 32(10): 882- 891.(in Chinese)

[13] BENEDIKTSSON J A, PALMASON J A, SVEINSSON J R. Classification of hyperspectral data from urban areas based on extended morphological profiles[J]. IEEE Transactions on Geoscience and Remote Sensing, 2005, 43(3): 480- 491.

[14] 高巍,彭宇.基于马氏距离多核学习的高光谱图像分类[J]. 仪器仪表学报, 2018, 39(3): 250-257.

GAO Wei, PENG Yu. Hyperspectral image classification based on Mahalanobis distance multiple kernel learning with Mahalanobis distance[J]. Chinese Journal of Scientific Instrument, 2018, 39(3): 250-257.(in Chinese)

[15] BRUKSTEIN A M, DONOHO D L, ELAD M. From sparse solutions of systems of equations to sparse modeling of signals and images[J]. SIAM Review, 2009, 51(1): 34- 81.

[16] QIAN Yuntao, YE Minchao. Hyperspectral imagery restoration using nonlocal spectral-spatial structured sparse representation with noise estimation[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2013, 6(2): 499-515.

[17] FANG Leyuan, LI Shutao, NIE Qing, et al. Sparsity based denoising of spectral domain optical coherence tomography images[J]. Biomedical Optics Express, 2012, 3(5): 927-942.

[18] FANG Leyuan, LI Shutao, MCNABB R P, et al. Fast acquisition and reconstruction of optical coherence tomography images via sparse representation[J]. IEEE Transactions on Medical Imaging, 2013, 32(11): 2034-2049.

[19] ZHANG Yiming, DU Bo, ZHANG Yuxiang, et al. Spatially adaptive sparse representation for target detection in hyperspectral images[J]. IEEE Geoscience and Remote Sensing Letters, 2017, 14(11): 1923-1927.

[20] 陈善学,王欣欣.基于字典优化的联合稀疏表示高光谱图像分类[J]. 信号处理, 2021, 37(4): 545-555.

CHEN Shanxue, Wang Xinxin. Joint sparse representation of hyperspectral image classification based on dictionary optimization[J]. Journal of Signal Processing, 2021, 37(4): 545-555.(in Chinese)

[21] 陈善学,陈雯雯.基于二级字典的联合稀疏表示高光谱图像分类[J]. 系统工程与电子技术, 2020, 42(3):550-556.

CHEN Shanxue, CHEN Wenwen. Joint sparse representation hyperspectral image classification based on secondary dictionary[J]. System Engineering and Electronics, 2020, 42(3): 550-556.(in Chinese)

[22] HSU P H, CHENG Yingying. Hyperspectral Image Classification via Joint Sparse Representation[C]∥IGARSS 2019-2019 IEEE International Geoscience and Remote Sensing Symposium. Yokohama, Japan. IEEE, 2019: 2997-3000.

[23] TU Bing, HUANG Siyuan, FANG Leyuan, et al. Hyperspectral image classification via weighted joint nearest Neighbor and sparse representation[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2018, 11(11): 4063- 4075.

[24] GAN Le, XIA Junshi, DU Peijun, et al. Class-oriented weighted kernel sparse representation with region-level kernel for hyperspectral imagery classification[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2018, 11(4): 1118-1130.

[25] 陈善学,王欣欣.基于空间预处理联合稀疏表示高光谱图像分类[J]. 系统工程与电子技术, 2021,43(9):2422-2429.

CHEN Shanxue, Wang Xinxin. Joint sparse representation of hyperspectral image classification based on spatial preprocessing [J].System Engineering and Electronics, 2021,43(9):2422-2429.(in Chinese)

[26] 王佳宁.基于联合稀疏表示与形态特征提取的高光谱图像分类[J]. 激光与光电子学进展, 2016, 53(8): 265-272.

WANG Jianing. Hyperspectral image classification based on joint sparse representation and morphological feature extraction[J]. Laser & Optoelectronics Progress, 2016, 53(8): 265-272.(in Chinese)

[27] CHEN Yi, NASRABADI N M, TRAN T D. Hyperspectral image classification via kernel sparse representation[J]. IEEE Transactions on Geoscience and Remote Sensing, 2013, 51(1): 217-231.

[28] ZHANG Qiang, LI Baoxin. Discriminative K-SVD for dictionary learning in face recognition[C]∥2010 IEEE Computer Society Conference on Computer Vision and Pattern Recognition. CA, USA. IEEE, 2010: 2691-2698.