1 引言

随着航空航天事业的不断发展,遥感图像越来越广泛地应用在军事、探测、环境监测等诸多领域,特别是随着光学传感器的进步,光学遥感图像的分辨率越来越高,给光学遥感图像的地物分类带来了机遇和挑战。遥感图像的地物分类,即对遥感图像中的目标及背景进行标注分类,最后得到逐像素标注类别的分割图像。

近年来,随着深度学习技术的快速发展,基于卷积神经网络的语义分割算法取得了显著的成就,2015年,Long等人[1]提出了全卷积网络(Fully Convolution Network,FCN),其将CNN网络中的全连接层用卷积层进行替换,由于不含全连接层,所以网络可以接收任意尺寸的输入图片,再利用反卷积层扩大特征图,得到精细的分割图。同时采用了跳跃结构以增强网络的稳定性。但FCN存在着分割细节较差、空间上下文信息利用不足的问题。2015年,Ronneberger 等人提出了U-Net[2]网络,该网络模型由编码器和解码器两部分组成,分别用来提取特征上下文信息和精确定位边界。为了获得更加丰富的上下文信息,Chen等人提出了deeplabv2[3]分割网络,首次提出了空洞空间金字塔池化模块[4](ASPP, atrous spatial pyramid pooling)。该模块利用不同膨胀率的空洞卷积对各个像素周围的空间信息进行处理,以提取多尺度的特征,然后再对其进行融合。而在PSPnet[5]中,金字塔池化将特征图以不同的尺寸的池化率进行池化,得到不同层次的采样,再把采样的特征进行拼接。事实上,使用空洞卷积的ASPP,能够获得更加广泛的感受野,对于上下文信息也有更好的结合。之后Chen等人对deeplabv2进一步改进,提出了deeplabv3[4]分割网络。相比于deeplabv2,deeplabv3在ASPP结构之中引入了全局平均池化[6](GAP, global average pooling),以更好地利用全局信息。2018年,Chen等人对deeplab系列进一步改进,提出了deeplabv3+[7]模型。该模型使用了编码-解码结构,以结合不同层次的信息,改善边界处的分割精度,并加入了ASPP,以获得多尺度的特征信息,提高分割的整体效果。同时主干网络使用了Xception[8]网络,提高了运算速度。2018年,Zhao等人用PSPnet结合Resnet的方法提出了Icnet[9]网络,对输入进行下采样后得到三种分辨率的图片,使用三个分支网络处理,在有效利用不同分辨率的信息的同时,也提升了计算效率。除了上述方法,还有很多从空间角度出发,探索更丰富有效的上下文信息的方法[10]。

上述方法通过编码不同尺度的空间上下文信息来改善目标的分割效果,但连续的卷积池化操作造成的空间细节信息损失对于图像的准确分割产生的不利影响,难以利用深层特征图的空间上下文信息来消除,为此本文提出了一种基于类别注意力机制[11]的多尺度特征融合方法来进一步改善分割效果。为此,本文引入了类别中心(CCB, class center)[11]的概念,类别中心代表了特征图不同特征通道与不同目标类别间相关性的大小。首先利用深层特征图生成粗略的分割结果,并对深层特征图与粗略分割结果做矩阵乘法生成CCB。之后在CCB的基础上引入注意力机制,生成基于类别信息的特征重加权向量,并利用该加权向量对深层特征图进行重加权,通过这种方式来缩小不同尺度特征间的语义差异,实现不同尺度特征的有效融合。相比之前的方法,本方法关注像素的类别特征信息,提出了一种基于类别注意力的特征融合方法,其分割有更好的类内聚合性,关注易错误标注的类别,有效提升了分割性能,得到更精细、准确的分割结果。对于具有目标小而多、目标类内差异大、类间差异小以及目标分布随机性强等特点的遥感图像,具有更好的性能表现。

2 基于类别注意力卷积网络的地物分类方法

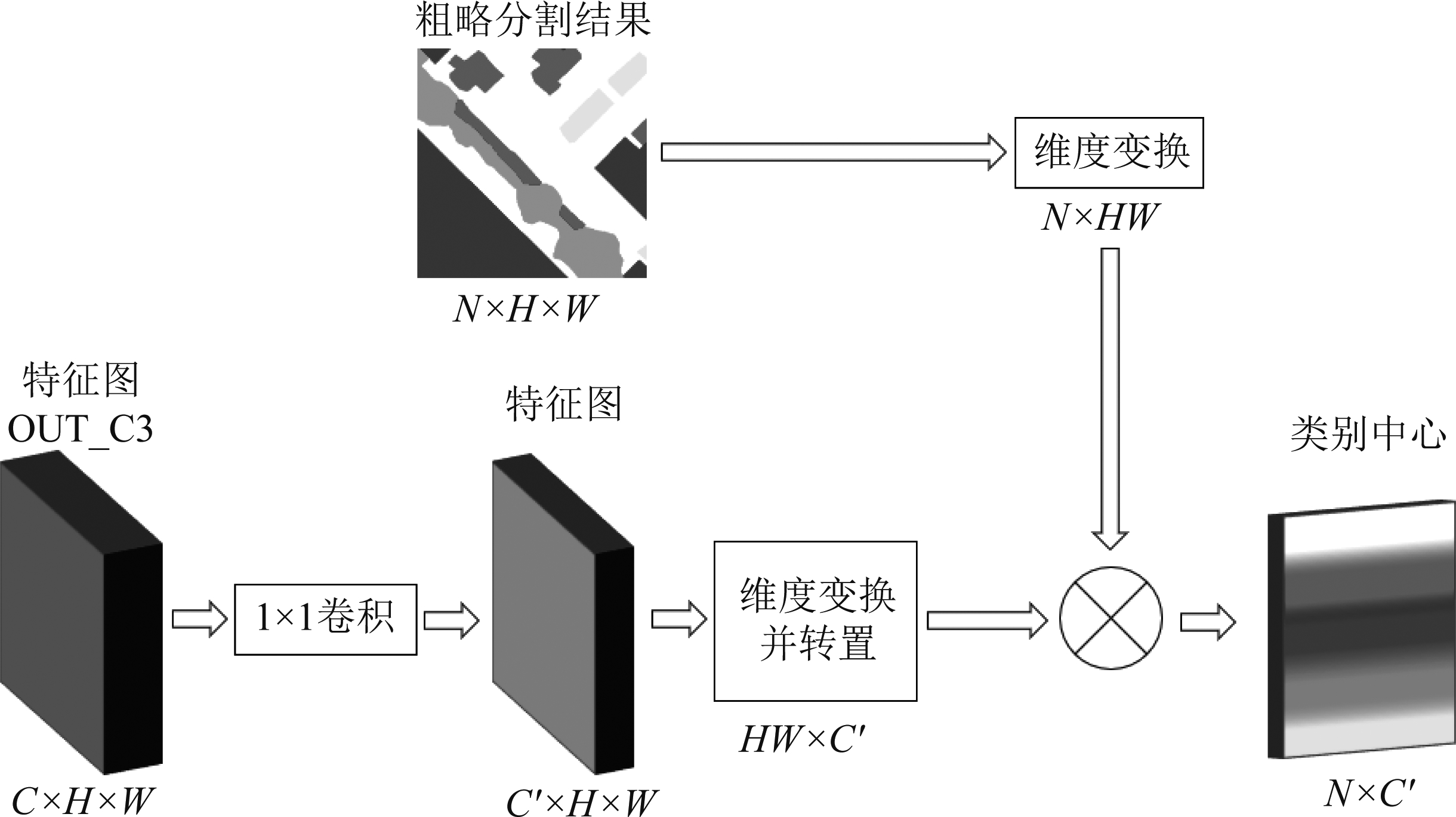

2.1 类别中心模块(CCB)

类别中心模块旨在从类别角度获取更丰富的上下文信息。将类别i的类别中心定义为所有属于类别i的像素点的平均特征。在理想情况下,给定特征图F∈![]() C×H×W,其中,C,H,W分别为特征图的通道数、高和宽。类别中心可由公式(1)定义,

C×H×W,其中,C,H,W分别为特征图的通道数、高和宽。类别中心可由公式(1)定义,

(1)

其中,xj为像素j的标签,δ(xj=i)在j的标签和类别i相等时为1,否则为0。

由于在实际中真实标注图是未知的,所以使用粗略分割结果来确定像素点属于哪一类。因为在粗略分割结果中,像素属于某一类,往往有很大可能性就是某一类,所以用来计算类别中心是具有代表性和一定的鲁棒性的。

给定粗略分割结果Pcoarse∈![]() N×H×W以及特征图F∈

N×H×W以及特征图F∈![]() C×H×W,其中N是类别数,类别中心可由如下公式(2)计算,

C×H×W,其中N是类别数,类别中心可由如下公式(2)计算,

(2)

其中,F′j∈![]() HW×C′由特征图F∈

HW×C′由特征图F∈![]() C×H×W经过1×1卷积将通道数由C减少到C′,再进行维度变换及转置得到。

C×H×W经过1×1卷积将通道数由C减少到C′,再进行维度变换及转置得到。![]()

![]() N×HW由粗略分割结果Pcoarse∈

N×HW由粗略分割结果Pcoarse∈![]() N×H×W进行维度变换得到。两者进行矩阵乘积再归一化后得到类别中心

N×H×W进行维度变换得到。两者进行矩阵乘积再归一化后得到类别中心![]()

![]() N×C′。当

N×C′。当![]() 表示像素点j为某一类的概率时,

表示像素点j为某一类的概率时,![]()

![]() 1×C′。将公式(2)与公式(1)进行对比,可发现使用粗略分割结果

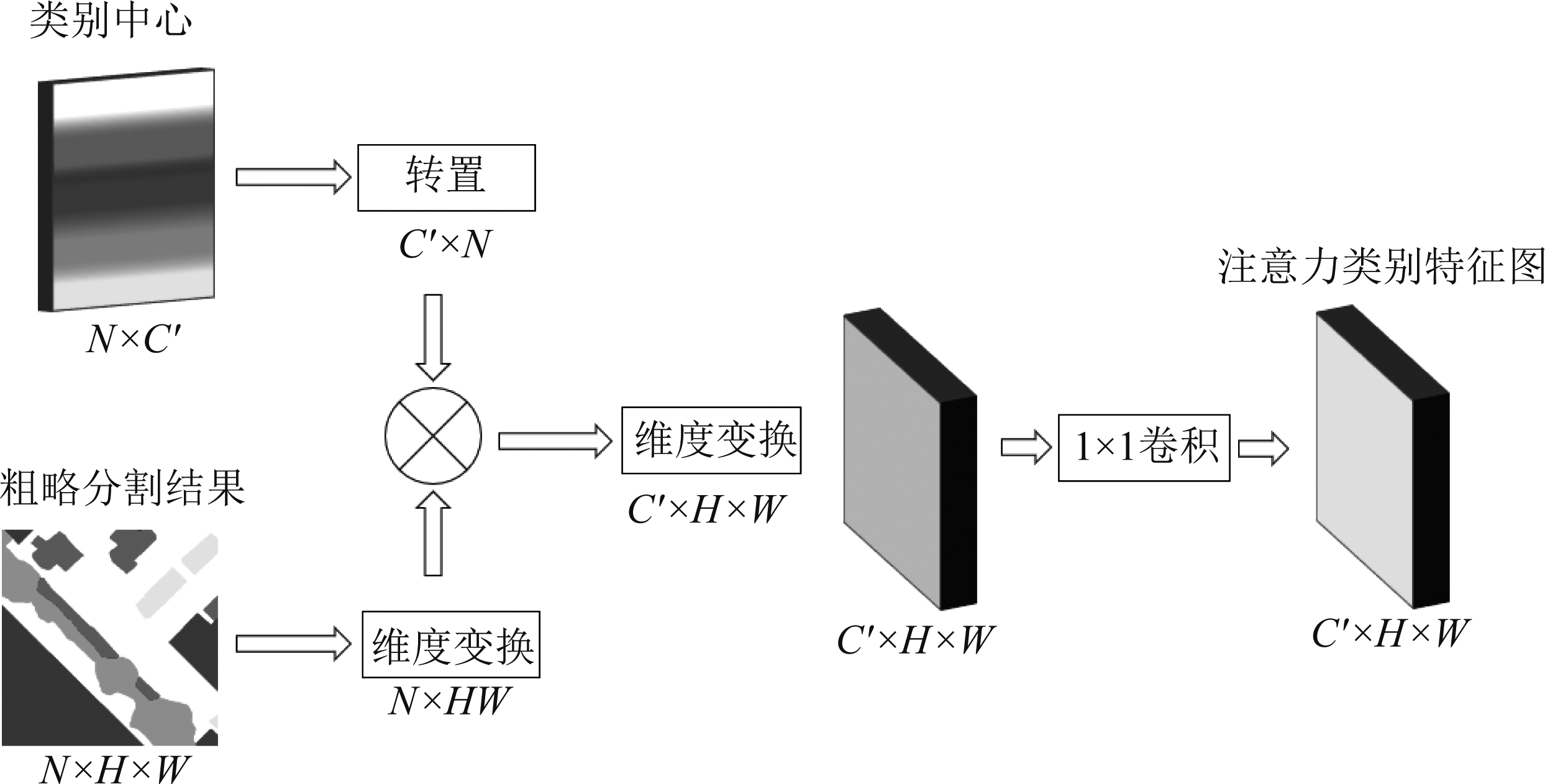

1×C′。将公式(2)与公式(1)进行对比,可发现使用粗略分割结果![]() 代替δ(xj=i)对像素点的类别进行判决。具体流程如图1所示。

代替δ(xj=i)对像素点的类别进行判决。具体流程如图1所示。

由于类别中心是类别像素点的组合,所以在训练中具有较强的信息监督能力,能够帮助模型学习不同类别之间的差异,减少相似类别之间的错误标注。此外,类别中心能帮助提升分割的类内聚合性,纠正类间的错误标注,例如:有A和B两类,边界上的A类像素点x被错误标注为B类,由类别中心的类内聚合性纠正,像素点x应属于A类,从而提高分割表现。

2.2 注意力类别特征(ACF)

本文关注类别特征信息对分割带来的影响,使用粗略分割图作为注意力图来计算类别的注意力类别特征。当粗略分割图中错误标注了某个像素点时,模型需要投入更多的注意力在这个错误标注的类别上,并且学习和检查类别的特征一致性。

基于类别中心![]() 和粗略分割结果

和粗略分割结果![]() 利用公式(3)可计算得到像素点j的注意力类别特征

利用公式(3)可计算得到像素点j的注意力类别特征![]() 如下,

如下,

(3)

即![]()

![]() N×C′先转置为

N×C′先转置为![]()

![]() N×H×W维度变换为

N×H×W维度变换为![]()

![]() N×HW,然后进行矩阵乘积并进行维度变换得到

N×HW,然后进行矩阵乘积并进行维度变换得到![]()

![]() C′×H×W,最后使用1×1卷积来优化得到的结果。

C′×H×W,最后使用1×1卷积来优化得到的结果。

注意力类别特征能够通过学习类别特征一致性,关注易错误标注的类别来提高分割性能,但是其计算依靠粗略分割结果和主干网络特征图,所以粗略分割结果和主干网络特征图的质量需要保证。

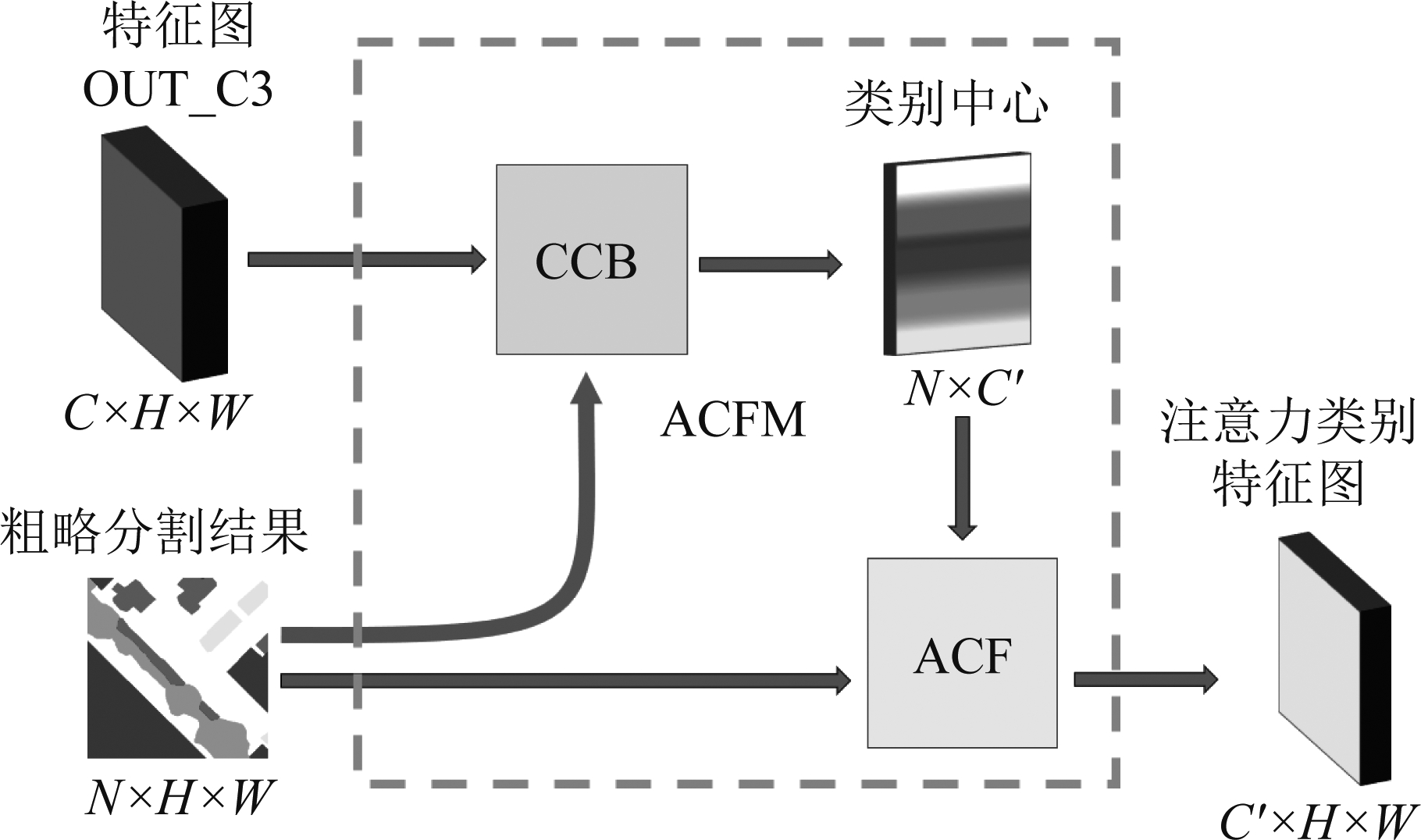

2.3 注意力类别特征模型(ACFM)

基于CCB和ACF的组合,可以得到注意力类别特征模型(ACFM)。在获取到粗略分割结果和主干网络浅层特征图后,先使用CCB计算类别中心,基于类别中心和粗略分割结果,通过ACF计算得到注意力类别特征图。具体如图3所示。

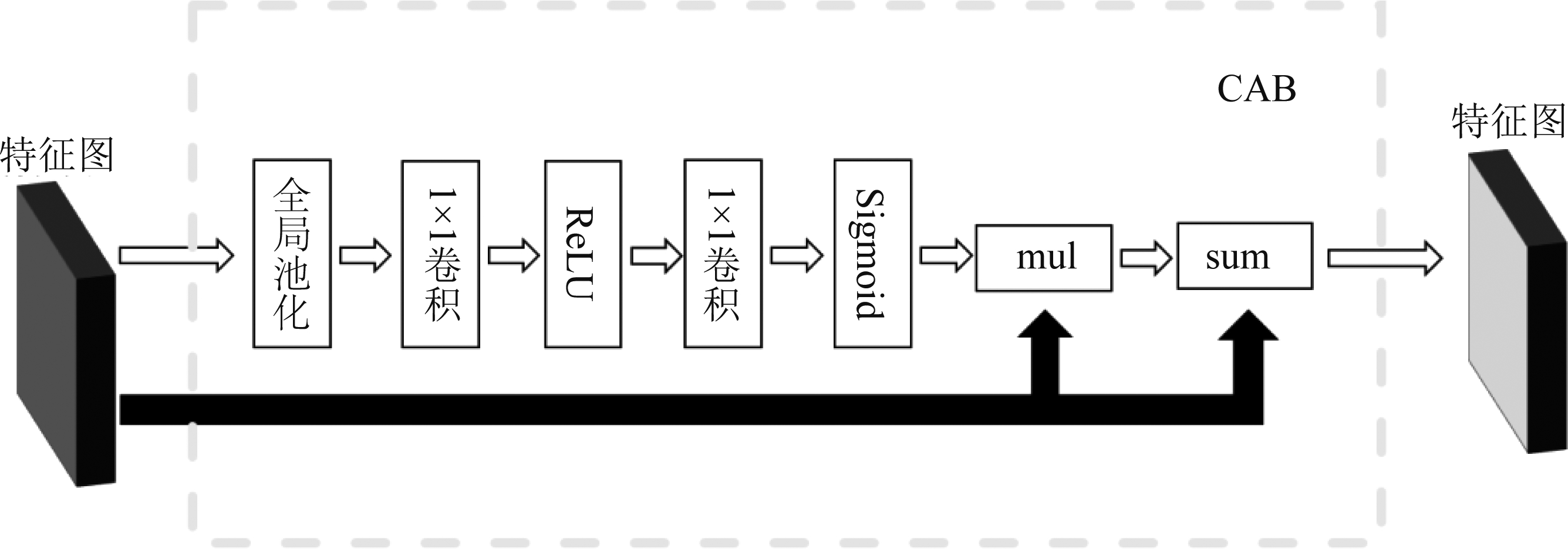

2.4 通道注意力模块(CAB)

为了增强特征图的特征一致性,本文使用通道注意力模块(Channel Attention Block, CAB),其具体实现如图4所示。首先对输入的特征图进行全局池化,在经过卷积层得到通道特征信息,即通道特征向量,然后用特征图与通道特征向量进行乘运算,再与乘积进行和运算,以实现注意力机制,得到增强的特征图。

图1 类别中心模块图

Fig.1 CCB:class center block

图2 注意力类别特征模块图

Fig.2 ACF:attentional class feature block

图3 注意力类别特征模型

Fig.3 ACFM:attentional class feature model

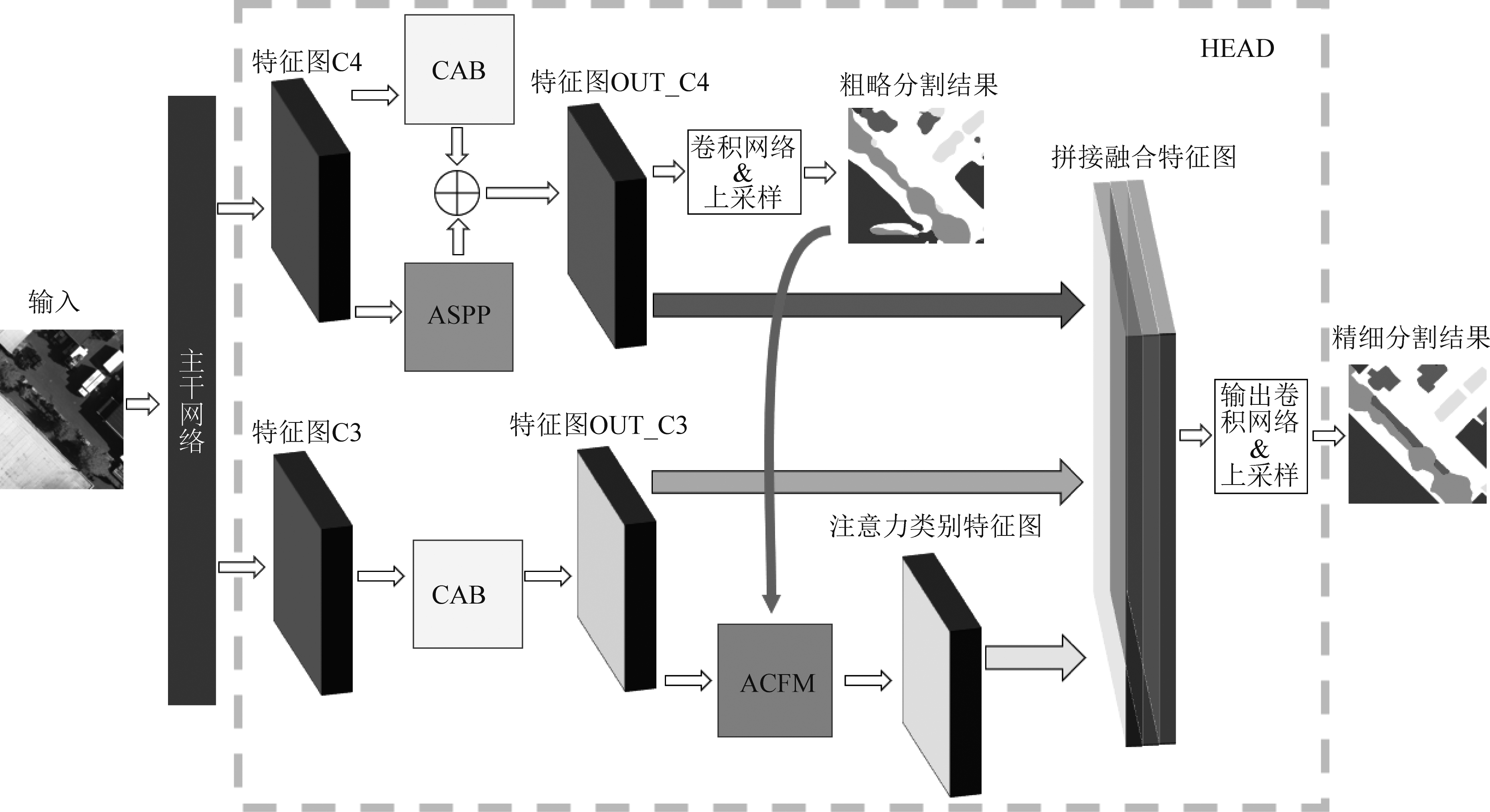

2.5 网络整体结构及特征融合

输入图片经过主干网络Resnet101[12]处理后,可以得到四个不同层次的特征图,依次从浅层到深层为C1,C2,C3,C4。如前所述,要得到良好的分割效果,需要提高粗略分割结果和特征图的质量。故在主干网络输出的深层特征图C4后引入ASPP模块增强空间特征信息获取,以及CAB(通道注意力机制)模块进行特征增强,并对两者进行特征融合,得到增强的深层特征图OUT_C4,再通过卷积层得到更高质量的粗略分割图,从而进一步提高注意力类别特征图的质量。得到粗略分割图后,使用主干网络输出的浅层特征图C3,并加入CAB模块对C3进行特征增强。使用增强的浅层特征图和改善质量的粗略分割图,通过ACFM模块得到注意力类别特征图。

为了获取更加丰富的特征信息,本文提出了一种多层次、多角度的特征融合方法。将增强的深层特征图OUT_C4、增强的浅层特征图OUT_C3以及注意力类别特征图OUT_ACF进行特征融合,使融合之后的特征图即含有深层和浅层的特征信息,又具有基于注意力类别机制的类别特征信息,进而提高分割效果。最后使用输出卷积层处理融合的特征图,得到精细的特征图,并通过双线性插值恢复。网络整体结构如图5所示。

图4 通道注意力模块

Fig.4 CAB:channel attentional block

此外,在使用损失函数时,本文对输出的粗略分割图和精细分割图设置一定的权重,以更好地优化分割结果,损失函数loss的表达式如公式(4)所示。

loss=λa*lossa+λc*lossc

(4)

其中,lossa和lossc分别为精细分割图和粗略分割图的损失函数,λa和λc为权重。

网络整体结构可分为两部分,主干网络部分和HEAD模块,主干网络输出的特征图由HEAD模块处理,进行不同深层特征和浅层特征,空间特征和类别注意力特征的融合,实现了特征信息的多角度丰富以及分割结果的从粗略到精细,提高了分割效果。

3 实验结果及分析

为了验证本文的地物分类方法,使用ISPRS遥感图像的Vaihingen数据集[13]以及高分2号卫星的AIR_SEG_GF2数据集为实验数据。ISPRS数据集包含6类地物目标:impervious surface、clutter/background、tree、building、car、low vegetation。其中训练数据集为11tiles,验证数据集为5tiles,测试数据集为17tiles。AIR_SEG_GF2数据集来自于高分二号卫星光学数据,分辨率优于1 m,包含9类地物目标:道路、建筑物、灌木&树木、草坪、土地、水体、交通工具、不透水地面、其他。实验数据的图片分辨率为512×512,其中400张为训练数据集、100张为测试数据集。实验平台参数为:OS: Ubuntu 18.04.5 LTS bionic x86_64;CPU: Intel Xeon Gold 5218 (64) 2.301GHz,Memory: 192064MiB;GPU: TITAN RTX,Memory: 24220MiB。实验环境:Python 3.7.7,torch版本为1.6.0,cuda 版本为10.1。

实验的性能指标主要观察mIOU和各类别IOU,以及可视化结果。性能指标的定义如公式(5)所示:

(5)

其中TP: 表示正确分类的目标像素的数量。FP:表示被分类为目标的非目标像素的数量。FN:表示分类为非目标的目标像素的数量。IoU度量了模型对某一类别预测结果和真实值的交集与并集的比值,mIOU基于类进行计算,将每一类的IOU计算之后累加,再进行平均,得到基于全局的评价。

实验中设置epoch数为300,学习率为0.005,batch size为4,crop_size为480,采用预训练的Resnet101作为主干网络。

3.1 消融实验

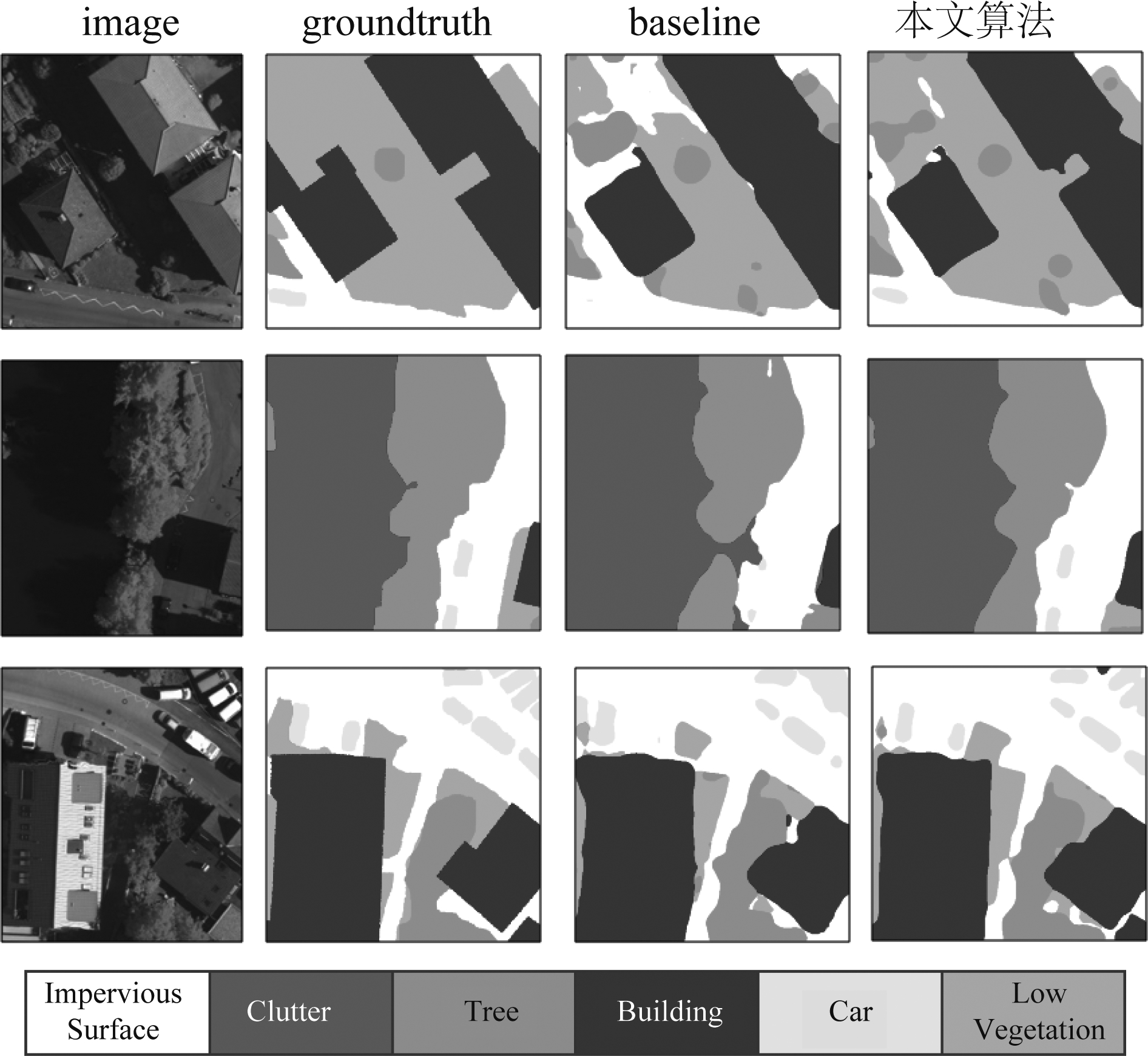

为验证本文算法对性能的提升,设置了消融实验。将特征融合中的ACFM模块移除,直接对图5中的特征图OUT_C3和特征图OUT_C4进行融合。消融实验得到的性能指标结果如表1所示,消融实验可视化结果对比如图6所示。

图5 整体网络模型

Fig.5 Overall network model

表1 消融实验的IOU(%)

Tab.1 IOU (%) of ablation study

算法Impervious surfaceClutterTreeBuildingCarLow vegetationmIOUBaseline76.2036.5273.9181.7343.7362.2862.39本文算法80.5746.0776.4886.5965.0765.5770.06

图6 消融实验可视化结果

Fig.6 Ablation experiment result visualization

实验结果表明,引入ACFM模块之后的特征融合算法表现出明显的性能提升。通过图6中的可视化结果,可以看到加入ACFM的特征融合算法对于目标分割有更准确、更精细的结果。

3.2 实验性能指标结果

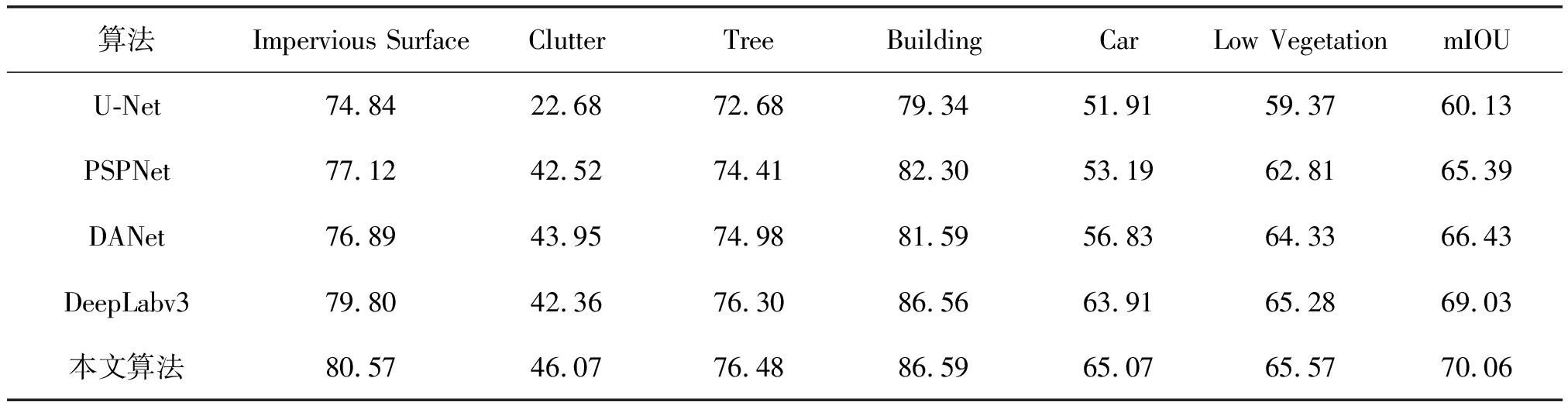

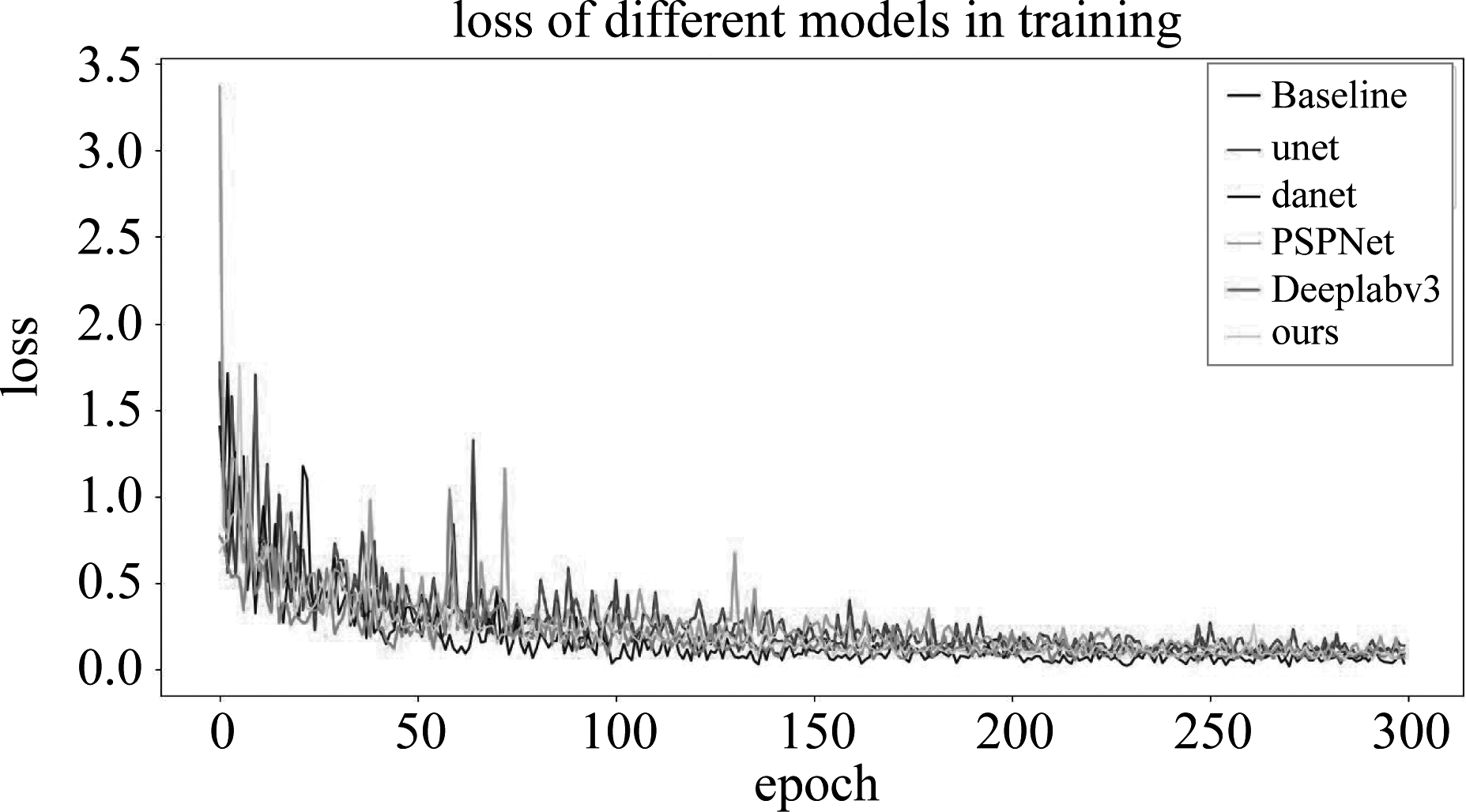

实验中将本文算法与U-Net、PSPNet、DANet以及DeepLabv3进行对比,在ISPRS数据集上得到如表2所示的性能指标结果。训练中的各个模型的损失曲线如图7所示。

实验得到的算法性能指标结果表明,本文算法分割的mIOU较对比算法更高,对于地物分类表现出了更好的性能。本文算法与已发表的算法FRF-Net[13]相比,mIOU从66.71%提升到了70.06%,提升了3.35%;与已发表算法CBGF-net[14]相比,mIOU从68.88%提升到了70.06%,提升了1.18%。

观察对比表2中各个类别的IOU在不同算法中的结果,可以发现,相比其他算法,本文算法在“car”一类目标的IOU提升明显。由于车辆在遥感图像中具有小、分布随机性强、易密集分布等特点,在进行地物分类时,容易造成类内混淆标注。引入类别注意力的特征融合能有效提高类内聚合性,对易混淆标注投入更多的注意力,提高地物分类性能。

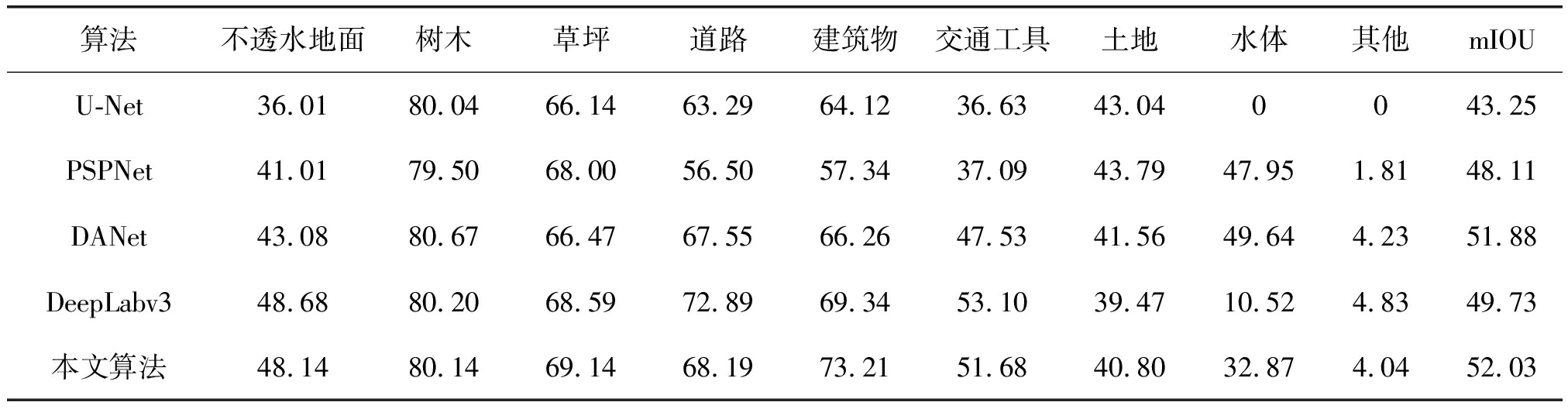

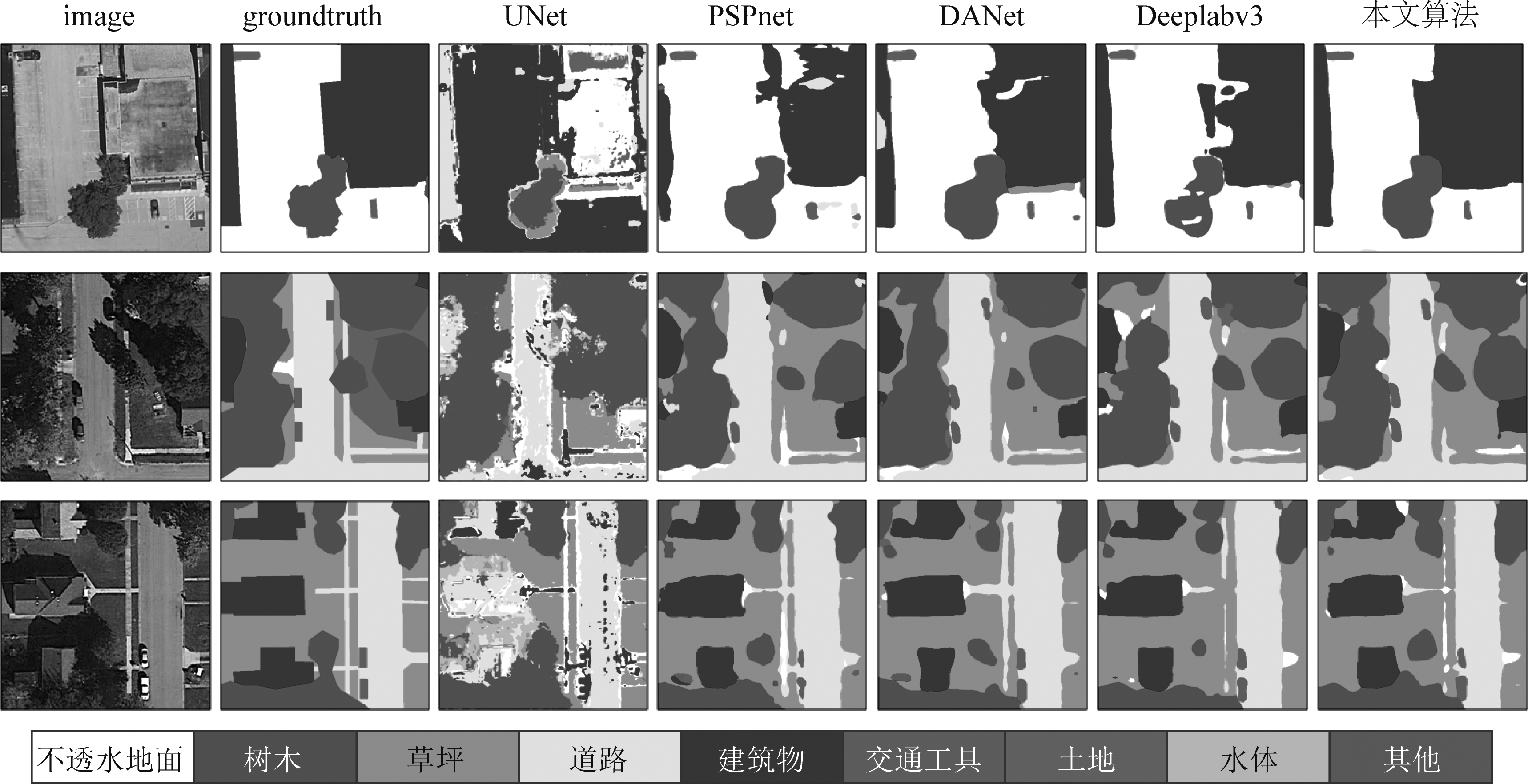

此外,本文还使用了更具挑战性的AIR_SEG_GF2数据集进行实验,得到了如表3所示的结果。实验结果表明,本文算法与其他对比算法相比有更好的性能表现。

表2 算法性能指标结果(%)(ISPRS)

Tab.2 Method performance metrics (%) (ISPRS)

算法Impervious SurfaceClutterTreeBuildingCarLow VegetationmIOUU-Net74.8422.6872.6879.3451.9159.3760.13PSPNet77.1242.5274.4182.3053.1962.8165.39DANet76.8943.9574.9881.5956.8364.3366.43DeepLabv379.8042.3676.3086.5663.9165.2869.03本文算法80.5746.0776.4886.5965.0765.5770.06

表3 算法性能指标结果 (%) (AIR_SEG_GF2)

Tab.3 Method performance metrics (%) (AIR_SEG_GF2)

算法不透水地面树木草坪道路建筑物交通工具土地水体其他mIOUU-Net36.0180.0466.1463.2964.1236.6343.040043.25PSPNet41.0179.5068.0056.5057.3437.0943.7947.951.8148.11DANet43.0880.6766.4767.5566.2647.5341.5649.644.2351.88DeepLabv348.6880.2068.5972.8969.3453.1039.4710.524.8349.73本文算法48.1480.1469.1468.1973.2151.6840.8032.874.0452.03

图7 各模型损失曲线(ISPRS)

Fig.7 Loss of models (ISPRS)

3.3 可视化结果

通过可视化结果的对比,可以进一步看出本文算法具有更好的地物分类表现。ISPRS数据集的可视化结果如图8所示。观察图8第一组图像的地物分类结果,相比于其他算法对于蓝色(建筑)目标的分割结果,比如:PSPNet出现了将同一类中的同一目标分割为同一类中的两个目标的情况,本文算法通过引入类别注意力机制的融合特征,有效保障了建筑分割的类别完整性,且有更好的分割精度,与真实标注图最为接近。进一步观察第三组图像中黄色(车辆)目标的分割结果,在其他算法中,特别是U-Net、PSPNet和DANet中,都出现了分割结果中类内目标相互“粘连”的情况,而本文算法有效改善了这种情况。

同样也对AIR_SEG_GF2数据集的结果进行了可视化展示,如图9所示。通过可视化结果的对比表明,本文算法有更好的地物分类表现。

图8 可视化结果(ISPRS)

Fig.8 Result visualization (ISPRS)

图9 可视化结果(AIR_SEG_GF2)

Fig.9 Result visualization (AIR_SEG_GF2)

4 结论

本文提出了一种基于类别注意力卷积网络的地物分类方法。该方法基于类别注意力机制,提出了一种有效的特征融合方法。通过类别注意力机制,能有效提取类别特征信息,实现了模型训练中的注意力优化、提高了关注易错类别并纠正错误标注的能力;并通过与不同层次的、类别与空间特征的多角度的特征图进行特征融合,得到了信息更为丰富且有效的特征图,进而提高了地物分类的表现。同时,在模型中引入了通道注意力机制以及ASPP,并对二者进行特征融合,有效提高了粗略分割图的质量,从而提升类别注意力特征图的质量,进一步提高类别注意力卷积网络的性能。最后通过对比实验验证了本文算法的有效性和优越性。

[1] LONG J, SHELHAMER E, DARRELL T. Fully convolutional networks for semantic segmentation[C]∥2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Boston, MA, USA. 2015: 3431-3440.

[2] RONNEBERGER O, FISCHER P, BROX T. U-net: Convolutional networks for biomedical image segmentation[C]∥Medical Image Computing and Computer-Assisted Intervention. MICCAI 2015, 2015: 234-241.

[3] CHEN L C, PAPANDREOU G, KOKKINOS I, et al. DeepLab: semantic image segmentation with deep convolutional nets, atrous convolution, and fully connected CRFs[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 40(4): 834- 848.

[4] CHEN L C, PAPANDREOU G, SCHROFF F, et al. Rethinking atrous convolution for semantic image segmentation[J]. arXiv preprint arXiv:1706.05587, 2017.

[5] ZHAO Hengshuang, SHI Jianping, QI Xiaojuan, et al. Pyramid scene parsing network[C]∥2017 IEEE Confer-ence on Computer Vision and Pattern Recognition (CVPR). Honolulu, HI, USA. 2017: 6230- 6239.

[6] LIN Min, CHEN Qiang, YAN Shuicheng. Network in network. arXiv preprint arXiv:1312.4400, 2013.

[7] CHEN L C, ZHU Yukun, PAPANDREOU G, et al. Encoder-decoder with atrous separable convolution for semantic image segmentation[C]∥Proceedings of the European Conference on Computer Vision (ECCV). 2018: 801- 818.

[8] CHOLLET F. Xception: deep learning with depthwise separable convolutions[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Honolulu, HI, USA. IEEE, 2017: 1800-1807.

[9] ZHAO Hengshuang, QI Xiaojuan, SHEN Xiaoyong, et al. ICNet for real-time semantic segmentation on high-resolution images[C]∥Proceedings of the European Conference on Computer Vision (ECCV). 2018: 405- 420.

[10] DING Henghui, JIANG Xudong, SHUAI Bing, et al. Context contrasted feature and gated multi-scale aggregation for scene segmentation[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City, UT, USA. IEEE, 2018: 2393-2402.

[11] ZHANG Fan, CHEN Yanqin, LI Zhihang, et al. ACFNet: attentional class feature network for semantic segmentation[C]∥2019 IEEE/CVF International Confer-ence on Computer Vision (ICCV). Seoul, Korea (South). IEEE, 2019: 6797- 6806.

[12] HE Kaiming, ZHANG Xiangyu, REN Shaoqing, et al. Deep residual learning for image recognition[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Las Vegas, NV, USA. IEEE, 2016: 770-778.

[13] SANG Qianbo, ZHUANG Yin, DONG Shan, et al. FRF-net: Land cover classification from large-scale VHR optical remote sensing images[J]. IEEE Geoscience and Remote Sensing Letters, 2020, 17(6): 1057-1061.

[14] WANG Yupei, SHI Hao, ZHUANG Yin, et al. Bidirectional grid fusion network for accurate land cover classification of high-resolution remote sensing images[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2020, 13: 5508-5517.