1 引言

数字公共交换电话网络为了节省宝贵且有限的通信带宽,将语音通信频段限制在0 Hz~4 kHz,通过该信道的语音会被滤除高频部分,从而输出窄带语音,虽然低频段保留了主要的语义信息,但丢失的高频部分包含了大量辅音能量以及音色和情感等语音声学特征,导致窄带语音在听觉感受会较为低沉,表达能力不足[1]。语音频带扩展技术旨在恢复语音丢失的高频信息,提高语音的清晰度、自然度和可懂度[2]。

传统的语音频带扩展方法如高斯混合模型(Gaussian Mixture Model,GMM)[3],由于建模能力有限,重构的宽带音频在听觉上会有“沙沙”的噪声,恢复的高频频谱也存在较多细节部分的失真。自从进入深度学习时代以来,语音频带扩展技术得到了快速发展,Li等人[4]提出了一种基于全连接神经网络(Dense Neural Network,DNN)的语音频带扩展方法,该模型的输入为窄带语音的对数功率谱(Log Power Spectrum,LPS)特征,输出为重构的高频频谱,最终将窄带频谱和重构的高频频谱拼接成宽带频谱,这一操作却导致了重构的宽带语音在低频段和高频段之间频谱过渡不连续,存在频谱丢失,并且高频频谱恢复的不够准确。随后Li又对模型进行了改进[5],利用DNN输出平滑特征的性质,将DNN模型的最后一层直接输出宽带LPS,重构的宽带语音频谱整体更为平滑,改进方法虽然解决了过渡带的不连续问题,但是丢失了更多的频谱细节信息。Kuleshov等人[6]提出了一种基于卷积神经网络(Convolution Neural Network,CNN)的端到端语音频带扩展方法,该模型不对训练数据进行任何特征提取,直接输入给神经网络模型进行宽带语音的重构。但是该方法的语音频带扩展进行了二次处理,先对窄带训练数据使用三次样条插值方法恢复了一次高频信息,接着使用CNN再一次对高频信息进行恢复,过程冗余复杂。并且该CNN模型采用维度拼接的形式进行跳跃连接,极大的增加了模型参数,进而增加了该模型的内存占用量和计算负担。Lim等人[7]和Dong等人[8]相继提出了基于时域和频域的神经网络模型,在时域分支和频域分支使用相同的神经网络结构,时域分支重构宽带语音波形,频域分支重构宽带语音频谱,最后通过频谱融合层输出重构宽带语音。该方法重构的宽带语音虽然在主客观度量值上有所提升,但并不高效,因为模型使用了两个神经网络的计算量。

除了神经网络模型,损失函数的设计也非常重要。以往语音频带扩展研究设置的损失函数,往往仅考虑到语音单个时域[9]或频域[10]的L1或L2损失,导致神经网络的训练结果具有偏向性。另外在时频域相近的语音在感知域不一定能获得相似的听觉感受,语音增强任务中通常在损失函数上添加感知损失,传统的感知损失函数是利用不同任务中预先训练好的模型来提取数据潜在空间的深度特征,然后使用L1或L2求两个特征之间的距离作为损失函数[11]。该方法提取的深度特征虽然能提升模型的预测性能,但对听觉感知特性研究的很少。

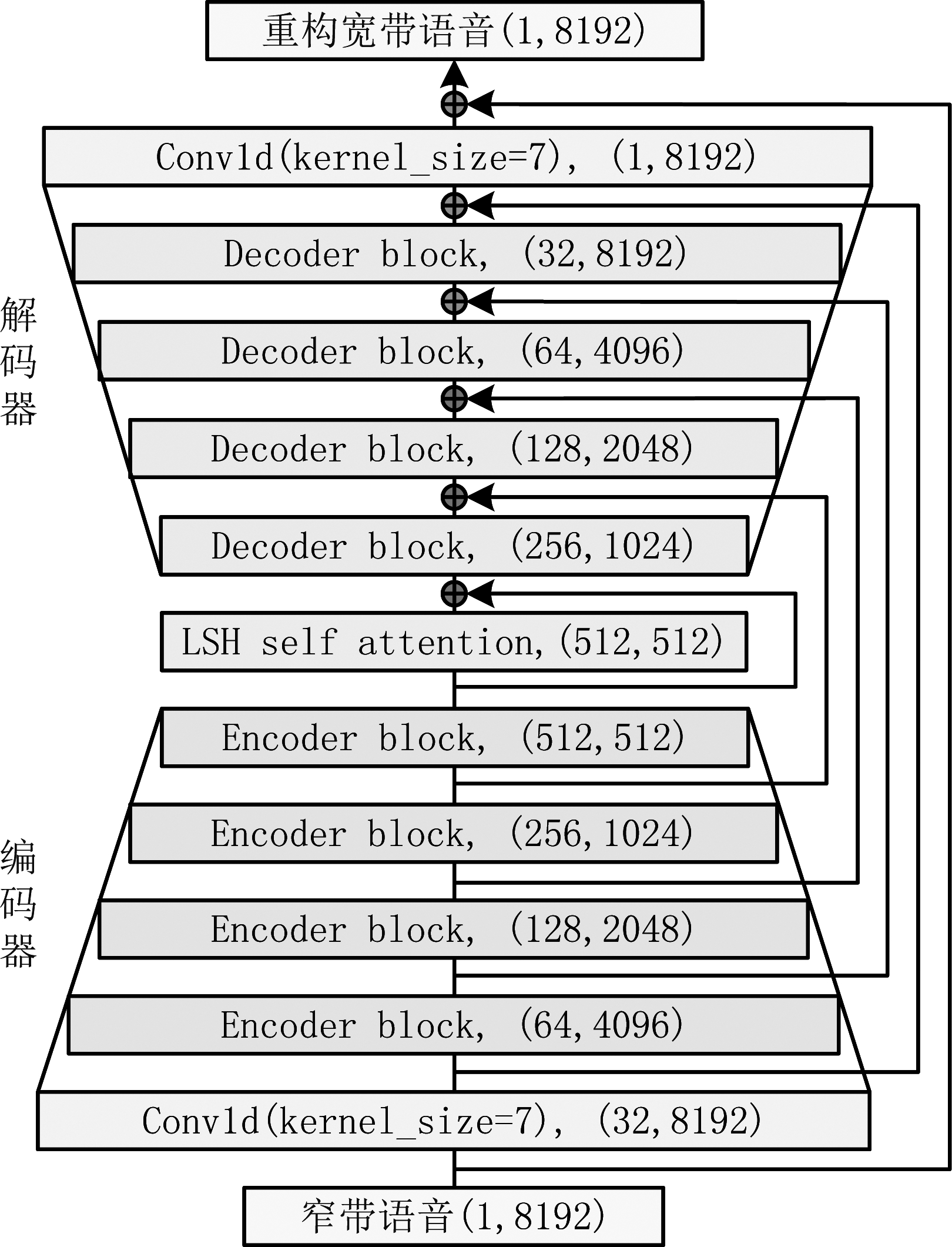

针对上述语音频带扩展方法存在的问题,本文提出了一种基于编解码器结构的神经网络模型用于端到端语音频带扩展,编解码器都使用了具有残差结构的时间卷积网络[12]的堆叠结构,该结构提高了神经网络对时序数据上下文依赖关系的学习能力。编码器负责在逐步下采样的过程中提取时域语音的声学特征,解码器则利用编码器学到的特征信息,逐步上采样恢复宽带语音。模型输入为未经任何特征提取的时域窄带语音,交由模型自身去学习和提取有用的数据特征,模型输出为重构宽带语音。同时为了编码器能提取更加重要的数据特征,在编码器的后面加上了局部敏感哈希自注意力层[13],促使模型在训练的过程中能给重要特征更高的权重,增加模型对重要特征的注意力,从而恢复更加高质量的重构宽带语音。

本文提出的模型虽然仅仅计算在时域维度,但为了模型能从时域、频域和感知域三个维度方向同时恢复宽带语音信息,提出了一种时频感知损失函数,由时域、频域和感知域三个损失函数线性组合而成。能全面且均衡的引导神经网络训练,生成更加真实的宽带语音。时域损失函数能拉动模型朝信号层面上的语音完整性训练,频域损失注重语音频谱层面上的完整性,而感知损失不仅能提高模型输出语音在特征层面上的完整性还能提高在人类听觉感知层面上的完整性。实验结果表明,本文提出的语音频带扩展方法重构宽带语音在主观和客观度量方面均优于其他对比方法。

本文结构如下: 第2节介绍了本文提出的模型,第3节阐述了时频感知损失函数,第4节进行了主客观评价实验,第5节进行了总结。

2 编解码器注意力模型

本文提出了一种结合注意力机制的编解码器神经网络模型,结构如图1所示,模型由编码器、局部敏感哈希自注意力层和解码器组成。为了充分利用每一层神经网络输出的特征信息,本文采用相加的形式进行跳跃连接,该操作既得到了和DenseNet[14]相似的效果,还规避了像DenseNet那样的占用大量内存的问题,因此,解码器中每一个解码块Decoder_block_(i)的输入为上一层的输出加上编码器中编码块Encoder_block_(4-i)的输出。

图1 结合注意力机制的编解码器神经网络模型

Fig.1 Neural network model of codec combined with attention mechanism

2.1 编码器结构

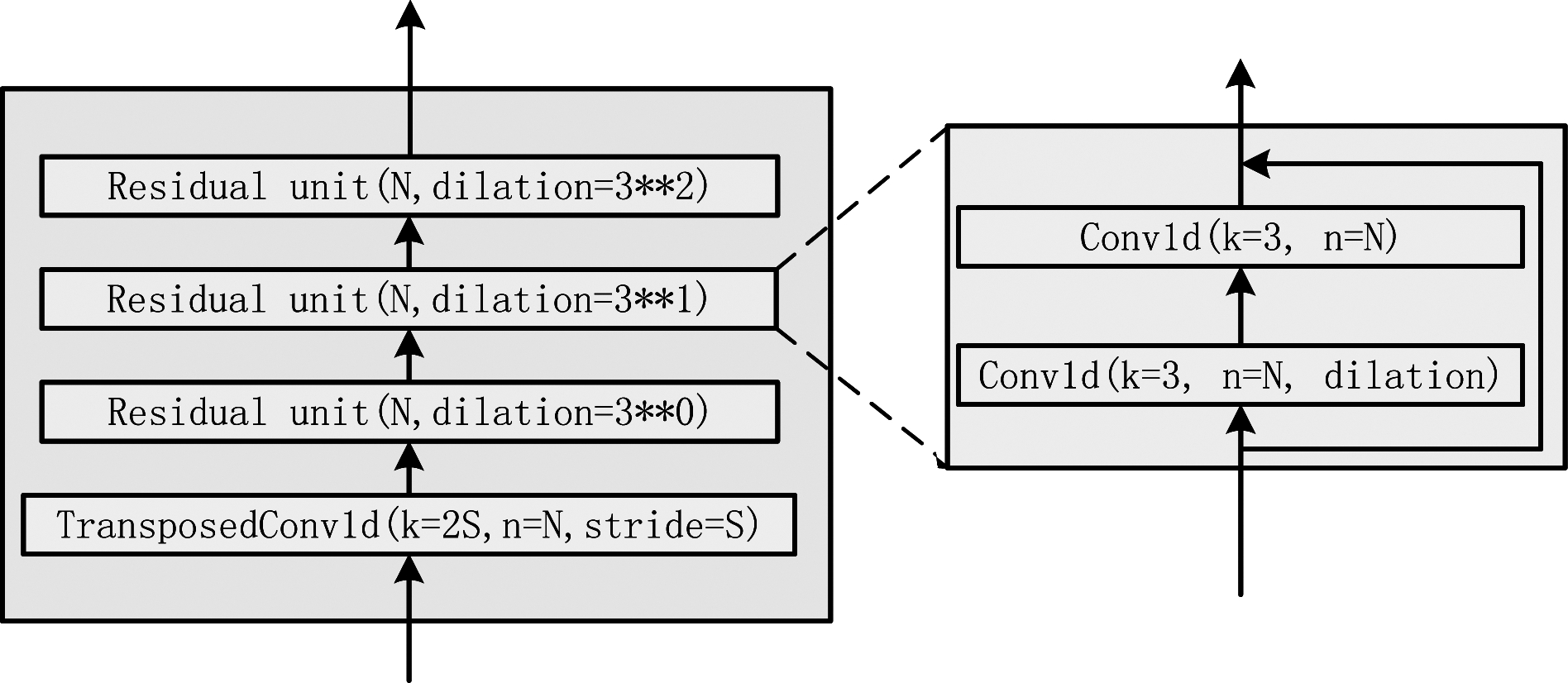

模型的编码器结构如图2所示,由一层卷积核大小为7的一维卷积层和四层编码块顺序堆叠组成。由于训练时模型输入为8192的长度,为了减少计算量和硬件设备内存的占用,每一层编码块都会对数据进行一次下采样,从而达到降维的效果,为了避免在下采样的过程中丢失过多的数据特征,将下采样倍率S统一设置为2。

图2 编码器中的编码块结构

Fig.2 Coding block structure in encoder

编码器中的残差单元是由扩张卷积和普通卷积神经网络组成的时间卷积神经网络结构,因为扩张卷积的卷积核是通过增加空洞来增加感受野的,而空洞部分无法提取数据特征,特征数据在提取的过程中会有一定程度的信息丢失。因此残差单元设计为两层,第一层使用扩张卷积,为了提取时序数据的上下文依赖关系,第二层使用普通卷积,残差单元的输出等于扩张卷积的输入加上普通卷积层输出。残差单元中的所有层均使用权重归一化[15],因为它只是对每一层神经网络权重矩阵进行归一化,从而加速模型收敛。不同残差块顺序堆叠时的扩张因子依次设置为dilation=3i,i∈[0,1,2],组成了扩张因果关系,更加有利于模型学习语音数据上下文依赖关系。

2.2 局部敏感哈希自注意力层

模型的瓶颈层引入了Reformer的局部敏感哈希(Locality-sensitive hashing,LSH)自注意力机制[13],Reformer是在Transfomer[16]基础上进行改进,其性能和Transformer不分伯仲,并且在长序列上有着更高的内存效率和更快的速度。

Transformer中使用点乘的注意力层表示如下:

(1)

式中,Q、K和V分别代表query、key和value组成的矩阵,公式(1)可以表述为使用Q和K的相似度作为权重,对所有的V进行加权求和,softmax的结果主要取决于其值最大的部分,如果qi向量距离ki向量越近,权重就越大,得到的注意力就越多。

LSH注意力通过hash函数对向量进行映射,只要附近向量以高概率得到相同的哈希值,而远处的没有,即可找到对位置敏感的最近邻。因此Attention对每次query位置i的公式可以改写为:

(2)

式中![]() 表示被注意的queryi集合,z表示softmax中的归一化项。

表示被注意的queryi集合,z表示softmax中的归一化项。

本文使用的是自注意力,即Attention(X,X,X),X为Attention层的输入,自注意力层能对特征数据内部做Attention,寻找特征数据内部的联系。

2.3 解码器结构

模型的解码器结构设计如图3所示,由四层解码块和一层卷积核大小为7的一维卷积层顺序堆叠组成。为了将编码器和局部敏感哈希自注意力层提取的特征恢复成宽带语音,每一层解码块都会对数据进行一次上采样。为了减少解码器恢复数据的压力,恢复更注重细节的语音,将上采样倍率S统一设置为2。

图3 解码器中的解码块结构

Fig.3 Decoding block structure in decoder

解码块中的上采样层使用一维转置卷积,在本文提出的模型中,经过仔细选择转置卷积层的滤波器大小和步幅,将卷积核数设置为步幅的2倍,生成的重构宽带语音能取得比PhaseShuffle[17]更少的频谱伪影。解码块中的残差单元采用和编码块中相同的扩张因果残差结构,能够更好地恢复语音数据上下文的依赖关系。

3 时频感知损失函数

模型迭代训练的目的是不断更新权重参数使得模型输出的重构宽带语音和宽带语音的损失函数取到最小值,不同的损失函数决定着不同的训练方向,因此损失函数的定义对于模型的训练非常重要,间接影响着重构宽带语音质量的高低。

本文提出了一种全新的时频感知损失函数,它由时域、频域和感知域三个子损失函数加权相加而成,既考虑到了语音时域和频域的特性,还考虑到了基于人耳感知域的特征。时域子损失函数能保证模型生成的重构宽带语音有更准确的时域波形,频域子损失函数能保证模型生成和宽带语音更相似的频谱,感知域子损失函数能保证模型生成和宽带语音难以区分的听觉感受,下面分别介绍三个子损失函数。

模型输出的重构宽带语音最理想的情况是每个采样点的值都和宽带语音一模一样,因此时域子损失设置为语音时域波形级别点到点之间的距离,使用均方根误差(Root Mean Square Error,RMSE)定义:

(3)

式中,y为宽带语音帧,![]() 为模型输出的重构宽带语音帧,n为当前帧的采样点索引,N为帧长。

为模型输出的重构宽带语音帧,n为当前帧的采样点索引,N为帧长。

频域子损失设置为重构宽带语音![]() 和宽带语音y提取对数梅尔频谱(Log Mel-Spectrogram, LMS)特征后的RMSE损失。因为LMS属于高度相关性的频域特征,并且基于人耳对声音频率感知的Mel刻度,所以LMS既能表征语音的频域特性,又能表征感知域特性。LMS的计算公式定义为:

和宽带语音y提取对数梅尔频谱(Log Mel-Spectrogram, LMS)特征后的RMSE损失。因为LMS属于高度相关性的频域特征,并且基于人耳对声音频率感知的Mel刻度,所以LMS既能表征语音的频域特性,又能表征感知域特性。LMS的计算公式定义为:

LMS(x)=log(mel_spec(x)+1e-8)

(4)

式中x为语音帧,1e-8为对数偏移量。

频域子损失定义为:

(5)

式中,M和K分别代表梅尔滤波器组数和帧数,m和k则是梅尔滤波器组和语音帧的索引。

感知域子损失使用的是Pranay等人[18]提出来的可区分感知音频度量(Differentiable Perceptual Audio Metric,DPAM),DPAM是使用一个大型的人类判断数据集训练神经网络构造的度量函数,该数据集的受试者会被问一个非常简单且客观的问题:两段录音相同吗?其中一段为纯净录音,另一段包含噪声、混响或压缩伪影。因此DPAM具有非常高的人类对声音的感知特性,且具有较高感知辨别能力,非常适合用来作为本文的感知域损失函数,感知域子损失函数定义为:

(6)

综上,时频感知损失定义为:

LossTFP=LossT+0.001*LossF+LossP

(7)

式中,0.001是通过网格搜索得到的频域损失权重。

4 实验与分析

为了验证提出的语音频带扩展方法性能,将窄带和宽带语音的语谱图与重构宽带语音进行了对比。并且分别复现了三次样条插值、文献[3]的GMM、文献[5]的DNN和文献[6]的CNN频带扩展方法,在主观评价和客观评价上将本文提出方法的重构宽带语音和三次样条插值方法、GMM方法,DNN方法、CNN方法的重构宽带语音进行了对比。

4.1 实验数据及设置

本文实验设计和数据集的选定遵循前人的研究[6,19,20],分别进行了单说话人和多说话人语音频带扩展实验,其中单说话人分别在VCTK-p225[21]和AISHLL-1-S0002数据集[22]上进行,多说话人在TIMIT数据集[23]上进行,数据集以7∶3的比例划分为训练集、验证集和测试集。VCTK和TIMIT数据集中的语音都是以英语为母语的美国本地人录制。而AISHLL-1-S0002数据集中的语音是中国本地人以普通话录制。进行单说话人和多说话人实验的目的在于对比模型的性能是否受到同类语种数据多样性的影响,在中文语音数据集实验的目的在于验证模型对不同语种语音的频带扩展性能影响。

本文使用librosa[24]库对语音数据进行预处理,首先将语音下采样到16 kHz,作为宽带语音,对于语音数据集采样率原本为16 kHz的不需要进行此操作,然后将16 kHz语音经过抗混叠低通滤波器后再次下采样到8 kHz,最后将8 kHz语音上采样到16 kHz,再次经过低通滤波器滤除频谱镜像,作为窄带语音,其中低通滤波器的截止频率为4 kHz。此时窄带语音和宽带语音具有相同的采样长度,但频带却只有宽带语音的一半,根据奈奎斯特采样定理,窄带语音带宽为0~4 kHz,宽带语音带宽为0~8 kHz。为了方便模型训练,窗长设置为8192,帧重叠设置为4096。

训练模型时批大小(batch size)设置为16,使用Adam优化器,学习率设置为0.0003,模型的神经网络权重参数均使用xavier_uniform初始化,偏置项初始化为0。

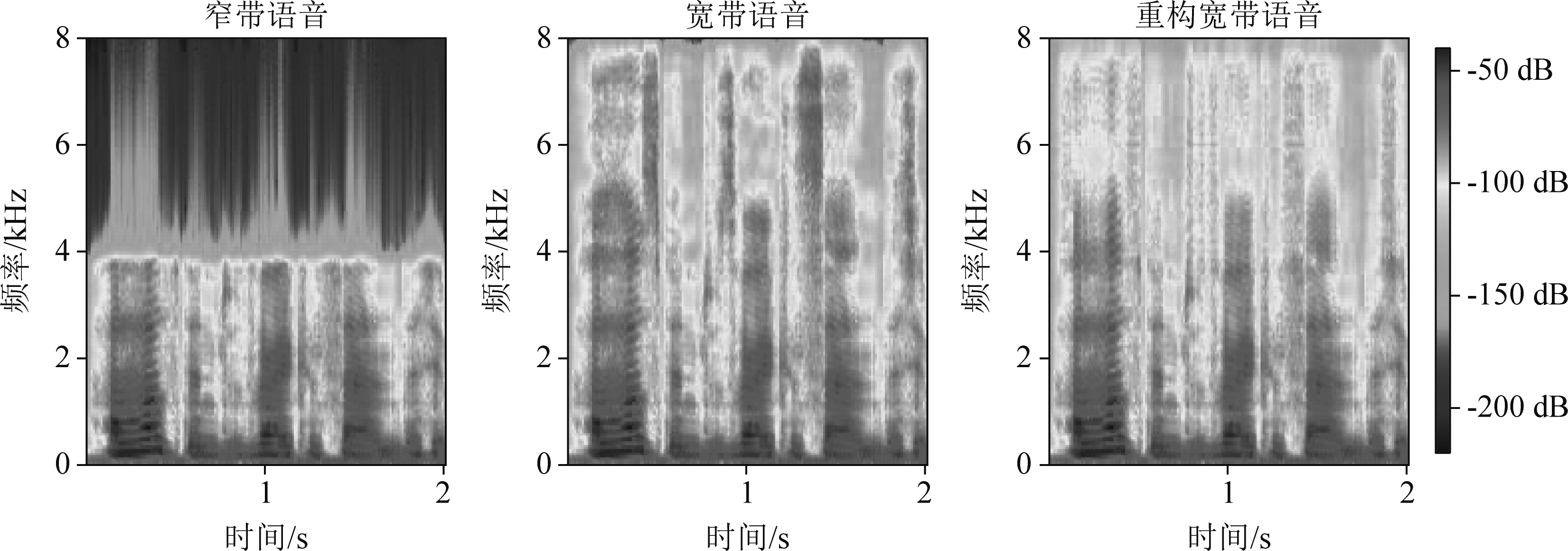

4.2 语谱图

通过语谱图能够更加直观的了解语音的频谱分布、能量分布以及声纹结构,语音频率越高,恢复的难度越大。图4给出了窄带语音、宽带语音和重构宽带语音的语谱图。由图可知,重构宽带语音的频谱图在0 kHz~4 kHz的频谱和宽带语音几乎一致,在4 kHz~8 kHz的频谱结构和纹理细节得到了大量的恢复,但是在高频能量恢复方面还待提高。

图4 语谱图对比

Fig.4 Comparison of spectrogram

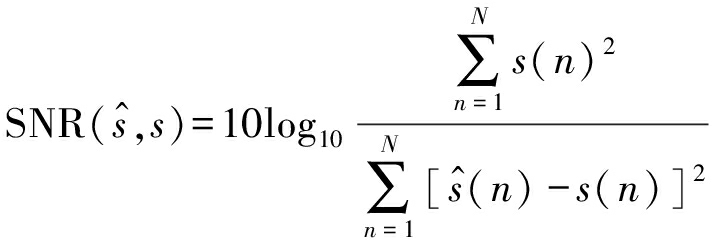

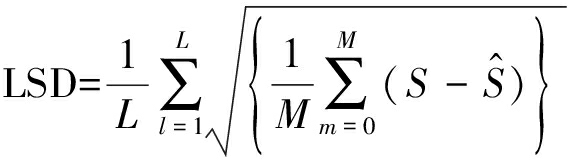

4.3 客观评价

客观评价主要使用信噪比[25](Signal to Noise Ratio,SNR)、对数谱距离[26](Log Spectral Distortion,LSD)、语音质量感知评估[27](Perceptual Evaluation of Speech Quality,PESQ)和短时客观可懂度[28](Short-Time Objective Intelligibility,STOI)度量来衡量重构宽带语音在时域波形、频域频谱以及感知域可懂度上面与宽带语音之间的差异。

SNR公式定义为:

(8)

式中,s(n)和![]() 分别代表宽带语音和重构宽带语音,SNR越大代表语音时域波形恢复的越准确。

分别代表宽带语音和重构宽带语音,SNR越大代表语音时域波形恢复的越准确。

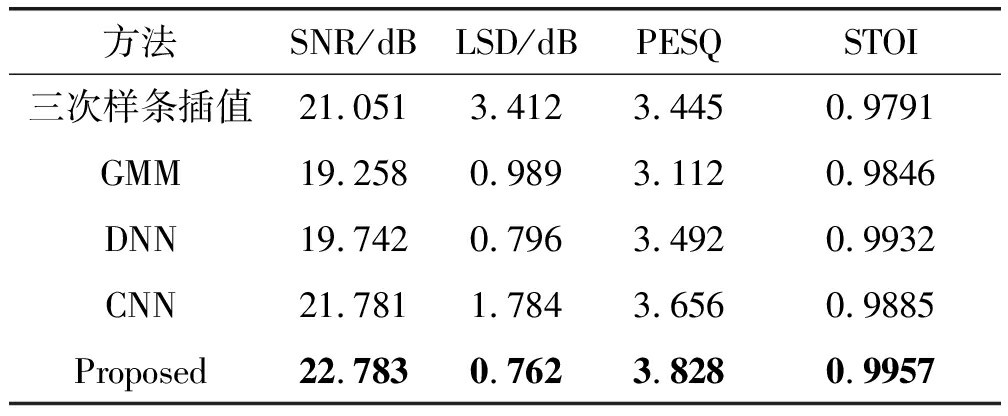

LSD公式定义为:

S=10log10|s(l,m)|2

(9)

(10)

(11)

式中,s(l,m)和![]() 分别为宽带语音和重构宽带语音的频谱,LSD越小代表重构宽带语音和宽带语音的频谱差别越小。

分别为宽带语音和重构宽带语音的频谱,LSD越小代表重构宽带语音和宽带语音的频谱差别越小。

PESQ是由国际电信联盟电信标准化部门指定的电话语音质量评价指标,用于估计人类感知的语音质量,其值在-0.5到4.5之间,值越高代表语音的感知质量越高。

STOI值介于0~1之间,越接近于1代表语音可懂度越高。

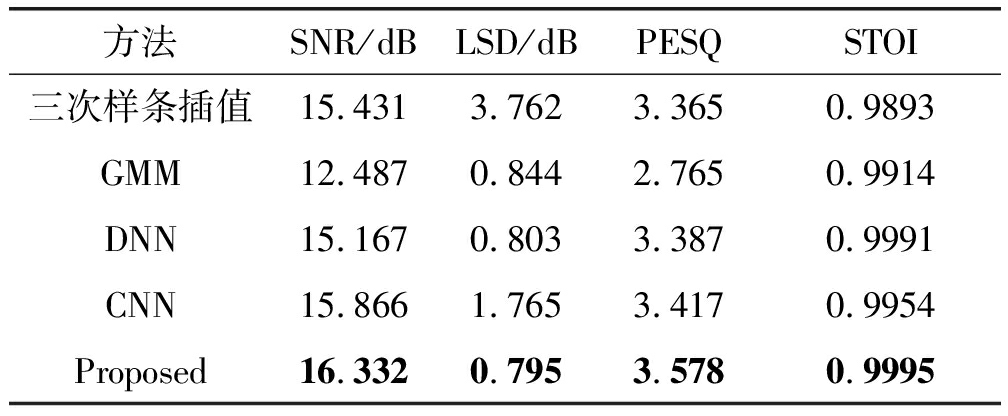

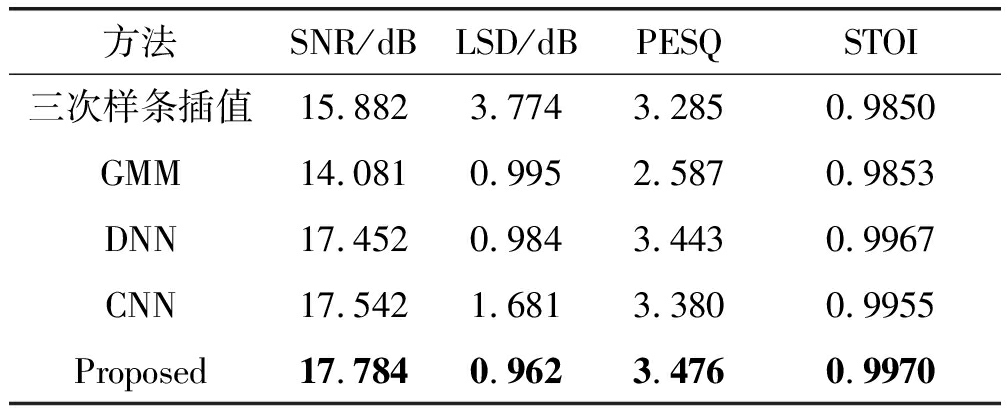

客观评价结果如表1~表3所示,在VCTK-p225、AISHLL-1-S0002以及TIMIT数据集实验中,本文提出来的方法生成的重构宽带语音在SNR、LSD、PESQ和STOI度量上均优于其他对比方法。在表1、表2和表3中,GMM方法生成的重构宽带语音引入了大量噪声,导致SNR过低,由此可知针对复杂多样性的语音声学结构,GMM很难训练出较好的性能。基于频域LPS特征的DNN方法,在SNR、LSD、PESQ和STOI度量上虽然没有达到最优,却也达到不错的结果。而基于时域端到端的CNN方法,在SNR和PESQ上获得不错的结果,但存在较为严重的频谱失真。

表1 VCTK-p225数据集实验客观评价结果

Tab.1 Results of objective evaluation of VCTK-p225 dataset experiment

方法SNR/dBLSD/dBPESQSTOI三次样条插值21.0513.4123.4450.9791GMM19.2580.9893.1120.9846DNN19.7420.7963.4920.9932CNN21.7811.7843.6560.9885Proposed22.7830.7623.8280.9957

表2 AISHLL-1-S0002数据集实验客观评价结果

Tab.2 Results of objective evaluation of AISHLL-1-S0002 dataset

方法SNR/dBLSD/dBPESQSTOI三次样条插值15.4313.7623.3650.9893GMM12.4870.8442.7650.9914DNN15.1670.8033.3870.9991CNN15.8661.7653.4170.9954Proposed16.3320.7953.5780.9995

表3 TIMIT数据集实验客观评价结果

Tab.3 Results of objective evaluation of TIMIT dataset experiment

方法SNR/dBLSD/dBPESQSTOI三次样条插值15.8823.7743.2850.9850GMM14.0810.9952.5870.9853DNN17.4520.9843.4430.9967CNN17.5421.6813.3800.9955Proposed17.7840.9623.4760.9970

4.4 主观评价

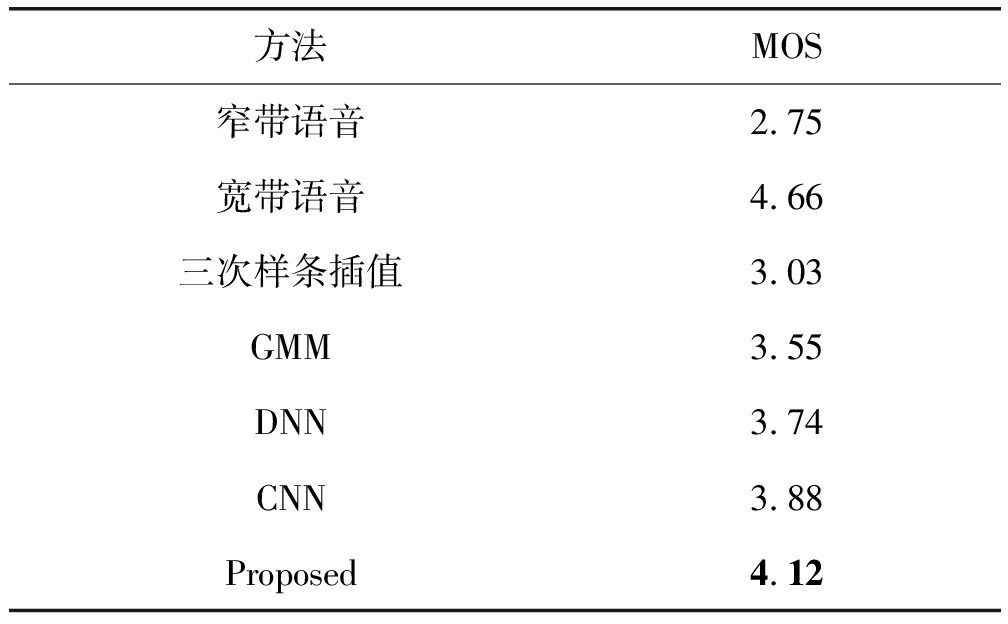

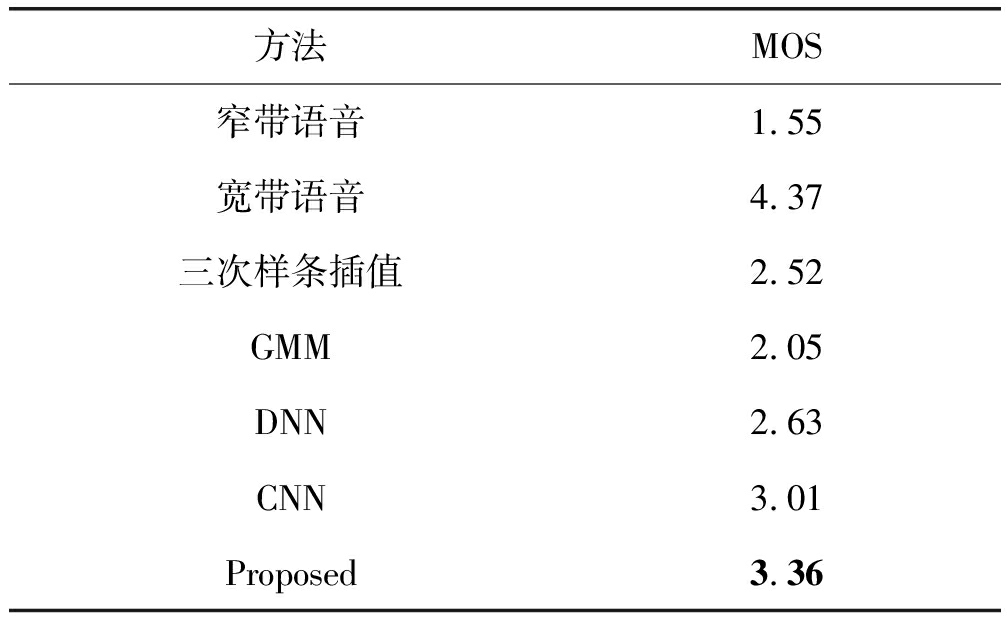

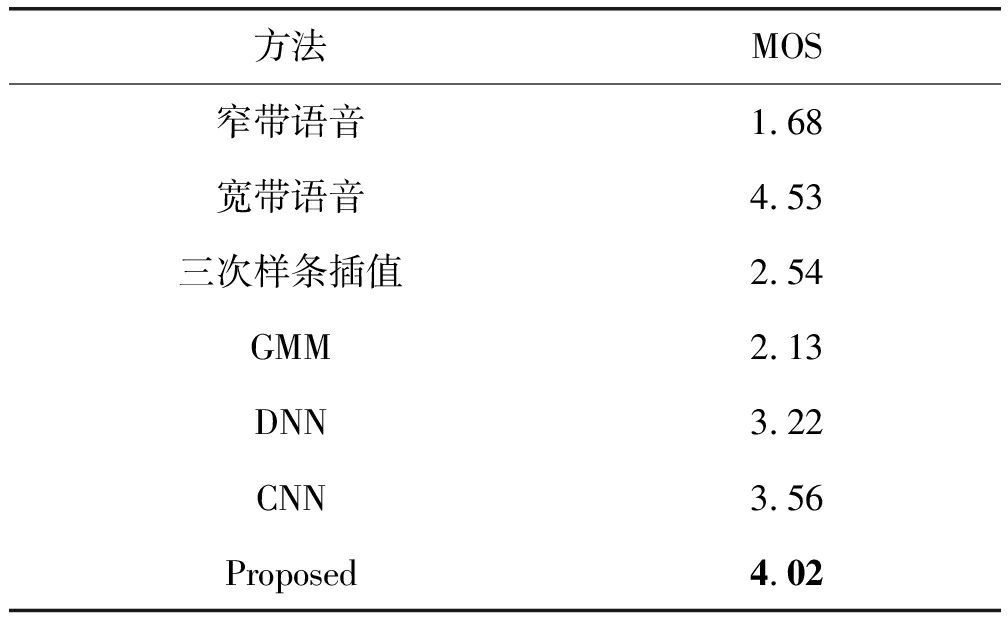

主观评价使用的是平均意见得分(Mean Opinion Score,MOS),主要衡量人耳对音频的主观感受,实验邀请20位听力正常的测听者,年龄分布在20~30岁之间,男女各半,采用对比听音的方式将本文方法重构宽带语音和其他对比方法的重构宽带语音给测听者听,为了测试主观评价的公正性,在测试语音中混入了窄带语音和宽带语音。要求测听者不带任何偏见,根据每段语音的听觉感受、自然度和清晰度进行主观意见打分,分数为0~5之间,最后对语音得分取平均值,得到该语音的最终MOS得分,MOS得分越高代表主观评价越好。主观评价结果如表4~表6所示,在三个语音数据集实验中,窄带语音的MOS得分最低,而宽带语音的MOS得分最高,由此可得,主观评价是较为公平公正的,并且本文提出的方法重构宽带语音MOS得分均优于其他对比方法。

表4 VCTK-p225数据集实验主观评价结果

Tab.4 Results of subjective evaluation of VCTK-p225 dataset

方法MOS窄带语音2.75宽带语音4.66三次样条插值3.03GMM3.55DNN3.74CNN3.88Proposed4.12

表5 AISHLL-1-S0002数据集实验主观评价结果

Tab.5 Results of experimental subjective evaluation of AISHLL-1-S0002 dataset

方法MOS窄带语音1.55宽带语音4.37三次样条插值2.52GMM2.05DNN2.63CNN3.01Proposed3.36

表6 TIMIT数据集实验主观评价结果

Tab.6 TIMIT dataset experimental subjective evaluation results

方法MOS窄带语音1.68宽带语音4.53三次样条插值2.54GMM2.13DNN3.22CNN3.56Proposed4.02

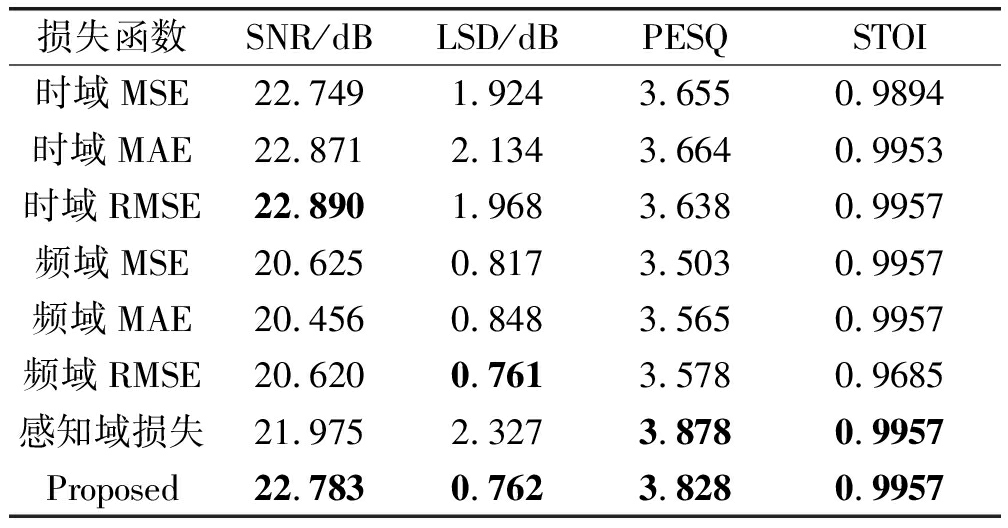

5 消融对比实验

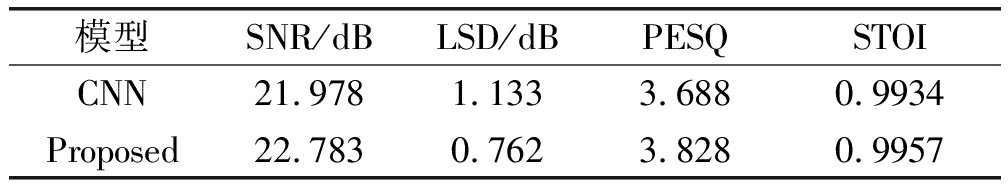

为了进一步证明本文提出的模型和时频感知损失函数的优越性,在VCTK-p225数据集上分别进行了两组实验。第一组实验控制时频感知网络不变,分别使用时域均方误差(Mean Square Error,MSE)、时域平均绝对值误差(Mean Absolute Error,MAE)、时域RMSE、频域MSE、频域MAE、频域RMSE损失函数和时频感知损失函数训练模型,重构的宽带语音进行客观评价对比;第二组实验因为CNN模型[6]也是基于时域波形的端到端语音频带扩展,控制时频感知损失函数不变,分别使用CNN模型与时频感知网络模型对窄带到宽带语音之间的非线性映射关系建模,对比两个模型重构宽带语音的客观度量得分。

时域MSE公式:

(12)

时域MAE公式:

(13)

频域MSE公式:

(14)

频域MAE公式:

(15)

第一组实验结果如表7所示。观察发现,时域损失函数能取得更高的SNR客观度量值,其中时域RMSE取得的SNR最高,但时域损失函数的LSD普遍偏高。频域损失函数能取得更低的LSD客观度量值,其中频域RMSE取得的LSD最低,但频域损失函数的SNR却普遍偏低。感知域损失函数能取得更高的PESQ值。本文提出来的时频感知损失函数均衡了时域RMSE、频域RMSE和感知域损失的优点,在取得较高SNR的同时,还取得了更低了LSD,以及更高的PESQ和STOI。

表7 时频感知网络模型在不同损失函数下的客观评价结果

Tab.7 Objective evaluation results of time-frequency sensing network model under different loss functions

损失函数SNR/dBLSD/dBPESQSTOI时域MSE22.7491.9243.6550.9894时域MAE22.8712.1343.6640.9953时域RMSE22.8901.9683.6380.9957频域MSE20.6250.8173.5030.9957频域MAE20.4560.8483.5650.9957频域RMSE20.6200.7613.5780.9685感知域损失21.9752.3273.8780.9957Proposed22.7830.7623.8280.9957

第二组实验结果如表8所示,观察发现,在同时使用时频感知损失函数的情况下,本文提出来的模型在SNR、LSD、PESQ和STOI取值上,普遍优于CNN模型[6]。

通过以上两组实验可以证明本文模型和时频感知损失函数的优越性。并且表8中的CNN各项得分均比表1中的CNN各项得分高,再一次证明时频感知损失函数能更好的引导模型训练。

表8 时频感知损失函数在不同模型下的客观评价结果

Tab.8 Objective evaluation results of time-frequency perceived loss function under different models

模型SNR/dBLSD/dBPESQSTOICNN21.9781.1333.6880.9934Proposed22.7830.7623.8280.9957

6 结论

本文提出了一种基于编码器结构的端到端语音频带扩展方法,模型引入了自注意力机制提取语音深度特征,使得编码器提取有用信息的能力得到了进一步提升。另外本文结合时域、频域和感知域提出了一种全新的时频感知损失函数用来训练神经网络,促使神经网络在时域、频域和感知域拟合出更加均衡也更加准确的重构宽带语音。通过消融对比实验表明,本文提出来的模型和时频感知损失函数相比于其他方法更具有优越性。通过主客观实验表明,提出的方法在频带扩展上性能更优越,重构宽带语音质量更高。

[1] VARY P, SCHLIEN T.Artificial bandwidth extension of speech signals[J].The Journal of the Acoustical Society of America, 2020, 148(4): 2541-2549.

[2] NOH K, CHANG J H.Deep neural network ensemble for reducing artificial noise in bandwidth extension[J].Digital Signal Processing, 2020, 102(5): 1-6.

[3] BACHHAV P, TODISCO M, EVANS N.Exploiting explicit memory inclusion for artificial bandwidth extension[C]∥2018 IEEE International Conference on Acoustics, Speech and Signal Processing(ICASSP).Calgary, AB, Canada.IEEE, 2018: 5459-5463.

[4] LI Kehuang, LEE C H.A deep neural network approach to speech bandwidth expansion[C]∥2015 IEEE International Conference on Acoustics, Speech and Signal Processing(ICASSP).South Brisbane, QLD, Australia.IEEE, 2015: 4395-4399.

[5] LI Kehuang, HUANG Zhen, XU Yong, et al.DNN-based speech bandwidth expansion and its application to adding high-frequency missing features for automatic speech recognition of narrowband speech[C]∥16th Annual Conference of the International Speech Communication Association.Dresden, Germany, 2015: 2578-2582.

[6] KULESHOV V, ENAM S Z, ERMON S.Audio super resolution using neural networks[C]∥International Conference on Learning Representations(ICLR).Palais des Congrès Neptune, Toulon, France.2017: 2063-2069.

[7] LIM T Y, YEH R A, XU Yijia, et al.Time-frequency networks for audio super-resolution[C]∥2018 IEEE International Conference on Acoustics, Speech and Signal Processing(ICASSP).Calgary, AB, Canada.IEEE, 2018: 646-650.

[8] DONG Yuanjie, LI Yaxing, LI Xiaoqi, et al.A time-frequency network with channel attention and non-local modules for artificial bandwidth extension[C]∥2019 IEEE International Conference on Acoustics, Speech and Signal Processing(ICASSP).Barcelona, Spain.IEEE, 2020: 6954-6958.

[9] LING Zhenhua, AI Yang, GU Yu, et al.Waveform modeling and generation using hierarchical recurrent neural networks for speech bandwidth extension[J].IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2018, 26(5): 883-894.

[10] FENG B, JIN Zeyu, SU Jiaqi, et al.Learning bandwidth expansion using perceptually-motivated loss[C]∥2019 IEEE International Conference on Acoustics, Speech and Signal Processing(ICASSP).Brighton,UK.IEEE,2019: 606-610.

[11] GERMAIN F G, CHEN Qifeng, KOLTUN V.Speech denoising with deep feature losses[C]∥Interspeech.Graz, Austria, ISCA, 2019: 2723-2727.

[12] ZHAO Yan, WANG Deliang, XU Buye, et al.Monaural speech dereverberation using temporal convolutional networks with self attention[J].IEEE/ACM Transactions on Audio, Speech, and Language Processing,2020,28(5): 1598-1607.

[13] KITAEV N, KAISER L, LEVSKAYA A.Reformer: the efficient transformer[C]∥International Conference on Learning Representations(ICLR), 2020: 4561-4573.

[14] HUANG Gao, LIU Zhuang, VAN D M L, et al.Densely connected convolutional networks[C]∥2017 IEEE Conference on computer vision and pattern recognition(CVPR).Honolulu,HI,USA.IEEE,2017: 4700-4708.

[15] SALIMANS T, KINGMA D P.Weight normalization: a simple reparameterization to accelerate training of deep neural networks[J].Advances in Neural Information Processing Systems, 2016, 29(12): 901-909.

[16] VASWANI A, SHAZEER N, PARMAR N, et al.Attention is all you need[C]∥31th Conference on Neural Information Processing Systems(NIPS).Long Beach, CA, USA, 2017: 6000-6010.

[17] DONAHUE C, MCAULEY J, PUCKETTE M.Adversarial Audio Synthesis[C]∥International Conference on Learning Representations(ICLR).2019.

[18] MANOCHA P, FINKELSTEIN A, JIN Zeyu, et al.A differentiable perceptual audio metric learned from just noticeable differences[C]∥Interspeech.Shanghai, China.ISCA, 2020: 2852-2856.

[19] WANG Heming, WANG Deliang.Time-frequency loss for CNN based speech super-resolution[C]∥2020 IEEE International Conference on Acoustics, Speech and Signal Processing(ICASSP).Barcelona, Spain.IEEE, 2020: 861-865.

[20] KIM Y S, SEOK J W.Deep Learning based Raw Audio Signal Bandwidth Extension System[J].Institute of Korean Electrical and Electronics Engineers, 2020, 24(4): 1122-1128.

[21] VEAUX C, YAMAGISHI J, MACDONALD K.Superseded-cstr vctk corpus: English multi-speaker corpus for cstr voice cloning toolkit[J].University of Edinburgh.The Centre for Speech Technology Research, 2016.

[22] BU Hui, DU Jiayu, NA Xingyu, et al.AISHELL-1: An open-source Mandarin speech corpus and a speech recognition baseline[C]∥20th Conference of the Oriental Chapter of the International Coordinating Committee on Speech Databases and Speech I/O Systems and Assessment.Seoul, Korea(South).IEEE, 2017: 1-5.

[23] GAROFOLO J S, LAMEL L F, FISHER W M, et al.DARPA TIMIT acoustic-phonetic continous speech corpus CD-ROM.NIST speech disc 1-1.1[J].NASA STI/Recon Tech.Rep.LDC93S1, 1993, 93: 27403.

[24] MCFEE B, RAFFEL C, LIANG Dawen, et al.Librosa: audio and music signal analysis in python[C]∥14th Python in Science Conference.Austin,Texas.SciPy,2015: 18-25.

[25] WANG Haonan, NISHIURA T.Speech quality improvement with bit-rate extension using spectral gain enhancement[J].Acoustical Science and Technology, 2020, 41(1): 411-412.

[26] WANG Heming, WANG Deliang.Towards robust speech super-resolution[J].IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2021, 28(6): 1-9.

[27] P.862 Recommendation.Perceptual evaluation of speech quality(PESQ): An objective method for end-to-end speech quality assessment of narrowband telephone networks and speech codecs[J].ITU, 2001, 14: 14-30.

[28] JENSEN J, TAAL C H.An algorithm for predicting the intelligibility of speech masked by modulated noise maskers[J].IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2016, 24(11): 2009-2022.