1 引言

语音增强的目的是从受噪声干扰的语音中提取目标语音,提高语音质量和可懂度,是语音识别[1]、移动语音通信和人工耳蜗[2]等应用中一个重要组成部分,在学术界和工业界受到广泛研究。在现实声学环境中噪声种类繁多,除目标语音外,其他任何声音包括人声都可以成为干扰噪声。因此,想要完全去除干扰噪声是非常困难的。

目前语音增强算法主要分为传统算法和基于深度学习的算法。传统方法通常不依赖语音的先验信息,需要的计算量较小,在实际应用中容易实现,但需要对噪声模型进行假设,常常会导致较大偏差,而且无法适应随时间变化的噪声,尤其在非平稳的噪声环境中。典型的传统语音增强算法有谱减法[3]、维纳滤波[4]和子空间法[5]等。近年来,随着计算机运算能力的提高和各类数据的爆炸性增长,基于神经网络的监督学习算法在语音增强任务中取得重大突破。与传统语音增强算法相比,基于神经网络的语音增强算法不需要对噪声模型进行假设,其算法核心是利用大量的训练数据对神经网络进行训练,使模型具有从带噪语音特征估计出目标语音特征的能力,在平稳和非平稳的噪声中能获得更好的语音质量和可懂度,成为当下语音增强任务的重点研究方向[6]。

基于神经网络的语音增强策略大致可以分为两类:Mapping和Masking。Mapping策略是直接利用目标语音谱作为网络训练目标,训练好的网络将带噪语音映射到目标语音[7];Masking策略类似于传统的基于掩膜的维纳滤波器,不同之处是将掩膜系数如理想二值掩膜(Ideal Binary Mask, IBM)、理想比率掩膜(Ideal Ration Masking, IRM)和幅度谱掩膜(Spectral Magnitude Mask, SMM)等作为网络输出目标[8],训练好的网络能够直接由输入带噪语音特征获得掩膜系数。为了进一步提升增强算法的性能,目前的工作主要在网络模型、输入特征和训练目标三个方向进行优化,在训练目标的研究中,多目标学习是被研究的方向之一。

2015年Xu等人[9]采用深度神经网络(Deep Neural Network, DNN)同时输出目标语音的对数功率谱(Log-Power Spectral, LPS)、梅尔频率倒谱系数(Mel Frequency Cepstrum Coefficient, MFCC)和IBM,并对三者进行联合优化,这种多特征联合优化相比于只优化LPS增加了更多的约束,从而提高网络对首要目标特征LPS的学习能力。2017年Sun等人[10]发现直接估计IRM在高信噪比可获得较好的结果,相反地,直接估计目标语音的LPS在低信噪比下获得了更好的结果。为了充分利用这种互补性,其采用长短时记忆(Long-Short Term Memory, LSTM)网络同时对IRM和目标语音的LPS进行预测。该方法保留了两种输出目标各自的优势,进一步提升了语音增强效果。带噪语音是由目标语音和噪声两部分组成,前述方法虽然采用了多种特征联合优化网络,但所采用的输出特征仍然是目标语音相关的,并没有对噪声信息进行充分利用。2017年Wang等人[11]提出一种联合噪声和掩膜的感知训练策略。其所提系统使用两个DNN,第一个DNN利用前导无声段的噪声和带噪语音的LPS作为网络的输入特征,估计出动态噪声信号[12]的LPS和目标语音的IRM,并将这两个特征连同带噪语音的LPS作为第二个DNN的输入,估计出目标语音LPS。实验结果表明,动态噪声估计与IRM信息有很强的互补性,可以让网络更好的预测目标语音的LPS。上述多目标学习的语音增强方法在网络优化过程中,通常分别对单个输出目标进行损失函数的计算,多目标之间是并行的,并没有充分利用多目标之间可能存在的关联。

针对上述问题,本文进一步提出基于语音、噪声、带噪语音三者联合优化的策略,设计了一个双输出(语音和噪声)系统框架,并提出一种新的多目标(语音、噪声和带噪语音)损失函数计算策略。该策略利用网络估计的语音和噪声计算出带噪语音,充分考虑了目标语音、噪声、带噪语音以及三者间的关联信息,在训练时对网络输出目标增加了更多的约束。本文构建了一个基于LSTM网络的语音增强系统,利用均方误差(Mean-Square error, MSE)和尺度不变信号失真率[13](Scale-Invariant Signal-to-Distortion Ration, SISDR)作为损失函数对网络参数进行优化,验证所提方法的有效性。实验结果表明,所提方法可有效提高网络对噪声的抑制能力,获得质量更高,噪声残留更少的增强语音。

2 算法描述

给定信号模型:

y(n)=x(n)+d(n)

(1)

其中x(n)、d(n)和y(n)分别为目标语音、噪声和带噪语音信号。语音增强的目的就是从带噪语音y(n)中尽可能的提取出目标语音x(n),从而降低噪声d(n)对语音质量和可懂度的影响。假设噪声和语音之间是不相关的,对公式(1)中各信号进行短时离散傅里叶变换(Short-time Fourier Transform, STFT)可得:

Y(t, f)=X(t, f)+D(t, f)

(2)

式中X(t, f)、D(t, f)和Y(t, f)分别表示各自时域信号的谱。t、f分别为时间帧与频率通道的索引。同样,增强的目标是从Y(t, f)中尽可能估计出X(t, f)。

2.1 基于LSTM网络的语音增强系统

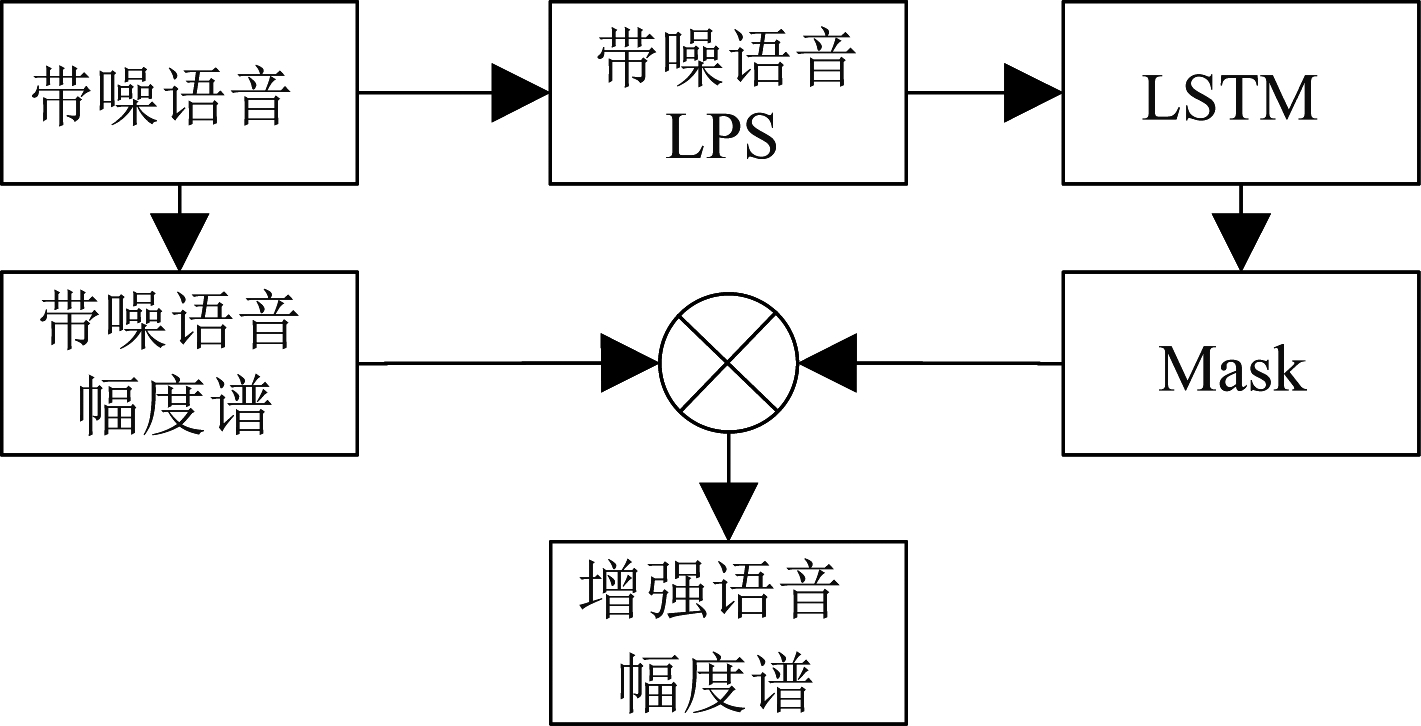

LSTM网络是为了缓解传统循环神经网络(Recurrent Neural Network,RNN)的梯度消失和爆炸而提出的,通过输入门、遗忘门和输出门对信息流进行动态的更新、丢弃和输出,可以有效利用信号自身的时序相关信息[14]。由于语音信号具有很强的时间相关性,LSTM网络可以很好地捕捉语音和噪声的统计特性,在语音增强中有较好的表现[15-18]。本文将利用LSTM网络在Masking策略下进行语音增强。为了在网络训练时得到最佳的Mask,可采用两种损失函数计算方式:其一是直接利用网络估计Mask系数如IBM、IRM和SMM等(与训练数据已知的相应系数值对比)计算损失函数;其二是将网络输出的Mask系数与带噪语音幅度谱相乘得到增强的幅度谱,再与目标语音幅度谱计算损失函数(称为信号逼近法[19] Signal Approximation, SA)。方法二的优势在于不用考虑使用何种掩膜对网络学习是最优的,因为其直接以目标语音的幅度谱为代价函数,本文将利用该方法进行实验。图1所示为本文所采用的语音增强系统框图。带噪语音的LPS作为特征输入给LSTM网络,输出的Mask与带噪语音幅度谱相乘得到增强语音幅度谱。在训练过程中,增强语音幅度谱与目标语音幅度谱计算损失函数,并更新网络参数,使网络具有估计目标语音的能力。在测试阶段,利用训练好的模型从带噪语音估计得到的增强语音幅度谱,再利用带噪语音的相位,进行时域波形的重构,从而实现语音增强。

图1 基于神经网络的语音增强系统框图

Fig.1 Structure of speech enhancement system based on neural network

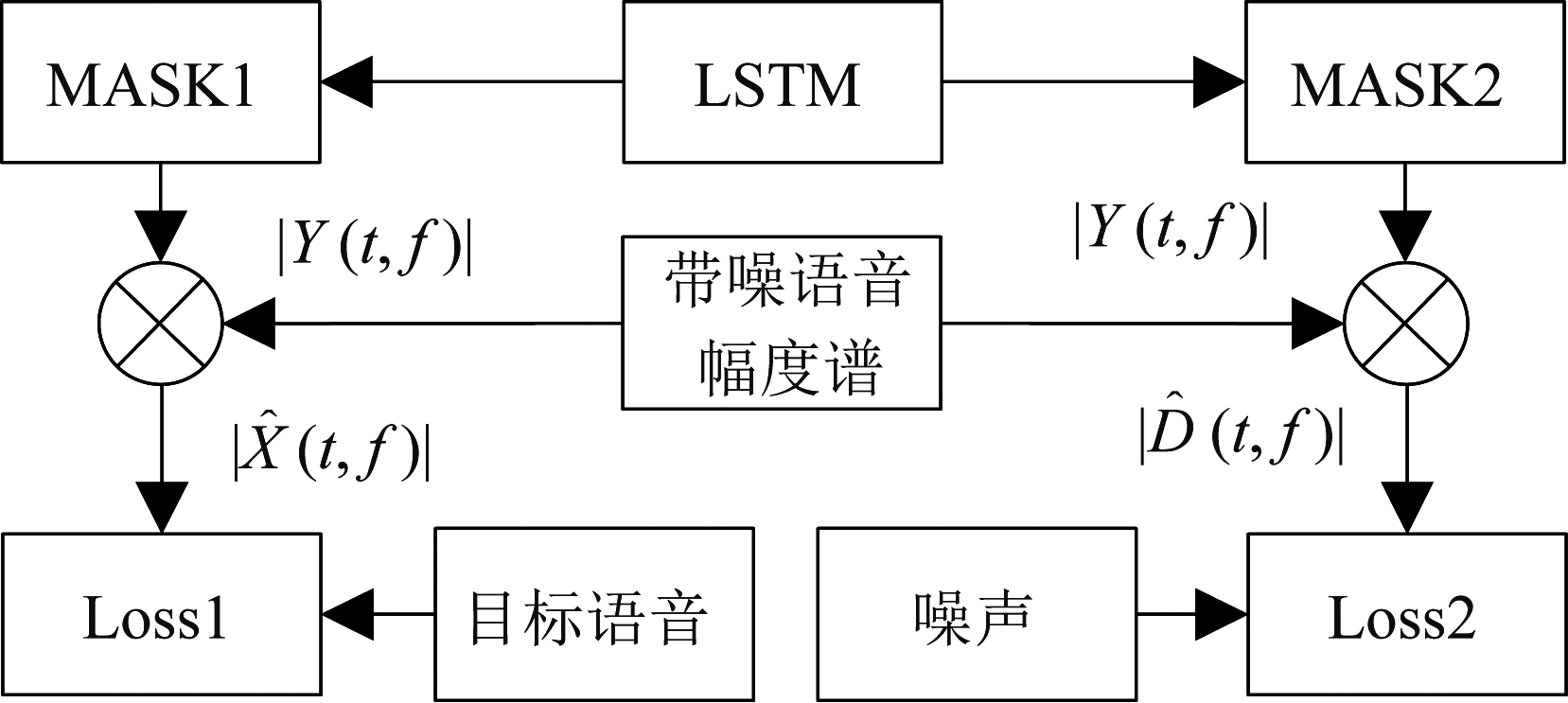

2.2 基于多目标损失函数的网络训练

语音增强系统的目标是输出目标语音,在基于神经网络的语音增强系统中,通常只会输出目标语音的谱特征或者掩膜系数。在文献[10]中,则将目标语音的谱特征和掩膜系数作为网络输出。受其启发,为了能在网络优化过程中考虑到噪声信息,本文设计了一个双输出系统框架,如图2所示。LSTM网络输出分为两个掩膜系数Mask1和Mask2,分别对目标语音和噪声的掩膜进行估计。将Mask1和Mask2分别与带噪语音幅度谱![]() 相乘获得估计的目标语音幅度谱

相乘获得估计的目标语音幅度谱![]() 和噪声幅度谱

和噪声幅度谱![]() 将二者分别与目标语音和原噪声的幅度谱计算网络估计的损失函数,分别记为Loss1、Loss2。在此基础上,本文引入第三个损失函数:根据幅度谱减法[3],计算

将二者分别与目标语音和原噪声的幅度谱计算网络估计的损失函数,分别记为Loss1、Loss2。在此基础上,本文引入第三个损失函数:根据幅度谱减法[3],计算![]() 原带噪语音幅度谱|Y(t, f)|的损失函数Loss3。最后得到联合优化损失函数:

原带噪语音幅度谱|Y(t, f)|的损失函数Loss3。最后得到联合优化损失函数:

图2 双输出系统框架

Fig.2 Dual-target output structure

![]()

(3)

其中α值依赖于损失函数的选取,当损失函数为MSE时,在训练过程中发现取值在0.5~4可以提升增强效果,取值在2左右时效果最好。当损失函数为SISDR时,α值小于0.02时可以提升增强效果,并在0.01左右时效果最好。引入Loss3的逻辑在于:虽然由Loss1和Loss2进行联合优化,并通过网络权值共享方式使语音和噪声在网络优化中相互影响,但实验结果发现,该方法并不能有效提升网络的增强性能。通过增加Loss3来优化网络,迫使估计得到的带噪语音![]() 与原始带噪语音|Y(t, f)|的损失函数最小。此时,由于估计带噪语音是由估计的语音和噪声构成的,优化

与原始带噪语音|Y(t, f)|的损失函数最小。此时,由于估计带噪语音是由估计的语音和噪声构成的,优化![]() 时同时也对估计的语音和噪声进行了优化,通过这种方式,将语音、噪声和带噪语音三者之间紧密联合,从而使网络能够更好的分离出噪声和语音,提升语音增强效果。

时同时也对估计的语音和噪声进行了优化,通过这种方式,将语音、噪声和带噪语音三者之间紧密联合,从而使网络能够更好的分离出噪声和语音,提升语音增强效果。

3 实验设置

3.1 实验数据

使用THCHS-30数据集[20]对2中所提算法进行性能验证。THCHS-30数据集包含训练、验证和测试三个子集,分别包含10000、893和2495句语音。本实验中,训练集和验证集的数据用于训练网络,测试集中随机选取50句用于测试。训练噪声数据使用NOISEX-92数据集[21],该数据集共包含15种不同的环境噪声。合成的带噪语音共使用5种不同的信噪比,分别是-5 dB、0 dB、5 dB、10 dB和20 dB。训练集和测试集中每句语音只混合一种噪声和一个信噪比,故训练集和测试集的带噪语音数量分别为10000句和893句。用于测试的噪声包含训练集中的15种噪声作为可见噪声,还包含来自MS-SNSD[22]中的两种噪声Station_1和Cafe_1作为不可见噪声。用于测试的每一句语音分别与所有17种噪声在上述5种SNR下构成带噪语音,故共有50*17*5=4250句带噪测试语音。

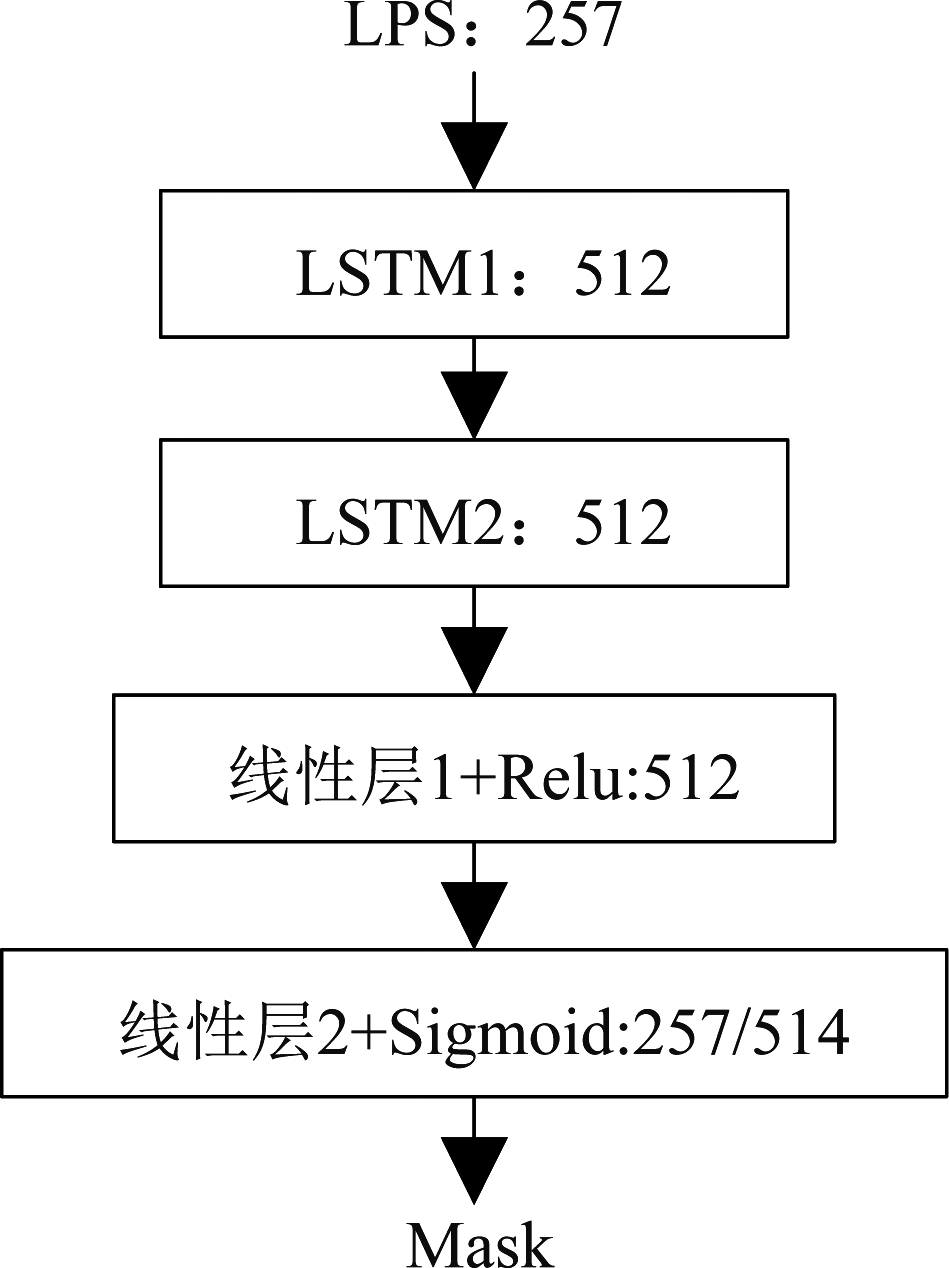

3.2 特征提取和网络设置

所有数据重采样率均为16 kHz。对语音进行512点短时傅里叶变换(使用汉宁窗,帧长32 ms,帧移16 ms),于是每一帧语音可得到257个点的幅度谱,计算其LPS作为网络的输入特征。网络结构设置如图3所示,257维LPS为输入网络的特征,中间两个LSTM层和线性层1的输出都是512维,上一层的输出作为下一层的输入。当预测单目标时,线性层2输出维度为257,对应Mask1;当预测为多目标时,线性层2输出维度为514,对应Mask1和Mask2。训练网络时,初始学习率设置为0.01,当上一个epoch验证集的Loss小于当前epoch验证集的Loss,学习率则以0.8的指数衰减率进行降低。批大小(batch size)不是固定的,训练时进行逐句训练,批大小根据每一句语音的长度而确定,并使用Adam优化器对网络进行优化,每个模型训练60个epoch。

图3 系统网络结构

Fig.3 System network structure

3.3 基线系统和所提算法

根据所采取的优化目标和损失函数不同,本实验对比六种不同的增强方法。方法一:采用MSE(记为:![]() 的单目标优化训练网络,网络输出只有语音,并只计算目标语音对应的损失函数,简写为ST_MSE(Single-Target MSE)。方法二:采用MSE的双目标联合优化训练网络,网络输出有语音和噪声,并分别对目标语音和噪声计算相应的MSE,计算二者之和作为损失函数进行联合优化,简写为DT_MSE(Dual-Target MSE)。方法三:采用MSE的多目标联合优化训练网络,网络输出有语音和噪声,并分别计算语音、噪声、带噪语音的MSE,按公式(3)所给损失函数联合优化网络,其中α设置为2,简写TT_MSE(Tri-Target MSE)。方法四、五、六与前三种方法相对应,但损失函数从MSE改为尺度不变信号失真率SISDR(记为:

的单目标优化训练网络,网络输出只有语音,并只计算目标语音对应的损失函数,简写为ST_MSE(Single-Target MSE)。方法二:采用MSE的双目标联合优化训练网络,网络输出有语音和噪声,并分别对目标语音和噪声计算相应的MSE,计算二者之和作为损失函数进行联合优化,简写为DT_MSE(Dual-Target MSE)。方法三:采用MSE的多目标联合优化训练网络,网络输出有语音和噪声,并分别计算语音、噪声、带噪语音的MSE,按公式(3)所给损失函数联合优化网络,其中α设置为2,简写TT_MSE(Tri-Target MSE)。方法四、五、六与前三种方法相对应,但损失函数从MSE改为尺度不变信号失真率SISDR(记为:![]() 近年来被用来作为端到端语音增强系统的损失函数[16,23]并获得较好的增强结果。在计算SISDR时,将估计的幅度谱(采用带噪语音的相位)先转换为时域波形再进行计算。方法六中的α设置为0.01。方法四、五、六分别简写为ST_SISDR、DT_SISDR和TT_SISDR。六种方法中除了上述的区别外,其余的设置都是相同的。在测试时,网络输出结果只考虑目标语音部分。

近年来被用来作为端到端语音增强系统的损失函数[16,23]并获得较好的增强结果。在计算SISDR时,将估计的幅度谱(采用带噪语音的相位)先转换为时域波形再进行计算。方法六中的α设置为0.01。方法四、五、六分别简写为ST_SISDR、DT_SISDR和TT_SISDR。六种方法中除了上述的区别外,其余的设置都是相同的。在测试时,网络输出结果只考虑目标语音部分。

4 结果分析

分别使用语音质量感知评估[24](Perceptual Evaluation of Speech Quality, PESQ)和短时客观可懂度[25](Short-Time Objective Intelligibility, STOI)对语音质量和可懂度进行评估。PESQ通过听觉变换计算响度谱,将增强语音与参考语音的响度谱进行比较,得到-0.5到4.5的语音质量分数值。文献[22]中证明,PESQ与主观听力测试MOS分有较大的相关性。STOI通过计算增强语音与参考语音的短时包络之间的相关性,得到0到1的分数值,通常被用来评价增强语音的可懂度。这两种客观指标数值越高,说明增强效果越好。

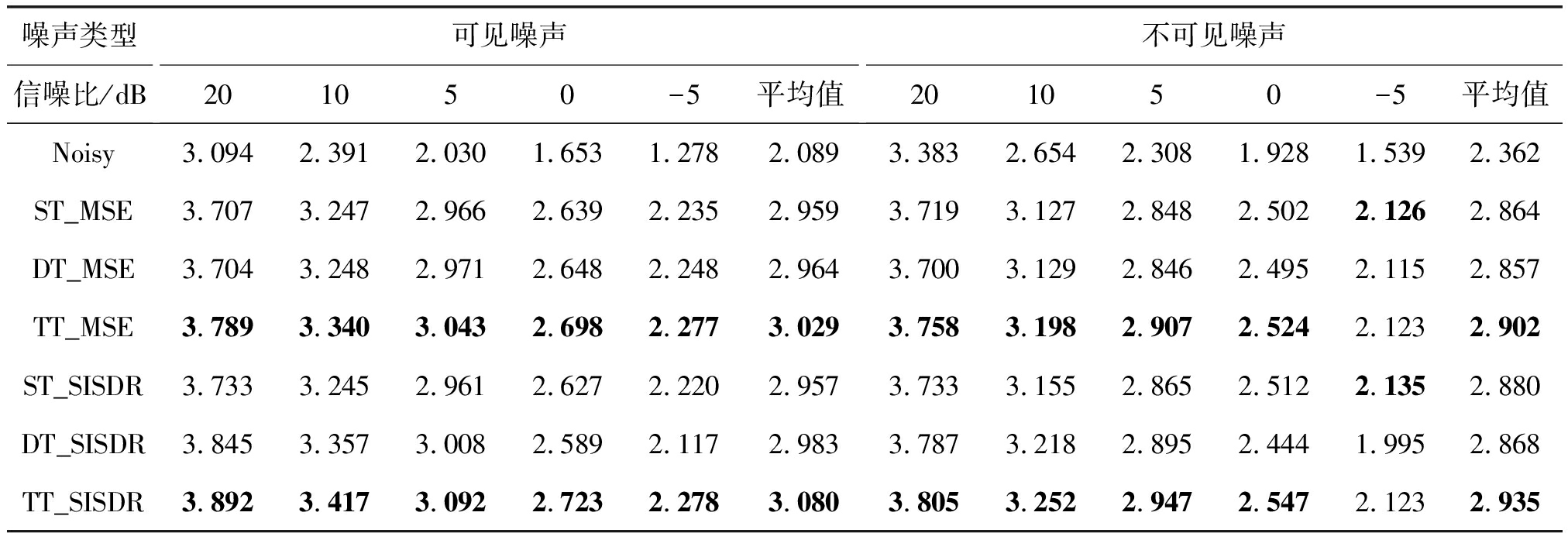

表1,给出了六种方法在可见噪声和不可见噪声下的PESQ得分结果,对每种噪声分别计算五种不同信噪比的得分均值和所有信噪比下的全局平均得分。对比ST_MSE和ST_SISDR,在可见噪声中,全局平均值没有太大差别,在20 dB的信噪比下ST_SISDR有一定的优势,在不可见噪声中,ST_SISDR在所有信噪比下呈现出轻微的提升,这个结果说明,在时域使用![]() 相比在幅度谱上使用

相比在幅度谱上使用![]() 具有一定的优势。DT_MSE对比ST_MSE整体在可见噪声会有轻微的提升,在不可见噪声则有轻微的下降,所以对于

具有一定的优势。DT_MSE对比ST_MSE整体在可见噪声会有轻微的提升,在不可见噪声则有轻微的下降,所以对于![]() 通过双目标联合优化的方法并不会对网络估计目标语音的能力产生太大影响。不过在DT_SISDR对比ST_SISDR中,在可见噪声和不可见噪声中的不同信噪比中的结果都有明显的提升或下降,DT_SISDR在高信噪比下有明显的提升,但在低信噪比下则会明显的下降。这说明在LSISDR下,双目标联合优化对网络估计目标语音可以产生一定的效果,但会导致信噪比低时性能下降。

通过双目标联合优化的方法并不会对网络估计目标语音的能力产生太大影响。不过在DT_SISDR对比ST_SISDR中,在可见噪声和不可见噪声中的不同信噪比中的结果都有明显的提升或下降,DT_SISDR在高信噪比下有明显的提升,但在低信噪比下则会明显的下降。这说明在LSISDR下,双目标联合优化对网络估计目标语音可以产生一定的效果,但会导致信噪比低时性能下降。

表1 PESQ指标评估结果

Tab.1 PESQ evaluation results

噪声类型信噪比/dB可见噪声201050-5平均值不可见噪声201050-5平均值Noisy3.0942.3912.0301.6531.2782.0893.3832.6542.3081.9281.5392.362ST_MSE3.7073.2472.9662.6392.2352.9593.7193.1272.8482.5022.1262.864DT_MSE3.7043.2482.9712.6482.2482.9643.7003.1292.8462.4952.1152.857TT_MSE3.7893.3403.0432.6982.2773.0293.7583.1982.9072.5242.1232.902ST_SISDR 3.7333.2452.9612.6272.2202.9573.7333.1552.8652.5122.1352.880DT_SISDR3.8453.3573.0082.5892.1172.9833.7873.2182.8952.4441.9952.868TT_SISDR3.8923.4173.0922.7232.2783.0803.8053.2522.9472.5472.1232.935

TT_MSE相比于ST_MSE和DT_MSE,除了在-5 dB不可见噪声外,其余条件下TT_MSE都有不同程度上的提升,尤其是在高信噪比的情况下,提升较为明显。TT_SISDR相比于ST_SISDR和DT_SISDR,在可见噪声中,所有信噪比都获得到了明显的提升,在不可见噪声下,除了-5 dB相比于ST_SISDR有轻微的下降,其余情况也是有稳定的提升,这里的结果并没有展现出DT_SISDR与ST_SISDR对比时产生高低信噪比两种方法各占优势的趋势。对比TT_SISDR和TT_MSE,在利用了所提的多目标损失函数计算策略后,可以克服信噪比低时![]() 不如

不如![]() 的情况,并且在高信噪比的条件下能更大程度的优于

的情况,并且在高信噪比的条件下能更大程度的优于![]() 的增强结果。上述结果说明,本文所提出的方法能进一步提升网络的语音增强性能,提高增强语音的语音质量。

的增强结果。上述结果说明,本文所提出的方法能进一步提升网络的语音增强性能,提高增强语音的语音质量。

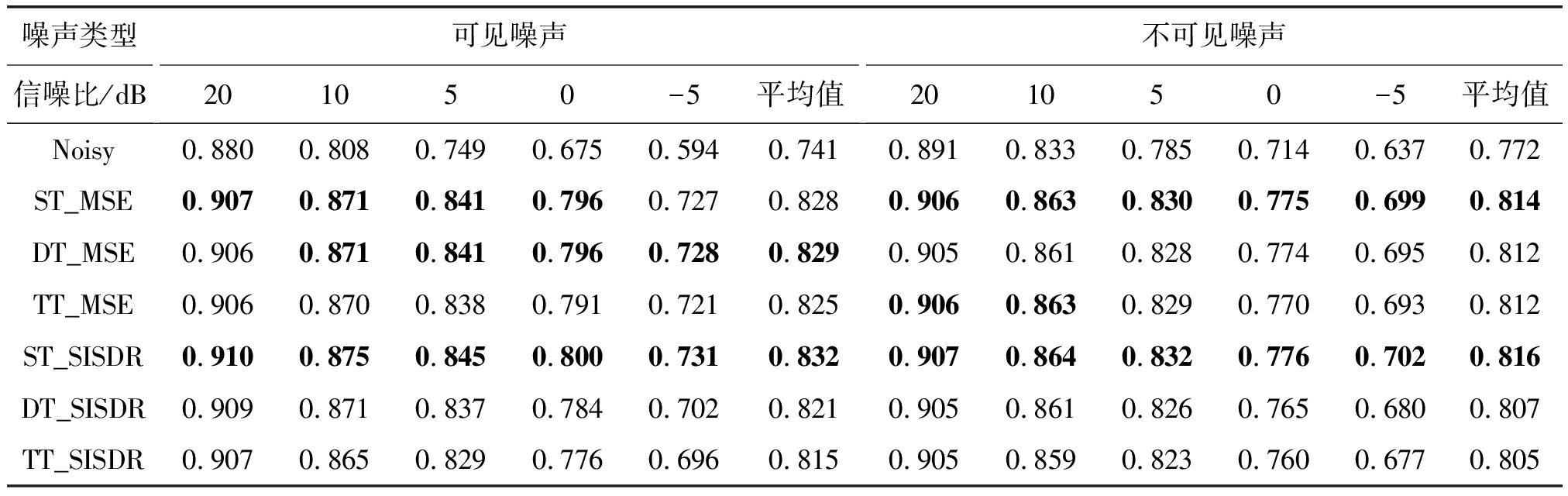

表2给出STOI得分结果。在利用![]() 时,在可见噪声和不可见噪声情况下,三种方法的结果都比较接近,但TT_MSE在低信噪比的情况下,则有一定的下降。在使用

时,在可见噪声和不可见噪声情况下,三种方法的结果都比较接近,但TT_MSE在低信噪比的情况下,则有一定的下降。在使用![]() 时,DT_SISDR和TT_SISDR在信噪比越低时,性能下降越严重,TT_SISDR下降程度比DT_SISDR更加明显,而ST_SISDR在可见和不可见噪声中都得到最好的结果。上述结果说明,所提算法在STOI指标上并没有有效的提升。

时,DT_SISDR和TT_SISDR在信噪比越低时,性能下降越严重,TT_SISDR下降程度比DT_SISDR更加明显,而ST_SISDR在可见和不可见噪声中都得到最好的结果。上述结果说明,所提算法在STOI指标上并没有有效的提升。

表2 STOI指标评估结果

Tab.2 STOI evaluation results

噪声类型信噪比/dB可见噪声201050-5平均值不可见噪声201050-5平均值Noisy0.8800.8080.7490.6750.5940.7410.8910.8330.7850.7140.6370.772ST_MSE0.9070.8710.8410.7960.7270.8280.9060.8630.8300.7750.6990.814DT_MSE0.9060.8710.8410.7960.7280.8290.9050.8610.8280.7740.6950.812TT_MSE0.9060.8700.8380.7910.7210.8250.9060.8630.8290.7700.6930.812ST_SISDR 0.9100.8750.8450.8000.7310.8320.9070.8640.8320.7760.7020.816DT_SISDR0.9090.8710.8370.7840.7020.8210.9050.8610.8260.7650.6800.807TT_SISDR0.9070.8650.8290.7760.6960.8150.9050.8590.8230.7600.6770.805

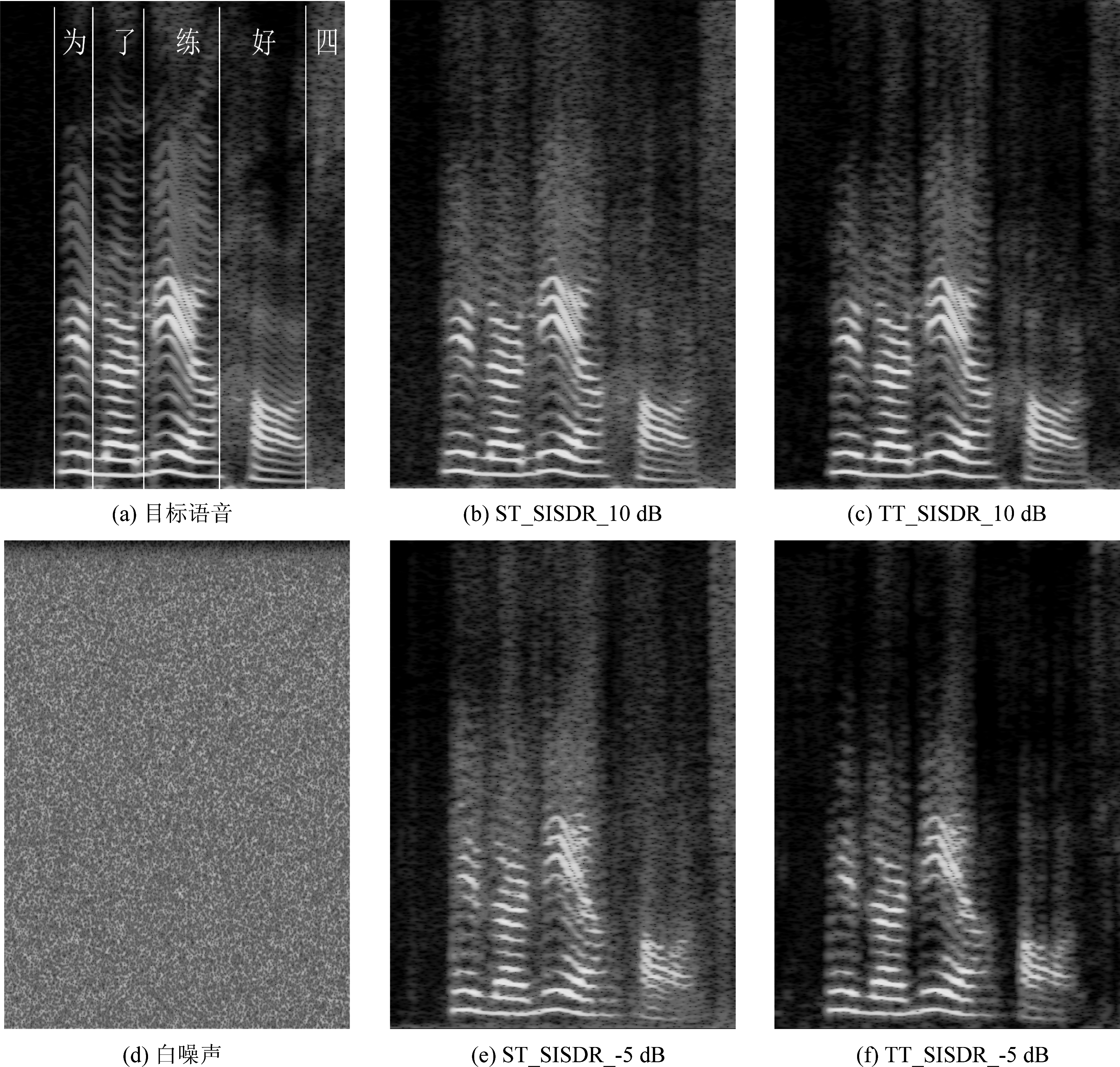

为了进一步分析得出以上结果的原因,图4给出目标语音、噪声、ST_SISDR和TT_SISDR分别对10 dB和-5 dB带噪语音的增强结果语谱图,混合噪声为白噪声。图中(b)、(c)、(e)、(f)的PESQ得分结果分别为3.212、3.376、2.221、2.288,STOI得分结果分别为0.858、0.846、0.743、0.713。图中两个增强方法降噪效果明显,但在更低的信噪比下,增强结果会造成更大的语音失真。对比两个信噪比下ST_SISDR和TT_SISDR的增强结果,可以观察到ST_SISDR的增强结果在高频区域和辅音谐波之间存在更多非目标语音能量,而TT_SISDR在清音的位置,如“四”,语音的能量则被明显的去除,在-5 dB信噪比下,“好”字的声母“h”也被基本去除。在非正式的主观听力测试中,TT_SISDR的增强结果相比于ST_SISDR可以明显感受到更少的噪声残留,并具有更舒适的听音体验,而在低信噪比条件下会感受到更多的语音失真。

图4 语谱图

Fig.4 Spectrogram

综上,本文所提双输出系统框架和多目标损失函数计算策略,能提高网络对噪声的抑制能力,在高信噪比条件下,可以获得残留噪声更少的增强结果,同时不会导致过多的语音失真。但在低信噪比条件下,噪声对语音信号有很强干扰与破坏,导致去除噪声的同时也去除更多的语音成分,尤其是清音部分,造成降噪后语音信号产生更多失真。因此,本文所提方法在要求语音质量较高、噪声残留较少的语音通话和人工耳蜗等应用中具有一定优势,而不适用于语音识别、声纹识别等对语音失真敏感的系统。

5 结论

本文在现有基于神经网络的语音增强算法基础上,提出一种新的双输出系统结构,并构造一个多目标损失函数计算策略,将目标语音、噪声和带噪语音三部分的信息加入到网络优化过程中,充分考虑目标语音、噪声、带噪语音以及三者间的关系,从而对网络输出增加更多的约束。通过实验验证,所提方法能提高网络对噪声的抑制能力,从而获得更好的语音质量。在接下来的工作中,如何提升低信噪比条件下的语音可懂度是主要研究的方向。此外,如何将网络估计的目标语音和噪声进行更合理的结合成带噪语音,使系统具有更好的增强效果,也是值得考虑的方向之一。

[1] LI Jinyu, DENG Li, GONG Yifan, et al.An overview of noise-robust automatic speech recognition[J].IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2014, 22(4): 745-777.

[2] BOLNER F, GOEHRING T, MONAGHAN J, et al.Speech enhancement based on neural networks applied to cochlear implant coding strategies[C]∥2016 IEEE International Conference on Acoustics, Speech and Signal Processing(ICASSP).Shanghai, China.IEEE, 2016: 6520-6524.

[3] BOLL S.Suppression of acoustic noise in speech using spectral subtraction[J].IEEE Transactions on Acoustics, Speech, and Signal Processing, 1979, 27(2): 113-120.

[4] SCALART P, FILHO J V.Speech enhancement based on a priori signal to noise estimation[C]∥1996 IEEE International Conference on Acoustics, Speech, and Signal Processing Conference Proceedings.Atlanta, GA, USA.IEEE, 1996: 629-632.

[5] EPHRAIM Y, VAN TREES H L.A signal subspace approach for speech enhancement[J].1993 IEEE International Conference on Acoustics, Speech, and Signal Processing, 1993, 2: 355-358.

[6] 鲍长春, 项扬.基于深度神经网络的单通道语音增强方法回顾[J].信号处理, 2019, 35(12): 1931-1941.

BAO Changchun, XIANG Yang.Review of monaural speech enhancement based on deep neural networks[J].Journal of Signal Processing, 2019, 35(12): 1931-1941.(in Chinese)

[7] XU Yong, DU Jun, DAI Lirong, et al.An experimental study on speech enhancement based on deep neural networks[J].IEEE Signal Processing Letters, 2014, 21(1): 65-68.

[8] WANG Yuxuan, NARAYANAN A, WANG Deliang.On training targets for supervised speech separation[J].IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2014, 22(12): 1849-1858.

[9] XU Yong, DU Jun, HUANG Zhen, et al.Multi-objective learning and mask-based post-processing for deep neural network based speech enhancement[C]∥Interspeech2015, 2015: 1508-1512.

[10] SUN Lei, DU Jun, DAI Lirong, et al.Multiple-target deep learning for LSTM-RNN based speech enhancement[C]∥2017 Hands-free Speech Communications and Microphone Arrays(HSCMA).San Francisco, CA, USA.IEEE, 2017: 136-140.

[11] WANG Qing, DU Jun, DAI Lirong, et al.Joint noise and mask aware training for DNN-based speech enhancement with SUB-band features[C]∥2017 Hands-free Speech Communications and Microphone Arrays(HSCMA).San Francisco, CA, USA.IEEE, 2017: 101-105.

[12] XU Yong, DU Jun, DAI Lirong, et al.Dynamic noise aware training for speech enhancement based on deep neural networks[J].Proceedings of the Annual Conference of the International Speech Communication Association, INTERSPEECH, 2014: 2670-2674.

[13] ROUX J L, WISDOM S, ERDOGAN H, et al.SDR-half-baked or well done?[C]∥ICASSP 2019-2019 IEEE International Conference on Acoustics, Speech and Signal Processing(ICASSP).Brighton,UK.IEEE,2019: 626-630.

[14] HOCHREITER S, SCHMIDHUBER J.Long short-term memory[J].Neural Computation, 1997, 9(8): 1735-1780.

[15] TU Yanhui, DU Jun, GAO Tian, et al.A multi-target SNR-progressive learning approach to regression based speech enhancement[J].IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2020, 28: 1608-1619.

[16] HU Yanxin, LIU Yun, LV S, et al.DCCRN: deep complex convolution recurrent network for phase-aware speech enhancement[C]∥Interspeech 2020.ISCA: ISCA, 2020: 2472-2476.

[17] TANG Xin, DU Jun, CHAI Li, et al.Geometry constrained progressive learning for lstm-based speech enhancement[C]∥ICASSP 2020-2020 IEEE International Conference on Acoustics, Speech and Signal Processing(ICASSP).Barcelona, Spain.IEEE, 2020: 7514-7518.

[18] GAO Tian, DU Jun, DAI Lirong, et al.Densely connected progressive learning for LSTM-based speech enhancement[C]∥2018 IEEE International Conference on Acoustics, Speech and Signal Processing(ICASSP).Calgary, AB, Canada.IEEE, 2018: 5054-5058.

[19] WANG Deliang, CHEN Jitong.Supervised speech separation based on deep learning: An overview[J].IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2018, 26(10): 1702-1726.

[20] WANG Dong, ZHANG Xuewei.Thchs-30: A free chinese speech corpus.arXiv preprint arXiv:1512.01882, 2015.

[21] VARGA A, STEENEKEN H J M.Assessment for automatic speech recognition: II.NOISEX-92: A database and an experiment to study the effect of additive noise on speech recognition systems[J].Speech Communication, 1993, 12(3): 247-251.

[22] REDDY C K A, BEYRAMI E, POOL J, et al.A scalable noisy speech dataset and online subjective test framework[C]∥Interspeech 2019.ISCA: ISCA, 2019: 1816-1820.

[23] KOLB☞K M, TAN Zhenghua, JENSEN S H, et al.On loss functions for supervised monaural time-domain speech enhancement[J].IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2020, 28: 825-838.

[24] RIX A W, BEERENDS J G, HOLLIER M P, et al.Perceptual evaluation of speech quality(PESQ)-a new method for speech quality assessment of telephone networks and codecs[C]∥2001 IEEE International Conference on Acoustics, Speech, and Signal Processing(ICASSP).Salt Lake City, UT, USA.IEEE, 2001: 749-752.

[25] TAAL C H, HENDRIKS R C, HEUSDENS R, et al.An algorithm for intelligibility prediction of time-frequency weighted noisy speech[J].IEEE Transactions on Audio, Speech, and Language Processing, 2011, 19(7): 2125-2136.