1 引言

语音增强的任务为从被噪声污染的语音信号中滤除噪声,提取干净语音,提升语音的质量与可懂度。根据麦克风数量划分,语音增强可分为多通道语音增强(多个麦克风)与单通道语音增强(单个麦克风),由于单通道语音增强方法具有结构简单、成本低廉、应用范围广、时频域能有效建模等优点,仍是国内外语音增强的重点研究方向。

早期研究一般采用传统信号处理方法来进行语音增强,如谱减法[1]、滤波法[2]以及基于最小均方误差(MMSE, Minimum mean square error)的谱估计算法[3]。谱减法即直接从含噪语音谱中减去噪声谱,估计得到增强语音谱,在平稳噪声下降噪效果较好,但面对非平稳噪声,谱减法容易将谱成分过多或过少的减去,从而造成语音失真并产生音乐噪声。滤波法能够在一定程度上处理非平稳噪声,克服了谱减法的部分问题,但其仍需对模型进行假设。不同于滤波法的是,基于MMSE的方法能够得到增强语音的非线性估计,在特定条件下有较好的处理能力。上述方法统称为基于模型的无监督语音增强方法,这类方法一般需要条件假设,对平稳和慢变噪声处理效果较好,但针对非平稳和变化明显的噪声,传统方法的增强效果会明显减弱,特别是在低信噪比下,跟踪噪声特征非常困难。

针对上述问题,有监督语音增强方法迅速发展起来。有监督语音增强采用有监督学习的方式,从大量的语音和噪声数据下学习一个数学模型,并通过该模型对含噪语音进行预测,得到增强语音。由于深度神经网络(DNN, Deep neural network)具有较强的非线性建模能力,WANG等人将其引入了语音分离和增强领域[4],相比于传统方法,分离与增强效果提升明显。2014年,XU Yong等人将含噪语音的对数功率谱(LPS, Logarithmic power spectrum)作为DNN的输入特征[5],利用DNN的非线性建模能力,构造了含噪语音LPS到纯净语音LPS的非线性映射函数,进一步提升了DNN的增强效果,值得一提的是,该方法未假设语音和噪声需满足任何前提条件,具有较强的泛化能力。在上述网络的基础上,衍生出了多种基于DNN的语音增强方法,文献[6]提出一种多目标学习方法,联合LPS以及理想比值掩蔽(IRM, Ideal ratio masking)作为DNN的学习目标,并利用语音子带特征来进行噪声感知训练,增强后的语音在质量与可懂度上都有较大提升。文献[7]结合稀疏非负矩阵分解(SNMF, Sparse non-negative matrix factorization)与DNN来进行语音增强,利用谱分解特性,能够保证清音和无结构语音部分不会引入额外失真,取得了较好的增强效果。尽管DNN在语音增强上展现出了许多优势,但其仍存在一定不足,随着神经元数量以及网络层数增加,网络参数量也会明显增加,计算开销加大,且网络训练容易陷入局部最优解和过拟合的情况,使得模型精度降低。

而近年来,卷积神经网络(CNN, Convolution neural network)迅速发展,其具有训练参数小、平移不变和对多维度数据处理能力好等优点,在图像和语音领域得到广泛应用。KYONG等人使用CNN来进行语音情感识别[8],取得了不错的效果。2015年,RONNEBERGER等人提出一种新颖的卷积神经网络(U-net)来进行图像分割[9],U-net包含编码层、中间层与解码层,其主要思想在于解码层的池化(pooling)操作用上采样来替代,为了融合高层与底层的特征信息,防止梯度消失,将高分辨率的输入(编码层)和经过上采样的输出(解码层)进行跳跃连接(Skip connection),在较小的数据集下,U-net也能取得较好的效果,这引起了语音领域的高度关注。2017年,PARK S R等人在U-net的基础上提出一种全卷积网络(FCN,Fully convolution network)[10],又称冗余卷积编解码网络(CED),该网络取消了U-net的上下采样操作与CNN的全连接层,通过调整卷积核的大小与步长来实现特征维度变化,相较于DNN与CNN,在较小网络参数的情况下取得了较多的指标提升。2018年,STOLLER D等人提出一种基于FCN的Wave-U-Net结构[11],该网络直接以语音的一维时域信号作为网络输入,并采用一维卷积的方式对输入语音进行处理,网络直接输出增强语音波形,具有较强的特征提取及处理能力,实时性较好。在前面网络的基础上,有学者对网络进行了进一步创新,PANDEY A等人搭建了一种深层的复数域卷积编解码网络[12],该网络直接估计语音的实部与虚部,重构阶段可以直接估计得到相位信息,但其存在特征训练困难的问题。

在上述的卷积编解码网络中,中间层一般只起到特征传递的作用,即将编码层提取到的抽象特征传递给解码层,对语音序列前后相关特征的处理能力有限。TAN Ke等人针对该问题提出一种卷积循环神经网络(CRN, Convolution recurrent network)[13],该网络以LSTM作为CED网络的中间层,能够更好关注语音的时序特征,对上下文关键信息进行捕获,但LSTM存在计算量大、并行性差的问题,在一定程度上影响了模型的增强效果。

针对卷积编解码网络对无法很好处理语音序列信息的问题,我们提出一种基于门控残差卷积编解码网络的语音增强方法。该方法借鉴自然语言处理[14]中的门控机制,将全卷积门控线性单元引入CED网络的中间层,同时采用膨胀卷积以及残差连接等操作来提升卷积过程的感受野与模型精度,所提方法能够更好关注语音的时序相关信息,有利于提升语音的整体质量与可懂度。同时在模型的目标函数上,采用时域评价指标与频域损失函数联合优化的策略,以进一步提升模型的增强效果。

2 系统结构

假设语音模型为:

y=s+d

(1)

其中y、s和d分别为含噪语音、干净语音和噪声的波形,表示一维向量,语音增强的任务是从y中滤除d得到尽可能干净的s。对式(1)进行短时傅里叶变换(STFT, Short time Fourier transform)到频域为:

Yn(k)exp(∠Yn(k))=Sn(k)exp(∠Sn(k))+

Dn(k)exp(∠Dn(k))

(2)

其中Yn(k)、Sn(k)、Dn(k)和∠Yn(k)、∠Sn(k)、∠Dn(k)分别为含噪语音、纯净语音和噪声在第n帧的幅度谱和相位谱向量,n为帧索引n=(1,2,…,N),k为频率索引k=(1,2,…,K),由于每一帧的频率数相同,式(2)可简写为:

Ynexp(∠Yn)=Snexp(∠Sn)+Dnexp(∠Dn)

(3)

考虑到人耳对相位信息不敏感,网络训练过程忽略相位信息,则有:

Yn=Sn+Dn

(4)

神经网络在语音增强任务中的作用可概括为:通过训练网络参数集θ构造一个含噪语音到干净语音特征空间的复杂的非线性映射函数fθ,使得其逼近真实语音,谱映射的形式为:

(5)

从而得到目标输出(增强语音幅度谱):

(6)

联合带噪音相位进行短时傅里叶逆变换(ISTFT, Inverse short time Fourier transform)得到时域增强语音:

(7)

2.1 卷积编解码网络

我们采用的基线网络为卷积编解码网络(CED),该网络采用全卷积操作,取消了上下采样以及全连接层,具体结构如图1所示。其中,网络的输入特征为含噪语音幅度谱,即时间(帧)和频率两个维度的特征图,输出为增强语音幅度谱,结合含噪语音相位可重构得到增强语音波形。总体上,网络大致可划分为三层,分别为编码层、中间层和解码层,每一层的结构及功能如下所述:

图1 基于CED网络的语音增强流程图

Fig.1 Speech enhancement flow chart based on CED network

1)编码层:编码层由5个二维卷积层组成,每个二维卷积层都包含二维卷积(2D-Conv, Two-dimension convolution)、批次归一化(BN, Batch Normalization)层以及泄露修正线性单元(LRelu, Leaky rectified linear unit)激活函数,首先对特征图进行二维卷积,然后进行批次归一化,最后通过激活函数得到每一层的输出。BN层对数据进行减均值和去相关等操作,使得卷积后的数据特征满足独立同分布假设,经研究发现,BN层有利于加快网络的收敛,防止梯度爆炸;激活函数采用LRelu,其能给负值特征添加一个斜率,保证训练过程负值特征不丢失,减少未训练单元数量;5层二维卷积(2D-Conv)逐层提取语音的幅度谱特征,每次卷积操作后,特征图在时间上保持不变、频率维度上减半、通道数翻倍,通过调整卷积核的大小、步长与数量来实现这一操作。值得注意的是,通过编码层后的特征图在时间维度上与输入特征图保持一致,这使得模型能够处理任意长度(帧长)的语音,具有较好的实时特性。

2)中间层:中间层由2个一维卷积层组成,每层都包含一维卷积(1D-Conv, One-dimension convolution)、BN层以及激活函数LRelu,一维卷积的卷积核与卷积步长都为1。卷积之前需要对编码器输出的二维张量进行调整(Reshape)降维,用以满足一维卷积的需求,同样,中间层的输出需要经过调整还原维度。整体上,中间层主要作用为特征传递。

3)解码层:解码层由5个二维反卷积层组成,每层都包含二维反维卷积(2D-Deconv, Two-dimension deconvolution)、BN层以及激活函数LRelu。2D-Deconv可以看作2D-Conv的逆过程,通过调整卷积步长即可还原特征图位置信息。同时,我们将编码层特征图输入到相同维度的解码层,通过通道拼接使得相应解码层特征图通道数扩大一倍,该操作有利于在解码过程中恢复细粒特征信息。

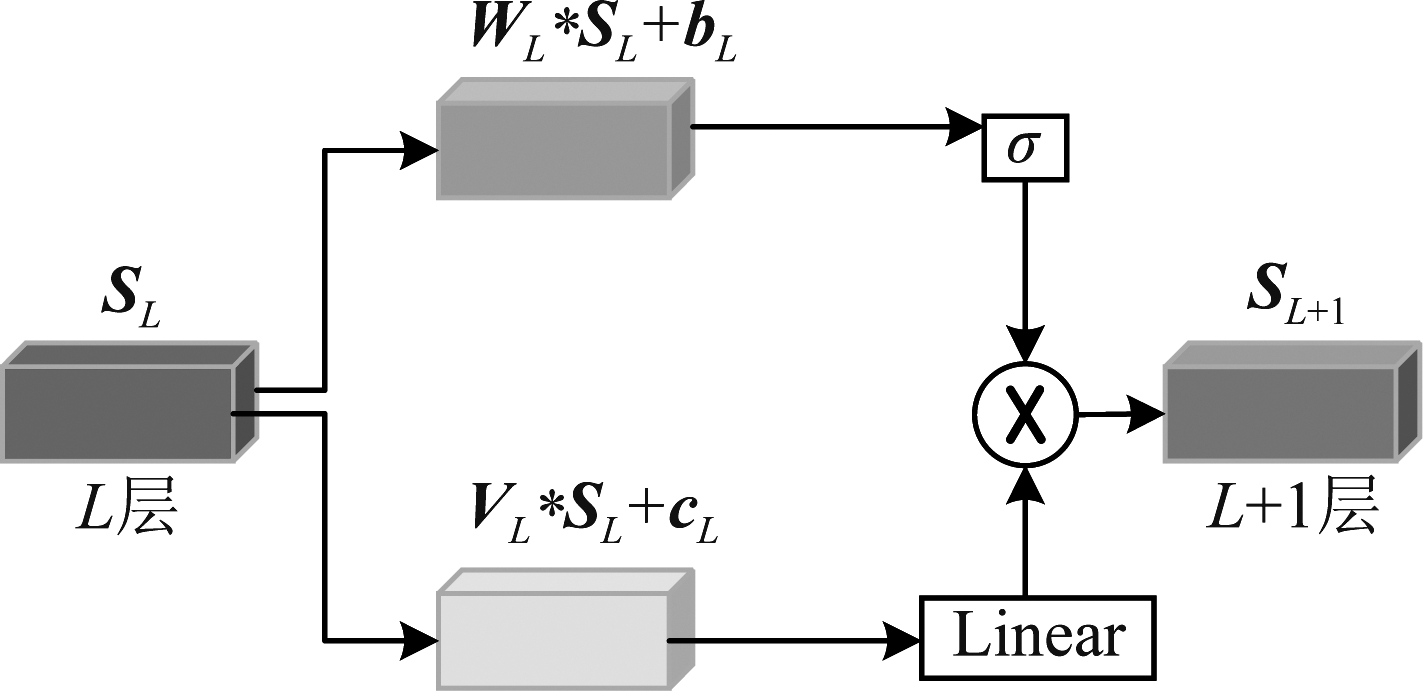

2.2 门控线性单元

由于中间的一维卷积层的主要作用为特征传递,对序列信息的处理能力有限。因此,我们采用一种门控机制来处理一维信息流,在早期研究中,一般采用基于RNN的门控机制来处理序列信息,如长短时记忆单元(LSTM,Long short-term memory)和门控循环单元(GRU, Gated recurrent unit),但其存在并行性差和计算量大的问题。针对上述问题,我们采用了一种全卷积门控线性单元(GLU, Gate linear unit)[14],如图2所示,该门控单元能够减小网络训练参数,并行性好,且能够选择性传递信息。值得注意的是,GLU中间层的两个激活函数分别为线性激活函数linear与Sigmoid(用符号σ表示,计算公式如式(9)所示),linear为梯度反向传播提供了线性路径来缓解梯度消失的问题,而Sigmoid用以维持网络的非线性特性,其取值为0到1,通过该激活函数可以关注我们所需要的语音特征同时忽略不相关的特征,GLU的表达式如式(8)所示:

图2 门控线性单元

Fig.2 Gate linear unit

SL+1=σ(WL*SL+bL)⊙(VL*SL+cL)

(8)

(9)

其中SL和SL+1分别表示第L层和第L+1层的输出特征,WL、VL、bL和cL分别表示第L层的权重和偏执,σ、*和⊙分别表示Sigmoid激活函数、卷积操作和阿达玛乘积(逐点相乘)。

2.3 一维膨胀卷积

在中间层中,我们使用了一维膨胀卷积(Dilated convolution),相比一维普通卷积,一维膨胀卷积能够获得更大的感受野(Receptive field)[23],随着膨胀率的提升,感受野往往呈指数级增长,这意味卷积过程能够获取更加丰富的语音上下文特征信息,可以更好挖掘序列中的信息依赖关系,其表达式如式(10)所示。

(10)

其中X和Y分别表示输入特征与输出特征,F和r分别表示卷积核与膨胀率,p、s、t∈Z,Z表示整数集。每层网络感受野的计算公式为:

RL+1=RL+(F-1)r

(11)

RL表示第L层卷积层的感受野,RL+1表示第L+1层卷积层的感受野。

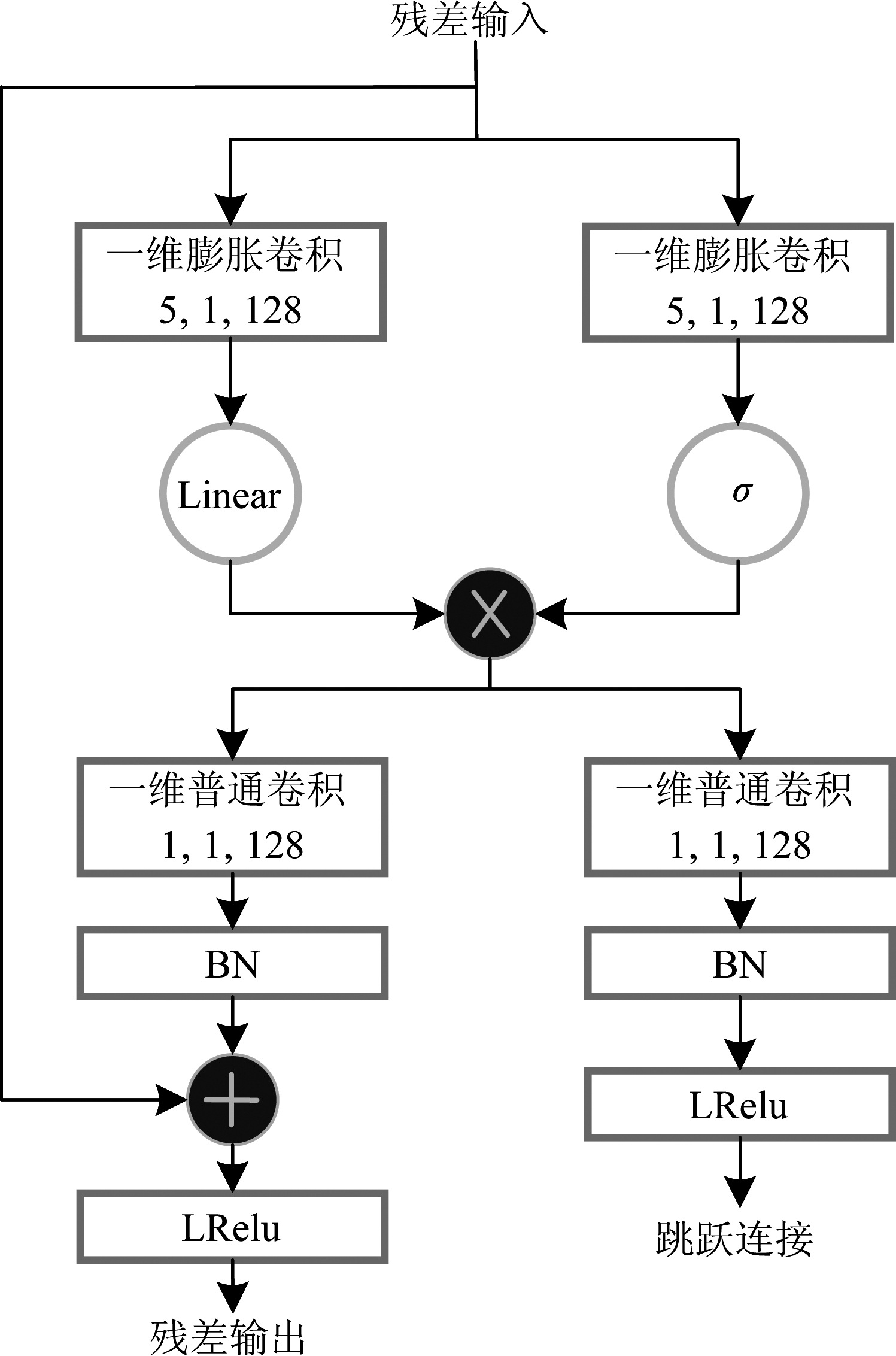

2.4 门控残差模块

残差网络能够解决深层神经网络的过拟合问题,同时还能防止梯度消失与梯度爆炸,提升模型精度,利用其优点,我们将残差网络与上述门控线性单元GLU相结合,并引入一维膨胀卷积,得到一种门控残差模块,其结构如图3所示。门控残差模块一共包含四个卷积层,上半部分相当于把GLU中的两个一维卷积替换为一维膨胀卷积,其卷积核的大小、步长与输出通道数分别为5、1和128,下半部分为两个并行的一维普通卷积层,卷积核的大小、步长与输出通道数为1、1和128,分别得到残差输出以及跳跃连接输出,由于模块输入输出的通道数一致,假设s为网络输入,F(s)为经过多个隐藏层的输出,则残差输出为o=F(s)+s。在两个一维普通卷层后,同样加入了BN层以及激活函数LRelu,用以保证模块输出特征仍然满足独立同分布假设以及保持网络的非线性特性。值得注意的是,模块中两个并行的膨胀卷积层采用同样的膨胀率,通过堆叠门控残差模块,并逐渐增大膨胀率,可以达到扩大感受野的目的。

图3 门控残差模块

Fig.3 Gate residual block

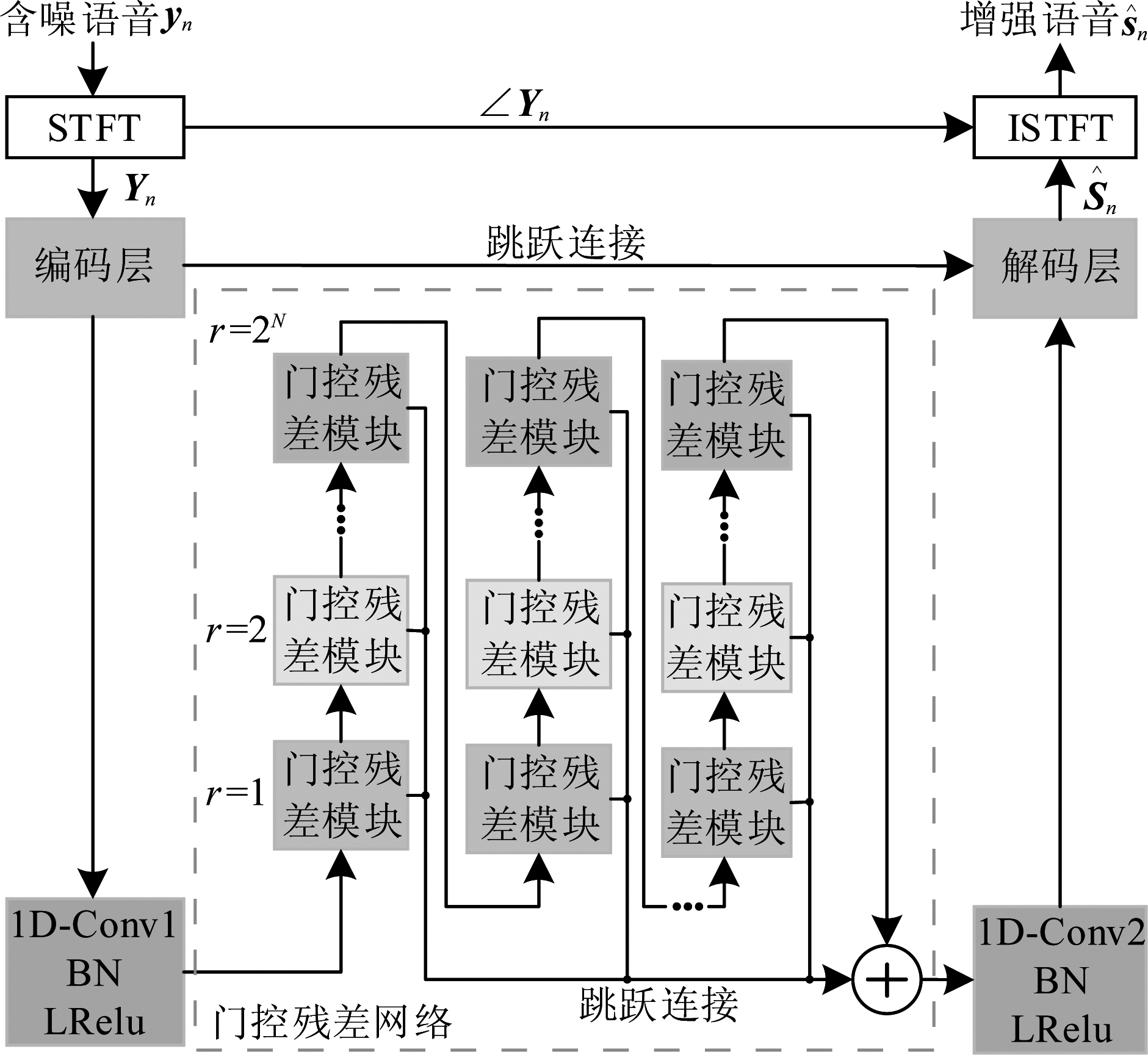

2.5 门控残差卷积编解码网络

在基线卷积编解码网络的基础上,我们将上述搭建的门控残差模块引入网络中间层,得到了一种门控残差卷积编解码网络,其网络结构如图4所示。在网络中间层中,通过将一组膨胀率r膨胀到某个最大系数2N的门控残差模块前后堆叠而形成了门控残差网络,该结构能够在较小参数量下显著提升感受野,并同时提升模型对序列信息的处理能力,更好地关注时序相关特征[15]。此外,门控残差网络中使用了跳跃连接,这允许网络将对应层级提取的特征合并(Add)到最终预测之中。值得注意的是,受文献[16]启发,我们通过卷积层来实现ISTFT,从而使得时域增强语音能够参与网络训练,且原始时域语音sn的相位能够补偿含噪语音相位并重建更加精确的时域增强语音![]()

图4 基于门控残差卷积编解码网络的语音增强流程图

Fig.4 Speech enhancement flow chart based on gated residual CED network

表1中,我们给出了网络模型具体参数设置,整体上,网络输入和输出特征维度为T×128,T表示时间帧、128表示频率维度,而第3个维度表示特征图通道数。超参数中,k表示卷积核的大小,s表示卷积步长,c表示输出通道数,r表示膨胀率。由于门控残差模块的输入输出维度保持不变,具有很好的可移植特性,可以根据模型需求来添加模块数量,通过实验对比,本文门控残差网络由15个门控残差模块组成,具体由3组膨胀率r分别为1、2、4、8、16的门控残差模块叠加得到(相同颜色模块膨胀率相同)。最后,选择合适的损失函数训练得到最优网络模型,通过网络映射得到增强语音幅度谱![]() 结合人耳对相位信息不敏感的特性,利用含噪语音相位∠Yn重构得到时域增强语音

结合人耳对相位信息不敏感的特性,利用含噪语音相位∠Yn重构得到时域增强语音![]()

表1 网络模型参数

Tab.1 Network model parameters

模块输入维度输出维度超参数Reshape1T×128T×128×1-编码层T×128×1T×4×64k=3×3, s=1×2, c=4、 8、 16、 32、 64Reshape2T×4×64T×256-1D-Conv1T×256T×128k=1, s=1, c=128门控残差网络T×128T×128k=5, s=1, c=128k=1, s=1, c=128}×15, (r=1, 2, 4, 8, 16)×31D-Conv2T×128T×256k=1, s=1, c=256Reshape3T×256T×4×64-解码层T×4×64T×128×1k=3×3, s=1×2, c=32、 16、 8、 4、 1Reshape4T×128×1T×128-

2.6 损失函数

本文网络采用小批量梯度下降法进行训练。由于频域损失能够更好关注语音的时频相关特征,我们在解码层输出端计算了频域损失,经文献[17]的实验证明,平均绝对值误差函数(MAE, Mean absolute error)在改善语音质量和可懂度方面表现更好,基于MAE的频域损失函数表达式为:

(12)

其中‖·‖表示向量的范数,Sn与![]() 分别表示第n帧原始语音与增强语音幅度谱向量,M表示批处理大小。

分别表示第n帧原始语音与增强语音幅度谱向量,M表示批处理大小。

由于语音客观评价指标的计算公式与网络训练损失函数具有一定差异,可能会存在损失函数与评价指标失配的问题,即当损失函数下降到一定程度,部分评价指标可能不会继续变化[18]。针对上述问题,提出了以语音评价指标作为网络损失函数,能够在一定程度上进一步提升语音增强效果,根据文献[19],若采用语音评价指标——比例不变信号失真比(SI-SDR, Scale-invariant signal-to-distortion ratio)作为网络的训练函数,增强语音的客观指标提升明显,SI-SDR的计算公式为:

(13)

sn与![]() 分别表示第n帧原始语音与增强语音波形,α为纯净语音的加权因子,计算公式为:

分别表示第n帧原始语音与增强语音波形,α为纯净语音的加权因子,计算公式为:

(14)

把式(14)代入式(13)可得SI-SDR的优化函数:

LSI-SDR=-SI-SDR=

![]()

(15)

LSI-SDR采用时域信号计算,其同时利用了含噪语音与纯净语音的相位信息,能够进一步优化网络权值,减小幅度谱的偏移。利用频域MAE与时域SI-SDR的优点,我们对MAE与SI-SDR进行联合优化,采用平衡因子γ对两个函数进行平衡,最终网络优化函数为(Joint):

LJoint=γLMAE+(1-γ)LSI-SDR,0≤γ≤1

(16)

其中平衡因子γ通过实验比较取得,通过最小化优化函数更新网络梯度并将误差传递至网络各层,从而更新迭代网络的权值参数与偏置量。

3 实验及结果分析

3.1 数据集及参数设置

本文训练集的纯净语音选自TIMIT语料库中的800条不同说话人语音,其中男女声各占一半。训练噪声选自Noise92噪声库以及一些常见环境噪声,共10种,分别为Factory1、Babble、White、Pink、Tank、Office、Street、Car、Machinegun、Buccaneer1。含噪语音由等长的纯净语音与噪声按不同信噪比混合得到,将800条纯净语音与10种噪声按7种信噪比(-9 dB、-6 dB、-3 dB、0 dB、3 dB、6 dB、9 dB)混合得56000条含噪语音,全部的含噪语音作为训练集,以训练集的10%作为验证集,每个轮次后,通过验证集来验证性能。

为了评估模型的增强效果,我们构建了不同的测试集。测试集的纯净语音选自TIMIT语料库中的另外200条不同说话人语音,男女声各占一半,测试噪声选用6种匹配噪声(参与训练的噪声,分别为Factory1、Babble、White、Pink、Street、Car)和4种不匹配噪声(未参与训练的噪声,分别为F16、Factory2、Volvo、Restaurant)。将200条纯净语音与6种匹配噪声按4种信噪比(-5 dB、0 dB、5 dB、10 dB)混合得到4800条含噪语音作为匹配噪声测试集。此外,为了评估模型的泛化能力,将4种不匹配噪声与上述200条纯净语音按4种信噪比混合得到3200条含噪语音,令其作为不匹配噪声测试集。

实验中,语音和噪声波形的采样频率为8 kHz,短时傅里叶变换的帧长为31.875 ms,即255个采样点,帧移为8 ms,由于STFT后的频谱具有共轭对称性,则采用一半的频谱来减少计算量,这使得每帧语音频率维度为128,然后通过维度重塑,得到维度为T×128×1的含噪语音幅度谱作为编码层的输入特征。

本文网络模型通过Keras在Tensorflow后端进行搭建,对网络进行有监督式训练,联合频域损失函数MAE和时域评价指标SI-SDR作为网络优化函数,采用小批量梯度下降法来更新网络权值参数,批处理大小为32,使用Adam作为网络优化器,初始学习率为0.001。

3.2 评价指标及对比方法

我们采取3种指标对语音进行客观评估。采用国际电联ITU-T推荐的语音质量感知评价(PESQ, Perceptual evaluation of speech quality)来衡量语音质量[20],其得分区间为[-0.5,4.5],得分越高语音质量越高,该客观指标能够很好近似主观听觉效果;采用短时客观可懂度(STOI, Short time objective intelligibility)衡量语音可懂度[21],其得分区间为[0,1],得分越高语音被理解的概率越大;采用SI-SDR衡量语音的失真程度[22],得分越高语音失真越小。

实验部分采用2.1节中的卷积编解码网络CED为基线网络,以CNN[8]方法和CRN[13]方法作为对比方法。CED对应层级参数设置与表1相同,CNN包含三个卷积层、三个最大池化层、两个全连接层,CRN即在CED的基础上把中间层替换为3层单向LSTM。CNN与CRN的具体参数与训练方式遵循原论文设置,基线CED与本文方法(Propose)的训练方式保持一致。所有方法均使用本文的数据集来进行训练和测试。

3.3 结果对比及性能分析

图5为10种测试噪声下本文网络在联合优化函数(Joint)的不同γ取值下得到的增强语音的PESQ均值。对比图5可知,不同的γ取值能够对模型的增强效果产生一定影响,γ=0表示仅采用频域MAE对网络训练,γ=1表示仅采用时域SI-SDR对网络训练,对比可看出,时域SI-SDR在语音质量上的表现要优于频域MAE,PESQ约提升了0.04~0.05。此外,联合SI-SDR与MAE后,网络指标进一步提高,这体现了本文联合优化策略的有效性,且当γ=0.3时,网络取得了相对更高的PESQ,因此我们把γ设置为0.3。

图5 目标函数的不同γ取值对增强语音的PESQ均值影响

Fig.5 The effect of different γ values of the objective function on the mean PESQ of enhanced speech

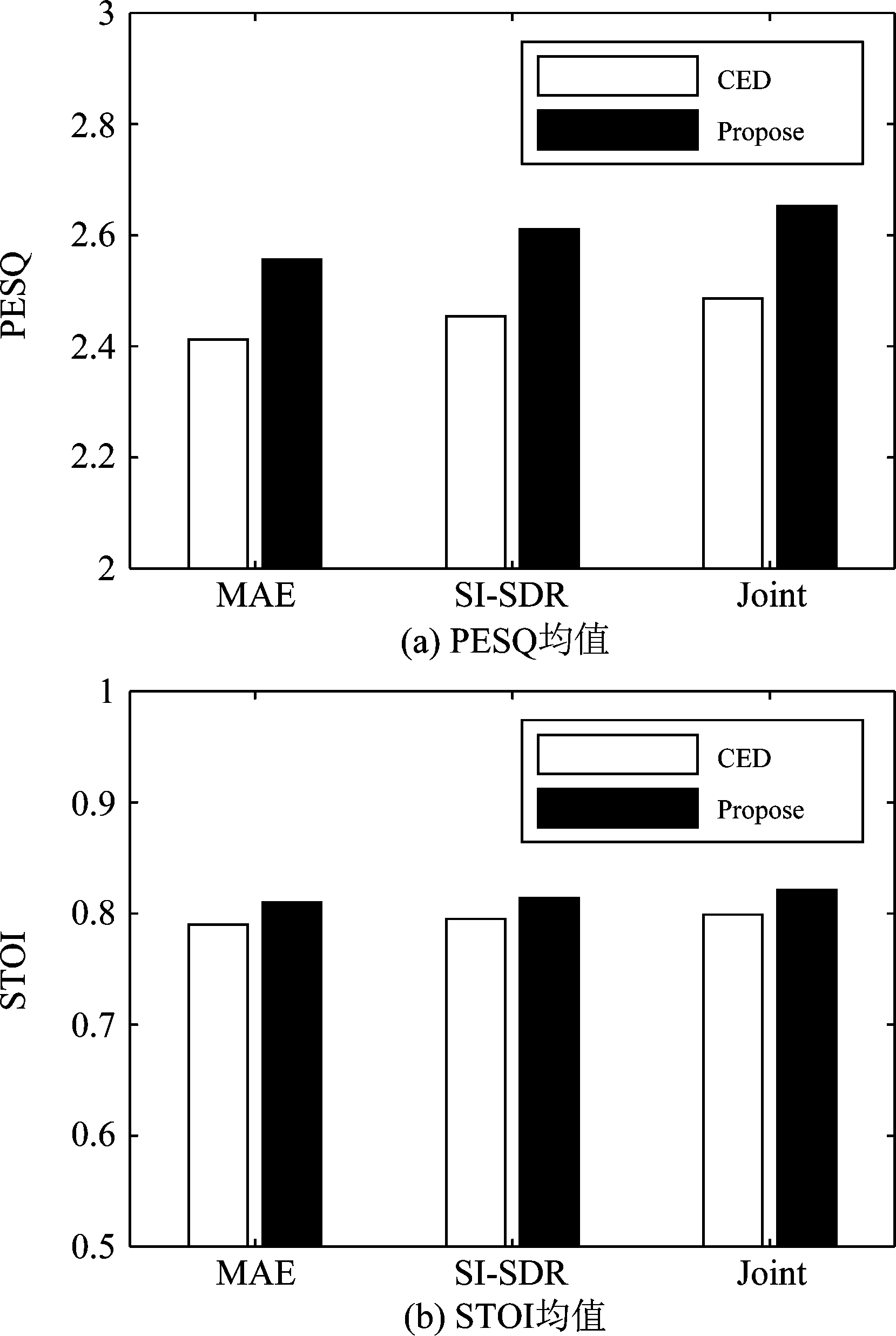

图6为基线CED与本文方法(Propose)在优化函数MAE、SI-SDR与Joint下得到的增强语音的PESQ与STOI(PESQ、STOI为10种测试噪声与4种信噪比下的均值)。由图6可看出,无论在何种优化函数下,本文方法都能取得优于基线CED的PESQ和STOI,这说明门控残差模块以及门控残差网络的应用促进了网络性能提升,使得网络能够捕获更多整体语音特征,且基线CED在各优化函数下的增强效果依然遵循图5所得结论,因此基线CED同样采用联合优化函数Joint。

图6 基线CED与本文方法在优化函数MAE、SI-SDR与Joint下得到的增强语音的PESQ与STOI均值

Fig.6 The PESQ and STOI mean values of enhanced speech obtained under the optimized functions MAE, SI-SDR and Joint of the baseline CED and the Propose method

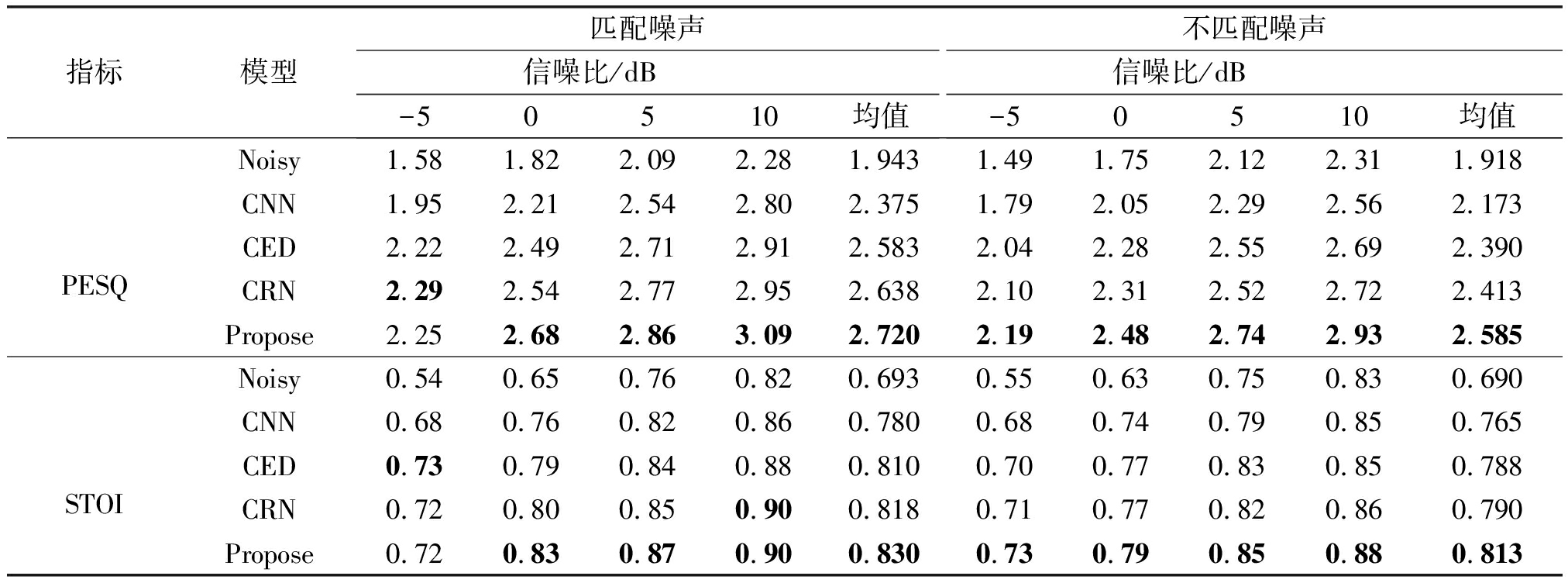

表2为匹配噪声和不匹配噪声下各对比方法在各信噪比下的平均PESQ和STOI。对比表2可知,在匹配噪声下,CNN的取得的指标要低于CED、CRN与本文方法,其增强效果有限。相比于基线CED方法,本文方法的指标得到全面提升,PESQ均值约提升了0.137,STOI均值提升了0.02,这说明本文网络对噪声的抑制效果较好,增强语音具有较高的质量与可懂度,但在-5 dB时,CED取得了更高的STOI,这说明低信噪比下本文方法对语音可懂度的改善有限。相比于CRN方法,本文方法在高信噪比下的PESQ提升较多,但在低信噪比下,CRN取得的PESQ略高于本文方法,这说明低信噪比下CRN与本文网络的降噪能力接近,同时我们发现,-5 dB与10 dB时,CRN与本文方法取得了相同的STOI,但在0 dB与5 dB时,本文方法的STOI取得较多领先,这说明在面对中等强度的噪声干扰时,本文方法对语音的增强效果更好,分析原因,可能是在这几种信噪比下,本文网络对语音序列相关信息的捕获能力更强,学习了更加丰富的语音特征。

表2 各方法的平均PESQ和STOI

Tab.2 The average PESQ and STOI of different methods

指标模型匹配噪声信噪比/dB-50510均值不匹配噪声信噪比/dB-50510均值PESQNoisy1.581.822.092.281.9431.491.752.122.311.918CNN1.952.212.542.802.3751.792.052.292.562.173CED2.222.492.712.912.5832.042.282.552.692.390CRN2.292.542.772.952.6382.102.312.522.722.413Propose2.252.682.863.092.7202.192.482.742.932.585STOINoisy0.540.650.760.820.6930.550.630.750.830.690CNN0.680.760.820.860.7800.680.740.790.850.765CED0.730.790.840.880.8100.700.770.830.850.788CRN0.720.800.850.900.8180.710.770.820.860.790Propose0.720.830.870.900.8300.730.790.850.880.813

在不匹配噪声下,各对比方法的指标均有一定下降,但经对比发现,本文方法指标下降较少,PESQ均值下降了0.135(4.96%)、STOI均值下降了0.017(2.05%),而CRN的PESQ均值下降了0.225(8.53%)、STOI均值下降了0.028(3.42%),且相较于CNN与基线CED方法,本文方法的平均PESQ和STOI都取得明显领先,这说明本文方法的泛化能力较强,具有更好的鲁棒性。

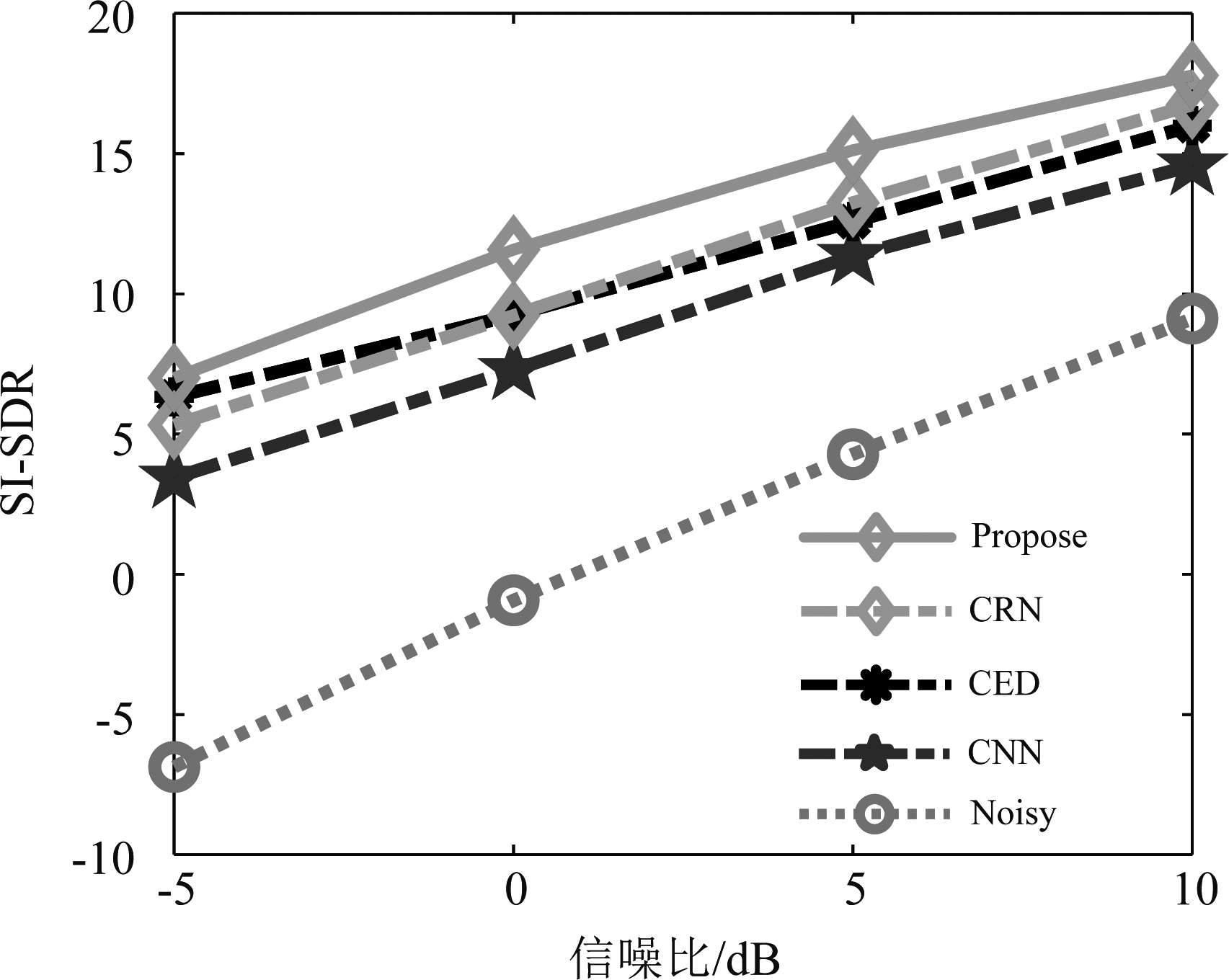

图7为十种测试噪声下各方法在四种信噪比下的平均SI-SDR。对比图7可知,在低信噪比下,本文方法的SI-SDR得分与其他几种方法接近,但在高信噪比下,SI-SDR取得了较为明显的提升,这说明本文方法得到的增强语音失真更小,对语音有较好的恢复效果。

图7 十种测试噪声下各方法在四种信噪比下的平均SI-SDR

Fig.7 The average SI-SDR of different methods in four SNR under ten test noises

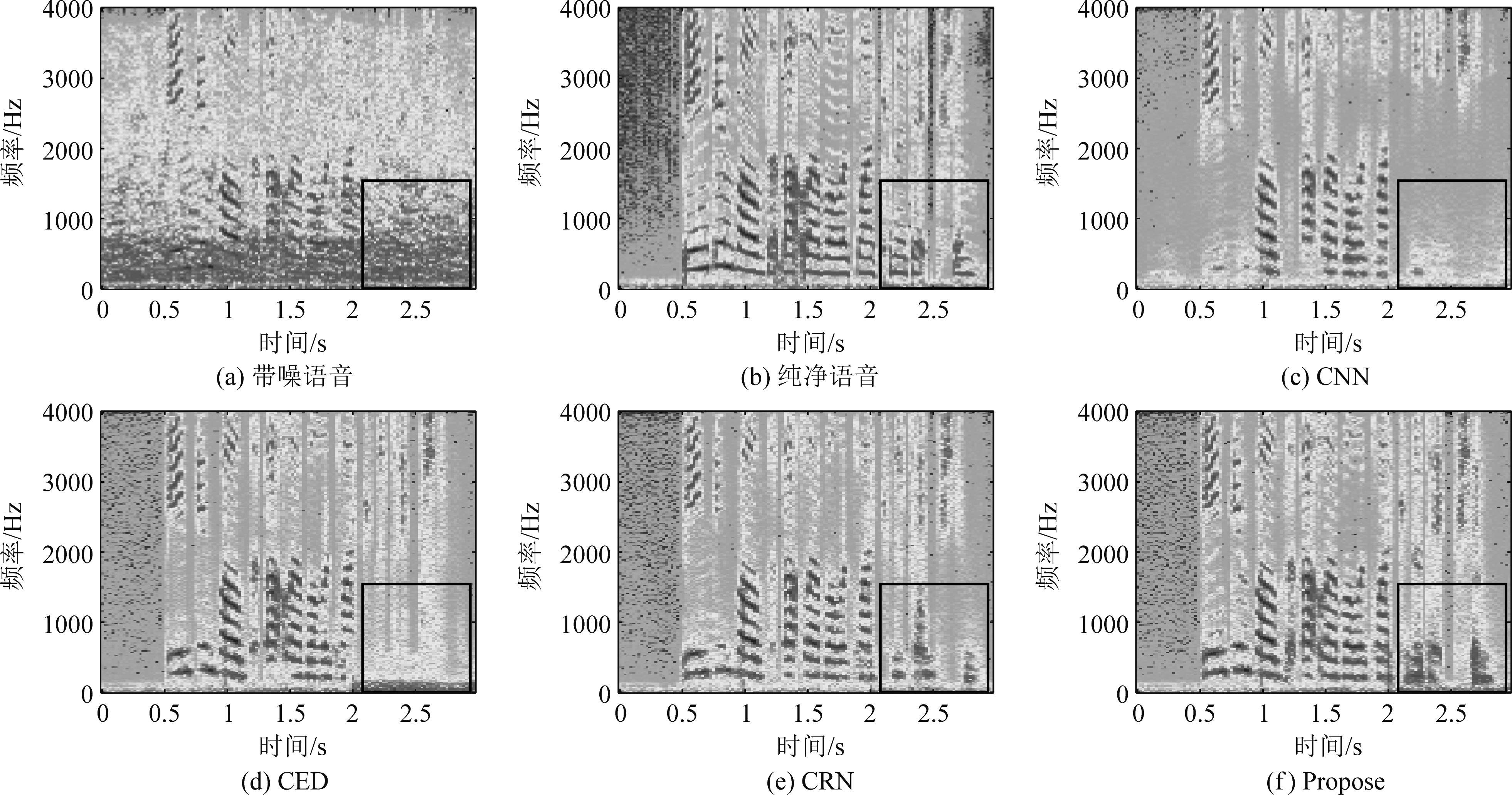

为了更直观的比较各方法的增强效果,我们对比了各方法的语谱图(0 dB的babble噪声下得到),如图8所示。对比可知,CNN恢复了部分浊音成分,但清音部分恢复较差,存在一定背景噪声,相比于CNN,CED对语音成分恢复和降噪效果更为明显,但仍有部分语音难以恢复,语音的谐波成分保留较少,而CRN在CED的基础上进一步提升了增强效果,清浊音部分都能得到有效恢复。相比于以上方法,本文方法明显恢复了更多语音成分,保留了更多谐波特征,同时对噪声的抑制效果更好。

图8 语谱图

Fig.8 Spectrogram

4 结论

本文在卷积编解码网络的基础上进行了改进,引入了门控机制、膨胀卷积以及残差连接,搭建了一种新的网络结构,该网络保留原来网络特性的同时能够更好地捕获语音时序相关信息,同时采用损失函数与评价指标联合优化的策略,进一步提升网络增强效果。实验部分,对比了本文方法与基线CED、CNN以及CRN方法的客观评价指标。结果表明,本文方法能够取得更高的平均PESQ、STOI和SI-SDR,在语音成分的恢复以及噪声抑制上,本文方法取得了明显优势,且具有相对较强的泛化能力,增强语音具有较高的质量与可懂度。

在后续研究中,还需进一步调整中间层门控残差模块的结构以及数量,用以保证在较小参数量的情况下最大化提升网络增强效果,此外,可以进一步优化网络目标函数,提升其在语音客观评价指标上的表现。

[1] MIYAZAKI R, SARUWATARI H, INOUE T, et al.Musical-noise-free speech enhancement based on optimized iterative spectral subtraction[J].IEEE Transactions on Audio, Speech, and Language Processing, 2012, 20(7): 2080-2094.

[2] WIENER N.Extrapolation, interpolation, and smoothing of stationary time series[M].Cambridge, MA, USA: The MIT Press, 1949.

[3] KIRUBAGARI B, PALANIVEL S, SUBATHRA N.Speech enhancement using minimum mean square error filter and spectral subtraction filter[C]∥International Conference on Information Communication and Embedded Systems(ICICES2014), Chennai, India, 2014: 1-7.

[4] WANG Yuxuan, WANG Deliang.Boosting classification based speech separation using temporal dynamics[C]∥Proc of the 13th Annual Conf of the Int Speech Communication Association.Grenoble,France:ISCA,2012:1528-1531.

[5] XU Yong, DU Jun, DAI Lirong, et al.An experimental study on speech enhancement based on deep neural networks[J].IEEE Signal Processing Letters, 2014, 21(1): 65-68.

[6] WANG Qing, DU Jun, DAI Lirong, et al.Joint noise and mask aware training for DNN-based speech enhancement with SUB-band features[C]∥2017 Hands-free Speech Communications and Microphone Arrays(HSCMA).San Francisco,CA,USA.IEEE,2017: 101-105.

[7] 时文华,倪永婧,张雄伟,等.联合稀疏非负矩阵分解和神经网络的语音增强[J].计算机研究与发展,2018,55(11):2430-2438.

SHI Wenhua, NI Yongjing, ZHANG Xiongwei, et al.Speech enhancement combined with sparse non-negative matrix factorization and neural network[J].Computer Research and Development, 2018, 55(11): 2430-2438.(in Chinese)

[8] KYONG H L, DO H K.Design of a convolutional neural network for speech emotion recognition[C]∥2020 International Conference on Information and Communication Technology Convergence(ICTC), 2020: 1332-1335.

[9] RONNEBERGER O, FISCHER P, BROX T.U-net: Convolutional networks for biomedical image segmentation[C]∥Medical Image Computing and Computer-Assisted Intervention-MICCAI 2015: 234-241.

[10] PARK S R, LEE J W.A fully convolutional neural network for speech enhancement[C]∥Interspeech 2017.ISCA: ISCA, 2017: 1993-1997.

[11] STOLLER D, EWERT S, DIXON S.Wave-u-net: A multi-scale neural network for end-to-end audio source separation[J].arXiv preprint arXiv:1806.03185, 2018.https:∥arxiv.org/abs/1806.03185.

[12] PANDEY A, WANG Deliang.A new framework for CNN-based speech enhancement in the time domain[J].IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2019, 27(7): 1179-1188.

[13] TAN Ke, WANG Deliang.A convolutional recurrent neural network for real-time speech enhancement[C]∥Interspeech 2018.ISCA: ISCA, 2018: 1405-1408.

[14] DAUPHIN Y N, FAN A, AULI M, et al.Language modeling with gated convolutional networks[C]∥International Conference on Machine Learning.PMLR, 2017: 933-941.http:∥proceedings.mlr.press/v70/dauphin17a.

[15] OORD A V D, DIELEMAN S, ZEN H, et al.WaveNet: A generative model for raw audio[J].arXiv preprint arXiv:1609.03499v2.2016.https:∥arxiv.org/abs/1609.03499.

[16] VENKATARAMANI S, HIGA R, SMARAGDIS P.Performance based cost functions for end-to-end speech separation[C]∥2018 Asia-Pacific Signal and Information Processing Association Annual Summit and Conference(APSIPA ASC), 2018: 350-355.

[17] PANDEY A, WANG Deliang.On adversarial training and loss functions for speech enhancement[C]∥2018 IEEE International Conference on Acoustics, Speech and Signal Processing(ICASSP).Calgary, AB, Canada.IEEE, 2018: 5414-5418.

[18] FU S W, WANG Taowei, TSAO Y, et al.End-to-end waveform utterance enhancement for direct evaluation metrics optimization by fully convolutional neural networks[J].IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2018, 26(9): 1570-1584.

[19] KOLBAEK M, TAN Zhenghua, JENSEN S H, et al.On loss functions for supervised monaural time-domain speech enhancement[J].IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2020, 28: 825-838.

[20] ITU-T, Perceptual Evaluation of Speech Quality(PESQ), an Objective Method for End-to-End Speech Quality Assessment of Narrow-band Telephone Networks and Speech Codecs, International Telecommunications Union(ITU-T)Recommendation, 2001: 862.

[21] TAAL C H, HENDRIKS R C, HEUSDENS R, et al.An algorithm for intelligibility prediction of time-frequency weighted noisy speech[J].IEEE Transactions on Audio, Speech,and Language Processing,2011,19(7):2125-2136.

[22] ROUX J L, WISDOM S, ERDOGAN H, et al.SDR-half-baked or well done?[C]∥ICASSP 2019-2019 IEEE International Conference on Acoustics, Speech and Signal Processing(ICASSP).Brighton, United Kingdom.IEEE, 2019: 626-630.

[23] GABBASOV R, PARINGER R.Influence of the receptive field size on accuracy and performance of a convolutional neural network[C]∥2020 International Conference on Information Technology and Nanotechnology(ITNT), 2020: 1-4.