1 引言

随着互联网技术和先进算法模型的不断发展,并行计算能力的不断提升,人工智能(Artificial Intelligence,AI)领域经历了从符号主义到连接主义,再到认知科学的演化过程[1]。AI也不再拘泥于机械的认知、感知和控制等功能,而是要像人脑一样利用信息、理解信息,其中场景理解(Scene Understanding)是AI领域在未来的研究热点之一。场景理解中应用最为广泛的是视觉场景理解(Visual Scene Understanding,VSU)和声学场景理解(Acoustic Scene Understanding,ASU),两者往往配合使用,相辅相成,如文献[2]中将置于听觉皮层内的听觉信息和视觉的亮度信息融合,提高场景分析算法性能。ASU是根据声学场景内容,识别其所对应的场景语义标签,达到理解周边环境的目的。

音频场景识别(Audio Scene Recognition,ASR)是ASU极为关键的环节[3],它是实现ASU的前提和基础,也是AI领域重要的研究方向之一。ASR通过音频信息判断环境类别,指导机器感知环境动态,它是处理、分析和应用音频信息的关键技术之一。ASR广泛应用于动植物保护和研究[4-6]、机器人和导航系统[7]、噪声源监测与识别[8]、音频检索[9]和地形分类[10]等领域。

近年来,随着并行计算能力的不断提升,深度神经网络在音频场景识别领域表现出卓越的性能,如卷积神经网络(Convolutional Neural Networks,CNN)[11-12]和长短时记忆网络(Long Short Term Memory Network,LSTM)[13-14],现已被广泛使用。传统深度学习算法在ASR领域取得一定效果后难以继续提升,因此,科研人员将深度学习算法和机器学习算法结合起来并融合多种优化机制来改善识别效果。例如,文献[15]首先运用生成对抗网络对实验数据进行增强,之后用一维深度卷积神经网络和与梅尔滤波器组特征集成的二维全卷积神经网络对音频场景分类,取得了不错的效果;文献[16]运用多任务学习和循环神经网络结合的算法对说话人的语音情感进行识别,在汉语和阿拉伯语中表现出较好的性能;文献[17]中的CNN网络融合梯度向量机算法生成新的模型对音频场景进行分类,取得了不错的效果;文献[18]把从语音中提取的FBANK特征作为输入,训练基于双向长短时记忆网络(BiLSTM)模型对民航陆空通话进行识别,取得了较好的效果;文献[19]中的胶囊网络融入了注意力机制,音频中重要时间帧的关注度通过加权得以实现,提高了家庭活动的识别率。综上所述,融合多优化机制的深度学习算法已经具备较为完整的理论框架,能够有效地提升识别率,在ASR领域大有用武之地。

本文拟采用CNN和双向门控循环单元(Bidirectional Gated Recurrent Unit,Bi-GRU)网络[20]构建基本并行框架[21-22],再融合批标准化机制(Batch Normalization,BN)[23]和分层注意力机制网络(Hierarchical Attention Networks,HAN)[24]生成模型解决音频场景识别问题,我们称之为基于多优化机制的并行卷积循环神经网络(Paralleling Convolutional Recurrent Neural Network,PCRNN)模型。

2 多优化机制下的深度神经网络模型

2.1 并行卷积循环神经网络框架

CNN是高效的深度神经网络模型,由卷积层、池化层等构成,它以特定大小的卷积核作用于局部区域从而获得其特征信息,能够有效地利用输入数据的二维结构处理音频信号。CNN在利用空间局部特性提取音频信号特征的同时,通过参数共享和稀疏交互等操作,尽可能减少算法的复杂度,提升算法效能。在多层卷积之间,某一层的特征映射(feature map)与其相邻层的卷积核进行卷积运算,之后其输出与偏置(bias)相加,再经激活函数运算后作为本层的输出特征映射。如公式(1)和(2)所示:

(1)

(2)

上式中,![]() 和

和![]() 表示卷积核的输入和输出,*表示卷积运算,f()为激活函数。

表示卷积核的输入和输出,*表示卷积运算,f()为激活函数。

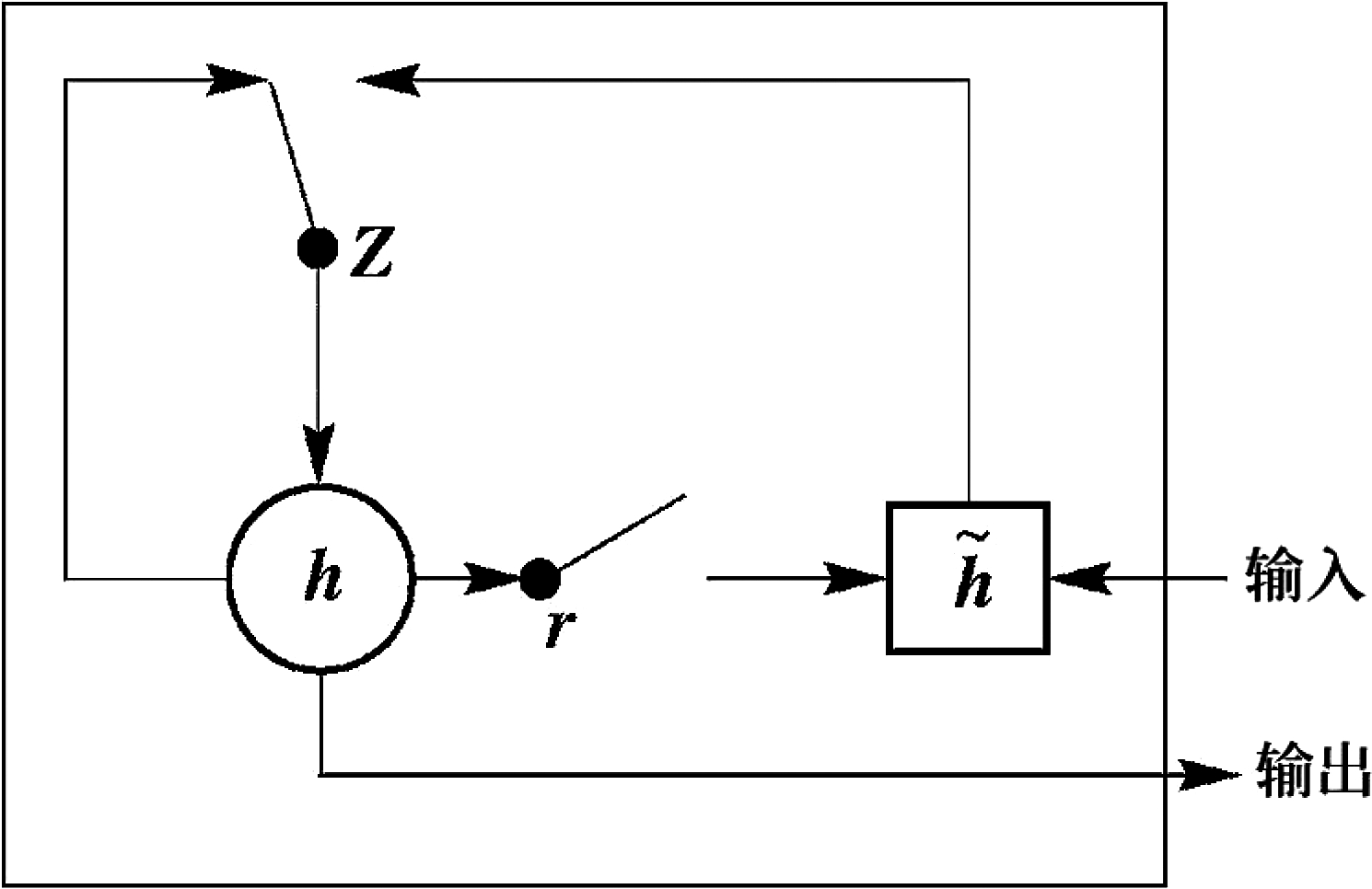

普通的循环神经网络(Recurrent Neural Network,RNN)[25]在训练时序性数据的过程中易出现梯度消失的问题[26],LSTM和门控循环单元(Gated Recurrent Unit,GRU)的提出解决了这个难题,GRU与LSTM的性能相似,但其拥有更为简洁的内部结构,可以减少网络模型的参数,提升了防止过拟合的能力,更适应本文中实验需求。LSTM通过“门”结构可以增加或去除数据信息到其记忆空间的能力,而“门”结构还可以有选择性地让信息通过。LSTM由输入门、遗忘门和输出门三个门函数控制输入值、记忆值和输出值。GRU中只有更新门和重置门,结构更为简洁,如图1所示。GRU结构的计算方式如公式(3)至(6)所示:

图1 GRU结构示意图

Fig.1 The GRU structure diagram

z=σ(Uzxt+Wzht-1)

(3)

r=σ(Urxt+Wrht-1)

(4)

s=tanh(Usxt+Wh(ht-1⊗r))

(5)

ht=(1-z)⊗s+z⊗ht-1

(6)

上式中,z为更新门,r为重置门,σ表示激活函数,⊗意为向量对应元素相乘运算,s表示当前的隐藏状态,ht为最后输出状态。

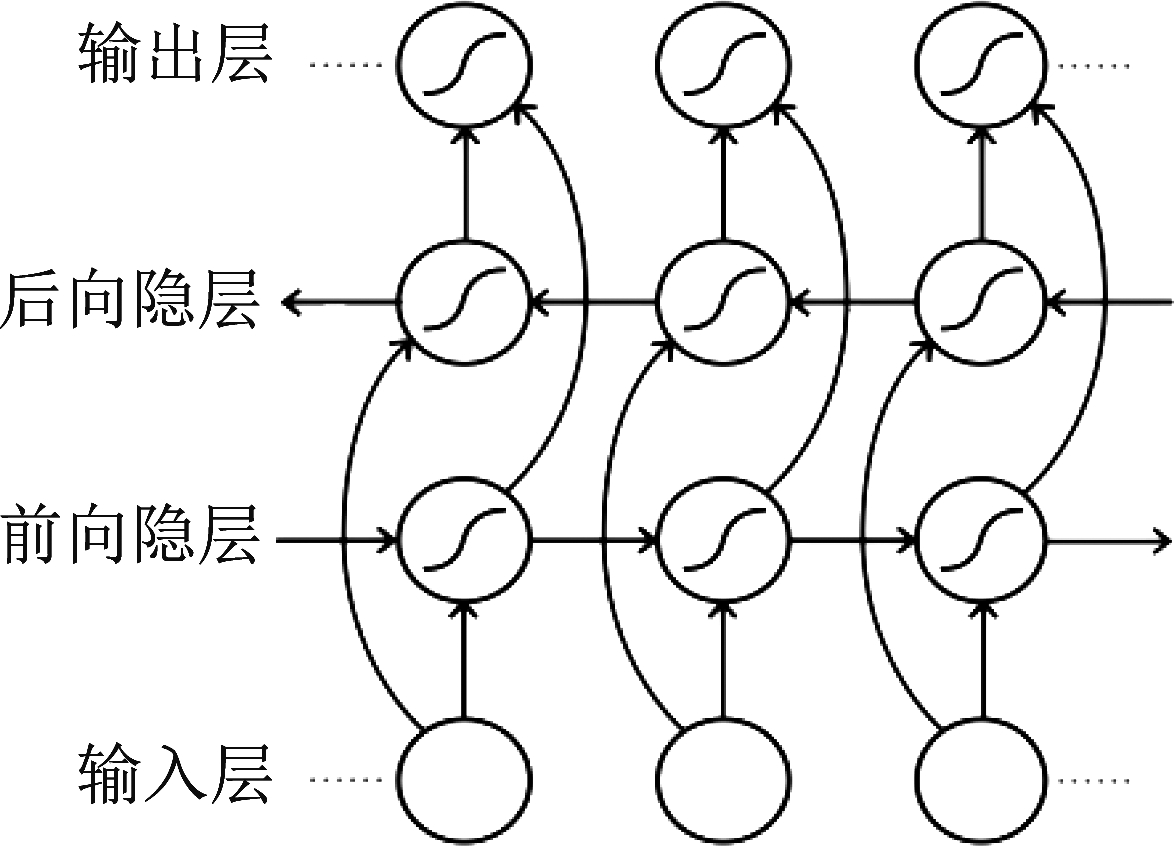

在原始的RNN网络中,状态的传输是由前向后的单向传输,而双向GRU网络结构既能使模型获取正向依赖信息,又能获取反向依赖信息,它由两个GRU网络上下堆叠构成,输出由两个GRU网络共同决定,在本实验中有良好的表现,其结构如图2所示。

图2 双向GRU结构示意图

Fig.2 The Bidirectional GRU structure diagram

2.2 批标准化机制

并行卷积循环神经网络训练数据的过程是十分复杂的。各层网络中的参数伴随着训练在不停地变化,当某一层的参数发生微小变化时,之后几层的改变会将这个微小变化逐渐积累放大,这时整个网络需要重新调整诸多参数去适应这个新的数据分布,进而影响网络训练进程。在数据训练过程中,网络中间层数据分布的变化叫做“Internal Covariate Shift”。批标准化机制能够有效地解决这一问题,它通过一定的规范化操作,把每层网络中任意神经元的输入分布变为均值为0方差为1的标准正态分布[23]。设某一层网络的输入x=(x(1),…,x(n)),维数为n,batchsize为m,样本集合A={x1,…,xm},则BN公式如(7)至(10)所示:

(7)

(8)

(9)

(10)

上式中,μA和![]() 代表样本集合A中的均值和方差,

代表样本集合A中的均值和方差,![]() 代表输入是x(k)时的标准化结果,将

代表输入是x(k)时的标准化结果,将![]() 进行线性变换后表示为y(k),和x(k)对应的待学习参数用γ(k)、β(k)表示。

进行线性变换后表示为y(k),和x(k)对应的待学习参数用γ(k)、β(k)表示。

批标准化机制极大提升了网络的训练速度,加快了模型收敛进程;而且能够降低网络对参数的敏感度,简化调参过程,使训练更加稳定;它可以提升分类性能,更适用于本文的任务。

2.3 分层注意力机制

注意力机制是人类特有的信号处理机制,人眼通过扫描全局图像,获取重点关注的目标信息,之后对这一目标投放更多的注意力资源,而抑制其余无用信息。深度学习算法中的注意力机制类似于人类的注意力机制,其本质也是从诸多信息中挑选出对当前任务更为有效的信息。场景类音频的特征向量在时间维度上的分布是不均匀的,所以对其进行建模需要考虑不同时间点的重要度。因此本文采用分层注意力机制,在给定音频特征向量后,通过赋予对不同时间帧的注意权重,让模型更“注意”那些对识别起重要作用的关键帧[24]。音频特征向量经过双向GRU网络后,获得一种新的表示为hit,注意力机制的流程如公式(11)至(13)所示:

uit=tanh(Wωhit+bω)

(11)

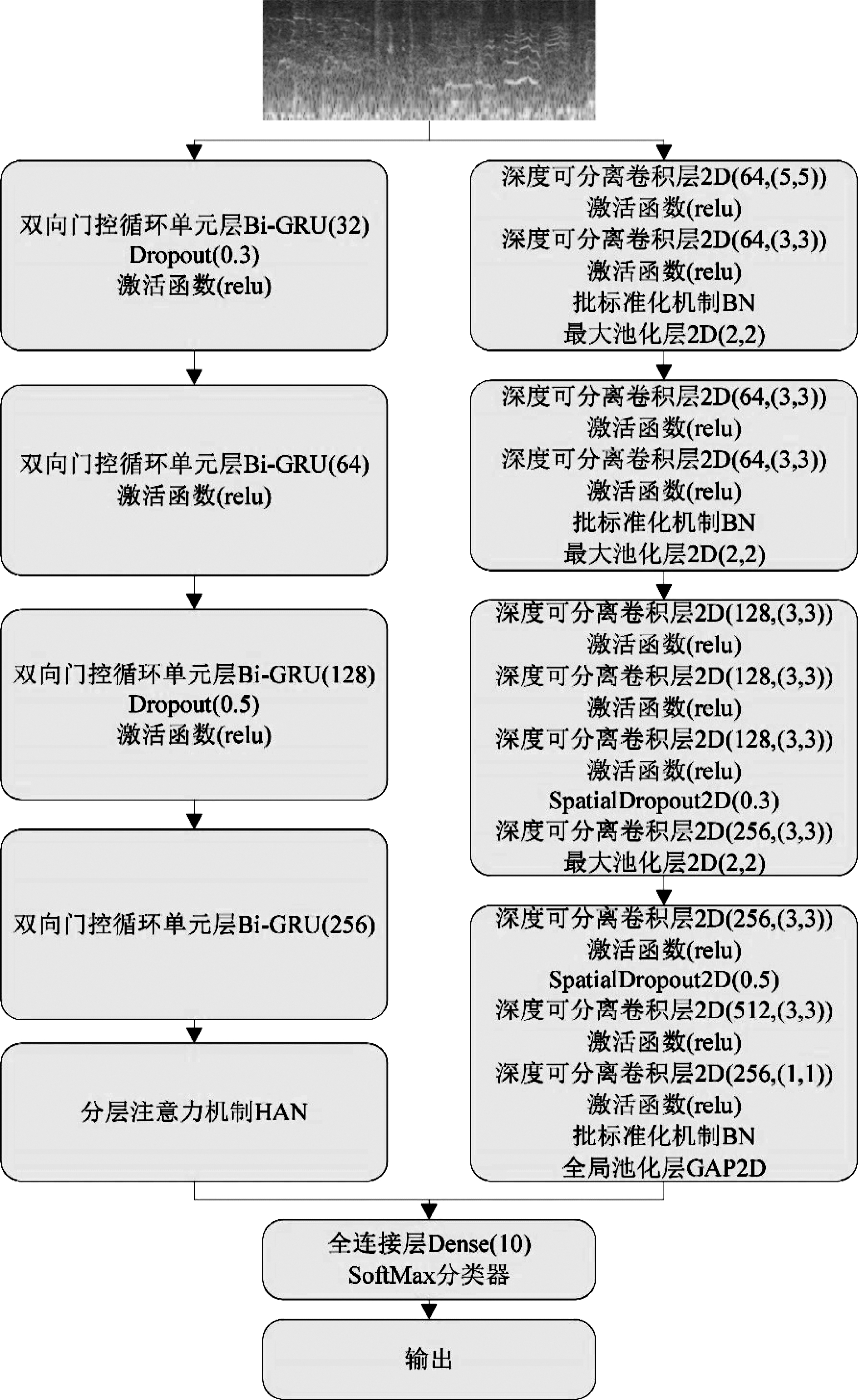

(12)

(13)

上式中,uit为hit的隐层表示,经SoftMax函数操作后的归一化权重系数用αit表示,uω作为随机初始化向量,随模型一起参与训练,si为输出向量。

2.4 多优化机制下深度神经网络的音频场景识别模型

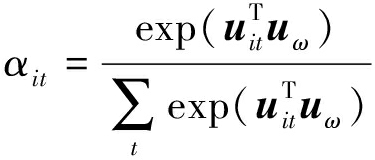

在本文中,运用并行卷积循环神经网络融合批标准化机制和分层注意力机制实现音频场景的识别任务。CNN在提取音频空间特征方面有着优异的性能,然而在其训练过程中却丢失了一些重要的时序性特征,对于音频信号而言,时序性关系尤为重要,因此,模型中所设计的Bi-GRU网络便发挥了独特且重要的作用,它可以有效地提取音频信号中的时序性特征。之后将两个并行网络的输出融合为一个新的特征向量,在经过全连接层之后,运用SoftMax分类器对音频场景进行分类识别。因此,并行卷积循环神经网络模型具备强大的空间特征和时间特征学习能力,可以有效提取音频特征参数,加之批标准化机制和分层注意力机制的显著优势,大大增强了网络模型的识别性能。网络模型如图3所示。

图3 网络模型结构示意图

Fig.3 The schematic diagram of network model structure

本文设计的网络结构采用4组融合BN机制的深度可分离卷积网络与4组Bi-GRU网络的并行模式。并行架构不仅能够在音频数据的空间结构上进行建模,而且还可以对其时间帧顺序进行建模,与单一结构相比,识别准确率有明显提升。在深度可分离卷积网络中融合BN机制并使用Dropout层,可加快模型收敛进程,提高网络泛化能力。在Bi-GRU网络中融合分层注意力机制,能够让模型更“注意”那些对识别起重要作用的关键帧。在模型训练阶段,场景音频数据经预处理获得尺寸为129×517的Mel声谱图,之后将其输入到并行网络中分别提取其空间特征和时间特征,两者在输出时融合为新的特征向量,然后输入到带有全连接层的SoftMax分类器进行分类识别,最后输出结果。本文任务采用基于python的TensorFlow-gpu深度学习环境进行模型训练和测试,实验参数如图3所示。

3 实验与结果分析

3.1 实验数据集

本实验采用音频场景、音频事件分类与检测挑战赛(Detection and Classification of Acoustic Scenes and Events Challenge,DCASE)提供的DCASE2019[27]、DCASE2020[28]和DCASE2017[29]任务一中的音频数据集进行训练和验证。DCASE2019任务一数据集分为10种场景类别,分别为飞机场(airport)、购物中心(shopping_mall)、地铁站(metro_station)、步行街(street_pedestrian)、广场(public_square)、街道交通(street_traffic)、电车(tram)、公共汽车(bus)、地铁声(metro)、公园(park)。它们录制于12个欧洲城市,包含14400个音频文件,每个音频文件时长10 s,采样率为48 kHz,存储为wav格式。DCASE2020任务一数据集使用4种设备录制于12个城市,分为购物中心(shopping_mall)、地铁站(metro_station)等10类场景,每个音频文件时长10 s,采样率为44.1 kHz,存储为wav格式。DCASE2017任务一数据集包含15种场景类别,本实验从中任意挑选海滩(Lakeside beach)、图书馆(Library)等10种场景类别进行训练和验证,每个音频文件时长亦为10 s,采样率为44.1 kHz,存储为wav格式。

3.2 音频特征提取

音频文件的特征提取包括预加重、加窗和分帧等步骤。预加重通过高通滤波器得以实现,如公式(14)所示,式中,μ为预加重系数:

H(Z)=1-μZ-1

(14)

分帧能够获得音频文件的短时平稳信号,选择Hamming窗函数。预处理后的音频信号通过短时傅里叶变换获得时频信号,如公式(15)所示,式中,m表示帧数,L表示帧长,i表示第i帧:

(15)

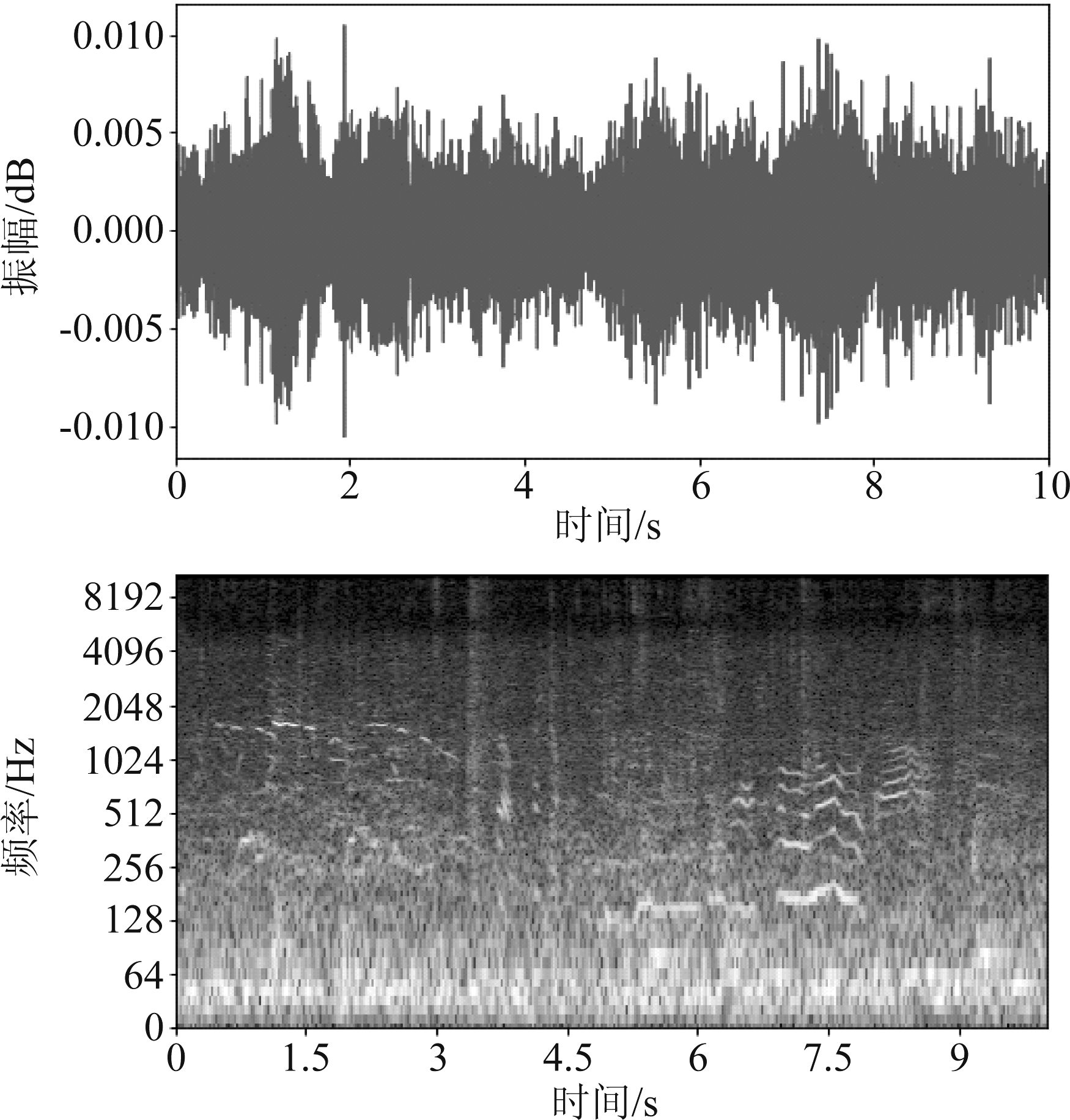

声谱图通过将每一帧频域信号相叠加而得到,再将其通过梅尔标度滤波器组转换为梅尔声谱图,它能够体现出音频信号的时频域信息与能量值,图4列举了DCASE2019数据集中飞机场的波形图和梅尔声谱图。

图4 飞机场音频场景波形图和梅尔声谱图

Fig.4 Waveform and Mel spectrogram of the airport audio scene

3.3 实验结果及分析

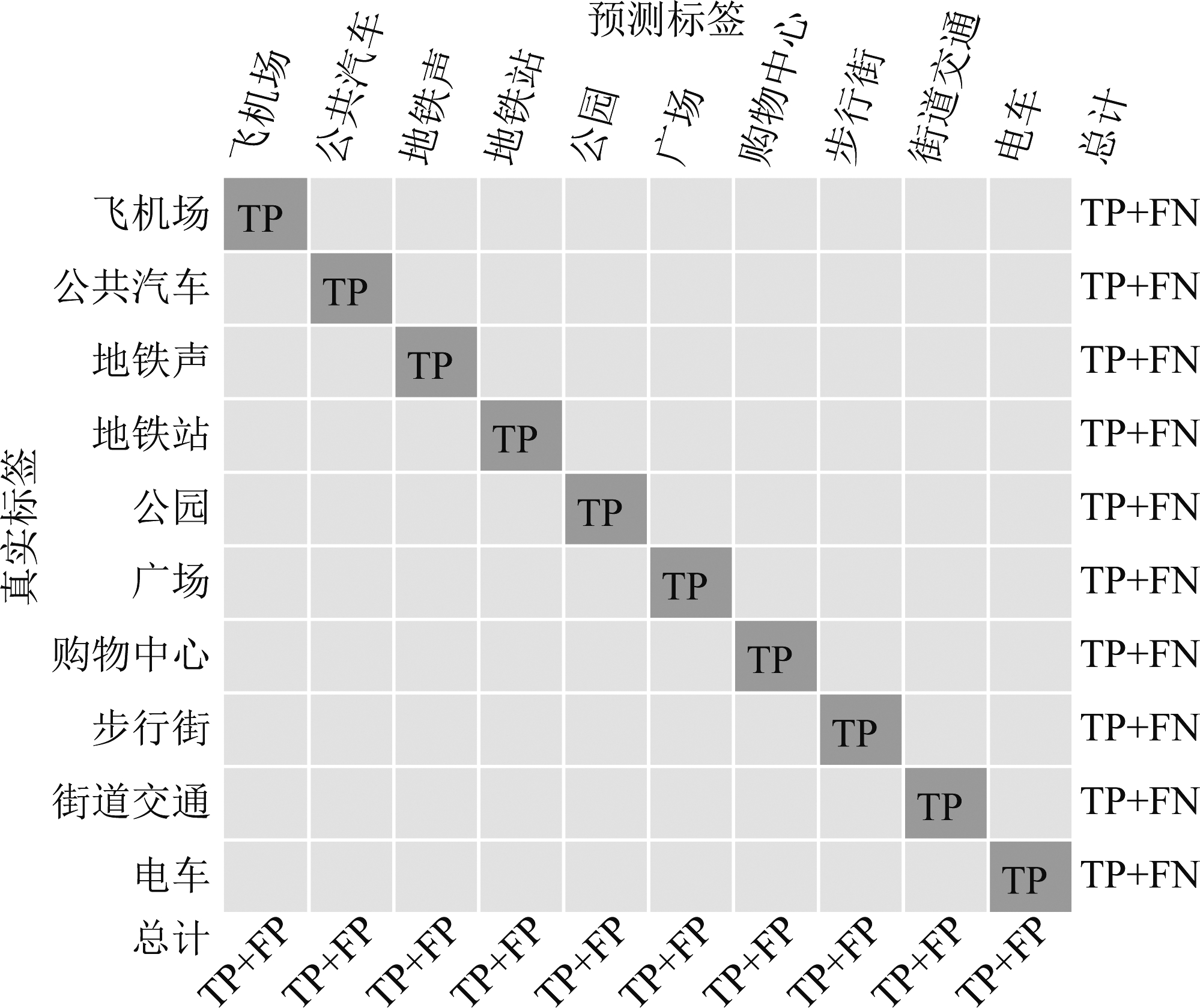

实验参数如2.4节所述。为了验证本文算法的有效性,在DCASE2019音频数据集下,将本文的算法模型分层次进行对比,之后在相同数据集下与其他三支DCASE参赛队所用的DCGAN模型[30]、CNN7-Avg模型[31]和DNN模型[32] 进行比较,运用识别准确率作为衡量算法模型有效性的指标,采用“CNN+3-Bi-GRU”作为本文的基线系统。对比结果如表1所示。需要说明的是,本实验采取10折交叉验证,并且采用准确率(Accuracy)、精确率(Precision)、召回率(Recall)和F1-Score值对网络模型进行综合评价。公式如(16)至(19)所示[33]:

(16)

(17)

(18)

(19)

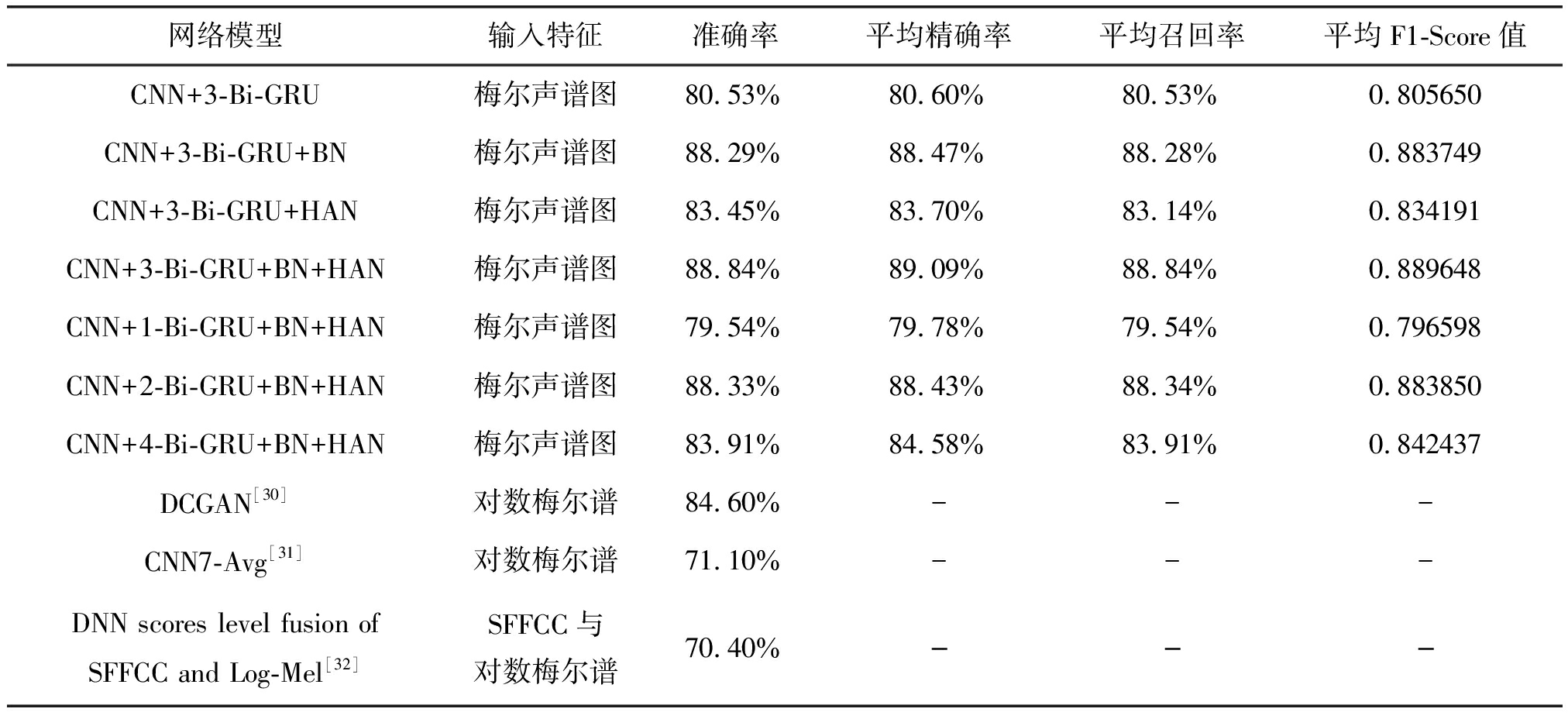

上式中,TP意为True positive,表示预测正确与实际分类正确的标签数量;FP意为False positive,表示预测标签中分类错误标签的数量;FN意为False negative,表示实际标签中分类错误标签的数量。如图5所示。

图5 TP、FP和FN含义及关系示意图

Fig.5 TP, FP and FN meaning and relationship diagram

从表1可以看出,批标准化机制在并行卷积循环神经网络框架中发挥了较大的作用,同时分层注意力机制也发挥了一定的作用,识别准确率比基线系统分别提高7.76%和2.92%,并在3层Bi-GRU时识别准确率达到最高,证明了并行卷积循环神经网络框架和优化机制的有效性。值得注意的是,在融合多优化机制的并行网络结构中,依次设置1、2、3层Bi-GRU网络时,识别准确率依次增加,当设置4层Bi-GRU网络时识别准确率却差强人意,这是因为当设置1、2层Bi-GRU网络时,模型处于不同程度的欠拟合状态,Bi-GRU网络为3层时拟合状态达到最佳,4层时出现了过拟合现象,导致识别准确率下降。

表1 算法模型对比1

Tab.1 Algorithm model comparison 1

网络模型输入特征准确率平均精确率平均召回率平均F1-Score值CNN+3-Bi-GRU梅尔声谱图80.53%80.60%80.53%0.805650CNN+3-Bi-GRU+BN梅尔声谱图88.29%88.47%88.28%0.883749CNN+3-Bi-GRU+HAN梅尔声谱图83.45%83.70%83.14%0.834191CNN+3-Bi-GRU+BN+HAN梅尔声谱图88.84%89.09%88.84%0.889648CNN+1-Bi-GRU+BN+HAN梅尔声谱图79.54%79.78%79.54%0.796598CNN+2-Bi-GRU+BN+HAN梅尔声谱图88.33%88.43%88.34%0.883850CNN+4-Bi-GRU+BN+HAN梅尔声谱图83.91%84.58%83.91%0.842437DCGAN[30]对数梅尔谱84.60%---CNN7-Avg[31]对数梅尔谱71.10%---DNN scores level fusion ofSFFCC and Log-Mel[32]SFFCC与对数梅尔谱70.40%---

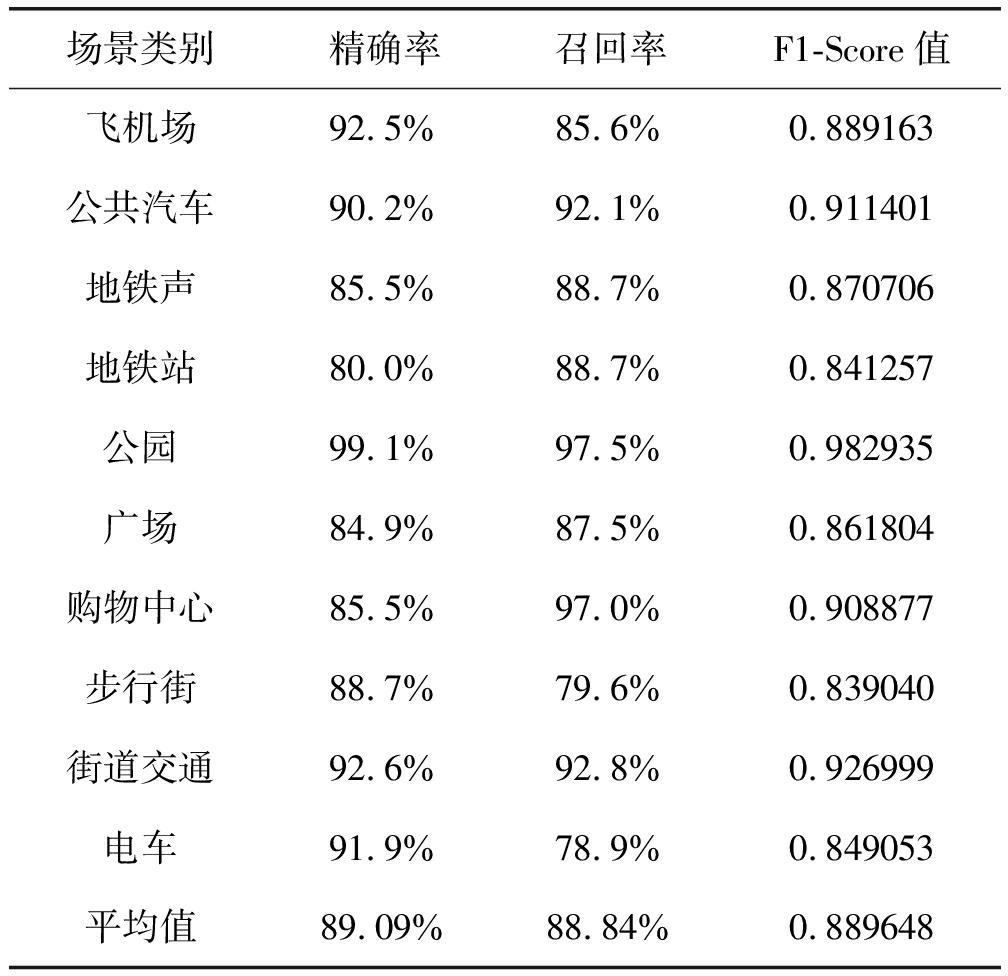

经训练得到“CNN+3-Bi-GRU+BN+HAN”网络模型的各类场景识别精确率Precision、召回率Recall与F1-Score值如表2所示。

表2 “CNN+3-Bi-GRU+BN+HAN”模型性能指标

Tab.2 “CNN+3-Bi-GRU+BN+HAN” model performance indicators

场景类别精确率召回率F1-Score值飞机场92.5%85.6%0.889163公共汽车90.2%92.1%0.911401地铁声85.5%88.7%0.870706地铁站80.0%88.7%0.841257公园99.1%97.5%0.982935广场84.9%87.5%0.861804购物中心85.5%97.0%0.908877步行街88.7%79.6%0.839040街道交通92.6%92.8%0.926999电车91.9%78.9%0.849053平均值89.09%88.84%0.889648

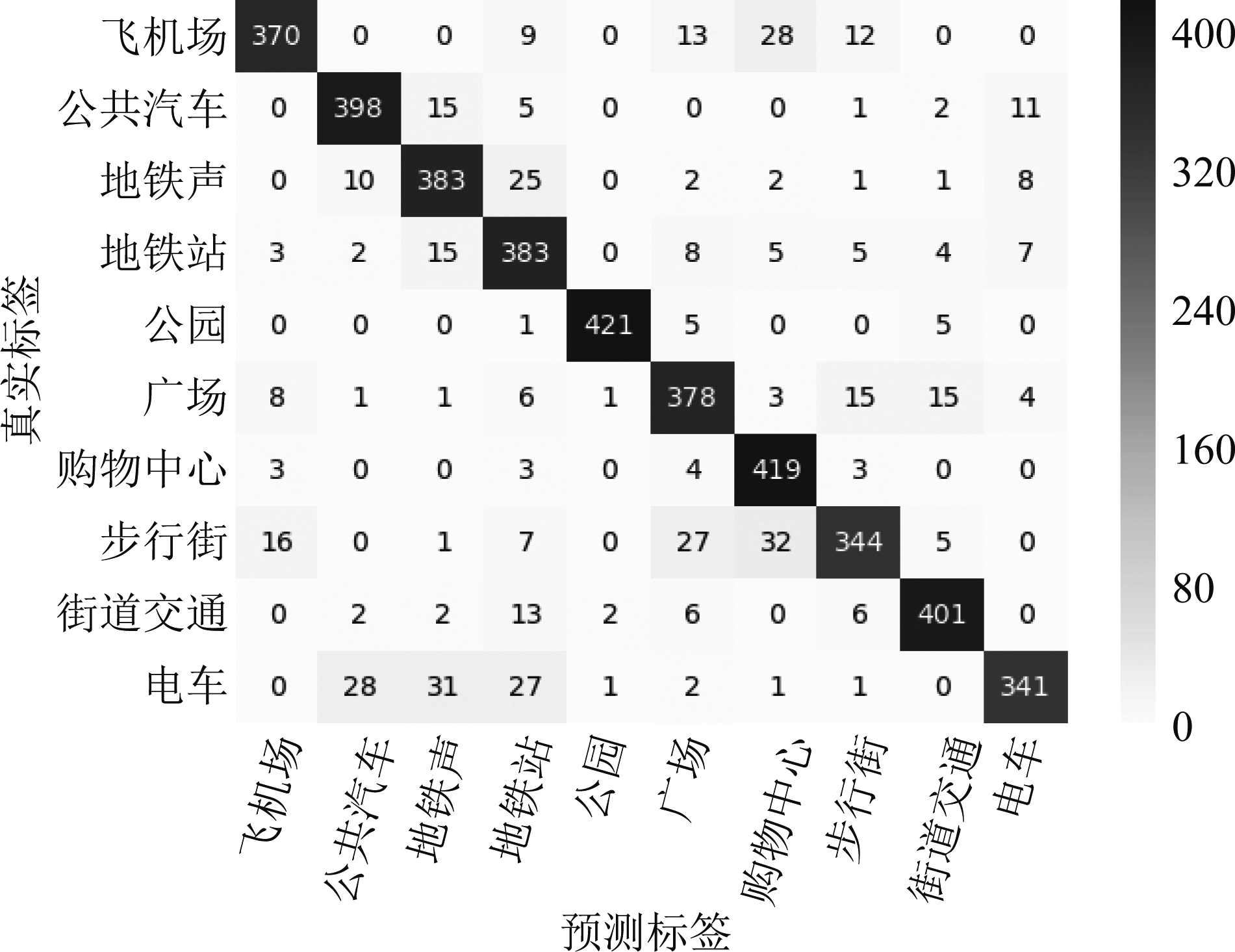

从表2可以看出,该模型中各类场景的各项指标都取得了较好的参数,从而验证了该算法模型的有效性。图6展示的混淆矩阵描述了“CNN+3-Bi-GRU+BN+HAN”网络模型中每一类音频场景识别的具体情况。从图中可以看出,有7.4%步行街的声音场景被误认为购物中心的声音场景,主要原因是两种声音场景中都含有行人活动以及讲话的声音,两类声学场景的特征有一定的相似性,产生误判的几率较高,导致识别精确率下降;此外,电车的声音场景有一部分被识别为地铁的声音场景,这两种类别的场景存在一定的相似性,也容易产生误判。

图6 音频场景识别混淆矩阵

Fig.6 Audio scene recognition confusion matrix

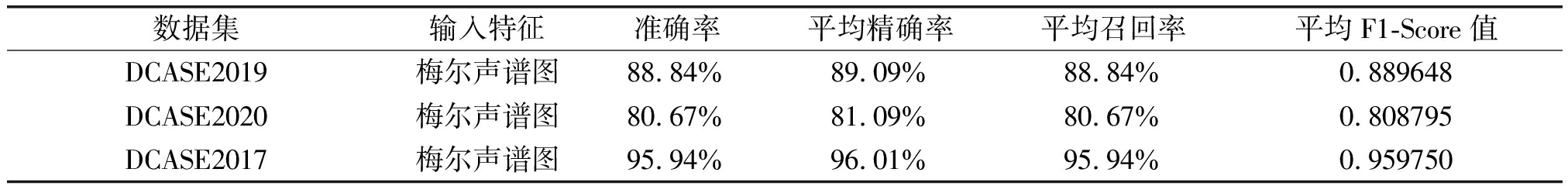

为了验证“CNN+3-Bi-GRU+BN+HAN”网络模型的稳定性以及泛化能力,我们选用DCASE2020和DCASE2017音频场景数据集进行测试,测试结果如表3所示。从表3可以看出,用不同数据集训练和测试网络模型,都能获得较好的参数,证明本文中网络模型有很高的稳定性和很好的泛化能力。

表3 算法模型对比2

Tab.3 Algorithm model comparison 2

数据集输入特征准确率平均精确率平均召回率平均F1-Score值DCASE2019梅尔声谱图88.84%89.09%88.84%0.889648DCASE2020梅尔声谱图80.67%81.09%80.67%0.808795DCASE2017梅尔声谱图95.94%96.01%95.94%0.959750

实验结果对比显示,本文中“CNN+3-Bi-GRU+BN+HAN”算法模型的识别准确率最高。该模型运用深度学习算法融合多种优化机制,充分利用其优势进行特征提取和识别,使模型的性能达到最优,识别准确率得到显著提高。

4 结论

在音频场景识别领域中,针对识别率不高的问题,本文应用融合批标准化机制和分层注意力机制的并行卷积循环神经网络算法模型,充分利用并行卷积循环神经网络可以提取音频信号的空间特征和时间特征参数的特点以及优化机制的独特优势,使模型的识别准确率达到了88.84%,实验结果证明本文的算法模型优于传统神经网络模型,从而验证了深度学习算法与多种优化机制的有机融合能够很好地适用于音频场景识别任务。

[1] 曾毅, 刘成林, 谭铁牛.类脑智能研究的回顾与展望[J].计算机学报, 2016, 39(1): 212-222.

ZENG Yi, LIU Chenglin, TAN Tieniu.Retrospect and outlook of brain-inspired intelligence research[J].Chinese Journal of Computers, 2016, 39(1): 212-222.(in Chinese)

[2] ATILGAN H, TOWN S M, WOOD K C, et al.Integration of visual information in auditory cortex promotes auditory scene analysis through multisensory binding[J].Neuron, 2018, 97(3): 640-655.e4.

[3] MIYAZAKI K, TODA T, HAYASHI T, et al.Environmental sound processing and its applications[J].IEEJ Transactions on Electrical and Electronic Engineering, 2019, 14(3): 340-351.

[4] DAN S.Computational bioacoustic scene analysis[M]∥Computational Analysis of Sound Scenes and Events.Cham: Springer International Publishing, 2017: 303-333.

[5] AIHARA I, MIZUMOTO T, AWANO H, et al.Call alternation between specific pairs of male frogs revealed by a sound-imaging method in their natural habitat[C]∥Interspeech 2016.ISCA, 2016: 2597-2601.

[6] T TH B P, CZEBA B.Convolutional neural networks for large-scale bird song classification in noisy environment[C]∥Conference and Labs of the Evaluation Forum(CLEF), 2016: 560-568.

TH B P, CZEBA B.Convolutional neural networks for large-scale bird song classification in noisy environment[C]∥Conference and Labs of the Evaluation Forum(CLEF), 2016: 560-568.

[7] TSUNODA Y, SUEOKA Y, OSUKA K.Experimental analysis of acoustic field control-based robot navigation[J].Journal of Robotics and Mechatronics,2019,31(1):110-117.

[8] MAIJALA P, ZHAO Shuyang, HEITTOLA T, et al.Environmental noise monitoring using source classification in sensors[J].Applied Acoustics, 2018, 129: 258-267.

[9] SUR S D, DUARTE A, SALVADOR A, et al.Cross-modal embeddings for video and audio retrieval[M]∥Lecture Notes in Computer Science.Cham: Springer International Publishing, 2019: 711-716.

S D, DUARTE A, SALVADOR A, et al.Cross-modal embeddings for video and audio retrieval[M]∥Lecture Notes in Computer Science.Cham: Springer International Publishing, 2019: 711-716.

[10] VALADA A, SPINELLO L, BURGARD W.Deep feature learning for acoustics-based terrain classification[M]∥Robotics Research.Springer, Cham, 2018: 21-37.

[11] LECUN Y, BOTTOU L, BENGIO Y, et al.Gradient-based learning applied to document recognition[J].Proceedings of the IEEE, 1998, 86(11): 2278-2324.

[12] HERSHEY S, CHAUDHURI S, ELLIS D P W, et al.CNN architectures for large-scale audio classification[C]∥2017 IEEE International Conference on Acoustics, Speech and Signal Processing(ICASSP).New Orleans,LA,USA.IEEE, 2017: 131-135.

[13] HOCHREITER S, SCHMIDHUBER J.Long short-term memory[J].Neural Computation,1997,9(8):1735-1780.

[14] VU T H, WANG J C.Acoustic scene and event recognition using recurrent neural networks[J].Detection and Classification of Acoustic Scenes and Events, 2016, 2016.

[15] CHEN Hangting, LIU Zuozhen, LIU Zongming, et al.Integrating the data augmentation scheme with various classifiers for acoustic scene modeling[EB/OL].2019: arXiv: 1907.06639[eess.AS].https:∥arxiv.org/abs/1907.06639.

[16] 冯天艺, 杨震.采用多任务学习和循环神经网络的语音情感识别算法[J].信号处理, 2019, 35(7): 1133-1140.

FENG Tianyi, YANG Zhen.Speech emotion recognition algorithm based on multi task learning and recurrent neural network[J].Journal of Signal Processing, 2019, 35(7): 1133-1140.(in Chinese)

[17] CHOI Y, ATIF O, LEE J, et al.Noise-robust sound-event classification system with texture analysis[J].Symmetry, 2018, 10(9): 402.

[18] 邱意, 贾桂敏, 杨金锋, 等.民航陆空通话语音识别BiLSTM网络模型[J].信号处理, 2019, 35(2): 293-300.

QIU Yi, JIA Guimin, YANG Jinfeng, et al.Speech recognition model of civil aviation radiotelephony communication based on BiLSTM[J].Journal of Signal Processing, 2019, 35(2): 293-300.(in Chinese)

[19] 王金甲, 纪绍男, 崔琳, 等.基于注意力胶囊网络的家庭活动识别[J].自动化学报, 2019, 45(11): 2199-2204.

WANG Jinjia, JI Shaonan, CUI Lin, et al.Domestic activity recognition based on attention capsule network[J].Acta Automatica Sinica, 2019, 45(11): 2199-2204.(in Chinese)

[20] CHO K, VAN MERRIENBOER B, BAHDANAU D, et al.On the properties of neural machine translation: Encoder-decoder approaches[C]∥Proceedings of SSST-8, Eighth Workshop on Syntax, Semantics and Structure in Statistical Translation.Doha, Qatar.Stroudsburg, PA, USA: Association for Computational Linguistics, 2014.

[21] FENG Lin, LIU Shenlan, YAO Jianing.Music genre classification with paralleling recurrent convolutional neural network[EB/OL].2017.

[22] CHOI K, FAZEKAS G, SANDLER M, et al.Convolutional recurrent neural networks for music classification[C]∥2017 IEEE International Conference on Acoustics, Speech and Signal Processing(ICASSP).New Orleans, LA, USA.IEEE, 2017: 2392-2396.

[23] IOFFE S, SZEGEDY C.Batch normalization: accelerating deep network training by reducing internal covariate shift[C]∥International Conference on Machine Learning.PMLR, 2015: 448-456.

[24] YANG Zichao, YANG Diyi, DYER C, et al.Hierarchical attention networks for document classification[C]∥Proceedings of the 2016 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies.San Diego, California.Stroudsburg, PA, USA: Association for Computational Linguistics, 2016: 1480-1489.

[25] RUMELHART D E, HINTON G E, WILLIAMS R J.Learning representations by back-propagating errors[J].Nature, 1986, 323(6088): 533-536.

[26] BENGIO Y, SIMARD P, FRASCONI P.Learning long-term dependencies with gradient descent is difficult[J].IEEE Transactions on Neural Networks, 1994, 5(2): 157-166.

[27] MESAROS A, HEITTOLA T, VIRTANEN T.A multi-device dataset for urban acoustic scene classification[J].arXiv preprint arXiv:1807.09840, 2018.

[28] HEITTOLA T, MESAROS A, VIRTANEN T.Acoustic scene classification in dcase 2020 challenge: generalization across devices and low complexity solutions[J].arXiv preprint arXiv:2005.14623, 2020.

[29] MESAROS A, HEITTOLA T, DIMENT A, et al.DCASE 2017 challenge setup: Tasks, datasets and baseline system[C]∥DCASE 2017-Workshop on Detection and Classification of Acoustic Scenes and Events, 2017.

[30] NING Fangli, DUAN Shuang, HAN Pengcheng, et al.Acoustic scene classification based on the dataset with deep convolutional generated against network[R].Detection and Classification of Acoustic Scenes and Events, 2019, 2019.

[31] MA Xinxin, GU Mingliang, MA Yong.Jsnu_wdxy submission for DCASE-2019: acoustic scene classification with convolutional neural networks[R].Detection and Classification of Acoustic Scenes and Events, 2019, 2019.

[32] PASEDDULA C, GANGASHETTY S V.DCASE 2019 TASK 1A: acoustic scene classification by SFFCC and DNN[R].Detection and Classification of Acoustic Scenes and Events, 2019, 2019.

[33] HAN J, KAMBER M, PEI J.Data mining: concepts and techniques, 3rd ed[M].San Francisco, CA, USA: Morgan Kaufman, 2012.