1 引言

声音作为多媒体的一种重要信息载体,在多样化的多媒体数据中占据了很大一部分。一段音频所包含的信息是极为丰富的。以语音为例,除了包含最明显的语义内容外,同时也包含了说话人性别、年龄、情绪、环境等多种副语言信息。除语音外人类的生活环境中还存在着各种各样的环境声音,这些环境声音信号同样可以传递很多有价值的信息。

人类的听觉系统可以自动对声音中复杂的信息进行分离和判别,如果计算机可以具备同样的识别有用信息的功能,在实际生活场景中将会有非常广阔的应用前景。因此,如何基于计算机对海量音频信息进行处理、分析和利用是现代信号处理领域中的一个重要课题。而声音事件检测(Sound Event Detection, SED)能够快速检测判断出环境中正在发生的事件类型,是解决这一问题关键技术之一,在多媒体信息处理中起着非常重要的作用,对于智能家居、噪声监测、无人驾驶、安防监控、环境监测等领域都将是不可缺少的关键部分[1-3]。基于声学特征分析的音频监控可以很好的弥补基于光学图像的视频监控的缺陷,在视觉受限严重的场景甚至可以替代传统的视频监控。总之,声音事件检测技术的市场前景广阔,值得更多学者研究。

声音事件检测的研究起步于20世纪80年代,最早应用在水下物体识别任务。1997年,Sawhney和Maes提出了声音事件检测以及声音场景分类等概念。二十一世纪初,随着公共安全监控需求的持续增长,以声音信号分析为核心的音频监控在视觉受限的场景下的突出作用,受到越来越多研究人员的关注。近几年,声音事件检测领域的技术创新受到了深度学习的巨大影响。Gencoglu[4]首次尝试将受限玻尔兹曼机与深度神经网络相结合,应用于声音事件检测中。部分研究人员开始尝试将在图像等领域有突出表现的卷积神经网络(Convolutional Neural Networks, CNN)[5]应用于声音事件检测[6-7]。同时,也有许多人尝试将在自然语言处理等领域已取得广泛应用的循环神经网络(Recurrent Neural Networks, RNN)[8]引入。Kim等人[9]利用RNN的特殊变体门限循环神经网络(Gated Recurrent Units, GRU)[10]作为分类器,有效地化解了对变长的音频片段的检测问题。进一步,Xu[11]等人提出的CNN+GRU模型,在DCASE2017比赛中在“audio tagging”任务中达到了0.556的F1值。同时也有很多研究人员针对池化层进行改进。Kong[12]等人根据注意力机制的思想,提出了attention 池化层。Wang[13]等人通过分析和对比五种常用池化层,提出了linear softmax池化层。

本文提出了一种基于改进池化层的弱标记声音事件检测系统,该系统针对弱标记声音事件数据集,提取Fbank特征,利用卷积循环神经网络搭建分类器,基于linear softmax池化层,提出了一种“指数可学习的幂函数softmax”池化层,并为指数设置不同初始值,进行实验对比验证。

2 Convolution recurrent neural network(CRNN)声音事件检测系统

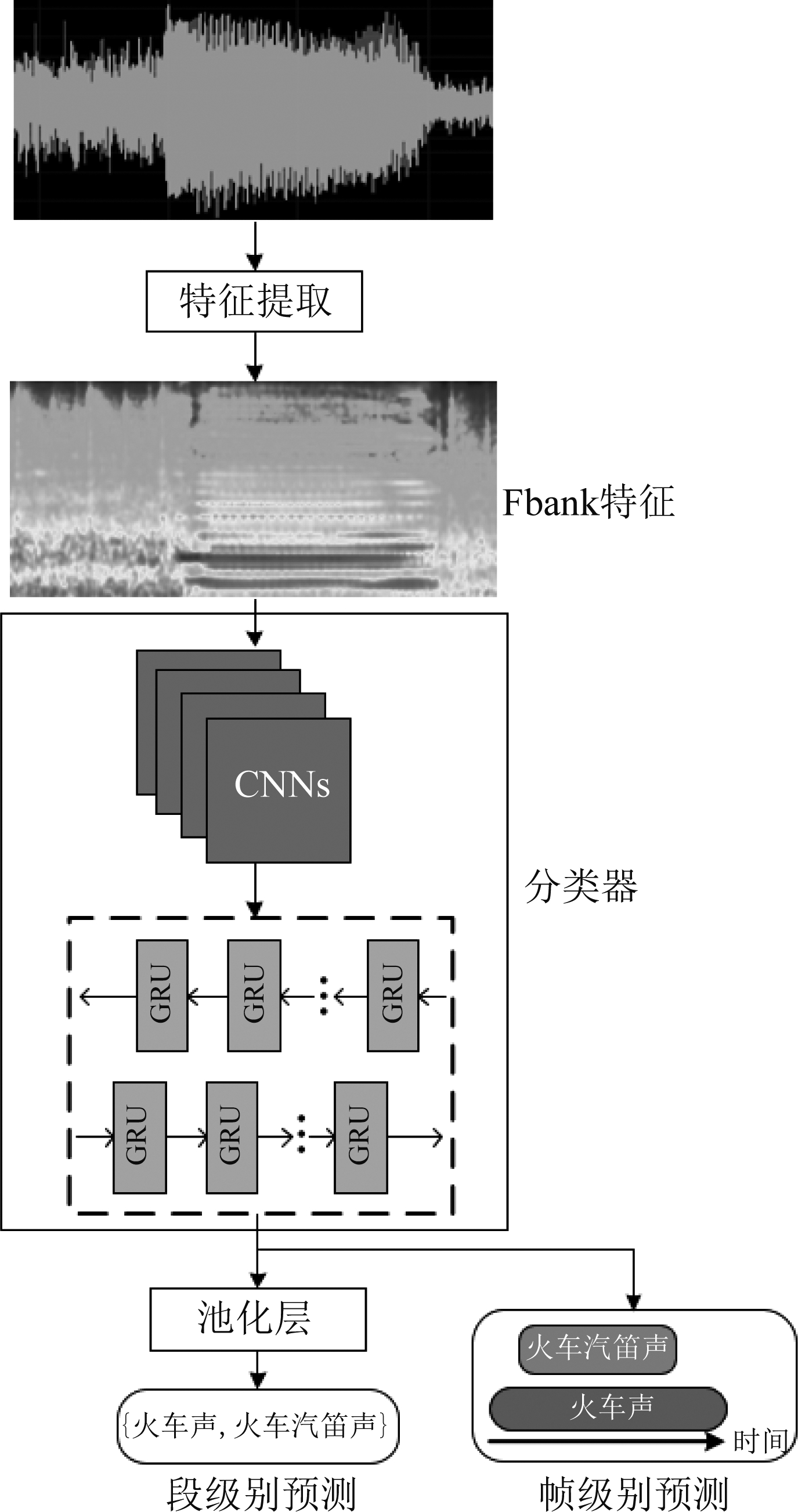

如图1所示,对于一个声音事件检测系统,它的输入通常是一段完整的音频,通过特定的特征提取方法,生成音频中的浅层声学特征,并输入到分类器中。最终,网络一方面输出该段音频中包含的事件类别,即段级别预测,另一方面输出每种声音事件的起止时间,即帧级别预测。

图1 CRNN声音事件检测系统

Fig.1 CRNN sound event detection system

2.1 特征提取

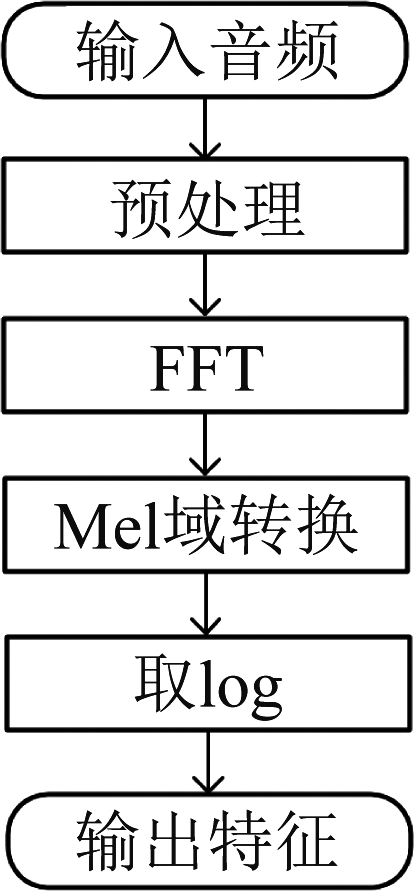

本文采用了64维的梅尔滤波器特征(Mel Filter banks,Fbank)。图2为Fbank提取过程流程图。首先对所有音频被重采样到为32 kHz,然后对音频进行分帧、加窗等预处理后,其中选用汉明窗,窗长为32 ms,帧移为10 ms。再利用快速傅里叶变换FFT将音频从时域转换到频域。接着用梅尔频率刻度的滤波器组对转换后的信号进行切分。梅尔刻度与频率的赫兹的关系如下。

图2 Fbank特征提取流程

Fig.2 Fbank feature extraction process

Mel(f)=2595lg(1+f/700)

(1)

最后对上一步Mel域转换后的结果取对数。取对数后,便可以压缩能量轴,从而增大能量较低处的差异,增加更多细节。这样就可以得到音频的Fbank特征。

2.2 CRNN网络

本文采用卷积循环神经网络(Convolutional Recurrent Neural Networks, CRNN)作为分类器。如图1所示,CRNN网络由CNN和RNN两部分构成。CNN部分由4个卷积块组成,每个卷积核包含两层核大小为3×3的卷积层和一层2×2的平均池化组成。每层卷积层之后都应用了批归一化(Batch Normalization, BN)和ReLU非线性函数。在RNN部分,本文采用了内部节点为32的双向门限循环网络(Bidirectional Gated Recurrent Units, Bi-GRU)。它的特点是在处理带有时间刻度的信息时,能将过去和未来的信息同时利用来进行预测。在CRNN内部,CNN提取音频的深层特征后输入到RNN中对声音事件的时间信息进行建模学习。可以说,CRNN网络结合了CNN和RNN两者的优点。文献[14]介绍了CRNN网络的具体细节设置。

2.3 池化层

如图1所示,池化层的作用是将CRNN网络输出的帧级别的预测聚合为段级别的预测,然后便可以和音频的声音事件弱标签一起输入到损失函数中计算损失值loss。

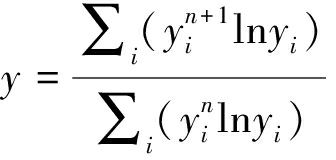

本文对常用的两种池化层(attention和linear softmax)以及提出的“指数可学习的幂函数softmax”池化层进行分析。在网络中,帧级别概率yi对应池化层输入,段级别概率y对应池化层输出。本节首先分析损失函数关于帧级别概率yi的梯度(在attention池化层中,还会关注权重wi的梯度)。令t是段级别的真实标签。损失函数选用交叉熵,公式如下。

L=-tlogy-(1-t)log(1-y)

(2)

求导得到损失值L对于段级别概率y的梯度![]()

(3)

![]() 与池化层的选择无关,当真实标签为正时(t=1)为负,当真实标签为(t=0)时为正。

与池化层的选择无关,当真实标签为正时(t=1)为负,当真实标签为(t=0)时为正。

然后使用链式法则分解损失值L相对于帧级别概率yi的梯度![]() 以及帧级别权重wi的梯度

以及帧级别权重wi的梯度![]()

(4)

(5)

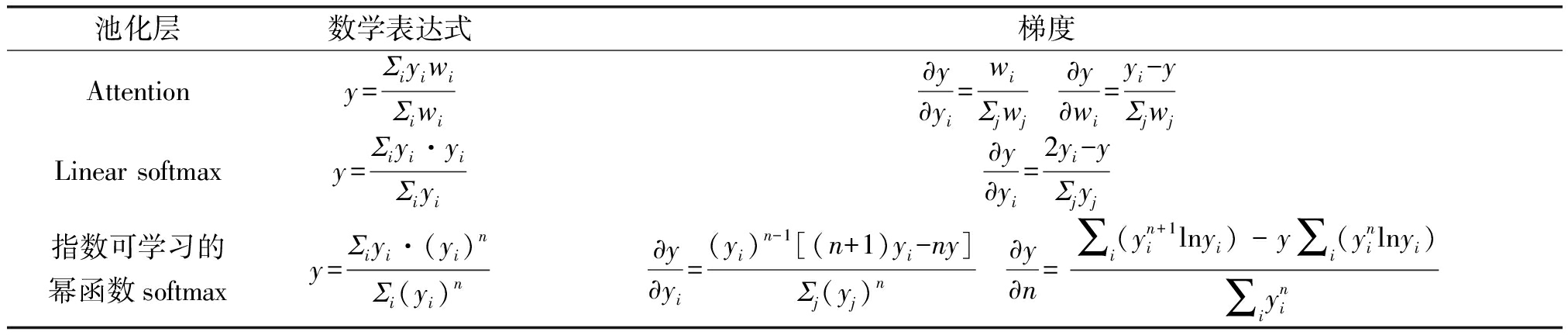

表1给出了三种不同的池化层的数学表达式和梯度![]()

表1 三种池化层的数学表达式及梯度

Tab.1 Mathematical expressions and gradients of three pooling layers

Attention池化层是一种加权平均。它在网络中设置特定层来学习每帧的权重wi,然后使用加权平均公式加权所有帧的概率来计算段级别概率y。梯度![]() 恒为正。因此,所有帧级别概率将随着真实标签的正负被提升或抑制,强度与所学习的权重相关。概率较大的帧获得较大的权重,这是理想的现象。但是,由于权重wi也是可学习的,我们也应该关注损失值关于权重的梯度

恒为正。因此,所有帧级别概率将随着真实标签的正负被提升或抑制,强度与所学习的权重相关。概率较大的帧获得较大的权重,这是理想的现象。但是,由于权重wi也是可学习的,我们也应该关注损失值关于权重的梯度![]() 该值在yi>y时为正。当样本标签为正时,

该值在yi>y时为正。当样本标签为正时,![]() 为负,这将导致权重在帧级别概率yi大于段级别概率y时增大,在帧级别概率小于段级别概率y时缩小,这与概率较大的帧y应获得较大权重wi的动机一致。然而,当样本标签为负时,

为负,这将导致权重在帧级别概率yi大于段级别概率y时增大,在帧级别概率小于段级别概率y时缩小,这与概率较大的帧y应获得较大权重wi的动机一致。然而,当样本标签为负时,![]() 为正,则会出现相反的现象:较大的权重将集中在概率较小的帧上。这将导致虽然段级别的概率y很小,但是会有很多大概率和小权重的帧,最终会导致帧级别上出现很多假阳性。

为正,则会出现相反的现象:较大的权重将集中在概率较小的帧上。这将导致虽然段级别的概率y很小,但是会有很多大概率和小权重的帧,最终会导致帧级别上出现很多假阳性。

Linear softmax池化层也是一种加权平均,分配的权重wi等于帧级别概率yi本身,其中较大的帧概率yi接收较大的权重wi。Linear softmax池化层的梯度![]() 在

在![]() 左右正负发生改变。对于正样本(t=1),梯度

左右正负发生改变。对于正样本(t=1),梯度![]() 当

当![]() 时为负,当

时为负,当![]() 时为正。因此,概率大的帧yi将被提升,而概率小的帧yi将被抑制,这是正确的导向。对于负样本(t=0),梯度

时为正。因此,概率大的帧yi将被提升,而概率小的帧yi将被抑制,这是正确的导向。对于负样本(t=0),梯度![]() 当

当![]() 时为正,当

时为正,当![]() 时为负。这意味着所有帧级别概率yi都将趋向

时为负。这意味着所有帧级别概率yi都将趋向![]() 考虑到段级别概率y是yi的加权平均值,所以y也会趋向

考虑到段级别概率y是yi的加权平均值,所以y也会趋向![]() 给定足够的迭代次数,所有帧的yi都将按预期收敛到0。这是符合对负样本的预测结果的期望,这是正确的现象。

给定足够的迭代次数,所有帧的yi都将按预期收敛到0。这是符合对负样本的预测结果的期望,这是正确的现象。

针对Linear softmax池化层的梯度![]() 固定在

固定在![]() 左右正负发生改变的现象,本文提出了“指数可学习的幂函数softmax”池化层。其分配的权重wi等于帧级别概率yi的n次方,而指数n在网络中被设置成可学习的参数。梯度

左右正负发生改变的现象,本文提出了“指数可学习的幂函数softmax”池化层。其分配的权重wi等于帧级别概率yi的n次方,而指数n在网络中被设置成可学习的参数。梯度![]() 在

在![]() 左右正负发生改变。与linear softmax池化层相比,不再固定“变化点”的值,而是让网络自身在训练过程去学习和估计该值。其他变化规律和linear softmax池化层一致,保留了其对帧级别概率的好的导向。梯度

左右正负发生改变。与linear softmax池化层相比,不再固定“变化点”的值,而是让网络自身在训练过程去学习和估计该值。其他变化规律和linear softmax池化层一致,保留了其对帧级别概率的好的导向。梯度![]() 在

在 左右正负发生变化,该变化点的大小与n的大小有关,也即让网络自身去学习。因此与attention池化层相比,不会因为权重梯度的错误变化,导致权重在帧级别概率上的错误分布。

左右正负发生变化,该变化点的大小与n的大小有关,也即让网络自身去学习。因此与attention池化层相比,不会因为权重梯度的错误变化,导致权重在帧级别概率上的错误分布。

3 实验设置

3.1 实验数据集

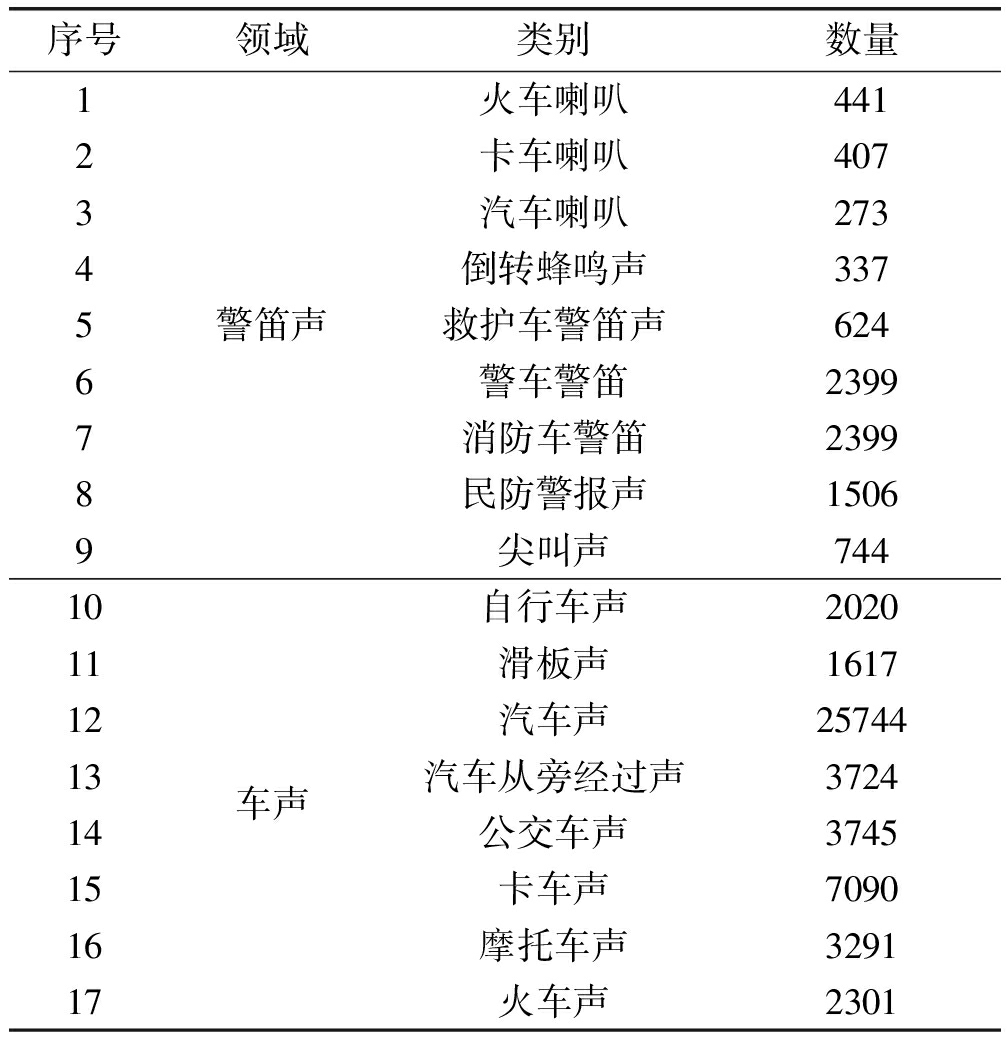

DCASE竞赛由伦敦大学玛丽皇后学院数字音乐中心等机构于2013年组织发起,是目前声学事件领域最权威的竞赛。DCASE2017 Task 4的主题是“智能驾驶领域的大规模弱监督声音事件检测”。该数据集由17种声音事件组成,每段音频时间不超过10 s,分为两个大类:“警笛声(Warning)”和“车声(Vehicle)”。表2显示了17种类别及每一类的数量。需要注意的是,每段音频可能对应不止一种的事件类别。另外该数据集为弱标签数据集,即每段音频对应一组标签,只知道整段音频出现的事件类别,但不知道事件出现的具体位置。

表2 数据集中音频种类及数量

Tab.2 Audio type and quantity in the dataset

序号领域类别数量123456789警笛声火车喇叭441卡车喇叭407汽车喇叭273倒转蜂鸣声337救护车警笛声624警车警笛2399消防车警笛2399民防警报声1506尖叫声7441011121314151617车声自行车声2020滑板声1617汽车声25744汽车从旁经过声3724公交车声3745卡车声7090摩托车声3291火车声2301

3.2 实验评价指标

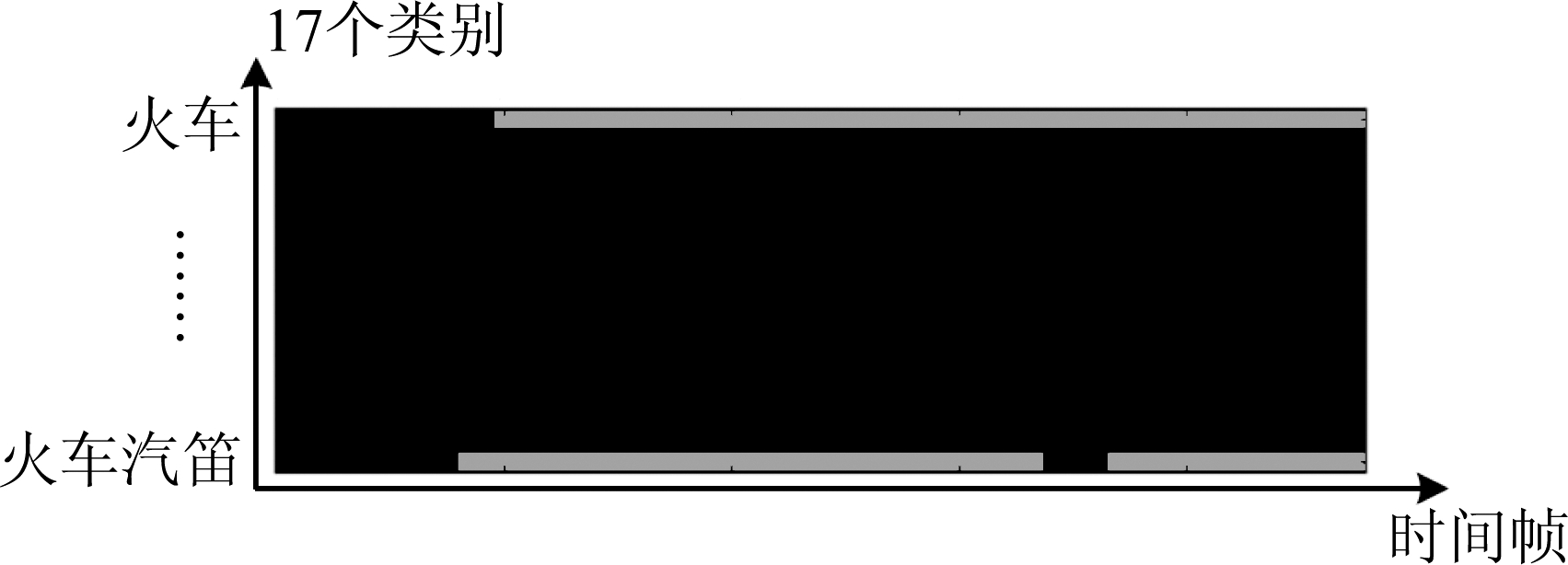

DCASE竞赛将声音事件检测任务分为两个目标,一个是给出整段音频上所包含的音频种类的预测,另一个是给出音频每一帧上包含的音频种类的预测,即要给出每一种事件出现的起止时间。帧级别预测示意图如下,火车和火车汽笛两种事件的在每一帧是否出现都给出预测(红色代表事件出现),其他事件则预测没有出现。

图3 帧级别预测示意图

Fig.3 Frame-level prediction diagram

因此,评价指标也分为两大类。一类是段级别的预测,用F1值[15]来评价,F1值的计算公式如下:

(6)

(7)

(8)

其中,TP,FP和FN分别是正确的正样本,错误的正样本和错误的负样本的数量。较高的F1值表明性能更好。通常,需要手动选择阈值并将其应用于输出预测以计算TP,FP和FN。另一类是帧级别的预测,用F1值及错误率(Error rate, ER)来评价。F1的计算方法同上。ER的计算公式如下。

(9)

其中,I,D,S是插入,删除和替换的种类的数量,文献[15]有详细阐述I,D,S的内容。越低的ER值表明性能越好。与段级别的预测相对应,帧级别的F1和ER是在确定好每个事件的起止时间后在长度为1 s的分段上进行统计和计算的[15]。

3.3 训练与预测阶段设置

训练数据输入过程中采用SpecAugmentation伪数据增强算法[16]。该算法的核心思想是对音频的频谱图进行掩盖(mask),掩盖部分频域通道和时域通道,以此来使训练出来的网络更加鲁棒。神经网络训练设置批处理数据大小为32,共训练60000轮。其中前50000轮设置学习率为0.001,最后10000轮设置学习率为0.0001,以更好拟合数据分布。训练优化器采用Adam优化算法[17]。该算法能在网络训练过程中根据网络中参数的变化状况对其学习率进行灵活微调,对变化较大的参数设置更低的学习率,反之,对那些变化较小的参数则设置更大的学习率来更新。

由本文2.3小节可知,“指数可学习的幂函数softmax”池化层的数学表达式中,指数n在网络中被设置成可学习的参数。在初始尝试过程中,发现指数n在网络初始化时的初始值不同,对最终的结果有一定的影响。按照指数n的初始值的不同,设置了多组对照实验,包括“n初始为1,可学习”、“n初始为0.75,可学习”、“n初始为0.5,可学习”等。

由本文3.2小节可知,在预测阶段,需要手动选择阈值并将其应用于输出声音事件的预测。本文的实验采取了“可学习阈值”优化策略[14],利用验证集的数据,设置随机梯度下降的方式来学习阈值的大小,这样一来便可不用考虑阈值调优等问题,使阈值自己学习到比较好的结果。在具体实验中验证了这种方法确实能有效提高最终结果。

4 实验结果及分析

4.1 段级别预测的结果

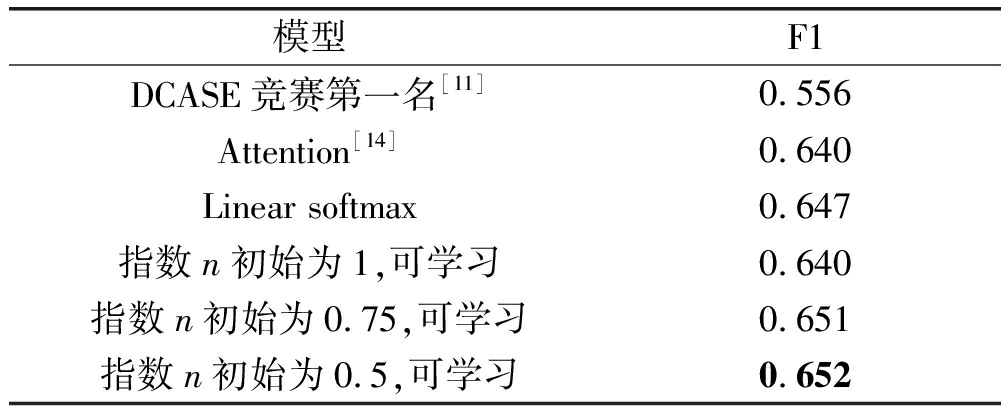

表3为不同模型在测试集上的段级别预测的F1值结果,最好结果被加粗显示。需要注意的是,表3中第一行是DCASE2017竞赛中获得第一名的模型的结果[11],该模型由CRNN搭建得到。而Attention池化层构成的模型结果来自于2020年发表一篇论文[14]。由表可知,应用“指数可学习的幂函数softmax”池化层的模型当指数初始值设置为0.5时,能得到最高的F1值为0.652,远远高于DCASE基线系统,与其他类型的池化层的结果相比也有一定的提升。

表3 不同模型段级别预测的F1值

Tab.3 The clip-level F1 value of different systems

模型F1DCASE竞赛第一名[11]0.556Attention[14]0.640Linear softmax0.647指数n初始为1,可学习0.640指数n初始为0.75,可学习0.651指数n初始为0.5,可学习0.652

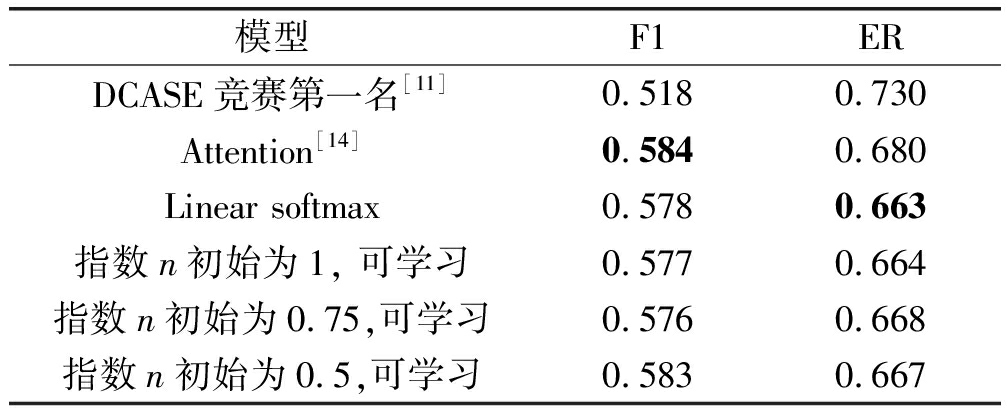

4.2 帧级别预测的结果

表4为不同模型在测试集上的帧级别预测的F1值和ER错误率,最好结果被加粗显示。应用“指数可学习的幂函数softmax”池化层的模型当指数初始值为0.5时,在F1值和ER错误率上都能到不错的效果,其中F1值可以达到0.583仅低于attention池化层模型的0.584,ER可以降低到0.667稍逊于linear softmax池化层模型的0.663。并且两个指标均远高于DCASE竞赛的最佳系统。从整体上看,本文提出的改进池化层在帧级别F1以及ER两个标准下的综合能力是最优的,说明“指数可学习的幂函数softmax”池化层对帧级别预测准确度的提高也有一定的促进作用。

表4 不同模型帧级别预测的F1值和ER

Tab.4 The frame-level F1 and ER of different systems

模型F1ERDCASE竞赛第一名[11]0.5180.730Attention[14]0.5840.680Linear softmax0.5780.663指数n初始为1, 可学习0.5770.664指数n初始为0.75,可学习0.5760.668指数n初始为0.5,可学习0.5830.667

5 结论

本文将DCASE2017挑战赛的弱标记声音事件检测音频作为数据集,通过对比分析两种常用的池化层,提出了一种“指数可学习的幂函数softmax”池化层。通过设置不同指数初始值的对照试验,最终选定0.5为初始值,使得检测系统在段级别预测的F1值达到0.652,帧级别预测的F1达到0.583,帧级别预测的ER降低到0.667,远远好于DCASE竞赛最佳系统的结果,并且与其他池化层的结果相比,也有一定的优势。需要进一步思考的是,本文仅对网络的最后输出的池化层进行改进,整体网络结构并没有改变,这也可能是文章结果没有非常大的提升的原因之一。未来的研究将把该池化层应用到CNN内部的池化层中,并且在数量更大、种类更多的声音事件数据集上进行尝试,期望落地到实际生活应用中。

[1] WANG W.Machine audition: principles, algorithms and systems[M].New York: IGI Publishing, 2010: 4-5.

[2] 刘亚荣, 黄昕哲, 谢晓兰, 等.美尔谱系数与卷积神经网络相组合的环境声音识别方法[J].信号处理, 2020, 36(6): 1020-1028.

LIU Yarong, HUANG Xinzhe, XIE Xiaolan, et al.Environmental sound recognition method combining Meir spectral coefficients and convolutional neural network[J].Journal of Signal Processing, 2020, 36(6): 1020-1028.(in Chinese)

[3] 杨浩聪, 史创, 李会勇.保留立体声相位信息的声音场景分类系统[J].信号处理, 2020, 36(6): 871-878.

YANG Haocong, SHI Chuang, LI Huiyong.Acoustic scene classification system using binaural phase information[J].Journal of Signal Processing, 2020, 36(6): 871-878.(in Chinese)

[4] GENCOGLU O, HUTTUNEN H, VIRTANEN T.Recognition of acoustic events using deep neural networks[C]∥Proceedings of the 22nd European signal processing conference(EUSIPCO).Lisbon, Portugal: IEEE, 2014:506-510.

[5] KRIZHEVSKY A, SUTSKEVER I, HINTON G E.ImageNet classification with deep convolutional neural networks[J].Communications of the ACM, 2017, 60(6): 84-90.

[6] HAN Y, LEE K.Convolutional neural network with multiple-width frequency-delta data augmentation for acoustic scene classification[J].IEEE AASP Challenge on Detection and Classification of Acoustic Scenes and Events, 2016.

[7] SALAMON J, BELLO J P.Deep convolutional neural networks and data augmentation for environmental sound classification[J].IEEE Signal Processing Letters, 2017, 24(3): 279-283.

[8] MIKOLOV T,KARAFI T M, BURGET L, et al.Recurrent neural network based language model[C]∥Proceedings of the Conference of the International Speech Communication Association.Chiba, Japan: ISCA, 2010: 1045-1048.

T M, BURGET L, et al.Recurrent neural network based language model[C]∥Proceedings of the Conference of the International Speech Communication Association.Chiba, Japan: ISCA, 2010: 1045-1048.

[9] KIM H G, KIM J Y.Acoustic event detection in multichannel audio using gated recurrent neural networks with high-resolution spectral features[J].ETRI Journal, 2017, 39(6): 832-840.

[10] CHO K, VAN MERRIENBOER B, GULCEHRE C, et al.Learning phrase representations using RNN encoder-decoder for statistical machine translation[C]∥Proceedings of the 2014 Conference on Empirical Methods in Natural Language Processing(EMNLP).Doha, Qatar.Stroudsburg, PA, USA: Association for Computational Linguistics, 2014: 1724-1734.

[11] XU Yong, KONG Qiuqiang, WANG Wenwu, et al.Large-scale weakly supervised audio classification using gated convolutional neural network[C]∥2018 IEEE International Conference on Acoustics, Speech and Signal Processing(ICASSP).Calgary, AB, Canada.IEEE, 2018: 121-125.

[12] KONG Qiuqiang, XU Yong, WANG Wenwu, et al.Audio set classification with attention model: A probabilistic perspective[C]∥2018 IEEE International Conference on Acoustics, Speech and Signal Processing(ICASSP).Calgary, AB, Canada.IEEE, 2018: 316-320.

[13] WANG Yun, LI Juncheng, METZE F.A comparison of five multiple instance learning pooling functions for sound event detection with weak labeling[C]∥ICASSP 2019-2019 IEEE International Conference on Acoustics, Speech and Signal Processing(ICASSP).Brighton, UK.IEEE, 2019: 31-35.

[14] KONG Qiuqiang, XU Yong, WANG Wenwu, et al.Sound event detection of weakly labelled data with CNN-transformer and automatic threshold optimization[J].IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2020, 28: 2450-2460.

[15] MESAROS A, HEITTOLA T, VIRTANEN T.Metrics for polyphonic sound event detection[J].Applied Sciences, 2016, 6(6): 162.

[16] PARK D S, CHAN W, ZHANG Yu, et al.SpecAugment: A simple data augmentation method for automatic speech recognition[C]∥Interspeech 2019.ISCA: ISCA, 2019: 2613-2617.

[17] DUCHI J, HAZAN E, SINGER Y.Adaptive subgradient methods for online learning and stochastic optimization[J].Journal of Machine Learning Research, 2011, 12(7): 257-269.