1 引言

歌声检测(Singing Voice Detection, SVD)严格来说是检测音乐中存在的歌声区域的过程。但在实践中,我们往往是检测帧级别的音乐片段是否含有歌声。歌声检测是音乐信息检索(Music Information Retrieval, MIR)领域的重要基础性工作,歌手识别[1],旋律提取[2],歌声分离[3-4],歌词对齐[5]等研究方向都把歌声检测作为前驱工作或者增强技术。歌声检测的主要难点是鉴别歌声和乐器的声音。要在混合了乐器和歌声的音乐片段中判断是否含歌声,对机器来说目前仍是颇具挑战性的工作。特别是一些乐器在制作过程中,发声原理就是根据人的发声过程来模拟制作的,鉴别它们和人声更是困难的事情。当前歌声检测工作主要集中在流行音乐领域,最近Krause等研究了歌剧中的歌声检测[6]。

一般地,歌声检测通过特征提取和分类两个步骤来完成。特征提取是根据歌声区别于乐器的特性,对音乐信号进行变换、降维等加工处理的过程。早期的特征提取技术大多来自于语音识别,在提取的特征中,最常用的特征是经过短时傅里叶变换后的时频图,其变形包括梅尔时频图和对数梅尔时频图等。其他特征还包括梅尔频率倒谱系数MFCCs(Mel Frequency Cepstral Coefficients)、线性预测系数LPCs(Linear Predictive Coefficients)、过零率ZCR(Zero Cross Rate)等等。后来研究人员开始注重挖掘歌声的音乐特性,并组合多个包含传统语音特性和音乐固有特性的特征,一同作为歌声检测的最终特征。Regnier等认为歌声的特征包括和声(Harmonicity)、共振峰(Formants)、颤音(Vibrato)和震音(Tremolo)[7],并提出一种提取颤音和震音参数来进行歌声检测的方法;Mauch等提出了从基音波动和旋律信息中提取歌声特征的方法[8]。Lehner等提出一种基于基音波动的动谱特征(Fluctogram)[9],并辅以两个可靠因子:谱平坦因子(Spectral Flatness)和谱收缩因子(Spectral Contraction)来鉴别歌声和乐器,并组合MFCCs来进行歌声检测。Zhang等在他们的歌声检测算法中组合了包括Chroma在内的8种不同的特征[10]。上述深度挖掘音乐信号信息,提取歌声特征的复杂过程,是歌声检测过程的特征工程。

分类步骤根据特征工程提取的特征,对音乐片段进行分类。分类方法包括两种:基于传统分类器的方法和基于深度神经网络DNN(Deep Neural Network)分类器的方法。传统的分类器包括隐马尔可夫模型HMM(Hidden Markov Model)、支持向量机SVM(Support Vector Machine)、随机森林RF(Random Forest)等;DNN分类器包括各种卷积神经网络CNN(Convolutional Neural Network)[11]分类器、各种循环神经网络RNN(Recurrent Neural Network)[12-13]分类器、以及各种混合CNN和RNN的分类器,比如LRCN(Long-Term Recurrent Convolutional Network)[10]分类器。

特征工程,再加上DNN强大的分类能力使得基于DNN的算法占据当前最高歌声检测水平的行列[9-10]。事实上,DNN的分类能力强大来自于它的特征学习能力。因此,在歌声检测算法领域,有一种新的趋势是把特征工程和分类两个独立的过程统一到一个DNN框架,一步完成(以下称统一DNN框架)。Schlüter等在CNN中[11,14],Leglaive等在RNN中[13]都没有特征工程步骤,网络输入是简单的时频图特征。其中文献[14]输入网络的是梅尔时频图,而文献[11,13]输入网络的是对数梅尔时频图。对于统一CNN框架算法[14],文献[15]在Jamendo数据集下做了比较,其性能(准确率为86.8%)和经过复杂特征工程的RF算法(准确率为87.9%),以及经过歌声分离预处理的RNN算法相比(准确率为87.5%)差距很小,说明统一DNN算法是可行的。

本文探讨的是如何在统一CNN框架下提升歌声检测算法性能的问题。在统一CNN算法中,学习到的特征,可以认为存在于各层次的特征图中,是通过卷积核“观察”上一层特征图得到的。然而对于一般CNN学习到的特征,CNN在“观察”他们时往往不进行重要性区分,在网络中所占权重相同。针对这一问题,本文提出在卷积神经网络中嵌入点积自注意力模块的算法,该算法通过学习得到各个特征的注意力分布,调整注意力权重,使得卷积神经元在“观察”这些特征时能区分轻重,从而提升网络的整体性能。

2 相关研究

2.1 注意力机制背景

Graves等首次提出神经网络中的注意力机制[16],他在设计神经图灵机的内存时提出一种基于内容的寻址机制,不同于传统的基于确定性的地址和存储内容的读写,这种读写机制是对工作内存的模糊(blurry)操作。例如在读操作过程中,某时刻的读操作可以用如下公式表示:

r=softmax(g(k,M))M

(1)

其中M=(m1,m2,...mn)T是工作内存矩阵,包含n个行向量,k是读写头产生的关键字向量,而![]() 是一个余弦函数,其中u,v是两个向量,该余弦函数用来度量k和工作内存的行向量mi,i∈[1...n]之间的相似性。此时,读出的向量r是内存向量的加权求和。这种机制就是余弦注意力机制。

是一个余弦函数,其中u,v是两个向量,该余弦函数用来度量k和工作内存的行向量mi,i∈[1...n]之间的相似性。此时,读出的向量r是内存向量的加权求和。这种机制就是余弦注意力机制。

自从Graves等的注意力机制在RNN实施后,对于DNN中的注意力机制研究迅速升温,Bahdanau等提出了应用于机器翻译和文字对齐的加性注意力模型[17],Luong等提出了一系列全局和局部注意力的模型,同样应用于机器翻译[18]。

2.2 点积自注意力网络

以上提及的注意力模型目标都是为某一外部向量求解注意力分布,Vaswani等提出著名的自注意力网络(或称缩放点积自注意力网络,本文统称为点积自注意网络),则是关注自身内部向量的关系[19]。他把向量键值对〈k,v〉和查询向量q通过点积自注意力(Scaled dot-product, Sdp)映射为另一个向量,其矩阵形式的映射过程可用如下公式表示:

(2)

其中dk是关键字向量k的维度,Q,Κ,V分别是多个查询向量q和多个向量键值对〈k,v〉组成的矩阵。虽然点积自注意力和余弦注意力机制都包含了点积过程,但是二者的性质差别很大,一是关注点不一样,自注意力模型关注的是内部向量之间的关系;二是计算注意力分布时,自注意力模型不是度量真实向量之间的相似性,而是度量和中间向量k的相似性,向量k是真实向量v的抽象,这就为实际操作带来了更多的灵活性。

2.3 基于CNN的歌声检测模型

图1构造的CNN网络是典型歌声检测算法模型之一,文献[15]使用的CNN模型和文献[11,14]都是基于此模型的,该模型包含4个卷积层和3个全连接层,本文把该模型当做基准的对比模型。

图1 基于CNN的歌声检测网络结构图

Fig.1 The network structure of singing voice detection based on CNN

上图中,每个卷积层后面有一个LeakyRelu增强非线性,每两个卷积层分别紧跟一个最大值池化层缩小特征图组成一个卷积组模块,卷积层的输出通道数按顺序分别是64, 32, 128, 64,卷积层的输出特征图进入全连接层前平铺成向量,然后进入三个线性变换层逐层降低向量的维度,每个线性变换紧跟一个Dropout层防止过拟合,线性变换的输出长度分别是128, 64, 1,最后输出的一维向量用于二分类。

3 算法模型

3.1 算法动机

在一般基于CNN的方案中,每一层次的特征都是不加重要性区分地进入下一层,下一层“观察”他们时,把他们的权重看成相同的,然而这些由CNN学习到的特征往往对歌声检测起着不同的作用,有些特征显著而重要,需要得到重点“关注”,而有些特征因其作用微弱需要得到抑制。

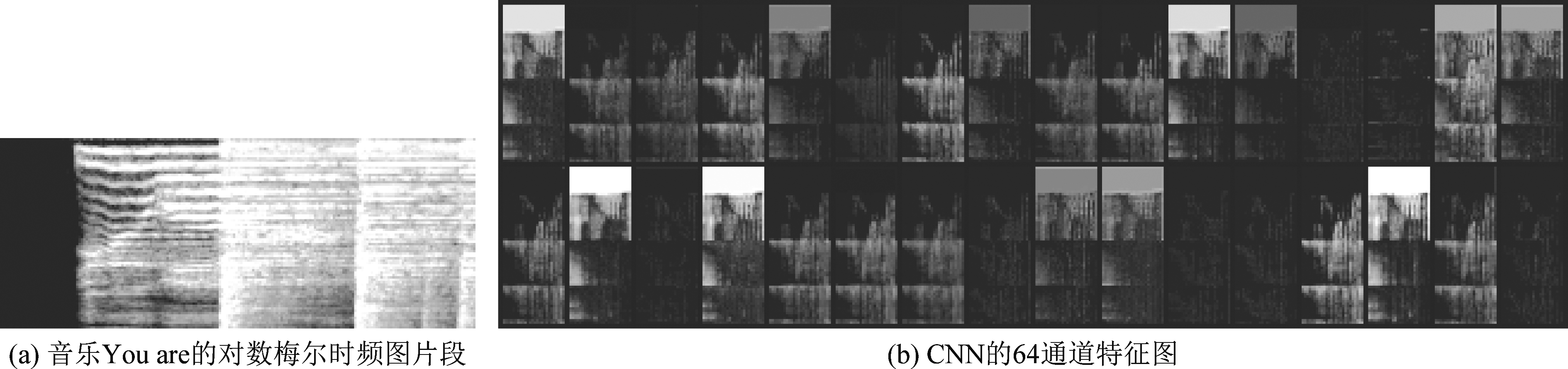

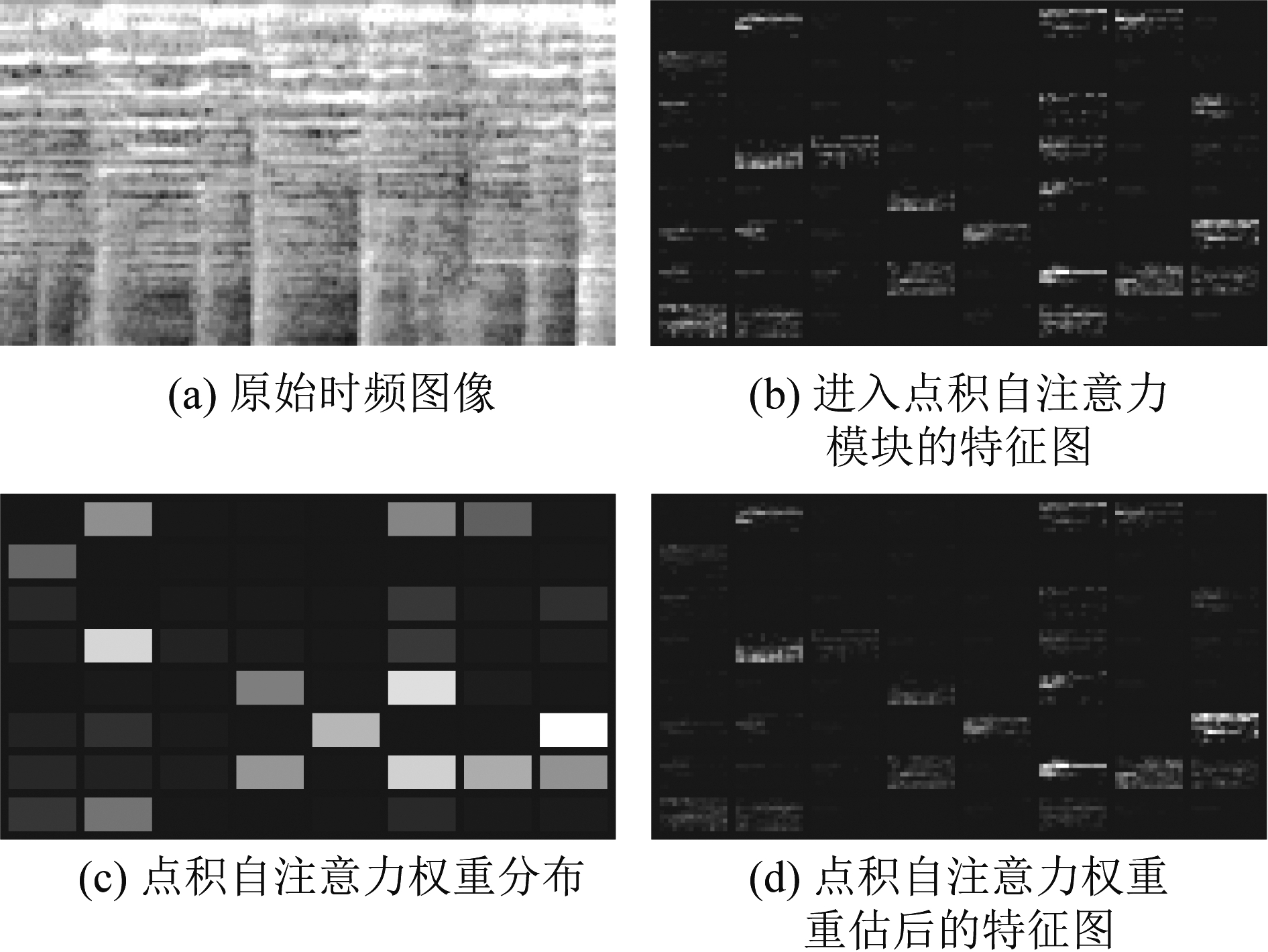

例如图2中,图2(b)是图2(a)输入的对数梅尔时频图片段在一个CNN中间层的64通道输出的特征图。CNN的下一层在“观察”该64个特征图时,按照一般CNN的处理方式,其对应的权重是相等的,但是从图2(b)中用肉眼显然能看出,他们的权重不应该是相等的,比如其中的黑色特征图因信息量少其权重应该小。因此,如果给这些通道加入权重指标,或者说“观察”时的注意力分布值,让CNN把“注意力集中”在关键特征图上,其鉴别特征能力应能得到提高。

图2 音乐You are的对数梅尔时频图输入片段和CNN中间层各通道输出特征图

Fig.2 An image from the log-mel spectrogram of the music “you are” and the corresponding output feature maps from a CNN median layer

3.2 点积自注意力卷积神经网络模型

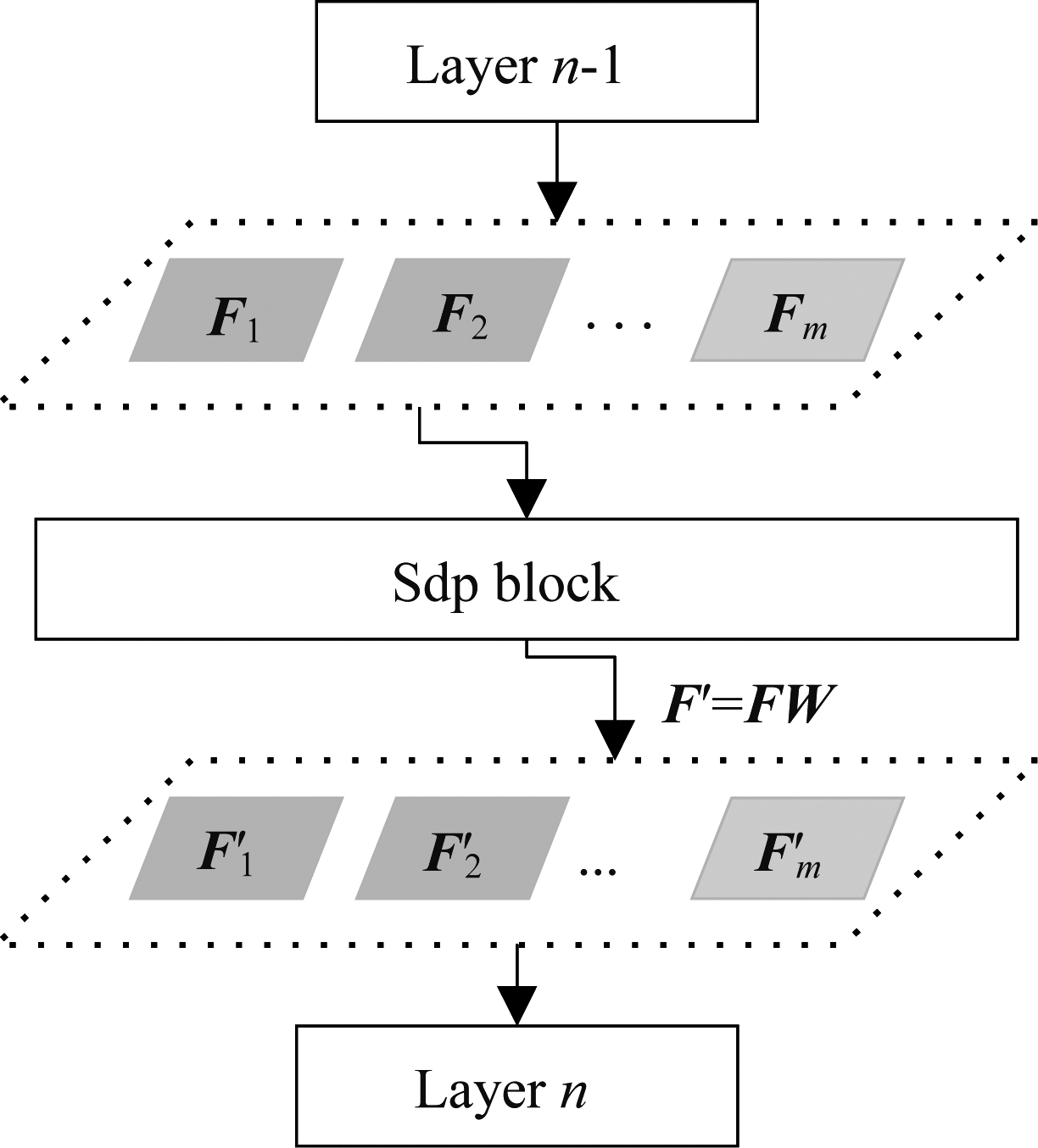

本算法的目标是通过自注意力模型,将CNN中学习到的特征根据注意力分布进行重估,然后再进入下一层网络,其模型可通过图3描述。图中CNN网络的n-1层的特征图F=(F1,F2,…,Fm)经过Sdp模块进行了注意力重估,转换成![]() 再进入到第n层网络。

再进入到第n层网络。

图3 特征图注意力重估

Fig.3 The attention is adjusted for the feature maps

大多数自注意力网络应用于机器翻译,构建于RNN,据作者所知,到目前为止,没有自注意力网络在歌声检测框架中的应用。为了适用于CNN模型的歌声检测,对自注意力网络需要做如下调整:

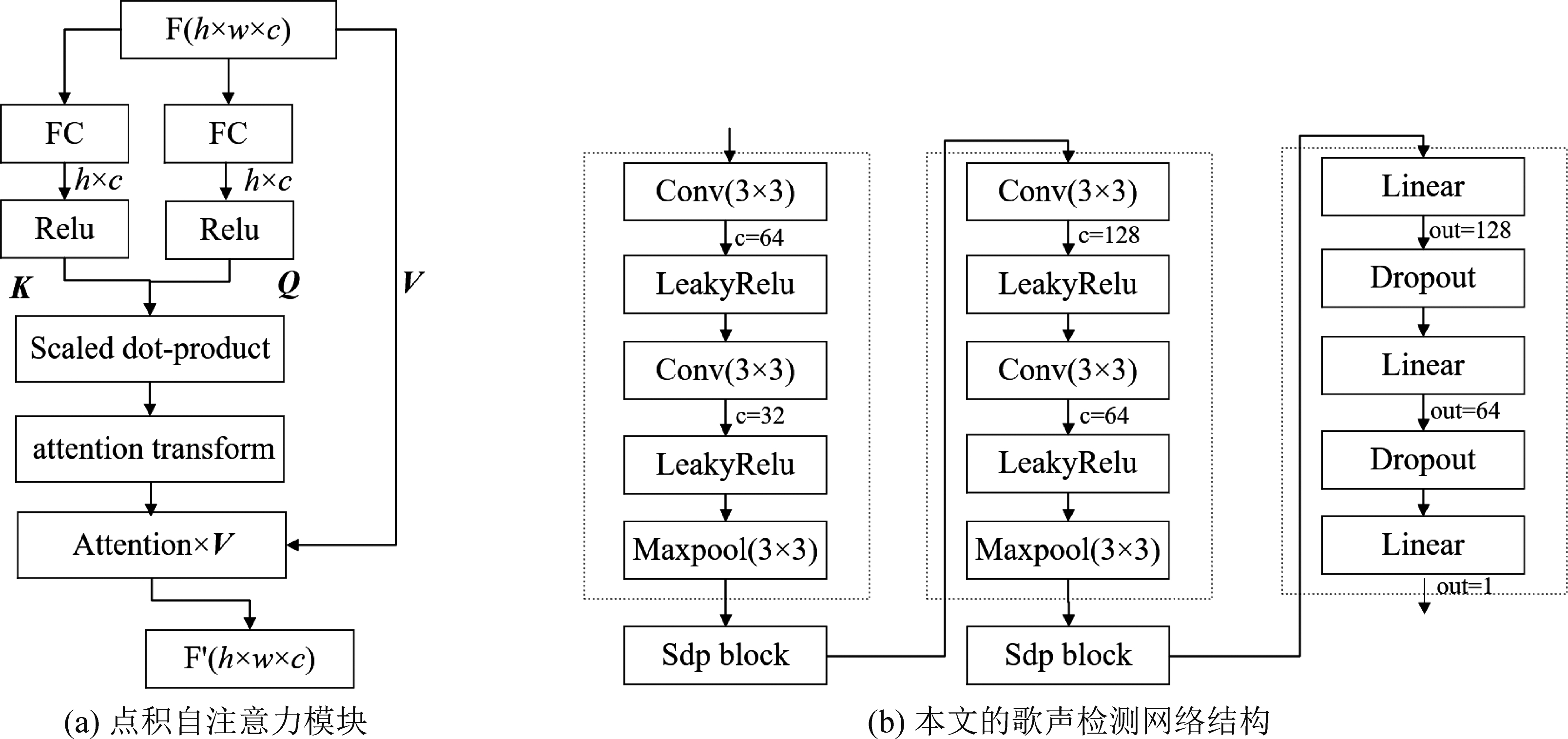

(1)q,k,v的表达含义变化。原自注意力网络的q,k,v在进行点积前都进行了线性变换,而本文的v保持不变,代表原特征图,网络学习到的自注意力分布和v相乘可得到新的特征图;而q,k,它们分别经过线性变换,长度由h×w变为h,代表着特征图的抽象,其中k是特征图v的键值,q是特征图查询向量,q,k在线性变换后都经过一个Relu单元,以增强非线性特性,如图4(a)。

图4 本文点积自注意力模块和网络结构

Fig.4 The module structure of the scaled dot-product attention and the network structure

(2)q,k,v的长度不等。原自注意力网络处理对象是词向量,输入与输出向量长度相等,三者保持长度不变,有利于各层次网络处理。而本算法的处理对象是对数梅尔时频图,且CNN网络的特征图大小在网络中发生变化,因此,这三者的向量长度应自适应变化。本算法中q,k的长度保持和特征图的高度相同,而高度是时频图中的频率个数;v的长度是特征图的高度和宽度之积,是特征图展开的向量。

(3)增加一个注意力分布变换(attention transform)机制。本算法在得到注意力分布后,还增加了一个变换机制,从分布矩阵形式变换为特征图的权重向量,降低了注意力重估的复杂度。变换过程可以用以下公式表示:

w=mean(R(1-E),dim=1)

(3)

其中R和E分别是自注意力分布矩阵和单位对角矩阵,R(1-E)则将注意力分布矩阵的对角线置零,不计算查询向量对自身的注意。在特征图的频率维度(dim=1)上取均值得到各特征图的注意力权重w(attention)。最后得到加权注意力后的特征图F′=wV。

为了检验点积自注意力模块的有效性,本文对图1基准模型进行改造,嵌入点积自注意力模块。嵌入的方法是在两个卷积组模块后分别进行嵌入,如图4(b),这样就在基准模型中一共增加了两个点积自注意力模块。增加的模块分别对其输入的特征图进行注意力权重重估,并把重估后的特征图送入到网络的下一层。由此,我们可以通过嵌入前后的实验结果来检验模块的有效性。此外,对于CNN中输出1维改成输出2维(图4(b)最后一个线性变换),用以应用交叉熵损失函数,由于嵌入前后均使用同样的交叉熵损失函数,因此,不会改变实验结果的公平性。

3.3 对数梅尔时频图输入

本算法重点关注对特征的注意力重估,因此忽略复杂的特征工程。本算法的输入是歌声检测中的常用基本特征,即对数梅尔时频图(log mel-spectrogram),首先对音频文件进行短时傅里叶变换,计算时分别对音频数据序列左右分别填充窗口长度的一半,此处音频文件采样率为22050 Hz,窗长为1024,帧移为315,时频的时间分辨率是14.3 ms;然后对傅里叶变换后的时频图进行梅尔刻度规范化,考虑到音乐的频率范围,此处频率区间取[27.5, 8000]Hz,梅尔频率数量取80个;最后对梅尔时频图的幅值取对数,便可得到对数梅尔时频图。得到的对数梅尔时频图实际上是一个二维的矩阵, 矩阵的行表示梅尔频率序号,矩阵的列对应音乐的进行时间。

输入到CNN网络时,从对数梅尔时频图矩阵的起始列位置开始提取图像,图像大小为80×115,提取下一个图像时设置跳数为5列,直到该对数梅尔时频图到达末尾为止。这里如果跳数设置为1,则图片总数量增加5倍。但是,通过我们实验,其实验结果和跳数为5的情况下仅有细微差别,因此,为节省计算时间,跳数设置为5。图像的宽度决定了输入到卷积神经网络的每个图像所属的音乐时长,为1.6 s。跳数决定了算法的检测精度,为71.5 ms。

3.4 网络设置

本文算法中点积自注意力卷积神经网络的实验部分基于Pytorch平台,通过Homura[20]封装网络输入和训练组件进行实现。模型采用Adam作为训练优化器,并在算法中通过早停机制和限制最大训练轮数来控制训练的终止。本文算法中的早停次数设置为10次,最大训练轮数设置为50轮。歌声检测可看成是一个二分类问题,因此,损失函数使用二分类交叉熵损失函数。又因为流行音乐中一般歌声占比大,纯乐器部分占比小,所以损失函数最终采用加权二分类交叉熵损失函数。在算法的实验中,权重设置为数据集中的歌声和非歌声的样本数量比例。设数据集中有N个样本,样本预测为歌声的概率为xi,样本所属标签为yi,其权重为wi则算法的加权二分类交叉熵损失函数为:

(4)

其中i∈[1,N]。

4 实验

4.1 数据集

为了验证算法的有效性,本文一共选择了2个公开数据集进行实验,一个是数据集RWC中的流行歌曲(简称RWC),另一是数据集Jamendo(简称JMD),两个数据集都有歌声和非歌声的标注信息。其中RWC包含100首流行歌曲,共407分钟,生成的图像总数量为33.9万个;JMD包含93首歌曲,共371分钟,生成的图像总数量为30.8万个。在训练集、验证集和测试集的划分问题上,对JMD来说,一般是采用原始的划分[15],对于RWC,没有看到公开的划分方式。为了进一步消除测试集与验证集分布差异,两个数据集的划分都引入交叉验证,在划分前将音乐文件的顺序进行洗牌,保证随机性。对于JMD,采用的是准6折交叉验证,在保证测试集中音乐文件全覆盖的基础上,前5次划分中训练集、验证集和测试集的音乐文件数量比例为61∶16∶16,最后一次为61∶16∶13。对于RWC,采用的是5折交叉验证,训练集、验证集和测试集的音乐文件数量比例为3∶1∶1。此外,RWC和JMD的歌声和非歌声的样本数量比分别为1.12和1.55,这个比例将在加权二分类交叉损失函数中使用。

4.2 基准系统实现

本实验是为了比较在CNN中嵌入点积自注意力模块前后的网络性能变化,其中2.3小节中描述的基于CNN的歌声检测系统是用于比较的基准系统。对于该系统的实现,文献[15]有公开的在keras框架的实现代码,但是为了保持各条件不变的情况下对比实验结果,因此把文献[15]的代码移植到和本文算法实现相同的Pytorch框架,这样网络的训练、验证和测试方法可以保持一致。

4.3 特征图的注意力分布

深度神经网络的不可解释性是它的一个主要弱点。虽然我们无法通过分析完全解释本文点积自注意力模块通过注意力分布调整达到提升CNN歌声检测效果的来龙去脉,但是,通过展示网络的特征图注意力分布可以加深对过程的理解。图5是音乐You are的一个对数梅尔时频图片段(如图5(a)),进入本文构造的基于点积自注意力的卷积神经网络,在第二个嵌入点积自注意模块前后的特征图的比较,每个特征图大小为8×12。从图5(b)中看到经过一系列网络“观察”处理后,64个通道的特征图中分别出现了“辨别是否含有歌声”的纹理特征,然而,这些特征图在辨别能力方面各有差异,点积自注意力网络通过注意力学习,给这些特征图赋以一定的注意力权重(图5(c)的灰度小图片表示了对应特征图的权重)。在一般CNN中没有点积自注意力模块,这些权重全是相同的,图5(c)中的灰度小图片应呈现全白色。经过注意力重估后,点积自注意力模块输出的特征图如图5(d),从前后特征图对比来看,施加了注意力分布后,64个特征图中有部分偏白的纹理特征变得暗淡或者消失了(如图5(d)中的最左列的部分小特征图),这说明部分歌声辨别贡献小的特征图被抑制或剔除了。

图5 音乐You are的一个对数梅尔时频图片段在点积自注意力权重重估前后的特征图比较

Fig.5 Comparison between the input feature maps and the output feature maps of a scaled dot-product attention module, with an input image from the log-mel spectrogram of the music “you are”

4.4 实验结果

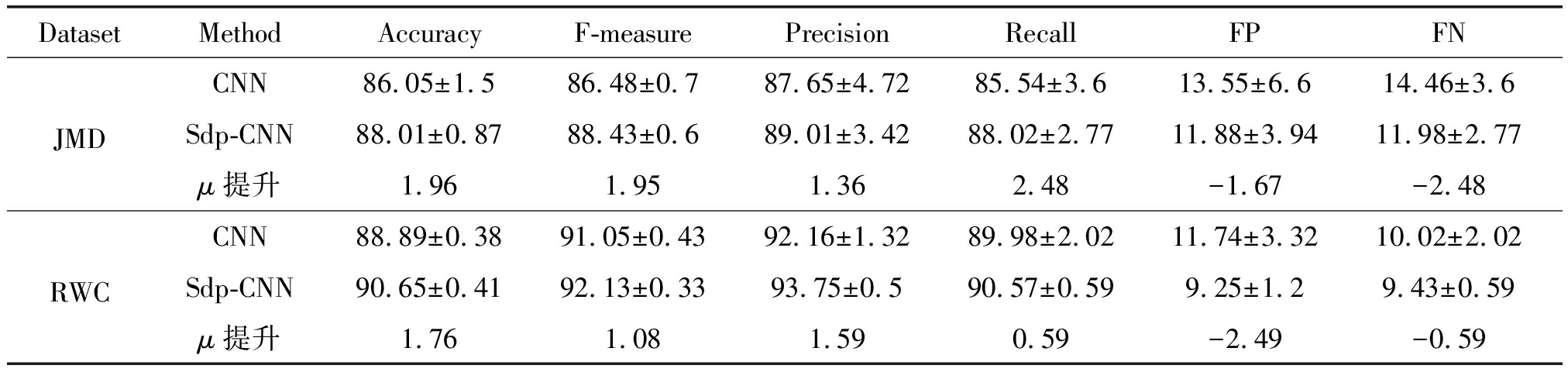

实验结果的评估标准包括准确率(Accuracy)、F值(F-measure)、精确率(Precision)、召回率(Recall)、假正例(FP)和假负例(FN)比率,其中F值是精确率和召回率的综合。JMD和RWC的各指标是准6折和5折交叉实验结果的百分点均值和方差(μ±σ),实验结果见表1。在保持JMD原有数据划分的情况下,文献[15]中CNN的准确率为86.8%,而在此划分下,我们执行三次得到的准确率均值为86.54%,两者结果基本一致,这在一定程度上反应本实验中算法实现的正确性。从表中可看出,在JDM和RWC两个数据集下,本算法相对基于CNN的算法,准确率和F值均有提升,FP和FN均有所下降,这说明在CNN中嵌入点积自注意力模块对歌声检测的有效性。总的来说,在RWC下的结果要好于JMD,这是因为RWC的歌曲都是流行歌曲,其训练、验证、测试集的分布相对JMD来说更趋一致,网络相对容易学习到更有效的特征。

表1 本文算法和基于CNN的算法实验结果(%)对比

Tab.1 The experimental result(%)comparison between the proposed algorithm and the traditional CNN based algorithm

DatasetMethodAccuracyF-measurePrecisionRecallFPFNJMDCNN86.05±1.586.48±0.787.65±4.7285.54±3.613.55±6.614.46±3.6Sdp-CNN88.01±0.8788.43±0.689.01±3.4288.02±2.7711.88±3.9411.98±2.77μ提升1.961.951.362.48-1.67-2.48RWCCNN88.89±0.3891.05±0.4392.16±1.3289.98±2.0211.74±3.3210.02±2.02Sdp-CNN90.65±0.4192.13±0.3393.75±0.590.57±0.599.25±1.29.43±0.59μ提升1.761.081.590.59-2.49-0.59

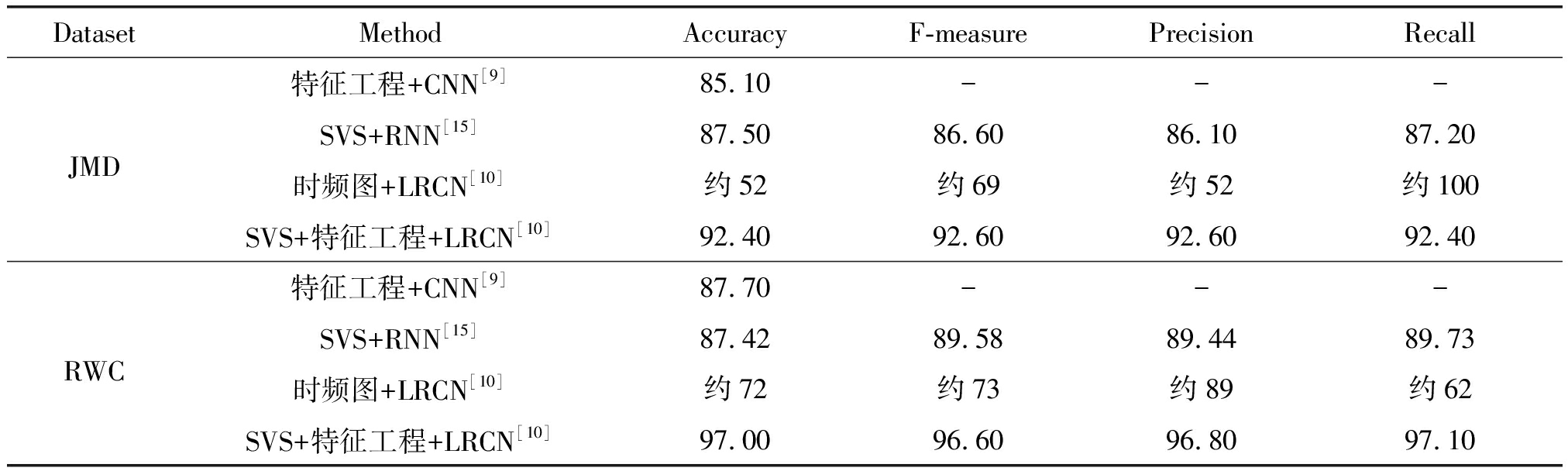

本文提出的歌声检测算法是没有特征工程情况下的统一CNN方法。表2中列出了代表当前DNN最高检测水平的检测结果。表中各实验设置如数据集和参数等相互之间存在不一致的情况,但不妨碍进行比较,对于实验设置的差异这里不再赘述。基于LRCN的方法[10]在JMD和RWC下都具有明显的优势,但是这种方法包含复杂的特征工程,而且依赖歌声分离(Singing Voice Separation,SVS)做预处理,而一个很好的SVS预处理算法将大幅降低歌声检测的难度。再者,在仅输入时频图没有特征工程的情况下,其结果大幅下降(由于原文没有提供具体数值,表中相关数据是通过原文的柱状图估计的),准确率在JMD和RWC下,比本文算法均值分别要低33%和19%。此外,表中可看出本文算法的准确率均值,还在JMD和RWC(88.01%和90.65%)下分别超过了文献[9]的特征工程+CNN的方法和文献[15]的SVS+RNN方法2.91%和0.51%、2.95%和3.23%。

表2 代表当前DNN最高检测水平的实验结果(%)

Tab.2 The experimental results(%)of the state-of-the-art DNNs

DatasetMethodAccuracyF-measurePrecisionRecallJMD特征工程+CNN[9]85.10---SVS+RNN[15]87.5086.6086.1087.20时频图+LRCN[10]约52约69约52约100SVS+特征工程+LRCN[10]92.4092.6092.6092.40RWC特征工程+CNN[9]87.70---SVS+RNN[15]87.4289.5889.4489.73时频图+LRCN[10]约72约73约89约62SVS+特征工程+LRCN[10]97.0096.6096.8097.10

5 结论

本文提出一种新型歌声检测算法,在卷积神经网络中嵌入了点积自注意力模块,该模块使得卷积网络学习到的特征在网络中的注意力分布不再是相同的,这种注意力重估机制使得各特征得到网络不同的对待,从而提升整体网络性能。通过实验证实,在原基准CNN模型中嵌入点积自注意力模块,歌声检测的准确率和F值等指标均有一定的提升。

[1] HSIEH T H, CHENG K H, FAN Zhecheng, et al.Addressing the confounds of accompaniments in singer identification[C]∥ICASSP 2020-2020 IEEE International Conference on Acoustics, Speech and Signal Processing(ICASSP).Barcelona, Spain.IEEE, 2020: 1-5.

[2] KUM S, NAM J.Joint detection and classification of singing voice melody using convolutional recurrent neural networks[J].Applied Sciences, 2019, 9(7): 1324-1341.

[3] PRÉTET L, HENNEQUIN R, ROYO-LETELIER J, et al.Singing voice separation: A study on training data[C]∥ICASSP 2019-2019 IEEE International Conference on Acoustics, Speech and Signal Processing(ICASSP).Brighton, UK.IEEE, 2019: 506-510.

[4] 张天, 张天骐, 葛宛营, 等.基于2DFT变换的伴奏音乐分离方法[J].信号处理, 2019, 35(10): 1708-1713.

ZHANG Tian, ZHANG Tianqi, GE Wanying, et al.Accompaniment music separation using 2DFT transform[J].Journal of Signal Processing, 2019, 35(10): 1708-1713.(in Chinese)

[5] GUPTA C,Y LMAZ E, LI Haizhou.Automatic lyrics alignment and transcription in polyphonic music: Does background music help?[J].ICASSP 2020-2020 IEEE International Conference on Acoustics, Speech and Signal Processing(ICASSP), 2020: 496-500.

LMAZ E, LI Haizhou.Automatic lyrics alignment and transcription in polyphonic music: Does background music help?[J].ICASSP 2020-2020 IEEE International Conference on Acoustics, Speech and Signal Processing(ICASSP), 2020: 496-500.

[6] KRAUSE M, MÜLLER M, WEIß C.Singing voice detection in opera recordings: A case study on robustness and generalization[J].Electronics, 2021, 10(10): 1214-1228.

[7] REGNIER L, PEETERS G.Singing voice detection in music tracks using direct voice vibrato detection[C]∥2009 IEEE International Conference on Acoustics, Speech and Signal Processing.IEEE, 2009: 1685-1688.

[8] MAUCH M, FUJIHARA H, YOSHII K, et al.Timbre and melody features for the recognition of vocal activity and instrumental solos in polyphonic music[C]∥2011 12th International Society for Music Information Retrieval Conference(ISMIR).Florida, USA.2011: 233-238.

[9] LEHNER B, SCHLÜTER J, WIDMER G.Online, loudness-invariant vocal detection in mixed music signals[J].IEEE/ACM Transactions on Audio, Speech, And Language Processing, 2018, 26(8): 1369-1380.

[10] ZHANG Xulong, YU Yi, GAO Yongwei, et al.Research on singing voice detection based on a long-term recurrent convolutional network with vocal separation and temporal smoothing[J].Electronics, 2020, 9(9): 1458-1481.

[11] SCHLÜTER J.Learning to pinpoint singing voice from weakly labeled examples[C]∥2016 International Society for Music Information Retrieval(ISMIR).New York, USA, 2016: 44-50.

[12] LEHNER B, WIDMER G, BÖCK S.A low-latency, real-time-capable singing voice detection method with LSTM recurrent neural networks[C]∥2015 23rd European Signal Processing Conference(EUSIPCO).Nice, France.IEEE, 2015: 21-25.

[13] LEGLAIVE S, HENNEQUIN R, BADEAU R.Singing voice detection with deep recurrent neural networks[C]∥2015 IEEE International Conference on Acoustics, Speech and Signal Processing(ICASSP).South Brisbane, QLD, Australia.IEEE, 2015: 121-125.

[14] SCHLÜTER J, GRILL T.Exploring data augmentation for improved singing voice detection with neural networks[C]∥International Society for Music Information Retrieval(ISMIR).Malaga, Spain, 2015: 121-126.

[15] LEE K, CHOI K, NAM J.Revisiting singing voice detection: A quantitative review and the future outlook[C]∥International Society for Music Information Retrieval Conference.Paris(France), Paris(France).International Society for Music Information Retrieval, 2018.

[16] GRAVES A, WAYNE G, DANIHELKA I.Neural turing machines[EB/OL].2014.https:∥arxiv.org/abs/1410.5401.

[17] BAHDANAU D, CHO K, BENGIO Y.Neural machine translation by jointly learning to align and translate[EB/OL].2014.https:∥arxiv.org/abs/1409.0473.

[18] LUONG T, PHAM H, MANNING C D.Effective approaches to attention-based neural machine translation[C]∥Proceedings of the 2015 Conference on Empirical Methods in Natural Language Processing.Lisbon, Portugal.Stroudsburg, PA, USA: Association for Computational Linguistics, 2015:1412-1421.

[19] VASWANI A, SHAZEER N, PARMAR N, et al.Attention is all you need[C]∥Advances in Neural Information Processing Systems, 2017: 5998-6008.

[20] HOMURA.Homura package[EB/OL].2019.https:∥github.com/moskomule/homura.