1 引言

情感计算通过赋予计算机识别、理解和表达情感的能力,达到使计算机更加人性化的目的。作为一个高度综合化的领域,随着心理学、计算机科学的发展,情感计算逐渐成为人机交互发展突破的关键,而情感识别作为情感计算的重要部分,也受到了广泛的关注。目前,情感识别已经应用于医学、教育、交通运输等与日常生活息息相关的领域[1],随着智能穿戴设备等技术的应用和普及,情感识别技术的应用也会更加广泛。

常见情感识别方法可以根据输入信号类型的不同分成基于非生理信号和基于生理信号的情感识别[2]。目前情感识别领域常用的情感信息载体主要有人脸图片、语音信号等非生理信号和脑电信号、皮肤电信号等生理信号。面部表情识别作为情感识别领域的重要发展方向,目前已取得较大的进展;语音情感识别也随着数据集的不断丰富而得到快速发展。如果情感识别的情感信息载体不止一种,称为多模态情感识别。

实验表明在大多数情况下,多模态情感识别系统远比对应最优的单模态情感识别系统更准确[3-5]。但由于数据集和生理信号理论知识的限制,更多的研究着眼于非生理信号之间的多模态融合。目前在多模态情感识别领域,非生理信号和生理信号的模态融合方面的研究虽有收获但仍有很大的发展空间,离散情感类别数少、准确率低都是目前面临解决的难题。

本文的研究重点是实现并优化面部表情识别系统和语音情感识别系统,提高模型的泛化能力,并实现融合视频模态和音频模态的多模态情感识别,达到较高的准确率。

在了解现有技术的基础上,本文实现的多模态情感识别模型融合了面部表情信号和语音信号。心理学家Mehrabian的研究表明,人与人通过交流所传递的信息中,仅有7%是通过语言传递的,通过面部表情和声音传递的信息分别高达55%和38%[6]。为了尽可能完整地捕捉到情感信息,本文将面部表情和语音信号这两个携带情感信息较多的非生理信号进行模态融合,最终得到多模态情感识别模型,并取得较好的识别结果。

2 相关工作

2.1 面部表情识别

面部表情是人类表达情感和意图最自然、最普遍、最有力的信号之一[7]。面部表情识别领域发展至今,研究成果丰富,已经形成了较为完整的体系。识别流程主要包括图像获取、预处理、特征提取和分类,其中预处理部分通常包括人脸识别、归一化、数据增强等。

传统的面部表情识别方法大多采用手工特征或浅层学习特征,但随着数据集的扩大、计算能力的提高以及各种有效网络结构的提出,越来越多的研究将深度学习技术应用到面部表情识别领域。

在面部表情识别的特征学习与分类判别模块,常见的深度学习技术有卷积神经网络(convolutional neural network, CNN)、深度置信网络(deep belief network, DBN)、深度自编码器(deep autoencoder, DAE)、循环神经网络(recurrent neural network, RNN)和生成对抗网络(generative adversarial network, GAN)等,其中CNN的应用最为普遍。

CNN被广泛应用于计算机视觉领域,研究表明CNN对于位置变化和尺度变化具有鲁棒性,并且在陌生人脸姿态变化的情况下表现得比多层感知机(multilayer perceptron, MLP)更好[8-9]。除此之外,R-CNN(Region-CNN)和Faster R-CNN也常用于面部表情特征学习[10-11]。

因为深度学习方法的应用,最新的面部表情识别方法研究很少强调人脸图像所提取的特征,往往是在图像进行人脸识别、归一化等预处理步骤后就送入网络,在网络中进行特征提取和分类判别,而网络所反馈的就是表情预测结果。但事实上,不管是传统方法还是深度学习方法,人脸表情的特征选取都十分重要。

用于面部表情识别的常用特征主要有几何特征、统计特征、频率域特征和运动特征等。几何特征主要是人脸的一些明显特征,比如五官的位置和大小、形状;统计特征主要是进行主成分分析(Principal Component Analysis,PCA)和独立成分分析(Independent Component Analysis)得到人脸表情的统计特征;频率域特征是对图像作频域变换,针对频域信息提取特征。

基于静态图片的面部表情识别在使用深度学习技术进行训练时,可以采取一定的策略对情感识别模型进行优化。预训练和微调能有效缓解深层网络在数据量较小的数据集上训练出现过拟合的问题,在网络结构中增加辅助块或改进层结构能使网络结构更适用于具体情境,此外还有网络集成、多任务网络、网络级联等优化方法[12]。

考虑到面部表情识别是数据驱动型任务,同时需要训练深层网络来学习表情特征,现有的数据集往往存在标注准确率不高、采样人员的选择范围局限、部分类别样本量小的问题,所以目前面部表情识别领域面临的挑战之一是缺乏样本量大且质量高的训练数据。同时,光照、姿势、阴影等对面部表情识别的结果影响很大,怎样有效提高识别系统的鲁棒性也是研究的重点之一。

2.2 语音情感识别

由于情感识别领域的语音语料库规模远远小于语音识别领域和说话人识别领域,所以目前语音情感识别还有很大的提升空间。目前最常用的语音情感识别的研究方法主要集中于特征提取和模型性能优化,以及二者结合共同作用语音情感识别。

特征提取方面,目前语音情感识别致力于从语音的不同维度提取关键的情感信息。由于梅尔倒谱系数等手工特征的维度一般不超过50,而基于预训练模型提取的特征往往在1000维左右,所以也称手工特征为低维特征,基于预训练模型提取的特征称为高维特征。Xu于2019年提出的分层粒度和特征模型(Hierarchical Grained and Feature Model HGFM)[13]使用了语音的低维特征包括过零率、常数Q变换和梅尔倒谱频率以及语音的高维特征包括语音的方差等,将不同维度的情感信息拼接在一起,这样提取的情感表示既保留了语音在一段很短的时间内的帧级情感信息,同时又含有句间的情感信息,可以反应一段时间内的情感变换,可以对音频情感识别产生较大的增益。

除了使用不同维度的手工特征,使用模型自动的从语音中提取适合下游模型的特征也是目前情感识别领域的一个研究热点。目前常用的做法是使用多个卷积层作为语音情感信息的特征提取器,从卷积层中提取原始语音编码后的高维特征作为情感识别系统的情感表示。研究表明,使用卷积层提取的情感表示相比于常见的手工特征往往保留更多的帧级情感信息,这一特性有助于情感识别模型挖掘语音中细微的情感变化,从而做出更准确的情感预测。

由于语音中的情感信息多出现于一定时间内音调,语速等特征的变化上,所以情感识别模型需要具有一定的时间上的记忆能力,才能更准确的预测语音中的情感。Xu在分层粒度和特征模型中使用的语音情感识别模型为分层门控循环单元框架(Hierarchical Gated Recurrent Unit, HiGRU)[14]。该模型具有前向和后向的记忆能力,通过将短时的帧级情感信息经过门控单元后编码为高维情感表示,再将该编码后的高维情感表示与语音中提取出的高维情感表示拼接,通过注意力机制选择合适的情感表示,再使用第二层的门控单元预测选择出的情感表示代表的情感。该方法可以有效捕捉语音中的帧级情感信息的变化和高维情感信息,比较好的使用了手工特征中含有的情感信息,是目前使用手工特征进行语音情感识别的常用方法。

2.3 多模态融合

已有实验证明[3-5]:在大多数情况下,多模态情感识别系统远比对应最优的单模态情感识别系统更准确。目前的多模态情感识别,可以根据混合的模态分为多种非生理信号混合、多种生理信号混合以及非生理信号和生理信号混合三种模式。其中非生理信号混合的多模态情感识别因其数据集采集难度较小,单模态情感识别领域发展较快,目前已经取得较大的进展,尤其是面部表情和语音语调信号的多模态融合[15]。而随着生理信号采集设备的发展和推广,非生理信号和生理信号混合的多模态情感识别也受到了越来越多的关注[16-18]。

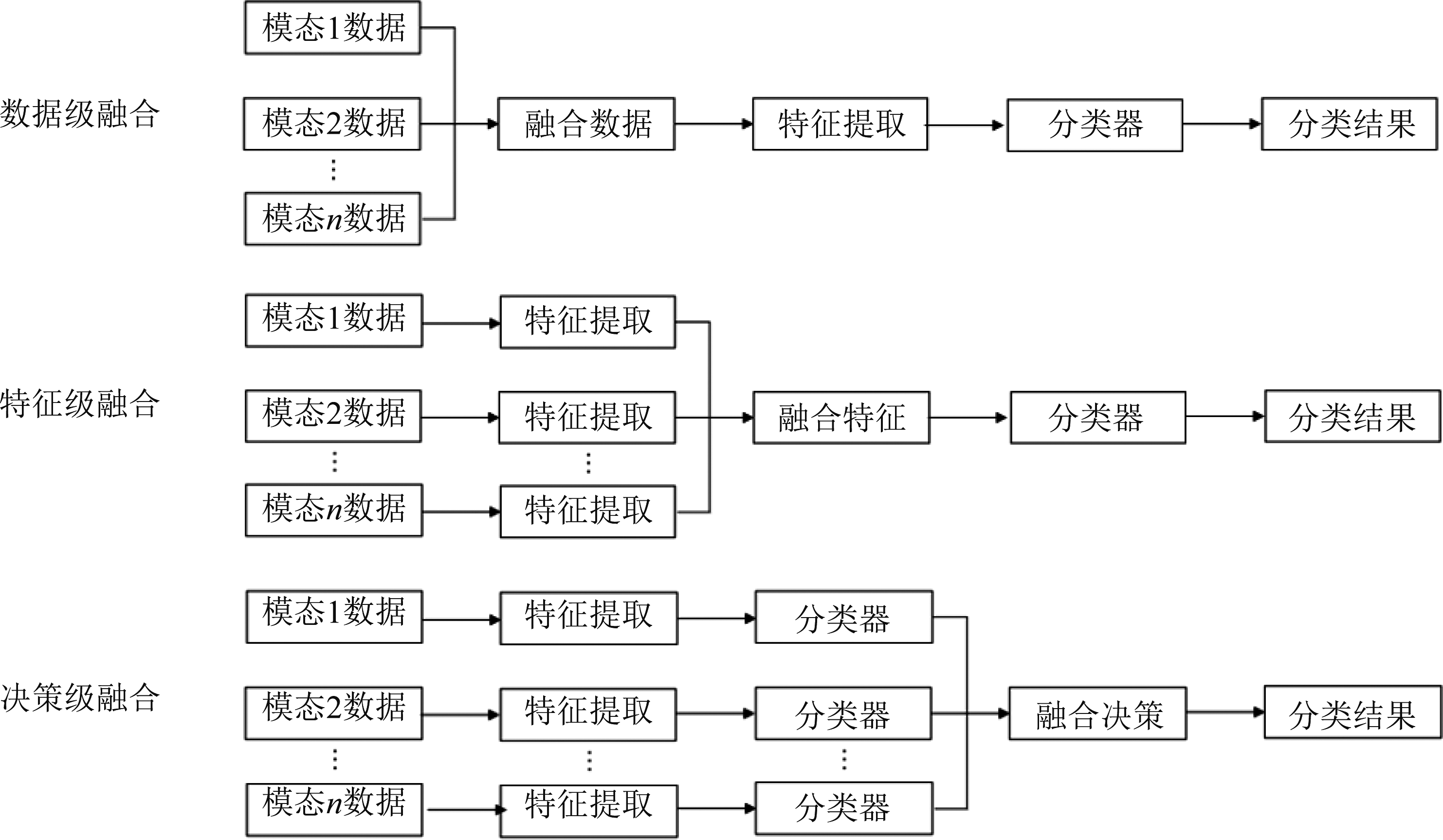

各模态之间的融合策略可以根据融合层次大致分为数据级融合、特征级融合和决策级融合[1]。图1展示了三种融合策略的系统流程图。

图1 融合策略流程图

Fig.1 Flowchart of the fusion strategy

数据级融合针对各模态未进行特殊处理的数据,各模态原始数据未经预处理操作就进行组合得到模态融合后的数据,最后将融合数据作为识别网络的输入进行训练或识别。由于对原始数据进行融合可以最大限度地保留样本信息,数据级融合可以有效保持样本信息的完整度,但由于各模态数据之间差距较大,融合过程相对复杂,且融合后的数据可能包含不少冗余信息。PCA变换、小波变换等都是常用的数据级融合方法。

特征级融合将各模态的特征拼接成一个大的特征向量后送入分类器进行分类识别。特征级融合的融合对象是各模态的特征,虽然会丢失部分信息,但只要特征选取得当,不会造成信息的大量丢失,同时也能提高融合的计算速度。

决策级融合是在各模态通过分类器得到预测概率后,根据各个模态的可信度决定各模态权重和融合策略,得到融合后的分类结果。决策级融合过程相对简单,计算速度快,但由于各模态存在相关性,而决策级融合往往将各模态独立看待,通常会丢失各模态间的相关性,在部分情境下并不适用。

上述三种融合策略,复杂程度依次降低,对系统其余流程的依赖性依次提高,通常需要针对具体情况选择具体的多模态融合策略。

随着硬件计算能力的提高和应用需求的增加,包含大量情感信息且数据集采集方法较为成熟的音视频情感识别的研究成果不断丰富。目前的音视频情感识别领域主要采用的模态融合策略为特征级融合和决策级融合。

特征级融合能够保留更多的数据信息。Kim等人[19]提出了一种二层DBN网络结构,首先分别学习音频和视频模态的特征,再连接两个模态的特征来学习第二层,最后用支持向量机(Support Vector Machine, SVM)对连接后的特征进行评估分类。Tzirakis等人[20]以端到端的方式训练模型,利用CNN提取音频特征,利用ResNet50提取视频特征,级联特征后使用长短时记忆网络(Long Short-Term Memory, LSTM)对上下文进行建模。

但由于特征级融合对计算能力有较高的要求,容易导致维数灾难,决策级融合的应用也较为常见。Sahoo等人[21]分别用隐马尔可夫模型(Hidden Markov Model, HMM)和SVM评估检测音频模态和视频模态后,根据不同情况下的决策规则对双模态结果进行融合。决策级融合的结构复杂程度较低,且不需要严格的时序同步,在部分应用场景下有较好的表现。

3 面部表情识别模型的实现

3.1 模型实现

ResNet残差网络是当前应用最为广泛的CNN特征提取网络之一。我们直观认为,深度学习网络的层数越深,网络模型的效果越好,能力越强。但实验发现CNN深度网络达到一定深度后,一味增加层数并不能带来性能的提高,甚至会导致网络的退化,在分类问题上的准确率相较于浅层网络反而会有所下降。Kaiming He等人结合计算机视觉领域的残差概念,提出了一种新的CNN网络结构——ResNet[22],解决了随着网络层数的增加而出现的网络退化问题并使网络结构的性能得到提升。

ResNet网络参考了VGG19[23]的网络结构,在其基础上加入了残差单元。ResNet遵循两个简单的设计原则:对于输出相同大小的feature map,过滤器数量相同;当feature map大小减半时,过滤器的数量翻倍以保持网络层的复杂度[23]。

在本次实验中我们选择ResNet18作为基础的学习特征的网络结构,网络结构如图2所示。ResNet18包含17个卷积层和1个全连接层,这些卷积层构成一个预处理块和四个残差网络块,每个残差网络块包含两个残差学习的基本单元,每个基本单元中包含两个卷积层,除了第一个残差网络块,其余三个残差网络块都会在第一个基本单元的直接映射部分进行下采样操作,使得直接映射部分的输出和残差部分的输出大小保持一致。

图2 ResNet18网络结构[22]

Fig.2 The network structure of ResNet18[22]

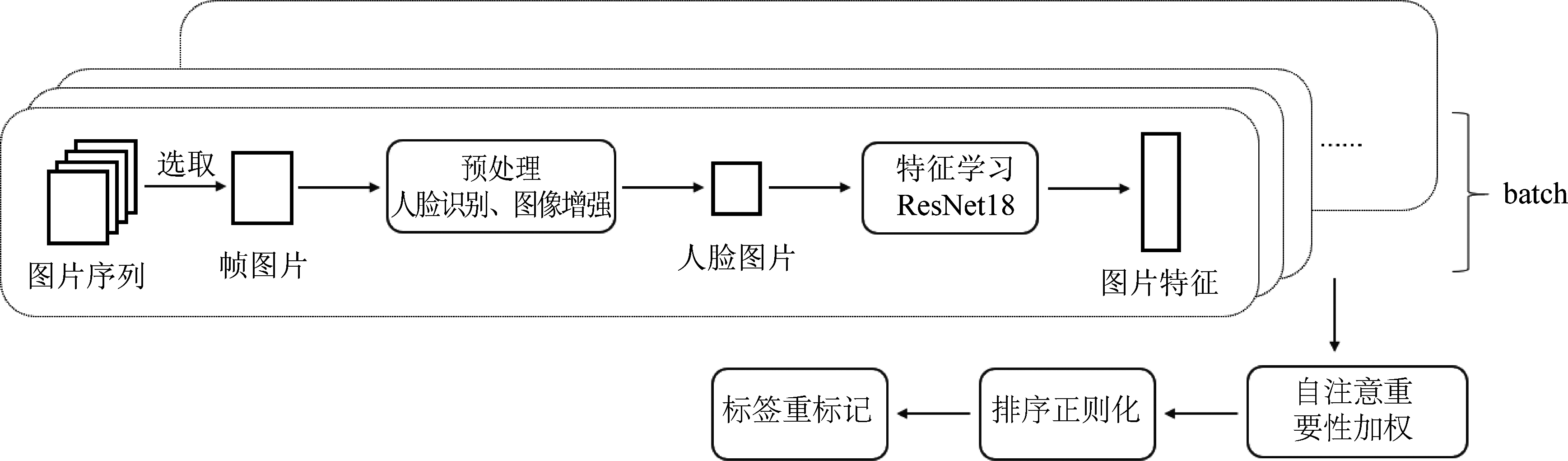

在ResNet18的基础上,我们参考Kai Wang等人[24]的工作,实现了基于ResNet18的系统框架。如前文提到的,目前大多数公开的数据集或多或少都存在人脸图像质量不高的问题,这种不确定性会对深度学习网络的学习造成困难。系统框架主要针对这种不确定性,设计模块,尝试实现系统对不确定性的抑制。

网络主要从两个方面抑制不确定性:第一,小批量的自注意力机制对训练样本进行排序正则化加权;第二,重标记模块对排序较低的样本进行标签修改。

系统由三个关键模块组成:自注意重要性加权、排序正则化和重标记。给定一批图像,首先通过ResNet18提取面部表情特征。然后,自注意重要性加权模块为每个样本学习一个权重来表示样本重要性,不确定性高的样本的权重较低,进行损失加权。接着,排序正则化模块将这些权重按降序排列,将它们分成两组(即高权重组和低权重组),并通过在两组的平均权重之间设置一个边缘宽度来对这两组进行正则化。这种正则化是通过一个损失函数来实现的,称为秩正则化损失(RR-Loss)。排序正则化模块确保第一个模块学习有意义的权值来突出某些样本(如可靠的标注),抑制不确定样本(如模糊标注)[24],达到防止过拟合的效果。最后一个模块是重标记模块,它试图通过比较最大预测概率与给定标签的概率,对低权重组重新标记这些样本。如果最大预测概率高于给定标签的一个边缘阈值,那么样本被分配到一个伪标签。系统通过上述环节对输入的数据进行调整以降低不确定性的影响。

3.2 模型训练

根据3.1小节搭建基线系统。

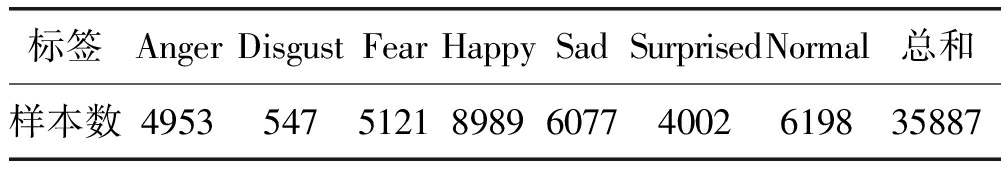

首先我们选择公开数据集FER2013作为面部表情识别模型的训练集。FER2013包含35887张人脸图片,每张图片均为大小固定为48×48的灰度图像[25]。图片的标签分为七类,数字标签0~6分别依次对应标签:生气、厌恶、恐惧、开心、伤心、惊讶和中性。FER2013数据集中各标签的图片样本数和总样本数见表1。训练过程中将FER2013样本的80%作为训练集,20%作为测试集。

表1 FER2013样本数

Tab.1 The sample size of FER2013

标签AngerDisgustFearHappySadSurprisedNormal总和样本数49535475121898960774002619835887

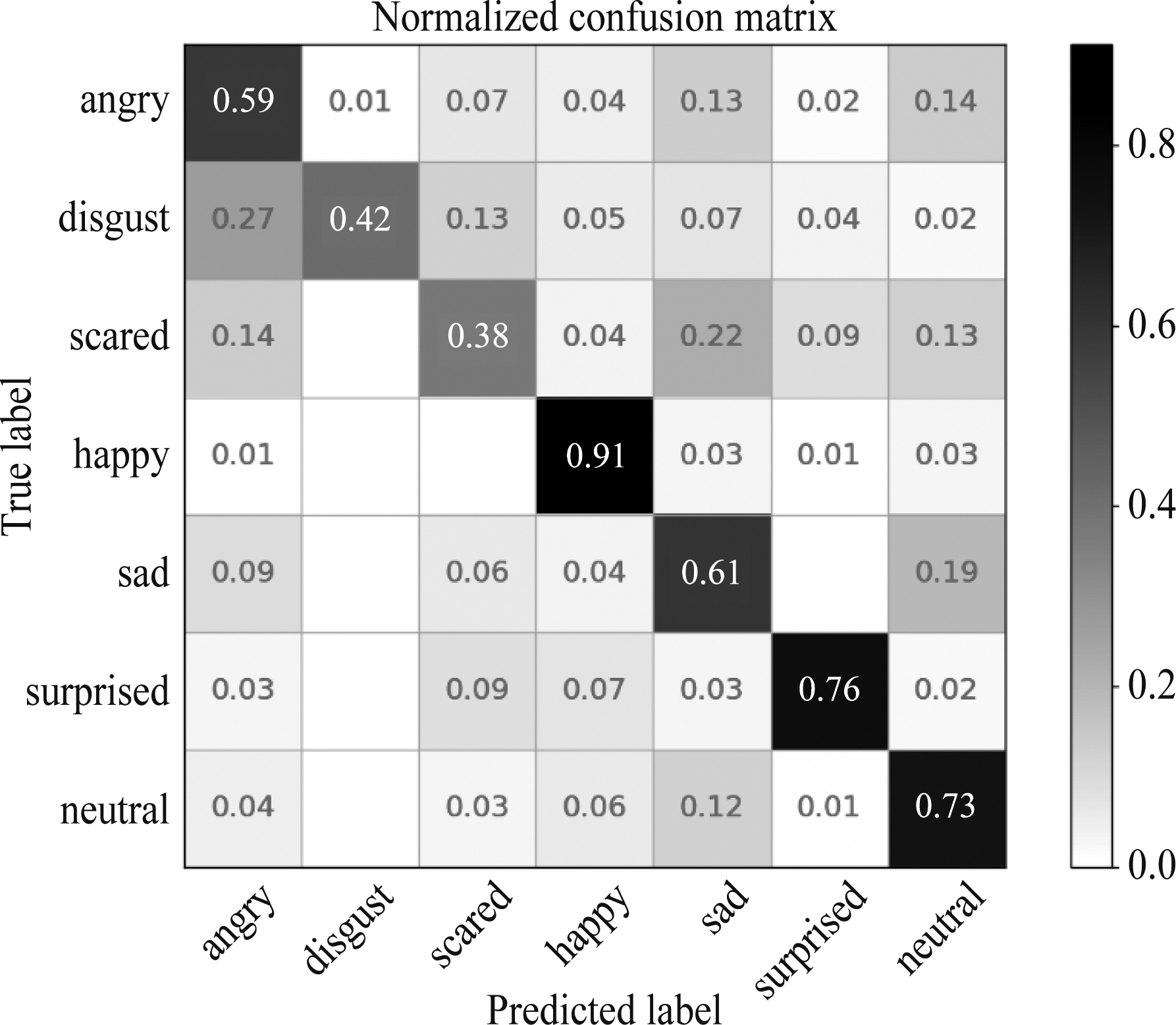

经过训练和参数调试,ResNet18模型在FER2013测试集上的七分类准确率达到了68.32%,混淆矩阵如图3所示。其中恐惧和厌恶两类的召回率相对较低,分别为38%和42%。标签为恐惧的人脸图片有22%被识别为伤心,而标签为厌恶的图片有27%被识别为生气。

图3 ResNet18模型在FER2013测试集上的七分类混淆矩阵

Fig.3 Seven classification confusion matrix of ResNet18 on the FER2013 testset

通过对错误样本的分析,可以发现恐惧和厌恶的低召回率主要是由数据集的样本质量导致的。观察数据集中标签为恐惧的图片,可以发现恐惧表情的表现特征并不好归纳,大多数图片中的人脸蹙眉、嘴角向下撇,但这样的表情和伤心的表情非常相似,单凭人眼判断也很难分辨。还有部分图片中的表情睁大双眼、张开嘴巴,这又和惊讶的表情非常雷同。

图4展示了FER2013数据集中标签为恐惧的部分样本,除了有非人脸图片的出现,人脸有遮挡、角度问题等也容易影响模型的判断,另外恐惧的面部表情特征比较细微,和伤心、惊讶等表情难以区分,也为情感识别带来了挑战。

图4 FER2013数据集中标签为恐惧的部分样本

Fig.4 Part of the samples labeled fear in FER2013

同样地,标签为厌恶的样本中也有一部分因为表情比较夸张,单凭人的判断也很容易判断为生气。因此,混淆矩阵中恐惧和厌恶的召回率较低是可以预见的。

通过七分类模型的训练,我们可以发现ResNet18网络在面部表情识别系统中能表现出较好的识别性能,适合作为视频模态的模型进行后续的多模态融合操作。

由于FER2013数据集所包含的样本为人脸表情图片,只适用于面部表情识别领域。而我们希望能实现视频模态和音频模态的融合,需要选择包含视频和音频模态信号的数据集。因此我们选择了IEMOCAP公开数据集[26]。

IEMOCAP包含大约12小时的视听数据,包括视频、语音、运动捕捉、文本转录等模态的信息,记录了10位演员在即兴表演或脚本场景中的数据,由多位注释员注释标签,每组标签对应的数据平均持续时间为4.5秒。用到的情感评价模型有两种,其一是VAD(Valence, Arousal and Dominance)情感模型,从三个维度对样本进行评价,其二是离散情感模型,将情感分为9类:生气、伤心、开心、厌恶、害怕、惊讶、挫败、激动和中性,在实验中我们采用离散情感评价标准。

为了后续和音频信号模态模型进行模态融合,我们只选用九类情感中的四类,即生气、伤心、开心和中性,用这四类标签样本数据进行ResNet18模型的训练。由于ResNet18网络的输入数据为一张图片,而IEMOCAP数据集中的数据以mp4的格式存储,故我们需要对每条样本进行处理才能得到方便训练的数据集。我们对每条样本按每秒一帧的帧率截取图片,再从截取得到的图片序列中随机抽取一张作为该条样本的面部表情识别输入图片。面部表情识别模型的系统流程图如图5所示。

图5 面部表情识别系统流程图

Fig.5 The flow chart of facial expression recognition system

在IEMOCAP上基线系统的准确率为62%,针对学习率、批尺寸等参数进行调整后,准确率达到70.70%。

4 语音情感识别模型的实现

4.1 模型实现

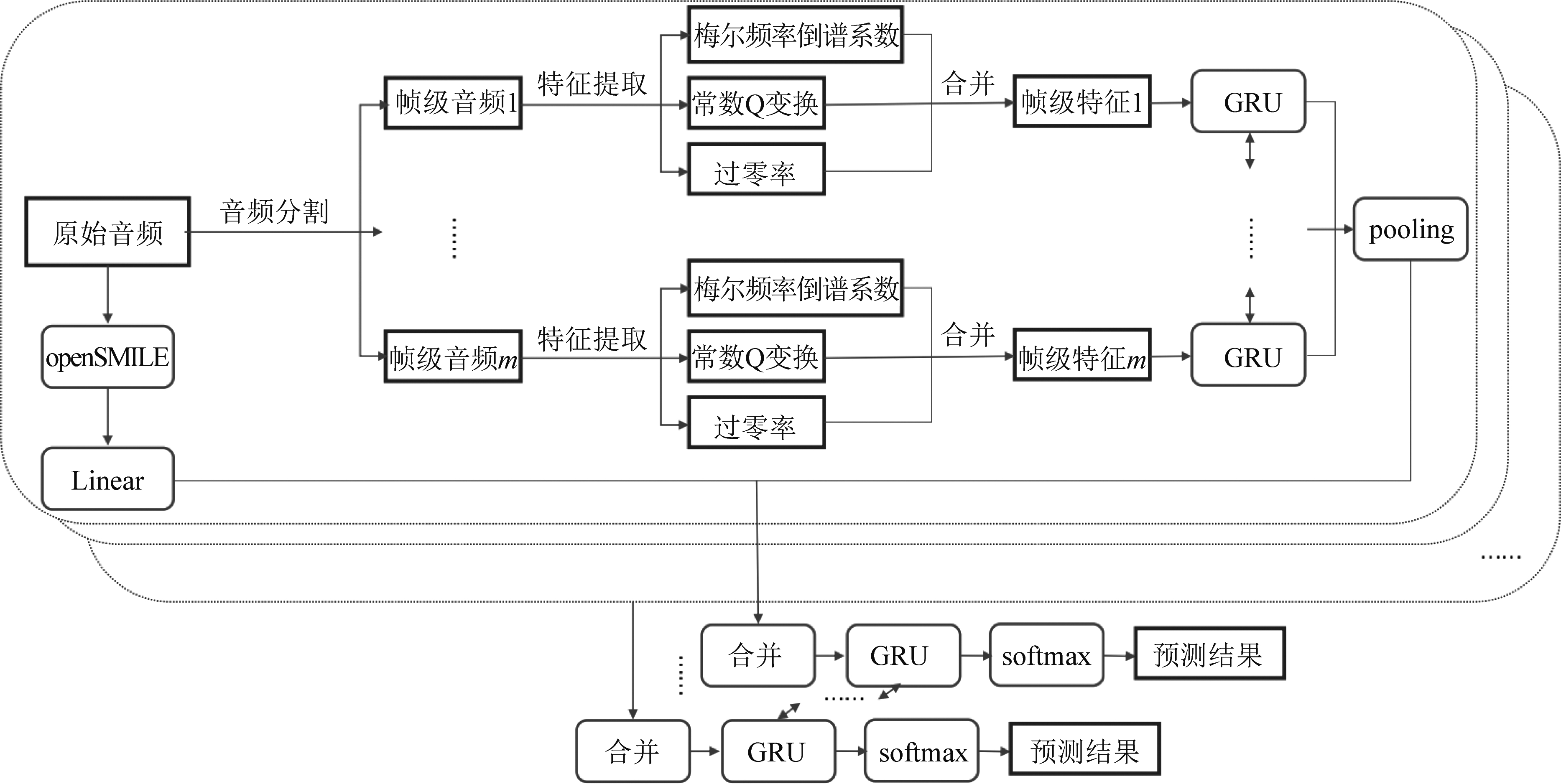

语音情感识别模型使用的是分层粒度和特征模型(Hierarchical Grained and Feature Model, HGFM)。语音情感特征使用了包括过零率、梅尔倒谱频率和常数Q变换的手工特征,通过门控循环单元(Gated Recurrent Unit, GRU)对低维的手工特征进行编码得到高维的情感特征,使用自注意力机制对编码得到的高维特征进行加权,再使用GRU对加权后的高维情感特征进行预测,得到音频模型的情感预测结果。

4.2 模型训练

我们在语音情感数据集IEMOCAP上进行实验,选择了高兴、生气、伤心和平静四种情感作为语音情感识别的目标情感。我们使用了十折交叉验证的方法划分训练集,验证集和测试集。对于IEMOCAP的每一条音频,我们先使用降噪,音频强度归一化等预处理方法处理原始音频,再提取音频每一帧的手工特征,帧长为2048个采样点,帧移为512个采样点,采样频率为22050 Hz,这样得到帧级的语音情感表示。将帧级情感表示通过图6所示的音频模型预测得到语音模型的识别结果。在模型训练中,设置进程数为4, 输入维度为33,GRU第一、二层隐藏单元维度均为300,全连接层维度为100,dropout为0.5,批尺寸为64,学习率按指数衰减,初始值为0.0007,衰减系数为0.9,损失函数选择交叉熵损失函数,优化器为adam优化器。经过多次训练实验,得到音频情感识别准确率为61.48%。

图6 基于HGFM架构的语音情感识别模型

Fig.6 The speech emotion recognition model based on HGFM

5 音视频融合的情感识别模型的实现

本次实验中多模态情感识别中的模态主要包括视频模态和音频模态,模型的训练和测试均在IEMOCAP数据集上完成。我们考虑对音频和视频模态进行特征级融合和决策级融合。

首先进行特征融合。音频和视频信号经过子网络的处理提取出了特征,再将两个模态的特征拼接在一起得到一个包含多模态信息的特征,通过一层全连接层作为分类器处理具有多模态信息的高维特征并进行分类,使用交叉熵损失函数对全连接层的输出计算损失值,并反向更新包含音频子网络,视频子网络和额外的全连接层的全部参数,通过这种方法得到特征级融合的多模态融合模型,并针对融合模型的预测结果计算准确率。

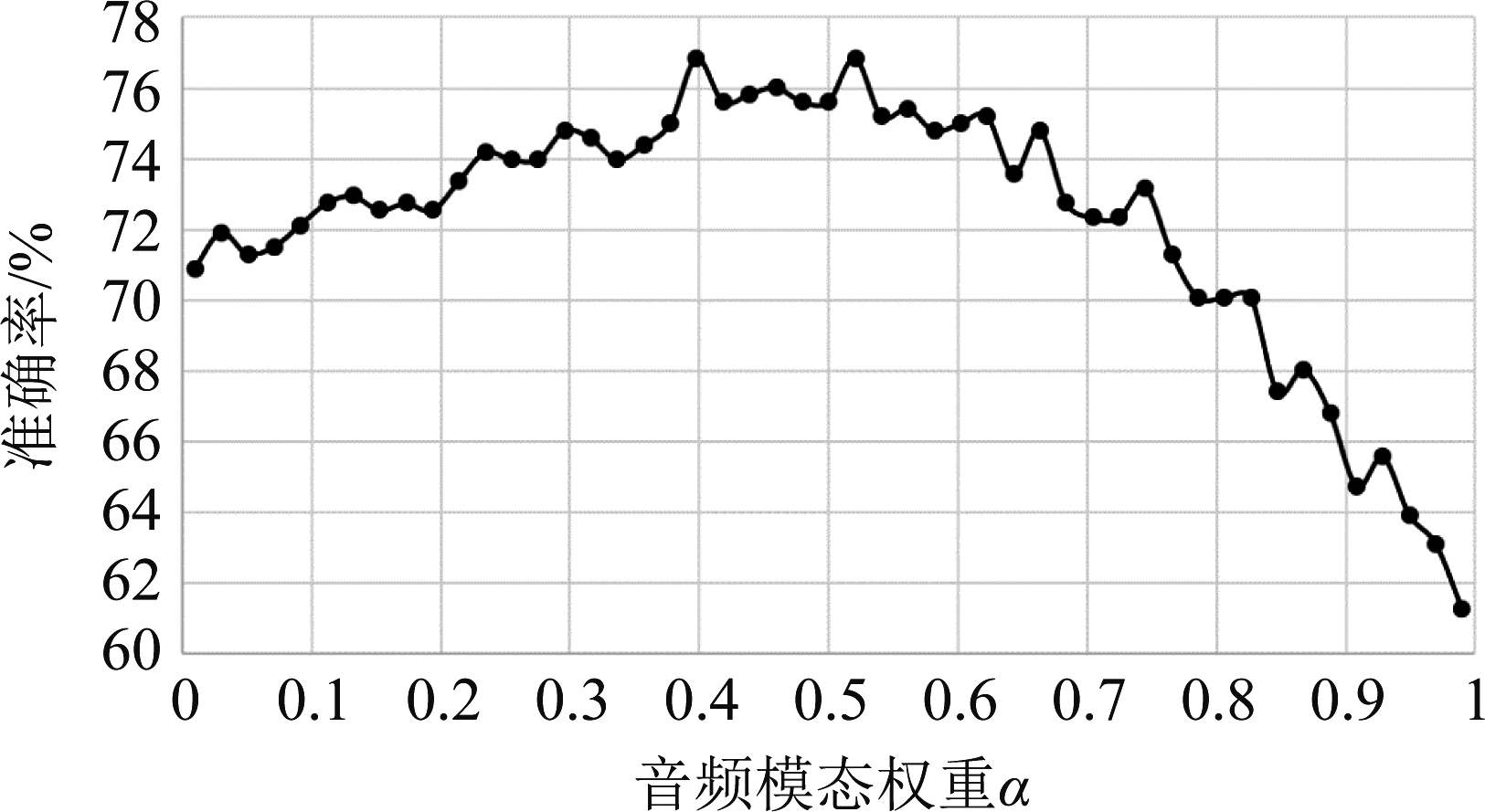

而决策级融合,是将音频和视频模态模型的输出经过softmax函数输出的概率乘以各自的权重,再将子模型对于每一类的加权概率相加,得到决策级模型的预测概率。我们在0.01到0.99之间等间距的取50个值作为音频模型的权重,同时保证视频模型的权重参数与音频模型的权重参数之和为1。分别计算了50个不同权重参数对决策级融合模型的输出结果的影响,以准确率作为衡量标准,得出音频模态的最佳权重为0.39,即音频模态以0.39的权重和权重为0.61的视频模态相加得到融合结果时具有最高的识别准确率76.84%。

音频模态权重与准确率之间的关系如图7所示。随着音频模态权重的增加,决策融合模型的准确率先呈现波动上升趋势,在权重为0.39时达到最高准确率76.84%,接着准确率随音频模态权重的增加而波动下降。

图7 决策融合中音频模态权重与准确率之间的关系

Fig.7 The relationship between weight on audio modal and accuracy in decision fusion

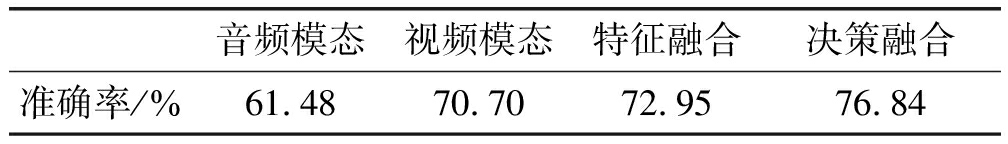

按上述融合策略得到多模态融合模型的测试结果。对于单模态,音频模态模型为61.48%,视频模态模型为70.70%,特征融合和决策融合的模型性能都强于单模态模型,分别达到了72.95%和76.84%的准确率,决策融合模型表现更为出色。

表2 多模态融合结果

Tab.2 The result of multimodal fusion

音频模态视频模态特征融合 决策融合准确率/%61.4870.7072.9576.84

目前在IEMOCAP数据集上的多模态情感识别,融合语音和文本的实验较为丰富,而音视频情感识别的研究大多采用的是相对较小的视听情感数据集,如eNTERFACE′05,在IEMOCAP上进行音视频情感识别模型训练的实验较少。对于融合语音和文本的多模态情感识别,Wu等人[27]提出了一种由时间同步分支和时间异步分支组成的双分支神经网络,实验得到的语音文本情感识别模型在IEMOCAP四种情感的数据集上准确率达77.76%;文献[28]设计了一种自监督学习结构,在IEMOCAP上训练得到了准确率为75.458%的语音文本情感识别模型;Zheng等人[29]实现的嵌入说话人信息的语音文本情感识别模型在IEMOCAP上取得了78.02%的准确率。

对于音视频情感识别,在IEMOCAP上的实验相对较少,其中性能领先的模型如下:Soujanya等人[30]设计了卷积递归多核学习的框架,采取特征融合的策略融合音频和视频模态,在IEMOCAP数据集上实现了73.34%的准确率;文献[31]采用分层融合的方式,在IEMOCAP数据集上的准确率为69.5%。本文采用ResNet18+HGFM的结构,决策融合后的音视频双模态模型的准确率达到了76.84%,与文献[31]相比提升超过7%,相比文献[30]提升了3.50%。

6 结论

本文介绍的工作主要可以分为三部分:面部表情识别系统的实现、语音情感识别系统的实现和多模态情感识别系统的实现。

在面部表情识别部分,实现了基于ResNet18的面部表情识别系统,在FER2013和IEMOCAP上都取得了不错的识别性能。在语音情感识别部分,实现了基于HGFM架构的语音情感识别模型,在IEMOCAP上表现良好。

在多模态融合部分,我们采用决策级融合和特征级融合作为多模态的融合策略。多模态模型的识别性能相对单模态模型有一定的提升,证明了多模态模型往往优于对应最优的单模态模型,最终达到了一个较好的情感识别水平。

[1] 潘家辉, 何志鹏, 李自娜, 等.多模态情绪识别研究综述[J].智能系统学报, 2020, 15(4): 633-645.

PAN Jiahui, HE Zhipeng, LI Zina, et al.A review of multimodal emotion recognition[J].CAAI Transactions on Intelligent Systems, 2020, 15(4): 633-645.(in Chinese)

[2] 聂聃, 王晓韡, 段若男, 等.基于脑电的情绪识别研究综述[J].中国生物医学工程学报, 2012, 31(4): 595-606.

NIE Dan, WANG Xiaowei, DUAN Ruonan, et al.A survey on EEG based emotion recognition[J].Chinese Journal of Biomedical Engineering, 2012, 31(4): 595-606.(in Chinese)

[3] D’MELLO S K, KORY J.A review and meta-analysis of multimodal affect detection systems[J].ACM Computing Surveys, 2015, 47(3): 1-36.

[4] PORIA S, CAMBRIA E, BAJPAI R, et al.A review of affective computing: From unimodal analysis to multimodal fusion[J].Information Fusion, 2017, 37:98-125.

[5] 黄泳锐, 杨健豪, 廖鹏凯, 等.结合人脸图像和脑电的情绪识别技术[J].计算机系统应用, 2018, 27(2): 9-15.

HUANG Yongrui, YANG Jianhao, LIAO Pengkai, et al.Fusion of facial expressions and EEG for emotion recognition[J].Computer Systems & Applications, 2018, 27(2): 9-15.(in Chinese)

[6] MEHRABIAN A, RUSSELL J A.An approach to environmental psychology[M].Cambridge: MIT Press, 1974.

[7] DARWIN C.The expression of the emotions in man and animals[M].New York: D.Appleton and Co., 1916.

[8] FASEL B.Robust face analysis using convolutional neural networks[C]∥2002 International Conference on Pattern Recognition.Quebec City, QC, Canada.IEEE, 2002: 40-43.

[9] FASEL B.Head-pose invariant facial expression recognition using convolutional neural networks[C]∥Proceedings of Fourth IEEE International Conference on Multimodal Interfaces.Pittsburgh, PA, USA.IEEE, 2002: 529-534.

[10] SUN Bo, LI Liandong, ZHOU Guoyan, et al.Combining multimodal features within a fusion network for emotion recognition in the wild[P].International Conference on Multimodal Interaction,2015.

[11] LI Jiaxing, ZHANG Dexiang, ZHANG Jingjing, et al.Facial expression recognition with faster R-CNN[J].Procedia Computer Science,2017,107: 135-140.

[12] LI Shan, DENG Weihong.Deep facial expression recognition: A survey[J].IEEE Transactions on Affective Computing, 2018, PP(99): 1.

[13] XU Yunfeng, XU Hua, ZOU Jiyun.HGFM: A hierarchical grained and feature model for acoustic emotion recognition[C]∥ICASSP 2020-2020 IEEE International Conference on Acoustics, Speech and Signal Processing(ICASSP).Barcelona, Spain.IEEE, 2020: 6499-6503.

[14] JIAO Wenxiang, YANG Haiqin, KING I, et al.HiGRU: Hierarchical gated recurrent units for Utterance-Level Emotion Recognition[EB/OL].2019.https:∥arxiv.org/abs/1904.04446.

[15] NGUYEN D, NGUYEN K, SRIDHARAN S, et al.Deep spatio-temporal feature fusion with compact bilinear pooling for multimodal emotion recognition[J].Computer Vision and Image Understanding, 2018, 174: 33-42.

[16] SOLEYMANI M, PANTIC M, PUN T.Multimodal emotion recognition in response to videos[J].IEEE Transactions on Affective Computing, 2012, 3(2): 211-223.

[17] HUANG Yongrui, YANG Jianhao, LIU Siyu, et al.Combining facial expressions and electroencephalography to enhance emotion recognition[J].Future Internet, 2019, 11(5): 105.

[18] KOELSTRA S, PATRAS I.Fusion of facial expressions and EEG for implicit affective tagging[J].Image and Vision Computing, 2013, 31(2): 164-174.

[19] KIM Y, LEE H, PROVOST E M.Deep learning for robust feature generation in audiovisual emotion recognition[C]∥2013 IEEE International Conference on Acoustics, Speech and Signal Processing.Vancouver, BC, Canada.IEEE, 2013: 3687-3691.

[20] TZIRAKIS P, TRIGEORGIS G, NICOLAOU M A, et al.End-to-end multimodal emotion recognition using deep neural networks[J].IEEE Journal of Selected Topics in Signal Processing, 2017, 11(8): 1301-1309.

[21] SAHOO S, ROUTRAY A.Emotion recognition from audio-visual data using rule based decision level fusion[J].2016 IEEE Students’ Technology Symposium(TechSym), 2016: 7-12.

[22] HE Kaiming, ZHANG Xiangyu, REN Shaoqing, et al.Deep residual learning for image recognition[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition(CVPR).Las Vegas, NV, USA.IEEE, 2016: 770-778.

[23] SIMONYAN K, ZISSERMAN A.Very deep convolutional networks for large-scale image recognition[EB/OL].2014.https:∥arxiv.org/abs/1409.1556.

[24] WANG Kai, PENG Xiaojiang, YANG Jianfei, et al.Suppressing uncertainties for large-scale facial expression recognition[C]∥2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition(CVPR).Seattle, WA, USA.IEEE, 2020: 6896-6905.

[25] GOODFELLOW I J, ERHAN D, LUC CARRIER P, et al.Challenges in representation learning: A report on three machine learning contests[J].Neural Networks, 2015, 64: 59-63.

[26] BUSSO C, BULUT M, LEE C C, et al.IEMOCAP: interactive emotional dyadic motion capture database[J].Language Resources and Evaluation, 2008, 42(4): 335-359.

[27] WU Wen, ZHANG Chao, WOODLAND P C.Emotion recognition by fusing time synchronous and time asynchronous representations[C]∥ICASSP 2021-2021 IEEE International Conference on Acoustics, Speech and Signal Processing(ICASSP).Toronto, ON, Canada.IEEE, 2021: 6269-6273.

[28] SIRIWARDHANA S, REIS A, WEERASEKERA R, et al.Jointly fine-tuning “BERT-like”self supervised models to improve multimodal speech emotion recognition[C]∥Interspeech 2020.ISCA: ISCA, 2020.

[29] LIAN Zheng, TAO Jianhua, LIU Bin, et al.Conversational emotion analysis via attention mechanisms[C]∥Interspeech 2019.ISCA: ISCA, 2019.

[30] PORIA S, CHATURVEDI I, CAMBRIA E, et al.Convolutional MKL based multimodal emotion recognition and sentiment analysis[C]∥2016 IEEE 16th International Conference on Data Mining(ICDM).Barcelona, Spain.IEEE, 2016: 439-448.

[31] MAJUMDER N, HAZARIKA D, GELBUKH A, et al.Multimodal sentiment analysis using hierarchical fusion with context modeling[J].Knowledge-Based Systems, 2018, 161: 124-133.