1 引言

语音情感识别作为情感信息处理领域的一大分支,旨在利用计算机自动识别给定语音的情感类别,其研究工作已开展30余年,并取得了显著进展和成果,但仍然是一项具有挑战性的任务。通常语音情感识别过程步骤为:从预处理后的语音信号中提取与情感信息相关的声学特征[1],然后使用分类器进行识别分类,其中传统分类器主要有混合高斯模型[2](Gaussian Mixture Model,GMM)、隐马尔可夫模型[3](Hidden Markov Model,HMM)、支持向量机[4](Support Vector Machine,SVM)等。

如何从语音信号中提取出高质量情感表征一直是一大难题与热点。韵律信息和频谱信息是现有情感识别技术中常用的声学特征。韵律信息主要包含音高(Pitch)、语速(Speed)、能量(Energy)以及停顿(Pause)等;通常采用梅尔倒谱系数(Mel-Frequency Cepstral Coefficients,MFCC)、线性预测系数(Linear Predicition Coefficient,LPC)及其相关特征作为频谱信息的特征参数。语音情感识别任务中常常使用各种语音特征集去捕捉情感显著信息,例如IS09特征集[5]、GeMaps特征集[6]、emobase特征集等。这些语音特征集由低级描述符及其统计值组成,但仅仅采用这些语音特征集不能保证系统获得良好的性能。通过大量特征工程实验,找寻出与情感高度相关的特征,是一件相当耗时耗力的工作。且所选特征的有效性在很大程度上依然依赖于所实现的识别模型,即分类器,导致其通用性较低[7]。因而迫切需要一种特定于语音情感识别任务的特征抽取方式。

在早期人工神经网络基础上升级的深度学习是一种让机器模仿人类大脑学习的技术,已经广泛应用于语音情感识别,并表现出良好的性能。直接利用深度网络从原始语音信号中捕获情感显著信息也成为了一项热点研究,如在文献[8]中,研究了一种时间延迟神经网络(Time Delay Neural Network and Long Short Term Memory,TDNN-LSTM)框架,从原始语音信号中捕获长期相关性,并与基于MFCC输入的深度神经网络(Deep Neural Networks,DNN)基线系统进行比较,得出原始波形超过硬编码(hard-coded)特征(如MFCC)的结论。为了进一步证明这一想法,文献[9]使用原始波形和不同复杂性的手工特征集(hand-crafted feature sets),对哭泣和非典型情感数据集(atypical affect dataset)进行了对比研究。实验结果表明手工制作的特征在哭泣时表现良好,使用原始波形提取的特征在非典型情感(atypical affect)时表现良好。此外,Zhao等人[10]探索了使用原始波形作为输入的CNN-LSTM(Convolutional Neural Network and Long Short Term Memory)架构,并在IEMOCAP数据集[11] 上取得了较好的效果。Xu等人[12]针对特征融合角度,提出一种3D和1D的语音情感识别方法,在3D网络中,采用语音的对数梅尔特征和其一阶差分与二阶差分作为双线性卷积神经网络(Bilinear Convolutional Neural Network, BCNN)的输入,从而提取出3D空间特征,在1D网络中,将语音的原始波形输入至一维卷积和LSTM网络中得到1D特征,再将3D空间特征与1D特征融合,在IEMOCAP数据库上实验,非加权平均召回率为61.22%。

在处理时序语音信号时,第一层网络提取的浅层特征的质量是整个多层网络模型最终能否取得良好效果的重要前提。同时深度神经网络随着输入特征维数以及隐藏层的数量的增加,需要学习大量的参数,从而导致计算量增加,对硬件配置要求更高。另一方面,目前仍以基于循环神经网络[13](Recurrent neural network,RNN)、卷积神经网络(Convolutional Neural Network,CNN)等模型的语音情感识别系统较多,但由于这些模型自身因素,易存在长距离梯度消失,以及长序列到定长向量的信息损失问题,因此传统的神经网络对于语音情感的全局信息尚未能很好的聚焦,且存在很大的局限性,然而这个性质在语音情感特征提取方面是相当重要的。

2018年,Bengio[14]专为第一层网络的特征提取能力,设计出一种直接处理语音时序信号的可解释神经网络,称为SincNet。它在传统卷积神经网络的基础上,在第一层采用了基于sinc函数的卷积,利用了滤波器的截断特性,使得网络更好地在低频中抽取出对性能有重大影响的滤波器参数。如Bengio中所言,经训练后的sincnet在频域方面,其具有较为规则的矩形带通滤波特性,能够有效减少噪声信号,更好地捕获到窄带信号,如音高(第一峰值)、第一共振峰(第二峰值)及其第二共振峰(第三峰值),弥补了传统CNN过于局限频率较低部分,无法捕获共振峰等不足。

Goole首次提出BERT模型[15],并在多个自然语言处理任务中取得突破性成就。其主体模型为Transformer模型编码器(Transformer Encoder),由于内部self-attention[16]可以处理输入序列的上下文信息,具备能够学习长距离依赖关系的能力,一定程度上可以替代传统卷积神经网络和循环神经网络结构,从而计算出整条序列的全局表征。

为此本文提出一种改进Transformer模型(Sinc-Transformer)来完成对原始语音信号的情感识别任务。Sinc-Transformer模型同时兼顾两种模型的优点,其中SincNet滤波器在原始语音波形中捕捉一些重要的窄带情感特征,使其整个网络结构在特征提取过程中具有指导性;其次利用Transformer模型编码器强大的特征学习能力来深化提取具有全局信息的情感特征,以提高语音情感识别效果。最终实验结果表明,在针对原始语音信号的情感识别任务中,该模型识别效果均优于多个基线系统及现有模型。

2 Sinc-Transformer模型

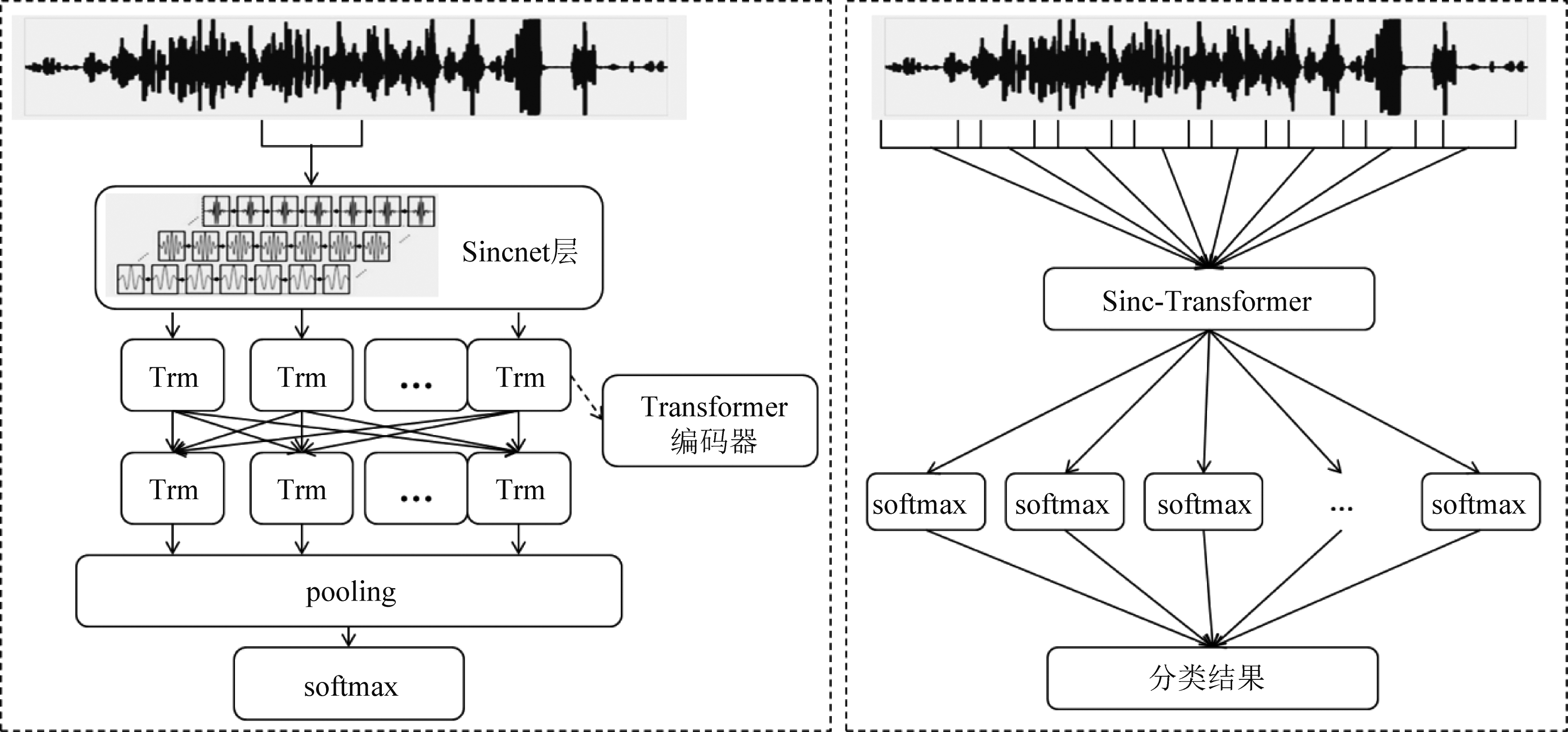

所述Sinc-Transformer模型结构如图1所示,由 SincNet 层与Transformer 模型编码器构建的一种融合全局信息特征的神经网络结构(Sinc-Transformer模型),具体地,包括SincNet 层、Transformer 模型编码器结构以及池化层。

图1 左图为Sinc-Transformer模型架构图,右图为模型流程图

Fig.1 On the left is architectures for Sinc-Transformer, on the right is the model flow chart

概括地说, Sinc-Transformer模型主要是在Transformer模型编码器的前面添加一层SincNet[17]。首先利用SincNet层作为整个网络结构的第一层,用以完成原始语音信号的浅层特征提取工作,并使网络更好地捕捉重要的窄带情感特征;其后添加两层Transformer模型编码器进行二次处理,以提取更深层次的情感信息和包含上下文信息的特征向量。在训练阶段,将音频信号分为250 ms,步长为10 ms的语音块(chunk)作为该模型的输入。在测试期间,获取每个chunk的最终softmax输出,并将其相加,以获得最终分类分数。

2.1 SincNet层

本文利用SincNet层完成语音原始波形信号的浅层特征提取工作,并使网络更好地捕捉重要的窄带情感特征,如音调和共振峰。与传统卷积层相比,该层通过利用参数化sinc函数来发现更有意义的滤波器,显示出具有更快的收敛和更高的可解释性[14]。具体地,将语音波形信号x[n]和SincNet层滤波器组函数g[n,θ]之间执行卷积计算,构建出包含浅层情感信息特征h[n],其映射关系式为[18]:

h[n]=x[n]*g[n,θ]

(1)

其中θ为可学习参数,g为滤波器组函数;

SincNet层是专门为实现矩形带通滤波器而设计的,只有其下截止频率和上截止频率是直接从数据中学习的。函数g的时域表达式如下[17]:

g[n, f1, f2]=2f2sinc(2πf2n)-2f1sinc(2πf1n)

(2)

其中, f1, f2分别表示为下截止频率和上截止频率。

SincNet层中所涉及的所有操作都是完全可微的,因而滤波器的截止频率可以使用随机梯度下降(SGD)或与Transformer模型编码器参数联合优化。

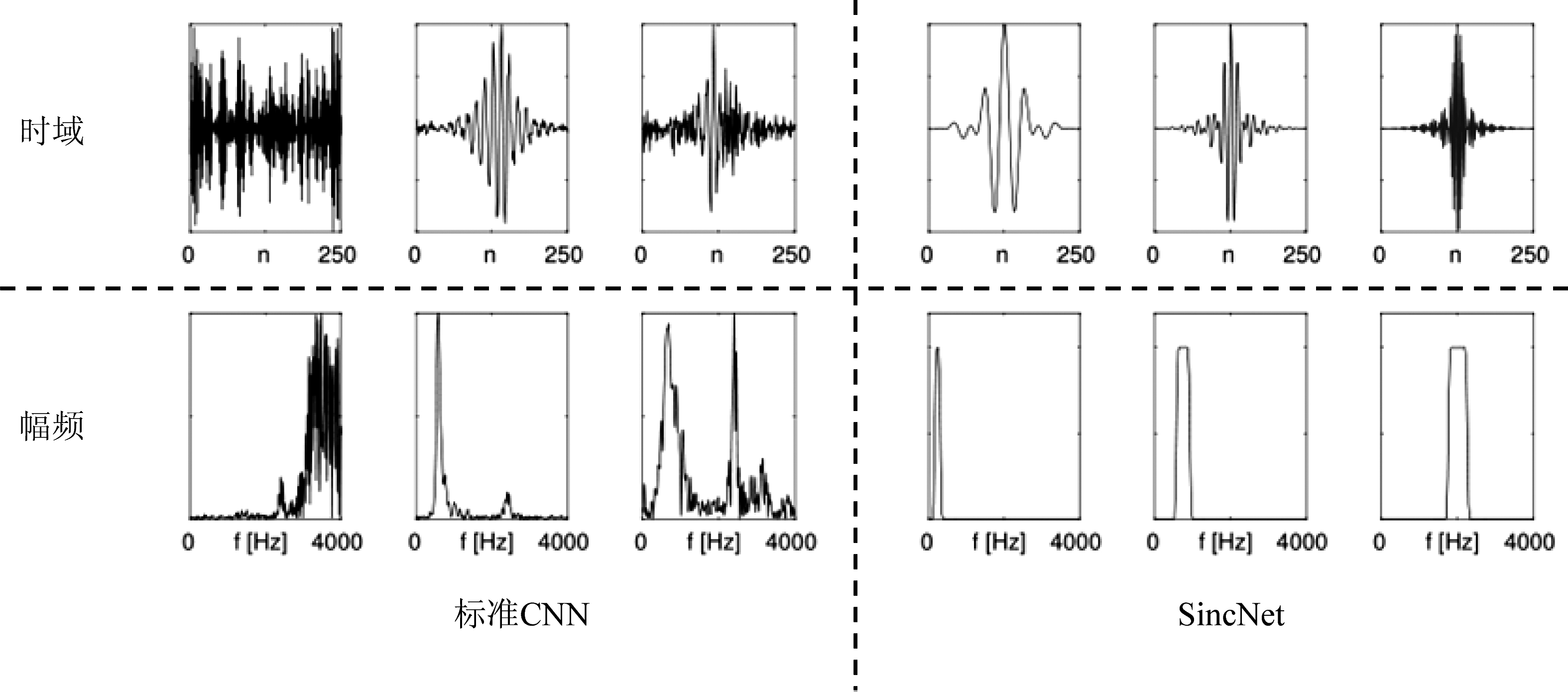

如图2所示,标准CNN并不能学习到明确频率响应的滤波器,在某些情况下,频率响应波形看起来十分嘈杂。相反,SincNet可以形成更有意义的滤波器组。

图2 标准CNN和SincNet滤波器的示例.第一行为时域中的滤波器,第二行为幅频响应

Fig.2 Examples of filters learned by a standard CNN and by the proposed SincNet.The first row reports the filters in the time domain, while the second one shows their magnitude frequency response

另一方面,对比标准CNN与SincNet的参数量。假设第一层神经网络由X个长度为L的滤波器组成,则标准CNN近似需要X*L个参数,而SincNet仅需2*X个参数。如果将滤波器的长度加倍,标准CNN的参数量也需要加倍,但是对于SincNet而言参数量是不变的(不管滤波器的长度如何变化,每个滤波器只需要两个参数,上截止频率和下截止频率)。由此可见,SincNet减少了深度神经网络第一层的参数量,降低计算复杂度。这些参数会根据情感识别任务,对滤波器的形状和带宽产生影响,从而调整滤波器参数,使其适用于语音情感识别任务。

2.2 Transformer模型编码器

Transformer模型[16]最早是用于机器翻译任务,可以很好地解决序列到序列(sequence to sequence,Seq2seq)问题,从而广泛用于自然语言处理领域中。该模型主要包括编码器(encoder)、解码器(decoder)以及它们之间的连接组成。其中,在Seq2seq模型中,编码器主要将输入单词序列映射为高维的连续表征序列,而解码器则在给定的高维连续表征序列的情况下,生成一个单词序列作为输出。例如,中文的“你是谁?”作为输入,解码器的英文输出则为“who are you?”。

但在语音情感分类任务中,一句话对应一个情感标签,且数据量不似机器翻译任务大,因而本文不采用transformer模型的解码器结构,单单采用Transformer模型编码器结构,从SincNet捕捉到的局部窄带情感特征中提取出高维的上下文特征向量,而解码器部分则利用softmax从高维的上下文特征向量中计算出每个类别概率,选取出概率值最高的作为该语音chunk的情感类别。

Transformer 模型编码器[16]主要有多头自注意子层和全连接前馈神经网络组成。作为核心组成部分的多头自注意力子层,其先将输入向量投影到不同维度的子空间,分别为queries(Q)、keys(K)、values(V),按公式(3)计算出注意力向量。

![]()

(3)

上述操作并行处理h次,再将计算得到的h个注意力向量串联拼接,并映射到原输入空间中,最后将得到的注意力向量作为输出。具体公式如下:

MutiHead(Q,K,V)=Concat(head1,…,headh)Wo

(4)

(5)

其中Concat是矩阵拼接函数;headi是第i个head的输出结果,h是head的个数;Wo是输出的映射参数矩阵;![]() 分别为Q,K,V在第i个head上的映射参数矩阵。

分别为Q,K,V在第i个head上的映射参数矩阵。

全连接前馈神经网络是对多头自注意力子层的输出结果进行两次线性变换和一次 RELU 激活操作。多头自注意力子层和前向反馈子层都包含一个残差连接(residual connection)结构,然后再做一个规范化(layer norm)操作作为子层最终输出。

将SincNet滤波器捕捉的浅层情感信息特征h[n]输入至Transformer编码器的多头自注意力子层,得到输入语音序列的帧级注意力特征向量;再将帧级注意力特征向量输入到Transformer编码器的全连接前馈神经网络,得到输入语音的上下文特征向量;使用softmax分类器来获取每个chunk的概率预测,并将其相加,最终得到语音情感类别。

3 实验

3.1 实验设置

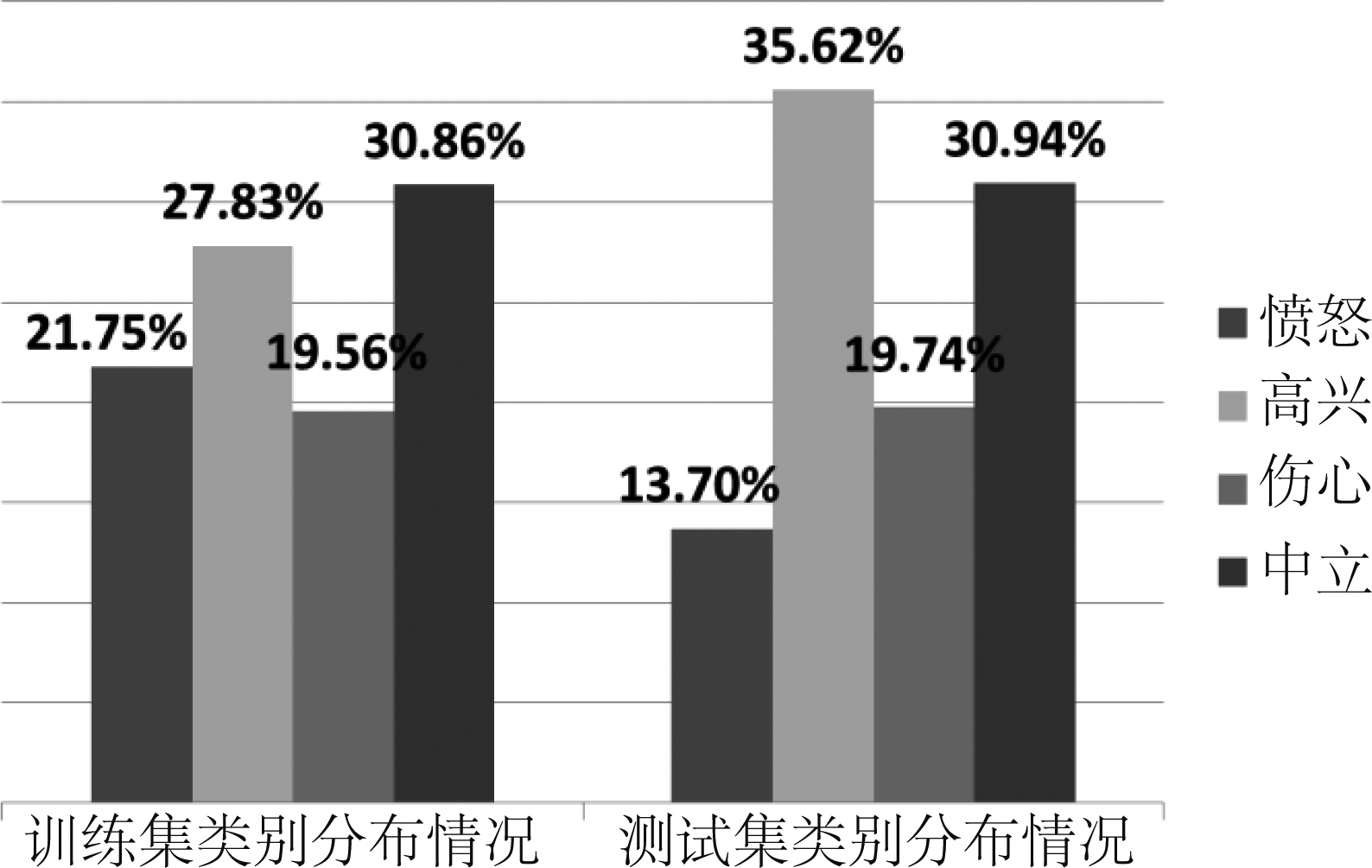

数据集:为了进行系统性能评估,本文在IEMOCAP数据集[11]上训练和测试了所提出的与说话人无关的语音情感识别系统。IEMOCAP数据集包含五组二元互动的会话,每组由一名男演员与一名女演员参与脚本场景和即兴创作,以引出特定的情感,其中五组会话所记录的演员各不相同。本文采用四种情绪进行分类,其中将高兴与兴奋划分为一类,共计5531句话语,具体分布为:愤怒:19.9%,快乐:29.5%,中立:30.8%,悲伤:19.5%。本文将前四组互动会话用于训练,剩余一组会话用于测试(训练集:4290句话语,测试集:1241句话语),从而实现一套独立于说话人的语音情感识别系统。在上述情感划分规则下,训练集和测试集的四类情感占比情况如图3所示。

图3 训练集与测试集的四类情感占比情况图

Fig.3 The proportion diagram of four categories of emotions in training set and test set

数据预处理:按照语音信号的常规处理流程:预加重(pre-emphasis)、加窗(window)、分帧(frame)和语音活性检测(voise activity detection,VAD),对原始波形信号进行预处理。语音信号的采样频率为16 kHz,每个采样点的量化位深为16 bit。每个训练音频信号分为250 ms,步长为10 ms的语音块作为训练网络模型的输入;在测试过程中,同样将测试音频信号切分为窗口大小为250 ms,步长为10 ms的语音块,计算该条测试音频信号上所有的语音块的预测概率累积和,最终得出该测试音频的情感类别。

实施细节:所述Sinc-Transformer模型在pytorch框架上实现,通过多次试验确定网络参数:网络采用Adam优化器用于优化分类交叉熵,该系统的学习率为1×10-3,训练批量大小设置为50,使用了241个epoch并保存最优模型作为最终模型;性能评估采用准确率(accuracy rate,ACC)和非加权平均召回率(Unweighted Average Recall, UAR)。

3.2 实验结果分析

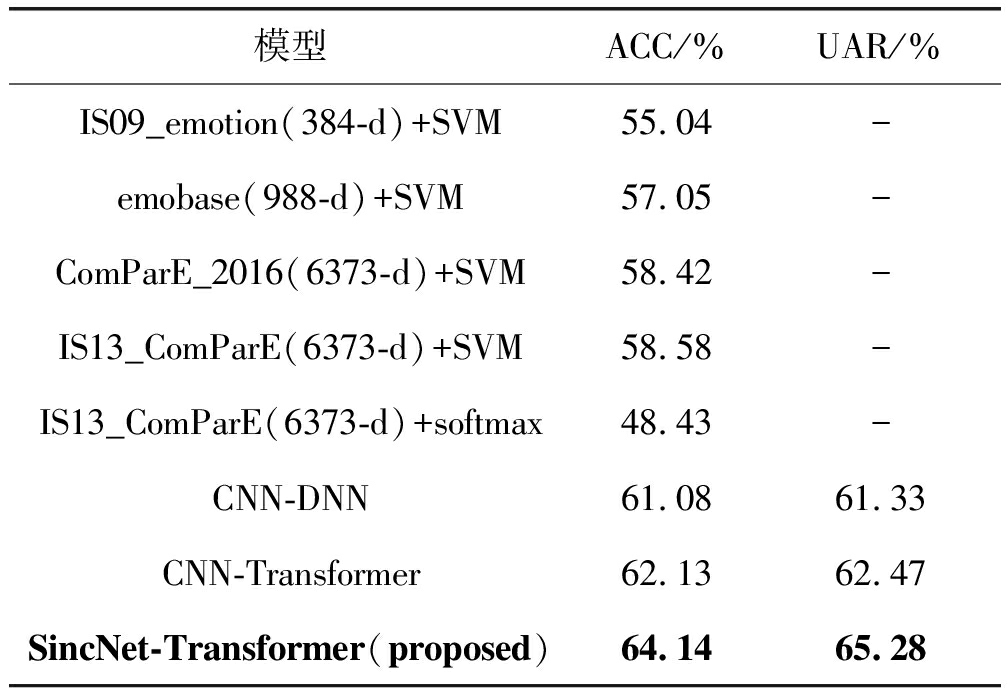

为了与Sinc-Transformer模型所提取的深度语音情感特征相比,本文提取了多组手工语音情感特征集来做对比实验。其中表1的上部分主要为使用openSMILE工具包[19]提取的传统语音情感特征,具体为384维的IS09_emotion 特征集,988维的emobase特征集,6373维的IS13_ComParE特征集和6373维ComParE_2016特征集,再将这些特征输入至SVM中进行语音情感识别,其中SVM内核类型设置为RBF,gamma参数为auto。

由表1可知,与传统语音情感识别任务中的语音情感特征集对比,在原始语音信号情况下,使用Sinc-Transformer模型进行深层语音情感特征抽取的效果更优,ACC比前者的最优高出5.56%。需要注意的是,在将分类器SVM换成softmax分类器时,即与本文所提系统的分类器一致时,选用在SVM下特征数据集中表现最优的IS13_ComParE特征集作为输入特征时,其识别效果有了明显的下降。由此得出一个大胆的猜想,在大数据量的情况下,Sinc-Transformer模型是否可作为预训练模型以提取更优的语音情感特征,这也将作为接下来的工作重点。

表1 多组实验在IEMOCAP数据库上的识别结果与比较

Tab.1 Recognition results and comparison of several experiments on IEMOCAP databases

模型ACC/%UAR/%IS09_emotion(384-d)+SVM55.04-emobase(988-d)+SVM57.05-ComParE_2016(6373-d)+SVM58.42-IS13_ComParE(6373-d)+SVM58.58-IS13_ComParE(6373-d)+softmax48.43-CNN-DNN61.0861.33CNN-Transformer62.1362.47SincNet-Transformer(proposed)64.1465.28

同时针对原始语音信号,本文还采用了CNN-DNN和CNN-Transformer模型结构作为基线系统,其中CNN-DNN模型结构主要由3层一维CNN与3层DNN组成,而CNN-Transformer模型则将SincNet-Transformer模型的第一层SincNet层替换为标准CNN层。如表1下部分所示,Sinc-Transformer模型比CNN-DNN模型的ACC提高了3.06%,UAR提高了3.95%;与CNN-Transformer模型相比,ACC提高了2.01%,UAR提高了2.81%。通过CNN-DNN模型与CNN-Transformer模型的实验结果可知,Transformer模型编码器结构比DNN模型可以学习到更深层次的上下文特征;此外,通过对CNN-Transformer模型与SincNet-Transformer模型的实验结果进行对比,体现了SincNet滤波器相比于标准CNN在语音情感识别任务中的确具有一定优势。

需要注意的是,从上述可知,本文在划分训练与测试集时,是独立于说话人且没有考虑类平衡的问题。因此在做上述基线系统时,采用相同划分策略;另一方面可解释在同等条件下识别率较低的问题。

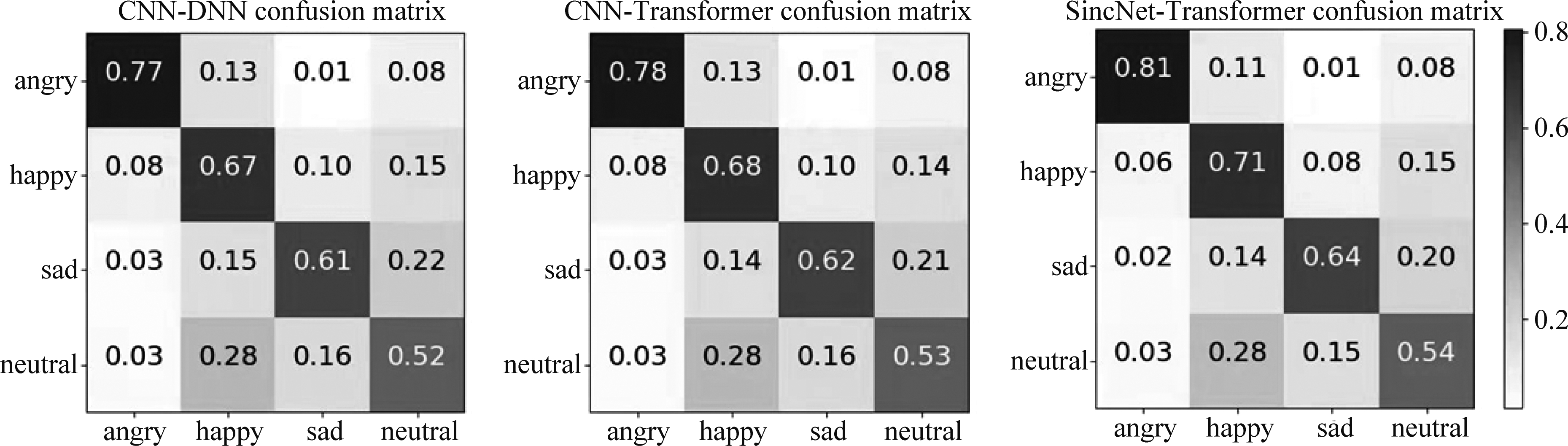

为了进一步对实验结果进行对比分析,图4给出了CNN-DNN、CNN-Transformer、SincNet-Transformer模型的混淆矩阵。观察图中三个模型的实验结果可知,可以发现SincNet-Transformer模型与前两个基线模型相比,四类情感类别的准确率皆有所提升,因而模型的准确率有一个显著的改进,但是因中立类别的本身情感因素不够凸显,该模型尚未能很好地捕捉其特性,这将在未来的工作中加以改进。

图4 在IEMOCAP数据库下四类情感的混淆矩阵

Fig.4 The confusion matrix of four categorical emotions on IEMOCAP databases

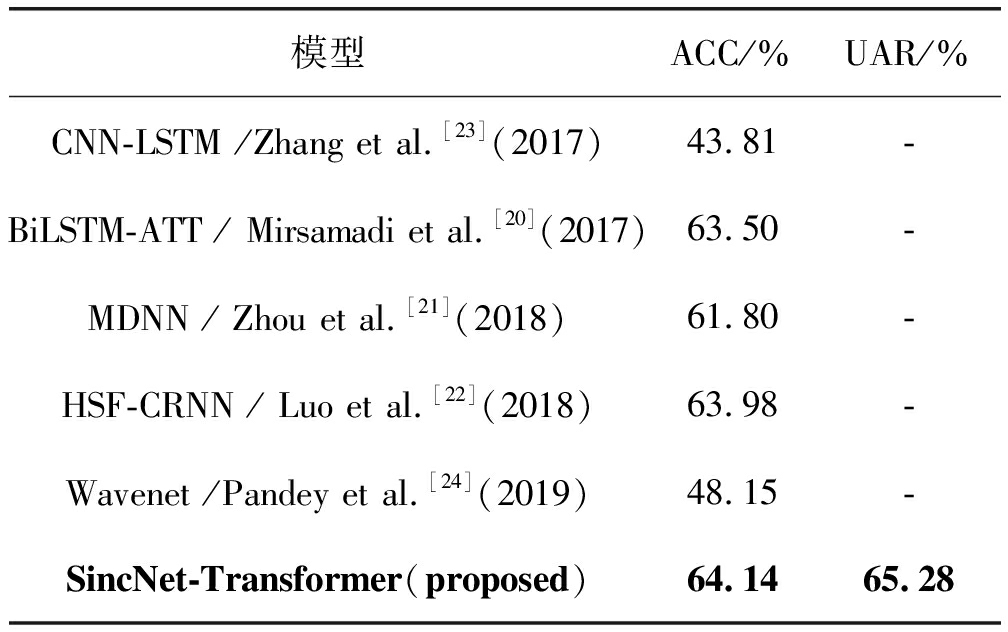

如表2所示,将Sinc-Transformer模型与其他现有模型的识别结果进行对比,其中BiLSTM-ATT模型[20]、MDNN模型[21]与HSF-CRNN模型[22]是基于手工特征提取的识别模型,CNN-LSTM模型[23]与Wavenet模型[24]为针对原始语音信号的情感识别模型。特别地,这些先前工作的数据集划分规则实际上并不是严格一致的。由表2的识别结果可以观察到与以前的工作相比,提出的改进Sinc-Transformer模型在一定程度上优于其他模型。特别地,在Wavenet模型中同样使用了原始语音波形进行情感识别,本模型识别率比其高出15.99%。

表2 现有模型与所提模型在IEMOCAP数据库上的识别结果与对比

Tab.2 Recognition results and comparison of existing models and the proposed model on IEMOCAP databases

模型ACC/%UAR/%CNN-LSTM /Zhang et al.[23](2017)43.81-BiLSTM-ATT / Mirsamadi et al.[20](2017)63.50-MDNN / Zhou et al.[21](2018)61.80-HSF-CRNN / Luo et al.[22](2018)63.98-Wavenet /Pandey et al.[24](2019)48.15-SincNet-Transformer(proposed)64.1465.28

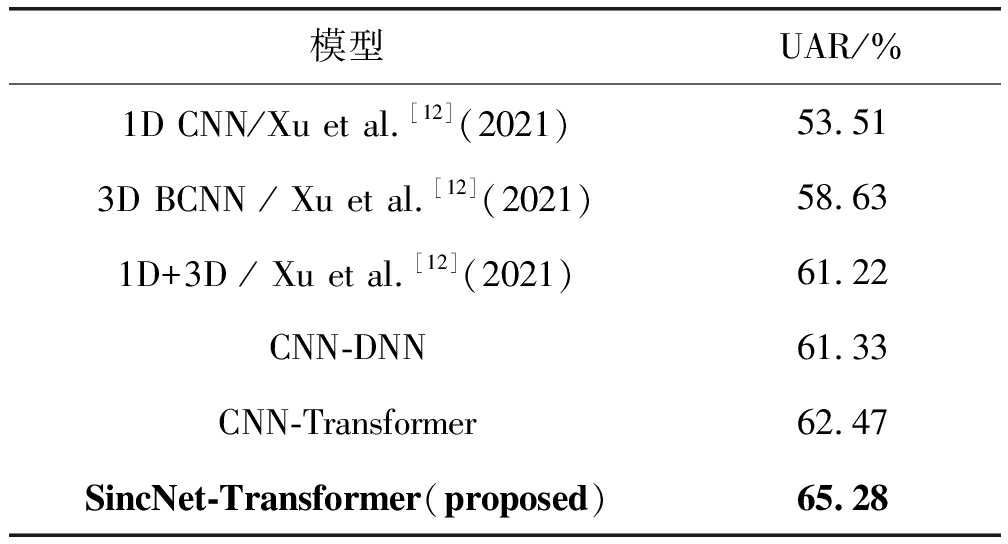

与近期的实验结果对比中可知,在文献[12]中1D CNN模型使用了原始语音波形作为输入,3D BCNN模型则利用了语音的对数梅尔特征和其一阶差分与二阶差分作为输入,而1D+3D模型则为将3D特征与1D特征进行融合。该工作同样做了说话人独立实验,将数据库中的8位说话者的语音数据作为训练集,一位作为验证集,剩余一位为测试集。而本文没有采用验证集,直接将8位说话者的语音数据作为训练集,剩余两位为测试集。此外由于文献[12]采用UAR作为评价指标,因此本文在上述相同的实验参数的设置下,同样使用UAR进行评估。如表3所示,本文所提出的Sinc-Transformer模型比其最优模型的UAR提高了4%。

表3 现有模型与所提模型在IEMOCAP数据库上的识别结果与对比

Tab.3 Recognition results and comparison of existing models and the proposed model on IEMOCAP databases

模型UAR/%1D CNN/Xu et al.[12](2021)53.513D BCNN / Xu et al.[12](2021)58.631D+3D / Xu et al.[12](2021)61.22CNN-DNN61.33CNN-Transformer62.47SincNet-Transformer(proposed)65.28

4 结论

为避免手动提取特征的繁琐性,解决深度神经网络参数过多问题、增强第一层提取浅层特征的有效性以及克服传统神经网络存在的信息损失等不足,本文提出一种Sinc-Transformer模型用以实现语音情感识别任务。Sinc-Transformer模型自动提取学习原始语音信号的情感表征,无需手工特征提取步骤。在该模型中,一方面依赖于SincNet层能定制化捕获语音信号的窄带情感信息,使其整个网络结构在浅层表征提取过程中具有指导性。另一方面Transformer模型编码器可以克服传统深度神经网络带来的梯度消失、信息损失等弊端,可以深化提取具有全局信息的情感特征。在IEMOCAP数据上进行识别测试,实验结果表明,Sinc-Transformer模型的准确率均优于多个基线系统及现有模型。在接下来的工作中,将继续研究如何利用深度网络来处理原始语音信号的情感识别任务,进一步提高语音情感识别性能;另一方面将尝试利用该结构训练出一个预训练模型,使其真正意义上用作语音情感特征提取器或作为其他任务的微调模型,最终实现语音情感识别的应用化与普及化。

[1] 韩文静, 李海峰, 阮华斌, 等.语音情感识别研究进展综述[J].软件学报, 2014, 25(1): 37-50.

HAN Wenjing, LI Haifeng, RUAN Huabin, et al.Review on speech emotion recognition[J].Journal of Software, 2014, 25(1): 37-50.(in Chinese)

[2] ZAO L, CAVALCANTE D, RUI C.Time-Frequency feature and AMS-GMM mask for acoustic emotion classification[J].IEEE Signal Processing Letters, 2014, 21(5): 620-624.

[3] SCHULLER B, BATLINER A, STEIDL S, et al.Recognising realistic emotions and affect in speech: state of the art and lessons learnt from the first challenge[J].Speech Communication, 2011, 53(9-10): 1062-1087.

[4] TARIQ U, LIN K H, ZHEN L, et al.Recognizing emotions from an ensemble of features[J].IEEE Transactions on Systems Man & Cybernetics Part B Cybernetics A Publication of the IEEE Systems Man & Cybernetics Society, 2012, 42(4): 1017-1026.

[5] SCHULLER B, STEIDL S, BATLINER A.The Interspeech 2009 Emotion Challenge[C]∥Interspeech 2009, England, UK: ISCA, 2009: 312--315.

[6] EYBEN F,SCHERER K R, SCHULLER B, et al.The geneva minimalistic acoustic parameter set(gemaps)for voice research and affective computing[J].IEEE Transactions on Affective Computing, 2016, 7(2): 190-202.

[7] 吕惠炼, 胡维平.基于端到端深度神经网络的语音情感识别研究[J].广西师范大学学报(自然科学版), 2021, 39(3): 20-26.

LV Huilian, HU Weiping.Research on speech emotion recognition based on end-to-end deep neural network[J].Journal of Guangxi Normal University(Natural Science Edition), 2021, 39(3): 20-26.(in Chinese)

[8] SARMA M, GHAHREMANI P, POVEY D,et al.Emotion identification from raw speech signals using dnns[C]∥Interspeech 2018.Hyderabad, India: ISCA, 2018: 3097-3101.

[9] WAGNER J, SCHILLER D, SEIDERER A, et al.Deep learning in paralinguistic recognition tasks: are hand-crafted features still relevant?[C]∥Interspeech 2018.Hyderabad, India: ISCA, 2018: 147-151.

[10] ZHAO J, MAO X, CHEN L.Speech emotion recognition using deep 1D & 2D CNN LSTM networks[J].Biomedical Signal Processing and Control, 2019, 47(JAN.): 312-323.

[11] BUSSO C, BULUT M, LEE C C, et al.IEMOCAP: interactive emotional dyadic motion capture database[J].Language Resources and Evaluation, 2008, 42(4): 335-359.

[12] 徐华南, 周晓彦, 姜万, 等.基于3D和1D多特征融合的语音情感识别算法[J].声学技术, 2021, 40(4): 496-502.

XU Huanan, ZHOU Xiaoyan, JIANG Wan, et al.Speech emotion recognition algorithm based on 3D and 1D multi-feature fusion[J].Technical Acoustics, 2021, 40(4): 496-502.(in Chinese)

[13] 冯天艺,杨震.采用多任务学习和循环神经网络的语音情感识别算法[J].信号处理, 2019, 35(7):1133-1140.

FENG Tianyi,YANG Zhen.Speech emotion recognition algorithm based on multi-task learning and recurrent neural network[J].Journal of Signal Processing, 2019, 35(7): 1133-1140.(in Chinese)

[14] RAVANELLI M, BENGIO Y.Interpretable convolutional filters with sincnet[C]∥32nd Conference on Neural Information Processing Systems(NIPS 2018).Montréal, Canada, 2018.

[15] DEVLIN J, CHANG M, LEE K, et al.BERT:pre-training of deep bidirectional transformers for language understanding[C]∥Proceedings of NAACL-HLT, Minneapolis, USA, 2019: 4171-4186.

[16] VASWANI A, SHAZEER N, PARMAR N, et al.Attention is all you need[C]∥Advances in Neural Information Processing Systems(NIPS 2017).Los Angeles, USA, 2017: 5998-6008.

[17] RAVANELLI M, BENGIO Y.Speaker recognition from raw waveform with sincnet[C]∥2018 IEEE Spoken Language Technology Workshop(SLT).Athens, Greece: IEEE, 2019:1021-1028.

[18] PRIYASAD D, FERNANDO T, DENMAN S, et al.Attention driven fusion for multi-modal emotion recognition[C]∥Proceedings of the 2020 IEEE International Conference on Acoustics, Speech and Signal Processing(ICASSP).Barcelona, Spain: IEEE, 2020: 3227-3231.

[19] EYBEN F, WLLMER M, SCHULLER B.Opensmile: the munich versatile and fast open-source audio feature extractor[C]∥International Conference on Multimedia.ACM, 2010: 1459-1462.

[20] MIRSAMADI S, BARSOUM E, ZHANG C.Automatic speech emotion recognition using recurrent neural networks with local attention[C]∥Proceedings of the 2017 IEEE International Conference on Acoustics, Speech and Signal Processing(ICASSP).New Orleans, LA, USA: IEEE, 2017: 2227-2231.

[21] ZHOU Suping, JIA Jia, Wang Qi, et al.Inferring emotion from conversational voice data: a semi-supervised multi-path generative neural network approach[C]∥32nd AAAI Conference on Artificial Intelligence, Louisiana, USA, 2018: 579-587.

[22] LUO Danqing, ZOU Yuexian, HUANG Dongyan.Investigation on joint representation learning for robust feature extraction in speech emotion recognition[C]∥Interspeech 2018.Hyderabad, India: ISCA, 2018: 152-156.

[23] ZHANG Shiqing, ZHANG Shiliang, HUANG Tiejun, et al.Speech emotion recognition using deep convolutional neural network and discriminant temporal pyramid matching[J].IEEE Transactions on Multimedia, 2017, 20(6):1576-1590.

[24] PANDEY S K,SHEKHAWAT H S,PRASANNA S.Emotion recognition from raw speech using wavenet[C]∥IEEE TENCON 2019.Kerala, India: IEEE, 2019:1292-1297.