1 引言

在带有噪声的语音信号中,噪声会覆盖语音中的关键信息,影响人对语音内容的理解。语音增强所做的工作就是将噪声信号移除,获得纯净语音,提升语音的听觉辨识度。语音增强是其他语音信号处理的前提,带噪语音经过增强后可以被广泛地应用于语音识别[1]、语音端点检测[2]等领域,所以提升语音增强的结果对语音的后续利用至关重要。

在非神经网络的语音增强方法中,常用的有谱减法[3]、维纳滤波器法[4]、卡尔曼滤波器法[5]。通过假设一种平稳的噪声信号,将这些噪声信号从带噪语音中消除,以达到增强的目的。但在实际应用中,噪声信号并不总是平稳的,这些方法在应用中存在一定的不足。

为了能更好地处理非平稳噪声信号,将神经网络引入到语音增强的任务中,其中包含两种主要方法。一种是掩蔽(Mask),语音的语谱可以完整地展示语音的时域、频域信息,所以Mask方法是从语音的语谱入手,通过处理语谱上的时频单元实现语音增强。常用的Mask方法有:理想二值掩蔽[6](Ideal Binary Mask,IBM),理想浮值掩蔽[7](Ideal Ratio Mask,IRM),理想幅度掩蔽[8](Ideal Amplitude Mask,IAM),相位敏感掩蔽[9](Phase Sensitive Mask,PSM),复数理想浮值掩蔽[10](Complex Ideal Ratio Mask,cIRM)。虽然通过Mask的方式可以取得不错的增强效果,但语谱无法直接转成语音信号,需要经过额外的操作才能变换为语音信号。

另一种神经网络方法是映射(Mapping),利用神经网络学习带噪数据与纯净数据之间的映射关系,映射方法分为频谱映射[11]和波形映射[12]。在频谱映射中,将带噪语音的幅度谱数据映射成纯净语音的幅度谱数据,然后利用波形合成的方式将数据恢复成时域信号。波形合成会用到幅度谱数据和相位谱数据,但目前并没很好地相位预估方法,只能将带噪信号的相位作为增强信号的相位,这会导致幅度与相位不匹配。在波形映射中,神经网络会在带噪语音的波形数据和纯净语音的波形数据之间建立非线性映射关系。由于网络的输入输出数据均为波形,这种方式最大的好处是不需要执行波形合成,避免了频谱映射中使用噪声相位的问题。

语音增强任务中采用了多种不同的神经网络结构,例如由全连接层构成的深度神经网络[13-15](Deep Neural Network, DNN)。DNN存在的问题是,输入数据太长会导致参数量太多、输入数据太短又导致模型无法很好的联系上下文。卷积神经网络[16-18](Convolution Neural Networks,CNN)可以很好的解决输入数据受限的问题。CNN存在的问题是,无法很好地利用语音信息的前后关联性。为了更好利用语音的信息,采用长短时记忆网络[19-21](Long short-term memory,LSTM)的结构实现语音增强。在LSTM中,当前时刻的输出依赖上一时刻的信息,网络可以充分利用数据的前后关联性。还有采用了对抗思想的生成对抗网络[22](Generative Adversarial Network, GAN),该网络包含生成器和判别器,利用生成器和判别器的相互反馈实现语音增强。在LSTM的基础上,Tan[11]又提出了一种CNN和LSTM复合的神经网络模型,被称为卷积循环神经网络(Convolution Recurrent Neural Network, CRN)。但是CRN的输入数据是语音的频谱信息,在波形的合成过程中要使用带噪信号的相位。在此基础上,Hu[23]提出了深度复数卷积循环神经网络(Deep Complex Convolution Recurrent Neural Network, DCCRN),DCCRN处理的数据是短时傅里叶复数频谱,其中包含幅度谱和相位谱信息,这样就避免了将噪声信号相位谱作为增强信号相位谱的问题。

鉴于CRN这样的复合网络结构在语音增强中取得了良好的效果,本文引入一种名为双路径循环神经网络[24](Dual-path Recurrent Neural Network, DPRNN)的神经网络模型,DPRNN同样是CNN和LSTM的复合网络结构,以波形作为输入输出数据避免了复杂的时频变换,采用LSTM增强了网络的建模能力。

2 系统描述

2.1 模型结构

DPRNN是一种已经被成功应用的网络结构,它的提出是为了解决单通道语音分离的问题,取得了不错的效果。在分离任务中,一条语音包含有多个说话人,网络输出数据的通道数等于说话人的数量。与分离任务相比,单通道语音增强任务中说话人的数量为1,因此将模型输出数据的通道数设置为1即可实现DPRNN由分离任务到增强任务的迁移。

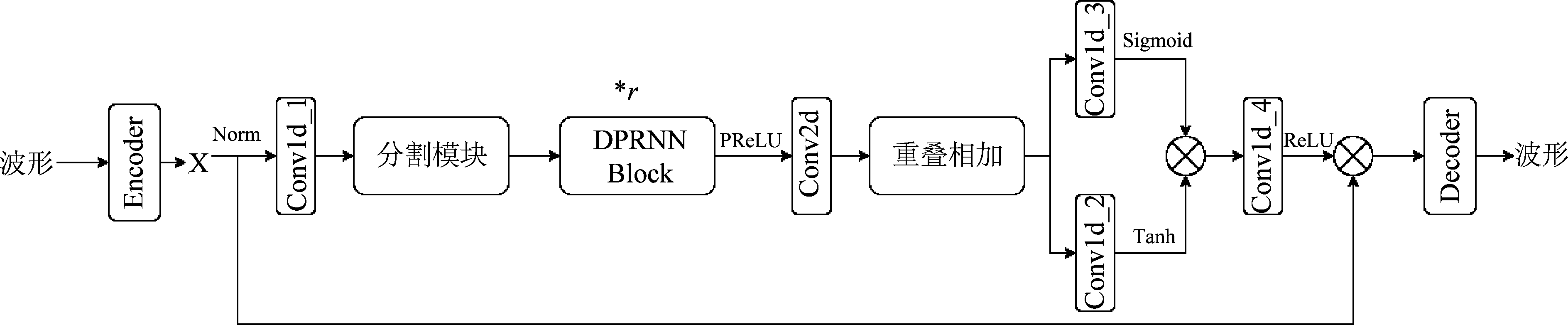

DPRNN的结构如图1所示,它由编码器(Encoder)、卷积层(Conv1d、Conv2d)、LSTM及解码器(Decoder)组成,网络需要分别实现特征提取、序列分割、数据建模、数据维度转换、特征恢复等功能。编码器和卷积层用来实现数据特征提取的功能,解码器用来实现特征恢复的功能。分割模块用来实现长序列切割的功能,它可以将一维长序列分割为二维短序列帧矩阵从而解决LSTM无法对长序列建模的问题。重叠相加是一种常用的波形重建的方式,它可以将二维的帧矩阵转换为一维的波形序列。

图1 DPRNN网络结构

Fig.1 The structure of DPRNN

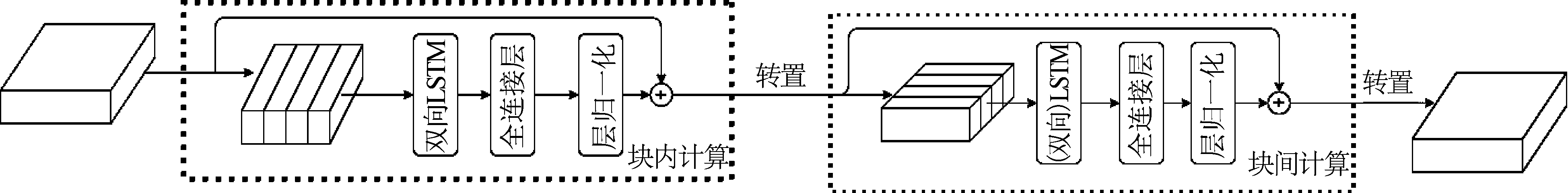

网络中最关键的结构是DPRNN Block,它的结构如图2所示由块内计算和块间计算两个模块组成。之所以采用这样的结构实现建模是因为二维帧矩阵是由一维波形序列经过重叠分帧后所得,帧矩阵中的数据不仅在帧内存在联系,还在帧与帧之间存在联系,常用的网络结构在处理帧矩阵时只会考虑到利用帧内数据的联系而忽略了帧间数据的联系,DPRNN Block这样的结构可以更好的利用数据在帧内与帧间的联系。DPRNN Block的工作过程如图2所示,帧矩阵首先会作为块内计算的输入数据,这个模块中的LSTM将会实现帧内数据实现建模,由于采用了双向LSTM会导致数据的维度产生变化,所以在LSTM后增加一个全连接层用于恢复数据的维度,之后使用层归一化和残差相加的数据处理方式则可得到块内计算的输出数据。完成帧内数据建模后需要接着完成帧间数据建模,帧间数据建模首先需要对块内计算的输出数据做转置操作并将其作为输入数据,最后经过与块内计算相同的计算步骤即可得到最终的输出数据。

图2 DPRNN Block的结构

Fig.2 The structure of DPRNN Block

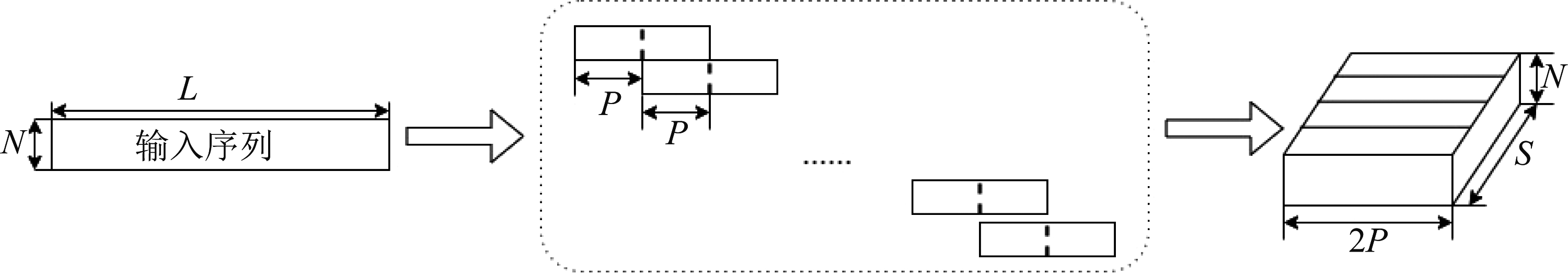

DPRNN的工作流程总结如下:DPRNN的输入输出数据分别是带噪语音和增强语音的波形,选择波形作为输入输出数据是为了避免时频变换的复杂处理步骤以及处理频域数据所必须执行的相位信息处理。波形数据进入网络后首先由编码器对数据编码,所得编码数据经过归一化后由卷积层提取特征值。提取到的特征值需要送入分割模块中进行数据分割,分割过程如图3所示。一维的数据序列以帧长2P、帧移P的长度进行分帧处理,每一帧都作为一个单独的数据块并将这些数据块堆叠在一起构成一个二维的数据矩阵,其中S表示长度为L的序列可分割块的数量。二维数据矩阵将会作为DPRNN Block的输入数据以此实现数据建模的目的,DPRNN Block采用LSTM建模,有效的利用了块内数据的关联性以及数据块之间的关联性,块内数据的关联性体现为数据在时间上的先后顺序,数据块之间的关联性体现为分块过程中前一块的后半部分与后一块的前半部分相同,网络结构中包含r个DPRNN Block,这样就可以迭代的执行r次块内计算和块间计算。建模后的数据需要经过一个二维卷积层再次提取特征并利用重叠相加[25]的方式实现波形重建,重叠相加是图3分块的逆过程,二维数据矩阵中相邻的两个数据块重叠的部分将会以求平均值的方式合并,所有的块都合并后便将二维矩阵变换为一维序列。生成的一维序列需要分别经由两个卷积层计算并采用sigmoid和Tanh激活,然后采用相乘的方式合并,最后利用解码器将数据恢复为增强后的语音波形。

图3 数据分割

Fig.3 Data segmentation

2.2 损失函数

在以波形为输入数据的神经网络映射中,通常会用网络的输出数据和标签数据计算时域损失。但语音是由不同频率的正弦波叠加而成的,在频域上更能反映语音的特征,仅采用时域损失无法体现语音在频域上的特征变化。

为了解决时域损失表现片面的问题,本文将时域损失和频域损失共同作为模型的损失。网络的输入输出数据是语音的波形,首先用波形数据计算时域损失。然后利用傅里叶变换将波形数据由时域转换到频域,利用得到的频域数据计算频域损失。最后将时域损失和频域损失通过线性结合的方式连接,作为模型损失。

神经网络训练中常用的损失函数有两种,分别是均方误差(Mean Square Error,MSE)和平均绝对误差(Mean Absolute Error,MAE)。Pandey[26]通过对比MSE和MAE的效果,发现MAE对提升指标更有帮助,所以本文采用MAE计算损失。假定x=(x0,x1,…,xn-1)表示标签数据的时间序列,y=(y1,y2,…,yn-1)表示输出数据的时间序列,时域损失可以表示为:

(1)

上式中,Lt表示时域损失,N表示序列的长度,n表示序列中第n个点。时频变换首先需要对波形数据做短时傅里叶变换并得到短时傅里叶频谱,短时傅里叶变换过程如下式所示:

(2)

上式中,Z表示短时傅里叶频谱,它是一个由实部Zr和虚部Zi构成的复数矩阵。在实部和虚部中,包含语音的幅度信息和相位信息。l表示帧号,k表示离散傅里叶指数,Δ表示帧移,M表示帧长,m表示帧中第m个点,w()表示窗函数。Pandey[26]认为在损失计算中仅使用幅度谱得到的效果要优于同时使用幅度谱和相位信息,所以本文在计算频域损失时仅使用幅度谱数据,频域损失表示为:

![]()

(|Xr(n)|+|Xi(n)|)|

(3)

Lf表示频域损失,Yr和Yi表示 y经过方程2变换后所得实部和虚部数据,Xr和Xi表示x经过方程2变换后所得实部和虚部数据。时域损失和频域损失经过线性相加后构成模型损失:

L=α*Lt+(1-α)*Lf

(4)

L是模型损失,α和1-α分别表示时域损失和频域损失在模型损失中所占的权重比,α取值0.9,该值参考了Wang[27]的文章并稍做修改,这样可以保证时域损失和频域损失的数量级相同。

3 实验

3.1 实验数据

本文使用的实验数据来自TIMIT[28]数据集,它是一个被广泛应用在语音信号处理中的数据集。训练集中包含有4620条语音数据,从中随机选择1500条作为训练数据。噪声数据来源于NOISEX-92,训练时用到的5种噪声为:buccaneer2、factory1、hfchannel、f16、white。训练数据合成时用到的信噪比为{-5 dB、0 dB}。最后得到的总训练数据为15000条(1500*5*2)。测试集中包含有192条语音,为了验证未知噪声条件下模型的增强效果,测试集中使用的噪声除训练数据中使用的5种外,额外增加了3种,它们分别是pink、factory2和m109,测试数据合成时用到的信噪比为{-5 dB、0 dB、5 dB}。

3.2 模型设置

实验中用到两个基线模型:AECNN:Pandey[26]所提出的编码解码结构,由卷积神经网络和反卷积神经网络构成。LSTM:由一个两层的单向LSTM和一个全连接层构成的网络结构,LSTM的主要参数有两个,分别是input-size和hidden-size,它们的数值均为512。全连接网络的参数为512。

图1网络结构的参数按照如下设置:Encoder:(256,6,1)、Conv1d_1:(64,1,1)、Conv2d:(64,1,1)、Conv1d_2:(64,1,1)、Conv1d_3:(64,1,1)、Conv1d_4:(256,1,1)、Decoder:(1,2,1),括号中的三个数字分别表示out-channel、kernel-size和stride的数值。DPRNN Block中的循环神经网络结构为双向LSTM(Bidirectional LSTM,Bi-LSTM),其中input-size和 hidden-size的数值分别是64和128。

0.0005是模型初始学习率,训练过程中学习率动态变化,每迭代一个epoch衰减为上一次的98%, epoch总数为100。模型的batch为1,并使用Adam的方法优化模型。每迭代一个epoch保存一次模型,并测试所有保存的模型,从中选取最优的结果。

3.3 结果分析

语音增强实验通常使用短时可懂度[29](Short-term Objective Intelligibility,STOI)和语音质量感知评估[30](Perceptual Evaluation of Speech Quality,PESQ)衡量增强效果的好坏,它们的取值范围分别为{0,1}和{-0.5,4.5},二者的值越大结果越好。为了能更直观的观察,STOI采用百分比的记录形式。此外本文还采用信噪比(Signal to Noise Rate,SNR)衡量增强效果的好坏,该值越大效果越好。

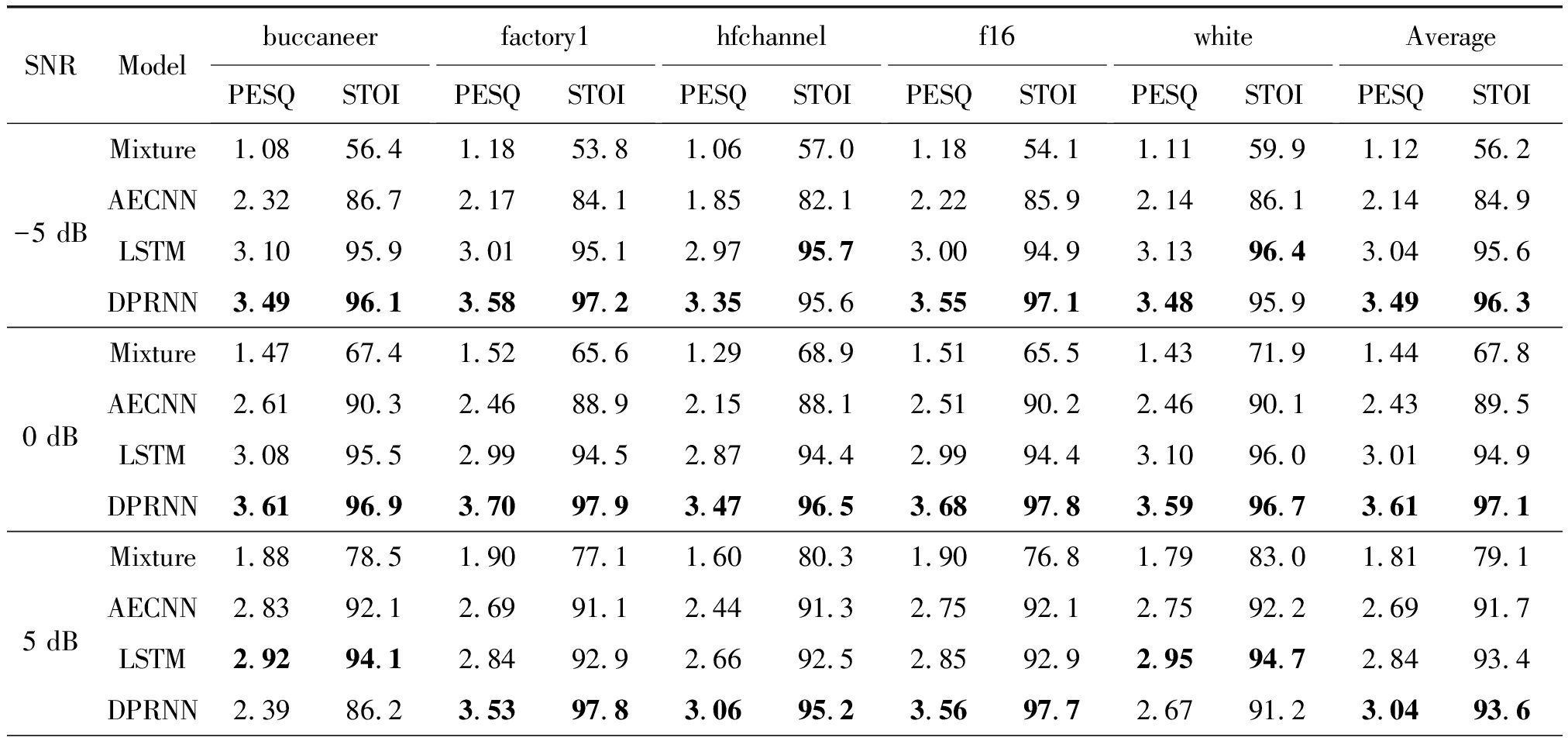

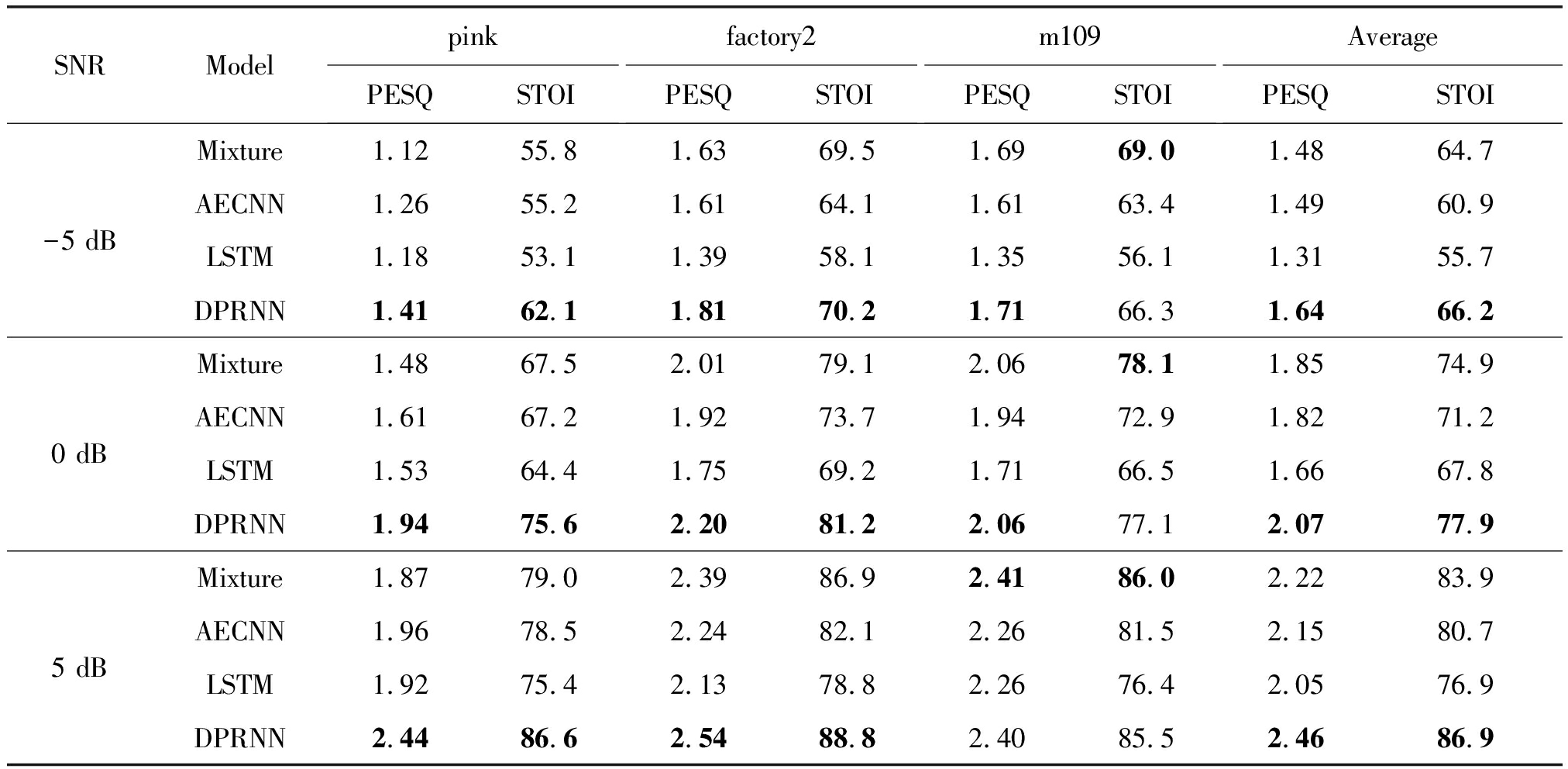

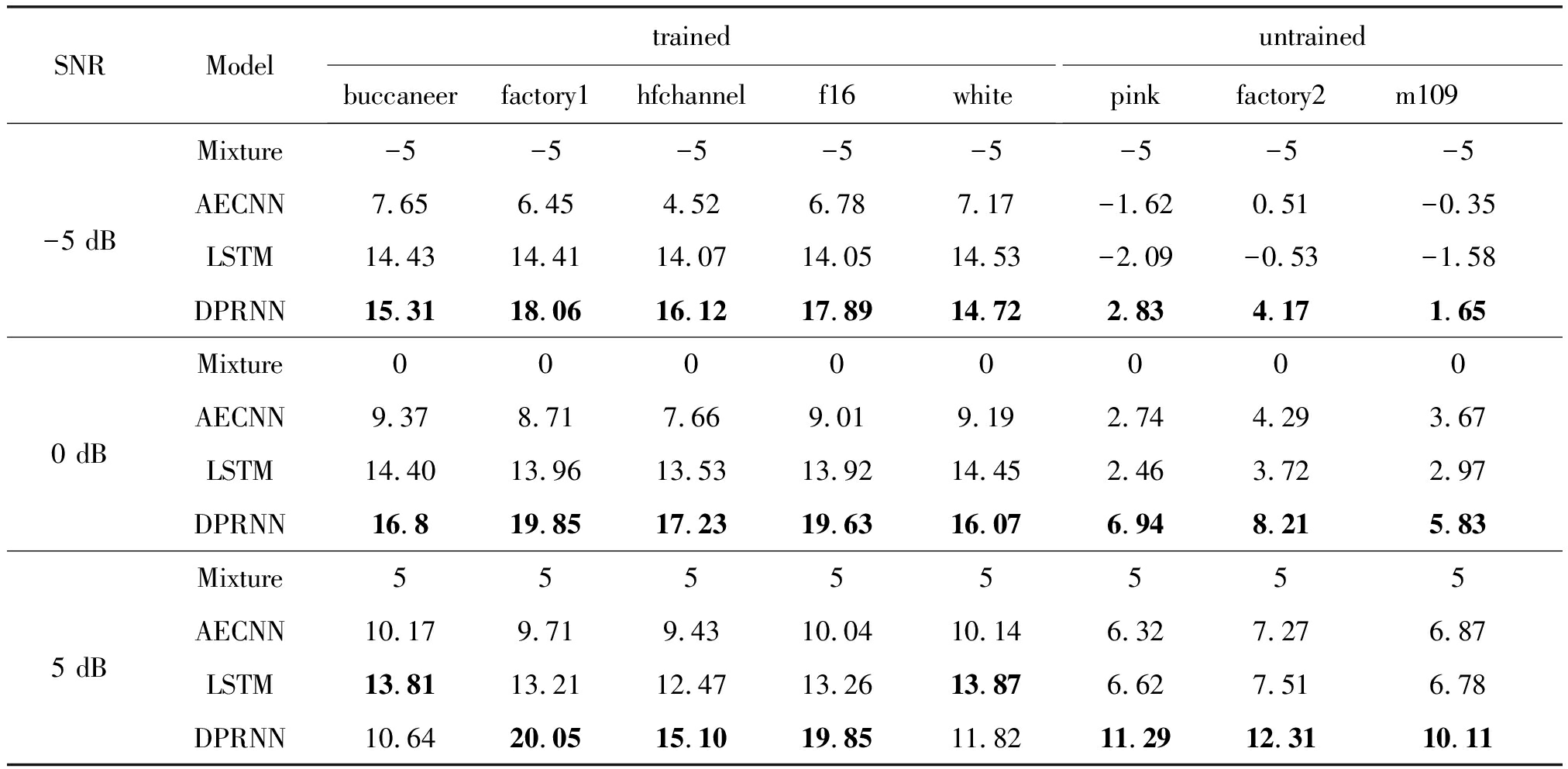

表1和表2给出了已知噪声和未知噪声条件下增强效果的PESQ和STOI得分。已知噪声是参与模型训练的噪声数据,未知噪声是未参与模型训练的噪声数据,用来测试模型的泛化能力。从表1可以看到,相比于Mixture, DPRNN在{-5 dB,0 dB,5 dB}三种信噪比情况下,PESQ和STOI得分分别提升了211%、71.3%、150%、43.2%、67.9%和18.3%。由表2可知,在未训练噪声条件下,DPRNN相比Mixture在PESQ和STOI得分上分别提升了10.8%、2.3%、11.8%、4%、10.8%和3.5%。与基线模型相比,DPRNN在客观评价指标上均取得最优结果。对比表1、表2和表3可以发现,针对已知的噪声,模型具有较好的拟合能力。面对未知噪声,模型的泛化性能较差,这是因为在训练过程中,模型不断拟合训练数据从而对未知噪声产生了抑制作用,导致已知噪声的结果逐渐变好,未知噪声的结果逐渐变差。虽然模型的泛化能力受到抑制,但相比于其他两个网络模型DPRNN仍取得较好的结果。

表1 训练噪声的STOI(%)和PESQ得分比较

Tab.1 Comparison of STOI(%)and PESQ scores on trained noise

SNRModelbuccaneerPESQSTOIfactory1PESQSTOIhfchannelPESQSTOIf16PESQSTOIwhitePESQSTOIAveragePESQSTOI-5 dBMixture1.0856.41.1853.81.0657.01.1854.11.1159.91.1256.2AECNN2.3286.72.1784.11.8582.12.2285.92.1486.12.1484.9LSTM3.1095.93.0195.12.9795.73.0094.93.1396.43.0495.6DPRNN3.4996.13.5897.23.3595.63.5597.13.4895.93.4996.30 dBMixture1.4767.41.5265.61.2968.91.5165.51.4371.91.4467.8AECNN2.6190.32.4688.92.1588.12.5190.22.4690.12.4389.5LSTM3.0895.52.9994.52.8794.42.9994.43.1096.03.0194.9DPRNN3.6196.93.7097.93.4796.53.6897.83.5996.73.6197.15 dBMixture1.8878.51.9077.11.6080.31.9076.81.7983.01.8179.1AECNN2.8392.12.6991.12.4491.32.7592.12.7592.22.6991.7LSTM2.9294.12.8492.92.6692.52.8592.92.9594.72.8493.4DPRNN2.3986.23.5397.83.0695.23.5697.72.6791.23.0493.6

表2 非训练噪声的STOI(%)和PESQ得分比较

Tab.2 Comparison of STOI(%)and PESQ scores on untrained noise

SNRModelpinkPESQSTOIfactory2PESQSTOIm109PESQSTOIAveragePESQSTOI-5 dBMixture1.1255.81.6369.51.6969.01.4864.7AECNN1.2655.21.6164.11.6163.41.4960.9LSTM1.1853.11.3958.11.3556.11.3155.7DPRNN1.4162.11.8170.21.7166.31.6466.20 dBMixture1.4867.52.0179.12.0678.11.8574.9AECNN1.6167.21.9273.71.9472.91.8271.2LSTM1.5364.41.7569.21.7166.51.6667.8DPRNN1.9475.62.2081.22.0677.12.0777.95 dBMixture1.8779.02.3986.92.4186.02.2283.9AECNN1.9678.52.2482.12.2681.52.1580.7LSTM1.9275.42.1378.82.2676.42.0576.9DPRNN2.4486.62.5488.82.4085.52.4686.9

表3 模型的SNR得分比较

Tab.3 Comparison of SNR scores of the model

SNRModeltrainedbuccaneerfactory1hfchannelf16whiteuntrainedpinkfactory2m109-5 dBMixture-5-5-5-5-5-5-5-5AECNN7.656.454.526.787.17-1.620.51-0.35LSTM14.4314.4114.0714.0514.53-2.09-0.53-1.58DPRNN15.3118.0616.1217.8914.722.834.171.650 dBMixture00000000AECNN9.378.717.669.019.192.744.293.67LSTM14.4013.9613.5313.9214.452.463.722.97DPRNN16.819.8517.2319.6316.076.948.215.835 dBMixture55555555AECNN10.179.719.4310.0410.146.327.276.87LSTM13.8113.2112.4713.2613.876.627.516.78DPRNN10.6420.0515.1019.8511.8211.2912.3110.11

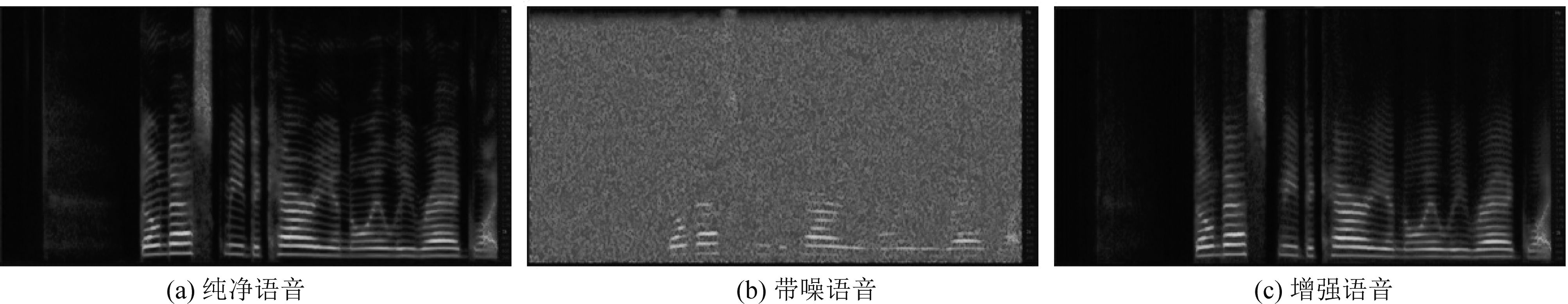

图4中(a)表示纯净语音的语谱图,(b)是纯净语音混合-5 dB白噪声后所得噪声语音的语谱图,(c)是(b)经过DPRNN增强后语音的语谱图。从图中明显看出DPRNN消除了噪声信号对语音的干扰,产生了良好的增强效果。

图4 纯净语音、带噪语音和增强语音语谱图

Fig.4 The spectrogram of clean, noisy and enhanced speech

4 结论

为了解决单一网络结构性能受限的问题,本文将一种名为DPRNN的复合网络结构应用到语音增强任务中,DPRNN是由CNN和LSTM构成的网络结构。模型通过对数据分块的方式,解决了长序列数据建模的问题。通过实验对比,DPRNN的指标要优于AECNN和LSTM。模型存在的问题是对未知噪声的泛化能力较差,未来的工作要更多的聚焦于这方面的优化。

[1] VISSER E, OTSUKA M, LEE T W.A spatio-temporal speech enhancement scheme for robust speech recognition in noisy environments[J].Speech Communication, 2003, 41(2/3): 393-407.

[2] XU Tianjiao, ZHANG Hui, ZHANG Xueliang.Joint training ResCNN-based voice activity detection with speech enhancement[C]∥2019 Asia-Pacific Signal and Information Processing Association Annual Summit and Conference(APSIPA ASC).Lanzhou, China.IEEE, 2019: 1157-1162.

[3] PALIWAL K, W JCICKI K, SCHWERIN B.Single-channel speech enhancement using spectral subtraction in the short-time modulation domain[J].Speech Communication, 2010, 52(5):450-475.

JCICKI K, SCHWERIN B.Single-channel speech enhancement using spectral subtraction in the short-time modulation domain[J].Speech Communication, 2010, 52(5):450-475.

[4] 张亮, 龚卫国.一种改进的维纳滤波语音增强算法[J].计算机工程与应用, 2010, 46(26): 129-131.

ZHANG Liang, GONG Weiguo.Improved wiener filtering speech enhancement algorithm[J].Computer Engineering and Applications, 2010, 46(26): 129-131.(in Chinese)

[5] SO S, PALIWAL K K.Modulation-domain kalman filtering for single-channel speech enhancement[J].Speech Communication, 2011, 53(6):818-829.

[6] HUMMERSONE C, MASON R, BROOKERS T.Ideal binary mask ratio: A novel metric for assessing binary-mask-based sound source separation algorithms[J].IEEE Transactions on Audio, Speech, and Language Processing, 2011, 19(7): 2039-2045.

[7] SRINIVASAN S, ROMAN N, WANG Deliang.Binary and ratio time-frequency masks for robust speech recognition[J].Speech Communication, 2006, 48(11): 1486-1501.

[8] WANG Yuxuan, NARAYANAN A, WANG Deliang.On training targets for supervised speech separation[J].IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2014, 22(12): 1849-1858.

[9] ERDOGAN H, HERSHEY J R, WATANABE S, et al.Phase-sensitive and recognition-boosted speech separation using deep recurrent neural networks[C]∥2015 IEEE International Conference on Acoustics, Speech and Signal Processing(ICASSP).South Brisbane, QLD, Australia.IEEE, 2015: 708-712.

[10] WILLIAMSON D S, WANG Yuxuan, WANG Deliang.Complex ratio masking for monaural speech separation[J].IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2016, 24(3): 483-492.

[11] TAN Ke, WANG Deliang.A convolutional recurrent neural network for real-time speech enhancement[C]∥Interspeech 2018.ISCA: ISCA, 2018: 3229-3233.

[12] FU S W, TSAO Y, LU Xugang, et al.Raw waveform-based speech enhancement by fully convolutional networks[C]∥2017 Asia-Pacific Signal and Information Processing Association Annual Summit and Conference(APSIPA ASC).Kuala Lumpur, Malaysia.IEEE, 2017: 006-012.

[13] KANG T G, SHIN J W, KIM N S.DNN-based monaural speech enhancement with temporal and spectral variations equalization[J].Digital Signal Processing, 2018, 74:102-110.

[14] KARJOL P, AJAY KUMAR M, GHOSH P K.Speech enhancement using multiple deep neural networks[C]∥2018 IEEE International Conference on Acoustics, Speech and Signal Processing(ICASSP).Calgary, AB, Canada.IEEE, 2018: 5049-5052.

[15] WANG Ziteng, LI Xu, WANG Xiaofei, et al.A DNN-HMM approach to non-negative matrix factorization based speech enhancement[C]∥Interspeech 2016.ISCA, 2016: 3763-3767.

[16] PARK S R, LEE J W.A fully convolutional neural network for speech enhancement[C]∥Interspeech 2017.ISCA: ISCA, 2017: 1993-1997.

[17] LIU Changle, FU S W, LI Youjin, et al.Multichannel speech enhancement by raw waveform-mapping using fully convolutional networks[J].IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2020, 28: 1888-1900.

[18] KOUNOVSKY T, MALEK J.Single channel speech enhancement using convolutional neural network[C]∥2017 IEEE International Workshop of Electronics, Control, Measurement, Signals and their Application to Mechatronics(ECMSM).Donostia, Spain.IEEE, 2017: 1-5.

[19] VALENTINI-BOTINHAO C, WANG Xin, TAKAKI S, et al.Speech enhancement for a noise-robust text-to-speech synthesis system using deep recurrent neural networks[C]∥Interspeech 2016.ISCA, 2016: 352-356.

[20] WENINGER F, ERDOGAN H, WATANABE S, et al.Speech enhancement with LSTM recurrent neural networks and its application to noise-robust ASR[C]∥International conference on latent variable analysis and signal separation.Springer, Cham, 2015: 91-99.

[21] WÖLLMER M, ZHANG Zixing, WENINGER F, et al.Feature enhancement by bidirectional LSTM networks for conversational speech recognition in highly non-stationary noise[C]∥2013 IEEE International Conference on Acoustics, Speech and Signal Processing.Vancouver, BC, Canada.IEEE, 2013: 6822-6826.

[22] BABY D, VERHULST S.Sergan: Speech enhancement using relativistic generative adversarial networks with gradient penalty[C]∥ICASSP 2019-2019 IEEE International Conference on Acoustics, Speech and Signal Processing(ICASSP).IEEE, 2019: 106-110.

[23] HU Y, LIU Y, LV S, et al.DCCRN: Deep complex convolution recurrent network for phase-aware speech enhancement[J].arXiv preprint arXiv:2008.00264, 2020.

[24] LUO Yi, CHEN Zhuo, YOSHIOKA T.Dual-path RNN: Efficient long sequence modeling for time-domain single-channel speech separation[C]∥ICASSP 2020-2020 IEEE International Conference on Acoustics, Speech and Signal Processing(ICASSP).Barcelona, Spain.IEEE, 2020: 46-50.

[25] VERHELST W.Overlap-add methods for time-scaling of speech[J].Speech Communication, 2000, 30(4): 207-221.

[26] PANDEY A, WANG Deliang.A new framework for supervised speech enhancement in the time domain[C]∥Interspeech 2018.ISCA: ISCA, 2018: 1136-1140.

[27] WANG Heming, WANG Deliang.Time-frequency loss for CNN based speech super-resolution[C]∥ICASSP 2020-2020 IEEE International Conference on Acoustics, Speech and Signal Processing(ICASSP).IEEE, 2020:861-865.

[28] GAROFOLO J S.Timit acoustic phonetic continuous speech corpus[J].Linguistic Data Consortium, 1993, 1993.

[29] TAAL C H, HENDRIKS R C, HEUSDENS R, et al.An algorithm for intelligibility prediction of time-frequency weighted noisy speech[J].IEEE Transactions on Audio, Speech, and Language Processing, 2011, 19(7):2125-2136.

[30] RIX A W, BEERENDS J G, HOLLIER M P, et al.Perceptual evaluation of speech quality(PESQ)-a new method for speech quality assessment of telephone networks and codecs[C]∥2001 IEEE International Conference on Acoustics, Speech, and Signal Processing.Proceedings(Cat.No.01CH37221).Salt Lake City,UT,USA.IEEE, 2001: 749-752.