1 引言

汉语方言不仅代表着一种文字符号,更承载着深厚的中华文化。方言也具有浓郁的地域文化色彩和社会风土人情。教育部和国家语言文字工作委员会(国家语委)也明确了“保护方言”的必要性。于此同时,科大讯飞于2018年面向全球举办方言种类识别挑战赛,践行“方言保护计划”,致力于利用人工智能相关算法的研究来推动方言的保护。当今,弱势方言正面临着全球化冲击,正处于逐渐消失的危险之中。因此,针对构成方言保护核心环节的方言语音识别研究具有重要的现实意义。

通常,汉语方言分为北方方言、粤方言等七大方言[1-2],也包含了江西省境内的赣方言和客家方言[3-4]。由于地域和文化差异,江西省境内的赣方言和客家方言在发音和语法上都存在一定的差异,跨越片区的方言互通程度仍然比较低。加上大规模方言语音语料库的采集和人工标注成本非常高,研究人员早期聚焦于带方言口音的普通话语音识别[5-8],这些传统模型主要基于概率模型或距离度量方法。此外,也有部分文献[9-15]利用传统特征工程方法进行方言语音识别。例如,文献[9]自动抽取并构建方言中的多发音词典,并将该词典用于维吾尔语方言语音识别。文献[10]和文献[11]分别针对蒙古语方言和重庆方言,提出了基于HMM(Hidden Markov Model)的方言语音识别系统。

由于传统特征工程方法成本太高,近期深度学习方法能够自动抽取语义特征,有效提升了方言语音识别性能[16-20]。然而现有深度学习模型缺乏考虑方言语音中特定方言音素的重要性,同时对多种语音特征提取及融合方面比较为鲜见,导致方言语音识别性能仍然不高。实际上,方言本身特定的音素串(发音底层特征)有利于方言语音识别。

鉴于此,本文系统地探索了由音素串信息构成的方言语音本身发音底层特征对于方言语音识别的有效性,同时提取了多种语音特征,并利用深度学习模型将两者加以集成。具体而言,模型首先利用残差网络(Residual Network)和Bi-LSTM(Bi-directional Long Short-Term Memory)提取帧内和帧间的语音特征,然后利用多头自注意力机制(multi-head attention)有效提取不同方言特有的音素串信息构成语音发音底层特征,并利用CTC(Connectionist Temporal Classification)计算音素损失,进行方言语音识别。我们在基准赣方言和客家方言两个语料库上进行实验,实验结果表明,引入多头自注意力机制能够有效提取不同方言特有的音素串发音底层特征,同时多种语音特征的融入使得方言语音识别性能得到大幅度提升。本文主要贡献如下:

(1)针对不同地域的方言词语对应的声母和韵母均存在显著的差异性,利用多头自注意力机制有效提取不同方言特有的音素串信息构成语音发音底层特征,并与残差网络和Bi-LSTM有效集成,充分发挥了残差网络在语音帧内部特征提取和Bi-LSTM在帧外部(时序)特征提取的优势;

(2)从语音信号处理角度出发,抽取了多种常用语音特征,并验证这些单个特征及组合特征对方言语音识别性能的影响,从而发挥不同类型语音特征的互补优势;

(3)在国际基准赣方言和客家方言两个方言语料库上的实验结果表明了该模型的有效性,并通过对注意力的可视化进一步分析了模型取得性能提升的根本原因。

本文的后续内容安排如下:第2节对方言语音识别方面的相关工作进行了综述;第3节阐述了本文提出的端到端方言语音识别模型;第4节是数据集、实验设置及实验结果分析部分;第5节总结了全文。

2 相关工作

本节主要介绍传统方言语音识别和深度学习方言语音识别领域的代表性工作。

2.1 传统方言语音识别

传统的方言语音识别方法主要基于经典的语音识别模型,把输入的汉语普通话或英语改为特定方言语料库,再利用代表性的线性预测编码技术(Linear Predictive Coding,简称LPC)[13]、动态时间规整(Dynamic Time Warping,简称DTW)[14]和隐马尔科夫模型[15]等技术进行语音识别。其中,LPC将语音信号建模为一个线性时变系统的输出,可以获得易于计算的语音参数的精确估计。DTW将两段时长不同的语音进行时间上的对齐,实现动态时间规整,从而更有效地比较同一时间段内两个语音段的相似性。此外,语音识别模型中声音建模方面主要利用GMM(Gaussian Mixed Model),通过计算似然函数的最大值实现分布参数的求解,并达到较高的精度和灵活度。文献[12]设计了嵌入式环境下基于HMM的广东方言和北方方言识别模型,该模型采用音节作为模型的基元,在声学模型规模、计算速度和识别率方面达到平衡。

2.2 深度学习方言语音识别

不同于传统基于特征工程的方言语音识别模型,深度学习模型可以自动抽取隐含的语义特征,其显著提升了方言语音识别的性能。例如,文献[17]提出了基于LSTM和CTC的短词语为主的客家方言语音识别,主要利用LSTM构建声学模型,并利用CTC计算音素损失,在客家方言的称呼语、日常用语和常用文字上得到97%的准确率。文献[18]抽取出海南方言语音的FilterBank作为语音特征,设计了基于深度前馈序列记忆网络与CTC结合的海南方言语音识别模型。文献[19]针对维吾尔语声学特征中元音的共振峰、时长和音强进行统计分析,抽取出不同性别下的发音特点,并设计了基于LSTM的维吾尔语方言识别模型。文献[20]将注意力机制融入两层CNN对声学模型进行建模,设计了大同方言语音翻译模型。文献[21]将注意力融入LSTM模型,可以自动学习上下文特征的权重,并利用多任务学习同时优化预测的三因子状态后验概率,进行远场语音识别。相关研究表明基于CTC[22]的声学模型能够取得比较好的语音识别效果[23-25]。此外,深度学习方法也广泛应用于语音识别相关的语种识别任务,即判断某段语音所属的语言类型[26-28]。例如,文献[26]将深度神经网络成功用于语种识别,该网络直接接收语音句子的底层声学特征,然后为每一帧给不同的语种进行打分,语音句子的得分是该句子所有帧的平均值。文献[27]利用了语音的发音底层特征来提升语种识别的效果,具体做法是使用一个音素识别模型来提取帧级的语音发音底层特征,然后将语音发音底层特征输入到语种识别模型。文献[28]提出了CNN与Attention结合的方言识别模型,该模型采用MFCC作为底层声学特征。

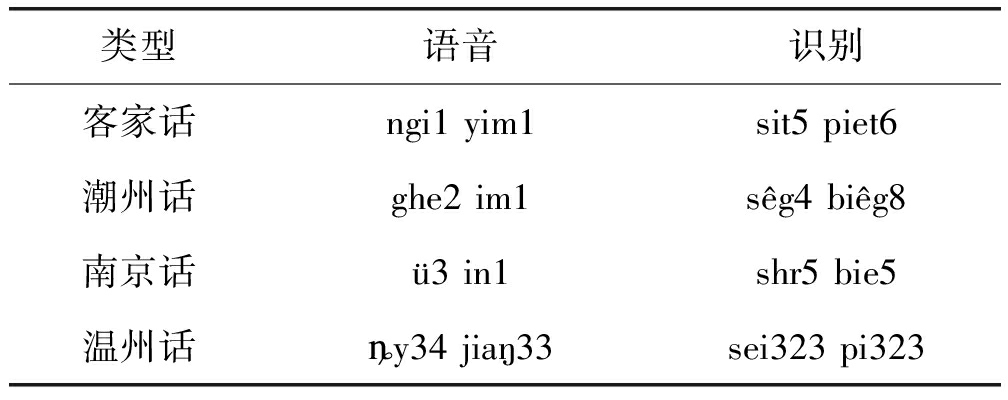

然而,现有深度方言语音识别模型一方面忽略了利用注意力机制提取有效的方言特定音素,以及如何利用这些特定方言音素指导方言语音识别。表1显示了“语音”和“识别”两个词语在客家话、潮州话、南京话和温州话对应的方言音素(1)http:∥cn.voicedic.com/。从表1可以看出,即使是相同的词语,各自对应的音素存在明显的差异。换言之,这些特有的发音底层特征对于提升方言语音识别性能势必具有重要的作用。另一方面,现有方言语音识别模型在多种语音特征提取及融合方面也较为鲜见。于此,本文提出了一个融合多种语音特征与自注意力机制的端到端方言语音识别模型。我们使用CTC损失函数来训练语音音素识别的声学模型,并且加入了一层多头自注意力层,该层能够赋予声学模型提取不同方言所特有发音底层特征的能力。同时,融入的多种语音特征对方言语音识别起到至关重要的作用。

表1 方言音素实例

Tab.1 Phoneme examples of dialects

类型语音识别客家话ngi1 yim1sit5 piet6潮州话ghe2 im1sêg4 biêg8南京话ü3 in1shr5 bie5温州话ȵy34 jiaŋ33sei323 pi323

3 模型

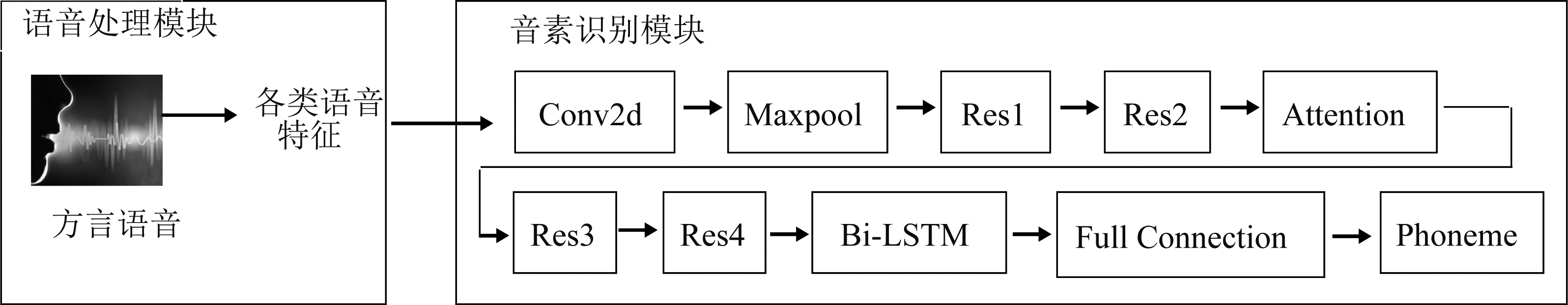

图1是本文提出的端到端方言语音识别深度学习模型,主要包含2个模块:语音处理模块和音素识别模块。通过对原始语音提取出各种语音特征,依次通过卷积神经网络、残差网络、多头注意力机制以及长短期记忆网络组合而成的声学模型可得到发音底层特征,再通过全连接层映射到合适的维度,生成音素串。经过CTC损失函数计算预测的音素串与真实的音素串的差值,并通过Adam算法对模型中的参数进行优化,最终得到音素错误率。下面分别介绍相应的模块。

图1 端到端方言语音识别模型

Fig.1 An end-to-end dialect speech recognition model

3.1 语音处理模块

本文提取的多种语音特征包含以下几类:

(1)FBank:通过对原始收入语音进行分帧、加窗处理之后,FBank特征很好地模拟了人耳在音频响应的非线性方式,可以作为方言语音识别的重要语音特征。我们利用Kaldi工具(2)http:∥www.kaldi-asr.org/从原始的wav音频文件中提取出80维的Fbank特征。具体过程为:首先对输入采样频率为16 kHz的音频预加重并去除直流偏移,然后选用分帧窗口大小为25 ms且帧移为10 ms的单位分帧,经过汉明窗处理,并通过离散傅里叶变换,利用23个滤波器组成的滤波器组处理得到梅尔频谱,并获取到80维的特征向量。

(2)MFCC(Mel-frequency cepstral coefficients):虽然FBank已经非常接近人耳的响应特性,但是由于相邻的滤波器组有明显的重叠,导致相邻的FBank特征间具有高度相关性。因此我们将信号进行离散余弦变换,从而得到相关性较低的MFCC特征。此外,由于MFCC降低了FBank相邻特征的高相关性,从而具有更好的判别度,其应用广泛。

(3)log-Mels:通过分帧和加窗操作后,然后进行快速傅里叶变换,得到频域方面的信息,并且通过堆叠所有频域信号可以获取声谱图。梅尔频率最大的优势在于其更符合人耳听觉的非线性特性,再取对数后,得到更加具有辨识度log-Mels,其原理在于人耳比较能区分每个频率区域有多少能量。

3.2 音素识别模块

如图1所示,该模块接收上述语音特征或组合作为输入,采用一个残差网络提取语音更抽象的局部特征,再利用一个多头自注意力层抽取每一帧语音与其他帧的关系,然后利用一个全连接层将音素映射到合适维度,最后采用CTC损失函数计算预测的音素串与真实音素串的差异,输出对应的音素串。整个音素识别模型主要采用ResNet18+Attention+Bi-LSTM结构,充分发挥了残差网络在提取帧内部和Bi-LSTM在提取帧外部(时序)方面特征的优势,将多头注意力层加在残差层后,残差网络经过四个残差层结构可以提取语音抽象的局部特征。模型设计出发点在于人们说话时隐含的语音自身特性让音素之间包含连贯性以及随着情绪起伏波动带来的情感性,使得相邻帧之间具有一定联系,甚至相隔较远的帧之间也会有一定联系,由于ResNet18中卷积神经网络使用的卷积核较小,其处理帧的范围有限,在帧内部特征提取方面具有优势。此外,Bi-LSTM的引入便于处理时间序列中间隔和延迟较长的帧(帧外部时序信息),而且多头注意力层能够观察到每一帧与其他帧之间的关系,能更好的提高识别准确率,平均池化层的输出用来预测音素串。虽然CNN能够更好的提取语音频率上的特征,但是残差网络能够使用更深的网络去提取更抽象的语音特征,由于残差机制的存在,即使网络层数增加也不会导致网络退化。

3.2.1 自注意力机制

自注意力机制是一种特殊的注意力机制,它只需要单独的序列来计算此序列的编码[29]。自注意力机制使用标准的点积注意力,其计算注意力权重如公式(1)所示:

(1)

其中,查询向量Q和键向量K的维度都是dk,值向量V的长度是dv。

多头自注意力是重复执行多次单个注意力,会产生h个Q,K和V。其中Q和K的维度大小为dk,V的维度大小为dv。向量的生成过程见公式(2)和公式(3):

MultiHead(Q,K,V)=Concat(head1,…,headh)WO

(2)

(3)

其中,![]() 是自注意力头的个数,dmodel是模型的总体维度。

是自注意力头的个数,dmodel是模型的总体维度。

3.2.2 CTC损失函数

CTC通过扩展模型的输出层,建立标签和输出文本的对应关系,直接对输入的语音特征进行训练,达到输出的序列在概率上最大化,并采用Adam极大化公式(4)所示的似然函数。

(4)

其中,(x,z)∈S表示训练实例,x代表输入的语音特征序列,z代表标签(音素串),每个训练样本可以用一个元组(x,z)来表示。

4 实验结果及分析

本节主要描述方言数据集、基准模型、参数设置和实验结果分析。

4.1 数据集

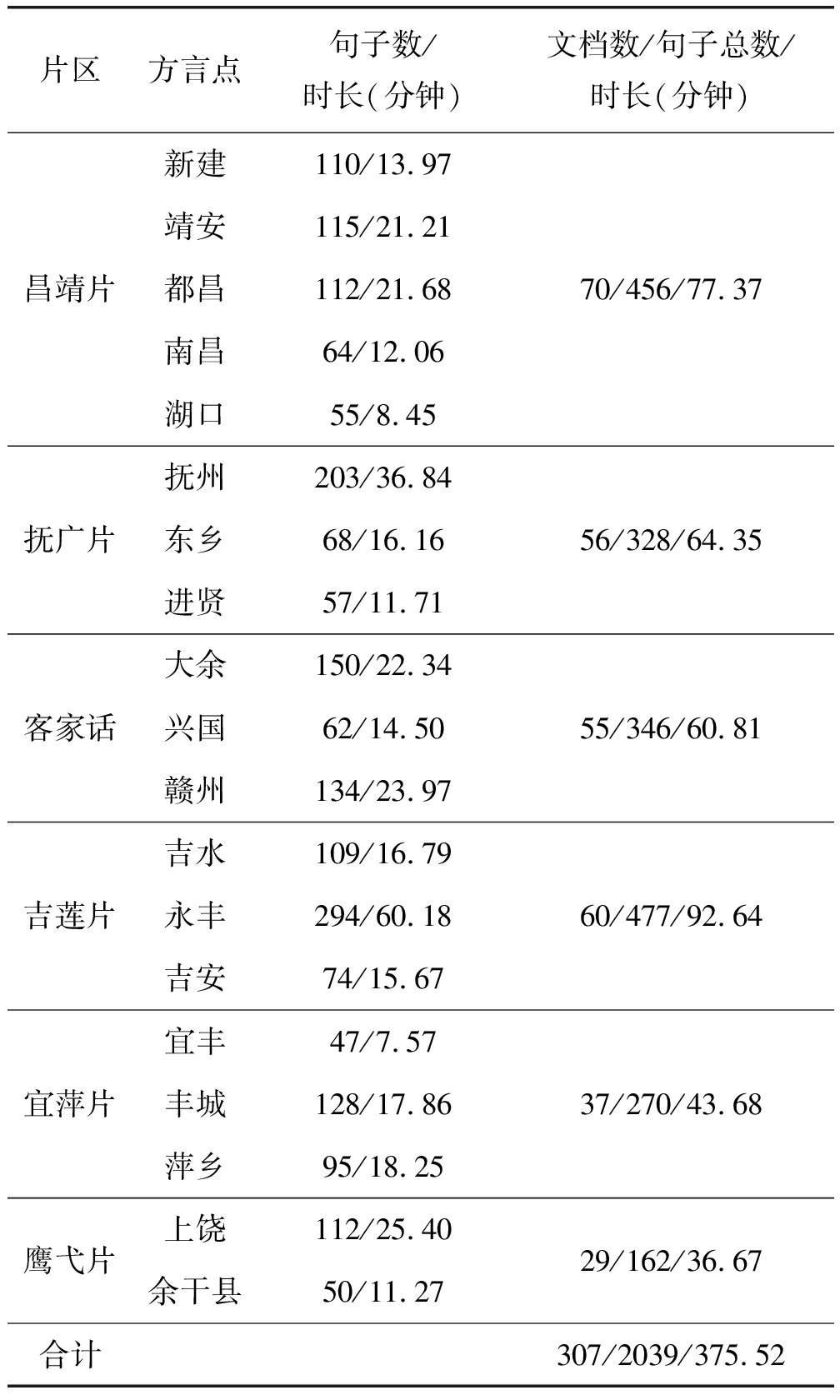

本次实验采用赣方言和客家方言两种数据集。表2显示了赣方言语料库的统计数据。其中赣方言数据集来源于文献[30]发布的XML(Extensible Markup Language)格式,包含了新闻、散文、等六大主题类型,包含江西境内的六大片区的19个方言点,分别为昌靖片(新建、南昌、都昌、湖口、靖安)、抚广片(抚州、东乡、进贤)、客家话片(大余、兴国、赣州)、吉莲片(吉安、永丰、吉水)、宜萍片(宜丰、丰城、萍乡)以及鹰弋片(上饶、余干县),共2039句语料,时长共375.52分钟,我们将语音数据按照8∶2的比例划分为训练集和测试集,并确保训练集和测试集没有重复说话人。我们利用ELAN工具(3)https:∥tla.mpi.nl/tools/tla-tools/elan对原始的篇章级赣方言音频文件进行切分,将其转化为多个音频句子。此外,采用的客家方言由科大讯飞组织的方言识别大赛中发布(4)http:∥challenge.xfyun.cn/2018/aicompetition/tech,覆盖35个说话人约6小时语音数据,其中训练集包含30个说话人,测试集包含5个说话人。训练集和测试集的总句子数分别为6000和500。该语料的采样率为16000 Hz。每个语音句子还有其对应的音素标签,比如“l iou4 sh iii2 _e er4 _v van2 s ii4 f en1”。

表2 赣方言数据集统计数据

Tab.2 Statistics of Gan dialect data set

片区方言点句子数/时长(分钟)文档数/句子总数/时长(分钟)昌靖片新建110/13.97靖安115/21.21都昌112/21.68南昌64/12.06湖口55/8.4570/456/77.37抚广片抚州203/36.84东乡68/16.16进贤57/11.7156/328/64.35客家话大余150/22.34兴国62/14.50赣州134/23.9755/346/60.81吉莲片吉水109/16.79永丰294/60.18吉安74/15.6760/477/92.64宜萍片宜丰47/7.57丰城128/17.86萍乡95/18.2537/270/43.68鹰弋片上饶112/25.40余干县50/11.2729/162/36.67合计307/2039/375.52

4.2 基准模型

由于直接进行方言语音识别的模型比较少。我们选取了如下基准模型,并编写代码重现这些模型。

基准模型1(LSTM+CTC):文献[17]设计了基于LSTM和CTC的客家方言语音识别模型,该模型采用LSTM构建声学模型,并利用CTC计算音素损失,我们重现了该模型。

基准模型2(ResNet&Bi-LSTM+CTC):文献[31]实现了ResNet与BiLSTM相结合的语音识别模型,同时采用CTC作为损失函数,我们重现了该模型。该模型的ResNet部分没有采用下采样和dropout操作,一方面模型运行时间花费较长,另一方面模型的性能也不高(见实验部分)。

基准模型3(WeNet):WeNet[32]面向产业界采用CTC/AED混合模型,针对streaming和non-streaming情形下设计了端到端语音识别系统。为了验证该模型在方言语音识别上的性能,我们直接将其普通话语音识别的训练和测试数据替换为方言情形,并利用其开源代码(5)https:∥github.com/wenet-e2e/wenet进行方言语音识别。WeNet实现了Conformer和Transformer两种模型,其中Conformer的Encoder端将CNN和Transformer进行有效结合,相比于更擅长提取长序列依赖特征的Transformer模型而言,它加入了卷积模型、Swish激活函数和dropout层。本次方言语音识别实验同时采用了WeNet的Conformer和Transformer两种模型。

基准模型4(DNN-HMM):由于DNN-HMM模型不需要预先假设声学特征服从何种类型的分布,同时有效地利用了上下文信息,成为一种经典的语音识别模型,在训练数据相对较少时取得了不错的语音识别性能。于是本文采用Kaldi进行DNN-HMM在方言语音识别下的实验。

4.3 评测指标

方言语音识别的性能评价指标采用音素错误率PER(Phoneme Error Rate),PER越低表示语音音素识别模型的效果越好。为了使识别出的音素串和标准的音素串一致,一般有插入(Insertion)、删除(Deletion)、替换(Substitution)三种操作,通过计算插入、删除、替换三类操作的总音素数再除以标准音素串中的总音素数(N),即得到音素错误率,计算公式(5)如下:

(5)

4.4 实验设置

本实验的参数alpha为0.001,β1为0.9,β2为0.98,epsilon设置为10e-9,Adam优化算法能够在训练过程中改变学习率,通过衰减的学习率来控制沿梯度下降的步长。本次实验在windows10系统下完成,使用Pytorch 1.7.1构建语音识别系统,显卡为GTX 1050Ti,CUDA版本为11.0。残差网络中 ResNet18网络参数设置如表3所示,同时设置dropout值为0.5,设置epoch和batch size分别为100和16。

表3 残差网络参数配置

Tab.3 Parameter configuration of residual networks

网络层输出大小下采样通道数残差块数conv2d40×Lin/2True64-maxpool20×Lin/4True64-res110×Lin/4False642res25×Lin/4False1282res33×Lin/4False2561res42×Lin/4False5121reshape512×Lin/4---

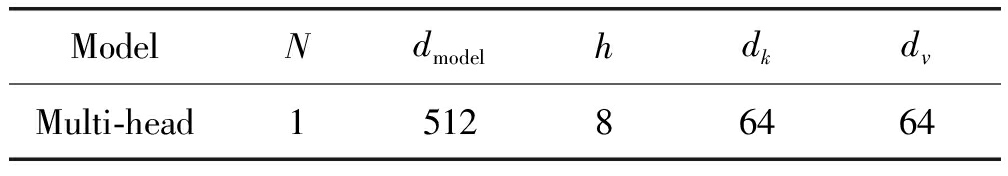

多头自注意力层使用的参数设置如表4所示。其中,N表示层数,其他参数与公式(2)和公式(3)对应。

表4 多头自注意力层网络结构配置

Tab.4 Structure configuration of multi head self attention layer network

ModelNdmodelhdkdvMulti-head151286464

4.5 实验结果

本节首先通过详细的实验数据对比阐述实验效果,然后对注意力机制进行可视化,从而分析模型取得较好效果的根本原因。

4.5.1 方言语音识别性能及分析

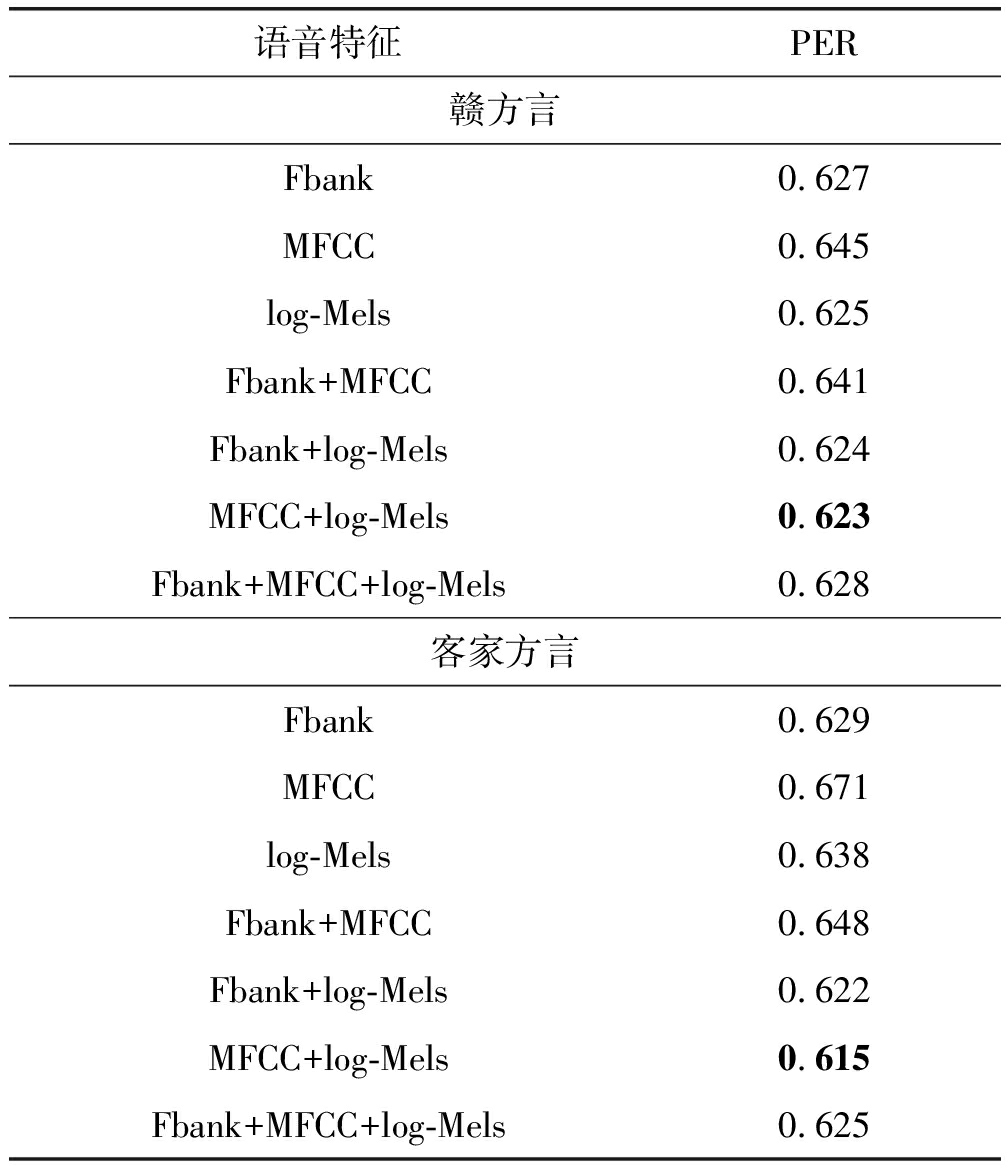

表5显示了采用不同语音特征(单一及组合特征)下方言语音识别性能。由于方言具有极强的地域性,很难采用通用的单一语音特征在不同语料库上同时取得最佳性能。针对赣方言而言,单一特征下的log-Mels取得了最好的方言语音识别性能,然后是Fbank和MFCC特征。然而,对应客家方言,Fbank取得了最好的方言语音识别性能。一般而言,Fbank性能均优于MFCC,原因在于FBank去除了离散余弦变换步骤,保留了更多的语音信息。同时,组合特征MFCC和log-Mels(采用向量拼接方式)取得了最好的方言语音识别性能,原因在于MFCC和log-Mels在特征方面具有良好的互补性,然而由于MFCC和FBank特征类似,导致MFCC和FBank的组合反而降低了方言语音识别性能。将三种语音特征加以拼接融合后,由于引入了噪音,并没有带来性能的进一步提升。

表5 各种语音特征对方言语音识别性能影响

Tab.5 Influence of various speech features on speech recognition performance of dialect

语音特征PER赣方言Fbank0.627MFCC0.645log-Mels0.625Fbank+MFCC0.641Fbank+log-Mels0.624MFCC+log-Mels0.623Fbank+MFCC+log-Mels0.628客家方言Fbank0.629MFCC0.671log-Mels0.638Fbank+MFCC0.648Fbank+log-Mels0.622MFCC+log-Mels0.615Fbank+MFCC+log-Mels0.625

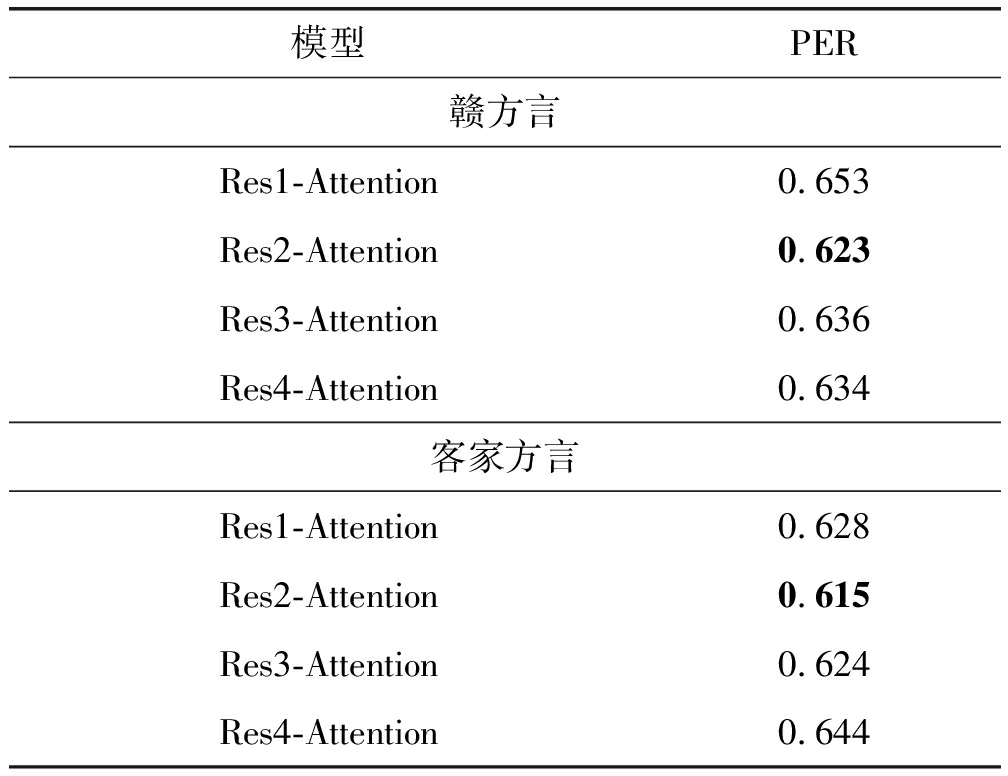

为了验证在不同层引入多头自注意力机制对语音识别效果的影响,分别在4个残差层后加入多头自注意力层,为方便描述分别命名为Res1-Attention,Res2-Attention,Res3-Attention和Res4-Attention。表6显示了最好组合特征下将多头注意力层加在不同位置下的方言语音识别性能。从表6的实验数据我们可以看出,将Attention层加在Res2后在两种方言语料库上均取得了最佳性能。原因在于,经过两层次的残差网络后,模型能够抽取比较好的语义特征,越往上层,抽取的特征也相对抽象。同时也验证了它在Bi-LSTM里能提高性能的原因相当于另外显式的加了一层对全局信息建模的过程,帮Bi-LSTM把没学到或者漏了的信息给补回来,而在第二层后引入自注意力层效果最好。

表6 多头注意力层不同位置对方言语音识别性能影响

Tab.6 Effects of different positions of multi head attention layer on dialect speech recognition performance

模型PER赣方言Res1-Attention0.653Res2-Attention0.623Res3-Attention0.636Res4-Attention0.634客家方言Res1-Attention0.628Res2-Attention0.615Res3-Attention0.624Res4-Attention0.644

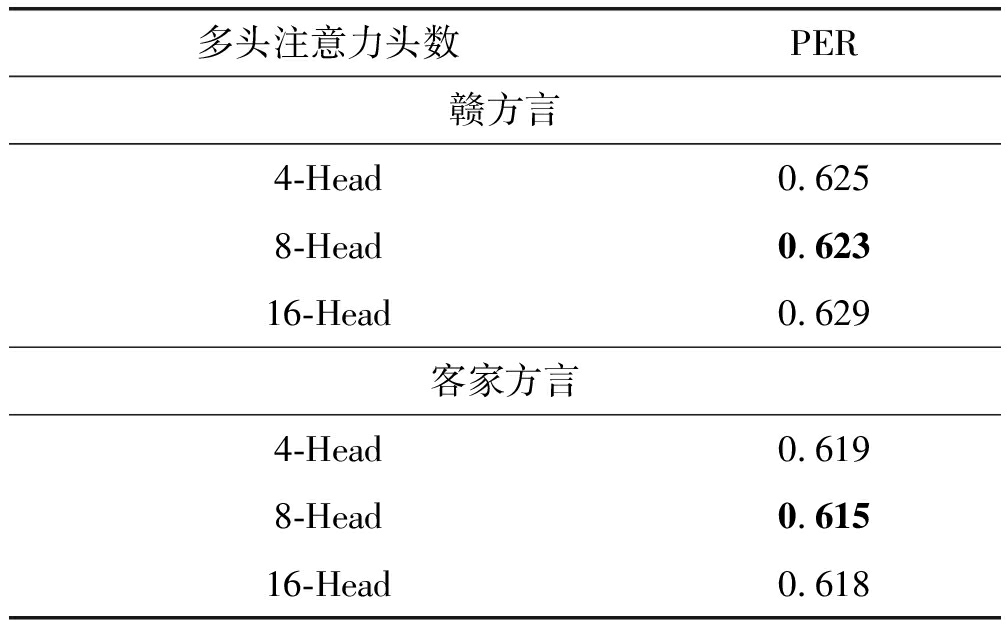

表7显示了最好组合特征和最好Attention位置下不同头数对方言语音识别性能的影响。经过实验结果不难发现,并非多头注意力头数越多,实验效果越好,经试验发现实验效果最好的为本次实验模型所用头数,即8头。分析原因,多头和单头的区别在于复制多个单头,但权重系数不一样,一般而言,头数越高,功能越强,语音识别音素准确率越高,但是本次实验由于数据量有限,头数过多使得训练发生了过拟合的情况,导致实验效果反而降低。

表7 多头注意力头数对方言语音识别性能影响

Tab.7 Effect of multiple attention heads on speech recognition performance of dialect

多头注意力头数PER赣方言4-Head0.6258-Head0.62316-Head0.629客家方言4-Head0.6198-Head0.61516-Head0.618

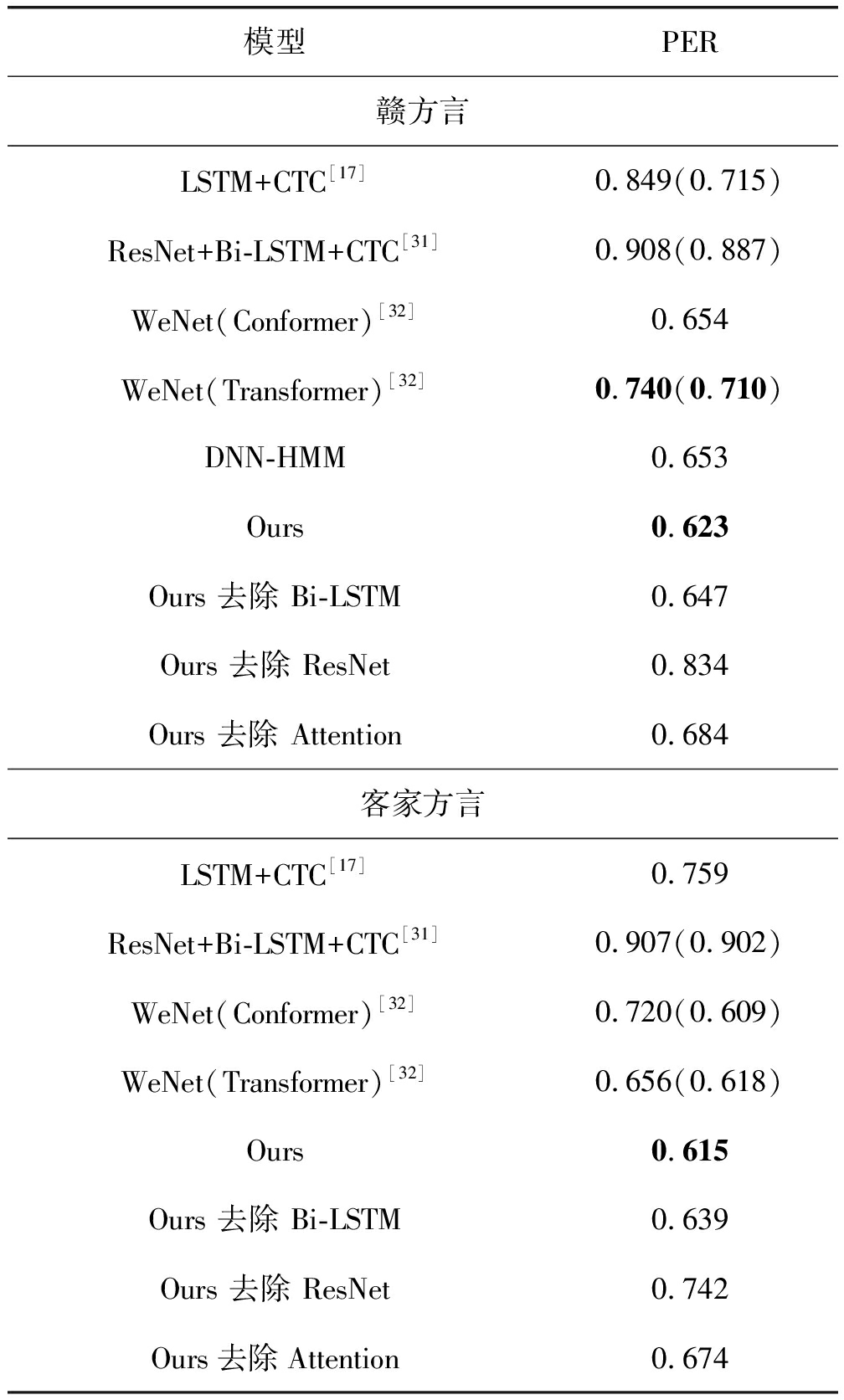

表8显示了本文模型与现有基准模型的方言语音识别性能以及消融实验(6)由于科大讯飞客家方言语料库中没有标注对应的汉字信息,仅仅提供了音素标注,但是赣方言同时提供了汉字和音素标注,本论文仅提供赣方言的DNN-HMM模型性能。。很明显,我们提出的模型性能显著优于基准方言语音识别模型。此外,通过表8实验数据可知,基准模型中采用原始的语音特征性能相对较低,利用本文提出的组合特征后进一步提升了基准模型的方言语音识别性能(见表8里括号中实验数据)。此外,我们还可以得出如下结论:

表8 方言语音识别性能对比

Tab.8 Performance comparison of dialect speech recognition

模型PER赣方言LSTM+CTC[17]0.849(0.715)ResNet+Bi-LSTM+CTC[31]0.908(0.887)WeNet(Conformer)[32]0.654WeNet(Transformer)[32]0.740(0.710)DNN-HMM0.653Ours0.623Ours 去除 Bi-LSTM0.647Ours 去除 ResNet0.834Ours 去除 Attention0.684客家方言LSTM+CTC[17]0.759ResNet+Bi-LSTM+CTC[31]0.907(0.902)WeNet(Conformer)[32]0.720(0.609)WeNet(Transformer)[32]0.656(0.618)Ours0.615Ours 去除 Bi-LSTM0.639Ours 去除 ResNet0.742Ours去除Attention0.674

(1)由于文献[31]的模型采用的3个卷积层属于并行结构,且没有采用下采样和dropout操作,导致其方言语音识别性能较差。相比较而言,我们模型采用了采样和dropout操作,同时融合了attention机制,集成了4个ResNet层抽取的语义特征。从而我们模型的性能优于现有模型。

(2)针对小数据量下的方言语音识别任务,DNN-HMM模型取得了不错的方言语音识别性能。其原因在于该模型不需要预先假设声学特征服从何种类型的分布,并通过连续的拼接帧,有效地利用了上下文信息。相比于端到端深度学习模型,DNN-HMM模型对标注数据的需求量也相对较少。

(3)虽然WeNet在普通话和英文语音识别性能上取得了不错的性能,但其在低资源方言语音识别上的性能一般。一方面在于,方言语音语料库远远达不到英文和普通话语料规模;另一方面在于通用语音识别模型没有针对方言特性挖掘特定发音底层特征。相比较而言,我们的模型利用不同的语音特征作为输入,同时充分发挥ResNet和Bi-LSTM模型互补优势,并利用多头注意力机制提取出方言特定的发音底层特征,采用该特征进行方言语音识别,在小规模低资源方言语音识别上面取得了较好的识别效果。此外,WeNet的Conformer模型由于融合了CNN模型,其在赣方言语音和客家方言语音识别性能上均优于Transformer模型。相比较而言,我们模型与Conformer存在两大区别:①从多头注意力机制上来说,Conformer采用了相对位置编码,而我们的模型通过调整attention在不同残差模块后的位置,提取不同级别的抽象特征,体现了一定的灵活性;②从特征提取角度来说,我们模型充分发挥了残差网络在提取帧内部和Bi-LSTM在提取帧外部(时序)方面特征的优势。总体而言,我们提出的模型在方言语音识别性能上要优于WeNet下的Conformer模型。

(4)通过消融实验,在不引入注意力机制时,赣方言和客家方言音素错误率分别为68.40%和67.40%,而引入注意力机制后,音素错误率为62.30%和61.50%,实验准确率分别提高了6.10%和5.90%,说明多头注意力机制的引入对实验识别效果更有帮助。原因在于,结合多头注意力机制能够观察到每一帧与其他帧之间的关系的特性,多头注意力层使得识别时更具有针对性,能够有效提高识别准确率。此外,去除ResNet和Bi-LSTM后,均导致方言语音识别性能的下降,尤其是去除ResNet后,赣方言和客家方言语音识别性能分别下降了21.10%和12.70%,说明ResNet在方言语音识别方面起着至关重要的作用,同时ResNet与Bi-LSTM在模型结构上也具有一定的互补性。

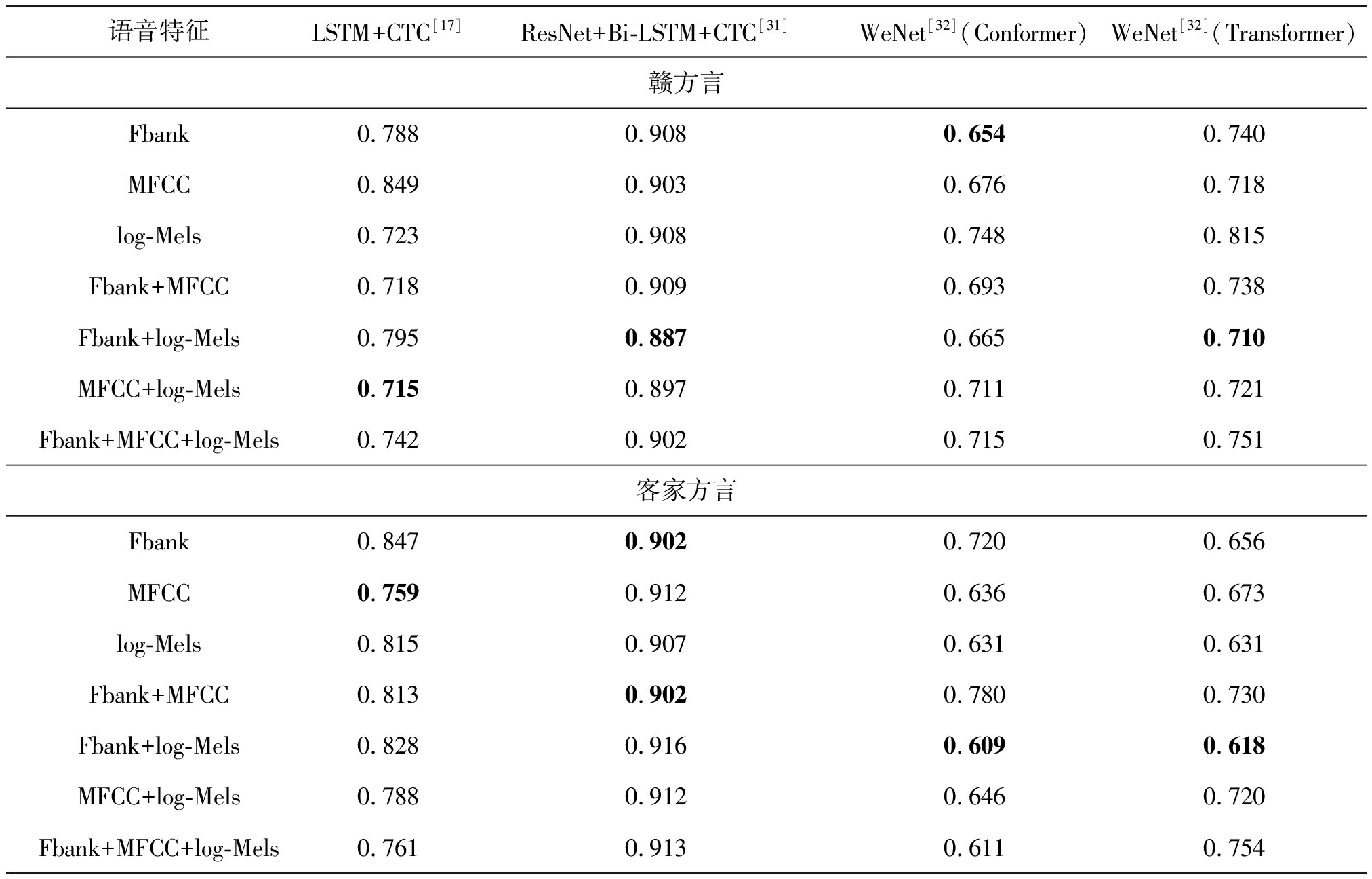

此外,表9显示了不同基准系统下各种语音特征对方言语音识别性能。从表9实验数据,我们可以明确:各种底层声学特征在不同Baselines下的方言语音识别性能具有较大的差异性。针对赣方言而言,Fbank、Fbank+log-Mels、FBank+log-Mels、MFCC+log-Mels分别在不同Baselines下取得了较好的识别性能;针对客家方言而言,Fbank、MFCC、Fbank+MFCC、FBank+log-Mels分别在不同Baselines下取得了较好的识别性能。相比于表5,我们提出的模型在不同底层特征方面具有稳定性,在采用MFCC+log-Mels底层声学特征下我们的模型同时在赣方言和客家方言下均取得了最好的识别性能。

表9 不同基准系统下各种语音特征对方言语音识别性能影响

Tab.9 Influence of various speech features on different baseline systems of Gan dialect speech recognition performance

语音特征LSTM+CTC[17]ResNet+Bi-LSTM+CTC[31]WeNet[32] (Conformer)WeNet[32] (Transformer)赣方言Fbank0.7880.9080.6540.740MFCC0.8490.9030.6760.718log-Mels0.7230.9080.7480.815Fbank+MFCC0.7180.9090.6930.738Fbank+log-Mels0.7950.8870.6650.710MFCC+log-Mels0.7150.8970.7110.721Fbank+MFCC+log-Mels0.7420.9020.7150.751客家方言Fbank0.8470.9020.7200.656MFCC0.7590.9120.6360.673log-Mels0.8150.9070.6310.631Fbank+MFCC0.8130.9020.7800.730Fbank+log-Mels0.8280.9160.6090.618MFCC+log-Mels0.7880.9120.6460.720Fbank+MFCC+log-Mels0.7610.9130.6110.754

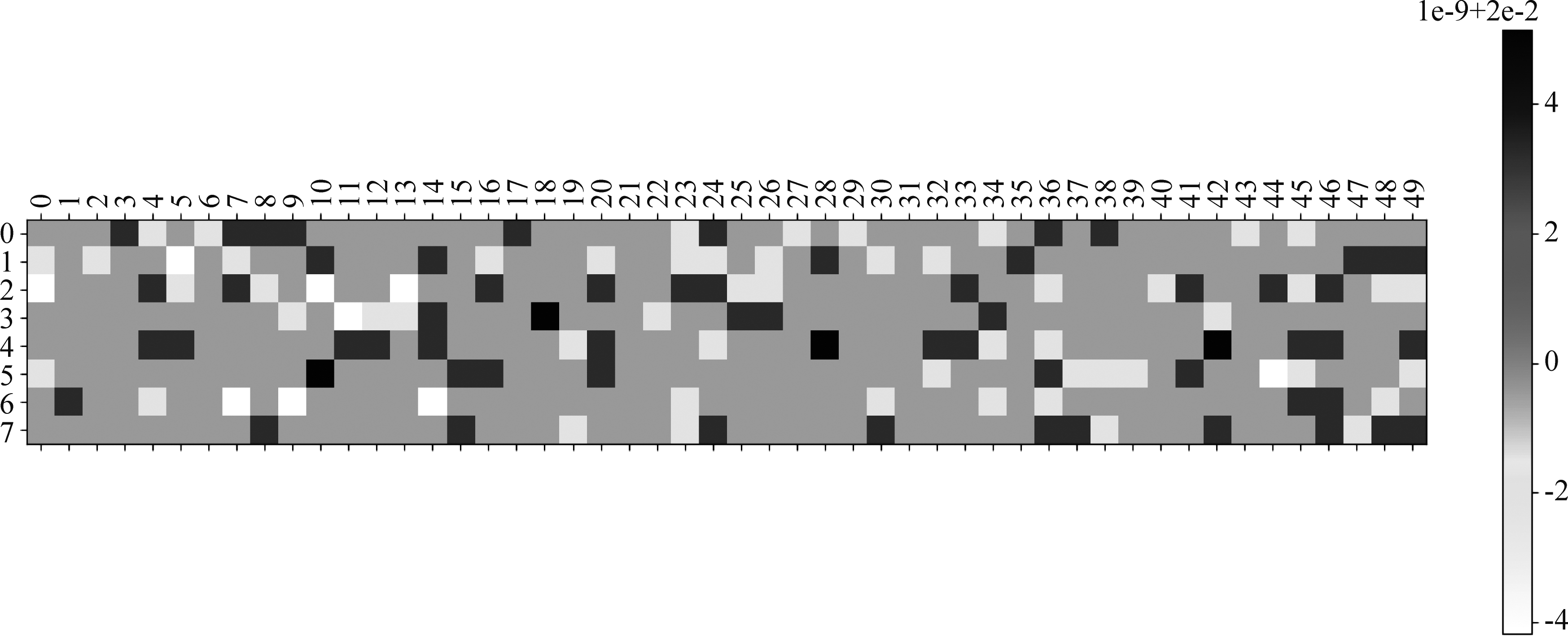

4.5.2 注意力可视化及分析

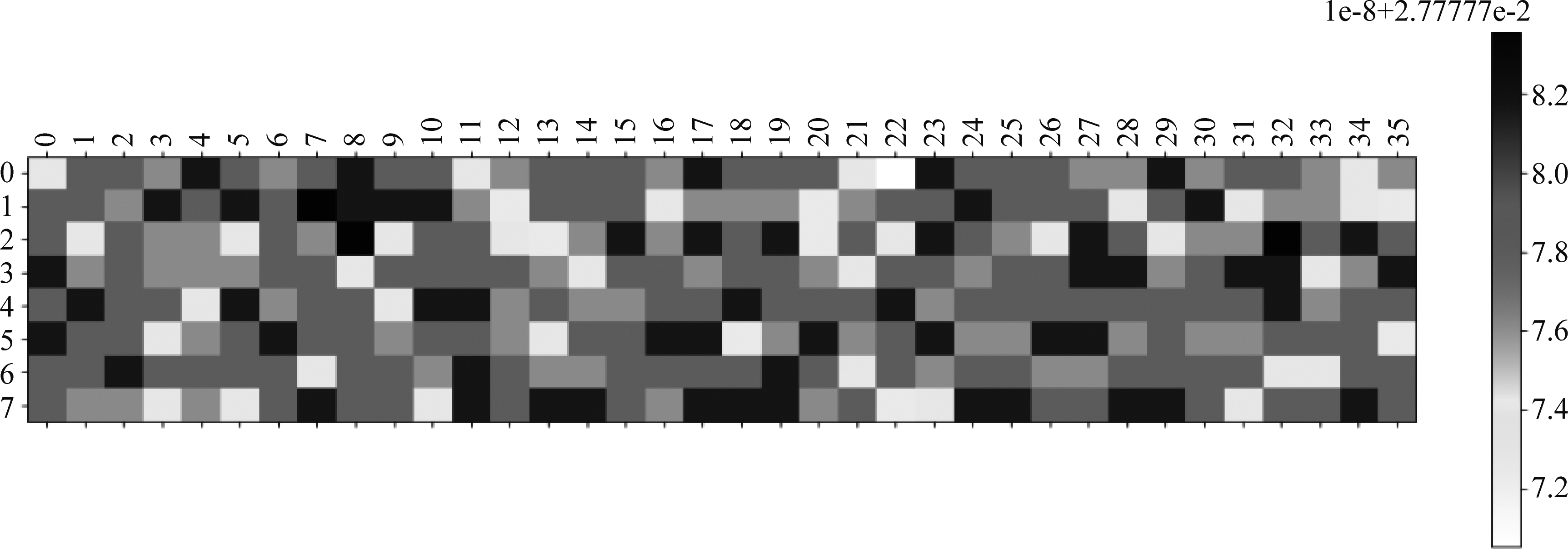

为了进一步分析模型性能得以提升的根本原因,我们对注意力进行可视化。图2和图3分别显示了从赣方言和客家方言语音数据集中挑选两个较短的音频文件进行可视化效果。其中,图2的横坐标代表赣方言帧数为50帧,纵坐标代表注意力机制的8个头。可以看出每个头均捕捉到了特征信息,且帧数范围在7~9和47~49的特征也有较大影响。图3的横坐标代表客家方言帧数为36帧,纵坐标代表注意力机制的8个头。同样,每个头都能抽取有用的信息。总体可知,多头注意力的每个头均能捕捉到特征信息,不同的语音多头注意力起作用的头数有区别,不同语音数据注意力所关注的区间也不尽相同,但是多头注意力提取的方言特有发音底层特征有利于提升方言语音识别性能。

图2 赣方言注意力可视化实例

Fig.2 Visualization of Gan dialect

图3 客家方言注意力可视化实例

Fig.3 Visualization of Hakka dialect

5 结论

本文提出了融合多种语音特征和自注意力机制的端到端方言语音识别模型,该模型分别探讨了方言特定发音底层特征(音素串)和多种语音特征对方言语音识别精度的影响。该模型充分发挥了残差网络和Bi-LSTM分别在语音帧内和帧间提取特征的互补优势。在基准赣方言和客家方言两个语料库上的实验结果表明,引入多头自注意力机制后,方言语音识别性能得到进一步提升。通过对注意力的可视化分析了模型性能取得提升的根本原因。我们后续将研究如何提取不同方言更有效的各自特有发音底层特征,并利用这些特征进一步提升方言语音识别性能。

[1] 田惠刚.汉语方言区划分概说[J].学术界, 1993(3): 90-92, 96.

TIAN Huigang.On the division of Chinese dialects[J].Academic Forum, 1993(3): 90-92, 96.(in Chinese)

[2] 李新魁.汉语各方言的关系和特点[J].学术研究, 1991(2): 87-93.

LI Xinkui.The relationship and characteristics of Chinese dialects[J].Academic Research, 1991(2): 87-93.(in Chinese)

[3] 谢留文.江西省的汉语方言[J].方言, 2008,30(2): 117-122.

XIE Liuwen.Chinese dialects in Jiangxi Province[J].Dialect, 2008, 30(2): 117-122.(in Chinese)

[4] 王福堂.关于客家话和赣方言的分合问题[J].方言, 1998, 20(1): 14-19.

WANG Futang.On the separation and combination of Hakka dialect and Gan dialect[J].Fangyan(Dialect), 1998, 20(1): 14-19.(in Chinese)

[5] 刘林泉, 郑方, 吴文虎.基于小数据量的方言普通话语音识别声学建模[J].清华大学学报(自然科学版), 2008, 48(4): 604-607.

LIU Linquan, ZHENG Fang, WU Wenhu.Small data set-based acoustic modeling for dialectal Chinese speech recognition[J].Journal of Tsinghua University(Science and Technology), 2008, 48(4): 604-607.(in Chinese)

[6] 吴健.方言口音普通话的语音矫正[J].现代语文(语言研究版), 2009(12): 101-102.

WU Jian.Phonetic correction of dialect accent and Putonghua[J].Modern Chinese, 2009(12): 101-102.(in Chinese)

[7] 张超, 刘轶, 郑方.面向多口音语音识别的声学模型重构[J].清华大学学报(自然科学版), 2011, 51(9): 1161-1166.

ZHANG Chao, LIU Yi, ZHENG Thomas Fang.Acoustic model reconstruction for multi-accent Chinese speech recognition[J].Journal of Tsinghua University(Science and Technology), 2011, 51(9): 1161-1166.(in Chinese)

[8] 魏思, 刘庆升, 胡郁, 等.带方言口音普通话自动水平测试[C]∥第八届全国人机语音通讯学术会议论文集.北京, 2005: 31-34.

WEI Si, LIU Qingsheng, HU Yu, et al.Automatic Mandarin proficiency test with dialect accent[C]∥2005 National Conference on Man-Machine Voice Communication.Beijing, 2005: 31-34.(in Chinese)

[9] 杨雅婷, 马博, 王磊, 等.多发音字典在维吾尔语方言语音识别中的应用[J].清华大学学报(自然科学版), 2011, 51(9): 1303-1306.

YANG Yating, MA Bo, WANG Lei, et al.Multi-pronunciation dictionary based Uyghur accent modeling for speech recognition[J].Journal of Tsinghua University(Science and Technology), 2011, 51(9): 1303-1306.(in Chinese)

[10] 伊·达瓦, 大川茂树, 白井克彦.蒙古语多方言语音识别及共享识别模型探索[J].中央民族大学学报, 2001, 28(4): 114-121.

I.Dawa, Shigeki Okawa, Katsuhiko Shirai.Inquiry into a common acoustic model to realize Mongolian dialectal speech recognition[J].Journal of the Central University for Nationalities, 2001,28(4): 114-121.(in Chinese)

[11] 张策, 韦鹏程, 陆晓燕, 等.重庆方言语音识别系统的设计与实现[J].计算机测量与控制, 2018, 26(1): 256-259, 263.

ZHANG Ce, WEI Pengcheng, LU Xiaoyan, et al.Design and implementation of speech recognition system in Chongqing dialect[J].Computer Measurement & Control, 2018, 26(1): 256-259, 263.(in Chinese)

[12] 王珩.中文方言语音识别的研究[D].上海: 上海交通大学, 2004.

WANG Heng.Research on Chinese dialect speech recognition[D].Shanghai: Shanghai Jiaotong University, 2004.(in Chinese)

[13] BUNDY A, WALLEN L.Linear predictive coding[M]∥Catalogue of Artificial Intelligence Tools.Berlin, Heidelberg: Springer Berlin Heidelberg, 1984: 61-61.

[14] SAKOE H, CHIBA S.Dynamic programming algorithm optimization for spoken word recognition[J].IEEE Transactions on Acoustics, Speech, and Signal Processing, 1978, 26(1): 43-49.

[15] RABINER L R.A tutorial on hidden Markov models and selected applications in speech recognition[C]∥Proceedings of the IEEE.IEEE,1989: 257-286.

[16] HINTON G, DENG Li, YU Dong, et al.Deep neural networks for acoustic modeling in speech recognition: The shared views of four research groups[J].IEEE Signal Processing Magazine, 2012, 29(6): 82-97.

[17] 余陆峰.基于深度学习的客家方言语音识别[D].广州: 华南理工大学, 2019.

YU Lufeng.Speech recognition of Hakka dialect based on deep learning[D].Guangzhou: South China University of Technology, 2019.(in Chinese)

[18] 余旭文.基于深度学习的海南方言语音识别[D].海口: 海南大学, 2020.

YU Xuwen.Speech recognition of Hainan dialect based on deep learning[D].Haikou: Hainan University, 2020.(in Chinese)

[19] 孙杰, 吾守尔·斯拉木, 热依曼·吐尔逊, 等.维吾尔语方言识别及相关声学分析[J].声学学报, 2019, 44(6): 1083-1092.

SUN Jie, WUSHOUER Silamu, REYIMAN Turson, et al.Acoustic analysis and language recognition of Uygur[J].Acta Acustica, 2019, 44(6): 1083-1092.(in Chinese)

[20] 刘晓峰, 宋文爱, 余本国, 等.基于注意力机制的大同方言语音翻译模型研究[J].中北大学学报(自然科学版), 2020, 41(3): 238-243, 248.

LIU Xiaofeng, SONG Wenai, YU Benguo, et al.Research on attention-based speech translation model of Datong dialect[J].Journal of North University of China(Natural Science Edition), 2020, 41(3): 238-243, 248.(in Chinese)

[21] 张宇, 张鹏远, 颜永红.基于注意力LSTM和多任务学习的远场语音识别[J].清华大学学报(自然科学版), 2018, 58(3): 249-253.

ZHANG Yu, ZHANG Pengyuan, YAN Yonghong.Long short-term memory with attention and multitask learning for distant speech recognition[J].Journal of Tsinghua University(Science and Technology), 2018, 58(3): 249-253.(in Chinese)

[22] GRAVES A, MOHAMED A R, HINTON G.Speech recognition with deep recurrent neural networks[C]∥2013 IEEE International Conference on Acoustics, Speech and Signal Processing.Vancouver, BC, Canada.IEEE, 2013: 6645-6649.

[23] MIAO Yajie, GOWAYYED M, METZE F.EESEN: End-to-end speech recognition using deep RNN models and WFST-based decoding[C]∥2015 IEEE Workshop on Automatic Speech Recognition and Understanding(ASRU).Scottsdale, AZ, USA.IEEE, 2015: 167-174.

[24] KIM S, HORI T, WATANABE S.Joint CTC-attention based end-to-end speech recognition using multi-task learning[C]∥2017 IEEE International Conference on Acoustics, Speech and Signal Processing(ICASSP).New Orleans, LA, USA.IEEE, 2017: 4835-4839.

[25] YI Jiangyan, TAO Jianhua, BAI Ye.Language-invariant bottleneck features from adversarial end-to-end acoustic models for low resource speech recognition[C]∥ICASSP 2019-2019 IEEE International Conference on Acoustics, Speech and Signal Processing(ICASSP).Brighton, UK.IEEE, 2019: 6071-6075.

[26] LOPEZ-MORENO I, GONZALEZ-DOMINGUEZ J, PLCHOT O, et al.Automatic language identification using deep neural networks[C]∥2014 IEEE International Conference on Acoustics, Speech and Signal Processing(ICASSP).Florence, Italy.IEEE, 2014: 5337-5341.

[27] TANG Zhiyuan, WANG Dong, CHEN Yixiang, et al.Phonetic temporal neural model for language identification[J].IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2018, 26(1): 134-144.

[28] XU Fan, LUO Jian, WANG Mingwen, et al.Speech-driven end-to-end language discrimination toward Chinese dialects[J].ACM Transactions on Asian and Low-Resource Language Information Processing, 2020, 19(5): 1-24.

[29] Ashish Vaswani, Noam Shazeer, Niki Parmar, et al.Attention is all you need[C]∥2017 International Conference on the Advances in Neural Information Processing Systems(NIPS).Long Beach, USA.2017: 5998-6008.

[30] XU Fan, WANG Mingwen, LI Maoxi.Building Parallel Monolingual Gan Chinese Dialects Corpus[C]∥2018 Conference on the Language Resources and Evaluation.Miyazaki, Japan.2018: 244-249.

[31] 胡章芳, 徐轩, 付亚芹, 等.基于ResNet-BLSTM的端到端语音识别[J].计算机工程与应用, 2020, 56(18): 124-130.

HU Zhangfang, XU Xuan, FU Yaqin, et al.End to end speech recognition based on ResNet-BLSTM[J].Computer Engineering and Applications, 2020, 56(18): 124-130.(in Chinese)

[32] YAO Zhuoyuan, WU Di, WANG Xiong, et al.WeNet: Production oriented streaming and non-streaming end-to-end speech recognition toolkit[C]∥2021 Conference on the Interspeech.Brno, Czech Republic, 2021: 1-5.