1 引言

过去的几十年里,自动语音识别领域取得了巨大的进展,技术上已经满足了人类的实际使用需求。深度神经网络(Deep Neural Network,DNN)-隐马尔可夫模型(Hidden Markov Model,HMM)[1-2]是第一个成功的基于深度学习的语音识别模型。典型的DNN-HMM混合模型由几个独立的模块组成,其中包括声学模型,发音词典和语言模型。所有这些模块都由独立设计并以不同的目标进行优化。除此之外,DNN-HMM模型需要一个复杂的解码器,通过集成声学模型,发音词典和语言模型来实现解码过程。总而言之,基于DNN-HMM的语音识别模型需要多个领域的丰富知识以及复杂的解码过程,使得整个语音识别过程很繁琐,优化任务艰难。

最近几年以来,端到端语音识别模型[3-5]在语音识别领域中普遍受欢迎。端到端的语音识别模型将常规DNN-HMM语音识别结构简化为单个深度神经网络的结构。此外,端到端的语音识别模型不再需要发音词典,可以直接预测字或单词,因此整个模型结构比DNN-HMM模型更简洁,容易优化。迄今为止,端到端语音识别模型已经在语音识别准确率上超过了传统的语音识别模型[6-7],因此无论是学术界还是工业界都开始大量的使用端到端语音识别模型。当前实现端到端的语音识别主要有两种方式:一种是基于链接时序分类(Connectionist Temporal Classification,CTC)的语音识别结构[8-9],另一种是基于注意力的语音识别结构[10-11]。

基于CTC的方法中输入和输出序列之间不需要严格对齐。该方法使用中间标签序列,允许标签重复并且引入了空标签表示无输出。CTC的损失可以通过正向-反向算法计算,具备快速训练和解码特点,比较合适实时性较强的识别任务。基于注意力机制的语音识别方法中,识别过程被视为一个语音特征序列到文本序列的序列学习任务,每一次解码都依赖于当前语音特征输入和上一时刻的输出,因此没法进行并行训练和解码,实时性较差。

最近基于注意力机制的Transformer[12]模型在各个语音识别任务中凭着本身捕获长距离语音特征信息和高度并行训练的特点逐步替代循环神经网络(Recurrent Neural Network,RNN)的模型,另外卷积神经网络也因善于提取局部细粒度特征的能力,开始在语音识别任务中广泛使用。随后研究者们便提出了既能捕获长距离信息又能提取局部特征信息的Conformer[13]模型,该模型在各个端到端的语音识别任务中以较少的模型参数量表现出优异的识别性能。

维吾尔语是黏着语,词汇量随着数据规模的增多而剧增,如果直接以词作为建模单元会出现大量的未登录词以及词汇量巨大,难以训练端到端的语音识别模型。目前维吾尔语上公开可利用的语音数据集较少属于低资源语言,低资源环境下模型识别性能较低。虽然以前有研究者们做过解决未登录词问题和低资源环境下提升识别性能的工作,但大部分都是以传统语音识别[14-15]方法为主,很少有端到端语音识别相关的研究工作。

为了解决上述的问题,本文中提出基于多任务学习的端到端维吾尔语语音识别模型,把Conformer模型作为共享层与CTC相连接,通过BPE-dropout[16]方法形成鲁棒性更强的子词,然后同时以子词和字作为建模单元进行多任务训练和解码,其中识别字符任务作为识别子词任务的辅助任务。多任务学习模型[17]能在低资源环境下,通过多个相关任务的学习充分利用数据,有效提高模型的泛化能力。在公开的维吾尔语语音数据集THUYG-20上的实验结果显示,本文提出的多任务学习模型能够有效解决未登录词问题的同时,在低资源环境下有效提升了语音识别性能。

2 模型结构及方法介绍

2.1 Conformer模型

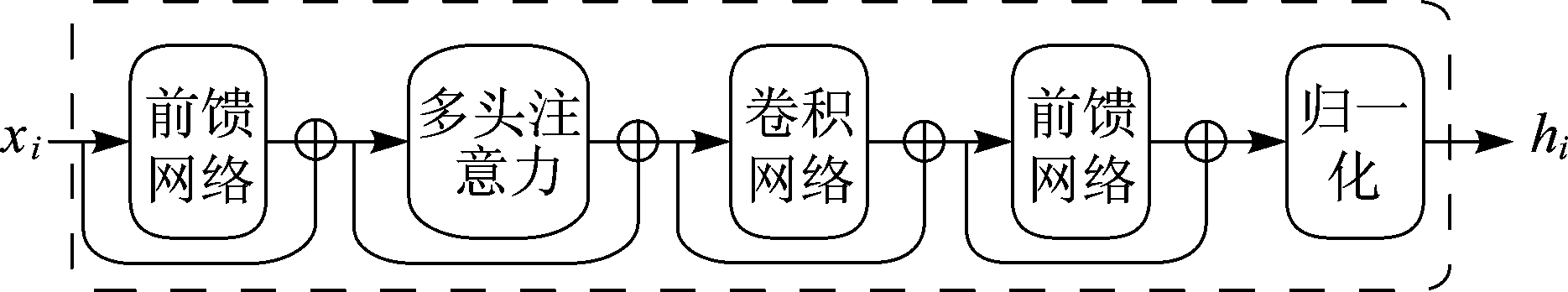

目前主流的端到端语音识别任务中Conformer模型开始被大量的使用,整体结构如图1所示,由多头注意力模块,卷积网络模块和前馈网络模块组成。

图1 Conformer模型结构

Fig.1 Conformer model structure

多头注意力模块结合Transformer-XL中使用的计算序列位置编码信息的方法,能够从整个输入的语音特征序列中学习到包含时序位置编码的重要语音特征信息。多头注意力模块前后通过层归一化层和Dropout层。卷积网络模块内部包含逐点卷积网络,Glue激活函数,1-D深度卷积网络组成。卷积网络模块从输入特征序列中学习到局部细粒度的语音特征信息,该某块内部也使用批归一化层和Dropout层。前馈网络模块内部使用两个线性变换层和Swish激活函数,模块内部也使用层归一化和Dropout层。Conformer模型参考Macaron-Net网络结构[18],把前馈网络模块分别放到多头注意力模块前面和卷积网络模块后面并在各个模块之间做残差连接。

将输入xi送入到Conformer模型,经过前馈网络,多头注意力,卷积网络和层归一化层编码输出hi的过程如下所示:

(1)

(2)

(3)

(4)

其中FFN是前馈网络模块,MHSA是多头注意力模块,CONV是卷积网络模块,Layernorm表示层归一化。Conformer模型中把前馈网络模块分别放到多头注意力模块前面和卷积网络模块后面有助于提升模型的识别性能。

2.2 链接时序分类(CTC)

链接时序分类(Connectionist Temporal Classification,CTC)[19]的方法中输入和输出序列之间不需要严格对齐,使用中间标签序列π=(π1,π2....,πT)来表示输入序列对应的中间标签序列,在中间标签序列π中标签可以重复且引入了特殊的空标签(-),空标签用来表示无标签输出和间隔符。通过编码器的输出,CTC能计算出每一时刻所对应标签的条件概率,其中输出的标签序列之间是相互独立的,概率p(π|x)的计算过程公式(5)所示:

(5)

其中![]() 表示第t时刻所对应标签πt的概率。CTC通过最大化p(y|x)来训练模型,计算过程公式(6)所示:

表示第t时刻所对应标签πt的概率。CTC通过最大化p(y|x)来训练模型,计算过程公式(6)所示:

(6)

φ(y)是所有合理CTC路径的集合,可以通过去重和删除空标签映射到输出标签序列y。使用前向-后向算法能够快速计算p(y|x)的概率分布,计算过程如公式(7)所示:

(7)

u表示标签下标,![]() 表示标签u在t时刻的前向概率之和,

表示标签u在t时刻的前向概率之和,![]() 表示u标签在t时刻的后向概率之和。CTC损失是输出标签序列的负对数似然,计算过程公式(8)所示:

表示u标签在t时刻的后向概率之和。CTC损失是输出标签序列的负对数似然,计算过程公式(8)所示:

LCTC=-ln(p(y|x))

(8)

2.3 建模单元

维吾尔语是典型的黏着语形态结构比较复杂,总包含32个字母,由8个元音和24个辅音字母构成[20]。通过词根和词缀进行构词,如:![]() (词根)+

(词根)+![]() (词缀)+

(词缀)+![]() (词缀),

(词缀),![]() (词根)+

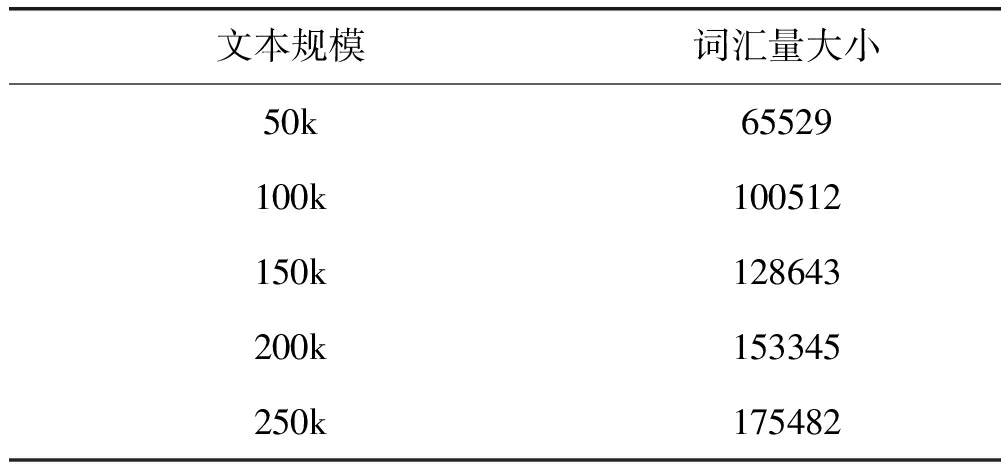

(词根)+![]() (词缀)。由于词根与词缀的种类比较多并且词根和词缀能以不同的组合形成新的词汇,因此维吾尔语中词汇量巨大,语音识别任务中常出现未登录词问题。表1所展示随着文本规模的增多(每次增加5万条文本)所包含词汇量的变化趋势。可以看出,随着文本规模的增加词汇量巨增。

(词缀)。由于词根与词缀的种类比较多并且词根和词缀能以不同的组合形成新的词汇,因此维吾尔语中词汇量巨大,语音识别任务中常出现未登录词问题。表1所展示随着文本规模的增多(每次增加5万条文本)所包含词汇量的变化趋势。可以看出,随着文本规模的增加词汇量巨增。

表1 词汇量随着文本规模的变化趋势

Tab.1 The changing trend of vocabulary size with text size

文本规模词汇量大小50k65529100k100512150k128643200k153345250k175482

在语音识别任务中所选取的建模单元会影响到模型的识别性能。如果把字作为建模单元会出现序列太长,模型很难学习到序列之间的依赖关系。通常子词作为建模单元,它既能有效减少词汇量规模,又能有效解决未登录词问题。

目前有多种方法可以把单词拆成子词,当前最普遍使用的方法是通过字节编码(Byte Pair Encoding, BPE)算法形成子词。字节编码算法中,首先初始化子词集合,子词集合包含所有的字符,随后通过迭代合并频繁出现的字符对,将其形成的子词放入到子词集合中,子词集合的子词数目达到指定上界时结束迭代。本文中使用BPE-dropout[21]方法形成子词,该方法是在字节编码算法的基础上引入一定的随机性,当进行迭代合并频繁出现的字符对时,以概率p丢弃一些合并操作,其中p=0以普通字节编码算法方式形成子词,p=1则不进行任何合并操作只保留字。使得该方法能够对相同词干类型的词,实现不同的子词切分,能够实现以动态方式获取子词。动态子词作为建模单元更具有鲁棒性,在一些序列学习任务中表现出较好的性能。该方法能确保子词集合包含所有的字母,因此遇到任何罕见词汇也能够映射到对应的子词。

2.4 多任务学习模型

本文提出的多任务学习模型结构如图2所示。多任务学习模型是基于Conformer和链接时序分类(CTC)的多层编码器-解码器网络结构,每一层编码器由多头注意力,卷积网络和前馈网络组成,其中每一层之间都进行归一化和随机失活。解码器是基于链接时序分类(CTC)进行快速训练和解码。

图2 多任务学习模型

Fig.2 Multi task learning model

首先对输入的语音进行特征提取,然后降采样通过线性层,将线性层输出x=(x1,...,xT)送入到编码器中,经过编码器内的多头注意力,卷积网络和前馈网络输出中间特征表示序列h=(h1,...,hT)。随后把中间特征序列h送入到不同任务的解码器中,在每一个时间步子词解码器和字解码器各自输出y=(y1,...,yU)和z=(z1,...,zk)中的一个标签,其中yi表示子词建模单元,zi表示字建模单元,计算过程如下所示:

h=Encoder(x)

(9)

y=Decoderbpe(h)

(10)

z=Decoderchar(h)

(11)

子词任务作为主任务,字任务作为辅助任务同时训练多任务学习模型。通过多任务学习基于Conformer的共享层能够学习到丰富的语音特征表示。多任务学习模型的目标函数是各任务CTC损失的加权和,计算过程如下所示:

LMTL=λLbpe+(1-λ)Lchar

(12)

其中λ∈(0,1)是个微调超参数。

3 实验配置

3.1 数据集

本文采用公开的维吾尔语语音数据集THUYG-20[22]完成所有的实验。该数据集中训练集时长为20小时,测试集为2.4小时,开发集为1.1小时。朗读内容覆盖小说,新闻,科技和生活等领域。所有语音数据都为16 kHz采样率,16 bit量化,单声道格式。本文以Kaldi和Pytorch作为实验平台完成各个实验。使用ThenoLM语言模型工具包,在20万条口语文本语料上训练3-gram语言模型。

3.2 模型配置参数

多任务学习模型的输入为80维的Fbank特征,窗口大小25 ms,帧移10 ms,使用8层编码器,每层包含2048个单元,注意力头数目设为4,其输出维度大小为256,卷积网络中卷积核数目设为13。每一层编码器内部dropout设为0.1,多任务学习训练权重λ=0.3,使用Adam优化器,学习率设为0.002。解码过程使用集束搜索算法,搜索宽度为20,语言模型比重为0.2,epoch次数为200。

3.3 对比实验

DNN-HMM模型使用80维的Fbank特征,包含4个隐藏层,每一个隐藏层有1024个结点,通过时间反向传播算法进行模型的训练,以交叉熵损失函数计算模型损失,学习率设为0.01,使用Adam优化器。

链式模型(chain model)采用TDNN(Time Delay Neural Network)网络结构,输入为80维的Fbank特征,包含4个隐藏层,每一个隐藏层有1024个结点,采用最大互信息区分性训练策略进行模型的训练,通过跳转方式每隔三帧取一个帧进行做解码,相比于DNN-HMM模型拥有较快的解码速度。

BLSTM-CTC/ATT模型是由编码器和解码器网络组成,本实验中为取得较好的识别性能,使用120维的梅尔倒谱系数作为该模型的输入,编码器由3层双向LSTM网络和全链接层组成,其中每一层的结点数为1024,解码器中分别把CTC和多头注意力连接,进行联合训练和解码,解码过程中使用集束搜索算法。

Transformer-CTC模型中,输入为80维的Fbank特征,由8层编码器组成,编码器内包含多头注意力,前馈网络和归一化层组成,注意力头个数设为4,模型的输出直接与链接时序分类(CTC)进行连接,解码过程中使用集束搜索算法。

Conformer-CTC 模型中,输入为80维的Fbank特征,由8层编码器组成,编码器内包含多头注意力,卷积网络,前馈网络和归一化层组成,注意力头个数为4,卷积核数为13。模型的输出直接与链接时序分类(CTC)进行连接,解码过程中使用集束搜索。

3.4 评价指标

本文中采用BPE错误率(bpe error rate,BER)和字错误率(character error rate,CER)作为模型的评价指标。其中I为插入错误,D为删除错误,R为替换错误,N为标准标签序列内的标签总数。

(13)

(14)

4 实验结果及分析

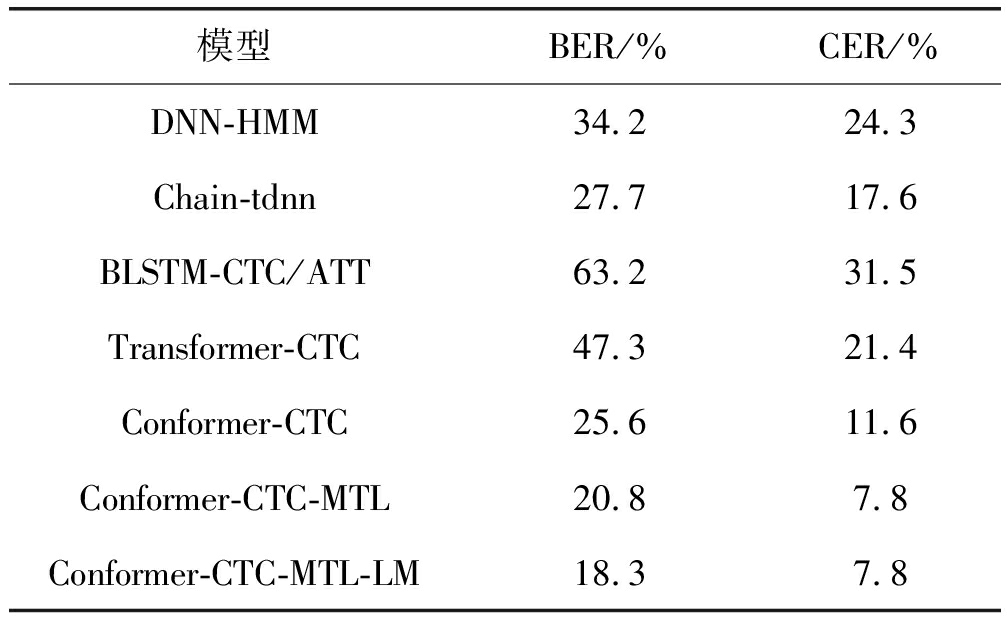

本文提出的多任务学习模型与其他模型的实验结果对比表2所示。

表2 多任务学习模型与其他模型的识别率对比

Tab.2 Comparison of recognition rate between multi task learning model and other models

模型BER/%CER/%DNN-HMM34.224.3Chain-tdnn27.717.6BLSTM-CTC/ATT63.231.5Transformer-CTC47.321.4Conformer-CTC25.611.6Conformer-CTC-MTL20.87.8Conformer-CTC-MTL-LM18.37.8

所有的实验都使用BPE-dropout方法形成的子词作为建模单元,BPE大小选取1000,丢弃率设为0.0001。从实验结果中可以看出,多任务学习模型的性能明显优于传统方法的语音识别模型,把子词错误率和字错误率分别降低了6.9%和9.8%。分析原因是,多任务学习模型的共享层中使用了自注意力和卷积网络结构,能有效捕获长距离和局部细粒度语音特征信息,并且容易搭建和训练深层网络模型,因此表现出较好的识别性能。

多任务学习模型与其他端到端的单任务学习模型相比较可以看出,多任务学习模型的识别性能明显优于其他端到端的模型,把子词错误率和字错误率分别降低到20.8%和7.8%。分析原因是,多任务学习模型能在低资源环境下通过不同相关任务的学习充分利用数据,使共享层能学习到更丰富的时序语音特征信息,进一步提高模型的泛化能力。在多任务学习模型的解码过程中结合语言模型能把子词错误率降到18.3%,由于解码出的字序列较长,基于字的统计语言模型没能带来字识别任务的提升。

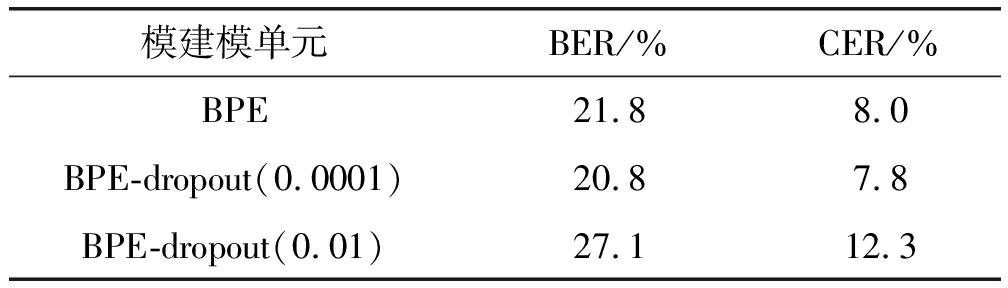

本文为了选取鲁棒性较强的子词建模单元,使用普通BPE和BPE-dropout方法形成子词,在多任务学习模型上进行训练,实验结果对比表3所示。

表3 BPE与BPE-dropout所形成的建模单元对识别性能的影响

Tab.3 Influence of modeling unit formed by BPE and BPE dropout on recognition performance

模建模单元BER/%CER/%BPE21.88.0BPE-dropout(0.0001)20.87.8BPE-dropout(0.01)27.112.3

实验结果中可以看出,使用BPE-dropout方法所形成的子词作为建模单元表现出较好的识别性能,与普通的字节编码算法(BPE)相比较把子词错误率和字错误率分别降低1%和0.2%,其中丢弃率也对识别性能有一定的影响,当丢弃率设为0.0001时表现出较好的性能,过大会降低识别性能。识别结果分析发现,随机丢弃形成的子词作为建模单元,模型能更好的识别一些未登录词,说明了字节编码算法中引入随机丢弃所形成的建模单元比较适合做维吾尔语语音识别任务的建模单元。

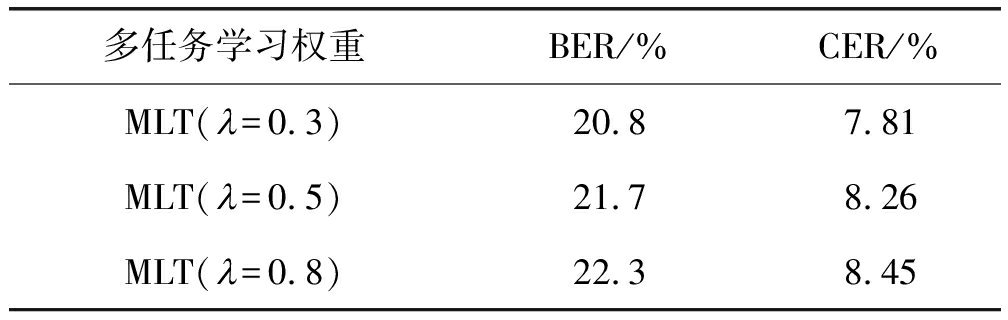

表4所示,随着多任务学习权重λ的提升,子词错误率和字错误率也开始上升,说明了训练过程中子词训练任务所占比的减少,能带来模型识别性能的提升。

表4 多任务学习权重对模型识别性能的影响

Tab.4 Influence of multi task learning weight on model recognition performance

多任务学习权重BER/%CER/%MLT(迟=0.3)20.87.81MLT(迟=0.5)21.78.26MLT(迟=0.8)22.38.45

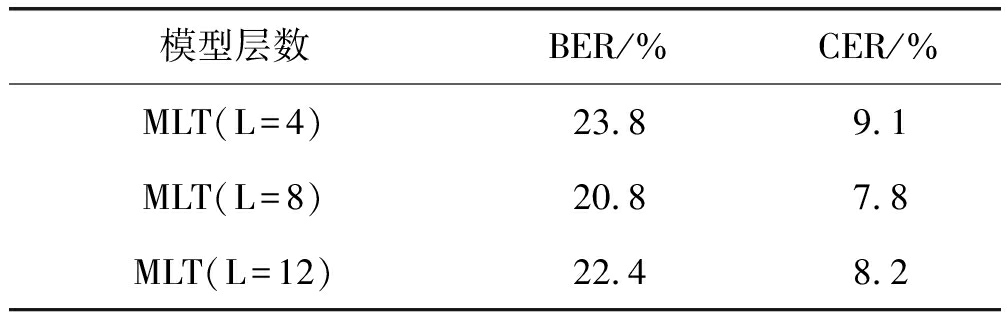

表5所示,模型随着编码器层数的加深,性能开始逐步提升,进一步说明深层网络模型能学到复杂的语音特征信息,编码器层数为8时表现出较好的性能,当编码器层数为12时模型性能变差。分析原因是随着层数的增多模型所需要训练的参数也增加,过多的参数在低资源环境下无法有效训练,导致模型容易出现过拟合,识别性能逐步下降。

表5 模型深度对识别性能的影响

Tab.5 Influence of model depth on recognition performance

模型层数BER/%CER/%MLT(L=4)23.89.1MLT(L=8)20.87.8MLT(L=12)22.48.2

5 结论

本文针对端到端的维吾尔语语音识别模型中常出现的未登录词问题和低资源环境下性能较低问题,提出基于多任务学习的端到端维吾尔语语音识别模型,与传统的语音识别模型相比极大简化了模型结构。多任务学习模型中把Conformer作为共享层并与链接时序分类(CTC)相连接,同时使用BPE-dropout方法形成的子词和字作为建模单元同时进行多任务训练和解码。其中子词作为建模单元能有效解决未登录词问题,通过多任务学习能让模型在低资源环境下充分利用数据,学习到丰富的时序语音特征信息,提高模型的泛化能力。多任务学习模型在公开的维吾尔语语音数据集上表现出较好的识别性能,把子词错误率和字错误率分别降低7.3%和3.8%。

[1] HINTON G, DENG Li, YU Dong, et al.Deep neural networks for acoustic modeling in speech recognition: The shared views of four research groups[J].IEEE Signal Processing Magazine, 2012, 29(6): 82-97.

[2] YAO Kaisheng, DONG Yu, SEIDE F, et al.Adaptation of context-dependent deep neural networks for automatic speech recognition[C]∥2012 IEEE Spoken Language Technology Workshop(SLT).IEEE, 2012: 366-369.

[3] GRAVES A, MOHAMED A R, HINTON G, et al.Speech recognition with deep recurrent neural networks[C]∥2013 IEEE International Conference on Acoustics, Speech and Signal Processing.Vancouver, BC, Canada.IEEE, 2013: 6645-6649.

[4] GONZALEZ-DOMINGUEZ J, EUSTIS D, LOPEZ-MORENO I, et al.A real-time end-to-end multilingual speech recognition architecture[J].IEEE Journal of Selected Topics in Signal Processing, 2015, 9(4): 749-759.

[5] XU Hainan, DING Shuoyang, WATANABE Shinji.Improving End-to-end speech recognition with Pronunciation-assisted Sub-word modeling[C]∥ICASSP 2019-2019 IEEE International Conference on Acoustics, Speech and Signal Processing(ICASSP).Brighton,UK.IEEE,2019: 7110-7114.

[6] ZHAO Yuanyuan, LI Jie, WANG Xiaorui, et al.The speech transformer for large-scale mandarin Chinese speech recognition[C]∥ICASSP 2019-2019 IEEE International Conference on Acoustics, Speech and Signal Processing(ICASSP).Brighton, UK.IEEE, 2019: 7095-7099.

[7] LUO Haoneng, ZHANG Shiliang, LEI Ming, et al.Simplified self-attention for transformer-based end-to-end speech recognition[J].2021 IEEE Spoken Language Technology Workshop(SLT), 2021: 75-81.

[8] LI Jinyu, YE Guoli, DAS A, et al.Advancing acoustic-to-word CTC model[C]∥2018 IEEE International Conference on Acoustics, Speech and Signal Processing(ICASSP).Calgary, AB, Canada.IEEE, 2018: 5794-5798.

[9] DAS A, LI Jinyu, YE Guoli, et al.Advancing acoustic-to-word CTC model with attention and mixed-units[J].IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2019, 27(12): 1880-1892.

[10] CHAN W, JAITLY N, LE Q, et al.Listen, attend and spell: A neural network for large vocabulary conversational speech recognition[C]∥2016 IEEE International Conference on Acoustics, Speech and Signal Processing(ICASSP).Shanghai, China.IEEE, 2016: 4960-4964.

[11] CHIU C C, SAINATH T N, WU Yonghui, et al.State-of-the-art speech recognition with sequence-to-sequence models[C]∥2018 IEEE International Conference on Acoustics, Speech and Signal Processing(ICASSP).Calgary, AB, Canada.IEEE, 2018: 4774-4778.

[12] MIAO Haoran, CHENG Gaofeng, GAO Changfeng, et al.Transformer-based online CTC/attention end-to-end speech recognition architecture[C]∥ICASSP 2020-2020 IEEE International Conference on Acoustics, Speech and Signal Processing(ICASSP).Barcelona, Spain.IEEE, 2020: 6084-6088.

[13] GULATI A,QIN J, CHIU Chungcheng, et al.Conformer: convolution-augmented transformer for speech recognition[C]∥Interspeech 2020.ISCA: ISCA, 2020: 5036-5040.

[14] ABLIMIT M, HAMDULLA A, KAWAHARA T.Morpheme concatenation approach in language modeling for large-vocabulary Uyghur speech recognition[C]∥2011 International Conference on Speech Database and Assessments(Oriental COCOSDA).Hsinchu, Taiwan, China.IEEE, 2011: 112-115.

[15] 努尔麦麦提·尤鲁瓦斯, 刘俊华, 吾守尔·斯拉木, 等.跨语言声学模型在维吾尔语语音识别中的应用[J].清华大学学报(自然科学版), 2018, 58(4): 342-346.

NURMEMET Yolwas, LIU Junhua, WUSHOUR Silamu, et al.Crosslingual acoustic modeling in Uyghur speech recognition[J].Journal of Tsinghua University(Science and Technology), 2018, 58(4): 342-346.(in Chinese)

[16] PROVILKOV I, EMELIANENKO D, VOITA E.BPE-dropout: Simple and effective subword regularization[C]∥Proceedings of the 58th Annual Meeting of the Association for Computational Linguistics.Online.Stroudsburg, PA, USA: Association for Computational Linguistics, 2020: 1882-1892.

[17] TOSHNIWAL S, TANG Hao, LU Liang, et al.Multitask learning with low-level auxiliary tasks for encoder-decoder based speech recognition[C]∥Interspeech 2017.ISCA: ISCA, 2017: 3532-3536.

[18] KIM Suyoun, HORI Takaaki, WATANABE Shinji, et al.Joint CTC-attention based end-to-end speech recognition using multi-task learning[C]∥2017 IEEE International Conference on Acoustics, Speech and Signal Processing(ICASSP).New Orleans,LA,USA.IEEE,2017:4835-4839.

[19] GRAVES A, FERN NDEZ S, GOMEZ F, et al.Connectionist temporal classification: Labelling unsegmented sequence data with recurrent neural networks[C]∥Proceedings of the 23rd international conference on Machine learning-ICML'06.Pittsburgh, Pennsylvania.New York: ACM Press, 2006: 369-376.

NDEZ S, GOMEZ F, et al.Connectionist temporal classification: Labelling unsegmented sequence data with recurrent neural networks[C]∥Proceedings of the 23rd international conference on Machine learning-ICML'06.Pittsburgh, Pennsylvania.New York: ACM Press, 2006: 369-376.

[20] 塔什甫拉提·尼扎木丁,梁瑞宇,谢跃, 等.采用原子表示模型的维吾尔语语音情感识别[J].信号处理,2020,36(1):9-17.

TASHPOLAT Nizamidin, LIANG Ruiyu, XIE Yue, et al.Atomic representation based emotion recognition from Uyghur speech[J].Journal of Signal Processing, 2020, 36(1): 9-17.(in Chinese)

[21] PROVILKOV I, EMELIANENKO D, VOITA E.BPE-Dropout: Simple and Effective Subword Regularization[C]∥Proceedings of the 58th Annual Meeting of the Association for Computational Linguistics, 2020.

[22] 艾斯卡尔·肉孜, 殷实, 张之勇, 等.THUYG-20: 免费的维吾尔语语音数据库[J].清华大学学报(自然科学版), 2017, 57(2): 182-187.

AISIKAER Rouzi, YIN Shi, ZHANG Zhiyong, et al.THUYG-20: A free Uyghur speech database[J].Journal of Tsinghua University(Science and Technology), 2017, 57(2): 182-187.(in Chinese)