1 引言

在人机交互系统中语音情感识别是其中一项关键技术,旨在识别用户情感,帮助机器更好的理解用户意图,提高多媒体通信的服务质量,提高用户体验。语言作为人类交流的工具,由于人类的情感只能在语音中某些特定的时刻出现,怎样从语音中提取这些重要信息对语音情感识别任务有重要意义。

很多情感语料库语音样本时间长度不同,例如典型的IEMOCAP情感语料库中,语音的持续时间是0~30 s,持续时间差距很大[1]。传统的静态模型通过计算全局信息来得到每个样本固定大小的特征向量。他们首先提取帧级的低级描述符(LLD),在LLD基础上做统计(如平均值、最大值等)得到句级特征,这种方法没有有效利用原始语音信号的时序信息,识别结果有待提高。而目前更为高效的深度学习方法,通常需要完整的帧级特征和固定的训练样本长度。Schuller B等人首先把超过3 s的语音样本分成长度相等的短样本[2]。提取谱图特征后,将不超过3 s的样本用零填充到3 s,在此基础上,将每个短样本赋予对应的整个样本的情感标签。虽然该方法可以降低神经网络结构的构建难度,但也会引入误差进而影响识别率。以上研究表明,把短样本赋予对应长样本的情感标签不是一个很好的处理方法。在对相对较长的非中性样本进行划分的过程中,由于只有部分样本包含明显的情感信息,使用切分后的短样本训练模型可能会导致模型错误分类中性和非中性情绪。此外,采用传统的零填充方法填充较短样本时,新填充的无效数据会干扰情绪识别模型的参数学习[3]。Huang J等人首先利用循环填充方法处理原始语音然后利用opensmile提取声学特征进行语音情感识别任务[4],受其启发,本文在log-Mel谱图中采用循环填充法代替常用的零填充方法处理可变长度的log-Mel谱图,该方法能够更好的学习时间动态信息,同时可以减少新填充的无效数据对情感模型参数学习的干扰。

情绪只会在某些特定的时刻出现在长时间的讲话中,捕捉与情绪相关的特征是困难和低效的。为了解决这一问题,Mirsamadi S等人提出了将注意机制应用于语音情感识别[5]。注意力机制是一种可以强调重要信息而忽略噪声或者无用信息的加权机制[6]。在基于循环神经网络(Recurrent Neural Network,RNN)和卷积神经网络(Convolutional Neural Networks,CNN)的(CRNN)模型中使用注意力机制是一个非常有效的方法,可以使模型对输入序列或图像的特定区域施加更大的权重[7]。为了解决有效的情感特征提取问题,本文基于以上研究在CRNN模型中引入高效通道注意(Efficient Channel Attention,ECA)模块[8]用于语音情感识别。在神经网络训练的过程当中,卷积层输出的特征对情感分类的重要程度不一样,相邻特征通道以及跨通道之间具有相关性,为了学习相邻通道以及跨通道之间的相关性,本文在CNN中引入高效通道注意(ECA)模块,根据特征通道之间的相关性对特征通道重要性进行打分重新调整特征通道的重要程度,提高特征的判别能力,使网络能够关注情感显著区域。

本文贡献如下:(1)本文采用循环填充方法代替零填充方法处理可变长度的log-Mel谱图,循环填充方法能够减少新填充的无效数据对模型参数学习的干扰。(2)本文在CRNN模型中引入高效通道注意(ECA)模块(CNN_ECA+BLSTM),该模型中的ECA能够关注与情感相关的特征,从而提升语音情感识别的性能。

2 基于ECA的CRNN模型

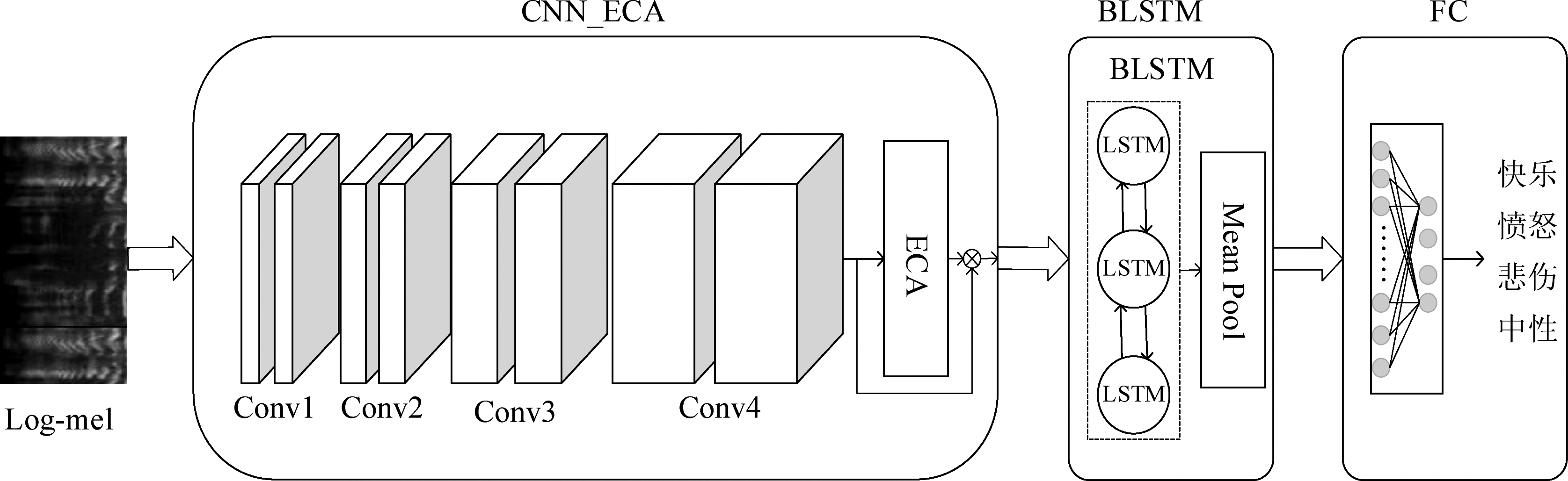

本文提出的基于ECA的CRNN模型,由具有高效通道注意力机制的卷积层(CNN_ECA)、BLSTM层、平均池化层(Mean pooling)与全连接层(Fully Connected Layer,FC)组成如图1所示。具体实现过程为:设置模型输入为利用循环填充法填充后的log-Mel谱图特征,log-Mel谱图首先通过Conv1~Conv4提取局部情感特征并对Conv4输出的情感特征进行通道方向的权重学习,标定权重语音情感特征,然后利用BLSTM模块从log-Mel谱图中提取序列信息,BLSTM层输出的帧级特征通过平均池化层聚合成句级特征,最后通过全连接层做出最终情感预测。

图1 基于ECA的CRNN模型

Fig.1 CRNN model based on ECA

2.1 变长语音信号循环填充处理方法

对于长度可变的样本,通常采取的方式是截取以及对样本进行零值填充。在人类交流中,我们不能假设每个对话中的情感信息是均匀分布的,因此对样本进行截断处理可能会导致关键信息的丢失。当对短样本以零值进行填充时新填充的零值数据可能会影响模型的参数学习。本文采用CNN处理变长语音,在该模型中,同一个批次的log-Mel谱图在训练阶段通过零填充方法填充到该批次时间方向最大长度,但是不同批次之间的填充长度是不同的。每个批次语音持续时间在0~30 s之间,零填充过长,会影响模型的参数学习。所以本文利用循环填充法处理来处理可变长度的log-Mel谱图,既可以减少填充的无效数据对模型参数学习的干扰,又能够更好的利用时间动态信息。具体算法如下:

(1)log-Mel谱图的最小时间长度设置为min,输入log-Mel谱图的时间长度为wavtime,通过max()函数计算出该批次最大时间长度记为max;

(2)若该批次最大时间长度max,大于等于log-Mel谱图最小时间长度min,则该批次最大时间长度为max,否则,max等于min;

(3)判断输入log-Mel谱图的时间长度wavtime,是否等于max,若为真,则返回时间长度为max的log-Mel谱图特征;

(4)若为假,用该批次最大时间长度max除以输入谱图时间长度wavtime得到待填充长度,利用repeat()函数进行循环填充;

(5)返回填充特征。

利用librosa[9]提取的log-Mel谱图如图2所示。

图2 log-Mel谱图对比图

Fig.2 A comparison of the log-Mel spectrograms

通过观察图2中原始log-Mel谱图(a)、传统零填充法的log-Mel谱图(b)和循环填充法的log-Mel谱图(c),可以看出原始log-Mel谱图长度为7.1 s,该批次样本最大时间长度为16 s,需要沿时间方向填充的长度为8.9 s。通过观察传统零填充法和循环填充法的log-Mel谱图发现:1)利用传统零填充法处理的log-Mel谱图,7.1 s后填充数据为“0”;2)从图2中的循环填充法的log-Mel谱图(c)可以看出采用本文提出方法处理的log-Mel谱图,从7.1 s后填充样本的值为原始log-Mel谱图,循复填充直到达到该批次语音样本最大时间长度16 s为止。

2.2 基于高效通道注意力的卷积网络(CNN_ECA)

2.2.1 卷积神经网络(CNN)

在语音情感识别任务中,通过CNN从语音片段中计算谱图特征目前成为了一个新的研究趋势[10]。AlexNet、Oxford VGGNet、ResNet等网络结构在传统图像处理与识别领域获得了良好的表现[11-12]。

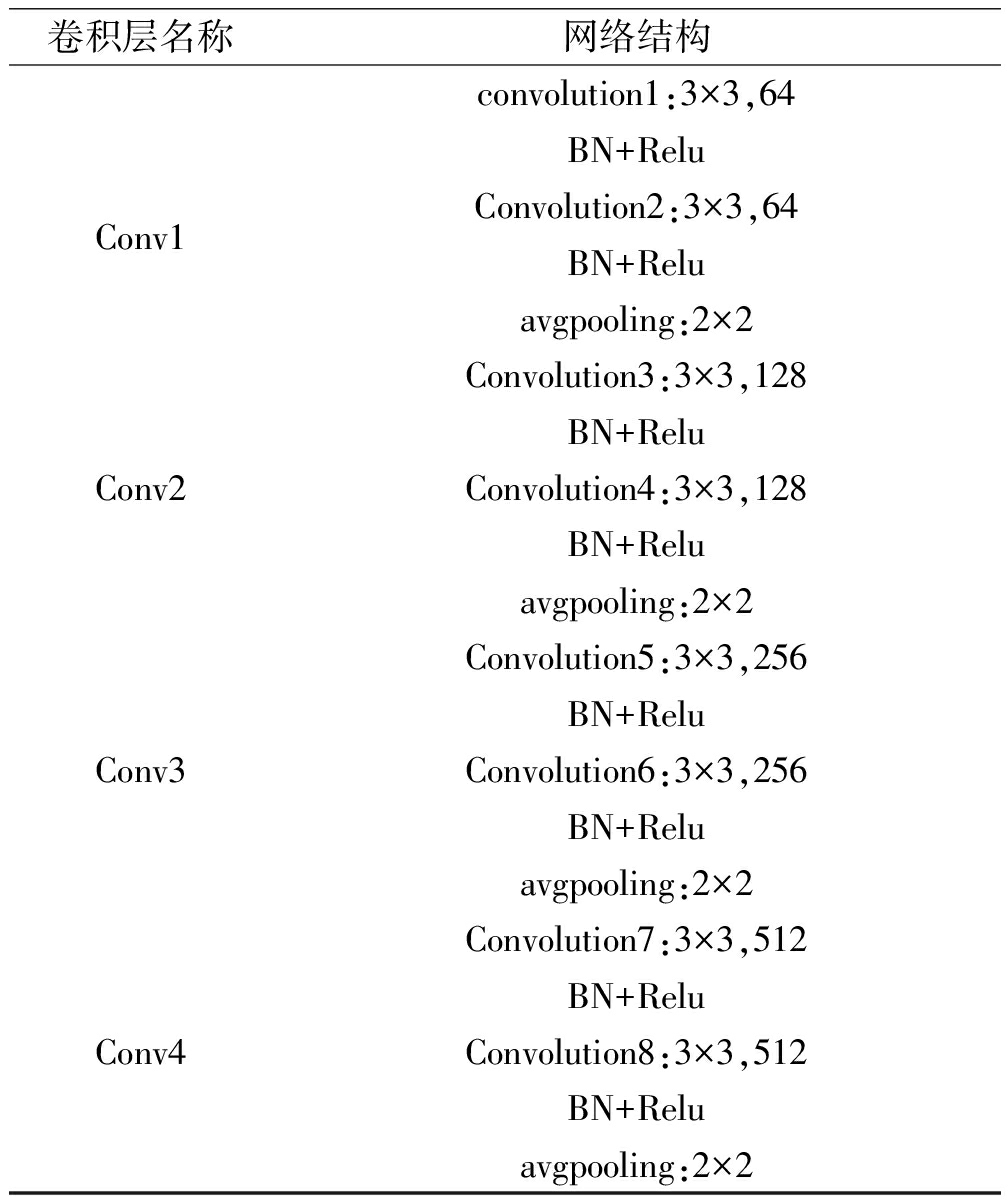

由于本文采用的语音情感数据库语音样本数目有限,直接使用VGGNet网络进行情感分类会造成训练不充分问题。本文对VGGNet网络进行了改善,使其网络结构更适合语音情感识别任务,CNN网络结构及具体参数如表1所示。

表1 CNN层网络结构参数

Tab.1 CNN layer network structure parameters

卷积层名称网络结构Conv1convolution1:3×3,64BN+ReluConvolution2:3×3,64BN+Reluavgpooling:2×2Conv2Convolution3:3×3,128BN+ReluConvolution4:3×3,128BN+Reluavgpooling:2×2Conv3Convolution5:3×3,256BN+ReluConvolution6:3×3,256BN+Reluavgpooling:2×2Conv4Convolution7:3×3,512BN+ReluConvolution8:3×3,512BN+Reluavgpooling:2×2

2.2.2 高效通道注意力机制(ECA)

在基于log-Mel谱图的语音情感识别中,经过CNN输出的特征图有三个维度F∈RC×H×W,通道(C)、频率(H)和时间维度(W),每个特征图对于语音情感的影响不同,作为特征映射的每个通道都被看做特征检测器,通道注意力机制旨在关注更有利于语音情感识别任务的特征通道。

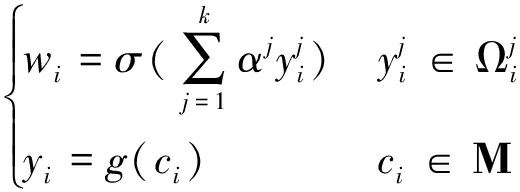

通道注意力机制设计如下,给定一个特征图F∈RC×H×W,通过全局平均池化操作对空间维度(H、W)的特征图F进行聚合,得到聚合特征D∈RC×1×1,然后通过一个卷积核大小为k的1D卷积进行学习,其中1D卷积的卷积核k,表示该区域跨通道交互的覆盖范围,该1D卷积能够权重共享,有利于减少模型参数量。高效通道注意(ECA)模块捕获局部的跨通道交互,意思是只计算每个特征通道与其k个相邻特征图之间的相互作用。依据该计算思路可以结合每个聚合特征yi与其k个相邻特征图计算出该通道的局部加权权重wi:

(1)

其中,Μ为需要进行加权的特征图通道集合,ci表示Μ中第i层特征图通道,g(·)为全局平均池化操作,yi表示ci经过全局平均池化后的聚合特征,![]() 表示yi的k个相邻特征通道的集合,

表示yi的k个相邻特征通道的集合,![]() 为第i个特征图通道临近的第j个通道的输出值,σ为Sigmoid激活函数。

为第i个特征图通道临近的第j个通道的输出值,σ为Sigmoid激活函数。

这种策略可以利用内核大小为k的快速一维卷积实现高效通道注意(ECA)模块的功能,通道注意力权重w计算公式如下所示:

w=σ(C1Dk(y))

(2)

其中C1D表示一维卷积,y为聚合特征。

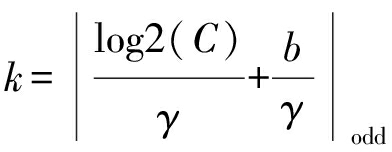

在ECA模块(等式(2))中,k是一个至关重要的参数。由于使用一维卷积来捕获局部的跨通道交互,k决定了交互的覆盖范围,不同的通道数和不同的CNN架构的卷积块可能不同。尽管k可以手动调参优化,但是它会耗费很多计算资源。k与通道维数C有关。一般认为,通道尺寸越长,长期交互作用越强,而通道尺寸越小,短期交互越强,即k和C之间存在一定的映射关系,其中k值可以通过C值自适应确定:

(3)

这里|t|odd离t最近的奇数。其中γ和b分别设置为2和1。

2.3 双向长短时记忆网络(BLSTM)

由于长短时记忆单元(Long Short-Term Memory,LSTM)可以解决RNN训练时的梯度消失或爆炸问题,因此将其作为RNN的基本单元[13]。本文使用双向长短时记忆(Bi-directional Long Short-Term Memory,BLSTM)网络,BLSTM由两个LSTM层组成,该网络主要利用两个方向相反的LSTM层来提取将来和过去的隐藏信息,这两部分的隐藏信息拼接成最后的输出,t时刻隐藏状态向量计算如下所示:

(4)

其中,![]() 是前向LSTM单元t时刻的隐藏状态向量,

是前向LSTM单元t时刻的隐藏状态向量,![]() 是后向LSTM单元t时刻隐藏状态向量,最终,将

是后向LSTM单元t时刻隐藏状态向量,最终,将![]() 拼接起来,得到BLSTM最后一层t时刻隐藏状态向量ht。

拼接起来,得到BLSTM最后一层t时刻隐藏状态向量ht。

3 实验验证

本文在已经完成基于ECA的CRNN模型搭建的基础上,为了验证所搭建模型的可行性与优化效果,将在交互式情绪二元运动捕捉(IEMOCAP)数据库上进行相关实验。

3.1 实验步骤

3.1.1 数据集

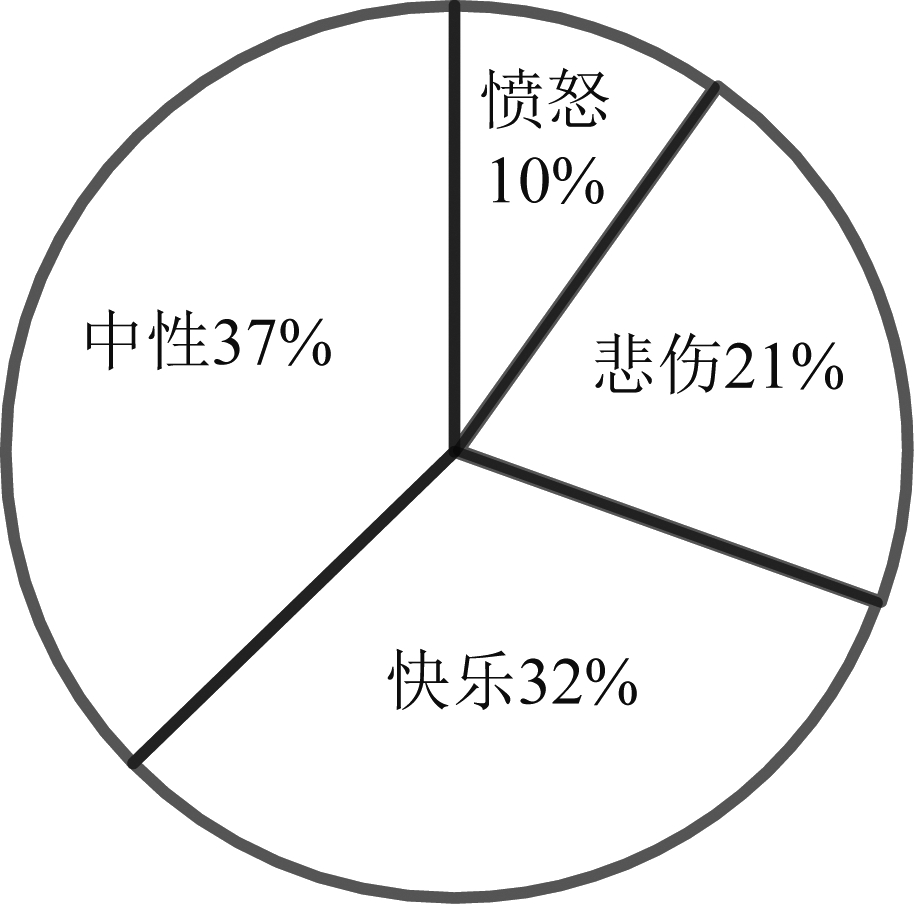

本文使用IEMOCAP数据库进行模型评估该数据库中的样本被分为9个情感类别[14]。根据前人工作,研究者普遍关注的是其中5种最有代表性的情感[15],所以本文只对该数据库中最有代表性的5种情感进行分类任务。因为该数据集存在类别不平衡现象,为避免这一现象对后续训练和测试造成的影响,本文在训练和测试过程中将兴奋类(Exicited)和快乐类(Happy)归为一类,形成{快乐,愤怒,悲伤,中性}为标签的四类数据库。IEMOCAP数据库包含脚本会话和即兴会话。由于脚本文本显示出与标记情绪的强烈相关性,这可能会导致语言内容的学习。因此本文只使用即兴会话数据。本文使用了2943条语音样本,语音样本中愤怒、悲伤、快乐、中性4种情感的分布情况如图3所示,IEMOCAP数据库被划分成10个子集,轮流将其中9个子集作为训练数据,1个子集作为测试数据,进行十折交叉验证,每次试验都会得到相应的分类准确率,最后对十次试验结果取平均获得最终的分类准确率,本文构建了一个不独立于说话人的语音情感识别系统。本文使用的评价指标是未加权精度(UA),加权精度(WA)来评价本文提出的方法,其中WA为测试集中所有样本的准确率,UA为全部情绪准确率的平均值。

图3 在IEMOCAP下四分类情感的分布饼图

Fig.3 Pie chart of four categories of emotions under IEMOCAP

3.1.2 数据预处理

实验采用log-Mel谱图作为输入,log-Mel谱图提取过程如下:将一系列重叠的汉明窗应用于语音波形,窗长设置为40 ms,帧移设置为10 ms,对于每帧语音信号,计算长度为2048的离散傅里叶变换(DFT)得到短时频谱,并对短时频谱取模的平方得到离散功率谱。将离散功率谱通过一个包含128个梅尔滤波器的梅尔滤波器组,从而可以计算出128个梅尔频谱。然后对梅尔频谱计算自然对数,即可算出log-Mel谱图。由于语音样本持续时间不相同,所以获得的log-Mel谱图的尺度也不同。

实验结果及分析由两个部分构成:第一部分,本文比较了传统零填充法和循环填充法用于训练神经网络的性能;第二部分,本文比较了不同模型的实验结果,验证了基于ECA的CRNN模型的有效性。

3.2 实验结果及分析

3.2.1 变长处理的影响

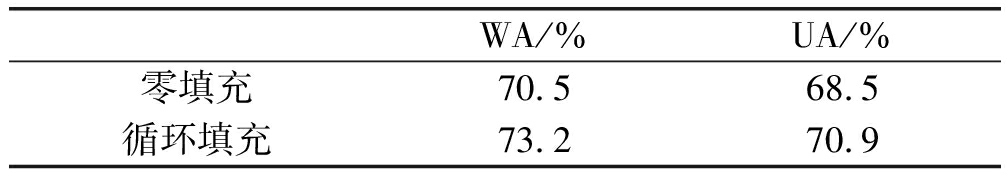

本文对比了两种log-Mel谱图填充方法:(1)传统零填充方法;(2)log-Mel谱图循环填充法。

为了确保性能的提高不来自于拓扑的改变,本节中利用2.2.1中所述的CNN结构对比了两种方法的性能。CNN层网络模型结构以及具体参数如表3所示。由于是可变长输入,CNN模型最后的输出时间维度是不固定的,全连接层的输入维度是固定的,为了输入全连接层,本文对CNN最后的输出进行两次池化操作,分别为沿着时间维度做均值池化操作和沿频率维度做最大池化,将特征压缩为512维的向量送入两层全连接层,最后输出分类结果。实验结果如表2所示。

表2 不同填充方法实验结果

Tab.2 Experimental results of different filling methods

WA/%UA/%零填充70.568.5循环填充73.270.9

从表中可以看出循环填充法的WA为73.2%比零填充方法高了2.7%,并且UA也达到了70.9%,相对于零填充方法,提高了2.4%。从结果中可以看出循环填充的性能优于零填充方法,循环填充会产生更长的情感过程。

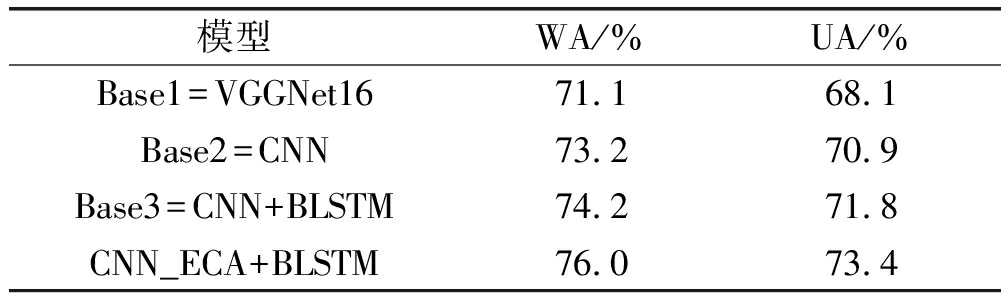

3.2.2 模型性能评估

为了更好的评估 CNN_ECA+BLSTM模型的有效性,本文创建了由整个模型不同部分组成的基线模型。在该系统中迭代次数为30次,批尺寸设置为4,Adam算法作为网络的优化器,学习率为1.00E-04,以交叉熵作为目标函数进行训练。具体实验如下:

(1)Base1(VGGNet16):本文以VGGNet16作为基线。

(2)Base2(CNN):本实验的目的是对比Base1,验证本文提出的CNN网络结构的有效性,具体结构如表1所示。

(3)Base3(CNN+BLSTM):本实验中CNN结构与Base2相同,BLSTM的最佳结构是一层,每层包含128×2个隐藏节点,输出的帧级特征通过均值池化操作汇聚成句级特征。

(4)Base4(CNN_SENet+BLSTM):本实验的目的是对比不同注意力机制的实验效果。本实验在Base3中引入单通道注意力机制中的挤压和激励模块(Squeeze-and-excitation networks,SENet)[16]。

(5)Base5(CNN_CBAM+BLSTM):本实验的目的是对比不同注意力机制的实验效果。本实验在Base3中引入双通道注意力机制中的卷积块注意模块(Convolutional Block Attention Module,CBAM)[17]。

(6)CNN_ECA+BLSTM:本实验的目的是对比Base3、Base4、Base5评估本文所提出的网络模型结构及其相关参数设置的可行性。相关参数设置与Base3相同。

实验结果如表3所示。本文以VGGNet16为基线系统,对比Base1和Base2实验结果可知,Base2的WA为73.2%,比Base1提高了2.1%,Base2的UA为70.9%,比Base1提高了2.8%。如Zhang Y等人所述由于训练数据有限,VGGNet16的在语音情感识别中的表现不好[18]。通过实验结果可知本文改进的CNN结构在情感识别方面的表现优于VGGNet16。观察CNN_ECA+BLSTM的实验结果可知,本文提出的CNN_ECA+BLSTM的准确率最高,WA和UA分别为76.0%和73.4%,由此可以证明高效通道注意力机制(ECA)在语音情感识别任务中的有效性。

表3 不同模型的实验结果

Tab.3 Experimental results of different models

模型WA/%UA/%Base1=VGGNet1671.168.1Base2=CNN73.270.9Base3=CNN+BLSTM74.271.8CNN_ECA+BLSTM76.073.4

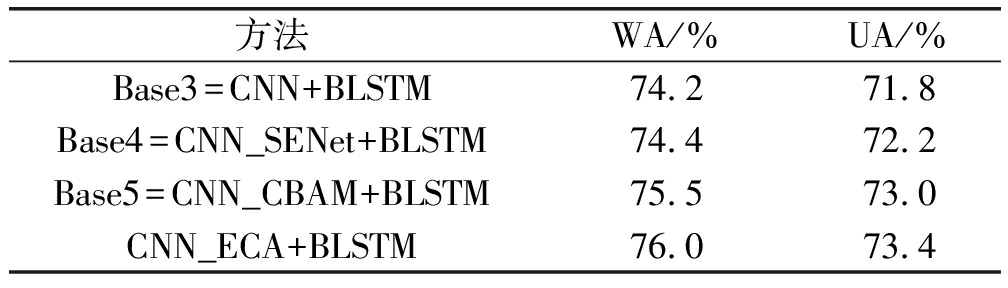

实验结果如表4所示。对比Base3和Base4实验结果可知,在CNN+BLSTM中引入通道注意力机制有利于提高语音情感识别准确率,对比Base4、Base5和CNN_ECA+BLSTM实验结果可知,双通道注意力机制的CBAM模块的语音情感识别率比单通道注意力机制的SENet模块的识别率高,本文引用的高效通道注意力机制ECA情感分类效果最好。

表4 不同注意力机制对比

Tab.4 Comparison of different attention mechanisms

方法WA/%UA/%Base3=CNN+BLSTM74.271.8Base4=CNN_SENet+BLSTM74.472.2Base5=CNN_CBAM+BLSTM75.573.0CNN_ECA+BLSTM76.073.4

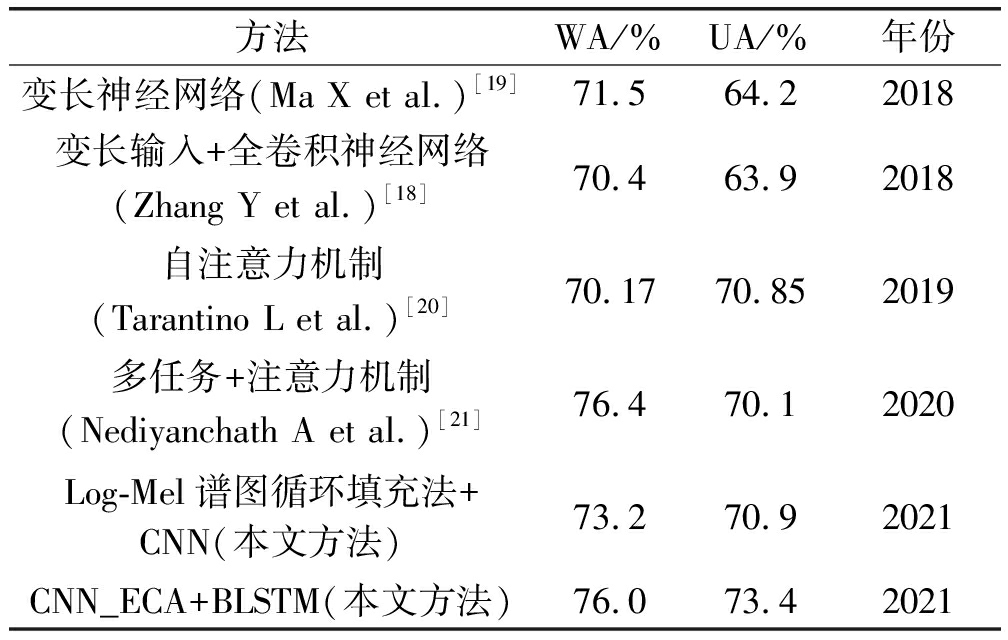

如表5所示,将本文的准确性与近几年发表的其他语音情感识别结果进行比较,这些结果使用与本文的实验相同的数据集和评估指标。

表5 与现有SER结果准确性比较

Tab.5 Comparison of the accuracy with the existing SER results

方法WA/%UA/%年份变长神经网络(Ma X et al.)[19]71.564.22018变长输入+全卷积神经网络(Zhang Y et al.)[18]70.463.92018自注意力机制(Tarantino L et al.)[20]70.1770.852019多任务+注意力机制(Nediyanchath A et al.)[21]76.470.12020Log-Mel谱图循环填充法+CNN(本文方法)73.270.92021CNN_ECA+BLSTM(本文方法)76.073.42021

实验结果表明,log-Mel谱图循环填充法比普通的变长处理方法表现的更好。log-Mel谱图循环填充法与现有的变长处理方法结果[16]相比,WA提高了1.7%,UA提高了6.7%。与多任务+注意力机制模型[18]相比,本文提出的CNN_ECA+BLSTM模型虽然WA没有提高,但是UA提高了3.3%。

为了进一步在IEMOCAP数据库上对实验结果进行对比分析,图4给出CNN(a)、CNN+BLSTM(b)、CNN_ECA+BLSTM(c)的混淆矩阵,如3.1.1所述,由于愤怒类是数据集中数量最少的情绪,模型对该类训练不充分,所以愤怒类的准确率较低。观察图中(b)和(c)的实验结果可知,当CNN+BLSTM添加ECA后,我们发现快乐类和伤心类的准确率有所提升,中性类有所下降。观察(a)和(b)可以发现与大多数实验结果相同快乐类与中性类易混淆,而CNN_ECA+BLSTM模型能够减少快乐类和中性类的误分率。这可以归因于该模型在识别辨别情绪特征方面的能力有所提升。因此,模型准确率有一个显著的改进。愤怒的准确率没有改变,中性的准确率略微下降,这可以归因于该模型具有更好的泛化能力。

图4 在IEMOCAP下四分类情感的混淆矩阵

Fig.4 The confusion matrix of four categorical emotions under IEMOCAP

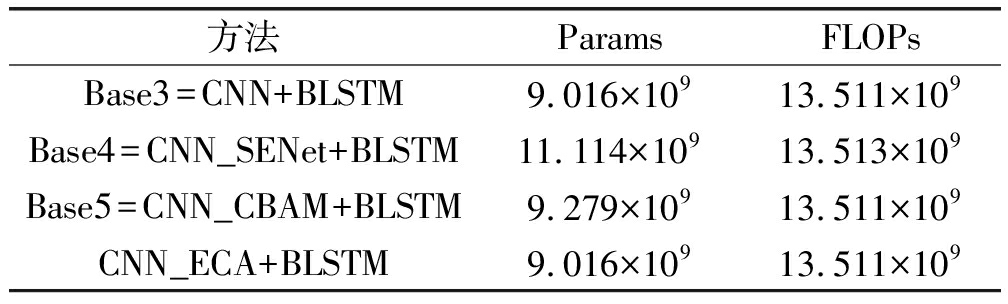

3.2.3 模型复杂度对比

为了进一步验证本文提出的CNN_ECA+BLSTM模型在语音情感识别方面的优势,本文在IEMOCAP数据库上进行了参数量(Params)和计算复杂度(FLOPs)对比实验。

如表6所示,在CNN+BLSTM中引入SENet模块其网络参数量最多,计算复杂度最大,并且其准确率最低。在CNN+BLSTM中引入高效通道注意力机制(ECA)不仅可以提高语音情感识别分类准确率,而且其网络参数量和计算复杂度变化微乎其微。

表6 网络复杂度对比实验结果

Tab.6 Network complexity comparison experimental results

方法ParamsFLOPsBase3=CNN+BLSTM9.016×10913.511×109Base4=CNN_SENet+BLSTM11.114×10913.513×109Base5=CNN_CBAM+BLSTM9.279×10913.511×109CNN_ECA+BLSTM9.016×10913.511×109

4 结论

本文针对可变长度的输入,我们引入循环填充法处理可长度的log-Mel谱图来生成更长的情绪过程。该方法能够更好的利用时序动态信息,有利于性能的提高。由于IEMOCAP语音样本较少,网络参数过多容易造成训练不充分的问题,本文基于VGGNet16设计了一个较浅的卷积网络结构用于语音情感识别,在此基础上,本文训练了一个CNN_ECA+BLSTM模型来完成语音情感识别任务。我们发现ECA模块能够关注log-Mel谱图的情感显著区域,有利于提升语音情感识别的性能。

[1] TAO Jianhua, HUANG Jian, LI Ya, et al.Semi-supervised ladder networks for speech emotion recognition[J].International Journal of Automation and Computing, 2019, 16(4): 437-448.

[2] SCHULLER B, BATLINER A, STEIDL S, et al.Recognising realistic emotions and affect in speech: State of the art and lessons learnt from the first challenge[J].Speech Communication, 2011, 53(9-10): 1062-1087.

[3] FAYEK H M, LECH M, CAVEDON L.Evaluating deep learning architectures for speech emotion recognition[J].Neural Networks, 2017, 92(2017): 60-68.

[4] HUANG Jian, LI Ya, TAO Jianhua, et al.Speech emotion recognition from variable-length inputs with triplet loss function[C]∥Interspeech.Hyderabad,India:ISCA, 2018: 3673-3677.

[5] MIRSAMADI S, BARSOUM E, ZHANG C.Automatic speech emotion recognition using recurrent neural networks with local attention[C]∥2017 IEEE International Conference on Acoustics, Speech and Signal Processing(ICASSP).New Orleans, USA: IEEE, 2017: 2227-2231.

[6] VASWANI A, SHAZEER N, PARMAR N, et al.Attention is all you need[C]∥Advances in Neural Information Processing Systems, 2017: 5998-6008.

[7] GORROSTIETA C, BRUTTI R, TAYLOR K, et al.Attention-based sequence classification for affect detection[C]∥Interspeech.Hyderabad, India: ISCA, 2018: 506-510.

[8] WANG Qilong, WU Banggu, ZHU Pengfei, et al.ECA-Net: efficient channel attention for deep convolutional neural networks[C]∥2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition(CVPR).Seattle, USA: IEEE, 2020: 11531-11539.

[9] MCFEE B, RAFFEL C, LIANG D, et al.Librosa: audio and music signal analysis in python[C]∥Proceedings of the 14th Python in Science Conference, 2015, 8: 18-25.

[10] CUMMINS N, AMIRIPARIAN S, HAGERER G, et al.An image-based deep spectrum feature representation for the recognition of emotional speech[C]∥Proceedings of the 25th ACM International Conference on Multimedia.2017: 478-484.

[11] KRIZHEVSKY A, SUTSKEVER I, HINTON G E.Imagenet classification with deep convolutional neural networks[J].Advances in Neural Information Processing Systems, 2012, 25(2012): 1097-1105.

[12] HE Kaiming, ZHANG Xiangyu, REN Shaoqing, et al.Deep residual learning for image recognition[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition.Las Vegas, USA: IEEE, 2016: 770-778.

[13] 冯天艺, 杨震.采用多任务学习和循环神经网络的语音情感识别算法[J].信号处理, 2019, 35(7): 1133-1140.

FENG Tianyi, YANG Zhen.Speech emotion recognition algorithm based on multi task learning and recurrent neural network[J].Journal of Signal Processing, 2019, 35(7): 1133-1140.(in Chinese)

[14] BUSSO C, BULUT M, LEE C C, et al.IEMOCAP: interactive emotional dyadic motion capture database[J].Language Resources and Evaluation, 2008, 42(4): 335-359.

[15] LI Pengcheng, SONG Yan, MCLOUGHLIN I V, et al.An attention pooling based representation learning method for speech emotion recognition[C]∥Interspeech.Hyderabad, India: ISCA, 2018:3087-3091.

[16] HU Jie, SHEN Li, SUN Gang.Squeeze-and-excitation networks[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition.Salt Lake City, UT, USA.IEEE, 2018: 7132-7141.

[17] WOO S, PARK J, LEE J Y, et al.CBAM: convolutional block attention module[M]∥Computer Vision-ECCV 2018.Cham: Springer International Publishing, 2018: 3-19.

[18] ZHANG Yuanyuan, DU Jun, WANG Zirui, et al.Attention based fully convolutional network for speech emotion recognition[C]∥2018 Asia-Pacific Signal and Information Processing Association Annual Summit and Conference(APSIPA ASC).Honolulu, USA: IEEE, 2018: 1771-1775.

[19] MA Xi, WU Zhiyong, JIA Jia, et al.Emotion recognition from variable-length speech segments using deep learning on spectrograms[C]∥Interspeech.Hyderabad, India: ISCA, 2018: 3683-3687.

[20] TARANTINO L,GARNER P N,LAZARIDIS A.Self-attention for speech emotion recognition[C]∥Interspeech.Graz, Austria: ISCA, 2019: 2578-2582.

[21] NEDIYANCHATH A, PARAMASIVAM P, YENIGALLA P.Multi-head attention for speech emotion recognition with auxiliary learning of gender recognition[C]∥2020 IEEE International Conference on Acoustics, Speech and Signal Processing(ICASSP).Barcelona, Spain: IEEE, 2020: 7179-7183.