1 引言

语音转换也称为说话人语音转换,是一种改变语音说话人身份的技术。它可以在保持语义内容不变的前提下,将语音中的非语义信息进行转换,将源说话人的音色转换为目标说话人[1]。语音转换技术在很多实用场景下已经得到广泛应用,例如:个性化语音合成[2]、歌声转换[3]、语音风格转换[4-6]等。

传统的语音转换方法主要包括以下步骤:(1)语音特征提取;(2)源说话人与目标说话人特征映射;(3)目标说话人语音生成。首先,语音特征提取主要提取出语音信号中的频谱和基频(F0)等参数。其次,特征映射是语音转换研究中的重点。传统的特征映射方法主要包括高斯混合模型[7]、样例方法[8]、频率弯折法[9]、深度神经网络[10]等。这些方法可以成功的将源说话人的语音转换为目标说话人,在英语、汉语等主流语种中表现出优秀的性能。最后,目标说话人语音生成主要使用语音信号重构算法将转换后的语音参数恢复为目标说话人的语音波形。但是,以上方法在模型训练过程中都需要将源说话人语音参数和目标说话人语音参数进行帧级对齐,这就要求研究人员在语音转换数据准备过程中构建高质量的平行语料库。但蒙古语是一种低资源语言,并不存在适合语音转换的平行语料库,而要想建立高质量的平行语料库费时费力,并不现实。因此,把蒙古语语音转换研究的重点放在非平行语料条件下。

非平行语料的获取相比平行语料相对容易,另外随着深度学习技术的发展,基于非平行语料的语音转换方法受到越来越多研究人员的关注。最近的研究工作提出了基于生成对抗网络的非平行语音转换方法,如端到端方法[11]、CycleGAN[12-14]、StarGAN[15-16]等。其中,基于CycleGAN(Cycle-Consistent Adversarial Networks)的语音转换方法通过对抗损失和循环一致性损失学习源语音和目标语音中的频谱特征映射关系,能够在有限的非平行语料条件下得到较好的转换效果。以上方法可以在非平行语料下实现语音转换,摆脱了语音转换中帧级别数据对齐的限制。但是,对于韵律特征的建模,这些方法都只是对不同说话人的基频(F0)参数进行简单的线性变换。语音信号的基频特征直接关系到语音的音调,是反映语音韵律信息的一个重要指标[17]。不同的说话人有各自的韵律风格,不同的说话人的基频特征也有着极大的差异,仅对基频做简单的线性变换显然无法完成精细的韵律风格转换。因此,如何在语音转换过程中对韵律特征进行精细化、细粒度的建模是一个亟需解决的问题。这一问题在蒙古语语音转换问题研究中更为突出,因为蒙古语属于阿尔泰语系,是一种黏着语[18],在蒙古语词句发音时严格遵循元音和谐律、辅音结合律[19]等特点,不同的元音字母组合和辅音字母组合会产生比汉语、英语等语种更加多变的韵律表现。连续小波变换(Continuous Wavelet Transform,CWT)可以将一个语音基频信号分解为更加精细的多级特征表示[20],并且广泛应用到情感语音转换[21]等工作,这为解决细粒度韵律建模问题提供了思路。

综上所述,以下两个问题给蒙古语语音转换研究带来很大挑战:(1)高质量的蒙古语语音转换平行语料难以获取;(2)蒙古语韵律变化丰富,传统的语音转换方法难以建模细粒度韵律特征。为了解决以上问题,本文提出基于细粒度韵律建模和条件CycleGAN的非平行蒙古语语音转换方法(Fine Grained Conditional CycleGAN,FG-CCycleGAN)。具体来说,本文首先使用连续小波变换对源说话人和目标说话人语音的基频参数进行处理得到多尺度、细粒度的基频参数。然后,为了保证非平行语料下不同说话人之间稳定的韵律转换效果,在传统CycleGAN模型[12]中加入了源说话人和目标说话人的说话人向量来构建条件CycleGAN网络[22]。最后,使用条件CycleGAN来学习非平行语料中多尺度基频参数的映射关系。这样的多尺度基频特征表示具有更加精细的韵律表达能力,从而可以实现韵律的细粒度建模。对于频谱参数的映射关系,直接使用带有说话人向量的条件CycleGAN进行学习。模型训练结束后,在转换阶段,可以将转换后的多尺度、细粒度基频参数与频谱参数重建为最终的具有丰富韵律表现的目标说话人语音。此外,对大规模蒙古语语音合成语料库中的语料进行筛选,建立了非平行蒙古语语音转换语料库。

本文结构组织如下:第2节介绍传统CycleGAN语音转换模型和连续小波变换等相关工作;第3节对本文提出的基于细粒度韵律建模和条件CycleGAN的非平行蒙古语语音转换方法进行详细介绍;第4节介绍语料库、实验设置和实验结果;最后在第5节总结全文。

2 相关工作

2.1 CycleGAN语音转换模型

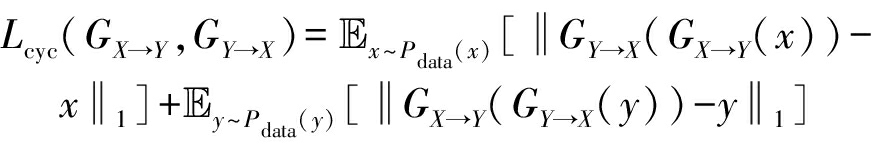

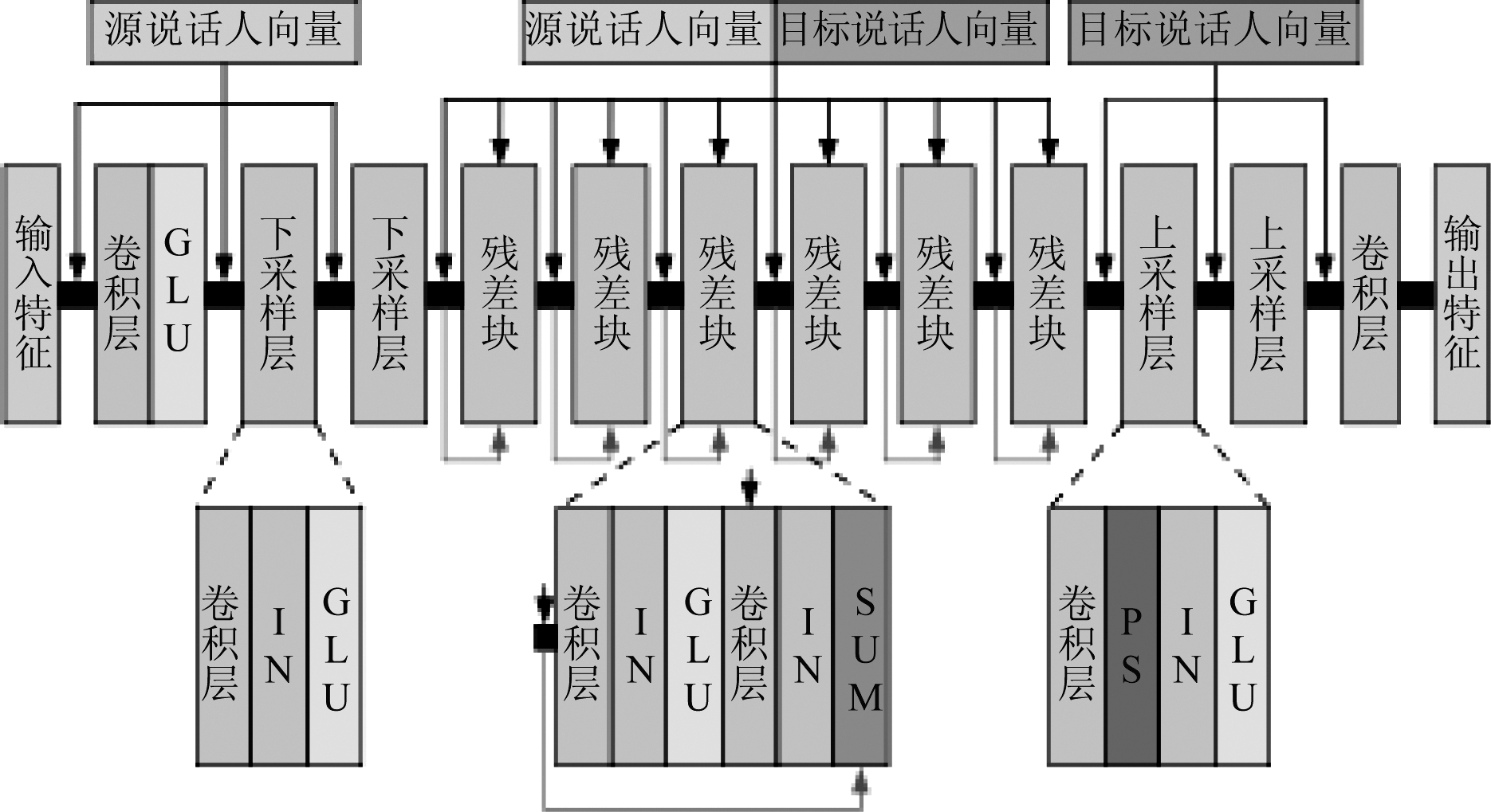

生成对抗网络(Generative Adversarial Network,GAN)是深度学习领域的一种生成模型[23],它通过生成器与判别器的对抗学习,来让生成器生成与真实样本类似的数据。CycleGAN作为GAN网络的一种变体,能够很好的解决两个不同域之间不成对数据的匹配问题。它可以在非平行语料条件下,通过对抗损失、循环一致性损失、身份映射损失来学习源说话人和目标说话人语音特征之间的映射,损失函数[12]分别如公式(1)、公式(2)、公式(3)所示。分别定义X和Y代表两个说话人,x∈X和y∈Y分别代表不同说话人的频谱特征。在训练过程中,对抗损失令生成器生成的频谱特征与目标说话人的频谱特征分布更接近,循环一致性损失得到源说话人和目标说话人频谱特征中相似结构的映射,身份映射损失确保语义信息在转换前后不发生改变。

(1)

(2)

(3)

综上所述,基于CycleGAN的语音转换的总损失函数如公式(4)所示:

Lfull=Ladv(GX→Y,DY)+Ladv(GY→X,DX)+

λcycLcyc(GX→Y,GY→X)+λidLid(GX→Y,GY→X)

(4)

其中,λcyc和λid为可变参数。

2.2 连续小波变换

连续小波变换作为一种常用的信号分析方法,在语音转换[24]、语音合成[25]等任务中应用广泛。它根据小波函数中不同的尺度和平移量进行运算,能够得到不同尺度上的信号表示。基频特征作为语音信号的重要参数,不仅与语音的音调相关,同时还反应了语音的韵律特征。使用连续小波变换的方法可以将基频特征映射到不同尺度上,从而得到不同尺度上的基频特征表示。通过这种方法,可以从基频序列中提取到粒度更加精细的韵律特征[20]。不同的尺度代表不同粒度、不同层级的韵律信息[25]。在较低尺度上能捕获短期韵律变化,在较高尺度上能捕获与语音长度相关的长期韵律变换[26]。

3 基于细粒度韵律建模和条件CycleGAN的非平行蒙古语语音转换方法

本文提出的基于细粒度韵律建模和条件CycleGAN的非平行蒙古语语音转换方法包含三个主要工作:(1)细粒度韵律特征表示;(2)条件CycleGAN的建立;(3)基于细粒度韵律建模和条件CycleGAN的非平行蒙古语语音转换方法的实现。细粒度韵律特征表示采用连续小波变换技术将基频特征分解为多尺度特征表示,从而刻画更加精细的韵律特征;条件CycleGAN以源说话人和目标说话人的说话人向量为条件输入,确保了不同说话人之间稳定的韵律转换;最后,FG-CCycleGAN对非平行数据的频谱参数和细粒度韵律参数映射关系进行学习,并在测试阶段将源说话人语音成功转换为目标说话人。

3.1 细粒度韵律特征表示

为了更加精细的刻画蒙古语的韵律变化,使用连续小波变换的方法对基频特征进行处理,从而得到细粒度的蒙古语韵律特征。但在蒙古语清音发音的过程中,气流从喉头流过时,声带并不振动[19],此时并不存在基频,则实际语音的基频序列可能并不连续。因此,在提取细粒度韵律特征前要对基频序列进行预处理。首先对于基频序列中为0的区域进行线性插值,之后对基频取对数,最后对整个序列中的数值进行归一化处理[26]。对于经预处理后的连续基频特征序列f0进行连续小波变换,连续小波变换的结果表示为W(f0)(τ,t),如公式(5)所示:

(5)

其中ψ为墨西哥帽母小波,τ和t分别为尺度和平移量。将基频特征映射到10个不同的尺度上,得到多尺度基频特征,即蒙古语语音中细粒度韵律特征表示,如公式(6)所示:

(6)

在韵律转换后,需要将多尺度基频特征转换为一维基频特征进行目标语音的合成。得到小波变换表示的基频特征序列W(f0)如公式(7)所示:

(7)

公式(6)和公式(7)中i=1,…,10,τ=0.5 ms,这些参数来自于文献[25]。最后对其进行逆小波变换从小波表示的W(f0)中恢复基频特征f0,如公式(8)所示:

(8)

通过将语音中的基频特征进行连续小波变换,能够得到不同尺度下的韵律特征,从而对蒙古语语音进行细粒度的韵律建模。

3.2 条件CycleGAN

在条件CycleGAN中,将源说话人和目标说话人使用说话人向量进行表示,用不同说话人的说话人向量引导CycleGAN进行目标语音的合成[22]。

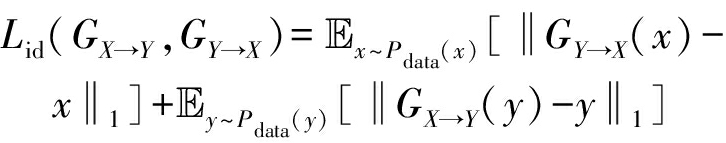

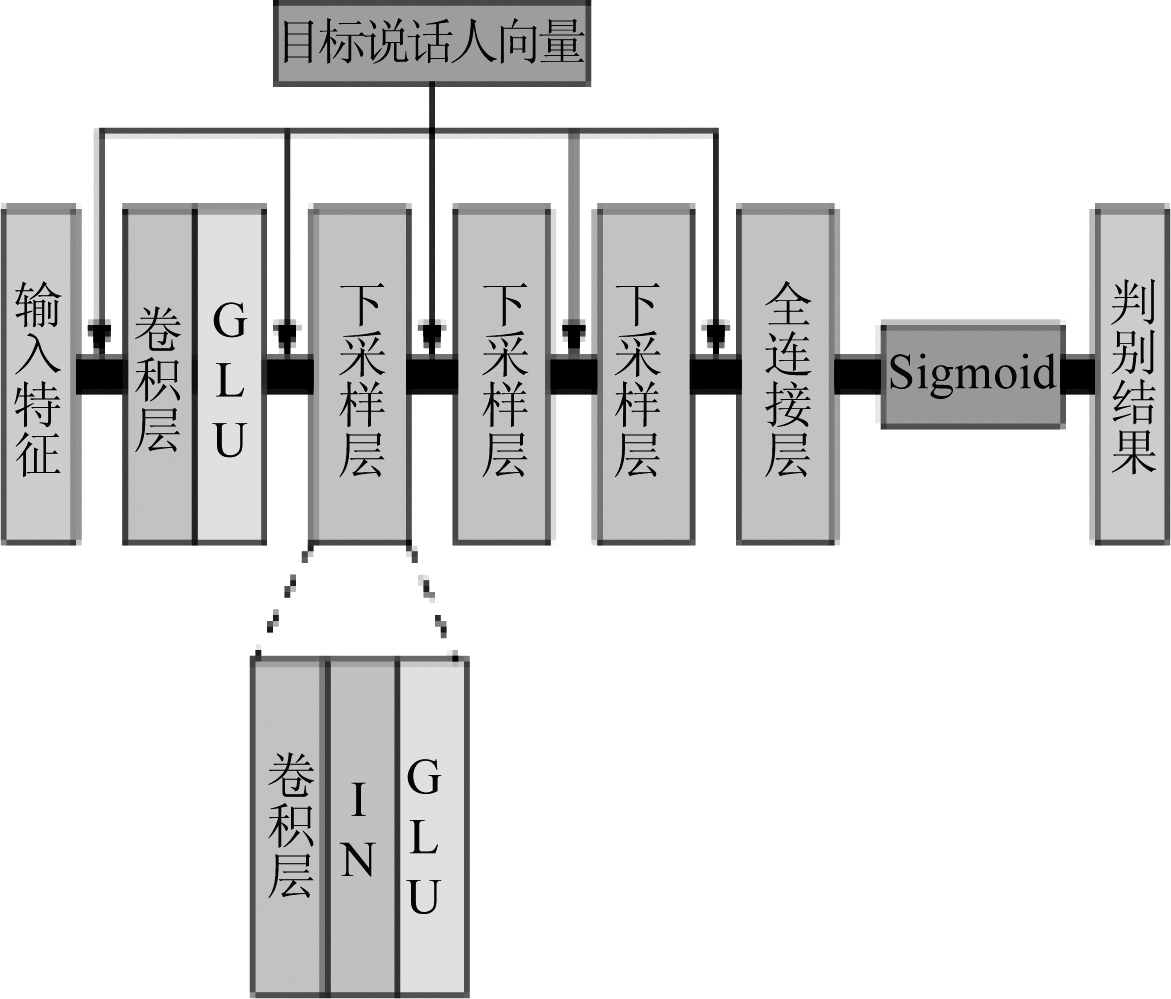

条件CycleGAN的生成器、鉴别器的网络架构分别如图1、图2所示。与文献[12]中的结构类似,生成器由前卷积层、两个下采样层、六个残差块、两个上采样层和后卷积层组成,主要进行一维卷积运算。其中,使用线性门控单元(Gate Linear Units,GLU)作为激活函数[27],它通过堆叠卷积层读取序列数据,降低了序列读取的运算量,同时结合了与LSTM类似的门控思想,来提取更具代表性的特征。在输入特征经过前卷积层和下采样层前,源说话人向量通过全连接层扩展到与当前层相同的尺寸,与上层的输出进行求和后输入到下一层。在训练数据输入到每个残差块前,将源说话人向量与目标说话人向量拼接组合成一个更高维的联合说话人向量,将联合说话人向量经过全连接层扩展到当前层相同的尺寸,将前一层的输入与联合说话人向量求和后的结果作为后一层的输入。在训练数据经过上采样层和后卷积层前,将目标说话人向量与前一层的输出以相同的方式进行求和,最后得到生成器生成的输出特征。判别器由卷积层、三个下采样层和一个全连接层构成,主要进行二维卷积运算。输入特征数据依次经过网络,最终输出判别结果。在训练数据经过每层之前,将目标说话人向量进行扩展后与前一层的输出进行求和,作为下一层的输入。

图1 条件CycleGAN生成器网络架构

Fig.1 Network architecture of Conditional CycleGAN generator

图2 条件CycleGAN判别器网络架构

Fig.2 Network architecture of Conditional CycleGAN discriminator

在网络中,说话人向量以二维独热向量的形式表示,其中元素1在不同维度分别表示为不同说话人向量。在训练过程中,将源说话人向量和目标说话人向量作为条件,将它们输入到相应的网络层中,以此来对源说话人到目标说话人的转换进行约束。

因此,条件CycleGAN的对抗损失如公式(9)所示:

(9)

其中,vx为源说话人向量,vy为目标说话人向量,DY(y,vy)表示在目标说话人向量vy条件下对特征数据y进行判别,![]() 表示在源说话人向量vx和目标说话人向量vy条件下输入特征数据x的生成结果。

表示在源说话人向量vx和目标说话人向量vy条件下输入特征数据x的生成结果。

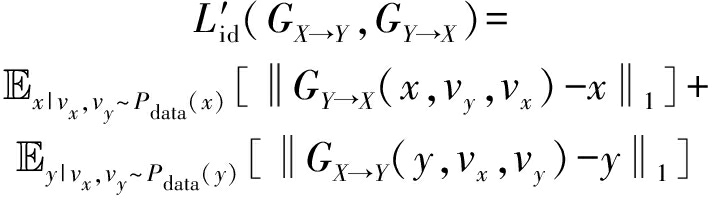

条件CycleGAN网络的循环一致性损失如公式(10)所示:

![]()

![]()

(10)

条件CycleGAN网络的身份映射损失如公式(11)所示:

(11)

综上所述,条件CycleGAN的总损失函数如公式(12)所示:

(12)

其中,λcyc和λid为可变参数。

为了确保源说话人和目标说话人的频谱特征和韵律特征能够进行稳定转换,使用说话人向量对不同说话人进行表示,并且将其作为条件经全连接层进行扩展后输入到CycleGAN网络的相应层中。

3.3 基于细粒度韵律建模和条件CycleGAN的非平行蒙古语语音转换方法的实现

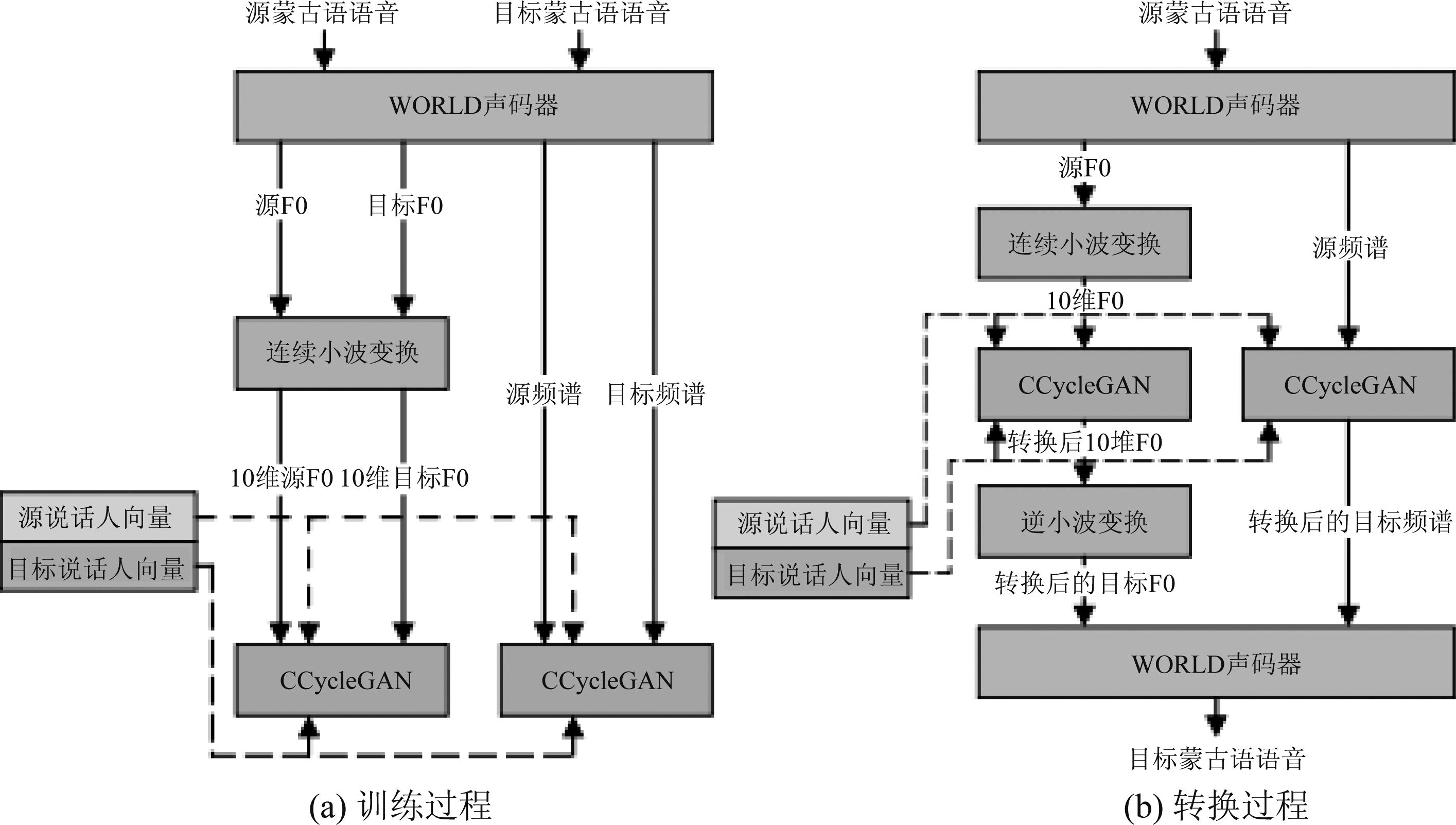

针对蒙古语韵律变化丰富的语音特性,提出一种基于细粒度韵律建模和条件CycleGAN的非平行蒙古语语音转换方法。如图3所示,为FG-CCycleGAN的训练过程与转换过程。

如图3(a)所示,为FG-CCycleGAN的训练过程。使用WORLD声码器分别提取源蒙古语语音和目标蒙古语语音的基频特征和频谱特征。对于韵律转换,将源说话人和目标说话的基频特征进行连续小波变换后得到10维源基频特征和10维目标基频特征,它们用来表示不同说话人的细粒度韵律特征。之后将两个说话人的10维度基频特征输入到条件CycleGAN中进行训练,学习源说话人和目标说话人在细粒度韵律特征上的映射。对于频谱转换,将源说话人和目标说话人的频谱特征直接输入另一个条件CycleGAN中进行训练,学习不同说话人在频谱特征上的映射。在训练的过程中,将源说话人向量和目标说话人向量作为条件,对两个条件CycleGAN网络的训练过程进行监督。

如图3(b)所示,为FG-CCycleGAN的转换过程。使用WORLD声码器提取源蒙古语语音的基频特征和频谱特征。对于基频特征,进行连续小波变换后得到10维基频特征,之后将其输入到韵律转换条件CycleGAN中进行转换。经转换后得到10维基频特征即目标说话人的细粒度韵律特征表示,将其经过逆小波变换得到转换后的基频特征。对于频谱特征,直接将源说话人的频谱特征输入到韵律转换条件CycleGAN中,得到转换后的频谱特征。使用WORLD声码器,将转换后的基频特征和频谱特征进行音频重建,得到经FG-CCycleGAN模型转换后的目标蒙古语语音。在转换过程中,同样使用源说话人向量和目标说话人向量,作为条件确保两个条件CycleGAN分别进行韵律特征和频谱特征的稳定转换。

图3 FG-CCycleGAN的训练过程与转换过程

Fig.3 The training phase and conversion phase of FG-CCycleGAN

4 实验

4.1 语料库

为了验证提出的方法,在大规模蒙古语语音合成语料库的基础上进行筛选,建立了非平行蒙古语语音转换语料库。

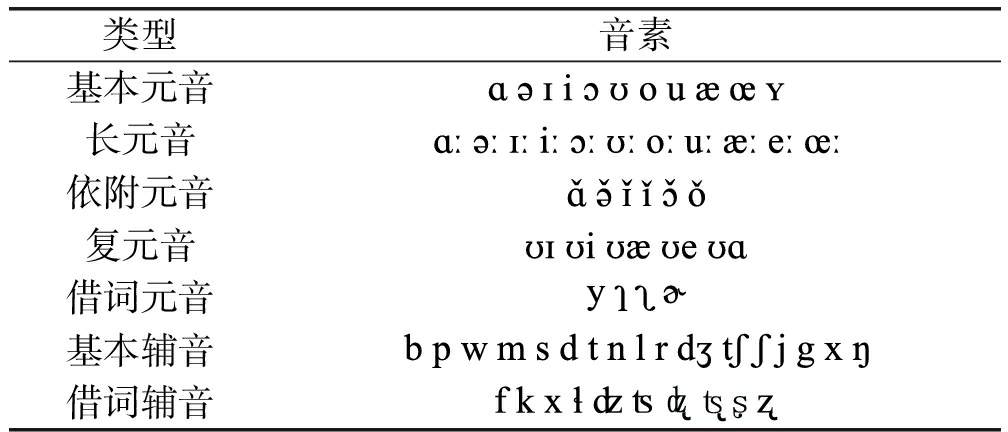

大规模蒙古语语音合成语料库中的语料由四名专业蒙古语母语播音员在标准录音室以16 kHz的采样频率进行录制,其中包括两名男性播音员和两名女性播音员的声音,每名播音员录制的语料总长度在10到25个小时不等,语料库中语料总时长为60小时左右。录制的文本内容大多为蒙古语文课本中的课文、蒙古语新闻稿以及蒙古族童话故事等。在录制前对文本内容进行分割,确保录制的单句在5至15 s之间。每名录制者根据分割好的文本进行单句的录制,并在录制的过程中由工作人员进行录音质量的评估,如果质量不达标,则会对该条语料进行重新录制。不同的录制者录制的语音内容之间有少量重复,但大部分语料的内容并不相同。为了验证提出的方法,从现有的大规模蒙古语语音合成语料库中进行筛选,人工挑选出高质量的音频,同时还要保证挑选出的句子尽可能全面覆盖蒙古语常用发音音素[19,28]。蒙古语常用发音音素如表1所示。

表1 蒙古语音素表

Tab.1 Mongolian Phoneme Table

类型音素基本元音长元音依附元音复元音借词元音基本辅音借词辅音

将两名女性播音员和两名男性播音员标记为F1、F2、M1、M2。对于每个录制者语料的筛选,首先选择听上去音质良好、音色尽量不变的语料。之后对每一条语料的内容进行了对比,选择尽量不包含相同蒙古语字词内容的非平行语料,来组成非平行蒙古语语音转换语料库。在模型测试阶段,由于转换后的目标说话人语音需要有真实参照语音进行实验指标的计算。因此,额外挑选了20句蒙古文文本相同的语料组成测试数据,一共得到80句平行语音。

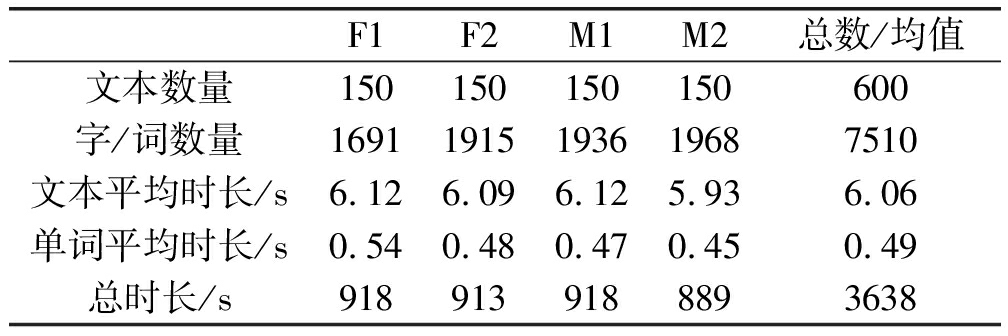

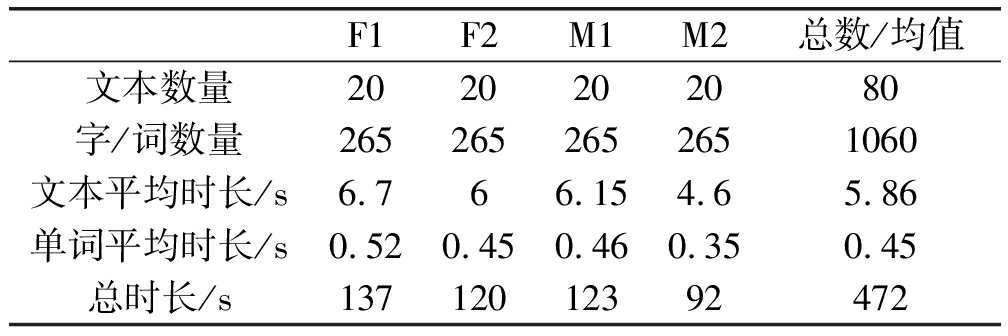

表2展示了非平行蒙古语语音转换训练数据的详细信息。如表2所示,整理得到文本总数600句,每名录制者分别选择150条语料,每条语料的平均时长在6 s左右,每个蒙古文单词发音平均时长在0.5 s左右。非平行训练语料总时长达到3638 s,约合1.01小时。表3展示了平行测试数据的详细信息。如表3所示,每名录制者分别选择20条平行语料,每条语料的平均时长在5.9 s左右,每个蒙古文单词发音平均时长在0.45 s左右。平行测试语料总时长达到472 s,约合7.9分钟。

表2 非平行蒙古语语音转换训练数据汇总

Tab.2 A summary of training data for non-parallel Mongolian voice conversion

F1F2M1M2总数/均值文本数量150150150150600字/词数量16911915193619687510文本平均时长/s6.126.096.125.936.06单词平均时长/s0.540.480.470.450.49总时长/s9189139188893638

表3 平行蒙古语语音转换测试数据汇总

Tab.3 A summary of testing data for parallel Mongolian voice conversion

F1F2M1M2总数/均值文本数量2020202080字/词数量2652652652651060文本平均时长/s6.766.154.65.86单词平均时长/s0.520.450.460.350.45总时长/s13712012392472

4.2 实验设置

使用非平行蒙古语语音转换语料库中的数据进行模型的训练。将训练数据下采样到16 kHz,然后每5 ms使用WORLD声码器提取每条语音的24维倒谱特征(Mel-cepstral coefficient,MCEP)、基频特征和非周期性特征。同时,还要对源说话人和目标说话人的倒谱特征进行归一化操作。为了验证本文提出的方法,选择传统CycleGAN网络作为基线模型(baseline),分别在条件CycleGAN模型(CCycleGAN)、基于细粒度韵律建模和条件CycleGAN的非平行蒙古语语音转换模型(FG-CCycleGAN)进行蒙古语语音转换实验。此外,为了验证细粒度韵律建模方法的有效性,使用传统CycleGAN网络将倒谱特征和经过韵律建模后的基频特征进行转换,将细粒度韵律建模与传统CycleGAN网络相结合(FG-CycleGAN),并进行实验验证。每个模型都进行了女转女(F1-F2)、男转男(M1-M2)、男转女(M1-F2)、女转男(F1-M2)四组实验。对于基线模型和CCycleGAN模型,使用24维倒谱特征作为输入,对于基频采用高斯归一化算法进行转换,使用WORLD声码器进行音频合成。对于FG-CycleGAN模型和FG-CCycleGAN模型,输入为倒谱特征和经小波变换后的10维基频特征。对于所有模型,设置参数λcyc=10,λid=5。仅在前105次迭代中使用身份映射损失指导网络的训练。

优化器选择Adam优化器,batch size大小设为1。生成器的初始学习率为0.0002,判别器的初始学习率为0.0001。在最初105次迭代中学习率保持不变,在剩下的105次迭代中学习率线性衰减,动量项β=0.5。

4.3 客观评价

在客观指标的选择上,使用MCD[29](Mel cepstral distortion)和RMSE[18](Root Mean Squared Error)分别对转换后的频谱特征和基频特征进行比较。MCD能够对目标语音和转换后语音对应帧之间频谱特征的不同程度进行量化,MCD数值越小,目标语音频谱与转换后语音频谱越接近。如公式(13)所示:

(13)

其中yi表示某一维度上转换后语音的频谱特征,yt表示该维度上目标语音的频谱特征。

通过计算目标语音与转换后语音基频的RMSE,能够对源语音到目标语音的韵律转换程度进行量化[30],RMSE数值越小,韵律转换的效果越好。如公式(14)所示:

(14)

其中Fi表示目标语音一帧的基频特征,Ft表示转换后语音对应帧的基频特征,N表示基频序列的长度。

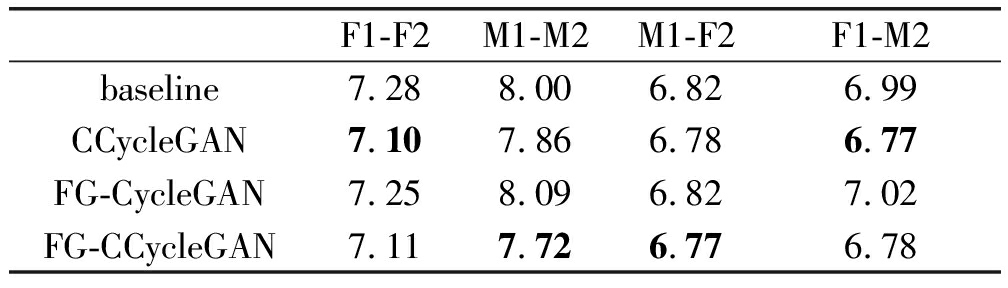

不同模型的MCD和RMSE结果分别在表4和表5中展示。由表4可知,CCycleGAN模型比基线模型的MCD在所有实验中均有降低,证明条件CycleGAN网络可以降低MCD指标。对比FG-CycleGAN模型和基线模型,在所有实验组中MCD并未有太大差异,证明细粒度韵律建模对MCD指标没有太大影响。对比FG-CycleGAN模型和FG-CCycleGAN模型,在所有实验组中MCD都有明显下降,证明在细粒度韵律建模的基础上使用条件CycleGAN网络,可以显著降低MCD指标。对比CCycleGAN模型和FG-CCycleGAN模型,在所有实验组中MCD虽有升有降,但总体上相差不大,证明在条件CycleGAN网络的基础上使用细粒度韵律建模方法对MCD指标影响不大。对比FG-CCycleGAN模型和基线模型,在所有实验中MCD均有明显降低,证明结合使用细粒度韵律建模和条件CycleGAN网络能够有效降低MCD指标。综上所述,条件CycleGAN网络能够在非平行蒙古语语料条件下有效提升转换前后语音的频谱相似度,使用条件CycleGAN可以在语音转换任务中得到稳定的频谱转换效果,而细粒度韵律建模方法对转换前后的频谱相似度没有太大影响。

表4 不同模型的MCD[dB]结果比较

Tab.4 Comparison of MCD[dB]results of different models

F1-F2M1-M2M1-F2F1-M2baseline7.288.006.826.99CCycleGAN7.107.866.786.77FG-CycleGAN7.258.096.827.02FG-CCycleGAN7.117.726.776.78

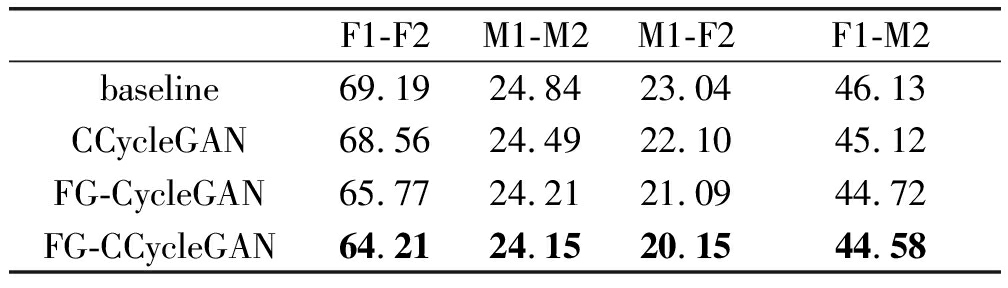

表5 不同模型F0的RMSE[Hz]结果比较

Tab.5 Comparison of RMSE[Hz]results of different models F0

F1-F2M1-M2M1-F2F1-M2baseline69.1924.8423.0446.13CCycleGAN68.5624.4922.1045.12FG-CycleGAN65.7724.2121.0944.72FG-CCycleGAN64.2124.1520.1544.58

由表5可知,FG-CycleGAN模型在所有实验中比基线模型的RMSE均有明显下降,证明细粒度韵律建模方法能有效降低RMSE指标。CCycleGAN模型在所有实验中比基线模型的RMSE也有一定程度下降,证明使用条件CycleGAN网络也能在一定程度上降低RMSE指标,但降低的程度并没有细粒度韵律建模方法明显。对比FG-CCycleGAN模型和CCycleGAN模型,在所有实验中RMSE值均有明显降低,证明在条件CycleGAN网络的基础上使用细粒度韵律建模的方法可以有效降低RMSE指标。对比FG-CCycleGAN模型和FG-CycleGAN模型,在所有实验中RMSE值均一定程度的下降,证明在细粒度韵律建模方法的基础上使用条件CycleGAN网络可以在一定程度上降低RMSE指标。对比FG-CCycleGAN模型与基线模型,在所有实验中RMSE都有明显的大幅度降低,证明使用细粒度韵律建模和条件CycleGAN网络结合的方法的能够有效降低RMSE指标。综上所述,细粒度韵律建模方法可以在非平行蒙古语语料的条件下得到较好的韵律转换效果。条件CycleGAN也能在一定程度上达到韵律转换的效果,但转换的效果并没有细粒度韵律建模得到的效果好。

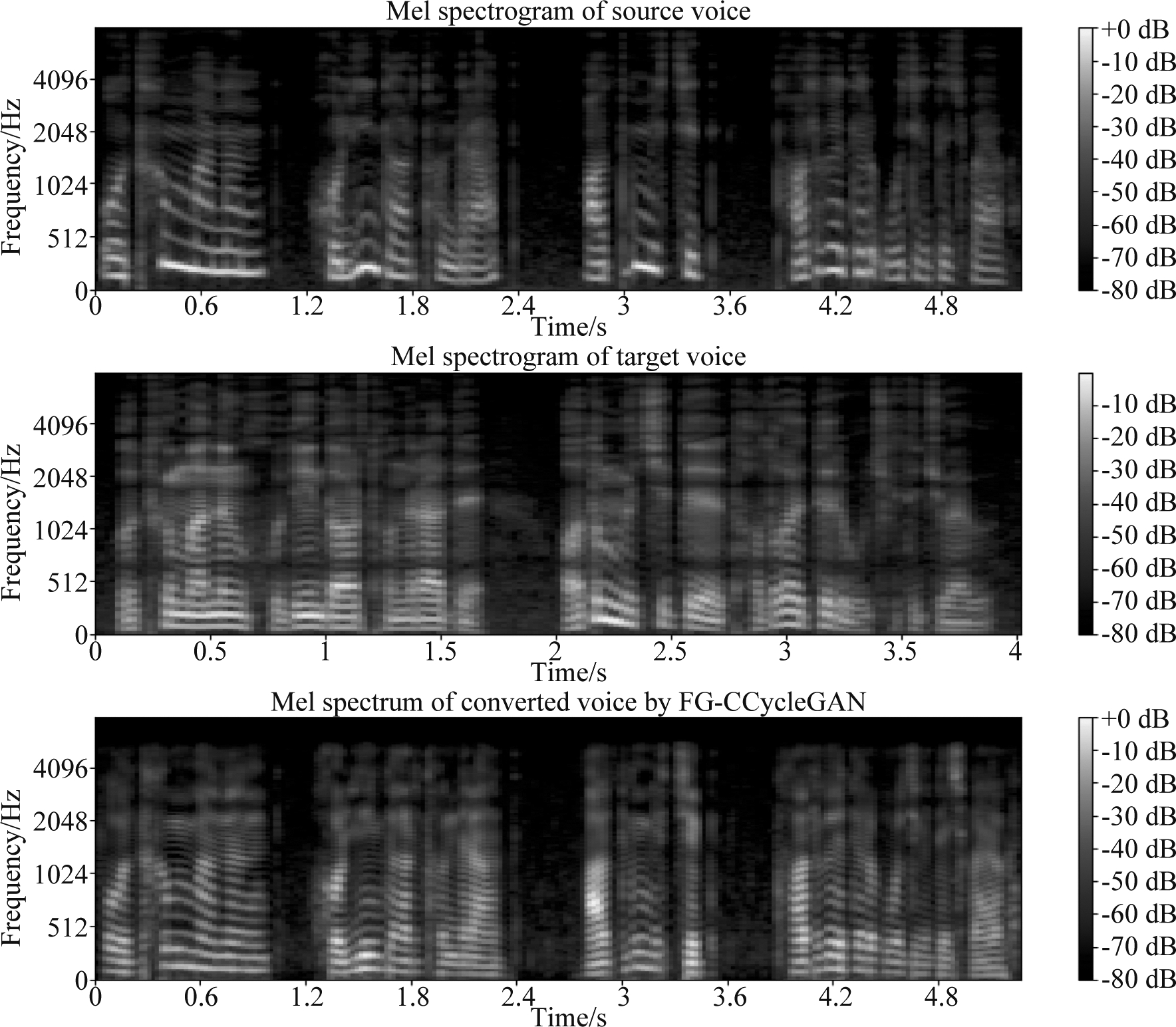

此外,还对FG-CCycleGAN模型转换前后的语谱图进行了对比分析。如图4所示,为源语音、目标语音和经FG-CCycleGAN模型转换后语音的梅尔频谱对比。从图中可以看出经FG-CCycleGAN模型转换后语音与源语音的长度没有发生很大改变,但转换后的梅尔频谱的共振峰分布发生了明显变化,其分布与目标语音语谱图的共振峰分布更相似。证明FG-CCycleGAN模型可以很好的学习到目标语音的语音风格。

图4 在F1-M2组中对源语音、目标语音和经FG-CCycleGAN模型转换后语音的梅尔频谱的对比,语音内容为“![]() (浓雾在脚下缭绕,繁星璀璨在星空)”

(浓雾在脚下缭绕,繁星璀璨在星空)”

Fig.4 Comparison of source voice’s,target voice’s and and the target voice conversion model FG-CCycleGAN via voice’s Mel spectrum in F1-M2 group the voice contents “![]() (The fog lingers beneath your feet, the stars shine brightly in the starry sky)”

(The fog lingers beneath your feet, the stars shine brightly in the starry sky)”

综上所述,在非平行蒙古语料的条件下,向传统CycleGAN语音转换模型中引入细粒度韵律建模和不同的说话人向量能够有效提高蒙古语语音转换的音质和韵律转换效果。

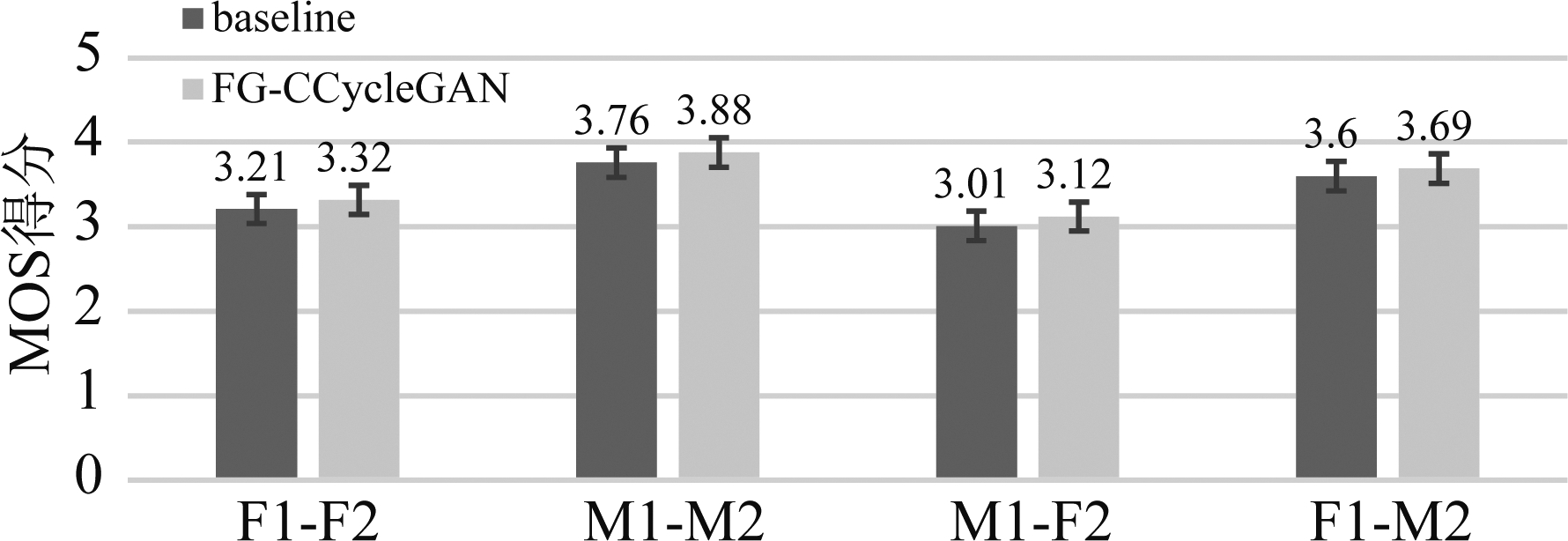

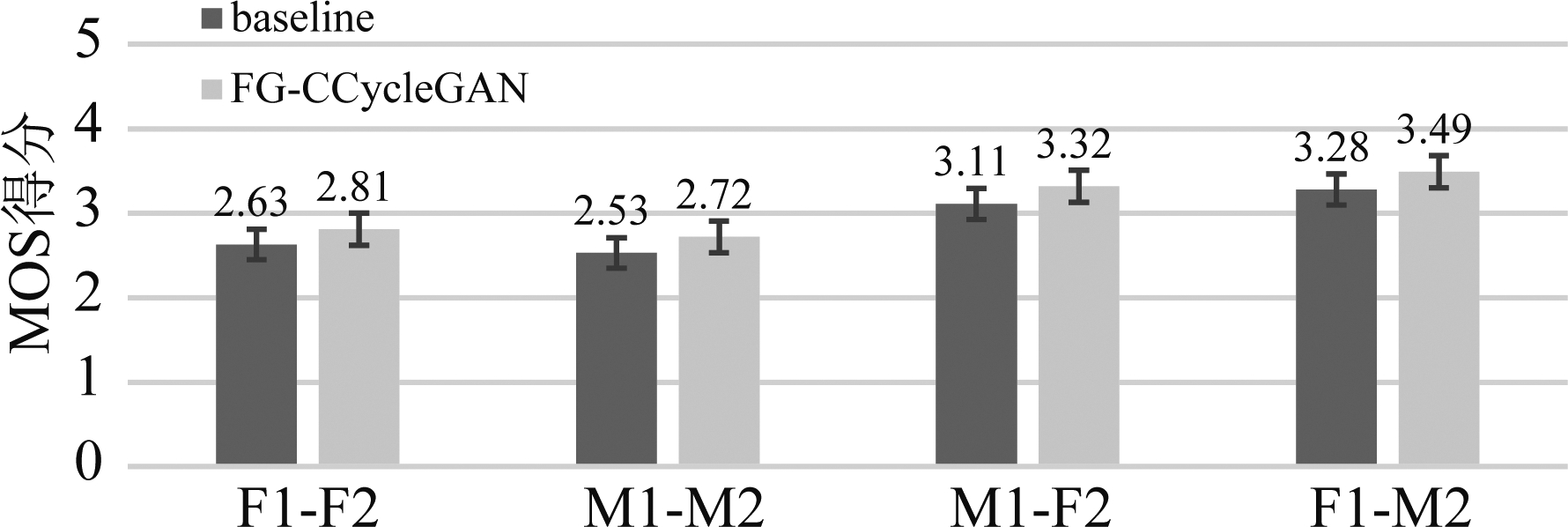

4.4 主观评价

在主观评价的选择上,采用MOS[31](Mean opinion score)测试的方法对转换后语音的自然度和相似度进行打分。语音自然度MOS值反应了转换后语音质量与真实语音质量的差异(5:优,4:良,3:一般,2:差,1:劣),语音相似度MOS值反应了转换后语音与目标说话人语音的音色相似程度(5:优,4:良,3:一般,2:差,1:劣)。

对于基线模型、FG-CCycleGAN模型转换后的语音进行听力测试。对平行蒙古语语音转换测试数据中的20条语音在每个模型的每组实验上进行了转换。在自然度测试中,按照随机顺序给出不同模型转换后的语音,测试者需要将其与目标说话人的真实语音的音质进行对比并打分。在相似性测试中,首先给出源说话人和目标说话人的真实语音,然后按照随机顺序给出不同模型转换后的语音,测试者需要根据不同模型转换后的语音与真实语音的音色相似度对比并进行打分。有6位母语为蒙古语的测试者参与了自然度测试。有10位测试者参与了相似性测试,其中6位测试者的母语为蒙古语,其余测试者的母语为汉语。

自然度MOS测试和相似度MOS测试的结果分别如图5、图6所示。由图5可知,FG-CCycleGAN模型比基线模型在所有实验中得到的自然度MOS均有提升,平均提升0.1左右,证明FG-CCycleGAN模型得到的蒙古语语音转换结果音质更好。由图6可知,FG-CCycleGAN模型比基线模型在所有实验中得到的相似度MOS均有提升,平均提升0.2左右,证明FG-CCycleGAN模型能够得到更好的语音转换效果。

图5 自然度MOS测试结果

Fig.5 Naturalness MOS test results

图6 相似度MOS测试结果

Fig.6 Similarity MOS test results

因此,在非平行蒙古语语料的条件下,向传统CycleGAN语音转换模型中引入细粒度韵律建模和不同说话人向量构成的条件CycleGAN网络能够有效提高蒙古语语音转换的音质和转换效果。

5 结论

本文提出了一种基于细粒度韵律建模和条件CycleGAN的非平行蒙古语语音转换方法,该方法通过引入说话人向量对CycleGAN的训练进行监督,同时使用连续小波变换对蒙古语语音中的韵律进行了细粒度建模,通过韵律转换和频谱转换最终完成了蒙古语语音转换任务。为了验证提出的方法,还建立了非平行蒙古语语音转换语料库,并在该语料库上进行了实验。实验结果表明,本文提出模型在客观评价和主观评价上都有所提升,证明了该方法在蒙古语语音转换中的有效性。但是转换后的语音与真实目标语音仍存在一定的差距,使用WORLD声码器合成的声音并不是很自然,并且平行与非平行条件对蒙古语语音的影响并不确定。在未来的工作中,将采用一些合成效果更自然的神经网络声码进行语音的合成,如WaveNet、MelGAN等。同时,将进一步研究平行与非平行条件对蒙古语语音转换效果的影响。

[1] ZHAO Yi, HUANG Wen-Chin, TIAN Xiaohai, et al.Voice Conversion Challenge 2020: Intra-lingual semi-parallel and cross-lingual voice conversion[C]∥Joint Workshop for the Blizzard Challenge and Voice Conversion Challenge 2020.ISCA: ISCA, 2020: 80-98.

[2] LEVY-LESHEM R, GIRYES R.Taco-VC: A single speaker tacotron based voice conversion with limited data[C]∥2020 28th European Signal Processing Conference(EUSIPCO).Amsterdam, Netherlands.IEEE, 2021: 391-395.

[3] POLYAK A, WOLF L, ADI Y, et al.Unsupervised cross-domain singing voice conversion[C]∥Interspeech 2020.ISCA: ISCA, 2020: 801-805.

[4] CAO Yuexin, LIU Zhengchen, CHEN Minchuan, et al.Nonparallel emotional speech conversion using VAE-GAN[C]∥Interspeech 2020.ISCA: ISCA, 2020: 3406-3410.

[5] PATEL M, PUROHIT M, SHAH J, et al.CinC-GAN for effective F0 prediction for whisper-to-normal speech conversion[C]∥2020 28th European Signal Processing Conference(EUSIPCO).Amsterdam, Netherlands.IEEE, 2021: 411-415.

[6] 罗武骏, 黄程韦, 查诚, 等.越南语语音情感特征分析与识别[J].信号处理, 2013, 29(10): 1423-1432.

LUO Wujun, HUANG Chengwei, CHA Cheng, et al.Emotional feature analysis and recognition from Vietnamese speech[J].Journal of Signal Processing, 2013, 29(10): 1423-1432.(in Chinese)

[7] TODA T, BLACK A W, TOKUDA K.Spectral conversion based on maximum likelihood estimation considering global variance of converted parameter[C]∥Proceedings of(ICASSP ′05).IEEE International Conference on Acoustics, Speech, and Signal Processing, 2005.Philadelphia, PA, USA.IEEE, 2005: I/9-I12.

[8] WU Zhizheng, VIRTANEN T, KINNUNEN T, et al.Exemplar-based voice conversion using non-negative spectrogram deconvolution[C]∥Eighth ISCA Workshop on Speech Synthesis,2013:201-206.

[9] SHUANG Zhiwei, BAKIS R, SHECHTMAN S, et al.Frequency warping based on mapping formant parameters[C]∥Ninth International Conference on Spoken Language Processing,2006:2290-2293.

[10] DESAI S, RAGHAVENDRA E V, YEGNANARAYANA B, et al.Voice conversion using artificial neural networks[C]∥2009 IEEE International Conference on Acoustics, Speech and Signal Processing.Taipei, Taiwan, China.IEEE, 2009: 3893-3896.

[11] BIADSY F, WEISS R J, MORENO P J, et al.Parrotron: An end-to-end speech-to-speech conversion model and its applications to hearing-impaired speech and speech separation[J/OL].arXiv preprint arXiv:1904.04169v3, 2019-10-29.

[12] KANEKO T, KAMEOKA H.CycleGAN-VC: Non-parallel voice conversion using cycle-consistent adversarial networks[C]∥2018 26th European Signal Processing Conference(EUSIPCO).Rome, Italy.IEEE, 2018: 2100-2104.

[13] KANEKO T, KAMEOKA H, TANAKA K, et al.Cyclegan-VC2: Improved cyclegan-based non-parallel voice conversion[C]∥ICASSP 2019-2019 IEEE International Conference on Acoustics, Speech and Signal Processing(ICASSP).Brighton, UK.IEEE, 2019: 6820-6824.

[14] KANEKO T, KAMEOKA H, TANAKA K, et al.CycleGAN-VC3: Examining and improving CycleGAN-VCs for mel-spectrogram conversion[C]∥Interspeech 2020.ISCA: ISCA, 2020: 2017-2021.

[15] KAMEOKA H, KANEKO T, TANAKA K, et al.StarGAN-VC: Non-parallel many-to-many voice conversion using star generative adversarial networks[C]∥2018 IEEE Spoken Language Technology Workshop(SLT).Athens, Greece.IEEE, 2018: 266-273.

[16] KANEKO T, KAMEOKA H, TANAKA K, et al.StarGAN-VC2: Rethinking conditional methods for StarGAN-based voice conversion[C]∥Interspeech 2019.ISCA: ISCA, 2019: 679-683.

[17] LIU Rui, SISMAN B, GAO Guanglai, et al.Expressive TTS training with frame and style reconstruction loss[J].IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2021, 29: 1806-1818.

[18] LIU Rui, SISMAN B, BAO Feilong, et al.Exploiting morphological and phonological features to improve prosodic phrasing for Mongolian speech synthesis[J].IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2020, 29: 274-285.

[19] 清格尔泰.蒙古语语法[M].呼和浩特: 内蒙古人民出版社, 1991: 77-133.

Qingertai.A grammar of the Mongolian language[M].Hohhot:Inner Mongolian People's Publishing House, 1991: 77-133.(in Chinese)

[20] VAINIO M, SUNI A, AALTO D.Continuous wavelet transform for analysis of speech prosody[J].TRASP 2013-Tools and Resources for the Analysys of Speech Prosody,2013:78-81.

[21] ZHOU Kun, SISMAN B, LIU Rui, et al.Emotional voice conversion: Theory, databases and ESD[EB/OL].2021.https:∥arxiv.org/pdf/2105.14762.pdf.

[22] LEE S, KO B, LEE K, et al.Many-to-many voice conversion using conditional cycle-consistent adversarial networks[C]∥ICASSP 2020-2020 IEEE International Conference on Acoustics, Speech and Signal Processing(ICASSP).Barcelona, Spain.IEEE, 2020: 6279-6283.

[23] GOODFELLOW I, POUGET-ABADIE J, MIRZA M, et al.Generative adversarial networks[J].Communications of the ACM, 2020, 63(11): 139-144.

[24] SISMAN B, LI Haizhou, TAN K C.Transformation of prosody in voice conversion[C]∥2017 Asia-Pacific Signal and Information Processing Association Annual Summit and Conference(APSIPA ASC).Kuala Lumpur.IEEE, 2017: 1537-1546.

[25] SUNI A S, AALTO D, RAITIO T, et al.Wavelets for intonation modeling in HMM speech synthesis[C]∥8th ISCA Workshop on Speech Synthesis,2013.

[26] ZHOU Kun, SISMAN B, LI Haizhou.Transforming spectrum and prosody for emotional voice conversion with non-parallel training data[C]∥Odyssey 2020 The Speaker and Language Recognition Workshop.ISCA:ISCA,2020: 230-237.

[27] DAUPHIN Y N, FAN A, AULI M, et al.Language modeling with gated convolutional networks[EB/OL].2016.http:∥proceedings.mlr.press/v70/dauphin17a.

[28] 飞龙, 高光来, 闫学亮.蒙古文字母到音素转换方法的研究[J].计算机应用研究, 2013, 30(6): 1696-1700.

FEI Long, GAO Guanglai, YAN Xueliang.Research on grapheme to phoneme conversion for Mongolian[J].Application Research of Computers, 2013, 30(6): 1696-1700.(in Chinese)

[29] KUBICHEK R.Mel-cepstral distance measure for objective speech quality assessment[C]∥Proceedings of IEEE Pacific Rim Conference on Communications Computers and Signal Processing.Victoria, BC, Canada.IEEE, 1993: 125-128.

[30] SISMAN B, ZHANG Mingyang, LI Haizhou.Group sparse representation with WaveNet vocoder adaptation for spectrum and prosody conversion[J].IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2019, 27(6): 1085-1097.

[31] STREIJL R C, WINKLER S, HANDS D S.Mean opinion score(MOS)revisited: Methods and applications, limitations and alternatives[J].Multimedia Systems, 2016, 22(2): 213-227.