1 引言

随着社会的飞速发展,国际交流沟通日益增多,人们会使用多种语言进行交流,因此多语种语音识别研究逐渐受到关注。传统的多语种语音识别技术首先判断语种信息,然后由对应语种的自动语音识别(Automatic Speech recognition, ASR)系统进行处理[1-3]。这种级联式的多语种语音识别系统时延较高,还需要针对每种语言开发单独的ASR系统,且语音识别准确率很大程度上会受到前端语种识别(Language Identification, LID)准确率的影响[4]。

基于深度神经网络-隐马尔可夫模型(Deep Neural Network-Hidden Markov Model , DNN-HMM)[5-7]的语音识别系统目前是工业界的主流模型。这种模型将隐马尔可夫的观测值概率用深度神经网络进行建模,同时需要基于加权有限状态转换器(Weighted Finite-State Transducers, WFST)[8],把发音词典、声学模型和语言模型编译成静态解码网络,优点是解码速度很快,缺点在于模型训练过程较为复杂。

与传统的DNN-HMM模型相比,端到端模型不需要繁琐的训练过程,应用更加便捷。近几年来,端到端ASR系统发展迅速,从连接时序分类(Connectionist Temporal Classification,CTC)[9],到循环神经网络变换器(Recurrent Neural Network Transducer, RNN-T)[10-12],再到基于注意力机制的编码器-解码器架构[13-14]。也有学者提出将连接时序分类和注意力机制相结合的方法,在语音识别任务上获得了不错的效果[15]。由于Transformer模型[16]在机器翻译、计算机视觉等领域的优秀表现,Dong等人[17]首次将Transformer模型引入语音识别领域,并在各类公开数据集上获得了优异的表现。在此基础上,有学者使用Transformer模型替换RNN-T模型中的循环神经网络,提出了Transformer-Transducer模型[18-19],也取得了不错的效果。

但在为新语言建立传统的ASR系统时,语言学信息的处理工作,如构建发音词典和分词等,是一个很大的障碍,而端到端ASR系统则能够在没有音素或语言学表征的条件下,直接将输入的语音特征转换为对应的标签序列输出。Watanabe等人[20]首先将端到端模型应用在多语种语音识别的研究上,提出了一种基于语种无关架构的端到端多语种识别模型。随后,Zhou等人[21]将Transformer模型应用在低资源的多语种语音识别任务上,相较于基线系统获得了10%的性能提升。Hou等人[22]提出了一种端到端的语种识别-语音识别多任务模型,并在大规模数据集上进行了测试。

参考以上工作,本文建立了一种整体式端到端多语种ASR系统,该系统采用了混合连接时序分类和注意力机制(Hybrid CTC/Attention)架构,采取多任务学习的训练机制,使用CTC来辅助注意力(Attention)对齐。本文使用Transformer构建了基于注意力机制的编码器-解码器架构,在每个编码器和解码器中均使用了注意力机制,能够更好地建立输入语音特征和识别结果之间的序列对应关系。本文使用东方语种识别竞赛[23]提供的10种语言的语音数据进行训练,将训练数据标注文本中出现的所有字符整合到字符集中,采用多语种语音数据进行训练,可以跨语言共享信息。本文提出的整体式多语种ASR系统识别性能显著优于单个语种ASR系统。此外,本文的实验部分也为模型增加了语种标签,使得系统在进行语音识别的同时也能判断目标语音的语种。

2 端到端多语种语音识别模型

多语种语音识别涉及到语种的类别较多,构建多语种词典的工作繁琐复杂。端到端语音识别模型需要较少的先验知识,且能达到和传统DNN-HMM语音识别模型相媲美的效果,可以很好地适应多语种语音识别任务。目前主流的端到端语音模型结构有CTC、RNN-T和Attention模型,本文结合CTC模型和Attention模型的优势,采用混合CTC/Attention模型,在简化了多语种语音识别模型训练流程的同时,获得了较高的模型性能。

2.1 连接时序分类(CTC)

CTC方法的主要思想是在输入序列和输出序列之间直接建立多对一的映射关系,以寻求最佳匹配。当输入序列和输出序列长度不等时,可以通过字符重复和空白字符填充两种方法来解决。CTC直接对序列进行学习,无需帧级别的标注。

假设输入序列X={x1,x2,…,xT},对应的输出序列为Y={y1,y2,…,yU},其中,T是输入序列的长度,U是输出序列的长度。CTC的训练目标是使X和Y尽量匹配,即使得输出概率P(Y|X)最大。输出序列Y可以通过CTC中间序列集合Actc(X,Y)生成,这个集合包含了字符重复和空白标签各种可能的组合。Y由X生成的概率为:

(1)

其中![]() 表示对输出序列Y经过字符重复和空白字符填充等操作后得到的某条映射序列,其长度和输入序列X一致,在对

表示对输出序列Y经过字符重复和空白字符填充等操作后得到的某条映射序列,其长度和输入序列X一致,在对![]() 合并连续重复字符并去掉空白单元能够得到最终的输出序列Y。

合并连续重复字符并去掉空白单元能够得到最终的输出序列Y。

CTC假设输出单元之间相互独立,因此映射序列![]() 出现的概率是每个时刻输出概率的乘积:

出现的概率是每个时刻输出概率的乘积:

(2)

其中,![]() 表示映射序列

表示映射序列![]() 在t时刻的输出标签,

在t时刻的输出标签,![]() 是其对应的输出概率,L′T表示长度为T的输入序列对应的所有可能输出序列的集合。

是其对应的输出概率,L′T表示长度为T的输入序列对应的所有可能输出序列的集合。

CTC的损失函数定义为训练集S所有样本的负对数之和,如下式所示:

(3)

CTC训练优化的目标是使Lctc最小化,其中后验概率分布P(Y|X)可以通过前向后向算法求解,如下式所示:

(4)

其中,αt(s)表示已经输出前t个观察值,并且在t时刻以标签s结尾的前向序列的概率之和;βt(s)表示在t时刻以标签s开头的后向序列的概率之和;![]() 表示输出在t时刻对应标签s的概率。

表示输出在t时刻对应标签s的概率。

2.2 注意力(Attention)机制

语音识别任务也可以看作序列对序列(Sequence-to-Sequence, Seq2Seq)问题,对于这类问题通常使用编码器-解码器(Encoder-Decoder)模型对输入特征和输出结果进行建模。编码器和解码器之间的关联可以通过注意力机制加强。Attention机制通过聚焦某个特定区域,得到更细节的信息,并根据重要性赋予相应的权重。

编码器将输入特征序列转为隐藏向量序列,解码器计算输出符号基于之前预测标签和输入特征序列的概率分布。Attention模型通过接收编码器生成的高维特征表征,计算注意力权重,并基于此权重来构建Decoder网络的上下文向量,进而建立输出序列与输入序列之间的对齐关系,指导解码器的输出。

本文使用谷歌提出的Transformer架构,这种架构含有多组编码器和解码器,每组编码器-解码器均引入了Attention机制,其完整结构如图1所示。编码器层主要由多头注意力机制(Multi-Head Attention)[24]层和前馈神经网络(Feed Forward Network,FFN)层这两个子层构成。多头注意力机制是由多个自注意力(Self-Attention)模块并联而成,输入特征在这里被传入多个子空间进行特征建模,最后再将各个子空间的输出进行合并,得到更高层次的特征编码。其目的是使当前节点能够关注到整个句子,进而将上下文关系引入模型之中。前馈网络层由多层全连接网络串联而成,激活函数为线性整流函数(Rectified Linear Unit, ReLU),其主要作用是更新多头注意力层输出向量的状态信息。

图1 Transformer模型

Fig.1 Transformer model

解码器层包含两个注意力模块和一个前馈神经网络模块,其中两个注意力模块的输入分别来自于编码器和上一层解码器的输出,其作用是将编码器的输出向量与解码器的输入向量进行对齐。此外,在注意力层都有残差连接,这样可以将前一层的信息直接传递到下一层,一方面可以为下一层提供更多的特征信息,另一方面也使得训练时反向传播更加稳定。

Transformer架构的核心模块是自注意力机制,它是一种根据输入序列不同位置间的关系来计算输入表示的机制。首先将输入H与代表Query、Key、Value的三个矩阵相乘,进行线性转换获得初始化权重矩阵Q、K和V,然后根据下式计算矩阵Q、K的相似度:

(5)

其中,dk是矩阵K的列数。

计算出相似度后,经过Softmax层输出0~1分布的概率矩阵,把这个概率矩阵再与矩阵V相乘,得到最后的输出结果Z,如下式所示:

Z=attention(Q,K,V)=softmax(f(Q,K))V

(6)

根据多头注意力的计算方法,可以得到不同组的Q、K和V表示,然后再将结果进行结合。多头注意力机制的计算完成之后,在编码器和解码器中还要经过一个前馈神经网络处理,该网络还设置了dropout层用来防止训练时模型过拟合。

由于注意力机制无法获取输入序列的时序位置信息,为了更好地使其应用于语音识别这类具有时序信息的任务,在将特征序列输入编码器之前,Transformer还对输入序列标签进行了位置编码,为每个标签引入位置信息,使得自注意力机制能够判断不同位置的相同标签代表的含义。

2.3 混合CTC/Attention模型

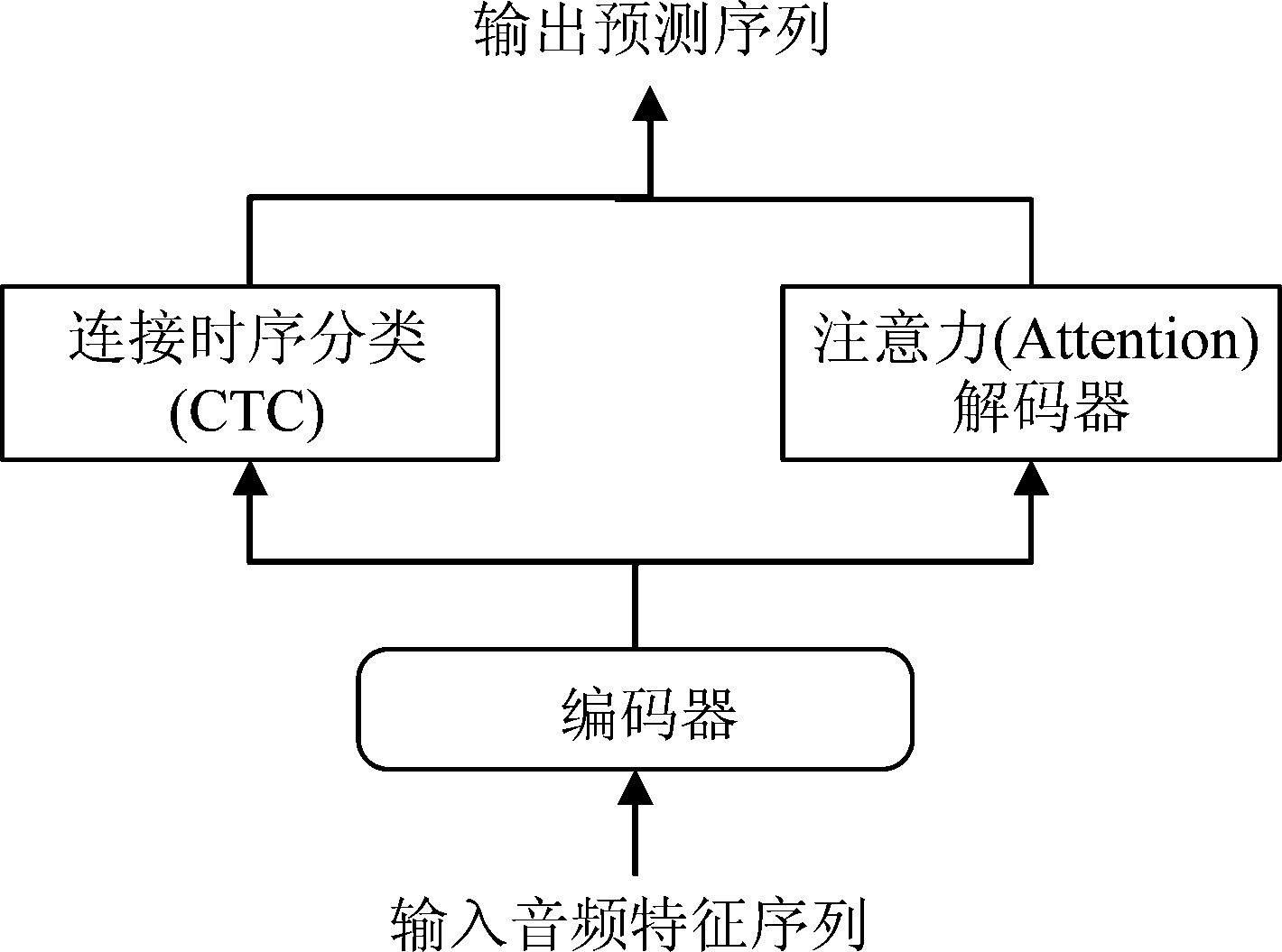

本文采用了一种混合CTC/Attention模型,如图2所示。该模型由三个部分组成:编码器、CTC解码器、基于注意力(Attention)机制的解码器。其中CTC和Attention解码器共用相同的编码器,在预测输出序列时进行联合解码,注意力模型使用Transformer架构。

图2 混合CTC/Attention模型

Fig.2 Hybrid CTC/Attention model

2.3.1 多任务学习

注意力机制模型的对齐关系没有先后顺序的限制,完全靠数据驱动得到,因此在训练时需要足够多的数据,对齐的盲目性也会导致训练时间很长。CTC的前向-后向算法可以引导输出序列与输入序列按时间顺序对齐。而混合CTC/Attention模型将两者结合,采用多任务学习方式,编码器由CTC和Attention共用,模型Loss计算是CTC-Loss与Attention-Loss做加权相加,如公式(7)所示:

L=αLctc+(1-α)Latt

(7)

其中,α表示CTC模型所占的权重。

使用CTC作为辅助任务能够避免输入序列和输出序列的对齐关系过于随机,且可以加快模型收敛速度。

2.3.2 联合解码

本文采用了一种混合CTC/Attention模型的联合解码方法,引入了CTC概率来使得输出序列和输入序列能够更好地对齐。混合CTC/Attention模型所得的结果是CTC和Attention输出结果的融合,由于CTC是根据输入帧计算分数,而Attention模型是根据输出符号计算分数,因此对于两者的融合过程需要进行相应的转换处理。基于Attention的识别模型通常使用集束搜索(Beam Search)算法来进行输出标签同步解码。在集束搜索算法中,解码器需要计算每种假设的分数,每一个当前标签都是由前面可能的标签序列扩展得到。解码最后比较所有可能序列的得分,取得分最高的序列为目标序列。对于长度为l的部分标签序列gl,它的得分scoreatt(gl)可以通过下式递归地计算得出:

scoreatt(gl)=scoreatt(gl-1)+logp(c|gl-1,X)

(8)

其中,c表示部分标签序列gl的最后一个标签。

对于给定的输入音频序列X,解码器的最终预测输出序列![]() 可以由下式得出:

可以由下式得出:

(9)

其中,Pctc和Patt分别为CTC和Attention模型给出的序列概率。

3 语种无关架构

本章节介绍了一种使用语种无关架构的整体式端到端多语种ASR模型,训练时不需要各语种语言相关的声学信息。各个语种共享所有的网络参数和根据扩充后的字符集构造的输出层。

3.1 扩增字符集

考虑到多语种语音识别涉及到多个不同语种的文字,如果使用词或者音素作为建模单元,则需要各个语种的专业知识,大大增加实验难度,因此我们选择字符作为模型的建模单元。

本文对输出符号集合进行了扩增,将所有在目标语言中出现过的字符并入输出字符集合。扩增字符集有利于以语种无关方式为所有语言训练一个单一的网络,且能够使得系统不需要任何语种识别模块即可对所有目标语言的语音进行识别,这样模型可以通过自主学习来预测并输出相应目标语言的字符序列。另外,模型没有针对每种语言划分各自的字符集,存在输出序列里出现不同语言字符的可能。

在训练多语种ASR模型时,不同语种之间会共享整个网络,从而使得编码器网络能够学到不同语种声学信息的差异和共性,这有助于减少不同语言规则语种之间的混淆并提高相似语言规则语种的识别准确率。此外,各语种共用相同的解码网络,则无需单独分析研究各个语种的声学和语言学特性,能够大大减少多语种语音识别系统的开发负担。

3.2 结合语种标签进行联合训练

为了能够在进行多语种语音识别的同时,显式地做出语种的判别,本文参考Watanabe等人[20]的工作,将多语种语音识别与语种标签进行了结合。进行模型训练时,在每个目标输出序列的开头插入对应的语种标签。本文通过链式法则引入语种标签的预测,如下式所示:

(10)

其中,k∈{ja-jp,ko-kr,…}表示语种标签,C={c1,c2,…,cl}表示预测的输出序列,l表示输出序列的字符数量,X表示输入的音频特征信息序列。

注意力机制对整句进行建模的特点,有利于这种联合架构在整句上进行语种识别。这种方式可以被看作是对级联式多语种语音识别模型思路上的模仿,即在模型解码预测时,首先判别语种,再预测输出文本序列。

4 多语种语音识别实验

4.1 实验设置

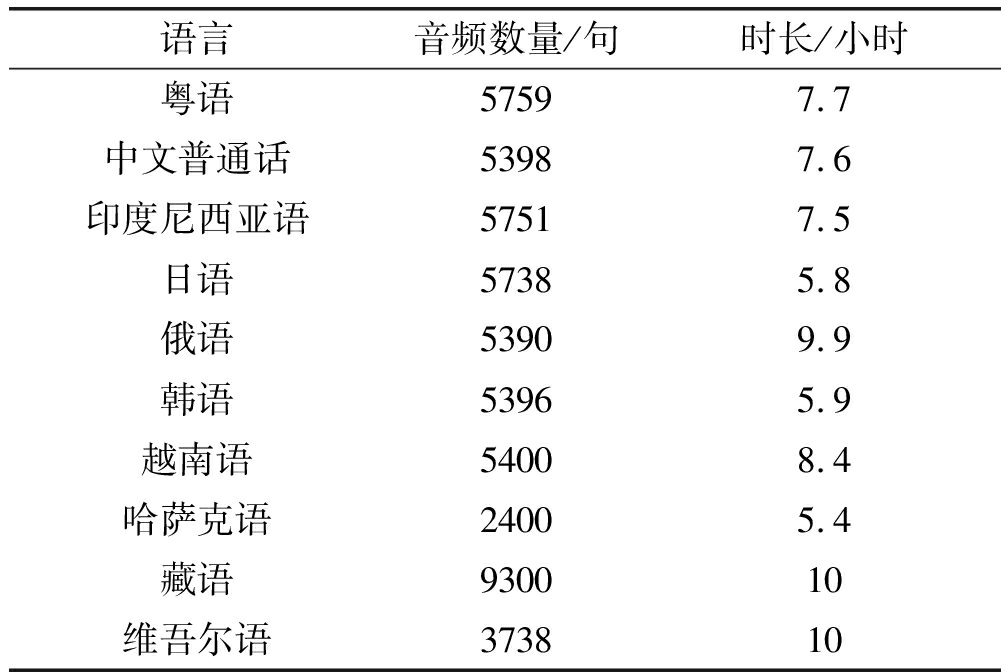

本文实验使用了东方语种识别竞赛提供的10种带标注的不同语言的语音数据集,如表1所示。该数据集中俄语、藏语和维吾尔语的时长约为10小时,越南语时长为8.4小时,粤语、中文普通话和印度尼西亚语时长在7.6小时左右,日语和韩语的音频数据时长在6小时左右,哈萨克语时长最短,仅有5.4小时。其中藏语每句时长较短,音频句数约为其余各语种语音句数的两倍。对于该数据集,本文对每种语言的数据随机抽取80%作为训练集,抽取10%作为开发集,剩下10%作为测试集。本文所有实验都是使用开源的Espnet端到端语音识别开发工具包[25]完成。

表1 东方语种识别竞赛10种语言数据集

Tab.1 Oriental Language Recognition Competition 10 languages dataset

语言音频数量/句时长/小时粤语57597.7中文普通话53987.6印度尼西亚语57517.5日语57385.8俄语53909.9韩语53965.9越南语54008.4哈萨克语24005.4藏语930010维吾尔语373810

在所有的实验中,对于音频数据都提取80维的FBank特征加上3维的pitch特征,总共83维特征作为语音特征。所有ASR模型都是基于字符进行建模,整体式多语种ASR模型输出字符集含有5570个字符。

本文网络使用的Transformer模型中,编码器层数设置为12层,前馈神经元个数为2048,解码器前馈层数设置为6层,神经元个数同样设置为2048。多头注意力的上下文向量维度设置为256。混合CTC/Attention模型训练时,CTC模型的权重参数设置为0.3,训练的epochs设置为30。在训练前,本文使用了音速扰动和频谱增强这两种数据增强技术,以增加训练数据量并提高数据多样性。对于音速扰动,我们使用0.9和1.1的速度因子来减慢和加快原始音频,然后把每个原始音频的两个变速副本加入训练数据集中,得到3倍的训练数据。此外,我们还使用了SpecAugment[26]方法来进行频谱增强,该方法对语音特征进行了时间扭曲、频域遮蔽和时域遮蔽。其中时间扭曲设置扭曲距离w=5,使用了两个频谱遮罩,设置f=30, 即遮蔽30个连续的梅尔频谱通道;使用了两个时间遮罩,设置t=40,即遮蔽40个连续的时间帧。解码时,CTC解码分数权重设置为0.5。系统没有训练额外的语言模型。

4.2 评价指标

本文提出的端到端模型是在字符级别进行建模的,且多语种词典构造较为困难,使用字错误率(Character Error Rate, CER)作为评价指标。字错误率的计算公式如下:

(11)

其中,I、S、D分别为插入、替换、删除的字符的总个数,N为正确输出序列中词的总个数。

4.3 对比实验

本文进行了单一语种语音识别模型和整体式多语种语音识别模型的对比实验,也将结合语种标签的多语种语音识别模型与整体式多语种语音识别模型进行了比较。

整体式多语种语音识别模型采用语种无关架构,使用3.1节介绍的方法对字符集进行了扩增。它的训练集、开发集和测试集分别由10个语种对应的数据集合并而来,且在测试时对模型隐藏待测音频的语种信息。

对于单一语种语音识别模型,本文针对数据集中的10个语种,分别使用对应语种的训练数据训练了10个单一语种语音识别模型,输出字符集限定由该语种训练集数据标注文本中出现的所有字符构成,并使用对应语种的开发集和测试集进行评估。模型网络参数和整体式多语种语音识别模型保持一致。

对于结合语种标签的多语种语音识别模型,其网络参数和训练策略与整体式多语种ASR模型保持一致,在整体式多语种ASR模型的基础上,采用了3.2节介绍的方法与语种识别联合。此外还单独针对语种标签的识别结果进行了分析。

5 实验结果与分析

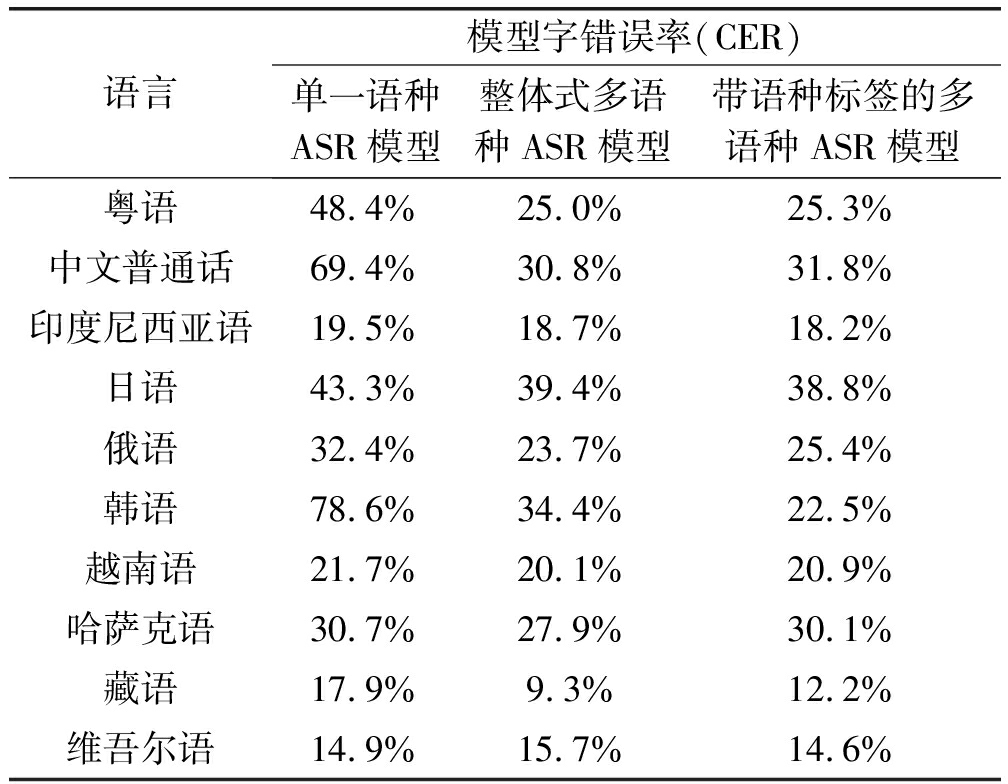

各系统的语音识别结果对比如表2所示。从表2中可以看出,在低资源条件下,整体式多语种ASR模型的性能在大多数语种上显著优于单一语种ASR模型。相较于单一语种ASR模型,除维吾尔语外,对于其余9种语言,整体式多语种ASR模型都在一定程度上降低了字错误率,其中在粤语、中文普通话、韩语和藏语上整体式模型相对降低了48%~56.2%的字错误率,对于印度尼西亚语、日语、越南语和哈萨克语整体式模型相对降低了4.1%~9.1%的字错误率,仅对于维吾尔语,整体式ASR模型增加了0.8%的绝对字错误率。在对单一语种ASR模型进行评估时,测试集不包含其它语言的测试音频,而对整体式多语种ASR模型进行评估时,实验使用的是多语种混杂的测试集,且没有为模型提供任何显式的语种信息。由此可以看出,整体式多语种ASR模型相对于单一语种ASR模型展现出良好的性能和可观的应用潜力。单一语种ASR模型为了对未知语种语音进行语音识别,除了需要前端处理进行语种辨别,还需要针对每种目标语言训练单独的ASR模型,开发代价较大。而整体式多语种ASR模型省去了进行语种判别的步骤,不仅语音识别准确率更高,还能减少开发代价。

表2 各语种语音在不同模型中的字错误率对比

Tab.2 Comparison of character error rate(CER)of different languages in different models

语言模型字错误率(CER)单一语种ASR模型整体式多语种ASR模型带语种标签的多语种ASR模型粤语48.4%25.0%25.3%中文普通话69.4%30.8%31.8%印度尼西亚语19.5%18.7%18.2%日语43.3%39.4%38.8%俄语32.4%23.7%25.4%韩语78.6%34.4%22.5%越南语21.7%20.1%20.9%哈萨克语30.7%27.9%30.1%藏语17.9%9.3%12.2%维吾尔语14.9%15.7%14.6%

此外,对比不同语言在单一语种ASR模型下的字错误率可以发现,语言规则相似的语种字错误率相近,例如粤语、中文普通话、日语和韩语这类单字(符)对应单音节的语种。在整体式多语种ASR模型下,对于这些语言规则相似语种的识别字错误率均能得到显著降低,这说明整体式多语种ASR模型能够学习到语种之间潜在的共同规则,并用来辅助进行多语种语音识别,这是单一语种ASR模型无法做到的。对于带语种标签的多语种ASR模型,引入语种标签后,相较于整体式ASR模型,韩语的字错误率降低了34.6%,粤语、中文普通话、俄语、越南语、哈萨克语的字错误率有1.2%~7.8% 的增加,而藏语的字错误率相对增加了31.1%。说明增加语种标签仅对部分语种的识别有利,由于语种标签统一由英文字符构造,对于某些语种来说,语种标签的引入,会为相应语种的输出序列添加不属于该语种的字符,可能会使得模型对该语种输出序列的预测产生混淆。

表3展示了带语种标签的多语种ASR模型语种标签的识别性能。从表中可以看到,粤语、越南语、藏语的识别准确率达到了100%,中文普通话的识别率也能达到99.8%。韩语识别准确率仅有90.4%,且有9.1%的韩语音频被识别为日语;同样地,有3.5%的日语音频被识别为韩语,哈萨克语的语种识别准确率也仅有91.3%,我们观察到韩语、日语和哈萨克语是数据集中音频时长最少的三种语言。实验结果一方面表明日语和韩语在发音和语言规则上相似,容易产生混淆;另一方面也说明训练资源的贫乏会对模型性能产生较大的影响。而引入语种标签后,多语种ASR模型在日语和韩语上的字错误率相较于整体式多语种ASR模型有相当的降低,说明语种标签在一定程度上有利于易混淆语种的判别和识别。

表3 带语种标签的多语种ASR模型中语种标签识别结果

Tab.3 Recognition result of language label in multilingual ASR model combined with language label

语种语种标签预测标签ct-cnzh-cnid-idja-jpru-ruko-krvi-vnKazakTibetUyghu粤语ct-cn100.0%---------中文普通话zh-cn-99.8%----0.2%---印度尼西亚语id-id--98.4%1.2%0.2%-----日语ja-jp---96.5%-3.5%----俄语ru-ru----94.4%5.6%----韩语ko-kr--0.5%9.1%-90.4%----越南语vi-vn------100.0%---哈萨克语Kazak----8.7%--91.3%--藏语Tibet--------100.0%-维吾尔语Uyghu---0.2%0.2%---1.2%98.2%

6 结论

本文提出了一种基于混合CTC/Attention架构的整体式多语种ASR模型,采用语种无关架构,使用多语种数据联合建模,在低资源多语种数据集上,能够获得比单语种数据训练得到的ASR模型更加优异的性能。此外,本文还为模型引入语种标签进行联合训练,该方法能够提升部分易混淆语种的语音识别准确率。

尽管本文使用到的训练数据时长较少,但是涉及到的语种并非全是低资源语种,例如中文普通话实际上有非常丰富的数据资源,本文未来工作将围绕多语种之间潜在的关联规则进行展开,探求利用富资源语种数据来提升低资源语种语音识别的准确率。

[1] LYU D C, LYU R Y.Language identification on code-switching utterances using multiple cues.[J].Interspeech, 2008:711-714.

[2] MABOKELA K R, MANAMELA M J.An integrated language identification for code-switched speech using decoded-phonemes and support vector machine[C]∥2013 7th Conference on Speech Technology and Human-Computer Dialogue(SpeD).Cluj-Napoca, Romania.IEEE, 2013: 1-6.

[3] BARROSO N, BARROSO O, SUSPERREGI U, et al.Language identification oriented to multilingual speech recognition in the Basque context[C]∥2010 IEEE 15th Conference on Emerging Technologies & Factory Automation(ETFA 2010).Bilbao, Spain.IEEE, 2010: 1-8.

[4] LIU Danyang, XU Ji, ZHANG Pengyuan, et al.A unified system for multilingual speech recognition and language identification[J].Speech Communication, 2021, 127: 17-28.

[5] HINTON G, DENG Li, YU Dong, et al.Deep neural networks for acoustic modeling in speech recognition: The shared views of four research groups[J].IEEE Signal Processing Magazine, 2012, 29(6): 82-97.

[6] RABINER L R.A tutorial on hidden Markov models and selected applications in speech recognition[J].Proceedings of the IEEE, 1989, 77(2): 257-286.

[7] DAHL G E, YU Dong, DENG Li, et al.Context-dependent pre-trained deep neural networks for large-vocabulary speech recognition[J].IEEE Transactions on Audio, Speech, and Language Processing, 2012, 20(1): 30-42.

[8] MOHRI M, PEREIRA F, RILEY M.Speech recognition with weighted finite-state transducers[M]∥Springer Handbook of Speech Processing.Berlin,Heidelberg:Springer Berlin Heidelberg, 2008: 559-584.

[9] GRAVES A, FERN NDEZ S, GOMEZ F, et al.Connectionist temporal classification: Labelling unsegmented sequence data with recurrent neural networks[C]∥Proceedings of the 23rd international conference on Machine learning-ICML′06.Pittsburgh, Pennsylvania.New York: ACM Press, 2006: 369-376.

NDEZ S, GOMEZ F, et al.Connectionist temporal classification: Labelling unsegmented sequence data with recurrent neural networks[C]∥Proceedings of the 23rd international conference on Machine learning-ICML′06.Pittsburgh, Pennsylvania.New York: ACM Press, 2006: 369-376.

[10] GRAVES A.Supervised sequence labelling with recurrent neural networks[M].Berlin, Heidelberg: Springer Berlin Heidelberg, 2012.

[11] RAO K, SAK H, PRABHAVALKAR R.Exploring architectures, data and units for streaming end-to-end speech recognition with RNN-transducer[C]∥2017 IEEE Automatic Speech Recognition and Understanding Workshop(ASRU).Okinawa, Japan.IEEE, 2017: 193-199.

[12] SAK H, SENIOR A, BEAUFAYS F.Long short-term memory recurrent neural network architectures for large scale acoustic modeling[EB/OL].2014.https:∥www.researchgate.net/publication/279714069_Long_short-term_memory_recurrent_neural_network_architectures_for_large_scale_acoustic_modeling.

[13] BAHDANAU D, CHOROWSKI J, SERDYUK D, et al.End-to-end attention-based large vocabulary speech recognition[C]∥2016 IEEE International Conference on Acoustics,Speech and Signal Processing(ICASSP).Shanghai, China.IEEE, 2016: 4945-4949.

[14] CHAN W, JAITLY N, LE Q, et al.Listen, attend and spell: A neural network for large vocabulary conversational speech recognition[C]∥2016 IEEE International Conference on Acoustics, Speech and Signal Processing(ICASSP).Shanghai, China.IEEE, 2016: 4960-4964.

[15] WATANABE S, HORI T, KIM S, et al.Hybrid CTC/attention architecture for end-to-end speech recognition[J].IEEE Journal of Selected Topics in Signal Processing, 2017, 11(8): 1240-1253.

[16] VASWANI A, SHAZEER N, PARMAR N, et al.Attention is all you need[C]∥Advances in Neural Information Processing Systems, 2017: 5998-6008.

[17] DONG Linhao, XU Shuang, XU Bo.Speech-transformer: A no-recurrence sequence-to-sequence model for speech recognition[C]∥2018 IEEE International Conference on Acoustics, Speech and Signal Processing(ICASSP).Calgary, AB, Canada.IEEE, 2018: 5884-5888.

[18] ZHANG Qian, LU Han, SAK H, et al.Transformer transducer: A streamable speech recognition model with transformer encoders and RNN-T loss[C]∥ICASSP 2020-2020 IEEE International Conference on Acoustics, Speech and Signal Processing(ICASSP).Barcelona, Spain.IEEE, 2020: 7829-7833.

[19] YEH C F, MAHADEOKAR J, KALGAONKAR K, et al.Transformer-transducer: End-to-end speech recognition with self-attention[EB/OL].2019.https:∥www.researchgate.net/publication/336889211_Transformer-Transducer_End-to-End_Speech_Recognition_with_Self-Attention.

[20] WATANABE S, HORI T, HERSHEY J R.Language independent end-to-end architecture for joint language identification and speech recognition[C]∥2017 IEEE Automatic Speech Recognition and Understanding Workshop(ASRU).Okinawa, Japan.IEEE, 2017: 265-271.

[21] ZHOU Shiyu, XU Shuang, XU Bo.Multilingual end-to-end speech recognition with A single transformer on low-resource languages[EB/OL].2018.https:∥www.researchgate.net/publication/325754815_Multilingual_End-to-End_Speech_Recognition_with_A_Single_Transformer_on_Low-Resource_Languages.

[22] HOU Wenxin, DONG Yue, ZHUANG Bairong, et al.Large-scale end-to-end multilingual speech recognition and language identification with multi-task learning[C]∥Interspeech 2020.ISCA: ISCA, 2020: 1037-1041.

[23] LI Zheng, ZHAO Miao, HONG Qingyang, et al.AP20-OLR challenge: Three tasks and their baselines[EB/OL].2020: arXiv: 2006.03473[eess.AS].https:∥arxiv.org/abs/2006.03473.

[24] KARITA S , SOPLIN N , WATANABE S , et al.Improving Transformer-based End-to-End speech recognition with connectionist temporal classification and language model integration[C]∥Interspeech 2019.2019.

[25] WATANABE S, HORI T, KARITA S, et al.ESPnet: end-to-end speech processing toolkit[EB/OL].2018.https:∥www.researchgate.net/publication/327389077_ESPnet_End-to-End_Speech_Processing_Toolkit.

[26] PARK D S, CHAN W, ZHANG Yu, et al.SpecAugment: A simple data augmentation method for automatic speech recognition[C]∥Interspeech 2019.ISCA: ISCA, 2019: 2613-2617.