1 引言

在语音人机交互系统前加入语音分离系统以获得目标说话者的纯净语音,可以有效的提高人机交互系统的语音识别率。几十年来,单声道语音分离系统被广泛研究,提出了很多实用的方法。但现实中, 由于目标说话者所处环境通常可能较复杂,目标语音信号会收到各种噪声干扰。因此,在实际环境中,尤其是非平稳噪声存在时,语音分离技术仍面临巨大挑战[1],传统算法在语音分离中的提升相当有限。近年来,随着机器学习的发展,基于深度学习的语音分离方法获得巨大的进步,且其分离效果远超传统算法。

Wang等人全面概述了基于深度学习的语音分离算法,指出了当前基于神经网络的语音分离算法可同时分离出混合语音中所有的声音[2]。Hershey与Yu等人为规避标签置换问题,提出了深度聚类算法(DPCL),置换不变训练(PIT),分离出了混合语音中各个说话者的纯净语音[3-5]。前期的网络多基于短时傅里叶变换(STFT)后的时频域信号,但傅里叶变换多语音分离信号的最佳变换[6],时域端到端模型开始受到更多研究者们的关注。Luo首次提出了一种端到端的时域膨胀卷积分离网络(Conv-TasNet)[6-7]。随后Berkan等人与Pandey等人对Conv-TasNet的编解码器进行延展叠加,提高了更复杂信号的特征提取能力[8-9]。除了卷积网络之外,Luo等人提出的双路径循环神经网络(DPRNN)也展现了良好的上下文关联能力[10]。

相比于只有语音输入的模型,加入一路与输入语音相关的信号进行辅助提取,可以更好的分离出所需的目标语音,而不用将所有说话者全部分离。Wang等人尝试并成功在分离模型中增加一路声纹信号提取声纹对应的目标语音[11]。基于视觉信息对声学噪声不敏感、与语音内容高度相关的特性,很多学者使用音视频联合的语音分离算法获得了更出色的分离效果。Gabbay提出了一种通过视频信息将可见说话人的语音与背景噪声分离的扩展网络[12],Afouras等人通过堆叠深度方向可分离的卷积块构建了包括一个幅度估计网络[13]和一个相位估计网络[14],相比于仅分离幅值的网络在听觉上有较大改善。为避免长窗处理以及时频域处理的弊端,研究者们开始尝试端到端的时域分离模型。Wu等人使用预训练的唇部特征提取网络[15]与Conv-TasNet结合,对音视频融合后的特征进行降维映射,用时域替换时频域进行音视频联合语音分离[16]。范等人利用混合语音与网络输出信号的差值,通过仅分离一路语音信号,实现了多路语音的计算,避免了PIT问题,构建了一种端到端的时域网络[17]。

本文提出了一种端到端的音视频特征多次融合的模型,该网络基于Conv-TasNet,并加入视频信号作为语音分离辅助信号,创新性的提出了一种对视频特征与语音特征进行多次串联映射的方式获取目标语音掩码,同时提出了一种视频流特征连续性补充的方案,降低了视频信号中语音相关特征单次融合被忽略的可能性,提高了音频流与视频流之间的关联,并加入了门限对特征更好地建模、选择和整合有用的视听表示,提高了语音分离性能,最后进行实验对比验证。

2 音视频联合分离网络

2.1 分离网络整体构架

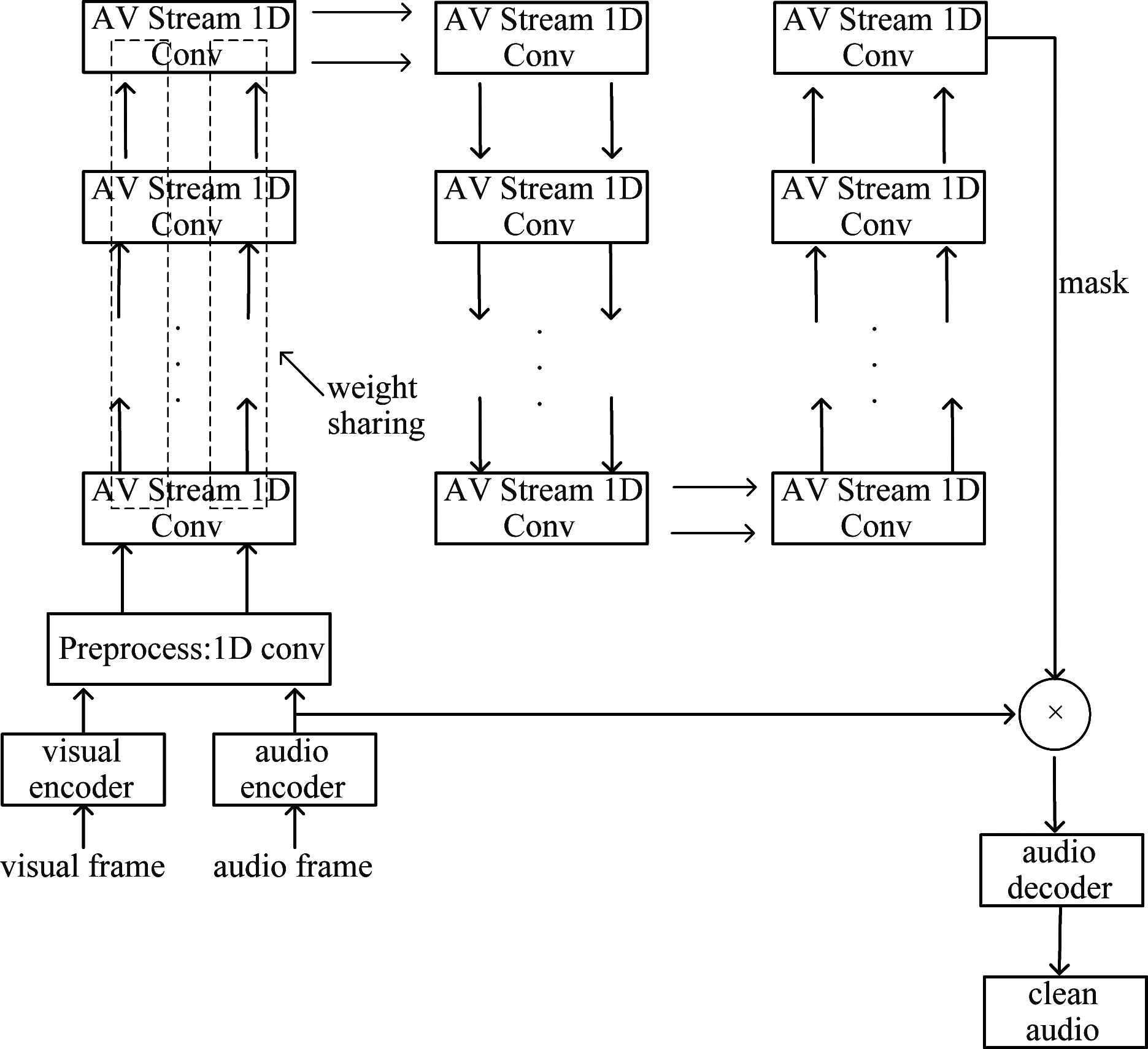

由于Conv-TasNet在语音分离中展现了极高的分离能力,且具有模型小、分离效果显著的特点,因此本文所构建模型是基于Conv-TasNet[13],并对其进行了改进,整体的网络构架如图1所示。

图1 语音分离网络整体构架

Fig.1 The flow chart of the separation network

从网络层次角度来讲,该模型由多流体系结构组成,该体系以检测到的唇部的视频流和混合的音频流作为输入,经过分离网络后输出时域掩码,该掩码对应视频流中的说话者,也即目标说话者。然后将混合音频的编码器输出结果在时域上乘以掩码,以得到目标说话人的分离的语音信号,同时抑制所有其他干扰信号,获得纯净语音的高维嵌入结果,经过解码器后得到时域的纯净语音,整个框架可以描述为式(1),

si=Decoder(Wx⊙mi)

(1)

其中,Wx为编码器得到的高维嵌入结果,mi为分离网络获得结果,两者可以表示为式(2)与式(3),

Wx=Encoder(w)

(2)

mi=Separator(Wx,vi)

(3)

这里,vi为视频流信息通过唇部特征提取器得到的结果,w为时域语音信号。

2.2 语音特征提取网络

在语音特征与视频特征融合之前,使用编码器对音频信号进行分段以及特征提取。语音特征提取网络采用编码器与解码器,对音频信号进行卷积与解卷积操作,编码器输入的混合音频信号进行高维嵌入与分段处理,解码器输入的掩码信号进行降维以及合并段处理。

编码器采用一维卷积进行代替STFT,设输入的混合语音为1×T维度的音频段,T为时间上的采样点,1代表输入通道数。一维卷积模块同时作为分段处理,设卷积核长度为K,卷积步长为S,为实现重叠分段的效果,使卷积步长S=K/2。设输出通道数为N,则输出的混合语音的维度为N×(2L/K-1),由于部分数据集内语音数据长度不一致,对该类语音进行末端填充,以获取同等维度的卷积输出结果。此外,在卷积结果后面增加整流线性单元PReLu函数,保证系统的非线性。解码器则进行相反的处理,来将维度为N×(2L/K-1)的掩码信号恢复成维度为1×T的纯净语音信号。

2.3 视频特征提取网络

视频编码器旨在从输入图像帧序列中提取视频特征vi。在本模型中,使用说话者的脸部说话视频信息,根据唇部说话的不同对需要的上下文和语音信息进行编码。该模型的视频编码器包含一个唇部特征提取器和一个时域卷积模块。

唇部嵌入提取器包括一个三维卷积层和一个残差网络(ResNet)层,类似于[14]中的工作。

卷积神经网络(CNN)可以提取足够丰富的视频特征,但随着CNN层数的增加,会出现梯度爆炸以及梯度消失等问题,He等人提出的残差神经网络ResNet可以有效的规避梯度爆炸[18]。在本模型中使用34层的ResNet,网络中包含33个卷积层以及1个全连接层,网络输出特征维度为256维。

本文中使用的唇部特征提取器是已经完成预训练的,与语音分离网络不同时进行训练。

通过唇部特征提取器后,提取器为每个视频帧输出256维特征向量,并将特征向量通过时间卷积块。该卷积块由一个时间卷积组成,之后是PReLU激活函数和批处理归一化来抑制梯度爆炸与消失的问题。在这里批处理归一化采用BN。为了减少模型参数,模型使用深度可分离卷积。在本文的设置中,视频特征提取块中所有卷积块选择卷积核大小为3,步幅大小为1和通道大小512。

2.4 掩码分离网络

分离网络旨在估计目标说话者的掩码。如图1中所示,分离网络中包括音视频信号预处理模块,多轮时间扩张的膨胀卷积模块,并提出了一种音视频多次融合的处理方式。下面对这几个模块进行详细介绍。

在音视频预处理模块中,对混合音频数据和视频特征数据进行一维深度膨胀卷积,类似TCN,该卷积块具有D个子块,其扩张指数增长因子为2d,其中d∈{0,1,...,D-1}。在本模型中,使用D=8的模型,每个子块的模型如下:包括一个一维卷积模块、PReLu激活函数、全局归一化层(gLN)和一个1×1Conv,输入输出的数据通道数保持相同,如图2所示。

图2 AV-stream 1D Conv模块

Fig.2 AV-stream 1D Conv block

卷积的膨胀性体现在一维卷积模块中,对于一组一维深度膨胀卷积,根据顺序每个子块的一维卷积模块的卷积核元素之间的间距为2d,保证卷积过程中收集到足够的上下文相关信息。

改进模型中相比于对传统的时间卷积网络(TCN)模块,本模型添加了一路约束信号,并将最后的卷积层替换为Sigmoid函数,以提高对有用特征的筛选以及对无用特征的滤除,实现整个模型中对目标说话者特征的更深层的提取。

预处理结束后,对视频特征信息进行上采样,保证与语音信息具有相同的时间分辨率,对处理后的视频特征信息和语音信息进行并行输入到多轮时间扩张的膨胀卷积模块中,该模块的每一个音视频流一维卷积模块(AV-stream 1D Conv)示意图均如图2所示。

2.5 音视频融合方式

AV-stream 1D Conv模块对输入的音频信号进行1×1 Conv,改变输入混合语音的通道数,对输入视频特征信号进行Sigmoid激活并分路,一路进行音视频融合,一路进行后续的处理。融合过程是通过在卷积通道尺寸上进行的特征维度串联操作来执行的,并进行位置投影以减小特征尺寸,该投影采用1×1 Conv实现,将串联得到的特征尺寸进行减半处理,相比于下采样,这种做法能够更好的融合两路信号的特征。融合后的混合信号进行PReLu和gLN处理,将负值正数化并在时间和通道维度上的特征标准化。将标准化后的结果通过两路一维深度膨胀卷积,为了能够更好的学习有用信息并滤除无用信息以模拟一种类似注意力的机制,将卷积后的其中一路加入Sigmoid函数后作为门控机制限制另一路的信息,并对两路输出结果求哈达玛积,来获取经筛选后的分离的必要信息。

另一路视觉信号则通过另一组一维深度膨胀卷积得到视频流的输出结果并与语音流一起作为下一个AV-stream 1D Conv模块的输入。该通路同时引入视频帧的输入作为残差,在避免梯度消失的同时将视频流的信息进行弥补,实现了视频流信息在整个模型中的连续性补充,保证模型每次音视频流融合时提取到新特征的可能性。

对于之前的联合模型,先前的所有研究中仅对两路信息进行一次特征维度连接并进行下采样,该做法势必会造成视频特征的丢失。在本文提出分离过程中,音视频进行多次联合处理,也即在每一个AV-stream 1D Conv块中都进行音视频的融合,同时对视频信号进行多次特征提取,这样保证了该模型细节特征提取的能力超过对比模型,同时加入的门控机制与多融合机制,可以使输出选择、集成更有用的信息。

AV-stream 1D Conv设置与TCN类似,将8个AV-stream 1D Conv模块设为1组,共重复3组,也即在每组中,音视频流共融合8次,对每个AV-stream 1D Conv模块中的深度卷积(Deep wise Conv)的卷积核元素之间的间距设置为2d(包括视频流、门控、语音流),实现膨胀。同时在每一组中加入纵向权值共享,如图1中虚线所示,即1组中的8个视频流和8个语音流的Deep wise Conv分别采用同样的权重,以减小整个模型的参数量。

在经过三组AV-stream 1D Conv,将最后一个AV-stream 1D Conv块在图2的左侧输出作为时域音频信号的掩码,掩码与编码器之后的结果进行相乘并解码,获得纯净的目标语音声音,因有视频流进行辅助,因此规避了排序问题。

2.6 客观评估标准

将解码器得到的估计值与真实值进行损失值计算,本模型使用尺度不变的信噪比(Si-SNR)用作训练目标函数以及评估函数[6],能够获得更可靠的分离质量,其定义为:

(4)

其中,st,se分别是原信号和估计值,并归一化为零均值,而α通过式(5)获得。

(5)

3 结果与分析

3.1 数据集建立

在实验中,本文使用开源的视频数据集GRID创建了训练数据集。本文数据集中不添加背景噪声,仅进行干净说话者的混合。本文将视频中的语音信号以及视频信号进行分离,将随机两个说话者的声音信号以介于-5 dB和5 dB之间的随机信噪比(SNR)进行混合来生成混合语音,总体分布服从以0 dB为中心的正态分布,并将声音主导方的视频帧信息,提取其唇部特征,作为视频流的输入数据。为增大数据集的随机性以及真实性,选择语音数据集中的10%,对其中的视频帧进行随机丢失,每条语音数据对应的视频流不超过该视频总帧数的10%。

3.2 训练参数设置

网络在3秒长的语音段和3秒长、每秒25帧的视频上训练。初始学习率设置为10-3,语音采样率为8 kHz。如果在3轮连续的训练内,验证集的准确性没有提高,则学习率将减半。优化器使用SGD优化器,损失函数使用Si-SNR。将视频帧裁剪到52×52大小的灰度图并且进行全局归一化处理以及方差归一化处理。其余模型中的超参数如表1所示。

表1 训练模型超参数设置

Tab.1 Training model parameter setting

符号参数解释参数值N编码器所用通道数256L编码器所用卷积核大小40B1∗1conv模块通道数128C分离说话者个数1H卷积模块通道数256P1D卷积模块卷积核大小3X一组AV-stream重复次数8Ra语音预处理次数1Rv视频预处理次数1RfAV-stream重复组数3Batch-size批处理量2

3.3 结果分析

鉴于TCN作为时域语音分离任务中表现名列前茅,本文使用相同的数据集在音视频联合的Conv-TasNet模型[13]上进行了分离训练以及评估,两种算法的相关比较如表2所示。

表2 本文模型与文献[13]模型比较

Tab.2 The compare of the article model and the model in paper[13]

模型损失值 评估值 模型大小本文模型11.56 dB10.21 dB35.4M文献[13]中的模型 10.92 dB9.79 dB32.0M

对于音视频联合的Conv-TasNet模型,设置编解码器的卷积核大小为40,与本文模型相同。设置其使用的唇部提取特征模型与本文所述模型为同一训练后的模型。两模型所设置的学习率以及优化函数相同,均使用Si-SNR作为评估标准且训练轮数相同。

由结果可见,本文所述模型相较于音视频联合的Conv-TasNet模型,不论是损失值还是评估值,都表现了更好的效果,在评估数据集上,该模型提高了0.43 dB的收益。这证明,使用音视频多次融合,确实可以提取出更多的单次融合所忽略的细节特征。但是本文模型由于引入了音视频多融合,使关于视频流的处理变得更加复杂,模型大小超过了音视频联合的Conv-TasNet的大小,但总体上相差不大。

为了验证视频通道对语音分离模型的辅助作用及其辅助程度,本文将模型的视频流去除掉,再次进行训练,并与添加视频流的模型进行比较,比较结果如表3所示。其中,不添加视频通道的网络架构仅在串联以及串联之后的一维卷积处有所省略,其余的网络结构以及超参数设置保持不变。

表3 添加视频流与去掉视频流比较

Tab.3 The compare of the model add visual stream and model without visual stream

模型损失值评估值添加视频流11.56 dB10.21 dB不添加视频流9.82 dB8.71 dB

通过结果证明,对模型增加视频流确实可以提高整个网络的分离能力,其分离能力能够提升1.5 dB左右。根据分析,这是因为视频信息中包含的特征与目标语音者所说语音的特征相似,两种特征进行比较、互补,可以辅助从混合语音中屏蔽其他说话者等不相干的信息。

此外,最终结果很大程度上取决于分离网络产生的目标语音者的掩码。对于同一个分离网络,影响分离结果的因素分别是归一化手段以及AV-stream 1D conv的组数,因此对这两个参数量进行改变。对于AV-stream 1D conv的组数,通过改变固定块总数,增加的值将带来更多融合特征的上下文信息。对Rf的数量进行改变,来探究对掩码效果的影响,其结果如表4所示。

表4 不同Rf下模型结果

Tab.4 The result of the different Rf

Rf损失值评估值110.80 dB9.90 dB211.22 dB9.95 dB311.56 dB10.21 dB411.73 dB9.93 dB

根据表中所示,在Rf为1、2、3的过程中,符合随着分离块的增加,损失值与评估值一起增加的特性,但是当Rf为4时,虽然损失值优于Rf为3的模型,但是评估性能却降低。这有可能是由于分离块增加,从而导致了网络在训练过程中出现了局部过拟合的情况,导致在不同数据集上的分离性能降低。因此,可以预估Rf为3时产生的模型具有更优的性能,这与wu等人的模型[13]所得到的结果是一致的。

4 结论

本文提出了一种基于时域音视频联合的语音分离模型,其架构结合了原始混合语音波形和目标说话人的视频流,可以直接预测目标语音波形,规避了STFT域语音分离的缺点,包括相位和幅度的解耦,以及计算STFT的高延迟等问题。本文所述模型基于Conv-TasNet,弥补了当前音视频联合的语音分离模型中对视频信息特征提取不够的问题,创新性的提出了音视频多次融合的手段。依据视频特征中仍包含有与语音相关的特征信息,在网络中对语音流进行分离的同时对视频流进行深度的特征提取,在整个网络过程中进行多次提取,每次提取后与语音信息进行融合。实验发现,使用多次融合所分离出的结果要优于当前音视频单次融合网络分离所得到的结果,带来了0.4 dB的性能提升。

[1] 刘文举, 聂帅, 梁山, 等.基于深度学习语音分离技术的研究现状与进展[J].自动化学报, 2016, 42(6): 819-833.

LIU Wenju, NIE Shuai, LIANG Shan, et al.Deep learning based speech separation technology and its developments[J].Acta Automatica Sinica, 2016, 42(6): 819-833.(in Chinese)

[2] DELFARAH M, WANG Deliang.Features for masking-based monaural speech separation in reverberant conditions[J].IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2017, 25(5): 1085-1094.

[3] HERSHEY J R, CHEN Zhuo, LE ROUX J, et al.Deep clustering: Discriminative embeddings for segmentation and separation[C]∥2016 IEEE International Conference on Acoustics, Speech and Signal Processing(ICASSP).Shanghai, China.IEEE, 2016: 31-35.

[4] YU Dong, KOLB☞K M, TAN Zhenghua, et al.Permutation invariant training of deep models for speaker-independent multi-talker speech separation[C]∥2017 IEEE International Conference on Acoustics, Speech and Signal Processing(ICASSP).New Orleans, LA, USA.IEEE, 2017: 241-245.

[5] KOLBAEK M, YU Dong, TAN Zhenghua, et al.Multitalker speech separation with utterance-level permutation invariant training of deep recurrent neural networks[J].IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2017, 25(10): 1901-1913.

[6] LUO Yi, MESGARANI N.TaSNet: time-domain audio separation network for real-time, single-channel speech separation[C]∥2018 IEEE International Conference on Acoustics, Speech and Signal Processing(ICASSP).Calgary, AB, Canada.IEEE, 2018: 696-700.

[7] LUO Yi, MESGARANI N.Conv-TasNet: Surpassing ideal time-frequency magnitude masking for speech separation[J].IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2019, 27(8): 1256-1266.

![]() B, HORGAN M, LIU Xiaoyu, et al.An empirical study of conv-tasnet[C]∥ICASSP 2020-2020 IEEE International Conference on Acoustics, Speech and Signal Processing(ICASSP).Barcelona, Spain.IEEE, 2020: 7264-7268.

B, HORGAN M, LIU Xiaoyu, et al.An empirical study of conv-tasnet[C]∥ICASSP 2020-2020 IEEE International Conference on Acoustics, Speech and Signal Processing(ICASSP).Barcelona, Spain.IEEE, 2020: 7264-7268.

[9] PANDEY A, WANG Deliang.TCNN: temporal convolutional neural network for real-time speech enhancement in the time domain[C]∥ICASSP 2019-2019 IEEE International Conference on Acoustics, Speech and Signal Processing(ICASSP).Brighton, UK.IEEE, 2019: 6875-6879.

[10] LUO Yi, CHEN Zhuo, YOSHIOKA T.Dual-path RNN: Efficient long sequence modeling for time-domain single-channel speech separation[C]∥ICASSP 2020-2020 IEEE International Conference on Acoustics, Speech and Signal Processing(ICASSP).Barcelona, Spain.IEEE, 2020: 46-50.

[11] WANG Quan, MUCKENHIRN H, WILSON K, et al.VoiceFilter: targeted voice separation by speaker-conditioned spectrogram masking[C]∥Interspeech 2019.ISCA: ISCA, 2019: 1101-1105.

[12] GABBAY A, SHAMIR A, PELEG S.Visual speech enhancement[C]∥Interspeech 2018.ISCA: ISCA, 2018: 1170-1174.

[13] EPHRAT A, MOSSERI I, LANG O, et al.Looking to listen at the cocktail party[J].ACM Transactions on Graphics, 2018, 37(4): 1-11.

[14] AFOURAS T, CHUNG J S, ZISSERMAN A.The conversation: Deep audio-visual speech enhancement[C]∥Interspeech 2018.ISCA: ISCA, 2018: 1400-1404.

[15] STAFYLAKIS T, TZIMIROPOULOS G.Combining residual networks with LSTMs for lipreading[C]∥Interspeech 2017.ISCA: ISCA, 2017: 85-89.

[16] WU Jian, XU Yong, ZHANG Shixiong, et al.Time domain audio visual speech separation[C]∥2019 IEEE Automatic Speech Recognition and Understanding Workshop(ASRU).Singapore.IEEE, 2019: 667-673.

[17] 范存航, 刘斌, 陶建华,等.一种基于卷积神经网络的端到端语音分离方法[J].信号处理, 2019, 35(4):542-548.

FAN Cunhang, LIU Bin, TAO Jianhua, et al.An end-to-end speech separation method based on convolutional neural network[J].Journal of Signal Processing, 2019, 35(4):542-548.(in Chinese)

[18] SZEGEDY Christian, LOFFE Sergey, VANHOUCKE Vincent, et al.Inception-v4, Inception-ResNet and the impact of residual connections on learning[C]∥International Conference on Learning Representations(ICLR).Puerto Rico.ICLR, 2016:1-12.