1 引言

音频超分辨率的目标是为给定低分辨率信号重建丢失的高频分量,扩大输入音频信号的频率范围,也称带宽扩展。高质量的音频数据需求随着智能音频设备以及生活品质的提升日益增长,以此来满足听觉输入的普遍性。音频超分辨率在语音移动端、压缩传输和智能语音处理前端都有非常重要的作用,能提高电信质量。目前电话信道的标准带宽为4 kHz,在保障低频信息被传递的同时,节省传输带宽[1],但人们追求更高分辨率的通话质量。窄带范围的通信严重影响了听觉障碍人群,以及人工耳蜗用户的音频识别率[2]。在音频合成任务和消费者数字媒体背景下,需要极端带宽扩展,如44.1 kHz或48 kHz[3]。消费者水平的录音设备也只能提供较低带宽,满足不了现在的娱乐体验。

传统的带宽扩展方法如码本映射[4]、高斯混合[5]和隐马尔可夫模型[7]、与神经网络[8-11]相比,这些方法的性能通常更差。音频超分辨率任务现有的大多数研究都在频域中工作,部分研究的想法借鉴了图像超分辨率领域的最新研究。ASRNet[8]将任务建模为残差跳过连接的深卷积神经网络,方法被证明大大优于传统的插值方法。Sefik Emre Eskimez et al.[11]提出了一种以log power spectrogram(LPS)作为输入,并生成相应的高频范围LPS的对抗网络结构,它工作在频域上,需要手动提取特征,不满足端到端设计。Aaron van den Oord et al.[12]提出的完全自回归生成音频波形的方法和样本RNN[13]的引入,激励了部分音频生成研究转移到时域当中,最近的工作直接在时域上探索音频超分任务。类似WaveNet的方法为了保证效率,只能以较低的采样率合成音频。Ling et al.[14]等将分层循环神经网络应用音频超分辨率任务当中,但是遇到了过度平滑问题,在信噪比低的较嘈杂语音段,模型学习转移到整体分布当中,无法学习高频数据分布,重建细节特征。Kuleshov et al.[8]提出了一种基于深度ResNet的编解码型卷积神经网络,直接工作在波形上,以窄带波形作为输入预测宽带波形。其中的Encoder部分由若干卷积层和池化层组成,这种局部运算,需要堆叠多层来提取长特征信息,该方法参数量、计算量大,且感知质量不高。还有部分研究将时域和频域相结合。如Lim et al.[9]提出了一种时频网络结构TFNet,在时间和频率两个方向上都利用带监督的深层网络结构,进行联合优化。Berthy Feng et al.[3]等基于波形采用三路分割求和的FFTNet[15]结构,另外添加了对数梅尔谱图的感知损失,将时域和频域结合起来,激励了更具感知质量的输出。文章提出未来的工作寻找替代感知损失的方法,其中就有对抗损失,这指明了本文研究的方向。

本文直接工作在音频波形上,提出了端到端的基于FFTNet-GAN的网络架构,成功适应了音频超分辨率任务。相比于SEGAN[16]和WaveNet[17,12]中存在的局限性如:缺乏对时域结构的重视和高复杂性的非实时性[18]。模型通过对原始波形的音频超分辨率任务进行建模,在保证输入输出维度一致的情况下,能避免频域带来的相位失配问题,模型可以处理2x/4x/6x倍分别对应于8 kHz~16 kHz、8 kHz~32 kHz、8 kHz~48 kHz的,以及和基线模型对比的8 kHz~44.1 kHz带宽扩展。基于FFTNet设计的生成器结构,能够保证原有FFTNet并行、非因果和浅层网络结构的优点,降低了训练开销和模型计算复杂度,通过引入生成对抗网络结构(GANs,Generative Adversarial Nets)[19],设计匹配判别器模型,稳定并进一步提高模型性能;同时增添频域感知损失,与样本空间损失固定加权,来控制音频失真对重建高频的相对重要性,提高了基于波形工作的感知质量。结果表明该方法在主客观评价方面均优于基线方法。

2 系统模型

2.1 网络结构

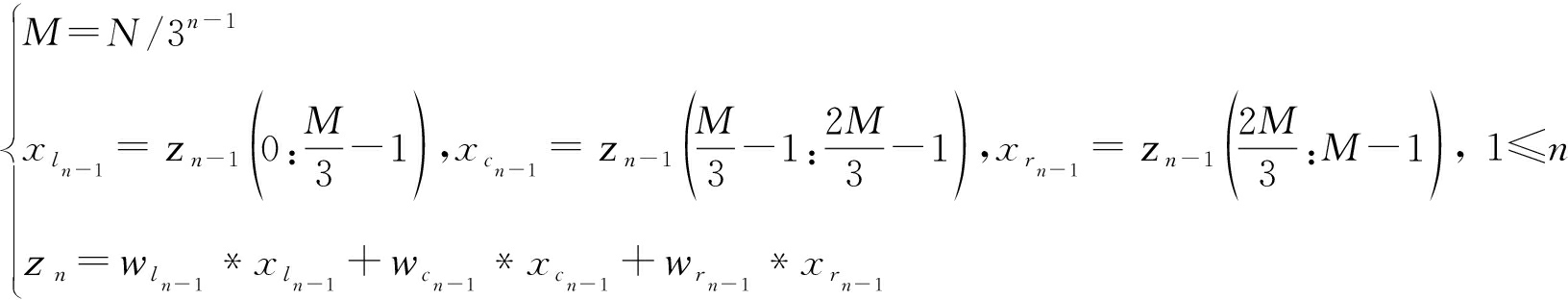

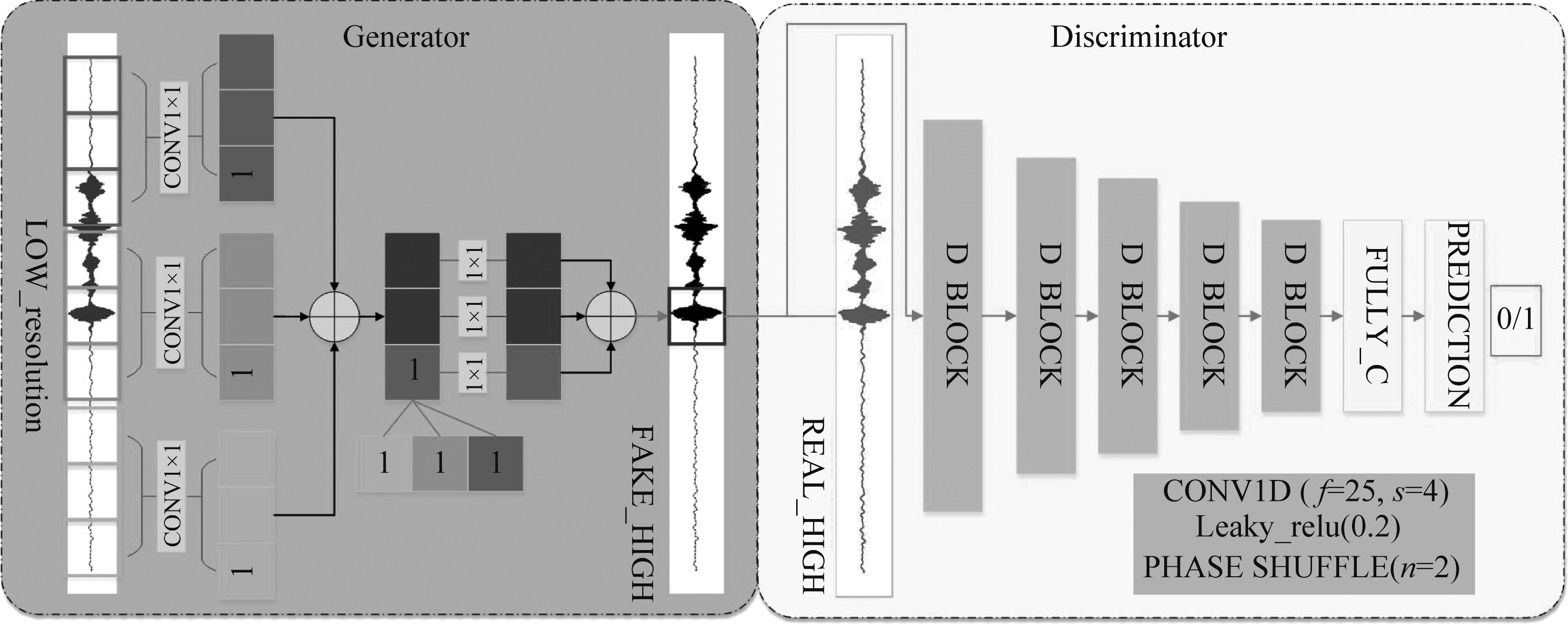

基于FFTNet设计的生成器,与传统基于波形域模型采用的局部运算提取邻近样本特征不同,模型考虑了输入样本之间较大的间隔,具有捕获高级声学特征的能力。FFTNet最开始的双路分裂求和[15]只能满足自回归的波形生成,输入输出不直接对应,超分辨率任务要求输入输出维度保持一致,我们使用了三路分裂求和的FFTNet[3]作为模型的生成器,其也为本文基线模型,如图1左。该生成器是一个序列到序列的模型,假设输入序列xN=(x0,x1,...,xN-1),本文序列长度N=16384,将输入序列xN分成三份,每份大小为N/3,对每份采用1×1卷积和激活变换相加后得到大小为N/3的向量。该向量继续相同的分裂、不同的1×1卷积和激活变换求和产生大小为N/9的向量。如此迭代,迭代过程如下,直到预测得到该输入样本之后大小为1的下一个样本输出。

z0=xN

(1)

图1 FFTNet-GAN网络结构

Fig.1 The network structure of FFTNet-GAN

其中,wln-1,wcn-1,和wrn-1分别表示第n次分割后左块xln-1,中块xcn-1,右块xrn-1的1×1卷积核权重,zn表示第n-1次分割时序列, M表示第n-1次分割时序列长度。

本文任务,使用GANs架构在有损观测的情况下重建高频细节信号。尽管GANs这种结合了对抗损失的架构相比传统的独立样本空间损失,能够改善重建细节效果,不会造成过平滑。但本文在设计判别器与生成器对抗训练时,都出现了大波动、不稳定、发散不收敛的问题,首先这和GANs本身难以训练有关,最主要是设计的判别器和生成器能力需要平衡,否则会造成生成器损失快速发散。对此我们设计了图1右所示的判别器模型。

判别器模型被训练用以区分ground-truth的高分辨率样本和生成器生成的假的超分辨率音频。本文设计了匹配生成器性能的判别器,以稳定GAN结构。判别器包括五个卷积层和一个全连接层,每个矩形块代表一层,其结构颜色编码在图1右子图。因为判别器训练之后被遗弃,本文使用多尺度卷积而不是跨步卷积,最小化损失梯度中的伪影影响。所有的激活函数都是LeakyReLU,其中负值非零斜率α取0.2,后接PHASE SHUFFLE层进行过采样。本文判别器模型类似WaveGAN[20]的判别器,这种长CONV1D滤波器能够捕获音频周期性质,1D内核计算成本较低,可在CPU和移动设备上对网络进行实时处理。

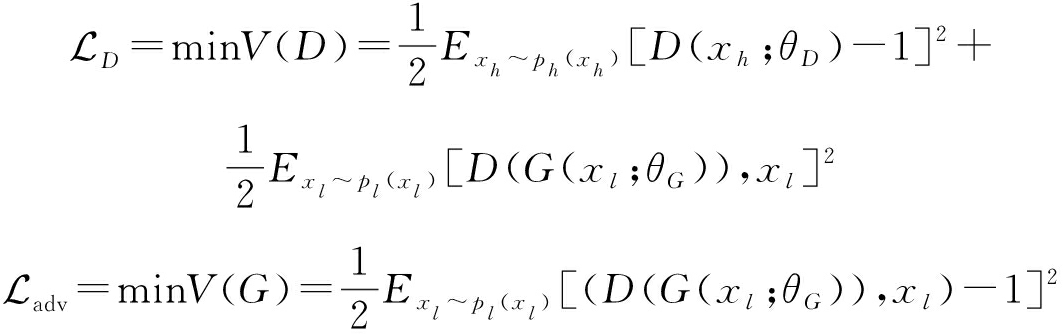

2.2 目标函数

生成对抗网络为生成器G和判别器D之间的极大极小值博弈。该框架联合训练G和D,G试图从真实分布中生成足够真实的样本,D一直优化区分真假样本的能力,以估计给定样本来自真实样本而不是由G合成的概率。直至G可以假乱真,D无法区分真假时,达到纳什均衡。对于音频超分辨率任务,G学习到高分辨率数据空间ph为G(xl;θG)的映射,其中低分辨率数据xl来源于空间分布pl;D被设计成从真实高分辨率数据分布ph和生成器生成的超分辨率数据分布pg中区分样本。对真实高分辨率样本数据xh下采样得到xl,我们期望最终的生成器能够达到G(xl;θG)≈xh,θG和θD分别表示G和D参数,对G和D进行极大极小值优化:

![]()

Exl~pl(xl)[log(1-D(G(xl;θG)))]

(2)

为了进一步提高稳定性,采用LSGAN[21]将判别器D的交叉熵损失函数替换为最小二乘损失:

(3)

样本空间![]() 损失即内容损失

损失即内容损失![]() 被设计成预测样本和真实样本之间的波形差异,以鼓励G生成更细粒度和真实的结果。本文首先训练生成器网络几个epochs的

被设计成预测样本和真实样本之间的波形差异,以鼓励G生成更细粒度和真实的结果。本文首先训练生成器网络几个epochs的![]() 损失来初始化,避免不需要的局部极小值产生较平滑的结果,保证低频部分的完整性。

损失来初始化,避免不需要的局部极小值产生较平滑的结果,保证低频部分的完整性。

(4)

与基线模型相比,仅使用样本空间![]() 损失和对抗损失

损失和对抗损失![]() 整体性能几乎没有改进。对抗模型被训练致力于重建高频信号,存在过估计和语意不符,将会引入较为持久的可听伪影,降低信噪比。因此我们用固定加权损失来控制语音失真对重建高频的相对重要性,为生成器设计了一个合适的损失函数

整体性能几乎没有改进。对抗模型被训练致力于重建高频信号,存在过估计和语意不符,将会引入较为持久的可听伪影,降低信噪比。因此我们用固定加权损失来控制语音失真对重建高频的相对重要性,为生成器设计了一个合适的损失函数![]() 将内容损失

将内容损失![]() 和感知损失

和感知损失![]() 按照相应权重与传统对抗损失相加,其中感知损失

按照相应权重与传统对抗损失相加,其中感知损失![]() 被定义为生成器生成的超分辨率音频G(xl;θG)和xh的对数梅尔谱图的

被定义为生成器生成的超分辨率音频G(xl;θG)和xh的对数梅尔谱图的![]() 损失。

损失。

(5)

3 实验结果与分析

为了与基线FFTNet模型[3]进行对比,本文同样在Device and Produced Speech(DAPS)[22]数据集下训练了8 kHz~44.1 kHz音频超分辨率任务,该数据集由20个(10男10女)说话人,每人阅读5个公共故事,每人约14min的录音数据,初始采样率为88.2 kHz,本文使用该44.1 kHz下采样版本。同时还在VCTK Corpus[23]数据集的特定部分上进行了不同重建倍数的任务,该数据集包含109个不同口音英语使用者,每人400句的语音数据,录音格式为16位48 kHz WAV文件,为了保证模型的鲁棒性我们采用了不同说话人数据来评估我们的模型。本文实验除了恢复8 kHz~16 kHz传统可懂度外,还能恢复8 kHz~32 kHz,8 kHz~44.1 kHz,以及8 kHz~48 kHz更高更细的感知质量和清晰度。采用三个性能指标来评判模型效果。

3.1 客观评判

A. SNR(signal-to-noise ratio),信噪比

(6)

其中xp和xh表示超分辨率信号G(xl;θG)和真实高分辨率信号,xp是参考信号xh的近似,SNR越高表示信号越清晰。

B. LSD(log-spectral distance),对数谱距离

LSD(xh,xp)=![]()

(7)

LSD表示信号频率之间的差异,作为一种距离评判信号的重建效果,相对信噪比能够表示更好的感知质量。其中Xh和Xp表示xh与xp的LPS,l和k表示窗口和频率索引,L是帧总数,K是frequency bins的数目。

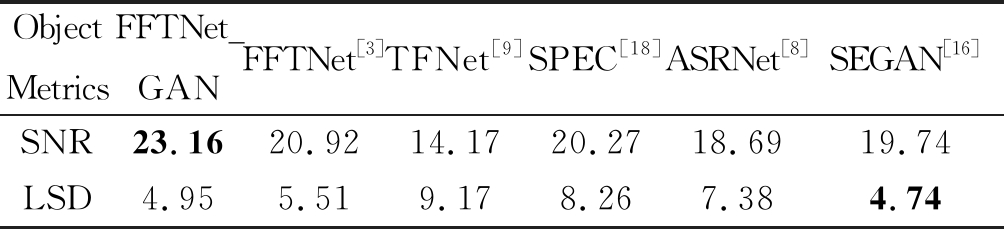

表1 基于DAPS数据训练的8 kHz~44.1 kHz任务的客观评价

Tab.1 Objective evaluation of 8 kHz~44.1 kHz task trained on DAPS data

Object MetricsFFTNet_GANFFTNet[3]TFNet[9]SPEC[18]ASRNet[8]SEGAN[16]SNR23.1620.9214.1720.2718.6919.74LSD4.955.519.178.267.384.74

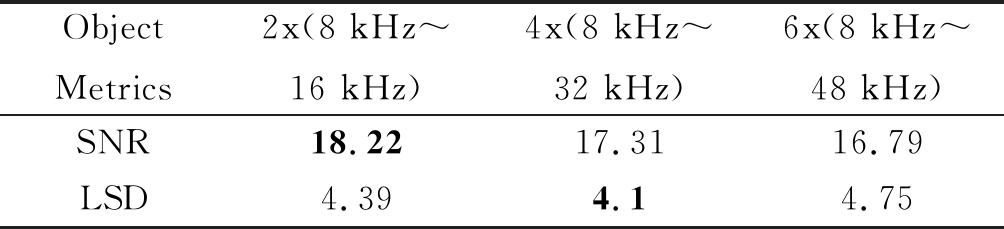

表2 基于VCTK数据训练的FFTNet-GAN模型2x/4x/6x倍重建任务的客观评价

Tab.2 Objective evaluation of 2x/4x/6x times reconstruction task of FFTNet-GAN model trained on VCTK data

Object Metrics2x(8 kHz~16 kHz)4x(8 kHz~32 kHz)6x(8 kHz~48 kHz)SNR18.2217.3116.79LSD4.394.14.75

本文从SNR和LSD两个客观评价指标综合评判FFTNet-GAN模型。表1所示,FFTNet-GAN的SNR指标在对比的所有模型中最高,比基线模型高约2个指标,同时其LSD指标与SEGAN[18]模型相当。说明该模型在此数据集上优于现有的模型,性能较基线FFTNet[3]有较大的提高。为了验证模型的鲁棒性,另外在其他训练集上对模型进行了评估,且让训练和测试样本来自不同的说话人,检验模型的泛化能力,还训练不同倍数重建模型,检验模型在不同采样率下的极端表现能力。根据表2,从中可以观察到,模型的LSD指标表现良好,SNR指标偏低,这表明FFTNet-GAN在重建过程中,偏离的样本距离导致合成更具感知相关的频率分量,但同时降低了信噪比。综合表明,生成模型适合预测出数据点之间的新值,SNR明显增大不少,得到更加清晰的音频。同样的数据训练下FFTNet-GAN比基线模型FFTNet[4]表现更佳,且优于现有的模型[8-9,18],同时其具有较强的鲁棒性和很好的泛化性能,能承担极端音频超分辨率重建任务。

表3 基于DAPS数据训练的8 kHz~44.1 kHz任务的主观评价

Tab.3 Subjective evaluation of 8 kHz~44.1 kHz task trained on DAPS data

Subjective MetricsGround-truthFFTNet_GANFFTNet[3]TFNet[9]SPEC[18]ASRNet[8]SEGAN[16]MOS4.674.244.093.353.793.744.14

3.2 主观评判

C.MOS(Mean Opinion Score),平均主观意见分在国际标准中,统一使用MOS值来评价系统接收到的经过压缩后的话音质量。本文的主观评价指标采用MOS,测试质量评级为1~5。受听力测试人员共57,实际有效54份,人员年龄集中18~28岁,且男女比例均衡,从事和研究不同专业领域,测试过程随机、单盲,得到的测试结果真实可靠。

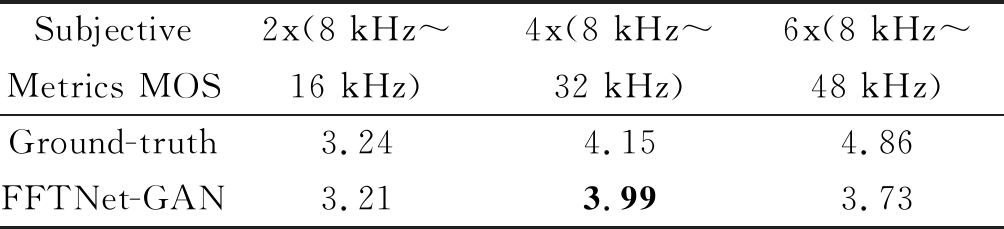

从表3可以看到,听众更喜欢FFTNet-GAN产生得音频,相比基线FFTNet[3]和其他模型方法[8-9,16,18],更接近真实样本的评价。结合表4,模型在其他数据集上,2x和4x倍的还原效果和真实非常接近;在极端的6x倍重建任务中,主要因为48 kHz的真实样本过于清晰真实,重建的音频相比之下,主观感受会受其影响,评价相对真实样本偏低。FFTNet-GAN生成的样本,总体主观评价和真实样本更加接近。SEGAN[16]模型和本文的模型,也表明生成模型在音频重建任务中的突出能力。

表4 基于VCTK数据训练的FFTNet-GAN模型

2x/4x/6x倍重建任务的主观评价

Tab.4 Subjective evaluation of 2/4/6 times reconstruction task of FFTNet-GAN model trained on VCTK data

Subjective Metrics MOS2x(8 kHz~16 kHz)4x(8 kHz~32 kHz)6x(8 kHz~48 kHz)Ground-truth3.244.154.86FFTNet-GAN3.213.993.73

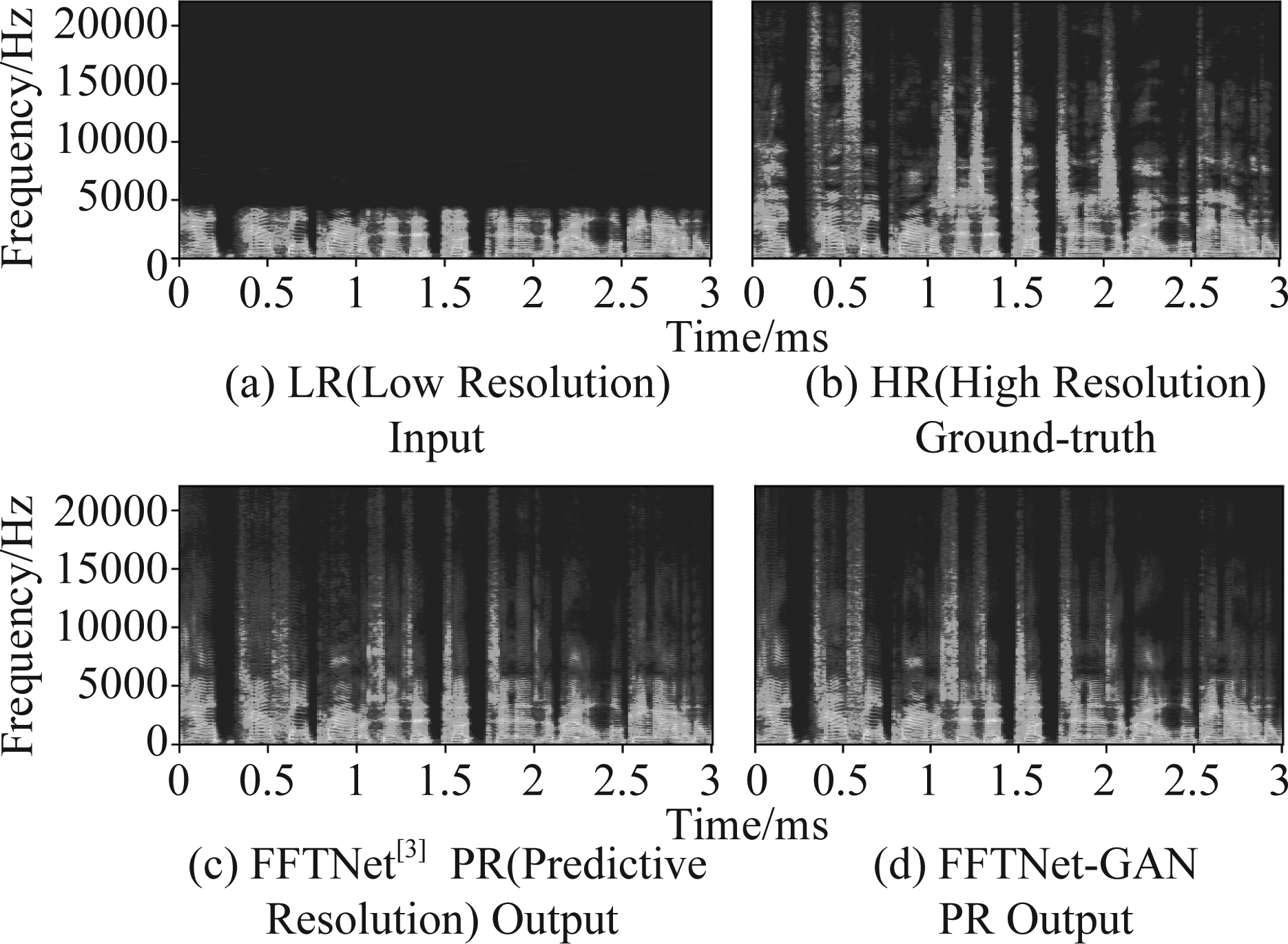

图2 基于DAPS数据训练的8 kHz~44.1 kHz重建语谱图

对比(FFTNet-GAN与基线FFTNet[3]模型), 其中

LR、HR、PR分别表示xl、xh、xp的语谱图

Fig.2 Comparison of 8 kHz~44.1 kHz reconstructed spectrogram trained on DAPS data (based on FFTNet-GAN and baseline FFTNet[3] model), where LR, HR and PR respectively represent the spectrogram of xl, xh and xp

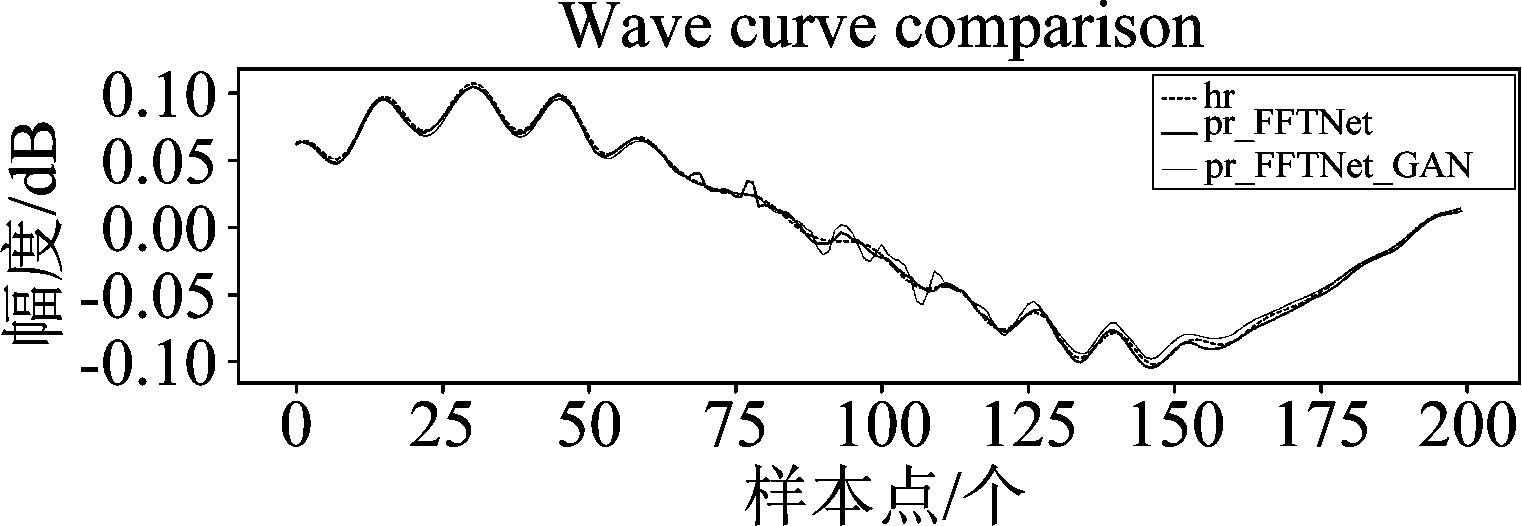

图3 FFTNet-GAN与基线FFTNet[3]模型重建波形

和真实波形对比,其中hr和pr分别表示xh、xp的波形

Fig.3 Comparison of reconstructed and real waveforms between FFTNet-GAN and baseline FFTNet[3] models, where hr and pr respectively represent the waveform of xh and xp

结合上述所有实验我们已经证明本文提出的FFTNet-GAN模型在音频超分辨任务中的重建能力,其主要的功能还是来自其中的三路分裂求和FFTNet[3]生成器模型,设计了匹配的判别器模型,适应了生成对抗网络结构并稳定训练,其次固定加权损失来控制音频失真对重建高频的相对重要性,保证了模型的感知质量和实际效果。从图2中,可以清晰的看到本文FFTNet-GAN产生了比基线FFTNet更加逼真的语谱图,细节更为精细突出,包含更多的能量。但是音频信号是连续相关的,含有非常丰富的细节信息,且具有在波峰和波谷附近密集的特点。离散的音频数据得到的是交替变化的极大极小值,同时预测正确的值应该是在最大值和最小值之间,否则得到的就是不相关的数据信号,这会造成SNR的显著下降和LSD明显的增加,如图3所示。这是因为GAN的特性造成的,其会造成一定的过估计和部分语义不符,细节锐利,在评价上会有所波动。将模型扩展到基于VCTK数据的2x/4x/6x倍重建任务,语谱图如图4所示,结合表2符合客观评价。随着重建任务难度提升,模型SNR指标变低,偏离的样本距离导致合成更具感知相关的频率分量,表现在4x倍比2x任务语谱图更符合真实情况,同时过估计和语义不符程度增加,6x波动更大,生成的语谱图过于细节,造成了LSD指标的增高。

图4 基于VCTK数据训练的FFTNet-GAN模型的重建语谱图对比(8 kHz~16 kHz, 8 kHz~32 kHz, 8 kHz~48 kHz)

Fig.4 Comparison of reconstructed spectrogram of FFTNet-GAN model trained on VCTK data

(8 kHz~16 kHz, 8 kHz~32 kHz, 8 kHz~48 kHz)

4 结论

音频超分辨率方法对音频高质量重建效果起着重要的作用,直接影响音频压缩、传输效率等问题,间接影响听者的感受和后期处理效果。本文提出了一种基于时域的FFTNet-GAN模型来实现音频超分辨率任务,模型采用了并发、非因果、非局部运算的FFTNet[3]生成器模型,设计了匹配性能的判别器,稳定适应生成对抗架构,同时添加了基于频域的感知损失,与样本空间损失固定加权减少重建失真和提高感知质量。实验表明该模型优于基线模型和现有方法,作为一种高质量重建音频高频信号的方法,能够对不同类型、不同采样率的低频信号实现多倍高频重建。未来工作把模型推广至广义的语音增强任务中,将这种参数少、浅层的FFTNet生成模型和GANs结构结合起来,胜任多任务学习。

[1] BERND Iser, GERHARD Schmidt. Bandwidth Extension of Telephony Speech[J]. In Speech and Audio Processing in Adverse Environments, 2008: 135-184.

[2] LIU Chuping, FU Qianjie, SHRIKANTH S Narayanan. Effect of Bandwidth Extension to Telephone Speech Recognition in Cochlear Implant Users[J]. The Journal of the Acoustical Society of America, 2009, 125(2): 77-83.

[3] FENG Berthy, JIN Zeyu, SU Jiaqi, et al. Learning Bandwidth Expansion using Perceptually-motivated Loss[C]∥ICASSP 2019-2019 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). IEEE, 2019: 606-610.

[4] BERND Iser, GERHARD Schmidt. Neural Networks Versus Codebooks in an Application for Bandwidth Extension of Speech Signals[C]∥8th European Conference on Speech Communication and Technology, EUROSPEECH 2003-INTERSPEECH 2003, Geneva, Switzerland, September 1-4, 2003. 2003: 565-568.

[5] LIU Xin, BAO Changchun, JIA MaoShen, et al. A Harmonic Bandwidth Extension Based on Gaussian Mixture Model[C]∥IEEE 2010 10th International Conference on Signal Processing (ICSP 2010)-Beijing, China, 2020: 474-477.

[6] JAX P, VARY P. Artificial Bandwidth Extension of Speech Signals using MMSE Estimation Based on a Hidden Markov Model[C]∥IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). IEEE, 2003: I-680-I-683.

[7] PARK S C, MIN K P, KANG M G. Super-resolution Image Reconstruction: A Technical Overview[J]. IEEE Signal Processing Magazine, 2003, 20(3): 21-36.

[8] KULESHOV V, ENAM S Z, ERMON S . Audio Super Resolution using Neural Networks[J]. arXiv preprint arXiv: 1708.00853, 2017.

[9] LIM T Y, YEH R A, XU Y, et al. Time-Frequency Networks for Audio Super-Resolution[C]∥ICASSP 2018-2018 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). IEEE, 2018: 646-650.

[10] WANG Mu, WU Zhiyong, KANG Shiyin, et al. Speech Super-Resolution Using Parallel WaveNet[C]∥2018 11th International Symposium on Chinese Spoken Language Processing (ISCSLP), 2018: 260-264.

[11] ESKIMEZ S E, KOISHIDA K. Speech Super Resolution Generative Adversarial Network[C]∥ICASSP 2019-2019 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). IEEE, 2019: 3717-3721.

[12] AARON van den Oord, SANDER Dieleman, HEIGA Zen, et al. WaveNet: A Generative Model for Raw Audio. arXiv preprint arXiv: 1609.03499, 2016.

[13] DONG C, LOY C C, HE K, et al. Learning a Deep Convolutional Network for Image Super-Resolution[C]∥European Conference on Computer Vision(ECCV). Springer, 2014: 184-199.

[14] LING Zhenhua, AI Yang, GU Yu, et al. Waveform Modeling and Generation Using Hierarchical Recurrent Neural Networks for Speech Bandwidth Extension[J]. IEEE/ACM Transactions on Audio Speech & Language Processing, 2018, 26(5): 883-894.

[15] JIN Zeyu, FINKELSTEIN A, MYSORE G J, et al. Fftnet: A Real-Time Speaker-Dependent Neural Vocoder[C]∥ICASSP 2018-2018 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). IEEE, 2018: 2251-2255.

[16] PASCUAL S, BONAFONTE A, SERRA J. SEGAN: Speech Enhancement Generative Adversarial Network. arXiv preprint arXiv: 1703.09452, 2017.

[17] RETHAGE D, PONS J, SERRA X. A Wavenet for Speech Denoising[C]∥ICASSP 2019-2019 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). IEEE, 2018: 5069-5073.

[18] LI Kehuang, LEE Chin-Hui. A Deep Neural Network Approach to Speech Bandwidth Expansion[C]∥ICASSP 2015-2015 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP).IEEE, 2015: 4395- 4399.

[19] GOODFELLOW I J, POUGET-ABADIE J, MIRZA M, et al. Generative Adversarial Nets[C]∥NIPS 2014 International Conference on Neural Information Processing Systems(NIPS), 2014: 2672-2680.

[20] YAMAMOTO R, SONG E, KIM J M. Parallel WaveGAN: A Fast Waveform Generation Model Based on Generative Adversarial Networks with Multi-Resolution Spectrogram[J]. arXiv: 1910.11480, 2019.

[21] MAO Xudong, LI Qing , XIE Haoran, et al. Least Squares Generative dversarial Networks[C]∥IEEE International Conference on Computer Vision(ICCV). IEEE, 2017:2813-2821.

[22] MYSORE, GAUTHAM J. Can we Automatically Transform Speech Recorded on Common Consumer Devices in Real-World Environments into Professional Production Quality Speech?-A Dataset, Insights, and Challenges[J]. IEEE Signal Processing Letters, 2015: 1006-1010.

[23] JUNICHI Yamagishi. CSTR VCTK corpus. https: ∥datashare.

is.ed.ac.uk/handle/10283/1942.