1 引言

在人机对话系统、车载系统、视频会议系统和助听器等人工智能应用中,混响是一个会影响语音信号可理解性的关键因素,甚至极大地降低了环绕立体声电影院的立体声效果[1]。因此,去混响方法已成为语音增强和语音识别等领域的研究重点[2]。

混响(Reverberation)是指麦克风所接收的除了声源发出的直达波以外,通过反射产生相位延迟和幅度衰减的非直达波。到目前为止,人们提出了许多语音去混响的办法。第一类为正则化多通道声学均衡语音去混响及其改进算法,该方法通过形成房间均衡冲击响应来去除语音混响[3]。但是在实际嘈杂的背景噪声环境下,这类算法去混响效果下降。第二类算法的思路是将信号谱估计与麦克风阵列波束形成算法相结合,在有效保留前期有效混响的基础上,去除后期产生掩蔽效应的混响。该类经典算法往往采用信号增强的维纳滤波器与最小方差无失真响应(MVDR)相结合进行去混响[4]。但是该类算法需要信号源的波达方向(DOA)估计。第三类算法为基于构建概率模型进行语音去混响,如多通道线性预测(MCLP)去混响算法。这类算法在预估计任意参数的前提下,均取得了较好的去混响效果[5-7]。但对于目标信号协方差的初始化要求较高,直接影响语音信号去混响的效果和输出信号是否失真。

本文提出采用相干扩散功率比(CDR)进行目标信号的协方差初始化,在时频域内只需要利用两个通道语音信号的功率谱,将经典算法谱减法应用到MCLP去混响算法中,利用优化目标函数协方差初始化,可以有效提高语音去混响的性能。

2 基于CDR的MCLP语音去混响算法

2.1 声学信号模型

假设在封闭房间中,声源仅为一个,利用均匀线性麦克风阵列进行语音信号采集,含有M个远场麦克风。则第m个麦克风采集到的远场语音信号表示为[8-9]

(1)

式中,离散时间变量为n,s(n)表示纯净语音信号,Nm(n)表示房间背景噪声,rm(n)表示麦克风阵列第m个麦克风到声源的房间冲激响应(RIR),其长度为Lr。对式(1)进行短时傅里叶变换,即

(2)

式中的n∈{1,...,N}表示语音信号分帧处理之后的帧数,k∈{1,...,K}表示频域的频带数,Nm(k,n)表示加性噪声的时频域表达式。rm(k,l)表示时频域内的房间冲击响应,其长度Lr。假设不考虑背景噪声的影响,即Nm(k,n)=0,仅考虑混响对语音信号质量的影响。

由于混响的早期反射对语音信号具有增强的作用,而后期反射则会产生掩蔽效应,降低语音信号的可懂度,式(2)可以进一步表示为

(3)

(4)

式中,dm(k,n)表示期望信号,为麦克风阵列中第m个传感器接收到的直达波和混响前期的反射波相加,τ为声源到麦克风阵列各个阵元间的时间延迟。所以去混响算法目的是去除后期混响反射,获得期望信号dm(k,n)。

2.2 MCLP语音去混响算法

将阵列接收的第r路语音信号作为参考信号,则利用MCLP语音去混响算法,式(3)表示为

(5)

式中,gm(k,l)表示长度为Lg的线性预测系数,等式右边的第二项为后期混响。令

xm(k)=[xm(k,1),...,xm(k,N)]T

dr(k)=[dr(k,1),...,dr(k,N)]T

gm(k)=[gm(k,0),...,gm(k,Lg-1)]T

Xτ(k)=[X1,τ(k),...,XM,τ(k)]

则式(5)进一步表示为

xr(k)=dr(k)+g(k)Xτ(k)

(6)

假设目标信号是一个零均值,协方差为λ(k,n)且符合广义高斯先验模型(TVG)的一个分布[10],即

(7)

(8)

式中,i表示迭代次数,D是由麦克风阵列接收信号协方差所构成的对角矩阵。将协方差写成向量形式,即

(9)

式(9)所示的协方差有可能导致部分为零的情况出现,进而导致语音智能处理系统性能下降。

现将式(3)改写成仅包括前期和后期混响反射两部分,具体表示为

xm(k,n)=dm(k,n)+rm(k,n)

(10)

式中,rm(k,n)表示后期混响部分,假设dm(k,n)和rm(k,n)互不相干。

麦克风阵列中任意两个传感器接收到的语音信号的自功率谱或互功率谱为

(11)

式中,ε是期望因子。

定义期望信号的自功率谱和后期混响反射的自功率谱均相等,表达式为

Φdidi(k,n)=Φdjdj(k,n)=Φd(k,n)

(12)

Φriri(k,n)=Φrjrj(k,n)=Φr(k,n)

(13)

则该系统在混响情况下的信噪比为

(14)

式中,SNR(k,n)被定义为相干扩散功率比(CDR)。

则构建麦克风阵列中任意两通道语音信号的相干函数为

(15)

式中,Td(k)表示目标信号的复空间相干函数,Tr(k)表示混响的复空间相干函数。

假设期望信号是远场平面波,则其复空间相干函数表达式为

Td(k)=ej2πkLsin(θ)/c

(16)

式中,c表示声速,θ表示波达方向角,L是麦克风传感器间的距离。任意两个麦克风之间的扩散相干函数为

(17)

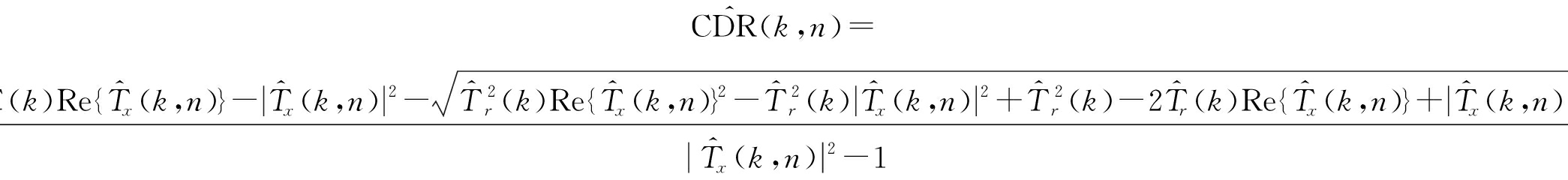

则相干扩散功率比CDR为

(18)

式中,Tr(k)、Tx(k,n)和Td(k)均为复数,理论上,相比之后的结果CDR(k,n)应为实数,但是实际中却很难得到。

于是,CDR(k,n)可以进一步估计得到

(19)

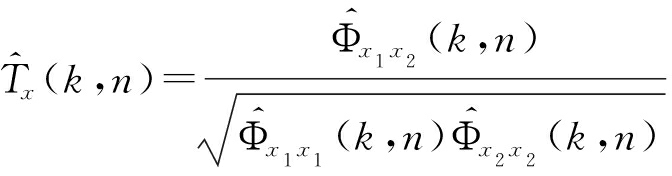

式中,![]() 利用任意两路信号的自功率谱和互功率谱表述为

利用任意两路信号的自功率谱和互功率谱表述为

(20)

(21)

其中α为平滑参数。

式(10)所示麦克风接收信号的功率谱为

|xm(k,n)|2=|dm(k,n)|2+|rm(k,n)|2+![]()

(22)

由于dm(k,n)和rm(k,n)互不相干,故![]() 所以

所以

|xm(k,n)|2=|dm(k,n)|2+|r(k,n)|2

(23)

因此

(24)

基于改进的CDR对协方差λ(k)进行初始化,进而采用递归平均方法得到估计值

(25)

基于改进的CDR协方差初始化MCLP语音去混响方法的具体步骤,如表1所示。

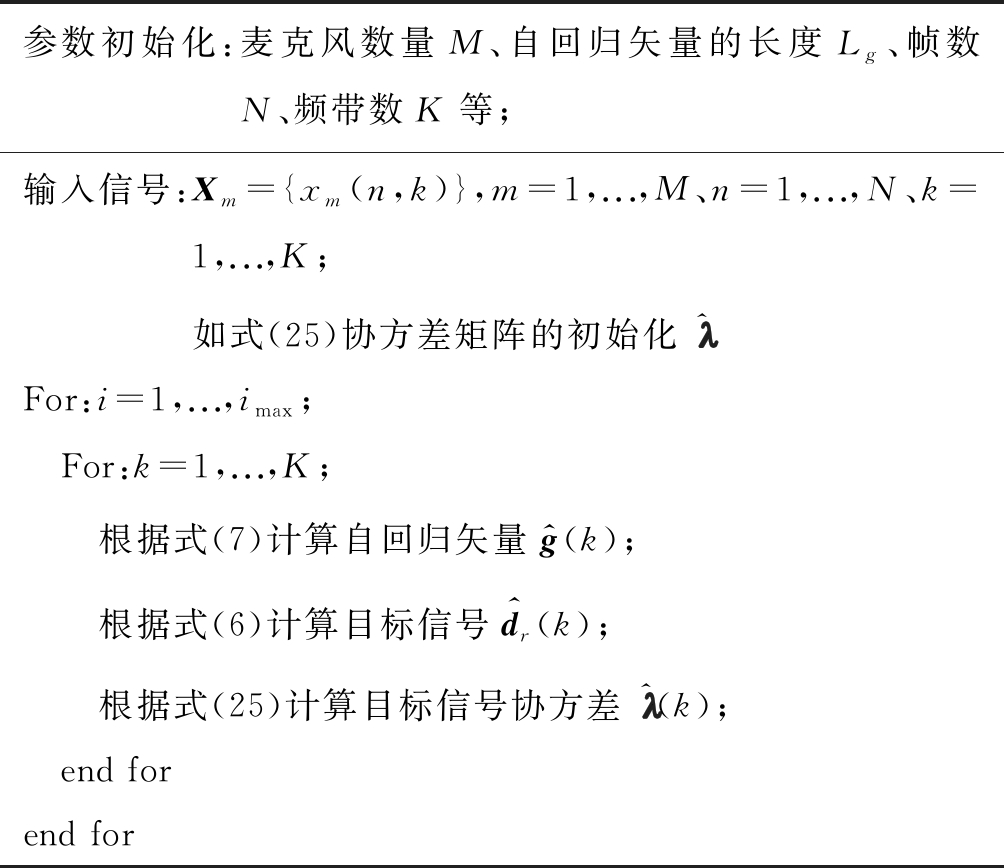

表1 CDR协方差初始化语音去混响方法步骤

Tab.1 Speech dereverberation based on CDR Covariance Initialization

参数初始化:麦克风数量M、自回归矢量的长度Lg、帧数N、频带数K等;输入信号:Xm={xm(n,k)},m=1,...,M、n=1,...,N、k=1,...,K;如式(25)协方差矩阵的初始化铖^For:i=1,...,imax; For:k=1,...,K; 根据式(7)计算自回归矢量g^(k); 根据式(6)计算目标信号d^r(k); 根据式(25)计算目标信号协方差铖^(k); end for end for

3 仿真实验结果与分析

纯净语音文本为“She have his dark clothes in clean wash water all year”。实验中带噪语音数据通过纯净语音分别与混响时间T60=250 ms(轻度)、T60=500 ms(中度)及T60=700 ms(重度)情况下的RIRs进行卷积得到。利用线性均匀麦克风阵列采集远场语音信号,4个麦克风之间的距离为8 cm,采样频率是16 kHz,满足语音信号在10 ms~30 ms内的短时平稳性,频带最大值为480 Hz。参数设置,Lg=8,τ=2。

为验证论文所提SMCLP算法的性能,实验选择语音信号去混响算法即迭代重加权最小方差(IRLS)算法[11]和原始MCLP算法[7]进行性能比较分析。算法有效性分别采用语谱图、语音质量的主观评估(PESQ)参数和频率加权分段的信噪比(FWSegSNR)来衡量。

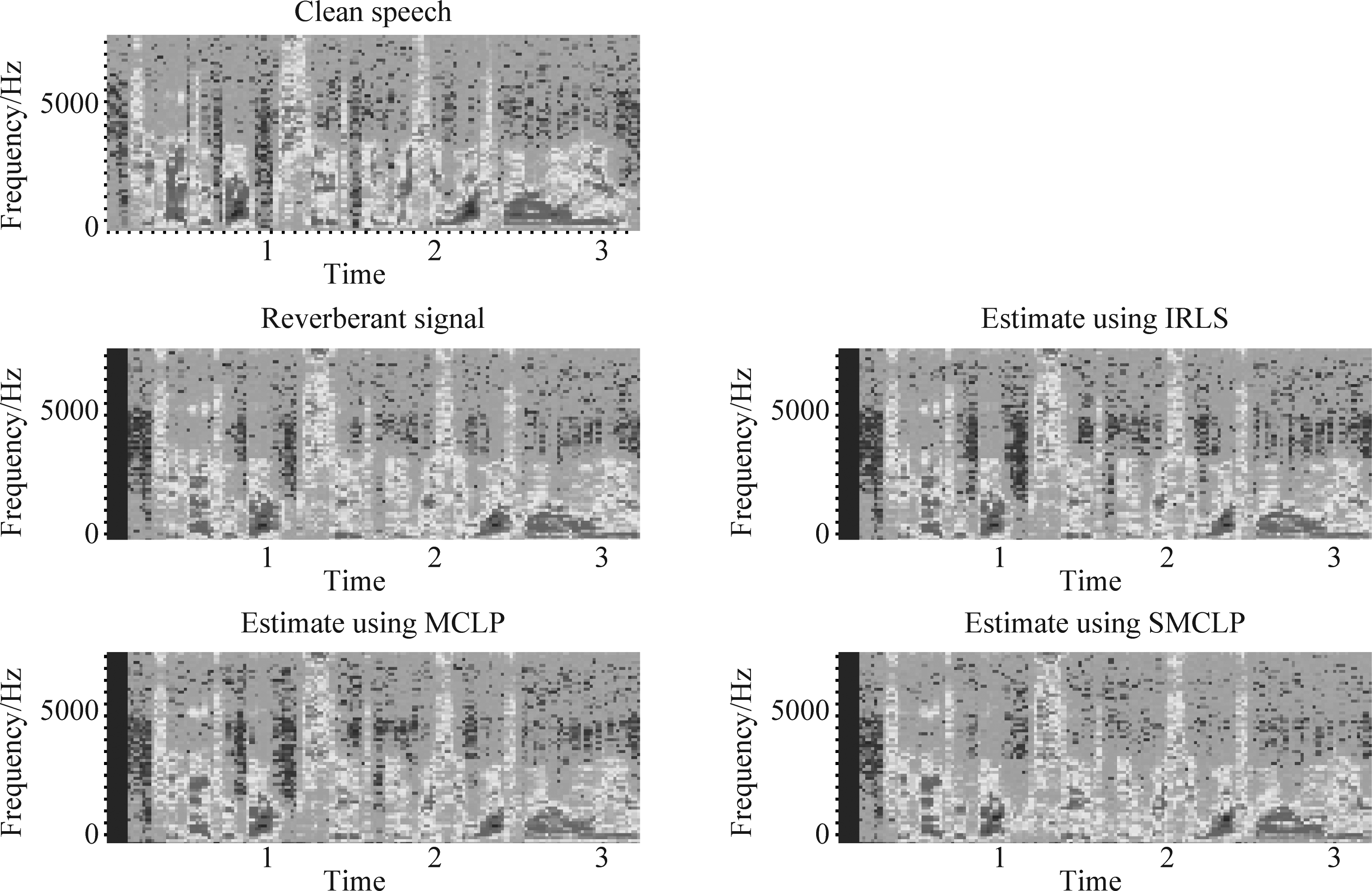

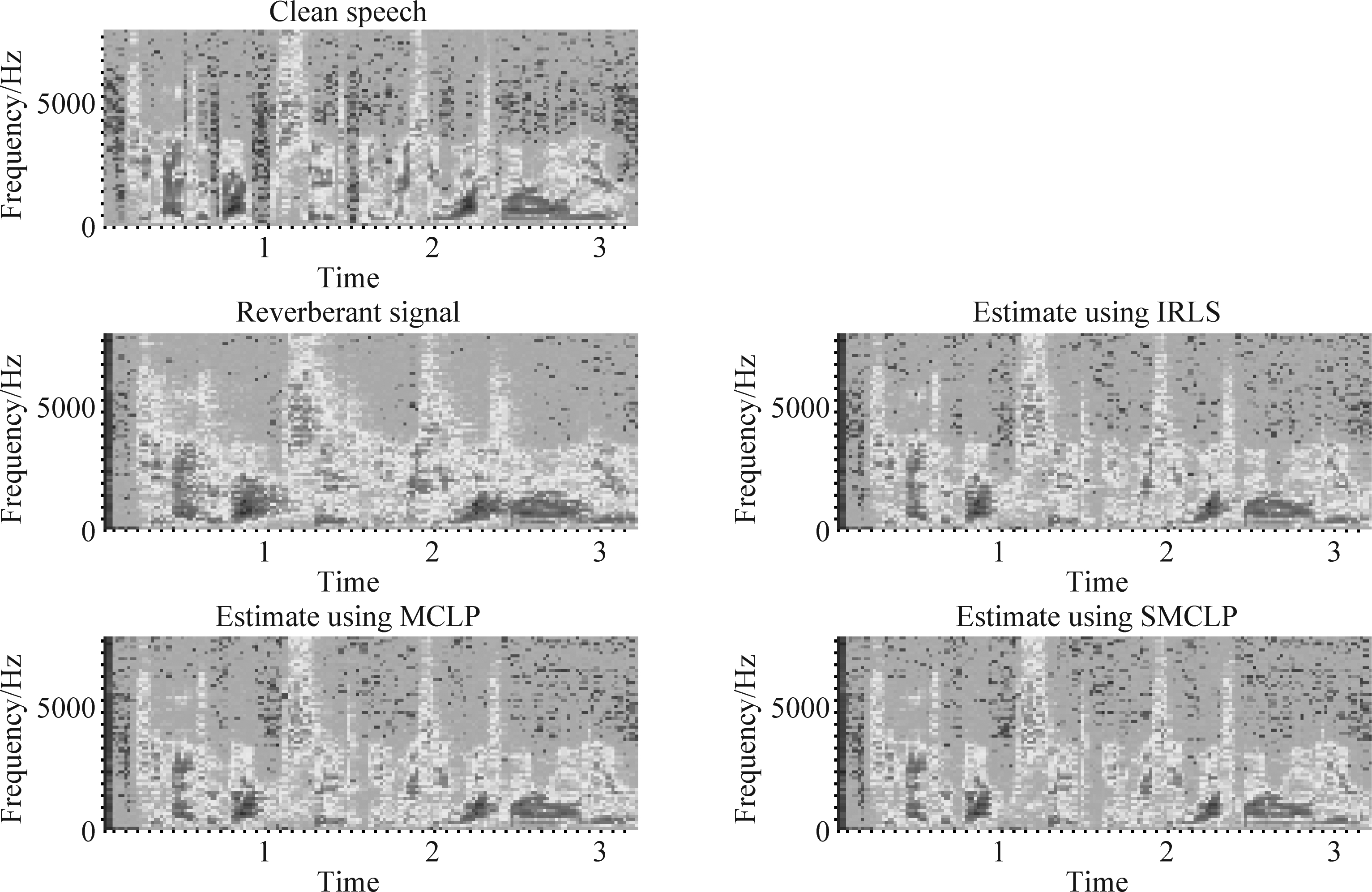

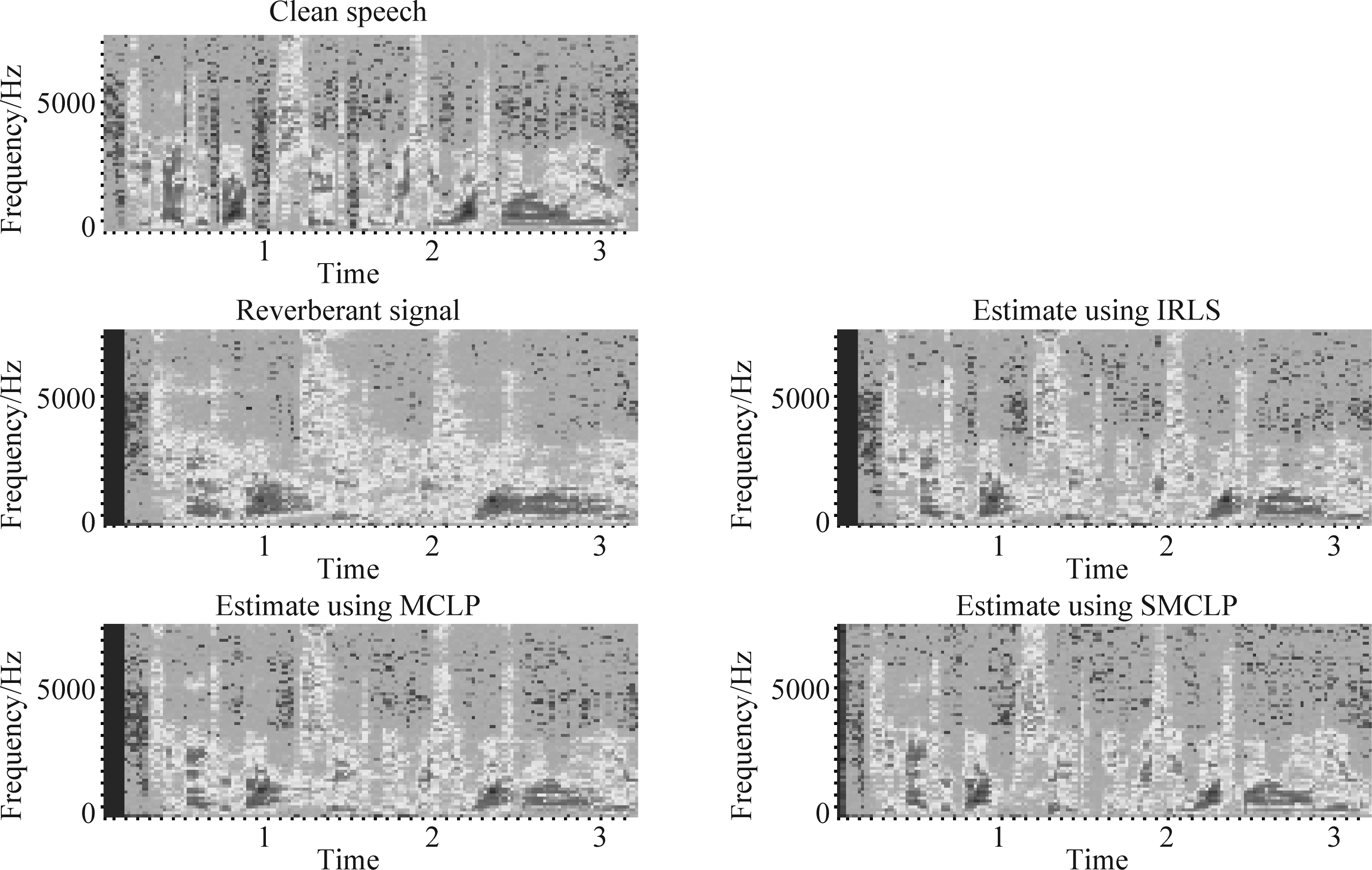

实验一 不同混响情况下算法语谱图显示的结果。

首先利用语谱图分析比较语音信号去混响的效果,语谱图根据谱的清晰程度来分析。图1~图3分别表示不同程度混响(T60=250 ms,500 ms,700 ms)环境中的IRLS、MCLP、SMCLP三种方法的语谱图。

图1显示在轻度混响T60=250 ms情况下,三种算法的去混响效果区别并不明显。图2和图3分别表示在中高度混响T60=500 ms和T60=700 ms情况下,三种算法的对比观察实验结果。从中可以看到,论文提出的SMCLP去混响算法,输出的语音信号频谱又恢复了清晰的纹理,即取得了较好的去混响性能。

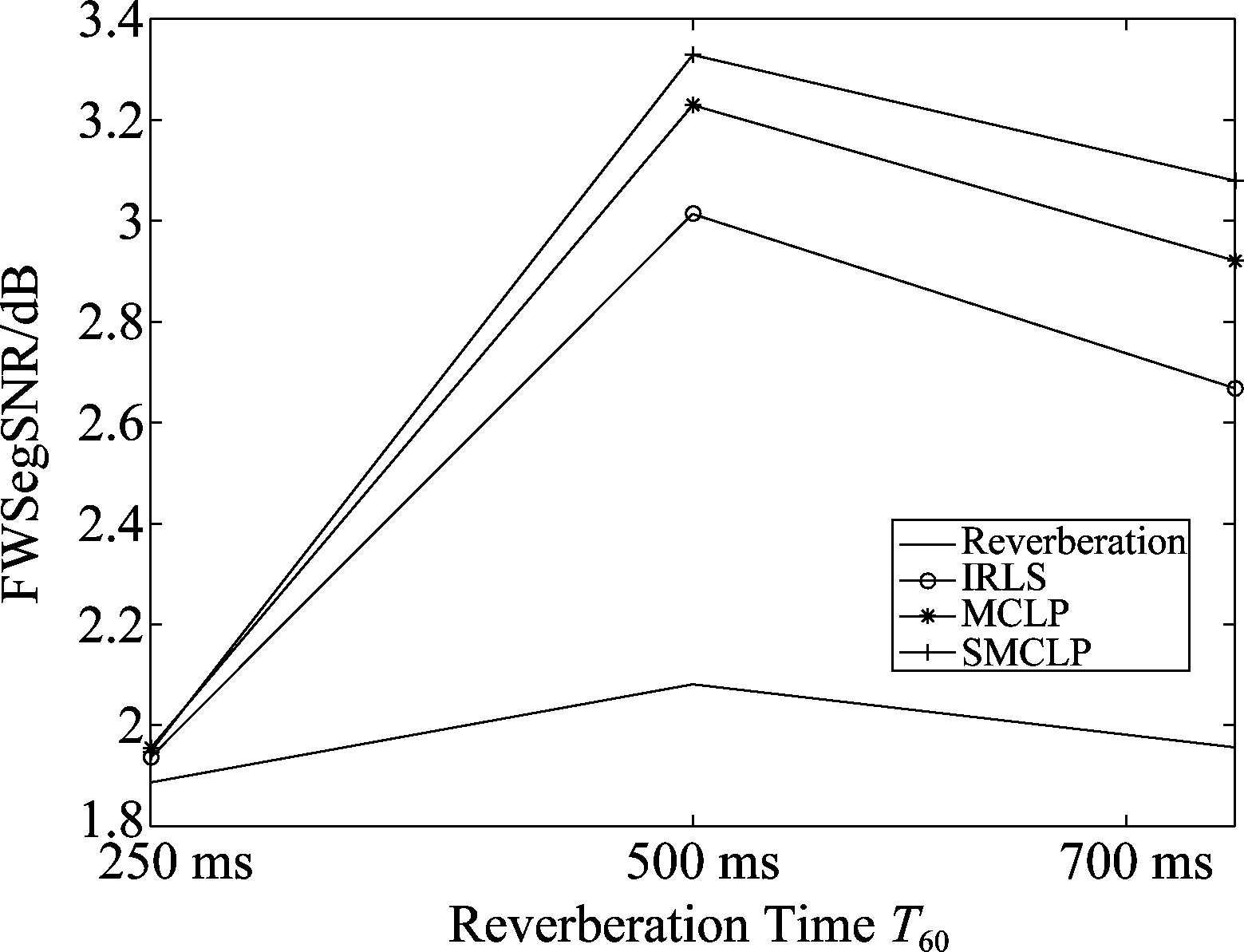

实验二 不同混响情况下,三种算法频率加权分段信噪比(FWSegSNR)的结果。具体如图4所示。

图1 语音信号的语谱图T60=250 ms

Fig.1 The spectrograms of the speech signal T60=250 ms

图2 语音信号的语谱图T60=500 ms

Fig.2 The spectrograms of the speech signals T60=500 ms

图3 语音信号的语谱图T60=700 ms

Fig.3 The spectrograms of the speech signals T60=700 ms

FWSegSNR参数表示去混响之后的纯净语音信号能量与剩余的混响能量之间的权重比,其值越大说明纯净语音信号能量高,去混响效果好[12]。从图中可以看出,三种方法在不同混响情况下均可以达到去混响的目的,且在中度混响情况下效果最好。而本文所提出的SMCLP算法在三种情况下均优于其他两种方法。

实验三 不同混响情况下,三种算法语音质量的主观评估(PESQ)参数的评估结果。具体如图5所示。

图4 FWSegSNR去混响参数折线图

Fig.4 The graph of FWSegSNR parameters

图5 PESQ参数折线图

Fig.5 The graph of PESQ parameters

PESQ参数代表去混响后的语音音质,参数值介于1与4.5之间,1为最差,4.5为无失真语音。图5表示不同混响情况下,IRLS、MCLP、SMCLP三种方法的PESQ参数。可以看出,三种去混响算法的主观语音质量评估均大幅度提高,并且本文方法的参数值较其他两种方法即IRLS和MCLP达到最高,说明本文提出的基于CDR目标信号协方差初始化的MCLP算法的去混响效果得到了进一步的提高。

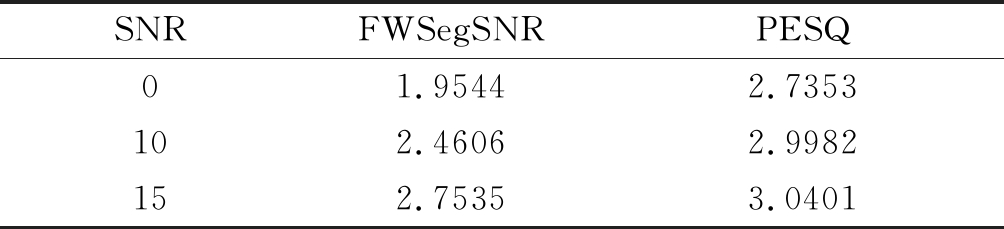

实验四 不同信噪比情况(0 dB、10 dB和15 dB),本文算法的性能如表2所示。

表2 不同信噪比情况下本文算法的语音质量参数(T60=500 ms)

Tab.2 Speech quality parameters of different SNR(T60=500 ms)

SNRFWSegSNRPESQ01.95442.7353102.46062.9982152.75353.0401

从表2可以看出,在噪声和混响共存的声学环节下,本文算法仍然可以取得较好的去混响效果,且信噪比越高,语音质量越好。也就是说,论文提出SMCLP算法的去混响性能受噪声因素影响不大。听音测试也证明了这一点。

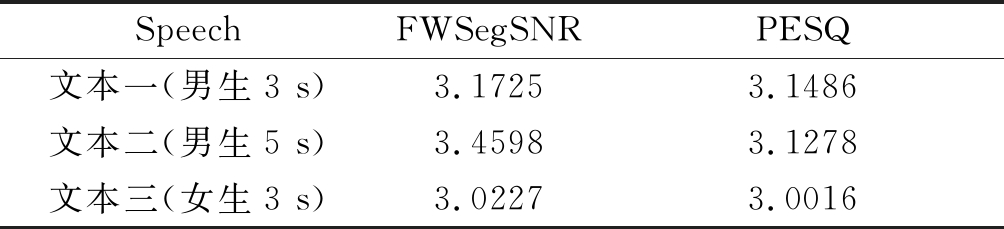

实验五 为验证论文算法对不同语音文本的有效性,实验随机从TIMID数据库选取了3个文本进行验证。实验结果如表3所示。

表3 不同文本情况下的语音质量参数(T60=500 ms)

Tab.3 Quality parameters of different speech (T60=500 ms)

SpeechFWSegSNRPESQ文本一(男生3 s)3.17253.1486文本二(男生5 s)3.45983.1278文本三(女生3 s)3.02273.0016

由表3可以看出,在中度混响情况下,本文SMCLP算法均取得较好的去混响效果。文本来源为公开数据库且随机选取,故说明论文算法也适用于其他语音文本文件,具有统计意义。

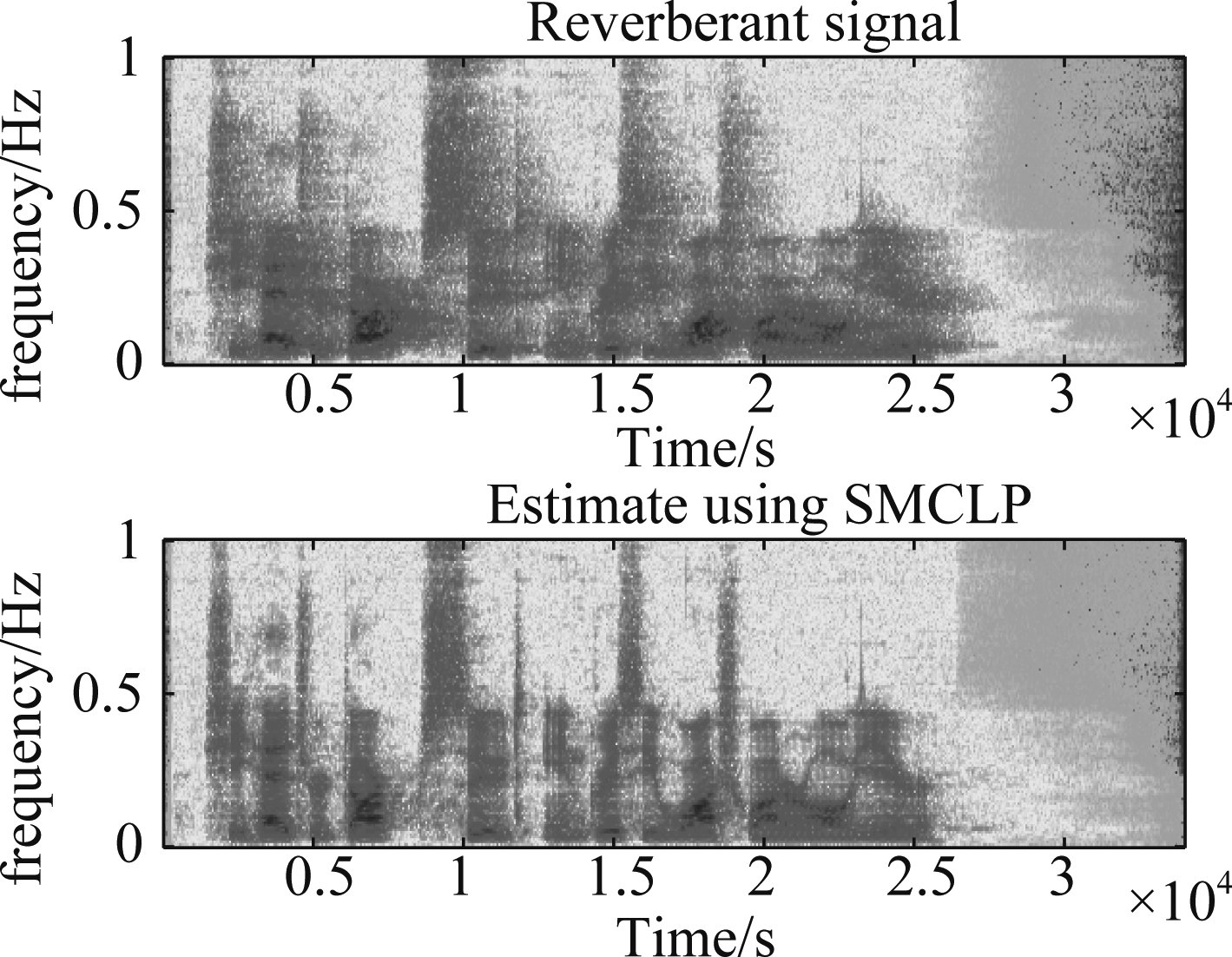

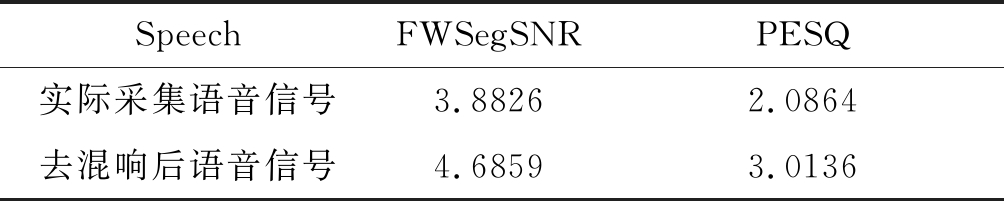

实验六 为验证论文方法的实用性,在教室(6 m*10 m)实际采集语音信号。利用所提出的SMCLP算法进行语音去混响处理,如图6所示。

图6 实际语音信号的语谱图

Fig.6 The spectrograms of the practical speech signals

图6显示实际采集的语音信号和去混响之后语音信号的语谱图,通过SMCLP方法去混响的语音信号声纹更清晰,说明该方法实际应用性能良好。考虑到语音去混响效果语谱图显示还不够清楚,利用FWSegSNR和PESQ语音质量参数验证,实验结果如表4所示。

表4 教室环境下的语音质量参数

Tab.4 Quality parameters in classroom environment

SpeechFWSegSNRPESQ实际采集语音信号3.88262.0864去混响后语音信号4.68593.0136

由表4可以看出,本文SMCLP算法去混响之后的实际采集语音信号,语音质量参数都有提高,证明该方法具有实用性。听音测试也证明了这一点。

4 结论

考虑到实际封闭环境下混响对语音质量的影响,论文给出了一种CDR目标信号协方差初始化的MCLP去混响方法。不同混响环境、不同语音文本甚至不同信噪比声学背景下的仿真实验均表明本文所提出的SMCLP算法具有较好的语音去混响效果。该方法输入语音信号由线性麦克风阵列采集得到,这种方法也可以拓展到二维圆阵和三维球阵等不同拓扑结构的阵列语音处理中。

[1] MIKIO Tohyama. Sound in the Time Domain[M]. America: Springer, 2018: 271-296.

[2] 罗俊杰, 王朋, 张春华. 基于盲源提取的强混响背景下LFM信号回波检测[J]. 信号处理, 2019, 35(9): 1513-1519.

LUO Junjie, WANG Peng, ZHANG Chunhua. Echo detection of LFM signal under strong reverberation background based on blind source extraction[J]. Journal of Signal Processing, 2019, 35(9): 1513-1519.(in Chinese)

[3] KODRASI I, JUKIC A, DOCLO S. Robust sparsity-promoting acoustic multi-channel equalization for speech dereverberation[J]. IEEE International Conference on Acoustics, 2016: 166-170.

[4] KUKLASINSKI A, DOCLO S. Maximum Likelihood PSD Estimation for Speech Enhancement in Reverberation and Noise[J]. IEEE/ACM Transactions on Audio Speech & Language Processing, 2016, 24 (9): 1595-1608.

[5] PARCHAMI M, ZHU W P, CHAMPAGNE B. Speech dereverberation using linear prediction with estimation of early speech spectral variance[J]. IEEE International Conference on Acoustics, Speech and Signal Processing, 2016, 14(6): 504-508.

[6] LEILA Mousavi, FARBOD Razzazi, AFROOZ Haghbin. Blind speech dereverberation using sparse decomposition and multi-channel linear prediction[J]. International Journal of Speech Technology, 2019, 22: 728-729.

[7] SRIKANTH Raj, CHETUPALLI, THIPPUR VSreenivas. Joint spatial filter and time-varying MCLP for dereverberation and interference suppression of a dynamic/static speech source[J]. IEEE Int. Conf. Acoust Speech Signal Process (ICASSP), 2019: 22-24.

[8] SCHWARZ A, KELLERMANN W. Coherent-to-Diffuse Power Tatio Estimation for Dereverberation[J]. IEEE/ACM Transactions on Audio Speech and Language Processing, 2015, 23(6): 1006-1018.

[9] 赵小燕, 陈书文, 周琳. 基于频率信噪比加权的麦克风阵列声源定位算法[J]. 信号处理, 2020, 36(3): 449- 456.

ZHAO Xiaoyan, CHEN Shuwen, ZHOU Lin. Sound source localization using SNR-based frequency weighting with microphone array[J]. Journal of Signal Processing, 2020, 36(3): 449- 456.(in Chinese)

[10] IWATA Y, NAKATANI. Introduction of speech log-spectral priors into dereverberation based on Itakura-Saito distance minimization[J]. IEEE Int. Conf. Acoust Speech Signal Process (ICASSP), 2012: 245-248.

[11] WIPF D, NAGARAJAN S. Iterative reweighted l1 and l2 methods forfinding sparse solutions[J]. IEEE J. Sel. Topic Signal Process, 2010, 4(2): 317-329.

[12] HU Y, LOIZOU P C. Evaluation of objective quality measures for speech enhancement[J]. IEEE Trans. Audio, Speech, Lang Process, 2008, 16(1): 229-238.