1 引言

在计算机视觉任务中,深度学习[1]可以提取到更丰富、更深层次的图像特征表示,并取得比传统图像处理方法更高的准确率,在人脸识别[2-3]、目标检测[4-5]、语义分割[6-7]等领域均实现了广泛的应用。其中,深度学习中的卷积神经网络具有局部感知、权值共享等一系列特点,大大降低了计算量,因此更适用于计算机视觉任务[8]。如在图像分类领域的ILSVRC挑战赛[9]上,卷积神经网络架构VGGNet[10]、GoogLeNet[11]及 ResNet[12]等均实现了很高的精度。与传统方法相比,深度学习最大的优势在于它可以通过层级连接对原始输入信号进行复杂的非线性运算,提取到更深层次的特征信息,从而获取更抽象、更本质的数据表示形式[13]。

在图像分类任务上,深度学习已经取得了极大进展。然而,细粒度图像分类任务仍然充满挑战,尚未得到解决[14]。细粒度图像分类是在区分出基本类别的基础上,进行更精细的子类划分,例如鸟类或犬类[15]。其具有挑战性的主要原因在于研究的类别具有较高的类内差异和较高的类间相似性[15],由于姿势、背景和拍摄角度的不同,同一类别外表看来可能具有较大的差异,而不同类别由于属于同一父类,它们之间的差异仅存在于一些细微的区域中,例如鸟的喙和尾巴等,往往需要专家知识对其进行识别。

根据训练过程中监督信息的不同,可以将细粒度图像分类研究分为两类:一类在训练过程中,除了使用常规图像类别标签外,还加入了边界框、部件注释等额外人工标注信息,这类研究被称为强监督方法。虽然这一类模型的测试精度更高,在鸟类、汽车等种类识别中取得了很好的性能,但是人工标注成本昂贵,且有一定的出错率,从而限制了在实际中的应用[16],另一类针对上述缺点,在训练过程中仅使用图像类别标签,被称为弱监督方法,其学习成本显著降低,在实际中有更广泛的应用,因此本文重点研究弱监督细粒度图像分类方法。

对于同一大类,如犬类或车类,最显著的区域中包含的线索往往具有较大的共性,其对于类内差异较小的细粒度图像分类的作用十分局限。现有的弱监督细粒度图像分类模型往往过多关注图像中的显著性区域,而忽略了其他蕴含互补信息的有利于区分子类的微小线索。为了解决该问题,本文提出了一种全局与局部结合的多视角细粒度图像分类模型,通过抑制图像中最显著的区域来迫使网络学习易混淆类别间微妙的特征,从而精确地区分同一大类下的不同子类。为避免网络过于关注局部特征,还引入了一个全局分支学习图像整体结构特征。传统的多分类交叉熵损失函数可以增大不同类之间的距离,使得数据在特征空间是类间可分的,但是对于细粒度图像分类,类内紧凑也十分重要,因此在此基础上,本文还提出了一种新的嵌入损失,减小各个图像和其对应类中心之间的距离,充分挖掘特征之间的关联,使学到的特征更具判别性。

2 相关工作

2.1 视觉注意力机制

引入视觉注意力可以捕获细粒度图像分类中微妙的类间差异。现有的视觉注意力模型大多以弱监督方式进行局部区域定位,每个注意力相当于一个边界框,对检测到的区域进行覆盖,如Jaderberg等人提出的STN[17]、Fu等人提出的RACNN[18]、Yang等人提出的NTS-Net[19]等,首先检测局部区域,然后在原始图像上对检测到的区域进行裁剪。但是这些方法往往需要额外的局部定位模块,从而导致计算量过大,因此Sun等人提出了MAMC[20],采用一个能够直接提取关键性区域特征的结构,相当于在特征图上施加一个软掩码来进行局部定位,大大降低了计算成本。这些方法由于受到固定数量部件的限制以及硬性裁剪导致周围环境缺失的影响,因此Ding等人提出了一种选择性稀疏采样网络[21],通过学习一组稀疏注意力,充分捕捉细粒度的视觉证据,同时无需裁剪,保留了区域的周围环境。

2.2 细粒度特征表示

学习具有代表性的特征对于细粒度图像分类至关重要,因此一部分工作尝试采用端到端特征编码的方法,通过开发用于细粒度识别的深度模型来直接学习更具判别性的表征。Lin等人提出了一种双线性池化模型(Bilinear Pooling,BP)[22],它使用两个深度卷积网络,将输出特征进行融合,从而对卷积激活的高阶统计量进行编码以增强中级学习能力。然而,双线性特征的极高维数使得它在实际应用中受到限制,特别是在大规模应用中。为此,Gao等人提出了一种紧凑的双线性模型[23],将原始的双线性模型改进为一个紧凑的结构,使得特征维数降低了两个数量级。Kong 等人提出了一种低秩双线性池化模型(Low-Rank Bilinear Pooling,LRBP)[24],用双线性分类器代替双线性特征,既提高了计算效率,又减少了要学习的参数数量。

2.3 度量学习

度量学习是指利用相似性度量来研究图像对之间关系的方法,它广泛应用于人脸验证、行人重识别等领域。与传统分类网络中使用的softmax损失相比,度量学习可以将样本嵌入到低维空间中,以尽可能多地捕获类内差异,从而鼓励正对彼此拉近,负对彼此远离,因此可用于细粒度图像分类[25]。Wen等人提出了一种新颖的中心损失(center loss)[2],通过最小化每个样本特征与对应类的特征中心之间的距离,从而减小类内差异,提高网络的分类性能。Sun等人采用n-pair损失[26]约束样本距离,与softmax损失相结合,挖掘图像中不同部件之间丰富的相关性。

3 方法

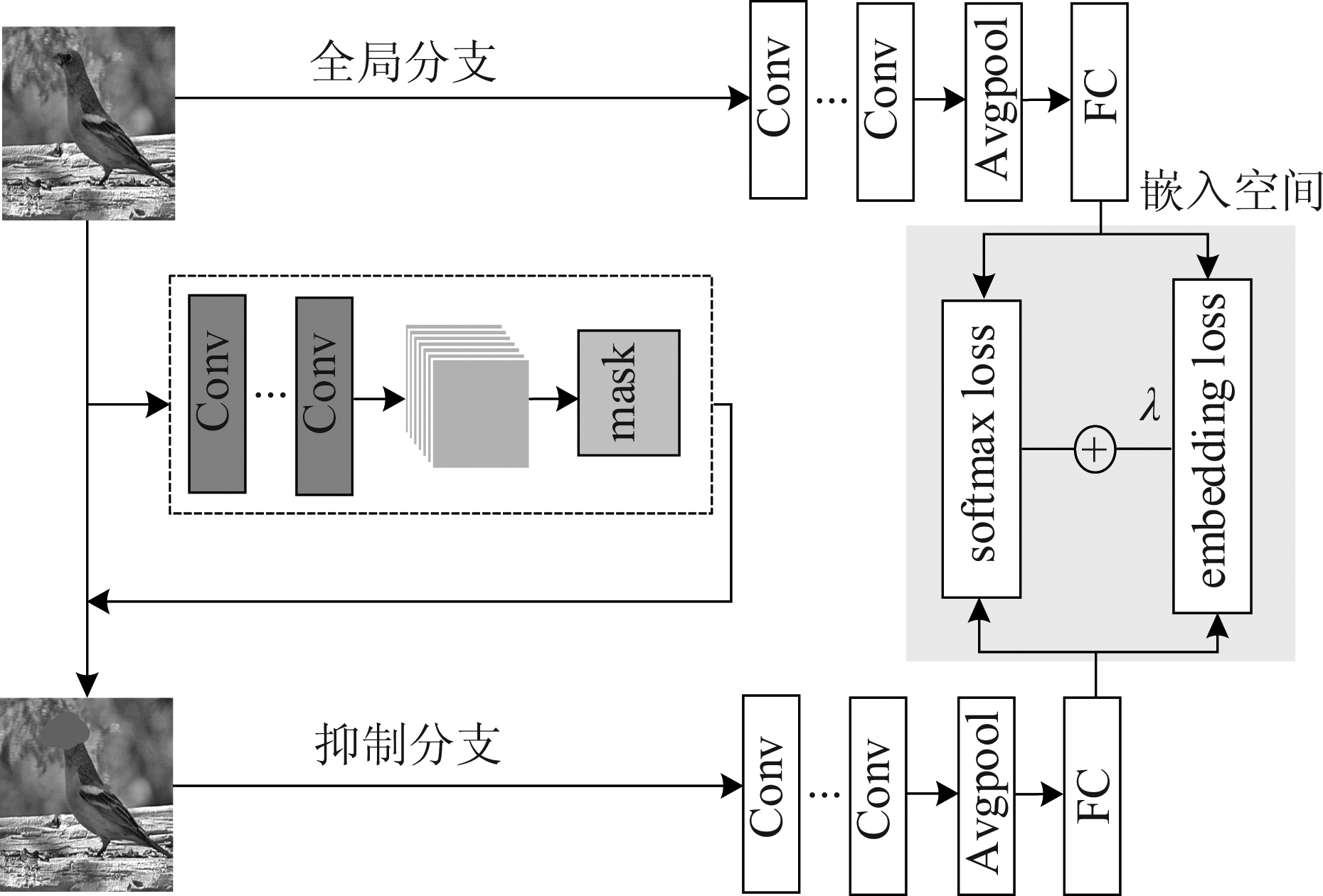

本文提出的模型结构如图1所示,包括两个分支:全局分支和抑制分支。其中,全局分支直接将固定大小的原始图像输入分类网络进行训练,抑制分支则基于特征图生成一个局部区域被掩蔽的抑制图像,将其输入至分类网络进行训练,从而分散注意力,使网络关注包含细微线索的互补区域。同时引入一个嵌入空间,使用一个新颖的嵌入损失函数对其进行训练,与softmax损失函数结合,增加不同类样本之间的距离,减小同类样本之间的距离,使得到的特征更具判别力。

图1 模型结构

Fig.1 Model structure

3.1 双线性池化

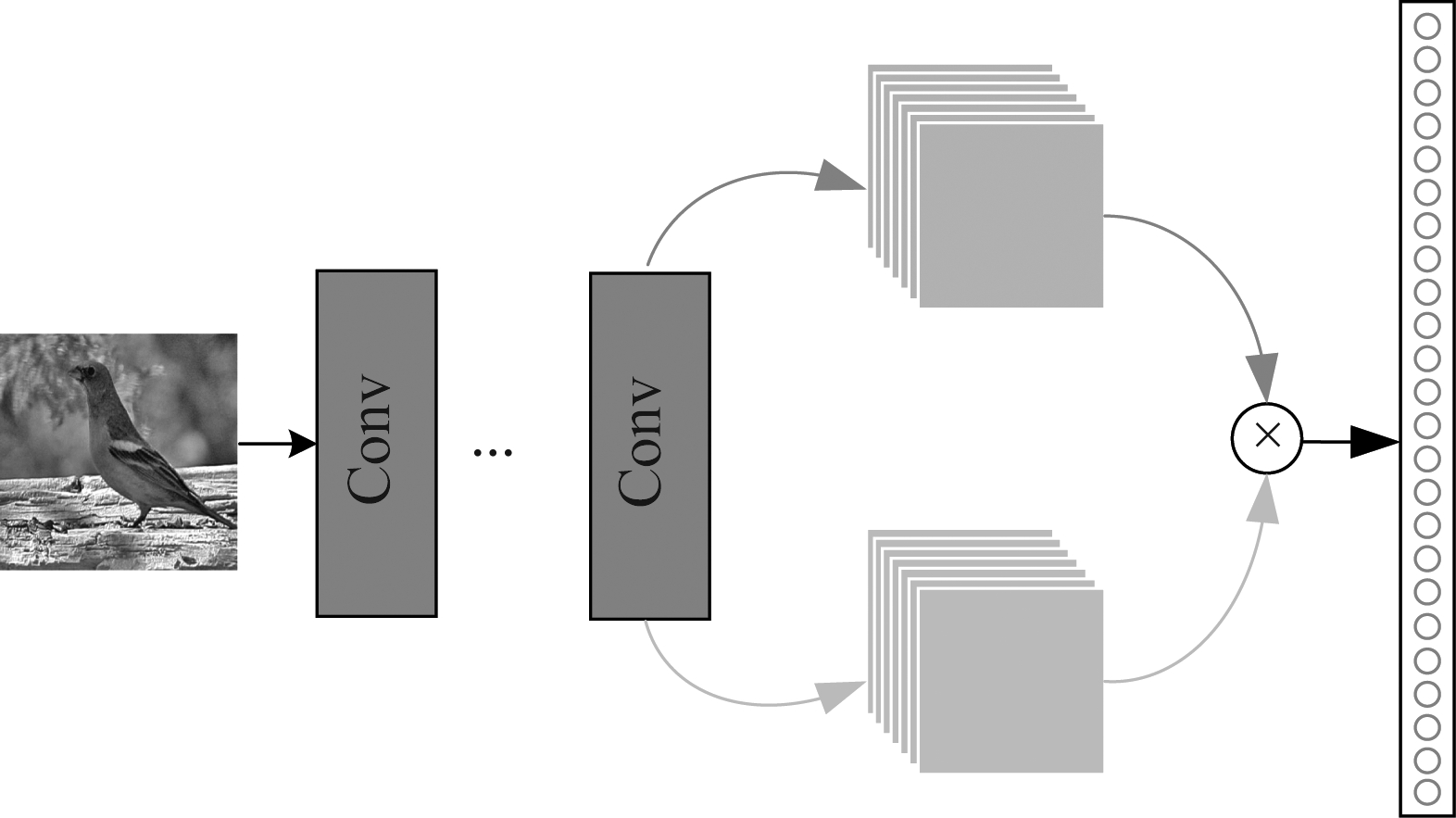

通过卷积层提取图像特征后,受到Lin等人提出的双线性池化模型[22]启发,将特征进行融合,从而使获取的特征具有更强的判别性。而且双线性池化形式简单,便于梯度反向传播,进而实现端到端的训练。

具体来说,如图2所示,得到ResNet-50中layer4第二个block的conv1和conv2输出的特征图,分别记为![]() 其中C1、C2表示两种特征的通道数,H和W分别表示特征图的高度和宽度。为了解决融合后特征维数过高的问题,同时保证生成的特征向量中所包含的特征信息足够多,只随机抽取F2中n个通道的特征图与F1进行融合。记特征图F1与F2中各个位置沿通道的特征向量为

其中C1、C2表示两种特征的通道数,H和W分别表示特征图的高度和宽度。为了解决融合后特征维数过高的问题,同时保证生成的特征向量中所包含的特征信息足够多,只随机抽取F2中n个通道的特征图与F1进行融合。记特征图F1与F2中各个位置沿通道的特征向量为![]() 两个特征向量相乘后可得到双线性矩阵

两个特征向量相乘后可得到双线性矩阵![]() 将特征图中各个位置对应的双线性矩阵进行相加,并将矩阵展为一个向量,即为双线性向量。该双线性向量包含了丰富的特征信息,可将其输入3.3节提出的嵌入空间进行约束。

将特征图中各个位置对应的双线性矩阵进行相加,并将矩阵展为一个向量,即为双线性向量。该双线性向量包含了丰富的特征信息,可将其输入3.3节提出的嵌入空间进行约束。

图2 双线性池化

Fig.2 Bilinear pooling

3.2 抑制分支

在以往工作中,通过学习输入图像到输出标签的映射,基于交叉熵损失函数的卷积神经网络往往关注一些显著的区域,忽略了其他蕴含互补信息的微小线索。由于细粒度图像中易混淆的类别间往往存在一些极其细微的差异,因此对微妙特征的关注是很有必要的。在本文研究中,通过抑制图像中的显著区域,将注意力进行分散,从而捕捉到图像中的各种细微特征之间的关系。

具体来说,对3.1节随机选取的特征图![]() 进行平均池化处理并降序排序,选择排序后第一个特征图,并将其放大至原始图像大小,计算该特征图的平均值A,以θ*A作为阈值,将特征图中大于阈值的元素设置为0,将其他元素设置为1,从而获得抑制掩码Mk:

进行平均池化处理并降序排序,选择排序后第一个特征图,并将其放大至原始图像大小,计算该特征图的平均值A,以θ*A作为阈值,将特征图中大于阈值的元素设置为0,将其他元素设置为1,从而获得抑制掩码Mk:

(1)

将抑制掩码覆盖到原始图像,对其进行掩蔽来抑制第k个部件区域,从而迫使神经网络从其他区域学到判别性信息。由于抑制了图像最显著的区域,分散了注意力,还可以降低网络对训练样本的依赖,防止过拟合,进一步提高了模型的鲁棒性。

3.3 嵌入空间

为了使提取到的特征更具判别性,将图像映射进一个嵌入空间,其中同一类别下的图像距离被拉近,不同类别下的图像距离被拉远。在以往的工作中,Schroff等人使用三元损失(triplet loss)作为嵌入损失[27],该损失函数从训练数据集中随机选取一个样本,称为锚(anchor),然后再随机选取一个和锚属于同一类的正样本(positive)和不同类的负样本(negative),由此构成一个锚,正样本,负样本三元组。三元损失的目的就是通过学习,让同类样本的特征表达间距尽可能小,而异类样本的特征表达间距尽可能大。但是使用三元损失需要构造大量的训练对,为了使网络收敛的速度加快,本文采取了一种新颖的损失函数Le对嵌入空间进行训练,由以下两个部分组成:

Le=Lw+Lb

(2)

其中Lw损失函数最小化每个图像和其对应类中心之间的距离,Lb损失函数最大化不同类中心之间的距离。

Lw损失函数来源于Wen等人提出的中心损失[2],对每个类别都计算一个特征向量作为对应类别的类中心,这个特征向量随着训练的进行会不断的更新。通过惩罚每个样本的双线性特征向量和对应类别样本中心的偏移,使得同一类别的样本尽量聚合在一起,省去了复杂的样本对构造过程。令xi表示第i个样本的双线性特征,cyi表示样本i对应类别所有样本的平均特征,即类中心,N表示当前批量的样本个数,形式如下:

(3)

Lb损失函数则通过最大化更新类中心之间的距离,使异类样本的特征表达间距尽可能大,m定义了惩罚距离的阈值,P表示当前批量类别数量,形式如下:

(4)

最终损失函数为softmax损失与嵌入损失结合,形式为:

L=Ls+λLe

(5)

4 实验

4.1 数据集

本文在CUB-200-2011[28]、Stanford Cars[29]和FGVC Aircraft[30]这三个细粒度基准数据集上对提出的模型进行评估,使用top-1准确率作为评估指标。在所有的实验中均未使用边界框或部件注释,表1展示了三个数据集的统计信息。

表1 基准数据集的统计信息

Tab.1 Statistics of benchmark datasets

数据集训练集测试集类别CUB-200-201159945794200Stanford Cars81448041196FGVC Aircraft66673333100

CUB-200-2011:包含200个类别的11788张鸟类图像,训练数据与测试数据的比值约为1∶1。由于每个物种只有30张训练图像,因此通常被认为是最具竞争力的数据集之一。

Stanford Cars:包含基于不同汽车品牌、车型和年份的196个类别的16185张车辆图像,训练数据与测试数据的比值约为1∶1。

FGVC Aircraft:包含100个类别的10000张飞机图像,训练数据与测试数据的比值约为2∶1。

4.2 实验设置

采用在ImageNet[31]上预训练的ResNet-50作为骨干网络。在训练阶段,为了提高模型的泛化能力,对数据进行增强处理来扩充数据的丰富性,将输入图像尺寸调整为512×512,接着随机裁剪为448×448,并对图像使用随机翻转操作。在测试阶段,先将输入图像尺寸调整为512×512,再中心裁剪为448×448。

所有的实验模型都训练了180个轮数,使用SGD作为优化器,初始学习速率设为0.001,每两个训练轮数下降为原来的0.9。设定权重衰减系数为0.00001,动量系数为0.9。

4.3 实验定量结果

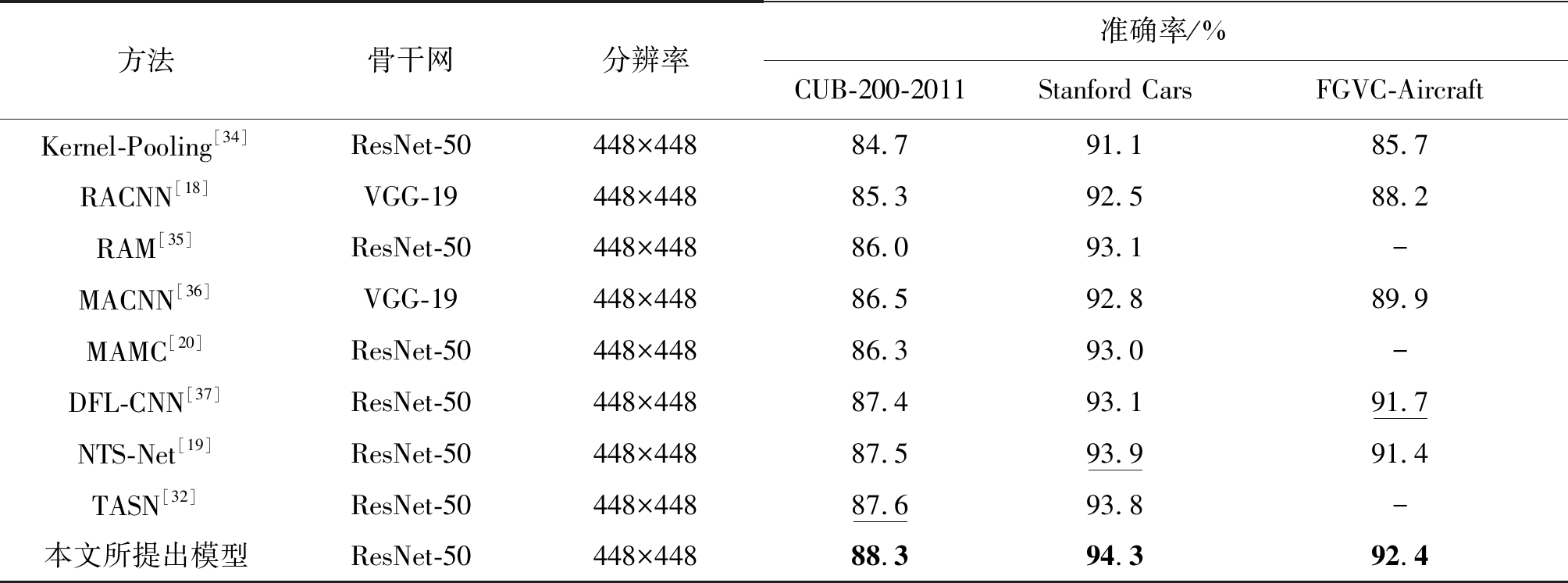

将本文实验结果与几种具有代表性的方法在CUB-200-2011,Stanford Cars和FGVC Aircraft这三个细粒度基准数据集上进行了分析比较,如表2所示,总的来说,本文方法在三个数据集上均实现了较好的效果。

可以观察到,本文的方法在鸟类分类任务上达到了最佳的精度。具体来说,本文方法的精度为88.3%,优于TASN[32]的87.6%。TASN表现良好,因为它首先使用一个子网络来找到显著性信息区域,然后从各个信息区域中提取到部件级特征并逐步蒸馏转移到对象级特征。而本文方法可以通过在图像中分散注意力来捕获更多相关区域,从而提升分类性能。

对于其他两个数据集,本文的方法也有较好的表现。在汽车上,达到了94.3%的top-1精度,超过了NTS-Net的93.9%。在飞机上,达到了92.4%的top-1精度,超过了DFL-CNN的91.7%。由于汽车和飞机是刚性对象,且有较清晰的背景,因此相比鸟类数据集分类精度较高[33]。

4.4 消融实验

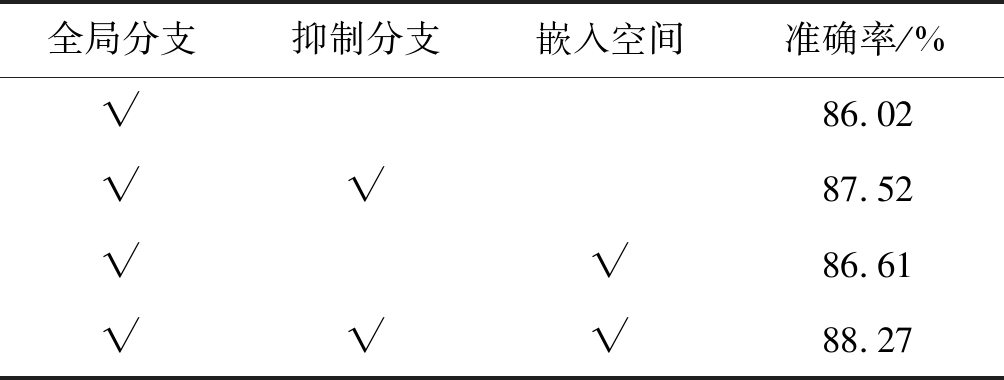

本文的模型主要由三个部分构成,包括全局分支,抑制分支,嵌入空间。为验证模型中各个组件的有效性,使用ResNet-50对本文所提出的分类模型在CUB-200-2011数据集中进行消融实验,即通过去除一部分组件来研究其对网络性能的影响,以便更好地理解网络的行为。表3列出了模型整体的top-1准确率和单个组件的top-1准确率,可以看出,当仅有全局分支时,分类准确率为86.02%,在全局分支的基础上加入抑制分支时,准确率提升了1.5%,在全局分支的基础上加入嵌入空间时,准确率提升了0.59%,而本文模型准确率为88.27%,相比全局分支提升了2.25%,由此可以看出,抑制分支通过迫使网络找到除最显著的部件之外的判别性部件来使信息区域多样化,嵌入空间通过引入一种嵌入损失使提取到的特征判别性更强,模型的各个组件都对性能有一定的贡献。

表2 在CUB-200-2011,Stanford Cars和FGVC Aircraft上的对比实验

Tab.2 Comparative experiment on CUB-200-2011, Stanford Cars and FGVC Aircraft

方法骨干网分辨率准确率/%CUB-200-2011Stanford CarsFGVC-AircraftKernel-Pooling[34]ResNet-50448×44884.791.185.7RACNN[18]VGG-19448×44885.392.588.2RAM[35]ResNet-50448×44886.093.1-MACNN[36]VGG-19448×44886.592.889.9MAMC[20]ResNet-50448×44886.393.0-DFL-CNN[37]ResNet-50448×44887.493.191.7NTS-Net[19]ResNet-50448×44887.593.991.4TASN[32]ResNet-50448×44887.693.8-本文所提出模型ResNet-50448×44888.394.392.4

图3 类激活图

Fig.3 Class activation map

表3 在CUB-200-2011上的消融实验

Tab.3 Ablation study on CUB-200-2011

全局分支抑制分支嵌入空间准确率/%√86.02√√87.52√√86.61√√√88.27

4.5 实验定性结果

为了进一步检验所设计模型的有效性,对模型各个分支进行了类激活图[38]可视化,即将特征图集进行加权重叠而形成的一个特征图,可以显示每个位置对其分类的重要程度。如图3所示,第一列为数据集中随机选取的原始图像,第二列为全局分支获得的类激活图,第三列为抑制分支获得的类激活图。可以看出在全局分支中,网络学习到了图像最显著的区域,如鸟的喙、汽车前照灯等,在抑制分支中,网络学习到了有利于细粒度分类的微妙的特征,如鸟的躯干、车轮等。多视角结合,使得网络模型的判断依据更为全面,既能学习到显著性区域,又能微妙地捕捉到细粒度特征。

5 结论

本文提出了一个多视角综合的细粒度图像分类模型,抑制分支迫使网络寻找易混淆类中微妙的判别性特征,全局分支直接将原始图像输入网络中,学习图像的整体结构。还引入了一个嵌入空间,将样本嵌入到低维空间中,学习一个特殊的嵌入损失函数对其进行训练,以尽可能多地捕获类内差异。网络模型的判断过程综合利用了全局特征和局部特征,使得网络模型的判断依据更为全面,既能照顾到整体结构,又能微妙地捕捉到细粒度特征。

在CUB-200-2011,Stanford Cars和FGVC Aircraft数据集上进行了实验,分类精度分别达到了88.3%,94.3%与92.4%,优于大多数现有的模型,且本文方法不需要使用任何人工标记的边界框或部件点注释,具有较高的实用性。本文所提出的细粒度图像分类算法还存在进一步提升准确率的可能,如探究图像通道之间的关联、与目标检测相结合、进一步挖掘图像特征等,需要在日后的研究工作中做进一步的完善和提升。

[1] Lecun Y, Bengio Y, Hinton G. Deep learning[J]. Nature, 2015, 521(7553): 436.

[2] Wen Yandong, Zhang Kaipeng, Li Zhifeng, et al. A Discriminative Feature Learning Approach for Deep Face Recognition[C]∥European Conference on Computer Vision, 2016: 499-515.

[3] Sun Yi, Wang Xiaogang, Tang Xiaoou. Deep Learning Face Representation from Predicting 10, 000 Classes[C]∥IEEE Conference on Computer Vision and Pattern Recognition, 2014: 1891-1898.

[4] Girshick R, Donahue J, Darrell T, et al. Rich Feature Hierarchies for Accurate Object Detection and Semantic Segmentation[C]∥IEEE Conference on Computer Vision and Pattern Recognition, 2014: 580-587.

[5] Ren Shaoqing, He Kaiming, Girshick R, et al. Faster R-CNN: Towards Real-Time Object Detection with Region Proposal Networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(6): 1137-1149.

[6] Long J, Shelhamer E, Darrell T. Fully Convolutional Networks for Semantic Segmentation[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 39(4): 640- 651.

[7] Murphy K, Papandreou G, Kokkinos I, et al. DeepLab: Semantic Image Segmentation with Deep Convolutional Nets, Atrous Convolution, and Fully Connected CRFs[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2018, 40(4): 834- 848.

[8] 罗建豪, 吴建鑫. 基于深度卷积特征的细粒度图像分类研究综述[J]. 自动化学报, 2017, 43(8): 1306-1318.

Luo Jianhao, Wu Jianxin. A Survey on Fine-Grained Image Categorization using Deep Convolutional Features[J]. Acta Automatica Sinica, 2017, 43(8): 1306-1318.(in Chinese)

[9] Russakovsky O, Deng Jia, Su Hao, et al. ImageNet Large Scale Visual Recognition Challenge[J]. International Journal of Computer Vision, 2015, 115(3): 211-252.

[10]Simonyan K, Zisserman A. Very Deep Convolutional Networks for Large-Scale Image Recognition[J]. Computer Science, 2014.

[11]Szegedy C, Liu Wei, Jia Yangqing, et al. Going Deeper with Convolutions[C]∥IEEE Conference on Computer Vision and Pattern Recognition, 2015.

[12]He Kaiming, Zhang Xiangyu, Ren Shaoqing, et al. Deep Residual Learning for Image Recognition[C]∥IEEE Conference on Computer Vision and Pattern Recognition, 2016.

[13]杨真真, 匡楠, 范露, 等. 基于卷积神经网络的图像分类算法综述[J]. 信号处理, 2018, 34(12): 1474-1489.

Yang Zhenzhen, Kuang Nan, Fan Lu, et al. Overview of Image Classification Algorithms Based on Convolutional Neural Networks[J]. Journal of Signal Processing, 2018, 34(12): 1474-1489.(in Chinese)

[14]Zheng Yixiao, Chang Dongliang, Xie Jiyang, et al. IU-Module: Intersection and Union Module for Fine-Grained Visual Classification[C]∥IEEE International Conference on Multimedia and Expo, 2020.

[15]Zhao Bo, Feng Jiashi, Wu Xiao, et al. A Survey on Deep Learning-based Fine-grained Object Classification and Semantic Segmentation[J]. International Journal of Automation and Computing, 2017, 14(2): 119-135.

[16]Chang Dongliang, Ding Yifeng, Xie Jiyang, et al. The Devil is in the Channels: Mutual-Channel Loss for Fine-Grained Image Classification[J]. IEEE Transactions on Image Processing, 2020, 29: 4683- 4695.

[17]Jaderberg M, Simonyan K, Zisserman A, et al. Spatial Transformer Networks[J]. Advances in Neural Information Processing System, 2015: 2017-2025.

[18]Fu Jianlong, Zheng Heliang, Mei Tao. Look Closer to See Better: Recurrent Attention Convolutional Neural Network for Fine-Grained Image Recognition[C]∥IEEE Conference on Computer Vision and Pattern Recognition, 2017.

[19]Yang Ze, Luo Tiange, Wang Dong, et al. Learning to Navigate for Fine-Grained Classification[C]∥European Conference on Computer Vision, 2018.

[20]Sun Ming, Yuan Yuchen, Zhou Feng, et al. Multi-Attention Multi-Class Constraint for Fine-Grained Image Recognition[C]∥European Conference on Computer Vision, 2018.

[21]Ding Yao, Zhou Yanzhao, Zhu Yi, et al. Selective Sparse Sampling for Fine-Grained Image Recognition[C]∥IEEE International Conference on Computer Vision, 2019.

[22]Lin Tsung-yu, Aruni R, Subhransu M. Bilinear CNN Models for Fine-Grained Visual Recognition[C]∥IEEE International Conference on Computer Vision, 2015: 1449-1457.

[23]Gao Yang, Beijbom O, Zhang Ning, et al. Compact Bilinear Pooling[C]∥IEEE Conference on Computer Vision and Pattern Recognition, 2015: 317-326.

[24]Kong Shu, Fowlkes C. Low-rank Bilinear Pooling for Fine-Grained Classification[C]∥IEEE Conference on Computer Vision and Pattern Recognition, 2016.

[25]Cui Yin, Zhou Feng, Lin Yuanqing, et al. Fine-Grained Categorization and Dataset Bootstrapping using Deep Metric Learning with Humans in the Loop[C]∥IEEE Conference on Computer Vision and Pattern Recognition, 2016.

[26]Sohn K. Improved Deep Metric Learning with Multi-class N-pair Loss Objective[J]. In Advances in Neural Information Processing Systems, 2016: 1857-1865.

[27]Schroff F, Kalenichenko D, Philbin J. Facenet: A Unified Embedding for Face Recognition and Clustering[J]. IEEE International Conference on Computer Vision, 2015: 815- 823.

[28]Wah C, Branson S, Welinder P, et al. The Caltech-UCSD Birds-200-2011 Dataset. Technical Report CNS-TR-2011-001, California Institute of Technology, 2011.

[29]Krause J, Stark M, Deng J, et al. 3D Object Representations for Fine-Grained Categorization[C]∥IEEE International Conference on Computer Vision Workshops, 2014.

[30]Maji S, Kannala J, Rahtu E, et al. Fine-Grained Visual Classification of Aircraft[J]. Tech. rep, 2013.

[31]Deng Jia, Dong Wei, Socher R, et al. ImageNet: A Large-Scale Hierarchical Image Database[C]∥IEEE Conference on Computer Vision and Pattern Recognition, 2009: 248-255.

[32]Zheng Heliang, Fu Jianlong, Zha Zheng-Jun, et al. Looking for the Devil in the Details: Learning Trilinear Attention Sampling Network for Fine-Grained Image Recognition[C]∥IEEE Conference on Computer Vision and Pattern Recognition, 2019.

[33]边小勇, 江沛龄, 赵敏, 等. 多分支神经网络模型的弱监督细粒度图像分类方法[J]. 计算机应用, 2020, 05:1295-1300.

Bian Xiaoyong, Jiang Peiling, Zhao Min, et al. Supervised Fine-Grained Image Classification Method based on Multi-Branch Neural Network Model[J]. Journal of Computer Applications, 2020, 05:1295-1300.(in Chinese)

[34]Cui Yin, Zhou Feng, Wang Jiang, et al. Kernel Pooling for Convolutional Neural Networks[C]∥IEEE Conference on Computer Vision and Pattern Recognition, 2017: 3049-3058.

[35]Li Zhichao, Yang Yi, Liu Xiao, et al. Dynamic Computational Time for Visual Attention[C]∥IEEE International Conference on Computer Vision, 2017.

[36]Fu Jianlong, Zheng Heliang, Mei Tao, et al. Learning Multi-attention Convolutional Neural Network for Fine-Grained Image Recognition[C]∥IEEE International Conference on Computer Vision, 2017.

[37]Wang Yaming, Morariu V I, Davis L S. Learning a Discriminative Filter Bank within a CNN for Fine-Grained Recognition[C]∥IEEE Conference on Computer Vision and Pattern Recognition, 2016.

[38]Zhou Bolei, Khosla A, Lapedriza A, et al. Learning Deep Features for Discriminative Localization[C]∥IEEE Conference on Computer Vision and Pattern Recognition, 2016: 2921-2929.