1 引言

随着信息、互联网等技术的迅猛发展,以及数字成像设备(如智能手机、数码相机等)的广泛使用,数字图像不仅成为人们日常生活和工作中的不可或缺的记录和传播信息的载体,而且在军事、艺术等多个领域发挥着越来越重要的作用。与此同时,数字图像具有易处理、可编辑、能伪造等特点。这给侦查取证、司法鉴定等需要确保信息真实性和完整性的工作造成了极大的障碍。为了解决这一问题,数字图像溯源取证技术引起了学术界的广泛关注。由于图像传感器制造工艺固有的问题所形成的光响应非均匀性(photo-response non-uniformity,PRNU)具有唯一性和稳定性[1-3],就像人类的指纹一样可以用来识别数字成像设备个体,进而用于完成图像来源鉴定任务。PRNU指纹提取主要包括三个步骤:一是滤波提取,提取包含PRNU的真实图像噪声;二是联合估计,利用同一数字成像设备获取的多幅图像计算噪声残差,然后使用最大似然估计法推导PRNU指纹;三是PRNU增强,去除同型号数字成像设备经过相同的图像信号处理器(Image Signal Processor, ISP)流程处理后的算法噪声,如镜头矫正、颜色插值、拜尔噪声去除、白平衡矫正、色彩矫正、伽马矫正、自动曝光控制等[4-5]。

为了提取可靠的PRNU指纹,研究者提出了许多有效的PRNU提取算法[6-11]。Lukas等人提出利用小波滤波去噪方法来提取PRNU指纹[6]。其中,小波滤波是一个两阶段的去噪滤波器,首先估计局部图像方差,然后在小波域中使用局部维纳滤波来获取去噪图像。得到多幅图像的噪声残差后,将其联合起来并利用最大似然法估计出PRNU指纹。该算法为数字图像中设备指纹提取研究方向开创性的工作,能够提取出具有较强鲁棒性的PRNU指纹,因而引起了学术界的广泛关注。后来,Cooper[7]提出了一种简化的去噪滤波策略,通过结合空间域的自适应滤波和中值滤波来实现PRNU指纹提取。首先,使用标准的自适应维纳滤波器直接在空域对图像进行滤波。然后,用两个级联的2×2中值滤波器抑制异常值像素。具体是与传统的小波滤波方法相比,该方法进一步提高了匹配和非匹配图像数据集的辨别能力。Cortiana等人提出一种基于稀疏3D变换域协同去噪滤波器的PRNU指纹提取方法,该滤波算法为性能最好的非深度学习类图像去噪算法之一,其中协同滤波是将图像中相似的2D块分组到3D数据数组中[8]。Kang等人提出一种高效的PRNU指纹提取方法[9]。首先,对所有的像素进行八近邻上下文自适应插值。该插值方法自适应地考虑平滑区域、边缘、其他等图像局部区域的不同特性。最后,采用维纳滤波得到更高质量的噪声残差。Zeng[10]提出一种基于内容自适应引导滤波器的PRNU指纹方法。内容自适应引导滤波器是近年来最成功的局部滤波方法之一,与全局优化滤波器相比,它算法简单、快速,在图像平滑、增强、去噪等多种应用中都有很好的表现。该PRNU指纹提取方法计算复杂度较低、具有较快的运算速度,可用于大规模的图像溯源取证。此外,为了实现大规模的图像溯源取证,文献[11]提出一种面向大规模计算优化的小波滤波PRNU提取方法。其中,为了克服现有相机和拍摄图像规模小的难题,作者使用了在线图像共享网站的图像数据。实验中测试了超过一百万张图像,涵盖了来自于150个型号的6896台不同的相机。实验中给出了FAR(false acceptance rate)和FRR(false rejection rate)的实际估计值,使我们有机会将实验数据与理论估计值进行比较。

上述研究工作表明,PRNU指纹的鲁棒性和有效性通常依赖于去噪滤波器,因此本文算法聚焦于如何采用有效的图像去噪方法来尽可能完整的提取PRNU指纹。图像去噪作为一项具有代表性的底层计算机视觉任务,是一个从给定噪声图像I恢复干净图像I0的过程。自然图像通常存在多种类型的噪声,其中在图像拍摄过程中,由于光照不足或高温等问题造成的噪声可以假定为服从高斯分布。为了简化求解,可以假设噪声n服从高斯分布,建立加性高斯白噪声(additive white Gaussian noise)模型I=I0+n。在过去的几十年里,许多研究工作致力于降低图像中的高斯噪声[12-17]。然而,基于传统机器学习方法的自然图像去噪的性能已经收敛,降噪水平的难以进一步的显著提升[18]。随着深度学习技术在今年来的火热发展,文献[19]使用一个普通的多层感知机网络就达到了和经典降噪算法[15]同样的降噪性能,进而大量的图像降噪方法[19-23]采用卷积神经网络(convolutional neural network,CNN)来提升图像去噪水平。

但是这些基于CNN的方法通常网络架构和训练方法上存在一定的局限性。例如,这些网络中使用的深度特征一般需要与输出具有相同的分辨率,这会消耗大量的GPU内存和训练时间[24]。为了解决这些问题,深度迭代缩放卷积神经网络(deep iterative down-up CNN model, DIDN)[24]通过连续重复的缩小与放大特征图的分辨率来提高GPU内存利用率和生成大的感受野,尽可能的挖掘潜在的真实噪声。本文算法将深度迭代缩放卷积神经网络应用到PRNU数字成像设备指纹提取算法中。首先通过连续重复的缩小与放大特征图的分辨率来提高GPU内存利用效率和生成大的感受野,尽可能的提取包含完整PRNU指纹的真实噪声,然后利用来自同一数字成像设备多幅图像的噪声残差来估计PRNU指纹。

2 深度迭代缩放卷积神经网络

深度迭代缩放卷积神经网络(deep iterative down-up CNN model, DIDN)[24]是一个改进的层次化U-Net网络[25],通过连续重复的缩小与放大特征图的分辨率可以提高GPU内存利用率,以及生成大的感受野。其中,感受野是神经网络中不同位置的神经元对原图像的感受范围的大小,而大的感受野有助于在全局上更好的提取图像真实噪声。图像噪声提取的越好,则其中能保留的PRNU噪声成分就越多,最终提取到的PRNU在用于图像来源鉴别时的性能会更强。DIDN网络主要包括四个部分:初始化特征提取、缩放块、重构块和增强处理。

2.1 初始化特征提取

假设输入一幅大小为H×W的图像,DIDN首先使用3×3的卷积核提取N个特征,同时设置步长为2,提取特征个数为

(1)

2.2 缩放块

缩放块由两个等比例缩小处理和两个等比例放大处理构成,其中等比例缩小使用的是步长为2,3×3 的卷积核,等比例放大使用的是亚像素卷积[26]。亚像素卷积进行上采样的核心是将r2(r为放大倍率)个通道h×w大小的特征图放大为rh×rw,

IUP=PS(WL*fL-1+bL)

(2)

其中,IUP为放大后的特征图,PS(·)为周期性混排运算符, fL-1为L-1层特征图,bL为L层偏置。在等比例缩小过程中,下采样使得特征图分辨率在垂直和水平方向上各减少一半,同时将特征的数量增加一倍。在等比例放大前,由于输入特征的数量减少到缩小前的四分之一,使用亚像素卷积上采样需要将特征图利用1×1的卷积核增加通道数来保持信息密度。此外, DIDN类似于U-Net网络将同一层级的特征进行连接复用,同时利用跳跃连接[27]将网络首尾两端模块的特征进行连接。本文使用的网络将利用6个重复的缩放块进行等比例缩放。

2.3 重构块

借鉴MemNet网络[20],DIDN网络将重构块放到了最后一个缩放块后面来充分利用所有的局部输出。其中,重建块由9个卷积层(Conv)和8个PReLU(parametric rectified linear units)[28]构成,包括四个连接的“Conv+PReLU+Conv+PReLU”加上一个“Conv”。所有的缩放块的输出形成重建块输入,同时所有的重建块输出连接起来输入到增强处理部分。

2.4 增强块

DIDN网络通过一个1×1的卷积核来减少重构块输出的特征图数量,同时利用亚像素卷积进行上采样来生成最终的降噪图像,进而可以得到包含PRNU指纹的真实噪声。

3 本文算法

本文提出了一种结合DIDN网络的光响应非均匀性PRNU设备指纹提取算法,该算法框架如图1所示,具体计算步骤如下:

(1)真实噪声提取

输入同一成像设备获取的M幅图像Ii,i=1,2,…,M,利用DIDN网络通过特征提取、缩放块、重构块和增强处理等过程,对原始图像Ii进行去噪处理,得到去噪图像![]()

(2)噪声残差计算

计算任意图像Ii对应的噪声残差Wi为

图1 本文算法框架图

Fig.1 The algorithm diagram proposed in this paper

![]()

(3)

(3)PRNU设备指纹估计

光响应非均匀性PRNU是由于成像传感器的半导体制造工艺存在的固有问题,导致感光单元在进行光电转换时普遍存在光敏特性差异。同时PRNU在较长的时间内不会随着环境的变化而发生改变,就如同人类手指的指纹一样,可以作为设备指纹来识别数字成像设备的唯一性。假设I为数字成像设备输出的图像,I0为成像过程中不存在任何瑕疵的真实场景图像,可以建立如下传感器输出模型:

I=I0+I0K+Θ

(4)

其中,K是PRNU因子,即传感器指纹;Θ是多种其他噪声的混杂,如量化噪声、散射噪声、输出噪声等。设备指纹K可以利用同一成像设备拍摄M幅图像I1,I2,…,IM和公式(3)获得噪声残差W1,W2,…,WM进行估计,利用最大似然法可以推导出设备指纹为

(5)

公式(5)采用的是像素级的内积操作。为了更好地估计PRNU,最好选择M幅平滑的图像。在实践中一般推荐使用失焦的蓝天白云图像。但是,本文的实验部分并没有根据这一推荐进行选择。而是,从图像数据集中随机选择了M幅图像用于PRNU提取算法性能的比较。

(4)溯源图像噪声残差计算

输入溯源图像Iz,利用DIDN模型可以得到去噪后的图像![]() 进一步根据公式(3),可以得到对应的噪声残差

进一步根据公式(3),可以得到对应的噪声残差![]()

(5)相似度计算

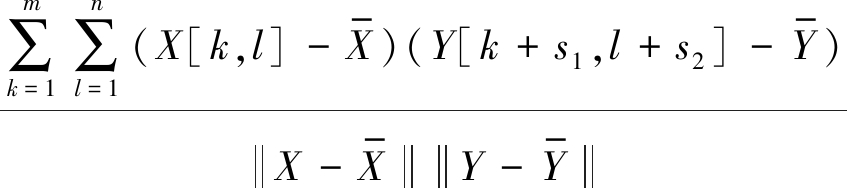

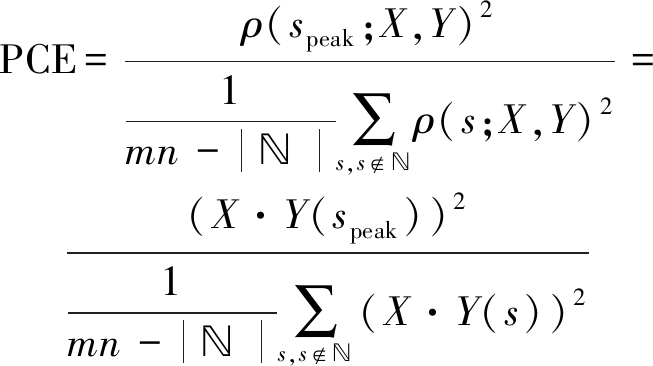

度量设备和溯源图像PRNU指纹的相似度,可以利用峰值相关能量比(peak to correlation energy ratio, PCE)来进行计算,当PCE值超过设定的阈值,就可以判定溯源图像来自比对设备。计算PCE值,首先需要求出最大化正则化的相关系数ρ[29],也就是

(6)

其中,

ρ(s1,s2;X,Y)=

(7)

||·||为L2范数,![]() 图像大小为m×n。然后,假设峰值出现在公式(6)最大值speak=[s1,s2]时,进一步可以得到

图像大小为m×n。然后,假设峰值出现在公式(6)最大值speak=[s1,s2]时,进一步可以得到

(8)

其中, 是峰值附近一个较小的近邻区域(本文

是峰值附近一个较小的近邻区域(本文 为11×11像素的平方区域);X·Y(s)是通过向量s循环移位得到的

为11×11像素的平方区域);X·Y(s)是通过向量s循环移位得到的![]() 和

和![]() 之间的点积。

之间的点积。

4 实验结果与分析

本文算法在两个数据集上进行了性能测试,一个是Dresden数据集[30],涉及的数字成像设备包括25个型号的73台数码相机,数据包括16961幅JPEG图像和1491 幅RAW图像,是当前使用最为广泛的相机图像来源取证数据集;另外一个是Daxing数据集[31],涉及的数字成像设备共包括22个型号的90台智能手机,数据包括43400幅JPEG图像,是当前图像规模最大的智能手机来源取证数据集。

为了检验算法在不同分辨率下的性能,实验中将Dresden和Daxing两个数据集中的图像从左上角开始统一裁剪为三种尺寸:128×128、256×256和512×512。在DIDN训练过程中,所有图像割成64×64的分块,一个训练批次包括16对随机分块,一个学习周期包括3.6万次迭代,网络训练使用Adam优化器以及初始学习率设为10- 4,并且学习率每过三个学习周期减半,共使用6个重复的缩放块进行等比例缩放,提取128个初始特征图[24]。在PRNU提取过程中,对于每一个数字成像设备,首先随机选择50幅图像提取设备指纹,然后在其他图像中随机挑选100幅图像并计算噪声残差,最后计算PRNU指纹和噪声残差之间的PCE值。

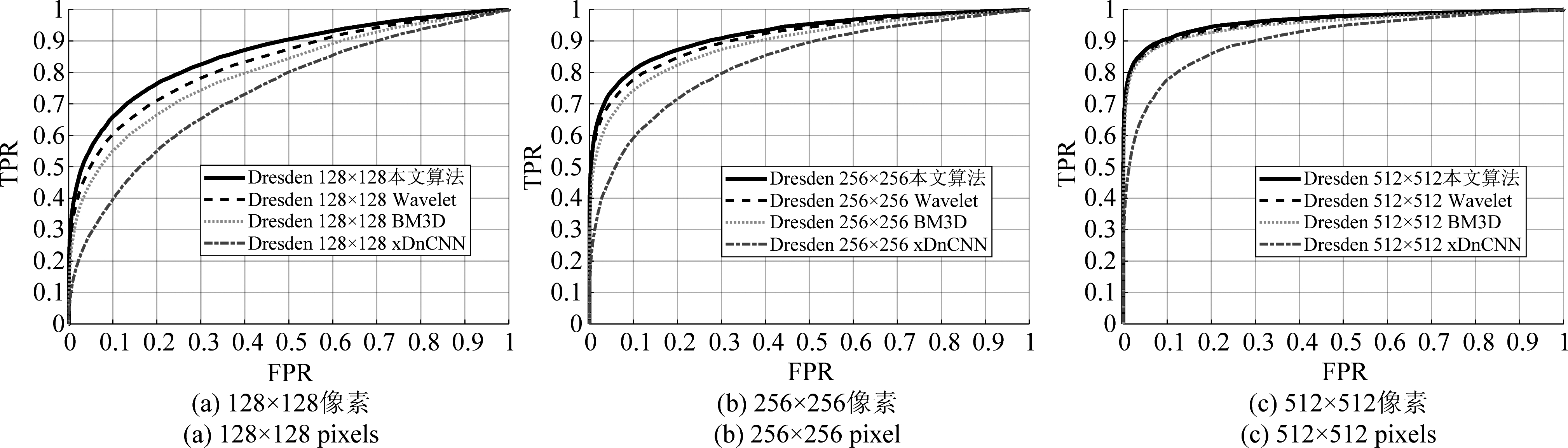

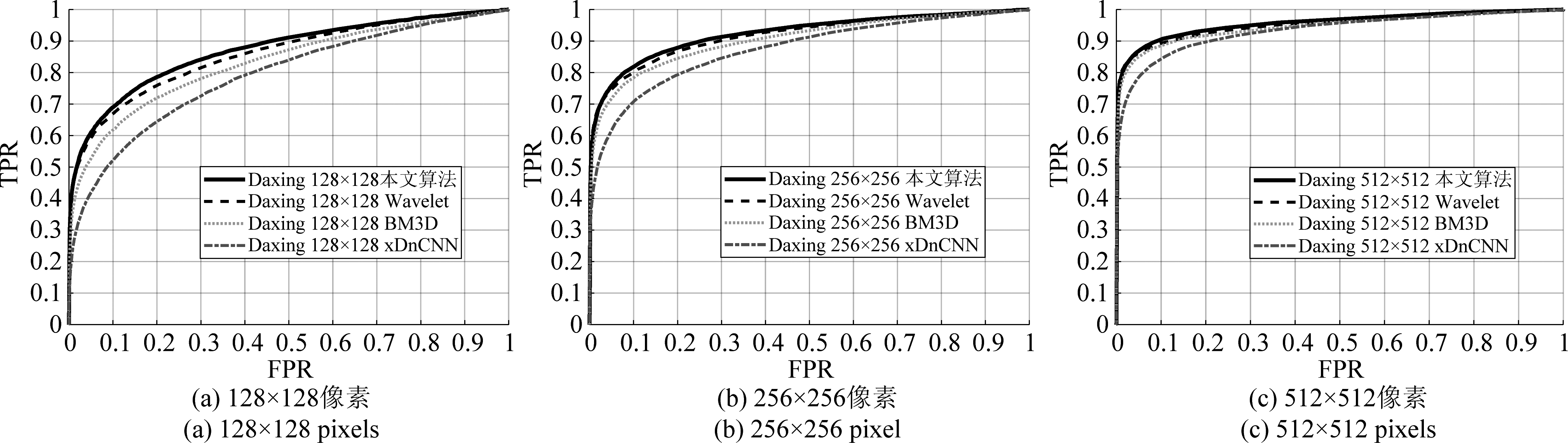

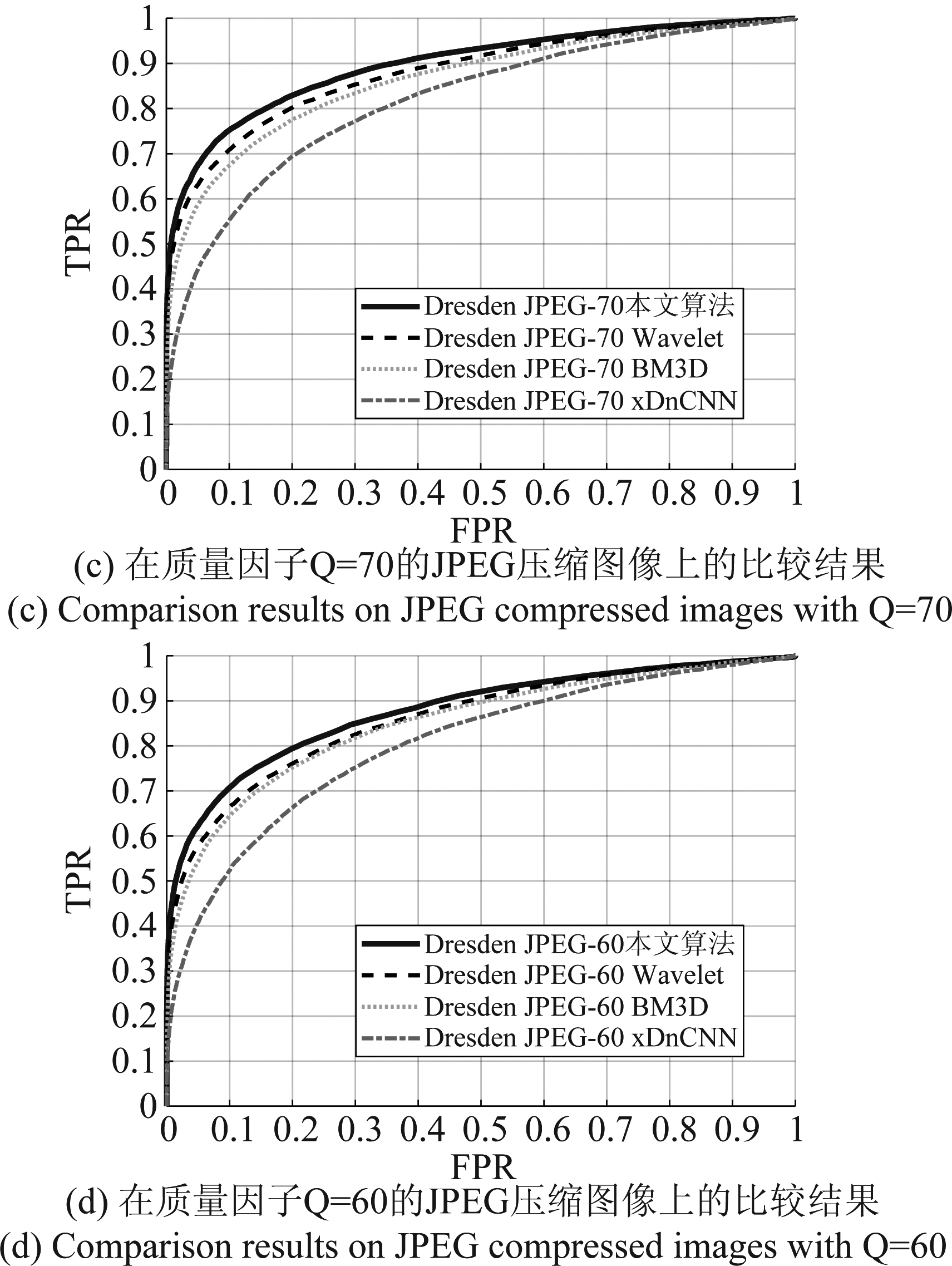

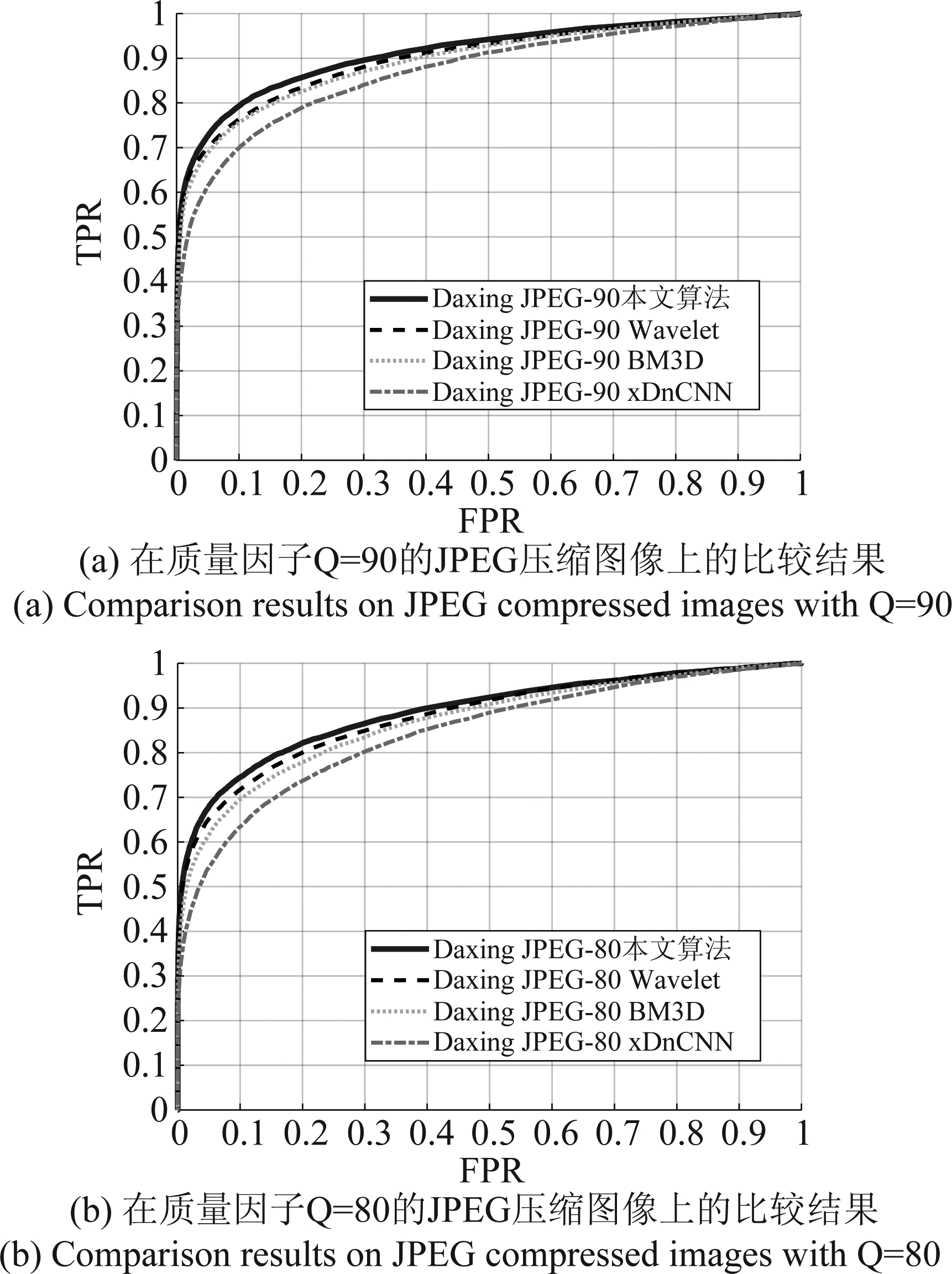

为了验证算法的有效性,本文算法与基于小波变化(Wavelet)的算法[11]、基于块匹配3D滤波(BM3D)的算法[8]以及基于前馈去噪卷积神经网络(xDnCNN)[32]的算法等进行了比较实验。其中,基于Wavelet的算法的代码来自于[33], 基于BM3D的算法的代码来自于[34],基于xDnCNN的算法的代码来自于[35]。比较实验所采用的性能指标为由真阳率(TPR)和假阳率(FPR)组成的ROC曲线。比较结果如图2和图3所示。

从图2可以看出,在相机图像数据集Dresden上128×128、256×256和512×512像素等三种不同分辨率下,本文算法既优于深度学习类的基于xDnCNN的算法,又优于传统的基于Wavelet的算法和基于BM3D的算法。从图3可以看出,在智能手机数据集Daxing上三种不同分辨率下,本文算法同样优于基于Wavelet的算法、基于BM3D的算法、基于xDnCNN的算法等三种算法。此外,从图2和图3可以看到,本文算法和基于Wavelet的算法、基于BM3D的算法、基于xDnCNN的算法相比,图像的分辨率越小,本文算法的性能优势越明显。即,其他三种算法与本文算法的性能差距在128×128像素图像上要大于 在256×256像素图像上,而在256×256像素图像上的差距要大于在512×512像素图像上。

图2 Dresden数据集上的实验结果比较

Fig.2 Comparison of experimental results on Dresden dataset

图3 Daxing数据集上的实验结果比较

Fig.3 Comparison of experimental results on Daxing dataset

通过对比图2和图3可以发现,图3的ROC曲线要优于图2的ROC曲线。例如,对于本文算法,当图像大小为128×128和FPR=0.1时,Daxing数据集的TPR=0.7,高于Dresden数据集上的TPR=0.66。图3的实验结果来自于智能手机拍摄的Daxing数据集,而图2的实验结果来自于数码相机(主要是单反相机)拍摄的Dresden数据集。这一现象也表明,同一算法在智能手机拍摄的图像上的性能表现要优于在数码相机拍摄的图像上的表现。造成这一差异的主要原因是智能手机的图像传感器的制作工艺要低于数码相机,这也导致智能手机的图像传感器更容易被区分。

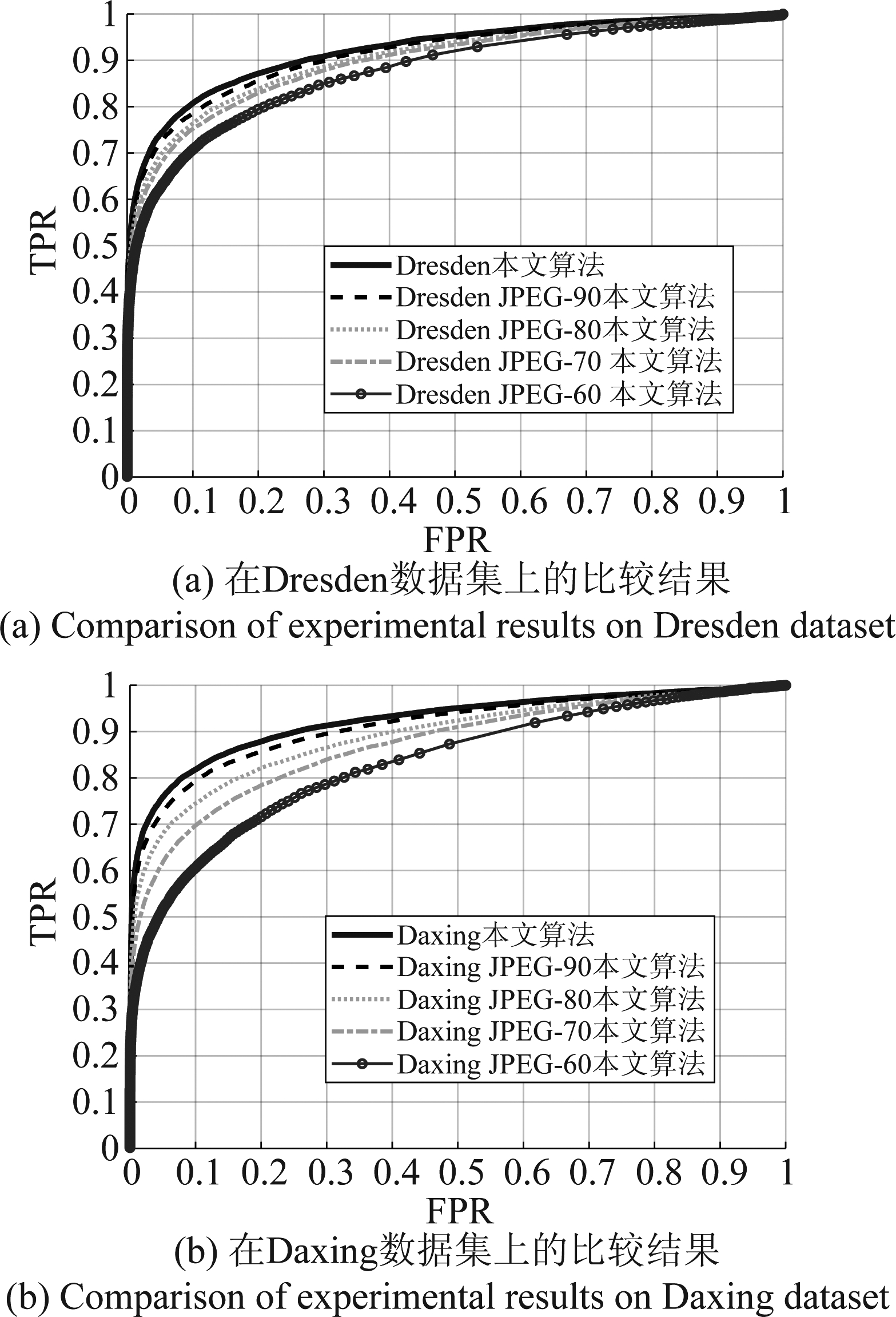

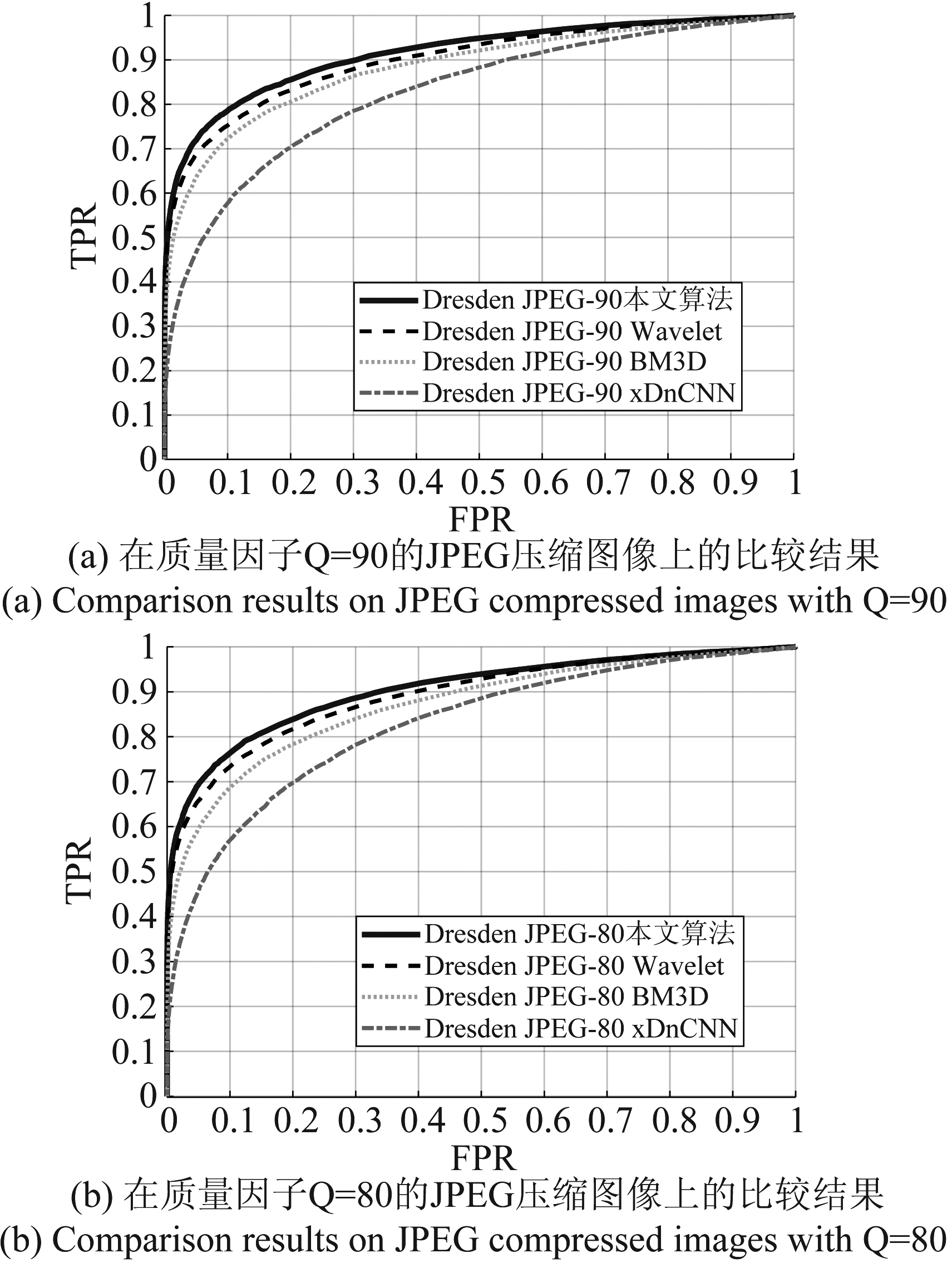

JPEG压缩是图像在传输、存储、使用的过程中经常运用的处理操作。因此,验证算法对JPEG压缩处理的鲁棒性是非常必要的。为了验证本文算法对JPEG压缩处理的鲁棒性,在质量因子为Q=60、Q=70、Q=80、Q=90等4个不同强度的JPEG压缩操作下,并同时在Dresden数据集和Daxing数据集上(图像分辨率分别为256×256),对本文算法的性能进行实验验证。实验采用的指标仍然是ROC曲线。实验结果如图4所示。实验结果表明随着JPEG压缩强度的增强,在Daxing数据集上本文算法的性能下降速度要高于在Dresden数据上。另外,在质量因子为Q=60、Q=70、Q=80、Q=90等4个不同强度的JPEG压缩操作下,还进行了本文算法与基于Wavelet的算法、基于BM3D的算法、基于xDnCNN的算法等三种算法的比较实验。实验结果如图5和图6所示。其中,图5为在Dresden数据集上的比较结果,图6为在Daxing数据集上的比较结果。这些JPEG压缩下的比较实验结果都显示出了本文算法在JPEG压缩下仍然要优于其他三种算法。

图4 在不同质量因子的JPEG压缩下本文算法的性能比较

Fig.4 Performance comparison of the proposed algorithm in JPEG compression with different compression factors

图5 在不同质量因子的JPEG压缩下本文算法与 其他算法在Dresden数据集上的性能比较

Fig.5 Performance comparison of on Dresden dataset under JPEG compression with different compression factors

图6 在不同质量因子的JPEG压缩下本文算法与 其他算法在Daxing数据集上的性能比较

Fig.6 Performance comparison of on Daxing dataset under JPEG compression with different compression factors

综合来看,无论是对智能手机图像还是数码相机图像,无论对大分辨率还是小分辨率图像,无论图像是否经历二次JPEG压缩,本文算法的性能与以上三种算法对比都具有一定的优势。这也表明本文算法在图像溯源取证方面具有的更好的识别率和普适性。

5 结论

本文首先分析了深度迭代缩放卷积神经网络的模型结构,然后结合该网络提出了数字成像设备PRNU指纹提取算法。最后,实验结果表明本文算法利用深度迭代缩放卷积网络,连续重复的缩小与放大特征图的分辨率来提高GPU内存利用效率和生成大的感受野,有助于尽可能完整的提取PRNU指纹。同时,本文算法在不同数据集上、不同分辨率、不同强度的JPEG压缩下与三种算法的性能比较实验验证了本文算法普适性。

[1] Chen M, Fridrich J, Goljan M, et al. Determining Image Origin and Integrity Using Sensor Noise[J]. IEEE Transactions on Information Forensics and Security, 2008, 3(1): 74-90.

[2] Yang Pengpeng, Baracchi D, Ni Rongrong, et al. A Survey of Deep Learning-Based Source Image Forensics[J]. J. Imaging 2020, 6(3): 1-24.

[3] 蒋翔, 韦世奎, 赵瑞珍, 等. 数字图像的设备溯源技术综述[J]. 北京交通大学学报, 2019, 43(2): 48-57.

Jiang Xiang, Wei Shikui, Zhao Ruizhen, et al. Survey of imaging device source identification[J]. Journal of Beijing Jiaotong University, 2019, 43(2): 48-57.(in Chinese)

[4] Al-Ani M, Khelifi F. On the SPN Estimation in Image Forensics: A Systematic Empirical Evaluation[J]. IEEE Transactions on Information Forensics and Security, 2017, 12(5): 1067-1081.

[5] 杨锐, 骆伟祺, 黄继武. 多媒体取证[J]. 中国科学-信息科学, 2013, 43(12): 1654-1672.

Yang Rui, Luo Weiqi, Huang Jiwu. Multimedia forensics[J]. China Science-Information Science, 2013, 43(12): 1654-1672.(in Chinese)

[6] Lukas J, Fridrich J, Goljan M. Digital camera identification from sensor pattern noise[J]. IEEE Transactions on Information Forensics and Security, 2006, 1(2): 205-214.

[7] Alan J Cooper. Improved photo response non-uniformity (PRNU) based source camera identification[J]. Forensic Science International, 2013, 226(1-3): 132-141.

[8] Cortiana Andrea, Conotter Valentina, Boato Giulia, et al. Performance Comparison of Denoising Filters for Source Camera Identification[J]. Proc Spie, 2011, 7880(1): 788007-788007- 6.

[9] Kang Xiangui, Chen Jiansheng, Lin Kerui, et al. A context-adaptive SPN predictor for trustworthy source camera identification[J]. J Image Video Proc., 2014, 19 (2014): 1-11.

[10]Zeng Hui, Kang Xiangui. Fast source camera identification using content adaptive guided image filter[J]. Journal of Forensic Sciences, 2016, 61(2): 520-526.

[11]Miroslav Goljan, Jessica Fridrich, Tom š Filler. Large scale test of sensor fingerprint camera identification[C]∥Media Forensics and Security. USA: SPIE, 2009: 725401-725412.

š Filler. Large scale test of sensor fingerprint camera identification[C]∥Media Forensics and Security. USA: SPIE, 2009: 725401-725412.

[12]Mihcak M Kivanc, Kozintsev I, Ramchandran K, et al. Low-complexity image denoising based on statistical modeling of wavelet coefficients[J]. IEEE Signal Processing Letters, 1999, 6(12): 300-303.

[13]Buades A, Coll B, Morel J M. A non-local algorithm for image denoising[C]∥IEEE Conference on Computer Vision and Pattern Recognition. San Diego, CA, USA: IEEE, 2005: 60- 65.

[14]Elad M, Aharon M. Image Denoising Via Sparse and Redundant Representations Over Learned Dictionaries[J]. IEEE Transactions on Image Processing, 2006, 15(12): 3736-3745.

[15]Dabov K, Foi A, Katkovnik V, et al. Image Denoising by Sparse 3-D Transform-Domain Collaborative Filtering[J]. IEEE Transactions on Image Processing, 2007, 16(8): 2080-2095.

[16]袁珍, 林相波, 王新宁. 滤除图像中混合噪声的LSE模型[J]. 信号处理, 2013, 29(10): 1329-1335.

Yuan Zhen, Lin Xiangbo, Wang Xinning. The LSE model to denoise mixed noise in images[J]. Journal of Signal Processing, 2013, 29(10): 1329-1335.(in Chinese)

[17]张智勇, 常侃, 陈诚, 等. 应用残差总变分及低秩表示的视频去噪算法[J]. 信号处理, 2016, 32(5): 558-566.

Zhang Zhiyong, Chang Kan, Chen Cheng, et al. A Video Denoising Algorithm Using Residual Total Variation and Low-Rank Representation[J]. Journal of Signal Processing, 2016, 32(5): 558-566.(in Chinese)

[18]Levin A, Nadler B. Natural image denoising: Optimality and inherent bounds[C]∥IEEE Conference on Computer Vision and Pattern Recognition Workshops (CVPR). USA: IEEE, 2011: 2833-2840.

[19]Burger H C, Schuler C J, Harmeling S. Image denoising: Can plain neural networks compete with BM3D?[C]∥IEEE Conference on Computer Vision and Pattern Recognition Workshops (CVPR). USA: IEEE, 2012: 2392-2399.

[20]Tai Y, Yang J, Liu X, et al. MemNet: A Persistent Memory Network for Image Restoration[C]∥IEEE International Conference on Computer Vision (ICCV), Venice: IEEE, 2017: 4549- 4557.

[21]Zhang Kai, Zuo Wangmeng, Zhang Lei. FFDNet: Toward a Fast and Flexible Solution for CNN-Based Image Denoising[J]. IEEE Transactions on Image Processing, 2018, 27(9): 4608- 4622.

[22]Zhang Yulun, Tian Yapeng, Kong Yu. Residual Dense Network for Image Super-Resolution[C]∥IEEE Conference on Computer Vision and Pattern Recognition, Salt Lake City, UT, USA: IEEE, 2018: 2472-2481.

[23]Lefkimmiatis S. Universal Denoising Networks: A Novel CNN Architecture for Image Denoising[C]∥IEEE Conference on Computer Vision and Pattern Recognition, Salt Lake City, UT, USA: IEEE, 2018: 3204-3213.

[24]Yu S, Park B, Jeong J Deep Iterative Down-Up CNN for Image Denoising[C]∥IEEE Conference on Computer Vision and Pattern Recognition Workshops (CVPRW). Long Beach, CA, USA: IEEE, 2019: 2095-2103.

[25]Ronneberger O, Fischer P, Brox T. U-Net: Convolutional Networks for Biomedical Image Segmentation[C]∥International Conference on Medical Image Computing and Computer-Assisted Intervention. Switzerland: Springer, 2015: 234-241.

[26]Shi Wenzhe, Caballero Jose, Husz r Ferenc. Real-Time Single Image and Video Super-Resolution Using an Efficient Sub-Pixel Convolutional Neural Network[C]∥IEEE Conference on Computer Vision and Pattern Recognition (CVPR), Las Vegas, NV, USA: IEEE, 2016: 1874-1883.

r Ferenc. Real-Time Single Image and Video Super-Resolution Using an Efficient Sub-Pixel Convolutional Neural Network[C]∥IEEE Conference on Computer Vision and Pattern Recognition (CVPR), Las Vegas, NV, USA: IEEE, 2016: 1874-1883.

[27]He Kaiming, Zhang Xiangyu, Ren Shaoqing. Deep Residual Learning for Image Recognition[C]∥IEEE Conference on Computer Vision and Pattern Recognition (CVPR), Las Vegas, NV, USA: IEEE, 2016: 770-778.

[28]He Kaiming, Zhang Xiangyu, Ren Shaoqing. Delving Deep into Rectifiers: Surpassing Human-Level Performance on ImageNet Classification[C]∥IEEE International Conference on Computer Vision (ICCV), Santiago: IEEE, 2015: 1026-1034.

[29]Kay S M. Fundamentals of Statistical Signal Processing[M]. Detection Theory, Prentice Hall, 1998.

[30]Gloe T, Böhme R. The Dresden image database for benchmarking digital image forensics[J]. Journal of Digital Forensic Practice, 2010, 3(2/4): 150-159.

[31]Tian Huawei, Xiao Yanhui, Cao Gang, et al. Daxing Smartphone Identification Dataset[J]. IEEE Access, 2019, 7: 101046-101053.

[32]Kligvasser I, Shaham T R, Michaeli T. xUnit: Learning a Spatial Activation Function for Efficient Image Restoration[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), Salt Lake City, UT, 2018: 2433-2442.

[33]Jessica Fridrich. Camera Fingerprint-Matlab implementation[EB/OL]. http:∥dde.binghamton.edu/download/camera_fingerprint, July 31, 2020.

[34]Alessandro Foi. Image and video denoising by sparse 3D transform-domain collaborative filtering[EB/OL]. http:∥www.cs.tut.fi/~foi/GCF-BM3D/index.html#ref_software, July 31, 2020.

[35]Kligvasser. xUnit[EB/OL]. https: ∥github. com/kligvasser/xUnit, July 31, 2020.