1 引言

视觉目标跟踪是计算机视觉与视频处理中最基本的任务之一,在视频内容分析、智能交通系统、人机交互、无人驾驶、视觉导航等领域有着重要的应用。典型的在线跟踪方法在给定视频第一帧中目标的边界框后,以自动的方式完成后续所有帧的目标定位。在真实的应用场景中,目标外观及场景的变化错综复杂,实现目标的精准跟踪是一个极具挑战性的问题。

在视觉目标跟踪中,初始目标区域通常由一个矩形框框定,其包含目标本身的同时也不可避免地引入了目标周围的局部背景区域。而且,在跟踪序列中目标对象通常处于一个不断变化的环境中,后续帧中目标周围的背景区域将变化不定。不断变化的背景区域将造成跟踪算法的关注点模糊不清甚至产生歧义,特别是在跟踪过程中存在各种噪声因素(例如光照变化、相似物、遮挡和运动模糊)干扰的情况下。因此,如何提高跟踪算法对干扰背景的区分能力,对提高跟踪算法的性能而言将十分重要。其次,相较于分类、检测及识别等其他高层计算机视觉任务,跟踪任务更加关注于对事先未知的非限定目标实现准确的定位,所以如何构建一个服务于跟踪任务的深度网络框架也十分关键。

考虑到以上问题,本文提出了一种基于多注意力图的视觉目标跟踪算法。具体的说,鉴于深度卷积神经网络(Convolutional Neural Networks,CNN)是对图像建立了层次化的表达,更深层特征包含更抽象的语义信息,对物体外观变化的不变性更强。首先,在基于孪生匹配的视觉跟踪框架下,建立了一种关注于前景目标区域特征表达的深度网络。该网络通过构建梯度注意力图损失函数项来引导网络训练,提升网络区分目标和干扰背景的能力。此外,为了进一步强化目标的特征表达,本文的方法还嵌入了通道注意力图和空间注意力图,并结合显式的梯度引导注意力网络结构,自动发掘有区分的特征表示。

本文的主要贡献总结如下:(1)提出了一种自适应前景敏感的特征提取与表征的深度网络,利用导向化的网络反向传播梯度来表征基础卷积滤波器的重要性,筛选高激活力特征,构建目标的模板掩膜,获得自适应关注前景主体部分的网络模型。(2)提出了对特征通道维和空间维敏感的网络模块,在CNN的结构上强化场景细节的捕捉能力。(3)建立了以前景/背景二元划分为导向的梯度损失,有效抑制背景干扰物对跟踪稳健性的影响。

本文的其余部分安排如下。在第二部分中,讨论了与本文提出的跟踪算法相关的工作。第三部分,将阐述提出方法的实现细节。我们在跟踪数据集中评估了提出的方法,并分别在第四部分讨论了相应的性能。

2 相关工作

大多数现有的基于卷积神经网络的视觉跟踪算法都试图使用预训练模型的网络权值,比如VGG-Net[1]。在HCF[2]中,使用一个预先训练好的卷积网络来提取浅卷积和深卷积特征,然后利用这些特征通过相关滤波器来预测目标的位置。Wang[3]等人提出了一种通用网络来捕获目标的类别信息,以及一种特定的网络来区分目标和背景。在文献[4]中,采用CNN预测目标特异性显著性图,突出目标区域。在STCT[5]中,神经网络是通过学习一组最优的基础学习者来训练的。采用二值映射对卷积层进行掩码,以减少过拟合。Qi[6]等人提出将基于相关滤波器的多个弱跟踪算法组合成一个更强的跟踪算法。需要注意的是,上述跟踪算法中使用的基本卷积神经网络最初都是为图像识别而训练的,在视觉跟踪任务中可能表现不佳。Nam[7]等人提出了一种用于视觉跟踪的多域卷积神经网络。该网络由共享层和特定领域层的多个分支组成,可以使用标记的视频序列进行充分的预训练。然而,这些对象特定的方法都需要在线更新模型,并且运行速度相对较慢。此外,在实际的跟踪任务中目标往往是由人工或检测器给定,且目标形式可能任意且无法事先预知,因此离线训练一个涵盖各种目标的跟踪器尤为困难也不现实。

基于孪生网络的视觉跟踪 将视觉目标跟踪当作一种相似度匹配,在搜索区域中进行逐点的目标模板匹配,然后在结果中找到最大相似度的目标中心的应用方式更贴合跟踪任务,孪生网络框架就是基于相似度匹配的网络架构。近几年,以孪生网络为基础结构的目标跟踪算法展现出了巨大的发展潜力。SiamFC[8]开创性地将孪生网络用于跟踪,利用卷积代替相关滤波,全卷积的结构可以直接将模板图像与大块的候选区域进行匹配,全卷积网络最后的输出就为我们需要的响应图。在响应图中寻找响应值最高的一点,该点在候选区域中的对应部分,为预测的目标位置。与使用第一帧作为固定模板的。与SiamFC[8]不同,DSiam[9]通过在线的方式从历史帧中学习目标的外观变化,并通过分离提取前景与背景信息,达到有效的背景抑制。SiamRPN[10]利用候选区域提案网络,增加判别分支和回归分支。在判别分支,通过分离前景与背景,判断该候选区域是否存在目标物体,进而增强前景、抑制背景。由于基础网络是从目标检测领域迁移而来,对于同类物体的区分能力较弱。为了精准分离目标主体,DaSiamRPN[11]针对目标干扰物,引入干扰物感知模型,增强网络的类内区分力。SiamRPN++[12]使用多层聚合的方式,以浅层特征与深层特征融合的方式,更大程度的发挥深层网络的特征捕捉能力。SiamMask[13]结合分割算法思想,在孪生网络框架后增加分割网络损失函数的计算分支,以分割分支提升跟踪精度提高跟踪精度。SiamDW[14]加深了Siamese网络的宽度与深度,优化特征提取过程。TADT[15]针对跟踪关注于对前景和背景的两类划分,增加了分类网络的类内距离训练,减少跟踪时使用的特征,并提高了跟踪速度。借助图像分类中的语义特征与图像匹配中外观特征之间的互补特性,SA-Siam[16]构建了双重孪生网络,聚焦于提升跟踪器区分变化目标物体的能力。综上,视觉目标跟踪算法的跟踪精度易受背景杂乱等干扰物影响,目前解决这一类问题的方法是分离目标前景背景信息,构建杂乱背景下的目标外观表达以提高目标跟踪精度。

视觉注意力机制 人类视觉系统的一个重要特性是不试图一次处理整个场景。相反,为了更好地捕捉视觉结构,利用一系列的局部聚焦,选择性地聚焦于突出的部分。卷积神经网络工作机制是一种受限于局部感受野的通过卷积滤波器融合空间信息和通道信息并将它们组合从而为网络效力,通过叠加一系列非线性层和下采样层交织的神经网络,CNN达到了对全局感受野信息的捕获从而达到描述整个图像的目的。最近,有几次结合注意力机制,提高CNNs在大规模分类任务中的性能的尝试。Wang[17]等人提出了一种残差注意网络,该网络使用了一种编码器和解码器形式的注意模块。通过改进特征映射,网络不仅性能良好,而且对噪声输入具有鲁棒性。DASiam[18]以表达能力更强的主干网络和双重注意力机制,解决由目标外观变化导致的跟踪漂移问题。在我们的工作中,并未基于三维卷积特征直接计算注意力图,而是采用了计算复杂度与参数量均较少的通道维与空间维分别计算注意力图的方式。

梯度反向传播的可解释性 Grad-CAM[19]提出了一种卷积神经网络的解释方法,通过构建热力图的形式,直观展示出卷积神经网络学习到的特征。基于梯度反向传播的可解释性,我们将获得的梯度用于规范网络训练和突出目标主体两方面,达到区分建模目标前景与局部背景的目的。

3 总体架构

基于多注意力图的孪生视觉目标跟踪将视觉目标跟踪视为图像匹配,即在搜索区域中逐点进行局部图像与模板图像间的相似性匹配计算,并取响应值最高的位置作为跟踪结果。本文方法基于SiamFC框架,给定模板图像x和搜索图像z,φ(·)表示特征提取网络,则相似性匹配响应得分为:

f(x,z)=φ(x)*φ(z)+b1

(1)

其中,*为卷积相关运算,b1为偏置。

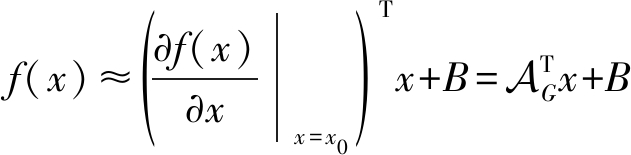

如图1所示为基于多注意力图的视觉目标跟踪算法框图,该网络通过引入多种注意力机制来提升网络对目标和干扰背景的区分能力。具体地,首先通过权值共享的孪生深度网络提取模板帧和搜索帧的图像特征,然后在每一层特征提取后,将各层特征分别输入通道注意力和空间注意力网络中。值得注意的是,通道注意力(Channel Attention,CA)和空间维注意力(Spatial Attention,SA)网络不会改变输入特征的大小,该视觉注意力机制可以增加网络对信息丰富特征的敏感性,通过增加区分特征的权重以提升网络的表达和区分能力,在不显著增加计算量和参数量的前提下增强模型的表征能力。在孪生网络特征提取完成后,将获得的相似性匹配响应分别与目标和干扰背景两个高斯标签进行逻辑匹配计算,再通过梯度反向传播获得梯度引导注意力图并将其作用于孪生网络特征提取阶段,完成对模板图像特征的强化。

3.1 梯度引导注意力嵌入

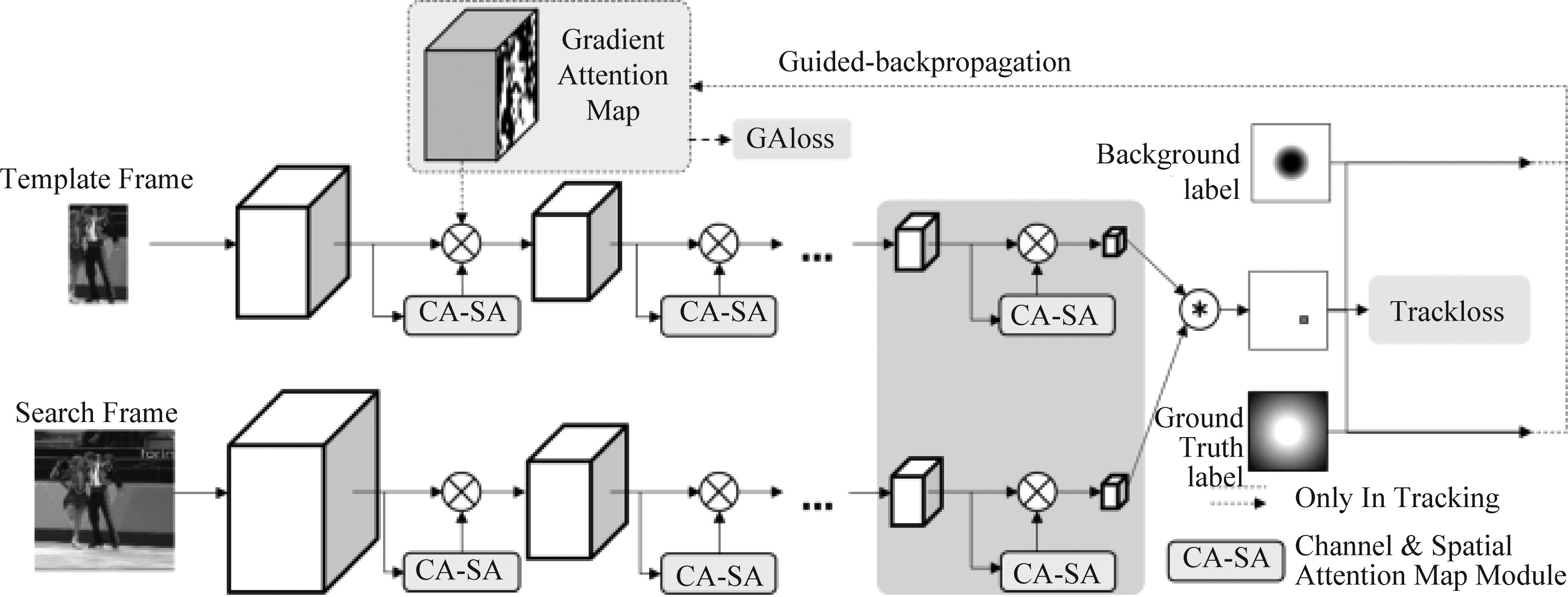

在SiamFC视觉跟踪框架下,相似性匹配响应图中每个值对应于相应位置的匹配得分,即得分反映了该位置为目标的可能性。给定模板图像x0,其匹配得分f(x)可以在x0局部邻域内用一阶泰勒展开来近似,即:

(2)

式中B为常数项,![]() 表示模板图像x0中每一个位置取值对匹配得分的贡献。本文定义

表示模板图像x0中每一个位置取值对匹配得分的贡献。本文定义![]() 为梯度注意力图,即当跟踪损失通过反向传播传递到各卷积层时,该层所有特征图上的每一个位置对应获得的梯度值组合而成的图像。此外,考虑到目标跟踪任务的独特性,正向梯度值会对匹配得分产生积极贡献,因此本文仅保留正梯度值作为梯度注意力图

为梯度注意力图,即当跟踪损失通过反向传播传递到各卷积层时,该层所有特征图上的每一个位置对应获得的梯度值组合而成的图像。此外,考虑到目标跟踪任务的独特性,正向梯度值会对匹配得分产生积极贡献,因此本文仅保留正梯度值作为梯度注意力图![]() 其他值予以抑制。由于视觉跟踪中的目标形式任意,从目标与背景二元划分角度看,模板图像中往往包含有前景的目标和局部背景两类信息。因此,对梯度注意力图

其他值予以抑制。由于视觉跟踪中的目标形式任意,从目标与背景二元划分角度看,模板图像中往往包含有前景的目标和局部背景两类信息。因此,对梯度注意力图![]() 可将其定义为对模板图像特征表达有增强作用的积极区域和有抑制作用的消极区域,这两个区域可结合公式(2),独立生成积极梯度注意力图

可将其定义为对模板图像特征表达有增强作用的积极区域和有抑制作用的消极区域,这两个区域可结合公式(2),独立生成积极梯度注意力图![]() 和消极梯度注意力图

和消极梯度注意力图![]()

图1 基于多注意力图的视觉目标跟踪网络结构图

Fig.1 Network structure of visual object tracking with multi-attention map

区别于传统BP算法[20]与判别式跟踪框架DAT[21],计算梯度注意力图的方法采用基于Grad-CAM[19]的导向梯度反向传播算法。如图1所示,对于模板图像,可以通过以下几个步骤分别得到积极和消极梯度注意力图。具体地,训练网络首先需要建立关于目标和干扰背景的两个高斯标签![]() 并分别计算这两个高斯标签与相似性匹配响应f(x)的匹配得分f(x)p和f(x)n:

并分别计算这两个高斯标签与相似性匹配响应f(x)的匹配得分f(x)p和f(x)n:

(3)

其中,将f(x)分别与两个高斯标签![]() 逐点计算距离得分,N为需要计算的像素总数。然后,以此得分f(x)p和f(x)n为导向梯度反向传播算法的导向指标,以网络损失的形式进行网络反向传播学习过程,获得积极梯度注意力图

逐点计算距离得分,N为需要计算的像素总数。然后,以此得分f(x)p和f(x)n为导向梯度反向传播算法的导向指标,以网络损失的形式进行网络反向传播学习过程,获得积极梯度注意力图![]() 和消极梯度注意力图

和消极梯度注意力图![]() 需要说明的是,该反向传播过程切断了参数的传递,因此不更新整个网络的参数。对于模板图像中的目标,希望

需要说明的是,该反向传播过程切断了参数的传递,因此不更新整个网络的参数。对于模板图像中的目标,希望![]() 中与目标相关位置的取值较大。相反,与干扰背景相关位置取值应该较小,所以这里将突出背景信息的

中与目标相关位置的取值较大。相反,与干扰背景相关位置取值应该较小,所以这里将突出背景信息的![]() 取反,以突出目标的响应。即梯度注意力图

取反,以突出目标的响应。即梯度注意力图![]() 的表达为积极区域和消极区域的两个梯度注意力图叠加:

的表达为积极区域和消极区域的两个梯度注意力图叠加:

(4)

其中,![]() 代表为了突出目标信息,而将由背景引导生成的梯度注意力图像进行数值取反。

代表为了突出目标信息,而将由背景引导生成的梯度注意力图像进行数值取反。

此外,考虑到目标通常位于模板的引入余弦窗函数分别用于抑制积极梯度注意力图中的背景位置信息和消极梯度注意力图的目标位置信息。由此,设计了一个新的损失函数项用于强化网络,训练其区分目标与干扰背景的能力,该损失函数项定义为:

(5)

其中,![]() 和

和![]() 分别表示目标和干扰背景梯度注意力图,σ和μ分别为对应的方差和期望,cos为余弦窗函数。

分别表示目标和干扰背景梯度注意力图,σ和μ分别为对应的方差和期望,cos为余弦窗函数。![]() 中的取反操作对背景梯度注意力图中本应作为计算主体的背景进行抑制,从而突出了对前景目标的建模,因此进一步增加了网络模型对目标的区分能力。

中的取反操作对背景梯度注意力图中本应作为计算主体的背景进行抑制,从而突出了对前景目标的建模,因此进一步增加了网络模型对目标的区分能力。

本文将梯度注意力损失函数LGA与原始跟踪损失交叉熵函数Ltrack联合组成跟踪损失函数:

Ltotal=Ltrack+βLGA

(6)

其中,Ltotal表示总损失函数,β为权重参数。在训练过程中该损失函数有助于网络更好的利用梯度注意力图,在抑制干扰背景的同时提高网络的区分能力。

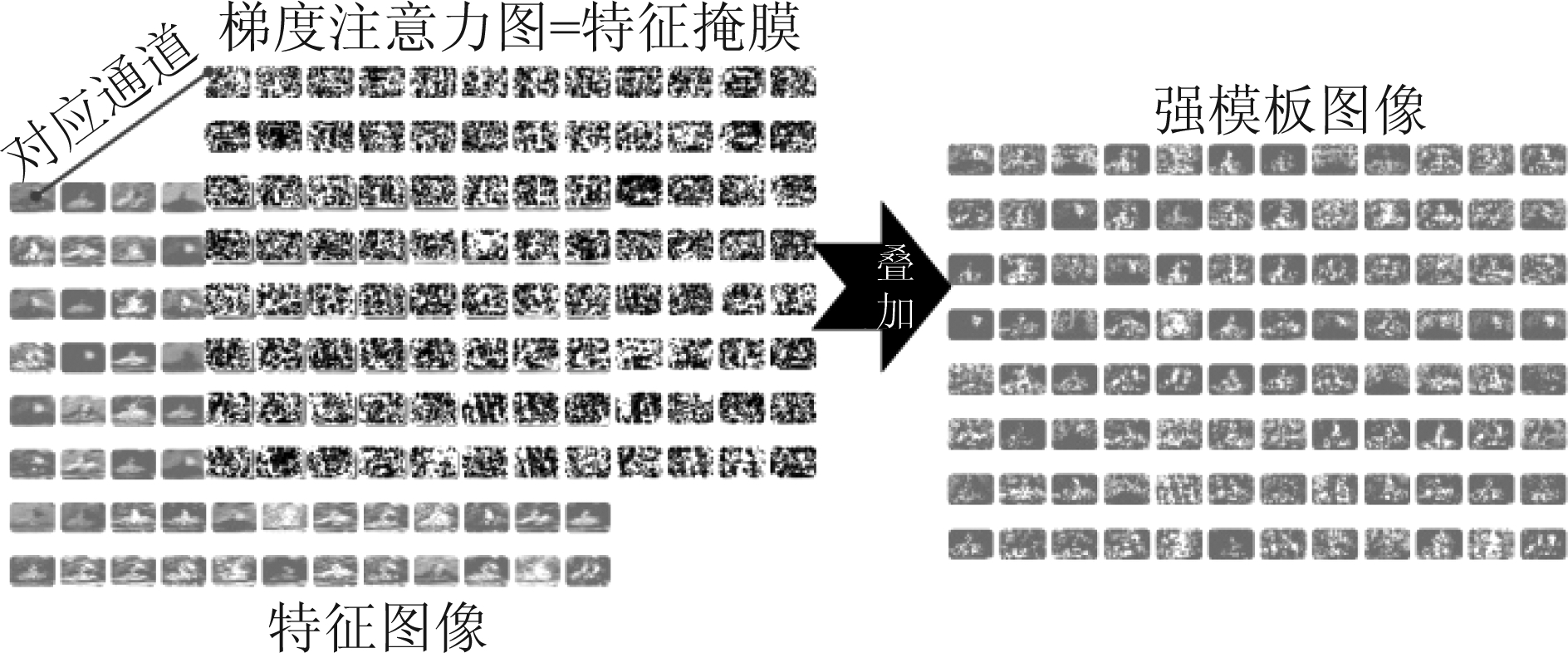

如图2所示,为了进一步丰富模板特征表达,本文将梯度注意力图![]() 作为特征掩膜,与模板图像的第一层卷积层输出进行叠加,生成强模板图像。该权重化操作在归一化的

作为特征掩膜,与模板图像的第一层卷积层输出进行叠加,生成强模板图像。该权重化操作在归一化的![]() 上进行,即归一化计算为:

上进行,即归一化计算为:

(7)

然后,将强模板图像与当前帧图像送入孪生网络中进行目标跟踪。通过将生成的梯度注意力图作用于特征空间以增加模板特征区分和表征能力,在杂乱背景下突出前景目标,达到跟踪性能的提升。

图2 结合梯度注意力图的强模板图

Fig.2 Strong template image combined with gradient attention map

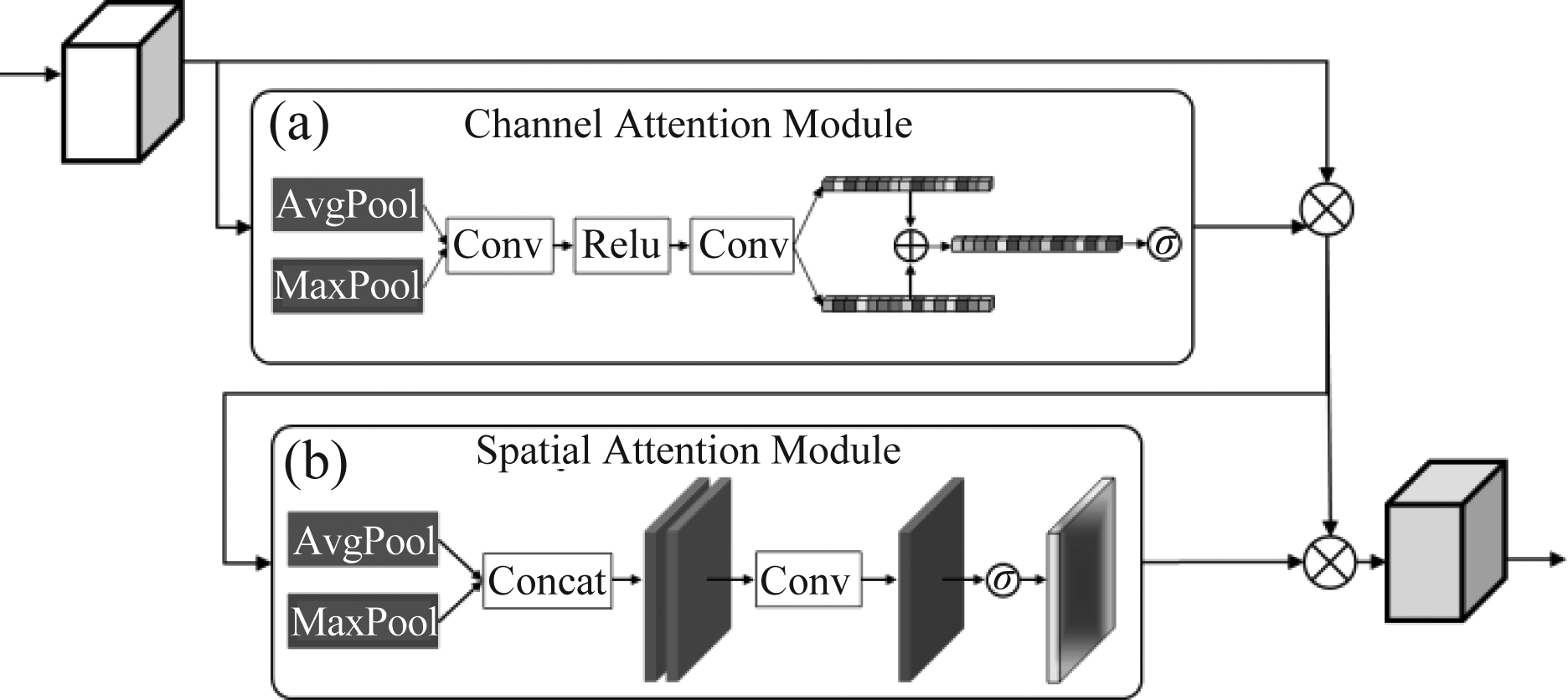

3.2 通道注意力模块

如图3(a)所示,本文在一帧图像每层卷积特征之后增加了通道注意力模块。通道注意力图关注于利用不同通道之间的关系,捕捉对目标任务有价值的信息。针对视觉跟踪中的目标形式任意、语义类别不固定,对每通道的特征采用空间维度上的平均池化和最大池化两种压缩操作,分别从统计平均和保留独特性两个方面,构建刻画通道重要性的注意力图。具体地,对任一中间层特征图x,生成特征通道注意力图的方式为:

(8)

其中,σ(·)为sigmoid函数,ω0和ω1是两个卷积层权值矩阵,R(·)为ReLU函数,Pavg(·)和Pmax(·)分别为平均池化和最大池化操作。

图3 通道注意力和空间注意力图模块结构图

Fig.3 Module structure of channel attention map and spatial attention map

3.3 空间注意力模块

空间位置注意力图的生成是通过利用特征的空间位置关系捕捉对目标任务有价值的信息。如图3(b)所示,沿着通道维分别进行平均池化和最大池化操作,将输入的特征图压缩并连接起来,进而经过卷积层生成对位置重要性敏感的特征:

(9)

其中[·;·]为特征图的连接操作,σ(·)为sigmoid函数,ω是空间位置注意力图卷积层的权值矩阵。

4 实验结果与分析

本文的模型实现基于PyTorch框架,并在Nvidia GTX 1080Ti GPU平台上完成。本方法在ILSVRC-VID视频数据集上离线训练。在训练通道注意力和空间注意力图模块阶段,固定特征提取网络参数,学习率为10-4,迭代50个轮次。然后,进行学习率为10-6,迭代为30个轮次的特征提取网络参数微调。加入梯度注意力损失函数后,网络的学习率和迭代轮次分别为10-6和50,对特征提取网络的最后两卷积层以及通道注意力和空间注意力图模块的最后一层参数进行微调。在线初始化过程则以第一帧目标位置对上一步调整的参数进一步微调,学习率设置为10-4,动量和权重衰减值分别设置为0.9和0.0005,两个损失函数组合权重β=1。

算法在OTB-100[22]、TC-128[23]和UAV20L[24]三个视觉跟公共数据集上进行测试。OTB-100是有100个视频序列,11个场景属性标注的数据集。TC-128是在11个场景属性上的128个序列组成的数据集。UAV20L是一个有20个长时视频序列的数据集。算法性能的基础评测指标采用精确率和成功率两种[22]。

4.1 消融实验

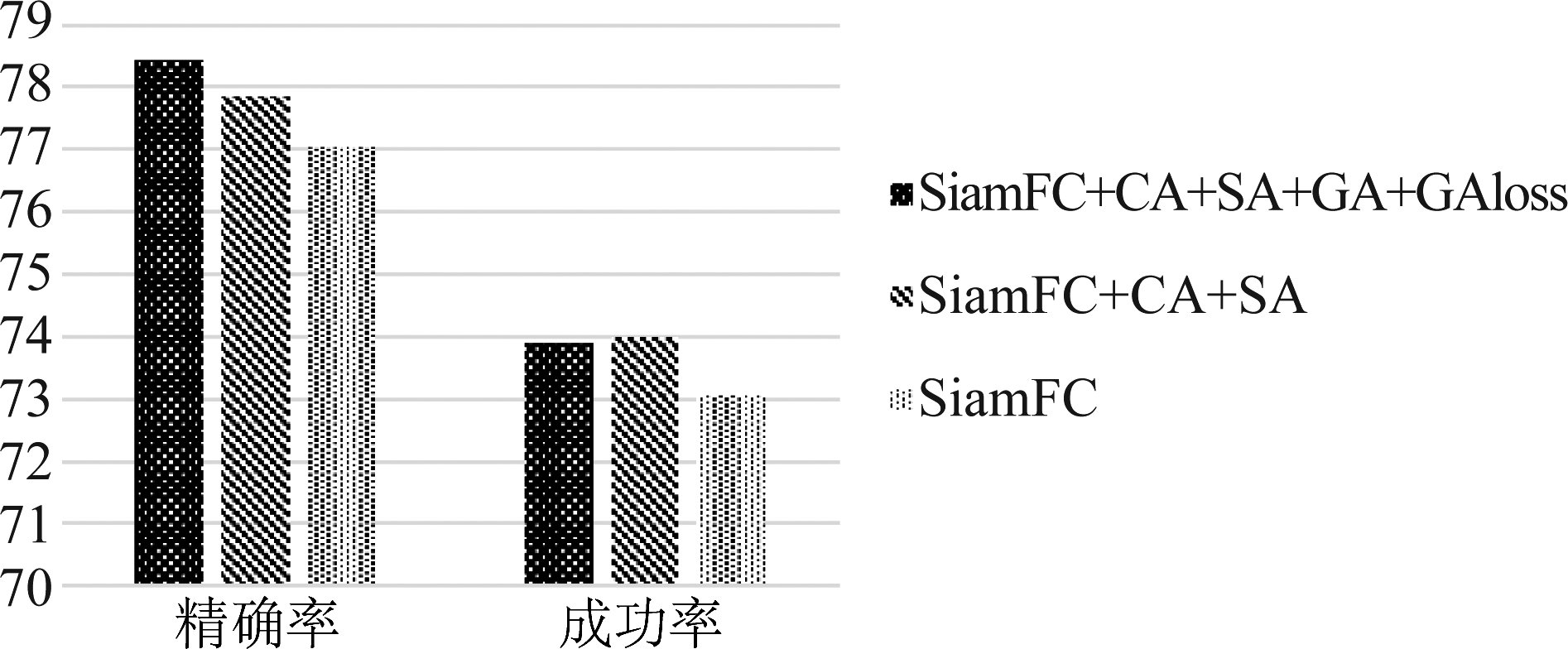

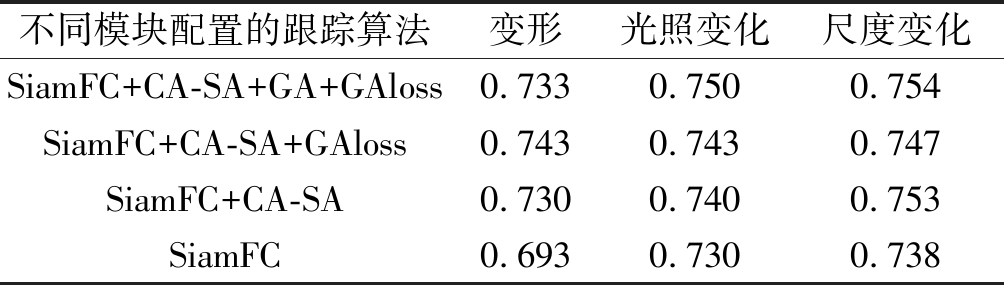

为了验证算法各个模块的有效性,本文分别比较了梯度注意力(GA)、通道注意力(CA)、空间注意力(SA)和梯度注意力损失函数(GAloss)四个模块在OTB-100数据集上的性能。图4给出了在整个数据集上的总体跟踪性能评估,结果显示本文的模型将精确率从0.770提高到0.781。

表1给出了尺度变化、光照变化和变形三种场景属性下算法性能,本文的模型精确率有明显的提升,分别达到了0.754,0.750和0.733。这说明本文的结构更有利于目标特征的表征。通道注意力和空间注意力图模块引入了滤波器重要性和空间位置重要性,在模型抗变形能力上有显著提升。但是,由于跟踪中模板帧保持不变,干扰物的影响导致该网络在对抗杂乱背景时的能力减弱。借助梯度注意力损失函数和梯度引导注意力图模块,使得整个网络聚焦于目标本身,抵抗干扰背景影响。

图4 本文算法消融实验精确率和成功率

Fig.4 Precision and success rate in ablation experiment of the proposed method

表1 本文方法在挑战属性视频上的消融实验

Tab.1 Ablation experiments of the proposed method on videos of challenge attributes

不同模块配置的跟踪算法变形光照变化尺度变化SiamFC+CA-SA+GA+GAloss0.7330.7500.754SiamFC+CA-SA+GAloss0.7430.7430.747SiamFC+CA-SA0.7300.7400.753SiamFC0.6930.7300.738

4.2 OTB-100数据集实验

跟踪算法的性能通常从两个方面进行评估,即是基于边界框的中心位置误差和基于边界框的重叠率。除了通常的一遍评估[22](One Pass Evaluation,OPE)外,还对跟踪算法进行了空间鲁棒性评估[22](Spatial Robustness Evaluation,SRE)。在SRE中,目标的初始边界框增加了平移或缩放的随机扰动。

实验将本文提出的算法与其他跟踪算法在OTB-100上进行评估,如Staple[25]、DSST[26]、LCT[27]、SAMF[28]、MEEM[29]、LMCF[30]、SiamFC[8]。在OPE、SRE评测中,精确率和成功率的结果如图5所示。

本文的算法在大部分的精确率图和成功率图中都优于Staple[25]、LMCF[30]等跟踪算法,这主要是因为本文的算法在多层面自适应分离目标前景和背景,自动生成的目标模板图像掩膜,提高了前景特征的表达能力。同时,网络结构对特征的通道维和空间维更加敏感,在深度网络的结构上强化前景特征的捕捉能力。同时,本文的算法优于基础方法SiamFC[8](图4中基标算法,精确率0.770)。这主要是因为本文的算法生成了梯度引导的目标模板图像注意力图,提高了目标特征的表达能力。并且,网络结构对特征生成了通道注意力图和空间注意力图,在深度网络的结构上强化目标特征的捕捉能力。基于卷积神经网络的跟踪算法在精度和鲁棒性方面较传统手工特征方法表现出较大优势,但其通常以增加计算复杂度为代价。

图5 OTB-100数据集上的使用OPE和SRE评估结果

Fig.5 Evaluation results of using OPE and SRE on OTB-100 dataset

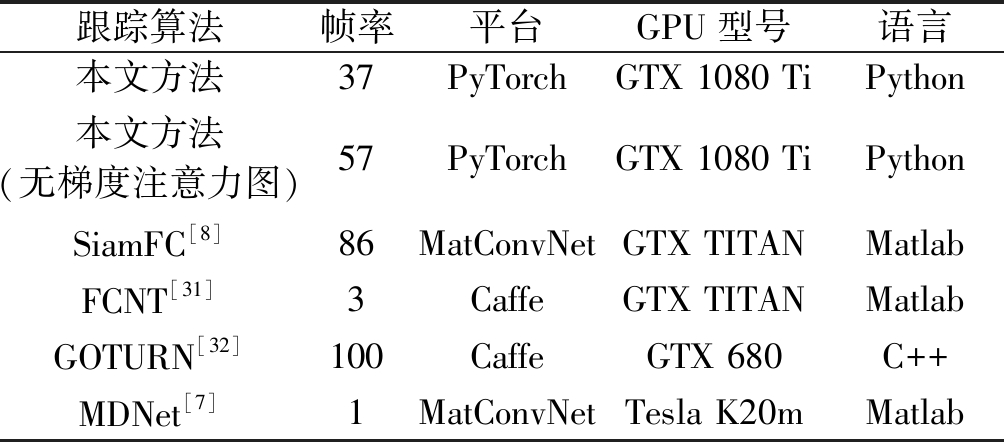

表2 本文方法与其他主流目标跟踪方法处理速度比较

Tab.2 Comparison of processing speed between the proposed method and other state-of-the-art visual trackers

跟踪算法帧率平台GPU型号语言本文方法37PyTorchGTX 1080 TiPython本文方法(无梯度注意力图)57PyTorchGTX 1080 TiPythonSiamFC[8]86MatConvNetGTX TITANMatlabFCNT[31]3CaffeGTX TITANMatlabGOTURN[32]100CaffeGTX 680C++MDNet[7]1MatConvNetTesla K20mMatlab

表2列出了一些基于卷积神经网络的跟踪算法的实现环境和跟踪速度。由于需要计算注意力图,本文的算法的处理速度相对慢于SiamFC[8],但在硬件条件、编写语言均不占优势的情况下也达到了37 FPS (Frame Per Second)实时跟踪。

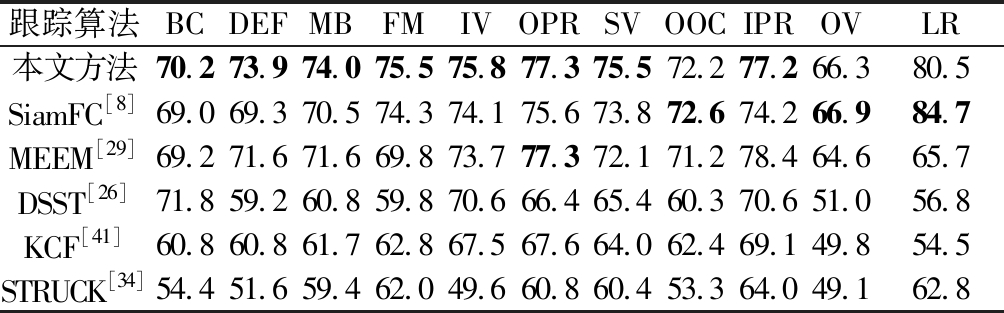

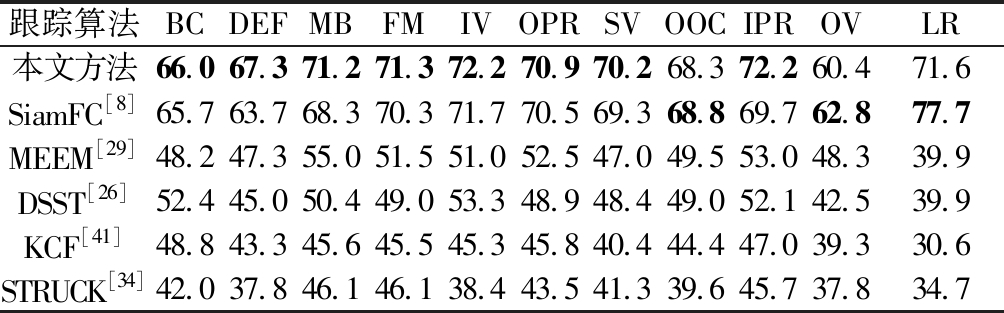

基于目标边界框中心定位精度和重叠率的结果分别如表3和表4所示。表格中IV表示光照变化(Illumination Variation),SV表示尺度变化(Scale Variation),OCC表示遮挡(Occlusion),DEF表示变形(Deformation),MB表示运动模糊(Motion Blur),FM表示快速移动(Fast Motion),IPR表示平面内旋转(In-Plane Rotation),OPR表示平面外旋转(Out-of-Plane Rotation),OV表示离开视野(Out-of-View),BC表示背景杂乱(Background Clutters),LR表示低分辨率(Low Resolution)。这是OTB序列的11种挑战属性。数据集中每个序列都有一种或一种以上的挑战属性。若跟踪算法在该属性上得分较高,则意味着该跟踪算法对于该属性有着很强的处理能力。一般,用挑战属性进行跟踪算法突出优势的分析。结果表明,当物体有变形、运动模糊、快速移动属性时,此算法表现出明显优势。这主要是因为这三个属性相对于其他几个属性是更关注于目标本身的属性,而此算法更关心目标的特征表达,强有力的模板特征可以提高在相似性匹配方法中的跟踪算法性能。

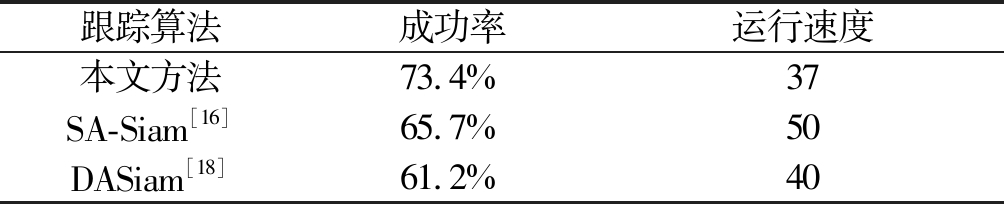

本文方法还与聚焦提升网络区分变化目标能力的跟踪方法SA-Siam[16]和采用双重注意力机制适应目标剧烈外观变化的跟踪方法DASiam[18]做了对比实验。如表5所示,本文方法相较于双重注意力机制的DASiam[18],增加了通道和空间注意力图网络结构

表3 OTB-100数据集上不同属性视频的跟踪精度对比(%)

Tab.3 Comparison of tracking precision of videos with different attributes on the OTB-100 dataset (%)

跟踪算法BCDEFMBFMIVOPRSVOOCIPROVLR本文方法70.273.974.075.575.877.375.572.277.266.380.5SiamFC[8]69.069.370.574.374.175.673.872.674.266.984.7MEEM[29]69.271.671.669.873.777.372.171.278.464.665.7DSST[26]71.859.260.859.870.666.465.460.370.651.056.8KCF[41]60.860.861.762.867.567.664.062.469.149.854.5STRUCK[34]54.451.659.462.049.660.860.453.364.049.162.8

表4 OTB-100数据集上不同属性视频的重叠率对比 (%)

Tab.4 Comparison of overlap rate of different attribute videos on OTB-100 dataset (%)

跟踪算法BCDEFMBFMIVOPRSVOOCIPROVLR本文方法66.067.371.271.372.270.970.268.372.260.471.6SiamFC[8]65.763.768.370.371.770.569.368.869.762.877.7MEEM[29]48.247.355.051.551.052.547.049.553.048.339.9DSST[26]52.445.050.449.053.348.948.449.052.142.539.9KCF[41]48.843.345.645.545.345.840.444.447.039.330.6STRUCK[34]42.037.846.146.138.443.541.339.645.737.834.7

以及梯度注意力图模块,获得跟踪性能的明显提升。而与关注于突出目标主体的SA-Siam[16]相比,本文方法采用的多注意力图网络结构从网络结构层面增加的目标与背景可分度,从而在跟踪成功率表现出优势。

表5 与SA-Siam和DASiam算法在OTB-100数据集的对比

Tab.5 Comparison with SA-Siam and DASiam algorithm on OTB-100 dataset

跟踪算法成功率运行速度本文方法73.4%37SA-Siam[16]65.7%50DASiam[18]61.2%40

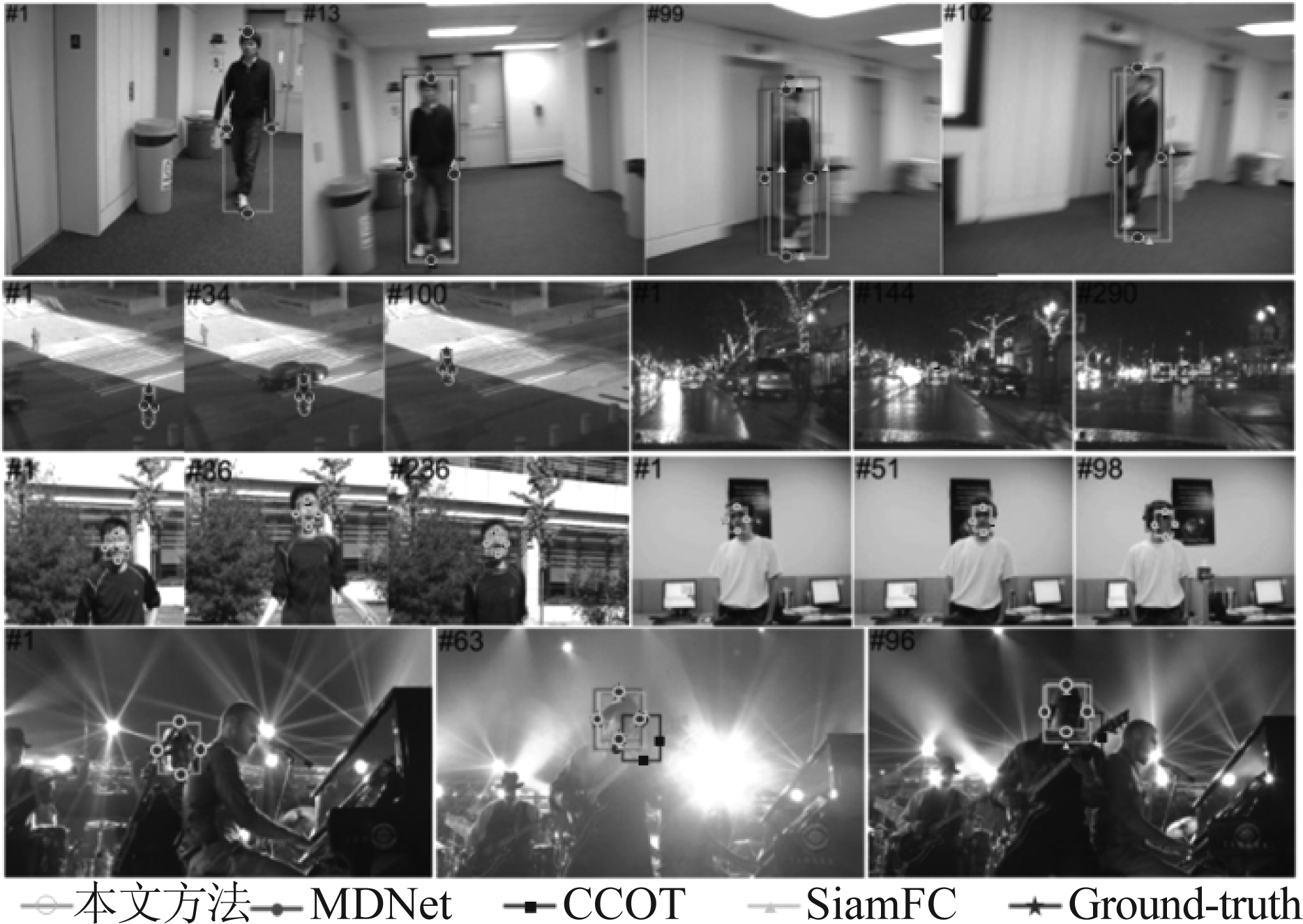

图6直观地比较了MDNet[7]、C-COT[33]、SiamFC[8]和本文方法在6个挑战性序列上的结果。在Jumping、BlurBody等运动序列中,快速运动物体呈现出严重的变形和运动模糊。这些结果显示了算法相对于其他跟踪器的优越性。例如,在Jumping中,MDNet在早期由跟踪目标更新成跟踪部分目标,C-COT无法覆盖物体的主体。SiamFC在第36帧有轻微的偏差,而本章的算法在整个序列中执行得很好。类似地,在BlurBody中,MDNet、C-COT和SiamFC由于运动目标变形跟踪结果不准确,不能很好地估计目标大小。在序列CarDark和Shaking中,跟踪器容易因为杂乱背景和强光照干扰分散注意力,而此算法总是紧紧抓住目标。还有一些其他类型的例子(David2、Crossing),由于能提取更有效模板特征表达,获得的跟踪结果更接近手工标定框。这些视频序列有同类物体遮挡、不同类物体遮挡或同类密集但无遮挡等情况发生,图6显示了在这些干扰影响下,本文方法可以很好地进行跟踪。

图6 OTB-100数据集上对挑战性的序列的定性评价

Fig.6 Qualitative evaluation of the challenging sequences on OTB-100 dataset

4.3 TC-128数据集实验

与最先进的跟踪算法Struck[34]、CSK[35]、MEEM[29]、KCF[41]等的比较如图7所示。图7上图显示了与先进的跟踪算法在精确率图中的比较。在比较的方法中,本文的方法的跟踪算法精确率为0.7005。图7下图显示了TC-128数据集中所有128个视频的成功率图。本文的跟踪算法的成功率为0.5188,表明本文的算法是有效的。

图7 TC-128数据集上跟踪器的精确率图和成功率图

Fig.7 Precision and success results of the trackers on TC-128 dataset

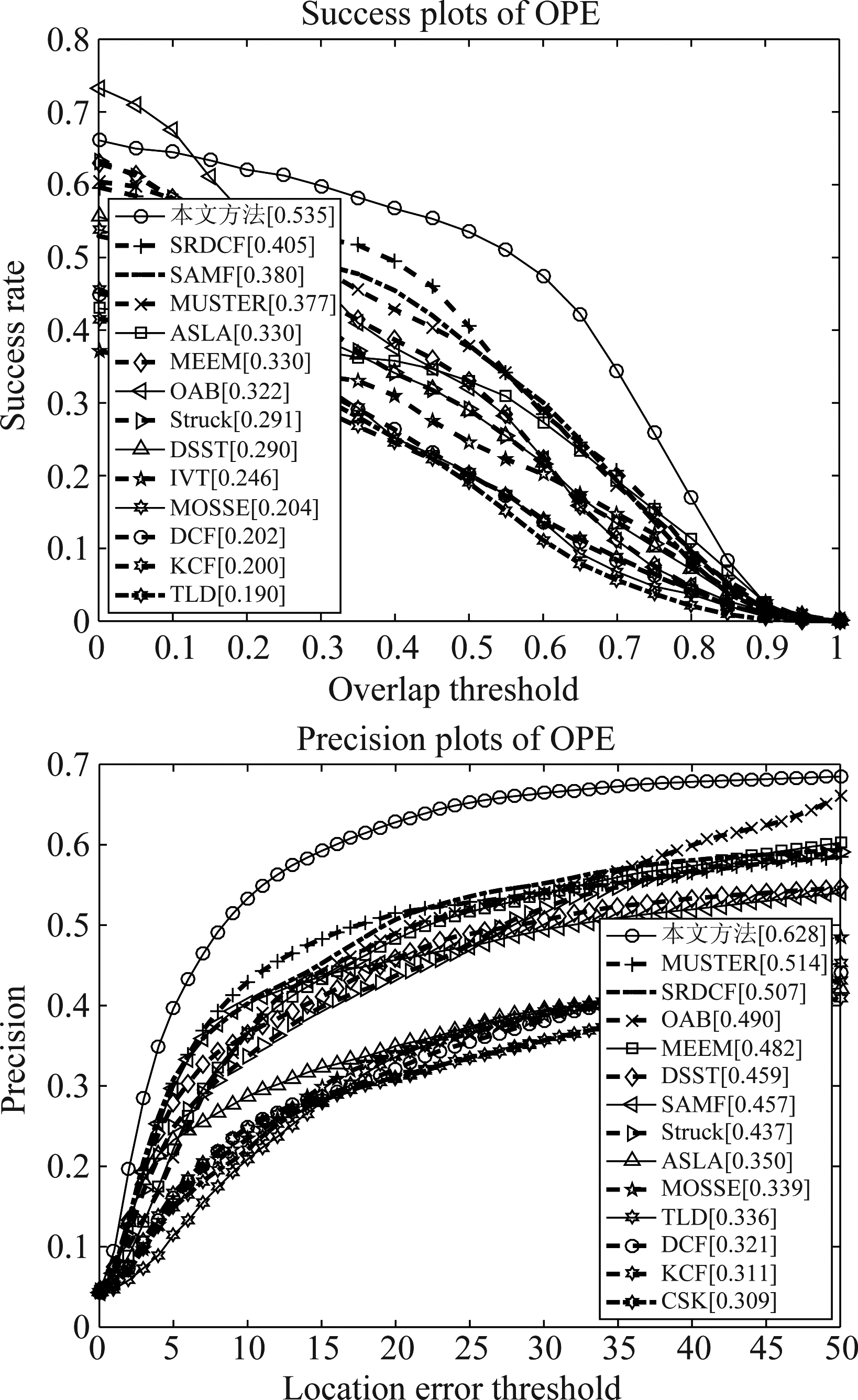

4.4 UAV20L数据集实验

与典型视觉目标跟踪算法(MUSTER[36]、SRDCF[37]、DCF[38]、TLD[39]、MOSSE[40]、MEEM[29]、DSST[26]、SAMF[28]、Struck[34]、KCF[41]、CSK[35])的比较如图8所示。图8在精确率和成功率上比较了本文的算法。具体而言,本文的跟踪算法的成功率得分为0.535,精确率得分为0.628,高于对比算法。

图8 UAV20L数据集上跟踪的精确率图和成功率图

Fig.8 Tracking precision and success on UAV20L dataset

5 结论

面向无约束场景视觉目标跟踪应用需求,本文研究了对前景敏感的深度网络,在此基础上提出了一种基于多注意力图的视觉目标跟踪算法。该方法利用梯度引导反向传播构建注意力图,并结合深度网络的通道注意力和空间注意力结构,增加网络对信息丰富特征的敏感性,进而提升网络对前景目标和背景的区分力。在视觉目标跟踪公共数据集OTB-100、TC-128和UAV20L上的大规模实验,验证了提出的算法的有效性。同时,在通用的深度学习计算平台下,提出的跟踪算法能够以37帧每秒的实时速度运行。未来的工作将面向特定的目标跟踪场景,尝试更为有效的训练标签及损失函数定义,进而通过嵌入目标先验信息方式提升跟踪性能;同时,也将探索应用提出的多注意力图结构到更加轻型、计算更为高效的基础网络上,进一步降低算法的计算复杂度。

[1] Simonyan K, Zisserman A. Very deep convolutional networks for large-scale image recognition [J]. ArXiv preprint arXiv: 1409.1556, 2014.

[2] Ma C, Huang J B, Yang X, et al. Hierarchical convolutional features for visual tracking [C]∥Proceedings of the IEEE International Conference on Computer Vision, 2015: 3074-3082.

[3] Wang L, Ouyang W, Wang X, et al. Visual tracking with fully convolutional networks [C]∥Proceedings of the IEEE International Conference on Computer Vision, 2015: 3119-3127.

[4] Hong S, You T, Kwak S, et al. Online tracking by learning discriminative saliency map with convolutional neural network [C]∥Proceedings of the IEEE International Conference on Machine Learning, 2015: 597- 606.

[5] Wang L, Ouyang W, Wang X, et al. STCT: Sequentially training convolutional networks for visual tracking [C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2016: 1373-1381.

[6] Qi Y, Zhang S, Qin L, et al. Hedged deep tracking [C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2016: 4303- 4311.

[7] Nam H, Han B. Learning multi-domain convolutional neural networks for visual tracking [C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2016: 4293- 4302.

[8] Bertinetto L, Valmadre J, Henriques J F, et al. Fully-convolutional Siamese networks for object tracking [C]∥Proceedings of the European Conference on Computer Vision, Springer, Cham, 2016: 850- 865.

[9] Guo Q, Feng W, Zhou C, et al. Learning dynamic Siamese network for visual object tracking [C]∥Proceedings of the IEEE International Conference on Computer Vision, 2017: 1763-1771.

[10]Li B, Yan J, Wu W, et al. High-performance visual tracking with Siamese region proposal network [C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2018: 8971- 8980.

[11]Zhu Z, Wang Q, Li B, et al. Distractor-aware Siamese networks for visual object tracking [C]∥Proceedings of the European Conference on Computer Vision, 2018: 101-117.

[12]Li B, Wu W, Wang Q, et al. SiamRPN++: Evolution of Siamese Visual Tracking with Very Deep Networks [C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2019: 4277- 4286.

[13]Wang Q, Zhang L, Bertinetto L, et al. Fast online object tracking and segmentation: A unifying approach [C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2019: 1328-1338.

[14]Zhang Z, Peng H, Wang Q. Deeper and Wider Siamese Networks for Real-Time Visual Tracking [C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2019: 4586- 4595.

[15]Li X, Ma C, Wu B, et al. Target-Aware Deep Tracking [C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2019: 1369-1378.

[16]He A, Luo C, Tian X, et al. A twofold Siamese network for real-time object tracking [C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2018: 4834- 4843.

[17]Wang Q, Teng Z, Xing J, et al. Learning attentions: residual attentional Siamese network for high performance online visual tracking [C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2018: 4854- 4863.

[18]杨康, 宋慧慧, 张开华. 基于双重注意力孪生网络的实时视觉跟踪[J]. 计算机应用, 2019, 39(6): 1652-1656.

Yang Kang, Song Huihui, Zhang Kaihua. Real-time visual tracking based on dual attention siamese network [J]. Journal of Computer Applications, 2019, 39(6): 1652-1656.(in Chinese)

[19]Selvaraju R R, Cogswell M, Das A, et al. Grad-cam: Visual explanations from deep networks via gradient-based localization [C]∥Proceedings of the IEEE International Conference on Computer Vision, 2017: 618- 626.

[20]Lecun Y, Boser B, Denker J, et al. Backpropagation Applied to Handwritten Zip Code Recognition [J]. Neural Computation, 1989, 1(4): 541-551.

[21]Pu S, Song Y, Ma C, et al. Deep attentive tracking via reciprocative learning [C]∥Advances in Neural Information Processing Systems, 2018: 1931-1941.

[22]Wu Y, Lim J, Yang M H. Object tracking benchmark [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(9): 1834-1848.

[23]Liang P, Blasch E, Ling H. Encoding color information for visual tracking: Algorithms and benchmark [J]. IEEE Transactions on Image Processing, 2015, 24(12): 5630-5644.

[24]Mueller M, Smith N, Ghanem B. A benchmark and simulator for UAV tracking [C]∥European Conference on Computer Vision. Springer, Cham, 2016: 445- 461.

[25]Bertinetto L, Valmadre J, Golodetz S, et al. Staple: Complementary learners for real-time tracking [C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2016: 1401-1409.

[26]Danelljan M, Häger G, Khan F S, et al. Discriminative scale space tracking [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2016, 39(8): 1561-1575.

[27]Ma C, Yang X, Zhang C, et al. Long-term correlation tracking [C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2015: 5388-5396.

[28]Li Y, Zhu J. A scale adaptive kernel correlation filter tracker with feature integration [C]∥Proceedings of the European Conference on Computer Vision. Springer, Cham, 2014: 254-265.

[29]Zhang J, Ma S, Sclaroff S. MEEM: robust tracking via multiple experts using entropy minimization [C]∥Proceedings of the European Conference on Computer Vision. Springer, Cham, 2014: 188-203.

[30]Wang M, Liu Y, Huang Z. Large margin object tracking with circulant feature maps [C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2017: 4021- 4029.

[31]Wang L, Ouyang W, Wang X, et al. Visual tracking with fully convolutional networks [C]∥Proceedings of the IEEE International Conference on Computer Vision, 2015: 3119-3127.

[32]Held D, Thrun S, Savarese S. Learning to track at 100 FPS with deep regression networks[C]∥Proceedings of the European Conference on Computer Vision, Springer, Cham, 2016: 749-765.

[33]Danelljan M, Robinson A, Khan F S, et al. Beyond correlation filters: Learning continuous convolution operators for visual tracking [C]∥European Conference on Computer Vision. Springer, Cham, 2016: 472- 488.

[34]Hare S, Golodetz S, Saffari A, et al. Struck: Structured output tracking with kernels [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 38(10): 2096-2109.

[35]Henriques J F, Caseiro R, Martins P, et al. Exploiting the circulant structure of tracking-by-detection with kernels [C]∥Proceedings of the European Conference on Computer Vision. Springer, Berlin, Heidelberg, 2012: 702-715.

[36]Hong Z, Chen Z, Wang C, et al. Multi-store tracker (MUSTER): A cognitive psychology inspired approach to object tracking [C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2015: 749-758.

[37]Danelljan M, Hager G, Shahbaz Khan F, et al. Learning spatially regularized correlation filters for visual tracking [C]∥Proceedings of the IEEE International Conference on Computer Vision, 2015: 4310- 4318.

[38]Lukezic A, Vojir T, Zajc L C, et al. Discriminative Correlation Filter with Channel and Spatial Reliability [C]∥Proceedings of IEEE Conference on Computer Vision and Pattern Recognition, Honolulu, HI, USA, 2017: 4847- 4856.

[39]Kalal Z, Mikolajczyk K, Matas J. Tracking-learning-detection [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2011, 34(7): 1409-1422.

[40]Wang N, Shi J, Yeung D-Y, et al. Understanding and diagnosing visual tracking systems [C]∥Proceedings of IEEE International Conference on Computer Vision, Santiago, Chile, 2015: 3101-3109.

[41]Henriques J F, Caseiro R, Martins P, et al. High-speed tracking with kernelized correlation filters[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(3): 583-596.