1 引言

信息技术的迅猛发展使便携式数码设备得到快速普及,从而大大增加了数字图像的数量。与此同时,数字图像逐渐成为传播视觉信息的重要载体,广泛应用于人们生活的各个方面。然而,Photoshop、GIMP、美图秀秀等易用性好、智能度高的数字图像编辑软件的出现,使得普通用户即便不具备图像处理专业知识,也可轻而易举地修改图像而不留明显视觉痕迹。这些伪造图像一旦被恶意应用于法庭举证、新闻报道、金融支付等领域[1-2]而得不到及时鉴别,将可能干扰司法判决、误导公众舆论,甚至造成重大经济损失。因此,作为防止图像被恶意篡改的有效手段,图像取证技术应该受到更多的关注[3-12]。

Copy-move伪造是常见的图像篡改方式,它通过复制图像中某一区域,并对此区域进行缩放、旋转等操作后移动并粘贴到同一图像的其他位置,达到隐藏重要信息或伪造虚假场景的目的。因为copy-move区域的亮度、噪声、纹理等重要属性往往与整个图像兼容,所以很难进行检测和识别。使用copy-move来伪造图像的事件层出不穷,例如伊朗某新闻媒体通过copy-move伪造导弹齐射画面来虚假宣传国家军力,以及写实摄影比赛中通过copy-move来增强作品效果,违反了比赛规则,构成了不公平竞争。这些copy-move伪造不仅破坏了图像的真实性,而且会向大众传达虚假信息,甚至还可能产生严重的社会危害。因此,研究有效的copy-move伪造检测与定位技术意义重大。

Copy-move伪造检测与定位可以分为基于手工提取特征的传统方法和基于自动提取特征的深度学习方法。基于手工提取特征的传统方法一般可分为基于块的检测方法[13-17]和基于关键点的检测方法[18-22]。基于块的方法通常先将图像分块,并在此基础上对每个图像块可分别进行DCT量化[13]、主成分分析[14]、傅里叶-梅林变换(FMT)[15]或者局部二值模式[16]等操作获得图像块特征,最后找出相同或相似的子块来定位图像相似区域。此外,基于块的copy-move伪造检测方法也可以先对整幅图像进行离散小波变换(DWT)[17],再进行分块处理,最后通过计算块与块之间的相似性得到伪造定位的结果。基于块的检测方法优点是理论简单,但缺点是计算量太大且一般只针对特定类型的篡改操作。基于关键点的copy-move伪造检测方法[18-22]首先检测图像关键点,然后在关键点处提取图像特征,最后通过特征点匹配来定位相似区域。基于关键点的检测方法可细分为基于尺度不变特征变换(Scale Invariant Feature Transform, SIFT)关键点方法和基于加速鲁棒特征(Speed Up Robust Feature, SURF)关键点方法。其中,基于SIFT关键点方法[18]在一定程度上提高了几何畸变情况下copy-move伪造的检测效果,但仍存在计算复杂的缺点[19]。Li等学者在SIFT算法的基础上,使用局部保留投影(Locality Preserving Projections, LPP)算法进行降维,一定程度上解决了特征向量维度过高的问题,但对本身存在重复性内容的图像,检测效率较低[20]。基于SURF关键点的算法,在检测速度上有所提高,但在定位精度上低于SIFT算法[21]。Li等学者将块和关键点算法进行了融合,提出一种先将图像分割成小块,然后提取关键点,最后通过块匹配方法检测copy-move区域的方法。该方法在公开数据库上可以取得较好的检测结果,但仍需要提高检测速度[22]。另外,Miroslav等学者提出利用存在于大多数数字图像中的线性模式(Linear Pattern, LP)来检测和定位copy-move伪造,但该方法局限于高分辨率、无压缩和高质量的JPEG图像[23],适用范围较窄。传统方法采用人工提取的特征,其检测性能很大程度上受限于研究者能否从海量数据中提取出适合该任务的特征。此外,传统方法一般通过检测copy-move伪造过程中发生的旋转、缩放等某一种操作的痕迹来发现相似区域进而检测copy-move伪造,但是在实际应用中无法事先知道具体采用了哪种伪造操作,因此难以选择合适的伪造检测方法。

近年来,深度学习在图像copy-move伪造检测与定位方面得到了广泛应用。Rao等学者提出利用卷积神经网络提取图像特征,用于copy-move伪造检测[24]。Ouyang等学者针对copy-move伪造检测任务,提出一种在ImageNet预训练模型上使用少量训练样本微调网络模型的方法,但该方法鲁棒性较差[25]。Liu等学者提出在copy-move伪造检测与定位任务中,使用卷积核网络进行特征提取,并采用自适应分割方法得到伪造定位结果[26]。Wu等学者针对图像copy-move伪造定位问题,利用卷积神经网络从图像中提取块特征,然后根据不同块之间的自相关性进行特征点匹配,最后再通过反卷积神经网络生成伪造定位结果[27]。Muzaffer和Ulutas利用AlexNet提取图像的特征向量,研究它们之间的相似性,用于copy-move伪造检测和定位[28]。Zhong等学者提出用Dense网络结构解决图像copy-move伪造检测和定位问题[29]。该方法首先利用金字塔特征提取器提取多维多尺度特征,再使用特征相关匹配模块自主学习特征的相关性,最后通过后处理模块得到伪造定位结果。Zhu等学者将自适应注意力机制和残差优化的神经网络结构引入copy-move伪造定位任务中,在获得粗掩码的基础上通过残差细分模块对结果进行优化,得到最终的伪造定位结果[30]。上述基于深度学习的copy-move伪造检测和定位方法,仅可定位出伪造图像中的相似区域,无法进一步区分伪造来源区域和伪造目标区域。

Copy-move伪造来源区域是指被复制的区域,包含真实可信的信息;而伪造目标区域是指被来源区域内容覆盖的区域,这个区域与来源区域高度相似,但原始信息已被覆盖。在定位出copy-move伪造图像相似区域的基础上,进一步区分出伪造来源区域和伪造目标区域可以为图像取证分析提供更丰富的信息,有助于取证人员推断造假者的伪造动机。Wu等学者在相似性检测网络[27]的基础上增加另一个分支结构,用于检测图像的伪造目标区域,进而提出了一个双路融合的BusterNet模型[31],可初步区分图像原始区域、伪造来源区域和伪造目标区域,但仍存在检测准确率较低的问题。

为进一步提升copy-move伪造检测任务中对上述三种区域的区分精度,本文提出了一种基于cGANs的copy-move伪造检测方法。主要创新和贡献如下:

(1)提出了基于cGANs的copy-move伪造检测方法,针对copy-move伪造检测任务的特点优化了网络模型的损失函数,除了对抗损失,还引入了基于L1距离的传统损失以及衡量伪造来源和目标区域误差的Lmask损失。

(2)提出了使用一定数量的弱监督样本——无伪造图像样本来提升模型性能的训练方法。无伪造图像样本是指图像中所有区域均未被篡改的样本,能够提供单类监督信息。现有方法通常忽略这类样本,但它们同样携带监督信息,适量合理使用可有效提升模型性能。

实验结果表明,所提方法不仅可以定位出伪造图像的相似区域,还可以有效区分伪造来源和伪造目标区域,在定位精度上显著优于对比方法。

2 基于cGANs的伪造检测方法

2.1 相关术语

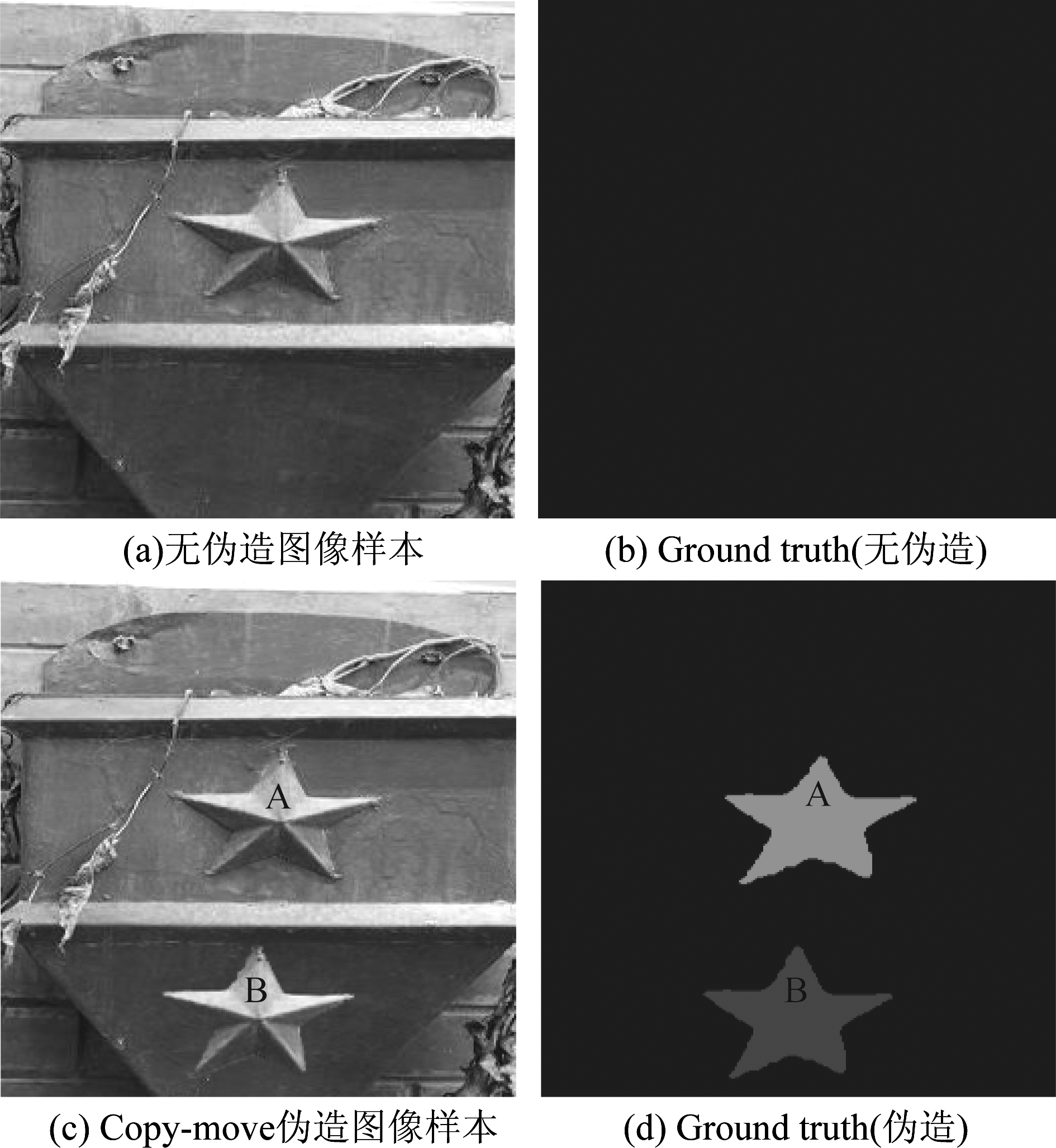

为了更清晰地描述copy-move伪造检测方法,本节首先介绍相关术语。对于一幅数字图像,如果未经过copy-move操作,称之为无伪造图像样本(如图1a),其ground truth图像只含有单一颜色(如图1b);若经历过copy-move操作(如图1c),则存在某个区域A被复制、粘贴至另一区域B,故称区域A为伪造来源区域,称区域B为伪造目标区域,除区域A和B外的其他未篡改区域为原始区域,其ground truth图像可用三种颜色标注(如图1d)。现有大部分copy-move伪造检测方法只进行二分类,即只区分相似区域和原始区域。如果能在相似区域基础上,进一步区分A和B,那么copy-move伪造检测将扩展为三分类问题,可提供更多取证信息,但检测难度也更大。

图1 Copy-move伪造的术语说明

Fig.1 Illustration of copy-move terminology

2.2 网络结构

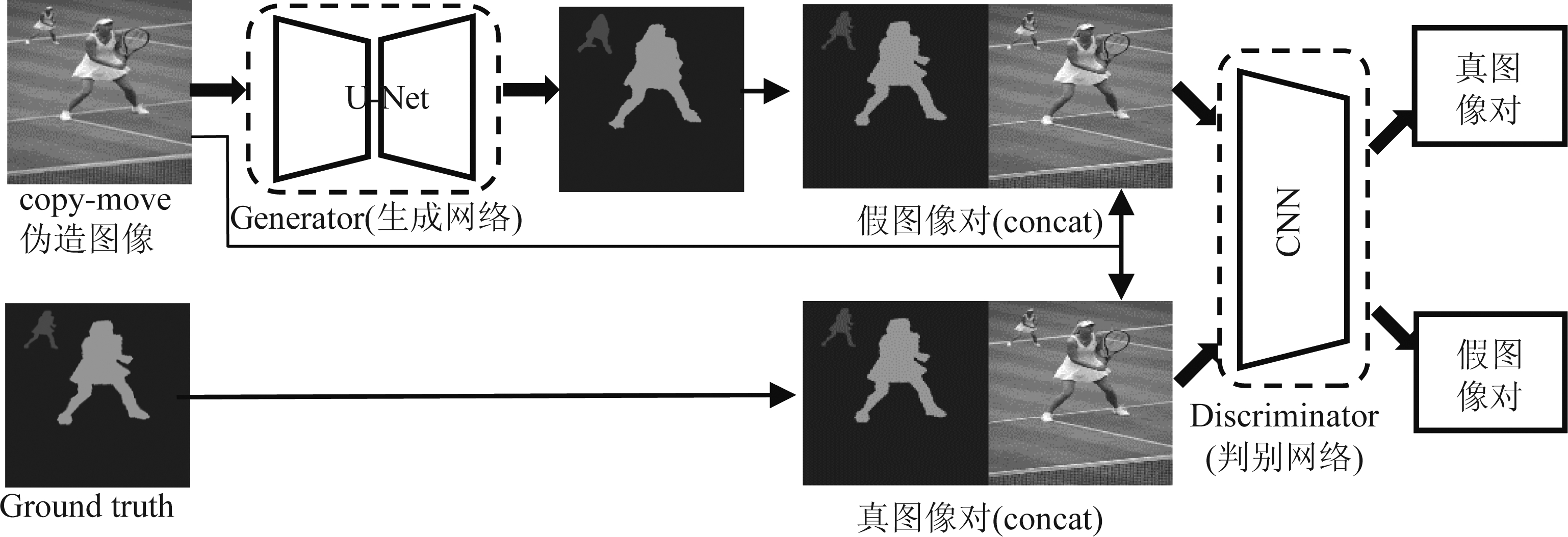

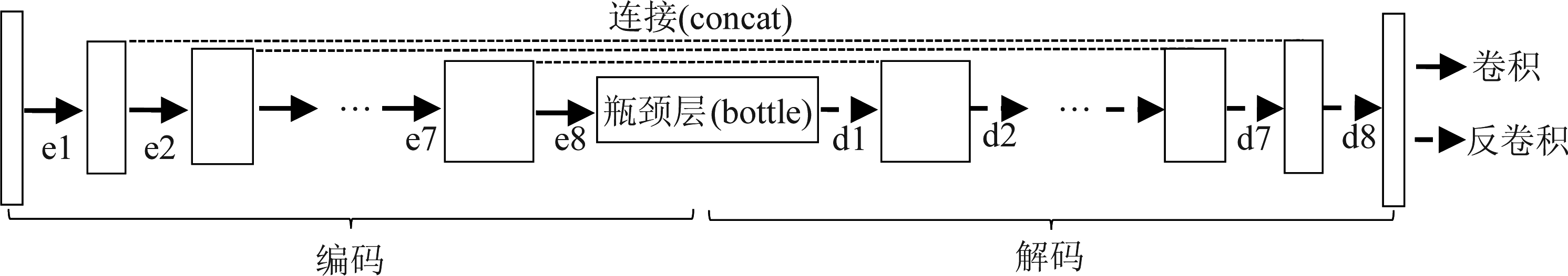

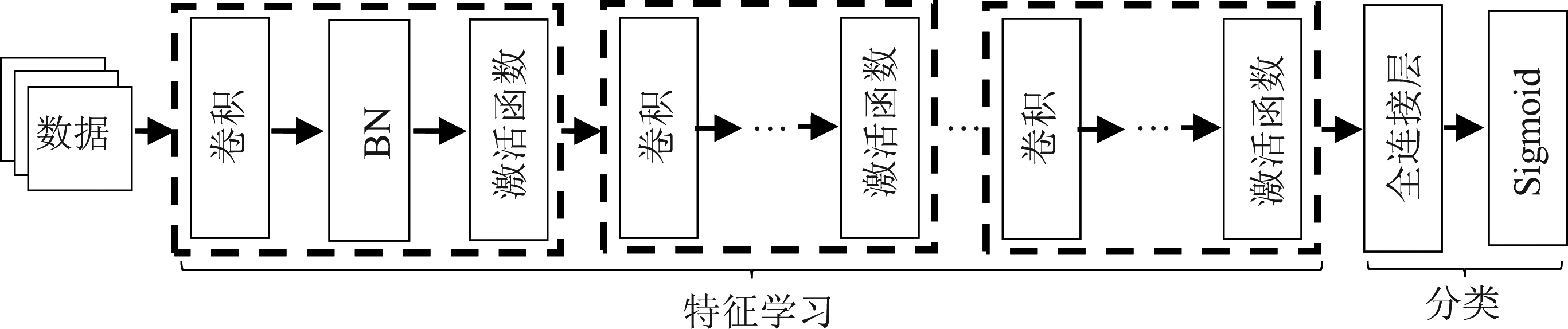

本文提出一种基于cGANs的copy-move伪造的检测和定位方法,用于区分伪造来源和目标区域。网络结构如图2所示,主体由生成网络和判别网络组成。生成网络采用经典的U-net结构,在普通的自编码器(Auto-encoder)结构上增加了跳线连接。U-net结构如图3所示,输入经过编码过程(Encoding)到达瓶颈层,然后经过解码过程(Decoding)使U-net结构的输出与输入维数相同。编码过程是对输入数据进行多组卷积、激活等操作,进而生成特征表达的过程;相应的解码过程是对特征表达进行反卷积、激活等操作,最终获得与输入相同维度的伪造检测结果的过程。另外,跳线连接将解码第i层的输出和编码的第n-i层的输出连接起来作为解码第i+1层输入。其中,n表示该网络编码或解码过程的总层数。判别网络的结构如图4所示,经过多组卷积、批归一化(Batch Normalization, BN)和激活函数处理后,进行全连接操作,最后使用sigmoid函数作为激活层,输出分类结果。

图2 网络结构

Fig.2 Network structure

图3 生成网络结构

Fig.3 Generator structure

图4 判别网络结构

Fig.4 Discriminator structure

上述网络结构的设计采用了对抗优化的思想。因为本文生成网络的输出最终将作为待检测图像的copy-move伪造定位结果,所以生成网络生成的检测结果应该尽可能接近ground truth图像。将待检测图像和ground truth图像构成的图像对,称为真图像对;将待检测图像和生成网络输出的检测结果构成的图像对,称为假图像对。显然,如果ground truth图像和检测结果相差很大,那么判别网络将很容易区分真图像对和假图像对。通过不断地交替优化生成网络和判别网络,两者最终将在博弈中达到平衡:生成网络所生成的检测结果和ground truth十分接近,判别网络无法区分图像对的真假。此时,生成网络可以作为图像copy-move伪造检测器,输入待检测图像,输出区分图像原始区域、伪造来源和目标区域的检测结果。

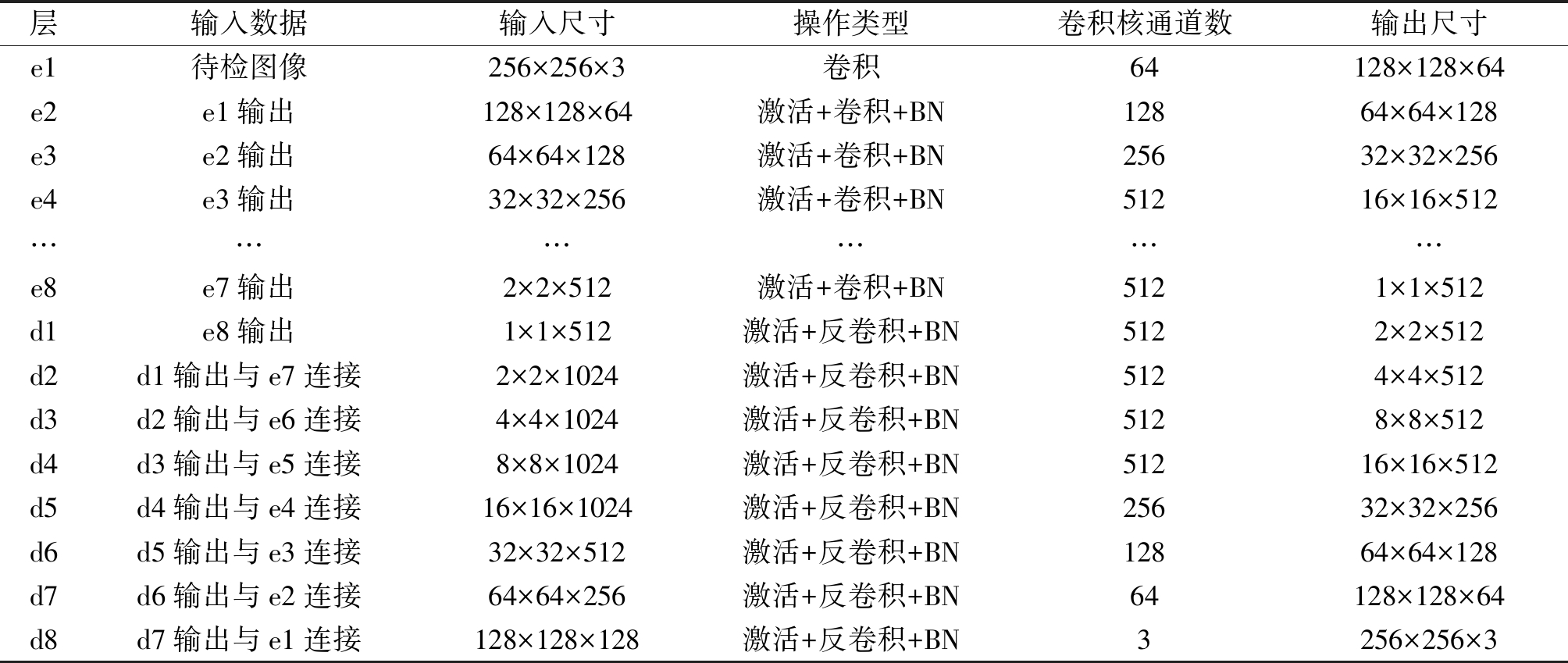

生成网络结构参数如表1所示。待检测图像和ground truth图像的尺寸均为256×256×3像素。在编码过程,待检测图像依次经过8组激活、卷积、BN操作(记为e1,…,e8),e8输出的特征维度为1×1×512。在解码过程,第一层(d1)是对e8输出特征的反卷积过程,然后将d1层的输出与e7层的输出连接起来作为d2层的输入;d2层的输出与e6层的输出连接起来作为d3层的输入;依此类推,d7层的输出与e1层的输出连接起来作为d8层的输入。最后,d8层的输出256×256×3的伪造定位结果。其中,卷积和反卷积过程中卷积核大小均为(5,5),卷积步长均为(2,2)。判别网络采用4层“卷积+BN+激活函数”的堆叠结构,最后通过全连接和激活层对真图像对和假图像对进行二类判别。

表1 生成网络结构参数

Tab.1 Structure parameters of generator

层输入数据输入尺寸操作类型卷积核通道数输出尺寸e1待检图像256×256×3卷积64128×128×64e2e1输出128×128×64激活+卷积+BN12864×64×128e3e2输出64×64×128激活+卷积+BN25632×32×256e4e3输出32×32×256激活+卷积+BN51216×16×512………………e8e7输出2×2×512激活+卷积+BN5121×1×512d1e8输出1×1×512激活+反卷积+BN5122×2×512d2d1输出与e7连接2×2×1024激活+反卷积+BN5124×4×512d3d2输出与e6连接4×4×1024激活+反卷积+BN5128×8×512d4d3输出与e5连接8×8×1024激活+反卷积+BN51216×16×512d5d4输出与e4连接16×16×1024激活+反卷积+BN25632×32×256d6d5输出与e3连接32×32×512激活+反卷积+BN12864×64×128d7d6输出与e2连接64×64×256激活+反卷积+BN64128×128×64d8d7输出与e1连接128×128×128激活+反卷积+BN3256×256×3

2.3 损失函数

针对copy-move伪造检测任务的特性,本文对cGANs的损失函数进行了优化。本节将以经典GANs[32]的目标函数作为切入点,详细阐述损失函数的设计思路。生成对抗网络的主要思想是生成器和判别器的相互博弈,经典对抗损失函数如下所示:

V(G,D)=Ex~pdata(x)[logD(x)]+ Ez~pz(z)[log (1-D(G(z)))]

(1)

其中,x表示真实图像,z表示输入生成网络的噪声,G(z)表示生成网络生成的图像。D(x)表示判别网络判断真实图像为真实的概率,D(G(z))表示判别网络判断生成网络生成的图像为真实的概率,E表示求指定数据分布下的期望。判别网络的目的是尽可能区分真实图像和生成图像。对于判别网络,x是真实数据,所以D(x)越接近1越好;G(z)为生成的假数据,所以D(G(z))应越小越好。换言之,对于判别网络,V(G,D)越大越好,即希望最大化优化目标。生成网络的目的是尽可能使生成的图像接近于真实图像,V(G,D)越小越好,即最小化优化目标。

同理,cGANs[33]模型就是在GANs的基础上引入了用户输入的图像数据,判别器不再是针对图像真假的判别,而是判别图像对的真假。条件生成对抗网络的损失函数和目标函数分别为:

LcGAN(G,D)=Ex,y~pdata(x,y)[logD(x,y)]+ Ex~pdata(x),z~pz(z)[log (1-D(x,G(x,z)))]

(2)

(3)

其中,x,z分别表示用户输入生成网络的图像和随机噪声。D(x,y)表示判别网络判断真实图像对为真实的概率。D(x,G(x,z))是判别网络判断假图像对为真实的概率。与经典生成对抗网络的优化目标的不同在于判别器不再是针对图像真假的判别,而是判别图像对的真假。

为了有效区分图像原始区域、伪造来源区域和伪造目标区域,生成网络所输出的检测结果不仅需要尽可能欺骗判别网络,还需要在数值上尽可能与ground truth接近。L1损失是一种平均绝对误差损失,作为传统损失添加至损失函数里,可以使生成网络得到的伪造定位结果在L1意义上更加接近ground truth。

在很多场合,伪造区域被误判为没有经过伪造(漏检)所产生的影响远大于图像原始区域被误判为伪造区域(误检)产生的影响,所以本文在设计损失函数时加入一项更加关注伪造来源和伪造目标区域的Lmask损失。该损失只关注伪造区域的检测误差,在生成网络生成的检测结果与ground truth L1距离的基础上,通过引入逐元素(element-wise)运算实现。综合之前引入的L1损失,相当于引入图像原始区域、伪造来源区域和伪造目标区域的加权损失。所以,基于区分伪造来源和伪造目标区域的检测任务,本文中cGANs的目标函数综合考虑了对抗损失、L1损失和Lmask损失。其中,L1损失如式(4)所示,Lmask损失如式(5)所示,该网络最终目标函数如式(6)所示。

L1(G)=Ex,y~pdata(x,y),z~pz(z)[||y-G(x,z)||1]

(4)

Lmask(G)= Ex,y~pdata(x,y),z~pz(z)[||y-G(x,z)||1⊙[0,1,1]]

(5)

(6)

其中,参数λ1、λmask的大小可根据具体任务进行相应的调整。

2.4 模型训练

本文所用的数据集是Wu实验组提供的USCISI-CMFD数据集,包括100000张copy-move伪造图像及其所对应的ground truth[31]。Copy-move伪造样本中的伪造来源区域会经过成比例缩放、0~30°随机旋转操作,再移动粘贴到伪造目标区域。将该数据集按照8∶1∶1的比例划分为训练集、验证集和测试集:训练集为80000张copy-move伪造图像及其对应的ground truth图像对;验证集为10000张copy-move伪造图像及其对应的ground truth图像对;测试集为剩余的10000张copy-move伪造图像及其对应的ground truth图像对。在实验过程中发现,训练好的生成网络模型在部分测试图像上的伪造检测结果会出现偏差,定位出除图像伪造区域之外的其他物体。为了引导生成网络更好地完成copy-move伪造检测,本文在训练集中加入1000张无伪造图像样本及其对应的ground truth。无伪造图像样本是指未经copy-move伪造的图像,此类样本对应的ground truth只有一个颜色,只包含单一类别的监督信息。此类样本中包含各类物体但是无需检测,旨在驱动网络仅需定位图像中潜在的伪造的区域,并不需要检测所有的物体。

本文对训练数据进行了预处理和增强操作,具体如下:

首先将所有的图像数据调整为256×256尺寸,然后将给定图像及其对应的ground truth串接起来作为模型的输入,便于判别网络对图像对的真假进行判别。训练数据扩增时, 1/3的概率直接使用训练数据对,1/3的概率先对训练数据对进行左右翻转,1/3的概率先对训练数据对进行上下翻转,丰富训练数据,可有效防止过拟合。

在初始的几轮训练中,生成模型和判别模型的性能较差,因此可以先固定生成样本,训练判别器,提高判别器的性能。接着,固定判别器,优化生成器的性能。最后,当生成器的数据概率分布和真实数据概率分布重合时,达到一个稳定状态,生成器可以生成足以以假乱真的图片,判别器判别不出真假样本,此时生成网络可以作为copy-move伪造检测器使用。

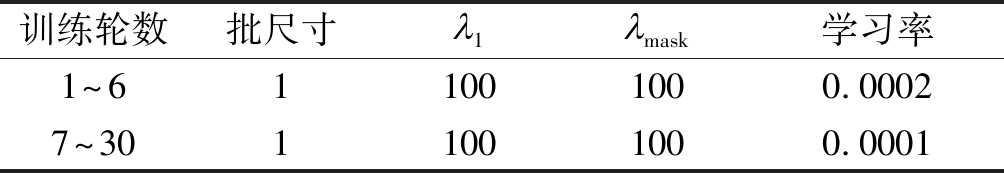

本文所提出网络模型的训练参数如表2所示,训练前6轮学习率设为0.0002,之后学习率减半直到训练结束。

表2 模型训练参数

Tab.2 Parameters of model training

训练轮数批尺寸㔮1㔮mask学习率1~611001000.00027~3011001000.0001

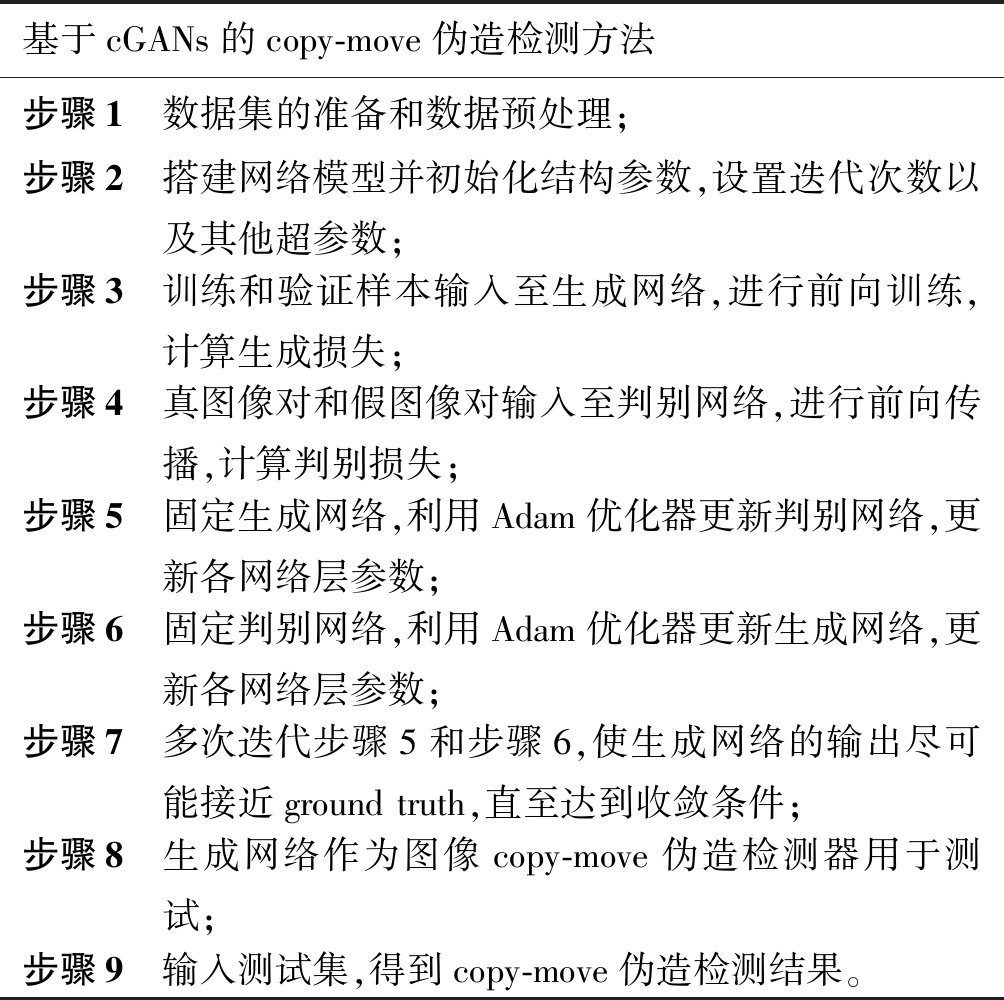

综上所述,本文所提的copy-move伪造检测方法的步骤如表3所示。

表3 copy-move伪造检测方法步骤

Tab.3 Steps of the proposed copy-move forgery detection

基于cGANs的copy-move伪造检测方法步骤1 数据集的准备和数据预处理;步骤2 搭建网络模型并初始化结构参数,设置迭代次数以及其他超参数;步骤3 训练和验证样本输入至生成网络,进行前向训练,计算生成损失;步骤4 真图像对和假图像对输入至判别网络,进行前向传播,计算判别损失;步骤5 固定生成网络,利用Adam优化器更新判别网络,更新各网络层参数;步骤6 固定判别网络,利用Adam优化器更新生成网络,更新各网络层参数;步骤7 多次迭代步骤5和步骤6,使生成网络的输出尽可能接近ground truth,直至达到收敛条件;步骤8 生成网络作为图像copy-move伪造检测器用于测试;步骤9 输入测试集,得到copy-move伪造检测结果。

3 实验分析

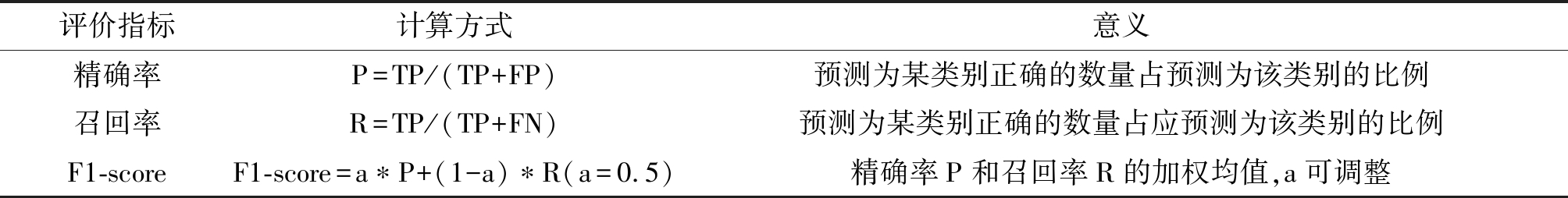

3.1 性能指标

图像copy-move伪造检测的评价指标如表4所示,所有指标均逐像素统计计算。在计算伪造来源区域的性能指标时,TP表示伪造来源像素被检测为伪造来源像素的数量,FP表示非伪造来源像素被检测为伪造来源像素的数量,FN表示伪造来源像素被检测为非伪造来源像素,TN表示非伪造来源像素被检测为非伪造来源像素的数量。

本文分别计算图像原始区域、伪造来源区域和伪造目标区域的精确率、召回率、F1-score来分析该模型的性能。

3.2 性能分析

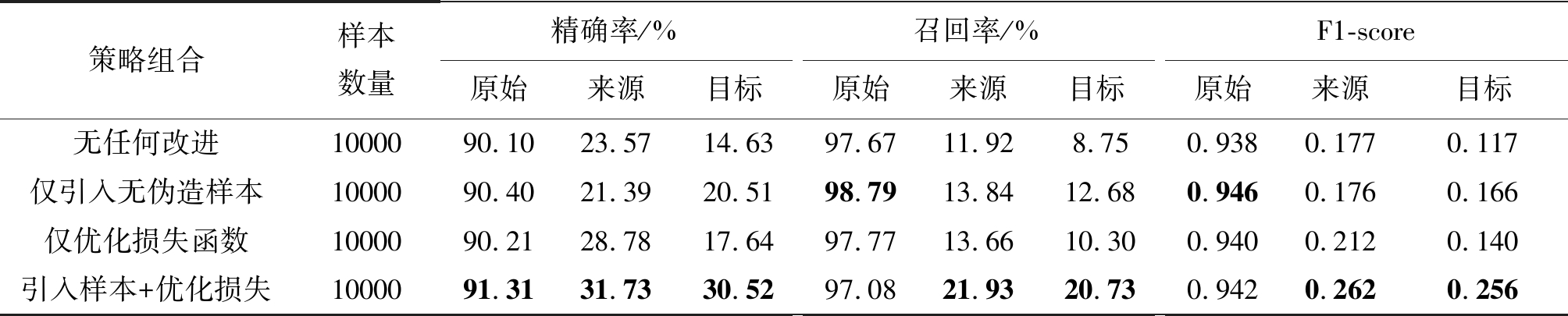

本文通过引入无伪造图像样本和优化损失函数来提升网络性能,在相同的参数设置下,无任何改进、仅引入1000张无伪造图像样本(在表5中用仅引入无伪造样本表示)、仅优化损失函数与本文所提出的既引入无伪造图像样本又优化损失函数(在表5中用引入样本+优化损失表示)的对比结果如表5所示。

结果表明,引入无伪造的图像样本和优化损失函数均可提升网络的检测性能,其中,既引入无伪造图像样本又优化损失函数的策略综合性能最优。

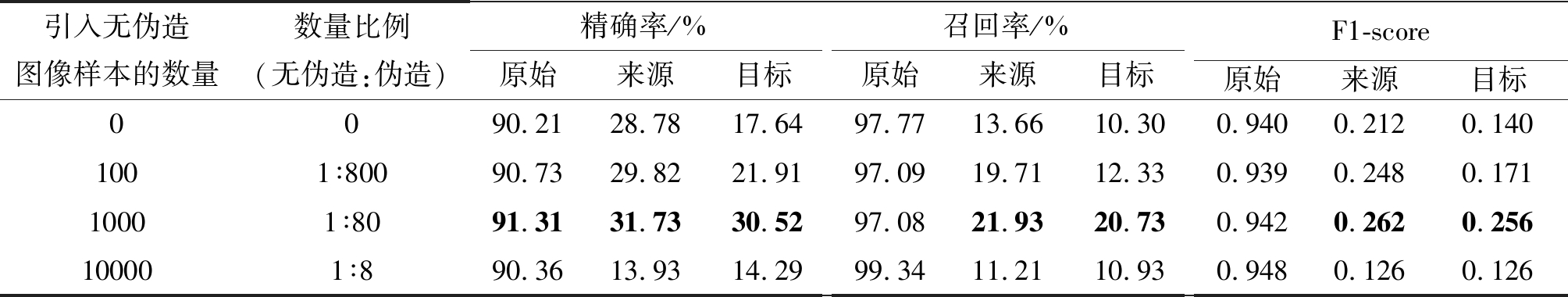

不同数量或比例的无伪造图像样本会对网络的检测性能产生影响。本文通过实验对比了在训练过程中不引入、引入100对、引入1000对和引入10000对无伪造图像样本对检测准确率的影响,在USCISI-CMFD数据集10000张测试样本上的检测结果如表6所示。结果表明,训练时加入无伪造样本的数量并非越多越好,数量级大致在1000幅左右(与伪造图像样本的数量比例是1:80)能取得较好综合性能。主要原因在于未经copy-move伪造的图像样本的所有区域都未经伪造,只提供单类监督信息,是一种弱监督样本;而经过copy-move伪造的图像样本中同时包含原始区域、伪造来源区域、伪造目标区域三类监督信息;弱监督样本数量如果太多,可能会主导训练进程,反而不利于最终检测性能的提高。

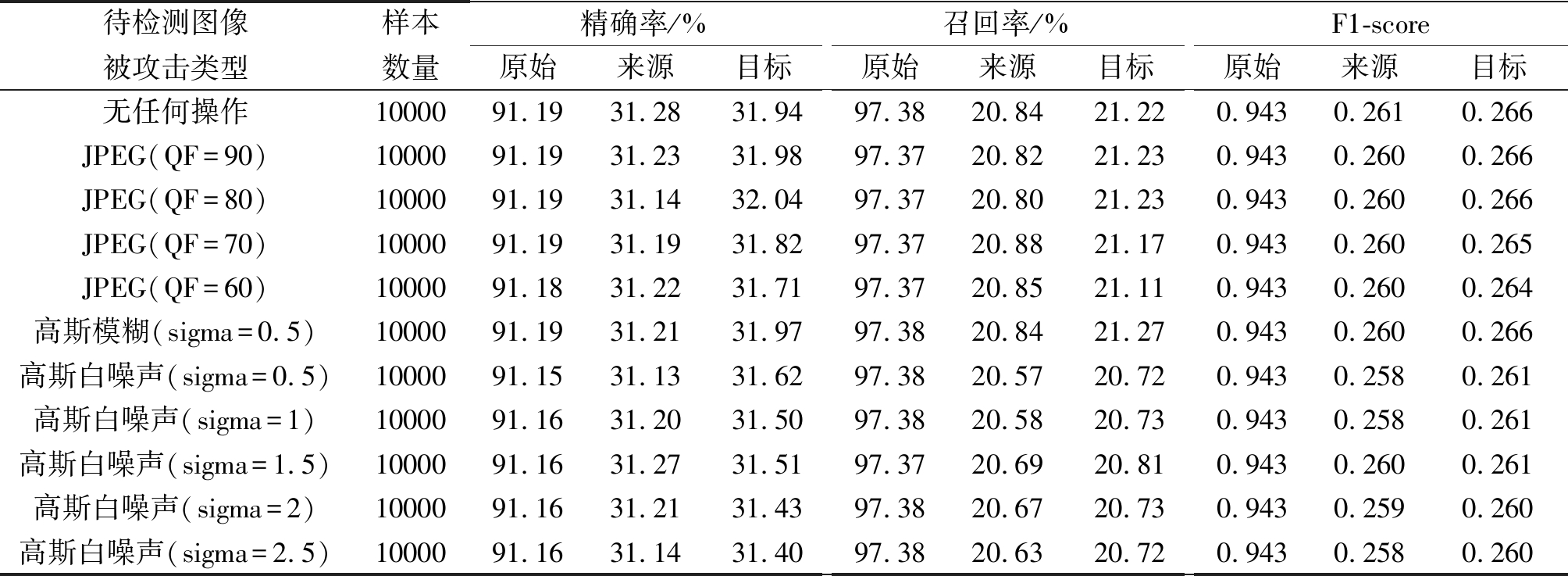

在实际应用场景中,由于待检测图像可能会经过JPEG压缩、模糊、加噪等处理,本文通过以下实验评估了所提方法的鲁棒性。实验分别对待检测图像进行质量因子(QF)为60、70、80、90的JPEG压缩,进行高斯低通滤波器尺寸为3×3、标准差(sigma)为0.5的高斯模糊以及引入均值为0、标准差(sigma)为0.5~2.5(图像像素的取值范围为0~255)的高斯白噪声之后,再进行copy-move伪造检测。在USCISI-CMFD数据集10000张测试样本上检测结果如表7所示,检测结果对比如图5所示。

表4 评价指标

Tab.4 Evaluation indices

评价指标计算方式意义精确率P=TP/(TP+FP)预测为某类别正确的数量占预测为该类别的比例召回率R=TP/(TP+FN)预测为某类别正确的数量占应预测为该类别的比例F1-scoreF1-score=a∗P+(1-a)∗R(a=0.5)精确率P和召回率R的加权均值,a可调整

表5 性能分析

Tab.5 Performance analysis

策略组合样本数量精确率/%原始来源目标召回率/%原始来源目标F1-score原始来源目标无任何改进1000090.1023.5714.6397.6711.928.750.9380.1770.117仅引入无伪造样本1000090.4021.3920.5198.7913.8412.680.9460.1760.166仅优化损失函数 1000090.2128.7817.6497.7713.6610.300.9400.2120.140引入样本+优化损失1000091.3131.7330.5297.0821.9320.730.9420.2620.256

表6 引入不同数量无伪造样本对测试结果的影响

Tab.6 Effect of introducing different numbers of copy-move-free samples

引入无伪造图像样本的数量数量比例(无伪造:伪造)精确率/%原始来源目标召回率/%原始来源目标F1-score原始来源目标0090.2128.7817.6497.7713.6610.300.9400.2120.1401001∶80090.7329.8221.9197.0919.7112.330.9390.2480.1711000 1∶8091.3131.7330.5297.0821.9320.730.9420.2620.256100001∶890.3613.9314.2999.3411.2110.930.9480.1260.126

图5 JPEG压缩、高斯模糊、高斯噪声干扰情况下的检测结果

Fig.5 Detection results under JPEG compression, Gaussian blurring, and Gaussian noise

3.3 性能对比

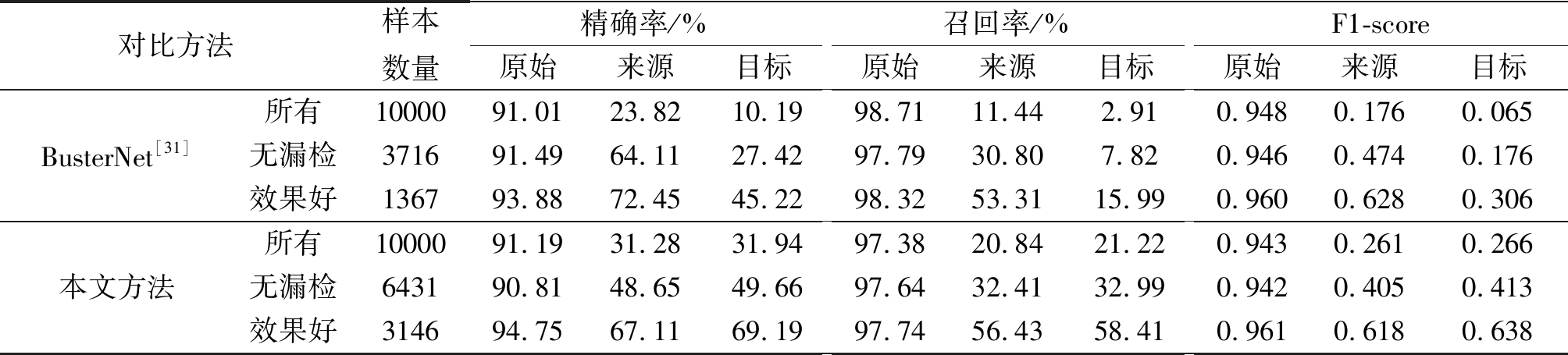

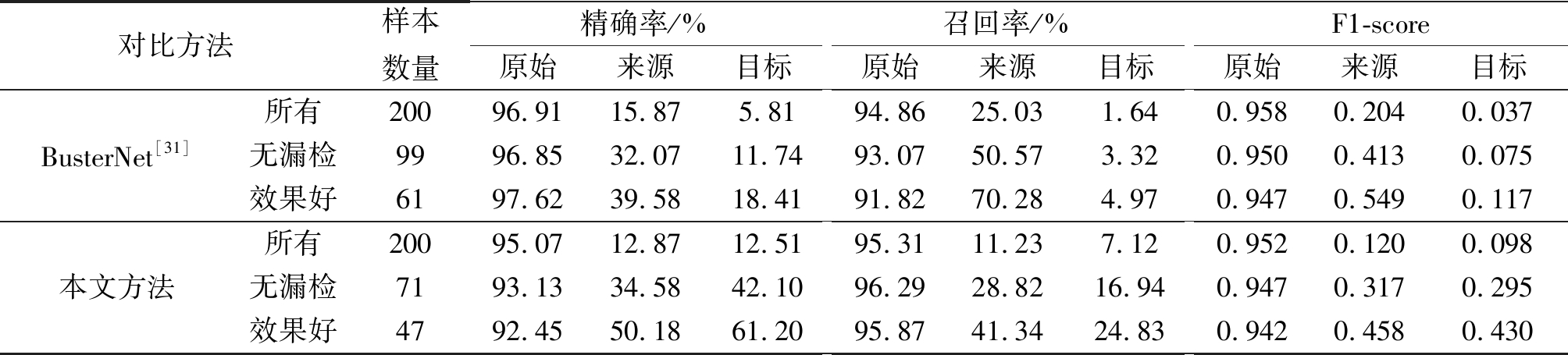

针对图像copy-move伪造检测与定位任务,区分伪造来源区域和目标区域的代表工作是BusterNet方法[31]。本文所提出的方法与BusterNet模型在USCISI-CMFD数据集10000张测试样本上的性能对比如表8所示。BusterNet方法的测试模型来自作者公开在Github上的预训练模型。

总体来看,本文所提出的方法在USCISI-CMFD测试集上的检测性能高于BusterNet方法。为了获得更加全面的检测性能,将10000张测试结果进一步分析。首先分析伪造来源区域和伪造目标区域的检测精确率或召回率大于0的检测结果(记为“无漏检”),本文方法得到6431张,而BusterNet方法仅得到3716张。本文方法的检测数量明显高于BusterNet方法,且对伪造来源和目标区域的定位性能优于对比方法。之后分析伪造来源区域和伪造目标区域的检测精确率或召回率大于0.5的检测结果(记为“效果好”),本文方法选出3146张,而BusterNet方法仅选出1367张。本文方法检测效果好的数量明显高于BusterNet方法,且综合性能较优,尤其是对伪造目标区域的定位效果远高于对比方法。

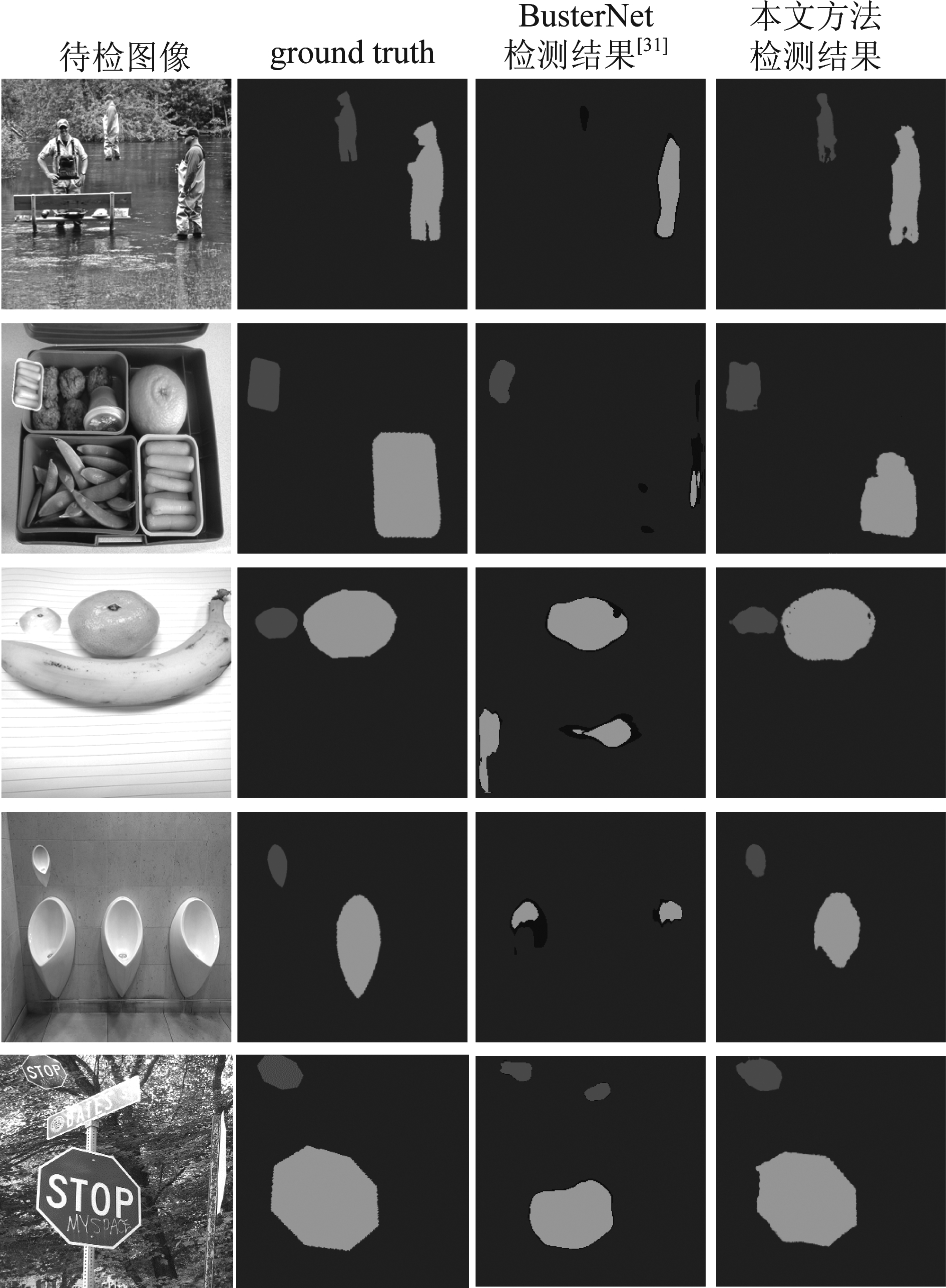

本文方法与BusterNet方法在USCISI-CMFD测试集上的部分检测结果如图6所示,其中黑色区域表示图像原始区域,灰色区域表示伪造来源区域,深灰色区域表示伪造目标区域。从检测结果可知,本文方法在伪造区域经历过成比例缩放或者旋转操作的测试样本上均具有良好的检测性能,可以有效区分出图像原始区域、伪造来源区域和伪造目标区域,且相较于BusterNet方法能更好地区分伪造来源和伪造目标区域。

为评估跨库泛化性能,本文方法与BusterNet方法在USCISI-CMFD数据库上完成训练,并在CoMoFoD数据库上测试,结果如表9所示。实验结果表明,本文所提出的方法在该数据库上能够更有效地区分copy-move伪造来源和伪造目标区域,主要体现在本文方法对伪造目标区域的定位性能优于对比方法。在“无漏检”和“效果好”测试条件下,本文方法选出的数量略低于BusterNet方法。但是从定位结果上看,本文方法在伪造目标区域的定位精度上远高于BusterNet方法。

表7 方法鲁棒性分析

Tab.7 Robustness analysis of the method

待检测图像被攻击类型样本数量精确率/%原始来源目标召回率/%原始来源目标F1-score原始来源目标无任何操作1000091.1931.2831.9497.3820.8421.220.9430.2610.266JPEG(QF=90)1000091.1931.2331.9897.3720.8221.230.9430.2600.266JPEG(QF=80)1000091.1931.1432.0497.3720.8021.230.9430.2600.266JPEG(QF=70)1000091.1931.1931.8297.3720.8821.170.9430.2600.265JPEG(QF=60)1000091.1831.2231.7197.3720.8521.110.9430.2600.264高斯模糊(sigma=0.5)1000091.1931.2131.9797.3820.8421.270.9430.2600.266高斯白噪声(sigma=0.5)1000091.1531.1331.6297.3820.5720.720.9430.2580.261高斯白噪声(sigma=1)1000091.1631.2031.5097.3820.5820.730.9430.2580.261高斯白噪声(sigma=1.5)1000091.1631.2731.5197.3720.6920.810.9430.2600.261高斯白噪声(sigma=2)1000091.1631.2131.4397.3820.6720.730.9430.2590.260高斯白噪声(sigma=2.5)1000091.1631.1431.4097.3820.6320.720.9430.2580.260

表8 同库测试性能对比

Tab.8 Performance comparison within the same database

对比方法样本数量精确率/%原始来源目标召回率/%原始来源目标F1-score原始来源目标BusterNet[31]所有1000091.0123.8210.1998.7111.442.910.9480.1760.065无漏检371691.4964.1127.4297.7930.807.820.9460.4740.176效果好136793.8872.4545.2298.3253.3115.990.9600.6280.306本文方法所有1000091.1931.2831.9497.3820.8421.220.9430.2610.266无漏检643190.8148.6549.6697.6432.4132.990.9420.4050.413效果好314694.7567.1169.1997.7456.4358.410.9610.6180.638

表9 跨库测试性能对比

Tab.9 Performance comparison across databases

对比方法样本数量精确率/%原始来源目标召回率/%原始来源目标F1-score原始来源目标BusterNet[31]所有20096.9115.875.8194.8625.031.640.9580.2040.037无漏检9996.8532.0711.7493.0750.573.320.9500.4130.075效果好6197.6239.5818.4191.8270.284.970.9470.5490.117本文方法所有20095.0712.8712.5195.3111.237.120.9520.1200.098无漏检7193.1334.5842.1096.2928.8216.940.9470.3170.295效果好4792.4550.1861.2095.8741.3424.830.9420.4580.430

图6 部分检测结果展示

Fig.6 Demonstrations of detection results

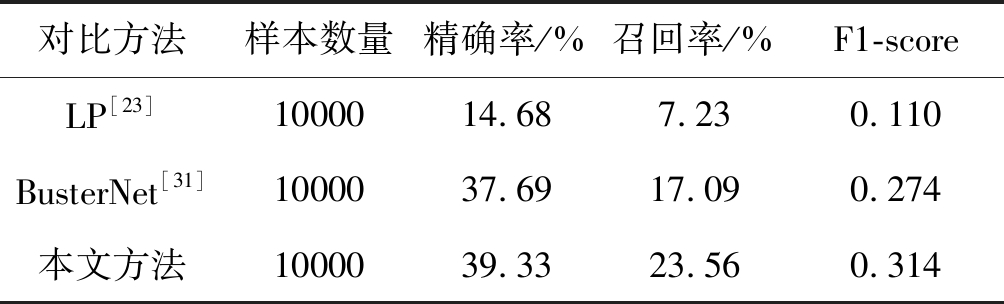

上述从三分类角度,对比了本文方法与BusterNet方法的性能。若将copy-move伪造检测视作二分类问题,则可以有更多对比方法。如表10所示,本文进一步对比了所提出方法与基于传感器线性模式(LP)的检测方法[23]以及BusterNet[31]方法在USCISI-CMFD数据集10000张测试图像上的copy-move二分类性能。实验结果表明,本文提出方法的在精确率、召回率和F1-score方面均优于其他两种方法。

表10 Copy-move二分类性能对比

Tab.10 Performance comparison of copy-move binary classification

对比方法样本数量精确率/%召回率/%F1-scoreLP[23]1000014.687.230.110BusterNet[31]1000037.6917.090.274本文方法1000039.3323.560.314

4 结论

为了有效区分伪造来源和目标区域,本文提出了一种基于条件生成对抗网络的copy-move伪造检测方法。该条件生成对抗网络的生成网络采用U-Net结构,通过编码解码过程对输入图像的潜在伪造区域进行定位;而判别网络采用经典的深度卷积结构,通过区分输入图像对的真假,与生成网络相互博弈,最终达到平衡。通过优化网络的损失函数,并在训练过程中引入提供弱监督信息的无伪造图像样本,copy-move伪造定位性能得到显著提升。大量实验结果表明所提方法可取得较好的定位结果,且在大部分测试情况下优于对比方法。

[1] Farid H. Image forgery detection[J]. IEEE Signal Processing Magazine, 2009, 26(2): 16-25.

[2] Sencar H T, Memon N. Overview of state-of-the-art in digital image forensics[M]∥Algorithms, Architectures and Information Systems Security, 2009: 325-347.

[3] 刘晓腾, 荆涛, 卢燕飞, 等. 基于 JPEG 双量化特性的彩色伪造图像盲检测[J]. 信号处理, 2011, 27(1): 136-142.

Liu Xiaoteng, Jing Tao, Lu Yanfei, et al. Blind detection of color forgeries using double JPEG quantization properties[J]. Journal of Signal Processing, 2011, 27(1): 136-142.(in Chinese)

[4] 卢燕飞, 鞠娅莉, 于跃. 基于图像背景噪声特性的篡改检测[J]. 信号处理, 2012, 28(9): 1299-1307.

Lu Yanfei, Ju Yali, Yu Yue. Image forgery detection using characteristics of background noise[J]. Journal of Signal Processing, 2012, 28(9): 1299-1307.(in Chinese)

[5] Yang J, Ren H, Zhu G, et al. Detecting median filtering via two-dimensional AR models of multiple filtered residuals[J]. Multimedia Tools and Applications, 2018, 77(7): 7931-7953.

[6] Dixit R, Naskar R. Copy-move forgery detection utilizing Fourier-Mellin transform log-polar features[J]. Journal of Electronic Imaging, 2018, 27(2): 023007.

[7] Niu Y, Li X, Zhao Y, et al. An enhanced approach for detecting double JPEG compression with the same quantization matrix[J]. Signal Processing: Image Communication, 2019, 76: 89-96.

[8] Zhang Q, Xiao H, Xue F, et al. Digital image forensics of non-uniform deblurring[J]. Signal Processing: Image Communication, 2019, 76: 167-177.

[9] Chen Z, Tondi B, Li X, et al. Secure detection of image manipulation by means of random feature selection[J]. IEEE Transactions on Information Forensics and Security, 2019, 14(9): 2454-2469.

[10]Wang J W, Wang H, Li J, et al. Detecting double JPEG compressed color images with the same quantization matrix in spherical coordinates[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2019, DOI: 10.1109/TCSVT.2019.2922309.

[11]Ding F, Wu H, Zhu G, et al. METEOR: Measurable Energy Map Toward the Estimation of Resampling Rate via a Convolutional Neural Network[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2020, DOI: 10.1109/TCSVT.2019.2963715.

[12]Ding F, Shi Y, Zhu G, et al. Real-time estimation for the parameters of Gaussian filtering via deep learning[J]. Journal of Real-Time Image Processing, 2020, 17(1): 17-27.

[13]Fridrich A J, Soukal B D, Luk š A J. Detection of copy-move forgery in digital images[C]∥in Proceedings of Digital Forensic Research Workshop, 2003.

š A J. Detection of copy-move forgery in digital images[C]∥in Proceedings of Digital Forensic Research Workshop, 2003.

[14]Popescu A C, Farid H. Exposing digital forgeries by detecting duplicated image regions[J]. Dept. Comput. Sci., Dartmouth College, Tech. Rep. TR2004-515, 2004: 1-11.

[15]Bayram S, Sencar H T, Memon N. An efficient and robust method for detecting copy-move forgery[C]∥2009 IEEE International Conference on Acoustics, Speech and Signal Processing. IEEE, 2009: 1053-1056.

[16]Li L, Li S, Zhu H, et al. An efficient scheme for detecting copy-move forged images by local binary patterns[J]. Journal of Information Hiding and Multimedia Signal Processing, 2013, 4(1): 46-56.

[17]Muhammad G, Hussain M, Bebis G. Passive copy move image forgery detection using undecimated dyadic wavelet transform[J]. Digital Investigation, 2012, 9(1): 49-57.

[18]Pan X, Lyu S. Region duplication detection using image feature matching[J]. IEEE Transactions on Information Forensics and Security, 2010, 5(4): 857- 867.

[19]Mohamadian Z, Pouyan A A. Detection of Duplication Forgery in Digital Images in Uniform and Non-uniform Regions[C]∥Uksim International Conference on Computer Modelling & Simulation. IEEE Computer Society, 2013.

[20]李子健, 阮秋琦. 基于 LPP 和改进 SIFT 的 copy-move 篡改检测[J]. 信号处理, 2017, 33(4): 589-594.

Li Zijian, Ruan Qiuqi. Copy-move forgery detection based on LPP and improved SIFT algorithm[J]. Journal of Signal Processing, 2017, 33(4): 589-594.(in Chinese)

[21]Xu B, Wang J W, Liu G J, et al. Image copy-move forgery detection based on SURF[C]∥2010 International Conference on Multimedia Information Networking and Security. IEEE, 2010: 889- 892.

[22]Li J, Li X, Yang B, et al. Segmentation-based image copy-move forgery detection scheme[J]. IEEE Transactions on Information Forensics and Security, 2014, 10(3): 507-518.

[23]Goljan M, Fridrich J, Kirchner M. Image manipulation detection using sensor linear pattern[J]. Electronic Imaging, 2018, 2018(7): 119-1-119-10.

[24]Rao Y, Ni J. A deep learning approach to detection of splicing and copy-move forgeries in images[C]∥2016 IEEE International Workshop on Information Forensics and Security (WIFS). IEEE, 2016: 1- 6.

[25]Ouyang J, Liu Y, Liao M. Copy-move forgery detection based on deep learning[C]∥2017 10th International Congress on Image and Signal Processing, BioMedical Engineering and Informatics (CISP-BMEI). IEEE, 2017: 1-5.

[26]Liu Y, Guan Q, Zhao X. Copy-move forgery detection based on convolutional kernel network[J]. Multimedia Tools and Applications, 2018, 77(14): 18269-18293.

[27]Wu Y, Abd-Almageed W, Natarajan P. Image Copy-Move Forgery Detection via an End-to-End Deep Neural Network[C]∥2018 IEEE Winter Conference on Applications of Computer Vision (WACV). IEEE, 2018: 1907-1915.

[28]Muzaffer G, Ulutas G. A new deep learning-based method to detection of copy-move forgery in digital images[C]∥2019 Scientific Meeting on Electrical-Electronics & Biomedical Engineering and Computer Science (EBBT). IEEE, 2019: 1- 4.

[29]Zhong J L, Pun C M. An End-to-End Dense-InceptionNet for Image Copy-Move Forgery Detection[J]. IEEE Transactions on Information Forensics and Security, 2019, 15: 2134-2146.

[30]Zhu Y, Chen C, Yan G, et al. AR-Net: Adaptive Attention and Residual Refinement Network for Copy-Move Forgery Detection[J]. IEEE Transactions on Industrial Informatics, 2020, DOI: 10.1109/TII.2020.2982705.

[31]Wu Y, Abd-Almageed W, Natarajan P. BusterNet: Detecting copy-move image forgery with source/target localization[C]∥Proceedings of the European Conference on Computer Vision (ECCV), 2018: 168-184.

[32]Goodfellow I, Pouget-Abadie J, Mirza M, et al. Generative adversarial nets[C]∥Advances in Neural Information Processing Systems, 2014: 2672-2680.

[33]Isola P, Zhu J Y, Zhou T, et al. Image-to-image translation with conditional adversarial networks[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2017: 1125-1134.