1 引言

图像字幕生成[1- 4]已经将标签空间的复杂性从一组固定的类别扩展到了可以传达更丰富概念的单词序列。该任务从早期的基于模板学习和语义迁移学习,到目前主要基于神经网络模型学习,其生成语句质量与性能的提升主要由神经网络的发展决定。该任务[5- 8]通常使用卷积神经网络(Convolutional Neural Network,CNN)作为图像编码器,将图像特征转换为“中间语言”,然后使用递归神经网络(Recurrent Neural Network,RNN)作为解码器来预测句子。这种方法抽象度高,泛化能力强,具有模板学习不可比拟的优势,同时生成的语句灵活度高,不受固定句式影响,与人类表达习惯更为贴切。其后续的工作大多是在此基础上融合更多的先验知识(如结合注意力机制、文本引导等),进一步提升描述词汇的准确度。除此之外,也有很多研究者[9]通过改善优化语句生成网络(即递归神经网络)来将描述单元模型变得更加强大,从而提高生成语句的质量。

基于以上研究,为得到图像更细粒度的描述,Justin J等人[10]提出了一种全卷积定位网络,通过在模型中添加区域定位模块,对候选区域进行插值与回归运算并将其送入LSTM(Long Short Term Memory)网络,在兼顾高效性和有效性的前提下,研发了一个可支持端到端训练且只需一次优化的模型,启发了研究者对密集字幕描述的探索。尽管双线性插值允许精确的端到端训练,但是由于梯度的变换特性,模型可能更难训练,因此只有寻找到更为合适的网络结构才能将端到端训练的优势充分发挥。之后,Yang L J等人[11]认为仅使用视觉区域可能会因重叠导致位置不准,且单个区域难以生成有质量的句子,因此提出了一种新颖的多区域联合推理模型结构,该模型结构结合了联合推理和上下文融合这两个概念来解决区域定位不准确问题。Li等人[12]则采取了一种更为简洁的方法,以VGG16为基础网络,采用gLSTM为检测到的视觉对象进行上下文编码,并以此指导每个区域的句子生成及视觉区域边界框的位置微调,实现更为精准的密集描述。虽然VGG网络层数加深可带来一定效果提升,但也会造成梯度消失,从而使模型学习困难。Yin等人[13]同样为解决上下文引用的问题,引入了局部信息、邻居信息与全局信息,从多个尺度上辅助每条语句的生成,其中邻居信息由CFE(Contextual Feature Extractor)获取,即用其余局部特征的加权点积。为探索更加简单有效的实现方法,本文模型中的上下文特征获取采用随机选择剩余局部特征。Kim等人[14]设计了一种更为复杂的模型的三重数据记忆流模型。他们根据人们在描述图像中视觉对象关系时常使用<主-介-宾>形式的习惯,为每种视觉对象区域(主/介/宾)设计一条专用的编码网络,然后使用多任务学习(Multi-task Learning)的方法为每个区域生成更具价值的视觉对象关系描述。这些方法都对直接使用视觉区域生成描述进行了改进,虽然密集描述中对视觉对象的内在逻辑关注较少,但研究者们不约而同地认为上下文语境对于生成可用且更为准确的区域描述的重要性,认识到图像各语义对象之间并不是完全孤立的,必须结合其周围的具体环境生成相应的细节描述,使各语句之间既相互独立,又互有联系。

本文针对基于Visual Genome数据集的字幕描述任务,利用深度残差网络与并行LSTM的联合模型开展密集字幕描述方法研究。结合图像特性,从训练网络深度、图像特征获取方式、特征表征使用、建议ROI特征数量以及特征融合算子不同等方面进行探究分析。我们替换了几种不同的网络结构以验证这两项创新,并进行了大量实验以探索其优势和特征。模型在Visual Genome V1.2数据集上实现了10.39%的平均精度(Mean Average Precision,mAP)。

2 模型

2.1 基线模型

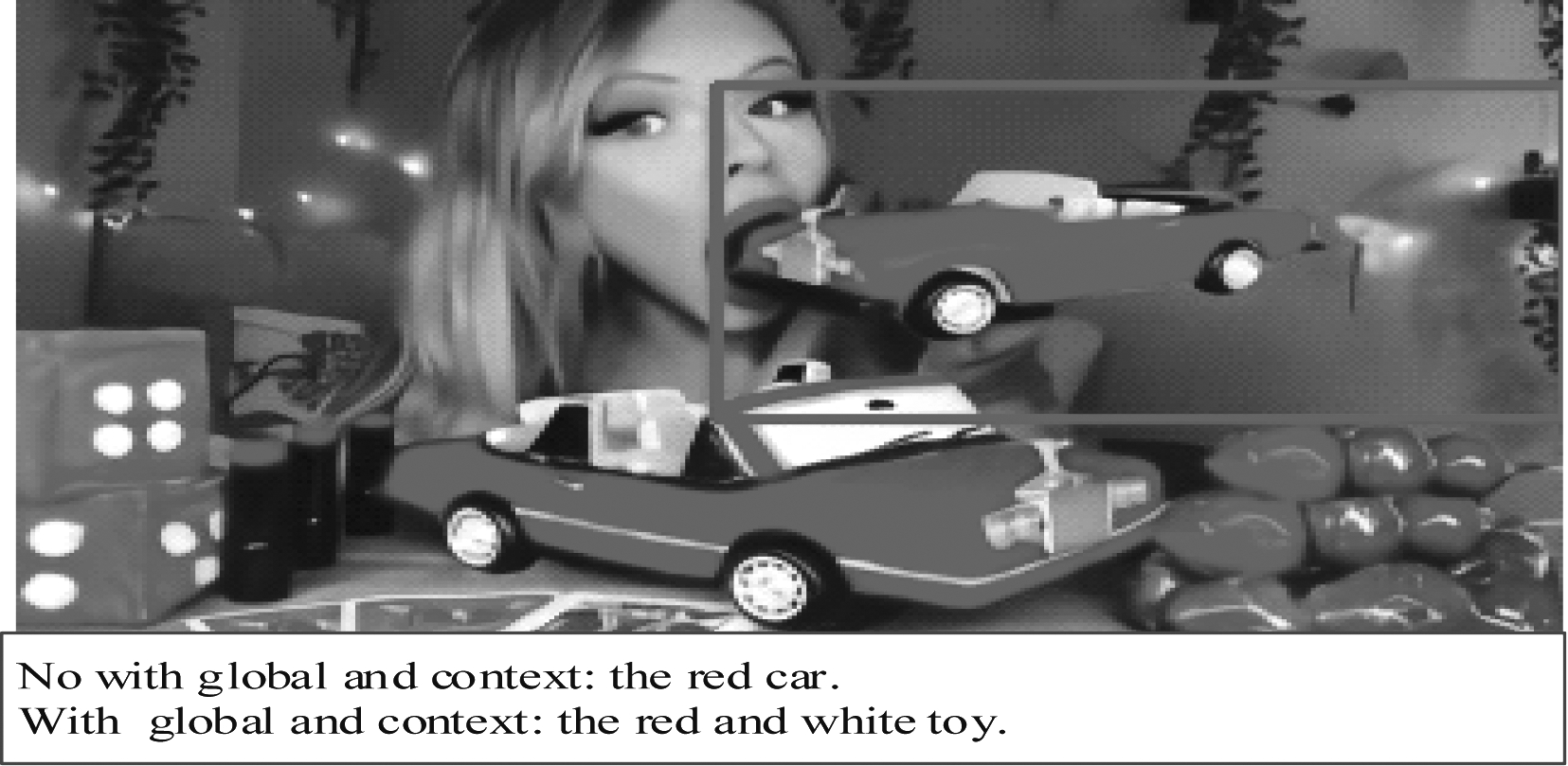

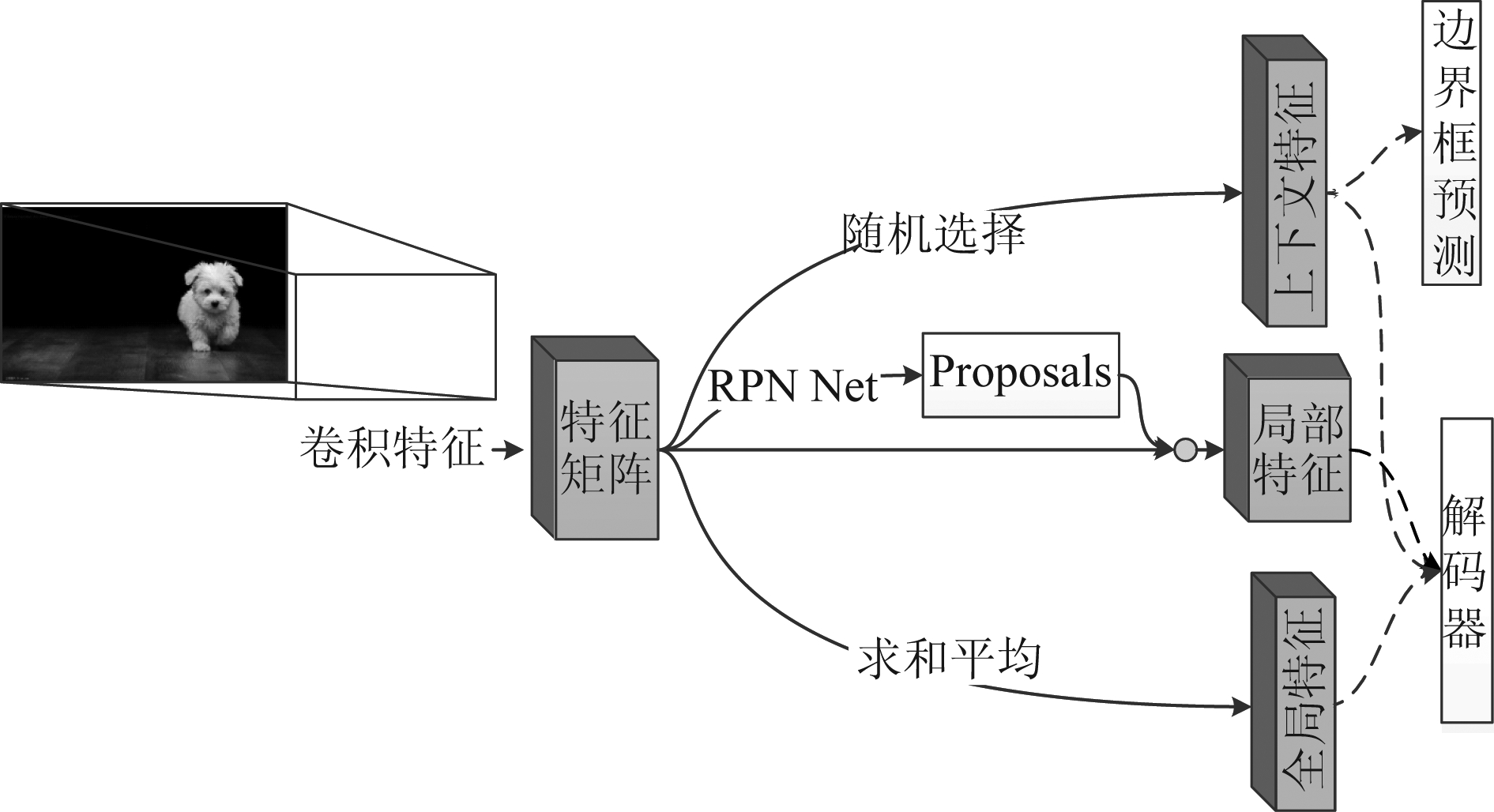

目前大多数模型采用Faster R-CNN(Faster R-Convolutional Neural Network)的两级神经网络来检测基于图像特征映射的对象,其中图像特征映射是由完全卷积神经网络生成。第一阶段,网络使用RPN(Regional Proposal Network)生成极有可能是感兴趣区域的区域提议,之后将每个区域提议转换成固定长度的特征向量;第二阶段,定长特征向量被送入下一网络,以预测对象类别及边界框偏移。由于梯度不能通过所提出的坐标传播,因此精确的联合训练对于Faster R-CNN是不可行的,可通过交替更新RPN和最终预测网络的梯度参数来训练,也可以通过近似联合的方法来训练更新后的两部分梯度参数。此外,研究者充分考虑区域与整体关系并利用上下文信息来避免较为明显的视觉描述错误,如图1所示。

图1 有无上下文和全局生成描述语句比较

Fig.1 Context and global information exist and do not exist generation description statement comparison

我们算法模型在第一阶段直接使用Faster R-CNN的RPN网络来生成感兴趣区域的区域提议,与前人所不同的是,本文的特征提取网络采用残差网络与Faster R-CNN相结合的联合模型。对于字幕生成和区域定位的第二阶段,我们使用图2的模型结构,其中区域特征除被送入并行LSTM以产生区域描述,还被用于预测边界框偏移和完成检测网络损失函数的计算。Li等人是先使用目标检测网络将图像中的目标对象及其相关特征信息(位置、大小)检测提取,结合相对应的LSTM网络获得目标上下文特征,以此作为第二阶段网络的输入。我们考虑到密集区域描述仍不可以过于脱离整体图像,从而除了考虑区域目标的相关特征信息,还进一步适时加入了全局特征信息,以达到区域描述更加符合图像语境。而Yin等人则采用上下文特征提取器获取了描述区域的邻居信息,受该项工作的启发,我们的模型简化了描述区域的上下文特征信息获取,采用随机选择其余感兴趣区域的方法,在不降低定位准确度和描述丰富度的前提下,很好的实现密集字幕描述任务。除此之外,本文算法第一阶段与第二阶段结合后可构成端到端结构,且我们的基线模型使用近似联合训练,这证明此种训练方式对目标检测和语义分割是有效的。

图2 基本模型框架图

Fig.2 Block diagram of basic model

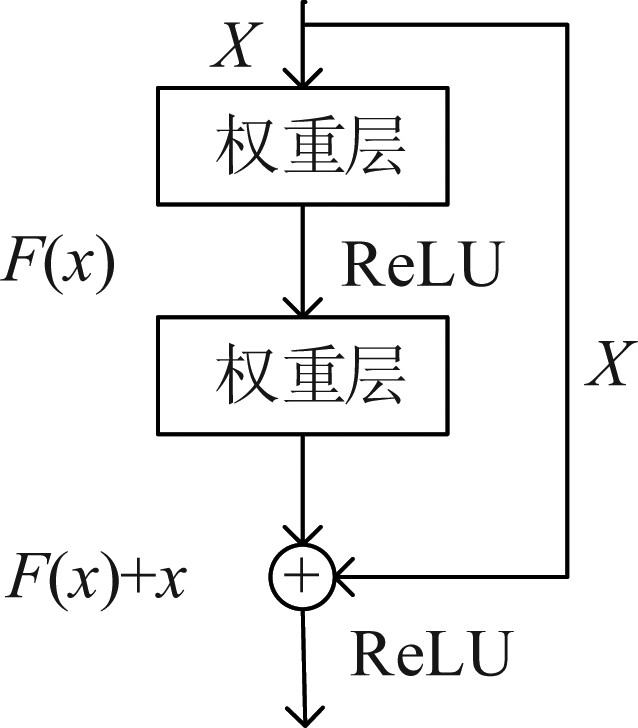

2.2 特征提取网络

基线模型中均以VGG为基础网络,VGG虽可通过深化模型结构来提高网络性能,但当VGG网络到达某个深度时,它会陷入性能饱和的困境。随着网络深度的加深,梯度消失,从而导致模型训练困难和“退化”现象(退化:模型深度增加,输出错误率也会增加)。残差网络[15-16]在一定程度上缓解了这个问题,增加网络深度的同时还提高了模型的分类性能。残差网络包括五个卷积层和一个平均池化层[17],它借鉴了高速网络跨层连接的思想,并在卷积中使用了残差单元,如图3所示。残差网络与其他特征提取网络最大的不同在于学习目标,残差网络学习的是上一单元的输入值与输出值的差,因此,模型的训练目标是将差趋于0,故精度不会随着网络加深而降低。残差网络的输入端可以接收所有图片数据,输出端过滤出称为特征图的图像特征。本文使用深度残差网络解决图像密集字幕描述中的特征提取,将输入图片进行预处理,然后将处理后的图像输入预训练好的神经网络(ResNet)中,从而获得相应的特征图向量。

图3 残差单元结构

Fig.3 Residual block structure

由基线模型可知,给定区域方案的边界框定位和区域描述联合推理的模型设计将这两者结合起来,很大程度上改善区域定位和密集字幕。与之相同,为了使边界框偏移预测器了解相关区域的语义信息,我们将边界框偏移作为区域描述编码LSTM的输出,如图4。并行LSTM分别使用一个LSTM序列来预测边界框偏移和密集字幕描述,将字幕模型和位置预测器的嵌入隐藏空间分开,但都接收最后预测单词的嵌入表示作为输入。当“Next Word”是句末标记并且描述完成时,在描述的最后一个时间步骤预测边界框偏移。由此网络在预测边界框偏移时便获得了关于整个图像描述的信息。

图4 边界框预测

Fig.4 Boundary box prediction

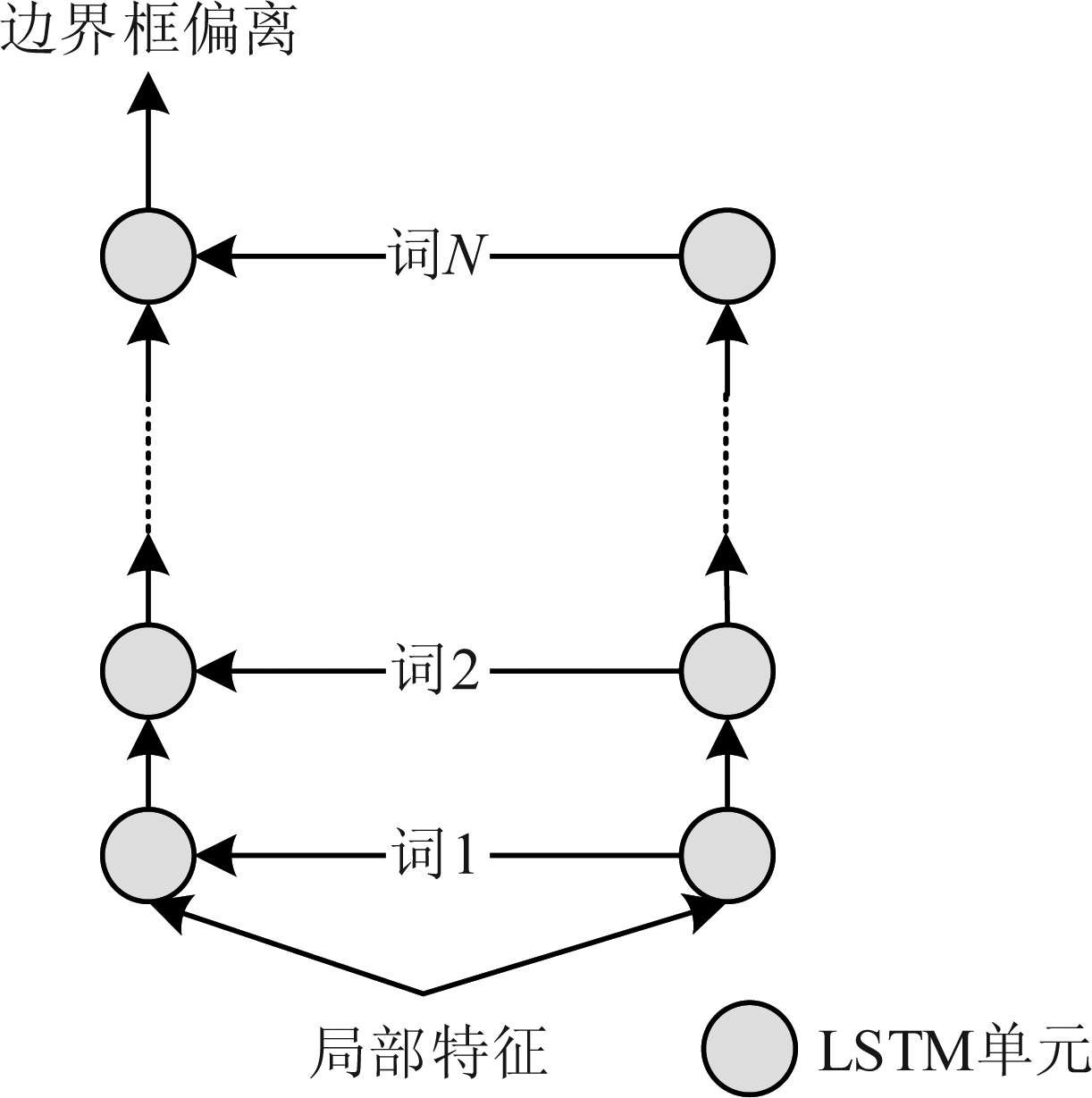

2.3 并行LSTM网络

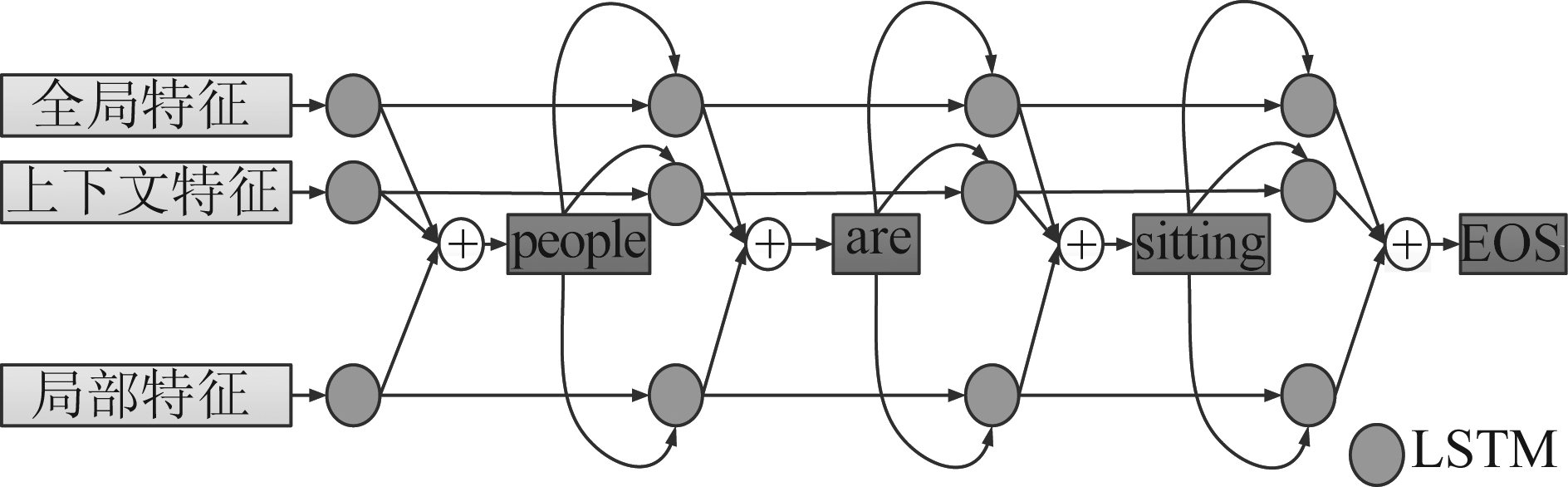

图像的视觉信息对于理解图像中的局部区域有很重要的作用[18],在很多领域中,图像上下文和全局信息已经在诸如目标检测和语义分割任务得到了很好的应用。尽管在这些任务中上下文特征和全局特征起到了积极的作用,本文希望找到一种在图像密集字幕描述生成模型的语言预测任务中结合上下文特征、全局特征和局部特征的有效方法,从而提升目标语言描述的质量。由于目标定位框没有直接影响到上下文特征和全局特征,因此本文仅使用上下文特征和全局特征来辅助目标语言描述的预测任务。

在这项工作中,算法结构将局部特征、上下文特征和全局特征分别输入到LSTM单元中,将它们的输出结合在一起,然后生成本文的预测单词。本文使用加法算子对这些输出进行结合,当前时间步选择单词后,其嵌入表示将反馈到三个并行的递归神经网络中,以指导下一个单词的生成,直到语句结束信号“EOS”出现。本文模型与基线模型有所差别,在Faster R-CNN生成目标特征矩阵时,会多生成一个维度的矩阵,基本模型的目标特征矩阵维度是256×512,而本文模型的目标特征矩阵的维度是257×512,其中多出来的1×512作为模型中的上下文特征,于此同时,本文将其余的256×512的特征矩阵进行求和,然后进行平均操作,从而得到一个1×512的特征矩阵,作为模型中的全局特征,具体实现见图5。

图5 特征获取

Fig.5 Features extraction

如图6所示,并联LSTM网络一共分为三层,每一层都有不同的输入,其中局部特征是感兴趣区域的特征,而全局特征是所有图片中的局部特征的集合,上下文特征是除当前局部特征之外,在其他局部特征中随机选择的特征向量。这三个特征的融合可以使图像感兴趣区域之间的关系更加紧密,此时生成的描述语句比传统图像描述模型生成的描述语句更加贴合图像本身,可以生成表达更准确和语义更丰富的描述,并且在各项评估指标上优于目前许多字幕生成模型。

图6 局部特征,全局特征和上下文特征的融合模型

Fig.6 A fusion model of local, global and context feature

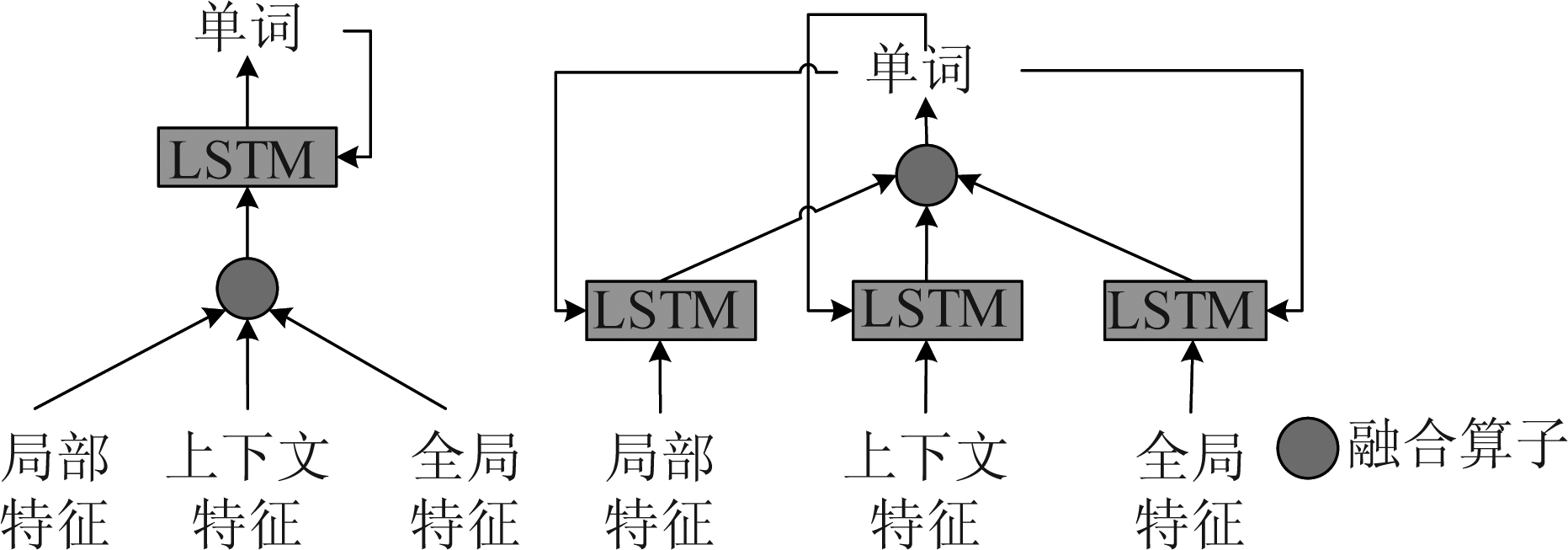

2.4 联合网络模型

前述的特征提取网络和并行LSTM特征融合的模型结构可以容易结合为整体密集字幕生成网络。本节中,我们进一步讨论了特征融合的时间及位置对整个描述模型最终结果的影响。在图7中可以看到我们分别采用早期和后期融合的方法完成整个网络模型。每个时间步预测一个单词,所有单词不仅被编码到位置,还要反向传播给LSTM网络,并在字幕的最后一个时间步预测边界框偏移。

图7 左为前期融合方法,右为后期融合方法

Fig.7 Shows the early fusion method on the left and the late fusion method on the right

最后,我们字幕模型训练归结为最小化以下损失函数L:

L=Lcap+αLdet+βLbbox

(1)

其中,Lcap、Ldet和Lbbox分别表示字幕预测损失、检测损失和边界框回归损失,α和β为加权系数。Lcap是用于在序列模型的每个时间步进行单词预测的交叉熵项,Ldet是前景/背景区域的两类交叉熵损失,而Lbbox是平滑L1损失。Ldet和Lbbox都是在区域建议网络和最终预测中计算的。对于使用LSTM预测边界框偏移的模型,在LSTM输出的最后一个时间步长计算第二个Lbbox。

3 实验结果分析

3.1 数据集

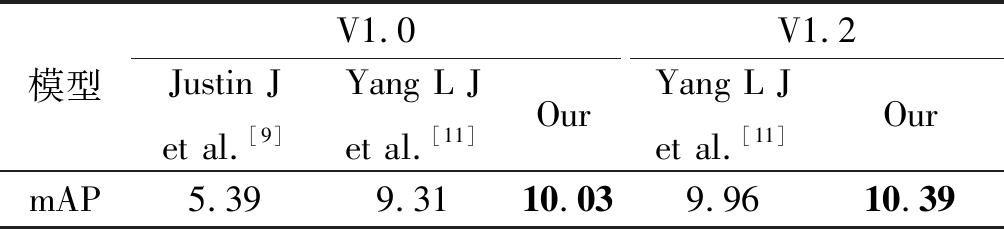

为方便比较,我们主要在数据集Visual Genome进行了实验,该数据集有Visual Genome 1.0和Visual Genome 1.2两个版本,其中包含94000张图像和4100000条图像区域描述语句。我们采用了与Justin J等人论文相同的训练/验证/测试划分标准和平均准确性(mAP)评估指标,该指标共同测量定位和描述精度。对于不同的Intersection over Union(IoU)定位精度阈值和不同的Meteor语言相似性得分阈值,计算平均精度后进行平均以产生mAP得分。除此之外,我们还使用了多个不同的阈值参数集,其中包括预测中使用的感兴趣区域数量和Non-Maximal Suppression(NMS)的IoU比率。基于此数据集,本文模型与其他工作最佳结果比较如表1。本文与Yang L J等人的方法有所区别,他们只考虑了上下文信息,本文在此基础上使用加法算子增加了全局信息,在Visual Genome 1.0与1.2数据集上分别将mAp分数提高至10.03%、10.39%。与他们的最佳实验结果9.31%、9.96%相比,我们达到了更好的实验结果,获得了更高质量的语句描述。在接下来的章节中,我们首先介绍训练和评估细节,然后评估和比较不同结构设计下的字幕生成模型,最后探讨超参数对模型评估的影响。在训练中,我们使用最小批量为1的随机梯度下降算法来近似联合训练整个网络。整个模型总共进行了700000次迭代。为提高效率,ROI语句长度不应超过10个字,并选择数据集中频率最高的10000个单词作为单词,其余的替换为

表1 在Visual Genome V1.0和V1.2上本文模型 与其他工作的最佳结果比较

Tab.1 The best results of this model and other works were compared on Visual Genome V1.0 and V1.2

模型V1.0Justin J et al.[9]Yang L J et al.[11]OurV1.2 Yang L J et al.[11]OurmAP5.399.3110.039.9610.39

3.2 深度特征提取网络

在本节中,我们评估了三个不同层数的残差网络和VGG16网络模型,所有模型都具有卷积层和RPN网络,并且采用近似联合训练。为了进一步阐明不同模型设计的效果,我们还基于相同的区域建议和图像特征进行实验来评估模型的性能,此时并未添加全局特征向量和上下文特征向量。为此,我们将Faster R-CNN的权重固定为VGG16的权重,并使用基于固定的Faster R-CNN权重在视觉基因组上训练的保留区域提议网络。端到端训练模型的结果显示在表2。

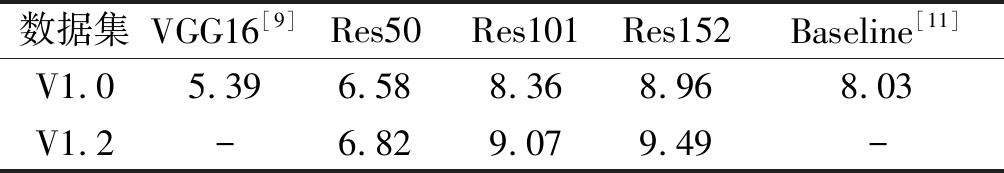

表2 同一超参数背景下VGG16与残差网络的实验结果比较

Tab.2 The experimental results of VGG16 and ResNet under the same hyperparameter background were compared

数据集VGG16[9]Res50Res101Res152Baseline[11]V1.05.396.588.368.968.03V1.2-6.829.079.49-

在相同端到端实验条件下,三个残差网络的实验结果均优于VGG16网络,并且随着卷积网络卷积层的增加,mAP分数依次增大。在使用ResNet的网络结构后,可以发现层数不断加深导致的训练集上误差增大的现象被消除了,ResNet网络的训练误差会随着层数增大而逐渐减少,但仍不可以无限延深。除此之外,我们还可以看到,仅ResNet-50网络模型的实验结果(6.58)比极限模型差,其余两个都优于基线模型的最优结果(8.03)。由ResNet构建的特征提取网络不仅没有出现退化问题,错误率也大大降低,同时计算复杂度也保持在很低的程度。以上数据表明,虽然深度特征提取网络提取的深层特征不会直接影响标题生成网络,但有助于更全面特征的获取,对整个模型都有积极的影响,从而产生语义丰富的描述语句。

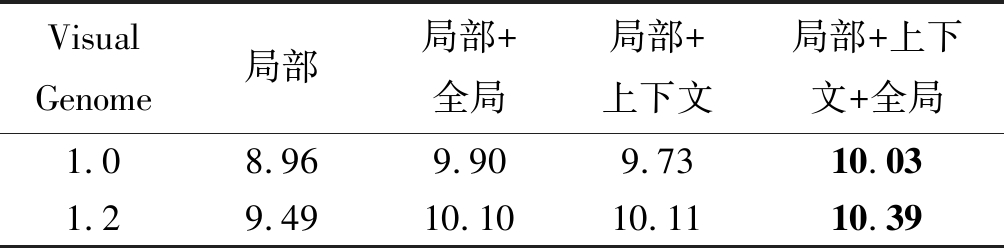

3.3 并行递归神经网络

在本节中,我们将全局特征和上下文特征融合到图像密集字幕生成模型中。图8显示了通过不同模型获得的实验结果。在图8的(a)、(b)和(c)中,显然,与没有融合全局特征和上下文特征的模型相比,我们提出的模型生成的感兴趣区域描述更为合理。模型不限于感兴趣区域的一小部分,而是与整个图像相结合以提取信息。在图8(d)中,我们的模型准确地给出了密集字幕示例描述,该示例产生了与图像整体紧密相关的感兴趣区域描述语句。

为了提高实验的说服力,我们仍然使用VGG16作为特征提取层,并且仅将并行字幕神经网络替换为原始字幕生成网络结构。如表3所示,我们使用数据集V1.0设置了与[10]相同的超级参数,与局部特征相比,局部+上下文+全局的mAP可以从5.39%提高到9.01%。局部+全局和局部+上下文的mAP分别达到7.97%和8.53%。因此,全局特征信息和上下文特征信息对改善实验最终性能做出了很大贡献。

表3 同一特征提取层与不同字幕生成网络的比较结果

Tab.3 Comparison results between the same feature extraction layer and different caption generation networks

局部局部+上下文局部+全局局部+上下文+全局5.398.537.979.01

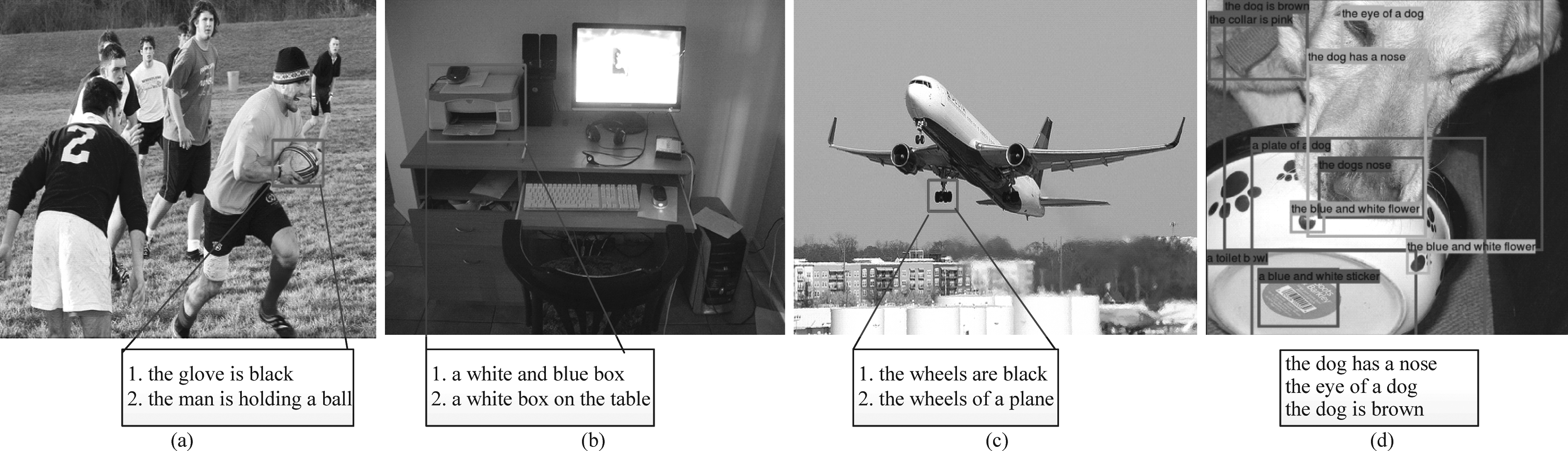

为了进一步验证模型的优势,我们使用Res152作为特征提取层,并采用局部特征,上下文特征和全局特征融合的并行字幕生成网络。如表4所示,基于数据集V1.0,与单纯使用局部特征相比,局部、上下文和全局融合实验结果mAP分数可以从8.96%提高到10.03%。此外,我们还基于数据集V1.2进行了类似的对比试验,在这里,我们看到了类似于V1.0的结果,局部、上下文和全局融合的实验结果mAP分数达到10.39%,这进一步证明了我们模型的优势,并且可以看到局部、上下文和全局的融合极大地提高了模型的整体性能,可以表达更准确和语义更丰富的描述,从而生成更完整的视觉表示。

表4 在数据集V1.0和V1.2上mAP结果比较

Tab.4 mAp results were compared on data sets V1.0 and V1.2

Visual Genome局部局部+全局局部+上下文局部+上下文+全局1.08.969.909.7310.031.29.4910.1010.1110.39

图8 (a)(b)(c)中,语句1表示没有融合全局和上下文信息的模型预测, 语句2表示本文的模型预测。(d)是本文提出模型的一个完整的预测实例

Fig.8 In (a)(b)(c), statement 1 represents the model prediction that does not incorporate global and context information, and statement 2 represents the model prediction in this article.(d) is a complete prediction example of the model presented in this paper

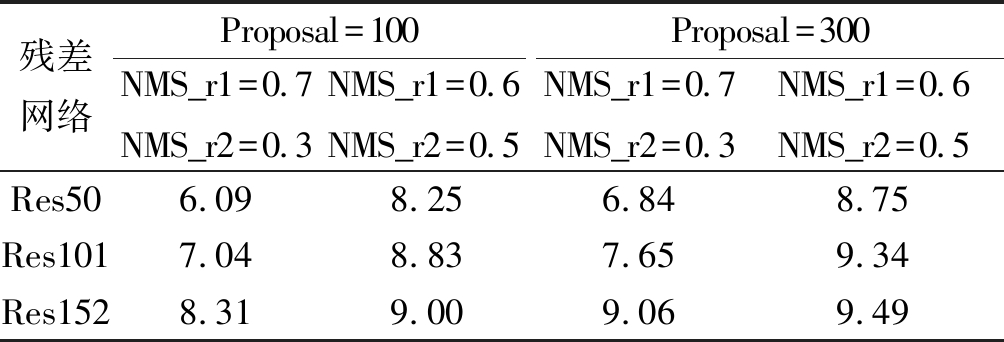

3.4 超参数

本文更改一些超参数以提高实验的可靠性。对于RPN生成的感兴趣区域数量,实验比较数量大小为100和300时的实验结果。除此之外,Faster R-CNN中NMS阈值,即IoU比率也作为超参数进行对比实验,分别表示为NMS_r1和NMS_r2,表5给出不同网络模型的实验结果。在三种不同深度的残差网络结构中,Res152特征提取网络在不同超参数下性能最好,mAP分数可达到9.493%。从mAP数据可以看出,ROI数量为300,NMS_r1和NMS_r2分别为0.6、0.5的实验效果最好。

表5 不同残差网络在不同超参数条件下的映射实验结果

Tab.5 Mapping experiment results of different ResNets under different hyperparameter conditions

残差网络Proposal=100NMS_r1=0.7NMS_r2=0.3NMS_r1=0.6NMS_r2=0.5Proposal=300NMS_r1=0.7NMS_r2=0.3NMS_r1=0.6NMS_r2=0.5Res506.098.256.848.75Res1017.048.837.659.34Res1528.319.009.069.49

3.5 联合网络模型

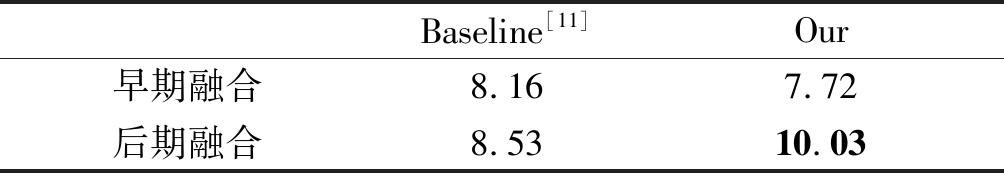

由前期文献资料可知,拼接、求和和乘法三种融合算子中,三种类型的融合方法都对不同模型的mAP进行了改进。一般来说,串联和乘法比求和更有效,但是余量很小。为方便比较,本文的两种融合模型均采用求和融合算子,与基线模型相对应的两种融合模型实验结果比较见表6。

表6 基于同一融合算法的不同融合方式实验结果

Tab.6 Experimental results of different fusion methods based on the same fusion algorithm

Baseline[11]Our早期融合8.167.72后期融合8.5310.03

对比具有上下文信息的早期融合和后期融合,我们发现对于所有对应的模型对,后期融合都优于早期融合。此外,早期融合的表现仅略胜于无背景的同行。早期融合的一个缺点是它直接结合了具有非常不同的视觉元素的局部和上下文特征,使得它不太可能在以后将视觉元素去相关到局部区域或上下文区域模型的各个阶段。对于相同早期融合方式的基线与本文模型算法,全局特征的加入使得算法比基线模型还要过分关注整个图像,从而不能将注意力集中在感兴趣区域,不能很好将局部特征表述清楚,以至于密集字幕生成的描述不够具体。对于相同后期融合方式的基线与本文模型算法,全局特征的加入不仅避免了早期融合由它引起的问题,而是进一步提升了mAP,获得的感兴趣区域描述语句不仅将区域细粒度特征描述出来,且符合此时语境。

4 结论

本文提出了一种基于深度卷积神经网络的图像描述生成方法,采用深度网络用于提取具有完整视觉描述的图像特征,并通过实验证明这对于传统图像描述模型是很好的补充,同时通过与其他特征提取网络的对比,选择性能更好的残差网络来实现特征获取。在此基础上,本文进一步提出了并行长短时记忆网络字幕生成模型,结合了局部信息、全局信息与上下文信息,可以提取更加全面的图像信息,从而获取更加丰富的视觉特征表示。此外,本文还通过改变感兴趣区域数量,进一步表现出了密集字幕相比于传统图像字幕的优势。实验结果表明,本文模型方法可以生成表达更准确和语义更丰富的描述,并且在Visual Genome数据集上取得出色的实验结果。

[1] Kelvin X, Jimmy L B, Ryan K, et al. Show, Attend and Tell: Neural Image Caption Generation with Visual Attention[C]∥International Conference on Machine Learning, Lille, France, 2015: 477- 499.

[2] Yu Niange, Hu Xiaolin, Song Binheng, et al. Topic-Oriented Image Captioning Based on Order-Embedding[J]. IEEE Transactions on Image Processing, 2019, 28(6): 2743-2754.

[3] Su Jinsong, Tang Jialong, Lu Ziyao, et al. A neural image captioning model with caption-to-images semantic constructor[J]. Neurocomputing, 2019, 367(8): 144-151.

[4] Xu Kaisheng, Wang Hanli, Tang Pengjie. Image captioning with deep LSTM based on sequential residual[C]∥IEEE International Conference on Multimedia and Expo(ICME), Hong Kong, China, 2019: 361-366.

[5] Zhu Xinxin, Li Lixiang, Liu Jing, et al. Image captioning with triple-attention and stack parallel LSTM[J]. Neurocomputing, 2018, 319(30): 55- 65.

[6] Fang Fang, Wang Hanli, Tang Pengjie. Image Captioning with Word Level Attention[C]∥IEEE International Conference on Image Processing, Athens, Greece, 2018: 1278-1282.

[7] Lin Xiao, Devi P. Leveraging Visual Question Answering for Image-Caption Ranking[C]∥European Conference on Computer Vision, Amsterdam, Netherlands, 2016: 261-277.

[8] 田萱, 王亮, 丁琪. 基于深度学习的图像语义分割方法综述[J]. 软件学报, 2019, 30(2): 440- 468.

Tian Xuan, Wang Liang, Ding Qi. Review of image semantic segmentation methods based on deep learning [J]. Journal of Software, 2019, 30(2): 440- 468.(in Chinese)

[9] Justin J, Andrej K, Li Fei-Fei. DenseCap: Fully Convolutional Localization Networks for Dense Captioning[C]∥IEEE Conference on Computer Vision and Pattern Recognition, Las Vegas, 2016: 4565- 4574.

[10]Hochreiter S, Schmidhuber J. Long Short-Term Memory[J]. Neural Computation, 1997, 9(8): 1735-1780.

[11]Yang Linjie, Kevin T, Yang Jianchao, et al. Dense Captioning with Joint Inference and Visual Context[C]∥IEEE Conference on Computer Vision and Pattern Recognition, Honolulu, USA, 2017: 1978-1987.

[12]Li Xiangyang, Jiang Shuqiang, Han Jungong. Learning object context for dense captioning[C]∥Proceedings of the Association for the Advance of Artificial Intelligence(AAAI), Hawaii, 2019: 8650- 8657.

[13]Yin Guojun, Sheng Lu, Liu Bin. et al. Context and attribute grounded dense captioning[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, Long Beach, 2019: 6241- 6250.

[14]Guo Longteng, Liu Jing, Yao Peng. et al. MSCap: Multi-style image captioning with unpaired stylized text[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Long Beach, 2019: 4204- 4213.

[15]Sharma N, Jain V, Mishra A. An Analysis Of Convolutional Neural Networks For Image Classification[J]. Procedia Computer Science, 2018, 132(8): 377-384.

[16]罗会兰, 卢飞, 孔繁胜. 基于区域与深度残差网络的图像语义分割[J]. 电子与信息学报, 2019, 41(11): 2777-2786.

Luo Huilan, Lu Fei, Kong Fansheng. Image semantic segmentation based on regional and deep residual networks[J]. Journal of Electronics and Information Technology, 2019, 41(11): 2777-2786.(in Chinese)

[17]Targ S, Almeida D, Lyman K. Resnet in Resnet: Generalizing Residual Architectures[J]. arXiv preprint arXiv: 1603.08029, 2016.

[18]Zhong Qiaoyong, Li Chao, Zhang Yingying, et al. Cascade region proposal and global context for deep object detection. arXiv preprint arXiv: 1710.10749, 2017.