1 引言

阴影是人类视觉中对深度和几何感知的单眼线索。知晓阴影的位置,一方面,可以获得光照方向[1]和场景几何信息[2- 3],另一方面也可以获取照相机的位置和参数信息。然而,阴影的存在抑制了许多基础的计算机视觉任务,如物体检测与跟踪[4- 5]。因此,阴影检测成为了计算机视觉任务中的一个基础问题。

传统的阴影检测方法一般是基于颜色与光照的物理模型,或者是基于手工特征的数据驱动方法。Finlayson等提出了基于均匀光照的完整的本征图像理论[6],并且使用熵最小化方法来获取检测和去除阴影区域所需的灰度不变图像。但是光照均匀的假设不是始终成立的,图像的质量也参次不齐,这些因素使得应用这类算法处理的图像不具备充分的鲁棒性;基于区域的阴影检测方法[9-12,36]通常利用聚类算法根据颜色、亮度、纹理等特征将图像像素分为阴影块和非阴影块;基于特征提取的方法[13-17,35,37]则是关注阴影区域和非阴影区域的不同特性;梁永侦等人[32]提出了基于LAB颜色空间的阴影检测和去除方法;王勇等人[29]旨在提升阴影和移动目标的区分度从而提高检测精度;王威等人[31]基于ViBE检测算法提出基于多特征融合的车辆阴影检测和去除;吴文君等人[33]将深度信息应用于阴影检测;张友鹏等人[34]在阴影检测中应用了光流跟踪技术。这些基于颜色与光照的物理模型,或者是基于手工特征的数据驱动方法在阴影检测方面获得了不错的结果,但是在面对复杂场景下的阴影时会显得捉襟见肘。

近年来,深度学习方法开始兴起,研究者们提出了许多利用卷积神经网络(Convolutional Neural Networks, CNN)来检测阴影的模型。Khan等人[18]首先在阴影检测领域应用了深度学习方法。他们训练了两个网络来分别检测阴影区域和边界,并且把检测结果输入到条件随机场中来优化图像结果;Vincente等人[19]使用了两个级联网络来实现阴影检测,第一个级联网络被用来提取阴影标记并将其作为阴影先验图与初始图像输入到第二个级联网络中来获取最终的阴影结果;Hosseinzadeh[20]等人应用基于颜色和纹理的支持向量机(Support Vector Machine, SVM)分类器来获取阴影先验图,并且将其与初始图像融合之后输入到预训练过的CNN中来得到阴影结果;Nguyen等人[21]使用条件生成对抗网络(Conditional Generative Adversarial Networks, CGAN)来检测阴影,其中的生成器和判别器可以互相对抗从而检测出阴影区域;Le等人[22]也从生成对抗网络(Generative Adversarial Networks, GAN)中得到了灵感,训练生成器和鉴别器分别在阴影区域衰减和阴影标记之后生成图像,以增强网络检测阴影的能力;汪明章等人[30]将图像缩放到不同尺度,从不同尺度的图像学习不同的信息。

传统方法注重图像中蕴含的物理特性,如颜色、亮度、饱和度、纹理等,而深度学习的方法是通过CNN来提取图像的不同特征,不断优化特征之间的融合方式。这些方法都忽略了初始图像本身隐藏的阴影区域的位置信息,本文通过对初始RGB图像进行灰度化处理并取反的操作,得到了初始图像的先验图。在先验图中,初始图像中的黑色阴影区域变成了白色,白色区域的数值大权重高,用先验图去加权特征提取网络提取出的不同深度的特征,可以引导网络学习到权重高的阴影区域。

本文的主要贡献总结如下:

1)首先,本文设计了一个先验加权模块(Prior Attention Module, PA)来从初始图像中提取用于引导网络学习阴影特征的先验信息。

2)其次,本文提出了一种新的阴影检测网络,采用PA提取先验信息,在自上而下路径中的上采样操作之后添加特征融合模块(Feature Polymerization Module, FPM)来更好地融合粗略的语义信息和精细的提取特征。

3)最后,在两个公开的基准数据集上评估了网络,并且将其和多种最先进的方法进行比较。结果表明,本文的方法表现出色,在SBU和UCF上正确率分别达到了96.6%和95.0%,平衡检测错误因子分别下降到了6.22和8.21。

2 网络详述

2.1 总体框架

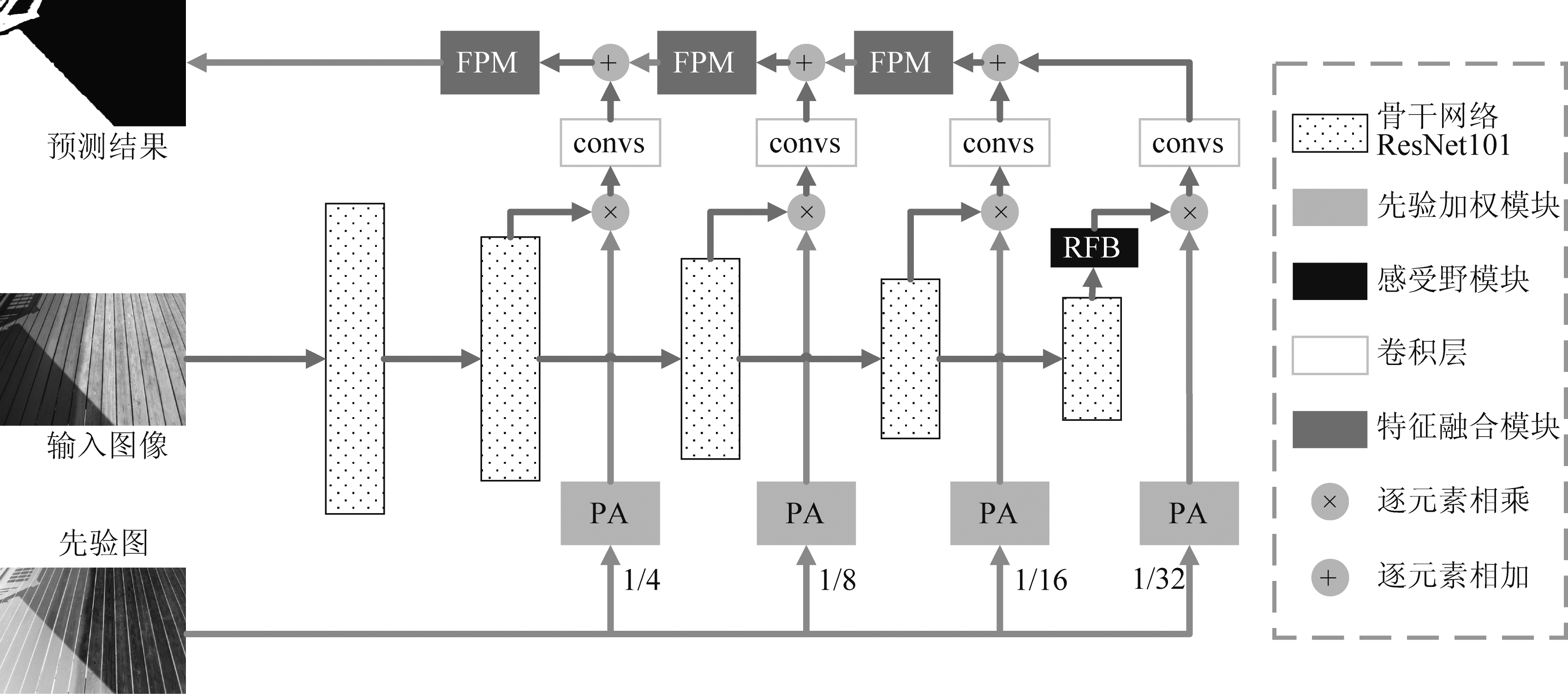

本文基于特征金字塔网络(Feature Pyramid Network, FPN[23])搭建了先验特征金字塔网络(Prior Feature Pyramid Network, PFPN),如图1所示,它是一种采用了经典U型网络结构设计的网络。

这类结构由于其强大的结合来自分类网络[24-25]的多级特征的能力,在许多视觉任务中被广泛采用,包括阴影检测。如图1所示,本文引入了先验加权模块来处理先验图,从而生成先验权值图。通过用先验权值图加权多级特征图,网络能够专注于阴影区域。为了获得更多的高级语义信息,本文在骨干网络的最上层采用感受野块[7](Receptive Field Block,RFB)来获得更大感受野的特征图。在自上而下的路径中,本文添加了多个FPMs[26]来缓解上采样对特征图带来的影响,并且确保了不同尺度的特征图能够无缝地融合在一起。

接下来,本文会逐步介绍上述网络中运用的模块并详细解释它们的功能。

2.2 通用的特征提取网络和感受野块

如图1所示,PFPN的特征提取网络选用了ResNet101[27]。作为一个通用的特征提取器,本文移除了最后的全局池化层和全连接层,使用了前5个残差块。为了简化表达,这五个残差块的侧输出用δi(αi),i∈{1,...,5},αi是δi的参数。为了获得更多的高级语义信息,本文在δ5后应用了RFB以增大特征图的感受野。对于一张H×W大小的输入图像,侧输出δ2到δ5输出的特征图f2到f5的尺度分别为![]() 最深层的来自δ5的特征图输入到RFB内以获得蕴含更多高级语义信息的特征图,将其表示为

最深层的来自δ5的特征图输入到RFB内以获得蕴含更多高级语义信息的特征图,将其表示为![]()

图1 本文方法的总体框架

Fig.1 The overall architecture of our approach

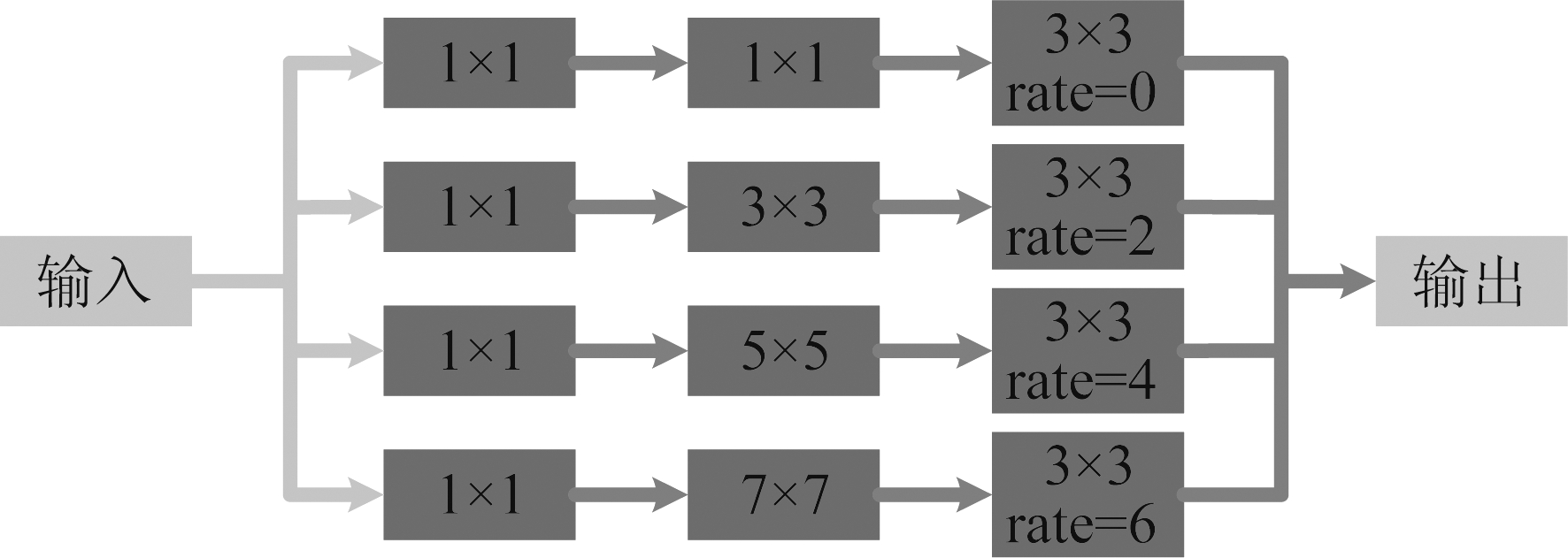

RFB的结构如图2所示。每个分支的第一层是1×1大小的卷积层,它用来改变输入特征图的通道数;分支的第二层分别是1×1,3×3,5×5,7×7的卷积层,它们的补零数分别为0,1,2,3;第三层采用了空洞卷积,卷积核大小为3×3,空洞率分别为0,2,4,6。在经过空洞卷积之后,得到了四张不同感受野的特征图,将其拼接输出特征图为![]()

图2 感受野块的结构,rate表示空洞率

Fig.2 Structure of the receptive field block and rate represents dilation rate

![]()

(1)

(2)

![]() 表示经过第i个分支处理的特征图f5;Conv3×3,2i-2表示3×3卷积核,空洞率为2i-2的卷积层;Conv(2i-1)×(2i-1),0和Conv1×1,0类似。

表示经过第i个分支处理的特征图f5;Conv3×3,2i-2表示3×3卷积核,空洞率为2i-2的卷积层;Conv(2i-1)×(2i-1),0和Conv1×1,0类似。

通过加入这四个分支,网络获得了高级语义信息被进一步地精炼的特征图![]() 随着卷积层的空洞率的不断增加,f5的感受野增大,聚集了更多的语义信息。当将四个分支的输出拼接在一起时,网络就获得了蕴含更多语义信息的

随着卷积层的空洞率的不断增加,f5的感受野增大,聚集了更多的语义信息。当将四个分支的输出拼接在一起时,网络就获得了蕴含更多语义信息的![]() 通过帮助骨干网络扩大感受野的方式增强了提取的阴影特征。

通过帮助骨干网络扩大感受野的方式增强了提取的阴影特征。

2.3 先验加权模块

PA在本文的阴影检测网络中有着重要的作用,提供了粗略的阴影区域的位置信息。它采用了使用两个残差块的PA来将先验图像转化成先验权值图。本文应用PA获取了先验权值图来引导网络专注于阴影区域。

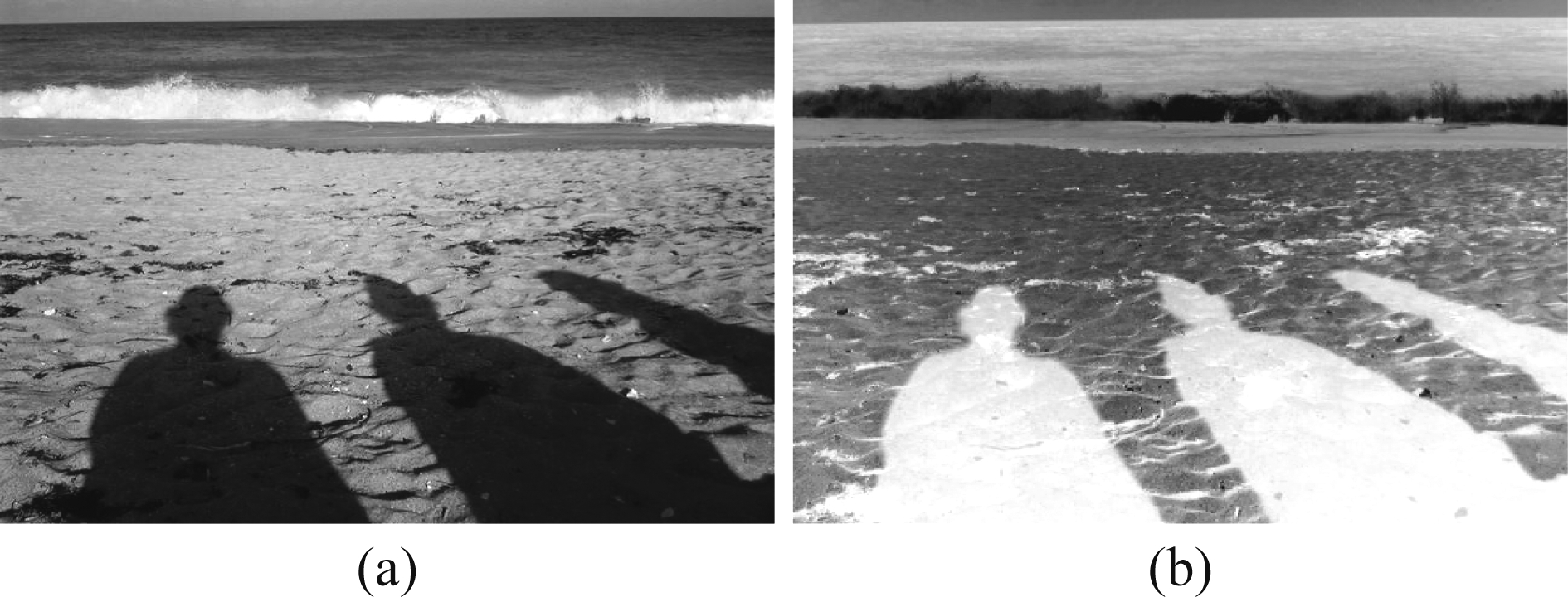

先验图中蕴含着阴影区域的位置信息。以图3中的(a)、(b)两幅图为例,(b)中的白色区域为阴影区域,它的数值大于(a)中的阴影区域的数值,阴影区域的权重也高于(a)。用(b)加权提取出的卷积特征,特征中阴影区域的权重变大,网络也就会侧重于学习权重大的阴影区域。所以先验图在网络训练时给予网络粗略的位置信息,可以让网络更快且准确地定位到阴影区域。但是,直接使用先验图加权卷积特征,先验图中的信息冗余,所以本文用PA获得先验权值图,再用权值图加权卷积特征,精炼了先验信息,减少了网络的计算量。

图3 在这个示例图像中,图像(a)是初始图像,图像(b) 是先验图像,它是将初始图像灰度化并取反得到

Fig.3 In this example image, image A is the original image and image B is the prior image which turns the original image into a grayscale image and inverts it

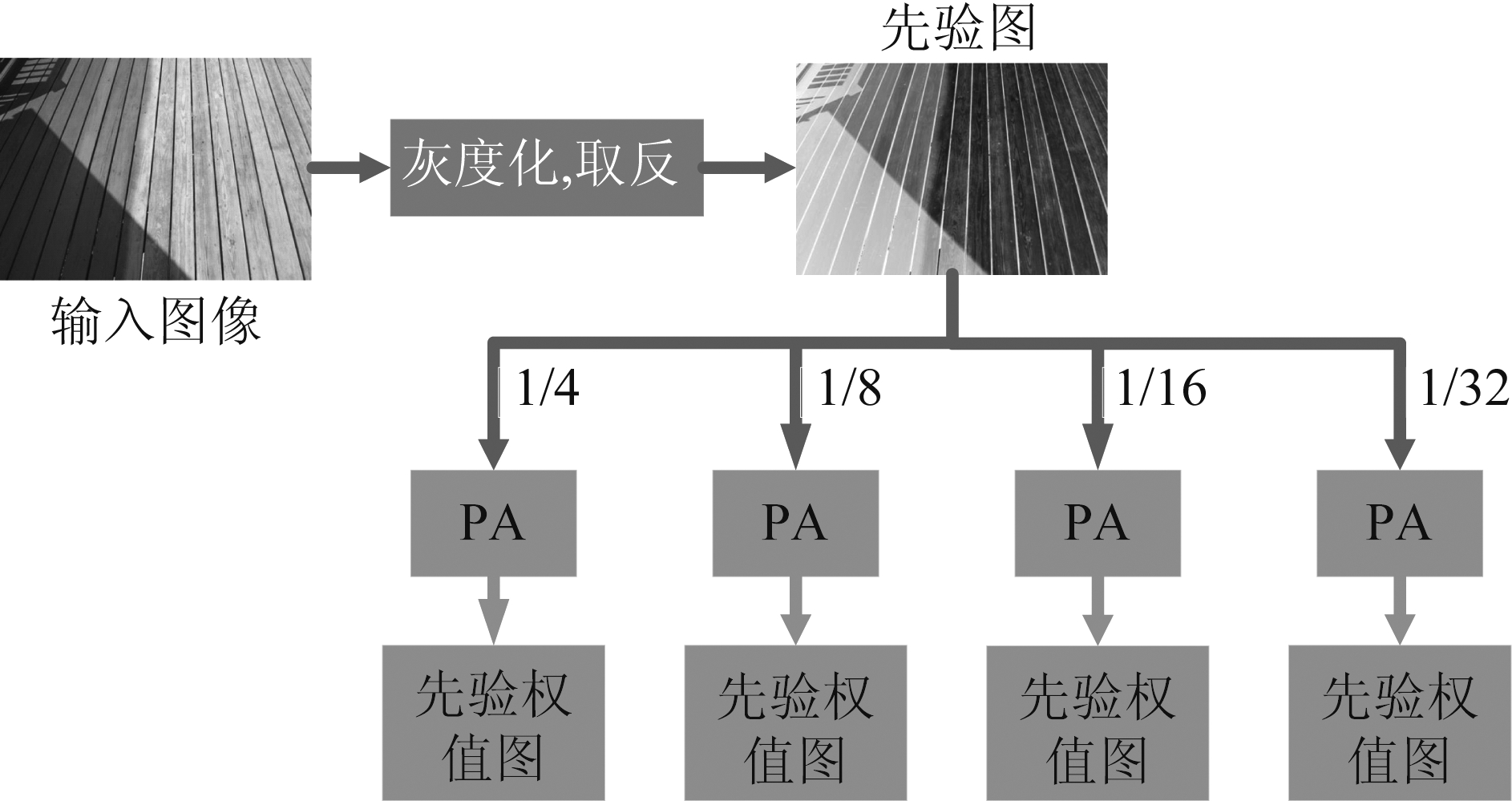

先验权值图的获取过程如图4所示。首先,将初始RGB图像灰度化且取反获得先验图。其次,用1×1大小的卷积层改变通道数以适应不同通道数的特征。接着,本文采用了4层max-pool层将先验图划分成4张![]() 的不同尺度的先验图,以便于与不同尺度的特征图融合。最后,将先验图输入到PA中得到了四张不同尺度不同通道数的先验权值图。这些先验权值图表示为βi,∀i=2,...,5。

的不同尺度的先验图,以便于与不同尺度的特征图融合。最后,将先验图输入到PA中得到了四张不同尺度不同通道数的先验权值图。这些先验权值图表示为βi,∀i=2,...,5。

图4 先验权值图的获取过程

Fig.4 The process of obtaining the prior weight map

(3)

PA表示先验加权模块;![]() 表示将先验图池化为原来尺度的

表示将先验图池化为原来尺度的![]() 大小;Conv1×1表示1×1卷积;ζ(·)表示灰度化和取反操作;ori-image表示初始图像。

大小;Conv1×1表示1×1卷积;ζ(·)表示灰度化和取反操作;ori-image表示初始图像。

图5 先验加权模块的结构

Fig.5 The construction of the prior attention module

如图5所示,PA由两个残差块和一些卷积层组成。两个残差块都是由1×1,3×3,1×1的卷积层搭建而成,后接3×3卷积层和双曲正切函数。两个残差块起到阴影先验信息的提取作用,并且在网络的训练过程中,网络的梯度反馈回来还可以优化阴影先验信息的提取过程。最后用双曲正切函数将权值图的值限制为1或-1,这样不但减少了运算量,而且在加权特征图时,特征图的阴影区域权重会越大,非阴影区域的权重会越小。

resi=pri-image+ Conv1×1(Conv3×3(Conv1×1(pri-image))),i=1,2

(4)

PA=Tanh(Conv3×3(res2(res1(pri-image))))

(5)

resi表示残差块;pri-image表示先验图;Conv3×3表示3×3的卷积,Conv1×1类似。

由PA生成的先验权值图不同于先验图,它比以前的图像包含了更多的阴影先验信息,去除了冗余信息。与此同时,先验权值图在参与网络的运算时的运算复杂度也更低。

2.4 特征融合模块

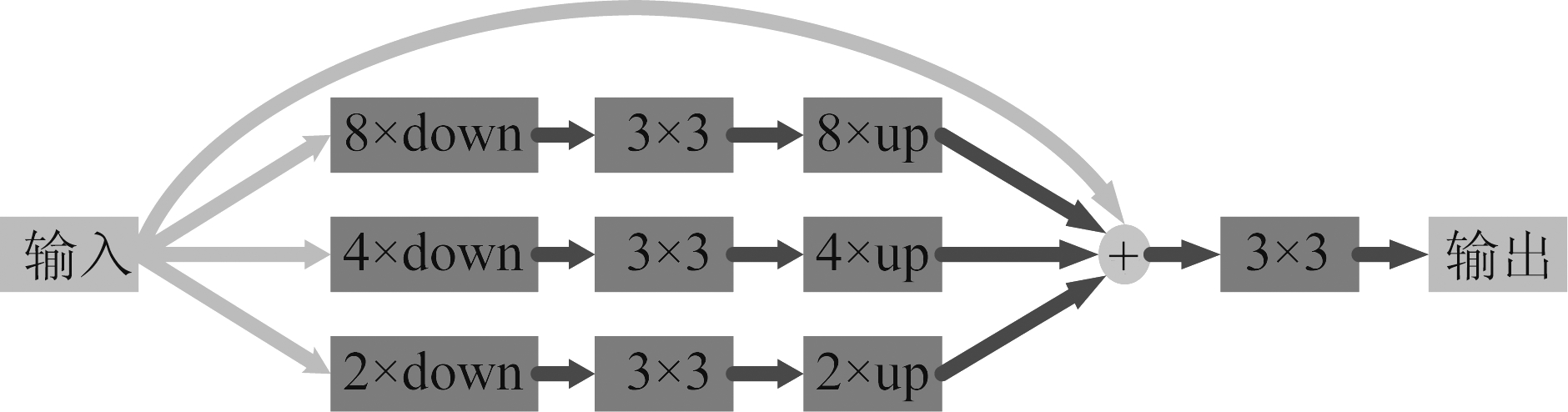

来自PA的权值图的先验信息被分配给不同尺度的特征图。然后将以两倍倍率上采样的高级特征图与上一级特征图以相加的方式融合。然而,上采样会带来混叠效应。通常,在融合操作之后添加一个3×3的卷积层可以缓解混叠效应带来的影响。但是,本文借鉴了程明明等人[26]的网络中特征融合模块,在上采样操作后加入了FPMs。

FPM的网络结构如图6所示,是由四个分支组成。特征图首先输入到下采样倍率为2,4,8的平均池化层中得到3张不同尺度的特征图,然后分别经过3×3的卷积层提取后再上采样回原特征图的尺度,最后将这3张特征图和原特征图相加经过3×3卷积层后输出。

图6 特征融合模块的结构

Fig.6 The structure of feature polymerization module

![]()

(6)

(7)

![]() 表示第n个分支的输出;up2n表示上采样2n倍;down2n表示下采样2n倍; fi表示第i层的特征图;Conv3×3表示3×3卷积层;

表示第n个分支的输出;up2n表示上采样2n倍;down2n表示下采样2n倍; fi表示第i层的特征图;Conv3×3表示3×3卷积层;![]() 表示输出特征图。

表示输出特征图。

总而言之,本文的FPM解决了两个问题。首先,在网络中应用FPM帮助网络缓解了上采样带来的混叠效应;其次FPM通过允许网络遍历不同尺度的本地上下文信息增大了网络的感受野,损失了更少的阴影信息。

3 实验

3.1 数据集

本文采用了两个基准数据集——SBU阴影数据集[19]和UCF阴影数据集[8]。SBU数据集是最大的公开可用注释阴影数据集,它由4089张训练图像和638张测试图像组成。这个数据集包含了多种阴影场景,例如人类、树木、雪、山脉、沙滩、公园、动物、交通工具和房屋等,涵盖了多种类型的图像,例如风景、自拍、近距离图像等。UCF数据集包含了145张训练图像和76张测试图像,涵盖了多种背景的室外场景。本文在SBU数据集训练了阴影检测网络,在SBU和UCF数据集上都进行了测试。

3.2 实验设置

本文采用了正确率和平衡错误检测因子作为评价标准。正确率的计算公式如下:

(8)

TP,TN,Np,Nn分别表示正样本,负样本,阴影像素的数目和非阴影像素的数目。由于在自然图像中Np通常小于Nn,本文采用了平衡错误检测因子,通过等价考虑阴影和非阴影区域来更加平衡地评价网络性能。

(9)

BER表示平衡错误检测因子,和正确率不同,BER越小,检测结果越好。

本文的网络是基于Pytorch库实现的。网络在一台9900 K的CPU和11 GB显存的2080ti的电脑上训练了30个epoch。使用了Adam优化器,初始速率为5×10-5,权重衰减为5×10-4。采用了在ImageNet数据集上预训练过的ResNet101作为骨干网络。在训练过程中,网络使用了二元交叉熵损失函数,批量输入大小为1。

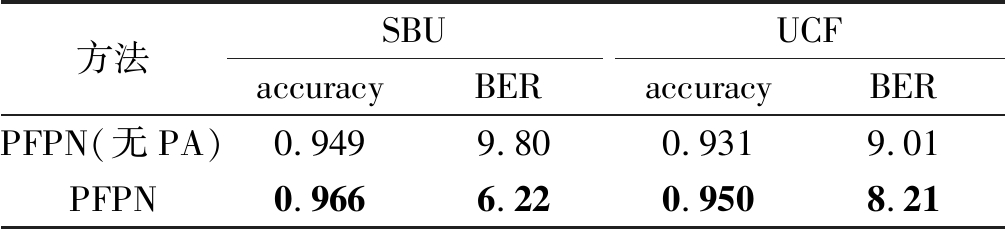

3.3 消融实验

本文的核心思想是通过先验信息引导网络学习阴影区域。为了验证先验信息是否能引导网络学习到阴影区域,本文设计了消融实验。将去除PA的PFPN与PFPN都用同样的参数在SBU数据集上训练,分别在SBU和UCF数据集上进行了测试,测试结果如表1所示。

表1 去除PA的PFPN与PFPN在SBU和 UCF数据集上的结果

Tab.1 PFPN and PFPN without PA’s results at the SBU and UCF datasets

方法SBUaccuracyBERUCFaccuracyBERPFPN(无PA)0.9499.800.9319.01PFPN0.9666.220.9508.21

从表1中可以看出,PFPN和PFPN(无PA)相比在SBU和UCF的正确率都领先了约2%,在SBU上的BER下降了约3.2,UCF上的BER下降了约0.8。这一结果充分说明,先验信息对于网络的性能提升有着很大的帮助。

表1还反应出:在SBU上,先验信息带给网络的性能提升要大于在UCF上的,这和两个数据集的差异有关。UCF的阴影检测的场景相比于SBU,场景更加复杂,所以先验信息对于网络的引导作用要略差于SBU。

通过消融实验的证明,本文的阴影先验信息在面对简单场景或复杂场景下的阴影检测时,都能给网络带来不小的提升。原因是阴影先验信息为网络提供了原始的阴影位置的粗略信息,能够引导网络学习到阴影区域。

3.4 和其他先进方法的比较

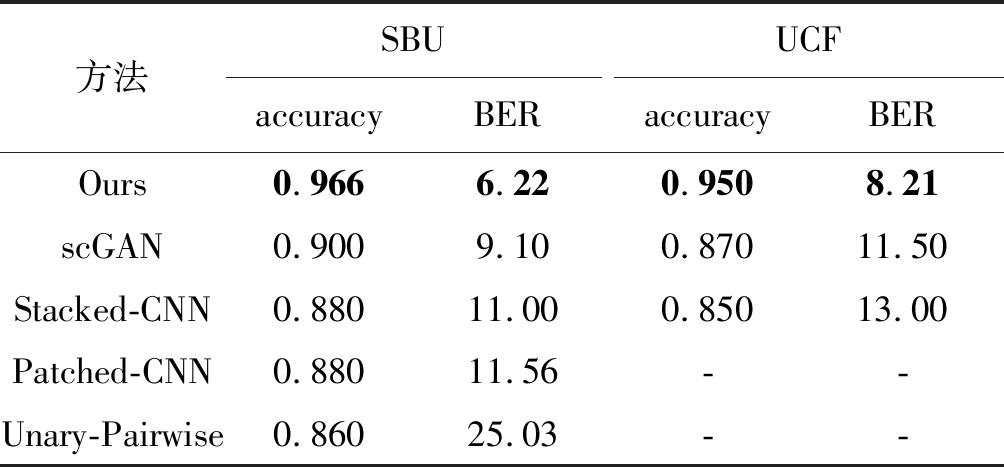

本文和四个先进的阴影检测方法进行了比较,它们分别是scGAN[21],stacked-CNN[19],patched-CNN[20]和Unary-Pairwise[9]。它们之中前三个是深度学习方法,最后一个是基于手工特征的方法。为了比较结果的公平,本文使用了他们公开的结果,或者采用公开的代码和默认参数来复现这些方法。

本文在SBU数据集与UCF数据集上和四种先进的阴影检测方法进行了比较。比较结果如图7和表2中所示。从图7中可以看出,本文的阴影检测结果相比于其他四种表现出色,标记的阴影区域和其他方法相比拥有清晰的边界。表2反应出本文网络在SBU数据集和UCF数据集上的正确率和平衡错误检测因子表现都优于其他四种方法,正确率比最高的scGAN高了6.6%,平衡错误检测因子比最低的scGAN下降了约3。从表2的数据上可以看出,本文的阴影检测结果比其他方法表现更加出色。

表2 与其他方法的正确率和平衡错误检测因子的定量比较

Tab.2 Visual comparison of shadow maps produced by our method and other methods

方法SBUaccuracyBERUCFaccuracyBEROurs0.9666.220.9508.21scGAN0.9009.100.87011.50Stacked-CNN0.88011.000.85013.00Patched-CNN0.88011.56--Unary-Pairwise0.86025.03--

图7 和其他阴影检测方法的阴影预测结果的可视化比较

Fig.7 Visual comparison of shadow maps produced by our method and other methods

4 结论

本文提出了一种基于阴影先验信息检测单幅图像阴影的阴影检测网络。该网络使用了先验加权模块提取出图像蕴含的阴影先验信息,并用其加权卷积特征来引导网络学习到阴影区域特征;引入特征融合模块来融合粗略的语义信息和精细特征,缓解了上采样带来的混叠效应。实验结果表明,图像本身蕴含的阴影先验信息可以帮助网络准确定位到阴影所在位置,本文方法在SBU和UCF数据集上的表现都优于其他四种先进的阴影检测方法。本文方法还存在着一些不足,比如阴影不明显图像中,阴影先验信息的作用有限,如图7最后一行所示。在后续工作中会继续改进研究,并将其用于阴影去除。

[1] Jean-François Lalonde, Alexei A Efros, Srinivasa G. Narasimhan. Estimating the Natural Illumination Conditions from a Single Outdoor Image[J]. International Journal of Computer Vision, 2012, 98(2): 183-190.

[2] Okabe T, Sato I, Sato Y. Attached shadow coding: Estimating surface normal from shadows under unknown re ectance and lighting conditions[C]∥IEEE International Conference on Computer Vision (ICCV), 2009: 1693-1700.

ectance and lighting conditions[C]∥IEEE International Conference on Computer Vision (ICCV), 2009: 1693-1700.

[3] Shen L, Wee Chua T, Leman K. Shadow optimization from structured deep edge detection[C]∥IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2015: 2067-2074.

[4] Cucchiara R, Grana C, Piccardi M, et al. Detecting moving objects, ghosts, and shadows in video streams[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2003, 25(10): 1337-1342.

[5] Nadimi Sohail, Bhanu Bir. Physical models for moving shadow and object detection in video[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2004, 26(8): 1079-1087.

[6] Graham D. Finlayson, Mark S. Drew and Cheng Lu. Intrinsic Images by Entropy Minimization[C]∥European Conference on Computer Vision (ECCV), 2004: 582-595.

[7] Liu Songtao, Huang Di, Wang Yunhong. Receptive Field Block Net for Accurate and Fast Object Detection[C]∥European Conference on Computer Vision (ECCV), 2018: 385- 400.

[8] Zhu J, Samuel K G, Masood S Z, et al. Learning to recognize shadows in monochromatic natural images[C]∥IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2010: 223-230.

[9] Guo R, Dai Q, Hoiem D. Single-image shadow detection and removal using paired regions[C]∥IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2011: 2033-2040.

[10]Guo Ruiqi, Dai Qieyun, Hoiem Derek. Paired regions for shadow detection and removal[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2013, 35(12): 2956-2967.

[11]Vicente T F Y, Yu C P, Samaras D. Single image detection using multiple cues in a super modular MRF[C]∥British Machine Vision Conference. Bristol: British Machine Vision Association, 2013: 1-12.

[12]Xingsheng Yuan, Marc Ebner, Zhengzhi Wang. Single-image shadow detection and removal using local colour constancy computation[J]. IET Image Processing, 2015, 9(2): 118-126.

[13]Panagopoul A, Wang C, Samaras D. Estimating shadows with the bright channel cue[C]∥European Conference on Trends and Topics in Computer. Heraklion: Springer, 2010: 1-12.

[14]Maryam Golchin, Fatimah Khalid, Lili Nurliana Abdullah, et al. SHADOW DETECTION USING COLOR AND EDGE INFORMATION[J]. Journal of Computer Science, 2013, 9(11): 1575-1588.

[15]Elena Salvador, Andrea Cavallaro, Touradj Ebrahimi. Cast shadow segmentation using invariant color features[J]. Computer Vision and Image Understanding, 2004, 95(2): 238-259.

[16]Dong Qi, Liu Yanli, Zhao Qijun,et al. Detecting soft shadows in a single outdoor image: From local edge-based models to global constraints[J]. Computers & Graphics, 2014, 38(1): 310-319.

[17]Tian Jiandong, Qi Xiaojun, Qu Liangqiong, et al. New spectrum ratio properties and features for shadow detection[J]. Pattern Recognition, 2016, 51(C): 85-96.

[18]Khan S H, Bennamoun M, Sohel F. Automatic feature learning for robust shadow detection[J]. Computer Vision and Pattern Recognition. Columbus: IEEE, 2014: 1939-1946.

[19]Vicente T F Y, Hou L, Yu C P. Large-scale training of shadow detectors with noisily-annotated shadow examples[C]∥Computer Vision-ECCV. Amsterdam: Springer, 2016: 816- 832.

[20]Hosseinzadeh S, Shakeri M, Zhang H. Fast shadow detection from a single image using a patched convolutional neural network[EB/OL]. http.∥arxiv.org/abs/1709.09283, (2018-03-16)[2020-5-14].

[21]Nguyen V, Vicente T F Y, Zhao M. Shadow detection with conditional generative adversarial networks[C]∥IEEE International Conference on Computer Vision. Venice: IEEE, 2017: 4520- 4528.

[22]Le H, Vicente T F Y, Nguyen V. A+D-Net: shadow detection with adversarial shadow attenuation[EB/OL]. https:∥arxiv.org/abs/1712.01361, (2018-07-27)[2020-5-14].

[23]Tsung-Yi Lin, Piotr Doll’ar, Ross B Girshick, et al. Feature pyramid networks for object detection[C]∥IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2017: 1- 6.

[24]He Kaiming, Zhang Xiangyu, Ren Shaoqing, et al. Deep residual learning for image recognition[C]∥IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2016: 3-7.

[25]Karen Simonyan, Andrew Zisserman. Very deep convolutional networks for large-scale image recognition[C]∥International Conference on Learning Representations (ICLR), 2015: 3-7.

[26]Liu Jiangjiang, Hou Qibin, Cheng Mingming, et al. A Simple Pooling-Based Design for Real-Time Salient Object Detection[C]∥IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2019: 3917-3926.

[27]He Kaiming, Zhang Xiangyu, Ren Shaoqing, et al. Deep residual learning for image recognition[C]∥IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2016: 770-778.

[28]Zhu J, Samuel K G, Masood S Z, et al. Learning to recognize shadows in monochromatic natural images[C]∥IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2010: 223-230.

[29]王勇, 王臻. 基于双树复小波的移动阴影检测和移除[J]. 网络安全技术与应用, 2020(4): 54-56.

Wang Yong, Wang Zhen. Moving shadow detection and removal based on dual-tree complex wavelet[J]. Network Security Technology & Application, 2020(4): 54-56.(in Chinese)

[30]汪明章, 邢冠宇. 基于深度学习的阴影检测算法[J]. 现代计算机, 2020(6): 97-101, 108.

Wang Mingzhang, Xin Guanyu. Shadow Detection Based on Deep Learning[J]. Modern Computer, 2020(6): 97-101, 108.(in Chinese)

[31]王威, 李志华, 吴世宇. 基于多特征融合的车辆阴影检测与去除[J]. 计算机与现代化, 2019(12): 49-54, 59.

Wang Wei, Li Zhihua, Wu Shiyu. Vehicle Shadow Detection and Removal Based on Multi-feature Fusion[J]. Computer and Modernization, 2019(12): 49-54, 59.(in Chinese)

[32]梁永侦, 潘斌, 郭小明, 等. 基于LAB颜色空间的图像阴影检测与去除方法[J]. 计算机与现代化, 2019(10): 88-93.

Liang Yongzhen, Pan Bin, Guo Xiaoming, et al. Image Shadow Detection and Removal Method Based on LAB Color Space[J]. Computer and Modernization, 2019(10): 88-93.(in Chinese)

[33]吴文君, 张玲, 肖春霞. 基于深度信息的单幅图像自动阴影检测[J]. 武汉大学学报(理学版), 2019, 65(5): 441- 449.

Wu Wenjun, Zhang Ling, Xiao Chunxia. Automatic Shadow Detection from Single Image Based on Depth Cues[J]. Journal of Wuhan University (Natural Science Edition), 2019, 65(5): 441- 449.(in Chinese)

[34]张友鹏, 王淳, 刘艳丽. 移动视点下在线视频的动态阴影检测与跟踪[J]. 系统仿真学报, 2019, 31(7): 1439-1447.

Zhang Youpeng, Wang Chun, Liu Yanli. Dynamic Shadow Detection and Tracking of Online Video from Mobile View[J]. Journal of System Simulation, 2019, 31(7): 1439-1447.(in Chinese)

[35]王建, 宋占杰, 何宇清. 使用闪光灯图像对的闪光灯阴影检测[J]. 信号处理, 2015, 31(11): 1425-1431.

Wang Jian, Song Zhanjie, He Yuqing. Flash shadow detection using flash image pairs[J]. Journal of Signal Processing, 2015, 31(11): 1425-1431.(in Chinese)

[36]袁博, 阮秋琦, 安高云. 改进的自适应灰度视频序列阴影检测方法[J]. 信号处理, 2014, 30(11): 1370-1374.

Yuan Bo, Ruan Qiuqi, An Gaoyun. Improved Adaptive Shadow detection Approach in Grayscale Video Sequences[J]. Journal of Signal Processing, 2014, 30(11): 1370-1374.(in Chinese)

[37]史洪印, 侯志涛, 郭秀花, 等. 基于道路信息和阴影检测的单幅高分辨率SAR图像动目标检测方法[J]. 信号处理, 2012, 28(12): 1706-1713.

Shi Hongyin, Hou Zhitao, Guo Xiuhua, et al. Moving Targets Indication Method in a Single High Resolution SAR Imagery Based on Road Information and Shadow Detection[J]. Journal of Signal Processing, 2012, 28(12): 1706-1713.(in Chinese)